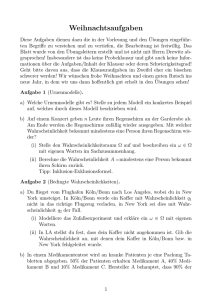

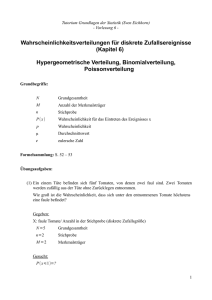

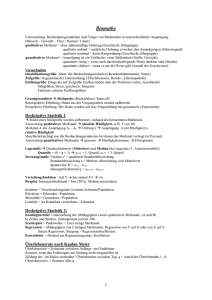

Einführung in elementare Statistik und Wahrscheinlichkeitsrechnung

Werbung