Asymptotik und stetige Zufallsvariablen Verteilungsfunktionen

Werbung

Asymptotik und stetige Zufallsvariablen

Verteilungsfunktionen

Verteilung von Aktien-Returns

Tschebyscheff-Ungleichung

Quiz

Gesetz der großen Zahlen

Stirling-Formel

Zentraler Grenzwertsatz

Normalverteilung

χ2-Verteilung

t-Verteilung

Exponentialverteilung

Die Verteilungsfunktion1 F einer Zufallsvariablen X

ordnet jeder reellen Zahl x die Wahrscheinlichkeit

F ( x ) = P( X ≤ x )

Beispiel: X hat eine Bernoulli-Verteilung mit p=0.3

P ( X = 0) = 0.7, P ( X = 1) = 0.3

F ( −2) = P ( X ≤ −2) = 0, F ( −0.1) = P ( X ≤ −0.1) = 0 ,

zu.

F (0) = P ( X ≤ 0) = 0.7, F (0.9) = P ( X ≤ 0.9) = 0.7 ,

0.0

0.2

0.2

0.4

0.4

0.6

0.8

0.6

1.0

0.8

0 , falls x < 4

P ( X = 4) = 1 ⇒ F ( x ) = P ( X ≤ x ) =

1, falls x ≥ 4

F (1) = P ( X ≤ 1) = 1, F (3) = P ( X ≤ 3) = 1

1.0

Beispiel: X hat eine Einpunktverteilung mit λ=4

4

8

12

0.0

0

1

distribution function (or cumulative distribution function)

-3

-2

-1

0

1

2

3

1

5

P ( X = 2) = 0.32 (1 − 0.3)5− 2 = 10 ⋅ 0.320.73 = 0.3087

2

x <- c(-10,0:n,10); F <- c(0,pbinom(0:n,n,p),1)

plot(x,F,type="s") # s: steps2

1.0

Beispiel: X hat eine Binomialverteilung mit n=5, p=0.3

0.4

F

0.6

0.8

n <- 5; p <- 0.3

dbinom(2,n,p) # P(X=2)

0.3087

dbinom(0:n,n,p) # P(X=0),P(X=1),P(X=2),…,P(X=n)

0.16807 0.36015 0.30870 0.13230 0.02835 0.00243

0.2

F ( 2.8) = P ( X ≤ 2.8) = P ( X = 0) + P ( X = 1) + P ( X = 2)

= 0.16807 + 0.36015 + 0.30870 = 0.83692

0.0

pbinom(0:n,n,p) # F(0),F(1),F(2),…,F(n)

0.16807 0.52822 0.83692 0.96922 0.99757 1.00000

-10

-5

0

5

10

x

2

Der Funktionswert an einer Sprungstelle ist immer so groß wie

die Funktionswerte nach dem Sprung, also z.B. F(0)=F(0.l).

Die senkrechten Linien an den Sprungstellen sollten nicht beachtet

werden, sie werden bei dieser Art von Plots automatisch gezeichnet.

2

Ist X eine diskrete Zufallsvariable, dann ist F(X) eine

Treppenfunktion.

Sind ω1 < ω2 < ω3 < ... die Elemente von X (Ω) , dann gilt:

Für die Berechnung der Momente einer diskreten Zufallsvariablen X ist also die Kenntnis der Verteilungsfunktion

von X ausreichend.

Beispielsweise ist der Erwartungswert gegeben durch

F (ω1 ) = P( X = ω1 )

E ( X ) = ∑ ω j P( X = ω j )

F (ω2 ) = P( X = ω1 ) + P( X = ω2 )

j ≥1

= ω1P ( X = ω1 ) + ∑ ω j P ( X = ω j )

F (ω3 ) = P ( X = ω1 ) + P ( X = ω2 ) + P ( X = ω3 )

j≥2

M

= ω1F (ω1 ) + ∑ ω j ( F (ω j ) − F (ω j −1 )) .

j ≥2

und umgekehrt

P( X = ω1 ) = F (ω1 )

P( X = ω2 ) = F (ω2 ) − F (ω1 )

P ( X = ω3 ) = F (ω3 ) − F (ω2 )

M

Diskrete Zufallsvariablen mit der gleichen Verteilungsfunktion haben daher auch die gleichen Momente.

Die Zufallsvariablen X 1 , X 2 , X 3 , ... heißen identisch

verteilt3, wenn sie die gleiche Verteilungsfunktion haben,

d.h.

P ( X 1 ≤ x ) = P ( X 2 ≤ x ) = P ( X 3 ≤ x ) = ... ∀x ∈ ℜ .

3

identically distributed

3

Sind X 1 , X 2 , X 3 , ... identisch verteilt mit

µ = E ( X 1 ) = E ( X 2 ) = E ( X 3 ) = ... ,

dann ist der Erwartungswert des arithmetischen Mittels4

X =

X 1 + ... + X n

n

für alle n gegeben durch

Die Zufallsvariablen X 1 , X 2 , X 3 , ... heißen unabhängig5,

wenn für alle n die Zufallsvariablen X 1 , ..., X n unabhängig

sind.

Die Zufallsvariablen X 1 , X 2 , X 3 , ... heißen i.i.d.6, wenn

sie unabhängig und identisch verteilt sind.

Sind X 1 , X 2 , X 3 , ... i.i.d. mit Erwartungswert µ und

Varianz σ 2, dann gilt für alle n

E ( X ) = E ( 1n ( X 1 + ... + X n ))

var( X ) = var( n1 ( X 1 + ... + X n ))

= n1 E ( X 1 + ... + X n )

=

= n1 ( E ( X 1 ) + ... + E ( X n ))

=

= n1 ( µ + ... + µ )

=

=µ.

1

n2

1

n2

1

n2

var( X 1 + ... + X n )

(var( X 1 ) + ... + var( X n ))

2

(σ 2 + ... + σ 2 ) = σn .

Die Varianz verschwindet für n→∞.

5

4

average (or sample mean)

6

independent

independent and identically distributed

4

Man sagt, dass die Folge von Zufallsvariablen Y1 ,Y2 , ...

im quadratischen Mittel7 gegen die Zufallsvariable Y

konvergiert, falls

E (Yn − Y )2 → 0 .

Sind X 1 , X 2 , ... i.i.d. mit Erwartungswert µ und Varianz

σ 2, dann konvergiert die Folge

Konvergiert die Folge Y1 ,Y2 , ... im quadratischen Mittel

gegen Y, dann konvergiert auch die Folge der Verteilungsfunktionen von Y1 ,Y2 , ... gegen die Verteilungsfunktion

von Y (Konvergenz in Verteilung9), d.h.

P (Yn ≤ y ) → F ( y ) = P (Y ≤ y )

an allen Stellen y∈ℜ, an denen F stetig ist.10

X1 X1 + X 2 X1 + X 2 + X 3

,

,

, ...

1

2

3

Es folgt also aus der Konvergenz im quadratischen Mittel

von X gegen µ, dass X auch in Verteilung gegen µ

der arithmetischen Mittel im quadratischen Mittel gegen

die konstante Zufallsvariable, die nur den Wert µ annimmt, konvergiert.

weil

Die Verteilungsfunktion von X nähert sich daher mit

2

2

2

σ

wachsendem n der Verteilungsfunktion einer EinpunktE ( X − µ ) = E ( X − E ( X )) = var( X ) = n → 0 .

verteilung mit Parameter µ an.

Allgemein werden Aussagen über die Konvergenz von X

9

Gesetze der großen Zahlen8 genannt.

convergence in distribution (or convergence in law)

10

7

converges in mean square

8

laws of large numbers (LLN)

Im Fall der Konvergenz gegen eine konstante Zufallsvariable ist die

Konvergenz in Verteilung äquivalent mit der Konvergenz in Wahrscheinlichkeit (welche erst später behandelt wird).

5

1

.

0

0

.

8

0

.

6

0

.

4

0

.

2

0

.

0

0.0

0.2

0.4

0.6

0.8

1.0

1

.

0

Verteilungsfunktion von X für n=100, p=0.3:

0

.

0

0.0

0.2

0.4

0.6

0.8

1.0

0

.

8

1

.

0

Verteilungsfunktion von X für n=500, p=0.3:

0

.

2

0

.

0

p <- 0.3; n <- 25 # or n <- 100 or n <- 500

x <- c(-0.1,(0:n)/n,1.1); F <- c(0,pbinom(0:n,n,p),1)

plot(x,F,type="s")

0

.

4

0

.

6

Beispiel: Die Verteilungsfunktion des arithmetischen

Mittels von n unabhängigen, Bernoulli-verteilten Zufallsvariablen mit Parameter p nähert sich mit wachsendem n

der Verteilungsfunktion einer einpunktverteilten Zufallsvariablen mit Parameter p an.

0

.

2

0

.

4

Ist diese Wahrscheinlichkeit positiv, dann hat die Verteilungsfunktion der Summe eine Sprungstelle an der Stelle

x und die Verteilungsfunktion von X an der Stelle x/n.

Die Sprunghöhen sind gleich.

0

.

8

x

X + ... + X n x

P ( X 1 + ... + X n = x ) = P 1

= = P X =

n

n

n

Verteilungsfunktion von X für n=25, p=0.3:

0

.

6

Die Summe von i.i.d. Zufallsvariablen X1,…,Xn nimmt

den Wert x mit der gleichen Wahrscheinlichkeit an

wie das arithmetische Mittel den Wert x/n:

0.0

0.2

0.4

0.6

0.8

1.0

6

Tschebyscheff-Ungleichung11:

E ( X ) = µ , var( X ) = σ 2 > 0 , k>0 ⇒ P( X − µ > kσ ) <

Beweis (für diskrete Zufallsvariablen):

σ =

2

∑ ( x − µ ) P( X = x )

2

x∈ X ( Ω )

≥

∑ ( x − µ )2 P( X = x ) +

x > µ + kσ

>

⇒

∑ ( kσ ) 2 P( X = x ) +

x > µ + kσ

1 >

∑ P( X

k2

x > µ + kσ

= x) +

∑ ( x − µ )2 P( X = x )

x < µ − kσ

∑ ( kσ ) 2 P( X = x )

x < µ − kσ

1

k2

Spezialfall:

k = 2 : P( X − µ > 2σ ) < 0.25 , P( X − µ ≤ 2σ ) > 0.75

Analog:

P ( X − µ ≥ kσ ) ≤

1

k2

, P ( X − µ < kσ ) ≥ 1 −

1

k2

Schwaches Gesetz der großen Zahlen12:

Sind X1,X2,X3,… i.i.d. mit E ( X 1 ) = µ und var( X 1 ) = σ 2 ,

dann konvergiert X in Verteilung gegen µ, da für alle k>0

P( X ≤ µ + k ) = P( X − µ ≤

∑ P( X = x )

≥ P( X − µ ≤

x < µ − kσ

k

var( X )

k

var( X )

var( X ))

var( X )) > 1 −

= P ( X > µ + kσ ) + P ( X < µ − kσ )

P ( X ≤ µ − k ) = P ( −( X − µ ) ≥

= P ( X − µ > kσ )

≤ P( X − µ ≥

Komplementär-Wahrscheinlichkeit:

P ( X − µ ≤ kσ ) = 1 − P ( X − µ > kσ ) > 1 −

11

Chebyshev's inequality

12

k

var( X )

→1,

2

→ 0.

k

var( X ))

var( X )

k

var( X )

1

k2

2

1

var( X )) ≤

1

k

var( X )

weak law of large numbers (LLN)

7

Der Erwartungswert der zentrierten13 Zufallsvariablen

X − EX

Sind X 1 , X 2 , X 3 , ... i.i.d. mit Erwartungswert µ und

Varianz σ 2, dann gilt für alle n

(

ist gegeben durch

E ( X − E ( X )) = E ( X ) − E ( E ( X )) = 0

1424

3

=E( X )

)

2

var n ( X − µ ) = n var( X − µ ) = n var( X ) = n σn = σ 2

und

X −µ

X −µ

X −µ

= var

var n

= var

= 1.

σ

σ

σ2

n

n

und die Varianz der standardisierten14 Zufallsvariablen

X − E( X )

sd ( X )

Im Unterschied zu Gesetzen der großen Zahlen, die Aussagen machen über die Konvergenz von X gegen die

2

degenerierte Zufallsvariable µ, die Varianz 0 hat, machen

X − E( X ) 1

var( X )

var( X − E ( X )) =

=

var

=1.

1

4

4

2

4

4

3

zentrale Grenzwertsätze15 Aussagen über die Konvergenz

var( X )

sd ( X ) sd ( X )

= var( X )

von nY = n ( X − µ ) bzw. n Z = n ( X − µ ) / σ gegen

eine nicht-degenerierte Zufallsvariable mit Erwartungswert

0 und Varianz σ 2 bzw. 1.

durch

13

14

centered

standardized

15

central limit theorems (CLT)

8

0

.6

0

.8

1

.0

n Z für n=50, p=0.3:

Die Summe S= X1+…+Xn ist binomialverteilt und ihre Verteilungsfunktion springt an den Stellen s=0,1,2,…,n genau

-3

n Z an den Stellen

-2

-1

0

1

2

3

n Z für n=1000, p=0.3:

Verteilungsfunktion von

1

.0

so wie die Verteilungsfunktion von

0

.0

0

.2

von n Z betrachten wir eine Folge von unabhängigen und

identisch Bernoulli-verteilten Zufallsvariablen X1,X2,X3,…

mit Erwartungswert µ=p und Varianz σ 2=p(1−p)>0.

Verteilungsfunktion von

0

.4

Beispiel: Zur Untersuchung des Grenzverhaltens für

n → ∞ (asymptotische Analyse16) der Verteilungsfunktion

1

n

( X1σ−µ + ... +

X n −µ

σ

) = s − nµ )

= P ( X 1 + ... + X n = s) .

p <- 0.3; n <- 50; s <- 0:n; F <- pbinom(0:n,n,p)

plot((s-n*p)/(sqrt(n*p(1-p)),F,type="s",xlim=c(-3,3))

# sqrt: square root, xlim: x coordinates range

16

asymptotic analysis

0

.4

= P(σ n

0

.2

s −nµ

)

nσ

0

.0

P( n Z =

0

.6

0

.8

( s − nµ ) / n σ , s=0,1,2…,n. Es gilt nämlich

-3

-2

-1

0

1

2

3

Mit wachsendem n werden die Sprünge immer kleiner,

die Verteilungsfunktion von n Z nähert sich einer

stetigen Funktion an.

9

Die Verteilungsfunktion einer diskreten Zufallsvariablen

X ist fast überall konstant und wächst nur durch Sprünge

an den Stellen x∈X(Ω). Die Sprunghöhe an der Stelle x

ist gegeben durch P(X=x). Die Summe aller Sprünge ist 1.

Im Gegensatz dazu gibt es bei einer stetigen Verteilungsfunktion keine Sprünge. Ein Anstieg von F(a) auf F(b) im

Intervall [a,b] lässt sich also nicht mit einer Summe von

Wahrscheinlichkeiten beschreiben. Jeder einzelne Wert

hat eine Wahrscheinlichkeit von 0.

Beispiel: Gleichverteilung auf Ω=(0,1], X(ω)=ω

x ∈ (0,1] : F ( x) = P ( X ≤ x) = P ( X ∈ (0, x]) = x

Eine Zufallsvariable X heißt stetig17, wenn eine Funktion

f: R→[0,∞) existiert, sodass für alle Borel-Mengen A gilt:

P ( X ∈ A) = ∫ f (t ) dt

A

Eine solche Funktion f heißt Dichtefunktion18 von X.

Die zugehörige Verteilungsfunktion ist gegeben durch

F ( x ) = P ( X ≤ x ) = P( X ∈ ( −∞, x ]) =

x

∫ f (t ) dt = ∫ f (t ) dt

( −∞, x ]

−∞

und ihre Ableitung F ′ durch f.

Beispiel: Gleichverteilung auf Ω=(0,1], X

x <- seq(-1,2,0.001); F <- dunif(x,0,1); plot(x,F,type="l")

0.2

0.4

0.6

0.8

1.0

x <- seq(-1,2,0.001); F <- punif(x,0,1) # uniform on 0,1

plot(x,F,type="l") # type="l": lines

0.0

17

18

-1.0

-0.5

0.0

0.5

1.0

1.5

2.0

continuous

density (or probability density function)

10

Beispiel: X1,X2,X3,… i.i.d. Bernoulli-verteilt

n=100, p=0.3: Binomialwahrscheinlichkeiten P ( nX = x )

Dichtefunktion f(x)

f ( x) =

− ( x − µ )2

1 1

,

exp

2σ 2

2π σ

wobei

0

.

0

0

ist für große n 19 gegeben durch

0

.

0

2

0

.

0

4

= nX

0

.

0

6

n!

P ( X 1 + ... + X n = x) =

p x (1 − p ) n− x

14243

x!(n − x)!

0

.

0

8

Eine Approximation der Binomialwahrscheinlichkeit

15

20

25

30

35

40

45

n=100, p=0.3: Verteilungsfunktion P( nX ≤ x )

x

µ = np , σ 2 = np(1 − p ) .

Verteilungsfunktion ∫ f (t ) dt

19

20

over 9000

normally distributed

0

.6

0

.0

0

.2

funktion einer Zufallsvariablen, dann heißt diese Zufallsvariable normalverteilt20 mit den Parametern µ und σ 2.

0

.

4

Ist diese Funktion f mit µ ∈ ℜ und σ 2 > 0 die Dichte-

0

.8

1

.0

−∞

15

20

25

30

35

40

45

11

Xj −µ

j =1

σ

= n

X −µ

σ

0

.

0

-2

-1

0

1

2

3

0

.

8

1

.

0

F <- pnorm(x,0,1); plot(x,F,type="l",xlim=c(-3,3))

x

Φ ( x ) = ∫ φ (t )dt .

−∞

Eine Zufallsvariable mit so einer Dichtefunktion heißt

standardnormalverteilt21.

standard normally distributed

0

.

4

und Verteilungsfunktion

21

-3

0

.

6

in Verteilung gegen eine stetige Zufallsvariable Z mit

Dichtefunktion

− x2

1

exp

φ ( x) =

2

2π

0

.

1

0

.

2

n

∑

0

.

2

1

n

0

.

0

n

x <- seq(-3,3,0.001); f <- dnorm(x,0,1) # my=0, sigma=1

plot(x,f,type="l",xlim=c(-3,3))

0

.

4

Sind X 1 , X 2 , X 3 , ... i.i.d. mit Erwartungswert µ und

Varianz σ 2, dann konvergiert

Eine standardnormalverteilte Zufallsvariable ist normalverteilt mit den Parametern µ=0 und σ 2=1.

0

.

3

Zentraler Grenzwertsatz:

-3

-2

-1

0

1

2

3

pnorm(c(-1,0,1,2)) # P(Z<2)=0.9772499

0.1586553 0.5000000 0.8413447 0.9772499

qnorm(c(0.025,0.5,0.975,0.995)) # P(Z<1.959964)=0.975

-1.959964 0.000000 1.959964 2.575829

12

log(n! ) = log(n ⋅ ( n − 1) ⋅ ... ⋅ 1)

Stirling-Formel23:

= log(n ) + log(n − 1) + ... + log(1)

n! ≈

= log(n ) + log(n − 1) + ... + log(2)

n + 0.5

1⋅log(2)+1⋅log(3)+…+1⋅log(10) (Fläche der Rechtecke)

≈ Integral von log(x) auf [1.5,10.5] (rot umrandete Fläche)

(siehe Abbildung)

1.5

= ( x log( x ) − x )

n + 0.5

1.5

= (n + 0.5) log(n + 0.5) − n − 0.5 − 1.5 log(1.5) + 1.5)

= (n + 0.5) log(n (1 + 0n.5 )) − n − 0.5 + 1.5(1 − log(1.5))

1442443

2.0

∫ log( x ) dx

1.5

≈

2π n ( ne ) n ≈ 2.506628 n ( ne )n

= n log(n ) + log((1 + 0n.5 ) n ) + 12 log(n ) + 12 log(1 + 0n.5 ) -n-0.5-C

144244

3

142

4 43

4

≈ n log(n ) − n + log( n ) + C

⇒ n! ≈ eC n e − n n n ≈ 2.439523 n ( ne ) n 22

0.5

≈0

0.0

≈ log( e0.5 ) = 0.5

1.0

=C

0

22

Die Approximation wird genauer, wenn man eC durch √2π ersetzt.

23

1

2

3

4

5

6

7

8

9

10

Stirling's formula

13

Für große n sind nur Wahrscheinlichkeiten für Werte x in

der Nähe von µ relevant. Für diese Werte gilt

x−µ

y −ν

≈ 0,

≈0.

Die Anwendung der Stirling-Formel

2π n ( ne ) n

n! ≈

µ

auf die Binomialwahrscheinlichkeit

n!

p x (1 − p )n − x

x!( n − x )!

P( X = x ) =

Mit Hilfe der Taylor-Approximation

log(1 + ε ) ≈ 0 + ε − 12 ε 2

ergibt mit y = n − x, q = 1 − p, µ = np, ν = nq, σ 2 = npq

1

2π

1

n nn e x e y x y

p q =

x

y

n

x y x y 12

2π

e3

n np

xy x

x

nq

y

=1

=

1

2π

1

µ

µ x − µ ν y −ν x

n 1 +

1 +

µ n

ν

n

1 1µ

≈

2π σ x

x

y

ν

.

y

ν

x

ν

y

y

und v − y = (1 − p )n − ( n − x ) = x − µ erhält man

y

x

x

x−µ

µ

log = − x log = − x log 1 +

µ

x

µ

2

x − µ ( x − µ )2

≈ µ − x − (x − µ) ,

≈ ( − µ − ( x − µ ))

−

µ

2µ

2 µ 2

x

y

ν

( x − µ )2 (1 − p ) ( y − ν ) 2 p

µ

log + log = −

−

,

2np (1 − p )

2n (1 − p ) p

x

y

P( X = x ) ≈

1 1µ

2π σ x

x

y

− ( x − µ )2

ν

1 1

.

exp

≈

2σ 2

2π σ

y

14

Der Erwartungswert einer stetigen Zufallsvariablen mit

Dichtefunktion f ist gegeben durch

∞

E ( X ) = ∫ x f ( x ) dx

∞

E ( X ) = ∫ x f ( x ) dx .

Beispiel: X ist gleichverteilt auf dem Intervall [a,b]

a

b

∞

x

dx + ∫ x ⋅ 0 dx

a b−a

b

a

=

b

1 x2 b

b2 − a 2

a+b

=

=

b−a 2 a

2( b − a )

2

∞

1 b 2

b3 − a 3

E ( X ) = ∫ x f ( x ) dx =

∫ x dx = 3(b − a )

b−a a

−∞

2

P( −∞ < X < ∞) = ∫ f ( x ) dx

b

a

2

∞

= ∫ f ( x ) dx + ∫ f ( x ) dx + ∫ f ( x ) dx

b

∞

1

dx + ∫ 0 dx = 1

a b−a

b

var( X ) = E ( X 2 ) − ( E ( X )) 2 =

b

= ∫ 0 dx + ∫

−∞

−∞

−∞

∞

a

∞

= ∫ x ⋅ 0 dx + ∫

falls x < a

0,

1

f ( x) =

, falls a ≤ x ≤ b

b − a

0 ,

falls x > b

−∞

b

= ∫ x f ( x ) dx + ∫ x f ( x ) dx + ∫ x f ( x ) dx

−∞

−∞

a

−∞

a

=

a 2 + ab + b2 a + b

−

3

2

2

(b − a ) 2

12

15

Momente der Normalverteilung:

Ist X normalverteilt mit den Parametern µ und σ 2,

dann gilt:

E( X ) = µ ,

Sind Z1 , ..., Z k i.i.d. standardnormalverteilt, dann ist

X = Z 12 + ... + Z k2

χ2-verteilt mit k Freiheitsgraden24.

E ( X ) = E ( Z 12 ) + ... + E ( Z k2 ) = 1 + ... + 1 = k

var( X ) = E ( X − µ ) 2 = σ 2

var( X ) = 2k

E ( X − µ )4 = 3σ 4

Ist die standardnormalverteilte Zufallsvariable Z unabhängig von der mit k Freiheitsgraden χ2-verteilten Zufallsvariablen X, dann ist

Z

T=

E ( X − µ )3 = E ( X − µ )5 = ... = 0

3

0

X −µ

Schiefe = E

= =0

σ

σ

4

3σ 4

X −µ

Wölbung = E

= 4 =3

σ

σ

X

k

t-verteilt mit k Freiheitsgraden25.

k > 1 ⇒ E( X ) = 0

k > 2 ⇒ var( X ) =

24

25

k

k −2

chi-squared distributed with k degrees of freedom

t-distributed with k degrees of freedom

16

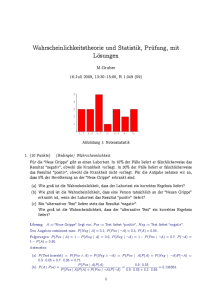

Zu diesem Plot der Dichtefunktion einer Standardnormalverteilung werden noch weitere Linien hinzugefügt,

nämlich die Dichtefunktionen von t-Verteilungen mit 3

bzw. 10 Freiheitsgraden.

konvergiert nach dem Gesetz der großen Zahlen als arithmetisches Mittel von k i.i.d. χ2(1) Zufallsvariablen gegen

den Erwartungswert einer χ2-Verteilung mit einem Freiheitsgrad, also gegen 1. Für große k wird T daher im

Wesentlichen nur von Z bestimmt.

f <- dt(x,3); lines(x,f,col="orange") # density of t(3)

f <- dt(x,10); lines(x,f,col="green") # density of t(10)

0.3

0.1

0

.2

0.0

0

.1

0

.0

f

0

.3

0

.4

f

x <- seq(-5,5,0.001); f <- dnorm(x,0,1) # density of N(0,1)

plot(x,f,type="l")

0.2

X

k

0.4

Die Zufallsvariable X/k in der Definition der t-verteilten

Zufallsvariablen

Z

T=

-4

-4

-2

0

2

4

-2

0

2

4

x

x

17

Die Dichtefunktion einer mit 2 Freiheitsgraden χ2-verteilten Abkürzungen:

Zufallsvariablen X ist für x≥0 gegeben durch

X ~ N ( µ ,σ 2 ) (X ist normalverteilt mit Parametern µ, σ2)

1

−x

exp

.

2

2

Allgemein heißt eine stetige Zufallsvariable X mit Dichtefunktion

1

−x

f ( x ) = exp

τ

τ

für x≥0 und f(x)=0 für x<0 exponentialverteilt26 mit dem

Parameter τ. Die Verteilungsfunktion von X ist gegeben

durch

f ( x) =

x

−t

−t

−x

F ( x ) = ∫ exp dt = − exp = 1 − exp

τ

τ 0

τ

0τ

x

1

für x≥0 und F(x)=0 für x<0. Weiters gilt:

X ~ χ 2 ( k ) (X ist χ2-verteilt mit k Freiheitsgraden)

X ~ t ( k ) (X ist t-verteilt mit k Freiheitsgraden)

X ~ Exp(τ ) (X ist exponentialverteilt mit Parameter τ)

d

X n → X (Xn konvergiert in Verteilung gegen X)

m. s.

X n → X (Xn konvergiert im quadratischen Mittel gegen X)

Es gilt:

X ~ N ( µ , σ 2 ) ⇒ a + b X ~ N ( a + b µ , b2σ 2 )

X ~ N ( µ , σ 2 ), Y ~ N (ν ,τ 2 ), X , Y unabhängig

⇒ X + Y ~ N ( µ + ν ,σ 2 + τ 2 )

X ~ χ 2 ( k ), Y ~ χ 2 ( m), X ,Y unabhängig

⇒ X + Y ~ χ 2 ( k + m)

E ( X ) = τ , var( X ) = τ 2

d

26

exponentially distributed

d

X n → X , g stetig ⇒ g ( X n ) → g ( X )

18

A <- cbind(1:3,c(1,1,1),5:3,c(0,1,1)); A

1 1 5 0

2 1 4 1

3 1 3 1

A[1:2,3] # erste zwei Komponenten der 3. Spalte von A

5 4

A[2,] # ganze zweite Zeile von A

2 1 4 1

Mit der Funktion data.frame kann man zu einer Matrix

von Zahlen, wie z.B. A, eine Spalte anderen Typs, z.B.

eine Datums-Spalte, hinzufügen:

z <- c("2014-12-31","2015-01-01","2015-01-02")

# z ist ein Text-Vektor.

d <- as.Date(z) # Umwandlung in Datums-Vektor

F <- data.frame(d,A); F

2014-12-31 1 1 5 0

2015-01-01 2 1 4 1

2015-01-02 3 1 3 1

Das neue Objekt F ist keine Matrix mehr, sondern ein

Data Frame, weil nicht alle seine Spalten vom gleichen

Typ sind.

19

Downloaden und Importieren von Aktienkursen:

• Auf der Website finance.yahoo.com gibt man den Namen

einer Firma, z.B. Home Depot, oder - falls bekannt - gleich

das Symbol, HD, im Feld Quote Lookup ein und wählt

durch Anklicken aus den vorgeschlagenen Alternativen.

• Zur Kontrolle lässt man sich Y anzeigen.

Y # HD-Kurse heruntergeladen am 8.11.2014

Date

Open High Low Close Volume Adj.Close

2014-11-07 97.17 97.75 96.69 97.65 3429500 97.65

M

1981-09-22 10.25 10.25 10.25 10.25 7435800 0.02

• Nach dem Anklicken von Historical Prices gelangt man

• Die erste Spalte des Data Frames Y wird in einen

zum Download-Menü, wo man den gewünschten Date

Datums-Vektor umgewandelt.

Range und die gewünschte Frequenz, z.B. Daily, wählt

und dann Get Prices und Download to Spreadsheet anklickt. Y[,1] <- as.Date(Y[,1])

• Das heruntergeladene File table.csv wird in ein zuvor

angelegtes Verzeichnis, z.B. C:\R Projects\HD, kopiert.

• Die zeitlich absteigende Reihenfolge der Zeilen von Y

wird umgedreht.

• R wird gestartet, das Working Directory C:\R Projects\HD n <- nrow(Y) # n = Anzahl der Zeilen von Y

Y[1:n,] <- Y[n:1,]; Y # Zeile n wird zu Zeile 1, …

wird gewählt, die Daten werden von table.csv eingelesen:

setwd("C:/R Projects/HD")

Y <- read.table("table.csv",sep=",",header=TRUE)

# values separated by comma, names of variables in 1st line

Date

Open High Low Close Volume Adj.Close

1981-09-22 10.25 10.25 10.25 10.25 7435800 0.02

M

2014-11-07 97.17 97.75 96.69 97.65 3429500

97.65

20

Plotten der 7. Spalte (bereinigte27 Schlusskurse) gegen

die 1. Spalte (Kalendertage):

0

20

40

60

80

100

d <- Y[,1]; y <- Y[,7]

plot(d,y,type="l") # type="l": Linienplot

Der Kursanstieg von 0.02 am 1981-09-22 auf 8.39 am

1992-12-24 (auf das ca. 420-fache!) wirkt unbedeutend

im Vergleich zum Anstieg von 5.84 am 1993-09-15 auf

52.07 am 1999-12-31 (auf das ca. 9-fache) und erst recht

zum Anstieg von 15.38 am 2009-03-06 auf 97.65 am

2014-11-07 (auf das ca. 6-fache).

1990

27

2000

2010

adjusted for dividends and splits

21

Eine graphische Darstellung des Kursverlaufs wäre

wünschenswert, bei der beispielsweise der Anstieg von 1

auf 2 (eine Verdoppelung) identisch ist mit dem von 10

auf 20 (ebenfalls eine Verdoppelung). Eine solche

Darstellung erhält man, wenn man die logarithmierten

Kurse anstelle der ursprünglichen Kurse plottet.

Die Tages-Rendite einer Aktie ist die relative Änderung

y − yt −1

Rt = t

yt −1

Es gilt nämlich:

log(2) − log(1) = log

Die Rendite29 Rt kann durch die logarithmierte Rendite30

( ) = log( ) = log(20) − log(10)

2

1

20

10

plot(d,log(y),type="l")

Log-Returns

des Schlusskurses yt an diesem Tag gegenüber dem

Schlusskurs yt-1 vom Vortag.28

rt = log( yt ) − log( yt −1 )

4

approximiert werden.

Die Approximation ist umso besser, je kleiner Rt ist:

-2

0

2

yt = 150, yt −1 = 100 ⇒ Rt = 0.50, rt ~ 0.4054651

yt = 105, yt −1 = 100 ⇒ Rt = 0.05, rt ~ 0.0487902

yt = 101, yt −1 = 100 ⇒ Rt = 0.01, rt ~ 0.0099503

28

Dividenden-Ausschüttungen werden hier ignoriert.

return

30

log return

-4

29

1990

2000

2010

22

Log-Returns können für die Tage 2,3,4,…,n berechnet

werden, nicht aber für den ersten Tag, weil es in diesem

Fall keinen Vorwert gibt.

Als Maß für die Volatilität kann man die Varianz bzw.

die Standardabweichung verwenden, die man durch die

Stichprobenvarianz32

0

.4

r <- log(y[2:n])-log(y[1:(n-1)]) # log(y[2])-log(y[1]),…

plot(d[2:n],r,type="l",xlab="",ylab="") # no axis labels

s2 =

1 n

∑ ( rj − r )2

n − 1 j =2

0

.2

bzw. die Stichprobenstandardabweichung33

0

.

0

s = s2

0

.4

0

.2

der n-1 Log-Returns r2,…,rn schätzen kann.

1990

2000

2010

Die Log-Returns sehen nicht so aus wie Zufallszahlen,

die alle mit der gleichen Wahrscheinlichkeitsverteilung

erzeugt wurden. Offenbar gibt es Perioden unterschiedlicher Volatiliät31. In manchen Perioden sind die Schwankungen viel größer als in anderen Perioden.

c(min(r),max(r),mean(r),sd(r),var(r))

-0.4054651081 0.4054651081 0.0010163232

0.0256705747 0.0006589784

32

33

31

sample variance (or empirical variance)

sample standard deviation (or empirical standard deviation)

volatility

23

Im Fall einer Zufallsstichprobe von einer stetigen WahrDass so viele Log-Returns in das Intervall (-0.0025,0.0025]

scheinlichkeitsverteilung könnte man die zugrundeliegende fallen, liegt daran, dass die bereinigten Schlusskurse sehr

Dichtefunktion mit einem Histogramm approximieren.

oft gleich bleiben. Anfangs sind sie nämlich sehr klein und

werden trotzdem nur mit 2 Nachkommastellen angegeben.

b <- seq(-0.4075,0.4075,0.005) # breakpoints of cells

Z.B.:

hist(r,breaks=b) # histogram of r

… 0.02 0.02 0.02 0.02 0.02 0.03 0.03 0.03 0.03 …

Histogram of r

Wir lassen daher die ersten 2500 Log-Returns weg.

Histogram of rr

2

0

0

4

0

0

F

re

q

u

e

n

c

y

6

0

0

1000

500

0

0

Frequency

8

0

0

1500

rr <- r[2501:(n-1)]

hist(rr,breaks=b,xlim=c(-0.1,0.1))

-0.4

-0.2

0.0

0.2

0.4

-0.10

-0.05

0.00

0.05

0.10

rr

r

24

Für einen Vergleich des Histogramms mit der Dichtefunktion einer Normalverteilung normieren wir das

Histogramm so, dass seine Fläche gleich 1 ist, und wählen

r und s 2 als Parameter für die Normalverteilung.

hist(rr,freq=FALSE,breaks=b,xlim=c(-0.1,0.1))

m <- mean(rr); s <- sd(rr) # R uses s as parameter, not s2

x <- seq(-0.5,0.5,0.001); f <- dnorm(x,m,s); lines(x,f,col="red")

20

25

Histogram of rr

Im Vergleich zu einer Normalverteilung gibt es bei den

Log-Returns sowohl mehr Werte im Zentrum als auch an

den Rändern.

Die Anpassung einer t-Verteilung an die Log-Returns ist

nicht sinnvoll, weil sie zu unflexibel ist. Ihr Erwartungswert ist immer 0, und ihre Varianz ist nahe bei 1.

Allerdings kann man einen beliebigen Erwartungswert und

eine beliebige Varianz durch eine lineare Transformation

erhalten. Ist die Dichte fX einer Zufallsvariablen X bekannt,

dann lässt sich auch die Dichte fY von Y=µ+σ X ermitteln:

15

10

5

0

Density

FY ( y ) = P(Y ≤ y ) = P ( µ + σX ≤ y )

-0.10

-0.05

0.00

rr

0.05

0.10

y−µ

y−µ

= P X ≤

= FX

σ

σ

y−µ

y−µ 1

⇒ fY ( y ) = FY' ( y ) = FX'

= fX

,

σ

σ σ

1

f X ( x ) = fY ( µ + σ x )

σ

25

Eine linear transformierte t-Verteilung mit k=4 Freiheitsgraden passt besser zu den Log Returns als eine Normalverteilung:

k <- 4; c <- s/sqrt(k/(k-2)); f <- dt(x,k)

lines(m+x*c,f/c,col="blue")

t-Verteilungen mit k=3 und 5 Freiheitsgraden implizieren

zu viele bzw. zu wenige Werte im Zentrum. Die Wölbung

ist hier kein geeignetes Maß zur Beschreibung dieses Verhaltens, weil diese nur für k≥5 existiert. Ebenso ist die

Schiefe nur bedingt geeignet zur Beschreibung der Symmetrie, weil sie nur für k≥4 existiert.

Histogram of rr

15

Density

15

10

10

5

5

0

0

Density

20

20

25

25

30

Histogram of rr

-0.10

-0.05

0.00

0.05

0.10

-0.10

-0.05

0.00

0.05

0.10

rr

rr

26

Quiz

Lösungen

P(X∈{1,2,3})=0.4, P(X=7})=0.3, P(X=9)=0.3, F(8.5)=?

F(8.5)=P(X≤8.5)=P(X∈{1,2,3})+P(X=7)=0.4+0.3=0.7

a,b∈[4,8], P(X∈[a,b])=(b-a)/4, F(5.6)=?

F(5.6)=P(X≤5.6)=P(X∈[4,5.6])=(5.6-4)/4=0.4

x∈[-2,2]), P(X≤x)=0.5+0.25x, P(X∈(1,3))=?

P(X∈(1,3))=P(X<3)−P(X≤1)=1−(0.5+0.25⋅1)=0.25

2

2

X~N(-2,3 ), E(X )=?

E(X2)=var(X)+(E(X))2=9+(-2)2=13

X~χ2(5), E(X2)=?

E(X2)=var(X)+(E(X))2=2⋅5+52=35

X~t(6), E(X2)=?

E(X2)=var(X)+(E(X))2=6/(6-2)+02=1.5

X,Y i.i.d. N(0,22), Z=X2+Y2, var(Z)=?

(X/2)2+(Y/2)2~χ2(2), Z=4((X/2)2+(Y/2)2), var(Z)=16⋅4=64

X~N(0,32), Y~N(-1,22), X,Y unabh. ⇒ 3−2(X+Y)~N(a,b), b=? X+Y~N(0-1,9+4) ⇒ 3−2(X+Y)~N(3+2,22⋅13) ⇒ b=52

Konvergenz in Verteilung: Xn →d 3, (2Xn−1)3 →d c, c=?

Xn →d 3, g(x)=(2x−1)3 stetig ⇒ g(Xn) →d g(3)=125=c

X1,X2,… i.i.d. t(9), Yn= 7n X →d Y, var(Y)=r, r=?

√n ( X − 0) / 9 /(9 − 2) = Yn /3 →d Z~N(0,1) ⇒ r=9

X1,X2,… i.i.d. χ2(1), Yn=n( X -1)2/2 →d Y, var(Y)=r, r=?

Zn=√n( X -1)/√2 →d Z~N(0,1) ⇒ Yn=(Zn)2 →d Z2~χ2(1), r=2

a <- pbinom(1,3,0.5)+pnorm(2,2,10) # R code # a=?

a=(0.53+3⋅0.53)+0.5=1

27