16 Erwartungswert und Varianz

Werbung

§16 Erwartungswert und Varianz

ô

KombinationenOhneWiederholung@n_Integer, k_IntegerD := Permutations@Join@Table@1, 8k<D, Table@0, 8n - k<DDD

DiscreteEmpiricalPDF@daten_, z_D := Module@8n, min, max, uni<,

n = Length@datenD;

min = Min@datenD;

max = Max@datenD;

uni = Union@datenD;

If@MemberQ@daten, zD, BinCounts@daten, 8min, max + 1<D@@Position@uni, zD@@1, 1DDDD ê n, 0D êê ND

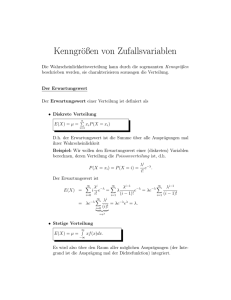

Das zufällige Verhalten einer Zufallsvariablen Z wird durch ihre Verteilung Z beschrieben. Für die Praxis ist es

wichtig, diese Verteilung durch einige wenige Größen möglichst aussagekräftig zu charakterisieren. Eine dieser

Größen ist der Erwartungswert @ZD. Damit wird beschrieben, um welchen Wert die Zufallsvariable Z schwankt.

Eine andere wichtige Größe ist die Varianz @ZD bzw deren Wurzel, die sogenannte Streuung @ZD, mit der

beschrieben wird, wie stark die Zufallsvariable Z um ihren Erwartungswert @ZD schwankt.

Wir werden uns in diesem Abschnitt mit dem Erwartungswert @ZD, der Streuung @ZD, der Varianz @ZD und

einigen weiteren, die Verteilung Z einer Zufallsvariablen Z charakterisierenden Größen eingehend befassen

und die Bedeutung dieser Größen an zahlreichen Beispielen erläutern. Außerdem werden wir uns mit der MonteCarlo Methode zur näherungsweisen Berechnung von Integralen befassen.

16.1 Der Begriff Erwartungswert

Wir bereiten die Definition des Begriffs "Erwartungswert einer Zufallsvariablen Z" an Hand von zwei historischen

Beispielen vor:

16.1.1 Beispiel: J. BERNOULLI wurde einmal mit der folgenden Frage befasst: Bei einem Glücksspiel kann

ein Spieler mit der Wahrscheinlichkeit p1 den Betrag z1 , mit der Wahrscheinlichkeit p2 den Betrag z2 , …

und mit der Wahrscheinlichkeit pn den Betrag zn gewinnen. Wie groß ist der zu erwartende (also der

durchschnittliche) Gewinn für diesen Spieler?

ô

Lösung: BERNOULLI argumentierte folgendermaßen: Angenommen es werden N Runden gespielt, wobei N sehr

groß ist. Dann wird der Spieler in etwa N pi Runden den Betrag zi gewinnen. Sein Gesamtgewinn wird somit

N p1 z1 + N p2 z2 + … + N pn zn = N Hz1 p1 + z2 p2 + … + zn pn L

betragen. Er wird also je Runde einen durchschnittlichen Gewinn von

z1 p1 + z2 p2 + … + zn pn

erzielen. Beispielsweise gilt: Wird mit einem Würfel gewürfelt und werden an einen Spieler so viele Euro ausbezahlt, wie die geworfene Augenzahl angibt, so erhält dieser Spieler wegen

1

1

1

1

1

1

1

+ 2 + 3 + 4 + 5 + 6 = 3.5

6

6

6

6

6

6

je Runde im Mittel 3.5 Euro.

Es würde nun naheliegen, den Erwartungswert @ZD einer diskreten Zufallsvariablen Z mit Träger Z und

Verteilungsdichte Z einfach durch

16_Erwartungswert_und_Varianz.nb

68

@ZD = ⁄ z @8Z = z<D = ⁄ z Z @zD

zœZ

zœZ

zu definieren. Dieser einfachen Begriffsbildung steht aber das folgende Paradoxon entgegen:

16.1.2 Beispiel (Petersburger Paradoxon): Mit einer Münze wird so lange gewürfelt, bis das erste Mal das

Ereignis "Zahl" erscheint. Tritt dieses Ereignis beim n-ten Wurf auf, so bekommt der Spieler 2n Euro

ausbezahlt. Welchen Betrag muss dieser Spieler einsetzen, damit das Spiel "fair" ist, er also genau jenen

Betrag einsetzt, den er im Mittel ausbezahlt bekommt?

ô

Lösung: Wir bezeichnen mit Z den Betrag, den der Spieler ausbezahlt bekommt. Die Zufallsvariable Z ist diskret

und besitzt den Träger Z = 82, 4, 8, …<, wobei für alle z = 2n œ Z offenbar

Z @zD = @8Z = z<D = @8Z = 2n <D = 2-n

gilt. Verwendet man nun die oben vorgeschlagene Formel für den Erwartungswert von Z, so ergibt sich

@ZD = ⁄ z @8Z = z<D = ⁄ 2n @8Z = 2n <D = ⁄ 2n 2-n = 1 + 1 + 1 + … = ¶

zœZ

nœ

nœ

Damit dieses Spiel im obigen Sinn "fair" ist, müsste unser Spieler somit vor dem Spiel unendlich viel Geld einsetzen, um dann wegen

@8Z < ¶<D = ⁄ @8Z = z<D = ⁄ @8Z = 2n <D = ⁄ 2-n = 1

zœZ

nœ

nœ

mit Sicherheit nur endlich viel Geld ausbezahlt zu bekommen. Von "fair" kann somit bei bestem Willen nicht

gesprochen werden.

Es gab viele Versuche, dieses Paradoxon aufzulösen, bis die Mathematik erkannte, dass man in solchen Situationen

den Erwartungswert einfach nicht definieren kann.

16.1.3 Definition: Ist Z eine diskrete bzw stetige Zufallsvariable mit der Verteilungsdichte Z und konvergiert

¶

die Summe ⁄zœ †z§ Z @zD bzw das Integral Ÿ-¶ †z§ Z @zD „ z (man spricht in diesem Zusammenhang von einer

Z

integrierbaren Zufallsvariablen), so nennt man die Summe

@ZD = ⁄zœ z @8Z = z<D = ⁄zœ z Z @zD

Z

Z

bzw das Integral

@ZD = Ÿ-¶ z @8Z œ @z, z + „ zD<D = Ÿ-¶ z Z @zD „ z

¶

¶

den Erwartungswert der Zufallsvariablen Z. Der Erwartungswert @ZD entspricht somit dem mittleren Wert der

Zufallsvariablen Z, also jenem Wert, um den die Zufallsvariable Z schwankt. Für nicht integrierbare Zufallsvariable wird kein Erwartungswert definiert. (Man beachte, dass der Erwartungswert @ZD einer Zufallsvariablen Z

nur von der Verteilung Z und nicht von der konkreten Abbildungsvorschrift Z : W Ø abhängt. Wir werden

daher auch vom Erwartungswert einer Verteilung reden.)

ô

Ist Z eine beliebige Zufallsvariable mit der Verteilungsfunktion Z und konvergiert das Integral Ÿ-¶ †z§ Z @„ zD, so

definiert man ganz allgemein

¶

@ZD = Ÿ-¶ z Z @„ zD

¶

wobei die dabei auftretenden Integrale als Lebesque-Stieltjes-Integrale zu verstehen sind.

Wir fassen die wichtigsten Eigenschaften des Erwartungswerts einer Zufallsvariablen in einem Satz zusammen:

16_Erwartungswert_und_Varianz.nb

69

16.1.4 Satz: Sind X, Y und Z beliebige Zufallsvariable, so gilt

Linearität: Sind X und Y integrierbar und sind a, b œ , so ist auch a X + b Y integrierbar und es gilt

@a X + b Y D = a @X D + b @Y D

Monotonie: Sind X und Y integrierbar und ist X § Y , so gilt

@X D § @YD

Hintereinanderausführung: Ist g : Ø eine Abbildung und ist g ëZ integrierbar, so gilt

@g ëZD = ⁄zœ g@zD Z @zD

Z

bzw

@g ë ZD = Ÿ-¶ g@zD Z @zD „ z

¶

ô

Beweis: Wir beweisen exemplarisch die letzte Aussage für den Fall, dass Z eine diskrete Zufallsvariablen ist: Die

Zufallsvariable Y = g ëZ nimmt den Wert y œ Y mit der Wahrscheinlichkeit

@8Y = y<D = @8g ëZ = y<D =

⁄ @8Z = z<D

zœZ

g@zD=y

an. Damit gilt

@g ëZD = @Y D = ⁄ y @8Y = y<D = ⁄ y

yœY

yœY

⁄ @8Z = z<D =

zœZ

g@zD=y

= ⁄ g@zD @8Z = z<D = ⁄ g@zD Z @zD

zœZ

zœZ

Bei der Berechnung des Erwartungswerts @ZD einer Zufallsvariablen Z mit gemischter Verteilung beachte man

16.1.5 Bemerkung: Jede Zufallsvariable Z mit gemischter Verteilung lässt sich in der Form

Z = a X + H1 - aL Y

darstellen, wobei X eine diskrete Zufallsvariable ist, welche den diskreten Anteil von Z beschreibt, Y eine

stetige Zufallsvariable ist, welche den stetigen Anteil von Z beschreibt und a die Summe der Sprunghöhen der

Verteilungsfunktion Z bezeichnet. Für den Erwartungswert @ZD gilt damit

@ZD = a @X D + H1 - aL @Y D

Wir erläutern die Berechnung des Erwartungswerts @ZD einer gemischten Zufallsvariablen Z an einem einfachen

Beispiel:

16.1.6 Beispiel: Die Zufallsvariable Z besitzt die Verteilungsfunktion

0

für z < 1

z ê2 - 1 ê3

für 1 § z < 2

Z @zD =

5 ê6

für 2 § z < 3

1

für z ¥ 3

Gesucht ist der Erwartungswert @ZD.

ô

Lösung: An Hand der Zeichnung

16_Erwartungswert_und_Varianz.nb

70

1.0

0.8

0.6

0.4

0.2

-1

1

2

3

4

erkennt man, dass es sich bei der Verteilung Z der Zufallsvariablen Z offenbar um die Mischung einer diskreten

Gleichverteilung auf der Menge 81, 2, 3< und einer stetigen Gleichverteilung auf dem Intervall @1, 2D handelt. Die

Zufallsvariable Z lässt sich daher in der Form

Z = a X + H1 - aL Y

darstellen, wobei X eine diskrete, auf der Menge 81, 2, 3< gleichverteilte Zufallsvariable ist, Y eine stetige, auf dem

Intervall @1, 2D gleichverteilte Zufallsvariable ist und für den Mischungsfaktor a = 1 ê2 gilt. Wegen

1

1

1

@X D = ⁄xœ x X @xD = 1 + 2 + 3 = 2

X

3

3

3

und

3

2

¶

@Y D = Ÿ-¶ y Y @yD „ y = Ÿ y „ y =

1

2

gilt damit

@ZD = a @X D + H1 - aL @Y D =

1

3

7

H2 + L =

2

2

4

16_Erwartungswert_und_Varianz.nb

71

16.2 Varianz und Streuung

Wie bereits erwähnt, kann man den Erwartungswert @ZD einer Zufallsvariablen Z als jenen für sie charakteristischen Wert auffassen, um den diese Zufallsvariable schwankt. Über die Größe dieser Schwankung gibt der

Erwartungswert jedoch keinerlei Auskunft. Wie wollen uns nun mit zwei Maßzahlen befassen, welche die Größe

dieser Schwankung beschreiben.

16.2.1 Definition: Ist Z eine quadratisch integrierbare Zufallsvariable (darunter versteht man eine Zufallsvariable, deren Quadrat integrierbar ist), so nennt man die positive Zahl

@ZD = @HZ - @ZDL2 D

die Varianz der Zufallsvariablen Z. Die Varianz @ZD gibt die mittlere quadratische Abweichung der

Zufallsvariablen Z von ihrem Erwartungswert @ZD an und ist damit eine Maßzahl für die Schwankung der

Zufallsvariablen Z. Die Wurzel @ZD = @ZD der Varianz nennt man die Streuung (Standardabweichung) der

Zufallsvariablen Z. (Man beachte, dass die Varianz @ZD einer Zufallsvariablen Z nur von der Verteilung Z

und nicht von der konkreten Abbildungsvorschrift Z : W Ø abhängt. Wir werden daher auch von der Varianz

einer Verteilung reden.)

Wir fassen die wichtigsten Eigenschaften der Varianz einer Zufallsvariablen wieder in einem Satz zusammen:

16.2.2 Satz: Die Zufallsvariable Z sei quadratisch integrierbar.

a) Es gilt die für praktische Berechnungen oft sehr bequeme Formel

@ZD = @Z 2 D - @ZD2

b) Für alle a, b œ ist auch a Z + b quadratisch integrierbar und es gilt

@a Z + bD = a2 @ZD

c) Ungleichung von Tschebyscheff: Für alle ¶ > 0 gilt

@ZD

@8 Z - @ZD > ¶<D §

¶2

ô

Beweis: a) Wegen der Linearität des Erwartungswerts gilt

@ZD = @HZ - @ZDL2 D = @Z 2 - 2 Z @ZD + @ZD2 D = @Z 2 D - 2 @ZD @ZD + @ZD2 = @Z 2 D - @ZD2

b) Ebenfalls wegen der Linearität des Erwartungswerts gilt

@a Z + bD = @HHa Z + bL - @a Z + bDL2 D = @ Ha Z - @a ZDL2 D = a2 @HZ - @ZDL2 D = a2 @ZD

c) Für alle ¶ > 0 gilt (mit 1 A bezeichnen wir die Indikatorfunktion der Menge A) wegen Satz 16.1.4

@ZD = @HZ - @ZDL2 D ¥ @HZ - @ZDL2 18 Z-@ZD >¶< D ¥ @¶2 18 Z-@ZD >¶< D = ¶2 @8 Z - @ZD > ¶<D

16.3 Erwartungswert und Varianz in Mathematica

Die Berechnung der Erwartungswerte @ZD und @g ëZD sowie der Varianz @ZD und der Streuung @ZD einer

Zufallsvariablen Z läuft auf die Berechnung von Summen bzw Integralen hinaus und lässt sich unter Verwendung

der entsprechenden Formeln mit Mathematica leicht bewerkstelligen. Besitzt die Zufallsvariable Z eine in Mathematica implementierte Verteilung Z , so lassen sich diese Werte @ZD, @g ëZD, @ZD und @ZD einfach unter Verwendung der Befehle Mean, ExpectedValue, Variance und StandardDeviation aufrufen (um "schöne" Formeln zu

erhalten, vereinfache man gegebenenfalls die Ergebnisse mit Hilfe von FullSimplify unter Verwendung der Bedingungen über die jeweiligen Parameter):

16_Erwartungswert_und_Varianz.nb

72

à Mean@distributionD

berechnet den Erwartungswert @ZD einer Zufallsvariablen Z mit der Verteilung distribution.

à ExpectedValue@g@zD, distribution, zD

berechnet den Erwartungswert @g ëZD der Zufallsvariablen g ëZ, wobei die Zufallsvariable Z die Verteilung

distribution besitzt.

à Variance@distributionD

berechnet die Varianz @ZD einer Zufallsvariablen Z mit der Verteilung distribution.

à StandardDeviation@distributionD

berechnet die Streuung @ZD einer Zufallsvariablen Z mit der Verteilung distribution.

Wir wollen nun den Erwartungswert und die Varianz der wichtigsten in Mathematica implementierten Verteilungen

ermitteln:

16.3.1 Beispiel: Man ermittle den Erwartungswert und die Varianz der diskreten Gleichverteilung @8m, n<D

mit den Parametern m < n œ .

ô

16.3.2 Beispiel: Man ermittle den Erwartungswert und die Varianz der Binomialverteilung @n, pD mit den

Parametern n œ und 0 § p § 1.

ô

16.3.3 Beispiel: Man ermittle den Erwartungswert und die Varianz der negativen Binomialverteilung @n, pD

mit den Parametern n œ und 0 § p § 1.

ô

16.3.4 Beispiel: Man ermittle den Erwartungswert und die Varianz der Poissonverteilung @lD mit dem

Parameter l > 0.

ô

16.3.5 Beispiel: Man ermittle den Erwartungswert und die Varianz der Gleichverteilung @8a, b<D auf dem

Intervall @a, bD.

ô

16.3.6 Beispiel: Man ermittle den Erwartungswert und die Varianz der Dreiecksverteilung @8a, b<D auf dem

Intervall @a, bD.

ô

16.3.7 Beispiel: Man ermittle den Erwartungswert und die Varianz der Exponentialverteilung @lD mit dem

Parameter l > 0.

ô

16.3.8 Beispiel: Man ermittle den Erwartungswert und die Varianz der Gammaverteilung amma@a, lD mit

den Parametern a > 0 und l > 0.

ô

16_Erwartungswert_und_Varianz.nb

16.3.9 Beispiel: Man ermittle den Erwartungswert und die Varianz der Laplaceverteilung @a, lD mit den

Parametern a œ und l > 0.

ô

16.3.10 Beispiel: Man ermittle den Erwartungswert und die Varianz der Betaverteilung eta@a, bD mit den

Parametern a > 0 und b > 0.

ô

16.3.11 Beispiel: Man ermittle den Erwartungswert und die Varianz der Normalverteilung @m, sD mit den

Parametern m œ und s > 0.

ô

16.3.12 Beispiel: Man ermittle den Erwartungswert und die Varianz der logarithmischen Normalverteilung

@m, sD mit den Parametern m œ und s > 0.

ô

16.3.13 Beispiel: Man ermittle den Erwartungswert und die Varianz der Chi-Quadrat Verteilung hi@nD mit

dem Parameter n œ .

ô

16.3.14 Beispiel: Man ermittle den Erwartungswert und die Varianz der Student T Verteilung @nD mit dem

Parameter n œ .

ô

16.3.15 Beispiel: Man ermittle den Erwartungswert und die Varianz der Fisher F Verteilung @m, nD mit den

Parametern m, n œ .

ô

16.3.16 Beispiel: Man ermittle den Erwartungswert und die Varianz der Weibullverteilung @a, bD mit den

Parametern a > 0 und b > 0.

ô

16.3.17 Beispiel: Man ermittle den Erwartungswert und die Varianz der Extremwertverteilung xtrem@m, bD

mit den Parametern m œ und b > 0.

ô

16.3.18 Beispiel: Man ermittle den Erwartungswert und die Varianz der Rayleighverteilung @sD mit dem

Parameter s > 0.

ô

16.4 Beispiele zum Erwartungswert und zur Varianz

An Hand von Beispielen werden wir nun zeigen, wie sich der Erwartungswert @ZD und die Varianz @ZD sowohl

von diskreten als auch von stetigen Zufallsvariablen Z ermitteln lässt. Dabei werden wir uns zuerst mit der Berech-

73

16_Erwartungswert_und_Varianz.nb

74

von diskreten als auch von stetigen Zufallsvariablen Z ermitteln lässt. Dabei werden wir uns zuerst mit der Berechnung des Erwartungswerts und der Varianz von Zufallsvariablen befassen, deren Verteilungsdichte bereits im

Kapitel 13 (es handelt sich dabei um die Beispiele 16.4.1 bis 16.4.5) bzw im Kapitel 14 (es handelt sich dabei um

die Beispiele 16.4.6 bis 16.4.9) ermittelt wurde. Anschließend befassen wir uns mit Tricks, welche oft bei der

Berechnung des Erwartungswerts bzw der Varianz einer Zufallsvariablen Z zum Einsatz gelangen.

16.4.1 Beispiel: In Urne I befinden sich 3 rote und 7 schwarze Kugeln. In Urne II befindet sich 7 rote und 3

schwarze Kugeln. Aus diesen Urnen wird nun obwechselnd (beginnend mit Urne I) so lange jeweils eine

Kugel gezogen, bis erstmals eine rote Kugel gezogen wird. Beobachtet wird die Anzahl X (bzw Y) der dabei

aus der ersten (bzw zweiten) Urne gezogenen Kugeln. Man berechne den Erwartungswerte @X D und @Y D

von X und Y für den Fall,

a) dass die Kugeln jeweils zurück gelegt werden,

b) dass die Kugeln nicht zurück gelegt werden.

ô

Lösung: In Beispiel 13.3.2 haben wir die Verteilungsdichte X bzw Y der diskreten Zufallsvariablen X bzw Y

bereits ermittelt und in Mathematica eingegeben:

Im Fall a)

pa@n_, k_D := k ê n; pb@n_, k_D := Hn - kL ê n;

f@x_, n_, k_D := 0 ê; Or@x < 1, NumberQ@xD && Not@IntegerQ@xDDD

f@x_, n_, k_D := HH1 - pa@n, kDL H1 - pb@n, kDLLx-1 Hpa@n, kD + pb@n, kD - pa@n, kD pb@n, kDL;

g@y_, n_, k_D := 0 ê; Or@NumberQ@yD && Not@IntegerQ@yDDD

g@y_, n_, k_D := H1 - pa@n, kDLy H1 - pb@n, kDLy-1 Hpa@n, kD + pb@n, kD - pa@n, kD pb@n, kDL;

g@0, n_, k_D := pa@n, kD;

Für den Erwartungswert @ZD ergibt sich damit (die Verteilung der Zufallsvariablen Z ist nicht in Mathematica

implementiert; wir können den Erwartungswert daher nicht mit dem Befehl Mean berechnen) nach Vereinfachung

mit FullSimplify

erw1 = FullSimplify@Sum@x f@x, n, kD, 8x, 1, •<D, k > 0D

erw2 = FullSimplify@Sum@y g@y, n, kD, 8y, 0, •<D, k > 0D

n2

k2 − k n + n2

n H−k + nL

k2 − k n + n2

Im Fall b)

pa@j_, n_, k_D := k ê Hn + 1 - jL;

pb@j_, n_, k_D := Hn - kL ê Hn + 1 - jL;

f@x_, n_, k_D := 0 ê; Or@x > n, NumberQ@xD && Not@IntegerQ@xDDD

f@x_, n_, k_D := Product@H1 - pa@i, n, kDL H1 - pb@i, n, kDL, 8i, 1, x - 1<D *

Hpa@x, n, kD + pb@x, n, kD - pa@x, n, kD pb@x, n, kDL;

g@y_, n_, k_D := 0 ê; Or@y > n - 1, NumberQ@yD && Not@IntegerQ@yDDD

g@y_, n_, k_D := Product@H1 - pa@i, n, kDL H1 - pb@i, n, kDL, 8i, 1, y - 1<D * H1 - pa@y, n, kDL *

Hpa@y + 1, n, kD + pb@y, n, kD - pa@y + 1, n, kD pb@y, n, kDL;

g@0, n_, k_D = pa@1, n, kD;

16_Erwartungswert_und_Varianz.nb

erw1 = FullSimplify@Sum@x f@x, n, kD, 8x, 1, 4<D, k > 0D

erw2 = FullSimplify@Sum@y g@y, n, kD, 8y, 0, 4<D, k > 0D

1

H−3 + nL2 H−2 + nL2 H−1 + nL2 n2

I−4 k8 + 16 k7 n + H−3 + nL2 H−2 + nL2 H−1 + nL2 n2 + k5 n H−141 + n H54 + 19 nLL +

k6 H47 − n H18 + 25 nLL + k H−3 + nL H−2 + nL H−1 + nL n H6 + n H18 + H−7 + nL nLL +

k2 H36 + n H42 + n H−319 + 5 H52 − 11 nL nLLL −

k3 n H−230 + n H150 + n H79 + H−44 + nL nLLL + k4 H−115 + n H75 + n H157 − n H67 + 6 nLLLLM

IHk − nL

I4 k8 − 16 k7 H−1 + nL − H−4 + nL H−3 + nL2 H−2 + nL2 H−1 + nL2 n + k5 I−188 + 207 n − 19 n3 M +

k6 H−44 + n H−31 + 25 nLL − k H−4 + nL H−3 + nL H−2 + nL H−1 + nL H6 + n H18 + H−7 + nL nLL +

k3 H−1 + nL H−460 + n H19 + n H177 + H−45 + nL nLLL +

k4 I64 + n I357 + n I−317 + 44 n + 6 n2 MMM +

k2 H120 + n H−890 + n H980 + n H−357 + n H38 + nLLLLLMM ë

IH−4 + nL H−3 + nL2 H−2 + nL2 H−1 + nL2 n2 M

16.4.2 Beispiel: Unser Zufallsexperiment besteht im Werfen von zwei homogenen Würfeln. Mit der

Zufallsvariablen Z wird die dabei auftretenden Augensumme bezeichnet. Man berechne den Erwartungswerte

@ZD von Z.

ô

Lösung: In Beispiel 13.3.3 haben wir die Verteilungsdichte Z der Rückkehrzeit Z bereits ermittelt und Mathematica-gerecht eingegeben:

fd1@z_D := 0 ê; Or@z < 2, z > 12, NumberQ@zD && Not@IntegerQ@zDDD

fd1@z_D := Hz - 1L ê 6 ^ 2 ê; 2 £ z £ 7

fd1@z_D := H13 - zL ê 6 ^ 2 ê; 8 £ z £ 12

Wegen

Sum@z fd1@zD, 8z, 2, 12<D

7

ist

@ZD = 7

16.4.3 Beispiel: Es werden so lange Kugeln auf n Urnen verteilt, bis in einer Urne 2 Kugeln sind, wobei jede

Kugel mit derselben Wahrscheinlichkeit in jede Urne kommen kann. Mit der Zufallsvariablen Z wird die

Anzahl der Kugeln bezeichnet. Man berechne den Erwartungswerte @ZD von Z.

ô

Lösung: In Beispiel 13.3.4 haben wir die Verteilungsdichte Z von Z bereits ermittelt und Mathematica-gerecht

eingegen:

fd@z_, n_D := Hz - 1L ê n ^ z n ! ê Hn - z + 1L !

Wegen

75

16_Erwartungswert_und_Varianz.nb

76

Sum@z fd@z, nD, 8z, 2, n + 1<D

n+1 zHz - 1L

@ZD = ‚

z=2

nz

n!

Hn - z + 1L !

16.4.4 Beispiel: Durch einen Kanal werden n unabhängige Kodeworte übertragen. Die Wahrscheinlichkeit

dafür, dass das Kodewort richtig empfangen wird, ist 0.9. Mit der Zufallsvariablen Z wird die Anzahl der

Kodeworten, die richtig empfangen wurden, bezeichnet. Man analysiere die Verteilungsdichte Z von Z.

ô

Lösung: In Beispiel 13.3.5 haben wir die Verteilungsdichte Z von Z bereits ermittelt und Mathematica-gerecht

eingegen:

fd1@z_, n_, p_D := 0 ê; Or@z < 1, z > n, NumberQ@zD && Not@IntegerQ@zDDD

fd1@z_, n_, p_D := Binomial@n, zD p ^ z H1 - pL ^ Hn - zL

Wegen

Sum@z fd1@z, n, pD, 8z, 1, n<D

np

In manchen Fällen ist es schwierig, die Verteilungsdichte Z einer diskreten Zufallsvariablen Z zu berechnen. In

diesen Fällen bietet sich an, diese Verteilungsdichte unter Verwendung des Befehls DiscreteEmpiricalPDF durch

Simulation bzw computerunterstütztes Abzählen (näherungsweise) zu ermitteln. Wir demonstrieren diese Vorgangsweise an den folgenden zwei Beispielen:

16.4.5 Beispiel: Aus einer Urne mit s = 8 schwarzen, r = 6 roten und g = 4 grünen Kugeln werden so lange

Kugeln gezogen und nach jedem Zug wieder zurückgelegt, bis erstmals hintereinander zwei gleich gefärbte

Kugeln gezogen werden. Man ermittle den Erwartungswert @ZD sowie die Varianz @ZD der Anzahl Z der

dazu erforderlichen Züge.

ô

Lösung: In Beispiel 13.3.6 haben wir die Verteilungsdichte Z der Anzahl Z der erforderlichen Züge durch

Simulation bereits näherungsweise bestimmt. Dazu haben wir zuerst das Datenmaterial daten

s = 8; r = 6; g = 4; n = 104 ;

farbe@s_, r_, g_D := Which@x = RandomInteger@81, s + r + g<D; x £ s, schwarz, x £ s + r, rot, x > s + r, grünD

daten = Table@For@zug = Table@farbe@s, r, gD, 82<D, zugP-1T =!= zugP-2T, zug = Append@zug, farbe@s, r, gDDD;

Length@zugD, 8n<D;

erzeugt und darauf den Befehl DiscreteEmpiricalPDF angewendet:

fd4@z_D := DiscreteEmpiricalPDF@daten, zD

Damit gilt für den gesuchten Erwartungswert bzw die gesuchte Varianz näherungsweise

16_Erwartungswert_und_Varianz.nb

Sum@z fd4@zD, 8z, 1, Max@datenD<D

Sum@z2 fd4@zD, 8z, 1, Max@datenD<D - HSum@z fd4@zD, 8z, 1, Max@datenD<DL2

3.8829

5.62279

Clear@s, r, g, n, x, zug, farbe, daten, fd4D

16.4.6 Beispiel: Aus dem Intervall @0, 1D werden zufällig n Zahlen ausgewählt und ihr Minimum Z

beobachtet. Gesucht ist der Erwartungswert @ZD und die Varianz @ZD der Zufallsvariablen Z.

ô

Lösung: In Beispiel 14.3.2 haben wir die Verteilungsdichte Z der stetigen Zufallsvariablen Z bereits ermittelt und

Mathematica-gerecht eingegeben

fs1@z_, n_D := Piecewise@88n H1 - zLn-1 , 0 £ z £ 1<<D

Für den Erwartungswert @ZD bzw die Varianz @ZD ergibt sich damit nach Vereinfachung mit FullSimplify

FullSimplify@Integrate@z fs1@z, nD, 8z, 0, 1<D, n > 0D

FullSimplify@HIntegrate@z2 fs1@z, nD, 8z, 0, 1<D - Integrate@z fs1@z, nD, 8z, 0, 1<DL2 , n > 0D

1

1+n

n2

I2 + 3 n + n2 M2

77

16_Erwartungswert_und_Varianz.nb

78

16.4.7 Beispiel: Ein Punkt wird zufällig in den ersten Quadrant des Einheitskreises geworfen und seine xKoordinate X bestimmt. Gesucht ist der Erwartungswert @X D und die Varianz @X D der Zufallsvariablen X.

ô

Lösung: In Beispiel 14.3.3 haben wir die Verteilungsdichte X der stetigen Zufallsvariablen X bereits ermittelt und

Mathematica-gerecht eingegeben:

fs2@z_D := Piecewise@884 Sqrt@1 - z2 D ê p, 0 £ z £ 1<<D

Für den Erwartungswert @X D bzw die Varianz @X D ergibt sich damit

Integrate@z fs2@zD, 8z, 0, 1<D

Integrate@z2 fs2@zD, 8z, 0, 1<D - HIntegrate@z fs2@zD, 8z, 0, 1<DL2

4

3π

1

16

−

9 π2

4

16.4.8 Beispiel: Auf der unteren und der linken Seitenkante eines Quadrats der Seitenlänge 1 werden

willkürlich zwei Punkte P und Q ausgewählt. Gesucht ist der Erwartungswert @ZD sowie die Varianz @ZD

ihres Abstandes Z.

ô

Lösung: In Beispiel 14.3.4 haben wir die Verteilungsdichte Z der stetigen Zufallsvariablen Z bereits ermittelt und

Mathematica-gerecht eingegeben:

fs3@z_D := Piecewise@88z p ê 2, 0 £ z £ 1<, 8z p ê 2 - 2 z ArcTan@Sqrt@z2 - 1DD, 1 £ z £ Sqrt@2D<<D

Für den gesuchten Erwartungswert @ZD und die gesuchte Varianz @ZD ergibt sich damit

Integrate@z fs3@zD, 8z, 0, Sqrt@2D<D

Integrate@z2 fs3@zD, 8z, 0, Sqrt@2D<D - HIntegrate@z fs3@zD, 8z, 0, Sqrt@2D<DL2

1

3

J 2 + ArcSinh@1DN

2

1

−

3

9

2

J 2 + ArcSinh@1DN

16.4.9 Beispiel: n Punkte werden zufällig in den Einheitskreis geworfen und der Abstand Z vom Mittelpunkt

des Einheitskreises zum nächst gelegenen dieser n Punkte beobachtet. Gesucht ist der Erwartungswert @ZD

und die Varianz @ZD von Z.

ô

Lösung: In Beispiel 14.3.5 haben wir die Verteilungsdichte Z der stetigen Zufallsvariablen Z bereits ermittelt und

Mathematica-gerecht eingegeben:

fs4@z_, n_D := Piecewise@882 n z H1 - z2 Ln-1 , 0 £ z £ 1<<D

16_Erwartungswert_und_Varianz.nb

79

Für den Erwartungswert @ZD und die Varianz @ZD liefert Mathematica damit

FullSimplify@Integrate@z fs4@z, nD, 8z, 0, 1<D, 8n > 0, n ΠIntegers<D

FullSimplify@Integrate@z2 fs4@z, nD, 8z, 0, 1<D - HIntegrate@z fs4@z, nD, 8z, 0, 1<DL2 , 8n > 0, n ΠIntegers<D

−

1

H−1Ln n GammaB− − nF Gamma@nD

2

2

1

−

π

2

1

Hn !L2 GammaB− − nF

2

1+n

4π

Berücksichtigt man nun, dass Mathematica für alle n œ die Abkürzung

G@-Hn - 1 ê2LD =

H-1Ln p

Hn - 1 ê 2L G@n - 1 ê 2D

verwendet, so ergibt sich schließlich

@ZD =

p G@n + 1D

2 G@n + 3 ê2D

und @ZD =

1

n+1

-

p HG@n + 1DL2

4 GH@n + 3 ê 2DL2

Lässt sich die Zufallsvariable Z in der Form Z = g@Y D darstellen, wobei die Verteilung der Zufallsvariablen Y

bekannt ist, so ist die Berechnung des Erwartungswerts @ZD und der Varianz @ZD oft einfach.

16.4.10 Beispiel: Ein Punkt P sei auf der Oberfläche der Einheitskugel gleichverteilt. q sei der Winkel

zwischen den Vektor 0 P und der z-Achse. Man analysiere die Verteilungsdichte q

Verteilungsfunktion q von q. Man berechne den Erwartungswert [cos2 q].

ô

Lösung:

W = 9Hx, y, zL œ 3 : x2 + y2 + z2 = 1=

A={Bœ3 : B Œ W}

und die

16_Erwartungswert_und_Varianz.nb

80

B={(x, y, z)œW: q<j=Arctg

x2 + y2 } ï

z

für j § 0

0

2 pRH1-CosjL 1-Cos j

=

für 0<j§p

2

4 pR2

Fläche von B

q HjL=[{q<j}]= Fläche von W =

für j > p

1

1

2 Sin j für 0 < j § p

0

sonst

ï q HjL =

Bestimmen wir den Erwartungswert [{Cos2 q}]. Damit folgt aus Satz 16.1.4 :

¶ Cos2 j HjL „ j= 1 p Cos2 jSin j „ j= 1 .

[{Cos2 q}]=Ÿ-¶

q

2Ÿ0

3

Für eine gleichverteilte Zufallsvariable Z

2

1 z2 „ z= ∫[{Cos2 j}], aber

[{Z 2 }]=Ÿ-1

3

[{Cos q}]= [{Z}] =0.

16.4.11 Beispiel: Der Durchmesser X eines Kreises sei im Intervall [a,b] gleich verteilt. Man ermittle den

Erwartungswert und die Varianz der Fläche dieses Kreises.

ô

Lösung:

S - die Fläche des Kreises; Damit folgt aus Satz 16.1.4

@SD = B

pX2

4

F=

p

4

AX 2 E;

X- gleichverteilte Zufallsvariable ï

1

X HxL = : b-a

AX 2 E = Ÿab x2

für a § x § b

0 sonst

1

b-a

„x=

b3 -a3

3 Hb-aL

p 2

p 2

4

4

ï [S]=

pIa2 +ab+b2 M

12

.

5 5

3 32

p 2 9 Ib -a M Hb-aL-5 Ib -a M

;

4

720 Hb-aL2

@SD = K O AX 2 E = K O IAX 4 E - AX 2 E2 M = K O

2

2

2

p 2 Hb-aL I4 a +7 ab+4 b M

[S]=K O

4

720

.

3

4p

@V D = @ 4 p R D =

@R3 D

3

3

also

Simplify@H4 p ê 3L ExpectedValue@x3 , UniformDistribution@8a, b<D, xDD

1

3

Ia3 + a2 b + a b2 + b3 M π

16.4.12 Beispiel: Ein Betrieb erzeugt Kugeln, wobei der Radius dieser Kugeln produktionsbedingten

16_Erwartungswert_und_Varianz.nb

81

Ein Betrieb erzeugt Kugeln, wobei der Radius dieser Kugeln produktionsbedingten

geringfügigen Schwankungen unterliegt. Messungen ergaben, dass der Radius R einer zufällig der Produktion

entnommenen Kugel im Intervall @a, bD gleichverteilt ist. Man ermittle den Erwartungswert @V D des

Volumens V einer zufällig der Produktion entnommenen Kugel.

ô

Lösung: Zwischen dem Radius R und dem Volumen V einer Kugel besteht die Beziehung V = 4 p R3 ë 3. Damit

folgt aus Satz 16.1.4

3

4p

@V D = @ 4 p R D =

@R3 D

3

3

also

Simplify@H4 p ê 3L ExpectedValue@x3 , UniformDistribution@8a, b<D, xDD

1

3

Ia3 + a2 b + a b2 + b3 M π

16.4.13 Beispiel (Quantisierer): Die Abtastung zeitkontinuierlicher Signale und die Quantisierung

wertkontinuierlicher Signale findet praktisch in jedem A/D-Wandler statt. Der Vorgang der Quantisierung

kann durch die Addition einer gleichverteilten Zufallsvariablen modelliert werden. Bei der Quantisierung wird

zu der wahren wertkontinuierlichen Größe x ein Quantisierungsfehler in Form einer Zufallsvariablen e addiert,

um dadurch eine wertdiskrete Größe xQ zu erhalten.

ô

Lösung: Die Breite eines Quantisierungsfaches sei Q. Dann kann die Wahrscheinlichkeitsdichte des resultierenden

Fehlers e durch eine im Intervall B- ,

Q Q

2

2

F gleichverteilte Zufallsvariable E angegeben werden

E HeL

0.5

0.4

0.3

0.2

0.1

-4-0.1

E @eD =

1êQ

-2 -Qê2 0

1 êQ für e œ B- ,

Qê2

Q Q

2

0

sonst

F

2 .

2

4

e

16_Erwartungswert_und_Varianz.nb

82

xQ

xmax

6

2Q 4

Q2

-6

-4

x

-2

2

-2

-Q

-4

-2Q

4

6

-6

Q ist die Breite einer Quantisierungsstufe und ergibt sich aus der maximalen Aussteuerung ≤ xmax und der Anzahl

der mit w Bit darstellbaren Stufen,

Q=

2 xmax

2w

Mit dieser Annahme ist der Erwartungswert

@ED = 0,

d.h., im Mittel wird durch die Quantisierung das Signal nicht verfälscht. An dieser Stelle ist aber für praktische

Anwendungen der durch die Quantisierung resultierende quadratische Fehler von Interesse, der im statistischen

Sinn direkt durch die Varianz des Quantisierungsrauschens quantitativ ausgedrückt werden kann. Dabei wird die

Gleichverteilung des resultierenden Fehlers im Intervall B- ,

Q Q

2

2

F berücksichtigt. Mit diesen Voraussetzungen und

mit diesen Annahmen berechnet sich die Varianz s2E des Quantisierungsfehlers wie folgt (aus Satz 16.1.4 ):

Q

Q2

1

2

2

2

2

¶

2

sE = AE E - @ED = AE E = Ÿ-¶ u E @uD „ u = Ÿ 2Q u2 „ u =

Q

12

2

Mit dieser Berechnung und diesem wichtigen Ergebnis ist gleichzeitig die Varianz für jede gleichverteilte

Zufallsvariable mit einer Fachbreite von Q angegeben. Für viele nachrichtentechnische Anwendungen wird der

Quantisierungsfehler als ein Rauschsignal aufgefasst und aus dem Quantisierungsrauschen der Signal-zu-Rauschabstand (Signal-Rausch-Verhältnis, SNR) in logarithmischem Maßstab angegeben:

SNR = 10 log10

s2X

s2E

in [dB]

Wenn mit den wertkontinuierlichen Größen x beispielsweise ein Sinussignal

x = sinHw tL und xmax = 1

beschrieben wird, dann erhält man

2p

2p

2p

2p

1

1

2

2

2

2

2

w

2

„ u - Ÿ0 w sinHw uL

„u = - 0 = .

s X = AX E - @X D = Asin Hw TLE - @sinHw TLD = Ÿ0 sin Hw uL

w

w

2

2

Mit der obigen Analyse haben wir dann den folgenden Signal-zu-Rauschabstand:

16_Erwartungswert_und_Varianz.nb

SNR = 10 log10

83

1ê2

6

6

6 µ 2-2

= 10 log10 2 = 10 log10

= 10 log10 -2 w = 6.02 w + 1.76 dB

2

2

w

Q ë12

Q

H2ê2 L

2

10 H Log@10, 3 ê 2D + 2 w Log@10, 2DL êê N

10. H0.176091 + 0.60206 wL

Praktisch besagt diese Analyse, dass mit jedem zusätzlich bei der Quantisierung eingesetzten Bit das SNR um 6dB

vergrößert werden kann. Die durch den Quantisierungsvorgang verursachten Fehler verringern sich also mit jedem

weiteren im A/D-Wandler eingesetzten Bit.

Lässt sich die Zufallsvariable Z in der Form Z = Z1 + Z2 + … + Zn schreiben, und lassen sich die Erwartungswerte

@Zi D der einzelnen Summanden leicht berechnen, so kann man den Erwartungswert @ZD mit Hilfe von Satz 16.1.4

ermitteln, ohne dabei die Verteilungsdichte von Z berechnen zu müssen.

16.4.14 Beispiel: Aus dem Intervall @0, 1D werden zufällig n Zahlen ausgewählt. Man ermittle den

Erwartungswert @ZD ihrer Summe Z.

ô

Lösung: Natürlich könnte man den Erwartungswert @ZD dieser Summe Z in der üblichen Weise berechnen, indem

man zuerst (etwa durch Simulation wie in Beispiel 14.3.6) die Verteilungsdichte der Zufallsvariablen Z ermittelt

und anschließend den Erwartungswert von Z in der üblichen Weise berechnet.

Es geht aber auch einfacher: Bezeichnet Zi die i-te zufällig ausgewählte Zahl, so gilt Z = Z1 + Z2 + … + Zn , wobei

die Zufallsvariablen Zi im Intervall @0, 1D gleichverteilt sind. Damit gilt wegen

Mean@UniformDistribution@80, 1<DD

1

2

@ZD = @Z1 + Z2 + … + Zn D = @Z1 D + @Z2 D + … + @Zn D =

n

2

16.4.15 Beispiel: Aus einer Urne mit w weißen und s schwarzen Kugeln wird n mal mit Zurücklegen gezogen.

Man bestimme die mittlere Anzahl der dabei beobachteten Farbwechsel.

Hinweis: Berechnen Sie auf keinen Fall die Verteilungsdichte (zu schwierig) sondern definieren Sie Zk =1,

falls ein Farbwechasel zwischen k-ter und Hk + 1L-ter Kugel stattgefunden hat und Zk =0 sonst und berechnen

Sie damit den Erwartungswert.

ô

Lösung: n Züge: X1 , X2 , ..., Xn

Zk = 1 Farbwechsel zwischen k - ter und Hk + 1L - ter Kugel

sonst

0

k = 1, ..., n - 1

Z -Anzahl der Farbwechsel bei n Zügen und damit wegen Satz 16.1.4

@ZD = @Z1 + Z2 + ... + Zn-1 D = @Z1 D + @Z2 D + ... + @Zn D = HZ1 = 1L + HZ2 = 1L + ... + HZn-1 = 1L

IZk = 1M = I9Xk = w= › 9Xk+1 = s=M + I9Xk = s= › 9Xk+1 = w=M =

16_Erwartungswert_und_Varianz.nb

84

= wê Hw + sL sêHw + sL + sê Hw + sL w êHw + sL =

@ZD =

2 w sHn-1L

Hw+sL2

2ws

, k = 1, 2, ..., n - 1

Hw+sL2

16_Erwartungswert_und_Varianz.nb

85

16.4.16 Beispiel: Die Zufallsvariablen X1 , ..., Xm , Xm+1 , ..., Xm+n seien positiv, integrierbar, identisch

verteilt. Man berechne

B

X1 +...+Xm

X1 +...+Xm+n

F

Hinweis: Berechnen Sie zunächst

B

X1

F

X1 +...+Xm+n

ô

Lösung:

B

X1

X1 +...+Xm+n

F=

⁄m+n Xi -⁄m+n

i=2 Xi F = @1D - B

B i=1

X1 +...+Xm+n

1 - Hm + n - 1L B

B

X1

X1 +...+Xm+n

B

X1 +...+Xm

X1 +...+Xm+n

X2

X3

Xm+n

F - B

F - ... - B

F=

X1 +...+Xm+n

X1 +...+Xm+n

X1 +...+Xm+n

X1

Ffl

X1 +...+Xm+n

F=

1

m+n

F = B

X1

X1 +...+Xm+n

F + B

X2

X1 +...+Xm+n

F + ... + B

Xm

m

F=

X1 +...+Xm+n

m+n

16.5 Höhere Momente von Zufallsvariablen

Neben dem Erwartungswert @ZD und der Varianz @ZD gibt es weitere Maßzahlen, mit denen sich gewisse Eigenschaften der Verteilung Z einer Zufallsvariablen Z beschreiben lassen. Wir definieren in diesem Zusammenhang

16.5.1 Definition: Ist Z eine Zufallsvariable mit integrierbarer n-ter Potenz, so nennt man die Maßzahlen

@Z n D

bzw

@HZ - @ZDLn D

das n-te Moment bzw das n-te zentrale Moment der Zufallsvariablen Z. Das erste Moment entspricht dabei

dem Erwartungswert, das zweite zentrale Moment entspricht der Varianz von Z. Die Maßzahlen

@HZ - @ZDL3 D

@HZ - @ZDL4 D

bzw

@ZD3

@ZD4

nennt man Schiefe bzw Kurtosis von Z. Es handelt sich dabei um Maßzahlen, mit denen die Asymmetrie bzw

die Wölbung der Verteilungsdichte Z beschrieben werden.

Die Berechnung des n-ten Momentes, des n-ten zentralen Moments, der Schiefe und der Kurtosis einer Zufallsvariablen Z läuft auf die Berechnung von Summen bzw Integralen hinaus und lässt sich unter Verwendung der

entsprechenden Formeln mit Hilfe von Mathematica leicht bewerkstelligen. Besitzt die Zufallsvariable Z eine in

Mathematica implementierte Verteilung Z , so lassen sich die n-ten Momente sowie die n-ten zentralen Momente

einfach unter Verwendung der bereits bekannten Befehle Mean und ExpectedValue ermitteln. Die Schiefe und die

Kurtosis lassen sich mit den Befehlen Skewness und Kurtosis direkt aufrufen.

à Skewness@distributionD

berechnet die Schiefe einer Zufallsvariablen Z mit der Verteilung distribution.

16_Erwartungswert_und_Varianz.nb

86

berechnet die Schiefe einer Zufallsvariablen Z mit der Verteilung distribution.

à Kurtosis@distributionD

berechnet die Kurtosis einer Zufallsvariablen Z mit der Verteilung distribution.

An Hand der beiden folgenden Beispiele wollen wir die Bedeutung der Begriffe Schiefe und Kurtosis diskutieren:

16_Erwartungswert_und_Varianz.nb

87

16.5.2 Beispiel: Man zeichne die Verteilungsdichte der Binomialverteilung @n, pD bzw der

Weibullverteilung @a, bD für verschiedene Werte ihrer Parameter n, p bzw a, b und berechne jeweils ihre

Schiefe. Das dabei erzielte Ergebnis ist zu diskutieren.

ô

Lösung: a) Analog zu Beispiel 13.2.2 stellen wir die Verteilungsdichte der Binomialverteilung @n, pD auf dynamische Weise graphisch dar und berechnen die jeweils dazugehörige Schiefe:

Manipulate@Show@8ListPlot@Table@8z, PDF@BinomialDistribution@n, pD, zD<, 8z, -1, 41<D,

PlotStyle -> [email protected], Filling -> Axis, AspectRatio Æ 0.4, AxesOrigin Æ 8-1, 0<,

PlotRange Æ All, AxesLabel Æ 8"z", "@zD"<, ImageSize Æ 8200, 100<D,

Graphics@

88Red, Text@"Schiefe: ", [email protected], 0.9<DD,

Text@Skewness@BinomialDistribution@n, pDD, [email protected], 0.9<DD<<D<D,

8n, 1, 40, 1, Appearance Æ "Labeled"<, 8p, 0.1, 0.9, Appearance Æ "Labeled"<D

n

33

p

0.52

Wir erkennen, dass die Binomialverteilung für p < 0.5 eine positive Schiefe ("langer rechter Schwanz") und für

p > 0.5 eine negative Schiefe ("langer linker Schwanz") besitzt. Für p = 0.5 ist die Schiefe gleich 0 (die Verteilungsdichte der Binomialverteilung ist in diesem Fall symmetrisch).

b) Analog zu Beispiel 14.2.14 stellen wir die Verteilungsdichte der Weibullverteilung @a, bD auf dynamische

Weise graphisch dar und berechnen wieder die jeweils dazugehörige Schiefe:

16_Erwartungswert_und_Varianz.nb

88

Manipulate@Show@8Plot@PDF@WeibullDistribution@a, bD, zD, 8z, -1, 10<,

PlotStyle Æ [email protected], AspectRatio Æ 0.4, AxesOrigin Æ 8-1, 0<, PlotRange Æ All,

AxesLabel Æ 8"z", "@zD"<, ImageSize Æ 8350, 150<D,

Graphics@

88Red, Text@"Schiefe: ", [email protected], 0.9<DD,

Text@Skewness@WeibullDistribution@a, bDD, [email protected], 0.9<DD<<D<D,

8a, 1, 5, Appearance Æ "Labeled"<, 8 b, 1, 5, Appearance Æ "Labeled"<D

a

1.76

b

4.665

@zD

Schiefe:

0.15

0.812103

0.10

0.05

z

0

2

4

6

8

10

Wir erkennen, dass die Schiefe der Weibullverteilung vom Parameter b unabhängig ist, was auch durch

Skewness@WeibullDistribution@a, bDD

1 3

1

2

3

F − 3 GammaB1 + F GammaB1 + F + GammaB1 + F ì

α

α

α

α

1 2

2 3ê2

−GammaB1 + F + GammaB1 + F

α

α

2 GammaB1 +

bestätigt wird. Weiters erkennen wir, dass die Weibullverteilung für kleine Werte von a eine positive Schiefe

("langer rechter Schwanz") und für große Werte von a eine negative Schiefe ("langer linker Schwanz") besitzt.

Unter Verwendung von FindRoot lässt sich zeigen, dass die Weibullverteilung für a = 3.60235 die Schiefe 0 besitzt

(was aber nicht! bedeutet, dass die Weibullverteilung in diesem Fall symmetrisch ist)

FindRoot@Skewness@WeibullDistribution@a, bDD ä 0, 8a, 3<D

8α → 3.60235<

16.5.3 Beispiel: Man berechne die Wölbung der Normalverteilung @m, sD, der Gleichverteilung @8a, b<D,

und der Student T Verteilung @nD und vergleiche die Verteilungsdichten der beiden zuletzt genannten

è è

Verteilungen jeweils mit der Verteilungsdichte einer Normalverteilung @m, sD, welche den gleichen

Erwartungswert und die gleiche Varianz besitzt. Das dabei erzielte Ergebnis ist zu diskutieren.

ô

16_Erwartungswert_und_Varianz.nb

89

Lösung: a) Wir berechnen mit Hilfe von Mathematica die Wölbungen dieser drei Verteilungen

Kurtosis@NormalDistribution@m, sDD

3

Kurtosis@UniformDistribution@8a, b<DD

9

5

Kurtosis@StudentTDistribution@nDD

6

n>4

−4+n

Indeterminate True

3+

und erkennen, dass die Wölbung der Normalverteilung und der Gleichverteilung von den jeweiligen Parametern

nicht abhängt, dass die Wölbung der Student T Verteilung nur für n > 4 definiert ist und für n Ø ¶ gegen 3 konvergiert.

b) Ein graphischer Vergleich der Verteilungsdichte der Gleichverteilung mit der Verteilungsdichte einer Normalverteilung mit dem gleichen Erwartungswert und der gleichen Varianz

Manipulate@If@a < b, With@8m = Mean@UniformDistribution@8a, b<DD, s = StandardDeviation@UniformDistribution@8a,

Plot@8PDF@UniformDistribution@8a, b<D, zD, PDF@NormalDistribution@m, sD, zD<, 8z, -3, 4<,

PlotStyle Æ [email protected], Blue<, [email protected], Red<<, AspectRatio Æ 0.4,

AxesOrigin Æ 8-3, 0<, PlotRange Æ All, AxesLabel Æ 8"z", "@zD"<, ImageSize Æ 8200, 100<DD, "a≥b"D,

8a, -2, 3, Appearance Æ "Labeled"<, 8b, -2, 3, Appearance Æ "Labeled"<D

a

-0.205

b

1.615

@zD

0.8

0.6

0.4

0.2

-2

-1

0

1

2

3

4

z

bzw ein graphischer Vergleich der Verteilungsdichte der Student T Verteilung mit der Verteilungsdichte einer

Normalverteilung mit dem gleichen Erwartungswert und der gleichen Varianz

16_Erwartungswert_und_Varianz.nb

90

Manipulate@With@8m = Mean@StudentTDistribution@nDD, s = StandardDeviation@StudentTDistribution@nDD<,

Plot@8PDF@StudentTDistribution@nD, zD, PDF@NormalDistribution@m, sD, zD<, 8z, -5, 5<,

PlotStyle Æ [email protected], Blue<, [email protected], Red<<, AspectRatio Æ 0.4,

AxesOrigin Æ 8-3, 0<, PlotRange Æ All, AxesLabel Æ 8"z", "@zD"<, ImageSize Æ 8200, 100<DD,

8n, 3, 20, 1, Appearance Æ "Labeled"<D

n

3

@zD

0.3

0.2

0.1

-4

-2

0

2

4

z

zeigen, dass die Wölbung in gewissem Sinn eine Maßzahl für die "Krümmung der Verteilungsdichte" darstellt. Die

Verteilungsdichte der Gleichverteilung ist offenbar "schwächer gekrümmt" als die Verteilungsdichte der Normalverteilung; ihre Wölbung ist mit 9/5 tatsächlich deutlich kleiner als 3. Die Verteilungsdichte der Student T

Verteilung ist hingegen "stärker gekrümmt" als die Verteilungsdichte der Normalverteilung; ihre Wölbung ist für

kleine n ja größer als 3.