II.3.1 Theoretische Linguistik _Bosch__AS

Werbung

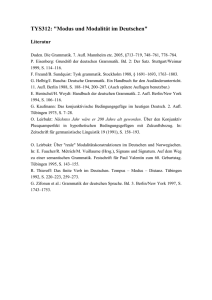

II. Teildisziplinen der Kognitionswissenschaft 3. Linguistik 1. Theoretische Linguistik Peter Bosch: Theoretische Linguistik. to app. in: Achim Stephan & Sven Walter (Hrsg.) Handbuch der Kognitionswissenschaft. J.B.Metzler Eine wissenschaftliche Disziplin ist durch ihre Forschungsfragen und ihre Methoden bestimmt. Die zentrale Forschungsfrage der theoretischen Linguistik ergibt sich aus der Beobachtung, dass Menschen mit endlichen mentalen Ressourcen in der Lage sind, eine potenziell unendliche Vielfalt von sprachlichen Äußerungen hervorzubringen und zu verstehen: Es gilt uns als selbstverständlich, dass Menschen Sätze äußern und auch verstehen können, die sie nie zuvor gehört oder gelesen haben. Diese Fähigkeit bezieht sich nicht nur auf die Phonologie, Morphologie und Syntax, sondern auch auf die Semantik und Pragmatik sprachlicher Äußerungen, d.h. sprachliche Ausdrücke werden unter immer neuen Umständen so verwendet und verstanden, dass Kommunikation allem Anschein nach zuverlässig stattfinden kann. Für diese Beobachtung, man spricht hier von der Produktivität menschlicher Sprache, sucht die theoretische Linguistik nach Erklärungen. Diese Forschungsfrage unterscheidet die theoretische Linguistik von anderen linguistischen Teildisziplinen und macht zugleich verständlich, dass die theoretische Linguistik von Anfang an zusammen mit der Philosophie, der Psychologie und der Künstlichen Intelligenz zu den Kerndisziplinen der Kognitionswissenschaft gehört hat. Von der Methode her ist die theoretische Linguistik auf formale Theorien festgelegt, aus denen empirisch überprüfbare Vorhersagen abgeleitet werden können. Insofern steht die theoretische Linguistik nicht im Gegensatz zu, und ist auch nicht komplementär zu empirischer Linguistik. Mit dem Adjektiv ‚theoretisch‘ wird die theoretische Linguistik lediglich von der angewandten Linguistik unterschieden, deren Fragestellungen von jeweils aktuellen Anwendungsproblemen bestimmt sind, während die theoretische Linguistik sich auf Theorieentwicklung richtet. Die Forschungsfrage. Beobachtungen zur Produktivität menschlicher Sprache finden sich immer wieder in der langen Geschichte der Linguistik und der Sprachphilosophie. Bis in das frühe 20. Jh. hinein fehlten jedoch die Voraussetzungen, um dieses Problembewusstsein in wissenschaftliche Forschung zu überführen. Es standen nicht die Mittel zur Formulierung komplexer Theorien und empirisch testbarer Hypothesen zur Verfügung. Erst mit den Entwicklungen in der Grundlegung der Logik und Mathematik und der Theorie der formalen Sprachen gegen Ende des 19. und in der ersten Hälfte des 20. Jh.s, insbesondere durch Gottlob Frege, Giuseppe Peano, Betrand Russell, Rudolf Carnap, Yehoshua Bar-Hillel, Alan Turing, Claude Shannon, Warren Weaver und Stephen Kleene, begann sich ein Bild der formalen Eigenschaften von Sprachen abzuzeichnen, das die Basis für eine Theorie auch menschlicher Sprache bilden konnte. Aufbauend auf den hier entwickelten Konzepten und auf frühen formalen Ansätzen in der strukturalistischen Linguistik (insbesondere Harris 1951) entwickelte Noam Chomsky in den 1950er Jahren die Grundlagen einer generativen Grammatiktheorie, mit dem Ziel, eben jene Produktivitätseigenschaften natürlicher Sprache zu klären. Grundgedanke war die Überlegung, dass eine menschliche Sprache analog zu formalen Sprachen als die nicht endliche Menge von wohlgeformten Zeichenfolgen betrachtet werden kann, die zu der Sprache gehören. Diese Menge von Sätzen kann durch eine formale Grammatik algebraisch beschrieben werden (Chomsky 1957, 1959, 13). Eine formale Grammatik ist hier als ein 4Tupel <N,Σ,P,S> zu verstehen, wobei N eine endliche Menge nicht-terminaler Symbole ist (also z.B. syntaktische Kategoriensymbole), Σ eine endliche Menge terminaler Symbole (also z.B. Wörter), S∈N das Startsymbol (für die syntaktische Kategorie Satz) und P eine endliche Menge von Produktionsregeln (z.B. die Regel ‚S→NP VP‘, die besagt, dass ein Satz aus einer Nominalphrase gefolgt von einer Verbphrase besteht). Das Ziel der theoretischen Linguistik besteht jedoch nicht in der grammatischen Beschreibung einzelner Sprachen, sondern in einem formalen Modell menschlicher Sprache überhaupt, d.h. einer Charakterisierung der Klasse möglicher Grammatiken menschlicher Sprachen, einer Universalgrammatik. Diese Charakterisierung darf nicht so eng ausfallen, dass mögliche menschliche Sprachen ausgeschlossen werden, aber auch nicht zu weit. Das Ziel ist ja, die formalen Eigenschaften menschlicher Sprachen herauszuarbeiten, die nicht notwendigerweise von Kunstsprachen oder tierischen Kommunikationssystemen geteilt werden. Das einfachste Modell wäre hier dasjenige des endlichen Automaten. Doch das wäre eher zu restriktiv, weil endliche Automaten den Begriff einer syntaktischen Konstituente nur schlecht modellieren können. Sie erlauben nur solche Produktionsregeln, die ein nichtterminales Symbol durch ein terminales Symbol oder durch eine Sequenz aus einem terminalen und einem nicht-terminalen Symbol ersetzen. Mit dieser Beschränkung können Abhängigkeiten zwischen nicht direkt aufeinander folgenden Zeichen einer Zeichenkette nur sehr unelegant dargestellt werden. Die intuitiv einfache Idee, dass z.B. in indoeuropäischen Sprachen ein Verb mit seinem Subjekt in den Merkmalen Person und Numerus übereinstimmen muss, könnte nicht direkt ausgedrückt werden, wenn Subjekt und Verb nicht aus zwei auf einander folgenden Wörtern bestünden, sondern selbst komplexe Ausdrücke wären. Im anderen Extrem könnte man die universelle Turingmaschine als Modell wählen und würde Grammatiken zulassen, die beliebige rekursiv aufzählbare Mengen von Sätzen beschreiben können. Doch diese Charakterisierung ist offensichtlich zu liberal, denn nicht jede rekursiv aufzählbare Menge von Sätzen konstituiert eine menschliche Sprache. Nach gegenwärtiger Auffassung reduziert sich die Suche nach einer Klasse von formalen Grammatiken für natürliche Sprache damit auf Modelle, die weniger mächtig sind als die universelle Turingmaschine, aber mächtiger als endliche Automaten, also auf kontextfreie und kontextsensitive Grammatiken, wie man es unter Bezug auf die Chomsky-Hierarchie ausdrücken würde (Chomsky 1956; Hopcroft/Ullman 1979). Ausgangspunkt für jede Grammatik ist eine empirisch gegebene, also endliche, Menge von Zeichenketten. Grammatiken, die in diesem Sinn empirisch korrekt sind, gelten als beobachtungsadäquat. Sie liefern jedoch insofern nur eine schwache Charakterisierung einer Sprache, als sie die Struktur der Zeichenketten ignorieren; strukturell mehrdeutige Zeichenketten können nicht unterschieden werden, so dass eine Grammatik, die nur die korrekte Satzmenge einer Sprache generiert, aber nicht die Struktur der Sätze beschreibt, als Basis für eine semantische Beschreibung ungeeignet ist (Chomsky 1959). Wenn eine Grammatik zusätzlich jedem Satz die angemessenen Konstituentenstrukturen zuschreibt, gilt sie als beschreibungsadäquat. Methoden. In Syntactic Structures (1957) hat Chomsky eine formale Grammatik nach den oben beschriebenen Grundsätzen beispielhaft für einen Ausschnitt des Englischen entwickelt. Er bricht hierbei mit der damals induktiv und deskriptiv ausgerichteten Arbeitsweise der Linguistik und optiert für ein deduktives Vorgehen, d.h. er verschiebt den Schwerpunkt auf die Validierung von Grammatiken: „One may arrive at a grammar by intuition, guess-work, all sorts of partial methodological hints, reliance on past experience, etc. … Our ultimate aim is to provide an objective, non-intuitive way to evaluate a grammar once presented“ (1957, 56). Zwei Aspekte sind hier zu unterscheiden: (1) die Frage, ob die Grammatik einer Sprache tatsächlich die als empirisch gegeben unterstellte Menge der Sätze mit den dazu gehörigen Strukturen definiert (Beschreibungsadäquatheit), und (2) die Frage, welche der beliebig vielen Grammatiken, die diese Anforderung erfüllen, die ‚richtige‘ ist. Die Parameter einer beschreibungsadäquaten Grammatik machen nicht notwendigerweise schon die allgemeinen Eigenschaften menschlicher Sprache sichtbar. Diese werden in einer allgemeinen Grammatiktheorie, oder Universalgrammatik, formuliert. Die grammatische Beschreibung einer Einzelsprache kann erst dann als erklärungsadäquat gelten, wenn sie in den Parametern der allgemeinen Grammatiktheorie formuliert ist und damit die grammatischen Regelmäßigkeiten der Einzelsprache als eine Instanziierung allgemeiner Eigenschaften menschlicher Sprache darstellt. In der Forschungspraxis bedeutet dies, dass auch empirisch korrekte Beschreibungen für Einzelsprachen korrigiert werden müssen, wenn sich herausstellt, dass ihre Kategorien mit für andere Sprachen erforderlichen Beschreibungskategorien unvereinbar sind. Eine nahe liegende, von Chomsky intendierte, jedoch auch innerhalb der theoretischen Linguistik nicht unkontroverse Interpretation der Universalgrammatik ist, dass es sich um die Theorie eines angeborenen menschlichen Sprachvermögens handelt, d.h. einer genetisch angelegten menschlichen Fähigkeit, wie z.B. der Fähigkeit, visuelle Reize auf Objekte abzubilden, sich im Raum zu orientieren oder aufrecht auf zwei Beinen zu gehen. Ebenso wie andere angeborene Fähigkeiten, und im Gegensatz z.B. zur Arithmetik, muss Muttersprache nicht unterrichtet werden, sondern wird anhand der sprachlichen Reize in der Umgebung und aufgrund einer angeborenen Universalgrammatik erworben. Die wesentliche Argumentation für diese Auffassung zum kindlichen Spracherwerb ist der Hinweis darauf, dass die sprachlichen Reize der Umgebung allein, zumal sie oft spärlich und fehlerhaft sind, den vergleichsweise schnellen und fehlerlosen Erwerb der Muttersprache nicht erklären könnten, wenn nicht bereits der Parameter-Raum für die implizit zu erlernende Grammatik – und genau als solcher wäre die Universalgrammatik zu sehen – angeboren wäre (das sog. poverty of the stimulus argument). Aktuelle Theorien des kindlichen Spracherwerbs sind im Wesentlichen als Weiterentwicklung bzw. Kritik dieser Angeborenheitshypothese entstanden. Die Grammatik einer Einzelsprache wird empirisch an der Menge von Sätzen überprüft, die unabhängig von der jeweiligen Grammatik als zu der Sprache gehörig betrachtetet werden. Die Entscheidung darüber, welche Sätze zu einer Sprache gehören, ist allerdings nicht trivial. Nicht jeder Satz, den ein muttersprachlicher Sprecher äußert, muss dieser Menge zugerechnet werden. Sprachliche Äußerungen können Fehler enthalten, die der Sprecher auch selbst erkennt, die z.B. durch Ablenkung, Müdigkeit, Drogen oder neurologische Störungen hervorgerufen werden können. Solche Fehler, oft auch nur einfache Versprecher, sind zwar Phänomene des Sprachverhaltens und können für viele wissenschaftliche Zwecke relevant sein, z.B. im Rahmen einer neurologischen Diagnose. Wenn jedoch die Grammatik der Sprache und damit das implizite sprachliche Wissen des Sprechers, beschrieben werden soll, schließt man sie vernünftigerweise aus. Chomsky (1965) hat in diesem Zusammenhang den Unterscheid zwischen Sprachkompetenz und Sprachperformanz eingeführt: Die Sprachperformanz können wir direkt im Sprachverhalten beobachten, während die Sprachkompetenz, also das implizite Wissen, das ein idealisierter muttersprachlicher Sprecher von seiner Sprache hat, der eigentliche Gegenstand der grammatischen Beschreibung ist. Die Ausgliederung der Performanz ist einerseits eine notwendige Konsequenz der Festlegung des Forschungsgegenstandes auf sprachliches Wissen, führt andererseits aber zu einem Empiriebegriff, der nicht ohne Probleme ist. Die wesentliche Form empirischer Überprüfung, die Chomsky vorschlug und die auch gegenwärtig die Arbeit in weiten Bereichen der theoretischen Linguistik bestimmt, ist die Überprüfung an Urteilen muttersprachlicher Sprecher: Ein Satz gehört zur Sprache, wenn er für einen muttersprachlichen Sprecher ‚akzeptabel‘ ist. Chomsky orientiert sich hier an dem logischempiristischen Begriff der Explikation oder rationalen Rekonstruktion. Er sieht die grammatische Beschreibung als „a familiar task of explication of some intuitive concept – in this case, the concept ‘grammatical in English’, and more generally, the concept ‘grammatical’ […] A certain number of clear cases, then, will provide us with a criterion of adequacy for any particular grammar“ (1957, 13f). Diese Sichtweise räumt der Empirie zwar einen wichtigen Platz ein, ist aber wesentlich motiviert durch die Entscheidung für ein strikt deduktives Vorgehen und den Wunsch nach einfachen Theorien. Viele theoretische Linguisten sehen gegenwärtig eine Datenerhebung über die Intuitionen muttersprachlicher Sprecher als eher unzureichend und unzuverlässig an (s.u.). Modularität. Die bisher skizzierten Aspekte der theoretischen Linguistik sind auf Syntax fokussiert und erklären noch nicht, wie den Sätzen einer Sprache rekursiv Bedeutungen zugeordnet werden und wie Sätze oder Bedeutungen in Zusammenhänge menschlichen Handelns und Wahrnehmens eingebunden sind. Dass der menschliche Gebrauch der Sprache ohne Bedeutungszuordnung und ohne Anbindung an Wahrnehmen und Handeln nur sehr eingeschränkt modelliert ist, ist unkontrovers. Kontrovers hingegen ist die Architektur einer Theorie des sprachlichen Wissens: (1) Ist sprachliches Wissen in einem engeren oder weiteren Sinn als ein eigenständiges kognitives Modul zu behandeln? und (2) Ist sprachliches Wissen in sich modular aufgebaut? Die Antworten hängen wesentlich davon ab, welche empirische Interpretation dem Modell zugeordnet und was genau unter Modularität verstanden wird. Ausgehend von der anfänglichen Fokussierung auf eine Menge wohlgeformter Sätze und eine postulierte Fähigkeit des muttersprachlichen Sprechers, die Zugehörigkeit von Sätzen zu dieser Menge zu beurteilen, wurde gelegentlich ein autonomes Syntaxmodul postuliert. Dies bringt jedoch gewisse empirische Probleme mit sich, da Wohlgeformtheitsurteile muttersprachlicher Sprecher selbst als kognitive Leistungen betrachtet werden müssen, die von intuitiven Bedeutungszuschreibungen, von vorgestellten Äußerungskontexten und von sprachlicher Erfahrung und sozialen Normen nicht unabhängig sind. Empirische Validierung syntaktischer Hypothesen ist somit letztendlich nicht ohne gewisse Annahmen zur Relation eines postulierten Syntaxmoduls mit anderen kognitiven Modulen möglich. Wenn das Syntaxmodul sehr konkret als ein Modul im menschlichen Sprachverarbeitungsprozess verstanden wird, das unabhängig vom Zugriff auf andere Module bestimmte Input-Output-Relationen definiert (Fodor 1983), ist die Hypothese eines Syntaxmoduls nicht haltbar. Es kann empirisch als gesichert gelten, dass im menschlichen Sprachverarbeitungsprozess syntaktische, semantische und kontextuelle Information interaktiv und nicht im strikten Sinn modular verarbeitet werden (Altmann/Steedman 1988; Marslen-Wilson/Tyler 1980). Nun steht es dem Theoretiker natürlich frei, Modularisierung in einem abstrakteren Sinn auf die Theorie selbst zu beziehen. Modularität der Theorie besteht dann darin, dass eine Teiltheorie unabhängig von anderen Teiltheorien in ihren jeweils eigenen Parametern formuliert werden kann. Die Theorie der Syntax ist dann zu verstehen als eine eigenständig formulierbare abstrakte Menge von Beschränkungen, denen Verarbeitungsprozesse – neben anderen Beschränkungen aus anderen Teiltheorien – unterworfen sind. Eine empirische Validierung eines so konzipierten Syntaxmoduls ist jedoch nur unter Zuhilfenahme von Annahmen über andere kognitive Module möglich. Dem Theoretiker bietet sich insofern die Option, den Begriff ‚sprachliches Wissen‘ um andere Module zu erweitern und damit u.a. eine größere Nähe zu Verarbeitungsprozessen und eine direktere empirische Validierung zu erreichen. Diese Option hat sich insbesondere bezüglich der Semantik und Pragmatik seit den 1980er Jahren in der theoretischen Linguistik etabliert und vielfach zu einer engen Interaktion mit Psycholinguistik und Neurolinguistik geführt. Semantik. Als Bedeutungen von Sätzen nimmt man in der theoretischen Linguistik im Allgemeinen vereinfacht Wahrheitsbedingungen an: „Einen Satz verstehen, heißt, wissen was der Fall ist, wenn er wahr ist“ (Wittgenstein 1921/1960, 4.024). Da es in jeder Sprache bei endlichem Vokabular dennoch unendlich viele verschiedene Sätze gibt, ist eine Erklärung der semantischen Produktivität, also der Fähigkeit, unendlich viele verschiedene Sätze zu verstehen, nur über die Annahme möglich, dass die Wahrheitsbedingungen eines Satzes funktional von den Bedeutungen der Wörter des Satzes und seiner syntaktischen Struktur abhängen. Man spricht hier vom Prinzip der Kompositionalität. Wir nehmen hier etwas vereinfacht an, dass Wörter entweder Dinge (konkreter oder abstrakter Art) oder Begriffe bezeichnen, wobei Begriffe nach Frege als Funktionen vorgestellt werden. So lässt sich erklären, dass die Bedeutung des Satzes ‚Der Bauer tritt den Esel.‘, d.h. ’tritt(ιx(Bauerc(x)), ιy(Eselc(y))÷, einerseits von der Syntax und der Denotation des Verbs, d.h. der Relation ’λx(λy.tritt(y,x))÷, abhängt und andererseits von der Denotation der beiden Nominalausdrücke ‚der Bauer‘, d.h. ’ιx(Bauerc(x))÷, und ‚der Esel‘, d.h. ’ιy(Eselc(y))÷. Deren Denotation wiederum hängt ab von der Denotation des definiten Artikels, ’λPιx(Pc(x))÷ – zu lesen als ‚der einzige Gegenstand x, der im aktuellen Kontext c unter den Begriff P fällt‘– und den Begriffen Bauer ’λx(Bauer (x))÷ bzw. ’λy(Esel (y))÷. Da die Syntax im Fall des ganz ähnlichen Satzes ‚Den Bauern tritt der Esel.‘ die Nominalausdrücke genau umgekehrt auf die Argumentstellen des Verbs abbildet, ergibt sich hier eine andere, aber völlig analoge Satzbedeutung. Auch für ihrer syntaktischen Struktur nach mehrdeutige Sätze wie ‚Hans liebt Maria.‘ (Hans kann Subjekt oder Objekt sein) oder Groucho Marx’ klassischen Spruch ‚I shot an elephant in my pyjamas.‘ (die Präposionalkonstituente ‚in my pyjamas‘ kann entweder das Verb oder das Objekt modifizieren) ist offensichtlich die syntaktische Struktur für den Unterschied in den Wahrheitsbedingungen ausschlaggebend. Sprache und Situation. Generative Syntax und kompositionelle Semantik stellen einen relativ gut ausgearbeiteten Kern einer linguistischen Theorie dar, die in Grundzügen eine Erklärung für syntaktische und semantische Produktivität und somit ein Teilmodell für sprachliches Wissen liefern kann. Zur Erklärung produktiven Sprachgebrauchs muss jedoch eine Interaktion mit zusätzlichem Wissen über die jeweiligen sprachlichen und nicht-sprachlichen Kontexte angenommen werden. Da jedoch Kontexte nicht wie Sätze nach einem rekursiven Algorithmus aus einer endlichen Anzahl von Elementen aufgebaut sind, lassen sich die Grundgedanken der generativen Syntax und kompositionellen Semantik nicht trivial auf Kontextabhängigkeit erweitern. Kontextabhängigkeit tritt in einer offensichtlichen Form u.a. bei der Interpretation von Pronomina auf. Die Wahrheitsbedingungen für den Satz ‚Er arbeitet.‘ müssen Bezug nehmen auf ein bestimmtes vom Sprecher intendiertes Referenzobjekt für das Pronomen, das sich jedoch aus der Semantik des Satzes allein nicht bestimmen lässt. Es muss sich um ein Referenzobjekt handeln, das entweder belebt und männlich ist oder durch ein maskulines Substantiv bezeichnet wird; es muss weiterhin ein Referenzobjekt sein, für das die Denotation des Verbs definiert ist, d.h. einen Gegenstand, von dem man sinnvoll fragen kann, ob er unter ein bestimmtes Konzept des Arbeitens fällt. Die Semantik des Satzes schränkt somit die Interpretation ein, determiniert sie aber nicht. Es bleibt offen, auf welches von beliebig vielen Referenzobjekten sich das Pronomen ‚er‘ bezieht bzw. worauf der Sprecher es beziehen möchte. Die Integration von Äußerungen in einen sprachlichen oder außersprachlichen Kontext verlangt, dass Pronomina einer Reihe weiterer nicht-semantischer Bedingungen genügen; u.a. müssen sie sich auf Referenzobjekte beziehen, die in der Äußerungssituation zugänglich sind (Kamp/Reyle 1993) und zudem in der einen oder anderen Weise prominent sind (Gundel et al. 1993). Zu vergleichbaren Problemen kommt es bei der Interpretation von Ausdrücken, die sich nicht auf Objekte, sondern auf Konzepte beziehen. Auch hier kann die Semantik lediglich Beschränkungen formulieren, keine notwendigen und hinreichenden Bedingungen. Wir haben es hier nicht bloß mit einfacher lexikalischer Ambiguität zu tun, sondern mit sog. Polysemie. ‚Arbeiten‘ kann im Gegensatz stehen zu in Ausbildung oder im Ruhestand befindlich oder zu Arbeitslosigkeit, oder im Gegensatz zu in Urlaub sein oder krank geschrieben sein – beides würde ‚arbeiten‘ im ersten Sinn voraussetzen. Es kann auch bedeuten, aktuell einer Tätigkeit nachzugehen im Gegensatz etwa zu Ausruhen – keines von beiden setzt ein Arbeitsverhältnis voraus oder stünde im Gegensatz zu ‚in Urlaub sein‘ oder ‚krankgeschrieben sein‘. Hier das situativ passende und vom Sprecher intendierte Konzept zu bestimmen, ist offenbar, trotz relativ klarer semantischer Beschränkungen, nicht ausschließlich eine Frage der Semantik, sondern hängt ebenfalls ab von kognitiven Fähigkeiten, die sich auf Kenntnis der Situation, auf plausible Ausdrucksintentionen des Sprechers u.ä. beziehen. Hier handelt es sich, ebenso wie im Falle der pronominalen Referenz, um Parameter, die nicht im strikten Sinn Teil des sprachlichen Wissens sind, wenngleich jede Verwendung sprachlichen Wissens in der Interpretation von sprachlichen Äußerungen nicht ohne sie auskommt. Ob und in welchem Umfang solche kontextuellen Parameter im Rahmen einer kompositionellen Theorie modelliert werden können, ist unklar. Grobe Skizzen hierfür gibt es bei Montague (1968/1974), Kaplan (1977/1989) oder Lewis (1970). Man wird jedoch eher davon ausgehen müssen, dass eine umfassende Behandlung von Kontextabhängigkeiten der genannten Art die Grenzen der Theorie sprachlichen Wissens überschreitet. Hier geht es um Interaktionen zwischen sprachlichem Wissen und anderen kognitiven Modulen – und somit um eine der aktuell größten Herausforderungen an die Kognitionswissenschaft. Literatur Altmann, Gerry/Steedman, Mark (1988): Interaction with context during human sentence processing. In: Cognition 30,191–238. Chomsky, Noam (1956): Three models for the description of language. In: I.R.E .Transactions on Information Theory 2, 113–124. Chomsky, Noam (1957): Syntactic Structures. De Haag. Chomsky, Noam (1959): On certain formal properties of grammars. In: Information & Control 2, 137–167. Chomsky, Noam (1965): Aspects of the Theory of Syntax. Cambridge, MA. Fodor, Jerry (1983): The Modularity of Mind. Cambridge, MA. Gundel, Jeanette/Hedberg, Nancy/Zacharski, Ro (1993): Cognitive status and the form of referring expressions in discourse. In: Language 69, 274–307. Harris, Zellig (1951): Structural Linguistics. Chicago, IL. Hopcroft, John/Jeffrey Ullman (1979): Introduction to Automata Theory, Languages, and Computation. Boston. Kamp, Hans/Reyle, Uwe (1993): From Discourse to Logic. Dordrecht. Kaplan, David (1977/1989): Demonstratives. In: Joseph Almog/Howard Wettstein/John Perry (Hg.): Themes from Kaplan. Oxford 1989, 481–563. Lewis, David (1970): General semantics. In: Synthese 22, 18–67. Marslen-Wilson, William/Tyler, Lorraine (1980): The temporal structure of spoken language understanding. In: Cognition 8, 1–71. Montague, Richard (1968/1974): Pragmatics. In Richmond Thomason (Hg.): Formal Philosophy. Selected papers of Richard Montague. New Haven, CT, 95–118. Wittgenstein, Ludwig (1921/1960): Tractatus logico-philosophicus. In: ders., Schriften, Bd 1. Frankfurt a.M. Peter Bosch