bivariate

Werbung

3.

Gemeinsame

und

bedingte

stochastische Unabhängigkeit

Verteilung,

Lernziele dieses Kapitels:

• Mehrdimensionale Zufallsvariablen (Zufallsvektoren)

(Verteilung, Kenngrößen)

• Abhängigkeitsstrukturen

• Multivariate Normalverteilung

(Definition, Eigenschaften)

Empfohlene Literatur:

• Mood, Graybill, Boes (1974), Kapitel IV, S. 129-174

• Wilfling (2011), Kapitel 4

94

3.1 Gemeinsame Verteilung und Randverteilung

Jetzt:

• Gleichzeitige Betrachtung mehrerer Zufallsvariablen

Einsatzgebiete:

• Diverse ökonomische Anwendungen

• Statistische Inferenz

95

Definition 3.1: (Zufallsvektor)

Gegeben seien die n Zufallsvariablen X1, · · · , Xn zu ein und demselben Zufallsexperiment, d.h.

Xi : Ω −→ R

für i = 1, . . . , n.

Dann nennt man X = (X1, . . . , Xn)0 eine n-dimensionale Zufallsvariable oder einen n-dimensionalen Zufallsvektor.

Bemerkungen:

• In der Wahrscheinlichkeitstheorie verwendet man für Zufallsvektoren oft auch die Schreibweisen

X = ( X1 , . . . , X n )

oder einfach

X1 , . . . , X n

96

• Für n = 2 schreibt man oft

X = (X, Y )0

oder

(X, Y )

oder

X, Y

• Für die Realisationen benutzt man Kleinbuchstaben:

x = (x1, . . . , xn)0 ∈ Rn

oder

x = (x, y)0 ∈ R2

Jetzt:

• Beschreibung der Wahrscheinlichkeitsverteilung des Zufallsvektors X

97

Definition 3.2: (Gemeinsame Verteilungsfunktion)

Für den Zufallsvektor X = (X1, . . . , Xn)0 heißt die Funktion

FX1,...,Xn : Rn −→ [0, 1]

mit

FX1,...,Xn (x1, . . . , xn) = P (X1 ≤ x1, X2 ≤ x2, . . . , Xn ≤ xn)

die gemeinsame Verteilungsfunktion von X = (X1, . . . , Xn)0.

Bemerkung:

• Definition 3.2 bezieht sich sowohl auf diskrete als auch auf

stetige Zufallsvariablen X1, . . . , Xn

98

Einige Eigenschaften der bivariaten VF (n = 2):

• FX,Y (x, y) ist monoton steigend in x und y

lim FX,Y (x, y) = 0

•

x→−∞

•

lim FX,Y (x, y) = 0

y→−∞

•

lim FX,Y (x, y) = 1

x→+∞

y→+∞

Bemerkung:

• Für die n-dimensionale VF FX1,...,Xn (x1, . . . , xn) gelten analoge

Eigenschaften

99

Jetzt:

• Gemeinsam diskrete versus stetige Verteilungen

Definition 3.3: (Gemeinsam diskrete Verteilung)

Der Zufallsvektor X = (X1, . . . , Xn)0 heißt gemeinsam diskret,

wenn es nur endlich (oder abzählbar unendlich) viele Realisationen x = (x1, . . . , xn)0 gibt, so dass

P (X1 = x1, X2 = x2, . . . , Xn = xn) > 0

und

X

P (X1 = x1, X2 = x2, . . . , Xn = xn) = 1,

wobei die Summation über alle möglichen Realisationen des Zufallsvektors erfolgt.

100

Definition 3.4: (Gemeinsam stetige Verteilung)

Der Zufallsvektor X = (X1, . . . , Xn)0 heißt gemeinsam stetig, falls

es eine nicht-negative Funktion fX1,...,Xn (x1, . . . , xn) gibt, so dass

FX1,...,Xn (x1, . . . , xn) =

Z x

n

−∞

...

Z x

1

−∞

fX1,...,Xn (u1, . . . , un) du1 . . . dun

gilt. Die Funktion fX1,...,Xn heißt gemeinsame Dichtefunktion des

Zufallsvektors.

Beispiel:

• Betrachte für X = (X, Y )0 die Dichtefunktion

fX,Y (x, y) =

(

x+y

0

, für (x, y) ∈ [0, 1] × [0, 1]

, sonst

101

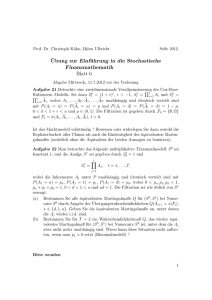

Dichtefunktion fX,Y (x, y)

2

1.5

fHx,yL 1

0.5

0

0

1

0.8

0.6

0.4 y

0.2

0.4

x 0.6

0.2

0.8

10

102

• Für die Verteilungsfunktion folgt

FX,Y (x, y) =

=

Z y

Z x

−∞ −∞

Z yZ x

0

0

fX,Y (u, v) du dv

(u + v) du dv

= ...

0.5(x2y + xy 2)

0.5(x2 + x)

=

2 + y)

0.5(y

1

, für

, für

, für

, für

(x, y) ∈ [0, 1] × [0, 1]

(x, y) ∈ [0, 1] × [1, ∞)

(x, y) ∈ [1, ∞) × [0, 1]

(x, y) ∈ [1, ∞) × [1, ∞)

(Beweis: Übungsaufgabe)

103

Bemerkungen:

• Es gilt:

∂ nFX1,...,Xn (x1, . . . , xn)

∂x1 · · · ∂xn

= fX1,...,Xn (x1, . . . , xn)

• Das Volumen unter der Dichtefunktion repräsentiert Wahrscheinlichkeiten:

o

o

u

P (au

1 < X1 ≤ a1, . . . , an < Xn ≤ an)

=

Z ao

n

au

n

...

Z ao

1

au

1

fX1,...,Xn (u1, . . . , un) du1 . . . dun

104

• In dieser VL:

Fokus auf stetige Zufallsvektoren

Für diskrete Zufallsvektoren gelten analoge Aussagen

(vgl. Mood, Graybill, Boes (1974), Kapitel IV)

Jetzt:

• Bestimmung der Verteilung einer einzelnen Zufallsvariablen

Xi aus der gemeinsamen Verteilung des Zufallsvektors

(X1, . . . , Xn)0

−→ Randverteilung

105

Definition 3.5: (Randverteilung)

Es sei X = (X1, . . . , Xn)0 ein stetig verteilter Zufallsvektor mit

den Verteilungs- und Dichtefunktionen FX1,...,Xn bzw. fX1,...,Xn .

Dann heißen

FX1 (x1) = FX1,...,Xn (x1, +∞, +∞, . . . , +∞, +∞)

FX2 (x2) = FX1,...,Xn (+∞, x2, +∞, . . . , +∞, +∞)

...

FXn (xn) = FX1,...,Xn (+∞, +∞, +∞, . . . , +∞, xn)

die Randverteilungsfunktionen bzw.

106

fX1 (x1) =

Z +∞

fX2 (x2) =

Z +∞

···

fXn (xn) =

−∞

−∞

Z +∞

−∞

...

Z +∞

fX1,...,Xn (x1, x2, . . . , xn) dx2 . . . dxn

...

Z +∞

fX1,...,Xn (x1, x2, . . . , xn) dx1 dx3 . . . dxn

...

Z +∞

fX1,...,Xn (x1, x2, . . . , xn) dx1 dx2 . . . dxn−1

−∞

−∞

−∞

die Randdichten der einzelnen (univariaten) Zufallsvariablen

X1, . . . , Xn.

107

Beispiel:

• Gegeben sei die bivariate Dichtefunktion

fX,Y (x, y)

=

(

40(x − 0.5)2y 3(3 − 2x − y)

0

, für (x, y) ∈ [0, 1] × [0, 1]

, sonst

108

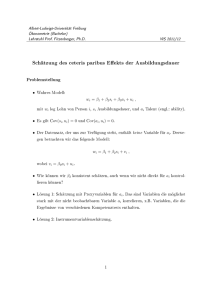

Dichtefunktion fX,Y (x, y)

3

fHx,yL 2

1

0.8

1

0

0

0.6

0.4 y

0.2

0.4

x 0.6

0.2

0.8

10

109

• Für die Randdichte von X gilt:

fX (x) =

Z 1

0

40(x − 0.5)2y 3(3 − 2x − y)dy

= 40(x − 0.5)2

Z 1

0

(3y 3 − 2xy 3 − y 4)dy

1

2x

1

3

= 40(x − 0.5)2 y 4 −

y4 − y5

4

4

5

0

3 2x 1

2

= 40(x − 0.5)

−

−

4

4

5

= −20x3 + 42x2 − 27x + 5.5

110

Randdichte fX (x)

fHxL

1.5

1.25

1

0.75

0.5

0.25

x

0.2

0.4

0.6

0.8

1

111

• Für die Randdichte von Y gilt:

fY (y) =

Z 1

0

40(x − 0.5)2y 3(3 − 2x − y)dx

= 40y 3

= −

Z 1

0

(x − 0.5)2(3 − 2x − y)dx

10 3

y (y − 2)

3

112

Randdichte fY (y)

fHyL

3

2.5

2

1.5

1

0.5

y

0.2

0.4

0.6

0.8

1

113

Bemerkungen:

• Beim Übergang zu den Randverteilungen ergibt sich ein Informationsverlust

(aus gemeinsamer Verteilung folgen die Randverteilungen,

aber nicht umgekehrt)

• Neben den einzelnen univariaten Randverteilungen ergeben

sich auch die multivariaten Randverteilungen aus der gemeinsamen Verteilung von X = (X1, . . . , Xn)0

114

Beispiel:

• Es sei n = 5, d.h. X = (X1, . . . , X5)0 mit gemeinsamer Dichtefunktion fX1,...,X5

• Dann ist die Randdichte von Z = (X1, X3, X5)0

fX1,X3,X5 (x1, x3, x5)

=

Z +∞ Z +∞

−∞

−∞

fX1,...,X5 (x1, x2, x3, x4, x5) dx2 dx4

(Herausintegrieren nicht interessierender Komponenten)

115

3.2 Bedingte Verteilungen und stochastische Unabhängigkeit

Jetzt:

• Verteilung einer ZV’en X unter der Bedingung, dass eine andere ZV’en Y bereits einen bestimmten Wert y angenommen

hat

(Bedingte Verteilung von X unter Y = y)

116

Definition 3.6: (Bedingte Verteilung)

Es seien X = (X, Y )0 ein stetig verteilter Zufallsvektor mit gemeinsamer Dichtefunktion fX,Y (x, y). Die bedingte Dichte von X

unter der Bedingung Y = y ist definiert durch

fX|Y =y (x) =

fX,Y (x, y)

fY (y)

.

Analog ist die bedingte Dichte von Y unter der Bedingung X = x

definiert als

fX,Y (x, y)

fY |X=x(y) =

.

fX (x)

117

Bemerkung:

• Bedingte Dichten für Zufallsvektoren werden analog definiert,

z.B.

fX1,X2,X4|X3=x3,X5=x5 (x1, x2, x4) =

fX1,X2,X3,X4,X5 (x1, x2, x3, x4, x5)

fX3,X5 (x3, x5)

118

Beispiel:

• Gegeben sei die bivariate Dichtefunktion

fX,Y (x, y)

=

(

40(x − 0.5)2y 3(3 − 2x − y)

0

, für (x, y) ∈ [0, 1] × [0, 1]

, sonst

mit der Randdichte

10 3

fY (y) = − y (y − 2)

3

(vgl. Folien 108-112)

119

• Dann gilt für die bedingte Dichte

fX|Y =y (x) =

=

fX,Y (x, y)

fY (y)

40(x − 0.5)2y 3(3 − 2x − y)

3(y − 2)

− 10

y

3

12(x − 0.5)2(3 − 2x − y)

=

2−y

120

Bedingte Dichte fX|Y =0.01(x) von X unter Y = 0.01

Bedingte

Dichte

3

2.5

2

1.5

1

0.5

x

0.2

0.4

0.6

0.8

1

121

Bedingte Dichte fX|Y =0.95(x) von X unter Y = 0.95

Bedingte

Dichte

1.2

1

0.8

0.6

0.4

0.2

x

0.2

0.4

0.6

0.8

1

122

Jetzt:

• Benutze Konzepte der gemeinsamen Verteilung bzw. der bedingten Verteilung zur Definition der stochastischen Unabhängigkeit

(zunächst für 2 ZV’e)

Definition 3.7: (Stochastische Unabhängigkeit [I])

Es sei (X, Y )0 ein stetig verteilter Zufallsvektor mit gemeinsamer

Dichtefunktion fX,Y (x, y). Dann heißen X und Y stochastisch

unabhängig, falls die gemeinsame Dichtefunktion dem Produkt

der Randdichten entspricht:

fX,Y (x, y) = fX (x) · fY (y)

für alle x, y ∈ R.

123

Bemerkungen:

• Alternativ drückt man die Unabhängigkeit auch über die gemeinsame Verteilungsfunktion aus:

X und Y sind genau dann unabhängig, wenn gilt:

FX,Y (x, y) = FX (x) · FY (y)

für alle x, y ∈ R.

• Sind X und Y unabhängig, so gilt für die bedingten Verteilungen:

fX|Y =y (x) =

fY |X=x(y) =

fX,Y (x, y)

fY (y)

fX,Y (x, y)

fX (x)

fX (x) · fY (y)

=

= fX (x)

fY (y)

fX (x) · fY (y)

=

= fY (y)

fX (x)

• Sind X und Y unabhängig und g und h zwei stetige Funktionen, so sind auch g(X) und h(Y ) unabhängig

124

Jetzt:

• Verallgemeinerung auf n ZV’en

Definition 3.8: (Stochastische Unabhängigkeit [II])

Es sei (X1, . . . , Xn)0 ein stetig verteilter Zufallsvektor mit gemeinsamer Dichtefunktion fX1,...,Xn (x1, . . . , xn) sowie Verteilungsfunktion FX1,...,Xn (x1, . . . , xn). Dann heißen X1, . . . , Xn stochastisch

unabhängig, falls für alle (x1, . . . , xn)0 ∈ Rn gilt

fX1,...,Xn (x1, . . . , xn) = fX1 (x1) · . . . · fXn (xn)

bzw.

FX1,...,Xn (x1, . . . , xn) = FX1 (x1) · . . . · FXn (xn).

125

Bemerkungen:

• Für diskret verteilte Zufallsvektoren definiert man analog:

X1, . . . , Xn sind stochastisch unabhängig, falls für alle Realisationen (x1, . . . , xn)0 ∈ Rn gilt:

P (X1 = x1, . . . , Xn = xn) = P (X1 = x1) · . . . · P (Xn = xn)

bzw.

FX1,...,Xn (x1, . . . , xn) = FX1 (x1) · . . . · FXn (xn).

• Bei Unabhängigkeit ergibt sich die gemeinsame Verteilung

aus den Randverteilungen (sonst nicht)

• Sind X1, . . . , Xn stochastisch unabhängig und g1, . . . , gn stetige

Funktionen, so sind auch die transformierten ZV’en Y1 =

g1(X1), . . . , Yn = gn(Xn) stochastisch unabhängig

126

3.3 Erwartungswerte und gemeinsame momentenerzeugende Funktion

Jetzt:

• Definition des Erwartungswertes einer Funktion

g : Rn −→ R

(x1, . . . , xn) 7−→ g(x1, . . . xn)

eines stetig verteilten Zufallsvektors X = (X1, . . . , Xn)0

127

Definition 3.9: (E-Wert einer Funktion)

Es sei (X1, . . . , Xn)0 ein stetig verteilter Zufallsvektor mit Dichtefunktion fX1,...,Xn (x1, . . . , xn) und g : Rn −→ R eine reellwertige

stetige Funktion. Dann ist der Erwartungswert der Funktion des

Zufallsvektors definiert als

E[g(X1, . . . , Xn)]

=

Z +∞

−∞

...

Z +∞

−∞

g(x1, . . . , xn) · fX1,...,Xn (x1, . . . , xn) dx1 . . . dxn.

128

Bemerkungen:

• Für einen diskret verteilten Zufallsvektor (X1, . . . , Xn)0 lautet

die entsprechende Definition

E[g(X1, . . . , Xn)] =

X

g(x1, . . . , xn) · P (X1 = x1, . . . , Xn = xn),

wobei über alle Realisationen des Vektors zu summieren ist

• Definition 3.9 umfasst den Erwartungswert einer einzelnen

ZV’en X:

Setze n = 1 sowie g(x) = x

−→ E(X1) ≡ E(X) =

Z +∞

−∞

xfX (x) dx

• Definition 3.9 umfasst die Varianz einer ZV’en X:

Setze n = 1 und sowie g(x) = [x − E(X)]2

−→ Var(X1) ≡ Var(X) =

Z +∞

−∞

[x − E(X)]2fX (x) dx

129

• Definition 3.9 umfasst die Kovarianz zweier ZV’en:

Setze n = 2 sowie g(x1, x2) = [x1 − E(X1)] · [x2 − E(X2)]

−→ Cov(X1, X2)

=

Z +∞ Z +∞

−∞

−∞

[x1 − E(X1)][x2 − E(X2)]fX1,X2 (x1, x2) dx1 dx2

• Mit der Kovarianz folgt der Korrelationskoeffizient:

Cov(X1, X2)

q

Corr(X1, X2) = q

Var(X1) Var(X2)

• Eigenschaften von Erwartungswerten, Varianzen, Kovarianzen,

Korrelationskoeffizienten

−→ siehe Übung

130

Jetzt:

• ’Erwartungswerte’ und ’Varianzen’ für Zufallsvektoren

Definition 3.10: (E-Wertvektor, Kovarianzmatrix)

X = (X1, . . . , Xn)0 sei ein Zufallsvektor. Unter dem Erwartungswertvektor von X versteht man den Vektor der Erwartungswerte

E(X1)

...

E(X) =

.

E(Xn)

Unter der Kovarianzmatrix von X versteht man die folgende Matrix von Varianzen und Kovarianzen:

Cov(X) =

Var(X1)

Cov(X1, X2)

Cov(X2, X1)

Var(X2)

...

...

Cov(Xn, X1) Cov(Xn, X2)

. . . Cov(X1, Xn)

. . . Cov(X2, Xn)

...

...

...

Var(Xn)

.

131

Bemerkung:

• Offensichtlich ist jede Kovarianzmatrix symmetrisch

Frage:

• Wie verhalten sich Erwartungswertvektoren und Kovarianzmatrizen unter linearen Transformationen von Zufallsvektoren

Es seien

• X = (X1, . . . , Xn)0 ein n-dimensionaler Zufallsvektor

• A eine (m × n)-Matrix reeller Zahlen

• b ein (m × 1) Spaltenvektor reeller Zahlen

132

Offensichtlich gilt:

• Y = AX + b ist ein (m × 1)-Zufallsvektor:

Y =

=

a11 a12

a21 a22

...

...

am1 am2

. . . a1n

X1

X

. . . a2n

2

+

...

...

...

. . . amn

Xn

b1

b2

...

bm

a11X1 + a12X2 + . . . + a1nXn + b1

a21X1 + a22X2 + . . . + a2nXn + b2

...

am1X1 + am2X2 + . . . + amnXn + bm

133

• Für den Erwartungswertvektor von Y gilt:

E(Y) =

a11E(X1) + a12E(X2) + . . . + a1nE(Xn) + b1

a21E(X1) + a22E(X2) + . . . + a2nE(Xn) + b2

...

am1E(X1) + am2E(X2) + . . . + amnE(Xn) + bm

= AE(X) + b

• Für die Kovarianzmatrix von Y gilt:

Cov(Y) =

Cov(Y1, Y2)

Var(Y1)

Var(Y2)

Cov(Y2, Y1)

...

...

Cov(Yn, Y1) Cov(Yn, Y2)

. . . Cov(Y1, Yn)

. . . Cov(Y2, Yn)

.

...

..

...

Var(Yn)

= ACov(X)A0

(Beweis: Übung)

134

Bemerkung:

• Vgl. Analogien zu den univariaten Fällen:

E(a · X + b) = a · E(X) + b

Var(a · X + b) = a2 · Var(X)

Bisher:

• Erwartungswerte für unbedingte Verteilungen

Jetzt:

• Erwartungswerte für bedingte Verteilungen

(vgl. Definition 3.6, Folie 117)

135

Definition 3.11: (Bedingter E-Wert einer Funktion)

Es sei (X, Y )0 ein stetig verteilter Zufallsvektor mit gemeinsamer

Dichtefunktion fX,Y (x, y) und g : R2 −→ R eine reellwertige

stetige Funktion. Dann ist der bedingte Erwartungswert der

Funktion unter der Bedingung X = x definiert als

E[g(X, Y )|X = x] =

Z +∞

−∞

g(x, y) · fY |X (y) dy.

136

Bemerkungen:

• Für einen diskret verteilten Zufallsvektor (X, Y )0 gilt eine

analoge Definition

• Die Definition 3.11 kann auf höher dimensionale Verteilungen

verallgemeinert werden

• Für g(x, y) = y erhält man als Spezialfall E[g(X, Y )|X = x] =

E(Y |X = x)

• Man beachte, dass E[g(X, Y )|X = x] im Allgemeinen eine

Funktion von x darstellt

137

Beispiel:

• Man betrachte die gemeinsame stetige Dichtefunktion

fX,Y (x, y) =

(

x+y

0

, für (x, y) ∈ [0, 1] × [0, 1]

, sonst

• Für die bedingte Verteilung von Y unter X = x folgt

x+y

x + 0.5

fY |X=x(y) =

0

, für (x, y) ∈ [0, 1] × [0, 1]

, sonst

• Mit g(x, y) = y ergibt sich der bedingte Erwartungswert als

Z 1

1

x+y

x

1

y·

E(Y |X = x) =

dy =

·

+

x + 0.5

x + 0.5

2

3

0

138

Bemerkungen:

• Wir betrachten die Funktion g(x, y) = g(y)

(d.h. g hängt nicht von x ab)

• Nun bezeichne h(x) = E[g(Y )|X = x]

• Wir berechnen nun den unbedingten Erwartungswert der

Transformation h(X)

• Es gilt:

139

E {E[g(Y )|X = x]} = E[h(X)] =

=

Z +∞

−∞

Z +∞

−∞

h(x) · fX (x) dx

E[g(Y )|X = x] · fX (x) dx

=

Z +∞ "Z +∞

=

Z +∞ Z +∞

g(y) · fY |X (y) · fX (x) dy dx

=

Z +∞ Z +∞

g(y) · fX,Y (x, y) dy dx

−∞

−∞

−∞

−∞

−∞

−∞

#

g(y) · fY |X (y) dy · fX (x) dx

= E[g(Y )]

140

Satz 3.12:

Es sei (X, Y )0 ein beliebig diskret oder stetig verteilter Zufallsvektor. Dann gilt

E[g(Y )] = E {E[g(Y )|X = x]}

und insbesondere

E[Y ] = E {E[Y |X = x]} .

Jetzt:

• Drei weitere wichtige Rechenregeln für bedingte und unbedingte Erwartungswerte

141

Satz 3.13:

Es seien (X, Y )0 ein beliebig diskret oder stetig verteilter Zufallsvektor und g1(·), g2(·) zwei eindimensionale Funktionen. Dann

gilt für die bedingten Erwartungswerte:

1. E[g1(Y ) + g2(Y )|X = x] = E[g1(Y )|X = x] + E[g2(Y )|X = x].

2. E[g1(Y ) · g2(X)|X = x] = g2(x) · E[g1(Y )|X = x].

3. Falls X und Y stochastisch unabhängig sind, so gilt für die

unbedingten Erwartungswerte

E[g1(X) · g2(Y )] = E[g1(X)] · E[g2(Y )].

142

Abschließend:

• Momentenerzeugende Funktion für Zufallsvektoren

Definition 3.14: (Gemeinsame momentenerz. Funktion)

Es sei (X1, . . . , Xn)0 ein beliebig diskret oder stetig verteilter Zufallsvektor. Dann ist dessen gemeinsame momentenerzeugende

Funktion definiert durch

mX1,...,Xn (t1, . . . , tn) = E

h

i

t

·X

+...+t

·X

n

n

1

1

,

e

falls dieser Erwartungswert für alle Werte von t1, . . . , tn mit −h <

tj < h für irgendein h > 0 und alle j = 1, . . . , n existiert.

143

Bemerkungen:

• Anhand der gemeinsamen momentenerzeugenden Funktion

mX1,...,Xn (t1, . . . , tn) lassen sich mit bestimmten Rechenoperationen die folgenden Objekte bestimmen:

die

marginalen

momentenerzeugenden

mX1 (t1), . . . , mXn (tn)

Funktionen

die Momente der Randverteilungen

sogenannte gemeinsame Momente

144

Zentrales Resultat: (vgl. Satz 2.23, Folie 85)

Zu einer gegebenen gemeinsamen momentenerzeugenden

Funktion mX1,...,Xn (t1, . . . , tn) gehört eine eindeutige gemeinsame Verteilungsfunktion FX1,...,Xn (x1, . . . , xn)

145

3.4 Die multivariate Normalverteilung

Jetzt:

• Verallgemeinerung der univariaten Normalverteilung

Definition 3.15: (Multivariate Normalverteilung)

Es sei X = (X1, . . . , Xn)0 ein n-dimensionaler stetiger Zufallsvektor. X heißt multivariat normalverteilt mit Parametern

σ12

= ...

· · · σ1n

...

...

und Σ

,

2

σn1 · · · σn

falls für x = (x1, . . . , xn)0 ∈ Rn die Dichtefunktion

µ1

..

µ= .

µn

1

fX(x) = (2π)−n/2 [det(Σ)]−1/2 · exp − (x − µ)0 Σ−1 (x − µ)

2

lautet.

146

Bemerkungen:

• Für die Definition und Eigenschaften der Determinanten einer

Matrix A, det(A), vgl. Chang (1984, S. 92 ff)

• Übliche Notation

X ∼ N (µ, Σ)

• µ ist ein Spaltenvektor mit µ1, . . . , µn ∈ R

• Σ ist (per Annahme) eine reguläre, positiv definite, symmetrische (n × n)-Matrix

• Bedeutung der Parameter:

E(X) = µ

und

Cov(X) = Σ

147

• Dichte der multivariaten Standardnormalverteilung N (0, In):

1 0

−n/2

φ(x) = (2π)

· exp − x x

2

• Man beachte die Analogien zur univariaten Dichte in Definition 2.24, Folie 91

Eigenschaften der N (µ, Σ)-Verteilung:

• Teilvektoren (Randverteilungen) von X sind wieder normalverteilt, d.h. falls

X=

"

X1

X2

#

∼N

"

µ1

µ2

# "

,

Σ11 Σ12

Σ21 Σ22

#!

dann gilt:

X1 ∼ N (µ1, Σ11)

X2 ∼ N (µ2, Σ22)

148

• Somit sind alle univariaten Elemente des Zufallsvektors X =

(X1, . . . , Xn)0 univariat normalverteilt:

X1 ∼ N (µ1, σ12)

X2 ∼ N (µ2, σ22)

...

2)

Xn ∼ N (µn, σn

• Auch die bedingten Verteilungen sind wiederum (uni- oder

multivariat) normal:

−1

(x

−

µ

Σ

Σ

X1|X2 = x2 ∼ N µ1 + Σ12Σ−1

),

−

Σ

2

11

12

2

22

22 Σ21

• Lineare Transformationen:

Es seien A eine (m × n)-Matrix und b ein (m × 1)-Vektor

reeller Zahlen sowie X = (X1, . . . , Xn)0 ∼ N (µ, Σ). Dann gilt:

AX + b ∼ N (Aµ + b, AΣA0)

149

Beispiel:

• Es sei

X ∼ N (µ, Σ)

∼ N

"

# "

0

1

,

1 0.5

0.5 2

#!

• Gesucht ist die Verteilung von Y = AX + b mit

A=

"

1 2

3 4

#

,

1

2

#

AΣA0 =

"

b=

"

• Es gilt Y ∼ N (Aµ + b, AΣA0)

• Matrixalgebra ergibt

Aµ + b =

"

3

6

#

und

12 24

24 53

#

150

Jetzt:

• Spezialisierung auf bivariaten Fall (n = 2), d.h.

X = (X, Y )0,

E(X) =

"

µX

µY

#

Σ=

,

"

2

σX

σY X

σXY

σY2

#

• Es gilt

σXY = σY X = Cov(X, Y ) = σX · σY · Corr(X, Y ) = σX · σY · ρ

• Mit Definition 3.15 und n = 2 gilt dann für die Dichte

fX,Y (x, y) =

1

2πσX σY

"

q

1 − ρ2

exp

−

1

2 1 − ρ2

(y − µY )2

(x − µX )2 2ρ(x − µX )(y − µY )

×

+

−

2

σX σY

σX

σY2

(Herleitung: Übungsaufgabe)

151

#)

Dichte fX,Y (x, y) mit µX = µY = 0, σx = σY = 1 sowie ρ = 0

fHx,yL0.1

0.15

2

0.05

0

0 y

-2

0

-2

x

2

152

Dichte fX,Y (x, y) mit µX = µY = 0, σx = σY = 1 sowie ρ = 0.9

0.3

fHx,yL0.2

2

0.1

0

0 y

-2

0

-2

x

2

153

Bemerkungen:

• Für die Randverteilungen gilt

2 ) und

Y ∼ N (µY , σY2 )

X ∼ N (µX , σX

−→ Besonderheit der Normalverteilung:

Ist ρ = Corr(X, Y ) = 0 (d.h. sind X und Y unkorreliert), so

sind X und Y stochastisch unabhängig

• Die bedingten Verteilungen sind gegeben durch

σ

2 1 − ρ2

X|Y = y ∼ N µX + ρ X (y − µY ), σX

σY

σ

Y |X = x ∼ N µY + ρ Y (x − µX ), σY2 1 − ρ2

σX

!

!

(Beweise: Übungsaufgabe)

154