Dynamik Neuronaler Netze

Werbung

Dynamik Neuronaler Netze

Ausarbeitung von Ercan Elitok nach „Theoretical Neuroscience” von Peter Dayan, L. F. Abbott, p. 260273

Inhalt

Dynamik Neuronaler Netze........................................................................................................ 1

Netzwerkstabilität ................................................................................................................... 2

Assoziatives Gedächtnis/Speicher......................................................................................... 3

Exzitatorisch-Inhibitorische Netzwerke .................................................................................. 7

Homogene Exzitatorische ond Inhibitorische Populationen .............................................. 8

Der Bulbus olfaktorius ...................................................................................................... 11

Oszillatorische Verstärkung ............................................................................................. 14

Legende

τ s = Zeitkonstante bis Erreichen des stationären Zustands des Neurons S,

v = F ( I s ) = Netzwerkfeuerrate, mit I s als Vektor des gesamten synaptischen Stroms

des Neurons S,

u = Inputvektor,

v = Outputvektor,

h = gesamter vorwärts gekoppelter Input,

w = Inputgewichtsvektor,

W = Gewichtsmatrix des Inputs,

M = Gewichtsmatrix des Outputs bzw. der Rückwärtskopplung,

t = Zeit.

Zusammenfassung

Die Dynamik neuronaler Netze kann mit unterschiedlichen Techniken analysiert

werden. Mit der Theorie der Lyapunovfunktionen kann untersucht werden, ob ein

Netzwerk Fixpunktverhalten zeigt. Hierbei wird deutlich, dass die Gewichtsmatrizen

eines neuronalen Netzwerks Stabilitätskriterien erfüllen müssen, die sich von eine r

Lyapunovfunktion ableiten. Am Beispiel eines assoziativen Speichernetzwerks wird

deutlich, dass zur Herleitung eines Modells die Eigenschaften der zugehörigen

symmetrischen Gewichtsmatrix wesentlich durch die zu bewerkstelligenden

Aufgaben des Netzwerks bestimmt sind. Das Netzwerkmodell muss zum Auslesen

bestimmter Muster passende Fixpunkte besitzen. Modelle exzitatorischinhibitorischer Neuronenpopulationen, die eine asymmetrische Gewichtsmatrix

besitzen zeigen neben einem Fixpunktverhalten auch oszillierende Aktivität. Die

Beurteilung, ob es sich um stabile bzw. instabile Fixpunkte oder um oszillatorisches

Netzwerkverhalten handelt kann mittels Phasenebenen- und Stabilitätsanalyse

untersucht werden. Hierbei sind die (komplexen) Eigenwerte der Gewichtsmatrix die

entscheidenden Kriterien für die Analyse. Ein Beispiel für ein exzitatorischinhibitorisches Modell stellt die Simulation des Bulbus olfaktorius dar. Hier können

Modell- und biologische Daten miteinander verglichen werden. Ein Beispiel für

oszillierende Aktivität eines exzitatorich-inhibitorischen Netzwerkmodells findet sich

bei auf bestimmten Input spezialisierten Neuronenpopulationen, deren Aktivität durch

abgestimmten Input selektiv verstärkt werden kann.

1

Netzwerkstabilität

Wenn ein Netzwerk bei einem konsta nten Input zu einem stationären Zustand

übergeht mit dv/dt=0, dann spricht man davon, dass das Netzwerk ein FixpunktVerhalten (fixed-point behavior) zeigt. Dies ist zwar nicht die einzige Form einer

Langzeitaktivität, die ein Netzwerkmodel annehmen kann, aber beim Vorliegen

bestimmter Bedingungen erreicht ein Netzwerk als Antwort auf einen konstanten

Input unausweichlich einen Fixpunkt. Die Theorie der Lyapunovfunktionen kann dazu

benutzt werden um dieses Netzwerkverhalten nachzuweisen was im Folgenden

einführend informal beschrieben wird.

Zur Diskussion der Lyapunovfuktionen betrachten wir zunächst die Dynamik der

Feuerrate

τs

dI s

= − I s + w ⋅ u , mit v = F ( I s ) ,

dt

(1)

In einem Netzwerkmodell stellt v = F (I ) den Vektor der Feuerrate dar, mit

F ' ( I ) > 0, ∀ I . I befolgt die Dynamik der Formel

dI

τs

= − I + h + M ⋅ F (I ) ,

dt

(2)

die die verallgemeinerte Form der Gleichung 1 für ein Netzwerkmodell darstellt.

Die Gleichung 2 kann auch dafür verwendet werden um das Feuerratenmodell von

rückwärtsgekoppelten Netzwerken darzustellen.

Cohen und Grossberg (1983) haben für diese Form des Feuerratenmodells

(Gleichung 2 mit einer symmetrischen rückwärtsgekoppelten Gewichtsmatrix M )

gezeigt, dass durch

N

Ia

1 v

L( I ) = ∑ ∫ dz a z a F ' ( z a ) − ha F ( I a ) − ∑ F ( I a ) M aa' F ( I a ' )

2 a '=1

a =1 0

Nv

eine Lyapunovfunktion gegeben ist. Um das nachzuvollziehen setze man die

dL

Ableitung der Gleichung 3

in die Gleichung 2 ein. Dies ergibt:

dt

2

dL( I )

1 Nv

dI a

= − ∑ F ' ( I a )

dt

τ s a=1

dt

(3)

(4)

Es gilt: dL / dt < 0 solange dI / dt ≠ 0 und F ' > 0. Ferner ist L ist nach unten beschränkt

und kann somit nicht beliebig kleiner werden. Daher muss I = h + M ⋅ v zu einem

Fixpunkt konvergieren. Hieraus folgt, dass v = F (I ) ebenfalls zu einem Fixpunkt

konvergieren muss.

Wir haben hierfür vorausgesetzt, dass F ' ( I ) > 0 , ∀I . Jedoch können wir zeigen,

dass die oben gezeigte Lyapunovf unktion ebenfalls gültig ist für den Fall der

Rektifizierung der Aktivierungsfunktion F ( I ) = [I ]+ , mit [I ]+ = max{ 0, I } . Weiterhin ist

es notwendig zu zeigen, dass die Lyapunovfunktion eine untere Schranke hat. Eine

Möglichkeit wäre eine sättigende Aktivierungsfunktion F zu benutzen, die bei

2

I → ∞ eine Schranke F * = lim F ( I ) hat und eine zweite Möglichkeit wäre die

I→∞

Gewichtsmatrix so zu wählen, dass ihre Eigenwerte genügend klein sind.

Assoziativer Speicher

Die Netzwerkmodelle für Gedächtnis, die mittels anhaltender Aktivität Informationen

speichern werden Arbeits- bzw. Kurzzeit-Gedächtnis gena nnt. In biologischen

Systemen scheint es so zu sein, dass die anhaltende Aktivität dazu dient

Informationen über einen Zeitraum von Sekunden bis Minuten zu speichern. Die

Informationsspeicherung im Langzeitgedächtnis, d.h. Speicherung über einen

Zeitraum von Stunden bis Jahren, scheint mehr über die Stärke der synaptischen

Verbindung als über anhaltende Aktivität zu erfolgen. Eine allgemeine Idee ist die

synaptische Gewicht in einem rückwärtsgekoppelten Netzwerk beim

Speichervorgang eines Gedächtnisinhaltes so zu setzen, dass das Netzwerk zu

einem späteren Zeitpunkt von sich heraus das Aktivitätsmuster des Speicherinhaltes

wiederherstellen kann. In solchen Netzwerken wird die persistente Aktivität sowohl

zur Signalisierung des Speicheraufrufs als auch zum Anzeigen der Identität des

aufgerufenen Speicherinhaltes benutzt und nicht für die Langzeitspeicherung der

möglichen Speichermuster. Das Aktivitätsmuster der Netzwerkneuronen bestimmt zu

Beginn des Speicheraufrufs welcher Informationsinhalt aufgerufen wird und zwar

vermittelt durch die Beziehung bzw. Assoziation des Aktivitätsmusters mit dem

Muster des Speicherinhalts.

Diese assoziativen Netzwerke wurden benutzt, um Gehirnregionen von Säugern mit

unterschiedlichen Gedächtnisformen einschließlich der Area CA3 des Hippokampus

und des präfrontalen Kortex zu modellieren.

In einem assoziativen, genauer autoassoziativen Speicher, wird ein Teil oder eine

annähernd gleiche Repräsentation eines gespeicherten Elements dazu benutzt um

das ganze Element abzurufen. Anders als bei einem Computer basiert in einem

assoziativen Gedächtnis der Speicherabruf mehr auf dem Inhalt als auf der Adresse

der Speicherstelle. Beispielsweise würde in einem Netzwerkmodell eines

assoziativen Speichers eine komplette Telefonnummer dadurch aufgerufen, dass

anfänglich nur einige Ziffern der Nummer als Anhaltspunkt angegeben werden. In

solchen Netzwerken sind die rückwärtsgekoppelten synaptischen Gewichte so

eingestellt, dass das Netzwerk ein Menge von diskreten Fixpunkten hat, die (fast)

identisch mit dem Speicherinhaltrepräsentierenden Aktivitätsmuster sind. In vielen

Fällen wird die Dynamik des Netzwerks durch die Lyapunovfunktion (Gleichung 2)

bestimmt, vorausgesetzt Fixpunkte existieren. Um nicht unnötig viele Informationen

zu speichern, entsprechen die Fixpunkte genau oder zumindest annähernd genau

dem Muster der Informationen. Während eines Speicheraufrufs wird in einem

assoziativen Gedächtnisnetzwerk die Mustererkennung derart berechnet, dass die

Fixpunkte gefunden werden die dem Anfangszustand des Netzwerkes am

ähnlichsten sind. Jedes Speichermuster hat einen Einzugsbereich (basin of

attraction), welcher durch die Menge der anfänglichen Aktivitätsmuster, die zu dem

jeweiligen Fixpunkt konvergieren, definiert ist. Dieser Einzugsbereich bestimmt die

Ausleseeigenschaften des Netzwerks.

3

Assoziative Gedächtnisnetzwerke könne durch Neuronen hergestellt werden, deren

Aktivität entweder mit stetigen oder mit binären (on/off) Werten charakterisiert wird.

Wir betrachten ein Netzwerk mit Neuronen stetiger Aktivitätswerte welches durch

τr

dv s

= −v + F ( h + M ⋅ v) mit h = 0 , ( h = W ⋅ u)

dt

(5)

beschrieben wird. Um dieses Modell für die Informationsspeicherung nutzen zu

können, definieren wir eine Mustermenge mit der Bezeichnung v m , ( m = 1,2,..., N mem ),

der sowohl für die Speicherung als auch für den Speicheraufruf genutzt wird. Hierbei

stellt v m den Vektor mit der Nummer m dar. Ein assoziativer Speicheraufruf erfolgt

indem das Netzwerk in einem Anfangszustand gestartet wird, der einem der

Informationsmuster ähnlich ist. D.h. v (0) ≈ v m für ein m, wobei das „ ≈" bedeutet, dass

der Startwert v (0) in der Nähe von v m liegt. Das Netzwerk verhält sich entsprechend

der Gleichung 5. Wenn der Datenaufruf erfolgreich ist, dann konve rgiert die Dynamik

des Netzwerks zu einem Fixpunkt, der dem Informationsmuster gleich oder

zumindest bedeutend ähnlicher als der Anfangsstatus v (0) ist, d.h. v (t ) → v m für

große t . Ein Datenaufruf misslingt entweder wenn der erreichte Fixpunkt v m nicht

gleicht oder ein Fixpunkt erst gar nicht erreicht wird.

Für einen genauen Datenaufruf ist es notwendig, dass v m ein Fixpunkt der

Netzwerkdynamik ist bzw.

v m = F (M ⋅ v m )

(6)

erfüllt.

Die Kapazität eines Netzwerkes ist beispielsweise durch die Anzahl verschiedener

Vektoren bestimmt, die bei geeigneter Wahl von M gleichzeitig Gleichung 6 erfüllen.

Bei großen N v (= Anzahl Neuronen im Netzwerk) ist die Netzwerkkapazität

typischerweise proportional zu N v . Neben der Kapazität des Netzwerks ist auch die

Anzahl der Fixpunkte für die Leistungsfähigkeit eines assoziativen

Speichernetzwerks von Bedeutung. Die Leistungsfähigkeit des Netzwerks wird durch

Fixpunkte, die nicht durch Speichermuster entstanden sind, herabgesetzt. Für

effiziente Musterabgleichung ist für jeden der Fixpunkte ein geeignet große r

Einzugsbereich notwendig.

Im Folgenden gehen wir von Neuronen im Netzwerk aus, die sich binär verhalten

(aktiv/inaktiv) obwohl sie stetige Werte des Aktivitätszustandes liefern könnten.

Inaktive Neuronen entsprechen Nullen und aktive Neuronen einer Konstanten c in

den Komponenten von v m . Zur Vereinfachung nehmen wir an, dass das Muster

genau α N v aktive und (1 − α ) N v inaktive Neuronen besitzt. Die Auswahl der aktiven

Neuronen ist zufällig und unabhängig von anderen Mustern. Hierbei stellt α die

Spärlichkeit (sparseness) dar. Je kleiner α ist, desto spärlicher sind die Muster.

Hierdurch können zwar mehr Muster gespeichert werden, jedoch nur auf Kosten

eines geringeren Informationsgehaltes pro Muster.

Um ein assoziatives Speichernetzwerk herzustellen konstruieren wir eine Matrix so,

dass die Informationsmuster die Gleichung 6 erfüllen. Zunächst gehen wir davon aus

4

eine Matrix K zu kennen, für die alle Muster degenerierte Eigenvektoren mit dem

Eigenwert λ darstellen,

K ⋅ v m = λv m , ∀m .

(7)

Danach betrachte n wir die Matrix

M =K−

nn

1

oder M aa ' = K aa' −

αN v

αN v

(8)

Hierbei ist n = (1,1,...,1) der 1-Vektor mit N v Einsen. Der Term nn stellt die

gleichförmige Inhibition zwischen Netzwerkneuronen dar. M erfüllt für jedes

Informationsmuster v m die

M ⋅ v m = λv m − cn .

(9)

Die rechte Seite des Terms folgt aus der Tatsache, dass n ⋅ v m = cαN v ist. Bearbeitet

man die Gleichung 6 komponentenweise für diese Matrix, so bilden sich zwei

Bedingungen: die erste für die Komponenten i mit v im = 0 die Null und die andere für

die Komponenten i von v im = c sind,

F ( −c ) = 0 und c = F (c (λ − 1)) .

(10)

Es ist vergleichsweise einfach Bedingungen zu finden, für die diese Gleichungen

eine Lösung haben. Für positive c ist die erste Bedingung, mit einer rektifizierende

Aktivierungsfunktion F ( I ) = 0 , mit I ≤ 0 , automatisch erfüllt. Für alle F ' ( I ) = 0 , mit

positiven I wird die zweite Gleichung (von Gleichung 10) erfüllt und die Gleichung 5

würde für c > 0 einen stabilen Fixpunkt als Lösung haben, wenn beispielsweise

λ > 1, ( λ − 1) F ' (0) > 1 und F ( c( λ − 1)) langsamer wachsen als c (für große c ).

Das Problem ein assoziatives Speichernetzwerk zu konstruieren besteht darin, die

Matrix K aus Gleichung 7 oder zumindest eine mit ähnlichen Eigenschaften zu finden.

Sehen wir voraus, dass die Neuronen mit Wahrscheinlichkeit α aktiv sind, d.h. deren

Ausgabewert auf c gesetzt ist, so ist die Wahrscheinlichkeit, dass dasselbe Neuron

in zwei verschiedenen Informationsmuster n und m aktiv ist gleich α 2 . Daraus folgt,

dass v n ⋅ v m ≈ α 2 c 2 N v , für n ≠ m. Würde einem der beiden Informationsmuster

entsprechender Vektor v m mit dem Vektor v n − αcn mittels Skalarprodukt

multipliziert, so wäre für m = n ( v n − α cn) ⋅ v m = c 2αN v (1 − α ) und für m ≠ n wäre

( v n − αcn ) ⋅ v m ≈ c 2α N v (α 2 − α 2 ) = 0 . Hieraus folgt, dass die Matrix

K=

Nmem

λ

v n (v n − αcn)

∑

2

c αN v (1 − α ) n=1

(11)

ähnliche Eigenschaften hat wie die Matrix in Gleichung 7, d.h. K ⋅ v m ≈ λv m , ∀m .

5

Erinnern wir uns noch einmal daran, dass die Lyapunovfunktion in Gleichung 3 nur

dann zusichert, dass das Netzwerk Fixpunkte hat, wenn es eine untere Schranke hat

und die Matrix M symmetrisch ist. Die Beschränkung der Lyapunovfunktion kann

durch Sättigung der Aktivierungsfunktion erreicht werden. Die rückwärtsgekoppelte

Gewichtsmatrix K , die man durch das Einsetzen des Ausdrucks aus Gleichung 11 in

Gleichung 8 erhält, scheint nicht symmetrisch zu sein. Eine Form des Ausdrucks

kann hergestellt werden, in dem man

M i, j =

Nmem

λ

nn

(vin − αcn)( v nj − αcn ) −

∑

2

c αN v (1 − α ) n=1

αN v

(12)

verwendet. Durch das Hinzufügen dieser zusätzlichen Terme in den

Summenausdruck (über die Muster) sind die Bedingungen aus Gleichung 10, die für

die Nutzung von Gleichung 12 erfüllt sein müssen, verändert zu

F ( −c (1 + αλ )) = 0 und c = F (c (λ − 1 − αλ)) .

(13)

Eine Möglichkeit die rückwärtsgekoppelte Gewichtsmatrix in Gleichung 12 zu

betrachten ist die vom Standpunkt einer Lernregel, die dazu benutzt wurde um die

Matrix herzustellen. Bei dieser Lernregel wird zur Verbindung zweier Neuronen ein

exzitatorischer Beitrag immer dann hinzugefügt, we nn beide Neuronen bei einem

bestimmten Informationsmuster entweder aktiv oder inaktiv sind. Ein inhibitorischer

Ausdruck wird hinzugefügt, wenn ein Neuron aktiv und die andere inaktiv ist. Die mit

Gleichung 12 verbundene Lernregel wird wegen ihrer Beziehung zu der

Kovarianzmatrix der Informationsmuster als Kovarianzregel bezeichnet.

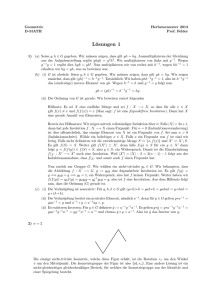

Abbildung 1: Aufruf eines Informationsmusters in einem assoziativen Speichernetzwerkmodell mit

50 Neuronen. (A) zeigt die Feurungsraten zweier repräsentativer Neuronen (oben Neuronaktivität

einer nicht-null- und unten Neuronaktivität einer null-Komponente des Informationsmusters). (B) und

(C) zeigen die Feurerungsraten aller 50 Neuronen, wobei die Dicke der Striche proportional zur

Feuerrate ist. In beiden Fällen konvergiert die Aktivität nach anfänglich zufälliger Aktivität der

Netzwerkneuronen zu dem jeweiligen Muster in (B) und C. Die Endmuster ähneln jeweils dem

gespeicherten Informationsmuster. Das Modell benutzt die Matrix aus Gleichung 12 mit α = 0.25,

λ = 1.25

und

F ( I ) = 150 Hz [tanh(( I + 20 Hz / 150Hz )) ]+ .

6

Die Abbildung 1 zeigt ein assoziatives Speichernetzwerk mit 50 = N v Neuronen unter

der Verwendung der Matrix aus Gleichung 12, das vier Muster speichert. Zwei dieser

Muster sind zufällig und um sie in der Abbildung leichter zu finden sind die beiden

anderen Muster sind nicht zufällig generiert. Ihr Aufruf ist in der Abbildung 1B und 1C

gezeigt. Von einem anfänglichen Muster der Aktivität gleicht es nur undeutlich einem

der gespeicherten Muster. Das Netzwerk erreicht einen Fixpunkt, der der

bestmöglichen Angleichung zu dem gespeicherten Informationsmuster sehr nahe

kommt. Wendet man die gleiche Prozedur auf die beiden anderen vom Netzwerk

gespeicherten Informationsmuster, so sind sie schwerer in der Abbildung zu

erkennen.

Die Matrix M von Gleichung 12, die wir als Basis für die Herleitung eines

assoziativen Speichernetzwerks benutzt haben, erfüllt die Bedingungen für genaue

Speicherung und das Auslesen von Informationsmustern nur annäherungsweise.

Diese Matrix führt einige Fehler in den Datenaufruf ein. Mit steigender Anzahl der zu

speichernden Muster verschlechtert sich die Approximation sowie die

Leistungsfähigkeit des assoziativen Speichers und senkt die Anzahl der

Informationen, die gespeichert werden können. Die einfache Beschreibung der

Kovarianz der Gewichte in Gleichung 12 ist weit vom Optimum entfernt. Andere

Vorschriften zur Erstellung von M können bedeutend höhere Speicherkapazitäten

ermöglichen.

Die Essenz der Untersuchung von assoziativen Gedächtnis Netzwerken ist, dass

große Netzwerke große Anzahl von Mustern speichern können insbesondere wenn

sie spärlich sind ( α klein ist) und beim Auslesen einige Fehler toleriert werden

können. Die Kapazität von bestimmten assoziativen Speichernetzwerken kann

analytisch berechnet werden. Die Anzahl der Informationsmuster, die gespeichert

werden können ist in der Größenordnung, wenngleich typischerweise kleiner als der

Neuronenanzahl in dem Netzwerk N v sowie abhängig von der Spärlichkeit

(sparseness) α . Die Menge der Information, die gespeichert werden kann ist

proportional zu N v2 , was annähernd der Anzahl der im Netzwerk befindlichen

Synapsen entspricht, wobei die gespeicherte Information je Synapse, d.h. die

Proportionalitätskonstante, typischerweise relativ klein ist.

Exzitatorisch-Inhibitorische Netzwerke

In diesem Abschnitt werden Modelle besprochen, in denen exzitatorische und

inhibitorische Neurone voneinander getrennt durch die

dv

τ E E = −v E + FE (hE + M EE ⋅ v E + M EI ⋅ v I ) und

(14)

dt

dv

τ I I = −v I + FI ( hI + M II ⋅ v I + M IE ⋅ v E )

(15)

dt

beschrieben werden. Diese Modelle sind dynamischer als die

Einzelpopulationsmodelle mit symmetrisch gekoppelten Matrizen. In Modellen mit

exzitatorisch-inhibitorischen Subpopulationen sind die synaptischen

Gewichtsmatrizen nicht symmetrisch, wodurch im Netzwerk Oszillationen entstehen

können. Wir analysieren nun ein Modell mit gleichförmig exzitatorisch-inhibitorischen

Populationen. Wir betrachten Methoden, die feststellen ob das Modell eine konstante

oder oszillierende Aktivität hervorbringt. Danach werden zwei Modelle besprochen, in

7

denen Oszillationen entstehen. Das erste ist ein Modell des Bulbus olfaktorius und

das zweite zeigt eine selektive Verstärkung in einem oszillierenden Modus.

Homogene Exzitatorische und Inhibitorische Populationen

Um die Dynamik in einem exzitatorisch-inhibitorischen Netzwerk zu veranschaulichen

analysieren wir ein einfaches Modell in welchem alle exzitatorischen Neurone durch

eine einzelne Feuerrate v E und die inhibitorischen mit einer zweiten Feuerrate v I

beschrieben werden. Obwohl wir uns dieses Modell als eine Interaktion zwischen

Neuronenpopulationen vorstellen, ist es so aufgebaut als ob es sich um nur zwei

Neurone handelt. Die Gleichung 14 und 15, zusammen mit den überschwelligen

linearen Antwortfunktionen, beschreiben diese zwei Feuerraten mit

τE

dv E

= −v E + [M EE v E + M EI v I − γ E ]+ und

dt

(16)

τI

dv I

= −v I + [M II v I + M IE v I − γ I ]+ .

dt

(17)

In diesem Modell sind die synaptische n Gewichte M EE , M IE , M EI und M II als Zahlen

und nicht als Matrizen zu verstehen. In diesem Beispiel seien M EE = 1.25, M IE = 1,

M EI = −1, M II = 0, γ E = −10Hz, γ I = 10Hz, τ E = 10 ms und τ I wird variiert. Der

negative Wert von γ E bedeutet hier nur, dass sie eine konstante Hintergrundaktivität

darstellt und keinen Schwellenwert.

Phase-Plane Methoden und Stabilitätsanalyse

Das durch die Gleichung 16 und 17 dargestellte Modell der Interaktion von

exzitatorisch und inhibitorischen Populationen bietet sich die Gelegenheit einige

Techniken, die zur Untersuchung der Dynamik der nichtlinearen Systeme nötig sind

zu veranschaulichen. Dieses Modell weist in Abhängigkeit von den Werten der

Parameter sowohl Fixpunkt- (konstantes v E und vI ) als auch oszillierende Aktivität

auf. Stabilitätsanalyse dient dazu um herauszufinden welche Parameterwerte zu

einem Übergang zwischen den beiden Formen der Aktivität führt.

Die Feuerraten v E (t ) und v I (t ) aus den Gleichungen 16 und 17 können als eine

Funktion der Zeit dargestellt werden, wie sie in Abbildung 3A und 4A zu sehen sind .

Eine andere nützliche Darstellung ist die paarweise Darstellung von v E (t ) und v I (t )

für ein Definitionsbereich von t -Werte n ( Abbildung 3B und 4B). Mit Änderung der

Feuerrate zeichnet sich eine Kurve bzw. Trajektorie in der v E - v I -Ebene ab, die als

die Phasenebene („phase plane“) des Modells bezeichnet wird. Die grafische

Darstellung von Phasenebenen gibt ein geometrisches Abbild der Dynamik eines

Modells wieder.

Von besonderem Interesse in der Phasenebenenanalyse sind die Werte für v E und

vI , für die die rechte Seite der Gleichungen 16 und 17 Null wird. Eine Reihe von

dv E

dv I

Werten für v E und vI (für die gilt

= 0 und

= 0 ), bilden zwei Linien in der

dt

dt

Phasenebene die als Nullkline bezeichnet werden. Die Nullklinen der Gleichungen 16

und 17 sind die geraden Linien in der Abbildung 2A. Die Nullklinen sind wichtig, weil

8

sie die Phasenebene in Gebiete einteilen mit gegensätzlichen Flussmustern. Das ist

dv E

dv I

so, weil wie in den Gleichungen 16 und 17 nachvollziehbar

und

auf der

dt

dt

einen Seite ihrer Nullkline positiv und auf der anderen negativ sind. Entlang der

dv E

Nullkline ist

gleich, oberhalb kleiner und unterhalb größer Null. Analog ist

dt

dv I

entlang der Nullkline

gleich, rechts kleiner und links größer Null. Diese Werte

dt

bestimmen die Flussrichtung in der Phasenebene und sind in der Abbildung 2A als

vertikale und horizontale Pfeile zu sehen. Typischerweise verringert sich die

Flussrate, wenn die Trajektorie der Phasenebene sich einer Nullkline nähert.

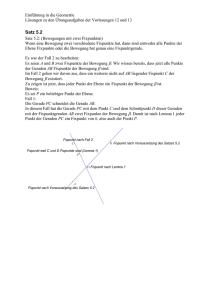

Abbildung 2: (A) Nullklinen, Flussrichtungen und Fixpunkt des Feuerratenmodells von

interagierenden exzitatorisch und inhibitorischen Neuronen. (B) der Real- (oben) und Imaginärteil

(unten) des Eigenwertes der die Stabilität des Fixpunkts bestimmt.

An einem Fixpunkt eines dynamischen Systems bleiben die Werte der

veränderlichen Variablen konstant. In diesem besprochenen Modell entsteht ein

dv E dv I

Fixpunkt wenn die Feuerraten v E und vI Werte annehmen für die

=

= 0 ist.

dt

dt

Dieser Fall tritt nur an der Schnittstelle der Nullklinen auf. In unserem Beispiel tritt

das bei v E = 26.67 und v I = 16.67 auf (aufgefüllter Kreis in der Mitte der Abbildung

2A). Ein Fixpunkt liefert zwar eine potentiell statische Konfiguration, jedoch ist es von

entscheidender Wichtigkeit ob der Fixpunkt stabil oder instabil ist. Wenn ein Fixpunkt

stabil ist werden die anfänglich in seiner Nähe befindlichen Werte von v E und vI über

die Zeit zu ihm hingezogen. Im Falle eines instabilen Fixpunktes wird das System bei

nur annähernd genauen Feuerraten von v E und vI vom Fixpunkt weggedrückt, es

sei denn die Feuerraten von v E und vI sind von Anfang an mit unendlicher

Genauigkeit auf die Werte des Fixpunktes gesetzt, denn dann bleibt das System

unbegrenzt im Fixpunkt.

Lineare Stabilitätsanalyse kann dazu benutzt werden um zu bestimmen, ob ein

Fixpunkt stabil ist oder nicht. Um diese Analyse durchzuführen benutzen wir

dv E

dv I

Abkömmlinge der Ausdrücke

und

, die dadurch entstehen indem die rechte

dt

dt

9

Seite der Gleichung 16 durch τ E und die der Gleichung 17 durch τ I dividiert wird.

Danach werden die dem Fixpunkt entsprechenden Werte für v E und vI in diese

Ausdrücke eingesetzt. Die auf diese Weise berechneten vier Terme werden dann in

einer Matrix angeordnet.

( M EE − 1) / τ E

M IE / τ I

M EI / τ E

( M II − 1) / τ I

(18)

Die Stabilität des Fixpunktes ist bestimmt durch die Realteile der Eigenwerte dieser

Matrix. Die Eigenwerte berechnen sich nach

M − 1 M II − 1

λ = EE

+

±

τI

τE

2

M EE − 1 M II − 1

4 M EI M IE

+

−

τI

τ Eτ I

τE

.

(19)

Wenn der Realteil beider Eigenwerte kleiner bzw. größer Null ist, dann ist der

Fixpunkt stabil bzw. instabil. Wenn der Ausdruck unter der Wurzel positiv ist, so sind

die Eigenwerte reell und das Verhalten Nahe dem Fixpunkt ist exponentiell. D.h. es

findet eine exponentielle Bewegung zum Fixpunkt hin statt, wenn beide Eigenwerte

negativ sind und vom Fixpunkt weg, wenn beide Eigenwerte positiv sind. Im Falle des

negativen Radikanden ist die Quadratwurzel eine imaginäre Zahl und die Eigenwerte

bilden ein komplex konjugiertes Paar. In diesem Falle ist das Verhalten des Systems

in der Nähe des Fixpunktes oszillierend und die Trajektorie windet sich bei negativem

Realteil der Eigenwerte spiralförmig zum Fixpunkt hinein oder bei positiven aus dem

Fixpunkt heraus. Der Imaginärteil des Eigenwertes bestimmt die Frequenz der

Oszillationen Nahe dem Fixpunkt. Der Real- und Imaginärteil von einem der

Eigenwerte ist in Abbildung 2B aufgezeichnet. Diese Darstellung zeigt, dass der

Fixpunkt bei τ I < 40ms stabil und bei größeren Werten für τ instabil ist.

Abbildung 3: Aktivität eines exzitatorisch-inhibitorischen Feuerratenmodells bei stabilem Fixpunkt.

(A) Abklingen der Frequenzschwankungen von

Phasenebenendarstellung.

v E und vI über die Zeit und (B) die zugehörige

10

Abbildung 3 und 4 zeigen Beispiele in denen der Fixpunkt stabil bzw. instabil ist. In

Abbildung 3A sind die Oszillationen von v E und vI gedämpft und die Feuerraten

bewegt sich zu einem stabilen Fixpunkt. Die zugehörige Phasenebenentrajektorie

stellt eine kollabierende Spirale dar ( Abbildung 3B ). In Abbildung 4A wächst die

Oszillation an und in Abbildung 4B ist die Trajektorie eine sich nach außen bis zu

einem Begrenzungskreis immer weiter ausdehnende Spirale. Ein Begrenzungskreis

ist eine geschlossene Umlaufbahn in der Phasenebene, die ein periodisches

Verhalten zeigt. Ohne Rektifizierung der Aktivierungsfunktionen würde sich die

Trajektorie spiralförmig bis ins unendliche ausdehnen. Die Nichtlinearität der

Rektifizierung verhindert, dass die Trajektorie über die Null hinaus expandiert und

stabilisiert auf diese weise den Begrenzungskreis.

Abbildung 4: Aktivität eines exzitatorisch-inhibitorischen Feuerratenmodells bei instabilem Fixpunkt.

(A) periodische Schwankungen der Feuerraten von

Phasenebenendarstellung.

v E und vI über die Zeit und (B) die zugehörige

Es gibt eine Vielzahl von Möglichkeiten wie ein nichtlineares System von einem

stabilen Fixpunkt zu einem Begrenzungskreis übergeht. Solche Übergänge werden

als Bifurkationen (Gabelungen) bezeichnet. Der zwischen Abbildung 3 und Abbildung

4 zu sehende Übergang ist eine Hopfbifurkation. In diesem Fall wird der Fixpunkt bei

Änderung eines Parameters (hier τ I ) instabil, wenn der Realteil des komplexen

Eigenwerts sein Vorzeichen ändert. In einer Hopfbifurkation entsteht der

Begrenzungskreis bei einer endlichen Frequenz, vergleichbar mit dem Verhalten

eines Typ II-Neurons, der anfängt Aktionspotentiale zu feuern. Andere

Bifurkationsformen wiederum zeigen ein Typ I-Verhalten mit Oszillationen bei der

Frequenz von Null. Ein Beispiel für diese Formen ist eine Sattelpunktbifurkation, die

dann entsteht, wenn sich die Parameter derart ändern, dass zwei Fixpunkte, einer

stabil und der andere instabil, sich im gleichen Punkt in der Phasenebene treffen.

Der Bulbus olfaktorius

Der Bulbus olfaktorius und analoge olfaktorische Regionen bei Insekten zeigen

Beispiele sensorischer Verarbeitung, die oszillatorische Aktivität zur Folge haben.

Der Bulbus olfaktorius ist die erste Stufe der Verarbeitung nach der

Geruchsrezeptorebene des Geruchssystems der Vertebraten. Die

Geruchsrezeptoren tragenden Neurone reagieren auf Duftstoffe und senden die

Information über ihre Axone zum Bulbus olfaktorius. Diese Axone enden in den

11

Mitral-, Pinselzellen und lokalen Interneuronen, die Knötchen bilden. Die Mitral- und

Pinselzellen übermitteln die Informationen zur p rimären olfaktorischen Hirnrinde und

haben synaptische Verbindungen zu den Körnerzellen, der größeren Gruppe

inhibierender Zellen. Die Körnerzellen wiederum inhibieren die Mitral- und

Pinselzellen.

Abbildung 5: (A) Aufzeichnung des extrazellulären Feldpotentials im Bulbus olfaktorius bei drei

aufeinander folgenden Riechvorgängen. (B) schematische Darstellung des Bulbus olfaktorius.

Bei vielen Vertebraten ist die Aktivität im Bulbus olfaktorius abhängig vom

Riechvorgang. Durch kurze Riechvorgänge gelangen die Duftstoffe zu den

Geruchsrezeptoren. Während drei kurzen aufeinander folgenden Riechvorgängen

sieht man in der Aufzeichnung des extrazellulär gemessenen Potentials drei

entsprechende große Ausschläge ( Abbildung 5). Uns interessieren hier jedoch die

kleineren Schwankungen höherer Frequenz, die durch oszillierende neurale

Aktivitäten entstehen und jeden der großen Ausschläge umgeben. Einzelne

Körnerzellen haben niedrige Feuerraten und feuern nicht bei jedem Zyklus der

Oszillation. In die phasensynchronen Oszillationen im Bulbus feuern verschiedene

Neurone zwar zu festen Zeitpunkten sind jedoch phasenverschoben zueinander.

Weiterhin werden durch verschiedenartige Düfte Unterschiede in den Amplituden und

Phasen hervorgerufen.

Li und Hopfield haben 1989 die Mitral- und Körnerzellen des Bulbus olfaktorius als

einen nichtlinearen inputgesteuerten Netzwerkoszillator modelliert. Abbildung 5B

zeigt die Architektur dieses Modells, dass die Gleichungen 14 und 15 (mit

M EE = M II = 0 ) benutzt . Diese fehlenden Verbindungen stimmen mit der Anatomie

des Bulbus überein und die Feuerraten von v E bzw. vI entsprechen denen von den

Mitral- bzw. Körnerzellen.

Die Abbildung 6A zeigt die Aktivierungsfunktionen des Modells. Die Zeitkonstanten

der Populationen von Körner- bzw. Mitralzellen sind gleich: τ E = τ I = 6.7 ms. h E

repräsentiert den von den Geruchsrezeptoren zu den Mitralzellen kommenden und

hI den konstanten vom olfaktorischen Kortex zu den Körnerzellen absteigenden

Input.

12

Abbildung 6: Aktivierungsfunktionen und Eigenwerte des Modells des Bulbus olfaktorius. (A)

Aktivierungsfunktionen der Mitral- ( FE ) und Körnerzellen ( FI ). (B) Real- (links) und Imaginärteil des

Eigenwertes, dass bestimmt ob das Modell ein Fixpunkt- oder Oszillationsverhalten annimmt.

Das Feldpotential in Abbildung 6A zeigt die Oszillationen während jedes einzelnen

Riechvorgangs ohne die dazwischen liegenden Phasen. Um das Model diesem

Aktivitätsmuster anzupassen, muss h E einen Übergang zwischen Fixpunkt und

schwingender Aktivität induzieren. Vor einem Riechvorgang muss das Netzwerk

einen stabilen Fixpunkt mit niedriger Aktivität annehmen. Mit Ansteigen von h E durch

einen Riechvorgang muss dieser ausgeglichene Zustand instabil werden und zu

einer oszillierenden Aktivität führen. Die Stabilitätsanalyse des Fixpunktes und das

Einsetzen der Oszillation ist vergleichbar mit unserer vorherigen Stabilitätsanalyse

des Modells verknüpfter exzitatorischer und inhibitorischer Neurone. Die

vergleichbarkeit beruht auf den Eigenwerteigenschaften der linearen

Stabilitätsmatrix. In diesem Fall umfasst die Stabilitätsmatrix den Beitrag der am

Fixpunkt berechneten Ableitungen der Aktivierungsfunktionen. Damit der Fixpunkt

instabil wird, muss der Realteil von mindestens einem der in dieser Analyse

berechneten Eigenwerte größer als 1 werden. Damit Oszillationen entstehen, muss

der Imaginärteil von mindestens einem der destabilisierenden Eigenwerte ungleich

Null sein. Diese Anforderungen prägen der Verbindung zwischen den Mitral- und

Körnerzellen sowie den Inputs Nebenbedingungen auf.

Die Abbildung 6B zeigt die Änderung des Real- und Imaginärteils des releva nten

Eigenwertes λ während eines Riechvorgangs. Nach etwa 100 ms wird der Realteil

von λ größer als 1. Der zu diesem Zeitpunkt gemessene Imaginärteil zeigt, dass er

im Netzwerk etwa 40 Hz hervorruft. Nach etwa 300 ms des Riechvorgangs sinkt der

Realteil von λ unter 1 und infolgedessen hören die Oszillationen auf. Der Input h E

erhöht bei diesem Vorgang zum einen durch Änderung des Fixpunktortes auf der

Aktivierungsfunktion in Abbildung 6A den Eigenwert λ über 1 und zum anderen

destabilisiert es ein bestimmtes Neuron, das dann zu oszillieren anfängt. Das

endgültige Muster oszillatorischer Aktivität ist sowohl durch den Input h E als auch

die Rückkopplungen des Netzwerks bestimmt.

Die Abbildung 7 zeigt das Verhalten des Netzwerks während eines Riechvorgangs

mit zwei unterschiedlichen Düften, die durch zwei unterschiedliche h E -Werte

repräsentiert werden. Die oberen Zeilen zeigen die Aktivität von vier Mitral- und die

unteren von vier Körnerzellen an. Die Amplituden und die Phasen der Oszillationen

13

zusammen mit den Erkennungsmerkmalen der beteiligten Mitralzellen zeigen eine

Signatur der Identität der gerochenen Düfte.

Abbildung 7: Aktivitäten von vier Mitral- (oben) und vier Körnerzellen (unten) während eines

Riechvorgangs von zwei unterschiedlichen Duftstoffen.

Oszillator ische Verstärkung

Zum Schluss betrachten wir ein Beispiel für Netzwerkoszillationen, indem wir die

Verstärkung des Inputs in einem rückwärtsgekoppelten Netzwerk betrachten. Zwei

Faktoren regeln die Menge von selektiver Verstärkung , die in rückwärtsgekoppelten

Netzwerken existieren kann. Die wichtigste Forderung an die rückwärtsgekoppelten

Gewichte ist, dass das Netzwerk so stabil ist, dass die Aktivität nicht unbeschränkt

anwachsen kann. Eine andere mögliche Anforderung deutet sich durch die

Abbildung 8A und B an.

Abbildung 8: Selektive Verstärkung in einem rückwärtsgekoppelten Netzwerk mit Rektifizierung. (A)

Aufzeichnung von

h (θ ), mit θ als den bevorzugten Winkel. (B) Gleichgewichtszustand des Outputs

v (θ ) , mit θ als den bevorzugten Winkel.

In der Abbildung 8 zeigt der Output eine abgestimmte Antwort obwohl der Input zum

Netzwerk eine nur von θ abhängige konstante Funktion ist. Ein abgestimmter Output

ohne einen abgestimmten Input könnte als Speicherungsmechanismus benutzt

werden. Jedoch ist dieser Mechanismus problematisch, denn würde beispielsweise

dieser Mechanismus in dem primär sensorischen Areal auftreten, so würde er eine

andauernde Wahrnehmung hervorrufen obwohl der Reiz nicht mehr da wäre. Die

Vermeidung dieses Mechanismus im Netzwerk würde die rückwärtsgekoppelten

Gewichten sowie das Ausmaß der Verstärkung, das unterstützt werden könnte,

begrenzen.

14

Li und Dayan haben 1999 gezeigt, dass diese Einschränkung durch die Benutzung

der Dynamik von Netzwerken mit gekoppelten inhibitorischen und exzitatorischen

Neuronen wesentlich gelockert werden kann. Die Abbildung 9 zeigt ein Beispiel mit

stetiger Neuronenkennzeichnung, das auf eine stetige Version der Gleichung 14 und

15 beruht. Der Input im abgestimmten Fall ist h E (θ ) = 8 + 5 cos( 2θ ) ( Abbildung 9C) und

nicht abgestimmten Fall h E (θ ) = 8 im (Abbildung 9C). Rauschen mit einer

Standardabeichung von 0.4 stört diesen Input. Der Input ist über die Zeit konstant.

Sowohl auf konstanten als auch auf abgestimmten Input oszilliert das Netzwerk.

Abbildung 9A zeigt den Durchschnittswert der Oszillationsaktivitäten der

Netzwerkneurone über die Zeit als eine Funktion ihrer bevorzugten Winkel zum einen

mit Abstimmung des Inputs auf Rauschen (durchgezogene Linie) und zum anderen

ohne Abstimmung des Inputs auf Rauschen (gestrichelte Linie).

Abbildung 9: Selektive Verstärkung in einem exzitatorisch-inhibitorischem Netzwerk. (A) Über die

Zeit gemittelte Antwortaktivität des Netzwerks auf eine abgestimmten (durchgezogene Linie) und nicht

abgestimmten Input (gestrichelte Linie). ’x’ und ’o’ markieren die 0° bzw. -37° Punkte die in (B) und (C)

dargestellt sind. (B) und (C) zeigen die Aktivitäten der Neurone, die 0° bzw. -37° bevorzugenden. Die

auf Gleichung 14 und 15 beruhenden Parameter sind τ E = τ I = 10ms, hI = 0, M EI = −δ (θ − θ ' ) / ρ 0 ,

M EE = (1/ πρ0 )[5.9 + 7.8 cos( 2(θ − θ ' )) ]+ , M IE = 13.3 / πρ0 , M II = 0 .

Auf den abgestimmten Input antworten die Neuronen auf eine hochgradig

angepasste und verstärkende Art und Weise. Bis auf die Verstärkung ist die

durchschnittliche Antwort der Neuronen auf den nicht abgestimmten Input

unabhängig von θ . Die Abbildung 9B und 9C zeigen die Aktivität der einzelnen

Neurone mit θ = 0° (´o`) bzw. θ = −37° (´x`) über die Zeit für den abgestimmten bzw.

nicht abgestimmten Input. Das Netzwerk bildet keine andauernde Wahrnehmung,

weil der Output auf ein nicht abgestimmten Input ebenfalls nicht abgestimmt ist. Im

Gegensatz dazu produziert eine nicht-oszi llierende Form dieses Netzwerks mit

τ I = 0 ein gleichmäßig abgestimmte n Output als Antwort auf einen nicht

abgestimmten Input mit einer rückwärtsgekoppelten Gewichte derselben Stärke. Auf

diese Weise kann das oszillierende Netzwerk in einer Ordnung von hochgradig

selektiver Amplifikation arbeiten ohne falsch abgestimmte Aktivität zu produzieren.

15