Kapitel 6 Verteilungsparameter

Werbung

Kapitel 6

Verteilungsparameter

Wie bei einem Merkmal wollen wir nun die Lage und die Streuung der Verteilung einer diskreten Zufallsvariablen durch geeignete Maßzahlen beschreiben.

Beginnen wir mit Maßzahlen für die Lage.

6.1

6.1.1

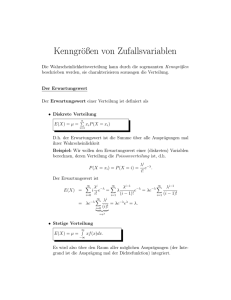

Der Erwartungswert

Diskrete Zufallsvariablen

In der Datenanalyse haben wir den Mittelwert eines diskreten Merkmals mit

den Merkmalsausprägungen a1 , . . . , ak und zugehörigen relativen Häufigkeiten h1 , . . . , hk folgendermaßen berechnet:

x̄ =

k

ai hi .

i=1

Die folgende Definition überträgt dieses Konzept auf eine diskrete Zufallsvariable X mit Wahrscheinlichkeitsfunktion fX (x).

Definition 6.1

Sei X eine diskrete Zufallsvariable mit Wahrscheinlichkeitsfunktion fX (x)

und Träger TX . Der Erwartungswert E(X) von X ist definiert durch

E(X) =

x fX (x)

(6.1)

{x|x∈TX }

Beispiel 54 (fortgesetzt)

Wir betrachten die Anzahl XMädchen in Familien mit zwei Kindern. Es gilt

E(X) = 0 · 0.25 + 1 · 0.5 + 2 · 0.25 = 1 .

159

KAPITEL 6. VERTEILUNGSPARAMETER

160

Beispiel 61

Tversky und Kahneman fragten Personen, welche der beiden folgenden Alternativen sie vorzögen.

Alternative A

Man erhält eine sichere Auszahlung von $ 240.

Alternative B

Mit Wahrscheinlichkeit 0.25 erhält man eine Auszahlung von $ 1000 und mit

Wahrscheinlichkeit 0.75 keine Auszahlung.

Wir wollen zunächst untersuchen, ob eine der beiden Situationen günstiger

ist. Die Konsequenz von Alternative A ist klar. Wir erhalten auf jeden Fall

$ 240.

Wir betrachten für Alternative B die Auszahlung X. Es gilt

P (X = 0) = 0.75

P (X = 1000) = 0.25 .

Es gilt

E(X) = 0 · 0.75 + 1000 · 0.25 = 250 .

Bei Alternative A haben wir eine sichere Auszahlung von $ 240 und bei

Alternative B eine erwartete Auszahlung von $ 250. Obwohl die erwartete

Auszahlung bei Alternative B höher ist, entschieden sich 84 Prozent der von

Tversky und Kahneman befragten Personen für Alternative A.

6.1.2

Stetige Zufallsvariablen

Definition 6.2

Sei X eine stetige Zufallsvariable mit Dichtefunktion fX (x). Der Erwartungswert E(X) von X ist definiert durch

∞

E(X) =

x fX (x) dx .

−∞

Beispiel 59 (fortgesetzt)

Es gilt

∞

E(X) =

10

x fX (x) dx =

−∞

0

x2 10

x 0.1 dx = 0.1

= 5.

2 0

(6.2)

6.1. DER ERWARTUNGSWERT

161

Beispiel 60 (fortgesetzt)

Es gilt

∞

E(X) =

∞

x fX (x) dx =

−∞

=

lim

x→∞

xe

−x

dx = − x e

0

−x

∞

0

∞

−

−e−x dx

0

∞

−x −1

−x

+

−

e

= lim x + (0 − (−1)) = 1

x

x→∞ e

e

0

Der Erwartungswert einer Zufallsvariablen muss nicht existieren.

Beispiel 62

Die Zufallsvariable X besitze die Dichtefunktion

1

für x > 1

x2

fX (x) =

0 sonst

Der Erwartungswert von X existiert nicht. Dies sieht man folgendermaßen:

∞

1

6.1.3

∞

1

x 2 dx = ln x

→∞

x

1

Erwartungswerte von Funktionen von Zufallsvariablen

Ist X eine diskrete Zufallsvariable mit Wahrscheinlichkeitsfunktion fX (x)

und g(X) eine Funktion von X. Dann können wir den Erwartungswert von

g(X) dadurch bestimmen, dass wir die Wahrscheinlichkeitsfunktion von g(X)

und über diese den Erwartungswert von g(X) bestimmen. Wir können den

Erwartungswert von g(X) aber auch bestimmen, ohne die Wahrscheinlichkeitsfunktion von g(X) herzuleiten. Es gilt nämlich

E(g(X)) =

{x|x∈TX }

g(x) fX (x)

(6.3)

KAPITEL 6. VERTEILUNGSPARAMETER

162

Beispiel 58 (fortgesetzt)

Wir betrachten nun noch einmal die Position X des Teilchens, das sich auf

den ganzen Zahlen bewegt. Es gilt

−3

x

P (X = x) 0.125

−1

1

3

0.375

0.375

0.125

Hieraus folgt

E(|X|) = | − 3| · 0.125 + | − 1| · 0.375 + |1| · 0.375 + |3| · 0.125 = 1.5 .

Wir können diesen auch mit der Wahrscheinlichkeitsfunktion von Y = |X|

bestimmen. Es gilt P (Y = 1) = 0.75 und P (Y = 3) = 0.25. Hieraus folgt

E(Y ) = 1 · 0.75 + 3 · 0.25 = 1.5 .

Bei einer stetigen Zufallsvariablen X mit Dichtefunktion fX (x) bestimmen

wir den Erwartungswert einer Funktion g(X) folgendermaßen:

∞

E(g(X)) =

g(x) fX (x) dx .

(6.4)

−∞

Beispiel 59 (fortgesetzt)

Wir suchen den Erwartungswert von X 2 . Es gilt

E(X 2 ) =

∞

x2 fX (x) dx =

−∞

10

0

x3 10 100

x2 0.1 dx = 0.1

=

.

3 0

3

Beispiel 60 (fortgesetzt)

Es gilt

2

∞

E(X ) =

∞

2

x fX (x) dx =

−∞

x2

= lim − x + 2

x→∞

e

2 −x

x e

dx = − x e

0

∞

xe−x dx = lim −

x→∞

0

2 −x

∞

0

∞

−

2x(−e−x ) dx

0

2x

2

+

2

=

lim

−

+2=2

x→∞

ex

ex

6.1. DER ERWARTUNGSWERT

6.1.4

163

Eigenschaften des Erwartungswerts

Der folgende Satz zeigt, wie sich der Erwartungswert unter linearen Transformationen verhält.

Satz 6.1

Sei X eine Zufallsvariable mit Wahrscheinlichkeitsfunktion bzw. Dichtefunktion fX (x) und a und b reelle Zahlen. Dann gilt

E(a X + b) = a E(X) + b

.

(6.5)

Beweis:

Wir zeigen den diskreten Fall.

E(a X + b) =

{x|x∈TX }

=

a x fX (x) +

{x|x∈TX }

= a

(a x + b) fX (x) =

(a x fX (x) + b fX (x))

{x|x∈TX }

b fX (x)

{x|x∈TX }

x fX (x) + b

{x|x∈TX }

fX (x)

{x|x∈TX }

= a E(X) + b

Mit

g(x) = a x + b

gilt also

E(g(X)) = g(E(X)).

Dies gilt aber nicht immer, wie das folgende Beispiel zeigt.

Beispiel 59 (fortgesetzt)

Es gilt

E(X 2 ) =

und

100

3

E(X)2 = 25

Nun gilt

E(X 2 ) − E(X)2 =

25

100 75

−

=

.

3

3

3

KAPITEL 6. VERTEILUNGSPARAMETER

164

Also ist bei der Gleichverteilung

E(X 2 ) > E(X)2 .

Oft betrachtet man die Zufallsvariable Y = X − E(X). Man sagt auch, dass

man die Zufallsvariable X zentriert. Es gilt

E(X − E(X)) = 0 .

(6.6)

Setzen wir in Gleichung (6.5) a = 1 und b = −E(X), so gilt

E(X − E(X)) = E(X) − E(X) = 0

.

Der Erwartungswert einer zentrierten Zufallsvariablen ist also gleich 0. Bei

einer zentrierten Zufallsvariablen sieht man also sofort, welche Werte kleiner

und welche größer als der Erwartungswert sind.

Die folgende Eigenschaft des Erwartungswertes benötigen wir im nächsten

Kapitel.

Satz 6.2

X sei eine Zufallsvariable mit Erwartungswert E(X). Außerdem seien g und

h reellwertige Funktionen. Dann gilt

E(g(X) + h(X)) = E(g(X)) + E(h(X))

Beweis:

Wir zeigen den diskreten Fall.

E(g(X) + E(h(X)) =

(6.7)

(g(x) + h(x)) fX (x)

{x|x∈TX }

=

(g(x)fX (x) + h(x)fX (x))

{x|x∈TX }

=

g(x)fX (x) +

{x|x∈TX }

h(x)fX (x)

{x|x∈TX }

= E(g(X)) + E(h(X))

Die Aussage des Satzes gilt auch, wenn wir mehr als zwei Funktionen von X

betrachten. Sind also g1 , . . . , gk reellwertige Funktionen, so gilt

E

k

i=1

gi (X) =

k

i=1

E(gi (X))

(6.8)

6.2. DIE VARIANZ

6.2

165

Die Varianz

Der Erwartungswert einer Zufallsvariablen X ist ein Maß für die Lage von X.

Neben der Lage der Verteilung einer Zufallsvariablen X ist auch die Streuung

von Interesse.

Für eine Urliste x1 , . . . , xn ist die mittlere quadratische Abweichung d2 folgendermaßen definiert:

n

1 =

(xi − x)2

n i=1

2

d

Wir bestimmen hier den Mittelwert der quadratierten Abweichungen der Beobachtungen vom Mittelwert. Ersetzen wir in diesem Satz Mittelwert durch

Erwartungswert und Beobachtungen durch Zufallsvariable, so erhalten wir

folgende Definition:

Definition 6.3

Sei X eine Zufallsvariable. Die Varianz V ar(X) von X ist definiert durch

V ar(X) = E([X − E(X)]2 )

(6.9)

Wir berechnen die Varianz im diskreten Fall also durch

V ar(X) =

[x − E(X)]2 fX (x)

(6.10)

{x|x∈TX }

und im stetigen Fall durch

∞

V ar(X) =

[x − E(X)]2 fX (x) dx

(6.11)

−∞

Wir wählen für die Varianz oft die Abkürzung σ 2 .

Die Varianz

besitzt nicht die gleiche Maßeinheit wie X, die Standardabwei

chung V ar(X) hingegen doch. Wir kürzen im folgenden die Standardabweichung mit σ ab.

KAPITEL 6. VERTEILUNGSPARAMETER

166

Beispiel 63

Im Beispiel 61 auf Seite 160 haben wir zwei Alternativen betrachtet. Bei Alternative A erhalten wir $ 240. Wir bezeichnen die zugehörige Zufallsvariable

mit X. Es gilt

P (X = 240) = 1

Bei Alternative B erhalten wir mit Wahrscheinlichkeit 0.25 $ 1000 und mit

Wahrscheinlichkeit 0.75 nichts. Wir bezeichnen die zugehörige Zufallsvariable

mit Y . Es gilt

P (Y = 0) = 0.75

P (Y = 1000) = 0.25

Es gilt E(X) = 240 und E(Y ) = 250. Obwohl der Erwartungswert von Alternative B höher ist, entscheiden sich 84 Prozent der Befragten für Alternative

A. Dies liegt an der unterschiedlichen Streuung. Offensichtlich gilt

V ar(X) = 0 .

Für Y gilt

V ar(Y ) = (0 − 250)2 · 0.75 + (1000 − 250)2 · 0.25 = 187500

Die zweite Alternative hat die größere Varianz. Tversky und Kahneman stellen fest, dass die meisten Personen in Situationen mit möglichem Gewinn

nicht risikofreudig sind. Bei möglichen Verlusten ist dies anders. Tversky

und Kahneman fragten Personen, welche der beiden folgenden Alternativen

sie vorzögen.

Alternative A

Man hat einen sicheren Verlust von $ 750.

Alternative B

Mit Wahrscheinlichkeit 0.75 verliert man $ 1000 und mit Wahrscheinlichkeit

0.25 nichts.

Sei X der Verlust bei Alternative A und Y der Verlust bei Alternative B. Es

gilt

P (X = 750) = 1

und

P (Y = 1000) = 0.75

P (Y = 0) = 0.25 .

6.2. DIE VARIANZ

167

Somit gilt E(X) = 750 und E(Y ) = 750. In beiden Fällen ist der erwartete Verlust gleich hoch. Die Varianz ist bei Alternative A gleich 0 und bei

Alternative B:

V ar(Y ) = (0 − 750)2 · 0.25 + (1000 − 750)2 · 0.75 = 187500 .

In diesem Fall entscheiden sich 87 Prozent der Befragten für Alternative B.

Der folgende Satz zeigt, wie man die Varianz einfach berechnen kann.

Satz 6.3

Sei X eine Zufallsvariable mit Varianz V ar(X). Dann gilt

V ar(X) = E(X 2 ) − E(X)2

(6.12)

Beweis: Mit Gleichung (6.8) auf Seite 164 gilt:

V ar(X) = E([X − E(X)]2 ) = E(X 2 − 2XE(X) + E(X)2 )

= E(X 2 ) − E(2XE(X)) + E(E(X)2 )

= E(X 2 ) − 2E(X)E(X) + E(X)2

= E(X 2 ) − E(X)2

Beispiel 63 (fortgesetzt)

Wir berechnen die Varianz der Zufallsvariablen Y mit Hilfe von (6.12). Es

gilt P (Y = 1000) = 0.75, P (Y = 0) = 0.25 und E(Y ) = 750. Weiterhin gilt

y 2 P (Y = y) = 02 · 0.25 + 10002 · 0.75 = 750000 .

E(Y 2 ) =

y

Also gilt

V ar(Y ) = E(Y 2 ) − E(Y )2 = 750000 − 7502 = 187500

Beispiel 59 (fortgesetzt)

Für die Gleichverteilung gilt E(X) = 5 und E(X 2 ) = 100/3. Also gilt

V ar(X) = E(X 2 ) − E(X)2 =

100

25

−5=

.

3

3

Beispiel 60 (fortgesetzt)

Für die Exponentialverteilung mit λ = 1 gilt E(X) = 1 und E(X 2 ) = 2.

Also gilt

V ar(X) = E(X 2 ) − E(X)2 = 2 − 1 = 1 .

168

KAPITEL 6. VERTEILUNGSPARAMETER

Schauen wir uns an wie sich die Varianz einer Zufallsvariablen X ändert,

wenn X linear transformiert wird. Ist X eine Zufallsvariable und a und b

reelle Zahlen, dann gilt:

V ar(a X + b) = a2 V ar(X)

.

(6.13)

Dies sieht man folgendermaßen:

V ar(a X + b) = E [a X + b − E(a X + b)]2

= E [a X + b − a E(X) − b]2 = E [a (X − E(X))]2

= E a2 [X − E(X)]2 = a2 E [X − E(X)]2

= a2 V ar(X)

Auf Seite 164 haben wir zentrierte Zufallsvariablen betrachtet. Der Erwartungswert einer zentrierten Zufallsvariablen ist gleich 0. Sei X eine Zufallsvariable mit E(X) = µ und V ar(X) = σ 2 . Wir betrachten die Zufallsvariable

Z=

X −µ

σ

.

(6.14)

Man nennt Z standardisierte Zufallsvariable. Es gilt

E(Z) = 0

(6.15)

und

V ar(Z) = 1

.

(6.16)

Schauen wir uns erst Beziehung (6.15) an:

1

X −µ

= E(X − µ) = 0 .

E(Z) = E

σ

σ

Beziehung (6.16) gilt wegen (6.13):

1

1

X −µ

= 2 V ar(X − µ) = 2 V ar(X) = 1 .

V ar(Z) = V ar

σ

σ

σ

6.3. DIE TSCHEBYSCHEFF-UNGLEICHUNG

6.3

169

Die Tschebyscheff-Ungleichung

Bisher haben wir die Frage noch nicht beantwortet, wann eine Varianz klein

odwer groß ist. Dies wollen wir jetzt nachholen. Wir betrachten zunächst eine

nichtnegative Zufallsvariable Y . Es gilt also P (Y = y) = 0 für y < 0.

Ist a eine positive reelle Zahl, so gilt

P (Y ≥ a) ≤

E(Y )

a

.

(6.17)

Dies ist die Markow-Ungleichung. Wir beweisen sie für eine stetige Zufallsvariable Y mit Dichtefunktion fY (y) am Ende dieses Unterkapitels. Vorerst schauen wir uns aber an, welche Folgerungen man aus der MarkowUngleichung ziehen kann.

Ist X eine Zufallsvariable mit E(X) = µ und V ar(X) = σ 2 . Wir betrachten

die Zufallsvariable Y = (X − µ)2 . Da diese nichtnegativ ist, können wir die

Markow-Ungleichung anwenden. Es gilt also

P ((X − µ)2 ≥ a) ≤

Wegen

√

und

E([X − µ]2 )

.

a

c2 = |c|

V ar(X) = E((X − µ)2 )

ist dies äquivalent zu:

P (|X − µ| ≥ a) ≤

V ar(X)

.

a

Setzen wir a = k 2 σ 2 mit k > 0, so gilt:

P (|X − µ| ≥ k σ) ≤

1

k2

.

(6.18)

Gleichung (6.18) ist die Tschebyscheff-Ungleichung. Diese erlaubt es, die

Wahrscheinlichkeit abzuschätzen, dass eine Zufallsvariable X Werte im Intervall (µ − k σ, µ + k σ) annimmt. Multiplizieren wir beide Seiten von Gleichung (6.18) mit −1 und addieren 1, so erhalten wir folgende Ungleichung:

1 − P (|X − µ| ≥ k σ) ≥ 1 −

1

k2

(6.19)

KAPITEL 6. VERTEILUNGSPARAMETER

170

Auf der linken Seite von Gleichung 6.19 zeigt die Wahrscheinlichkeit des

Komplementärereignisses von |X − µ| ≥ k σ. Dieses ist |X − µ| < k σ. Also

gilt

P (µ − k σ < X < µ + k σ) ≥ 1 −

1

k2

Für k = 1, 2, 3 gilt also

P (µ − k σ < X < µ + k σ) ≥

0

3

4

8

9

für k = 1

für k = 2

für k = 3

Bei jeder Zufallsvariablen X liegen also mindestens 75 Prozent der Werte im

Intervall (µ − 2 σ, µ + 2 σ). Bei speziellen Verteilungen kann dieser Wert aber

bedeutend größer sein.

Beispiel 59 (fortgesetzt)

Bei der Gleichverteilung auf [0, 10] gilt σ = 25/3 = 2.87. Hieraus folgt

µ − 2 σ = 5 − 2 · 2.87 = −0.74

und

µ + 2 σ = 5 + 2 · 2.87 = 10.74 .

Somit liegen alle Werte im Intervall [µ − 2 σ < X < µ + 2 σ].

Beispiel 60 (fortgesetzt)

Bei der Exponentialverteilung mit λ = 1 gilt µ = 1 und σ = 1. Hieraus folgt

P (µ − 2 σ < X < µ + 2 σ) = P (1 − 2 · 1 < X < 1 + 2 · 1)

= P (−1 < X < 3) = FX (3) − FX (−1)

= 1 − e−3 − 0 = 0.9502

und

P (µ − 3 σ < X < µ + 3 σ) = P (1 − 3 · 1 < X < 1 + 3 · 1)

= P (−2 < X < 4) = FX (4) − FX (−2)

= 1 − e−4 − 0 = 0.9817

6.4. QUANTILE

171

Nun noch der Beweis der Markow-Ungleichung. Es gilt

∞

E(Y ) =

a

∞

y fY (y)dy =

0

y fY (y)dy +

0

∞

a

∞

y fY (y)dy ≥ a

≥

a

yfY (y)dy

fY (y)dy = a P (Y ≥ a)

a

Also gilt

E(Y ) ≥ a P (Y ≥ a) .

Hieraus folgt

P (Y ≥ a) ≤

6.4

E(Y )

.

a

Quantile

Im Kapitel 2.2.2 haben wir empirische Quantile betrachtet. Das p-Quantil ist

der Wert, der von 100·p Prozent der Beobachtungen nicht überschritten wird.

Bei einem stetigen Merkmal gilt F̂ (xp ) = p. Wir wollen Quantile hier nur

für stetige Zufallsvariablen betrachten, bei denen die Verteilungsfunktion auf

dem Träger streng monoton wachsend ist. Dies ist bei den Verteilungen in den

Beispielen 59 und 60 der Fall. In Analogie zur Empirie ist das (theoretische)

Quantil xp der Wert, für den gilt FX (xp ) = p.

Beispiel 59 (fortgesetzt)

Der Träger der Gleichverteilung auf [0, 10] ist das Intervall [0, 10]. Hier gilt

FX (x) = 0.1 x .

(6.20)

Um das Quantil xp zu bestimmen, setzen wir xp für x in die Gleichung (6.20)

ein und erhalten:

FX (xp ) = p = 0.1 xp .

Lösen wir diese Gleichung nach xp auf, so erhalten wir

xp = 10 · p

So ist das untere Quartil der Gleichverteilung auf [0, 10] gleich x0.25 = 10 ·

0.25 = 2.5.

KAPITEL 6. VERTEILUNGSPARAMETER

172

Beispiel 60 (fortgesetzt)

Für die Exponentialverteilung mit Parameter λ = 1 ist der Träger das Intervall [0, ∞). Hier gilt

FX (x) = 1 − e−λx .

(6.21)

Um das Quantil xp zu bestimmen, setzen wir xp für x in die Gleichung (6.21)

ein und erhalten:

FX (xp ) = p = 1 − e−λxp .

Diese Gleichung können wir nach xp auflösen:

p = 1 − e−λxp ⇐⇒ e−λxp = 1 − p ⇐⇒ −λxp = ln (1 − p)

1

⇐⇒ xp = − ln (1 − p)

λ

So ist der Median der Exponentialverteilung mit λ = 1 gleich x0.5 = ln 0.5 =

−0.693.

Wir werden später oftmals die standardisierte Zufallsvariable

Z=

X −µ

σ

betrachten. Dabei ist µ der Erwartungswert und σ 2 die Varianz von X. Ist

xp das p-Quantil von X, so gilt für das p-Quantil zp von Z

zp =

xp − µ

σ

.

(6.22)

Wir haben zu zeigen:

P (Z ≤

xp − µ

)=p

σ

Dies sieht man folgendermaßen:

P (X ≤ xp ) = p ⇔ P (X − µ ≤ xp − µ) = p ⇔ P (

xp − µ

X −µ

≤

)=p

σ

σ

xp − µ

)=p

σ

Wir können zp natürlich auch aus xp bestimmen, indem wir Gleichung 6.22

nach zp auflösen. Wir erhalten

⇔ P (Z ≤

xp = µ + zp σ

.

(6.23)