Stochastic kurz und knapp

Werbung

Stochastic kurz und knapp

Holger Karl

Nach: S. M. Ross, Introduction to Probability

and Statistics for Engineers and Scientists,

3rd. ed., Elsevier.

Computer Networks Group

Universität Paderborn

Wahrscheinlichkeit

• „In diesem Gebiet gibt es mit 60% Wahrscheinlichkeit Öl!“

• Interpretation 1:

• Sprecher hält das Vorkommen von Öl für plausibler als das NichtVorkommen; 60% ist eine Aussage über sein Vertrauen in den

Wahrheitsgehalt der Aussage

• Sog. subjektive Interpretation

• Interpretation 2:

• Wenn man ganz viele gleichartige Gebiete nimmt, dann wird man

in 60% dieser Gebiete Öl finden und in 40% nicht

• Sog. Häufigkeitsinterpretation

• Uns interessiert nur Interpretation 2!

v 1.1

Stochastik kurz und knapp

2

Von Häufigkeiten zu Wahrscheinlichkeiten

• Häufigkeiten: Beobachtungen über Anzahl von bestimmten

Ereignissen

• Insbes. „zufällige“ Ereignisse – kein Determinismus vorhanden

oder erkennbar

• Wahrscheinlichkeit: Formalisierung der Intuition

• Von Beobachtung tatsächlicher Ereignisse losgelöst

• Wahrscheinlichkeitstheorie: Entwickeln von Rechenregeln

v 1.1

Stochastik kurz und knapp

3

Experiment, Ereignisse, Ereignisraum

• Gedankliche (!) Grundlage: Ein Experiment mit zufälligem

Resultate

• Ereignisraum (sample space) S: Menge aller möglichen

Resultate

• Münzwurf, S = {Kopf, Zahl}

• Würfelwurf, S = {1, ..., 6}

• Wettrennen mit n Teilnehmer; S = {Alle Permutation der Zahlen

1, .., n}

• Teilmengen des Ereignisraums sind Ereignisse (event)

• Mit naheliegender Interpretation der Mengenoperationen

v 1.1

Stochastik kurz und knapp

4

Wahrscheinlichkeit

• Wahrscheinlichkeit: Ereignissen werden Zahlen zwischen 0

und 1 zugeordnet

• Genauer: Jeder Teilmenge des Ereignisraums (= jedem Ereignis)

wird eine Zahl zwischen 0 und 1 zugeordnet

• Geschrieben als Funktion P: 2S ! [0, 1]

• P für Probability

• ... mit folgenden Einschränkungen

• 0 <= P(E) <= 1 für alle E

• P(S) = 1

• P ([ Ei) = ∑ P(Ei) für alle Ei ½ S mit Ei Ej = 0

v 1.1

Stochastik kurz und knapp

5

Bedingte Wahrscheinlichkeit

• Angenommen, uns interessiert P(E)

• Wir wissen, dass ein anderes Ereignis F eingetreten ist

• Hilft uns das bei P(E)?

E

F

• Notation: Uns interessiert

P(E|F)

• Wahrscheinlichkeit von E, wenn

F schon eingetreten ist

• Angenommen, wir kennen P(F)

• Dann ist P(E|F) Wahrscheinlichkeit von E und F, normiert

auf Wahrscheinlichkeit von F

v 1.1

Stochastik kurz und knapp

6

Bedingte Wahrscheinlichkeit – Beispiel

• Urne enthält Dreiecke und Fünfecke

Aufdruck

=1

Dreiecke

40

2

2

Aufdruck

=2

1

20

1

10

30

2

1

1

2

1

2

Fünfecke

2

1

1

2

• Ziehen mit verbundenen Augen!

Berechne P(Aufdruck = 1 | Fünfeck gezogen)

v 1.1

Stochastik kurz und knapp

7

Bedingte Wahrscheinlichkeiten liefern

Fallunterscheidungen

• Angenommen, wir wollen Wahrscheinlichkeit P(A) eines

Ereignisses A berechnen

• Wir kennen die Wahrscheinlichkeiten anderer Ereignisse Bi, von

denen A abhängt

• Sowie die bedingten Wahrscheinlichkeiten P(A|Bi)

• Wenn die Bi alle Möglichkeiten abdecken und disjunkt sind,

kann man P(A) als Fallunterscheidung ausrechnen

• Formal: [ Bi = S, Bi Bj = 0

• Satz von der totalen Wahrscheinlichkeit

v 1.1

Stochastik kurz und knapp

8

Zufallsvariablen

• Oft: Nicht alle Details eines

Ereignisses relevant

• Formalisiert: Zufallsvariable

• Zufallsvariablen bilden

Ereignisse auf Werte ab

• Beispiel: Würfelwurf mit 20

Würfeln – alle Ereignisse

aufzählen ziemlich mühselig

• Sind also eigentlich Funktionen

• Praktisch: Wesentliche

Eigenschaften eines Ereignisses

benennen und Ereignis dadurch

definieren

• Eigenschaft meist numerisch

• Beispiel: Ereignis = Alle

Wurfkombinationen, bei denen

die Augensumme 25 ist

v 1.1

• Konvention: Geschrieben mit

großen lateinischen Buchstaben;

Werte mit kleinen lateinischen

Buchstaben

• Die Wahrscheinlichkeit, dass

eine Zufallsvariable einen Wert

„annimmt“, ist die Summe der

Wahrscheinlichkeiten, dass ein

entsprechendes (Elementar-)

Ereignis eintritt

Stochastik kurz und knapp

9

Typen von Zufallsvariablen

Diskrete Zufallsvariable

Kontinuierliche

Zufallsvariablen

• Nehmen Werte aus

diskreter Menge an

• Nehmen Werte aus einer

kontinuierlichen Menge an

• Z.B. jede endlich Menge,

natürliche Zahlen, ...

• Z.B. die reellen Zahlen

• Haben eine

Verteilungsfunktion

• Haben eine

Verteilungsfunktion

• FX(x) = P (X <= x)

• FX(x) = P (X <= x)

• Haben eine Zähldichte

• Haben eine Dichte

• fX(x) = P(X = x)

• Beispiel: P(X=1) = 0.3 ;

P(X=5) = 0.7 ; P(X=3) = 0

v 1.1

• fX(x) = FX‘(x)

• Achtung: P(X=x) sinnlos!

Stochastik kurz und knapp

10

Gemeinsam verteilte Zufallsvariablen

• Für ein Experiment kann man mehrere Zufallsvariablen

definieren

• Beispiel: X = Anzahl Zigaretten pro Tag, Y = Alter bei

Lungenkrebsbeginn

• Da auf gleichem Experiment (und entsprechenden

Ereignissen) definiert, haben sie eine gemeinsame

Verteilungsfunktion

v 1.1

Stochastik kurz und knapp

11

Unabhängige Zufallsvariable

• Gemeinsame verteilte Zufallsvariablen X, Y können

spezielles Verhalten haben:

Der Wahrscheinlichkeit für X hat keine Relevanz für den

Wahrscheinlichkeiten von Y u.u.

• Formal: X, Y heißen unabhängig g.d.w.

v 1.1

Stochastik kurz und knapp

12

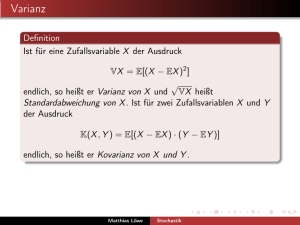

Erwartungswert

• X diskret: E[X] = ∑i xi fX(xi) ,

wobei xi alle möglichen Werte von X annimmt

• Analog: E[g(X)] = ∑i g(xi) fX(xi)

• X kontinuierlich: E[X] = s x x fX(x) dx ,

wobei x alle möglichen Werte von X annimmt

• Analog: E[g(X)] = s x g(x) fX(x) dx

• Erwartungswert ist linear, additiv

v 1.1

Stochastik kurz und knapp

13

Some discrete random distributions

!

• Bernoulli distribution

• Flip a coin, heads / success

with probability p, tails with

probability 1-p

• Discrete uniform DU(i,j )

• All numbers between i and j

(inclusive) occur with the same

probability

!

• Binomial bin(n,p)

• Number of heads of n

independent Bernoulli

experiments with probability p

v 1.1

if x ∈ [0,..., n]

⎧ p

f X ( x) = ⎨

⎩ 1 − p otherwise

⎧ 1

⎪

f X ( x) = ⎨ j − i + 1

⎪⎩ 0

if x ∈ [i,..., j ]

otherwise

⎧⎛ n ⎞ x

⎪⎜⎜ ⎟⎟ p (1 − p) n − x if x ∈ [0,..., n]

f X ( x) = ⎨⎝ x ⎠

⎪

0

otherwise

⎩

Stochastik kurz und knapp

14

Some discrete random distributions

!

• Geometric geo(p): When

tossing a Bernoulli coin with

success probability p, the

number of consecutive failures

( tails ) before the first success

is geometrically distributed

• Negative binomial (s, p):

Number of failures of

independent Bernoulli

experiments with probability p

before s successes have

occurred

v 1.1

⎧ p (1 − p) x if x ∈ [0,1,...]

f X ( x) = ⎨

otherwise

⎩ 0

⎧⎛ s + x − 1⎞ s

⎟⎟ p (1 − p) x if x ∈ [0,1,...]

⎪⎜⎜

f X ( x) = ⎨⎝ x ⎠

⎪ 0

otherwise

⎩

Stochastik kurz und knapp

15

Some discrete random distributions

!

• Poisson (λ): Number of events

occurring in an interval of unit

time, when the time between

events is distributed

exponentially with parameter λ

v 1.1

⎧ e − λ λx

⎪

f X ( x) = ⎨ x!

⎪⎩ 0

Stochastik kurz und knapp

if x ∈ [0,1,...]

otherwise

16

Some continuous distributions

!

!

• Uniform U(a,b): R.v. varies

between a and b, without

preference for any particular

values.

U(0,1) is fundamental for

generating random values of all

other distributions!

• Exponential exp(λ): Time

between occurrence of events,

when events happen with a

constant rate (= number of

events per time interval).

Compare Poisson distribution

v 1.1

⎧ 1

⎪

f X ( x) = ⎨ b − a

⎪⎩ 0

if a ≤ x ≤ b

otherwise

⎧ 1 − x / λ

⎪ e

if x ≥ 0

f X ( x) = ⎨ λ

⎪⎩0

otherwise

⎧1 − e− x / λ

FX ( x ) = ⎨

⎩ 0

Stochastik kurz und knapp

if x > 0

else

17

Some continuous distribution

• Gamma (α,β): Time to complete

some task, generalizes

exponential distribution

• Weibull (α,β): Time to complete

some task

v 1.1

⎧ β −α xα −1e − x / β

⎪

f X ( x) = ⎨

Γ(α )

⎪⎩

0

α

⎧⎪1 − e −( x / β )

FX ( x) = ⎨

⎪⎩

0

Stochastik kurz und knapp

if x > 0

else

if x > 0

else

18

Some continuous distributions

!

• Normal (µ,σ): often describes

effects well that are the sum of a

large number of other quantities

f X ( x) =

1

2πσ 2

e

− ( x − µ ) 2 /( 2σ 2 )

• Lognormal (µ,σ): Time to

complete some task (similar to

Gamma and Weibull for α > 1,

with an additional spike close to

x=0

1

⎧

− (ln x − µ ) 2 /( 2σ 2 )

e

⎪

2

f X ( x) = ⎨ x 2πσ

⎪⎩

0

v 1.1

Stochastik kurz und knapp

if x > 0

else

19

Some continuous distributions

• Pareto (α): Time between task

arrivals (compare exponential)

•

v 1.1

1

⎧

⎪1 −

α

F

(

x

)

=

Pareto distribution is first

(

1

+

x

)

⎨

X

example of a so-called heavy⎪⎩

0

tailed distribution:

Stochastik kurz und knapp

if x >= 0, α > 0

else

20

Stochastischer Prozess

• Oft: nicht nur einzelne Experimente interessant, sondern

Folgen von Experimenten

• Entsprechend: Folge von Zufallsvariablen

• Formal: Stochastischer Prozess ist eine Folge von

Zufallsvariablen X1, X2, X3, ...

• ... mit vielen Erweiterungen und Spezialfällen

• Wichtige Spezialfälle

• Alle Xi haben die gleiche Verteilungsfunktion

• Alle Xi sind paarweise stochastisch unabhängig

• Beides gilt – die Xi sind dann independent and identically

distributed (i.i.d.)

v 1.1

Stochastik kurz und knapp

21

Stochastischer Prozess – Markov-Kette

• Wichtiger Spezialfall: Markov-Kette

• Eigenschaften

• Zufallsvariablen Xi nehmen nur Werte aus endlicher

Zustandsmenge {s1, ...., sn} an

• Indexmenge sind die natürlichen Zahlen: i 2 N

• Zeit ist diskret – Interpretation: Wert der Zufallsvariable Xi

beschreibt Systemzustand im iten Zeitschritt

• Die Wahrscheinlichkeit, welchen Wert Xi+1 annimmt, hängt NUR

vom Wert von Xi ab

• Die ganze Vorgeschichte Xj, j< i, ist irrelevant

• Formal:

P (Xk+1 = s(k+1) |Xk = s(k) ∧ Xk−1 = sk−1 ∧ · · · ∧ X1 = s(1) )

= P (Xk+1 = s(k+1) |Xk = s(k) )

• Die sog. Markov-Eigenschaft

v 1.1

Stochastik kurz und knapp

22

Markov-Kette – Notation

• Sei M die Zustandsübergangsmatrix

• M = (mij) mit mij = P(X2 = j | X1 = i) = P(Xk+1 = j | Xk = i)

• Matrizen gleich für alle k: homogene Markov-Kette

• Sei π = (π1, ..., πn) ein Zeilenvektor mit n Elementen aus

[0,1], so dass π1+...+πn = 1

• Wir benutzen π(k) als Kurzschreibweise für die Verteilung von Xk,

also π(k)i = P(Xk = i)

• Solche Zeilenvektoren π heißen auch kurz „eine Verteilung der

Markov-Kette“

v 1.1

Stochastik kurz und knapp

23

Zustandsübergänge bei Markov-Ketten

• Es gilt (Satz von der totalen Wahrscheinlichkeit):

n

�

(k+1)

(k)

πj

=

πi mij

i=1

• Oder auch kurz in Matrixschreibweise:

π

• Offenbar gilt:

(k+1)

π

(k)

=π

=π

(k)

(0)

M

M

k

• Die Verteilung des kten Zustandes hängt also nur von M und der

Anfangsverteilung π(0) ab

v 1.1

Stochastik kurz und knapp

24

Gleichgewichtsverteilungen

• Besonders interessant: Verteilungen von Xk, die sich nicht

ändern, wenn ein Schritt der Markov-Kette ausgeführt wird

• Formal: π* heißt stationär bezüglich der Markov-Kette M

wenn gilt

∗

∗

π =π M

• Unter geeigneten Annahmen (irreduzibel, aperiodisch, homogen)

existiert π* und ist eindeutig bestimmt

• Insbesondere: Unabhängig von der Anfangsverteilung π(0) !

• Interpretation: Egal zu welchem Zeitschritt man auf das

System schaut, es wird immer die gleiche Verteilung der

Zustände haben

v 1.1

Stochastik kurz und knapp

25

Finden der Gleichgewichtsverteilungen

• Für manche (irreduzibel, aperiodisch, homogen) Markov ∗

Ketten gilt:

π

k

lim M = · · ·

k→∞

∗

π

• Formaler Beweis: recht technisch

v 1.1

Stochastik kurz und knapp

26

Finden der Gleichgewichtsverteilung II

• Was nützt uns das?

• M ist diagonalisierbar, M= UDU-1;

• D Diagonalmatrix, D = (λ1, ..., λn), U Basiswechselmatrix

• λ1 = 1 ist der betragsgrößte, einfache Eigenwert von M

• Satz von Perron und Frobenius

• D.h.,

• Und:

• Damit:

v 1.1

−1 k

k −1

M k = (U

DU

)

=

U

D

U

1

0

k

lim D =

· · ·

k→∞

0

0

0

···

···

0

···

0

0

0

1

0

k

lim M = U

· · ·

k→∞

0

0

0

···

···

0

···

Stochastik kurz und knapp

0

0

U −1

0

27