Wahrscheinlichkeit

Werbung

1

Aufbau-SE Logik III: Wahrscheinlichkeit (G. Schurz, Ws 2016-17, Mi 10:3012:00, 23.31, U1.46)

Zeitplan:

19.10. Objektive (statistische) vs. subjektive (epistemische) Wahrscheinlichkeit

(Carnap, Reichenbach)

26.10. Mathematische Gesetze der Wahrscheinlichkeit (Kolmogoroff)

02.11. entfällt (Konferenzreise)

09.11. Probabilistische Rechtfertigung von Schlussarten (Suppes, Adams)

16.11. Philosophische Probleme der objektiv-statistischen Wahrscheinlichkeit (von

Mises, Reichenbach, Salmon, Kutschera) - Determinismus und stat. W.

23.11. Philosophische Probleme der subjektiv-epistemischen Wahrscheinlichkeit

(Ramsey, de Finetti, Carnap, Skyrms, Earman, Howson-Urbach)

30.11. Verbindungen von objektiver und subjektiver Wahrscheinlichkeit

(Reichenbach, Carnap, de Finetti, Lewis, Strevens, eigener Ansatz)

07.12. Überprüfung statistischer Hypothesen (Fisher, Neyman)

14.12. Likelihood-Intuition und ihre bayesianische Rechtfertigung (Earman, Gillies)

21.12. Objektiver und subjektiver Bayesianismus (Howson-Urbach, Laplace,

Williamson)

11.01. Induktionsproblem I: No free lunch Theorem (Wolpert)

18.01. Induktionsproblem II: Algorithmische Komplexität (Solomonoff)

25.01. Induktionsproblem III: Metainduktion (eigener Ansatz)

01.02. Zeitpuffer / Wiederholung

08.02. Klausur/BN

1

2

2

Literatur: Das Aufbau-Seminar stützt sich auf mein Buch:

Gerhard Schurz: Wahrscheinlichkeit, De Gruyter, Berlin/Boston 2015

(25 Euro). Siehe:

https://www.amazon.de/Wahrscheinlichkeit-Grundthemen-Philosophie-GerhardSchurz/dp/3110425505)

Weitere Literatur:

Adams, E.W. (1998): A Primer of Probability Logic, CSLI Publications, Stanford.

Bortz, J. (1985): Lehrbuch der Statistik, 2. Aufl., Springer, Berlin (Neuaufl. als

Statistik für Human- u. Sozialwissenschaflter, 6. überarb. Aufl. 2005).

Carnap, R. (1959): Induktive Logik und Wahrscheinlichkeit. Bearbeitet von W.

Stegmüller, Springer, Wien.

Carnap, R. und Jeffrey, R. (1971): Studies in Inductive Logic and Probability, Univ.

of California Press, Berkeley.

Gillies, D. (2000): Philosophical Theories of Probability, Routledge, London.

Earman, J. (1992): Bayes or Bust?, MIT Press, Cambridge/Mass

Howson, C. und Urbach, P. (1996): Scientific Reasoning: The Bayesian Approach,

Open Court, Chicago (2. Aufl.).

Stegmüller, W. (1973b), Probleme und Resultate der Wissenschaftstheorie und

Analytischen Philosophie. Band IV: Personelle und Statistische Wahrscheinlichkeit,

Springer, Berlin.

3

1. Objektive (statistische) vs. subjektive (epistemische) Wahrscheinlichkeit

Geschichte: Theorie der Wahrscheinlichkeit entstand im 16. und 17. Jahrhundert, im

Kontext von Glücksspielen: Galilei, 1654 Briefwechsel Pascal-Fermat, 1657 Huygens, 1713 Bernoulli (Binomialverteilung, Gesetz der großen Zahlen), 1763 Theorem

von Bayes, 1814 Laplace, 1933 axiomatische Fundierung durch Kolmogorov.

Intuitive Begriff der Wahrscheinlichkeit involviert etwas Objektives („wahr-“) und

etwas Subjektives („-scheinlich“).

Erst im 20. Jahrhundert wurde die unterschiedliche Natur der beiden Wahrscheinlichkeitsbegriffe herausgearbeitet.

Frühen Begründer hatten dies nur unzureichend bemerkt.

Laplace (1814) unterschied das subjektive „Gleichverteilungsprinzip“ nicht von der

objektiven Gleichwahrscheinlichkeit der Wurfresultate eines regulären Würfels; erst

von Mises (1928, 69) machte den Unterschied deutlich.

Gegenwärtige Wahrscheinlichkeitstheorie durch eine anhaltende Lagertrennung

gekennzeichnet (vgl. auch Gillies 2000):

in den empirischen Wissenschaften objektiv-statistische Wahrscheinlichkeit

(Begründer von Mises 1964, Reichenbach 1935, 1949, und Fisher 1956; Einführungsliteratur Bortz 1985; Spezialvariante "objektive Einzelfallwahrscheinlichkeit").

in

Philosophie

und

kognitiver

Wissenschaft

subjektiv-epistemische

Wahrscheinlichkeit im Sinn von rationalen Glaubensgraden (Begründer Ramsey

1926 und de Finetti 1934/70; Einführungsliteratur Earman 1992, Howson/Urbach

1996); Spezialvarianten "objektiver Bayesianismus", "logische Wahrscheinlichkeit"

Carnap 1959).

3

4

4

in Mathematik wird Interpretationskonflikt systematisch ignoriert.

Objektive Wahrscheinlichkeit drückt eine subjektunabhängige Eigenschaft der

Realität aus.

Subjektive Wahrscheinlichkeit drückt

Glaubensgrad eines (aktualen oder

hypothetischen) rationalen Subjekts aus.

Wenn es sich dabei um intersubjektive Glaubensgrade handelt, spricht man auch von

„epistemischer“ Wahrscheinlichkeit.

Zur Unterscheidung beider verwenden wir die prädikatenlogische Schreibweise:

"Fx" für "x ist ein F" und „Fa“ für "a ist ein F".

"F" ist ein Prädikat, das wiederholbares (binäres) Merkmal / Ereignistyp F

bezeichnet,

z.B.

"rothaarig

zu

sein".

„x“

Individuenvariable

und

„a“

Individuenkonstante.

(In Mathematik unterscheidet man das nicht formal, schreibt für beides eine binäre

mathematische 'Zufallsvariable' Xï)

Die

statistische

(objektive)

Wahrscheinlichkeit

eines

Merkmals

oder

wiederholbaren Ereignistyps, z.B. Fx, ist die relative Häufigkeit seines Eintretens

bzw. der Grenzwert seiner relativen Häufigkeit auf lange Sicht.

Formal kleines p(): p(Fx) =

Häufigkeit bzw. Häufigkeitsgrenzwert, mit der

beliebige Individuen x eines gegebenen Bereichs die Eigenschaft F besitzen.

Beispiel: Die Häufigkeit von Sonnentagen in Düsseldorf.

Die epistemische (subjektive) Wahrscheinlichkeit eines bestimmten Ereignisses

bzw. Sachverhaltes, z.B. Fa, ist der rationale Glaubensgrad, in dem ein

(oder

mehrere gegebene) Subjekt(e) an das Eintreten des Ereignisses glauben.

Formal großes P(): P(Fa) = der subjektive Glaubensgrad dafür, dass das Individuum

a die Eigenschaft F besitzt.

5

Beispiel: Unser Glaubensgrad, dass der morgige Tag in Düsseldorf ein Sonnentag

sein wird.

Für endlichen Individuenbereich (Population, Grundgesamtheit) D ist die statistische

Wahrscheinlichkeit gleich der relativen Häufigkeit eines Ereignistyps Fx in D:

h(Fx) = Anzahl aller Fs in D geteilt durch die Anzahl aller Individuen in D.

Problem: Endliche Häufigkeiten sind Zufallschwankungen unterworfen; sie geben

nicht direkt die Wahrscheinlichkeitsdispositionen wieder (Beispiel: Münzwurf)

Für unendlichen Individuenbereich D ist die relative Häufigkeit undefiniert.

Man bezieht sich auf eine zufällige Anordnung der Individuen in D in Form einer

(unendlichen) Zufallsfolge (a1,a2,), produziert durch ein "Zufallsexperiment".

Statistische Wahrscheinlichkeit p(Fx) =def limn hn(Fx) = Grenzwert der relativen

Häufigkeiten hn(Fx) von Fs in den n-gliedrigen Anfangsabschnitten einer

Zufallsfolge, für n gegen unendlich.

p(Fx) = 0,6 heißt per definitionen: für jedes noch so kleines >0 gibt es eine

Stellenzahl n, sodass für alle m n die relative Häufigkeit hm(Fx) vom Grenzwert 0,6

um weniger als abweicht

(je kleiner , desto größer n)

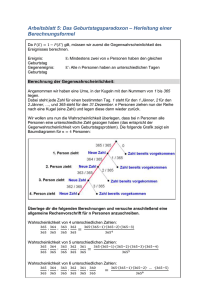

hn(Fx)

limnhn(Fx)=0,6

n

5

6

6

Konvergenz der relativen Häufigkeiten eines Ereignisses mit Häufigkeitsgrenzwert

p(Fx) = 0.6 in zwei Zufallsfolgen (programmiert in Visual Basic).

Häufigkeitsgrenzwerte sind theoretische Idealisierungen p(Fx) = 0.6 bedeutet:

Zufallsexperiment hat gewisse Disposition, Ergebnis Fx mit einer auf lange Sicht

nach 0.6 konvergierenden Häufigkeit zu produzieren („generische Propensität“).

Auch zufälliges Ziehen eines Individuums aus Individuenbereich D ist

Zufallsexperiment.

Zusammenhang: Statistischen Wahrscheinlichkeit, zufällig ein F-Individuum aus D

zu ziehen = endliche Häufigkeit von Fx in D gdw. jedes Individuum in D dieselbe

statistische Chance besitzt gezogen zu werden. (Ziehen mit Zurücklegen)

Zur Interpretation von Eins- und Nullwahrscheinlichkeiten:

Im epistemischen Fall bedeutet die Aussage P(A) = 1, dass sich Subjekt hinsichtlich

der Aussage A sicher ist.

Im statistischen Fall komplizierter:

Nur bei endlichem Individuenbereichs ist p(Fx) = 1 gleichbedeutend mit

ausnahmslosen Allsatz xFx (Alle Individuen sind F), bzw. p(Fx) = 0 mit xFx.

Bei unendlichem Individuenbereichs ist p(Fx) = 1 schwächer als xFx, bedeutet nur,

dass die Häufigkeiten hn(Fx) gegen eins konvergieren.

Beispiel: Sei Zufallsfolge (1, 2,3) und Fx das Prädikat „x ist eine ganzzahlige

Potenz von 2“. Dann gibt unter den natürlichen Zahlen unendlich viele ganzzahlige

2er-Potenzen; dennoch gilt limk p(Fx) = limk(k/2k) = 0.

Grundlegender Unterschied: Statistische Wahrscheinlichkeit p(Fx) bezieht sich

immer auf wiederholbaren Ereignistyp (Sachverhaltstyp) ausgedrückt durch Prädikat

bzw. offene Formel Fx; der Operator "p" bindet die freie Individuenvariable ("px").

7

Subjektive Wahrscheinlichkeit p(Fa) bezieht sich auf

bestimmtes Ereignis

(Sachverhalt) ausgedrückt in einem Satz bzw. einer geschlossenen Formel Fa.

Bekannteste

Prinzip,

um

statistische

Wahrscheinlichkeiten

auf

subjektive

Einzelfallwahrscheinlichkeiten zu übertragen (Reichenbach 1949, §72):

Prinzip der engsten Referenzklasse: Die subjektive Wahrscheinlichkeit P(Fa) eines

Einzelereignisses wird bestimmt als die (geschätzte)

bedingte statistische

Wahrscheinlichkeit p(Fx|Rx) des entsprechenden Ereignistyps Fx in der engsten

(nomologischen) Bezugsklasse bzw. Referenzklasse R, von der das zugrundeliegende

Subjekt 'weiß' bzw. mit Sicherheit glaubt, dass a in ihr liegt (also Ra gilt).

Anwendung in Alltag und Wissenschaft:

Subjektive Wahrscheinlichkeit dafür, dass gegebene Person Autounfall hat

(Versicherungsstatistik): engste bekannte Referenzklasse, die nicht unter Datenschutz

fällt.

Wahrscheinlichkeit dafür, dass es morgen in NRW regnet: engste Referenzklasse =

die vom Meteorologen berücksichtigte vorausgehende Wetterentwicklung.

Bezug zum induktiven Spezialisierungsschluss (Carnap 1950; "direct inference" nach

Levi 1977):

Generelle Prämisse 1: r % aller Fs sind Gs

Singuläre Prämisse 2: Dies ist ein F

===================== [mit r % Glaubenswahrscheinlichkeit]

Konklusion: Dies ist ein G

Prinzip der Gesamtevidenz: die singuläre Prämisse muss die gesamte für die

Konklusion relevante Evidenz enthalten.

Mit Prinzip der engsten Referenzklasse kann nur subjektive Wahrscheinlichkeit

von Singulärsätzen durch statistische Wahrscheinlichkeiten bestimmt werden, nicht

7

8

subjektive W.keit von generellen Hypothesen (Problem des Bayesianismus).

8

9

2. Mathematische Gesetze der Wahrscheinlichkeit

Statistische und der epistemische Wahrscheinlichkeitsbegriff gehorchen denselben

Grundgesetzen (Kolmogorov 1933)

Kolmogorov benutzt die mathematisch übliche mengenalgebraische Darstellung:

Möglichkeitsraum = {e1,e2,.}

Elemente ei von = {e1,e2,}: mögliche (maximal bestimmte) Ergebnisse eines

Zufallsexperimentes.

"Ereignisse" = Teilmengen von , als Disjunktionen aufgefaßt.

Beispiel Würfelwurf:

= {1,2,3,4,5,6} Ergebnis z.B. "1" Ereignis z.B. "gerade Zahl" = {2,4,6}.

Anderes Beispiel: Ziehen eines Individuums aus dem Individuenbereich: = D.

Wir verwenden sprachliche Darstellung (zwecks Unterscheidung von p und P):

Im statistischen Fall:

= Menge möglicher Ergebnistypen eines (wiederholten) Zufallsexperimentes,

dargestellt durch maximal starke offene Formeln der Sprache:

Ei(x)(binäre Zufallsvariable) oder f(x) = ei (mehrstufige Zufallsvariable)

Ereignisse (Teilmengen) dargestellt durch offene Formel (entsprechen Disjunktio

nen maximal starker Formeln, z.B. "Gerade(x)" = "x=2 x=4 x=6".

Im epistemischen Fall:

=

Menge

möglicher

Ergebnisse

eine

einzelnen

Durchführung

des

Zufallsexperimentes, dargestellt durch maximal starke geschlossene Formeln der

Sprache:

Ei(aj)(binäre Zufallsvariable) oder f(aj) = ei (mehrstufige Zufallsvariable).

Teilmengen dargestellt durch geschlossene Formel.

9

10

10

11

Axiome der Wahrscheinlichkeit:

Im folgenden bezeichnen A, B,

offene Formeln im statistischen Wahrscheinlichkeitsaufbau,

geschlossene Formeln im epistemischen Aufbau,

-Teilmengen im mathematischen Aufbau.

Dass A und B disjunkt sind, bedeutet

dass die Extension von AB faktisch (im gegebenen Modell) leer ist ist im

statistischen Aufbau.

dass AB in allen (logisch, epistemisch) möglichen Modellen der Sprache

unerfüllbar ist im epistemischen Aufbau.

dass AB leer istim mathematischen Aufbau.

Zur Erinnerung: entspricht , entspricht , A entspricht A.

Grundaxiome der Wahrscheinlichkeit

Für alle A, B, , wobei statt „p“ auch „P“ stehen kann:

(A1) p(A) 0

(Nicht-Negativität)

In Worten: Wahrscheinlichkeiten sind immer größer-gleich null.

(A2) p(AA) = 1

(Normierung auf 1)

In Worten: die Wahrscheinlichkeit des gesamten Möglichkeitsraumes ist 1.

(A3) Wenn A, B disjunkt sind: p(AB) = p(A) + p(B)

(endliche Additivität)

In Worten: für disjunkte Ereignis(typen) addieren sich die Wahrscheinlichkeiten.

11

12

12

Dass A exhaustiv ist bedeutet dass

A von allen Individuen erfüllt wird im statistischen Aufbau,

A von allen möglichen Modellen wahr gemacht wird im epistemischen Aufbau,

A = gilt im mathematischen Aufbau.

Eine Partition von ist eine Menge {A1,,An} vom wechselseitig disjunkten und

zusammen exhaustiven Ereignissen Ai.

Theoreme unbedingter Wahrscheinlichkeit

(T1) p(A) = 1p(A) (Komplementärwahrscheinlichkeit)

In Worten: Die Wahrscheinlichkeit der Negation eines Ereignisses ist 1 minus jener

des Ereignisses.

(T2) p(A) 1 (obere Schranke)

In Worten: Die Wahrscheinlichkeit jedes Ereignisses ist kleiner-gleich 1.

(T3) p(AA) = 0 (Kontradiktion).

In Worten: Ein Widerspruch besitzt die Wahrscheinlichkeit Null.

(T4) Für jede Partition A1,,An: 1in p(Ai) = 1 und p(B) = 1in p(BAi).

In Worten: Die Summe der Wahrscheinlichkeiten der Ereignisse einerPartition {Ai:

1in} von addiert sich zu 1, und die Ereignisse {AiB: 1in} bilden eine

Partition von B, deren Wahrscheinlichkeiten sich zu p(B) aufaddieren..

(T5) p(A1A2) = p(A1) + p(A2) p(A1A2) (allgem. Additionsgesetz)

(T6) Wenn A1A2 =def A1A2 exhaustiv ist, dann gilt p(A1) p(A2) (Monotonie)

In

Worten:

Wenn

A1

mit

Notwendigkeit

A2

impliziert,

Wahrscheinlichkeitn von A1 kleiner-gleich der von A2.

(T7) Ist A1A2 exhaustiv, dann gilt p(A1) = p(A2) (Äquivalenz)

dann

ist

die

13

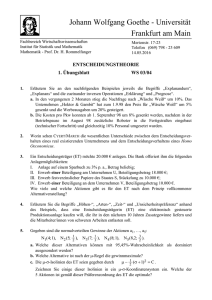

Die Wahrscheinlichkeit von A unter der Annahme, dass B vorliegt, nennt man die

bedingte Wahrscheinlichkeit von A gegeben B, p(A|B) bzw. P(A|B):

(Def. 3-2) Bedingte Wahrscheinlichkeit: p(A|B) =def

p(A B)

, sofern p(B) > 0.

p(B)

(Analog für „P“ anstelle von „p“.)

B = bedingende Ereignis oder Antecedens; B = bedingte Ereignis oder Konsequens.

Im endlich-statistischen Fall ist p(A|B) die relative Häufigkeit von A-Individuen in

der Menge B siehe Abbildung.

A

8

p(Bx|Ax) = 12/20 = 3/5

12

B

4

p(Ax|Bx) = 12/16 = 3/4

|D| = 24, p(Ax) = 20/24 = 5/6

p(Bx) = 16/24 = 2/3

Im unendlich-statistischen Fall ist p(A|B) der Häufigkeitsgrenzwert von As in einer

Zufallsfolge von B-Individuen.

Im subjektiv-epistemischen Fall ist P(A|B) der hypothetische Glaubensgrad an A,

unter der hypothetischen Annahme, dass B sicher wäre.

Wird B tatsächlich mit Sicherheit geglaubt, gilt P(B) = 1 woraus P(A) = P(A|B) folgt.

Subjektive Sicherheit bzgl. A impliziert nicht, dass A wahr ist: subjektiver Glaube

ist fallibel und Glaubensfunktion P ist unabhängig von Wahrheitswertfunktion v.

Hinweis: Gewöhnliche Definition von p(A|B) hat Nachteil, dass p(A|B) für ein 0wahrscheinliches Ereignis B undefiniert.

Carnap 1971, Popper 1935: direkte Axiomatisierung bedingter Wahrscheinlichkeit.

13

14

14

Zwei (binäre) Ereignisse A, B heißen probabilistisch unabhängig voneinander,

abgekürzt AB, g.d.w. p(AB) = p(A)p(B).

Es gilt: AB g.d.w. p(A|B) = p(A) oderp(B) = 0

in Worten: g.d.w. die Annahme von B A‘s Wahrscheinlichkeit nicht ver

ändert, oder Null beträgt.

Ergo: Zwei nicht-nullwahrscheinliche Ereignisse sind probabilistisch abhängig g.d.w.

p(A|B) p(A) gilt.

A und B sind

positiv abhängig, wenn p(A|B) > p(A) (bzw. p(AB) > p(A)p(B))

negativ abhängig, wenn p(A|B) < p(A) (bzw. p(AB) < p(A)p(B)) gilt.

Wichtig ist die Nichtmonotonie bedingter Wahrscheinlichkeiten:

ein hoher Wert von p(A|B) impliziert nicht einen hohen Wert von p(A|BC);

vielmehr kann zugleich p(A|BC) = 0 gelten.

Beispiel:

A

B

BC

C

p(A|B) ist hoch, aber p(A|BC) beträgt Null.

Anderes Beispiel: Die meisten Einwohner Deutschlands essen Schweinefleisch, aber

nicht: Die meisten islamischen Einwohner Deutschlands essen Schweinefleisch.

15

Theoreme bedingter Wahrscheinlichkeit (sofern p(A|B) definiert):

(TB1): Für die auf B konditionalisierte Wahrscheinlichkeitsfunktion

pB(A) =def p(A|B) gelten alle Gesetze der unbedingten Wahrscheinlichkeit.

(TB2:) WennAB exhaustiv ist, dann gilt p(B|A) = 1. Die Umkehrung gilt nicht.

(TB3) p(AB) = p(A|B)p(B)

(TB4) Für jede Partition B1,,Bn giltp(A) = 1in p(ABi) p(Bi)

(allg.

Multiplikationsprinzip). Speziell folgt: p(A) = p(A|B)p(B) + p(A|B)(1p(B))

(TB5) p(A|B) = p(B|A) p(A) / p(B) (Bayes-Theorem, 1. Version)

(TB6) Für jede Partition A1,,An giltp(Ai|B) = p(B|Ai)p(Ai) / 1in p(BAi)p(Ai)

(Bayes-Theorem, 2. Version)

(TB7) Symmetrie der probabilistischen Abhängigkeit (sofern 1 > p(B), p(A) > 0):

p(A|B) > p(A) g.d.w. p(B|A) > p(B) g.d.w. p(A|B) > p(A|B) (analog für )

(TB7) Symmetrie probabilistischer Abhängigkeiten

(TB5), (TB6) Bedeutung bayesscher Theoreme liegt in Situationen, in denen man

an P(Ai|B) interessiert ist, aber nur inverse Wahrscheinlichkeit P(B|Ai) zugänglich ist.

Beispiel 1: Ai um rivalisierende Hypothesen, B ein empirisches Resultat

Beispiel 2: Diagnoseprobleme, B Indikator für eine zu diagnistizierenden Zustand A.

Z.B.: B positiver Krebstestbefund, A Krebskrankheit.

Einfach messbar ist nur p(BA).

p(B|A) die Sensitivität und p(B|A) die Spezifität des Indikators B für A.

p(A|B) Reliabilität und p(A|B) Effizienz des Indikators als Prognoseinstrument

Base rate fallacy: p(A|B) = p(B|A)p(A) / ( p(B|A)p(A) + p(B|A)p(A) )

= 0,950,01 / ( 0,950,01 + 0,950,99) = nur 0,01 !

15

16

16

Statistische Unabhängigkeit, Binomialverteilung und Gesetz der großen Zahl

Unabhängige Wiederholungen desselben (identischen) Zufallsexperiments:

Beispiel: Ergebnisse von n Münzwürfen (x1,,xn), mit xi {Zahl, Kopf}

Sprachlich dargestellt: Fx1Fxn

("F" für "Zahl", "F" für "Kopf")

Vereinbarung: i.te Variable der Formel, von links nach rechts angeordnet,

entspricht i.ter Durchführung des Zufallsexperimentes.

Unabhängigkeit bedeutet physikalisch, dass das Zufallsexperiment im Verlaufe

wiederholter Durchführungen seine Dispositionen nicht ändert (sonst: "MarkovKette").

Statistisches Unabhängigkeitsgesetz für Ereigniskombinationen:

Fx1Gx2, d.h. p(Fx1Gx2) = p(Fx)p(Gx) (Produktgesetz)

In Worten: Statistische Wahrscheinlichkeit, in zwei Durchführungen einmal F und

dann G zu erzielen = Produkt der Wahrscheinlichkeiten, in einmaliger Durchführung

F respektive G zu erzielen.

Mathematische Notation: p(F1,G2) = p(F1)p(G2)

Daraus folgt: p(Gx2|Fx1) = p(Gx2) und p(Fx1|Gx2) = p(Fx1).

Beispiel: Wahrscheinlichkeit, in zwei Würfen einmal eine Sechs und ein anderes Mal

eine gerade Zahl zu würfeln = (1/6)(1/2) = (1/12).

Für subjektiven Wahrscheinlichkeiten kombinierter Ereignisse gilt das

Unabhängigkeitsgesetz im allgemeinen nicht.

Im Gegenteil: sobald das epistemische Wahrscheinlichkeitsmaß induktiv ist, wächst

unser Glaubensgrad dafür, dass das nächste Individuum ein F ist, mit der Häufigkeit

von bisher beobachteten F-Individuen an:

17

Es gilt also P(Fa|Fb) > P(Fa) und somit P(FaFb) > P(Fa)P(Fb).

Erklärung dieses Unterschieds:

In subjektiver Wahrscheinlichkeitstheorie geht man davon aus, dass man

statistische Wahrscheinlichkeit nicht mit Sicherheit kennt.

Ist gegebenen Münze symmetrisch (p = 1/2) oder asymmetrische Münze mit Bias?

Dann induktiv sinnvoll, aus gehäuften Eintreten von Kopf zu schließen, dass die

Münze eher Kopf als Zahl ergibt.

In der statistischen Wahrscheinlichkeitstheorie spricht man nicht über

Glaubensgrade, sondern über statistische Wahrscheinlichkeit selbst und nimmt diese

als gegeben bzw. "bekannt" an.

Für diese gilt aufgrund physikalischen Unabhängigkeitsannahme das Produktgesetz.

D.h. wenn die Münze mit Häufigkeitsgrenzwert r auf Kopf landet, so tut sie dies

unabhängig von vorausliegenden Münzwürfen.

tiefliegende Unterschiede zwischen obj. und subj. W.keit)

Aus statistischen Produktgesetz folgt Binomialgesetz (oder Bernoulli Gesetz) für nfache-Durchführung eines Zufallsexperimentes, bzw. Ziehen von n-elementigen

Zufallsstichproben:

Sei p = p(Fx), hn(Fx) = relative Häufigkeit von Fx in n-elementiger Zufallsstichprobe:

Binomialformel: p( hn(Fx) = kn ) = nk pk (1p)nk .

n

n!

k („n über k“) =

= Anzahl der Möglichkeiten, aus n Individuen k

k! (n - k)

auszuwählen.

17

18

18

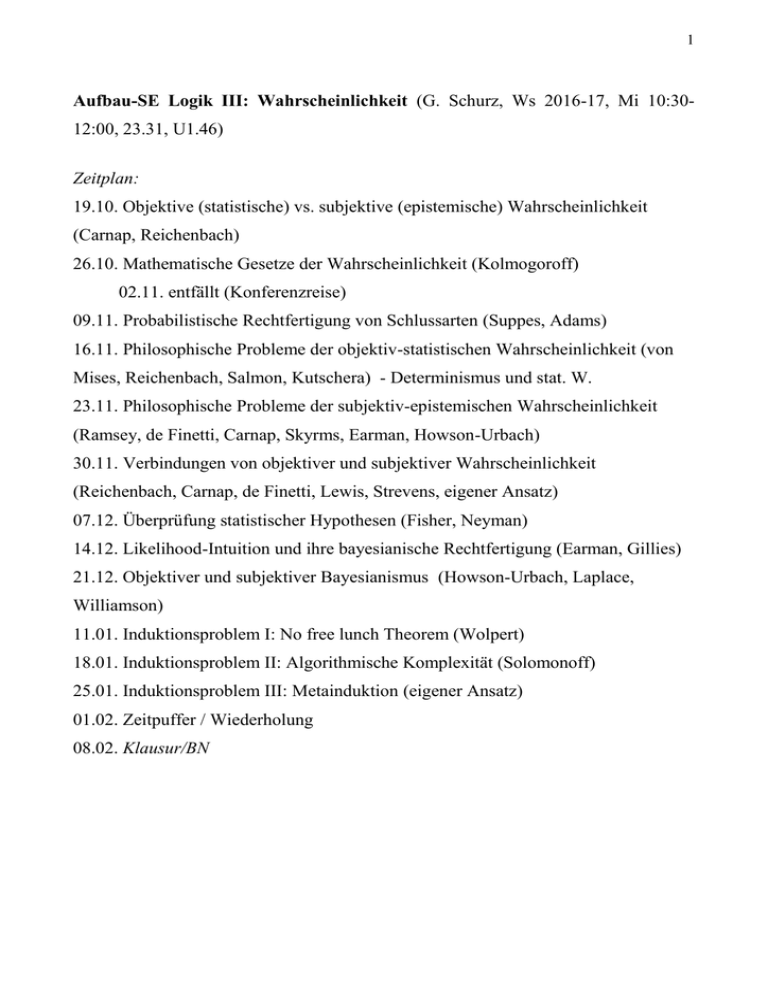

p(hn) ( = Wahrscheinlichkeit einer Stichprobe mit F-Häufigkeit hn)

n = 1000

n = 100

n = 10

x

x

x

x

x

0

x

x

x

Drei Binomialverteilungen

Normalverteilungen).

x

p(hn=k/n)

hn= kn (Stichprobenhäufigkeit von F)

für

p=1/2

(approximiert

durch

Für zunehmende Stichprobengrößen n immer steilgipfeliger ( = p (1 - p)/n ) .

Daraus ergeben sich:

Gesetze der großen Zahlen:

Schwaches Gesetz der großen Zahlen: Für jede noch so kleine positive Zahl strebt

die Wahrscheinlichkeit dafür, dass hn(F) von p(F) um weniger als abweicht, für n

gegen unendlich gegen 1.

(3-4.2) Starkes Gesetz der großen Zahlen: Die Wahrscheinlichkeit dafür, dass der

Häufigkeitsgrenzwert

von

F

in

einer

unendlichen

Zufallsfolge

mit

der

Wahrscheinlichkeit von F übereinstimmt, beträgt 1. (benötigt -Addditivität)

Intuition: Gesetze der großen Zahlen "Bestätigung" statistischer W.keitstheorie.

Doch nur formale Theoreme; die für W.keit in jeder Interpetation gelten.

Erkennt man daran dass die Konvergenz der Häufigkeiten nur mit W.keit behauptet

wird was je nachdem, wie „W,keit“ interpretiert wird, unterschiedliches bedeutet.

19

Interpretiert man Wahrscheinlichkeiten subjektiv, so besagt starkes Gesetz:

Mit subjektiver Sicherheit (P = 1) wird geglaubt, dass Häufigkeitsgrenzwert in einer

unendlichen Folge von gleichwahrscheinlichen und voneinander unabhängigen

Ereignissen mit der Glaubenswahrscheinlichkeit der Ereignisse übereinstimmt.

Für und Wider

Sigma-Additivität (unendnliche Additivität): P/p heißt -additiv g.d.w.:

die Wahrscheinlichkeit der Vereinigung von unendlich vielen paarweise disjunkten

Ereignissen = unendliche Summe ihrer Wahrscheinlichkeiten.

Problem: Unendliche Summe iN p({i}) kann nur dann den Wert 1 (bzw. irgend

einen Wert größer als Null und kleiner als Unendlich) annehmen, wenn die Folge der

Wahrscheinlichkeiten p({i}) hinreichend schnell gegen Null strebt::

p=1

p=0

|N

-additive Wahrscheinlichkeitsmaße über |N.

Annahme zwingt jeder Wahrscheinlichkeitsverteilung über einem abzählbar

unendlichen Möglichkeitsraumeinen Bias auf; ist daher nicht generall adäquates

Axiom.

Kelly (1996): -Additivität von subjektiven Wahrscheinlichkeiten impliziert

schwache induktive Annahme:

19

20

20

Für universelle Hypothese xFx über unendlichen Bereich D muss W.keit, dass das

n.te Individuum die erste falsifizierende Instanz von xA(x) ist, mit zunehmenden n

schnell gegen Null gehen.

Weiters: P(xFx) = limn P(Fa1Fan)

Humescher Induktionsskeptiker würde nicht zustimmen:

nach jeder noch so großen endlichen Anzahl bestätigender Beobachtungen Fa1,,Fan

verbleiben unendlich viele unbeobachtete Individuen, die Allyypothese falsifizieren

können, weshalb für Induktionsskeptiker W.keit nicht gesunken ist.

Nicht--additive W.keitsmaße: Bhaskara Rao & Rao (1983), Schurz & Leitgeb

(2008). Erfüllen schwächerer Gesetze, z.B. p(ip({i})) iN p({i}).