Reduzieren der Wortformen - Institut für Computerlinguistik

Werbung

Reduzieren der Wortformen

c

Clab-Team

Institut für Computerlinguistik

Universität Zürich

Dez. 2008

Zusammenfassung

Das Reduzieren von verschiedenen Wortformen des selben Wortes auf eine geeignete Grundform ist für viele Anwendungen in

der Computerlinguistik relevant. Dies kann einerseits durch einfache, algorithmische Verfahren wie Trunkierung oder Stemming

erreicht werden, oder über komplexere, aufwendigere Methoden, die viel linguistische Information benötigen. Diese reichen

von der relativ einfachen Lemmatisierung bis zur vollständigen

Morphologieanalyse. Je nach Anwendungsgebiet und Sprache

eignet sich die eine oder die andere Vorgehensweise.

Reduzieren der Wortformen

1

1

Voraussetzungen

Derivation: Derivation erzeugt neue Wörter

(im Sinn von

L Lexemen) aus einem

Bevor Sie diese Lerneinheit bearbeiten, sollten

selbständigen Wort und verschiedenen L Af-

Sie einerseits wissen, was Tokenisierung ist (sie-

fixen:

he Hess (2005)), andererseits sollten Ihnen die

Ziele und Methoden des Information Retrieval

compute, computer, computerize, recompute, recomputerize etc.

(IR) bekannt sein (s. ebenfalls Hess (2005)).

Derivation verändert oft die Wortkategorie

(part-of-speech): compute ist ein Verb, computer ist

2

ein Substantiv.

Lernziel

Normalerweise wird auch semantischer Ge-

Sie sollten nicht nur in theoretischer Hinsicht

halt zugefügt: Das Präfix re- in recompute be-

den Unterschied zwischen L Trunkierung, L

deutet wieder. compute, computes, computing, und

Stemming und echter Morphologieanalyse ken-

computed hingegen differieren nur in (bedeu-

nen, sondern auch abschätzen können, wie weit

tungsirrelevanten) Aspekten wie L Tempus, L

Trunkierung in einem konkreten Anwendungs-

Numerus, L Genus, L Kasus, Aspekt etc.

kontext ( L Information Retrieval) trägt. Sie sollten sodann selbständig Regeln für einen konkre-

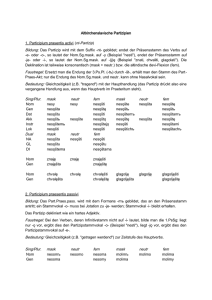

Eine sehr komplexe Wortform, graphisch

veranschaulicht1 , siehe Abbildung 1.

(QUIZ) Grundlagen der Wortreduktion

ten Stemmer (Porter-Stemmer) für verschiedenen Sprachen schreiben können.

3

Flexion,

Derivation

und

Komposition

Die Vielfalt von Wortformen für dieselben oder

ähnliche Inhalte in natürlichen Sprachen erschwert das Suchen in Texten sehr. Die Komplexität von Wortformen ergibt sich aus den Operationen, die bei der Wort(form)bildung involviert

sind:

1. L Flexion (Konjugation, Deklination.., u.a.

Komposition Komposition erzeugt ein neues

mit Ablauten)

Wort aus mehreren selbständigen Wörtern:

2. L Derivation (Affixierung etc.)

Haus + Bau → Hausbau

(Zusammensetzung

Komposition ist ebenfalls semantisch rele-

selbständig existierender Wortformen zu neu-

vant; allerdings ist es oft sehr schwierig, die Be-

en Wörtern)

deutung eines Kompositums aus den Bedeutun-

L

3.

Komposition

gen der Einzelwörter systematisch zu ermitteln.

Flexion: Flexion erzeugt verschiedene Formen

desselben Lemmas (Grundform):

Hund → Hunde

Die Wortkategorie wird dadurch natürlich nicht

verändert, aber die Flexion ist semantisch relevant.

1

Vgl. Smith (1991).

4

Grundlegendes zur Wortreduktion

Eines der grundlegenden Probleme der textbezogenen Informationstechnologie besteht darin,

Reduzieren der Wortformen

2

Texte so zu speichern, dass auf eine L Anfra-

• Trunkierung: Das Abtrennen einer bestimm-

ge hin möglichst alle relevanten Informationen

ten Anzahl von Zeichen am Wortende. Hier-

(und nur diese!) zurückgeliefert werden. Eine

bei muss man noch unterscheiden zwischen

erste wesentliche Hürde hierfür stellt die Vielfalt

dem Kürzen auf eine bestimmte Anzahl Zei-

von Formen dar, die Wörter, selbst bei gleichem

chen und dem Kürzen um eine bestimmte An-

Inhalt und gleicher Wortart, aufweisen.

Sogar im Englischen ist das ein echtes Pro-

zahl Zeichen. Beispiel:

blem:

{Museum, Museen, Mus, Muster}

→ mus

to mean →

mean

• Stemming: Die rein algorithmische Bestim-

means

mung von “Wortstämmen”, ohne Verwen-

meant

dung wortspezifischer, einzelsprachlicher In-

meaning

formation; oft ist das Gefundene daher keineswegs der L Stamm eines Worts im lingui-

Das offensichtliche Problem hierbei ist, dass

z.B. der Benutzer eines Dokumentenretrievalsystems grundsätzlich alle flektierten Formen jedes einzelnen Suchterms (also alle zu einem

stischen Sinn, weshalb der Begriff stemming eigentlich recht irreführend ist

{Museum, Museen} → muse

Wort gehörenden Wortformen) in seiner Anfra-

• Lemmatisierung: Reduktion der Wortform

ge eingeben müsste, um keine relevanten Dokumente zu verpassen. Er müsste also Anfragen

auf die linguistisch korrekte Grundform,

das sog. L Lemma (also das, was in ei-

stellen wie:

nem Wörterbuch den Eintrag einleitet) unter

Berücksichtigung einzelsprachlicher Regeln

(mean OR means OR meant OR meaning)

Weniger offensichtlich, aber mindestens so

der Wortbildung inkl. unregelmässigen Bildungen, also durch Benützung einzelsprachli-

schwerwiegend, ist das Problem, dass alle

cher Wortbildungsregeln und Wörterbücher:

brauchbaren Dokumentenretrievalsysteme die

{Museum, Museen} → Museum

Indexterme aufgrund ihrer Häufigkeit gewichten. Die L Gewichtung eines Terms hat grossen

Einfluss auf die Position eines Dokuments in der

Ergebnisliste. Beim Gewichten werden die extrem häufig vorkommenden Terme ebenso wie

• Morphologische Analyse: Ermittlung des

Lemmas und aller morphologischen Merkmale (wie Numerus, Genus, Kasus, Tempus,

L Modus etc.)

die extrem selten vorkommenden Terme gerne

Museen → Museum (Gender=Neutr,

ignoriert. Da nun aber, ohne besondere Vorkeh-

Number=Pl, Case=*)

rungen, jede gebeugte Form eines gegebenen

• Rooting: Manchmal ist noch das Isolieren der

Worts in einem Dokument als einzelnes Wort-

Wurzel sinnvoll. Das wird im Folgenden aber

vorkommen gezählt wird, wird das aufaddierte

nicht betrachtet.2

Total für dieses Wort (und damit sein Gewicht)

wahrscheinlich zu klein (da die selten vorkom-

Beispiel:

menden Beugungsformen ignoriert werden). Es

Farbe

|

ist daher fast unerlässlich, nur die “Grundform”

färben

|

der Wörter als Indexterme zu benutzen.

farbig

|

→ FARB

Prinzipiell gibt es mehrere Möglichkeiten,

um zu einer sinnvollen Grundform zu gelangen:

Aber: Die morphologische Analyse ist viel

aufwendiger zu automatisieren, deshalb hat

2

Rooting wird manchmal auch als Stemmatisierung bezeichnet. Das ist nicht dasselbe wie Stemming!

Reduzieren der Wortformen

3

man meist versucht, so lange es geht, die einfa-

S-Algorithmus (mit m=1):

cheren oben genannten Methoden einzusetzen.

give | s

Welche dieser automatischen Methoden

kann man wann einsetzen?

cat

• Für schwach flektierende Sprachen (wie z.B.

Englisch) und für anspruchslose Aufgaben

| s

Dieses Verfahren ist:

kann man zur Not die Trunkierung anwen-

• schnell

den.

• sprachunabhängig (allerdings nur im Prinzip)

• Für morphologisch komplexere Sprachen

(wie z.B. Deutsch) und etwas anspruchsvollere Aufgaben ist aber zumindest Stemming

• für sehr viele Zwecke ungeeignet

Zum Letzten:

oder aber Lemmatisierung erforderlich. Hier-

• Beim Indexieren werden abide und abiding

bei kann man nach mehr oder weniger lingui-

unterschieden werden (siehe Beispiel oben),

stischen Prinzipien verfahren. In einer Spra-

weshalb beide Terme ein zu geringes Gewicht

che mit wenig L Morphologie wie dem Eng-

erhalten. Es handelt sich jedoch um Wortfor-

lischen kommt man mit relativ unlinguisti-

men des selben Wortes.

schen Methoden schon weit; man wird aber

• Für den Stil eines Autors mag es z.B. wich-

in jedem Fall nur die regelmässigen Bildun-

tig sein, wie oft er Wörter aus der Klasse ab-

gen erfassen.

hor verwendet, aber da abhor und abhorr unter-

• Für wirklich anspruchsvolle Anwendungen

ist eine echte und vollständige Morphologieanalyse erforderlich. Dieses Thema wird in

schieden werden, wird hier der Wert bei der

Zählung erneut zu gering ausfallen.

Ebenso: abet/abetto, abide/abidin

der Vorlesung “Morphologie und Lexikogra-

Kann man durch die Wahl anderer Werte für

phie” viel tiefer behandelt.

m die Situation verbessern? Nicht prinzipiell zwar fallen nun abide und abiding korrekterwei-

5

Trunkierung

se zusammen, aber dafür fälschlicherweise auch

aboriginal und abort:

Trunkierung einer Wortform heisst: eine fixe Anzahl (m) Zeichen am Anfang der Wortform be-

Beispiel mit m=4:

halten (T-Algorithmus), oder (seltener) vom En-

aber | ration

de der Wortform abschneiden (S-Algorithmus).

Beispiel (aus Celex):

abet |

T-Algorithmus (mit m=6):

aberra | tion

abet

abetto | r

abeyan | ce

abeyan | t

abhor

abet | tor

abey | ance

abey | ant

abho | r

abho | rrence

abho | rrent

abid | e

abid | ing

abhorr | ence

Scheint nicht sehr ins Gewicht zu fallen, aber:

abhorr | ent

abor | iginal

abide

abor | iginal

abidin | g

abor | igine

Abor | igine

Reduzieren der Wortformen

4

abor | t

Im Englischen gibt es ca. 75 Präfixe und 250 Suf-

abor | tion

fixe. Ein kleiner Auszug:

abor | tionist

abor | tive

a-

anti-

de-

ex-

in-

pre-

re-

un-

Übereinstimmungen.

Testen Sie nun, ob Sie die Konzepte und

-able

-ages

-ance

-aric

-anced

-ature

-ble

-eature

Methoden des Trunkieren verinnerlicht haben:

-enced

-ened

-er

-fied

(QUIZ) Trunkieren

-icated

-ing

-ion

Hier gibt es nun schon sehr viele falsche

Das Entfernen von Präfixen ist zwar zu-

6

Stemming

verlässiger als das Entfernen von Suffixen, da

letztere oft orthographische Veränderungen in-

Stemming versucht den Stamm in etwas

volvieren (stratify → stratified). Je-

präziserer Weise zu isolieren.

doch verändern Präfixe die Bedeutung der

Stammwörter derart stark (asymmetry →

Methoden:

symmetry), dass das Entfernen von Präfixen

1. Kontextunabhängiges L Suffix-Stripping

für viele Zwecke nicht sinnvoll ist.

2. Kontextabhängiges Suffix-Stripping

fernen von Suffixen betrachtet.

6.1

Kontextunabhängiges

Stripping

Suffix-

Im Folgenden wird daher nur noch das Ent-

Resultate (Suffix-Stripping: einfacher exakter

longest match für obige Suffixe):

Am einfachsten sind jene Methoden, bei denen

asymmetry

→ asymmetry

Affixe aus einer vorgegebenen Liste abgetrennt

able

→ [ ]4

werden. Zu unterscheiden sind dabei:

interesting → interest

1. longest match: entferne (von hinten und/oder

von vorne) die längste Kette, die als Affix3

aufgelistet ist; siehe (Salton:381)

king

→ k

producer

→ produc

creature

→ cr

feature

→ f

2. shortest match: entferne die kürzeste Kette

3. in beiden Fällen: einfach oder iteriert; beim

iterativen Vorgehen werden wiederholt SuffiResultate (Suffix-Stripping: einfacher exakter

shortest match):

xe entfernt.

4. in beiden Fällen: entweder zuerst Präfixe und

dann Suffixe (→), oder umgekehrt (←).

asymmetry

able

→ symmetry

→ a

5. in beiden Fällen: exakter oder annähernder

Match. Beim partiellen Match genügt ein

interesting → interest

annäherndes Matchen mit z.B. einem Präfix:

king

→ k

producer

→ produc

sky ≈ ski

(skies → sky)

3

Affix sollte hier nicht als linguistisch korrekter Term aufgefasst werden!

4

[] = leere Menge

Reduzieren der Wortformen

5

Zu unterscheiden ist im Folgenden klar der

creature

→ cre

feature

→ fe

L Algorithmus selbst und die konkreten L Parameter-Werte. Der Algorithmus ist sprachun-

Diese Verfahren ergeben also teilweise ausserordentlich merkwürdige Resultate. Einige davon

kann man unterdrücken, indem z.B. eine Minimallänge von 3 verbleibenden Zeichen verlangt

wird. Damit würden [], k, cr, f, a, k

und fe wegfallen.

Auch dann gilt aber: Neben der korrekten

Ermittlung von Stämmen für einige Wortformen erhält man für andere Wortformen inkorrekte Stämme, weil die potentiellen Affixe als

abhängig, die Parameter-Werte5 hingegen sind

es nicht.

6.2.1

Der Lovins-Algorithmus

Der Algorithmus von Lovins (1968). 6

1. Einfacher longest match gegen 294 Suffixe:

-alistically

-izationally

-arizability

...

Buchstabenkombination am Ende oder Beginn

einer Wortform vorkommen. Verwendet man

-able

-ably

-ages

-ally

eine längere Liste von Affixen als in diesem Bei-

-ance

-ancy

-ants

-aric

spiel, erhält man noch viel mehr unerwünschte

-arly

-ated

-ates

-atic

overstemming-Resultate. In bestimmtem Anwen-

-ator

-ealy

-edly

-eful

dungen (z.B. IR) schadet das oft wenig, in ande-

-eity

-ence

-ency

-ened

ren hingegen schon.

-enly

-eous

-hood

-ials

-ians

-ible

-ibly

-ical

-ides

-iers

-iful

-ines

-ings

-ions

-ious

-isms

-ists

-itic

-ized

-izer

• basiert aber nicht auf linguistischen Prinzi-

-less

-lily

-ness

-ogen

pien, und overstemming ist daher ein grosses

-ward

-wise

-ying

-yish

Problem, da “Stämme” ermittelt werden, die

...

-i

-s

Beurteilung: Simples Suffix-Stripping

• ist zwar einfach (und daher schnell)

es in der jeweiligen Sprache gar nicht gibt.

• ist daher nur sehr beschränkt verwendbar

-a

-e

-o

-y

2. Mit 29 Anwendbarkeitsbedingungen (jedes

6.2

Kontextabhängiges

stripping

Suffix-

der 294 Suffixe hat eine dieser Anwendbarkeitsbedingungen):

Man versucht oft, durch den kontextabhängigen

W-age → W

sofern W > 3

Einsatz von Suffixregeln bessere Resultate zu

W-ion → W

sofern W > 3 und

nicht nach L oder N

erreichen. Bekannt sind in diesem Zusammenhang zwei Stemmer:

Beispiel: production

→ product

1. Algorithmus von Lovins (halbwegs linguistisch basiert)

2. Algorithmus von Porter (wenig linguistisch

basiert)

3. Mit

35

Rekodierungsregeln

(recoding:

“Flicken von Stämmen”):

• Wortstammtransformationsregeln (Englisch):

5

Welche Suffixe gibt es? Was ist die Minimallänge eines Stamms

6

http://www.ifi.uzh.ch/arvo/cl/hess/classes/le/lovins_stemmer.html

Reduzieren der Wortformen

6

{bb|dd|gg|mm|nn|pp|rr|ss|tt} | Suffix

→

|{b|d|g|m|n|p|r|s|t}

(bei betonter Endsilbe)

Beispiel: hopp|ing → hopp → hop

• *d die Grundform endet auf Doppelvokal

(z.B. -tt, -ll)

• *o die Grundform endet auf cvc, wobei das

zweite c nicht W, X oder Y ist (z.B. -wil, -hop)

• -uct →-uc:

production →produc [-er]

-umpt→-um:

consumption→consum [-er]

-ond →-ons:

responding →respons [-ive]

CVCV...C

VCVC...C

-olut→-olv:

resolution →resolv [-e]

CVCV...V

VCVC...V

metr-→meter-: metrical

Ein Wort (bzw. Teil davon) kann sein:

→meter [-ing]

Beispiel:

resp.

production → product → produc

[C](VC)m [V]

6.3

Der Porter-Algorithmus

Der Algorithmus von Porter (1980) 7 :

1. Suffixe sind in Klassen aufgeteilt:

mit m ≥ 0

Porter nennt m das “Mass” eines Wortes oder

Wortteils. Beispiele:

(a) -s, -es, -sses, -ies, -ss, -eed, -ed, -ing etc. (Fle-

[C]

(VC)m

[V]

xion)

(b) -ion, -tion, -ic, -ate, -ence, -ance etc. (Deri-

m=0

vation)

Ein Wort kann mehrere Suffixe aufweisen,

aber nur eins pro Klasse

m=1

ee

by

b

y

trouble

tr

oubl

e

pr

iv at

e

trees

Suffix-Klassen geordnet, immer längste Kette

und Regeln

tr

oats

2. iteratives Suffix-Stripping in 5 Schritten, nach

3. Anwendbarkeitsregeln auf Stamm, Suffix

tree

ivy

m=2

private

troubles

Begriffsunterscheidungen:

m=3

• Vokale v sind A,E,I,O,U und Y nach Konso-

thesaurus

th

es aur us

consonsant

nant

Überlegen Sie sich, wie das Ergebnis für die

• Konsonanten c sind der Rest

fehlenden Beispiele aussehen würde (by, oats,

• eine Kette aus einem oder mehreren v wird V

trees..).

geschrieben, analog C

• (VC)m ist die m-fache Wiederholung von VC

• [x] ist ein optionales Vorkommen von x

• *S die Grundform eines Worts endet auf S

(analog für andere Buchstaben)

Die folgende Auswahl von Regeln soll

zeigen, wie der Porter-Stemmer verschiedene

Phänomene behandelt. Die Regeln müssen nicht

notwendigerweise in dieser Reihenfolge abgearbeitet werden; die exakte Sequenzierung ist ein

zusätzlich zur Regelformulierung zu lösendes

Problem.

• *v* die Grundform beinhaltet einen Vokal

7

Lokale Kopie: http://www.ifi.uzh.ch/cl/hess/classes/le/porter_stemmer.txt

Reduzieren der Wortformen

7

Regeln (Auswahl):

european/europe

Regel 1:

create/creation

-sses

→

-ss

(caresses

→

caress)

-ies

→

-i

(ponies

→

poni)

-ss

→

-ss

(caress

→

caress)

-s

→

-

(cats

→

cat)

abschätzen zu können, betrachte man folgendes

(m>0)ed

→

ee

(feed

→

feed)

Beispiel (mit Stopwortelimination)

(*v*)ed

→

-

(plastered

→

plaster)

(*v*)ing

→

-

(motoring

→

motor)

(m>0)ational

→

ate

(relational

→

relate)

(m>0)tional

→

tion

(conditional

→

condition)

(m>0)enci

→

ence

(valenci

→

valence)

(m>0)izer

→

ize

(digitizer

→

digitize)

matrices/matrix

Um die Leistungen dieses Stemmers grob

Text:

Regel 2:

This document will describe marketing

strategies carried out by U.S.

companies for their agricultural

chemicals, report predictions for

Regel 3:

(m>0)icate

→

ic

(triplicate

→

triplic)

market share of such chemicals,

(m>0)ative

→

-

(formative

→

form)

or report market statistics for

(m>0)alize

→

al

(formalize

→

formal)

agrochemicals, pesticide, herbicide,

Regel 4:

fungicide, insecticide, fertilizer,

((m>1) and

predicted sales, market share,

(*S or *T))ion

→

-

(adoption

→

adopt)

stimulate demand and price cut,

(m>1)ou

→

-

(homologous

→

homolog)

volume of sales

(m>1)ism

→

-

(platonism

→

platon)

→

-

(rate

→

rate)

→

-

(cease

→

ceas)

Regel 5:

(m>1)e

Extrahierte Terme:

((m=1) and

not *o)e

chemic report predict market share

chemic report market statist agrochem

((m>1) and

d and *L)

→

single

letter

market strateg carr compan agricultur

(controll

→

Auch hier ist ein Hauptproblem die Erzeugung nicht existierender “Stämme”:

iteration -> iter

general -> gener

control)

pesticid harbicid fungicid insecticid

fertil sale stimul demand price cut

volum sale

Beachte auch: Diese Art des Stemming führt

im Deutschen zu deutlich schlechteren Resultaten, und zwar aus folgenden Gründen:

Man könnte meinen, das sei kein Problem,

da bei der Query ja derselbe Stamm erzeugt

wird, aber:

• Wortinterne

Prozesse

(v.a.

Umlautung

im Wortinneren: Baum/Bäume; Ablaut: lesen/liest/las), Präfigierung: lesen/gelesen

1. Die Präzision leidet (wegen künstlicher Ambiguitäten):

{organization, organ} -> organ

{policy, police} -> polic

• Komposita

lierung

verhindern

von

L

sinnvolle

Constraints:

FormuFerienen-

de/lesende/Ende

Sie finden hier eine ILAP, anhand derer Sie

{execute, executive} -> execut

herausfinden können, inwieweit Sie Trunkie-

{arm, army} -> arm

rung und Stemming allein mit regulären Aus-

2. Die Ausbeute leidet auch, weil verwandte

Formen nicht identifiziert werden:

drücken implementieren können, und was die

Resultate im Deutschen und im Englischen sind:

Reduzieren der Wortformen

8

und Komposition und Nachschlagen der po-

(ILAP) Trunkierung mit regulären Ausdrücken

tentiellen Grundform in einem Grundformenlexikon.

Versuchen Sie nun insbesondere, die Leistungsfähigkeit des Porter-Stemmers genauer

und gezielter in folgender ILAP zu ermitteln:

(ILAP) Porter-Stemmer

Nachdem Sie das Verhalten der verschiedenen Wortreduktionsmethoden in einem eher abstrakten Sinn kennengelernt haben, können Sie

in der folgenden ILAP diese Methoden in einem

konkreten Anwendungskontext (IR) ausprobieren und vergleichen:

(ILAP) (Demo) Information Retrieval und Wortreduktion

Schliesslich können Sie versuchen, die

Ein Vollformenlexikon ist aufwendiger hinsichtlich Speicherplatz, aber effizienter bei der Verarbeitung (wenn richtig gespeichert, z.B. als “Trie”

(Buchstabenbaum) oder als endliche Automaten).

Sie können die Leistungsfähigkeit eines

kommerziellen

Morphologieanaylsesystems

hier ermitteln:

(ILAP) (Demo) Morphologische Analyse mit

GERTWOL

(SET) Was ist ein Lemma?

8

Echte Morphologieanalyse

Regeln eines dieser Verfahren (des PorterStemmers) für diesen spezifischen Anwen-

8.1

Aspekte einer echten Morphologieanalyse

dungskontext zu optimieren:

(ILAP) IR mit eigenen Porterstemmer-Regeln

Ziele (in der Theorie):

1. wohlgeformte Eingaben akzeptieren und

Testen Sie schliesslich, ob Sie die Konzepte

und Methoden des Stemming verinnerlicht ha-

analysieren (also alle morphologischen Merkmale ermitteln)

ben:

2. nicht wohlgeformte Eingaben zurückweisen

(QUIZ) Stemming

7

Lemmatisierung

Sie kennen nun die Grenzen der rein algorithmischen Wortreduktionsmethoden. Um besse-

Beispiel:

• akzeptiert werden sollten big, bigger, und biggest

• aber nicht akzeptiert werden sollte aliver (als

Komparativ von alive)

re Resultate zu erreichen, sind linguistisch informierte Methoden unerlässlich: Die Reduktion der Wortformen auf ihre Grundform durch

In der Praxis der Computerlinguistik wird

das zweite Ziel nicht so hoch bewertet werden, da aliver kaum vorkommen wird. Aber:

1. Nachschlagen in einem Vollformenlexikon:

Übergenerierung wie hier erzeugt immer spu-

jede Wortform kann direkt im Lexikon nach-

rious ambiguity (und beim Generieren würde es

geschlagen werden.

mit derartigen Regeln natürlich ganz chaotisch

2. Reduzieren der Wortform auf eine potentiel-

werden).

le Grundform durch Anwendung morpholo-

Ein Fall von spurious ambiguity: Wenn -er

gischer Regeln bezüglich Flexion, Derivation

nicht nur als Suffix von Adjektiven, sondern

von allen Typen von Wörtern erlaubt würde, so

Reduzieren der Wortformen

9

würde writer zwei Analysen erhalten: Einmal er (korrekt) als agentives Suffix eines Verbs, und

einmal als komparatives Suffix.

In Morphologieanalyseprogrammen muss

zumindest die Flexionsinformation ermittelt

werden, und wenn möglich auch noch die Derivationsinformation. Wie das Resultat einer Morphologieanalyse aussieht, soll anhand des Outputs von PC-Kimmo gezeigt werden.8

1. Auflistung: explizite Liste: compute, computer,

computerize, recompute, recomputerize

2. Regelbasierte L Ableitung (echte Derivation): Liste von Stämmen und Affixen (computer, +er, +ize und +ation) plus Regeln zu ihrer

Kombination (morphologische Komponente

einer Grammatik)

Die echte Derivation ist der offensichtlich

mächtigere Ansatz:

Für die Wortformen

1. auch neue Wörter können erkannt werden.

• fox (singular Substantiv)

Wobei man noch unterscheiden muss, ob die-

• foxes (ein regelmässiger Plural)

se nur neu für das System oder echte Neologismen, und somit neu für den Menschen,

• mice (ein unregelmässiger Plural) und

• computer (von einem Verb abgeleitetes Sub-

sind.

2. markant kleineres Wörterbuch

stantiv)

3. theoretisch attraktiver, da dies ein Modell der

ermittelt PC-Kimmo

‘fox

[[

Sprache,und nicht einfach eine Liste, darstellt.

‘fox

Allerdings gibt es auch Probleme mit dem

number:SG

pos:

Derivations-Ansatz:

N]]

1. Dekomposition kann zu Pseudo-Analysen

(spurious parses) führen:

‘fox+s

‘fox

[[

number:PL

Wenn man das Suffix +age hat, um baggage,

pos:

acreage, voltage etc. abzuleiten, dann wird man

N]]

auch bekommen: cab → cabbage. Da das Suf‘mice

‘mouse

[[

number:SG

die falschen Analysen), könnte man in diesem

pos:

Fall auch die Derivate auflisten.

fix +age jedoch recht selten ist (seltener als

N]]

com‘pute+er ‘computer

[[

2. Phonologische und/oder morphologische Ir-

number:SG

regularitäten:

pos:

reception

N]]

ist

klarerweise

abgeleitet

vom

Stamm receive plus NominalisierungssufJedes Wort hat:

1. das Merkmal number (da alle Wörter in dieser Liste Substantive sind)

2. ein Merkmal pos (part-of-speech).

Zur Derivation: Für die Derivation gibt es zwei

Strategien:

fix -tion, ebenso wie deceive/deception, conceive/conception, perceive/perception. Der phonologische Abstand macht Derivations-Regeln

(zwischen -ceive und -cep) sehr kompliziert.

Da nur relativ wenig Wörter so gebildet werden, kann man

• diese abgeleitete Formen explizit ins Lexikon schreiben

8

siehe auch Englex: A Computational Morphology of English: http://www.sil.org/pckimmo/v2/doc/englex.html

Reduzieren der Wortformen

10

• ihre Herkunft aber im Lexikon angeben

(V(re‘ceive)+NR)

8.2

Probleme der Mehrdeutigkeit

Wie in anderen Bereichen der Computerlingui-

3. Viele abgeleitete Wörter erhalten eine neue

stik quält uns auch in der Morphologie das Pro-

(spezialisierte) Bedeutung:

blem der Mehrdeutigkeit:

business ist eine reguläre nominale Derivation

1. kategoriale Mehrdeutigkeit (besonders im

Englischen sehr verbreitet):

des Adjektivs busy, aber es hat nicht (mehr)

die Bedeutung state of being busy.

mean:

Daher kann man

• diese abgeleiteten Formen mit neuer Bedeutung ins Lexikon schreiben

• die nicht mehr verfügbare abgeleitete

1.

Substantiv (Durchschnitt)

2.

Adjektiv

(durchschnittlich)

3.

Verb

(bedeuten;im Sinn haben;..)

can:

Form (busy+ness AJ+NR) evtl. explizit

1.

Substantiv (Büchse,Kanister;..)

blockieren

2.

Hilfsverb

4. Manche an sich klare Ableitungen sind im

(können)

2. lexikalische Mehrdeutigkeit:

normalen Sprachgebrauch nicht mehr bewusst: resilient ist (morphologisch und seman-

mean (Adjektiv):

tisch) transparent abgeleitet vom Verb resile.

1. durschnittlich

Dies ist aber bloss noch etymologisch rele-

2. gemein, niederträchtig

vant, daher werden in solchen Fällen abgeleitete Formen ins Lexikon aufgenommen.

3. Kombinationen von Mehrdeutigkeit und L

Homonymie:

Zur Komposition: Komposita und Nominal-

mean:

verkettungen kommen in drei Arten vor (im

1. Substantiv

Englischen):

2. Adjektiv a. (durchschnittlich)

solid

hyphenated

open

“bedroom”

“moth-eaten”

“rose bush”

Oft alle 3 wild durcheinander: on line, on-line,

online.

(Durchschnitt)

b. (gemein, niederträchtig)

3. Verb

9

(bedeuten;im Sinn haben;..)

Konkrete Systeme für die

Morphologieanalyse

Offene Komposita fallen eigentlich nicht in

die Kompetenz eines Morphologieanalyseprogramms. Manche Systeme (z.B. PC-KIMMO)

Eine kurze und sehr unvollständige Übersicht

können nur Bindestrich-Komposita analysieren;

über konkrete Systeme (kommerzielle und aka-

die festen werden als einfache Lexeme behan-

demische) für die Morphologieanalyse:9

delt, die offenen als zwei (rsp. mehrere) getrennte. Dies ist natürlich keine Lösung, schon gar

nicht für Sprachen wie das Deutsche. GERTWOL kann Komposita sehr gut zerlegen. Bei

der Analyse von geschlossenen (solid) Komposita entstehen allerdings teilweise bizarre Lesarten (siehe 9.3).

9.1

PC-KIMMO

PC-KIMMO ist eine eigentliche Wortgrammatik mit entsprechender Analyseform als Baum.

Das System verfügt über ca. 20’000 Lexikoneinträge und analysiert zwar Flexion und Derivationen, jedoch keine Komposita. Ausserdem ist

PC-KIMMO gratis.

9

siehe auch http://www.ifi.uzh.ch/arvo/cl/InteractiveCLtools/index2.php#as-t1-Morp

Reduzieren der Wortformen

11

enlargement:

*buch+s+neutr+pl+dat

--> *büchern

Diese Systeme weisen eine hohe Korrektheit auf, 99% für orthographisch korrekten Text

und über 98% für unbeschränkten Text. Einziger

Nachteil: da es sich um kommerzielle Systeme

handelt, sind sie nicht gratis. Die Grundlage für

das Lexikon von GERTWOL bildet der Collins

German Dictionary, zuätzlich wurde das Lexikon um 6’300 Substantive und 11’000 Eigennamen erweitert.

Total:

Word:

[ head:

1. 11’000 Adjektive

[ number:SG

pos:

N ]

2. 2’000 Adverbien

lemma: ‘large

3. 400 Interjektionen

lemma pos:AJ ]

lemma pos ist die Wortart; Kimmo kann also

auch als Teil eines Taggers verwendet werden.

9.2

4. 50’000 Substantive

5. 6’500 Verben

6. 12’000 Eigennamen

Morphy

Morphy (Lezius, 2000) ist ein frei verfügbares

System zur Morphologieanalyse und Wortar-

7. 1’700 Abkürzungen

Derivationen (˜ steht für Suffix):

tenbestimmung im Deutschen. Das verwendete

Lexikon umfasst ca. 16’500 Einträge. Komposita werden nicht analysiert. Morphy ist nur für

ENGTWOL

enlargement:

Windows verfügbar und wird auch nicht mehr

"<enlargement>"

weiterentwickelt.10

"enlargement" N NOM SG

9.3

ENGTWOL/GERTWOL/etc.

Engtwol und Gertwol sind kommerzielle Sy-

GERTWOL:

"<interessanten>"

steme zur Morphologieanalyse, entwickelt von

"interess˜ant"

A POS SG AKK MASK

der Firma Lingsoft in Finnland. Neben Flexion

"interess˜ant"

A POS SG DAT MASK

und Derivation analysieren diese System auch

"interess˜ant"

A POS SG GEN MASK

Komposita, ausserdem sind sie sehr schnell (200

"interess˜ant"

A POS SG DAT NEUTR

Wörter/sec auf Sun SPARCstation 2). Zusätzlich

"interess˜ant"

A POS SG GEN NEUTR

zur Analyse gibt es auch eine Version, mit der

"interess˜ant"

A POS SG DAT FEM

man Wortformen generieren kann:

"interess˜ant"

A POS SG GEN FEM

"interess˜ant"

A POS PL NOM

"interess˜ant"

A POS PL AKK

"interess˜ant"

A POS PL DAT

"interess˜ant"

A POS PL GEN

lernen+v+ind+präs+sg3

--> lernt

gut+a+komp+sg+akk+neutr --> besseres

10

siehe http://www.wolfganglezius.de/doku.php?id=public:cl:morphy

Reduzieren der Wortformen

12

Die Ausgabeinformation ist sehr viel einfacher

als PC-KIMMO, aber für viele Anwendungen

genügend. Komposita werden analysiert:

und, auch sehr schön:

Abchasen:

"<Abchasen>"

Berg#wiese

"Abchas˜e"

S MASK PL NOM

Schreib#maschine

"Abchas˜e"

S MASK PL AKK

"Abchas˜e"

S MASK PL DAT

rache|durst˜ig

"Abchas˜e"

S MASK PL GEN

fett|arm

"Abchas˜e"

S MASK SG GEN

“#” trennt Elemente, die auch separat auftreten

"Abchas˜e"

S MASK SG DAT

können, während “|” unselbständige Elemen-

"Abchas˜e"

S MASK SG AKK

te trennt (u.a. Präpositionen, Präfixe). Fugen-

"Abc#hase"

S MASK PL NOM

elemente, die besonders schwierig zu erkennen

"Abc#hase"

S MASK PL AKK

sind, werden ebenfalls erkannt (markiert durch

"Abc#hase"

S MASK PL DAT

“\”):

"Abc#hase"

S MASK PL GEN

"Abc#hase"

S MASK SG GEN

"Abc#hase"

S MASK SG DAT

"Abc#hase"

S MASK SG AKK

Lehrling\s#not

Wohnung\s#tür

Strasse\n#bahn#linie

Bund\es#verfassung\s#gericht

Zu beachten sind insbesondere die von GERTWOL gelieferten z.T. recht bizarren (aber techni-

Zum Ausprobieren: GERTWOL von LingSoft

(SET) Was ist Morphologie?

sche gesehen korrekten!) Analysen:

10

Fleischerzeugnis:

"<*fleischerzeugnis>"

"*fleischer#zeug˜nis"

"*fleischer#zeug˜nis"

"*fleischer#zeug˜nis"

S NEUTR SG NOM

S NEUTR SG AKK

S NEUTR SG DAT

"*fleisch#er|zeug˜nis" S NEUTR SG NOM

"*fleisch#er|zeug˜nis" S NEUTR SG AKK

"*fleisch#er|zeug˜nis" S NEUTR SG DAT

"*fleisch˜er#zeug˜nis" S NEUTR SG NOM

"*fleisch˜er#zeug˜nis" S NEUTR SG AKK

"*fleisch˜er#zeug˜nis" S NEUTR SG DAT

Schluss

In vielen Anwendungenbereichen der Computerlinguistik ist man darauf angewiesen, dass

man unterschiedliche Wortformen, die dieselben oder ähnliche Inhalte ausdrücken, auf eine

gemeinsame Form bringen kann. Dies kann mit

unterschiedlichen Mitteln erreicht werden (nach

Aufwand geordnet):

1. Trunkierung

⇓

2. Stemming

oder

⇓

Regalbretter:

"<*regalbretter>"

"*regal#brett"

"*regal#brett"

"*regal#brett"

2a. kontextunabhängies Suffix-Stripping

⇓

S NEUTR PL NOM

2b. kontextabhängiges Suffix-Stipping

S NEUTR PL AKK

⇓

S NEUTR PL GEN

3. Lemmatisierung

"*reg#alb#rett˜er"

"*reg#alb#rett˜er"

S MASK SG NOM

"*reg#alb#rett˜er"

"*reg#alb#rett˜er"

S MASK SG DAT

S MASK PL NOM

Grundsätzlich gilt: Je genauer das Vorgehen, de-

"*reg#alb#rett˜er"

"*reg#alb#rett˜er"

S MASK PL AKK

sto aufwendiger ist es zu realisieren.

S MASK SG AKK

S MASK PL GEN

⇓

4. Morphologieanalyse

Reduzieren der Wortformen

13

Literatur

Hess, Michael: Einführung in die Computerlinguistik I: Interaktives Vorlesungsskript WS 04/05. Link: Skript

ECL WS05, 2005

Lezius, Wolfgang: Morphy - German Morphology, Part-of-Speech Tagging and Applications. In Heid,

Ulrich et al. (Hrsg.): Proceedings of the 9th EURALEX International Congress. Stuttgart, 2000

hURL: http://www.wolfganglezius.de/lib/exe/fetch.php?id=public%3Acl%3Amorphy\

&cache=cache\&media=public:cl:euralex2000.pdfi, 619–623

Lovins, J.B.: Development of a Stemming Algorithm. 1968, 220–31

Porter, Martin F.: An Algorithm for Suffix Stripping. Program, 14 1980, Nr. 3, 130–137

Salton, G.: Automatic Text Processing; The Transformation, Analysis, and Retrieval of Information by Computer. Reading, Mass.: Addison-Wesley, 1989

Smith, George W.: Computers and Human Language. New York/Oxford: Oxford University Press, 1991