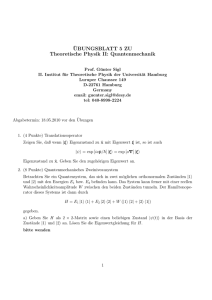

Link - Professur für Theoretische Informatik

Werbung