Einführung in Statistik

Werbung

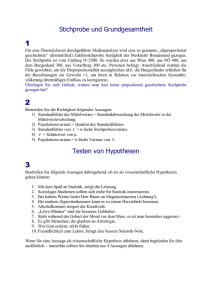

Einführung in Statistik 4. Semester Begleitendes Skriptum zur Vorlesung im Fachhochschul-Studiengang Informationstechnologien und Telekommunikation von Günther Karigl FH Campus Wien 2009 Inhaltsverzeichnis Einführung in Statistik Einleitung 1 1. Deskriptive Statistik 3 1.1 Univariate Datenbeschreibung 1.2 Multivariate Datenbeschreibung 2. Wahrscheinlichkeitsrechnung 2.1 Grundlagen der Wahrscheinlichkeitsrechnung 2.2 Diskrete Verteilungen 2.3 Stetige Verteilungen 3. Überblick Schätz- und Testverfahren 3.1 Punkt- und Intervallschätzung 3.2 Einige statistische Testverfahren Anhang: Statistische Tafeln und Funktionen 3 13 22 22 31 36 41 41 46 A1 1 Einleitung Einleitung Wenn man von Statistik hört, denkt man vielleicht zunächst an Erhebungen über Konsumgewohnheiten, Verkehrsunfälle, an Berechnungen von Preisindizes oder Durchschnittseinkommen − kurzum an das weite Gebiet der sogenannten beschreibenden (deskriptiven) Statistik. Dieser älteste Zweig der Statistik beschäftigt sich vor allem mit der übersichtlichen Darstellung von Datenmengen mittels Tabellen, Graphiken und der Berechnung charakteristischer Maßzahlen (Mittelwert, Varianz, Korrelationskoeffizient u.a.). Die beschreibende Statistik wird heute z.B. von der Republik Österreich im Rahmen der "Amtlichen Statistik", von Markt- und Meinungsforschungsinstituten, u.s.w. betrieben. Daneben wird das Wort Statistik noch in einem anderen Sinn verwendet: Man denke etwa an Wahlhochrechnungen, an Prognosen über die Bevölkerungsentwicklung, an Vergleiche über die Wirksamkeit von Medikamenten oder an die Prüfung von Umweltbelastungen durch Schadstoffe. Fragen dieser Art gehören zum Gebiet der beurteilenden (induktiven) Statistik, deren Ziel es ist, auf Grund von Stichprobendaten allgemeingültige Aussagen über eine bestimmte Grundgesamtheit zu gewinnen. Ein Verständnis der Methoden der beurteilenden Statistik, die in vielen Bereichen der Technik, der Medizin, der Wirtschafts- und der Sozialwissenschaften zur Anwendung gelangen, setzt zumindest Grundkenntnisse der Mathematik, insbesondere der Wahrscheinlichkeitsrechnung, voraus. Ein einfaches Beispiel möge einen ersten Einblick in die Arbeitsweise der induktiven Statistik vermitteln: Der Einfluss von Alkohol auf das menschliche Reaktionsvermögen soll untersucht werden. Dazu werden zehn Personen (behandelte Gruppe "B") zufällig ausgewählt und deren Reaktionszeit in einem genau festgelegten Experiment nach Konsumation einer bestimmten Alkoholmenge gemessen. Zusätzlich werden die Reaktionszeiten von zehn weiteren Personen (Kontrollgruppe "K") ermittelt, die keinen Alkohol zu sich genommen haben. Die erhaltenen Messwerte sind in der folgenden Tabelle zusammengefasst: Gruppe B Gruppe K Reaktionszeiten (in s) der einzelnen Personen 0.79, 0.82, 0.82, 0.67, 0.88, 0.60, 0.94, 0.77, 0.90, 0.74 0.59, 0.68, 0.80, 0.62, 0.64, 0.70, 0.82, 0.91, 0.72, 0.60 Die beiden Gruppen sollen also hinsichtlich eines Merkmals, der Reaktionszeit, miteinander verglichen werden. Dazu wird man zunächst die beiden Gruppenmittel x B = 0.793 bzw. x K = 0.708 berechnen, die erwartungsgemäß nicht übereinstimmen. Für die Verschiedenheit kann es mehrere Gründe geben. Wir wollen ausschließen, dass die Versuchsplanung oder Versuchsdurchführung fehlerhaft war (z.B. kann bei nicht zufälliger Auswahl der Probanden eine künstliche Heterogenität zwischen den beiden Gruppen entstehen). In der Regel werden aber bei jedem Versuch Zufallsschwankungen mitspielen, die z.B. durch biologische Variabilität oder durch Messfehler bedingt sind. Solche Abweichungen sind unvermeidbar und werden in den statistischen Verfahren entsprechend berücksichtigt. Einleitung 2 Schließlich kann tatsächlich ein Unterschied im Verhalten der Gruppen bestehen, d.h. ein Einfluss des Alkoholkonsums auf die Reaktionszeit, und dieser Effekt soll ja gerade aufgedeckt werden. Kann also aus der Ungleichheit der Gruppenmittel geschlossen werden, dass die mittlere Reaktionszeit all jener Menschen, die durch diese 20 Versuchspersonen repräsentiert werden, von Alkoholkonsum beeinflusst wird? Diese Frage lässt sich durch einen statistischen Test beantworten, der angibt, wie und mit welcher Sicherheit von den beiden Stichproben auf die entsprechenden Grundgesamtheiten geschlossen werden kann. Am Beginn einer jeden statistischen Untersuchung sollte stets eine genaue Abgrenzung des zu untersuchenden Problems und die Formulierung von Hypothesen stehen. Erst dann kann sinnvoller weise ein Experiment oder eine Erhebung geplant, ausgeführt und ausgewertet werden. Die statistische Analyse des Datenmaterials ermöglicht schließlich den Schluss von den Stichprobendaten auf die (reale oder hypothetische) Grundgesamtheit, der nie mit vollkommener Sicherheit, sondern lediglich mit einer bestimmten, angebbaren Wahrscheinlichkeit erfolgen kann. Dabei versteht man unter einer realen Grundgesamtheit eine tatsächlich existierende Grundgesamtheit, bestehend aus einer endlichen Anzahl von Individuen oder Objekten (z.B. die Gesamtbevölkerung Österreichs, alle Neugeborenen des Jahres 2000 oder alle Computer einer bestimmten Type aus einer festgelegten Produktionsperiode). Hypothetische Grundgesamtheiten hingegen existieren nur in der Vorstellung und können meist als unendlich groß aufgefasst werden (z.B. alle Leukämiepatienten in vergleichbarem Zustand, die der gleichen Therapie unterzogen werden könnten, oder alle Messungen, die mit demselben Apparat an einem bestimmten Präparat durchgeführt werden könnten). Aussagen über die Grundgesamtheiten erhalten wir aus Untersuchungen von Stichproben. Diese müssen daher so gewählt sein, dass die Ergebnisse auf die betreffende Grundgesamtheit verallgemeinerbar sind. Zumeist geschieht dies in Form von Zufallsstichproben, d.h., dass jedes Element der Grundgesamtheit bei einer Auswahl die gleiche Chance hat, in die Stichprobe zu gelangen. Diese Darstellung ist folgendermaßen gegliedert: Der erste Abschnitt ist der deskriptiven Statistik gewidmet. Dabei werden beschreibende Verfahren für ein- und mehrdimensionale Stichproben, d.h. für Beobachtungen, bei denen ein oder mehrere Merkmale erfasst werden, behandelt. Hierzu zählen tabellarische und graphische Methoden, die Berechnung von Maßzahlen sowie die Regressions- und Korrelationsrechnung. Der nächste Abschnitt beinhaltet das Rechnen mit Wahrscheinlichkeiten, diskrete und stetige Zufallsvariablen und deren Verteilungen. Der dritte Abschnitt ist der beurteilenden Statistik vorbehalten. Dazu zählen insbesondere Verfahren zur Schätzung von Parametern sowie Hypothesentests, wobei Hypothesen über Grundgesamtheiten anhand von Stichproben überprüft und entweder angenommen oder verworfen werden. Unumgänglich im Bereich der Statistik ist natürlich auch die Verwendung geeigneter Statistik-Software. Auswertungen im Rahmen der beschreibenden, aber auch der beurteilenden Statistik sind ohne EDV-Unterstützung praktisch nicht möglich. Aus diesem Grund ist das begleitende EXCEL-Arbeitsskriptum eine wesentliche Ergänzung. 1.1 Univariate Datenbeschreibung 3 1. Deskriptive Statistik Die statistische Auswertung eines Datenmaterials, das durch Messungen, Zählungen oder allgemein durch Beobachtungen an irgendwelchen Objekten gewonnen wurde, beginnt im Allgemeinen wohl damit, dass man die Daten überschaubar ordnet. Diese werden anfangs meist listenartig in der Reihenfolge, wie sie die Untersuchung ergeben hat, vorliegen. Eine solche Darstellung ist aber kaum geeignet, Besonderheiten der Daten erkennen zu lassen und kann vor allem auch keine Vorstellung darüber vermitteln, wie sich z.B. die Beobachtungswerte bei den verschiedenen Merkmalsausprägungen konzentrieren oder welche Symmetrie das so entstehende Verteilungsbild hat. Informationen darüber erhält man meist erst aus einer übersichtlichen Darstellung der Daten in Form der verschiedenen, in der deskriptiven Statistik gebräuchlichen Tabellen oder Diagramme. Während diese also Überschaubarkeit mit möglichst detaillierter Erfassung der Datenstruktur verbinden, hat man in den Lage- und Streuungsmaßen numerische Größen zur Verfügung, die das Datenmaterial global kennzeichnen, und zwar einerseits hinsichtlich der Lage des Zentrums der Beobachtungswerte, andererseits hinsichtlich deren Streuung. Das zu untersuchende Datenmaterial wird in der Regel aus einer umfassenderen Grundgesamtheit ausgewählt sein, d. h. eine Stichprobe bilden. Während sich also dieses Kapitel mit der Beschreibung von Stichproben im Sinne der deskriptiven Statistik befasst, wird es später − im Rahmen der induktiven Statistik − darum gehen, auf der Basis von Stichproben Aussagen über die entsprechenden Grundgesamtheiten zu gewinnen. 1.1 Univariate Datenbeschreibung An Hand des in der folgenden Tabelle dargestellten Beobachtungsmaterials sollen zuerst einige grundlegende Begriffe erläutert werden. Die Tabelle Tab. 1 enthält Daten über gewisse Eigenschaften von insgesamt 64 Kraftfahrzeugen, die durchnumeriert und in Form einer sogenannten Urliste angeschrieben wurden. Man nennt die bei einer statistischen Untersuchung beobachteten Objekte, hier also die einzelnen Fahrzeuge, auch Beobachtungseinheiten. Um klar zu machen, dass die Liste gerade aus 64 Beobachtungseinheiten besteht, spricht man genauer von einer Stichprobe vom Umfang n = 64. Während sich in Tab. 1 jede Zeile auf eine Beobachtungseinheit bezieht, wird durch die mit X1, X2 und X3 überschriebenen Spalten angegeben, wie gewisse Eigenschaften (Eigengewicht, Vorhandensein eines Katalysators bzw. Fahrzeugtyp), die man in diesem Zusammenhang Merkmale (oder Variable) nennt, in der aus den 64 Fahrzeugen bestehenden Stichprobe variieren. An jeder Beobachtungseinheit können entweder ein oder auch mehrere Merkmalsausprägungen erfasst werden. Entsprechend nennt man, je nachdem, wie viele Merkmalsausprägungen von jeder Beobachtungseinheit vorliegen, eine Stichprobe ein-, zweioder mehrdimensional (bzw. univariat, bivariat oder multivariat). So stellt z.B. das gesamte Datenmaterial in Tab. 1 eine dreidimensionale Stichprobe dar. Beschränken wir uns etwa nur auf das Merkmal X1 (Eigengewicht), so haben wir eine eindimensionale Stichprobe. 4 1.1 Univariate Datenbeschreibung Tab. 1. Urliste für die an 64 Kraftfahrzeugen beobachteten Merkmale: X1 Eigengewicht (in kg) X2 Katalysator: vorhanden (j), nicht vorhanden (n) X3 Typ: Klein-LKW (1), Kombi (2), Sportwagen (3), PKW (4), Oldtimer (5) Lfd.Nr. 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 X1 823 1201 920 828 688 487 799 542 426 1266 1108 879 734 934 872 700 669 1183 1303 1222 731 465 845 1030 1072 1170 927 1244 671 1123 X2 j j j j j n j j j j j j j j j j j j j j j j n n n j j j j j X3 4 2 4 1 3 4 2 4 4 1 2 1 2 2 2 4 1 1 4 4 2 4 4 2 4 1 2 1 1 4 Lfd.Nr. 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 X1 848 937 792 782 862 1071 965 780 867 1068 875 700 549 542 672 799 920 920 590 918 1083 811 995 673 975 720 715 1152 1450 1125 935 710 1605 1445 X2 j j j n n n j j j n n j n n j j j j n n j j j n j j j j j j j j j j X3 4 2 4 3 1 4 1 4 4 4 5 4 2 2 4 4 4 4 3 2 2 2 2 3 2 2 4 4 4 4 4 4 4 4 Es ist zweckmäßig, zwischen quantitativen und qualitativen Merkmalen zu unterscheiden. Bei quantitativ oder metrisch skalierten Merkmalen sind die Merkmalsausprägungen Ergebnisse von Messungen oder Zählungen und somit von Natur aus zahlenmäßig darstellbar. Von den Merkmalen in Tab. 1 ist X1 (Eigengewicht) natürlich metrisch. Im Gegensatz zu den quantitativen Merkmalen sind die Merkmalsausprägungen bei qualitativ skalierten Merkmalen nicht mehr mess- oder zählbar, sondern nur begrifflich unterscheidbar. Folglich sind die Merkmalsausprägungen häufig in Verbalform dargestellt, wie z.B. „vorhanden“ bzw. „nicht vorhanden“ beim Merkmal X2 (Katalysator) von Tab. 1. Manchmal 1.1 Univariate Datenbeschreibung 5 lassen sich die Ausprägungen eines Merkmals jedoch anordnen, etwa bei Ausprägungen der Form „schwach“, „mittel“, „stark“. Qualitative Merkmale, deren Ausprägungen in eine solche Rangordnung gebracht werden können, heißen ordinal im Unterschied zu den nominalen, bei denen dies nicht möglich ist. Somit ergibt sich die nachstehende, in Hinblick auf die Weiterverarbeitung wichtige Unterscheidung der sogenannten Skalenniveaus von Merkmalen: • Nominalskala: Diese hat das niedrigste Niveau. Die einzelnen Ausprägungen unterscheiden sich nur begrifflich voneinander. Sind sie durch Zahlen codiert, kann man mit diesen Zahlen in keiner Weise rechnen. Beispiel: Geschlecht (männlich, weiblich), Farbe (rot, blau, usw.) oder Kraftfahrzeugtyp (Variable X3 in Tab. 1). • Ordinalskala: Hier ist eine Anordnung der Ausprägungen festgelegt, weitergehende Berechnungen sind aber nicht möglich. Beispiel: Schulnoten von sehr gut (1) bis nicht genügend (5). • Metrische Skala: Die Werte auf dieser Skala sind stets Zahlen, mit denen auch gerechnet werden kann. Bei der Intervallskala können Differenzen von Messwerten gebildet und verglichen werden, der Nullpunkt ist jedoch mehr oder weniger willkürlich festgelegt. Beispiel: Temperatur (in °C). Die Verhältnisskala dagegen hat einen absoluten Nullpunkt, ansonsten gibt es nur positive Werte. Insbesondere können aber auch Quotienten und prozentuelle Unterschiede in sinnvoller Weise betrachtet werden. Beispiel: Körpergewicht oder Körpergröße einer Person, Größe der Klassen an Schulen und Fachhochschulen. Merkmale lassen darüber hinaus auch eine Einteilung in diskret und stetig zu. Im diskreten Fall kommen nur bestimmte, endlich oder abzählbar unendlich viele Werte als Merkmalsausprägungen in Frage. Stetige Merkmale sind hingegen solche, deren Ausprägungen (zumindest theoretisch) beliebige Zahlenwerte aus einem Intervall auf der reellen Zahlengeraden annehmen können. Häufigkeiten bei diskreten Merkmalen In einer Urliste wird oft dieselbe Ausprägung eines bestimmten Merkmals bei mehreren verschiedenen Beobachtungseinheiten auftreten. Es ist naheliegend, diese zusammenzufassen und so die Urliste in eine wesentlich übersichtlichere Häufigkeitstabelle für das betrachtete Merkmal zu verdichten. Beispiel: Wir betrachten die aus den in Tab. 1 enthaltenen Beobachtungen des qualitativen Merkmals X3 (Fahrzeugtyp) bestehende eindimensionale Stichprobe. Der Stichprobenumfang ist n = 64, und es gibt die fünf möglichen Merkmalsausprägungen a1 = 1, a2 = 2, a3 = 3, a4 = 4, a5 = 5. Die Zusammenfassung gleicher Ausprägungen ergibt unmittelbar die absoluten Häufigkeiten der einzelnen Merkmalsausprägungen, die durch Abzählen gewonnen werden können. So findet man als absolute Häufigkeit der Ausprägung a1 = l, kurz mit k1 bezeichnet, den Wert k1 = 10, usw. Dividiert man die absoluten Häufigkeiten ki (i = 1,2,3,4,5) durch den Stichprobenumfang n, so erhält man die entsprechenden relativen Häufigkeiten h1 = k1/n = 10/64 = 0,156, usw. Durch Zusammenfassen der so gewonnenen Ergebnisse erhält man schließlich die nachstehende Häufigkeitstabelle für die betrachtete Stichprobe. Insbesondere erkennt man auch, dass stets hi ≥ 0 gilt und dass h1 + h2 + h3 + h4 + h5 = 1 sein muss. 6 1.1 Univariate Datenbeschreibung Häufigkeitstabelle für die aus den Beobachtungswerten des Fahrzeugtyps X3 gebildete Stichprobe von Tab. 1 Auspr. ai 1 2 3 4 5 Summe Strichliste //// //// //// //// //// /// //// //// //// //// //// //// //// / / abs. Häuf. ki 10 18 4 31 1 64 rel. Häuf. hi (in %) 15.6 28.1 6.3 48.4 1.6 100.0 Allgemein kann also über eindimensionale Stichproben vom Umfang n für ein Merkmal mit den m Ausprägungen al, a2, ..., am gesagt werden: Die relative Häufigkeit hi einer jeden Ausprägung ai erhält man als Quotient ihrer absoluten Häufigkeit ki und des Stichprobenumfanges n, d.h. hi = ki n (i = 1,2,..., m) . Dabei gilt stets hi ≥ 0 und Σ hi = 1. Der durch die Zuordnung zwischen Merkmalsausprägung ai und der relativen Häufigkeit hi für alle i = 1,2,...,m gegebene Zusammenhang heißt kurz Häufigkeitsverteilung des betrachteten Merkmals. Neben der tabellarischen Darstellung einer Häufigkeitsverteilung gibt es auch verschiedene graphische Veranschaulichungen, von denen das Stabdiagramm sowie das Kreisdiagramm genannt seien (siehe Abbildung). Stabdiagramm Kreisdiagramm 35 5 30 1 abs. Häufigkeit 25 20 15 4 10 2 5 0 1 2 3 4 5 3 Fahrzeugtyp Klassenbildung Bei quantitativ diskreten Merkmalen mit einer großen Zahl verschiedener Merkmalsausprägungen ist es zumeist zweckmäßig, benachbarte Merkmalsausprägungen zu Klassen zusammenzufassen. Dazu wird ein Intervall, in dem alle beobachteten Werte liegen, in eine bestimmte Anzahl von meist gleich großen Teilintervallen, den sogenannten Klassen, zerlegt. 7 1.1 Univariate Datenbeschreibung Unumgänglich sind Klasseneinteilungen bei stetigen Merkmalen. Tatsächlich stellt bereits die Niederschrift einer Urliste eine Klasseneinteilung dar, die durch die begrenzte Genauigkeit in den Zahlenangaben bedingt ist. Beispiel: Für die 64 Messwerte der Variablen X1 (Fahrzeuggewicht) von Tab. 1 wählen wir eine Einteilung in Klassen von 300 bis 500, von über 500 bis 700, ..., von über 1500 bis 1700, was eine Gruppierung der Daten in 7 Klassen ergibt. Die oben genannten Zahlen heißen die Klassengrenzen und die (konstante) Differenz jeweils aus oberer und unterer Klassengrenze wird Klassenbreite genannt. Für die Festlegung der Klassenbreite bzw. der Anzahl der zu bildenden Klassen gibt es keine festen Regeln. Als Faustregel für die Klassenzahl kann man sich am Wert Klassenzahl ≈ n orientieren, wobei n den Umfang der Stichprobe bezeichnet. Viele (und damit enge) Klassen setzen einerseits die Übersichtlichkeit herab, andererseits können bei wenigen (d.h. großen) Klassen interessante Details verloren gehen. Diese Einteilung ist auch die Grundlage für die nachstehende Häufigkeitstabelle. Nach der Klassennummer i sind dort die Klassengrenzen angeführt, danach die Klassenmitten ui, weiters für jede Klasse die absolute Klassenhäufigkeit ki (d.h. die Anzahl der Stichprobenwerte, die in die jeweilige Klasse fallen) sowie die relative Klassenhäufigkeit hi (d.h. die durch den Stichprobenumfang n dividierte absolute Klassenhäufigkeit) und schließlich die relative Summenhäufigkeit Hi, die den Anteil der Beobachtungsdaten in den Klassen von 1 bis i angibt. Folglich erhält man Hi auch durch Aufsummieren der relativen Klassenhäufigkeiten h1, h2, , hi. Häufigkeitstabelle für die gruppierten Eigengewichtswerte X1 von Tab. 1 Kl.Nr. i 1 2 3 4 5 6 7 Summe Kl.Grenzen von über / bis 300 - 500 500 - 700 700 - 900 900 - 1100 1100 - 1300 1300 - 1500 1500 - 1700 Kl.Mitte ui 400 600 800 1000 1200 1400 1600 abs.Kl.H. ki 3 11 20 16 10 3 1 64 rel.Kl.H. hi (in %) 4.7 17.2 31.3 25.0 15.6 4.7 1.6 100.0 rel.S.H. Hi (in %) 4.7 21.9 53.1 78.1 93.8 98.4 100.0 Eine graphische Veranschaulichung der durch diese Häufigkeitstabelle bestimmten Verteilung ist das Histogramm. Auf einer horizontalen Merkmalsachse werden die Klassengrenzen bzw. Klassenmitten vermerkt und über jeder Klasse ein Rechteck mit einer der absoluten oder relativen Klassenhäufigkeit entsprechenden Höhe errichtet. (Die Rechteckflächen sind also den jeweiligen Klassenhäufigkeiten proportional.) Gegenüber den Originaldaten bedeutet die Häufigkeitstabelle bzw. das Histogramm aber einen Verlust an Information, nämlich über die Verteilung der Stichprobenwerte in jeder einzelnen Klasse. 8 1.1 Univariate Datenbeschreibung Histogramm 25 Häufigkeit 20 15 10 5 0 400 600 800 1000 1200 1400 1600 Fahrzeuggewicht (gruppiert) Lage- und Streuungsmaße Stichproben werden in übersichtlicher Form und, wenn man von Klasseneinteilungen absieht, ohne jeden Informationsverlust durch Häufigkeitstabellen dargestellt. Dem gegenüber werden zur globalen Kennzeichnung von Stichproben einige numerische Größen verwendet, zu denen vor allem die verschiedenen Lage- und Streuungsmaße gehören. Von den Lagemaßen findet zweifellos das arithmetische Mittel, kurz der Mittelwert am häufigsten Verwendung. Man berechnet ihn bekanntlich, indem man alle Stichprobenwerte zuerst aufsummiert und die Summe dann durch den Stichprobenumfang geteilt wird. Ist n der Stichprobenumfang und sind xl, x2, ..., xn die Stichprobenwerte, so gilt für den Mittelwert x= 1 1 n ( x 1 + x 2 + ... + x n ) = ∑ x i . n n i =1 Erleichtert wird die Berechnung von x , wenn man nicht auf die Urliste zurückgreifen muss, sondern bereits eine Häufigkeitstabelle vorhanden ist. Liegt dieser eine Klasseneinteilung zugrunde, so lässt sich daraus der Mittelwert allerdings nur näherungsweise bestimmen. Wenn insgesamt n Stichprobenwerte in m Klassen eingeteilt sind und wenn ui bzw. ki die Klassenmitte bzw. absolute Klassenhäufigkeit der i-ten Klasse ist, dann gilt 1 1 m x = (k 1 u 1 + k 2 u 2 + ... + k m u m ) = ∑ k i u i . n n i =1 Beispiel: Für die Fahrzeuggewichte von Tab. 1 beträgt der Mittelwert x = 901,77 kg. Auf Basis der vorgenommenen Klasseneinteilung erhält man statt des exakten Wertes den Näherungswert x ≈ 900,00 kg. Die Übereinstimmung mit dem exakten Wert ist natürlich umso besser, je feiner die Klasseneinteilung vorgenommen wird. Man beachte, dass das arithmetische Mittel i. Allg. mit keinem Stichprobenwert zusammenfällt, ja − bei einem diskreten Merkmal − zumeist nicht einmal mit irgendeiner möglichen 9 1.1 Univariate Datenbeschreibung Merkmalsausprägung übereinstimmen wird. Ferner ist die Bildung des Mittelswert nur auf metrischem Skalenniveau möglich, bei qualitativen Merkmalen ist sie sinnlos. Neben dem arithmetischen Mittel spielt auch der Median (oder Zentralwert) als Mittelwertmaß eine wichtige Rolle. Zu seiner Bestimmung wird die Stichprobe xl, x2, ..., xn der Größe nach geordnet, sodass sie als sogenannte Rangliste in der Form x(l) ≤ x(2) ≤ ... ≤ x(n) vorliegt. Bei ungeradem Stichprobenumfang n ist der Median ~ x dann nämlich gleich dem mittleren der Stichprobenwerte, bei geradem n gleich dem arithmetischen Mittel aus den beiden mittleren Werten, d.h. x (k +1) xɶ = x (k ) + x (k +1) 2 für n = 2k + 1 für n = 2k . x. Damit liegen stets gleich viele Stichprobenwerte unterhalb wie oberhalb von ~ Der Median ist ein Sonderfall eines allgemeineren Lagemaßes, nämlich des p-Quantils ~ xp ~ (für 0 < p < 1). Dabei ist x jener Wert, der von einem Anteil p aller Stichprobenwerte unterp schritten und von einem Anteil 1 − p überschritten wird. Seine explizite Berechnung erfolgt nach folgender Formel: x (k +1) xɶ p = x (k ) + x (k +1) 2 mit k = [pn], falls pn keine ganze Zahl mit k = pn, falls pn ganze Zahl (wobei k = [pn] in der ersten Zeile die nächst kleinere ganze Zahl an pn, also k + 1 die nächst x = ~ x 0.5 gerade das 50%größere ganze Zahl an pn bezeichnet). Somit stellt der Median ~ Quantil dar, während die 25%- bzw. 75%-Quantile auch erstes Quartil Q1 = ~ x 0.25 und drittes Quartil Q3 = ~ x 0.75 genannt werden. Während der Mittelwert streng genommen nur für quantitative Merkmale sinnvoll ist, können der Median und alle Quantile auch für ordinale Merkmale verwendet werden. Besitzen die Ausgangsdaten lediglich nominales Merkmalsniveau, eignet sich als Lagemaß einer solchen Stichprobe nur noch die Angabe des Modalwerts (oder Modus) xmod, welcher einfach als häufigster Wert des betrachteten Merkmals definiert ist (falls es diesen gibt). Zwei Stichproben können das gleiche Mittelwertmaß besitzen und trotzdem stark voneinander abweichen, indem die Stichprobenwerte mehr oder weniger um dieses Maß streuen. Dementsprechend wird die Häufigkeitsverteilung in einem Fall einen eher flachen, im anderen Fall einen eher steilen Verlauf aufweisen. Zur Kennzeichnung dieser Eigenschaft ist über das Lagemaß hinaus die Angabe eines Streuungsmaßes unerlässlich. Das wichtigste Streuungsmaß ist die Varianz s2. Diese ist für eine Stichprobe xl, x2, ..., xn mit dem Umfang n und dem Mittelwert x definiert durch s2 = n 1 n 1 2 2 ( x − x ) = ( x i − nx 2 ) . ∑ ∑ i n − 1 i =1 n − 1 i =1 Falls alle Stichprobenwerte xi zusammenfallen, gilt xi = x und folglich s2 = 0. In jedem anderen Fall ist s2 > 0. Die Wurzel von s2 nennt man die Standardabweichung s. 10 1.1 Univariate Datenbeschreibung Beispiel: Für die Fahrzeuggewichte von Tab. 1 lautet der Mittelwert x = 901,77 kg. Die Varianz ist gegeben durch s2 = 61436,50 kg2, und damit beträgt die Standardabweichung s = 247,86 kg. Liegt die Stichprobe als Klasseneinteilung vor, so erhält man wie vorhin bei der Berechnung des arithmetischen Mittels einen Näherungswert für s2, wenn man für jede Klasse die darin liegenden Stichprobenwerte als in der Klassenmitte befindlich annimmt. Für die gruppierten Fahrzeuggewichte berechnen wir: Kl.Nr. i 1 2 3 4 5 6 7 Summe Kl.Mitte ui 400 600 800 1000 1200 1400 1600 abs.Kl.H. ki 3 11 20 16 10 3 1 64 kiui 1200 6600 16000 16000 12000 4200 1600 57600 ki(ui− x )2 750000 990000 200000 160000 900000 750000 490000 4240000 Diesem Schema kann man unmittelbar als Näherungen x = 57600/64 = 900 sowie s2 = 4240000/63 = 67301,59 und folglich s = 259,43 entnehmen. Vergleiche zwischen den Streuungen in zwei Stichproben mittels s2 oder s sind nur dann sinnvoll, wenn die Werte in beiden Stichproben dieselbe Größenordnung besitzen. Ansonsten ist eine Relativierung von s auf den Mittelwert x angebracht. Die dadurch entstehende Größe v = s/ x heißt Variationskoeffizient, sie ist dimensionslos und wird meist in Prozenten angegeben. Besonders einfach kann die Streuung einer Stichprobe durch ihre Spannweite R = xmax − xmin erfasst werden, d.h. durch die Differenz zwischen dem größten und kleinsten Messwert. Diese schnell zu bildende Größe ist vor allem bei kleinem Stichprobenumfang durchaus geeignet, eine Vorstellung über die Streuung der Beobachtungswerte zu vermitteln, sie ist allerdings sehr stark durch Ausreißer beeinflusst. Dieser Abhängigkeit der Spannweite von Ausreißern versucht man dadurch entgegenzuwirken, dass man die Daten an den beiden äußersten Rändern der Stichprobe nicht einbezieht. Auf diese Weise erhält man etwa den sogenannten Interquartilabstand IQR, welcher als Abstand zwischen dem ersten und dritten Quartil definiert ist, also IQR = Q3 − Q1. Die folgende Übersicht zeigt, welche Skalenniveaus für die sinnvolle Berechnung der einzelnen Lage- und Streuungsmaße notwendig sind. Skala Modalwert nominal ordinal metrisch (Intervall) metrisch (Verhältn.) ja ja ja ja Lagemaße Streuungsmaße Median, Mittelwert Spannweite, Varianz, VariationsQuantile IQR Std.Abw. koeffizient ja ja ja ja ja ja ja ja ja ja 11 1.1 Univariate Datenbeschreibung Eine einfache graphische Darstellung, welche Aufschlüsse über Lage und Streuung einer Stichprobe erlaubt, sind die sogenannten Box-Plots (oder Box-and-Whiskers-Plots). Dabei wird um den Median ein Rechteck vom ersten zum dritten Quartil gezeichnet, welches 50% der Stichprobenwerte beinhaltet. Die von diesem Rechteck ausgehenden Striche zeigen die Lage des Minimums und des Maximums der Stichprobe an (siehe Abbildung). 1. Quartil Minimum 3. Quartil Mittelwert Maximum Median Box-Plots zum Vergleich der Körpergröße von n1 = 39 männlichen und n2 = 30 weiblichen Studenten Neben den Lage- und Streuungsmaßen gibt es noch weitere Kennzahlen zur Charakterisierung von Stichproben und deren Verteilungen. Dazu gehört u.a. die Schiefe g, welche ein Maß für die Symmetrie bzw. Asymmetrie der Verteilung eines metrisch skalierten Merkmals darstellt. Sie ist formelmäßig gegeben durch 12 1.1 Univariate Datenbeschreibung 1 n ⋅ ∑ (x i − x) 3 n i =1 . g= s3 Die Schiefe g ist dimensionslos, sie kann sowohl positiv als auch negativ sein. Für eine symmetrische Verteilung gilt g = 0, sie ist rechtsschief, falls g > 0 bzw. linksschief, falls g < 0 (siehe Abbildung). Empirische Verteilungen mit unterschiedlicher Schiefe linksschief g<0 x <~ x < xmod symmetrisch g=0 x =~ x = xmod rechtsschief g>0 x >~ x > xmod Zusammenfassung Das bei einer Untersuchung anfallende Datenmaterial schreibt man zweckmäßigerweise zuerst in einer so genannten Urliste zusammen, etwa in Form einer Tabelle, in der jede Zeile einer Beobachtungseinheit in der Stichprobe und jede Spalte einem Merkmal entspricht. Die Anzahl der Beobachtungseinheiten bestimmt den Stichprobenumfang, je nach der Anzahl der Merkmale spricht man von ein- oder mehrdimensionalen Stichproben. Die einzelnen Merkmale können nominales, ordinales oder metrisches Skalenniveau besitzen. Eine einfache und zugleich übersichtliche Darstellung des Datenmaterials einer eindimensionalen Stichprobe ist die Häufigkeitstabelle. Diese enthält neben den einzelnen Ausprägungen a1, a2, ..., am des beobachteten Merkmals die entsprechenden absoluten Häufigkeiten kl, k2, ...,km bzw. relativen Häufigkeiten h1, h2, ..., hm, wobei für i = 1,2,...,m gilt: hi = ki ≥ 0 und n m ∑h i =1. i =1 Zur Erreichung einer übersichtlicheren Darstellung ist es bei stetigen und häufig auch bei diskreten Merkmalen notwendig, die Merkmalsausprägungen in Klassen zusammenzufassen. Erfahrungsgemäß wählt man etwa m ≈ n Klassen bei einem Stichprobenumfang von n. Unbesetzte mittlere Klassen sollten durch geeignete Wahl von m bzw. der Klassengrenzen vermieden werden. Die Anzahl der Stichprobenwerte, die in die Klasse i fallen, heißt die entsprechende absolute Klassenhäufigkeit ki. Nach Division durch den Stichprobenumfang n ergibt sich daraus die relative Klassenhäufigkeit hi = ki/n. Schließlich ist die relative Summenhäufigkeit Hi gleich der auf den Stichprobenumfang bezogenen Anzahl der Stichprobenwerte in den Klassen 1,2,...,i, d.h. 13 1.1 Univariate Datenbeschreibung i Hi = ∑ h j . j=1 Nach der Klasseneinteilung treten die ursprünglichen Beobachtungsdaten nicht mehr in Erscheinung. Vielmehr wird angenommen, dass alle Werte einer Klasse i in der zugehörigen Klassenmitte ui liegen. Graphisch lassen sich eindimensionale Stichproben z.B. durch Stabund Kreisdiagramme bzw. bei gruppierten Daten durch Histogramme veranschaulichen. Die Lagemaße kennzeichnen die Werte einer Stichprobe insofern, als sie deren „Lage“ jeweils durch eine einzige Zahl beschreiben. Am wichtigsten ist das arithmetische Mittel x , das man durch einfache Durchschnittsbildung erhält. Demgegenüber ist der Median ~ x als spezielles Quantil jene Zahl, die von ebenso vielen Stichprobenwerten unter- wie überschritten wird. Weitere Quantile sind die beiden Quartile Q1 und Q3. Der Modalwert ist der häufigste Wert innerhalb einer Stichprobe. Offensichtlich ist bei nominalen und ordinalen Merkmalen die Bildung des arithmetischen Mittels sinnlos, ebenso die Bildung des Medians bei nominalen, nicht aber bei ordinalen Merkmalen. Bei metrischen Merkmalen findet meist das arithmetische Mittel Verwendung. Da dieses im Unterschied zum Median von extremen Stichprobenwerten, sogenannten „Ausreißern“, stark beeinflusst wird, kann sich bei unsymmetrischer Häufigkeitsverteilung der Median als das zweckmäßigere Lagemaß erweisen. Bei symmetrischen Verteilungen fallen x und ~ x zusammen; eingipfelige unsymmetrische Verteilungen mit ~ x < x heißen rechtsschief, solche mit x < ~ x linksschief. Zur Kennzeichnung der Streuung der Werte einer Stichprobe (für ein metrisches Merkmal) sind die Spannweite R, d.i. der maximale Abstand der Stichprobenwerte, der Interquartilabstand IQR, d.i. der Abstand der beiden Quartile und schließlich die Varianz s2 bzw. die Wurzel aus s2, d.i. die Standardabweichung s gebräuchlich. Lage und Streuung von Stichproben können übersichtlich mit Hilfe von Box-Plots dargestellt werden. 1.2 Multivariate Datenbeschreibung Wenngleich auch bisher schon mehrere Merkmale je Beobachtungseinheit betrachtet und datenmäßig erfasst wurden, so erfolgte doch deren statistische Auswertung stets getrennt. In diesem Abschnitt sollen nun der Zusammenhang zwischen zwei Merkmalen, also z.B. Körpergröße und Körpergewicht, Haarfarbe und Augenfarbe oder Geschwindigkeit und Bremsweg untersucht sowie Art und Ausmaß der Abhängigkeiten zwischen diesen Merkmalen beschrieben werden. Zu diesem Zweck sollen zwei Situationen auseinandergehalten werden, je nachdem, ob die beiden betrachteten Merkmale qualitativer oder quantitativer Natur sind. Kontingenztafeln Wir betrachten zunächst den Fall, dass beide Beobachtungen qualitative Merkmale betreffen, deren Ausprägungen also in (zwei oder mehrere) begrifflich unterscheidbare Klassen ein- 14 1.2 Multivariate Datenbeschreibung geteilt werden können. Eine derartige Situation ist z.B. dann gegeben, wenn Haarfarbe und Augenfarbe oder − wie in folgendem Beispiel − Geschlecht und Rauchgewohnheiten miteinander verglichen werden sollen. Beispiel: In einer Gruppe von Studenten befinden sich 39 Männer und 30 Frauen. Unter den Männern sind 19 Raucher, unter den Frauen sind es dagegen 10. Kann von diesen Daten auf einen Zusammenhang zwischen den beiden Merkmalen Geschlecht und Rauchgewohnheiten geschlossen werden? Tab. 2. Vierfeldertafel für die Merkmale Geschlecht und Rauchen männlich weiblich Raucher n11 = 19 n21 = 10 n.1 = 29 Nichtraucher n12 = 20 n22 = 20 n.2 = 40 n1. = 39 n2. = 30 n = 69 Eine übersichtliche Darstellung des Datenmaterials erreicht man in Form einer so genannten Vierfeldertafel, in der die absoluten Häufigkeiten aller möglichen Kombinationen von Merkmalsausprägungen eingetragen sind. Die Anzahl der männlichen Raucher bezeichnen wir mit n11 = 19, und entsprechend sind die Besetzungszahlen der weiteren Klassen durch n12, n21 und n22 gegeben (siehe Tab. 2). Aus ihnen lassen sich die Randhäufigkeiten berechnen, das sind die Zeilensummen n1. = n11 + n12 = 39 und n2. = n21 + n22 = 30, die die Besetzungszahlen für das Merkmal Geschlecht angeben, und die Spaltensummen n.1 = n11 + n21 = 29 und n.2 = n12 + n22 = 40, die die Besetzungszahlen für das Merkmal Rauchen darstellen (dabei gibt der Punkt jeweils an, über welchen Index summiert wurde). Die Gesamtzahl aller Studenten ist somit n = n1. + n2. = n.1 + n.2 = 69. Um aus den oben eingeführten absoluten Häufigkeiten die entsprechenden relativen Häufigkeiten zu erhalten, dividieren wir durch den Stichprobenumfang n. Berechnung der relativen Häufigkeiten für Tab. 2 männlich weiblich Raucher h11 = 0,275 h21 = 0,145 h.1 = 0,420 Nichtraucher h12 = 0,290 h22 = 0,290 h.2 = 0,580 h1. = 0,565 h2. = 0,435 1 Aus dieser Tabelle geht hervor, dass sich unsere Stichprobe aus 56,5% Männern und 43,5% Frauen bzw. aus 42% Rauchern und 58% Nichtrauchern zusammensetzt. Mit Hilfe dieser relativen Häufigkeiten kann man sich schon ein grobes Bild von der Abhängigkeit zwischen den beiden betrachteten Merkmalen verschaffen. Nehmen wir nämlich an, dass zwischen beiden Merkmalen Unabhängigkeit besteht, so müsste der Prozentsatz der Raucher (jeweils innerhalb der Männer bzw. Frauen) für Männer und Frauen gleich groß, und zwar gleich h.1 = 0,42 sein. Das bedeutet beispielsweise für die männlichen Raucher, dass n11 / n1. = h.1 bzw. n11 15 1.2 Multivariate Datenbeschreibung = n1.⋅h.1 = n⋅h1.⋅h.1 sein muss. Wir können daher im Fall der Unabhängigkeit der beiden Merkmale die folgenden absoluten Klassenhäufigkeiten erwarten: e11 = n⋅h1.⋅h.1 = 16,4, e12 = n⋅h1.⋅h.2 = 22,6, e21 = n⋅h2.⋅h.1 = 12,6, e22 = n⋅h2.⋅h.2 = 17,4. Ein Vergleich dieser erwarteten Ergebnisse mit den tatsächlich beobachteten Größen n11, n12, n21 und n22 (Tab. 2) zeigt jedoch deutliche Unterschiede, und es könnte vermutet werden, dass allgemein der Anteil der Raucher unter den Männern größer ist als unter den Frauen. Präzise Aussagen liefert erst ein statistischer Test, nämlich der χ2-Test. Im Allgemeinen können die beiden Merkmale natürlich auch mehr als zwei verschiedene Merkmalsausprägungen aufweisen. Betrachtet man die Merkmale X und Y, die in den Ausprägungen a1, a2, ..., ak bzw. bl, b2, ..., bm vorkommen, so kann man die Besetzungszahlen nij der einzelnen Klassen in Form einer Kontingenztafel anordnen. (Die Vierfeldertafel ist also ein Spezialfall einer Kontingenztafel für k = m = 2.) Allgemeine Form einer Kontingenztafel für zwei Merkmale mit k bzw. m Ausprägungen b1 b2 ⋯ a1 n11 n12 ⋯ n1 j ⋯ n1m n1. a2 n 21 n 22 ⋯ n 2 j ⋯ n 2 m n 2. ⋮ ⋮ ⋮ ai n i1 ni2 ⋮ ⋮ ⋮ ak bj ⋮ ⋯ n ij ⋮ ⋯ bm ⋮ ⋯ n im ⋮ ⋮ n i. ⋮ n k1 n k 2 ⋯ n kj ⋯ n km n k. n .1 n n .2 ⋯ n. j ⋯ n .m Die Randhäufigkeiten ni. und n.j sind wieder die Zeilen- bzw. Spaltensummen, und die Gesamtsumme n entspricht der Anzahl aller Beobachtungen. Die relativen Häufigkeiten ergeben sich genauso wie bei der Vierfeldertafel, und auch die Überlegungen zur Unabhängigkeit gelten hier unverändert. Korrelation Zu den in der Statistik am häufigsten verwendeten Verfahren zählen zweifellos die Korrelations- und die Regressionsanalyse. Beide Verfahren sind dazu geeignet, Beziehungen zwischen zwei (oder mehreren) quantitativen Merkmalen zu studieren, jedoch zu jeweils verschiedenem Zweck. Wir betrachten im Folgenden zwei Variablen X und Y, die mit einer Stichprobe (x1,y1), (x2,y2), ..., (xn,yn) vom Umfang n erhoben wurden. Zunächst nehmen wir an, dass keine Unterscheidung in eine abhängige und eine unabhängige Variable möglich oder sinnvoll ist, sondern beide Größen einander gleichberechtigt gegenüberstehen. Die ältesten Beispiele für diese für die Korrelationsanalyse typische Situation stammen aus der Biostatistik und betreffen den Zusammenhang quantitativer Merkmale zwischen Verwandten, also z.B. die Körpergröße von Brüdern und Schwestern. Eine Beurteilung des Zusammenhanges zwischen derartigen Größen ermöglicht der (empirische) Korrelationskoeffizient r, der als Maß für die „Kovariabilität“ der beiden Merkmale angesehen werden kann; er gibt den Grad der Linearität des Zusammenhanges zwischen den beobachteten Größen an und wird wie folgt berechnet: 16 1.2 Multivariate Datenbeschreibung r= s xy sxsy . Dabei bedeuten sx und sy die Standardabweichungen der x- bzw. y-Werte und sxy die Kovarianz der (x,y)-Wertepaare der Stichprobe gemäß s xy = 1 n 1 n ( x i − x )( y i − y) = ∑ x i y i − nxy . ∑ n − 1 i =1 n − 1 i =1 Ferner gilt stets −1 ≤ r ≤ 1. Beispiel: In Tab. 3 ist der systolische Blutdruck für 16 Zwillingspaare angegeben. Wir fragen nach der Güte des linearen Zusammenhanges zwischen den Blutdruckwerten der Zwillingspaare und berechnen dazu den Korrelationskoeffizienten der Stichprobe. Tab. 3. Systolischer Blutdruck (in mm Hg) von identischen Zwillingen 1. Zwilling X 2. Zwilling Y 152 123 124 188 121 150 165 144 123 174 155 138 127 182 117 160 143 160 125 170 119 182 170 117 145 130 118 186 172 120 160 138 Korrelogram m 200 190 180 Blutdruck Y 170 160 150 140 130 120 110 100 100 120 140 160 180 200 Blutdruck X Um eine ungefähre Vorstellung über den möglichen Zusammenhang zwischen den x- und yWerten zu gewinnen, zeichnen wir die sechzehn Wertepaare in ein (x,y)-Koordinatensystem, wobei sich ein sogenanntes Korrelogramm (oder Streudiagramm) ergibt (siehe Abbildung). Dieses vermittelt den Eindruck, dass die entsprechenden Punkte annähernd auf einer Geraden liegen, d.h., dass ein linearer Zusammenhang zwischen den Größen X und Y besteht. Der Reihe nach berechnen wir nun sx = 24,26, sy = 23,07 und sxy = 515,11; daraus ergibt sich der Korrelationskoeffizient r = sxy / (sxsy) = 0,92. 17 1.2 Multivariate Datenbeschreibung Zur Beurteilung dieses Wertes betrachte man zunächst die theoretisch möglichen Grenzfälle r = 0 und r = ±l. Allgemein bedeutet r = 0, dass aus den beobachteten Daten kein linearer Zusammenhang erkennbar ist. Ist r = 1 oder r = −1, dann liegen alle Beobachtungspunkte im Korrelogramm exakt auf einer Geraden, sonst hingegen nicht. Je näher r bei 1 (oder −1) liegt, desto genauer folgen die Punkte der Geraden im Korrelogramm. Ein positiver Korrelationskoeffizient bedeutet, dass für wachsende x-Werte im Durchschnitt auch die y-Werte ansteigen; ist r negativ, so fällt y im Mittel für größer werdendes x. Der Korrelationskoeffizient ist eine dimensionslose Größe, sein Wert ist unabhängig von den Maßeinheiten der x- bzw. y-Werte. In obigem Beispiel sind die Blutdruckwerte der beiden Zwillinge positiv korreliert: Mit steigendem Blutdruck des ersten Zwillings nimmt auch der des zweiten Zwillings zu. Der hohe Wert von r = 0,92 für den Korrelationskoeffizienten zeigt einen sehr guten linearen Zusammenhang der beiden Merkmale in den beobachteten Daten. Der Korrelationskoeffizient r ist kein Maß für den Zusammenhang zweier Merkmale schlechthin, sondern r beurteilt nur den linearen Zusammenhang; es ist daher durchaus möglich, dass r nahe bei 0 liegt, obwohl die Datenpaare z.B. recht genau dem Verlauf einer Parabel folgen. Zur richtigen Einschätzung des rechnerischen Ergebnisses ist daher unbedingt auch das Korrelogramm zu studieren. Ein hoher r-Wert sagt nur statistisch etwas über den Zusammenhang der beobachteten Daten aus. Keineswegs darf eine solcherart errechnete Abhängigkeit ohne jede weitere Überlegung als Kausalzusammenhang interpretiert werden. In solch einem Fall kann nämlich Y von X oder auch X von Y abhängen, die beiden Merkmale können einander aber auch gegenseitig beeinflussen. Oder aber es gibt noch eine dritte Größe Z im Hintergrund, welche sowohl X als auch Y beeinflusst. Bei einem Zusammenhang dieser Art spricht man von einer Scheinkorrelation. Der Korrelationskoeffizient r kann nur gebildet werden, wenn die Merkmale X und Y beide quantitativ sind. Ist mindestens eines der beiden Merkmale nur ordinal, so kann man sich so behelfen, dass man statt der Originalwerte x1, x2, ..., xn bzw. y1, y2, ..., yn die Rangzahlen R(x1), R(x2), ..., R(xn) bzw. R(y1), R(y2), ..., R(yn) nimmt, die diesen bei einer aufsteigenden Sortierung zukommen. Durch Einsetzen in obige Formel für r ergibt sich dann der sogenannte Rangkorrelationskoeffizient von Spearman n 6∑ d i rs = 1 − 2 i =1 n (n − 1)(n + 1) mit d i = R ( x i ) − R ( y i ) . Genau wie der Korrelationskoeffizient r kann auch rs nur Werte in dem Intervall [−1,1] annehmen, allerdings mit dem Unterschied, dass die Extremwerte +1 und −1 genau dann angenommen werden, wenn ein durchgängiger monotoner Zusammenhang (und zwar wachsend bzw. fallend, je nach Vorzeichen) zwischen den ursprünglichen x- und y-Werten besteht. Regression In diesem Abschnitt wollen wir zwei quantitative Größen studieren, bei denen die Werte des einen Merkmals ursprünglich bekannt oder vorgegeben sind, während die Werte des zweiten Merkmals von diesen − wenn auch mit zufallsbedingten Schwankungen − abhängen mögen. 18 1.2 Multivariate Datenbeschreibung Die Regressionsanalyse wird angewendet, wenn der formelmäßige Zusammenhang bestimmt und Werte des einen Merkmals zu gegebenen Werten des anderen Merkmals vorhergesagt bzw. geschätzt werden sollen. Historisch geht die Bezeichnung Regression auf Beobachtungen über den Zusammenhang zwischen der Größe von Vätern und deren Söhnen zurück, die zuerst von F. Galton gemacht wurden: Es zeigte sich, dass große Väter im Durchschnitt zwar auch große Söhne haben, diese sind aber zumeist etwas kleiner als ihre Väter; entsprechendes gilt für kleine Väter. Galton schloss daraus auf einen Rückschritt (Regress) zur durchschnittlichen Größe der Population. Beispiel: Aus einer Stichprobe von zwölf Frauen sei das Alter X (in Jahren) sowie der systolische Blutdruck Y (in mm Hg) gegeben (Tab. 4). Kann damit allgemein aus der Kenntnis des Alters einer Frau eine Aussage über deren ungefähren Blutdruck gemacht werden? Tab. 4. Alter und systolischer Blutdruck von Frauen Alter X (in Jahren) Syst. Blutdruck Y (in mm Hg) 42 137 50 168 52 147 25 132 32 121 36 134 38 133 60 165 67 188 68 165 70 180 40 128 Wir stellen die zwölf Wertepaare zunächst wieder in einem Korrelogramm dar und erkennen, dass Y bis auf zufallsbedingte Schwankungen linear von X abhängt, d.h., dass wir den x-yZusammenhang annähernd durch eine Gerade beschreiben können. Diejenige Gerade, die diesen Zusammenhang in gewissem Sinn am besten erfasst, heißt (empirische) Regressionsgerade von Y bezüglich X; sie minimiert die Summe der Quadrate der senkrechten Abstände (Prinzip der kleinsten Quadrate). Die Regressionsgerade lässt sich allgemein darstellen durch 19 1.2 Multivariate Datenbeschreibung y = a + bx (a,b konstant) oder y − y = b (x − x ). Dabei sind x und y die arithmetischen Mittel der x- und y-Werte. Den Proportionalitätsfaktor b nennt man Regressionskoeffizient. Zu seiner Berechnung ermitteln wir zuerst die Varianz sx2 der x-Werte und die Kovarianz sxy der (x,y)-Wertepaare der Stichprobe; der Regressionskoeffizient ergibt sich dann aus b= s xy sx 2 , die Konstante a aus a = y − bx . Für die Daten aus obigem Beispiel berechnen wir nun sukzessive x = 48,33, y = 149,83, sx2 = 230,61 und sxy = 307,33. Somit erhalten wir b = sxy / sx2 = 1,33 und a = y − b x = 85,42. Die Regressionsgerade ist also durch die Gleichung y = 85,42 + 1,33 x bestimmt und ebenfalls in obiger Abbildung dargestellt. Sie erlaubt es uns, zu einer vorgegebenen Ausprägung x des Merkmals X einen Näherungswert y des Merkmals Y zu finden, d.h., zu einem gewissen Alter einen erwarteten (durchschnittlichen) Wert für den systolischen Blutdruck anzugeben. Ein Maß dafür, wie genau die einzelnen Beobachtungen der Regressionsgeraden folgen, ist das so genannte Bestimmtheitsmaß r2, welches als Quadrat des Korrelationskoeffizienten r berechnet wird. Das Bestimmtheitsmaß kann als Anteil der durch Regression erklärten Variation an der Gesamtvariation interpretiert werden, es gilt stets 0 ≤ r2 ≤ 1. Der Wert r2 = 1 wird genau dann angenommen, wenn alle Punkte auf der Regressionsgeraden liegen. In diesem Fall spricht man davon, dass die gesamte Streuung der y-Werte durch die Regression erklärt wird. Je mehr die Punkte von der Regressionsgeraden abweichen, desto kleiner wird das Bestimmtheitsmaß. Von der Regressionsgeraden von Y bezüglich X (fast immer) verschieden ist die Gerade von X bezüglich Y, die die Summe der Quadrate der waagrechten Abstände minimiert. Sie kann vollkommen analog zu den obigen Überlegungen bestimmt werden, wobei lediglich die xWerte gegen die y-Werte auszutauschen sind. Im Allgemeinen ist aber eines der beiden Merkmale als ursprüngliche, bekannte oder unabhängige Variable ausgezeichnet, aus der man mittels einer Regressionsformel die unbekannte, abhängige Variable näherungsweise berechnen möchte. Die Ermittlung einer Regressionsgeraden ist allerdings nur dann sinnvoll, wenn sich im Korrelogramm tatsächlich ein annähernd linearer Zusammenhang und nicht etwa ein deutlicher Kurvenverlauf zeigt. Dann wäre unter Umständen ein Verfahren der nichtlinearen Regression zielführend, wobei gelegentlich eine Zurückführung auf den linearen Fall möglich ist, wie das nachfolgende Beispiel zeigt. Beispiel: Für ein radioaktives Präparat wurden nach x Tagen die folgenden Aktivitäten gemessen: Zeit X (in Tagen) Aktivität Y (in Zerfällen/Minute) 0 5 10 15 20 25 30 510 397 307 240 181 142 108 20 1.2 Multivariate Datenbeschreibung Wir wollen mit Hilfe dieser Daten einen formelmäßigen Zusammenhang zwischen den Größen X und Y finden und daraus die Halbwertszeit für den Zerfallsprozess bestimmen. Trägt man die sieben Wertepaare (xi,yi) als Punkte in ein Korrelogramm ein, so kann man deutlich einen abnehmenden nichtlinearen Kurvenverlauf erkennen (vgl. untenstehende Abbildung). Tatsächlich wird ein radioaktiver Zerfall durch eine Exponentialfunktion der Form y = y 0 e − λx beschrieben, wobei die Konstante y0 die Aktivität zum Zeitpunkt x = 0 und λ die sogenannte Zerfallskonstante bedeuten. Eine häufig angewandte Methode zur Bestimmung dieser Größen besteht nun darin, diese Gleichung zu logarithmieren, also ln y = ln y 0 − λx zu bilden, und auf diese Weise den exponentiellen Zusammenhang zwischen X und Y auf einen linearen Zusammenhang zwischen X und Z = ln Y mit a = ln y0 und b = −λ zurückzuführen. Die Anwendung der linearen Regressionsrechnung auf die entsprechenden Wertepaare (xi,zi) liefert unmittelbar die Konstanten a = 6,24 und b = −0,052, somit y0 = ea = 513,84 und λ = −b = 0,052. Die Zerfallskurve wird daher durch die Gleichung y = 513,84e −0, 052 x beschrieben und ermöglicht für jeden Zeitpunkt x die näherungsweise Bestimmung der entsprechenden Aktivität y(x). Die Halbwertszeit τ ergibt sich schließlich aus der Gleichung y(τ) = 0,5 y0 und beträgt somit τ = −(ln 0,5)/λ = 13,3 Tage. Zusammenfassung Eine zweidimensionale Stichprobe qualitativer Merkmale kann in übersichtlicher Form durch eine Kontingenztafel dargestellt werden. Kommen die Merkmale A und B in den Ausprägungen A1, A2, ..., Ak bzw. Bl, B2, ..., Bs vor, so geben die Besetzungszahlen nij in der i-ten 1.2 Multivariate Datenbeschreibung 21 Zeile bzw. j-ten Spalte der Kontingenztafel die Anzahl jener Elemente der Stichprobe an, die vom Typ Ai und zugleich vom Typ Bj sind. Besitzt jedes Merkmal nur zwei verschiedene Ausprägungen, d.h. k = s = 2, spricht man von einer Vierfeldertafel. Die Randhäufigkeiten, das sind die Zeilen- bzw. Spaltensummen der Kontingenztafel, bestimmen die Randverteilungen der einzelnen Merkmale. Eine Division sämtlicher absoluter Größen durch den Stichprobenumfang n liefert die relativen Häufigkeiten, mit deren Hilfe erste grobe Überlegungen zur Abhängigkeit der betrachteten Merkmale angestellt werden können. Die Einschätzung der Stärke des linearen Zusammenhangs zwischen zwei quantitativen Merkmalen ist durch den Korrelationskoeffizienten r möglich, der gemäß r = sxy / (sxsy) definiert ist (sx, sy Standardabweichungen der x- bzw. y-Werte, sxy Kovarianz). Der Korrelationskoeffizient gibt den Grad der Linearität des Zusammenhanges zwischen den beobachteten Größen an, er kann aber auch − im Rahmen einer Regressionsanalyse − als Maß für die Güte der Anpassung der Regressionsgeraden an die Datenpunkte im Korrelogramm interpretiert werden. Ein hoher Wert des Korrelationskoeffizienten lässt jedoch noch keinen Schluss auf die Art oder Richtung der Abhängigkeit zwischen den beiden Merkmalen zu; bei einer Scheinkorrelation besteht − trotz eines hohen r-Wertes − überhaupt kein unmittelbarer Zusammenhang zwischen den entsprechenden Größen. Ferner ist für die Beurteilung von r die Anzahl n der Beobachtungspaare wesentlich. Mit zunehmendem n steigt auch die Zuverlässigkeit des Korrelationskoeffizienten, während etwa große r-Werte bei geringem Stichprobenumfang nur wenig Aussagekraft besitzen. (Im Fall n = 2 gilt sogar stets r = ±1.) Die Regressionsanalyse ermöglicht die Beschreibung eines funktionellen Zusammenhanges zwischen zwei (oder mehreren) quantitativen Größen. Ausgangspunkt ist eine Stichprobe von Zahlenpaaren, die graphisch in einem (x,y)-Diagramm in Form eines Korrelogramms veranschaulicht werden können. Die im Sinne der Methode der kleinsten Quadrate bestmögliche Approximation dieser Datenpunkte im Korrelogramm durch eine Gerade stellt die Regressionsgerade dar. Sie ist durch die Gleichung y = a + bx gegeben, wobei die Konstante a durch a = y − b x und der Regressionskoeffizient b durch b = sxy /sx2 festgelegt sind ( x , y arithmetische Mittel, sx2 Varianz, sxy Kovarianz). Diese Regressionsgerade, deren Ermittlung allerdings nur sinnvoll ist, wenn das Korrelogramm oder auch andere Überlegungen einen annähernd linearen Zusammenhang vermuten lassen, ermöglicht es, zu jedem vorgegebenen Wert des einen Merkmals einen durchschnittlichen Wert für das zweite Merkmal anzugeben.