Methodenlehre II

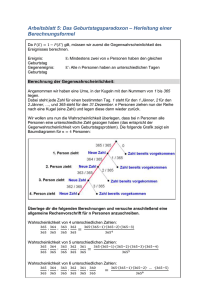

Werbung