Wahrscheinlichkeits- rechnung und Statistik

Werbung

Wahrscheinlichkeitsrechnung und

Statistik

21

21.1 Zufall und Wahrscheinlichkeit

21.1.1 Wahrscheinlichkeit

Wenn Begriffe stark durch den Alltag geprägt sind, muss man bei der Mathematisierung besonders vorsichtig sein. Für Zufall und Wahrscheinlichkeit ist das sicher so.

(Wie wahrscheinlich ist es, dass es morgen regnet? Sicher scheint die Sonne!)

Wie groß ist die Chance, mit zwei Würfeln die Gesamtaugenzahl 7 zu werfen? Fragen wie diese sind Musterbeispiele für einfache Experimente. Wahrscheinlichkeit und

Zufall sind miteinander eng verbundene Begriffe. Mit Zufall bezeichnen wir im Alltag

meist Ereignisse, die wir nicht beeinflussen oder vorhersehen können. Die Definition

hängt also implizit von unserem Kenntnisstand und unseren Möglichkeiten ab. Die

Diskussion, ob es letztendlich wirklichen“ Zufall gibt, führt einerseits zur Quanten”

mechanik und andererseits in die Metaphysik. In den Naturwissenschaften beschränkt

man sich daher auf axiomatische Annahmen über Zufallsereignisse und deren Wahrscheinlichkeiten, die im Einzelfall natürlich Idealisierungen sind.

Ein Ereignis kann eintreffen (wahr sein) oder auch nicht (falsch sein). Ein Experiment stellt fest, ob das Ereignis eintritt ( erfolgreich ist“) oder nicht. Man ist versucht,

”

den Begriff Wahrscheinlichkeit so zu definieren: Wenn man dieses Experiment nmal wiederholt und die Zahl der erfolgreichen Experimente mit m bezeichnet, so gilt

für die Wahrscheinlichkeit, mit der das Ereignis A eintrifft,

m

.

n→∞ n

P (A) = lim

(21.1)

Da man aber nie wirklich unendlich viele Versuche durchführen kann, muss man die

Wahrscheinlichkeit theoretisch begründen oder einfach postulieren. Man nennt sie daher a-priori Wahrscheinlichkeit. Die a-priori Wahrscheinlichkeit, dass bei einem

perfekten Würfel die Zahl 6 geworfen wird, ist offenbar 1/6. An diverse kombinatorische Regeln wird in M.21.1 erinnert.

614

21 Wahrscheinlichkeitsrechnung und Statistik

M.21.1 Kurz und klar: Kombinatorik

Hier folgt eine sehr kurze Erinnerung an die wichtigsten Abzählregeln.

Variation: Möglichkeiten, aus einem Alphabet mit n Zeichen (mit Zurücklegen) Worte mit

k Zeichen zu bilden; Anzahl Vk = nk . (Beispiel: Es gibt 105 fünfstellige Dezimalzahlen; dabei zählen auch 00000 und andere fünfstellige Zahlen mit vorlaufenden

Nullen.)

Permutation: Alle verschiedenen Anordnungen von n verschiedenen Elementen; Anzahl

Pn = n! (Beispiel: Es gibt 5!=120 Möglichkeiten, die fünf Buchstaben {a,b,c,d,e}

anzuordnen.)

Permutation von Gruppen: Alle unterscheidbaren Anordnungen von insgesamt n Elementen, die in k Untergruppen von jeweils ni gleichen Elementen eingeteilt sind; Anzahl

Pn,k = Qk

n!

i=1 ni !

.

(Beispiel: Es gibt 5!/(2! 2 !1!) = 30 unterscheidbare Möglichkeiten, die fünf Buchstaben {a,a,b,b,c} anzuordnen.

Kombination: Auswahlmöglichkeiten

von k Elementen aus einer Menge von n Elementen

n

(ohne Zurücklegen), Anzahl k (Beispiel: Lotterie 6 aus 45: Es gibt 45

6 = 8145060

Möglichkeiten.)

Zwei Ereignisse gibt es auf jeden Fall: das unmögliche Ereignis Φ ( der Würfel

”

zeigt keine der Augenzahlen 1 bis 6“) und das sichere Ereignis E ( der Würfel zeigt

”

eine der Augenzahlen zwischen 1 und 6 “, der Hund folgt mir, oder er tut es nicht “).

”

Um die Wahrscheinlichkeiten zu normieren, nehmen wir an, dass P (Φ) = 0 und

P (E) = 1 ist. Alle anderen Ereignisse haben also einen Wert 0 ≤ P ≤ 1.

Wir müssen etwas präziser werden. Man kann Ereignisse wie Mengen und deren

Elemente behandeln und die Wahrscheinlichkeiten als Mengenmaße (vgl. unseren

Ausflug in die Maßtheorie in Kap. 5) definieren. Dazu wollen wir alle möglichen

Ergebnisse eines Versuchs als Elementarereignisse bezeichnen, die so definiert sind,

dass sie nicht gleichzeitig zutreffen können. Ein Elementarereignis ist also zum Beispiel, dass ein Würfelwurf den Wert 3 ergibt. Ein Ereignis ist eine aus solchen Elementarereignissen bestehende Menge. Die Menge {3, 5} beschreibt das Ereignis, dass

der Wurf entweder 3 oder 5 ergibt. Die Menge aller möglichen Elementarereignisse

ist der Wahrscheinlichkeitsraum E, das sichere Ereignis. Im Zusammenhang mit Experimenten und Stichproben nennt man E auch Grundgesamtheit. Die leere Menge

beschreibt das unmögliche Ereignis Φ. Unser Axiomensystem weist nun jedem Ereignis, also jeder Menge, eine Zahl zu. Diese bezeichnet die Wahrscheinlichkeit, dass

der Versuch eines der Ereignisse der Menge ergeben hat. (Mengenfunktionen oder

Maße ähnlicher Art haben wir schon in Kap. 5 besprochen.)

21.1 Zufall und Wahrscheinlichkeit

615

Verschiedene Ereignisse kann man mit den Definitionen der Mengenlehre behandeln und zu einem neuen Ereignis auf verschiedene Arten zusammenfassen.

• C = A + B : entweder A oder B oder beide treten ein (Vereinigungsmenge).

• C = A B : sowohl A als auch B treten ein (Durchschnittsmenge).

Neben A B und A + B sind noch folgende Operationen nützlich:

• A : Elemente von E, die nicht in A enthalten sind (Komplementärmenge).

• C = A − B ≡ A B : in A aber nicht in B enthalten (Differenzmenge, oft auch mit

A\B bezeichnet).

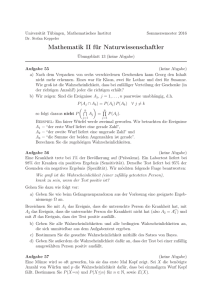

Die Mengen werden oft durch so genannte Venn-Diagramme dargestellt (Abb. 21.1).

Man kann grafisch leicht bekannte Zusammenhänge, wie etwa den Satz von De Morgan, zeigen:

A+ B = A B , AB = A + B .

(21.2)

Wenn E insgesamt n Elementarereignisse enthält, dann gibt es offenbar 2n mögliche

E

A

AB

B

Abb. 21.1 Venn-Diagramm für

überlappende Ereignismengen.

Vereinigung und Durchschnitt folgen

den üblichen Regeln der Mengenlehre.

Untermengen, also 2n denkbare Ereignisse. Die Menge E aller zufälligen Ereignisse

enthält also insbesondere auch E und Φ, zu jedem A ⊂ E natürlich auch A und auch

alle Kombinationen A + B. Sie ist daher ein Körper (siehe M.2.2). Wenn man beliebig viele (abzählbar unendlich viele) Ereignisse zulässt und auch alle Vereinigungsmengen und Durchschnittsmengen, so handelt es sich sogar um einen so genannten

Borelschen Mengenkörper.

Beispiel: Wenn E die reellen Zahlen R bezeichnet, so muss man als Ereignisse Intervalle

und Punkte auf den reellen Zahlen betrachten, sowie alle Vereinigungs- und Durchschnittsmengen dieser Intervalle und Punkte. Punkte werden allerdings meist die Wahrscheinlichkeit

null haben. Elementarereignisse sind dann disjunkte Teilmengen, wie wir sie schon bei der

Einführung der Integration in Kap. 5 besprochen haben.

Es ist zum Beispiel sinnvoll zu fragen, ob die Zerfallsdauer eines instabilen Elementarteilchens zwischen 10 und 10.1 s liegt. Die Wahrscheinlichkeit, dass sie genau 10 s ist, ist allerdings null. Dazu müsste sie ja tatsächlich genau 10.00000. . . s sein. Man erkennt die Tücke der

reellen Zahlen.

616

21 Wahrscheinlichkeitsrechnung und Statistik

Kolmogorow hat ein Axiomensystem für die Wahrscheinlichkeitsrechnung aufgestellt, in dessen Rahmen wir uns bewegen. Folgende Grundsätze gehören dazu:

• Jedes Ereignis A hat eine Wahrscheinlichkeit P (A) ≥ 0.

• Das sichere Ereignis E hat die Wahrscheinlichkeit P (E) = 1.

• Für disjunkte Ereignisse (A B = Φ) gilt P (A + B) = P (A) + P (B), die Wahrscheinlichkeiten addieren sich also.

Man sieht daraus leicht einige bekannte Eigenschaften, wie etwa

A ⊂ B ⇒ P (A) ≤ P (B)

(21.3)

A B 6= Φ ⇒ P (A + B) = P (A) + P (B) − P (A B) .

(21.4)

oder

Wie groß ist die Wahrscheinlichkeit, dass es regnet, wenn wir einen Regenschirm

mitgenommen haben? (Manche behaupten, sie wäre null!) Diese Frage nach möglichen Abhängigkeiten ist oft sehr wichtig. Sind die Ereignisse voneinander unabhängig

oder nicht?

Wir bezeichnen die bedingte Wahrscheinlichkeit, dass A eintritt, falls B eingetreten ist, mit P (A|B) (gesprochen: P (A wenn B)“). Wie groß ist P (A|B)? A und

”

B gehören beide zum Wahrscheinlichkeitsraum und sind also Teilmengen von E. Offenbar muss P (A|E) = P (A) und P (B|E) = P (B) gelten, da ja E sicher eintritt.

Wenn sich A und B ausschließen, dann ist natürlich P (A|B) = 0, da ja niemals A

und B gleichzeitig wahr sein können. Wenn hingegen B ⊂ A wäre, dann ist sicher

P (A|B) = 1. Ein Beispiel dafür wäre die Frage: Wie wahrscheinlich ist es, eine

”

gerade Zahl zu würfeln, wenn man die Zahl 6 gewürfelt hat?“

Man fragt also nach der Wahrscheinlichkeit der Ereignisse, die in A B sind (vgl.

Abb. 21.1P (A B)) , im Vergleich zu denen, die in B sind, also normiert relativ zu B.

Die Definition

P (A B)

P (A|B) =

falls P (B) 6= 0

(21.5)

P (B)

erfüllt all diese Bedingungen. Daraus folgt

P (A B) = P (A|B) P (B) = P (B|A) P (A) .

(21.6)

Diese Definition der bedingten Wahrscheinlichkeit kann man auf die Rechnung mit

relativen Häufigkeiten zurückführen, wie man im folgenden Beispiel sehen kann.

Beispiel: Man hat einen Topf mit 10 Kugeln, davon sind 6 aus Silber und 4 aus Gold. Man

zieht zufällig zwei Kugeln (ohne zurückzulegen). Wir nennen

• A das Ziehen einer Goldkugel beim ersten Mal,

• B das Ziehen einer Goldkugel beim zweiten Mal,

• A B das zweimalige Ziehen einer Goldkugel.

21.1 Zufall und Wahrscheinlichkeit

617

Es ist P (A) = 2/5; wenn schon eine Goldkugel gezogen wurde, hat sich das Verhältnis von

Silber zu Gold auf 6:3 geändert, daher ist P (B|A) = 1/3. Daher ist

P (A B) = P (B|A) P (A) =

2

.

15

Man kann das leicht auch durch Abzählen aller Möglichkeiten überprüfen. Etwas schwieriger

ist die Frage nach P (A|B): Wenn man weiß, dass die Kandidatin beim zweiten Mal Gold

gezogen hat, mit welcher Wahrscheinlichkeit hat sie das auch beim ersten Mal getan? Man

beachtet P (B) = P (B A) + P (B A) = 2/5 und findet P (A|B) = 1/3.

Wenn wir

P E in eine Anzahl von einander ausschließenden Ereignissen Ai zerlegen,

also E = i Ai , dann ist ein beliebiges Ereignis auf dieser Mengenbasis darstellbar,

!

!

X

X

X

P (B) = P (B E) = P B

Ai = P

B Ai =

P (B Ai ) (21.7)

i

i

i

und daher

P (B) = P (A1 ) P (B|A1 ) + P (A2 ) P (B|A2) + · · · =

X

P (Ai ) P (B|Ai) . (21.8)

i

Dies führt zum Satz von Bayes, der es erlaubt, die bedingte Wahrscheinlichkeit auf

einem Umweg zu bestimmen:

P (B|Ai) P (Ai)

.

P (Ai|B) = P

j P (B|Aj ) P (Aj )

(21.9)

Beispiel: Angenommen, Sie haben drei Internetprovider (Firmen, die Internetzugänge vermieten) zur Auswahl. Provider X hat 250 Telefoneingänge, von denen durchschnittlich 30%

besetzt sind, Y hat 100 mit durchschnittlicher Besetzungsrate von 20% und Z hat 50 mit 30%

Belegung. Alle werden über eine gemeinsame Telefonnummer angesteuert, die dann zufällig

mit einem der Providereingänge verbunden wird. Wie wahrscheinlich ist es, dass Sie einen

freien Eingang finden? Falls der Anschluss besetzt ist, mit welcher Wahrscheinlichkeit sind

Sie bei Provider Z gelandet?

Die Ereignismengen sind E = X + Y + Z (für die Provider) und E = F + B (für freien

oder besetzten Eingang) mit den Wahrscheinlichkeiten

100

50

250

= 0.625 , P (Y ) =

= 0.25 , P (Z) =

= 0.125 ,

400

400

400

P (F |X) = 0.7 ,

P (F |Y ) = 0.8 ,

P (F |Z) = 0.7 .

P (X) =

Daher ist

P (F ) = 0.625 0.7 + 0.25 0.8 + 0.125 0.7 = 0.725 ,

P (B) = 1 − P (F ) = 0.275 .

Sie bekommen also in 72.5% der Versuche einen freien Eingang. Falls nicht, dann sind Sie mit

folgender Wahrscheinlichkeit bei Z gelandet:

P (Z|B) =

0.3 0.125

P (B|Z) P (Z)

=

= 0.136 .

P (B)

0.275

618

21 Wahrscheinlichkeitsrechnung und Statistik

Wenn Sie ein Weinglas und ein Bierglas gleichzeitig zu Boden fallen lassen, dann ist

die Wahrscheinlichkeit dafür, dass das Bierglas zerbricht, sicher unabhängig von der

für das Weinglas. Die Wahrscheinlichkeit, dass beide zerbrechen (Scherben bringen

Glück?), ist offenbar das Produkt der Einzelwahrscheinlichkeiten. Wir fassen zusammen: Wenn die Ereignisse A und B voneinander unabhängig sind, so ist

P (A B) = P (A) P (B) .

(21.10)

Dies passt gut zur Definition der bedingten Wahrscheinlichkeit, da ja P (A|B) = P (A)

und P (B|A) = P (B) die gegenseitige Unabhängigkeit festlegt. Mehrere Ereignisse

sind voneinander unabhängig, wenn sie paarweise unabhängig sind, und es gilt

!

Y

Y

Ai =

P (Ai) .

(21.11)

P

i

i

Damit können wir endlich auch die Wahrscheinlichkeit von Mengensummen unabhängiger Ereignisse bestimmen,

P (A + B) = P (A) + P (B) − P (A B) = P (A) + P (B) − P (A) P (B) . (21.12)

Beispiel: Wir betrachten radioaktive Nuklide. Die Wahrscheinlichkeit, dass ein einzelnes Atom

in den folgenden Minute nicht zerfällt, sei a. Nach unserem Kenntnisstand ist diese Wahrscheinlichkeit unabhängig vom Zeitpunkt, also für die darauffolgende Minute (sofern es nicht

schon zerfallen ist) ebenfalls a. Die Wahrscheinlichkeit, dass das Atom die zwei Minuten ohne

Zerfall überdauert, ist daher a2 , bei t Minuten also at . Mit a = e−λ erhalten wir das bekannte

Gesetz, dass die Wahrscheinlichkeit des radioaktiven Zerfalls proportional zu e−λ t ist.

Beispiel: Ein Chip wird zweimal unabhängig voneinander auf Produktionsfehler untersucht.

Es werden in den beiden Tests c Fehler beide Male gefunden, darüber hinaus aber noch weitere

a Fehler beim Check A und, davon verschieden, b Fehler beim Check B. Wie nehmen an, dass

die verschiedenen Fehlerarten mit gleicher Wahrscheinlichkeit gefunden werden. Wie viele

Fehler hat der Chip vermutlich insgesamt?

Wir nennen P (A) und P (B) die Wahrscheinlichkeit, einen Fehler beim Check A oder B

zu finden (vgl. Abb. 21.1). Aufgrund der Beobachtung schätzen wir

P (A|B) =

c

P (A B)

≈

,

P (B)

b+c

P (B|A) =

P (A B)

c

≈

.

P (A)

a+c

(Die tatsächlichen Wahrscheinlichkeiten werden durch unsere Messwerte nur approximiert,

und wir haben daher das entsprechende Zeichen verwendet.) Das sind gleichzeitig die Schätzwerte für P (A) und P (B), da wegen der Unabhängigkeit

P (A B) = P (A) P (B) ,

P (A|B) = P (A) ,

P (B|A) = P (B) .

Daher finden wir eine Schätzung der Wahrscheinlichkeit, einen Fehler in zumindest einem der

beiden Tests zu finden, zu

P (A+B) = P (A)+P (B)−P (A B) ≈

c

c2

c (a + b + c)

c

+

−

=

.

b + c a + c (a + c) (b + c)

(a + c) (b + c)

21.1 Zufall und Wahrscheinlichkeit

619

Die vermutete Gesamtzahl N aller vorhandenen Fehler ist in der Schätzung von P (A) versteckt, da ja P (A) ≈ (a + c)/N , gleichzeitig aber (siehe oben) auch c/(b + c) ein entsprechender Schätzwert ist. Daher erhalten wir

1

N = (a + c) (b + c)

c

als geschätzte Gesamtanzahl der Fehler im Chip. Die Genauigkeit dieser Schätzwerte wird

natürlich mit der Zahl der gefundenen Fehler zunehmen. Wie man sich darüber eine bessere

Vorstellung verschafft, wird im Abschnitt 21.5.1 über Schätzungen und Statistik erklärt.

21.1.2 Zufallsvariablen und Verteilungsfunktionen

Die Augenzahl des geworfenen Würfels ist eine Zufallsvariable. Ebenso ist die Lebensdauer eines instabilen Atoms eine solche. Allgemein sind Zufallsvariablen X Abbildungen von Ereignissen in Intervalle auf R:

X : e 7→ x ∈ I ⊂ R .

Die Zufallsvariable X nimmt nur endliche Werte x ∈ R an. Die Wahrscheinlichkeit,

dass X einen Wert im Intervall I hat, wird also mit der Wahrscheinlichkeit des entsprechenden Ereignisses gleichgesetzt.

• Jedem reellen Zahlenintervall (−∞, x) entspricht ein Ereignis.

• Die Wahrscheinlichkeit, dass X = ±∞ ist, muss null sein.

Beispiel: Ein instabiles Teilchen zerfällt in einem Experiment nach t Sekunden. Wir definieren

eine Zufallsvariable X, die dann den Wert 1 hat, wenn 5 ≤ t < 27 ist,

0 t<5,

X(t) =

1 5 ≤ t < 27 ,

0 27 ≤ t .

Diese Zufallsvariable hat nur die Werte 0 oder 1.

Wir unterscheiden genau zwischen der Zufallsvariablen X und dem Wert x, den

sie im Experiment jeweils annehmen kann. X steht gewissermaßen als Platzhalter für

Werte, die die Variable entsprechend einer gegebenen Wahrscheinlichkeit annehmen

kann, ist also eine Art Operator, wohingegen x einfach eine reelle Zahl bezeichnet.

Beispiel: Ein Experiment misst die Orientierung des halbzahligen Spins eines Atoms, die

Elementarereignisse seien die – gleich wahrscheinlichen – Werte + 1/2 und − 1/2. Diese Zahlen

wählen wir auch als die entsprechenden Werte in R, welche die Zufallsvariable annehmen

kann. Beliebige Intervalle enthalten also entweder keinen dieser Werte oder einen davon oder

sogar beide. So sind zum Beispiel

P (X < −0.5) = 0 , P (X ≤ 0) = 0.5 , P (−0.5 < X < 0.5) = 0 , P (X ≤ 0.9) = 1 .

620

21 Wahrscheinlichkeitsrechnung und Statistik

Die Menge der Wahrscheinlichkeiten für alle denkbaren Ereignisse definiert die

Wahrscheinlichkeitsverteilung oder kurz Verteilung. Die Verteilungsfunktion gibt

die Wahrscheinlichkeit einer Verteilung an. Man definiert sie als Wahrscheinlichkeit

dafür, dass die Zufallsvariable X einen Wert x ≤ t annimmt,

FX (t) ≡ P (X ≤ t) .

(21.13)

Die Funktion ist also monoton wachsend, da ja für x1 < x2 auch P (X ≤ x1 ) ≤

P (X ≤ x2 ) ist. Wahrscheinlichkeiten für Teilintervalle werden aus den Werten von

FX zusammengesetzt,

P (x1 < X ≤ x2 ) = P (X ≤ x2 ) − P (X ≤ x1 ) = FX (x2 ) − FX (x1 ) .

(21.14)

Wir werden für den Fall einer einzigen Zufallsvariable FX künftig einfach nur F nennen, da dann Verwechslungen ausgeschlossen sind.

Beispiel: Im weiter oben erwähnten Beispiel einer Spinmessung wäre die Verteilungsfunktion

(unmöglichesEreignis) ,

0 x < − 21

1

1

1

−

≤

x

<

Ereignis − 12 ,

F (x) =

2

2 12

1 2 ≤x

sicheres Ereignis + 12 oder − 21 .

Wir wollen die Verteilungsfunktion immer so definieren, dass sie stetig von rechts

ist, also

lim F (x + ǫ) = F (x) .

(21.15)

ǫ→0

Das eben besprochene Spin-Beispiel entspricht dieser Forderung.

Diskrete Zufallsvariablen nehmen diskrete Werte (also zum Beispiel ganze Zahlen)

an. Für diese Zufallsvariablen, die die Werte xi mit den Wahrscheinlichkeiten Pi annehmen, ist F eine Stufenfunktion (vgl. Abb. 21.5),

X

X

F (x) =

Pi mit

Pi = 1 .

(21.16)

xi ≤x

i

Stetige Zufallsvariablen nehmen beliebige, meist kontinuierliche reelle Werte an. In

diesem Fall definiert man eine geeignete nichtnegative Dichtefunktion f (x) ≥ 0, so

dass (vgl. Abb. 21.2 und 21.7)

Z x

Z ∞

F (x) =

dt f (t) mit F (∞) =

dt f (t) = 1 .

(21.17)

−∞

−∞

Überall, wo F (x) differenzierbar ist, gilt

f (x) =

d

F (x) ,

dx

(21.18)

und wenn F (x) an abzählbar vielen Punkten nur stetig, aber nicht differenzierbar ist,

dann kann man dort f (x) beliebige endliche Werte zuweisen.

21.1 Zufall und Wahrscheinlichkeit

621

Beispiel: Wir betrachten noch einmal das Experiment zur Messung der Lebensdauer eines

instabilen Teilchens. Die Zufallsvariable sei nun die Lebensdauer T eines Teilchens, ihr Wert

in einer Messung sei t. Ein Ereignis Et soll einer Messung der Lebensdauer eines Teilchen

zwischen 0 und t Sekunden entsprechen. Das sichere Ereignis ist also E ≡ E∞ .

Um nach Kolmogorows System den Messwerten Wahrscheinlichkeiten zuzuordnen, brauchen wir eine auf R+ positive und integrable Funktion p(t) mit der Normierung

Z ∞

dt′ p(t′ ) .

P (E) = 1 =

0

Damit ist (vgl. Abb. 21.2)

P (Et ) ≡

Z

t

dt′ p(t′ ) .

0

Die Wahrscheinlichkeit, genau einen bestimmten Wert zu messen, ist natürlich 0.

p

P (t1 <t< t 2 )

Abb. 21.2 Beispiel für eine

Wahrscheinlichkeitsdichtefunktion p(t)

für eine Zufallsvariable T . Die

Wahrscheinlichkeit, eine Lebenszeit

t1 < t ≤ t2 zu beobachten, entspricht

der dunkelgrau markierten Fläche. Sie

Rt

ist P (t1 < t ≤ t2 ) = t12 dt′ p(t′ ).

p( t )

t1

t2

t

Für diskrete Zufallsvariablen kann man formal auch eine Dichtefunktion definieren, die dann eine Summe von Deltafunktionen (Definition der Deltafunktion siehe

Kap. 14) ist und F (x) eine Stufenfunktion. Die Dichtefunktion, auch Wahrscheinlichkeitsdichte oder Verteilungsdichte genannt, hat Eigenschaften analog einer Massendichte oder einer Ladungsdichte, die von einer Variablen x (etwa dem Abstand vom

Ursprung) abhängt. Eine Summe von Deltafunktionen entspricht dann zum Beispiel

einer Anordnung von Punktladungen.

Beispiel: Man lässt eine Nadel zufällig auf den Boden fallen. Die Zufallsvariable sei die Richtung der Nadel; sie ist durch einen Winkel 0 ≤ α < 2π gegeben. Die Wahrscheinlichkeitsdichte ist laut Annahme konstant und bevorzugt keine Richtung (wir vernachlässigen Magnetisierung, Nordpol und andere unfreundliche Bemerkungen zu diesem Beispiel), daher

0 x<0,

1

0 ≤ x < 2π ,

f (x) =

2π

0 2π ≤ x

und die Verteilungsfunktion lautet daher

0

x

F (x) =

2π

1

x<0,

0 ≤ x < 2π ,

2π ≤ x .

Wir haben die Dichtefunktion bereits richtig normiert.

622

21 Wahrscheinlichkeitsrechnung und Statistik

21.1.3 Erwartungswerte und Momente

Es gibt sehr verschiedene Verteilungsfunktionen und Verteilungsdichten. Einige davon

besprechen wir im nächsten Abschnitt 21.2. Sie unterscheiden sich durch ihre Form,

und man hat verschiedene typische Parameter zur Charakterisierung eingeführt. Eine

Hauptforderung an die Definition der Parameter ist, dass es auch möglich sein soll, sie

zumindest näherungsweise zu bestimmen, wenn die Wahrscheinlichkeitsdichte nicht

explizit bekannt ist, sondern nur durch Messung von Zufallsvariablen definiert ist.

Genau das ist ja im tatsächlichen Experiment meistens der Fall!

Die Parameter einer Verteilung werden daher jeweils als Erwartungswert (auch

Mittelwert genannt) einer Funktion g(X) der Zufallsvariablen definiert,

Z ∞

hg(X)i ≡

dx f (x) g(x) ,

(21.19)

−∞

beziehungsweise für diskrete Zufallsvariable

X

hg(X)i ≡

Pi g(xi ) ,

(21.20)

i

wobei natürlich sowohl die Pi als auch die Dichtefunktion f (x) normiert sein müssen.

Offenbar ist dann der Erwartungswert von g(x) = 1 auf jeden Fall

Z ∞

h1i ≡

dx f (x) = 1 ,

(21.21)

−∞

also trivial.

Der wichtigste nichttriviale Parameter ist der Mittelwert der Verteilung (englisch:

mean value),

Z

∞

µ ≡ hXi =

dx f (x) x .

(21.22)

−∞

Man sieht sofort, dass

ha X + bi = a µ + b .

(21.23)

Bei einer Massendichteverteilung ist hXi die Position des Massenschwerpunkts.

Daneben sind die einfachsten Parameter die Momente der Verteilung, definiert

durch hX n i. Neben dem Mittelwert (1. Moment) am bekanntesten ist die aus dem 2.

Moment berechenbare Varianz

Z ∞

2

2

Var(x) ≡ σ ≡ h(X − µ) i =

dx f (x) (x − µ)2 ,

(21.24)

−∞

die man umformen kann:

h(X − µ)2 i = hX 2 i − 2hX µi + hµ2 i = hX 2 i − µ2 .

(21.25)

Wir haben dabei hµ Xi = µhXi = µ2 verwendet. Man kann ja µ als konstanten Faktor

herausziehen.

21.1 Zufall und Wahrscheinlichkeit

623

M.21.2 Kurz und klar: Verteilungsfunktion, Dichte, Momente

Eine Zufallsvariable X nimmt Werte x ∈ R an. Die Wahrscheinlichkeiten für die Messwerte (beziehungsweise Intervalle) definieren die Wahrscheinlichkeitsverteilung oder kurz

Verteilung.

Die Verteilungsfunktion FX (x) = P (X ≤ x) gibt die Wahrscheinlichkeit einer Verteilung an. Die Funktion ist monoton wachsend. Die Wahrscheinlichkeitsdichte oder Verteilungsdichte ist eine nichtnegative Funktion f mit der Eigenschaft

Z ∞

Z x

dt f (t) = 1 .

(M.21.2.1)

dt f (t) mit F (∞) =

F (x) =

−∞

−∞

Wo F (x) differenzierbar ist, gilt

f (x) =

d

F (x) .

dx

Erwartungswerte sind Mittelwerte über die Verteilung

Z ∞

dx f (x) g(x) .

hg(X)i ≡

(M.21.2.2)

(M.21.2.3)

−∞

Andere gebräuchliche Bezeichnungen für Erwartungswerte sind

hg(X)i ≡ g(x) ≡ E(g(x)).

(M.21.2.4)

Wichtige Erwartungswerte sind der Mittelwert µ = hXi, die Varianz σ 2 = h(X − µ)2 i =

hX 2 i − µ2 und die zentralen Momente µk = h(X − µ)k i. Diese Parameter charakterisieren

eine Verteilung.

Die Varianz σ 2 (oft auch Streuung oder mittlere quadratische Abweichung genannt)

ist ein Maß für die Breite der Verteilung. Sie ist nichtnegativ und kann nur dann√

null

werden, wenn X nur den Wert µ annehmen kann. Ihre Quadratwurzel σ = + σ 2

heißt Standardabweichung.

Vertrauensgrenzen ergeben sich durch Integration der jeweils relevanten Verteilungsdichte. Allgemein ist ja

Z b

P (a < x < b) =

dx fX (x) .

(21.26)

a

Bei einer Normalverteilung (im Abschnitt 21.2 genauer besprochen) für Messdaten

liegen rund 2/3 der erwarteten Werte von X in einem Intervall µ − σ < x < µ + σ.

Man nennt diesen Bereich daher auch das Vertrauensintervall (auch Konfidenzintervall), die Grenzen sind die Vertrauensgrenzen. Diese Größe wird bei Messdaten

in Form eines Fehlerbalkens angegeben. Numerische Angaben werden in der Form

1.234 ± 0.072 oder auch 1.234(72) gemacht, wobei in Klammern der Fehler“ der

”

letzten Stellen angegeben wird. Mehr über die Wahrscheinlichkeitsinterpretation des

Fehlerbalkens folgt in Abschnitt 21.5.1.

626

21 Wahrscheinlichkeitsrechnung und Statistik

21.2.1 Binomialverteilung

Im Boston Museum of Science kann man ein Galtonsches Nagelbrett bewundern. Von

oben fallen in der Mitte Kugeln herab, die den Stiften im Brett jeweils nach links oder

rechts ausweichen müssen. Darunter gibt es eine weitere Reihe von Stiften, und so ist

jede Kugel auf ihrem Weg nach unten mehreren Zufallsentscheidungen unterworfen.

In den Fächern am Boden ordnen sich die Kugeln so an, dass die entstehende Wahrscheinlichkeitsdichte einer Glockenkurve ähnelt (Abb. 21.4; Anmerkung des Lektors:

bei den gezeichneten sieben Fächern eine gewagte Aussage“).

”

0000

1111

0000

1111

0000

1111

111

000

0000

1111

0000

1111

000

111

0000

1111

0000

1111

000

111

0000

1111

0000

1111

000

111

0000

1111

0000

1111

0000

1111

000

111

0000

1111

0000

1111

0000

1111

0000

1111

000

111

0000

1111

0000

1111

0000

1111

0000111

1111

000

0000

1111

0000

1111

0000

1111

0000

1111

00000000000000000000

11111111111111111111

1111

0000

1111

0000

000

0000

1111

0000

1111

0000

1111

0000111

1111

00000000000000000000

11111111111111111111

Abb. 21.4 Das Galtonsche Nagelbrett

muss man sich als schiefe Ebene

vorstellen, in die an den markierten

Stellen Stifte eingeschlagen sind. Eine

von oben nach unten rollende Kugel

landet schließlich in einem der Fächer.

Die Treppenkurve darunter gibt die

Wahrscheinlichkeitsdichte an, also die

Wahrscheinlichkeit, mit der eine Kugel

in dem entsprechenden Fach landet.

Offenbar kann ein bestimmtes Fach über verschiedene Wege erreicht werden. Da

jeder Stift einer links-rechts-Entscheidung entspricht, die zufällig jeweils mit Wahrscheinlichkeit 0.5 passieren soll, kann man die Häufigkeit der Wahl eines Fachs aus

der Menge der verschiedenen Wege zum Fach berechnen. Die entsprechende Dichtefunktion ist die einer Binomialverteilung. Sie wird auch Bernoullische Verteilung

genannt.

y

0.25

0.2

0.15

0.1

0.05

f (x)

2

y

1

0.8

0.6

0.4

0.2

4

6

8

10 x

4

6

8

10 x

F(x)

2

Abb. 21.5 Wahrscheinlichkeitsdichte

und Verteilungsfunktion für die

Binomialverteilung (n = 10, p = 1/2);

der Mittelwert µ = 5 und die

p

Standardabweichung σ = 5/2 sind

ebenfalls eingezeichnet. Nur für p = 1/2

ist die Verteilung symmetrisch zum

Punkt x = µ. Der Median stimmt hier

mit dem Mittelwert überein. Mit rund

67.4% Wahrscheinlichkeit liegt ein Wert

von X im Intervall [µ − σ, µ + σ].

21.2 Spezielle Wahrscheinlichkeitsverteilungen

627

Für eine Verallgemeinerung betrachten wir ein Experiment, bei dem das Ergebnis

entweder 0 oder 1 ist. Die Wahrscheinlichkeiten für die beiden Fälle müssen nicht

gleich sein, wohl aber müssen sie sich zum Gesamtwert 1 ergänzen. Zum Beispiel

kann P (0) = p und P (1) = 1 − p ≡ q sein. Wenn wir das Experiment n-mal wiederholen, ist das Ergebnis eine Menge von Werten, also etwa (0, 1, 1, 0, 1, . . . ). Bei

n Versuchen gibt es insgesamt genau 2n mögliche Ergebnisse. Wir fragen nun, wie

wahrscheinlich es ist, k-mal den Wert 0 zu bekommen.

Wenn n = 2 ist, lässt sich die Gesamtwahrscheinlichkeit 1 folgendermaßen aufteilen

(p + q) (p + q) = p2 + p q + q p + q 2 = p2 + 2 p q + q 2 .

(21.32)

Die einzelnen Terme auf der rechten Seite der ersten Gleichung entsprechen den Wahrscheinlichkeiten für die Ergebnisse (0, 0), (0, 1), (1, 0), (1, 1). Die Summe aller Terme

ist natürlich 1.

Man erkennt leicht, dass die Vorfaktoren 1, 2, und 1 die Binomialko2

effizienten k sind (siehe auch Anhang A). Die Wahrscheinlichkeit, bei n Versuchen

k-mal den Wert 0 zu bekommen, ist also

n k

p (1 − p)n−k .

(21.33)

P (X = k) =

k

Wenn die Wahrscheinlichkeit für 0 oder 1 gleich, also p = 1/2 ist, dann ist für alle

Werte von k der Faktor derselbe, nämlich pk (1 − p)n−k = 1/2n .

Die Verteilungsdichte für diese diskrete Zufallsvariable kann also formal als Summe

von Deltafunktionen (siehe Kap. 14) geschrieben werden. Es ist

n X

n k

p (1 − p)n−k δ(x − k) ,

f (x) =

k

k=0

[x] X n

(21.34)

pk (1 − p)n−k ,

F (x) =

k

k=0

µ = np ,

σ 2 = n p (1 − p) .

Wir haben dabei die Bezeichnung [x] für die größte ganze Zahl ≤ x“ (siehe Anhang

”

A) verwendet. Abb. 21.5 zeigt die Verteilung für n = 10 und p = 1/2.

Beispiel: Ihr Computerprogramm ist soeben abgestürzt“, und sie betrachten verzweifelt einen

”

binären Coredump (Ausdruck des Speicherbereichs). Wie wahrscheinlich ist es, dass die Quersumme (Anzahl der 1-Bits) eines Bytes gleich 2 ist?

Ein Byte entspricht acht Binärstellen. Wenn die Zahlen vollkommen zufällig verteilt sind,

sollte jeder Bitwert gleich wahrscheinlich sein. Die Frage führt also zur Binomialverteilung

für n = 8 und p = 1/2. Die Antwort ist

2 6

8

1

8!

7

1

=

=

≈ 0.109 . . . ,

2

2

2! 6! 256

64

2

und daher wird im Mittel eines von neun Bytes diese Eigenschaft haben.

21.2 Spezielle Wahrscheinlichkeitsverteilungen

631

21.2.4 Normalverteilung

Die Gaußsche Normalverteilung ist neben der Gleichverteilung vermutlich die wichtigste Verteilung. Wie wir später sehen werden, beschreibt sie insbesondere den Grenzfall, dass eine Zufallsvariable eine Summe von Zufallsvariablen unbekannter Verteilung ist. Genau das ist in den meisten Experimenten der Fall; man kann keine Messung

einer reellen Zahl exakt, ohne irgendeinen Fehler, ausführen. Meist ist der Messfehler

eine Summe verschiedener kleiner, aber kaum kontrollierbarer Fehler, wie etwa das

thermische Rauschen der elektronischen Apparatur, akustische Störungen, elektromagnetisches Rauschen und Ähnliches.

y

0.4

f (x)

0.3

0.2

0.1

−3

−2

−1

1

2

3 x

y

1

0.8

0.6

F(x)

0.4

0.2

−3

−2

−1

1

2

3 x

Abb. 21.8 Verteilungsdichte und

Verteilungsfunktion für die

Normalverteilung (µ = 0, σ = 1); der

Mittelwert und die Standardabweichung

sind ebenfalls eingezeichnet. Mit rund

68.3% Wahrscheinlichkeit liegt ein Wert

von X im Intervall [µ − σ, µ + σ].

Die Normalverteilung ist (siehe Abb.21.8 )

!

(x − µ)2

1

exp −

f (x) = √

,

2σ 2

2πσ 2

!

Z x

(x − µ)2

1 1

x−µ

1

.

dx exp −

≡ + erf √

F (x) = √

2σ 2

2 2

2σ

2πσ 2 −∞

(21.38)

Mittelwert µ und Standardabweichung σ sind schon in die Definition eingebaut. Die

unvollständige Integration über die Gaußsche Glockenkurve kann nicht analytisch

durchgeführt werden. Aus diesem Grund hat man die Errorfunction“ erf(x) ein”

geführt, die man entweder numerisch berechnen oder in Tabellen nachschlagen kann.

In Kap. 5 haben wir in (5.76) die vollständige Integration der Glockenkurve durchgeführt. Man kann sich also leicht davon überzeugen, dass F (∞) = 1 gilt.

Wegen der Symmetrie der Verteilungsdichte verschwinden alle zentralen Momente

ungerader Potenzen

h(X − µ)2k+1 i = 0 .

(21.39)

632

21 Wahrscheinlichkeitsrechnung und Statistik

Die geraden zentralen Momente lassen sich ebenfalls mit Hilfe der in Abschnitt 5.3

besprochenen Verfahren bestimmen. Nach einer Variablentransformation Y = (X −

µ)/σ ergibt sich

Z ∞

y2

1

2k

hY i = √

dy y 2k e− 2

2π −∞

k Z ∞

2

1

k ∂

− a 2y dy e

= √ (−2)

∂ak −∞

2π

a=1

(21.40)

k

− 12 k ∂

a = (2k − 1)!!

= (−2)

∂ak

a=1

⇒

h(X − µ)2k i = (2k − 1)!! σ 2k .

Dabei verwenden wir die gebräuchliche Abkürzung

(2k − 1)!! ≡ (2k − 1) (2k − 3) · · · 1 ,

(21.41)

also eine Fakultätsfunktion, in der nur jeder zweite Faktor berücksichtigt wird (siehe

Anhang A).

Die Gauß-Verteilung ist auch der Grenzfall einer Binomialverteilung für große n

und große n p (1 − p), die in diesem Fall in der Nähe ihres Maximums durch eine

Normalverteilung der Form

!

(k − n p)2

1

exp −

(21.42)

P (X = k) ≃ p

2 n p (1 − p)

2 π n p(1 − p)

genähert werden kann. Dieser Übergang spielt auch in der statistischen Physik eine

wesentliche Rolle.

21.2.5 Exponentialverteilung

Die Beobachtung radioaktiver Atomkerne hat gezeigt, dass die Zerfallswahrscheinlichkeit eines Atomkerns nicht von seiner Vorgeschichte abhängt. Es ist zu jedem

Zeitpunkt gleich wahrscheinlich, dass das Atom in der nächsten Zeitspanne dt zerfällt.

Die Wahrscheinlichkeit dafür, dass das Atom nicht zerfällt, sei (1 − λ dt). Die Wahrscheinlichkeit, dass das Atom ein n-faches dieser Zeitspanne überlebt, ist (1 − λ dt)n .

Wenn wir eine gegebene Zeitspanne t in n Teile dt = t/n zerlegen und die Zerlegung

immer feiner machen, erhalten wir

n

λt

lim 1 −

= e−λt ,

(21.43)

n→∞

n

die so genannte Exponentialverteilung. Von einer zu t = 0 gegebenen Anzahl N(0) =

N0 von Atomkernen werden zu einem späteren Zeitpunkt also

N(t) = N0 e−λt

(21.44)