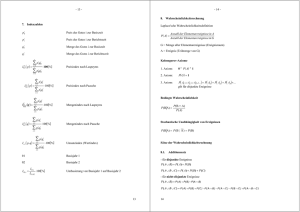

2.7 Summen von Zufallsgrößen

Werbung

2.7 Summen von Zufallsgrößen Literatur: [Papula Bd. 3, Kap. II.7.5 ff.], [Benning, Kap. 3.4] Satz 1 (Additionssatz für Erwartungswerte) Der Erwartungswert einer Linearkombination von (diskreten oder stetigen, nicht notwendig unabhängigen) Zufallsgrößen, deren Erwartungswerte existieren, ist gleich der Linearkombination der Erwartungswerte der einzelnen Zufallsgrößen, E(a1 X1 + a2 X2 + . . . + an Xn ) = a1 E(X1 ) + a2 E(X2 ) + . . . + an E(Xn ). Beweis Wir beweisen den Fall zweier diskreter Zufallsgrößen. Es gilt: XX E(aX + bY ) = (axi + byj )pij = a = a i j X xi X pij + b i j X xi pi∗ + b i X yj X j X pij i yj p∗j j = aE(X) + bE(Y ). Der Fall mehrerer Zufallsgrößen und der Fall stetiger Zufallsgrößen lässt sich analog behandeln. q.e.d. Bsp 2 Beim Zufallsexperiment Würfeln mit zwei unterscheidbaren Würfeln interessieren wir uns für die Zufallsvariable Z = Augensumme beider Würfel, die als Summe der beiden Zufallsvariablen X = Augenanzahl der ersten Würfels Y = Augenanzahl der zweiten Würfels darstellbar ist. Wir haben bereits berechnet, dass die Erwartungswerte von X und Y gleich 3,5 ist. Nach dem Satz ist der Erwartungswert von Z = X + Y gleich 7. Das hatten wir auch schon einmal ausgerechnet. 2.7 – 1 Satz 3 (Additionssatz für die Varianz) Der Varianz einer Linearkombination von (diskreten oder stetigen) unabhängigen Zufallsgrößen ist gleich der Linearkombination der Varianzen der einzelnen Zufallsgrößen, Var(a1 X1 + a2 X2 + . . . + an Xn ) = a21 Var(X1 ) + a22 Var(X2 ) + . . . + a2n Var(Xn ). Beweis Wir beweisen auch hier nur den Fall zweier Zufallsgrößen. Mit den Abkürzungen µX = E(X) und µY = E(Y ) gilt: Var(aX + bY ) = E[(aX + bY − E(ax + bY ))2 ] = E[(a(X − µX ) + b(Y − µY ))2 ] = E[a2 (X − µX )2 + 2ab(X − µX )(Y − µY ) + b2 (Y − µY )2 ] = a2 E[(X − µX )2 ] + 2abE[(X − µX )(Y − µY )] + b2 E[(Y − µY )2 ] = a2 Var(X) + 2abE[(X − µX )(Y − µY )] + b2 Var(Y ). Der störende Term E[(X − µX )(Y − µY )] = E(XY ) − µX µY wird genau dann Null, wenn die Zufallsgrößen X und Y unabhängig sind. Der Fall mehrerer Zufallsgrößen lässt sich analog behandeln. q.e.d. Bsp 4 Wir haben bereits auf diese beiden Sätze vorgegriffen, als wir Erwartungswert und Varianz bei der Binomialverteilung bewiesen haben. Seien die Zufallsgrößen X1 , . . . , Xn die Resultate von Bernoulliexperimenten, bei denen das beobachtete Ereignis mit Wahrscheinlichkeit p eintritt. Die Summe X = X1 + . . . + Xn ist dann laut Definition eine binomialverteilte Zufallsgröße mit den Parametern n und p. Wir hatten bereits geprüft, dass für die Einzelereignisse E(Xi ) = p, Var(Xi ) = p(1 − p) i = 1, . . . , n, gilt. Nach den beiden hier formulierten Sätzen folgt E(X) = np, Var(X) = np(1 − p). Bsp 5 Wir bilden aus n unabhängigen, normalverteilten Zufallsgrößen X1 , . . . , Xn den arithmetischen Mittelwert X= 1 (X1 + . . . + Xn ). n Besitzen alle Xi denselben Mittelwert µ und dieselbe Varianz σ 2 , dann folgt E(X) = µ, Var(X) = n · 1 2 σ2 σ = . n2 n Beim Bilden des Mittelwertes bleibt der Erwartungswert erhalten, während die Varianz auf den n-ten Teil zurückgeht. 2.7 – 2 Bem 6 In naturwissenschaftlich-technischen Anwendungen hat man es häufig mit Zufallsgrößen zu tun, deren Verteilung man nicht kennt, z.B. Messfehler oder Fertigungsfehler. Was man aber immer beobachten kann, ist die Summe, bzw. das arithmetische Mittel X aus n solchen, unabhängigen Zufallsgrößen X1 ,. . . , Xn . Satz 7 (Zentraler Grenzwertsatz von Lindenberg/Levy) Wenn die unabhängigen Zufallsvariablen X1 ,. . . , Xn derselben Verteilung mit dem Erwartungswert µ und der Varianz σ 2 genügen, dann konvergiert die Verteilungsfunktion Fn der Zufallsgröße n 1X Xi − µ n i=1 √ Yn = σ/ n für n → ∞ gegen die Verteilungsfunktion Φ der Standardnormalverteilung, 1 lim Fn (y) = √ n→∞ 2π Zy 2 /2 e−t dt f.f.a. y ∈ R. −∞ Bem 8 1. Die Ersetzung von Fn durch Φ ist praktisch für n > 30 möglich. 2. Wir haben oben festgestellt, dass der arithmetische Mittelwert aus n unabhängigen, normalverteilten Zufallsgrößen stets normalverteilt mit gleichem Mittelwert und auf den n-ten Teil reduzierter Varianz ist. Der Zentrale Grenzwertsatz besagt, dass das für große n auch für alle anderen Verteilungen annähernd gilt. 3. Für allgemeinere Grenzwertsätze sei auf die Literatur verwiesen. Bsp 9 Insbesondere kann der Satz auf die Binomialverteilung angewandt werden. Seien die Zufallsgrößen X1 , . . . , Xn die Resultate von Bernoulliexperimenten, bei denen das beobachtete Ereignis mit Wahrscheinlichkeit p eintritt. Es gilt E(Xi ) = p, Var(Xi ) = p(1 − p) i = 1, . . . , n. Die Zufallsgröße X = X1 + . . . + Xn = nX ist dann binomialverteilt mit den Parametern n und p. Nach dem Zentralen Grenzwertsatz konvergiert die Verteilungsfunktion der standardisierten Zufallsgröße n n X 1X Xi − p Xi − np n i=1 i=1 Yn = p =p p(1 − p)/n np(1 − p) für n → ∞ gegen die Verteilungsfunktion Φ der Standardnormalverteilung. Dieser Satz ist auch unter dem Namen Grenzwertsatz von Moivre-Laplace bekannt. Eine Illustration dafür bietet das Galton-Brett , siehe auch http: //www.unizh.ch/biostat/kurs/normal/kap53.htm 2.7 – 3 Bem 10 Der Zentrale Grenzwertsatz ist ein wichtiges Resultat. Dennoch hat er eine einschränkende Voraussetzung. Es müssen der Erwartungswert und die Varianz der Verteilung der Zufallsgrößen Xi bekannt sein. Man kann diese nun durch Bildung von Mittelwert und empirischer Varianz aus einer Stichprobe schätzen. Danach sollte man aber prüfen (testen), ob X tatsächlich annähernd normalverteilt mit den empirisch gewonnenen Parametern ist. Das ist Aufgabe der induktiven Statistik, der wir uns in Kapitel 3 zuwenden. Dazu benötigen wir jedoch noch einige Verteilungen, die hier eingeführt seien. Def 11 Gegeben seien n unabhängige standardnormalverteilte Zufallsgrößen X1 , . . . , Xn . Dann heißt die Verteilung der Zufallsgröße χ2 = X12 + . . . + Xn2 χ2 -Verteilung mit n Freiheitsgraden (auch Helmert-Pearson-Verteilung). Ihre Verteilungsfunktion wird mit Fχ2 (x) und die zugehörige Dichtefunktion mit fχ2 (x) bezeichnet. Def 12 Ist X eine standardnormalverteilte Zufallsgröße und Y eine von X unabhängige χ2 -verteilte Zufallsgröße mit m Freiheitsgraden, dann heißt die Verteilung der Zufallsgröße X T =p Y /m Student-Verteilung oder t-Verteilung mit m Freiheitsgraden. Def 13 Sind X1 und X2 unabhängige, χ2 -verteilte Zufallsgrößen mit m1 bzw. m2 Freiheitsgraden, dann heißt die Verteilung der Zufallsgröße Fm1 ,m2 = m2 X 1 · m1 X 2 Fisher-Verteilung oder F -Verteilung mit den Freiheitsgraden m1 und m2 . Bem 14 Für Verteilungs- und Dichtefunktion der χ2 -, t- und F -Verteilung sei auf die Literatur verwiesen. Quantile sind tabelliert. 2.7 – 4