Statistik für Ingenieure

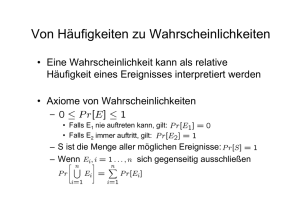

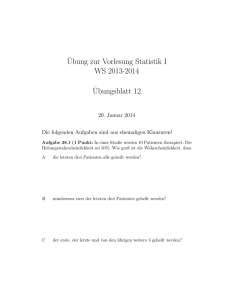

Werbung