als normalverteilung

Werbung

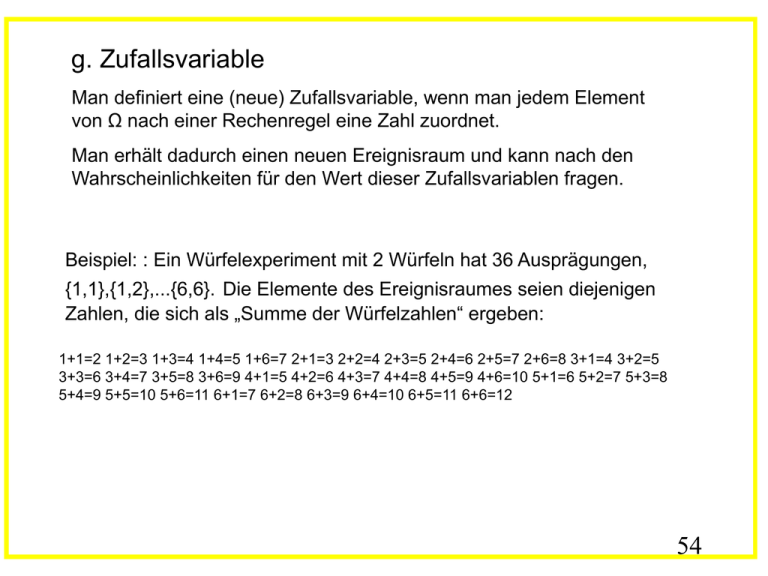

g. Zufallsvariable

Man definiert eine (neue) Zufallsvariable, wenn man jedem Element

von Ω nach einer Rechenregel eine Zahl zuordnet.

Man erhält dadurch einen neuen Ereignisraum und kann nach den

Wahrscheinlichkeiten für den Wert dieser Zufallsvariablen fragen.

Beispiel: : Ein Würfelexperiment mit 2 Würfeln hat 36 Ausprägungen,

{1,1},{1,2},...{6,6}. Die Elemente des Ereignisraumes seien diejenigen

Zahlen, die sich als „Summe der Würfelzahlen“ ergeben:

1+1=2 1+2=3 1+3=4 1+4=5 1+6=7 2+1=3 2+2=4 2+3=5 2+4=6 2+5=7 2+6=8 3+1=4 3+2=5

3+3=6 3+4=7 3+5=8 3+6=9 4+1=5 4+2=6 4+3=7 4+4=8 4+5=9 4+6=10 5+1=6 5+2=7 5+3=8

5+4=9 5+5=10 5+6=11 6+1=7 6+2=8 6+3=9 6+4=10 6+5=11 6+6=12

54

Erei

gnis

X

2

3

4

5

6

7

8

9

10

11

12

abs.

Häuf

igkei

t f(X)

1

2

3

4

5

6

5

4

3

2

1

rel.

Häuf

igkei

t

P(X)

1/36

2/36

3/36

4/36

5/36

6/36

5/36

4/36

3/36

2/36

1/36

Die Summe der pi = P(X=i+1) ist gleich 1 (i läuft von 1 bis 11 !)

55

7

6

5

f(X)

4

3

2

1

0

1

2

3

4

5

6

7

8

9

10

11

12

X

56

Die Verteilung einer diskreten Zufallsvariablen X kann durch ihre Lage und

Streuung charakterisiert werden; man verwendet dafür deren Erwartungswert

E(X) (auch "1. Moment") und Varianz Var(X) (auch "2. Moment"):

E(X) = μ =

p x

i

i

i

Var(X) = σ =

2

2

p

(

x

)

i i

i

Die Wurzel aus Var(X) heißt Standardabweichung σ (auch Streuung), diese

wird in denselben Einheiten gemessen wie der Erwartungswert und ist deshalb

oft sinnvoller zu verwenden.

Beispiel: die obigen Daten ergeben Erwartungswert 7 und Varianz =

1/36*(2-7)2 + 2/36*(3-7)2 + ... =5.833 und die Standardabweichung σ =

2.42

57

Satz: Für alle Zufallsvariablen X, Y und alle reellen Zahlen a,b gilt

E(aX + bY) = a E(X) + b E(Y)

Satz: Für jede Zufallsvariable X gilt Var(X) = E(X2) – E(X)2

Satz: Für jede Zufallsvariable X gilt Var(aX) = a2 Var(X)

Satz: Sind die Zufallsvariablen X, Y unabhängig, dann gilt E(XY) = E(X) E(Y) und

Var(X + Y) = Var(X) + Var(Y) [die Umkehrung gilt auch]

Satz: (√n - Gesetz): X sei eine Zufallsvariable. Bei n-maliger unabhängiger

Wiederholung des Zufallsversuchs sei Xi der Wert von X beim i-ten Versuch. Für

die Mittelwertgröße

M:= 1/n (X1 + .... + Xn)

gilt dann E(M) = E(X) und σ(M) = σ(X)/√n

58

höhere Momente

das 3. Moment ist die Schiefe (Asymmetrie), definiert durch

Schiefe(X) =

3

p

(

x

)

/ σ3

i i

i

(<0: „linksschief“="rechtsgipflig"; >0: „rechtsschief“="linksgipflig")

das 4. Moment ist die Kurtosis (Wölbung, Exzess), definiert durch

Kurtosis(X) = p ( x

i

i

i

)4 /

σ4 – 3

! Achtung : Definition mit -3

(<0: flacher als Normalverteilung; >0 spitzer als Normalverteilung)

59

kontinuierliche Verteilungen

b

P(a≤x≤b) =

f ( x)dx

, wobei a und b reelle Zahlen sind

a

f(x) = Wahrscheinlichkeits-Dichtefunktion, >=0

∞

a

P(x=a) =

f ( x)dx

=0 ;

a

Ptot =

70

P(60≤x≤70) =

f ( x)dx

∫−∞ f ( x)dx

=1

, wenn f(x) die

60

Dichtefunktion für die Gewichte ist.

60

70

P(-∞≤x≤70) =

f ( x)dx

y

und allgemein P(-∞≤x≤y) =

f ( x)dx

= F(y)

F(y) wird Verteilungsfunktion genannt, es ist die

Stammfunktion von f(y) .

61

E(X) und Var(X) bei kontinuierlichen Verteilungen

E(X) = μ =

f ( x) xdx

Var(X) = σ =

2

f ( x)( x ) 2 dx

f ( x)( x E ( x)) 2 dx

62

Wichtige Wahrscheinlichkeitsverteilungen

1. Gleichverteilung

(diskret / kontinuierlich)

2. Binomialverteilung

(diskret)

3. Poissonverteilung

(diskret)

4. Normalverteilung

(kontinuierlich)

63

2. Binomialverteilung

Wir betrachten eine Folge von Einzelversuchen (EV)

a)

die EV seien dichotom mit möglichen Ausgängen "Erfolg"= S und

"Mißerfolg"=F

b)

die EV sind voneinander unabhängig mit p=P(S) und q=P(F) und p+q=1

c)

wir interessieren uns für die Anzahl X der eingetroffenen Erfolge S

d)

die Anzahl n der EV ist vorher festgelegt, d.h. X kann nicht größer als n

werden

Dann ist X gemäß der sog. Binomialverteilung verteilt, d.h. die Zufallsvariable X

"ist binomialverteilt mit Parametern n und p", und es gilt:

b)

n k

P( X k ) p (1 p) n k

k

E(X) = n p

c)

Var(X) = n p (1-p) = n p q

d)

0 < Var(X)/E(X) < 1

a)

für k=0,1,2,...,n

d.h. Var(X) < E(X)

Aus experimentellen Daten kann man p abschätzen durch

p̂ = Messwert/n

64