Vertiefungen mit Literaturvereichnis in einer Datei

Werbung

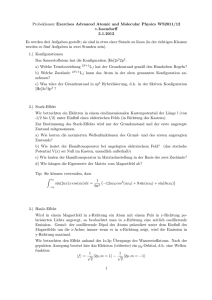

Weitere Vertiefungen zu: KÜNSTLICHE INTELLIGENZ Günther Görz und Bernhard Nebel 3. November 2003 1 Kognition Mit Kognition werden die geistigen Leistungen des Wahrnehmens, Denkens und Vorstellens bezeichnet, in Abgrenzung von anderen mentalen Bereichen — etwa des Fühlens, der Affekte oder des Wollens. Diese psychischen Prozesse entsprechen der ersten der drei geistigen Vermögen (Erkenntnis, Gefühl und Wille) der traditionellen Psychologie. Aufgrund ihrer Orientierung an der naturwissenschaftlichen Methodik wird in der kognitiven Psychologie die Frage des Bewußtseins i.d.R. nicht thematisiert. In der zweiten Hälfte des 20. Jahrhunderts hat sich die Kognitionswissenschaft als eine neue interdisziplinäre Disziplin etabliert, in der Philosophen, Psychologen, Sprachwissenschaftler, Neurowissenschaftler und Informatiker zusammenarbeit; eine interdisziplinäre Vorgehensweise wird als unumgänglich für eine adäquate Beschreibung und Erklärung mentaler Prozesse angesehen. In Anlehnung an die Konzeption kognitiver Theorien in der Psychologie versteht sich die Kognitionswissenschaft als nicht behavioristisch. Kognitive Theorien betonen die Bedeutung der nicht ausschließlich auf rein physiologische dem behavioristischen Reiz-Reaktions–Schema entsprechende Mechanismen zurückführbaren sprachlich symbolischen Vermittlung beim Erkennen und Verstehen einer Situation und bei der Bildung der auf sie gerichteten Intentionen, d.h. Erwartungen und Zwecksetzungen. Voraussetzung für eine fruchtbare interdisziplinäre Zusammenarbeit ist eine gemeinsame methodische Basis und Übereinstimmung in gewissen Grundannahmen. Eine zentrale Arbeitshypothese ist die von Newell sogenannte Physical Symbol Systems Hypothesis. Sie postuliert einen Typ von formalen Verarbeitungsmodellen, die physisch als kognitive Systeme realisiert sind und die ihrerseits aus zwei Komponenten bestehen: symbolischen Strukturen, die untereinander in Beziehung stehen, und Methoden, die auf ‘symbolischen Ausdrücken“ operieren. ” Letztere dienen zur Generierung neuer und zur Modifikation, Reproduktion und Löschung vorhandener Strukturen. Solche Systeme, so Newell, besitzen notwendige und hinreichende Mittel für intelligente Aktion. Hierdurch hat die Kognitionswissenschaft eine gemeinsame Basis mit der klassischen KI und deshalb sind die beiden Disziplinen auch besonders eng und intensiv aufeinander bezogen. Aufbauend auf der Konzeption des abstrakten Universalrechners ( Computer” paradigma“) wird in der Kognitionswissenschaft eine eigene Repräsentationsebene postuliert (vgl. Wissensrepräsentation), auf der kognitive Prozesse operieren. Damit ist der Rahmen abgesteckt, innerhalb dessen die methodischen Prinzipien der Kognitionswissenschaft entwickelt wurden. Von besonderer Bedeutung sind hier Explizitheit und empirische Fundierung. Erstere verlangt eine vollständige Operationalisierung bei der Modellbildung, die ihrerseits eine unverzichtbare Voraussetzung für die empirische Überprüfung kognitionswissenschaftlicher Theorien ist. Neben die lebensweltlich beobachtende“ und durch Laborbedingungen be” stimmte experimentelle Datenerhebung tritt die durch computergestützte Simulation, welche sich gegenseitig ergänzen. Die wichtigsten Bereiche der kognitiven Modellierung und damit Untersuchungsgegenstand der Kognitionswissenschaft sind Prozesse • der visuellen und akustischen Wahrnehmung und des Erkennens, • der Kodierung, Speicherung und des Erinnerns, also der Gedächtnisorgani- 2 sation • des Lernens und des Wissens, • des Problemlösens und des Schließens, • des Sprachverstehens und • der motorischen Steuerung. Dabei kommt der Wechselwirkung dieser Prozesse untereinander und mit der Umwelt im Sinne einer Gesamtschau besondere Bedeutung zu. Kognitive Prozesse entwickeln und ereignen sich im sozialen Kontext und stehen mit ihm in unmittelbarer Wechselwirkung. So lag es nahe, Entscheidungsprozesse in komplexen Organisationen als Schlußfolgerungsprozesse zu verstehen, so dass die Analyse der von Personen an unterschiedlichen Positionen innerhalb einer Organisation zugrundegelegten Prämissensysteme Prognosen über die anstehenden Entscheidungen erlaubt (Administrative Behavior von H.A. Simon, Nobelpreis für Wirtschaftswissenschaften 1978). Damit ist die Kognitionswissenschaft auch unmittelbar relevant für den Entwurf und Einsatz entscheidungsunterstützender sowie kommunikations- und handlungsunterstützender Systeme der Informationsverarbeitung. 3 Das Leib-Seele-Problem Das Leib-Seele-Problem ist ein Beispiel für ein klassisches philosophisches Problem, das im Zusammenhang mit dem Computermodell des Geistes in der KI und der Kognitionswissenschaft aufgegriffen und intensiv diskutiert wurde. Es geht dabei um die Frage nach der Wechselwirkung zwischen leiblichen und seelischen Vorgängen, weshalb man auch vom psychophysischen Problem spricht. Während man in Antike und Mittelalter Leib und Seele als eine Einheit verstand, hatte Descartes eine Tennung in zwei Substanzen, die körperliche (res extensa) und die seelische (res cogitans) vorgenommen. Wenn wir übrigens im Folgenden vom Körper-Geist-Problem“ sprechen, wie es heutzutage üblich ist, müssen wir uns ” vor Augen halten, dass damit eine Verengung erfolgt, denn weder bezeichnen Leib und Körper dasselbe, noch Seele und Geist. Descartes’ Dualismus wirft in verschärfter Form die Frage nach der Interaktion des ausgedehnten Körpers mit dem nicht ausgedehnten Geist auf, die er als Kausalbeziehung postuliert, jedoch in keiner Weise befriedigend erklären konnte. Als Schnittstelle“ sah er die Zirbeldrüse im Gehirn an: Der Geist wird nur von diesem ” Teil des Körpers unmittelbar beeinflußt. Für ihn bestehen alle Empfindungen aus Bewegungen im Körper, die über die Nerven in die Zirbeldrüse gelangen und dort dem Geist ein Signal geben, das ein bestimmtes Ereignis hervorruft. Wie auch immer man den dualistischen Ansatz weiterzudenken versucht, landet man entweder bei Widersprüchen oder bei einem unendlichen Regress — was wir hier jedoch nicht weiter vertiefen können —, dennoch hat er unser alltagspsychologisches Reden und Erklären zutieft beeinflußt. In unserem Zusammenhang ist interessant, inwieweit der kognitionswissenschaftliche Diskurs neues Licht auf das psychophysische Problem werfen konnte. Der am ehesten einschlägige unter den neuen Ansätzen ist der Funktionalismus von Hilary Putnam u.a. Für ihn sind mentale Zustände die funktionalen Zustände eines Systems. Sie werden durch ihre kausale Rolle bestimmt, durch ihre Vernetzung mit anderen Zuständen und mit den Ein- und Ausgaben des Systems. Beispielsweise bedeutet Schmerzen zu haben nicht, ein bestimmtes Verhalten zu zeigen oder in einem bestimmten organischen Zustand zu sein, sondern einen funktionalen Zustand, mit dem das Ziel verbunden ist, ihn loszuwerden. Was auch immer diese kausale Rolle spielt, gilt als Schmerz (vgl. [1]). Mentale Zustände können wie die Zustände einer Turing-Maschine in verschiedenen Organismen auf unterschiedliche Weise realisiert sein. Insofern ist der Funktionalismus kompatibel mit dem Computermodell des Geistes. Andere Autoren gehen noch weiter, indem sie mentale Zustände als solche funktionalen Zustände definieren, denen eine bestimmte, z.B. biologische, Funktion für das System zugeschrieben werden kann. Da in diesem Zusammenhang der Körper zumeist auf das Gehirn reduziert wird (!), ergibt sich ein Verhältnis von Gehirn zu Geist wie das von Hardware zu Software, und geistige Eigenschaften werden zu abstrakten Informationsverarbeitungs-Eigenschaften des Gehirns. Verknüpft man diese Position mit der These des sog. reduktiven Materialismus, nämlich dass geistige Zustände Hirnzustände und nichts anderes sind, hat man lediglich eine Variante der starken KI-Hypothese formuliert. Eine Erklärung, wie Wahrnehmungen, Gefühle, Überzeugungen, Wünsche, Absichten unser Verhalten lenken können, wenn zugleich wahr ist, daß dieses Verhalten lückenlos physisch verursacht ist, ist damit nicht gewonnen. 4 Nun mag man einwenden, das Computermodell des Geistes solle gar nicht eine solche Erklärung liefern, sondern es ginge im Hinblick auf die MenschMaschine-Interaktion um eine Analogie: Maschinen mentale Zustände zuzuschreiben hieße dann nicht, zu behaupten, sie hätten mentale Zustände. Die Maschinen verhielten sich aber so, als ob sie sich in entsprechenden mentalen Zuständen befänden; tatsächlich haben sie aber keine mentalen Zustände, weil sie nichts bewußt erleben oder nicht das bewußt erleben, was ein Mensch dabei bewußt erlebt. In diesem Sinne verhielte sich die KI als empirisches Forschungsprojekt neutral. Sie machte keine Aussagen darüber, wie ähnlich uns ein anderes Lebewesen oder ein künstliches System in seinem Verhalten, in seinen physikalischen und chemischen Eigenschaften sein muss, damit wir von ihm sagen, es habe mentale Zustände. Mit einer derart abgeschwächten Position geben sich aber zumindest einige Hirnforscher nicht zufrieden — doch ist gegenüber vorschnellen Schlüssen Vorsicht geboten. Inzwischen kann als unbestritten gelten, dass kognitive Prozesse der Wahrnehmung und des Denkens stets mit messbaren Gehirnaktivitäten korreliert sind, was Messungen mit bildgebenden Verfahren wie z.B. der PositronenEmissions-Tomographie (PET) belegen. Die Feststellung einer Korrelation ist allerdings etwas ganz anderes als die einer Kausalbeziehung. Zur Aufstellung eines Kausalgesetzes bedarf es einer theoretischen Begründung, die bestenfalls durch eine beobachtete Korrelation gestützt werden kann. Und es ist keineswegs klar, ob dies mit endlichen Mitteln erreichbar ist. So hat der Hirnforscher Gerhard Roth in einem Artikel (Die Zeit Nr. 14 vom 29.3.1996, s.a. [2]) ausgeführt: Die Hirn” forschung steckt, sofern sie sich auf das Geist-Gehirn-Problem einläßt, in einem tiefen Dilemma: Sie muss in einer mentalistischen“ Sprache reden, sonst entge” hen ihr genau die Phänomene, die es zu erklären gilt. Gleichzeitig muss sie sich in naturwissenschaftlichen Begriffen ausdrücken, denn im Gehirn geht es nun einmal physikalisch-physiologisch zu. . . . In der Psychologie . . . glaubt man, kognitive Prozesse ohne Ansehen des materiellen Substrats beschreiben zu können. Dies ist jedoch ein schwerwiegender Irrtum. Jeder geistigen Aktivität entspricht genau ein neuronaler Prozess . . . , und jeder Veränderung des Gedankens entsprechen strukturelle und funktionelle Veränderungen im Verschaltungsmuster von Nervenzellen. Die Architektur des Gehirns bestimmt seine kognitiven Leistungen, und kognitive Leistungen — durch das limbische System bewertet — verändern die Architektur des Gehirns. Für diese Nichtabtrennbarkeit von Geist eine gemeinsame psychoneuronale Begriffs- und Erklärungssprache zu finden ist die größte Herausforderung an beide Disziplinen. Sie würde den eigentlichen Schritt über Decartes hinaus darstellen. . .“ 5 Zur Entwicklung der Logik Traditionell umfasst die Logik die Lehre vom Begriff (wie wird korrekt definiert?), die Lehre vom Urteil (wie werden Aussagen gebildet?) und die Lehre vom Schluss (was ist eine korrekte Folgerung?); die moderne formale Logik hat i.W. den dritten Aspekt in den Fokus genommen, während, wie wir noch sehen werden, für die KI die beiden anderen ebenso wichtig sind. Aristoteles, der Vater der Logik“, geht von ” Schlüssen folgender Art aus: Alle Griechen sind Menschen“ und Alle Menschen ” ” sind sterblich“, folglich Alle Griechen sind sterblich“ und nennt einen derartigen ” Schluss einen logischen Schluss, weil es bei ihm nicht auf den Inhalt der Wörter Grieche“, Mensch“ und sterblich“ ankommt, sondern nur auf die Form der Aussa” ” ” gen. Wenn wir die Wörter Grieche“ durch die Aussagenvariable P, Mensch“ durch ” ” Q und sterblich“ durch R ersetzen, erhalten wir das Schema des Schlusses: ” Alle P sind Q und Alle Q sind R folglich Alle P sind R Aristoteles fragt dann allgemein nach solchen Aussageformen und nach den Möglichkeiten, von (wahren) Aussagen auf andere (wahre) Aussagen allein aufgrund der Form zu schliessen. Insgesamt kann er für die gültigen Schlüsse vier Formen identifizieren, die sog. Syllogismen. Uneingedenk der historisch überragenden Bedeutung der aristotelischen Syllogistik knüpft die moderne Logik sachlich aber eher an die der Stoiker an. Diese hatten die Möglichkeiten der Zusammensetzung beliebiger Aussagen und die Beziehungen zwischen solcherart zusammengesetzten Aussagen untersucht. Aus gegebenen Aussagen können mit den Junktoren nicht“, und“, oder“ und wenn–dann“ zusammengesetzte Aussa” ” ” ” gen gebildet werden. Die Logik dieser Junktoren (heute auch Aussagenlogik“ ge” nannt) befasst sich mit der Frage, wann aus so gebildeten komplexen Aussagen auf Grund der Form allein auf andere Zusammensetzungen geschlossen werden kann. Die aristotelische Logik bzw. zunächst nur der von Boethius (um 500 n.Chr.) überlieferte Teil führte dann zu einer selbständigen und sehr reichhaltigen Weiterentwicklung der Logik ab ca. 1150. Erst im 20. Jahrhundert hatte man erkannt, dass sehr viele in der modernen Logik und Sprachphilosophie untersuchten Fragen bereits in der Scholastik intensiv diskutiert worden waren; hierzu gehören u.a. Erweiterungen der Logik um modale und temporale Aussagen und logische Paradoxien. Dies war aber mit dem Verfall der Scholastik in Vergessenheit geraten. An die Stelle der Logik trat in der Neuzeit die Mathematik — und diese kümmerte sich nicht um die ihr selbst zugrundeliegende Logik, bis erst im 19.Jh. ein Wechsel einsetzte. Die neuzeitliche Mathematik ist vor allem Analysis; der Analytiker deduziert nicht nach logischen Regeln, sondern er operiert mit seinen Formeln nach den Regeln der Analysis selbst. Das war jedenfalls die Auffassung des 17. und 18.Jahrhunderts. Dass ein Mathematiker bemerkt, dass die Logik für sein eigenes Denken entscheidend ist, ist die Ausnahme, z.B. bei Leibniz. Das sog. Leibnizprogramm zur Schaffung neuen Wissens hat folgende Bestandteile: In dem von einer universellen Wissenschaftssprache aufgespannten Rahmen soll es mit Hilfe einer characteristica universalis, einer universellen Zeichenlehre, möglich werden, einfache Begriffe eineindeutig auf Zeichen abzubilden. Dadurch sollen Denkstrukturen in einem Zeichensystem repräsentiert und Denkprozesse durch Veränderung von Zeichenreihen ausgedrückt werden. Die logica 6 inventiva oder Erfindungslogik soll ausgehend von einfachen Relationsaussagen Schritt für Schritt alle Wahrheiten liefern. Der calculus ratiocinator ist ein Kalkül, in dem alle Folgerungsschritte durch syntaktische Umformungen von Zeichenreihen erfolgen. In der Wissenschaft werden diese Mittel für die ars iudicandi und die ars inveniendi eingesetzt. Die ars iudicandi oder Beurteilungskunst erlaubt, sachliche Meinungsverschiedenheiten durch Ableitungen im Kalkül beizulegen. Schließlich dient die ars inveniendi dazu, neue Wahrheiten auf rechnerischem Wege zu ermitteln, eine Kunst, die mit der auf den mittelalterlichen Gelehrten Raymundus Lullus zurückgeführten Kombinatorik verbunden ist. Mit Leibnizens Konzeption der cogi” tatio symbolica“ wird die Rechenprozedur zu einem erkenntnistheoretischen Ideal und führt zu einem Forschungsprogramm, das auch heute noch eine Leitlinie in der KI und darüberhinaus ist. Erst Mitte des 19.Jh. beschäftigten sich englische Mathematiker wie De Morgan und Boole aus Interesse an formalen Gesetzen der Algebra mit der tradierten Syllogistik. Boole entwickelte zum dritten Mal in der Geschichte (er wusste weder von der stoischen noch der scholastischen Logik etwas) die Logik der Junktoren — diesmal in algebraischer Form, die uns als Boolesche Algebra“ bekannt ist ( An In” ” vestigation of the Laws of Thought...“, London, 1854). Den entscheidenden Schritt zur modernen Logik machte dann Gottlob Frege mit seiner Begriffsschrift, eine der ” arithmetischen nachgebildete Formelsprache des reinen Denkens“ (1879), in der er neben den Junktoren erstmalig die Quantoren ( für alle“, für einige“) als logi” ” sche Partikeln zur Zusammensetzung von Aussagen in Betracht zieht. Diese neue Quantorenlogik — oft auch etwas missverständlich als Prädikatenlogik“ bezeich” net — enthält die Junktorenlogik und die aristotelische Syllogistik als Teilgebiete. Sie kennt nicht nur Variablen für Aussagen, sondern auch Formeln, in denen Variablen für beliebige Individuen“ vorkommen, also parametrisierte Aussagen (Aussa” geformen). Allerdings ist die Frage nach der logischen Äquivalenz solcher Formeln — im Unterschied zur Junktorenlogik und der Syllogistik — nicht mehr allgemein entscheidbar. Der Mathematiker David Hilbert hatte 1900 in seiner berühmten Rede vor dem Mathematikerkongress in Paris ein Forschungsprogramm der reinen Mathematik entwickelt, das auf eine vollständige Axiomatisierung und damit einen abgeschlossenen Kalkül für alle mathematischen Sätze zielte. Dieses formalistische“ ” Programm, das das Leibniz-Programm zumindest innerhalb der Mathematik realisieren wollte, stieß auf heftige Kritik der Konstruktivisten“ und Intuitionisten“ un” ” ter den Logikern, die von aussermathematischen Grundbegriffen wie Konstruktion oder Berechenbarkeit ausgingen. Die Formalisten hingegegen suchten nach einer innermathematischen formalen Definition des Zahl- und Funktionsbegriffs, so beispielsweise in den berühmten Principia Mathematica“ (1910–13) von Russell und ” Whitehead. Ein Ergebnis dieses heftig geführten Grundlagenstreits war das Scheitern des formalistischen Programms einer umfassenden Axiomatisierung der Mathematik, was Kurt Gödel in zwei bahnbrechenden Arbeiten aufzeigte. In der ersten Arbeit ( Die Vollständigkeit der Axiome des logischen Funktionenkalküls“, 1930) ” hatte Gödel einen wesentlichen Baustein zum Hilbert-Programm geleistet, indem er bewies, dass die Quantorenlogik (Prädikatenlogik erster Stufe) vollständig und widerspruchsfrei ist. Jeder logisch wahre Satz ist auch im Kalkül ableitbar, also formal beweisbar, und jede ableitbare Formel ist auch semantisch wahr. Bedauerlicherweise sind die damit erfaßten Kalkülsprachen nicht ausdruckskräftig genug, um etwa die Zahlentheorie zu formalisieren, was aber eine Voraussetzung zur For- 7 malisierung großer Teile der Mathematik wäre. In der zweiten Arbeit ( Über for” mal unentscheidbare Sätze der Principia Mathematica und verwandter Systeme I“, 1931) zeigte Gödel, dass ein vollständiger und widerspruchsfreier Abschluss solcher Kalküle im Hilbertschen Sinn prinzipiell nicht möglich ist. Jede derartige Kalkülsprache lässt stets Aussagen zu, die in dem vom Kalkül modellierten Zahlenbereich inhaltlich wahr sind, aber nicht im Kalkül abgeleitet und damit in ihm nicht formal bewiesen werden können. Wahrheit und Beweisbarkeit sind also zwei verschiedene Begriffe, die sich zwar überschneiden, aber nicht zusammenfallen. 8 Turing-Maschine Alan Turing entwarf einen abstrakten Computer“, der jede Operation ausführen ” kann, die ein Mensch mit Bleistift und Papier bewerkstelligen kann: Die TuringMaschine. Sie hatte — statt eines Schreibblockes — ein unbegrenzt langes Papierband, das in Schreibfelder unterteilt war, die je ein Zeichen (einschließlich des Leerzeichens) aufnehmen können. Die Maschine kann immer nur ein Feld des Bandes bearbeiten, aber zum Bearbeiten der anderen Felder kann sie das Band nach links oder nach rechts verschieben. Das gerade zur Bearbeitung anstehende Feld kann entweder mit einem Zeichen beschrieben werden, oder sein Inhalt kann gelöscht werden, oder die Maschine geht zur Bearbeitung eines des Nachbarfelder über. Die Maschine selbst hat eine sehr einfache Struktur. Sie hat nur ein Speicherfeld, das eine von endlich vielen, verschiedenen Zustandsnummern speichern kann, und einem Programm, das aus einer Folge von elementaren Operationen besteht. Diese Operationen sind: Wenn im Zustand i das Zeichen x auf ” dem betrachteten Feld steht, dann gehe zum Nachbarfeld nach links und speichere den Zustand j“ oder . . . gehe zum Nachbarfeld nach rechts . . .“ oder . . . lösche ” ” das Zeichen x und schreibe y . . . .“. Turing hat gezeigt, dass seine Maschine ein mathematisches Modell einer universellen Rechenmaschine ist, die bei geeignetem Programm jede auch mit Bleistift und Papier durchzuführende Berechnung ausführen kann. Wir sprechen hier von Berechnung“ zunächst in einem sehr all” gemeinen intuitiven Sinn, der alle Tätigkeiten einschließt, die sich als schriftliche Arbeit, also als Handlungen mit Zeichensystemen, ausführen lassen. In der Folgezeit wurde bewiesen, dass das mathematische Modell der Turing-Maschine zu allen bekannten Kalkülen der Berechenbarkeit äquivalent ist. 9 Der Turing-Test und das chinesische Zimmer Turing hat mit seinem Imitationsspiel [4, 5] versucht, eine operationale Bestimmung der Intelligenz vorzulegen. In einem rein behavioristischen Versuchsaufbau werden nur die Eingaben in eine Black Box“ und die Ausgaben aus ihr betrachtet. ” Kann aufgrund der (für den Beobachter sinnvollen) Ausgaben nicht entschieden werden, ob es sich um Resultate menschlicher oder maschineller Aktion handelt, so soll der Black Box Intelligenz zugeschrieben werden, ganz gleich, ob hinter ihr ein menschlicher Dialogpartner oder ein geeignet programmierter Computer steckt. Dass dies nicht unbestritten bleiben würde, hat Turing bereits vorausgeahnt, da er einige mögliche Einwände bereits selbst vorwegnahm und diskutierte. Doch besteht bis heute keine Einigkeit über Sinn und Angemessenheit dieses Tests, m.a.W., was denn gezeigt wäre, wenn er mit einer Maschine erfolgreich verliefe — wie eine umfangreiche Literatur belegt. Häufig wird gesagt, dass das Turingsche Imitationsspiel ein geeignetes empirisches Verfahren sei, um die funktionale Äquivalenz eines Simulationsprogramms mit dem Original“´, dem menschlichen ” Dialogpartner, zu zeigen. Dabei heißen zwei Systeme funktional äquivalent, wenn sie wenn sie im mathematischen Sinn dieselbe Funktion realisieren, d.h. dieselbe Abbildung von Eingaben auf Ausgaben zeigen. Als Verfahren zur Beurteilung von Simulationsmodellen ist der Turing-Test zweifelsohne geeignet. Tests können kein Modell verifizeren, es aber auf seine Stärken und Schwächen prüfen. Ist der Test erfolgreich, spricht dies bestenfalls für die Simulationsmethode, kann aber keinesfalls die zugrundgelegte Theorie begründen. Dies ist aber etwas ganz anderes als eine operationale Definition maschineller Intelligenz. Eine naheliegende Frage wäre, ob es denn nur darauf ankommt, dass plausible Ausgaben vorliegen und nicht auch, wie sie zustande kommen. An dieser Stelle hakt u.a. der Philosoph John Searle mit seiner Geschichte vom Chinesischen Zimmer ein, das eine Variante des Turingschen Szenarios ist. Gegeben ist ein Zimmer, in das Blätter hineingereicht werden, die Nachrichten in chinesischer Sprache enthalten, und aus dem Zimmer werden werden wiederum Blätter mit Antworten in chinesischer Sprache herausgereicht. Sind die Antworten bezüglich der hineingegebenen Nachrichten für einen Sprecher der chinesischen Sprache plausibel, kann man dann sagen, es liege ein System vor, das Chinesisch versteht? Searle meint nein, denn es könnte in dem Zimmer ein Mensch sitzen, der ohne jede Kenntnis der chinesischen Sprache einfach anhand einer Tabelle, die für jede mögliche Eingabe eine passende Ausgabe angibt, ohne weiteres korrekte Antworten erzeugen. Diese Aufgabe kann auch von einem entsprechend programmierten Computer wahrgenommen werden, denn es handelt sich um eine rein syntaktische Interaktion: Die Eingabezeichen müssen nur ihrer Form nach richtig erkannt werden, um passende Ausgabezeichen zu wählen — auf ihren Sinn muss hierbei keinerlei Bezug genommen werden. Selbst wenn es also gelänge, so Searle, ein Programm zu schreiben, das sprachliche Interaktion perfekt simuliert, kann noch lange nicht daraus geschlossen werden, dass damit inhaltliches Verstehen konstituiert wird. Liegt nicht mit der Tabelle, die im Zentrum des chinesischen Zimmers steht, das in Regeln geronnene Chinesisch-Verstehen ihres Autors vor? Wohl ja, aber die Ausführung der Regeln ist nur eine notwendige Bedingung für das Erbringen der Verstehensleistung. Nun wurde eingewandt, dass Searle stillschweigend voraussetzt, dass ein System, das aus Teilen aufgebaut ist, deren jedes kein Chinesisch versteht, auch im Ganzen nicht Chinesisch verstehen kann. Zwar ist dieser 10 Einwand formal berechtigt, aber inhaltlich unbegründet: Die negative Behauptung, nämlich einer Regel die Eigenschaft des Verstehens abzusprechen, ist unproblematisch — im Unterschied zur positiven Behauptung. Denn für das Zusprechen einer solchen Eigenschaft wäre ein begründetes Verfahren anzugeben, und dasselbe gilt für Systeme von Regeln. Hinter der Behauptung der Emergenz einer Eigenschaft für ein System von Objekten, deren Teilen diese Eigenschaft nicht zukommt, steht eine Analogie aus der Systemtheorie. Es müssten in unserem Fall aber gute Gründe — notwendige und hinreichende Bedinungen — namhaft gemacht werden, inwiefern dies für die Eigenschaft des Verstehens gilt, und die sind bis heute ungenannt geblieben. Die Sache ist also nicht einfacher geworden: Sowohl Searle als auch die meisten seiner Kritiker haben sich in den Fallstricken der Sprache — in der wir über das Gedankenexperiment sprechen — verfangen. Das Problem der verschiedenen Sprachebenen, der rein syntaktischen im Regelsystem und der semantischen, in der wir über das bewußte Verstehen sprechen, wird nicht gelöst. Searle hat einen Ausweg versucht durch die empirische Behauptung, dass nur das Gehirn, das neuronale Medium, in der Lage ist, Bewußtsein als emergente Systemeigenschaft zu erzeugen. Damit tappt er aber in dieselbe Falle: Mit einer Verschiebung des Problems in einen naturalistischen Erklärungsversuch, der seinerseits noch komplexer ist und viele neue ungeklärte Fragen aufwirft, könnte er erst überzeugen, wenn er seine Behauptung durch ein nachvollziehbares Verfahren stützt. Gibt es Alternativen? Wir meinen ja: Gerade der Vorschlag einer pragmatischen Verankerung des Verstehensproblems, also im lebensweltlichen Handeln (s. Kapitel Sprachverarbeitung), erlaubt uns eine kritische Sichtweise auf den Turing-Test und schließt den Kreis zur These am Ende des Einleitungskapitels. Es geht nicht darum, einer Black Box Intelligenz zu- oder abzusprechen, sondern Intelligenz konstituiert sich — wenn überhaupt — in der Interaktion. 11 Sprechakttheorie Die Sprechakttheorie postuliert eine kommunikative Kompetenz, die die Fähigkeit zur Verwendung von Äußerungen in Sprechhandlungen zum Gegenstand hat und fragt nach einem fundamentalen System von Prinzipien und Regeln, über das Sprecher und Hörer verfügen, soweit sie die Bedingungen für eine erfolgreiche Verwendung von Äußerungen in Sprechhandlungen erfüllen. So unterscheidet Austin konstative Äußerungen (Behauptungsäußerungen), die wahr oder falsch sein können, und performative Äußerungen, welche gelingen können oder auch nicht, wobei die Frage der Wahrheit bei ihnen keine Rolle spielt. Diese Unterscheidung rekonstruiert er als verschiedene Aspekte ein und derselben Sprechhandlung: • lokutionäre Akte: das Äußern von Wörtern und Sätzen; • propositionale Akte: Bezugnahme (Referenz) auf Objekte und Beziehungen zwischen Objekten (Prädikation); • illokutionäre Akte: z.B. Behaupten, Fragen, Versprechen, Informieren etc. als Intention oder Redeabsicht; • perlokutionäre Akte: Konsequenzen des illokutionären Aktes beim Hörer, die Wirkungen auf ihn haben, d.h. das, was er versteht und im Ergebnis tut. In der Betrachtung des Sprechakts als Grundeinheit der Kommunikation versucht Searle, analytische Beziehungen herzustellen zwischen dem Sinn von ” Sprechakten, dem was der Sprecher meint, dem, was der geäußerte Satz bedeutet, dem, was der Sprecher intendiert, dem, was der Zuhörer versteht, und den Regeln, die für die sprachlichen Elemente bestimmend sind“ [3]. Er formuliert notwendige und hinreichende Bedingungen für das Äußern bestimmter Sätze als regelgeleitete Ausführung illokutionärer Akte und betont dabei besonders den intentionalen Charakter der Sprache. Indem man spricht, verfolgt man die Intention, sich anderen verständlich zu machen. Solches Sprechen ist ohne vorgängig ihm zugehörende — normative — Konventionen und Institutionen nicht möglich. Die Sprachtheorie ist damit Teil einer allgemeinen Handlungstheorie. Dies steht im Einklang mit Erkenntnissen der Soziolinguistik, dass sich der Gebrauch der Sprache mit der Situation, den Beziehungen und Absichten der Kommunikationspartner verändert. Die Redepartner sind in der Lage, die Intentionen und die spezifischen Fähigkeiten ihres Gegenüber einzuschätzen und danach ihr kommunikatives Handeln zu differenzieren. Wenn auch unterschiedlich ausgeprägt, so besitzt doch jeder Teilnehmer an der Sprachgemeinschaft über ein Repertoire an Ausdrucksmöglichkeiten, sich an die jeweilige Situation anzupassen. Damit wird aber auch eine Grenze für die maschinelle Sprachverarbeitung deutlich, denn sie sieht sich vor die Aufgabe gestellt, die Erfahrungen der Mitglieder der menschlichen Sprachgemeinschaft mit formalen Mitteln zu approximieren. 12 Syntaxanalyse Bisher ist noch offen geblieben, wie die grammatische Zerlegung sprachlicher Äußerungen algorithmisch durchgeführt werden kann. Die Grundlagen hierfür liefert die Theorie der formalen Sprachen, in der Bildungsgesetze für Zeichenketten untersucht werden. Der Linguist Noam Chomsky hat, ausgehend von unbeschränkten Regelsystemen, durch immer stärkere Einschränkung der Form der Regeln eine Hierarchie von Klassen formaler Sprachen definiert: als mächtigste Turing-äquivalente (mit Turing-Maschinen berechenbare), dann kontextsensitive, kontextfreie und reguläre Sprachen. Von besonderer Bedeutung für die Anwendung auf natürliche Sprachen ist die kontextfreie Familie, da der überwiegende Teil der Strukturen natürlicher Sprachen mit kontextfreien Mitteln elegant und hinreichend effizient beschrieben werden kann. Dies hat einen offensichtlichen Grund: Die einfachste uniforme Möglichkeit zur Beschreibung von Konstituentenstrukturen besteht darin, zuzulassen, dass die Muster, welche die Aufeinanderfolge von Elementen beschreiben, selbst rekursiv sind — genau dadurch ist aber die Klasse der kontextfreien formalen Sprachen konstituiert. Die Elemente derartiger Muster sind also nicht auf Wörter oder Wortkategorien beschränkt, sondern können selbst Namen anderer Muster, d.h. Kategoriennamen, sein. Das System der Kategorien selbst beruht ausschließlich auf der Form immer wiederkehrender Muster; als Randbedingung für seine Festlegung wird lediglich das Ökonomieprinzip der Minimalität und Redundanzfreiheit gefordert. Jedes Verfahren, das zu einer Zeichenkette mindestens einen korrespondierenden Strukturbaum bestimmt, muss die Regeln in einer vorgegebenen Reihenfolge anwenden. Die Folge dieser Schritte wird Ableitung der Zeichenkette genannt. Beginnt man die Ableitung mit dem sog. Startsymbol der Grammatik — in unserem Fall S für Satz“ — und wendet dann die entsprechenden Regeln für die davon ” abhängigen Kategoriensymbole an, bis man bei den terminalen“ Symbolen, den ” Wörtern, angelangt ist, so bezeichnet man eine solche Ableitung als top-down“. ” Beginnt man die Ableitung bei den terminalen Symbolen, also ganz unten“ im ” Baum bei den Wörtern und wendet die Regeln von rechts nach links an, so spricht man von einer bottom-up“-Ableitung. Orthogonal dazu unterscheidet man Tiefe” ” zuerst- (depth first)“ und Breite-zuerst- (breadth first)“ Ableitungen, je nachdem, ” ob die Expansion (Ableitung) in Teilbäume in die Tiefe — jeweils ein Pfad im Baum über mehrere Niveaus — oder in die Breite — zuerst alle Knoten auf einem Niveau — erfolgt. Durch Kombination dieser Dimensionen sind auch andere Ordnungen der Ableitungsschritte möglich; im Strukturbaum selbst wird über die Reihenfolge abstrahiert. Beispiel: In der folgenden einfachen kontextfreien Grammatik bedeuten die Zeichen S: Satz, NP: Nominalphrase, VP: Verbalphrase, V: Verb, Art: Artikel, N: Nomen. S VP NP → → → NP VP V NP Art N Die Lexikoneinträge seien der Einfachkeit halber auch in Regelform notiert; der senkrechte Strich steht für oder“: ” N → Katze | Maus V → fängt Det → die | eine 13 Für den Satz Die Katze fängt eine Maus wird der folgende Konstituentenstrukturbaum abgeleitet: S b b bb NP VP @ @ @ @ Art N V NP @ @ Art die Katze fängteine N Maus Mit kontextfreien Grammatiken tritt jedoch das Problem auf, dass für jede Kombination von Merkmalen linguistischer Objekte im Prinzip jeweils eigene Kategoriensymbole und mit diesen entsprechende Regeln definiert werden müßten, was die Übersichtlichkeit und Handhabbarkeit von Grammatiken sehr schnell begrenzt. Unter dem Begriff des Merkmals werden linguistisch relevante Eigenschaften von phonologischen, morphologischen, syntaktischen oder semantischen Einheiten verstanden; in unserem Beispiel wären das z.B. für das Nomen Katze“, ” dass es das Genus Feminin hat, und den Artikel die“, dass er (im vorliegenden ” Fall) das Genus Feminin, den Numerus Singular, den Kasus Nominativ hat und in der dritten Person steht. Erst dann kann unterschieden werden, dass die Katze“ ” eine zulässige NP ist, das Katze“ aber nicht. Im Falle der Übereinstimmung ( die ” ” Katze“) kann man diese Eigenschaften an die ganze NP vererben. Wir bräuchten dann aber statt eines NP-Symbols mehrere, in unserem Fall also ein Symbol für NP-feminin-singular, etc., wodurch auch die Anzahl der Regeln drastisch erhöht würde. Eine elegante Lösung dieses Problems bieten die sog. constraint-basierten oder Unifikations-Grammatikformalismen. In diesen treten an die Stelle atomarer Kategoriensymbole komplexe Merkmalsstrukturen. Merkmalsstrukturen sind endliche Mengen von Merkmalen, deren jedes aus einem Merkmalsnamen und einem Merkmalswert besteht, wobei letzterer entweder ein atomares Symbol oder selbst wieder eine Merkmalsstruktur ist. Darauf können wir an dieser Stelle nicht weiter eingehen, wollen aber festhalten, dass in nahezu allen modernen Sprachverarbeitungssystemen mit constraint-basierten Grammatikformalismen gearbeitet wird. 14 Entwicklung der Neuronalen Netze McCulloch und Pitts hatten mit ihren bahnbrechenden Vorarbeiten die Grundlage für ein wichtiges Teilgebiet der KI gelegt. Zunächst sei aber an dieser Stelle eine grundsätzliche Bemerkung zur Idee der formalen Neuronen angebracht. Die neurophysiologische Forschung der jüngsten Vergangenheit konnte immer mehr Klarheit über die ausserordentliche Komplexität der Struktur und Funktionsweise biologischer Neuronen herausfinden, doch selbst gegen den Kenntnisstand der 1940er Jahre nehmen McCulloch und Pitts eine extreme Vereinfachung durch die Reduktion auf Wahrheitsfunktionen vor. Auch die späteren Erweiterungen der Funktionalität formaler Neuronen sind noch weit von der biologischen Realität entfernt. Zu solchen Erweiterungen gehören statistische Regeln zur Aktivierung in Netzwerken lokal interagierender Einheiten lernfähige Netzwerke mit kontinuierlichen Veränderungen der Aktivierungs-Schwellwerte der Einheiten und mit anregenden oder hemmenden Gewichten“ ihrer Verbindungen. Dies besagt selbstverständlich ” nicht, dass unter gewissen Fragestellungen Vereinfachungen unzulässig sind. Man muss sich nur dessen bewusst sein, was damit noch erfasst werden kann und was nicht, und man sollte eine nüchterne Skepsis gegenüber Behauptungen der Art bewahren, neuronale Netze realisierten Computer, die wie das Gehirn“ funktio” nieren. Dennoch gingen die theoretischen Ambitionen von McCulloch und Pitts sehr weit: Wahrnehmung, Schlußfolgerung, Lernen, Introspektion, Motivation, Psychopathologie und Werturteile im Allgemeinen sollten im Prinzip mit ihrem Ansatz erklärbar sein. Die ganze Psychologie würde künftig auf die Definition bestimmter Netzwerke hinauslaufen, die alle Funktionen des Geistes realisieren. Dies ist eine der Wurzeln der sog. Rechnertheorie des Geistes ( computational theory of ” mind“): Die Arbeitsweise des Computers wird auf den Geist übertragen. Diese Auffassung war nicht unumstritten; so neigte etwa der Mathematiker John von Neumann, dem u.a. grundlegende Beiträge zum klassischen Universalrechnerkonzept zu verdanken sind, zu einer gewissen Skepsis, mit einem Computer die Aktivitäten des menschlichen Gehirns zu duplizieren. Auch wenn ihr Anspruch überzogenen war, hatte die Arbeit von McCulloch und Pitts wegen der Rückführung aller Berechnungen auf elementare logische Operationen auch auf die Entwicklung der konventionellen, auf dem Dualsystem basierenden digitalen Universalrechner Einfluss. Zudem zeigte sie auf, dass auf diese Weise auch symbolische — im Unterschied zu numerischen — Berechnungen, wie z.B. das junktorenlogische Schließen, modelliert werden können. Und sie gab einen entscheidenden Impuls zu weitergehenden Forschungen an neuronalen Netzwerken bis hinein in die Neurologie. In einem weiteren Aufsatz von 1947 wiesen sie auf den grundsätzlich parallelverarbeitenden Charakter neuronaler Netzwerke hin, was sie vom sequentiell arbeitenden Universalrechner unterscheidet. Darüberhinaus zeigten sie, dass neuronalen Netzen eine gewisse Robustheit eigen ist, denn sie können auch dann noch akzeptable Ergebnisse liefern, wenn einige formale Neuronen fehlerhaft arbeiten oder ausfallen oder das Eingabesignal verrauscht ist. Sie benutzten dazu ein statistisches Verfahren auf der Basis von Differentialgleichungen in Analogie zur Thermodynamik. Mit diesen Erweiterungen konnte die in ihrer ersten Arbeit vorausgesetzte, aber biologisch unrealistische Annahme der perfekten Daten aufgegeben werden. Vor einigen Jahren wurden übrigens im Nachlass Alan Turings Aufzeichnungen 15 gefunden, aus denen hervorgeht, dass er schon vor McCulloch und Pitts an der Idee der neuronalen Netzwerke arbeitete, so dass eigentlich ihm der Primat dieser Erfindung zukommt — nur hatte er sie leider nicht veröffentlicht. 16 Künstliche und Biologische Neuronale Netze Forschungen zur Architektur Künstlicher Neuronaler Netze haben entscheidende Anregungen von Ergebnissen der Neurophysiologie erfahren. So hat sich gezeigt, dass über 90% der menschlichen Großhrinrinde sehr homogen aus sechs Schichten aufgebaut sind, innerhalb derer die Neuronen säulenförmig gekoppelt sind. Im Großen ergibt sich folgendes Bild: Neuronen in einer Säule erregen sich gegenseitig, erregen schwächer diejenigen in Nachbarsäulen und hemmen die Neuronen in weiter entfernten Säulen. Diese Eigenschaften werden in sog. KohonenNetzwerken simuliert, die in der Lage sind, Eingabemuster wie auf einer Karte zu repräsentieren. Die Struktur der Karten bildet sich dabei nach Ähnlichkeit und Häufigkeit der Eigabemuster selbsttätig aus; die selbstorganisierenden Kohonenkarten sind also ein Beispiel für das unüberwachte Lernen. Beim Menschen sind solche Karten im Kortex bekannt, die u.a. die Körperoberfläche des Menschen abbilden, wobei sensorisch sensibleren Teilen wie z.B. Händen und Lippen eine entsprechend größere Fläche korrespondiert. Die Informationsverarbeitung mit diesen Karten erfolgt in modularer Weise: Eine Karte bildet ein Modul in einer Gruppe von Modulen, die miteinander zusammenarbeiten. Dies hat offensichtlich Effizienzvorteile. In diesem Zusammenhang sei noch eine weitere Besonderheit des menschlichen Kortex erwähnt: Was ihn auszeichnet, ist seine Plastizität. Anhand der Unteruchung behinderter Menschen konnte bei verschiedenen Behinderungen nachgewiesen werden, dass offensichtlich erhebliche Reorganisationsprozesse im Kortex stattfinden. So etwa im Gefolge der Amputation von Gliedmassen oder bei Blinden, bei denen sich die Kortexfläche für den lesenden Zeigefinger mit dem Erlernen der Blindenschrift nachweisbar vergößert. Es wird vermutet, dass aufgrund der gleichförmigen Organsiation des Kortex dies nicht nur für sensorische Kortexareale gilt, sondern auch für höhere“, die für weitere kognitive Prozesse massgeblich ” sind. Künstliche Neuronale Netzwerke, in denen jedes Neuron mit allen anderen Neuronen verbunden ist, wurden 1982 zuerst von dem Physiker John Hopfield entworfen. Diese autoassoziativen Netzwerke werden deshalb auch als HopfieldNetzwerke bezeichnet. Sie haben in Verbindung mit der Hebbschen Lernregel die folgenden Eigenschaften: (1) Ein Eingangssignal in Form eines räumlich verteilten Musters von Aktivierung und Nicht-Aktivierung kann als Aktivierungsmuster aktivierter und inaktivierter Neuronen gespeichert werden. Werden einige Neuronen angeregt, geben sie diese Anregung weiter und empfangen ihrerseits Anregungen von anderen Neuronen. Mit der korrespondierenden Veränderung der Synapsengewichte kann sich ein solches Netzwerk in einen stabilen Zustand entwickeln, der als assoziatives Speicherabbild interpretierbar ist. In der Sprache der dynamischen Systeme wird ein solcher Zustand auch Attraktor genannt. (2) HopfieldNetze können mehr als einen Attraktor ausbilden. Es wurde gezeigt, dass die maximale Anzahl speicherbarer Muster bei ca. 13% der Gesamtzahl der Neuronen liegt. (3) Der Zugriff auf die gespeicherten Muster kann über die die Vorlage eines Teils des gspeicherten Musters erfolgen. Sind etwa Bilder von menschlichen Gesichtern gespeichert, so genügt ein Teilbild oder ein verrauschtes Bild eines Gesichts, um es anhand der gespeicherten Muster zu vervollständigen. (4) Entspricht das vorgelegte Muster nicht exakt einem der gespeicherten, sondern ist es einem solchen nur hinsichtlich bestimmter Merkmalsausprägungen ähnlich, so 17 konvergiert der Aktivierungszustand des Netzwerks in Richtung dieses Musters. Man spricht in diesem Zusammenhang auch von der Generalisierungsfähigkeit von Hopfield-Netzen. Mit ihnen kann also die Ausbildung neuronaler Verbindungsstrukturen in biologischen Neuronennetzen simuliert werden. Versucht man, rückgekoppelte Netzwerke im Schema von Reiz und Rekation zu charakterisieren, so kann man sagen, dass ihr Verhalten“, dargestellt durch den Wechsel ihrer Aktivierungs” zustände in der Zeit, nicht nur von den Eingabemustern abhängt, sondern auch von den unmittelbar vorangegangenen Aktivierungen — die ja auch ein Teil der Eingabe sind. Damit können solche Netzwerke grundsätzlich zeitliche Muster, d.h. Regelmäßigkeiten in Folgen verarbeiten. Nicht mehr einzelne Muster, sondern ihre Abfolge ist für die Verarbeitung entscheidend. Damit ist eine neue Qualitätsstufe erreicht: Es wurde der Übergang von der statischen, isolierten Musterklassifikation zur Musterklassifikation im zeitlichen Kontext vollzogen. Sofern die Gehirnanalogie“ Künstlicher Neuronaler Netze nicht nur auf ei” ne oberflächliche Ähnlichkeit rekurriert, sondern trotz ihres hohen Abstraktionsgrads und damit einhergehender erheblicher Vereinfachungen — wenn man an die physikalisch-chemischen Detailprozesse biologischer Neuronen denkt — als Paradigma der Netzwerkforschung gesehen wird, ergeben sich für die Zukunft enorm spannende, aber auch höchst komplizierte Herausforderungen. Wir hatten gesehen, dass jede Synapse zwei Arten der Verarbeitung leistet. In einfacher Weise gesehen, verarbeitet sie Signale, indem sie diese über die Zeit summiert. Das heißt, sie ist fähig, erst dann eine Ausgabe zu erzeugen, wenn mehrere Impulse kurz aufeinander folgend eintreffen. Synapsen können aber auch räumlich summieren: Eine Eingabe an einer Synapse muss noch keine Ausgabe bewirken, sondern diese erfolgt erst dann, wenn mehrere Signale zu etwa der gleichen Zeit bei verschiedenen Synapsen desselben Neurons eintreffen. Die zweite Art der Verarbeitung — neben der zeitlichen und räumlichen Summation — besteht darin, dass eine Synapse ihre Verarbeitungskapazität, also Qualität, als Ergebnis ihrer Erfahrungen“ verändern kann, wodurch sie die Verschaltung“ und damit das ” ” Verhalten des Gehirns verändert. Darin, so glaubt man, liegt die Voraussetzung für adaptives Lernen. Weiterhin hat man detaillierte Kenntnisse über die Zuordnung bestimmter Regionen der Großhirnrinde zu bestimmten kognitiven Leistungen wie Sehen, Hören und Sprechen sowie über die hauptsächlichen Charakteristika der linken und rechten Gehirnhälfte. Seit den Untersuchungen von Broca und Wernicke im 19. Jahrhundert weiss man, dass die menschliche Sprachfähigkeit von der Funktionstüchtigkeit bestimmter Regionen der Großhirnrinde der linken Gehirnhälfte abhängt. Detaillierten Aufschluss gaben Versuche mit elektrischen Reizungen bestimmter Partien durch Penfield u.a. um 1959. Auch über die Aufgabenteilung“ bei ” der kognitiven Verarbeitung hat man detailliertes Wissen aufgrund der Erkenntnis, dass das Zentralnervensystem hierarchisch organisiert ist, ableiten können, z.B., dass ein bestimmtes Muster der kortikalen Organisation allgemein zu sein scheint: Interpretierende Regionen der Gehirnrinde liegen in unmittelbarer Nähe zu den Zonen, die Sinnesreize empfangen, und dieses Organisationsprinzip gilt für alle Formen der Wahrnehmung. Jede der beiden Gehirnhälften ist hochgradig parallel organisiert, doch ist jede in anderer Weise — was durchaus ökonomisch erscheint — spezialisiert“: Offenbar weisen sie unterschiedliche Modalitäten des ” Denkens auf. Der linken Hemisphäre ist primär das analytische, systematische Denken eigen, während die rechte eher ganzheitlich“, holistisch arbeitet. So ge” 18 schieht die Sprachverarbeitung überwiegend im Zentrum der linken, die räumliche Orientierung und die Produktion und Aufnahme von Musik überwiegend in der rechten Hemisphäre. Beide Hälften sind durch eine Brücke, das sog. corpus callosum verbunden, das aus ca. 200 Millionen Nervenfasern besteht und über das beide Hemisphären mit ca. vier Milliarden Impulsen pro Sekunde kommunizieren. Da die Reize körperlicher Empfindungen jeder Körperseite in die jeweils gegenüberliegende Gehirnhälfte geleitet werden, ist diese Verbindung auch für die menschliche Sprachverarbeitung von außerordentlicher Bedeutung, denn die rechte Hemisphäre hat nicht dasselbe Potential für Sprachverarbeitung wie die linke. Was schon für normale Rechner gilt, muss erst recht auf die kognitive Verarbeitung zutreffen: Aus einer Untersuchung des Verlaufs der Signale in einer Schaltung kann nicht auf Sinn und Bedeutung des ablaufenden Programms geschlossen werden. Ob es je gelingen wird, diese Lücke zu schliessen, ist sicher nicht nur eine empirische Frage der Neurophysiologie, sondern ebenso auch eine methodische. 19 LITERATUR Literatur [1] Lenzen, M.: Natürliche und Künstliche Intelligenz: Einführung in die Kognitionswissenschaft, Einführungen, Campus, Frankfurt/Main, New York, 2002. [2] Roth, G.: Das Gehirn und seine Wirklichkeit, 2. Ausg., 1995. Suhrkamp, Frankfurt/Main, [3] Searle, J.: Sprechakte, Suhrkamp, Frankfurt/M., 1971. [4] Turing, A.: Computing Machinery and Intelligence, Mind, Bd. 59, 1950, S. 433–460. [5] Turing, A.: Kann eine Maschine denken? (dt.: Computing Machinery and Intelligence), in Zimmerli, W. C.; Wolf, S. (Hrsgb.): Künstliche Intelligenz: Philosophische Probleme, Reclam, Stuttgart, 1997, S. 39–78.