DS-FAQ

Werbung

DS-FAQ

Zusammenstellung

aller DVP-Fragen

Beispiele

Erklärungen

Tipps

Tabellen

Version 1.0

5. April 2001

F. Deißenböck

A. Freyschmidt

http://www.deissenboeck.de/faqs

Inhaltsverzeichnis

1 Allgemeines

1.1 Was und warum . . . . . .

1.1.1 Was? . . . . . . . . .

1.1.2 Warum? . . . . . . .

1.2 Ein bißchen Lernpsychologie

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

3

3

3

3

2 Fragen zu Diskrete Strukturen I

2.0 Mathematische Grundprinzipien

2.1 Kombinatorik . . . . . . . . . . .

2.2 Graphentheorie . . . . . . . . . .

2.3 Algorithmen und Rekursionen . .

2.4 Algebraische Strukturen . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5

5

7

8

10

13

3 Fragen zu Diskrete Strukturen II

3.1 Endliche Wahrscheinlichkeitsräume . .

3.2 Unendliche Wahrscheinlichkeitsräume

3.3 Stochastik allgemein . . . . . . . . . .

3.4 Stochastische Prozesse . . . . . . . . .

3.5 Induktive Statistik . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

19

19

21

22

28

30

4 Tips&Tricks

4.1 Tips zu den verschiedenen Aufgabentypen . . . . . . .

4.2 Rechnen mit Summen . . . . . . . . . . . . . . . . . .

4.2.1 Allgemeines . . . . . . . . . . . . . . . . . . . .

4.2.2 Schreibweisen . . . . . . . . . . . . . . . . . . .

4.2.3 Gesetze . . . . . . . . . . . . . . . . . . . . . .

4.3 Lösen von Rekursionen . . . . . . . . . . . . . . . . . .

4.3.1 Lösen linearer Rekursionsgleichungen 1. und 2.

4.3.2 Erzeugendenfunktionen . . . . . . . . . . . . .

. . . . .

. . . . .

. . . . .

. . . . .

. . . . .

. . . . .

Grades

. . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

33

33

33

33

33

34

34

34

36

A Tabellen

A.1 Algebraische Strukturen . . . . . . .

A.2 Endliche Summen . . . . . . . . . .

A.3 Unendliche Summen . . . . . . . . .

A.4 Erzeugendenfunktionen . . . . . . .

A.5 Verteilungen . . . . . . . . . . . . . .

A.5.1 Bernoulli-Verteilung . . . . .

A.5.2 Binomialverteilung . . . . . .

A.5.3 Geometrische Verteilung . . .

A.5.4 Poisson-Verteilung . . . . . .

A.5.5 Pascal-Verteilung . . . . . . .

A.5.6 Hypergeometrische Verteilung

A.5.7 Normalverteilung . . . . . . .

A.5.8 Gleichverteilung . . . . . . .

A.5.9 Exponentialverteilung . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

41

41

44

44

45

46

46

46

47

48

49

49

50

51

51

Literaturverzeichnis

DS-FAQ v1.0

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

53

2

Kapitel 1

Allgemeines

1.1

1.1.1

Was und warum

Was. . .

. . . ist das alles? Diese Zusammenfassung gliedert sich in drei Teile. Die Kapitel 2 und 3 sind eine Zusammenfassung

der am häufigsten gestellten Fragen aus den DS-DVP-Protokollen. Diese haben wir selbst beantwortet, was aber

meistens bedeutet, daß wir die Antwort aus dem Skript abgeschrieben haben. Bei manchen Fragen sind kleine

Erläuterungen oder Beispiele dabei.

Kapitel 4 gibt erst mal Tipps zu verschiedene Aufgabentypen. Das sind einfach Dinge die uns beim berechnen

der Übungsblätter und Klausuren aufgefallen sind. Dann sind hier nochmal die wichtigsten Rechenregeln für Summen zusammengefasst, wobei man aber auch unbedingt einen Blick in [3] werfen sollte. Auf den letzten Teil des

Tipps-Kapitels sind wir besonders stolz, da er einen, wir finden, klaren und verständlichen Weg aufzeigt, wie man

Rekursionen zu Leibe rücken kann.

Der Anhang enthält Tabellen, die man andauernd braucht. Die verschiedenen algebraischen Strukturen, endliche

und unendliche Summen, Erzeugendenfunktionen und die Verteilungen. Ganz am Ende befindet sich noch ein

kommentiertes Literaturverzeichnis.

1.1.2

Warum?

Diese Zusammenfassung entstand in der Zeit, in der wir versucht haben, den DS1-Schein und die DS-DVP zu

bestehen (das dauerte bei uns immerhin ein Jahr). In dieser Zeit haben wir immer wieder von neuen alle Kapitel

lernen müssen und waren somit gezwungen uns mit einer Thematik auseinander zu setzen, die zuerst absolut

hoffnungslos aus sah. Nach dem wir jetzt aber ein Jahr lang gekämpft haben können wir aber behaupten, daß wir

doch das meiste verstanden haben. Auf jeden Fall so, daß wir die Prüfung bestehen können (der Alex hat das sogar

schon bewiesen).

Na ja, auf jeden Fall haben wir diese Zusammenfassung am Anfang eigentlich nur für uns erstellt, um einen

Überblick zu bekommen und uns das alles zu merken. Um uns zwingen sauber zu arbeiten haben wir aber schon

von Anfang an für eine fiktives Publikum geschrieben. Dann kam uns natürlich der Gedanke, daß vielleicht auch

andere Leute etwas damit anfangen könnten. Deshalb haben wir es dann noch ein bißchen ordentlicher gemacht

und hier ist das Ergebnis. Wir müssen wohl eigentlich nicht erwähnen, daß wir keine Garantie für die Richtigkeit

des Inhalts übernehmen.

Bevor irgendwelche Copyright-Beschwerden kommen möchten wir nochmal daraufhin weisen, daß die Fragen

zum Großteil aus den Protokollen abgeschrieben wurden und die Antworten dazu hauptsächlich aus den Skripten

von Frau Steger [1] und [2]. Die Aufgaben stammen aus den Skripten oder den Übungsblättern von Frau Steger

und Herrn Mayer. Es sind aber auch ein paar Sachen dabei, die wir uns selber überlegt haben, aber uns ging es vor

allem darum, das vorhandene Material in dieser Form zusammenzustellen.

1.2

Ein bißchen Lernpsychologie

Da unser Nebenfach ”Psychologie” heißt hier eine kurze Liste von Tipps, die recht hilfreich sind. Wir bitte zu

beachten, daß dies keine ”DOs and DONTs”-Liste ist, sondern einfach nur Anregungen geben soll.

• Wichtig ist es, das Stoffgebiet von Anfang an sauber zu gliedern. D.h. Ähnliches in Zusammenhang zu setzen

und unterschiedliche Dinge klar voneinander zu trennen. Am besten eignet sich dafür eine Übersichtsgrafik

über alle Stoffgebiete in der man mit Pfeilen und Gruppierungen die Zusammenhänge klar herausarbeitet.

Ein Beispiel befindet sich in [11, S.2].

DS-FAQ v1.0

3

1.2. Ein bißchen Lernpsychologie

• Man sollte versuchen das Wissen, das man erwirbt durch möglichst viele Verknüpfungen zu festigen. Das kann

zu einen bedeuten, daß man es mit ähnlichen Inhalten verknüpft (z.B. Markovkette → stationäre Verteilung

→ Eigenwerte → linear Algebra) oder auch mit fachfremden Inhalten. So kann man z.B. wenn man etwas

über Markovketten liest erst mal auf [12] die Biographie von Herrn Markov lesen. Wer z.B. über Kurt Gödel

gelesen hat, daß er aus Angst vergiftet zu werden, nichts mehr gegessen hat bis er verhungert ist, wird Wissen,

was mit Gödel zu tun hat beim nächsten mal bestimmt schneller parat haben.

• Regelmäßige Pausen sind wichtig, damit sich das neue Wissen setzen kann.

• Eine ausreichend lange Tiefschlafphase (ca. 8h) ist ebenfalls sehr wichtig. Sonst merkt man sich deutlich

weniger.

• Beim Lösen von komplizierten Problemen treten oft Set-Effekte auf. Man verrennt sich und kommt einfach

nicht weiter. Am besten das Problem für eine halbe Stunde ruhen lassen und es dann nochmal probieren.

• Wenn es irgendwie geht (prädestiniert sind Graphen) sollte man versuchen das Problem zu visualisieren. Ein

mit Urnen und Bällen vollgeschmiertes Blatt hat schon oft weiter geholfen.

• Wir mußten leider feststellen, daß es in DS oft Probleme gibt, bei denen man mit kreativen Problemlösen

nirgendwo hin kommt. In solchen fällen sollte man ruhig in das andere Extrem gehen und das Problem zu Tode

formalisieren. Das fängt natürlich mit der Aufgabenstellung an. Wer öfters an den Aufgaben rumrechnet,

merkt automatisch, wo das unerlässlich ist.

• Man sollte sich bewußt sein, daß Wissen das man gerade lernt, zuvor gelerntes Wissen hemmen kann. Das gilt

insbesondere wenn die Themen sehr ähnlich sind. Also, ein bißchen zwischen den Themen springen schadet

nichts.

• Wir finden, daß gemeinsames lernen (2 oder 3 Leute) deutlich effektiver ist als alleine lernen. Wichtig dabei

ist, daß man den Vorteil der Gruppe auch wirklich nutzt. Wenn man z.B. an einer komplizierten Aufgabe sitzt

ist auf jedem Fall gut, die Aufgabenstellung gemeinsam zu besprechen, damit sich jeder auch wirklich klar ist,

um was es da geht. Dann kann ruhig jeder alleine vor sich hinrechnen. Aber der Schluß ist das wichtigste. Falls

eine Lösung gefunden wurde sollte diese ausführlich diskutiert werden (stimmt das?, Paßt das mit unseren

bisherigen Vorstellungen zusammen?, was können wir daraus schließen?). Falls keine gefunden wurde und

man einen leichten Schimmer hat wieso man nichts gefunden hat, muß das genauso diskutiert werden.

• Es ist unumgänglich das Faktenwissen, das man gelernt hat auch exzessiv an den Aufgaben zu testen. Da

erlebt man meist böse Überraschungen.

• Die beste Art zu lernen, dürfte wohl sein, so eine Zusammenfassung zu schreiben, da man sich hier zwingen

muß sein Wissen kommunizierbar zu machen und dabei gehen einem einige Lücken auf.

• Wen das alles genauer interessiert, der sollte sich [9] oder [10] anschauen.

DS-FAQ v1.0

4

Kapitel 2

Fragen zu Diskrete Strukturen I

2.0

Mathematische Grundprinzipien

2.0.1 Was ist das kartesische Produkt zweier Mengen?

Das kartesische Produkt der Menge A mit der Menge B besteht aus allen Paaren (a, b) mit a ∈ A und b ∈ B.

Bei einem Paar kommt es auf die Reihenfolge an, es gilt:

(a, b) = (b, a), falls a = b

Man spricht von geordneten Paaren. Das kartesische Produkt von A und B bezeichnet man mit A × B. Es

ist also

A × B := {(a, b)|a ∈ A und b ∈ B}

Für A = ∅ oder B = ∅ gilt A × B = ∅. Es gilt

A × B = B × A, falls A = B und A × B = ∅

Für endliche Mengen A und B gilt:

|A × B| = |A| · |B|

Beispiel: Sei A = Z3 = {0, 1, 2} dann kann das kartesische Produkt A × A so dargestellt werden:

(0, 0)

(1, 0)

(2, 0)

(0, 1)

(1, 1)

(2, 1)

(0, 2)

(1, 2)

(2, 2)

Auf diese Darstellung kommen wir noch mal bei den Relationen (2.0.2) zurück.

2.0.2 Was ist eine Relation?

Eine Relation zwischen zwei Mengen A und B ist gegeben durch eine Teilmenge R ⊆ A × B. Man sagt es

besteht eine Relation zwischen a ∈ A und b ∈ B genau dann wenn (a, b) ∈ R. Eine weitere Schreibweise für

(a, b) ∈ R ist aRb.

Genau diese Schreibweise verwendet man, wenn man z.B. schreibt a > b, a = b, oder a ≤ b. Diese drei

Relationen sind in den folgenden Abbildungen grafisch dargestellt. Die hinterlegten Elemente bilden jeweils

die Teilmenge des kartesischen Produkts, die die Relation beschreibt.

>

(0, 0) (0, 1) (0, 2)

(1, 0) (1, 1) (1, 2)

(2, 0) (2, 1) (2, 2)

=

(0, 0) (0, 1) (0, 2)

(1, 0) (1, 1) (1, 2)

(2, 0) (2, 1) (2, 2)

≤

(0, 0) (0, 1) (0, 2)

(1, 0) (1, 1) (1, 2)

(2, 0) (2, 1) (2, 2)

Ist R eine Relation zwischen A und B dann nennt man die Menge

V (R) = {a ∈ A|es gibt ein b ∈ B mit (a, b) ∈ R}

DS-FAQ v1.0

5

2.0. Mathematische Grundprinzipien

den Vorbereich von R und

N (R) = {b ∈ B|es gibt ein a ∈ A mit (a, b) ∈ R}

den Nachbereich von R . Ist V (R) = A, dann heißt R linkstotal, ist N (R) = B, dann heißt R rechtstotal.

Eine Relation R zwischen A und B heißt linkseindeutig, wenn aus a1 Rb und a2 RB stets a1 = a2 folgt; sie

heißt rechtseindeutig wenn aus aRb1 und aRb2 stets b1 = b2 folgt. Eine Abbildung oder Funktion (2.0.4) ist

eine linkstotale, rechtseindeutige Relation.

Eine Relation R ⊆ A × A heißt:

•

•

•

•

reflexiv, wenn für alle a ∈ A gilt, daß (a, a) ∈ R

symmetrisch, wenn für alle a, b ∈ A gilt: (a, b) ∈ R ⇒ (b, a) ∈ R

antisymmetrisch, wenn für alle a, b ∈ A gilt: (a, b) ∈ R ∧ (b, a) ∈ R ⇒ a = b

transitiv, wenn für alle a, b, c ∈ A gilt (a, b) ∈ R ∧ (b, c) ∈ R ⇒ (a, c) ∈ R

Relationen die reflexiv, symmetrisch und transitiv sind heißen Äquivalenzrelationen. Relationen die reflexiv

oder antireflex, antisymmetrisch und transitiv sind heißen Ordnungsrelationen.

Beispiel: Eine triviale Äquivalenzrelation ist die Gleichheit, für eine Menge A gilt:

• für alle a ∈ A gilt: a = a ⇒ reflexiv

• für alle a, b ∈ A gilt: a = b ⇒ b = a ⇒ symmetrisch

• für alle a, b, c ∈ A gilt a = b ∧ b = c ⇒ a = c ⇒ transitiv

2.0.3 Was sind die Landau-Symbole?

Symbol

O(g)

Definition

O(g) := {f | ∃C∃n0 ∀n ≥ n0 : |f (n)| ≤ C|g(n)|}

Ω(g)

Ω(g) := {f | ∃C∃n0 ∀n ≥ n0 : |f (n)| ≥ C|g(n)|}

Θ(g)

Θ(g) := O(g) ∩ Ω(g)

o(g)

ω(g)

o(g) := {f | ∀C∃n0 ∀n ≥ n0 : |f (n) < C|g(n)|}

ω(g) := {f | ∀C∃n0 ∀n ≥ n0 : |f (n)| > C|g(n)|}

Beschreibung

f wächst bis auf einen Konstanten Faktor C ab n0 nicht schneller als g

f wächst bis auf einen Konstanten Faktor C ab n0 nicht langsamer als g

f wächst bis auf einen Konstanten Faktor C ab n0 genau so

schnell wie g

f wächst echt langsamer als g

f wächst echt schneller als g

2.0.4 Was ist eine Abbildung

Eine linkstotale, rechtseindeutige Relation R zwischen zwei Mengen A und B nennt man Abbildung. Das

bedeutet, daß jedes Element in A auf genau ein Element in B abgebildet wird. Es können aber zwei unterschiedliche Elemente a, b ∈ A auf das selbe Elemente c ∈ B abgebildet werden. Handelt es sich bei den

Elementen der beiden Mengen um Zahlen, so spricht man von einer Funktion.

Üblicherweise bezeichnet man das einzige Element in B, das mit einem Element a ∈ A in Relation steht mit

f (a). f (a) nennt man Bild von a. a bezeichnet man als das Urbild.

Eine Funktion f beschreibt man in dem man die Regel angibt, nach der für eine Element a ∈ A sein Bild f (a)

berechnet wird. Man verwendet dafür die Schreibweise:

f: A

a

→B

→ f (a)

Das Urbild eines Elements ist definiert als

f −1 (b) := {a ∈ A|f (a) = b}.

Eine Abbildung f : A → B heißt:

DS-FAQ v1.0

6

2.1. Kombinatorik

Bezeichnung

injektiv

Erklärung

wenn alle Elemente aus A unterschiedliche Bilder haben, wenn

also für b ∈ B gilt:

Beispiel

Gegenbeispiel

A

B

A

B

A

B

A

B

A

B

A

B

|f −1 (b)| ≤ 1

surjektiv

wenn jedes Element aus B ein

Bild von mindestens einem Element aus A ist, d.h. wenn für

alle b ∈ B gilt:

|f −1 (b)| ≥ 1

bijektiv

wenn die Abbildung sowohl injektiv als auch surjektiv ist.

Wenn f bijektiv ist gilt:

|f −1 (b)| = 1

2.0.5 Bitte schreiben Sie die Stirling-Formel zum Abschätzen von n! auf.

n! =

2.1

n n √

1

1

+O

2πn

1+

e

12n

n2

Kombinatorik

2.1.1 Was beschreiben die Stirlingzahlen zweiter Art und wie sind sie definiert?

Die Anzahl der k-Partitionen (k-elementige, disjunkte Teilmengen) einer n-elementigen Teilmenge ist durch

die Stirlingzahlen zweiter Art Sn,k gegeben, wobei gilt:

wenn n = 0, k = 0

1

0

wenn n = 0 oder k = 0 aber nicht beide

Sn,k =

Sn−1,k−1 + kSn−1,k sonst

2.1.2 Sei Σ∗ = {a, b, c}∗ . Wie viele Möglichkeiten gibt es, ein 2-stelliges Wort aus Σ∗ zu generieren? Wie viele

Möglichkeiten gibt es allgemein?

Es gibt 32 Möglichkeiten, allgemein gibt es k n = |Σ|n Möglichkeiten.

2.1.3 Wie viele Möglichkeiten gibt es nun, wenn keine Buchstabe mehrmals vorkommen darf?

Es gibt 32 Möglichkeiten, allgemein gibt es k n = |Σ|n Möglichkeiten.

2.1.4 Was beschreiben die Sterling-Zahlen erster Art und wie sind sie definiert?

Die Anzahl der Permutation von n Elementen mit genau k Zyklen ist durch die Stirlingzahlen erster Art sn,k

gegeben, wobei gilt:

wenn k > n oder k = 0

0

1

wenn k = n

sn,k =

sn−1,k−1 + (n − 1) · sn−1,k sonst

2.1.5 Schreiben Sie die Tabelle für das Bälle-Urnen-Modell auf ;).

DS-FAQ v1.0

7

2.2. Graphentheorie

|N | = n, |R| = r

N unterscheidbar

R unterscheidbar

N nicht unterscheidbar

R unterscheidbar

N unterscheidbar

R nicht unterscheidbar

N nicht unterscheidbar

R nicht unterscheidbar

2.2

beliebig

injektiv

surjektiv

bijektiv

rn

rn · [r ≥ n]

r! · Sn,r

n! · [r = n]

r+n−1

r n−1

r−1

[r = n]

Sn,k

[r ≥ n]

Sn,r

[r = n]

Pn,k

[r ≥ n]

Pn,r

[r = n]

n

r

k=1

r

k=1

n

Graphentheorie

2.2.1 Was ist ein Baum?

Ein Baum ist ein zusammenhängender, kreisfreier Graph. Es gelten folgende Aussagen:

• ein Baum ist kantenminimal zusammenhängend, d.h. wenn man eine Kante weg nimmt ist er nicht mehr

zusammenhängend

• ein Baum ist kantenmaximal kreisfrei, d.h. wenn man eine Kante hinzufügt, enthält er einen Kreis

• |E| = |V | − 1

• Jeder Baum T = (V, E) (|V | ≥ 2) enthält mindestens zwei Blätter

• Sei T = (V, E) ein Baum, v ∈ V ein beliebiger Knoten und T1 , . . . , Tk die Komponenten von T [V \ {v}].

Dann sind die Komponenten T1 , . . . , Tk Bäume und deg(v) = k

2.2.2 Was ist eine Wald?

Ein Wald ist ein Graph dessen Komponenten Bäume sind.

2.2.3 Was sind spannende Bäume und mit welchen Algorithmen kann man sie erzeugen?

Sei G = (VG , EG ) ein Graph. Ein Graph T = (VT , ET ) heißt spannender Baum in G falls gilt

1. T ist ein Baum

2. VT = VG und ET ⊆ EG

Spannende Bäume können mit Tiefen- oder Breitensuche gefunden werden.

2.2.4 Wie kann man die Anzahl verschiedener Bäume auf n Knoten zählen. Welche Voraussetzungen müssen erfüllt

sein?

Falls die Knoten markiert sind, ist die Anzahl der Bäume auf n Knoten nn−2 (Satz von Cayley, 1889).

2.2.5 Was ist ein Graph?

Ein Graph G ist ein Tupel (V, E), wobei V eine (endliche) Menge von Knoten ist und E ⊆

von Kanten ist.

V 2

eine Menge

2.2.6 Wann ist ein Graph zusammenhängend?

Ein Graph G heißt zusammenhängend, genau dann wenn für jedes Paar von Knoten u und v ein u − v-Pfad

in G existiert. Es gilt

• Ein zusammenhängender Graph G = (V, E) muß mindestens |E| = |V | − 1 Kanten enthalten

• jeder Graph für den |E| > |V 2|−1 gilt, ist zusammenhängend

2.2.7 Wie kann man die Anzahl der Zusammenhangskomponenten eines Graphen bestimmen?

DS-FAQ v1.0

8

2.2. Graphentheorie

Mit einer modifizierten Form der Breitensuche.

2.2.8 Welche Arten von Graphen kennen Sie?

• zusammenhängende

• planare

• Bäume und Wälder

• bipartite

• gerichtete

• vollständige

2.2.9 Wie ist ein bipartiter Graph definiert?

Die Knotenmenge eines bipartiten Graphen G = (A B, E) setzt sich aus zwei disjunkten Teilmengen A und

B zusammen. Für jede Kante e gilt, daß der eine Endpunkt in A und der andere in B liegen muß.

2.2.10 Was ist ein Matching?

Eine Kantenmenge M ⊆ E heißt Matching in dem Graphen G = (V, E), falls kein Knoten des Graphen in

mehr als einer Kante aus M vorkommt, d.h. wenn

e∩f =∅

für alle e, f ∈ M mit e = f

2.2.11 Was ist ein perfektes Matching?

Ein Matching heißt perfekt, wenn |M | =

wird.

|V |

2 ,

wenn also jeder Knoten durch genau eine Kante aus M überdeckt

2.2.12 Was ist ein eulerscher Kreis und welche Voraussetzungen muß ein Graph haben, damit es einen solchen gibt?

Ein Eulerkreis ist ein geschlossener Weg durch einen Graphen G = (V, E), wobei jede Kante des Graphen

genau einmal durchlaufen wird.

Ein Graph G = (V, E) besitzt genau dann einen Eulerkreis, wenn der Grad aller Knoten gerade ist.

2.2.13 Was sind Zusammenhangskomponenten?

k

Sei i=1 Vi eine Partition von V so daß zwei Knoten u und v genau dann durch einen Pfad verbunden sind,

wenn sie im selben Teil der Partition liegen. Dann heißen die Subgraphen G[Vi ] Komponenten von G.

2.2.14 Beschreiben Sie Breitensuche und Tiefensuche.

Mit Breiten- und Tiefensuche kann man einen Graphen durchlaufen und damit einen spannenden Baum finden.

Wir möchten hier nicht die genaue Algorithmen angeben (die stehen in [1]), sondern am Beispiel beschreiben

wie sie funktionieren. Für die folgenden Betrachtungen verwenden wir diesen Graph.

DS-FAQ v1.0

9

2.3. Algorithmen und Rekursionen

Breitensuche

Bei der Breitensuche wird der Graph, wie der

Name schon sagt in der Breite durchlaufen. Das

sieht dann so aus. Man fängt bei einem Startknoten an und besucht erst mal alle Nachbarn dieses

Knotens. Wenn alle besucht wurden geht man

zu einem dieser Nachbarknoten und wiederholt

das Spiel dort. D.h. man besucht von dort aus

alle noch nicht besuchten Nachbarknoten. Wenn

man das erledigt hat geht man wieder eine Ebene

höher und macht beim nächsten Knoten weiter.

Am besten dürfte das wohl ein Beispiel erklären.

Der folgende Graph zeigt das Ergebnis der Breitensuche auf unserem Graphen. An den Stellen

wo der Algorithmus den nächsten Knoten nicht

deterministisch beschreibt, haben wir immer den

kleinsten verwendet. Gestartet wurde in Knoten

1.

Tiefensuche

Auch die Tiefensuche tut genau das, was ihr Name sagt. Wir fangen bei einem Startknoten an

und besuchen einen Nachbarn. Jetzt gehen wir

aber nicht zurück, sondern gehen von hier aus

gleich weiter zum nächsten unbesuchten Knoten.

Das machen wir so lange bis wir entweder fertig sind oder es nicht weiter geht. Dann gehen

wir so lange zurück, bis wir an einem Knoten

sind, der noch unbesuchte Nachbarn hat. Dort

machen wir weiter. Auch hier sollte das Beispiel

zeigen, wie es geht. Wir haben wieder in Knoten

1 gestartet.

1

6

2

4

5

3

7

8

10

9

Hier haben wir den entstandenen Spannbaum

mal optisch als Baum aufbereitet und man sieht,

er ist ziemlich breit.

Daß die Tiefensuche ihrem Namen alle Ehre

macht, sieht man am entstandenen Spannbaum,

er ist zu einer Kette entartet. Das er hier so breit

aussieht, liegt nur am Layout, eigentlich reiht er

alle Knoten von oben nach unten auf. Tiefer geht

es also nicht mehr.

1

2

3

2.3

1

4

9 7

2

3

5

6 10 8

4

7

9

6

8

5

10

Algorithmen und Rekursionen

2.3.1 Erklären Sie den Unterschied zwischen dynamischer Programmierung und Divide&Conquer.

Bei Divide&Conquer wird ein Problem in mehrere Teilprobleme zerlegt und diese einzeln berechnet, die Gesamtlösung wird aus den Teillösungen zusammengesetzt. Dynamische Programmierung wird angewandt, wenn

die Teilprobleme nicht unabhängig sind, es werden Zwischenergebnisse gespeichert, damit diese nicht mehrfach

berechnet werden müssen.

Beispiele für Divide&Conquer

• Mergesort

• Quicksort

DS-FAQ v1.0

10

2.3. Algorithmen und Rekursionen

Beispiele für dynamische Programmierung

• Berechnung von Binomialkoeffizienten

• Knapsack

• CYK-Algorithmus

• Floyd-Warshall-Algorithmus

2.3.2 Erklären Sie das Prinzip der Greedy-Algorithmen.

Ein Greedy-Algorithmus wählt in jedem Schritt das lokale Optimum. Dadurch kann unter Umständen das

globale Optimum bestimmt werden.

Beispiele

• Kruskal (minimale Spannbäume)

2.3.3 Erklären Sie bitte das Master-Theorem.

Das Master-Theorem beschreibt das Laufzeitverhalten eines Algorithmus der das Divide&Conquer verfahren

anwendet, und bei dem ein Problem gelöst wird, indem es in α Teilproblem aufgeteilt wird. Die Teilprobleme

können sich überlappen — im Master-Theorem wird dieser Tatsache Rechnung getragen, indem angenommen

wird, daß die Teilprobleme die Größe n/β haben, wobei n die Größe des ursprünglichen Problems ist.

Im Theorem beschreibt die Funktion f (n) die Funktion mit der die Lösung des ursprünglichen Problems

aus den Lösungen der Teilprobleme berechnet wird. Wie man sieht hängt die Laufzeit des Divide&ConquerVerfahrens hauptsächlich von der Laufzeit dieser Funktion ab.

Seien α ≥ 1 und β > 1 zwei Konstanten und sei f (n) eine nichtnegative Funktion und sei T (n) definiert durch

die Rekursionsgleichung

n

T (n) = αT

+ f (n)

β

wobei nβ sowohl als nβ als auch als nβ gelesen werden kann, dann ist

log α Θ n β

wenn f (n) = O nlogβ α−ε

für ein konstantes ε > 0,

Θ nlogβ α log n wenn f (n) = Θ nlogβ α

T (n) =

Θ(f (n))

wenn

f(n) = Ω nlogβ α+ε für ein konstantes ε > 0 und

αf nβ ≤ cf (n) für ein konstantes 0 < c < 1

2.3.4 Für welche Rekursionsgleichungen existieren Lösungsformeln?

Für homogene und inhomogene lineare Rekursionsgleichungen ersten Grades und für homogene lineare Rekursionsgleichungen zweiten Grades. siehe (4.3).

2.3.5 Was ist eine formale Potenzreihe?

Um eine Folge der Form

(an )n≥0 = a0 , a1 , . . . , ak , . . .

besser greifbar zu machen wird eine neue Schreibweise für die Folgen eingeführt. Man multipliziert das

Folgeglied ak mit xk und addiert die einzelnen Folgeglieder:

a0 + a1 x + a2 x2 + . . . + ak xk + . . .

Wenn jetzt noch die Summenschreibweise verwendet wird, kann man die Folge (an )n≥0 als

an xn

A(x) :=

n≥0

DS-FAQ v1.0

11

2.3. Algorithmen und Rekursionen

schreiben. Das k-te Folgeglied ak wird als

[xk ]A(x) = [xk ]

an xn := ak

n≥0

geschrieben. Wir betrachten die Summen nicht als Reihen sondern einfach als andere Schreibweise für Folgen

und beschäftigen uns auch nicht mit dem Konvergenzverhalten. Wir sprechen von formalen Potenzreihen.

2.3.6 Wie sieht das Schema zum Lösen von Rekursionsgleichungen aus?

siehe (4.3).

2.3.7 Zeigen Sie das auflösen einer Rekursion am Beispiel der Fibonacci-Zahlen.

siehe (4.3).

2.3.8 Wie kann man das Knapsack-Problem a) mit einem Greedy-Algorithmus und b) mit dynamischer Programmierung lösen

a) Der Greedy-Algorithmus nimmt in jedem Schritt den Gegenstand mit dem besten Profit-GewichtVerhältnis pi /wi . Dies führt im allgemeinen nicht zu einer optimalen Lösung.

b) Angenommen wir haben einen Rucksack der höchstens M =17kg wiegen darf und die folgenden N =5

verschiedenen Elemente, die in den Rucksack gepackt werden können.

Element

Gewicht

Wert

1

3

4

2

4

5

3

7

10

4

8

11

5

9

13

Der folgende Algorithmus (in JAVA) löst das Problem. Dieser Algorithmus stammt aus [5].

/*

Felder:

weight[]

val[]

cost[]

:

:

:

best[]

:

Variablen:

N

:

M

:

Gewichte der Gegenstände

Werte der Gegenstände

cost[i] ist der optimale Werte der mit einem Rucksack

mit Fassungsvermögen i erzielt werden kann (am Anfang

mit 0 initialisiert

best[i] ist das letzte Element, das hinzugefügt wurde

um dieses Maximum zu erreichen

Anzahl verschiedener Element (im Beispiel: N=5)

Kapazität des Rucksacks (im Beispiel: M=17)

*/

public static void knapsack(){

for(int j=1;j<=N;j++){

for(int i=1;i<=M;i++){

if(i-weight[j]>=0)

if (cost[i]<(cost[i-weight[j]]+val[j])){

cost[i]=cost[i-weight[j]]+val[j];

best[i]=j;

}

}

}

}

Wie funktioniert dieser Algorithmus? Zuerst berechnen wir für alle Größen des Rucksacks (≤17kg) den maximalen

Wert, wenn nur Elemente vom Typ 1 verwendet werden, danach den maximalen Wert wenn nur Elemente vom Typ

1 und 2 verwendet werden usw. Die Lösung reduziert sich auf eine einfache Berechnung von cost[i]. Nehmen

wir an, daß ein Element j für den Rucksack gewählt wird; dann wäre der beste Gesamtwert, der erzielt werden

könnte val[j] (für das Element) plus cost[i-weight[i]] (um den Rest des Rucksacks aufzufüllen). Wenn dieser

DS-FAQ v1.0

12

2.4. Algebraische Strukturen

Wert den besten übersteigt, der ohne ein Element j erreicht werden kann, aktualisieren wir cost[i] und best[i];

andernfalls lassen wir die Größen unverändert.

Die Tabelle zeigt den Ablauf des Algorithmus’. Das erste Zeilenpaar zeigt den maximalen Wert (den Inhalt

der Felder cost[i] und best[i]), wenn nur Elemente vom Typ 1 benutzt werden; das zweite Zeilenpaar zeigt den

maximalen Wert, wenn Elemente vom Typ 1 und Typ 2 benutzt werden, usw. Der höchste, Wert der mit einem

Rucksack der Größe 17 erreicht werden kann ist 24.

Der tatsächliche Inhalt des optimalen Rucksacks kann mit Hilfe des Feldes best[] berechnet werden. Per

Definition ist best[M] in ihm enthalten, und der restliche Inhalt ist der gleiche wie im optimalen Rucksack der

Größe M-weight[best[M]]. Daher ist best[M-weight[best[M]]] im Rucksack enthalten, usw. Für unser Beispiel ist best[17]=3. Ein Element vom Typ 3 hat Gewicht 7, deshalb finden wir das nächste Element mit

best[M-7]=best[10]=3. Wieder Typ 3, also finden wir jetzt bei best[10-7]=best[3]=1 ein Element vom Typ 1.

Also besteht die optimale Packung aus zwei Element vom Typ 3 und einem Element vom Typ 1, die laut obiger

Tabelle zusammen 24 wert sind.

j=1

j=2

j=3

j=4

j=5

2.4

k

cost[k]

best[k]

cost[k]

best[k]

cost[k]

best[k]

cost[k]

best[k]

cost[k]

best[k]

1

0

2

0

0

0

0

0

0

0

0

0

3

4

1

4

1

4

1

4

1

4

1

4

4

1

5

2

5

2

5

2

5

2

5

4

1

5

2

5

2

5

2

5

2

6

8

1

8

1

8

1

8

1

8

1

7

8

1

9

2

10

3

10

3

10

3

8

8

1

10

2

10

2

11

4

11

4

9

12

1

12

1

12

1

12

1

13

5

10

12

1

13

2

14

3

14

3

14

3

11

12

1

14

2

15

3

15

3

15

3

12

16

1

16

1

16

1

16

1

17

5

13

16

1

17

2

18

3

18

3

18

3

14

16

1

18

2

20

3

20

3

20

3

15

20

1

20

1

20

1

21

4

21

4

16

20

1

21

2

22

3

22

3

23

5

17

20

1

22

2

24

3

24

3

24

3

Algebraische Strukturen

2.4.1 Was ist eine Boolesche Algebra?

Eine Algebra A = S, ⊕, , ¬ mit zwei zweistelligen Operatoren ⊕ und und einem einstelligen Operator ¬

heißt Boolesche Algebra, falls

B1. S, ⊕ ein abelsches Monoid mit neutralem Element 0 ∈ S ist,

B2. S, ein abelsches Monoid mit neutralem Element 1 ∈ S ist und

B3. für den Operator ¬ gilt:

a ⊕ (¬a) = 1 für alle a ∈ S und

a (¬a) = 0 für alle a ∈ S

B4. das Distributivgesetz gilt, d.h.

a (b ⊕ c) = (a b) ⊕ (a c) für alle a, b, c ∈ S und

a ⊕ (b c) = (a ⊕ b) (a ⊕ c) für alle a, b, c ∈ S

2.4.2 Was ist eine Homomorphismus?

= S,

Φ

zwei Algebren mit der selben Signatur. Dann heißt eine Abbildung h : S → S

Seien A = S, Φ und A

falls für alle einander entsprechende Operatoren f ∈ Φ und f ∈ Φ

gilt:

ein Homomorphismus von A nach A,

f und f sind mit h vertauschbar,d.h.

f h(a1 ), . . . , h(am ) = h f (a1 , . . . , am ) für alle a1 , . . . , am ∈ S

wobei m die Stelligkeit von f (und damit auch die von f ) bezeichnet.

Graphisch kann der Homomorphismus so dargestellt werden:

f

S m −−−−→

h

S

h

f

Sm −−−−→ S

Man sieht, daß man zum gleichen Ergebnis kommt, egal ob man oben“ oder unten“ rum läuft.

”

”

DS-FAQ v1.0

13

2.4. Algebraische Strukturen

2.4.3 Was ist ein Atom?

Informell ist ein Atom das (oder die) zweit-kleinste(n) Element(e) einer Booleschen Algebra. So ist das Atom

der True/False-Algebra True und die Atome der Potenzmengenalgebra sind die 1-elementigen Teilmengen.

Formal:

Sei A = S, ⊕, , ¬ eine Boolesche Algebra. Ein Element a heißt Atom, falls a = 0 und

b a =⇒ b = a für alle b ∈ S \ {0}

Es gilt:

1. a Atom

=⇒

[a b = a oder a b = 0] für alle b ∈ S

2. a und b Atome mit a = b

=⇒

ab=0

3. zu jedem Element b ∈ S \ {0} gibt es ein Atom a mit a b.

2.4.4 Nennen Sie mir den Darstellungssatz der Booleschen Algebra?

Sei S, ⊕, , ¬ eine endliche Boolesche Algebra. Dann läßt sich jedes Element x ∈ S, x = 0 in eindeutiger

Weise als ⊕-Summe von Atomen schreiben:

a

x=

a∈S

a Atom

ax=0

2.4.5 Wie mächtig ist eine Boolesche Algebra mit n Atomen?

Eine Algebra mit n Atomen enthält 2n Elemente.

2.4.6 Was ist eine Algebra?

Eine Algebra besteht aus einer Trägermenge S und einer Folge Φ von Operationen auf S. Dabei gilt: Jeder

Operator ist eine Abbildung

f : Sm → S

der Stelligkeit m für ein m ∈ N. Zweistellige Operatoren werden auch Verknüpfungen genannt.

2.4.7 Was ist der Unterschied zwischen einem Ring und einem Körper?

Beim Ring bildet S \ {0}, ein Monoid beim Körper eine abelsche Gruppe.

2.4.8 Was ist ein Monoid?

Eine Algebra A = S, ◦ mit einem zweistelligen Operator ◦ heißt Monoid, falls

M1. ◦ assoziativ ist und

M2. A ein neutrales Element e ∈ S besitzt. Für e gilt: e ◦ x = x ◦ e = x für alle x ∈ S (e ist eindeutig)

2.4.9 Geben Sie ein Beispiel für ein nicht abelsches Monoid an.

Sei Σ ein endliches Alphabet und Σ∗ die Menge aller Worte über Σ. Bezeichnen wir mit ◦ die Konkatenation

von zwei Worten, so ist Σ∗ , ◦ ein nicht abelsches Monoid. Das neutrale Element ist das leere Wort ε.

Beispiel: für das Alphabet Σ = {ε, a, b} gilt:

◦ ε a

b

ε ε a

b

a a aa ab

b b ba bb

2.4.10 Wie kann man Algebren ineinander überführen?

DS-FAQ v1.0

14

2.4. Algebraische Strukturen

Mit Hilfe von Homomorphismen (siehe 2.4.2).

2.4.11 Was ist ein Isomorphismus?

Wenn h ein Homomorphismus(2.4.2) ist und h bijektiv(2.0.2) ist, so nennt man h einen Isomorphismus.

2.4.12 Nennen Sie Beispiele von Booleschen Algebren.

• True/False-Algebra, True ist das Atom

• Potenzmengenalgebra, die 1-elementigen Teilmengen sind die Atome

2.4.13 Beweisen Sie (a ◦ b)−1 = b−1 ◦ a−1 .

Mit den Gesetzen der Gruppe (2.4.17) gilt:

e

X

G2

a ◦ a−1 = (a ◦ b) ◦ (a ◦ b)−1 = (a ◦ b) ◦ (b−1 ◦ a−1 )

G1

a ◦ (b ◦ b−1 ) ◦a−1 = a ◦ a−1 = e

=

=

G2

G2

=e

X

Wobei an der Stelle = die Aussage, die es zu beweisen gilt, verwendet wird. Man sieht, das es auch im Beispiel

Z, + funktioniert, sei a = 5 und b = 3

0

G2

5 + −5 = (5 + 3) + −(5 + 3) = (5 + 3) + (−3 + −5)

G1

5 + (3 + −3) + −5 = 5 + −5 = 0

=

=

X

G2

G2

2.4.14 Was ist ein Körper?

Eine Algebra A = S, ⊕, mit zwei zweistelligen Operatoren ⊕ und heißt Körper, falls

K1. S, ⊕ eine abelsche Gruppe mit neutralem Element 0 ∈ S ist,

K2. S \ {0}, eine abelsche Gruppe mit neutralem Element 1 ∈ S ist und

K3. a (b ⊕ c) = (a b) ⊕ (a c) für alle a, b, c ∈ S

= R, + an und zeichnen das kommutierende

2.4.15 Geben Sie einen Isomorphismus von A = R+ , · nach A

Diagramm.

Da log(x · y) = log x + log y ist folgende Funktion eine Isomorphismus:

h : R+

→ R

x → log x

Das Diagramm sieht so aus:

•

−−−−→

Rm=2

+

log x

R+

log x

Rm=2 −−−−→ R

+

2.4.16 Was ist eine Halbgruppe?

Eine Algebra A = S, ◦ mit einem zweistelligen Operator ◦ heißt Halbgruppe, falls ◦ assoziativ ist. Es gilt

a ◦ (b ◦ c) = (a ◦ b) ◦ c für alle a, b, c ∈ S

2.4.17 Was ist eine Gruppe?

Eine Algebra A = S, ◦ mit einem zweistelligen Operator ◦ heißt Gruppe, falls

DS-FAQ v1.0

15

2.4. Algebraische Strukturen

G1. ◦ assoziativ ist und

G2. A ein neutrales Element e ∈ S besitzt. Für e gilt: e ◦ x = x ◦ e = x für alle x ∈ S (e ist eindeutig)

G3. es zu jedem Element a ∈ S ein Inverses a−1 gibt. Für a−1 gilt: a−1 ◦ a = a ◦ a−1 = e

2.4.18 Was ist eine Untergruppe?

Eine Unteralgebra A einer Gruppe G heißt Untergruppe, wenn sie selbst wieder eine Gruppe ist.

2.4.19 Was muß gelten wenn B, · eine Untergruppe von A, · ist?

Die Kardinalität von B teilt die Kardinalität von A.

|A| | |B|

2.4.20 Was ist eine Nebenklasse?

Sei H eine Untergruppe einer Gruppe G und sei b ein beliebiges Element in G. Dann heißt:

H ◦b= h◦b|h∈H

eine rechte Nebenklasse von H in G und

b◦H = b◦h|h∈H

eine linke Nebenklasse von H in G.

Es gilt:

• H ◦ h = H für alle h ∈ H.

• für b, c ∈ G sind die Nebenklassen H ◦ b und H ◦ c entweder identisch oder disjunkt.

• |H ◦ b| = |H| für alle b ∈ G.

• Sei H Untergruppe von G, dann bildet die Menge der rechten (linken) Nebenklassen von H eine Partition

(disjunkte Zerteilung) von G.

• Die Anzahl verschiedener Nebenklassen von H in G heißt der Index von H in G und wird abgekürzt mit

indG (H) oder auch kurz ind(h).

• Sei G eine endliche Gruppe und H eine Untergruppe in G, dann gilt |G| = |H| · ind(H). Also teilt die

Kardinalität von H die von G.

2.4.21 Zeigen Sie, daß alle Nebenklassen von H in G eine disjunkte Zerlegung von G bilden.

Sei G eine Gruppe und H eine Untergruppe von G. Wir zeigen zuerst daß für b, c ∈ H gilt, daß H ◦ b und

H ◦ c entweder identisch oder disjunkt sind.

Seien b, c ∈ G mit H ◦ b ∩ H ◦ c = ∅ (d.h. H ◦ b und H ◦ c sind nicht disjunkt), etwa h1 ◦ b = h2 ◦ c (h1 , h2 ∈ H)

Dann ist

c = h−1

2 ◦ h1 ◦ b

H ◦ c = H ◦ h−1

2 ◦ h1 ◦ b = H ◦ b

=H da H◦h=H

Jetzt wissen wir, daß die Nebenklassen entweder identisch oder disjunkt sind und müssen nur noch zeigen,

daß sie ganz G überdecken.

Wegen e ∈ H und H ◦ b ⊆ G für alle b ∈ G, ist klar daß

G⊆

H ◦b⊆G

b∈G

Damit haben wir gezeigt, daß die Nebenklassen von H eine disjunkte Zerlegung von G bilden.

DS-FAQ v1.0

16

2.4. Algebraische Strukturen

2.4.22 Wie ist die Ordnung eines Elementes definiert?

Sei G eine Gruppe. Die Ordnung ord(a) eines Elements a ∈ G ist das minimale r ∈ N, so daß

ar = e

Falls kein solches r existiert sei ord(a) := ∞

Es gilt:

• Sei G eine endliche Gruppe, dann hat auch jedes Element in G endliche Ordnung.

• Sei G eine Gruppe und a ∈ G ein Element mit endlicher Ordnung ord(a). Dann gilt

ak = e

⇐⇒

ord(a) | k

• Sei G eine abelsche Gruppe und a und b zwei Elemente in G deren Ordnungen teilerfremd sind, so gilt:

ord(a ◦ b) = ord(a) · ord(b)

• Sei G eine endliche abelsche Gruppe und a ein Element mit maximaler Ordnung

ord(a) = max{ord(y) | y ∈ G}.

Dann teilt die Ordnung eines jeden Elements die Ordnung von a:

ord(b) | ord(a)

für alle b ∈ G

• Sei G eine endliche Gruppe, so teilt die Ordnung eines jeden Elements die Kardinalität der Gruppe.

2.4.23 Was ist eine Permutationsgruppe?

Die Permutationen einer Menge M bilden bezüglich der Verkettung eine Gruppe. Für M = {1, 2, . . . , n} heißt

diese die symmetrische Gruppe vom Grad n; sie wird mit Sn bezeichnet. Jede Untergruppe von Sn heißt eine

Permutationsgruppe vom Grad n.

2.4.24 Was ist eine zyklische Gruppe?

Eine Gruppe G heißt zyklisch, wenn es ein Element b, so daß

G = {bi | i ∈ Z}.

Ein solches Element b nennt man auch erzeugendes Element oder Generator von G.

Beispiel: :

Z, +, Zn , +n sind zyklische Gruppen

2.4.25 Was ist eine multiplikative Gruppe? Ist sie zyklisch?

In jedem Körper K ist die multiplikative Gruppe K ∗ = K \ {0} zyklisch.

2.4.26 Was sind Restklassen?

Man definiert für a, b ∈ Z und m ∈ N

a≡b

(mod m) ⇐⇒ m | a − b

D.h. a ist kongruent zu b modulo m genau dann, wenn m ein Teiler von a − b ist. Dies Kongruenzrelation ist

eine Äquivalenzrelation (2.0.2) in Z; die zugehörigen Äquivalenzklassen sind die Restklassen modulo m. Die

4er Restklassen (modulo 4) z.B. sind

[0]

[1]

[2]

[1]

DS-FAQ v1.0

=

=

=

=

{. . . , −8, −4, 0, 4, 8, . . .}

{. . . , −7, −3, 1, 5, 9, . . .}

{. . . , −6, −2, 2, 6, 10, . . .}

{. . . , −5, −1, 3, 7, 11, . . .}

4er

4er

4er

4er

Rest

Rest

Rest

Rest

0

1

2

4

17

2.4. Algebraische Strukturen

Diese Definition kann auch genauso auf die, bei der Konstruktion von Körper beschriebenen Polynome [1,

S.110] angewandt werden.

Zwei Polynome f (x) und g(x) sind genau dann kongruent modulo π(x), wenn ihre Differenz durch π(x) teilbar

ist. Die von f (x) erzeugte Restklasse modulo π(x) bezeichnet man mit [f (x)]π

[f (x)]π = {g(x) ∈ K[x] | π(x) teilt f (x) − g(x)}

Die Restklassen haben folgende Eigenschaften:

• Sind f1 (x) und f2 (x) zwei verschiedene Polynome mit grad(f1 ), grad(f2 ) < grad(π), so gilt [f1 (x)]π ∩

[f2 (x)]π = ∅

• Ist f (x) eine Polynom mit grad(f ) ≥ grad(π), so gibt es ein Polynom f (x) mit [f (x)]π = [f (x)]π und

grad(f ) < grad(π).

• Insbesondere gilt also, daß es genau |K|grad(π) viele verschiedene Restklassen gibt und diese paarweise

disjunkt sind. Die Menge dieser verschiedenen Restklassen bezeichnen wir mit K[x]/π(x). Formal:

K[x]/π(x) := {[f (x)]π | f (x) ∈ K[x], grad(f ) < grad(π)}

2.4.27 Gibt es einen Körper mit 4 Elementen?

Ja. 4 ist eine Primzahlpotenz, daher gibt es den Körper GF (pk ). Es gibt aber noch andere. Man setzt

K = {0, 1, a, b} und definiert Addition und Multiplikation wie folgt:

⊕ 0 1 a b

0 0 1 a b

1 1 0 b a

a a b 0 1

b b a 1 0

DS-FAQ v1.0

0

1

a

b

0

0

0

0

0

1 a b

0 0 0

1 a b

a b 1

b 1 a

18

Kapitel 3

Fragen zu Diskrete Strukturen II

3.1

Endliche Wahrscheinlichkeitsräume

3.1.1 Was ist die Bernoulli-Verteilung?

Eine Zufallsvariable X ist bernoulliverteilt, wenn es nur die Ausfälle 1 (Treffer) oder 0 (kein Treffer) gibt, p

gibt die Erfolgswahrscheinlichkeit an. Eine Zufallsvariable mit X mit WX = {0, 1} und der Dichte

p

für x = 1

fX (x) =

1 − p =: q für x = 0

heißt bernoulliverteilt. Es gilt

E[X] = p und

Var[X] = pq

3.1.2 Erklären Sie die Poisson-Verteilung.

Die Poisson-Verteilung besitzt den Wertebereich WX = N0 und hat die Dichte

Pr [X = i] = fX (i) =

e−λ λi

für i ∈ N0

i!

Es gilt

E[X] = λ und

Var[X] = λ

Die Poisson-Verteilung tritt immer dann auf, wenn wir über einen festen Zeitraum zählen, wie oft ein bestimmtes Ereignis eintritt. Dabei müssen folgende Voraussetzungen erfüllt sein:

• Es treten nie zwei Ereignisse gleichzeitig auf.

• Die Wahrscheinlichkeit, daß ein Ereignis in dem sehr kleinen Zeitintervall δt auftritt, ist ungefähr λδt.

• Die Anzahl der Ereignisse in einem festen Zeitintervall hängt nur von der Länge des Intervalls, nicht

aber von der Lage auf der Zeitachse (d.h. nicht von einer absoluten Zeit).

• Wenn man zwei disjunkte Zeitintervalle betrachtet, so sind die Anzahlen der Ereignisse in diesen

Zeiträumen voneinander unabhängig.

Beispiel: Wie groß ist die Wahrscheinlichkeit, daß bei 100-maligem Drehen des Roulette-Rads höchstens

zweimal der Ausfall 0 erscheint?

Die Zufallsvariable

X := Anzahl der Ausfälle 0 bei 100-maligem Drehen des Rades

hat den Erwartungswert E[X] = λ = 100 ·

Pr [X ≤ 2]

=

=

1

37 .

Daraus ergibt sich

2

e−λ λi

e−λ λ0

e−λ λ1

e−λ λ2

+

+

=

i!

0!

1!

2!

i=0

2 !

100

100 1 100

1+

+

e− 37

37

2 37

=

= 0, 492962 . . .

DS-FAQ v1.0

19

3.1. Endliche Wahrscheinlichkeitsräume

Die gesuchte Wahrscheinlichkeit beträgt also etwa 49,3%.

3.1.3 Was ist die Binomialverteilung?

Ist eine Zufallsvariable X := X1 + X2 + . . . + Xn als Summe von n unabhängigen Bernoulli-verteilten

Zufallsvariablen mit gleicher Erfolgswahrscheinlichkeit p definiert, dann heißt X binomialverteilt. Es gilt

WX = {0, . . . , n} und die Dichte ist

n x n−x

Pr [X = x] = fX (x) = B(x; n, p) =

p q

x

mit q := 1 − p. Für die Verteilung gilt:

Pr [X ≤ x] =

x

B(i; n, p)

i=0

Es gilt

E[X] = np

und

Var[X] = npq

Die Abbildung zeigt die Dichte der Verteilung B(x; 10, 0.4).

0,30

B(x; 10, 0.4)

0,25

0,20

0,15

0,10

0,05

0,00

0

2

4

6

8

10

3.1.4 Was ist die geometrische Verteilung?

Die geometrische Verteilung tritt dann auf, wenn wir ein Bernoulli-Experiment solange wiederholen, bis es

erfolgreich ist. Wenn ein einzelner Versuch mit Wahrscheinlichkeit p gelingt, so ist die Anzahl der Versuche

bis zum ersten Erfolg geometrisch verteilt. Wir erhalten die folgende Dichte:

fX (i) = pq i−1 für i ∈ N

Für Erwartungswert und Varianz ergibt sich:

E[X] =

1

p

und

Var[X] =

q

p2

Beispiel: Bei einem Rechnernetz stehe eine Leitung mit Wahrscheinlichkeit 0.8 zur Verfügung. Dann sind im

1

= 1.25 Versuche erforderlich, um eine Nachricht erfolgreich zu übertragen.

Durchschnitt 0.8

3.1.5 Welchen Zusammenhang gibt es zwischen der Poisson- und der Binomialverteilung?

Für große n und kleine p läßt sich eine Binomialverteilung durch eine Poisson-Verteilung approximieren:

n x

(np)x −np

Pr [X = x] =

p (1 − p)n−x ≈

e

x

x!

DS-FAQ v1.0

20

3.2. Unendliche Wahrscheinlichkeitsräume

3.2

Unendliche Wahrscheinlichkeitsräume

3.2.1 Erklären Sie die Exponentialverteilung.

Eine Zufallsvariable X heißt exponentialverteilt mit dem Parameter λ, wenn sie die Dichte

λ · e−λx falls x ≥ 0

f (x) = Pr [X = x] =

0

sonst

hat. Für die entsprechende Verteilungsfunktion gilt (falls x ≥ 0)

" x

x

λ · e−λt dt = [−e−λt]0 = 1 − e−λx

F (x) = Pr [X ≤ x] =

0

Für x < 0 gilt selbstverständlich F (x) = 0. Es gilt:

E[X] =

1

λ

und

Var[X] =

1

λ2

Außerdem gilt folgender Satz:

Sei X eine exponentialverteilte Zufallsvariable mit dem Parameter λ. Für a > 0 ist die Zufallsvariable Y := aX

wieder exponentialverteilt mit dem Parameter λa .

Eine exponentialverteilte Zufallsvariable ist gedächtnislos, siehe dazu 3.3.7.

Beispiel: Die Lebensdauer T eines elektrischen Bauteils sei exponentialverteilt mit dem Erwartungswert

E[X] = 500h.

Die Wahrscheinlichkeit, daß das Bauteil zwischen den Zeitpunkten 400 und 600 ausfällt, lautet

Pr [400 ≤ T ≤ 600]

600

400

= F (400) − F (600) = 1 − e− 500 − 1 + e− 500

= e−0.8 − e−1.2 = 0.148.

Die Wahrscheinlichkeit, daß die Lebensdauer mindestens 500h beträgt, lautet

500

Pr [T ≥ 500] = 1 − Pr [T ≤ 500] = e− 500 = e−1 = 0.368.

3.2.2 Erklären Sie die Normalverteilung.

Die Normalverteilung spielt vor allem in der Statistik eine große Rolle. Immer wenn man Größen betrachtet,

die um einen bestimmten Werte schwanken, so kann man das meist gut mit einer Normalverteilung modellieren.

Eine Zufallsvariable X mit Wertebereich WX = R heißt normalverteilt mit den Parametern µ ∈ R und σ ∈ R,

wenn sie die Dichte

#

$

1

(x − µ)2

f (x) = Pr [X = x] = √

· exp −

=: φ(x; µ, σ)

2σ 2

2πσ

hat. In Zeichen schreiben wir X ∼ N (µ, σ 2 ). N (0, 1) heißt Standardnormalverteilung.

Die Verteilungsfunktion zu N (µ, σ 2 ) lautet

1

·

F (X) = Pr [X ≤ x] = √

2πσ

#

$

(t − µ)2

exp −

dt =: Φ(x; µ, σ)

2σ 2

−∞

"

x

Es gilt:

E[X] = µ und

Var[X] = σ 2

3.2.3 Wie kann man eine beliebige N (µ, σ 2 )-verteilte Zufallsvariable durch eine N (0, 1)-verteile darstellen?

DS-FAQ v1.0

21

3.3. Stochastik allgemein

Sei X eine N (µ, σ 2 )-verteilte Zufallsvariable. Die für beliebige a ∈ R \ {0} und b ∈ R definierte Zufallsvariable

Y = aX + b ist N (aµ + b, a2 σ 2 )-verteilt.

Dies ermöglicht es, eine beliebige N (µ, σ 2 )-verteilte Zufallsvariable X durch die Transformation Y = X−µ

σ

in eine N (0, 1)-verteilte Zufallsvariable zu überführen. Die Funktionen φ und Φ ohne Angabe der Parameter

µ und σ entsprechen der Dichte und Verteilung von N (0, 1). Damit können wir das Ergebnis a < X ≤ b“

”

durch

#

$

a−µ

b−µ

b−µ

a−µ

<Y ≤

Pr [a < X ≤ b] = Pr

=Φ

−Φ

σ

σ

σ

σ

berechnen. Y heißt dann normiert.

3.2.4 Was besagt der zentrale Grenzwertsatz?

Die Zufallsvariablen X1 , . . . , Xn haben jeweils die selbe Verteilung und sind voneinander unabhängig. Den

Erwartungswert dieser Verteilung bezeichnen wir mit µ und die Varianz mit σ 2 .

Die Zufallsvariablen Yn werden definiert durch Yn := X1 + . . . + Xn (n ≥ 1). Dann sind die Zufallsvariablen

Zn :=

Yn − nµ

√

σ n

asymptotisch standardnormalverteilt, also Zn ∼ N (0, 1) für n → ∞. Anders formuliert heißt das, daß die

Variablen Yn die Verteilung N (nµ, nσ 2 ) haben.

Der zentrale Grenzwertsatz hat folgenden intuitive Konsequenz:

Wenn eine Zufallsgröße durch lineare Kombination vieler einzelner Zufallsgrößen entsteht, so erhält

man Näherungsweise eine Normalverteilung.

Das erklärt auch, warum die Normalverteilung bei natürlichen Phänomenen, wie z.B. der Körpergröße von

Menschen, so oft auftritt.

3.2.5 Was ist die Gleichverteilung?

Eine besonders einfache stetige Verteilung ist die Gleichverteilung auf dem Intervall [a, b]. Sie ist definiert

durch

1

für x ∈ [a, b]

b−a

f (x) = Pr [X = x] =

0

sonst

Die Verteilungsfunktion lautet:

"

F (x) = Pr [{t ∈ R : t ≤ x}] =

0

x

f (t) =

−∞

Es gilt:

E[X] =

3.3

a+b

2

und

Var[X] =

x−a

b−a

1

für x < a

für a ≤ x ≤ b

für x > b

(a − b)2

12

Stochastik allgemein

3.3.1 Was ist ein Wahrscheinlichkeitsraum?

Ein endlicher Wahrscheinlichkeitsraum ist bestimmt durch eine endliche Ergebnismenge Ω = {ω1 , . . . , ωn } von

Elementarereignissen. Jedem Elementarereignis ωi ist eine (Elementar-) Wahrscheinlichkeit Pr [ωi ] zugeordnet.

Für diese Wahrscheinlichkeiten gilt

Pr [ω] = 1

ω∈Ω

Eine Menge E ⊂ Ω heißt Ereignis. Die Wahrscheinlichkeit Pr [E] dieses Ereignisses ist definiert durch

Pr [ω]

Pr [E] =

ω∈E

DS-FAQ v1.0

22

3.3. Stochastik allgemein

3.3.2 Was ist ein Ereignis?

Siehe 3.3.1.

3.3.3 Erklären Sie bedingte und unbedingte Wahrscheinlichkeit.

Zusätzliche Informationen beeinflussen die Wahrscheinlichkeit eines Ereignisses. Dies wird formal durch die

bedingte Wahrscheinlichkeit gefaßt.

A und B seien Ereignisse mit Pr [B] > 0. Die bedingte Wahrscheinlichkeit Pr [A|B] von A gegeben B ist

definiert durch

Pr [A ∩ B]

Pr [A|B] =

Pr [B]

Man verwendet auch folgende Form

Pr [A ∩ B] = Pr [B|A] · Pr [A] = Pr [A|B] · Pr [B]

Anschaulich bedeutet dies: Um auszurechnen wie wahrscheinlich es ist, daß A und B gleichzeitig eintreten,

genügt es die Wahrscheinlichkeiten zu multiplizieren, daß zuerst A allein eintritt und dann B unter der

Bedingung, daß A bereits eingetreten ist.

Unbedingte Ereignisse sind unabhängig, siehe dazu (3.3.16).

3.3.4 Wie lautet der Satz von der totalen Wahrscheinlichkeit?

Die Ereignisse A1 , . . . , An bilden eine disjunkte Zerlegung von Ω, d.h. sie sind paarweise unvereinbar und es

gilt A1 ∪ . . . ∪ An = Ω. Dann folgt

n

Pr [B|Ai ] · Pr [Ai ]

(3.1)

Pr [B] =

i=1

Beispiel:

Gegeben seien drei Urnen. Urne 1 enthält eine weiße und eine schwarze Murmel, Urne 2 eine schwarze und

vier weiße Murmel und Urne 3 enthält je drei weiße und schwarze Murmeln. Ein Würfel wird geworfen. Falls

1, 2 oder 3 Augen erscheinen wird Urne 1 gewählt, bei Ausgang 4 wird Urne 2 gewählt und 5 oder 6 wird

Urne 3 gewählt. Nun wird aus der ausgewählten Urne eine Murmel gezogen.

Sei A das Ereignis, daß die gezogene Murmel weiß ist. Bestimmen Sie Pr [A].

Wir kennen folgenden Wahrscheinlichkeiten, wobei Ui das Ereignis ist, daß Urne i gewählt wurde.

1

2

1

Pr [A|U1 ] =

2

Pr [U1 ] =

1

6

4

Pr [A|U2 ] =

5

Pr [U2 ] =

1

3

1

Pr [A|U3 ] =

2

Pr [U3 ] =

Jetzt brauchen wir nur noch in (3.1) einsetzen.

3

Pr [A]

=

Pr [A|Ui ] · Pr [Ui ]

i=1

= Pr [A|U1 ] · Pr [U1 ] + Pr [A|U2 ] · Pr [U2 ] + Pr [A|U3 ] · Pr [U3 ]

1 1 4 1 1 1

· + · + ·

=

2 2 5 6 2 3

11

=

20

3.3.5 Wie lautet der Satz von Bayes?

Die Ereignisse A1 , . . . , An bilden eine disjunkte Zerlegung von Ω. Ferner sei B ein Ereignis mit Pr [B] > 0.

Dann gilt für ein beliebiges i

Pr [Ai |B] =

DS-FAQ v1.0

Pr [B|Ai ] · Pr [Ai ]

Pr [Ai ∩ B]

= n

Pr [B]

j=1 Pr [B|Aj ] · Pr [Aj ]

23

3.3. Stochastik allgemein

Bemerkung: Aus dem Satz der totalen Wahrscheinlichkeit (3.3.4) und der Definition der bedingten Wahrscheinlichkeit (3.3.3) ergibt sich, daß nicht nur die beiden Brüche gleich sind sondern das gilt:

Pr [Ai ∩ B] = Pr [B|Ai ] · Pr [Ai ]

n

Pr [B] =

Pr [B|Aj ] · Pr [Aj ]

j=1

Beispiel:

Wir setzen hier das Beispiel von (3.3.4) fort und fragen wie groß ist Pr [U2 |A]?

Jetzt müssen wir die bedingten Wahrscheinlichkeiten ”umdrehen” und genau das erledigt der Satz von Bayes.

Pr [U2 |A]

Pr [A|U2 ] · Pr [U2 ]

Pr [U2 ∩ A]

=

Pr [A]

Pr [A]

4 1

5 · 6

=

=

11

20

8

33

=

3.3.6 Wie lautet die Siebformel für zwei Ereignisse A und B?

Die Siebformel lautet für zwei endliche Mengen A und B lautet:

|A ∪ B| = |A| + |B| − |A ∩ B|.

entsprechend berechnet sich die Wahrscheinlichkeit der Ereignisse:

Pr [A ∪ B] = Pr [A] + Pr [B] − Pr [A ∩ B] .

Zum Verständnis die Abbildung für die Siebformel mit drei Mengen:

|A ∪ B ∪ C| = |A| + |B| + |C| − |A ∩ B| − |A ∩ C| − |B ∩ C| + |A ∩ B ∩ C|

A B

A B C

A

A C

B

C

B C

3.3.7 Schreiben Sie formal die Definition der Gedächtnislosigkeit auf.

Für eine exponentialverteilte Zufallsvariable X mit Parameter λ gilt (x, y) > 0

Pr [X > x + y | X > y] = Pr [X > y]

Andersherum gilt auch, daß eine gedächtnislose Zufallsvariable zwangsläufig exponentialverteilt ist.

3.3.8 Was sind Dichte und Verteilung?

Wenn man WX als Ergebnismenge interpretiert und die Zahlen xi mit den Wahrscheinlichkeiten pi als Elementarereignisse auffaßt, so erhält man den zugrunde liegenden Wahrscheinlichkeitsraum der Zufallsvariablen

X. Die Zuordnung von Wahrscheinlichkeiten zu Elementarereignissen

fX : WX

xi

DS-FAQ v1.0

→ [0, 1]

→

pi

24

3.3. Stochastik allgemein

nennt man Dichte(funktion) von X. Ferner heißt die Funktion

FX : R → [0, 1]

x → Pr [X ≤ x] =

pi

i: xi ≤x

Verteilung(sfunktion) von X.

3.3.9 Wie hängen Dichte- und Verteilungsfunktion zusammen?

Im diskreten ist die Verteilungsfunktion die Summe über die Dichtefunktion und im kontinuierlichen das

Integral über die Dichtefunktion.

3.3.10 Wie ist der Erwartungswert im a) diskreten Fall und b) kontinuierlichen Fall definiert?

a)

E[X] =

x · Pr [X = x] =

n

xi · pi

i=1

x∈WX

b)

"

E[X] =

∞

−∞

t · fX (t) dt

3.3.11 Wie ist die Varianz im a) diskreten Fall und b) kontinuierlichen Fall definiert?

a)

Var[X] = E[(X − E[X])2 ] = E[X 2 ] − E[X]2 =

n

(xi − E[X])2 · pi

i=1

b)

"

Var[X] = E[(X − E[X])2 ] = E[X 2 ] − E[X]2 =

∞

−∞

(t − E[X])2 · fX (t) dt

3.3.12 Was ist der Erwartungswert?

Bei der Untersuchung einer Zufallsvariablen ist es interessant zu wissen, welches Ergebnis man im Mittel“

”

erwarten kann. Man nimmt an das man das Experiment hinreichend oft wiederholt und das das arithmetische

Mittel der Werte, die die Zufallsvariable annimmt, gegen einen festen Wert konvergiert. Diesen Wert bezeichnet

man als Erwartungswert. Zur Berechnung siehe 3.3.10.

3.3.13 Was ist die Varianz

Die Varianz gibt die zu erwartende Abweichung vom Erwartungswert an. Ein naheliegende Lösung wäre

E[|X − E[X]|] zu verwenden. Wegen der unhandlichen Betragsfunktion verwendet man die quadratische

Abweichung vom Erwartungswert: E[(X − E[X])2 ]

3.3.14 Was ist die Standardabweichung?

Die Standardabweichung bezeichnet die Größe:

σ :=

%

Var[X]

3.3.15 Wie lautet die Ungleichung von Chebyshew

Sei X eine Zufallsvariable und t ∈ R+ . Dann gilt

'

&

%

1

Pr |X − E[X]| ≥ t Var[X] ≤ 2

t

oder alternativ

Pr [|X − E[X]| ≥ t] ≤

DS-FAQ v1.0

Var[X]

t2

25

3.3. Stochastik allgemein

3.3.16 Wie ist Unabhängigkeit definiert?

Zwei Ereignisse A und B sind unabhängig, falls gilt

Pr [A ∩ B] = Pr [A] · Pr [B]

Mit (3.3.3) kann das umgeformt werden zu:

Pr [A] =

Pr [A ∩ B]

= Pr [A|B] , falls Pr [B] = 0

Pr [B]

Die Zufallsvariablen X1 , . . . , Xn heißen unabhängig, wenn für alle xi ∈ WXi mit i = 1, . . . , n gilt

Pr [X1 = x1 , . . . , Xn = xn ] = Pr [X1 = x1 ] · . . . · Pr [Xn = xn ]

3.3.17 Warum ist Unabhängigkeit von Vorteil?

Bei unabhängigen Zufallsvariablen gelten Gesetze die bei abhängigen Zufallsvariablen nicht gelten:

• für unabhängige Zufallsvariablen X, Y gilt:

E[X · Y ] = E[X] · E[Y ]

• für unabhängige Zufallsvariablen X1 , . . . , Xn und X := X1 + . . . + Xn gilt:

Var[X] = Var[X1 ] + . . . + Var[Xn ]

3.3.18 Wodurch werden den Elementarereignissen Wahrscheinlichkeiten zugeordnet?

Durch die Dichtefunktion.

3.3.19 Was sind Zufallsvariablen?

Eine Zufallsvariable ist mathematisch gesehen eine Abbildung, sie ordnet jedem Ausgang eines Experiments

eine Zahl zu. Ist Ω die Menge der möglichen Ausgänge eines Experiments, so ist eine Zufallsvariable eine

Abbildung

X : Ω → R.

X(Ω) ist der Wertebereich von X:

WX := X(Ω) = {x ∈ R | ∃ ω ∈ Ω mit X(ω) = x}

Eine Zufallsvariable heißt diskret, wenn ihr Wertebereich WX endlich (oder abzählbar unendlich) ist.

3.3.20 Was ist die relative Häufigkeit

Wenn ein Versuch n mal wiederholt wird gibt Z die relative Häufigkeit von A an:

Z=

Anzahl der Versuche, bei denen A aufgetreten ist

Anzahl aller Versuche (n)

3.3.21 Erklären sie das Gesetz der großen Zahlen.

Gegeben sei eine Zufallsvariable X. Ferner seien ε, δ > 0 beliebig aber fest. Setzt man

N :=

Var[X]

= const,

εδ 2

dann gilt für alle n ≥ N :

Sind X1 , . . . , Xn unabhängige Zufallsvariablen mit derselben Verteilung wie X und setzt man

Z :=

DS-FAQ v1.0

X1 + . . . + X n

n

26

3.3. Stochastik allgemein

so gilt

Pr [|Z − E[Z]| ≥ δ] ≤ ε

Für den Beweis wird die Chebyshew-Ungleichung verwendet.

Anschaulich bedeutet dies: Wenn wir ein Zufallsexperiment genügend oft wiederholen und das arithmetische

Mittel Z aller Werte berechnen, welche die Zufallsvariablen Xi dabei annehmen, so gilt: Z liegt mit beliebig

hoher Wahrscheinlichkeit 1 − ε in einem beliebig kleinen Sicherheitsstreifen [E[X] − δ, E[X] + δ] um den

Erwartungswert E[X].

3.3.22 Welchen Zusammenhang gibt es zwischen der Poisson- und der Exponentialverteilung?

Wenn man Ereignisse zählt, wobei der zeitliche Abstand zweier Ereignisse exponentialverteilt ist, so ist die

Anzahl der Ereignisse Poisson-Verteilt.

Es gilt auch die Gegenrichtung, ist die Anzahl der Ereignisse Poisson-Verteilt, so ist der Abstand der Ereignisse

exponentialverteilt.

3.3.23 Beweisen Sie E[a · X + b] = a · E[X] + b.

E[a · X + b] =

n

(a · xi + b) · pi = a ·

i=1

n

xi · pi +b

i=1

=E[X]

n

pi = aE[X] + b

i=1

=1

3.3.24 Beweisen Sie Var[X + b] = Var[X].

Var[X + b]

= E[(X + b)2 ] − E[X + b]2 = E[X 2 + 2Xb + b2 ] − (E[X] + b)2

1

= E[X 2 ] + E[2Xb] + E[b2 ] − E[X]2 + 2bE[X] + b2

2

= E[X 2 ] + 2bE[X] + b2 − E[X]2 − 2bE[X] − b2

= E[X 2 ] − E[X]2

= Var[X]

Wobei wir an Stelle 1 die Linearität der Erwartungswerte ausgenutzt haben. An der Stelle 2 machen wir uns

den Satz von (3.3.23) zu Nutze. Außerdem ist noch zu erwähnen, daß E[b2 ] = b2 gilt, da b eine Konstante ist.

Dieses Ergebnis sollte eigentlich auch nicht Verwundern, da die Varianz ja die Abweichung vom Erwartungswert

angibt. Durch das b wird der Erwartungswert aber nur verschoben, die Abweichung darf sich dadurch nicht

ändern.

3.3.25 Beweisen Sie Var[a · X + b] = a2 · Var[X].

Wie wissen bereits daß Var[X + b] = Var[X] und zeigen nur noch Var[a · X] = a2 · Var[X].

Var[a · X]

= E[(aX)2 ] − E[aX]2 = a2 E[X 2 ] − (aE[X])2 =

= a2 E[X 2 ] − a2 E[X]2 = a2 (E[X 2 ] − E[X]2 )

= a2 Var[X]

3.3.26 Beweisen Sie, daß für unabhängige Zufallsvariablen X, Y gilt E[X · Y ] = E[X] · E[Y ]

Mit WX = x1 , . . . , xn und WY = y1 , . . . , yn gilt:

E[X · Y ]

n m

=

i=1 j=1

n

n

i=1

j=1

xi · Pr [X = xi ]

=

DS-FAQ v1.0

xi ji · Pr [X = xi , Y = yi ]

Unabh.

n m

=

xi ji · Pr [X = xi ] · Pr [Y = yj ]

i=1 j=1

yj · Pr [Y = yj ] = E[X] · E[Y ]

27

3.4. Stochastische Prozesse

3.3.27 Beweisen Sie die Linearität der Erwartungswerte.

E[X + Y ] =

X(ω) + Y (ω) · Pr [ω]

ω∈Wx

=

X(ω) · Pr [ω] +

ω∈Wx

Y (ω) · Pr [ω]

ω∈Wx

= E[X] + E[Y ]

3.3.28 Beweisen Sie, daß für unabhängige Zufallsvariablen X, Y gilt: Var[X + Y ] = Var[X] + Var[Y ].

Var[X + Y ]

= E[(X + Y )2 ] − E[X + Y ]2 = E[X 2 + 2XY + Y 2 ] − E[X]2 + 2E[X]E[Y ] + E[Y ]2

= E[X 2 ] + E[2XY ] + E[Y 2 ] − E[X]2 + 2E[X]E[Y ] + E[Y ]2

1

= E[X 2 ] + 2E[X]E[Y ] + E[Y 2 ] − E[X]2 + 2E[X]E[Y ] + E[Y ]2

= E[X 2 ] − E[X]2 + E[Y 2 ] − E[Y ]2

= Var[X] + Var[Y ]

Wobei wir an der Stelle 1 die Unabhängigkeit ausgenutzt haben, in dem wir die Erwartungswerte multiplizieren.

3.4

Stochastische Prozesse

3.4.1 Was sind Markovketten?

Eine (endliche) Markovkette (mit diskreter Zeit) über der Zustandsmenge S = {0, . . . , n − 1} besteht aus einer

unendlichen Familie von Zufallsvariablen Xt (t ∈ N0 ) mit Wertemenge S sowie einer Startverteilung q0 mit

q0T ∈ Rn≥0 . Die Komponenten von q0 addieren sich zu Eins. Die Werte

pij := Pr [Xt+1 = j | Xt = i] = const

sind von t unabhängig und definieren die Zustandsübergangsmatrix P = (pij )0≤i,j≤n . Ferner gilt für jede

Indexmenge I ⊂ {0, . . . , t − 1} und beliebige Zustände i, j, sk (k ∈ I)

Pr [Xt+1 = j | Xt = i, ∀k ∈ I : Xk = sk ] = Pr [Xt+1 = j | Xt = i] = pij

(∗)

Wenn man S = N0 zuläßt, so spricht man von einer unendlichen Markovkette. Die Bedingung (∗) heißt

Markov-Bedingung und kann anschaulich so geschrieben werden:

pij = Pr [Kette ist jetzt in Zustand j — Kette war einen Schritt davor in Zustand i] =

Pr [Kette ist jetzt in Zustand j — Kette war einen Schritt davor in Zustand i

+ zusätzliche Information]

D.h.: Wenn wir den Zustand i zum Zeitpunkt t kennen, dann hängt die Übergangswahrscheinlichkeit zum

Folgezustand j nur von i und j ab. Die Vergangenheit (Zustände zu Zeitpunkten < t) der Markov-Kette

spielen hierbei keine Rolle.

3.4.2 Was ist eine stationäre Verteilung?

P sei die Zustandsübergangsmatrix einer Markov-Kette. Einen Wahrscheinlichkeitsvektor π mit π = π · P

nennen wir stationäre Verteilung der Markovkette.

3.4.3 Gibt es für alle Markovketten eine stationäre Verteilung?

Für endliche, irreduzible, aperiodische Markovketten existiert der Grenzwert

lim qt =: π

t→∞

π

ist zugleich die eindeutige stationäre Verteilung der Kette, d.h. der einzige Vektor mit π = π · P und

i∈S πi = 1

DS-FAQ v1.0

28

3.4. Stochastische Prozesse

3.4.4 Was heißt aperiodisch?

Ein Zustand heißt aperiodisch, wenn er die Periode T = 1 hat. Eine Markovkette, in der alle Zustände

aperiodisch sind, heißt aperiodisch.

3.4.5 Erzählen sie etwas zum Gambler’s Ruin Problem.

Beim Gambler’s Ruin Problem spielen zwei Spieler A und B um eine gewissen Geldbetrag M , wobei A a

Geldeinheiten und B (M − a) Geldeinheiten zu Beginn des Spiels besitzt. Wenn man davon ausgeht, daß A

ein Spiel mit Wahrscheinlichkeit p und B mit 1 − p gewinnt, so kann man Berechnung darüber anstellen, ob

A B in den Ruin treiben (oder umgekehrt) wird und wie lang das voraussichtlich dauern wird.

3.4.6 Was versteht man unter einem Birth-Death-Prozeß?

Ein Birth-Death-Prozeß ist eine kontinuierliche Markovkette mit einem Übergangsdiagramm der folgenden

Form.

0

1

3

2

3.4.7 Wie berechnet man die stationäre Verteilung eines Birth-Death-Prozesses?

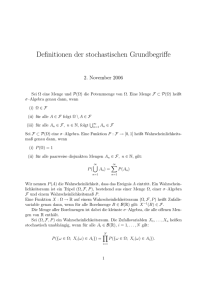

Zuerst muß man π0 berechnen: