1 Beispiel zum GMM ∑ ∑ ∑ ∑ ∑

Werbung

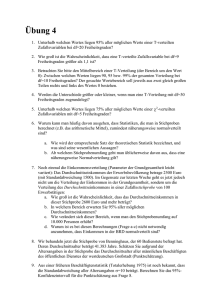

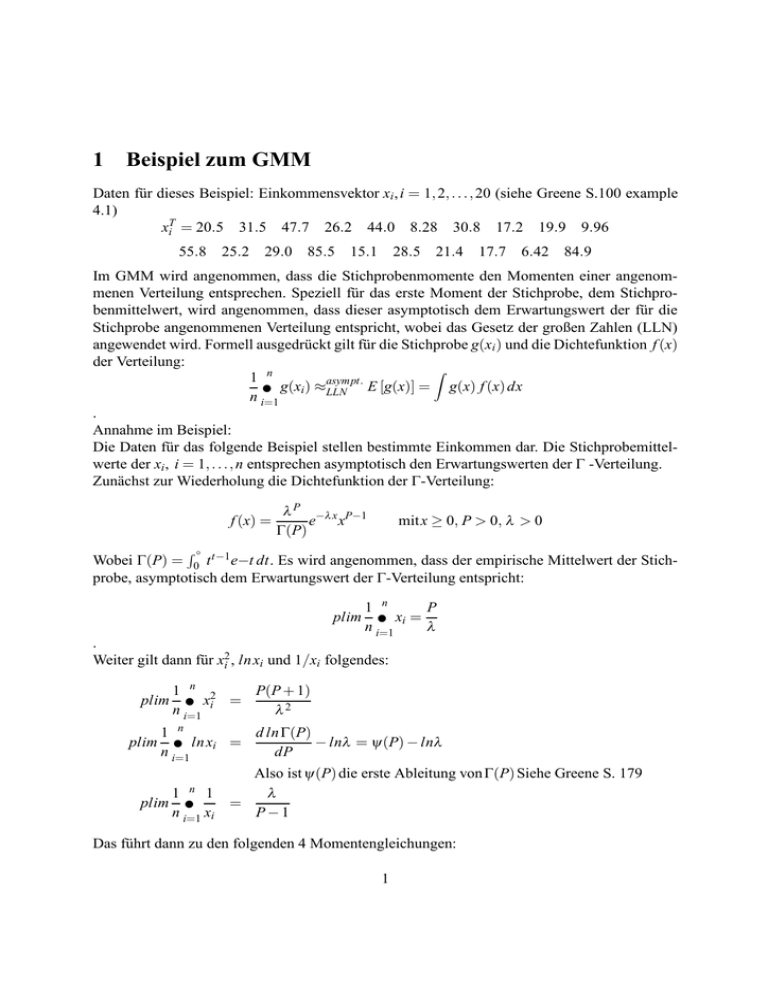

1 Beispiel zum GMM Daten für dieses Beispiel: Einkommensvektor xi , i = 1, 2, . . ., 20 (siehe Greene S.100 example 4.1) xTi = 20.5 31.5 47.7 26.2 44.0 8.28 30.8 17.2 19.9 9.96 55.8 25.2 29.0 85.5 15.1 28.5 21.4 17.7 6.42 84.9 Im GMM wird angenommen, dass die Stichprobenmomente den Momenten einer angenommenen Verteilung entsprechen. Speziell für das erste Moment der Stichprobe, dem Stichprobenmittelwert, wird angenommen, dass dieser asymptotisch dem Erwartungswert der für die Stichprobe angenommenen Verteilung entspricht, wobei das Gesetz der großen Zahlen (LLN) angewendet wird. Formell ausgedrückt gilt für die Stichprobe g(x i ) und die Dichtefunktion f (x) der Verteilung: Z 1 n asympt. E [g(x)] = g(x) f (x) dx g(x ) ≈ ∑ i LLN n i=1 . Annahme im Beispiel: Die Daten für das folgende Beispiel stellen bestimmte Einkommen dar. Die Stichprobemittelwerte der xi , i = 1, . . ., n entsprechen asymptotisch den Erwartungswerten der Γ -Verteilung. Zunächst zur Wiederholung die Dichtefunktion der Γ-Verteilung: f (x) = λ P −λ x P−1 e x Γ(P) mit x ≥ 0, P > 0, λ > 0 Wobei Γ(P) = 0∞ t t−1 e−t dt. Es wird angenommen, dass der empirische Mittelwert der Stichprobe, asymptotisch dem Erwartungswert der Γ-Verteilung entspricht: R plim 1 n P xi = ∑ n i=1 λ . Weiter gilt dann für x2i , ln xi und 1/xi folgendes: plim plim 1 n 2 P(P + 1) xi = ∑ n i=1 λ2 1 n d ln Γ(P) ln xi = − lnλ = ψ (P) − lnλ ∑ n i=1 dP n plim 1 1 ∑ n i=1 xi Also ist ψ (P) die erste Ableitung von Γ(P) Siehe Greene S. 179 λ = P−1 Das führt dann zu den folgenden 4 Momentengleichungen: 1 P E xi − λ P(P + 1) E (xi )2 − λ2 = m1 (P, λ ) = 0 = m2 (P, λ ) = 0 E [ln(xi ) − ψ (P) + lnλ ] = m3 (P, λ ) = 0 λ 1 E − = m4 (P, λ ) xi P − 1 = 0 Setzen x1 = x, x2 = x2 , x3 = ln x und x4 = 1/x. Außerdem setzt man µ1 (P, λ ) = λP , µ2 (P, λ ) = λ P−1 als Erwartungswerte der Γ-Verteilung. P(P+1) λ2 , µ3 (P, λ ) = ψ (P) + lnλ und µ4 (P, λ ) = Wobei dann der Mittelwert der ersten Momentengleichung nach folgender Formel berechnet wird: 1 n ∑ mi1(θ ) n i=1 1 n P = ∑ xi1 − λ n i=1 m̄1 (θ ) = 1 n ∑ [xi1 − µ1 (θ )] n i=1 = x̄1 − µ1 = . Dabei ist nun x̄1 der Mittelwert der Stichprobe und µ1 der entsprechende Erwartungswert der Γ-Verteilung. Analog gelten diese Gleichungen für m̄2 (θ ), m̄3 (θ ) und m̄4 (θ ). Fragestellung: Wie muss man die Parameter P und λ wählen, so dass die Mittelwerte der Stichprobe möglichst genau den entsprechenden Momenten der Verteilung entsprechen, also wie muss der Parametervektor θ gewählt werden ? In einem Problem, wo die Anzahl der zu schätzenden Parameter der Anzahl der Momentengleichungen entspricht, löst man einfach das Gleichungssystem, das sich aus den Momentengleichungen ergibt. In diesem Beispiel jedoch hat man ein sogenanntes overdetermined Problem: Die Anzahl der Momentengleichungen (4) ist größer als die Anzahl der 2 zu schätzenden Parameter (2). Also muss man die Abweichungen der tatsächlich beobachteten Stichprobe von der Γ-Verteilung minimieren. Für die Anfangsschätzung werden gewöhnliche kleinste Quadrate verwendet. Das führt zu folgendem Optimierungsproblem: 4 ∑ m̄l (θ ) l=1 2 = " n P ∑ x1i − λ i=1 #2 " n P(P + 1) + ∑ x2i − λ2 i=1 #2 + " n ∑ x3i − Ψ(P) + lnλ i=1 2 #2 " λ + ∑ x1i − P−1 i=1 n = [x̄1 − µ1 (θ )]2 + [x̄2 − µ2 (θ )]2 + [x̄3 − µ3 (θ )] + [x̄4 − µ4 (θ )]2 = m̄(θ )T m̄(θ ) −→ minθ . Wobei diese zu minimierende Funktion als Kriteriumfunktion q bezeichnet wird, was zu folgender Notation führt: 4 ∑ [x̄l − µl (θ )]2 q = l=1 = m̄(θ )T m̄(θ ) −→ minθ Der Schätzer θ̂ für die Lösung dieses Minimierungsproblems wird als Schätzer mit kleinster Distanz bezeichnet, weil hier die Varianz minimiert wird, wobei die Gewichtungsmatrix die Einheitsmatrix ist. Diese nichtlineare Problem muss iterativ gelöst werden. Eine Vereinfachung dieses Problems erhält man durch die Umskalierung der Momentengleichungen. Dazu werden die Gleichungen mit der Diagonalmatrix λ 0 0 0 0 λ2 0 0 J= 0 0 1 0 0 0 0 (P − 1) Also mit J = diag λ , λ 2 , 1, (P − 1) multipliziert. Die vier Momentengleichungen für die Schätzung sind dann folgende: λ x̄1 − P λ x̄2 − P(P + 1) ln x̄3 − ψ (P) + lnλ (P − 1)x̄4 − λ 2 = = = = 0 0 0 0 Das ist äquivalent zur Minimierung von: q = m̄(θ )T J T J m̄(θ ) = m̄∗ (θ )T m̄∗ (θ ) 3 #2 . Dabei ist die Gewichtungsmatrix hier immernoch die Einheitsmatrix I. Als Startwerte für die Schätzung werden die Maximum-Likelihood-Schätzwerte verwendet (siehe Greene S. 144 example 4.26) : P̂ML = 2.106 und λ̂ML = 0.07707008 . Diese Werte werden nun verwendet, um die Gewichtungsmatrix W zu schätzen. Eine GMMSchätzung benötigt so eine first-step-Schätzung, um einen konsistenten (wenn schon nicht effizienten) Schätzer für θ zu erhalten, der dann verwendet wird, um die Gewichtungsmatrix W zu erhalten. Wenn man keine Schätzwerte zur Verfügung hat, verwendet man eine grid search oder andere Methoden. Mit den gegebenen Schätzungen, berechnet man die Momente und J und erhält dann Ŵ , das sich durch folgende Formel bestimmen lässt: ˆ m̄(θ̂ )] Ŵ = Var[ 1 1 n = mi (θ̂ ) mi (θ̂ )T ∑ n n − 1 i=1 . Eine Gewichtungsmatrix einzuführen hat den Sinn, dass sich dadurch die asymptotische Varianz minimiert wird und man damit einen effizienteren Parameterschätzer erhält. Dabei sind die Inverse der Gewichte proportional Varianz der Momente ist. Wenn eine andere Matrix als die Gewichtungsmatrix Ŵ verwendet wird, erhält man konsistentes aber ineffizientes Ergebnis. Daraus ergibt sich dann folgende Kriteriumfunktion: q = m̄(θ )T Ŵ −1 m̄(θ ) −→ minθ . Also ergibt sich die Gewichtungsmatrix bei einer Stichprobe von n = 20 im Beispiel durch: T ˆ ˆ xi1 − Pˆ xi1 − Pˆ λ λ ˆ P+1) ˆ ˆP+1) ˆ P( P( 20 1 1 x − x − i2 i2 λˆ2 λˆ2 Ŵ = ∑ 20 19 i=1 x − ψ ( P̂) + ln λ̂ x − ψ ( P̂) + ln λ̂ i3 i3 λˆ λˆ xi4 − P−1 xi4 − P−1 ˆ ˆ Den GMM-Schätzer erhält man wegen der vorgenommenen Umskalierung mit J dann durch die Minimierung von: −1 q = m̄(θ )T J T JŴ J T J m̄(θ ) −→ minθ . Die zwei Schätzungen sind dann: P̂GMM = 2.5675 und 4 λ̂GMM = 0.071193 . Mit diesen zwei Werten ist der Wert von q = 2.2222. Die asymptotische Kovarianzmatrix der GMM wird allgemein folgendermaßen berechnet: −1 VGMM = GT W −1 G . Dabei ist G die Ableitungsmatrix, wobei sich die j-te Zeile folgendermaßen darstellt: Gj = ∂ m̄ j (θ ) ∂θT . Also sind in der j-ten Zeile alle partiellen Ableitungen der j-ten Momentenbedingung enthalten. Damit ergibt sich die transponierte Matrix von G in diesem Beispiel durch: " # GT = Ĝ T = " = ∂ m1 ∂ m2 ∂ m3 ∂ m4 ∂P ∂P ∂P ∂P ∂ m1 ∂ m2 ∂ m3 ∂ m4 ∂λ ∂λ ∂λ ∂λ 0 −1 −(2P+1) −Ψ (P) 2 λ λ 2P(P+1) P 1 λ λ2 λ3 λ (P−1)2 −1 (P−1) # −14.046 −1210.4 −0.47490 0.028974 506.567 50768.6 14.046 −0.63794 . Durch die Umskalierung mit J erhält man folgende asymptotische Kovarianzmatrix: V = h T −1 T T i−1 Ĝ J J Ŵ J J Ĝ 0.32848 0.0086099 = 0.0086099 0.0015788 . Ist ein Schätzer effizient, so ist seine asymptotische Kovarianzmatrix minimal. Die asymptotische Kovarianzmatrix wird für statistische Tests benötigt, wie zum Beispiel dem Wald-Test, der asymptotisch äquivalent zum Lagrange-Multiplier Test ist. Außerdem wird sie für die Verteilungsannahme des GMM-Schätzers benötigt: Asymptotische Verteilung des GMM-Schätzers Wenn θ̂GMM der GMM-Schätzer ist folgt(siehe Greene S.479 Theorem 11.7: θ̂GMM ∼a N(θ ,VGMM ) . Das waren Anwendungen, wo die asymptotische Kovarianzmatrix gebraucht wird. 5