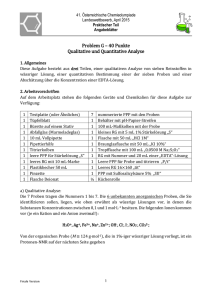

4. Wahrscheinlichkeitsrechnung 4.1. Ereignisse und

Werbung

4. Wahrscheinlichkeitsrechnung

4.1. Ereignisse und Wahrscheinlichkeiten

• Zufälliger Versuch:

Vorgang, der (zumindest gedanklich) beliebig oft wiederholbar ist und dessen Ausgang innerhalb einer Menge

möglicher Ausgänge ungewiss (zufällig) ist.

Ω ...

Menge der möglichen (elementaren, einander

ausschließenden) Versuchsausgänge ω ∈ Ω

A . . . Ereignisfeld, enthält Teilmengen von Ω,

die Ereignisse A ∈ A

• Ein Ereignis A tritt ein, wenn der Versuchsausgang ω, den

der Versuch liefert, ein Element der Menge A ist, d.h. wenn

ω ∈ A.

'

$

'

v

$

Ω

A

ω

&

%

&

%

1

• Beispiele

1) Würfeln mit idealem Würfel

Ω = {1, 2, 3, 4, 5, 6}

A = {2, 4, 6} . . .

Ereignis, dass eine gerade Zahl

gewürfelt wird

B = {3, 4, 5, 6} . . . Ereignis, dass Zahl > 2 gewürfelt

wird

C = {6} . . .

Ereignis, dass ”6” gewürfelt wird

A ∩ B = {4, 6} . . . ” A und B ”, Ereignis, dass eine

gerade Zahl gewürfelt wird, die

größer als 2 ist

2) Würfeln mit 2 unterscheidbaren Würfeln

Ω = { (1, 1), (1, 2), . . . , (1, 6), (2, 1), . . . , (6, 6) }

ω = ( Ergebnis Würfel 1, Ergebnis Würfel 2 ) ∈ Ω

2

3) Auswahl einer Versuchsperson, die Antwort auf eine

Frage auf einer Ratingskala (10 cm lang) markiert :

+————————X——————————————+

0

10

z.B.: sehr unsympathisch —————– sehr sympathisch

Ω = [ 0, 10 ]

(überabzählbar viele mögliche Antworten !)

4) Zahlenlotto 6 aus 49

Ω = Menge der möglichen Tipps

(Auswahl von 6 aus 49 Zahlen)

µ ¶

49

also

= 13 983 816 verschiedene Tippscheine möglich.

6

5) Auswahl von 100 Personen aus einer bestimmten

Population

Ω = {(ω1, ω2, . . . , ω100), ωi ist ein Bürger aus der Population}

3

”Rechnen mit Ereignissen’’

A ∩ B ist ein Ereignis. Es tritt ein, wenn A und B gleich'

$

zeitig eintreten.

'

$

p pp pp pp pp pp pp pp

pp ppp ppp ppp ppp ppp ppp ppp ppp ppp

ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp

pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp p

pp pp pp pp pp pp pp pp p

&p p p p p p p %

A

B

&

%

A∪B ist das Ereignis, das eintritt, wenn A oder B eintritt

'

pppppppppppp $

(oder beide zugleich).

p pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

p pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp'

pppppppppp

pp pp pp pp pp pp pp pp pp pp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp pp p $

ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp pp

pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

p pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

p pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

p p p p p p p pp pp pp pp pp pp pp pp pp pp%

pppppppppp

&

pp pp pp pp pp pp pp pp pp pp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp

p pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

p pp pp pp pp pp pp pp pp pp pp pp pp pp pp p

pppppppppppp %

&

A

B

A \ B ist das Ereignis, das eintritt, wenn A eintritt aber

'

pppppppppppp $

p pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

B nicht.

pp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp p

pp pp pp pp pp pp pp pp pp pp'

pppppppppp

$

pp pp pp pp pp pp pp pp pp pp ppp ppp pp p p p p p p p

pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp A

pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp

p pp pp pp pp pp pp pp pp pp

p pp pp pp pp pp pp pp pp

ppppppp

&

B

%

&

%

Ā ist das Ereignis, das eintritt, wenn A nicht eintritt, Ā

ist das komplementäre Ereignis zu A.

'

p p pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp p $

pp ppp ppp ppp '

p p p p p p p p p p p p p p p p p p p p pp pp pp pp pp pp pp pp pp pp pp pp pp p

pppppppppppppp

p p p p p pp pp pp p p p p p p p p p p p p p p p pp ppp $

p ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp

pp ppp ppp ppp ppp ppp ppp p

pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp

ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp

ppp ppp ppp ppp ppp ppp ppp

pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp

pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp pp pp

pppppppppppppp

pp pp pp pp pp pp pp

pp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp

pp pp pp pp pp pp pp

p pp pp pp pp pp pp pp pp pp pp pp pp pp pp

p pp pp pp pp pp pp p

p

p

p p pp pp pp pp pp pp pp pp pp pp pp pp pp pp

pp pp pp pp pp &

ppp

p pp pp pp ppp ppp ppp ppp pp pp pp pp pp pp pp pp pp pp pp pp pp ppp ppp ppp %

pppppppppppppp

p p p p p p p p p p p p p p p p p p p p p p pp pp pp pp pp pp pp pp pp pp pp p p %

&

Ω

A

Ā

Spezielle Ereignisse:

∅ . . . unmögliches Ereignis (leere Menge)

Ω . . . sicheres Ereignis (Ω ⊂ Ω)

4

Beziehungen zwischen Ereignissen

A ⊂ B . . . A zieht B nach sich

'

'

$

$

Ω

'

$

B

A

&

%

&

&

%

%

Ist A eingetreten, d.h. der Versuchsausgang ist ein ω ∈ A,

so gilt ω ∈ B, d.h. B ist ebenfalls eingetreten.

Gilt A ∩ B = ∅, so heißen A und B unvereinbar, sie

können niemals gemeinsam eintreten.

'

$

'

A

&

Ω

$

'$

%

B

&%

%

&

Das Ereignisfeld A wird nun aus genügend vielen

Ereignissen gebildet, so dass alle obigen Operationen

zwischen diesen Ereignissen ausführbar sind und außerdem

Ω ∈ A gilt.

(Enthält Ω unendlich viele Elemente (vgl. Bsp. 3) so müssen

auch Grenzwerte von Operationen der Form A1 ∪ A2 ∪ . . . in

A sein. A ist dann σ-Algebra.).

Den Operationen zwischen Ereignissen entsprechen Operationen zwischen Mengen (Durchschnitt, Vereinigung, . . . ).

5

Wahrscheinlichkeiten

Vorbetrachtung:

n-malige Durchführung eines zufälligen Versuches und zählen,

wie häufig ein uns interessierendes Ereignis A eingetreten ist:

• absolute Häufigkeit:

Hn(A)

• relative Häufigkeit:

hn(A) =

1

Hn(A)

n

Erfahrung: Für große n stabilisieren sich die relativen Häufigkeiten

6

Eigenschaften der relativen Häufigkeit:

h1)

h2)

0 ≤ hn(A) ≤ 1

Ω tritt immer ein: Hn(Ω) = n, ∅ tritt nie ein:

hn(Ω) = 1,

h3)

hn(∅) = 0 .

Gilt A ∩ B = ∅, (A und B disjunkt ) dann treten

A und B niemals gleichzeitig ein, und es gilt

Hn(A ∪ B) = Hn(A) + Hn(B),

(∗)

und somit:

hn(A ∪ B) = hn(A) + hn(B),

h4)

A ∩ B = ∅.

Gilt A ∩ B 6= ∅, dann wird auf der rechten Seite in (∗)

doppelt gezählt, falls A ∩ B eintritt. Also gilt

Hn(A ∪ B) = Hn(A) + Hn(B) − Hn(A ∩ B),

und somit:

hn(A ∪ B) = hn(A) + hn(B) − hn(A ∩ B).

Beispiel Würfel:

A = {1, 2} , B = {2, 3} , A ∪ B = {1, 2, 3}

hn({1 , 2 , 3} = hn({1, 2}) + hn({2, 3}) − hn({2}).

7

Wahrscheinlichkeiten können als Modell verstanden werden für

die Grenzwerte der relativen Häufigkeiten (n → ∞), bzw.

für die Gesetzmäßigkeiten, die dahinterstecken oder dahinter

vermutet werden.

P (A),

A ⊂ Ω (A ∈ A)

Wahrscheinlichkeit des Ereignisses A,

definiert in Analogie zu den Eigenschaften der hn durch ein

Axiomsystem (Kolmogorov, 1933)

A1

0 ≤ P (A) ≤ 1 für alle A ∈ A

A2

P (Ω) = 1,

A3

A ∩ B = ∅ ⇒ P (A ∪ B) = P (A) + P (B)

P (∅) = 0

(Additivität)

Genauer muss man verlangen:

A3’

Für A1, A2, A3, . . . mit Aj ∈ A, j ∈ N, und

Ai ∩ Aj = ∅, i, j ∈ N, i 6= j, gilt

P (A1 ∪ A2 ∪ A3 ∪ . . .) =

∞

X

P (Ai)

i=1

(σ-Additivität)

↑

Grenzwert von

n

X

i=1

8

für n → ∞

Daraus folgen, wie für hn, weitere wichtige Formeln:

P (Ā) = 1 − P (A)

denn: A ∩ Ā = ∅ und A ∪ Ā = Ω,

A3

A2

P (A) + P (Ā) =

P (A ∪ Ā) = P (Ω) =

1.

P (A ∪ B) = P (A) + P (B) − P (A ∩ B)

denn: A ∪ B lässt sich disjunkt zerlegen in A \ B, A ∩ B und

B \ A.

'

$

$

'

A\B

A∩B

&

B\A

%

&

%

Also ist

P (A ∪ B) =

=

P (A \ B) + P (B \ A) + P (A ∩ B)

(P (A) − P (A ∩ B))

+ (P (B) − P (A ∩ B))

+ P (A ∩ B)

Anschaulich:

Ω = Teig der Masse 1 (kg) (ungleichmäßig) ausgerollt.

Ein Plätzchen: A = Ereignis hat die Masse P (A).

9

P (A \ B) = P (A) − P (A ∩ B) = P (A ∩ B̄)

” A und nicht B ”

Beispiel:

Gegeben:

P (A)

= 0.7

P (B)

= 0.4

P (A ∩ B) = 0.15

Dann gilt: P (A ∩ B̄) = 0.7 - 0.15 = 0.55

P (Ā ∩ B) = 0.4 - 0.15 = 0.25

P (A ∪ B) = 0.7 + 0.4 - 0.15 = 0.95

Darstellung in ”Vierfeldertafel”:

B

A 0.15

Ā 0.25

0.4

B̄

0.55 0.7

0.05 0.3

0.6 1

Das Tripel ( Ω, A, P ) heißt Wahrscheinlichkeitsraum.

10

Die klassische Wahrscheinlichkeit

Modell für z.B. Würfeln, Münzwurf, Roulette, Ziehung von

Lottozahlen;

Ausgangspunkt: Man erkennt keinen Grund, einem der

möglichen Versuchsausgänge eine größere Wahrscheinlichkeit

zuzuordnen als einem anderen.

Also:

Ω = {ω1, ω2, . . . , ωn}

Ereignisse {ωi} gleichwahrscheinlich, daraus folgt:

1

P ({ωi}) =

n

denn:

Sei P ({ω1}) = P ({ω2}) = . . . = P ({ωn}) = p .

Dann ist

1 = P (Ω) = P ({ω1}) + P ({ω2}) + . . . + P ({ωn}) = np .

In gleicher Weise erhält man für jedes Ereignis A ∈ A:

X 1

X

P (A) =

P ({ωi}) =

n

i: ωi ∈A

i: ωi ∈A

Also:

P (A) =

=

Anzahl der ωi in A

n

”Anzahl der für A günstigen Fälle”

Anzahl aller möglichen Fälle

Zur Bestimmung dieser Anzahlen sind häufig die Formeln der

Kombinatorik hilfreich.

11

Bedingte Wahrscheinlichkeiten

Beispiel. Spiel: Urne mit 50 Kugeln, leichte und schwere, weiße

und rote, wobei das Ziehen einer roten Kugel einen Gewinn

verspricht, das Ziehen einer weißen nicht.

weiß rot

Verteilung (Vierfeldertafel):

10 g

5

20 25

50 g

20

5

25

25 50

25

Versuch: Ziehen einer Kugel

A . . . ”Die gezogene Kugel ist rot” = ”Gewinn”

B . . . ”Die gezogene Kugel ist schwer”

Klassische Wkt.: P (A) =

25

= 0.5 = 50%.

50

Die Gewinnchance beträgt 50%.

Zusatzinformation: Beim Herausnehmen kann der Spieler

- noch bevor er die Farbe erkennt - zweifelsfrei feststellen, dass

es eine schwere Kugel ist.

5

Er erwartet jetzt nur noch mit PB (A) =

= 0.2 = 20%

25

einen Gewinn.

Die Information ”B ist eingetreten” hat die Bewertung der

Chancen für das Eintreten von A geändert.

12

Sei (Ω, A, P ) ein Wahrscheinlichkeitsraum. Für jedes B ∈ A

mit P (B) > 0 heißt

P (A ∩ B)

PB (A) = P (A | B) =

P (B)

Bedingte Wahrscheinlichkeit von A unter der Bedingung B

Folgerungen:

• Für jedes B ∈ A mit P (B) > 0 werden durch

PB = P ( . | B) Wahrscheinlichkeiten auf A

definiert.

• Diese Wahrscheinlichkeiten sind ”auf B konzentriert”:

P (B | B) = 1.

•

P (A | Ω) = P (A)

• Sei min{ P (A), P (B) } > 0. Dann gilt

P (A | B) · P (B) = P (B | A) · P (A) .

Die bedingte Wahrscheinlichkeit eines jeden Ereignisses ergibt

sich ”aus seinem Anteil an B”.

Formeln für Wkt.en gelten bei fester Bedingung analog.

Bsp.:

P (A ∪ B | C) = P (A | C) + P (B | C) − P (A ∩ B | C)

P (A | B) + P (Ā | B) = 1

13

Mitunter ist bedingte Wkt. P (A | B)

ermitteln als P (A ∩ B). Man benutzt dann:

leichter

P (A ∩ B) = P (A | B) · P (B)

”Multiplikationssatz”

Bsp.: Wiederholtes Ziehen ohne Zurücklegen:

Urne; 10 grüne und 15 gelbe Kugeln

A ... 2. Ziehung gelbe Kugel

B ... 1. Ziehung gelbe Kugel

leicht:

P (B) =

15

3

14

7

= , P (A | B) =

=

25

5

24

12

Es folgt:

P (A ∩ B) = P (A | B) · P (B) =

14

21

7

3 7

·

=

=

5 12

60 20

zu

Unabhängigkeit

Wir vergleichen P (A) mit P (A | B):

Gilt P (A) = P (A | B), dann hat die Information, dass B

eingetreten ist, keinen Einfluss auf die Bewertung der Chance,

dass auch A eingetreten ist.

Definition: Die Ereignisse A und B heißen unabhängig, wenn

gilt:

P (A ∩ B) = P (A) · P (B).

Anderenfalls heißen die Ereignisse abhängig.

Wegen

P (A | B) =

P (A ∩ B)

P (B)

ist Unabhängigkeit dann (falls P (B) 6= 0) gleichbedeutend

mit:

P (A | B) =

P (A ∩ B)

P (A) · P (B)

=

= P (A)

P (B)

P (B)

15

• Definition harmoniert meistens mit der üblichen

Vorstellung von Unabhängigkeit;

Gefahr bei Kopplung über ”dritte”:

– Anzahl der beobachteten Störche am Tag x

– Anzahl der Geburten am Tag x

gekoppelt über saisonale Schwankungen

• Unterscheiden zwischen

– der oben definierten paarweisen Unabhängigkeit von

jeweils zwei Ereignissen und

– der vollständigen Unabhängigkeit von mehr als zwei

Ereignissen

Beispiel: Würfeln mit zwei Würfeln:

A . . . erster Würfel: gerade Zahl

B . . . zweiter Würfel: gerade Zahl

C . . . Summe der Augenzahlen ungerade

P (A) = P (B) = P (C) = 1/2

P (A ∩ B) = P (A ∩ C) = P (B ∩ C) = 1/4

⇒ paarweise unabhängig, aber

P (A ∩ B ∩ C) = 0

16

4.2

Zufallsvariable

4.2.1

Einführung

Eine Zufallsvariable X ordnet jedem elementaren Versuchsausgang ω ∈ Ω eine reelle Zahl X(ω) zu, d.h. X ist eine Funktion

X : Ω→R

Ω 3 ω → X(ω) ∈ R

Bezeichnung:

Zufallsvariable mit Großbuchstaben (X, Y, Z, X1, X2, X3, . . .),

Funktionswert = Wert für konkreten Versuchsausgang ω mit

kleinen Buchstaben X(ω) = x

In der Literatur wird auch der Begriff Zufallsgröße statt

Zufallsvariable verwendet.

Beispiel: Würfeln mit zwei Würfeln

X . . . Summe der Augenzahlen

z.B.

Y ...

X((3, 4)) = 7

Maximum der Augenzahlen

z.B.

Y ((3, 4)) = 4

Beispiel: Auswahl von 100 Personen

X1(ω) = Alter der Person ω1 ,

X2(ω) = Alter der Person ω2 , . . .

n

1 X

Xi(ω) = Durchschnittsalter in der Stichprobe

X̄(ω) =

n i=1

Zufall nicht in der Funktion X, sondern im zufälligen Versuch

mit Ausgang ω !

17

Es interessieren z.B. die folgenden Ereignisse

{ X < x } = { ω : X(ω) < x } ⊂ Ω,

{ X = x },

{ X > x },

usw.

Die Wahrscheinlichkeit P , definiert für Teilmengen aus Ω,

bestimmt die Wahrscheinlichkeiten für die Zufallsvariable X.

Beispiel: Würfeln mit zwei Würfeln

P (X = 7) = P ({ω : X(ω) = 7})

= P ({(1, 6), (2, 5), (3, 4), (4, 3), (5, 2), (6, 1)})

=

6

1

=

36

6

Beispiel: Auswahl von 100 Personen

P ( X1 < 40 ) = Anteil der Unter-40-jährigen in der Population

Problem: Welche Werte x kann die Zufallsvariable X mit

welcher Wahrscheinlichkeit annehmen?

18

4.2.2 Diskrete Zufallsvariable

Eine Zufallsvariable, die nur endlich viele (x1, . . . , xn) oder

abzählbar unendlich viele (x1, x2, . . .) Werte annehmen kann,

heißt diskrete Zufallsvariable.

Beispiel: idealer Würfel

X(ω) = Augenzahl

mögliche Werte xi: (1, 2, 3, 4, 5, 6)

P (X = xi) =

1

6

Verteilungstabelle

xi x1 x2 . . .

pi p1 p2 . . .

allgemein:

pi = P (X = xi)

Beispiel:

X . . . Summe der Augenzahlen bei zwei Würfeln

(Werte zwischen 2 und 12)

xi

2

3

4

5

6

7

8

9

10 11 12

pi

1 2 3 4 5 6 5 4 3 2 1

36 36 36 36 36 36 36 36 36 36 36

(! Probe: Summe der Wahrscheinlichkeiten = 1 ?)

Die Verteilungstabelle beschreibt die Zufallsvariable vollständig.

Aus ihr lassen sich die Wkt.en aller interessierenden Ereignisse

für die Zufallsvariable berechnen!

19

Beispiel:

µ

¶

P (6 ≤ X ≤ 8) = P {X = 6} ∪ {X = 7} ∪ {X = 8}

= P (X = 6) + P (X = 7) + P (X = 8)

5

6

5

16

4

=

+

+

=

=

36

36

36

36

9

Grafische Darstellung

Balkendiagramme

diskreter

Verteilungen

durch

Erwartungswert einer diskreten Zufallsvariablen

n

X

E(X) =

x i pi

bzw.

i=1

∞

X

E(X) =

xi pi

falls Grenzwert existiert

i=1

Beispiel: Würfel

1

1

1

· 1 + · 2 + · · · + · 6 = 3, 5

6

6

6

Schwerpunkt der Verteilung,

vgl. arithmetisches Mittel in deskriptiver Statistik:

Werte xi mit Häufigkeiten ni, n = n1 + n2 + . . . + nk

k

n1x1 + n2x2 + . . . + nk xk

1 X

ni x i

x̄ =

=

n

n i=1

=

k

X

i=1

20

hn({X = xi}) · xi

Streuung (Varianz) D2X, var (X)

var (X) =

n

X

(xi − E(X))2 · pi

i=1

bzw.

var (X) =

∞

X

(xi − E(X))2 · pi ,

falls GW existiert

i=1

Es gilt:

2

2

2

var (X) = E(X−E(X)) = E(X )−(E(X)) =

X

X

x2i pi−(

xipi)2

! vgl. empirische Varianz

Beispiel: Würfel

1

1

(1 − 3, 5)2 + · · · + (6 − 3, 5)2

6

6

1

1

1

1

1

1

= 1 · + 22 · + 32 · + 42 · + 52 · + 62 · − 3, 52

6

6

6

6

6

6

1

= (1 + 4 + 9 + 16 + 25 + 36) − 3, 52

6

1

= · 91 − 3, 52 = 15, 166̄ − 12, 25 = 2, 9166̄

6

var (X) =

Rechenregeln für Erwartungswert und Streuung

E(a · X + b) = a E(X) + b ,

var (a · X + b) = a2 var (X)

21

(a, b ∈ R, X, Y Zufallsvariable )

4.2.3

Wichtige diskrete Verteilungen

Die Binomialverteilung

Modell:

Bernoulli-Schema

Ein Versuch wird unter konstanten Bedingungen n-mal

unabhängig wiederholt. Registriert wird jeweils nur das

Eintreten eines interessierenden Ereignisses A

(Erfolg oder Misserfolg).

X . . . Anzahl der Erfolge (in den n Versuchen)

Beispiel:

1. n-maliger Wurf derselben Münze,

X . . . Anzahl der Wappen

2. n-maliges Würfeln,

X . . . Anzahl der ”6”

3. Entnahme einer Kugel aus ”Urne” mit Zurücklegen (und

Mischen),

X . . . Anzahl der ”roten Kugeln”

p . . . Erfolgswahrscheinlichkeit in jedem Einzelversuch

Beispiel (oben):

1. p =

2. p =

3. p =

1

2

1

6

Anzahl roter Kugeln

Anzahl aller Kugeln

22

X kann die Werte 0,1, . . . , n annehmen

X = 0: nur Misserfolge

P (X = 0) = (1 − p)n

X = 1: genau ein Erfolg (entweder beim 1. oder 2. oder . . . )

P (X = 1) =

n

↑

n Möglichkeiten

· p · (1 − p)n−1

↑

↑

1 Erfolg

n−1 Misserfolge

wann Erfolg

allgemein:

µ ¶

n

P (X = k) =

pk (1 − p)n−k ,

k

k = 0, 1, . . . , n.

↑ vgl. Kombinatorik

X heißt dann

binomialverteilt mit Parametern n und p,

Es gilt:

E(X) = n · p

var (X) = n · p · (1 − p).

23

X ∼ B(n; p)

Beispiel:

1. 10-mal Würfeln mit unverfälschtem Würfel,

1

)

6

Wahrscheinlichkeit, dass genau drei Sechsen dabei sind:

µ ¶ µ ¶3 µ ¶7

10

1

5

P (X = 3) =

·

·

= 0, 155

3

6

6

X . . . Anzahl von ”6”, X ∼ B(10,

2. Die absolute Häufigkeit Hn(A) eines Ereignisses A mit

P (A) = p in n unabhängigen Durchführungen eines

zufälligen Versuches ist B(n; p) -verteilt mit

E(Hn(A)) = np,

var (Hn(A)) = np (1 − p).

Für die relativen Häufigkeiten hn(A) folgt dann

µ

¶

1

1

E(hn(A)) = E

Hn(A) = np = p

n

n

µ

¶

1

1

var (hn(A)) = var

Hn(A) = 2 np (1 − p)

n

n

=

1

p (1 − p).

n

”Die mittlere quadratische Abweichung zwischen hn(A)

und P (A) wird für große n immer kleiner.”

24

Die hypergeometrische Verteilung (info)

Modell:

Entnahme von M Kugeln aus einer Urne mit N Kugeln - davon

sind r rot und (N − r) blau - ohne Zurücklegen

(nicht binomialverteilt!).

X . . . Anzahl der gezogenen roten Kugeln

X kann die Werte 0, 1, . . . , min{r, M } annehmen.

µ ¶µ

¶

r

N −r

m

M −m

µ ¶

, m = 0, 1, . . . , M,

P (X = m) =

N

M

µ ¶

l

falls wir vereinbaren, dass

= 0 gilt, falls L ≤ 0 oder

L

L > l ist.

Plausibel: Falls M klein ist gegenüber N , dann ist der Unterschied zwischen dem Versuch mit und dem ohne Zurücklegen

gering.

Tatsächlich sind dann die Einzelwahrscheinlichkeiten von

Binomial– und hypergeometrischer Verteilung fast gleich.

Wichtig bei Umfragen!

25

Die gleichmäßige diskrete Verteilung

Definition: Eine Zufallsvariable mit der Verteilungstabelle

xk

x1

x2

. . . xn

pk 1/n 1/n . . . 1/n

heißt gleichmäßig diskret verteilt.

Hinweis: Entspricht der klass.Wkt; ideale Münze; idealer Würfel;

Roulette, Lotterie; Urnenschemata; ...

Kenngrößen:

1

1

1

+ x2 · + . . . + xn ·

= x̄

n

n

n

1

1

var (X) = (x1 − x̄)2 · + (x2 − x̄)2 ·

n

n

1

+ . . . + (xn − x̄)2 ·

n

n

1 X

=

(xk − x̄)2

n

E(X) = x1 ·

k=1

26

4.2.4

Stetige Zufallsvariable

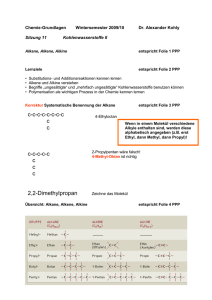

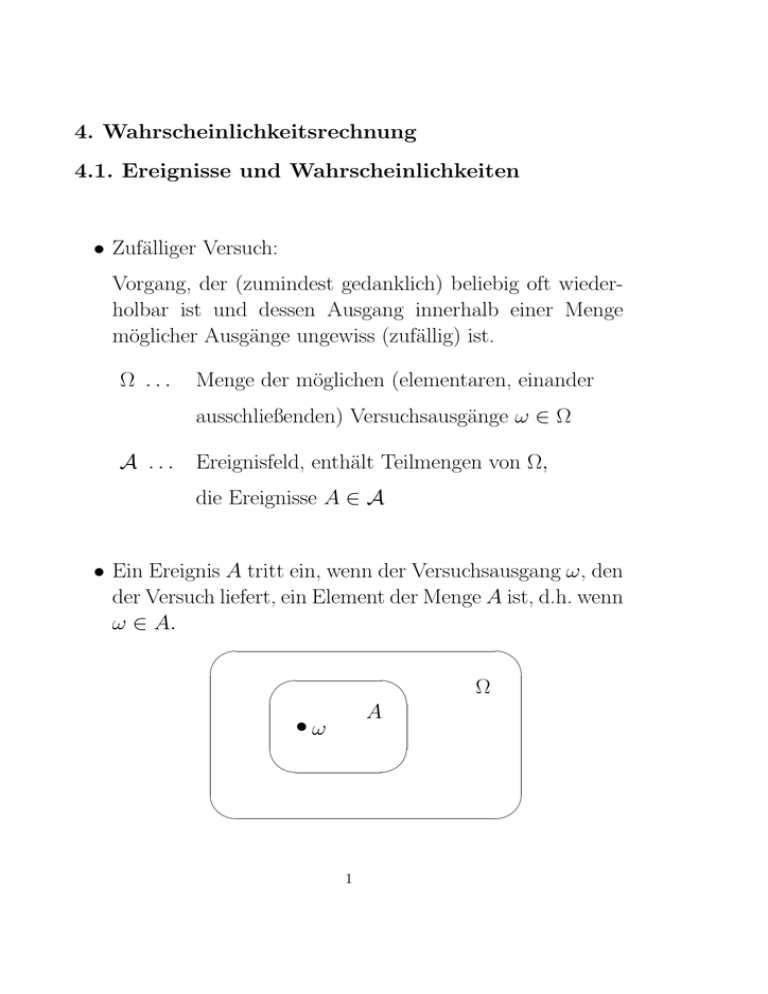

Beispiel. Abfüllung von 500–Gramm–Packungen einer

bestimmten Ware auf einer automatischen Abfüllanlage.

Die Zufallsvariable X beschreibe die Füllmenge einer zufällig

ausgewählten Packung in g.

X kann jeden Wert (in der Nähe von 500 g) annehmen.

Bei beliebig genauer Messung wird i.a. jeder konkrete Wert nur

mit Wkt. Null auftreten:

P (X = 500) = 0 ,

aber P (495 < X < 505) wird i.a. positiv sein, und diese

Wahrscheinlichkeit beschreibt den Anteil der Packungen mit

einer Füllmenge zwischen 495 g und 505 g unter allen

abgefüllten Packungen.

Nun: Betrachtung von ’immer feineren’ Histogrammen für eine

Stichprobe mit sehr vielen kontrollierten Packungen

siehe nächste Seite

Bei beliebiger Verfeinerung (und immer größeren Stichprobenumfängen) wird eine Funktion erkennbar.

Die Verteilungsdichte fX modelliert das Histogramm der

relativen Häufigkeiten der Füllmengen aller abgefüllten

Pakete, beziehungsweise das ’Abfüllverhalten’ der Maschine,

wenn diese Werte in immer feinere Intervalle einsortiert

werden.

In jedem Teilintervall entspricht die Fläche unter fX der Wkt.,

dass die ZV Werte in diesem Intervall annimmt.

27

4000

2000

Anzahl

Anzahl

3000

2000

1500

1000

1000

500

0

490,00

500,00

490,00

510,00

500,00

510,00

Füllmenge

Füllmenge

750

1250

1000

Anzahl

Anzahl

500

750

500

250

250

0

490,00

500,00

510,00

490,00

Füllmenge

500,00

Füllmenge

600

500

400

300

200

100

Mean = 500,0029

Std. Dev. = 3,96016

N = 10.000

0

485,00

490,00

495,00

500,00

505,00

Füllmenge

510,00

515,00

510,00

Definition: Eine Zufallsvariable, deren Werte alle reellen Zahlen

in einem bestimmten (endlichen oder unendlichen) Intervall

annehmen können, und für die eine Funktion fX ≥ 0 existiert,

so dass

Z

b

P (a < X < b) =

fX (x)dx

a

gilt, heißt stetige Zufallsvariable.

Die Funktion fX heißt Dichtefunktion der ZV X.

pqqpqqpqqqpqqpqqqpqqpqqqpqqpqqqp

pqqppqqppqp qqppp ppp ppp ppp ppp ppp ppp ppp ppp pppqqpppqqqppqqqp qqpq

q

q

p

p

q

q

q

qqp p p p p p p p p p p p p p p p p p p qpqq

qqpppqqpppqp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp pppp qppppqqqppp qqppqqqp

q

X

q

q

q p p p p p p p p p p p p p p p p p p p p p p p p p pq

qqqqq ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp ppp qqqqqqqqq

q

q

q

pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp qqqqq

qqqqq

qqqqqq

pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

qqqqqq

qqqqqqq

pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

q

q

q

q

q

q

q

qqqqqqqq

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

q

q

pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp pp

qqqqq

qqqqqqqqqqqqq

q

q

q

q

q

q

q

q

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

p

q

q

q

qqqqqq

pppppppppppppppppppppppppp

qqqqqqqq

f

a

b

>

Verteilungsfunktion FX der Zufallsvariablen X

Z x

FX (x) = P (X ≤ x) =

fX (y)dy .

−∞

qqqq

qqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqq

qqqqqqqqqqqqqqqqqq

q

q

q

q

q

q

q

q

q

q

q

q

qq

qqqqqqqqqqq

X

qqqqqqqqqq

6

q

q

q

q

q

q

q

q

q

q

q

q

q

q

qqqqqq

qqqqqqqqq

? qqqqqqqqqqqqqqqqqqq

qqqqqqqqq

qqqqqqqqqqqqqqqq

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

q

qq

F

P (a < X < b)

a

b

>

Im Beispiel ist also F (495) die Wahrscheinlichkeit, dass ein

zufällig ausgewähltes Paket eine Füllmenge von höchstens 495 g

aufweist und modelliert den Anteil aller solcher Pakete an der

Gesamtproduktion dieser Maschine.

Außerdem gilt P (495 < X < 505) = FX (505) − FX (495).

28

Hinweis: Da für jeden Wert x gilt: P (X = x) = 0, braucht

man bei stetigen ZV nicht zwischen

P (a < X < b), P (a < X ≤ b), P (a ≤ X < b) und

P (a ≤ X ≤ b) zu unterscheiden!

Es gilt für stetige ZV:

P (a ≤ X ≤ b) = FX (b) − FX (a)

P (X ≤ b) = FX (b)

P (a ≤ X) = 1 − FX (a)

Allgemeines:

Die Verteilungsfunktion kann auch für diskrete ZV definiert

werden.

Eigenschaften einer Verteilungsfunktion:

1. FX ist monoton nichtfallend.

2. FX ist rechtsstetig.

3. lim FX (x) = 0

x→−∞

4. lim

x→∞

FX (x) = 1

29

Erwartungswert einer stetigen Zufallsvariablen X:

Z ∞

E(X) =

x fX (x) dx

−∞

Rechenregeln:

X Zufallsvariable, dann auch a · X + b, a, b ∈ R

E(aX + b) = a E(X) + b

Beispiel: Stetige gleichmäßige Verteilung über dem Intervall

[a,b] aus R:

1 , x ∈ [a, b]

b−a

fX (x) =

0

sonst

”Rechteckverteilung” entspricht der diskreten gleichmäßigen

Verteilung; jedes Teilintervall von [a,b] gleicher Länge hat die

gleiche Wahrscheinlichkeit

0

, x<a

x−a

FX (x) =

, x ∈ [a, b]

b

−

a

1

, x>b

Z

E(X) =

b

x·

a

a+b

1

dx =

b−a

2

30

Streuung (Varianz)

2

var (X) = D2X = σX

= E(X − E(X))2

Z ∞

=

(x − E(X))2 fX (x) dx

−∞

! Zahl

= E(X 2) − (E(X))2

Z ∞

↑

x2fX (x)dx

−∞

Beispiel: Stetige gleichmäßige Verteilung über [a,b]

(b − a)2

var (X) =

12

Rechenregel:

var (a · X + b) = a2 var (X)

31

(a, b ∈ R)

Die Normalverteilung

1. wichtigste stetige Verteilung

2. viele Größen sind (näherungsweise!) normalverteilt

Gauß −→ Beschreibung von Messfehlern

3. Bedeutung folgt aus sogenannten Grenzwertsätzen

Summen sehr vieler kleiner (unabhängiger) Summanden

−→ NV

Dichtefunktion der NV: Gaußsche Glockenkurve

(x−µ)2

1

−

f (x) = √ · e 2σ2 ,

σ 2π

NV mit dem Parameter µ und σ

X ∼ N (µ, σ 2)

µ: Zentrum

σ: Form

E(X) = µ, var (X) = σ 2

32

−∞ < x < ∞

linke Kurve: Dichtefunktion einer N(0,1)-verteilten ZV

rechte Kurve: Dichtefunktion einer N(3,1)-verteilten ZV

linke Kurve: Dichtefunktion einer N(0,1)-verteilten ZV

rechte Kurve: Dichtefunktion einer N(3,4)-verteilten ZV

Es gilt: Ist X ∼ N (µ, σ 2), dann ist

Z=

X −µ

σ

standard-normalverteilt: Z ∼ N (0, 1)

mit Dichtefunktion:

2

1

− x2

ϕ(x) = √ · e

2π

und Verteilungsfunktion:

1

Φ(x) = √

2π

Z

x

e

2

− t2

dt

−∞

(Gaußsche Fehlerfunktion)

Begriff: Standardisieren

Hinweis: Die Verteilungsfunktion einer Normalverteilung

(z.B. Φ(x)) ist keine mit einer Formel darstellbare elementare

Funktion. Man verwendet deshalb Tafeln für Φ(x) !

33

Bestimmung von Wahrscheinlichkeiten aus Tafeln

(Tafel im Aufgabenheft)

!!! Tafeln existieren nur für die Werte der Verteilungsfunktion

Φ(x) der N (0, 1)-Verteilung für positive Werte x

Ablesebeispiele:

Φ(1) = 0, 841345

Φ(1, 1) = 0, 864334

Φ(1, 11) = 0, 866500

Es gilt

Φ(x) = 1 − Φ(−x)

also z.B.

Φ(−1) = 1 − Φ(1) = 1 − 0, 841345 = 0, 158655

X ∼ N (µ, σ 2), dann

µ

¶

a−µ

σ

¶

µ

¶

µ

a−µ

b−µ

− Φ

P (a < X < b) = Φ

σ

σ

µ

¶

b−µ

P (X > b) = 1 − Φ

σ

P (X < a) = Φ

Achtung: Division durch σ, nicht durch σ 2

Beispiel:

X ∼ N (8, 9),

Gesucht P (X < 10)

¶

µ ¶

µ

2

10 − 8

= Φ

= 0, 747

P (X < 10) = Φ

3

3

34

Quantile der (standardisierten) Normalverteilung

Φ(zq ) = q

zq . . . Quantil der Ordnung q

z0,95 = 1, 645

Andere Bezeichnung möglich!

Zusammenhang mit sogenannten kritischen Werten:

z1−α , Φ(z1−α ) = 1 − α (”einseitige Fragestellung”):

rrrrrrrrrrrrrrrrrrrrrrrrrr

rrrrrrrr

rrrrr

r

r

r

r

rrrrr

rrrr

r

rrrr

r

rr

rrrr

r

r

r

rrr

r

rr

rrrr

r

r

rrr

r

r

r

rrrr

r

rrr

rrrr

r

r

r

r

rrrr

r

r

r

r

rrrrr

r

rr

r

r

rrrrr

r

r

r

r

r

rrrrrr

r

rrrr

r

r

pprrrpprrprrr¡

r

r

r

r

r

r

r

r

rr

pp pp¡

pp pprrrpprrrpprrrprrrprrrrrrrr

ª

rrrrrrrrrrrrrrr

ϕ

Fläche = α

0

z1−α

z1−α/2 , Φ(z1−α/2) = 1 − α/2 (”zweiseitige Fragestellung”):

rrrr

rrrrrrrrrrr rrrrrrrrrrrrrrrr

rrrrr

rrrrr

r

r

r

r

rrrr

rrr

r

r

rrrr

r

rrr

rrrr

r

r

r

r

rrrr

r

rr

rrrr

r

r

r

rrr

r

rr

rrrr

r

r

r

rrrr

r

r

r

r

rrrr

α

r

rrr

rrrrr

r

r

r

r

rrrrr

r

r

2 rrrrrr

rrrrrrr

@ rrrrrrrrr

rrrrprrrr ¡

r

r

r

r

r

r

r

p

p

p

p

p

pp ¡

pprrrpp rrpprrrpprrrprrrp rrrp

r

r

r

@

¡

r

r

r

r

@

R

ª

r

r

r

r

rrp p p p p p p p

ϕ

Fläche =

−z1− α2

Fläche =

0

35

z1− α2

α

2

”k · σ Grenzen” für die Normalverteilung:

Für X ∼ N (µ, σ 2) gilt

P (|X − µ| ≤ kσ) = 2Φ(k) − 1 und für k = 1, 2, 3 ergibt sich

1 · σ Grenze: 0,6826 ,

2 · σ Grenze: 0,9546 ,

3 · σ Grenze: 0,9974 .

rrrrrrrrrrrrrrrrrrrrrrrrr

rrrrrrr

rrrrr

r

r

r

rrrrr

rr

rrrr

rrrr

r

r

r

rrrr

r

rr

rrr

X

r

r

r

rrrr

r

r

r

r

rrr

r

r

r

r

r

rrrr

rrr

rrrr

rrrr

rrrr

r

r

r

r

rrrrr

r

r

r

r

r

rrrrr

r

rrrr

rrrrrr

r

r

r

r

r

r

rrrrrrrr

r

r

r

rrrr

r

rrrrrrrrrrr

r

r

r

r

r

r

r

r

r

rrrrrrrr

rrrrrrrrrrr

f

µ−3σ

µ−2σ

µ−σ

µ

µ+σ

µ+2σ

µ+3σ

Hinweis:

Im Zusammenhang mit der Behandlung von Aufgaben der

schließenden Statistik benötigt man verschiedene weitere

stetige Verteilungen und deren Tafeln.

Beispiele: χ2-, t-, F-Verteilung (im Zusammenhang mit der

Normalverteilung) −→ später

und weitere Verteilungen im Zusammenhang mit sogenannten

nichtparametrischen Tests.

36