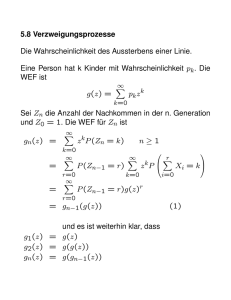

Stochastik I und Masstheorie Universität Zürich FS 2012

Werbung