Mathematik für Informatiker B und (Teile von) C - Christian

Werbung

Mathematik für

Informatiker B und (Teile von) C

Malte Braack

Christian-Albrechts-Universität zu Kiel

06.11.2015

Inhaltsverzeichnis

1 Modulare Arithmetik

1.1 Teiler . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2 Euklidischer Algorithmus . . . . . . . . . . . . . . .

1.3 Restklassen . . . . . . . . . . . . . . . . . . . . . .

1.3.1 Operationen auf den Restklassen . . . . . .

1.3.2 Anwendung von Restklassen auf Prüfziffern

Eine Ziffer fehlerhaft . . . . . . . . . . . . .

Zahlendreher . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2 Gruppen

2.1 Isomorphe Gruppen . . . . . . . . . . . . . . . . . . . .

2.2 Klassifikation von Gruppen . . . . . . . . . . . . . . . .

2.2.1 Klassifikation der Gruppen mit einem Element .

2.2.2 Klassifikation der Gruppen mit zwei Elementen

2.2.3 Klassifikation der Gruppen mit drei Elementen .

2.2.4 Gruppen mit vier Elementen . . . . . . . . . . .

2.3 Zyklische Gruppen . . . . . . . . . . . . . . . . . . . .

2.4 Permutationsgruppen . . . . . . . . . . . . . . . . . . .

2.5 Existenz von multiplikativen Inversen in Zm . . . . . .

2.6 Die Gruppe Z∗n und die Eulersche Funktion . . . . . . .

2.7 RSA-Public-Key Verschlüsselung . . . . . . . . . . . .

2.7.1 Chiffrieren . . . . . . . . . . . . . . . . . . . . .

2.7.2 Dechiffrieren . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

3

4

5

6

6

6

.

.

.

.

.

.

.

.

.

.

.

.

.

9

11

12

12

12

12

13

13

14

15

17

19

20

21

3 Ringe

23

3.1 Der Ring Zm . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 24

3.2 Polynomringe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 24

ii

M. Braack - INHALTSVERZEICHNIS

4 Körper

4.1 Angeordnete Körper . . . . . . . . . . . . . . . . . .

4.2 Der Körper der reellen Zahlen . . . . . . . . . . . . .

4.2.1 Darstellung reeller Zahlen . . . . . . . . . . .

4.3 Der Körper der komplexen Zahlen . . . . . . . . . . .

4.3.1 Graphische Darstellung der komplexen Zahlen

4.4 Polynomdivision . . . . . . . . . . . . . . . . . . . . .

4.5 Polynome in C . . . . . . . . . . . . . . . . . . . . .

4.6 Polynome in R . . . . . . . . . . . . . . . . . . . . .

4.6.1 Intervallhalbierungsverfahren . . . . . . . . .

4.7 Polynomdivision zur Datensicherung . . . . . . . . .

4.8 Horner-Schema . . . . . . . . . . . . . . . . . . . . .

5 Vektorräume

5.1 Beispiele von Vektorräumen . . . . . .

5.1.1 Die Vektorräume Rn und Cn . .

5.1.2 Der Vektorräume Zn2 . . . . . .

5.1.3 Funktionenräume . . . . . . . .

5.2 Unterräume . . . . . . . . . . . . . . .

5.3 Linearkombinationen und aufgespannte

5.4 Lineare Abhängigkeit . . . . . . . . . .

5.5 Basen und Dimension . . . . . . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

Teilräume

. . . . . .

. . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6 Lineare Abbildungen

6.1 Kern und Bild . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.2 Matrizen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.2.1 Matrizenprodukte . . . . . . . . . . . . . . . . . . . . . . . .

6.2.2 Endomorphismen des Rn . . . . . . . . . . . . . . . . . . . .

6.2.3 Dreiecksmatrizen . . . . . . . . . . . . . . . . . . . . . . . .

6.2.4 Transponierte und symmetrische Matrizen . . . . . . . . . .

6.2.5 Rang einer Matrix . . . . . . . . . . . . . . . . . . . . . . .

6.3 Lineare Gleichungssysteme . . . . . . . . . . . . . . . . . . . . . . .

6.3.1 Allgemeine und spezielle Lösungen . . . . . . . . . . . . . .

6.3.2 Vorwärts- und Rückwärtseinsetzen . . . . . . . . . . . . . .

6.3.3 Gauß’sches Eliminationsverfahren bei quadratischen regulären

Matrizen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

C Code . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

27

29

30

32

32

35

35

38

39

40

40

42

.

.

.

.

.

.

.

.

45

46

46

47

47

47

48

49

51

.

.

.

.

.

.

.

.

.

.

57

59

62

64

65

67

68

69

71

72

73

. 74

. 76

INHALTSVERZEICHNIS

iii

6.3.4

6.4

6.5

6.6

Gauß’sche Elimination bei nicht notwendigerweise quadratischen Matrizen . . . . . . . . . . . . . . . . . . . . . . . . .

Determinanten . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.4.1 Entwicklungssatz von Laplace . . . . . . . . . . . . . . . . .

6.4.2 Berechnung von Inversen mittels Determinanten . . . . . . .

6.4.3 Lösen von Gleichungssystemen mittels Determinanten . . . .

Eigenwerte und Eigenvektoren . . . . . . . . . . . . . . . . . . . . .

Skalarprodukt und orthogonale Matrizen . . . . . . . . . . . . . . .

6.6.1 Skalarprodukt . . . . . . . . . . . . . . . . . . . . . . . . . .

6.6.2 Anwendungsbeispiel . . . . . . . . . . . . . . . . . . . . . .

7 Folgen und Grenzwerte

7.1 Metrische Räume . . . . . . . . . . . . .

7.1.1 Äquivalente Metriken . . . . . . .

7.2 Folgen . . . . . . . . . . . . . . . . . . .

7.2.1 Konvergente Folgen in metrischen

7.2.2 Cauchy-Folgen . . . . . . . . . .

7.2.3 Folgen in angeordneten Körpern .

7.2.4 Folgen reeller Zahlen . . . . . . .

7.2.5 Folgen mit rationalen Elementen

7.2.6 Folgen in C . . . . . . . . . . . .

7.2.7 Rekursiv definierte Folgen . . . .

7.2.8 Landau-Symbole . . . . . . . . .

. . . . .

. . . . .

. . . . .

Räumen

. . . . .

. . . . .

. . . . .

. . . . .

. . . . .

. . . . .

. . . . .

8 Reihen

8.1 Harmonische Reihe . . . . . . . . . . . . . .

8.2 Geometrische Reihe . . . . . . . . . . . . . .

8.3 Die Eulersche Zahl e . . . . . . . . . . . . .

8.4 Konvergenzkriterien für Reihen . . . . . . .

8.4.1 Umsortierungen . . . . . . . . . . . .

8.4.2 Alternierende Reihen . . . . . . . . .

8.4.3 Absolut konvergente Reihen . . . . .

8.5 Vervollständigungen . . . . . . . . . . . . .

8.6 Potenzreihen . . . . . . . . . . . . . . . . . .

8.6.1 Die Exponentialfunktion . . . . . . .

8.6.2 Die Trigonometrischen Funktionen .

8.6.3 Die Binomialreihe . . . . . . . . . . .

8.6.4 Allgemeinere Form von Potenzreihen

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

76

80

84

86

87

88

94

94

96

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

99

99

103

104

105

106

107

108

111

113

113

116

.

.

.

.

.

.

.

.

.

.

.

.

.

119

. 121

. 122

. 123

. 123

. 123

. 124

. 125

. 127

. 128

. 131

. 132

. 132

. 133

iv

M. Braack - INHALTSVERZEICHNIS

9 Stetige Funktionen

9.1 Eigenschaften stetiger Funktionen . . . . . . . . . . . . . .

9.2 Die Potenzfunktion mit rationalen Exponenten . . . . . . .

9.3 Die Exponentialfunktion in Q . . . . . . . . . . . . . . . .

9.4 Die Exponentialfunktion in C . . . . . . . . . . . . . . . .

9.5 Die Logarithmusfunktion . . . . . . . . . . . . . . . . . . .

9.6 Die Exponential- und Logarithmusfunktion zur allgemeinen

10 Differenzierbare Funktionen

10.1 Differentiationsregeln . . . . . . . . . .

10.2 Lokale Extrema und der Mittelwertsatz

10.3 Taylor-Entwicklung . . . . . . . . . . .

10.4 Approximation von Ableitungen . . . .

10.5 Newton-Verfahren . . . . . . . . . . . .

. . . .

. . . .

. . . .

. . . .

. . . .

Basis

. . . . . . . . . . . . . .

der Differentialrechnung

. . . . . . . . . . . . . .

. . . . . . . . . . . . . .

. . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

135

. 137

. 138

. 139

. 140

. 143

. 143

.

.

.

.

.

145

. 148

. 152

. 155

. 157

. 158

Kapitel 1

Modulare Arithmetik

1.1

Teiler

Das nachfolgende Lemma charakterisiert die Division mit Rest.

Lemma 1.1 Zu jedem Zahlenpaar (a, d) ∈ Z×Z∗ gibt es eindeutig bestimmte Zahlen

q, r ∈ Z mit a = dq + r und 0 ≤ r < |d|.

Bezeichnung: a heißt hierbei Dividend, d ist der Divisor, q der Quotient und r

der Rest.

Beispiele:

• (a, d) = (99, 4), 99 = 24 · 4 + 3, also q = 24 und r = 3.

• (a, d) = (99, −4), 99 = (−24) · (−4) + 3, also q = −24 und r = 3.

• (a, d) = (−99, −4), −99 = 25 · (−4) + 1, also q = 25 und r = 1.

• (a, d) = (−99, 4), −99 = (−25) · 4 + 1, also q = −25 und r = 1.

Also hat q immer das gleiche Vorzeichen wie das Produkt ad.

Beweis. Sei zunächst a, d ≥ 0. Wir setzen q als die größte ganze Zahl mit dq ≤ a

und r := a − dq, also r ≥ 0. Aufgrund der Maximalität von q gilt auch r < |d|. Die

Eindeutigkeit von q folgt aus der Forderung 0 ≤ r < |d|. Die übrigen Fälle a ≤ 0

bzw. d < 0 erfolgen analog.

Definition 1.2 Gilt im obigen Satz r = 0, so heißt d Teiler von a. Man schreibt

dann d|a, anderenfalls d6 | a.

2

M. Braack - Modulare Arithmetik

Jedes d ∈ Z∗ ist Teiler der Null: d|0. Die Eigenschaft “d ist Teiler von a” kann

man auffassen als eine transitive Relation auf Z. Es folgt also insbesondere

a|b ∧ b|c =⇒ a|c .

Eine andere offensichtliche Regel ist:

d|a ∧ d|b =⇒ d|(αa + βb) ∀α, β ∈ Z .

(1.1)

Definition 1.3 Zu zwei ganzen Zahlen a, b ∈ Z heißt d ∈ Z∗ ein gemeinsamer

Teiler, wenn d|a und d|b. Gilt ferner d > 0 und für jeden anderen gemeinsamen

Teiler c ∈ Z, c|d, so heißt d größter gemeinsamer Teiler und wird bezeichnet mit

d = ggt(a, b).

Lemma 1.4 Zu a, b ∈ Z kann es maximal einen größten gemeinsamen Teiler geben.

Beweis. Seien d1 , d2 > 0 zwei größte gemeinsame Teiler von a und b. Dann gilt

di |dj , für i, j ∈ {1, 2}, also d1 = q1 d2 und d2 = q2 d1 mit geeigneten q1 , q2 ∈ Z. Da

aber d1 und d2 als positiv vorausgesetzt wurden, muß auch q1 > 0 und q2 > 0 gelten.

Ferner folgt d1 = q1 q2 d1 , bzw. q1 q2 = 1. Da q1 , q2 ∈ N, folgt q1 = q2 = 1.

Dennoch wissen wir noch nicht, ob es immer einen ggt gibt. Wir werden dies

aber etwas später sehen.

Lemma 1.5 Es gilt für alle d ∈ N:

(i) d = ggt(qd, d) für alle q ∈ Z.

(ii) Sind a, b, q ∈ Z, so gilt die Äquivalenz:

d = ggt(a, b) ⇐⇒ d = ggt(a − qb, b) .

Beweis. (i): d ist offensichtlich ein gemeinsamer Teiler von qd und von d. Für

jeden weiterer Teiler c von qd und d gilt c|d, also d = ggt(qd, d).

(ii): Wir zeigen zunächst “⇒”: Ist d = ggt(a, b) so ist d auch ein Teiler von a − qb

wegen (1.1). Sei c ∈ Z ein weiterer Teiler von a − qb und b. Dann bleibt zu zeigen,

dass c|d. Dies sieht man wie folgt: Da c|qb und c|a − qb ist auch c|a. Somit ist c

gemeinsamer Teiler von a und b. Da nach Voraussetzung d = ggt(a, b) folgt c|d. Die

andere Richtung “⇐” folgt analog.

1.2 Euklidischer Algorithmus

1.2

3

Euklidischer Algorithmus

Der euklidische Algorithmus kann verwendet werden, um den größten gemeinsamen

Teiler d = ggt(a, b) zu ermitteln. Wir nehmen an, dass |a| > |b|. Dann geht man

folgendermaßen vor:

a = bq0 + r0 ,

0 ≤ r0 < |b| ,

b = r0 q1 + r1 ,

0 ≤ r1 < r0 ,

r0 = r1 q2 + r2 ,

..

.

0 ≤ r2 < r1 ,

rn−2 = rn−1 qn + rn ,

0 ≤ rn < rn−1 ,

rn−1 = rn qn+1 .

In jedem Schritt wird der Rest echt kleiner, 0 ≤ ri+1 < ri . Daher bricht diese

sukzessive Dividieren mit Rest irgendwann ab, wenn der Rest den Wert Null erreicht.

Wenn dieses Abbruchkriterium erreicht ist gilt

rn = ggt(a, b) .

(1.2)

Wir werden sehen, dass sogar gilt:

rn = ggt(ri , ri−1 ) ∀i = 0, . . . , n .

(1.3)

Insbesondere folgt dann auch (1.2). Die Eigenschaft (1.3) sieht man mittels Induktion nach i. Da wir den Induktionsbeweis rückwärts führen lautet die Induktionsannahme rn = ggt(rn , rn−1 ). Dies ist aber eine unmittelbare Folgerung aus Lemma 1.5

(i), da rn−1 ein Vielfaches von rn ist. Wir nehmen nun rn = ggt(ri , ri−1 ) für ein

i ∈ {1, . . . , n} an. Da nach Konstruktion

ri = ri−2 − ri−1 qi

gilt, folgt rn = ggt(ri−1 , ri−2 ) nach Lemma 1.5 (ii).

Beispiel: Zur Ermittlung von ggt(91, 133) erhält man:

133 = 91 · 1 + 42

91 = 42 · 2 + 7

42 = 7 · 6

=⇒

7 = ggt(91, 133) .

Als Nebenprodukt dieses Algorithmus erhalten wir folgenden Existenzsatz:

4

M. Braack - Modulare Arithmetik

Satz 1.6 Zu zwei ganzen Zahlen a, b ∈ Z, a, b 6= 0, gibt es genau einen größten

gemeinsamen Teiler d = ggt(a, b). Ferner existieren α, β ∈ Z mit d = αa + βb.

Beweis. Die Existenz haben wir zuvor mittels des Euklidischen Algorithmus gezeigt. Die Eindeutigkeit haben wir in Lemma 1.4 bereits gezeigt. Es bleibt also die

Behauptung zu zeigen, dass sich der ggt(a, b) stets als Linearkombinationen von

a und b darstellen läßt: Hierzu verifizieren wir, dass der Rest rn im Euklidischen

Algorithmus eine Linearkombination von a und b ist, also rn = αa + βb:

r0 = a − bq0 = α0 a + β0 b

r1 = b − r0 q1 = b − (α0 a + β0 b)q1 = α1 a + β1 b

r2 = r0 − r1 q2 = α2 a + β2 b

..

.

rn = rn−2 − rn−1 qn = αn a + βn b

Mit jeweils geeigneten Koeeffizienten αi , βi ∈ Z.

1.3

Restklassen

Definition 1.7 Zwei ganze Zahlen a, b ∈ Z heißen kongruent modulo m ∈ N,

wenn m|(a − b). In diesem Fall schreibt man

a ≡ b mod m .

Lemma 1.8 Die Relation “kongruent modulo m” ist eine Äquivalenzrelation auf Z.

Die zugehörigen Äquivalenzklassen heißen Restklassen modulo m. Diese werden

mit [·]m bezeichnet.

Beweis. Für den Nachweis einer Äquivalenzrelation muss man die Reflexivtät,

die Symmetrie und die Transitivität nachweisen. Wir lassen diese einfache Übung

als Übungsaufgabe.

Man überlege sich folgende Äquivalenz:

a ∈ [b]m ⇔ [a]m ∈ [b]m .

Lemma 1.9 Für a, b ∈ Z und m ∈ N sind äquivalent:

(a) a ≡ b mod m.

(b) a und b liefern bei Division durch m den selben Rest.

1.3 Restklassen

5

(c) Für die Restklassen modulo m gilt: [a]m = [b]m .

Beweis. (a) ⇒ (b) : Laut Definition gilt m|(a − b). Also existiert ein d ∈ Z mit

a − b = md. Sei ferner a = md1 + r1 und b = md2 + r2 mit 0 ≤ r1 , r2 < m. Es folgt

m(d1 − d2 ) + r1 − r2 = md .

Somit muß m|(r1 − r2 ). Da aber −m < r1 − r2 < m folgt r1 = r2 .

(b) ⇒ (c) : Es gelte a = md1 + r und b = md2 + r, also a − md1 = b − md2 . Dann

gilt aber a ∈ [b + m(d1 − d2 )]m = [b]m , und mit dem oben gezeigten [a]m = [b]m .

(c) ⇒ (a) : Aus [a] = [b] folgt a ∈ [b]. Dies besagt aber gerade, dass a und b

kongruent modulo m sind.

Als Konsequenz dieses Satzes ergibt sich, dass es genau m Restklassen gibt, nämlich

[0], [1], . . . , [m − 1]. Die Restklassen werden also durch den zugehörigen Rest repräsentiert.

1.3.1

Operationen auf den Restklassen

Lemma 1.10 Die Operationen ⊕ und auf der Menge der Restklassen, definiert

durch

[a]m ⊕ [b]m := [a + b]m ,

[a]m [b]m := [a · b]m .

sind wohldefiniert.

Beweis. Mit Wohldefiniertheit ist hier gemeint, dass die Operationen unabhängig

sind von den jeweiligen Repräsentanten. Beispielsweise gilt für a, a0 ∈ [a]m und

b, b0 ∈ [b]m :

[a]m ⊕ [b]m = [a0 ]m ⊕ [b0 ]m ,

[a]m [b]m = [a0 ] [b0 ]m .

Die Begründung hierfür ist, dass m|(a − a0 ) sowie m|(b − b0 ). Hiermit gilt dann auch

m|((a + b) − (a0 + b0 )) bzw. [a + b]m = [a0 + b0 ]m . Die Multiplikation geht entsprechend

und lassen wir als Übungsaufgabe.

Diese Operationen auf den Restklassen erlauben es uns in Zukunft einfach mit

den Repräsentanten zu rechnen. Wir können also neue Operationen auf den Zahlen

0, 1, . . . , m − 1 folgendermassen definieren:

a ⊕ b = (a + b) mod m

a b = (ab) mod m .

6

M. Braack - Modulare Arithmetik

1.3.2

Anwendung von Restklassen auf Prüfziffern

Die ISBN Nummern im Buchhandel werden an der letzten Stelle mit einer Prüfziffer

versehen. Anhand dieser können manche Übertragungsfehler aufgedeckt werden. Der

Aufbau der 10-stelligen ISBN Nummer ist wie folgt (verwendet bis zum Jahr 2006):

An den ersten neun Stellen ai stehen Ziffern aus denen die letzte Ziffer (Prüfziffer)

a10 folgendermaßen gebildet wird:

!

9

X

a10 ≡

iai mod 11 .

i=1

Im Fall a10 = 10 wird das Symbol “X” verwendet. Seit 1.1.2007 besitzt die ISBN

Nummer sogar 13 Stellen (ISBN-13).

Beispiel: Das Buch von P. Hartmann [7] besitzt die ISBN Nummer 3-8348-0096-1.

Die entsprechende gewichtete Summe der ersten neun Ziffern ergibt

3 · 1 + 8 · 2 + 3 · 3 + 4 · 4 + 8 · 5 + 0 · 6 + 0 · 7 + 9 · 8 + 6 · 9 = 210 .

Da 210 ≡ 1 mod 11 erhält man tatsächlich die 1 als letzte Ziffer.

Eine Ziffer fehlerhaft

Wir werden nin sehen, dass eine fehlerhafte Ziffer zu einer nicht zulässigen Prüfziffer

führt. Im Fall, dass eine Ziffer fehlerhaft ist, also abi anstelle von ai , so würde bei

gleicher Prüfziffer gelten:

iai ≡ iabi mod 11 .

Hieraus folgt dann aber i(ai − abi ) ≡ 0 mod 11, bzw. ausgedrückt in Restklassen:

[i]11 [ai − abi ]11 = [0]11 .

Dann müsste aber i ≡ 0 mod 11 oder ai − abi ≡ 0 mod 11 sein. Da 11 eine Primzahl

ist, ist dies nur für den Fall ai = abi möglich. Also liegt keine falsche Ziffer vor.

Zahlendreher

Wir wollen uns nun überlegen was im Fall eines Zahlendrehers passiert, also bei

einem Vertauschen von ai und aj für i 6= j. Bliebe die Prüfziffer gleich, so würde

gelten:

iai + jaj ≡ (iaj + jai ) mod 11 .

1.3 Restklassen

7

Dies bedeutet aber

(i − j)(ai − aj ) ≡ 0 mod 11 .

Aufgrund der Rechenregel von Restklassen ist dies aber gleichbedeutend mit:

[i − j]11 [ai − aj ]11 = [0]11 .

Dann müsste aber i − j ≡ 0 mod 11 oder ai − aj ≡ 0 mod 11 sein. Dies ist aber nur

möglich für ai = aj . Also wird die Prüfziffer bei dem Vertauschen zweier verschiedener Ziffern sicherlich anders sein.

Bemerkung: Die Begründung, dass aus [a]11 [b]11 = [0]11 folgt, dass [a]11 = [0]11

oder [b]11 = [0]11 gilt, beweisen wir erst im Abschnitt 4. Hierzu ist wichtig, dass 11

eine Primzahl ist. Anderenfalls gilt diese Folgerung nicht. Beispielsweise ist [2]4 [2]4 =

[0]4 .

8

M. Braack - Modulare Arithmetik

Kapitel 2

Gruppen

Im folgenden beschäftigen wir uns mit Mengen G, auf denen eine (binäre) Verknüpfung, beispielsweise mit ∗ bezeichnet, definiert ist. Hierunter versteht man eine

Abbildung

∗ : G×G→G

(x, y) 7→ x ∗ y

Wir beginnen mit Mengen auf denen solch eine Verknüpfung definiert ist, die aber

noch recht “schwache” Struktureigenschaften aufweisen.

Definition 2.1 (Halbgruppe und Gruppe) Eine Halbgruppe (G, ∗) besteht aus

einer Menge G und einer Verknüpfung ∗ : G × G → G auf dieser Menge, so dass

das Assoziativgesetz gilt, d.h.

(G1)

(a ∗ b) ∗ c = a ∗ (b ∗ c)

∀a, b, c ∈ G .

Eine Halbgruppe (G, ∗) heißt Gruppe, wenn folgenden Eigenschaften gelten:

(G2) Es gibt ein neutrales Element e ∈ G, d.h. a ∗ e = e ∗ a = a ∀a ∈ G .

(G3) Für jedes Element a ∈ G existiert ein inverses Element inv∗ (a) ∈ G, d.h.

a ∗ inv∗ (a) = e.

Eine Gruppe heißt kommutative Gruppe (oder abelsche Gruppe), wenn zusätzlich

das Kommutativgesetz gilt, d.h.

a∗b = b∗a

∀a, b ∈ G .

10

M. Braack - Gruppen

Ist |G| endlich, so spricht man von einer endlichen Gruppe.

Beispiele:

1. (Z, +) ist eine kommutative Gruppe mit neutralem Element e = 0 und Inversem inv+ (a) = −a.

2. (Q, +) ist eine kommutative Gruppe mit neutralem Element e = 0 und Inversem inv+ (a) = −a.

3. (Q \ {0}, ·) ist eine kommutative Gruppe mit neutralem Element e = 1 und

Inversem inv· (a) = 1/a.

4. (N0 , +) ist nur eine Halbgruppe, da es keine Inversen in dieser Menge gibt

(abgesehen von dem Inversen des neutralen Elementes 0).

Lemma 2.2 In einer Gruppe G sind die linksinversen und rechtsinversen Elemente

gleich, d.h. a ∗ inv∗ (a) = inv∗ (a) ∗ a = e.

Beweis. Sei a ∗ inv∗ (a) = e. Dann folgt mit dem Rechtsinverse b = inv∗ (a):

inv∗ (a) ∗ a = (b ∗ a) ∗ e = (b ∗ a) ∗ (b ∗ inv∗ (b))

= b ∗ (a ∗ b) ∗ inv∗ (b) = b ∗ e ∗ inv∗ (b) = b ∗ inv∗ (b) = e .

Lemma 2.3 In einer Gruppe G gibt es nur ein neutrales Element und zu jedem

a ∈ G auch nur ein Inverses.

Beweis. Übungsaufgabe.

Definition 2.4 (Untergruppe) Eine Teilmenge U ⊂ G einer Gruppe (G, ∗) heißt

Untergruppe von G, wenn für alle a, b ∈ U gilt a ∗ b ∈ U und inv∗ (a) ∈ U .

Beispiele:

1. (Z, +) ist eine Untergruppe von (Q, +).

2. (N, +) ist hingegen keine Untergruppe von (Q, +), da die Inversen nicht enthalten sind.

2.1 Isomorphe Gruppen

2.1

11

Isomorphe Gruppen

Definition 2.5 Eine Abbildung f : G1 → G2 zwischen zwei Gruppen (G1 , ∗) und

(G2 , +) heißt (Gruppen-) Homomorphismus, wenn

f (a ∗ b) = f (a) + f (b)

∀a, b ∈ G1 .

Ist f dabei bijektiv, so heißt f (Gruppen-) Isomorphismus, und G1 und G2 werden

isomorph genannt.

Beispiele:

1. Die Identität id : (Z, +) → (R, +) ist ein Homomorphismus.

2. Die Funktion, die einer reellen Zahl den ganzzahligen Anteil (INT) zuweist,

f : (R, +) → (Z, +), x 7→ [x] ist kein Homomorphismus, denn beispielsweise

gilt 1 = f ( 34 ) = f ( 23 + 32 ) 6= f ( 23 ) + f ( 32 ) = 0 + 0. Das gleiche gilt für andere

Arten der “Rundung”.

3. Dadurch dass ein Rechner immer nur endlich viele Dezimalstellen verarbeiten

kann, ist die Abbildung f der reellen Zahlen auf Maschinenzahlen ebenfalls

kein Homomorphismus. Ein wichtiger Effekt ist die Auslöschung: Wenn wir

mit 4-stelliger Fließkomma-Arithmetik arbeiten erhält man mit a = 1.2343e4,

b = −1.2344e4:

−1 = f (−1) = f (a + b) 6= f (a) ⊕ f (b) = 1.234 · 104 ⊕ (−1.234 · 104 ) = 0 .

Hierbei bezeichnet ⊕ die Maschinen-Addition mit Fließkommazahlen. Dass

es zu einem Unterschied zwischen der exakten und der Maschinenaddition

kommt, ist nicht weiter verwunderlich. Wichtig ist hier aber, dass der Fehler

relativ zum Endergebnis sehr groß ist.

Lemma 2.6 Seien G1 und G2 Gruppen mit neutralen Elementen e1 ∈ G1 und e2 ∈

G2 . Dann gilt für jeden Homomorphismus f : G1 → G2 :

f (e1 ) = e2

und

f (inv(a)) = inv(f (a)) ∀a ∈ G1 .

Beweis. Wir verwenden für die binären Verknüpfungen auf den beiden Gruppen

das gleiche Symbol ∗. Es gilt:

f (e1 ) = f (e1 ∗ e1 ) = f (e1 ) ∗ f (e1 ) .

12

M. Braack - Gruppen

Wegen der Eindeutigkeit des neutralen Elementes in G2 (Satz 2.3) folgt e2 = f (e1 ).

Ferner folgt nun:

e2 = f (e1 ) = f (a ∗ inv(a)) = f (a) ∗ f (inv(a)) .

Dies bedeutet aber inv(f (a)) = f (inv(a)).

Mit Hilfe von Isomorphismen können wir jetzt Gruppen klassifizieren:

2.2

2.2.1

Klassifikation von Gruppen

Klassifikation der Gruppen mit einem Element

Bis auf Isomorphismen gibt es nur eine Gruppe mit einem Element. Diese besteht nur

aus dem neutralen Element G = {e} und der Operation e ∗ e = e und dem Inversen

inv(e) = e. Das Inverse des neutralen Elementes ist übrigens in jeder Gruppe das

neutrale Element selbst.

2.2.2

Klassifikation der Gruppen mit zwei Elementen

Die Gruppe mit zwei Elementen bezeichnen wir mit G = {e, a}, wobei e das neutrale

Element ist und a ein weiteres Element, also a 6= e. Nun wollen wir uns die möglichen

Verknüpfungstafeln überlegen:

*

e

a

e

e

a

a

a

x

Damit reduziert sich die Anzahl von möglichen Gruppen auf zwei, nämlich je nachdem welchen Wert a ∗ a ∈ {e, a} annimmt. Hierbei ist a ∗ a = a aber ausgeschlossen,

da sonst das neutrale Element nicht eindeutig wäre; also gibt es bis auf Isomorphie

nur eine Gruppe mit zwei Elementen. Diese erhält man, indem man in der obigen

Verknüpfungstafel x = e setzt. Diese ist gerade die Gruppe Z2 = {0, 1} zusammen

mit der Addition modulo 2.

2.2.3

Klassifikation der Gruppen mit drei Elementen

Für Kandidaten mit drei Elementen erhält man zunächst mehr Möglichkeiten:

2.3 Zyklische Gruppen

13

* e a

e e a

a a ?

b b ?

b

b

?

?

Hier kommt nur a ∗ a = e oder a ∗ a = b in Betracht (wieder wegen der Eindeutigkeit

des neutralen Elementes). Aus dem gleichen Grund darf in jeder Zeile und in jeder

Spalte kein Element doppelt vorkommen. Wäre nun a ∗ a = e, so müßte a ∗ b = b

ergeben; was aber zu einem Konflikt mit b ∗ e = b führt. Also ist nur a ∗ a = b,

b ∗ a = e, a ∗ b = e, b ∗ b = a möglich. Wir erhalten:

*

e

a

b

e a

e a

a b

b e

b

b

e

a

Dies entspricht der Gruppe Z3 = {0, 1, 2} mit der Addition modulo 3.

2.2.4

Gruppen mit vier Elementen

Bei vier Elementen gibt es allerdings zwei mögliche Gruppen, die nicht isomorph

zueinander sind, die Gruppe Z4 (links) und die sogenannte Klein’sche Vierergruppe

(rechts):

* e a b

e e a b

a a b c

b b c e

c c e a

2.3

c

c

e

a

b

* e a

e e a

a a e

b b c

c c b

b

b

c

e

a

c

c

b

a

e

Zyklische Gruppen

Wenn man jedes Element der Gruppe durch ein geeignetes Vielfaches ein und desselben Elementes darstellen kann, so spricht man von einer zyklischen Gruppe. Hierbei

bezeichnet an = an−1 ∗ a für n ∈ N, n > 1, und a1 = a. Die genaue Definition einer

zyklischen Gruppe lautet:

Definition 2.7 Eine endliche Gruppe heißt zyklisch, wenn es ein a ∈ G gibt, so

dass

G = {a, a2 , a3 , . . .} .

14

M. Braack - Gruppen

Dieses Element heißt dann erzeugendes Element der Gruppe.

Lemma 2.8 Sei G eine zyklische Gruppe mit n Elementen, n ∈ N. Dann gilt an = e

für das erzeugende Element a ∈ G.

Beweis. Da G zyklisch mit erzeugendem Element a ist, gilt G = {a, a2 , . . . , an }.

Folglich existiert ein m ∈ {1, . . . , n} mit am = e. Mit diesem m gilt dann am+1 =

am ∗ a = e ∗ a = a. Wäre nun m < n, so hätte G weniger als n Elemente. Da dies

ein Widerspruch zur Voraussetzung wäre, folgt m = n.

Die zuvor betrachteten Gruppen Zm sind allesamt zyklisch. Im nächsten Abschnitt betrachten wir Gruppen, die u.U. zyklisch sein können, aber nicht müssen.

Der folgende Satz verwendet eine zyklische Untergruppe im Beweis.

Satz 2.9 Sei (G, ∗) eine endliche Gruppe mit neutralem Element e. Dann gilt a|G| =

e für alle a ∈ G.

Beweis. Wir betrachten die zyklische Untergruppe

Ua := {an ∈ G : n ∈ N}.

Nun gilt einerseits

a|U |a = e.

Andererseits ist die Mächtigkeit einer Untergruppe

Ua einer endlichen Gruppe G

stets ein Teiler von |G| (Satz von Lagrange): |U |a |G|, bzw. |G| = |U |a m, mit m ∈ N.

Hieraus folgt die Behauptung:

a|G| = (a|U |a )m = em = e.

2.4

Permutationsgruppen

Wenn M eine Menge ist, dann bildet die Menge G aller bijektiven Abbildungen f :

M → M zusammen mit der Komposition ◦ von Abbildungen eine Gruppe (G, ◦). Im

Spezialfall einer endlichen Menge, z.B. repräsentiert durch M = {1, 2, . . . , n}, erhält

man durch diese bijektiven Abbildungen gerade die Permutationen. Man spricht

dann von der Permutationsgruppe Sn :

Sn = {f : M → M bijektiv} .

2.5 Existenz von multiplikativen Inversen in Zm

15

Für M = {1, . . . , n} können wir jedes Element f aus Sn eindeutig darstellen mittels

(f (1), f (2), . . . , f (n))

mit paarweise verschiedenen f (k). Entsprechend ist jedes Element aus Sn identifizierbar mit einer Permutation der n Elemente. Ein Element dieser Gruppe ist also

eine Permutation auf n Elementen. Somit gilt nach dem folgenden Satz |Sn | = n!.

Satz 2.10 Die Elemente einer n-elementigen Menge, n ∈ N, lassen sich auf genau

n! verschiedene Arten anordnen.

Beispiel: Für n = 3 können wir die Permutation f , die abbildet 1 7→ 2, 2 7→ 3,

3 7→ 1, verkürzt ausdrücken durch den Ausdruck (2, 3, 1). Führen wir diese Permutation 3 mal hintereinander aus, so erhalten wir das neutrale Element: f ◦ f ◦ f =

f 3 = id. In diesem Fall hat man also einen Zyklus. Es ist aber damit nicht gesagt,

dass die Gruppe S3 zyklisch ist.

Die Permutationsgruppe ist im Fall n = 2 zyklisch. Im allgemeinen Fall (n > 2)

gilt dies jedoch nicht. Untergruppen der Permutationsgruppe können aber sehr wohl

zyklisch sein.

Man überlege sich, dass man jede Permutation als Komposition von 2er-Zyklen

(sogenannte Transpositionen) darstellen kann.

2.5

Existenz von multiplikativen Inversen in Zm

Wir hatten bereits gesehen, dass man auf den Äquivalenzklassen der Relation modulo

m eine Multiplikation definieren kann. Allerdings existieren nicht für alle a ∈ Zm

Inverse bezüglich der Multiplikation. Der Euklidische Algorithmus liefert uns aber

für bestimmte a die Inversen:

Lemma 2.11 Für m ∈ N und a ∈ Z mit ggt(a, m) = 1 existiert ein inverses

Element von [a]m bezüglich der Multiplikation in Zm . Dieses bezeichnen wir mit

[a]−1

m ∈ Zm .

Beweis. Wir müssen eine Restklasse [x]m ∈ Zm finden mit [x]m [a]m = [1]m .

Da ggt(a, m) = 1 liefert der Euklidische Algorithmus ganze Zahlen α, β ∈ Z mit

αa + βm = 1. Hieraus folgt insbesondere

αa + βm ≡ 1 mod m .

16

M. Braack - Gruppen

Subtraktion von βm liefert bereits αa ≡ 1 mod m. Da aber zunächst noch α ∈ Z gilt,

bilden wir die entsprechende Restklasse von x ∈ {1, 2, . . . , m − 1} mit [α]m = [x]m .

Dies ist dann das gewünschte multiplikative Inverse [a]−1

m := [x]m

[x]m [a]m = [1]m .

Dieser Beweis liefert uns gleichzeitig eine Konstruktionsmöglichkeit des Inversen

über den Euklidische Algorithmus.

Beispiel: Das multiplikative Inverse von a = 325 im Ring Zm mit m = 1848

erhält man wie folgt:

1848

325

223

102

19

7

5

2

= 325 · 5 + 223

= 223 · 1 + 102

= 102 · 2 + 19

=

19 · 5 + 7

=

7·2+5

=

5·1+2

=

2·2+1

=

1·2+0

; 223 = 1848 − 5 · 325

; 102 = 325 − 223 = −1848 + 6 · 325

; 19 = 223 − 102 · 2 = 3 · 1848 − 17 · 325

; 7 = 102 − 19 · 5 = −16 · 1848 + 91 · 325

; 5 = 19 − 7 · 2 = 35 · 1848 − 199 · 325

; 2 = 7 − 5 · 1 = −51 · 1848 + 290 · 325

; 1 = 5 − 2 · 2 = 137 · 1848 − 779 · 325

Wir erhalten also

1 = 137 · 1848 − 779 · 325 ≡ (β · m + α · a) mod m

≡ (β · 1848 + α · 325) mod m .

Das multiplikative Inverse zu a = 325 im Ring Z1848 lautet also

α = −779 ≡ −779 + 1848 ≡ 1069 mod 1848 .

Nun wissen wir, dass es unter gewissen Voraussetzungen multiplikative Inverse gibt.

Da (Zm , ) aber im allgemeinen keine Gruppe ist, wissen wir nichts über die Eindeutigkeit solcher Inversen. Um dies doch zu zeigen benötigen wir zunächst eine

weitere Hilfsaussage:

Lemma 2.12 Für beliebige a, b ∈ Z∗ sind äquivalent:

(a) ggt(a, b) = 1,

(b) ∃α, β ∈ Z : αa + βb = 1.

2.6 Die Gruppe Z∗n und die Eulersche Funktion

17

Beweis. Die Richtung (a) ⇒ (b) ist bereits gezeigt in Satz 1.6. Für die Gegenrichtung sei c ein gemeinsamer Teiler von a und b. Damit ist auch c|αa + βb für

beliebige α, β ∈ Z, speziell für die aus Voraussetzung (b). Dies impliziert c|1, woraus

wiederum (a) folgt.

Mit diesen Hilfsmitteln können wir die Eindeutigkeit der Inversen beweisen:

Satz 2.13 Sei a ∈ Z, m ∈ N und ggt(a, m) = 1. Dann liefert a · i für 0 ≤ i < m

paarweise verschiedene Reste modulo m. Insbesondere existiert genau ein 0 < x < m,

so dass [x]m das multiplikative Inverse von [a]m ist. Hierfür gilt ggt(x, m) = 1.

Beweis. Zunächst zu den paarweise verschiedenen Resten: Angenommen ai ≡

aj mod m für 0 ≤ i ≤ j < m. Dies bedeutet m|a(i − j). Da a und m nur die

gemeinsamen Teiler ±1 haben, folgt m|(i − j). Dies ist aber nur möglich für i =

j. Zusammen mit Lemma 2.11 folgt hieraus die Existenz und Eindeutigkeit des

multiplikatives Inversen [x]m ∈ Zm :

ax ≡ 1

mod m .

Dies bedeutet, dass ein q ∈ Z existiert mit ax − 1 = qm, bzw. ax − qm = 1. Mit

Lemma 2.12 ist dies äquivalent mit ggt(x, m) = 1.

2.6

Die Gruppe Z∗n und die Eulersche Funktion

Wir betrachten zu n ∈ N folgende Menge

Z∗n := {[i]n ∈ Zn : ggt(i, n) = 1}.

Die Elemente von Z∗n werden Einheiten modulo n genannt. Zusammen mit der Multiplikation (im Sinne von Restklassen) ist dies eine kommutative Gruppe:

Lemma 2.14 (Z∗n , ·) ist eine kommutative Gruppe.

Beweis. Der Beweis ergibt sich aus den folgenden Punkten:

• Zur Abgeschlossenheit bzgl. der Multiplikation: Seien [a]n , [b]n ∈ Z∗n , also

ggt(a, n) = ggt(b, n) = 1. Dann ist 1 der einzige gemeinsame positive Teiler von a und n, sowie der von b und n. Dann ist aber auch 1 der einzige

gemeinsame positive Teiler von a · b und n, also ggt(ab, n) = 1. Somit folgt

[ab]n ∈ Zn∗ .

• Das Assoziativgesetz gilt offensichtlich, da es in ganz Zn gilt.

18

M. Braack - Gruppen

• Das multiplikative neutrale Element ist [1]n . Dieses ist offensichtlich auch ein

Element in Z∗n .

• Die Existenz der Inversen ist nach Lemma 2.11 gesichert.

Wir erhalten als unmittelbare Folgerung:

Satz 2.15 Ist p eine Primzahl, so ist Z∗p = Zp \ {0}. Insbesondere gibt es in Zp für

alle [a] ∈ Zp , a 6= 0, ein eindeutiges multiplikatives Inverse [a]−1 ∈ Zp : [a]−1

p [a]p =

[1]p .

Die Mächtigkeit der Menge Z∗n wird ϕ(n), bzw. Eulersche Funktion, genannt:

ϕ(n) := |Z∗n |.

Für Primzahlen p gilt offensichtlich

ϕ(p) = p − 1.

Für das Produkt verschiedener Primzahlen gilt hingegen:

Lemma 2.16 Seien p, q zwei verschiedene Primzahlen, n = pq. Dann gelten ϕ(pq) =

(p − 1)(q − 1) und

Z∗n := Zn \ {p, 2p, . . . , (q − 1)p, q, 2q, . . . , (p − 1)q}.

Beweis. Sei M := {p, 2p, . . . , (q − 1)p, q, 2q, . . . , (p − 1)q}. Alle Zahlen k ∈ Zn ,

k 6= 1, die Teiler von n = pq sind, sind Vielfache von p oder von q, also Elemente aus

M . Umgekehrt besitzen die Elemente aus M gemeinsame Teiler mit pq, die größer

als 1 sind. Daher gilt die Äquivalenz:

a ∈ M ⇔ ggt(a, n) > 1 ⇔ a 6∈ Z∗n .

Die Umkehrung ergibt:

a ∈ Zn \ M ⇔ ggt(a, n) = 1 ⇔ a ∈ Z∗n .

Da die oben angegebenen Elemente aus M paarweise verschieden sind, gilt |M | =

q − 1 + p − 1. Hiermit folgt

ϕ(n) = |Z∗n | = |Zn \ M | = pq − (q − 1 + p − 1) = (p − 1)(q − 1).

Für das Konzept von Verschlüsselungstechniken benötigen wir den Satz von Euler:

2.7 RSA-Public-Key Verschlüsselung

19

Satz 2.17 (Satz von Euler) Für n ∈ N und a ∈ Z mit ggt(a, n) = 1 gilt:

aϕ(n) ≡ 1 mod n.

Beweis. Aus ggt(a, n) = 1 folgt [a]n ∈ Z∗n . Nach Satz 2.9 folgt:

∗

aϕ(n) = a|Zn | ≡ 1 mod n.

2.7

RSA-Public-Key Verschlüsselung

Das RSA-Public-Key Verschlüsselungverfahren, benannt nach R. Rivest, A. Shamir

und L. Adleman (1977) beruht auf folgendem Prinzip:

Satz 2.18 Seien p, q zwei verschiedene Primzahlen, n = pq, m = (p − 1)(q − 1),

und e ∈ N derart, dass ggt(e, m) = 1 gilt. Dann ist die Abbildung

C : Z∗n → Z∗n , a 7→ C(a) := ae mod n

eine Bijektion. Die Inverse von C ist

D : Z∗n → Z∗n , b 7→ D(b) := bd mod n,

wobei e · d = 1 mod m.

Beweis. (a) Zunächst ist zu zeigen, dass die Bilder unter C tatsächlich wieder

in Z∗n liegen. Für a ∈ Z∗n gilt ggt(a, n) = 1. Es folgt dann ggt(ae , n) = 1, also

C(a) ∈ Z∗n .

(b) Existenz von d: Da ggt(e, m) = 1, ist e ∈ Z∗m und besitzt somit ein Inverses

d ∈ Zm . Für dieses d gilt die Forderung

e · d ≡ 1 mod m.

(2.1)

(c) Die Abbildungseigenschaft von D folgt aus den gleichen Gründen wie in (a).

(d) Wir zeigen nun, dass für alle a ∈ Z∗n gilt D(C(a)) = a. Hieraus folgt die Bijektivität von C. Aufgrund der Verträglichkeit der Multiplikation mit der Äquivalenzklassenbildung gilt:

D(C(a)) = (ae mod n)d mod n = aed mod n.

20

M. Braack - Gruppen

Wegen (2.1), folgt mit einem geeigneten k ∈ Z:

aed ≡ a1+km mod n

≡ (a · (am )k ) mod n

≡ a · (am mod n)k mod n.

Das Lemma 2.16 liefert uns m = ϕ(n). Der Satz von Euler 2.17 besagt nun am ≡ 1

mod n. Damit folgt

aed ≡ a · 1k mod n

≡ a mod n.

(e) Analog folgert man C(D(b)) = b für b ∈ Z∗n , so dass C und D tatsächlich bijektiv

auf Z∗n sind.

2.7.1

Chiffrieren

Das Chiffrieren geschieht mittels der bijektiven Funktion

C : Z∗n → Z∗n , C(a) = ae mod n.

Dabei ist die Konstruktion der Funktion C öffentlich (öffentlicher Schlüssel). Insofern

sind e, n ∈ N bekannt. Hierbei muss n als ein Produkt von zwei Primzahlen gewählt,

n = pq.

Es ist dabei zu beachten, dass man die Botschaft, die verschlüsselt werden soll, so

in Einzelportionen zerteilt, dass man jedes Teil durch eine Zahl aus Z∗n repräsentieren

läßt. Für große Primzahlen p, q ist aber die Mächtigkeit von |Z∗n | vergleichbar mit

der von |Zn |, denn

|Z∗n |

(p − 1)(q − 1)

pq − (p + q − 1)

=

=

> 1−

|Zn |

pq

pq

1 1

+

p q

≈ 1.

Ferner läßt sich sagen, dass die Anwendung von C relativ schnell möglich ist, selbst

wenn e eine große Zahl ist.

Die chiffrierte Nachricht C(a) kann nun versendet werden. Durch alleinige Kenntnis von e und n kann man aber a nicht aus C(a) zurückerhalten. Hierzu würde man

die Umkehrfunktion D aus dem nächsten Teilabschnitt benötigen.

2.7 RSA-Public-Key Verschlüsselung

2.7.2

21

Dechiffrieren

Das Dechiffrieren geschieht über die Umkehrfunktion

D : Z∗n → Z∗n , b 7→ D(b) := bd mod n.

Gemäß des Satzes 2.18 gilt D ◦ C = Id : Z∗n → Z∗n . Hierdurch wird die Nachricht

a ∈ Z∗n tatsächlich zurückerhalten. D bzw. die Zahl d sind nur einem kleinen Kreis

bekannt ist (z.B. nur der Empfangsperson). d ist aber auch berechenbar aus Kenntnis

der Primzahlen p und q, denn d ist das multiplikative Inverse von e modulo m =

(p − 1)(q − 1). Dies geschieht z.B. durch den Euklidischen Algorithmus. Durch die

Kenntnis von n allein, ist dies aber nicht möglich.

Das ganze Verfahren beruht nun auf der folgenden wichtigen Eigenschaft: Man

kann C(a) schnell bei Kenntnis von a, n und e ermitteln, aber nicht umgekehrt a

aus C(a), n und e. Ferner muss d auch so groß sein, dass man nicht durch bloßes

ausprobieren, den Schlüssel errät. Aus diesem Grund müssen die beiden Primzahlen p, q sehr groß sein. In der Praxis ist die Zahl n mind. von der Größenordnung

1024 Bits. Rechnet man dies um in Dezimalstellen, so ergeben sich p und q in der

Größenordnung 10100 . In dieser Größenordnung läßt sich auch die Faktorisierung

von n in die Primzahlen p, q nicht ohne Kenntnis von p oder q in vertretbarer Zeit

bestimmen.

22

M. Braack - Gruppen

Kapitel 3

Ringe

Mehr Struktur als eine Gruppe hat ein sogenannter Ring. Hierzu müssen allerdings

zwei Verknüpfungen definiert sein.

Definition 3.1 (Ring) Ein Ring (R, +, ·) besteht aus einer Menge R und zwei

Verknüpfungen + : R × R → R und · : R × R → R auf dieser Menge mit folgenden

Eigenschaften:

(a) (R, +) ist eine kommutative Gruppe.

(b) (R, ·) ist eine Halbgruppe.

(c) Es gelten die Distributivgesetze, d.h. ∀a, b, c ∈ R gilt:

a · (b + c) = (a · b) + (a · c) ,

(b + c) · a = (b · a) + (c · a) .

Gilt ferner das Kommutativgesetz für die Verknüpfung ·, so spricht man von einem

kommutativen Ring.

Wir haben hier einfach die Bezeichnungen + und · als Verknüpfungen gewählt,

obgleich dies zunächst nicht unbedingt die Addition bzw. Multiplikation sein muß. Es

wird sich aber als sehr praktikabel erweisen, diese Operationen stets mit “Addition”

und “Multiplikation” zu bezeichnen. Ferner bezeichnen wir im folgenden das neutrale

Element bzgl. + als 0 und das (additive) Inverse von a ∈ R als −a. Mit a − b

bezeichnen wir a + (−b) und mit ab den Ausdruck a · b. Desweiteren werden wir mit

R∗ im folgenden die Menge R \ {0} bezeichnen.

24

M. Braack - Ringe

Lemma 3.2 In einem Ring (R, +, ·) gilt für alle x ∈ R: x · 0 = 0. Existiert im Ring

die 1, so gilt außerdem:

(−1)x = −x, (−1)2 = 1, (−x)2 = x2 .

Beweis. (a) Zunächst folgt mit dem Distributivgesetz x·0 = x·(0+0) = x·0+x·0.

Demnach ist x · 0 das neutrale Element der Addition. Mit der Eindeutigkeit des

neutralen Elementes folgt x · 0 = 0.

(b): Mit dem Distributivgesetz und Aussage (a) folgt: (−1)x + x = (−1 + 1)x =

0 · x = 0. Also ist (−1)x das additive Inverse von x, d.h. (−1)x = −x.

(c): (−1)2 x = (−1)(−1)x = (−1)(−x) = −(−x) = x.

(d): Distributivgesetz und Aussage (a) liefern:

(−x)2 − x2 = (−x)(−x) − x2 = (−x)(−1)x − x2 = (−x(−1) − x)x

= (−x)(1 − 1)x = (−x)0x = 0.

3.1

Der Ring Zm

Wir hatten bereits gesehen, dass man auf den Äquivalenzklassen der Relation modulo

m ebenfalls eine Addition und eine Multiplikation definieren kann. Die Menge der

zugehörigen Restklassen wird mit Zm (oder auch Z/mZ) bezeichnet und bildet einen

Ring:

Lemma 3.3 Für m ∈ N bildet (Zm , ⊕, ) einen kommutativen Ring mit 1, d.h. es

existiert ein neutrales Element für die Multiplikation.

Beweis. Übungsaufgabe.

3.2

Polynomringe

Definition 3.4 (Polynom) Sei (R, +, ·) ein kommutativer Ring und ai , 0 ≤ i ≤ n,

n ∈ N0 endlich viele Elemente aus R. Dann versteht man unter einem Polynom

auf R eine Abbildung p : R → R gegeben durch

p(x) =

n

X

ai x i .

i=0

Ist an 6= 0, so heißt deg(p) = n Grad des Polynoms. Die ai ∈ R heißen Koeffizienten

des Polynoms und x ∈ R das jeweilige Argument.

3.2 Polynomringe

25

Den Grad des Nullpolynoms definiert man als negativ, d.h. deg(0) = −1. Ferner

gehen wir bei obiger Definition des Polynomgrads davon aus, dass die Darstellung

des Polynoms “minimal” ist: beispielsweise ist im Ring Z2 das Polynom p(x) = x2

identisch mit p(x) = x und besitzt daher den Polynomgrad deg(p) = 1.

Lemma 3.5 Sind p, q Polynome auf R , so sind auch p + q, pq definiert durch

(p + q)(x) = p(x) + q(x) ,

(p · q)(x) = p(x) · q(x)

Polynome auf R mit deg(p + q) ≤ max{deg(p), deg(q)} und deg(pq) ≤ deg(p) +

deg(q) .

Beweis. Dies sieht man indem man sich die Koeffizienten von p + q und pq

überlegt. Wenn p und q von der Form

m

X

p(x) =

i

ai x ,

q(x) =

i=0

n

X

bi x i

i=0

sind, so ist die Summe gegeben durch:

max{m,n}

X

(p + q)(x) =

(ai + bi )xi .

i=0

In dieser Darstellung ist ai = 0 für i > m und bj = 0 für j > n zu verstehen. Das

Produktpolynom lautet:

(pq)(x) =

m X

n

X

ai bj x

i=0 j=0

i+j

=

m+n

X

ck x k ,

k=0

mit Koeffizienten:

ck =

n

X

aj bk−j

0 ≤ k ≤ n + m.

j=0

Beispiel: Wir betrachten der einfach halber Polynome auf dem Ring (Q, +, ·):

1

p(x) = 2 + 3x + x2 ,

2

q(x) = −2 + x − x3 .

26

M. Braack - Ringe

Dann gilt:

1

(p + q)(x) = 4x + x2 − x3

2

1

1

(pq)(x) = −4 + (2 − 6)x + (3 − 1)x2 + (−2 + )x3 − 3x4 − x5 .

2

2

Übungsaufgabe: Man überlege sich ein Beispiel zweier Polynome p, q über einem Ring

R, so dass deg(pq) < deg(p) + deg(q).

Lemma 3.6 (Polynomring) Sei (R, +, ·) ein kommutativer Ring. Dann ist die

Menge der Polynome zusammen mit den Verknüpfungen + und · ein Unterring aller

Abbildungen R → R, der sogenannte Polynomring R[x]. Besitzt R ein Einselement

1, so ist besitzt auch R[x] ein Einselement, nämlich das Polynom p(x) = 1.

Beweis. Das vorherige Lemma besagt gerade, dass R[x] abgeschlossen bezüglich

der Addition und der Multiplikation ist. Die Assoziativgesetze für die Addition und

für die Multiplikation, sowie die Distributivgesetze folgen direkt aus denen in R. Es

bleibt zu zeigen, dass (R[x], +) eine Gruppe ist, dass also ein neutrales Polynom

und inverse Polynome für die Addition existieren. Das neutrales Polynom ist das

Nullpolynom p(x) = 0 und das Inverse zu p ∈ R[x] ist −p.

Kapitel 4

Körper

Definition 4.1 Ein kommutativer Ring (K, +, ·) heißt Körper, wenn (K ∗ , ·) eine

Gruppe ist.

Beispiele:

1. Q bildet zusammen mit + und · ein Körper.

2. Genauso ist (R, +, ·) ein Körper.

Lemma 4.2 (K, +, ·) ist genau dann ein Körper, wenn

(K1) (K, +, ·) ist ein kommutativer Ring.

(K2) Es gibt ein multiplikatives neutrales Element, d.h. es existiert 1 ∈ K mit 1·x =

x für alle x ∈ K ∗ := K \ {0}.

(K3) Für alle x ∈ K ∗ existiert ein multiplikatives Inverses.

Beweis. Es genügt nachzuweisen, dass (K ∗ , ·) nicht nur eine Halbgruppe, sondern

eine Gruppe ist, sofern (K1)-(K3) erfüllt sind. Dies ist aber trivial.

Lemma 4.3 In einem Körper (K, +, ·) gilt für x, y ∈ K mit xy = 0, dass x = 0

oder y = 0.

Beweis. Zunächst folgt mit dem Distributivgesetz x · 0 = x · (0 + 0) = x · 0 + x · 0.

Demnach ist x · 0 das neutrale Element der Addition, also x · 0 = 0. Für die zweite

Aussage nehmen wir an, dass xy = 0 und x 6= 0 gelte. Dann folgt mit der ersten

Aussage dieses Satzes:

0 = x−1 · 0 = x−1 (xy) = (x−1 x)y = 1 · y = y .

28

M. Braack - Körper

Man verwendet die Bezeichnung

xn := x

. . · x} .

| · .{z

n−mal

Satz 4.4 Für p ∈ N gilt: (Zp , ⊕, ) ist genau dann ein Körper, wenn p eine Primzahl ist.

Beweis. Wir wissen bereits nach Lemma 3.3, dass (Zp , ⊕, ) für beliebiges p ∈

N ein kommutativer Ring mit 1 ist. Ferner wissen wir wegen Satz 2.15, dass es

eindeutige Inverse gibt, wenn p prim ist.

Ist p hingegen keine Primzahl, so existieren q1 , q2 ∈ {2, 3, . . . , p−1} mit p = q1 q2 , also

[q1 ]p [q2 ]p = 0. Wäre nun (Zp , ⊕, ) ein Körper, so würde man mittels Lemma 4.3

einen Widerspruch erhalten.

Bemerkung: Dass Zp ein Körper ist, liefert die Rechtfertigung für Abschnitt die

Prüfziffern bei den ISBN Buchnummern.

Satz 4.5 (Kleiner Fermat’scher Satz) Sei p eine Primzahl und a ∈ Z∗ kein

Vielfaches von p. Dann gilt

ap−1 ≡ 1 mod p .

Beweis. Die Aussage folgt direkt aus dem Satz von Euler und der Tatsache

ϕ(p) = p − 1:

ap−1 = aϕ(p) ≡ 1 mod p .

Man kann es aber auch direkt beweisen: Die Restklassen [a]p , [2a]p , . . . , [(p − 1)a]p

müssen alle paarweise verschieden sein, denn wäre [ia]p = [ja]p für 1 ≤ i, j < p,

so wäre 0 = [(i − j)a]p = [i − j]p [a]p . Nach Lemma 4.3 folgt, dass [a]p = 0

oder [i − j]p = 0. Da nach Voraussetzung [a]p 6= 0 gilt, muß i = j sein. Damit

entsprechen die p − 1 Restklassen [a]p , [2a]p , . . . , [(p − 1)a]p gerade den Restklassen

[1]p , . . . , [p − 1]p . Es folgt für die Produkte:

p−1

Y

i=1

ai ≡

p−1

Y

i mod p .

i=1

bzw.

(p − 1)! ap−1 ≡ (p − 1)! mod p .

4.1 Angeordnete Körper

29

Da ggt((p − 1)!, p) = 1, können wir beide Seiten durch (p − 1)! teilen und erhalten

so die Behauptung.

Da jeder Körper K auch ein Ring ist, können wir auch den Polynomring K[x]

bilden. Dies werden wir im folgenden auch machen, wenn wir Polynome dividieren.

4.1

Angeordnete Körper

Definition 4.6 Ein Körper K heißt angeordnet, wenn es einen Positivbereich

P ⊂ K mit folgenden Eigenschaften gibt:

(A1) P, −P und {0} bilden eine Zerlegung von K.

(A2) Aus x, y ∈ P folgt x + y, xy ∈ P .

Die Elemente aus P heißen positiv, die aus −P negativ.

Hierbei ist −P := {x ∈ K : −x ∈ P }. Summen und Produkte positiver Elemente

sind also wieder positiv. Man beachte ferner, das die Bezeichnung “positiv” abhängt

von der Wahl des Positivbereichs P ; es mag i.a. mehrere Mengen geben, die (A1)

und (A2) erfüllen.

Definition 4.7 In einem angeordneten Körper K lassen sich folgende Ordnungsrelationen definieren:

x < y :⇐⇒ y − x ∈ P ,

x ≤ y :⇐⇒ (x < y) ∨ (x = y) ,

x > y :⇐⇒ y < x ,

x ≥ y :⇐⇒ y ≤ x .

Auch diese Relationen <, ≤, >, ≥ hängen also i.a. von der Wahl des Positivbereichs

P ab.

Lemma 4.8 In angeordneten Körpern K gilt:

(a) Für alle x, y ∈ K: (x < y) ∨ (y < x) ∨ (x = y)

(b) Die Relation < ist transitiv.

(c) Verträglichkeit mit +: Aus x1 < y1 und x2 < y2 folgt x1 + x2 < y1 + y2 .

30

M. Braack - Körper

(d) Verträglichkeit mit ·: (x < y) ∧ (z > 0) =⇒ xz < yz,

(x < y) ∧ (z < 0) =⇒ xz > yz .

(e) Übergang zum Inversen: x > 0 =⇒ −x < 0,

x < y =⇒ −x > −y ,

0 < x < y =⇒ 0 < y −1 < x−1 .

Beweis. Übungsaufgabe

Lemma 4.9 In angeordneten Körpern gilt x2 > 0 für alle x ∈ K ∗ . Insbesondere gilt

0 < 1.

Beweis. Ist x > 0, so gilt nach Anordnungsaxiom (A2) x2 > 0. Im Fall von

x < 0 ist −x > 0 und damit nach (A2) auch (−x)2 > 0. Da wir bereits (−x)2 = x2

in beliebigen Körpern gezeigt haben, folgt x2 > 0. Die zweite Aussage folgt nun

aufgrund von 0 < 12 = 1 · 1 = 1.

In einem angeordneten Körper wird man also niemals ein x finden mit x2 = −1.

Lemma 4.10 Jeder angeordnete Körper K enthält (bis auf Isomorphie) die rationalen Zahlen Q.

Beweis. Wir identifizieren die Zahl n ∈ N mit der n-fachen Addition des Einselementes in K: n = 1| + 1 +

{z. . . + 1}. Da die Addition abgeschlossen ist in K, folgt

n-mal

n ∈ K, und damit N ⊂ K. Diese Einbettung muss injektiv sein, da 1 < 1 + 1 <

1 + 1 + 1 < . . . < n. Da in einem Körper auch die additiven Inversen enthalten

sein müssen, folgt Z ⊂ K. Aufgrund der Existenz der multiplikativen Inversen folgt

Q ⊂ K.

4.2

Der Körper der reellen Zahlen

Definition 4.11 Sei K ein angeordnete Körper. Eine Teilmenge A ⊆ K heißt nach

oben beschränkt, wenn es eine obere Schranke M ∈ K gibt, d.h x ≤ M für alle

x ∈ A. Sie heißt nach unten beschränkt, wenn es eine untere Schranke m ∈ K

gibt, d.h. m ≤ x für alle x ∈ A. Eine obere Schranke heißt Supremum, wenn sie

die kleineste obere Schranke ist. Eine untere Schranke heißt Infimum, wenn sie die

größte untere Schranke ist.

Beispiele im Körper Q:

4.2 Der Körper der reellen Zahlen

31

• Die Menge Q+ ist nach unten, aber nicht nach oben beschränkt. Das Infimum

lautet 0.

• Die Menge Z ist in Q weder nach oben, noch nach unten beschränkt.

• A = {x ∈ Q 1 < x < 2} ist nach oben und nach unten beschränkt mit

Infimum m = 1 und Supremum M = 2.

• Die Menge

p

2

W =

x= ∈Q: x <2

q

ist nach oben durch z.B. 3 beschränkt, aber es gibt kein Supremum in Q.

Definition 4.12 Ein angeordnete Körper heißt vollständig, wenn in ihm jede nach

oben beschränkte Menge ein Supremum besitzt.

Beispiel: Die rationalen Zahlen Q sind zwar angeordnet aber nicht vollständig.

Dies zeigte die obige Beispielmenge W .

Der folgende Satz ist ein wenig aufwändiger zu beweisen, so dass wir im Rahmen

dieser Vorlesung auf den Beweis verzichten wollen.

Satz 4.13 Es gibt (bis auf Isomorphie) genau einen angeordneten vollständigen

Körper. Dieser wird Körper der reellen Zahlen R genannt.

Die reellen Zahlen sind eine Obermenge der rationalen Zahlen, aber sie ist sehr

√

√

viel “reichhaltiger”. Beispielsweise sind auch die Zahlen 2, − 2 und π reelle Zahlen. Diese drei Zahlen lassen sich nicht in Form von Dezimalzahlen mit endlich vielen

Stellen darstellen. Auch werden die Nachkommastellen nicht notwendigerweise periodisch, wie etwa 17 = 0.14 285714 285714 285714 . . .

Im folgenden wird uns das folgende Lemma noch sehr nützlich sein:

Lemma 4.14 Zu jedem x ∈ R, x > 0, gibt es ein n ∈ N mit 0 <

Beweis. Mit 0 < x ist auch 0 <

0 < 1 < nx bzw. 0 < n1 < x.

1

.

x

Wir wählen n ∈ N mit:

1

n

< x.

1

x

< n. Es folgt

32

4.2.1

M. Braack - Körper

Darstellung reeller Zahlen

Streng genommen können Zahlen aus R \ Q gar nicht exakt mit dem Rechner dargestellt werden. Sie können allerdings approximiert (d.h. näherungsweise dargestellt)

werden. Insofern wird eine reelle Zahle x in der Informatik durch eine rationale Zahl

q ∈ Q mit einer vorgegebenen Anzahl von Nachkommastellen angenähert. Üblicherweise werden hierzu Darstellungen der Form

Vorzeichen, Mantisse, Exponent

(4.1)

gewählt. Hierbei bezeichnet “Vorzeichen” das Vorzeichen der Zahl. Hierzu ist nur

ein Bit notwendig. Die “Mantisse” bezeichnet die führenden Dezimalstellen. In Java

sind bei dem Datentyp float hierfür 23 Bit vorgesehen. Der “Exponent” stellt den

Exponenten zur Basis 2 dar. Hierfür sind für float 8 Bit vorgesehen, also Zahlen

von −126 bis +127. Insgesamt werden also 32 Bit, bzw. 4 Byte benötigt.

Beispiele: Die Zahl q = 2/3 wird mit 8-stelliger Mantisse und 2-stelligem Exponenten approximativ dargestellt durch 6.6666667E − 01. Die reelle Zahl π hingegen

durch 3.1415926E + 00.

4.3

Der Körper der komplexen Zahlen

Wir werden jetzt den Körper der reellen Zahlen weiter vergrößern, um auch Aus√

drücke wie −1 zu erhalten. Diese Erweiterung soll wieder zu einem Körper führen.

Nach Satz 4.13 wird der resultierende Körper aber nicht mehr angeordnet sein. Da

√

auf der Zahlengeraden R kein Platz für −1 ist, geht man in die zweite Dimension:

C := R2 = {(a, b) : a, b ∈ R} .

Die reellen Zahlen R sollen hierin eingebettet sein:

R ∼

= {(a, 0) : a ∈ R} ⊂ C .

Hierbei bedeutet ∼

= “isomorph”, d.h. es gibt eine bijektive Abbildung zwischen den

beiden Mengen, die Verträglich ist mit den Verknüpfungen + und ·. Nun wollen wir

noch die Addition und Multiplikation auf C so definieren, dass (C, +, ·) wieder ein

Körper ist und eingeschränkt auf R die gewöhnlichen Operationen + und · darstellt.

Diese Operationen lauten auf C:

(x1 , y1 ) + (x2 , y2 ) := (x1 + x2 , y1 + y2 )

(x1 , y1 ) · (x2 , y2 ) := (x1 x2 − y1 y2 , x1 y2 + x2 y1 ) .

4.3 Der Körper der komplexen Zahlen

33

Die Addition ist hierbei sicherlich sofort verständlich. Die Multiplikation wirkt hingegen zunächst sehr konstruiert. Doch zunächst wollen wir verifizieren, ob diese

Operationen mit denen in R wohldefiniert sind:

(a, 0) + (b, 0) = (a + b, 0) ,

(a, 0) · (b, 0) = (ab − 0 · 0, a · 0 + b · 0) = (ab, 0) .

Somit sind die Operationen miteinander verträglich: Wenn wir zwei reelle Zahlen a, b

als komplexe Zahlen interpretieren und dann die komplexen Operationen ausführen,

erhalten wir das gleiche wie durch die reellen Operationen. Als praktikabel wird sich

zudem der Betrag einer komplexen Zahl herausstellen:

√

a2 + b 2

|(a, b)| :=

Satz 4.15 (C, +, ·) ist ein Körper.

Beweis. Es sind mehrere Dinge zu zeigen:

(i): (C, +) ist eine abelsche Gruppe mit neutralem Element (0, 0) und Inversen

(−a, −b) zu (a, b) ∈ C.

(ii): (C∗ , ·) ist eine abelsche Gruppe mit neutralem Element (1, 0). Das multiplikative

Inverse von (a, b) ∈ C∗ lautet:

a b

,−

c c

mit c = |(a, b)|2 = a2 + b2 > 0. Dies sieht man wie folgt:

2

a b

b(−b) a(−b) ba

a

(a, b)

,−

=

−

,

+

= (1, 0) .

c c

c

c

c

c

(iii): Auch die Distributivgestze sind einfach nachzuvollziehen.

Auch hier sollte man sich vergewissern, ob das multiplikative Inverse verträglich ist

mit dem in R (Übungsaufgabe).

Lemma 4.16 Im Körper der komplexen Zahlen lässt sich die Quadratwurzel aus

√

−1 ziehen. Das Ergebnis wird die imaginäre Einheit i = −1 = (0, 1) ∈ C genannt.

Beweis. Man prüft einfach nach:

i2 = (0, 1) · (0, 1) = (0 · 0 − 1 · 1, 0 · 1 + 1 · 0) = (−1, 0)

Da (−1, 0) der reellen Zahl −1 entspricht, folgt i2 = −1.

34

M. Braack - Körper

Dieses Lemma läßt uns die komplexen Zahlen auch auf anderer Art darstellen:

a + ib := (a, b) .

Diese Darstellung ist insbesondere für die Addition und Multiplikation sehr suggestiv:

(a + ib) · (c + id) = ac + ibc + aid + ibid

= ac − bd + i(ad + bc)

= (a, b) · (c, d) .

Definition 4.17 Daher nennt man bei z = a + ib ∈ C den Anteil a auch Realteil

und den Anteil b Imaginärteil:

Re(a + ib) = a ,

Im(a + ib) = b .

Lemma 4.18 Für die Betragsfunktion gilt mit z1 , z2 ∈ C:

(a) Dreiecksungleichung: |z1 + z2 | ≤ |z1 | + |z2 |.

(b) |z1 z2 | = |z1 | · |z2 |

Beweis. Wir beweisen lediglich (a) während wir (b) als Übungsaufgabe lassen.

Da die Terme auf beiden Seiten von (a) positiv sind, reicht es zu zeigen:

|z1 + z2 |2 ≤ (|z1 | + |z2 |)2 .

Mit der Darstellung z1 = a + ib und z2 = c + id erhält man dann durch Subtraktion

von a2 + b2 + c2 + d2 , dass die Ungleichung äquivalent ist mit:

p

ac + bd ≤

(a2 + b2 )(c2 + d2 ) .

Nun könen wir nochmals das Quadrat auf beiden Seiten bilden und erhalten nach

weiterem subtrahieren von identischen Termen:

2acbd ≤ a2 d2 + b2 c2 .

Dies ist aber wiederum äquivalent mit:

0 ≤ a2 d2 − 2acbd + b2 c2 = (ad − bc)2

Da diese Ungleichung wahr ist, haben wir die Dreiecksungleichung bewiesen.

4.4 Polynomdivision

35

Definition 4.19 Unter der zu z = x + iy ∈ C, (x, y ∈ R), konjugierten Zahl z̄

versteht man z := x − iy ∈ C.

Lemma 4.20 Es gilt z1 + z2 = z1 + z2 , z1 z2 = z1 · z2 und |z|2 = zz.

Beweis. Übungsaufgabe.

Insbesondere ist also das Produkt einer komplexen Zahl z mit ihrem konjugiert

komplexen z immer reell: zz ∈ R.

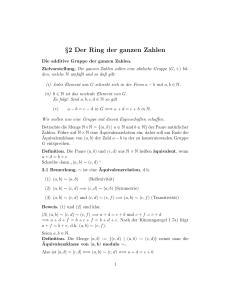

4.3.1

Graphische Darstellung der komplexen Zahlen

Die komplexen Zahlen können als “Vektoren” der komplexen Ebene dargestellt werden, siehe Abb. 4.1. Der Realteil Re(z) von z ∈ C ist dann gerade die Projektion

auf die waagerechte Koordinatenachse, der Imaginärteil Im(z) die Projektion auf

die senkrechte Achse.

Im(z)

z

Re(z)

z

Abbildung 4.1: Der Real- und Imaginärteil einer komplexen Zahl z ergeben sich als

Projektion auf die Koordinatenachsen. Die konjugierte Zahl z̄ erhält man mittels

Spiegelung an der reellen Achse.

4.4

Polynomdivision

Analog zum Euklidischen Algorithmus zur Division von ganzen Zahlen lassen sich

auch Polynome dividieren.

36

M. Braack - Körper

Satz 4.21 (Polynomdivision) Sei K ein Körper. Dann kann man im Polynomring K[x] die Division mit Rest durchführen, d.h.:

∀p, q ∈ K[x], q 6= 0 ∃s, r ∈ K[x], deg(r) < deg(q) :

p = sq + r .

Beweis. Den Beweis führen wir per vollständiger Induktion nach dem Polynomgrad n = deg(p) ≥ 0:

Induktionsverankerung: Zunächst behandeln wir den einfachen Fall, dass p ein konstantes Polynom ist, also n = 0. Sollte auch q ein konstantes Polynom sein, so

wählen wir einfach das konstante Polynom s = p/q. Dann gilt p = sq. Sollte hingegen deg(q) ≥ 1, so leisten s ≡ 0 und r = p das Gewünschte.

Der Induktionsschritt geht nun von m ≤ n nach n + 1: Wir gehen von folgender

Form von p und q aus:

p(x) =

n+1

X

i

ai x ,

q(x) =

i=0

m

X

b i xi ,

i=0

mit bm 6= 0, an+1 6= 0. Im Fall m > n + 1 wählen wir einfach wieder s ≡ 0 und r = p.

Im Fall m ≤ n + 1 setzen wir s1 = abn+1

xn+1−m ∈ K[x]. Nun gilt:

m

r1 := p − s1 q

n

m

X

an+1 X n+1−m+i

i

=

ai x −

bi x

bm i=0

i=0

=

n+1

X

i

ai x − an+1 x

i=0

n

X

n+1

m−1

an+1 X n+1−m+i

−

bi x

bm i=0

m−1

an+1 X n+1−m+i

=

ai x +

bi x

.

b

m

i=0

|i=0{z } |

{z

}

Grad≤n

i

Grad≤n+1−m+m−1=n

Es existieren also r1 , s1 ∈ K[x] mit p = s1 q + r1 und

deg(r1 ) ≤ n .

Nach Induktionsannahme existieren nun s2 , r ∈ K[x] mit deg(r) < deg(q) so dass

r1 = s2 q + r. Es folgt insgesamt

p = s1 q + s2 q + r = (s1 + s2 )q + r .

Setzen wir s = s1 + s2 erhalten wir die geforderte Polynomdivision.

Im Beweis sehen wir, dass wir multiplikative Inverse b−1

m bilden müssen. Daher muss

K ein Körper sein. Ein Ring reicht dafür i.a. nicht aus.

Beispiele:

4.4 Polynomdivision

37

1. Wir wollen diese Polynomdivision einmal an einem konkreten Beispiel durchführen:

(x4 + 2x2 − 1) : (2x2 + x) = 0.5 x2

− [x4 + 0.5 x3 ]

−0.5 x3 + 2x2 − 1

−0.25 x

=

− [−0.5 x3 − 0.25 x2 ]

2.25 x2 − 1

=

1.125

2

− [2.25 x + 1.125x]

−1.125x − 1

Damit erhalten wir

4

2

2

x

+ x) (0.5 x2 − 0.25 x + 1.125) + (−1.125x − 1)

| + 2x

{z − 1} = (2x

| {z } |

{z

} |

{z

}

p(x)

s(x)

q(x)

r(x)

2. Die Polynomdivision ist in jedem Körper möglich. Wenn wir das Polynom

p(x) = 2x2 + 4x − 1 beispielsweise in Z5 durch q(x) = x + 4 teilen wollen,

erhalten wir:

In Z5 :

(2x2 + 4x − 1) : (x + 4) = 2x

−[2x2 + 3x]

x−1 =

1

−[x + 4]

0

In diesem Fall läßt sich das Polynom also sogar ohne Rest teilen:

In Z5 :

In Z5 :

(2x2 + 4x − 1) : (x + 4) = 2x + 1

2x2 + 4x − 1 = (x + 4)(2x + 1)

Das Polynom verschwindet also in Z5 an den Stellen x0 = 1 und x1 = 2:

x0 + 4 ≡ 0 mod 5,

2x1 + 1 ≡ 0 mod 5.

Definition 4.22 Unter einer Nullstelle eines Polynoms p ∈ K[x] versteht man

ein x0 ∈ K für das das Polynom verschwindet, also p(x0 ) = 0 gilt.

38

M. Braack - Körper

Das folgende Lemma macht eine Aussage über die Polynome mit einer Nullstelle.

Lemma 4.23 Hat p ∈ K[x] eine Nullstelle in x0 ∈ K so existiert ein s ∈ K[x] mit

p(x) = (x − x0 )s(x) für alle x ∈ K.

Beweis. Wir setzen q(x) = x − x0 und wenden Satz 4.21 an. Dieser liefert

p(x) = (x − x0 ) · s(x) + r(x) ,

mit einem Polynom r vom Grad deg(r) < deg(q) = 1. Also besteht r aus einer

konstanten Funktion r(x) = r0 . Da ferner 0 = p(x0 ) = (x0 − x0 ) · s(x0 ) + r0 = r0

gilt, verschwindet r.

Dieses Lemma besagt also, dass man für jede Nullstelle x0 den Linearfaktor

(x − x0 ) ohne Rest von dem Polynom abspalten kann. Es ist aber noch nicht gesagt,

ob überhaupt solche Nullstellen existieren. Im Fall des Körpers C kann man hingegen

die Existenz von n = deg(p) Nullstellen beweisen. Hiermit beschäftigen wir uns im

folgenden Abschnitt.

4.5

Polynome in C

Satz 4.24 Jedes Polynom p ∈ C[x] vom Grad deg(p) ≥ 1 hat (mindestens) eine

Nullstelle in C.

Beweis. Da der Beweis dieser Aussage relativ aufwändig ist, werden wir in diesem

Rahmen keinen Beweis angeben. Diese Aussage wurde erstmalig von C.F. Gauß im

Jahr 1799 bewiesen. Der heute am meisten verbreitete Beweis benutzt Techniken

aus der Funktionentheorie. Das ist die Theorie von Funktionen in C. Es gibt aber

noch eine ganze Reihe anderer Beweise, die aber alle den Rahmen dieser Vorlesung

sprengen würden.

Satz 4.25 (Fundamentalsatz der Algebra) Sei p ∈ C[x] ein Polynom vom Grad

P

n ∈ N, also p(z) = ni=0 ai z i mit an 6= 0. Dann gilt:

(i) p hat genau n Nullstellen z1 , . . . , zn ∈ C (Vielfachheiten mitgezählt),

(ii) p zerfällt in n Linearfaktoren, d.h

n

Y

p(z) = an (z − zi ) .

i=1

4.6 Polynome in R

39

Beweis. Auch hier verwenden wir als Beweisprinzip die vollständige Induktion

nach n = deg(p). Für n = 1 ist z1 := −a0 /a1 eine Nullstelle und p(z) = a1 (z +a0 /a1 )

die geforderte Faktorisierung in Linearfaktoren. Ferner ist z1 die einzige Nullstelle,

denn wäre z2 eine weitere Nullstelle, so würde folgen:

0 = p(z2 ) = a1 (z2 − z1 ) .

Da C ein Körper ist, würde mit Lemma 4.3 folgen: a1 = 0 oder z1 = z2 , was beides

zu einem Widerspruch führt. Für den Induktionsschritt n − 1 → n benutzen wir

Satz 4.24. Dieser liefert uns die Existenz mindestens einer Nullstelle zn ∈ C. Lemma

4.23 gibt uns die Faktorisierung:

p(z) = (z − zn )q(z)

mit q ∈ C[x]. Ein Koeffizientenvergleich liefert deg(q) = n − 1, und der führende

Koeffizient von q ist der gleiche wie der von p, also gerade an . Nach Induktionsannahme zerfällt q in n − 1 Linearfaktoren mit Vorfaktor an . Hierdurch erhält man die

Behauptung.

Beispiel: Das Polynom p(z) = 2z 3 − 2iz 2 + 2z − 2i hat die Nullstellen z1 = z2 = i,

z3 = −i und die Darstellung

p(z) = 2(z − i)2 (z + i) .

Hier ist allerdings noch nicht gesagt, wie man diese Nullstellen erhält. Dies werden

wir in einem späteren Kapitel behandeln.

4.6

Polynome in R

Bei Polynomen in R läßt sich generell keine Aussage über die Anzahl der reellen

Nullstellen treffen. Wir wollen jedoch ein Resultat vorweg nehmen, dass wir später

in einem sehr viel allgemeineren Kontext beweisen werden.

Lemma 4.26 Sei p ∈ R[x] ein Polynom mit p(a) · p(b) < 0 für zwei reelle Zahlen

a < b. Dann besitzt p (mindestens) eine Nullstelle im offenen Intervall (a, b).

Beweis. Wie gesagt werden wir den Beweis später führen und zwar allgemein für

“stetige” Funktionen. Allerdings sei hier angemerkt, dass die Voraussetzung p(a) ·

p(b) < 0 impliziert, dass p(a) und p(b) ungleich Null sind und entgegengesetztes

Vorzeichen besitzen. Hierdurch ist auch anschaulich klar, dass der Graph von p die

40

M. Braack - Körper

Nulllinie (x-Achse) zwischen x = a und x = b mindestens einmal schneiden muss.

Dies korrespondiert dann gerade mit einer Nullstelle.

Insbesondere haben somit Polynome mit ungeradem Grad mindestens eine reelle

Nullstelle.

4.6.1

Intervallhalbierungsverfahren

Dieses Resultat liefert uns aber auch einen Algorithmus, Nullstellen von Polynomen

unter gewissen Voraussetzungen zu finden. Wir nehmen an, die Voraussetzungen des

Lemmas seien erfüllt. Dann liegt also in I1 := (a, b) mindestens eine Nullstelle von

p. Nun halbieren wir das Intervall und erhalten die beiden Teilintervalle (a, c) und

(c, b) mit c = (a + b)/2. Nun könen drei Fälle eintreten: p(c) = 0, p(a) · p(c) < 0

oder p(c) · p(b) < 0. Im ersten Fall sind wir fertig. Im zweiten Fall wählen wir

I2 = (a, c), sonst I2 = (c, b). Nun wiederholen wir das ganze mit I2 , also teilen

und Fälle unterscheiden. Wir nähern uns so immer näher einer Nullstelle, denn die

Intervalllänge der In halbiert sich sukzessive.

Exakt treffen wir die Nullstelle im allgemeinen aber nicht. Wir generieren daher

nur sogenannte approximative Lösungen, indem wir als Näherungslösung z.B. den

Mittelpunkt xn des Intervalls In wählen. Wir haben dann automatisch eine Fehlerabschätzung:

|xn − x∗ | <

1

(b − a) ,

2n

wobei x∗ eine (exakte) Nullstelle von p bezeichnet.

4.7

Polynomdivision zur Datensicherung

Zur Datensicherung werden i.d.R. Prüfbits an die zu übermittelnden Daten herangehängt. Wie bei der ISBN Nummer geben diese Aufschluß über einen etwaige

Datenübertragungsfehler. Die Prüfbits können beispielsweise per Polynomdivision

erhalten werden. Angenommen wir wollen n Prüfbits zur Kontrolle “opfern”. Eine

Nachricht in Bitreihenfolge w ∈ Z2 codiert soll also um n Bits verlängert werden:

eigentliche Daten der Länge m | n Prüfbits

Das verlängerte Wort nennen wir W . Dieses wird also übermittelt.

Für die Erzeugung der Prüfbits wird ein fest gewähltes (sogenanntes) Generatorpolynoms g ∈ Z2 [x] mit n = deg(g) benutzt. Der Algorithmus um das Wort w

zu senden verläuft wie folgt:

4.7 Polynomdivision zur Datensicherung

41

1. Das Wort w wird als Polynom f ∈ Z2 interpretiert und um den Faktor xn

erweitert: p(x) = xn f (x). Das Polynom p ∈ Z2 [x] entspricht dem w erweitert

um n Nullen (den Stellen für die Prüfbits).

2. Teile p durch g:

p(x) = q(x)g(x) + r(x) .

Das Restpolynom r ∈ Z2 [x] hat den Grad deg(r) < n. Wir bilden das Polynom

P := p − r = qg. Hier sei noch angemerkt, dass in Z2 [x] gilt r = −r. Daher

folgt insgesamt:

P = p + r = qg .

Da p in den letzten n Stellen nur Nullen besitzt, entspricht das Polynom P dem

um n Bits erweiterten Wort w. Diese hinzugefügten Bits entsprechen gerade

dem Rest r.

3. Wir interpretieren jetzt P wieder zurück als eine Bitkombination W ∈ Z2 und

übertragen dieses Wort.

4. Bei dem Empfänger kommt W an. Er interpretiert dies als ein Polynom P

und dividiert dies durch g. Wenn kein Fehler vorliegt gilt P = qg, es bildet

sich also kein Rest. Liegt hingegen ein Übertragungsfehler vor, so bildet sich

(wahrscheinlich) ein Rest.

Beispiel: Wir wollen das in Bitreihenfolge kodierte Wort w = 10110 übermitteln und

prüfen.

f (x) = x4 + x2 + x,

g(x) = x3 + 1

p(x) = x7 + x5 + x4

x7 + x5 + x4 = (x4 + x2 )(x3 + 1) + x2

5

4

P (x) = |x7 + x

x2 = x7 + x5 + x4 +x2

{z + x} − |{z}

p(x)

(in Z2 )

r(x)

W = 10110 100

Bemerkung: In der Praxis sind die zu übertragenden Worte natürlich länger. Bei dem

weit verbreiteten Datenübertragungsprotokoll X.25 beträgt die gesamte Datenlänge

4096 Byte = 215 Bit. Hierbei werden 2 Byte als Prüfbytes verwendet, also gerade

mal 0.5 Promille. Erkannt werden hierdurch alle Bitfehler mit ungerader Anzahl,

42

M. Braack - Körper

sowie 2-Bit Fehler. Das Generatorpolynom lautet g(x) = x16 + x12 + x5 + 1. Das

Polynom p hat den Grad 32767 = 215 − 1:

Gesamte Wortlänge W

davon Wortlänge w

Prüfbitlänge b

4.8

215 Bit= 212 Byte

215 − 24 Bit= 212 − 2 Byte

n = deg(p) = 24 = 16 Bit= 2 Byte.

Horner-Schema

Zur (numerischen) Auswertung von Polynomen wird sinnvollerweise das Horner

Schema verwendet, da hierdurch die Anzahl der mathematischen Operationen (Addition und Multiplikation) im Gegensatz zur Standard-Darstellung

p(x) =

n

X

ai x i

(4.2)

i=0

verringert wird. Zunächst wollen wir die Anzahl der notwendigen Operationen auf

Basis der Darstellung (4.2) ermitteln:

• Der Ansatz (4.2) verlangt n Additionen und 1+2+. . .+(n+1) = (n+1)(n+2)/2

Multiplikationen. Also insgesamt (n2 + 5n + 2)/2 Operationen.

• Selbstverständlich ist dies die naivste Art, denn die Ausdrücke xk kann man

zwischenspeichern und wiederverwenden. In diesem Fall reduziert sich die Anzahl an Multiplikationen auf 1 + 2 + 2 + . . . + 2 = 2n − 1. Man kommt dann

auf insgesamt 3n − 1 Operationen.

Alternativ hierzu werden wir nun den Faktor x sukzessives ausklammern:

p(x) = a0 + x(a1 + a2 x + a3 x2 + . . . + an xn−1 )