Künstliche neuronale Netze

Werbung

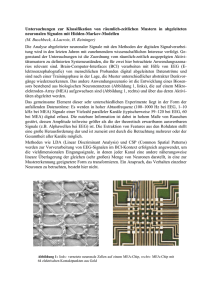

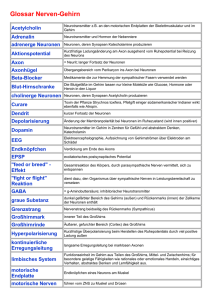

Künstliche neuronale Netze Eigenschaften neuronaler Netze: I hohe Arbeitsgeschwindigkeit durch Parallelität, I Funktionsfähigkeit auch nach Ausfall von Teilen des Netzes, I Lernfähigkeit, I Möglichkeit zur Generalisierung I keine Begründung der Ergebnisse Anwendungen: I Klassifikation I Mustererkennung, z.B. Bild- und Spracherkennung I Funktions-Approximation I Modellierung zeitlicher Verläufe I Assoziation I Clustering (Zuordnung von Mustern zu Bündeln) 133 Lernverfahren I überwachtes Lernen Trainingsmenge enthält Paare (Muster, Ausgabevektor) (partielle Funktion, Werte an Stützstellen) Trainingsziel: Funktion, die an den Stützstellen mit der Trainingsmenge übereinstimmt I bestärkendes Lernen Trainingsmenge enthält Muster Schüler erfährt nach jedem Lernschritt, ob Ausgabe korrekt ist. Trainingsziel: Funktion, die an den Stützstellen die korrekte Ausgabe erzeugt I Wettbewerbslernen (unüberwachtes Lernen) Trainingsmenge enthält nur Muster Trainingsziel: I I Gruppierung ähnliche Muster oft auch topologisch sinnvolle Anordnung 134 Typen künstlicher Neuronen I McCulloch-Pitts-Neuron: I I I I I I R Schwellwertelemente I I I I Ein- und Ausgabe: Boolesche Vektoren keine Kantengewichte Schwellwert θ ∈ erregende und hemmende Eingänge Aktivierung durch Stufenfunktion Ein- und Ausgabe: Boolesche Vektoren Kantengewichte und Schwellwert ∈ Aktivierung durch Stufenfunktion R Neuronen mit reeller Ein- und Ausgabe I I I Ein- und Ausgabe: Reelle Vektoren Kantengewichte und Schwellwert ∈ Aktivierung durch lineare, sigmoide oder Stufenfunktion R alle mit gewichteter Summe als Eingabefunktion und Identität als Ausgabefunktion 135 Typen künstlicher neuronaler Netze I Feed-Forward-Netze I I I I RBF-Netze Netze mit Rückkopplung I I I Elman-Netz Jordan-Netz Assoziativspeicher I I I Ein-Schicht-FFN Mehr-Schicht-FFN BAM Hopfield-Netz Selbstorganisierende Karten Funktionsweise aller Netztypen in zwei Phasen: 1. Trainingsphase: (Anpassung / Lernen durch Änderung der Kantengegewichte anhand gegebener Trainingsmuster) 2. Ausführungsphase (Reproduktion): Berechnung der Ausgaben zu beliebigen Mustern 136 Ein-Schicht-FFN I Topologie: I I I I Eingabeschicht Ausgabeschicht teilweise vorwärts verbunden Kantengewichte repräsentieren Stärke eingehender Signale Gewichtsmatrix I McCulloch-Pitts-Neuronen, Schwellwertelemente oder Neuronen mit reellen Ein- und Ausgängen und Aktivierung durch lineare, sigmoide oder Stufenfunktion. I Training (überwachtes Lernen): ∆-Regel wij0 = wij + ηxi (tj − yj ) Anwendungen: I Klassifikation in linear trennbare Klassen I lineare Approximation 137 Mehr-Schicht-FFN I Topologie: I I I I I Eingabeschicht eine oder mehrere versteckte Schichten Ausgabeschicht teilweise vorwärts zwischen benachbarten Schichten verbunden Kantengewichte repräsentieren Stärke eingehender Signale Gewichtsmatrix mit Blockstruktur I Neuronen mit reellen Ein- und Ausgängen und Aktivierung durch lineare oder sigmoide Funktion. I Training (überwachtes Lernen): Backpropagation-Regel wij0 = wij + ηδj xi (mir Fehlertermen δj ) Anwendungen: I Muster-Klassifikation I Funktions-Approximation 138 RBF-Netze I Topologie: Zwei-Schicht-FFN Eingabeschicht, eine versteckte Schicht, Ausgabeschicht I Neuronen der versteckten Schicht: Eingabefunktion: Skalarprodukt (Abstand) mit Vektor der eingehenden Gewichte (eingehende Kantengewichte repräsentieren RBF-Zentren) Aktivierungsfunktion: RBF-Funktion (z.B. Zylinder-, Kegel- oder Glockenfunktion) Ausgabefunktion: Identität Training mit Clustering-Techniken (z.B. wie SOM) I Neuronen der Ausgabeschicht: Schwellwertelemente oder Neuronen mit reellen Ein- und Ausgängen und Aktivierung durch lineare oder Stufenfunktion. (eingehende Kantengewichte repräsentieren Stärke eingehender Signale) Training (überwachtes Lernen) mit ∆-Regel Anwendungen: Muster-Klassifikation, Funktions-Approximation (durch gewichtete Summe von RBF) 139 Netze mit Rückkopplung Idee: Rückkopplung als Kurzzeitgedächtnis Topologie: Ein- oder Mehrschicht-FFN mit zusätzlichen Rückwärtskanten zwischen verschiedenen Schichten (oft zur Eingabeschicht) häufig zusätzliche Neuronen (Kontextneuronen) in Eingabeoder versteckten Schichten Kantengewichte repräsentieren Stärke eingehender Signale I Neuronen mit reellen Ein- und Ausgängen und Aktivierung durch lineare oder sigmoide Funktion. I Training (unüberwachtes Lernen): Backpropagation-Regel (nur für Vorwärtskanten) I I Jordan-Netz: zu jedem Ausgabeneuron ein Kontextneuron in der Eingabeschicht Elman-Netz: zu jedem versteckten Neuron ein Kontextneuron in der vorigen versteckten bzw. Eingabeschicht Anwendungen: I I Klassifikation von Mustern variabler Länge Modellierung zeitlicher Verläufe 140 Bidirektionaler Assoziativspeicher I Topologie: I I I I I I Eingabeschicht Ausgabeschicht vollständige symmetrische Verbindungen zwischen Neuronen verschiedener Schichten, keine Verbindung innerhalb einer Schicht Kantengewichte repräsentieren Stärke eingehender Signale Neuronen mit bipolaren Ein- und Ausgängen und Aktivierung durch Signumfunktion (modifizierte Schwellwertelemente). Training (unüberwachtes Lernen): I I Hebb-Regel wij0 = wij + ηxi yj oder direkte Berechnung (Matrixoperationen) Anwendungen: I Zuordnungen zwischen verschiedenen Mustermengen I Mustererkennung, -rekonstruktion 141 Hopfield-Netz I Topologie: I I I nur eine Schicht von Neuronen (Eingabeschicht) vollständige symmetrische Verbindungen zwischen allen Neuronen, keine Selbstrückkopplung Kantengewichte repräsentieren Stärke eingehender Signale I Neuronen mit bipolaren Ein- und Ausgängen und Aktivierung durch Signumfunktion (modifizierte Schwellwertelemente). I Asynchrone Neuberechnung der Neuronen-Aktivierung Training (überwachtes Lernen): I I I Hebb-Regel oder direkte Berechnung (Matrixoperationen) Anwendungen: I Rekonstruktion unscharfer und unvollständiger Muster I Lösen von Optimierungsproblemen (z.B. TSP) 142 Selbstorganisierende Karten (SOM) I Topologie: Ein-Schicht-FFN vollständig vorwärts zwischen beiden Schichten verbunden Kantengewichte repräsentieren Bündelzentren I Neuronen der Ausgabeschicht: Eingabefunktion: Skalarprodukt (Abstand) mit Vektor der eingehenden Gewichte (Bündelzentren) Aktivierungsfunktion: (Wettbewerb) nur Neuron mit dem kleinsten Eingabewert 1, alle anderen 0 Ausgabefunktion: Identität I Training (unüberwachtes Lernen): schrittweise Verschiebung der Bündelzentren (und evtl. ihrer Nachbarn) in Richtung der dem Bündel neu zugeordneten Trainingsmuster Anwendungen: I Clustering: Bündeln von Mustern nach unbekannten Gemeinsamkeiten I topologieerhaltende Abbildung (oft auf kleinere Dimension) 143