Vorlesung Wahrscheinlichkeitsrechnung und mathematische Statis

Werbung

Vorlesung Wahrscheinlichkeitsrechnung und mathematische Statistik

für Ingenieure

Lesender: Prof. Dr. H.-U. Küenle

Wintersemester 99/00

1. Zufall und Wahrscheinlichkeit

1.1. Einleitende Bemerkungen

Auf Schritt und Tritt werden wir im täglichen Leben mit dem Zufall konfrontiert. Man spricht

von einem zufälligen Ereignis, wenn dieses Ereignis eintreten kann, aber nicht eintreten muß.

So sind die Ereignisse

"am 30. Oktober 2000 regnet es in Cottbus",

"Herr M.M. wird älter als 80 Jahre",

"Der Wasserstand der Elbe übersteigt in Dresden in den nächsten 10 Jahren eine bestimmte

Marke nicht",

"Kaiserslautern gewinnt das nächste Fußballspiel gegen München"

oder

"Bei der nächsten Lottoziehung werden die Zahlen 7,10,14,15, 23 gezogen"

in diesem Sinne zufällige Ereignisse.

Dabei spielen auch zufällige Daten eine große Rolle. Solche zufällige Daten können z.B. sein:

Die Niederschlagsmenge an einem bestimmten Tag, die Wasserstände der Elbe in Dresden, das

Ergebnis eines Fußballspiels, die Augensumme beim Werfen zweier Würfel usw. Vielfach ist

man geneigt, die Zufälligkeit von Daten zu ignorieren. Das kann aber erfahrungsgemäß zu

schwerwiegenden Irrtümern führen. Angenommen, es soll ein Hochwasserschutzdeich gebaut

werden. Sollte man als Höhe das Maximum der Wasserstände der letzten 50 Jahre nehmen?

Oder 10 % mehr? Oder 20 % mehr? Es wird wohl hier deutlich, wie wichtig es ist, sich mit den

Gesetzmäßigkeiten des Zufalls zu befassen. Solche Gesetzmäßigkeiten fallen vor allem im Zusammenhang mit Massenerscheinungen auf. Dabei ist die mathematische Theorie, die sich mit

diesen Gesetzmäßigkeiten beschäftigt, die Wahrscheinlichkeitsrechnung, während sich die

mathematische Statistik auf der Grundlage der Wahrscheinlichkeitsrechnung mit der Analyse

zufälliger Daten befaßt.

Neben den Lebensversicherungen waren es vor allem die Glücksspiele, die am Anfang der

Entwicklung der Wahrscheinlichkeitsrechnung standen.

So gilt als Ausgangspunkt der Wahrscheinlichkeitsrechnung ein Briefwechsel zwischen P.

FERMAT (1601-1665) und B. PASCAL (1632-1662), dessen Anlaß Fragen waren, die der

Glücksspieler CHEVALIER

DE

MERÉ an PASCAL gerichtet hatte. Obwohl sich in der Ver-

gangenheit viele berühmte Mathematiker mit der Wahrscheinlichkeitsrechnung beschäftigten,

so dauerte es doch bis in die erste Hälfte dieses Jahrhunderts, bis sie zu einer exakten mathematischen Disziplin wurde. Große Verdienste hat sich in diesem Zusammenhang vor allem

A.N. KOLMOGOROV (1903-1987) erworben, dessen Axiomensystem heute allgemein anerkannt

ist.

Daraus wird wohl schon ersichtlich , daß es sich bei der Wahrscheinlichkeitsrechnung und

mathematischen Statistik um keine "leichten" Disziplinen handelt. Wer hier eine Sammlung

von Faustformeln erwartet, wird enttäuscht werden. Die Schwierigkeit besteht meist darin, sich

klarzumachen, welche Voraussetzungen erfüllt sind, d.h. welches mathematische Modell zur

Beschreibung eines konkreten Sachverhaltes geeignet ist und wie die Ergebnisse zu interpretieren sind. Das bloße Einsetzen von Daten in eine Formel führt in der Regel zu Unsinn.

Die Vorlesung wird sich also sowohl mit der mathematischen Theorie als auch mit deren Anwendung auf einfache bzw. vereinfachte praktische Probleme befassen. Beides wird schwierig

sein, und nur erhebliche Anstrengungen werden einen Erfolg garantieren.

1.2. Zufallsversuche

Will man zufällige Vorgänge mathematisch beschreiben, so geht man am besten von der Vorstellung eines Zufallsversuchs (auch Zufallsexperiment genannt) aus.

Unter einem Zufallsversuch versteht man einen Versuch, dessen Ausgang durch die

betrachteten Versuchsbedingungen nicht eindeutig bestimmt ist.

Dabei kann es sich um einen physikalischen Versuch handeln, bei dem normalerweise auch bei

gleichen Versuchsbedingungen das Ergebnis infolge von Meßfehlern nicht eindeutig bestimmt

ist, sondern in gewissen Grenzen variieren kann. In unserem Sinne wird aber auch ein Zufallsversuch beim Werfen einer Münze, eines Würfels oder bei der Ziehung der Lottozahlen durchgeführt. In unserem Sinne unternimmt auch die Natur am 30. Oktober einen Zufallsversuch,

dessen Ausgang "Regen" oder "kein Regen" ist. Wesentlich für die mathematische Modellierung eines Zufallsversuchs ist die Menge der möglichen Versuchsausgänge.

Die Menge aller möglichen Versuchsausgänge heißt Grundraum.

Wichtig ist, daß tatsächlich alle möglichen Versuchsgänge enthält. Demgegenüber ist es

wie wir später sehen werden nicht so schlimm, wenn "zu groß" ist, d.h. auch Elemente

enthält, die in Wahrheit gar nicht eintreten können.

Beispiele:

1. Werfen eines Würfels (Würfelexperiment)

1,2,3,4,5,6

2. Werfen einer Münze (Münzwurf)

z , w

mit

z = "Zahl",

oder

2

w = "Wappen"

0,1

mit

0 = "Zahl",

1 = "Wappen"

3. Lotto "5 aus 35"

( x1 , x2 , x3 , x4, x5 ) : xi 1, 2,...,35 , i 1, 2,3, 4,5 , x1 x2 x3 x4 x5

Hier werden die Ergebnisse einer Ziehung schon in geordneter Reihenfolge angegeben,

denn nur die interessiert ja in der Regel.

4. Werfen eines Punktes auf das Einheitsquadrat (Schießscheibenexperiment)

Man kann sich die annähernde Verwirklichung dieses Experimentes durch das Schießen

auf eine quadratische Scheibe mit Kantenlänge 1 vorstellen, wobei bis zum ersten Treffer

geschossen wird und nur die Koordinaten dieses Treffers von Interesse sind.

ist hier das Einheitsquadrat, d.h.

0,1 0,1 ( x1, x2 ): x1 0,1 , x2 0,1

In der Regel hat man mehrere Möglichkeiten, einen geeigneten Grundraum zu wählen. Das

wird an folgendem Beispiel deutlich.

5. Produktion von Bauteilen

Ein Automat produziert Bauteile, wobei fehlerhafte Bauteile auftreten können. Diese

werden in Paketen zu je 12 Stück versendet. Interessiert man sich für die Anzahl der

einwandfreien Teile, so wird man evtl. als Grundraum

0,1,2,...,12 wählen mit i = " i einwandfreie Teile" für i .

Interessiert man sich nur dafür, ob in einem bestimmten Paket wenigstens

10 einwandfreie Teile sind oder nicht, so kann man auch

' 0,1 als Grundraum wählen mit

0 "weniger als 10 einwandfreie Teile"

1 "mindestens 10 einwandfreie Teile".

Man kann sich aber auch die Teile durchnumeriert denken (etwa in der Reihenfolge der

Produktion) und als Grundraum

(1 ,..., 12 ) : i 0,1, i 1,...,12

wählen, wobei

" i 0" bedeutet, daß das i-te Teil defekt ist,

" i 1" bedeutet, daß das i-te Teil einwandfrei ist.

Z.B. ist = (1,1,0,0,1,1,0,1,1,1,1,1) der Versuchsausgang, bei dem das 3. , das 4. und

das 7. Teil defekt sind, die anderen Teile aber einwandfrei.

3

1.3. Zufällige Ereignisse

Nachdem wir einen Zufallsversuch nun zunächst durch die Menge der möglichen Versuchsausgänge beschrieben haben, stellt sich jetzt die Frage, wie sich zufällige Ereignisse mathematisch

darstellen lassen. Wir betrachten dazu einmal das letzte Beispiel, wobei wir als Grundraum

0,1,2,...,12 wählen. Das zufällige Ereignis A = "mindestens 10 einwandfreie Teile" tritt

genau dann ein, wenn einer der Versuchsgänge "10 einwandfreie Teile", "11 einwandfreie

Teile" oder "12 einwandfreie Teile" auftritt. Man kann es also beschreiben durch die Angabe

der Versuchsausgänge, bei deren Auftreten es eintritt. Daher kann man A als Teilmenge von

auffassen, nämlich als die Menge aller der Elemente, bei deren Auftreten es eintritt:

A 10,1112

,

Hätten wir ' 0,1 zugrundegelegt, so würde gelten

A' = "mindestens 10 einwandfreie Teile" = 1

Bei Zugrundelegen von " wäre das betrachtete Ereignis die Menge aller 12-Tupel aus Nullen und Einsen, die wenigstens 10 Einsen, also höchstens 2 Nullen enthalten.

Betrachten wir das Ereignis "höchstens ein einwandfreies Teil", so läßt es sich bei Zugrundelegen von 0,1 überhaupt nicht beschreiben. Bei Zugrundelegen von

' 0,1,2,...,12 gilt:

B' = "höchstens ein einwandfreies Teil" = 0,1

Bei Zugrundelegen von " gilt

B" = "höchstens ein einwandfreies Teil" = {(0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0) ,

(1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0) ,

(0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0) ,

. . .

(0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1)}

Die mathematische Beschreibung eines zufälligen Ereignisses hängt also von der Wahl des

Grundraumes ab. Wir kommen nun zur ersten Definition.

Definition 1.1.

Gegeben sei ein Zufallsversuch mit Grundraum . Eine Teilmenge A heißt zufälliges Ereignis. Die Einermengen für heißen Elementarereignisse.

Bemerkung 1:

Häufig werden die Versuchsausgänge selbst als Elementarereignisse bezeichnet. Sie

sind dann aber keine Ereignisse im Sinne unserer Definition (weil keine Teilmengen von

).

4

Bemerkung 2:

Diese Definition ist bei tiefergehenden mathematischen Untersuchungen im Grunde nur für

abzählbares geeignet. Bei überabzählbaren Grundräumen heißen dann nicht alle Teilmengen Ereignisse, sondern nur, wenn sie zusätzliche Forderungen erfüllen.

Beispiele:

Würfelexperiment:

A = "es wird gerade Augenzahl geworfen"

B = "es werden mindestens 5 Augen geworfen"

A = 2,4,6

B = 5,6

Münzwurf:

A = "es wird Zahl geworfen" = z

Schießscheibenexperiment:

A = "Fahrkarte":

B = "10 Ringe":

C = "mindestens 8 Ringe":

D = "obere Hälfte":

Wir identifizieren also auch hier die betrachteten Ereignisse mit den schraffierten Mengen.

5

Nachdem wir zufällige Ereignisse als Teilmengen einer Grundmenge definiert haben, wollen

wir uns überlegen, wie spezielle Mengen und Verknüpfungen zwischen Mengen zu interpretieren sind.

1. : tritt immer, d.h. bei jedem Versuchsausgang, ein.

heißt sicheres Ereignis.

2. : Die leere Menge tritt niemals, also bei keinem Versuchsausgang, ein.

heißt unmögliches Ereignis.

3. A \ A : A tritt genau dann ein, wenn A nicht eintritt.

A heißt zu A komplementäres Ereignis (bzw. "nicht A")

Beispiele:

Würfelexperiment:

A 1, 3, 5 = "ungerade Augenzahl" , B 1, 2, 3, 4 = "höchstens 4 Augen"

Schießscheibenexperiment

A = "keine Fahrkarte":

D = "untere Hälfte":

4. A B " A und B": tritt genau dann ein, wenn A und B eintreten, also wenn sowohl

A als auch B eintritt.

Beispiele:

Würfelexperiment:

A B 6 , A B 2, 4

6

Schießscheibenexperiment:

D C:

AB

Gilt wie im letzten Beispiel A B , so heißen A und B disjunkt oder unvereinbar.

A und B können in diesem Fall nie gleichzeitig auftreten.

5. A B " B oder B" : A B tritt genau dann ein, wenn wenigstens eines der Ereignisse

A , B eintritt.

Beispiele:

Würfelexperiment:

A B 2, 4, 5, 6

Schießscheibenexperiment:

A D :

B C C:

6. A \ B = "A ohne B" : A \ B tritt genau dann ein, wenn A , aber nicht B eintritt.

Beispiele:

Würfelexperiment:

A \ B = 2, 4 , B \ A = 5

l q

lq

Schießscheibenexperiment:

A\D:

A\B=A, B\C=

7

7. A B "A zieht B nach sich"

A B heißt: Wenn A eintritt, so tritt auch B ein.

Die Rückführung von Ereignissen auf Mengen hat zur Folge, daß alle Rechenregeln für

Mengen nun auch für Ereignisse gelten.

1.4. Der klassische Wahrscheinlichkeitsbegriff

Bisher haben wir uns damit befaßt, wie man die Zufälligkeit eines Ereignisses mathematisch

modellieren kann. Aber man gibt sich natürlich nicht damit zufrieden, zu wissen, ob ein

Ereignis zufällig ist oder nicht, sondern man will auch die Sicherheit, mit der es eintritt, mathematisch beschreiben.

Dazu gehen wir von einem Spezialfall aus. Wir nehmen an, daß der Grundraum endlich ist

und alle Versuchsausgänge gleichberechtigt sind, das heißt, daß die Chance für das Eintreten

jedes Versuchseinganges gleich ist.

Ist 1 , 2 ,..., N ( N Versuchsausgänge), so sagt man "Jeder Versuchsausgang tritt

mit der Wahrscheinlichkeit 1 ein"

N

Die Wahrscheinlichkeit eines beliebigen Ereignisses A definiert man nun wie folgt

Definition 1.2.

A

A

P A

N

heißt klassische Wahrscheinlichkeit des Ereignisses A .

( A bezeichnet die Anzahl der Elemente von A)

Anzahl der zu A gehörenden Versuchsausgänge

Es ist also P( A)

Anzahl aller Versuchsausgänge

Beispiele:

1. Würfelexperiment

1,2,3,4,5,6

Wahrscheinlichkeit eine (keine) "6" zu würfeln:

1

5

P 6 6 , P 6 P 1,2,3,4,5 6

Wahrscheinlichkeit, eine ungerade Augenzahl zu würfeln:

3

P 1,3,5 6 21

Wahrscheinlichkeit, höchstens 2 Augen zu würfeln:

2 1

P 1,2 6 3

8

2. Münzwurf

z , w

1

P z P w 2

3. Werfen zweier Würfel (unterscheidbar)

= { (1,1) , (1,2) , (1,3) , (1,4) , (1,5) , (1,6) ,

(2,1) ,

(3,1) ,

(4,1) ,

(5,1) ,

(2,2) ,

(3,2) ,

(4,2) ,

(5,2) ,

(2,3) ,

(3,3) ,

(4,3) ,

(5,3) ,

(2,4) ,

(3,4) ,

(4,4) ,

(5,4) ,

(2,5) ,

(3,5) ,

(4,5) ,

(5,5) ,

(2,6) ,

(3,6) ,

(4,6) ,

(5,6) ,

(6,1) , (6,2) , (6,3) , (6,4) , (6,5) , (6,6) }

36

A "gleiche Augenzahl auf beiden Würfeln" A

11, ,2,2,3,3,4,4,5,5,6,6

6 1

P A 36 6 ,

B "Augensumme 5" B

1,4, 2,3, 3,2,4,1 P B 364 91

4. "5 aus 35"

i1 , i2 , i3 , i4 , i5 : ik 1,...35, i1 i2 i3 i4 i5

.

35

35!

31 32 33 34 35

31 8 1117 7 324632

120

5 30!5!

A "5 richtige" auf Tipschein

j1, j2

1

j3 j4 j5 P ( A) 1

324632

Hat ein Ereignis A die Wahrscheinlichkeit p P(A) , so wird bei einer großen Zahl von Versuchen, die man unter Beibehalten der wesentlichen Versuchsbedingungen durchführt, A in

annähernd p 100 % der Fälle auftreten. So kann man erwarten, daß bei vielen Würfen mit

einem idealen Würfel in etwa 100 % 16,7% der Fälle eine "6" auftritt. Bei kleineren Ver6

suchsserien gilt das aber nicht: Sie wissen selbst, wie lange man bei "Mensch ärgere Dich

nicht" mitunter auf eine "6" wartet.

Eigenschaften der klassischen Wahrscheinlichkeit

1

(1) P

Die Wahrscheinlichkeit des sicheren Ereignisses ist 1. (Das sichere Ereignis tritt immer ein)

(2) P()

0

9

Die Wahrscheinlichkeit des unmöglichen Ereignisses ist 0. (Das unmögliche Ereignis tritt nie

ein)

(3) 0 P ( A) 1 ( A 0 A )

(4) Gilt A B (d.h. A, B sind elementefremd, d.h. haben kein gemeinsames Element),

so folgt P A B P A P B .

Beispiel: "Werfen zweier Würfel"

A = "Augensumme 4" 1,3, 2,2, 3,1

B = "Augensumme 3".

1,2, 2,1

A B " 3 Augensumme 4"

A B ,

5

P( A B) P (1,3),(2,2),(3,1),(1,2),(2,1) 36 ,

5

P( A) P B P (1,3),(2,2),(3,1) P (1,2),(2,1) 36

(5) P A 1 P( A)

(Beweis: A A , A A P ( A) P ( A ) P ( ) 1

Beispiel: "Werfen zweier Würfel"

A 6 "6 Augen" A "höchstens 5 Augen"

1 5

P A 1 P ( A) 1 6 6

(6) P A B P( A) P( B) P( A B)

(Beweis: A = (A \ B) A B P ( A) P ( A \ B) P A B

B = (B \ A) A B P ( B ) P ( B \ A) P A B

A B = (A \ B) (B \ A) ( A B )

P ( A B ) P(A \ B) + P(B \ A) + P ( A B )

( P ( A) P ( A B )) ( P ( B ) P ( A B )) P ( A B )

P ( A) P ( B ) P ( A B )

(7) A B P ( A) P ( B )

(Beweis: B = A ( B \ A)

P(B) = P(A) + P(B \ A) P(A)

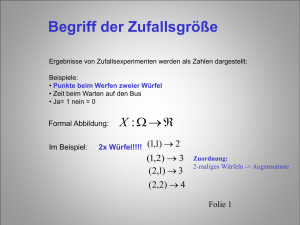

1.5. Beschreibung von Ereignissen durch Zufallsgrößen

Wir haben im Beispiel "Werfen zweier Würfel" (Abschnitt 1.4.) uns vor allem für die Augensumme interessiert. Man könnte deshalb , anstelle des dort angegebenen Grundraumes

einen Grundraum ' , ' 2,...,12 , benutzen. Dieser hat jedoch den Nachteil, daß nicht

mehr alle Versuchsausgänge die gleiche Chance haben, einzutreten, also die klassische Definition der Wahrscheinlichkeit uns hier nicht helfen würde (z.B. ist die Wahrscheinlichkeit für

10

"Augensumme 12" 1/36, für "Augensumme 7" aber 1/6).

Diesen Nachteil werden wir zwar später umgehen können, aber oftmals ist es zweckmäßig, eine

größere Grundmenge zur Verfügung zu haben, z.B. wenn man sich wie bei manchen Glücksspielen auch für Ereignisse wie "gleiche Augenzahlen", "aufeinanderfolgende Augenzahlen"

usw. die Wahrscheinlichkeit angeben will.

Man kann nun jedem Element (i , j ) die Augensumme X i , j i j zuordnen, die

Augensumme ist also eine spezielle reelle Funktion auf .

Definition 1.3.

Es sei ein (abzählbarer) Grundraum. Eine reelle Funktion X: R heißt Zufallsgröße.

Bemerkung: Für überabzählbares muß man zusätzliche Bedingungen an X stellen.

Beispiele:

Werfen zweier Würfel:

Augensumme: X((i,j)) = X(i, j) = i + j

Münzwurf:

z , w

Beispiel für eine Zufallsgröße : Y(z) = 1 , Y(w) = 0

Würfelexperiment:

X (Augenzahl)

"5 aus 35"

T i1, i2 , i3 , i4 , i5 sei ein fester Tip.

j1 , j2 , j3 , j4 , j5 wird gezogen.

Man kann ein X definieren mit folgender Eigenschaft:

X ( ) 0 , falls keine der Zahlen von T und übereinstimmen

X ( ) 1 , falls genau eine Zahl übereinstimmt.

...

X ( ) 5 , falls alle 5 Zahlen übereinstimmen.

Man wird sich nun etwa für die Wahrscheinlichkeit interessieren, einen Dreier mit

einem

Tipschein zu erreichen, also für die Wahrscheinlichkeit dafür, daß X 3 ist.

Für das Ereignis " X ( ) x" schreibt man oft X x als Kurzschreibweise für

: X () x

(x ist eine feste Zahl).

Beispiel "Werfen zweier Würfel":

X () 8 : X () 8 (i, j) : i j 8 2,6,(3,5),(4,4),(5,3),(6,2)

11

Wir werden später noch häufig mit Zufallsgrößen zu tun haben.

1.6. Die relative Häufigkeit

Da die klassische Wahrscheinlichkeit davon ausgeht, daß alle Versuchsausgänge gleichberechtigt sind, versagt sie schon, wenn der Würfel falsch oder die Münze gezinkt ist oder beim Fußballtoto, wo Heimmannschaften eine größere Siegeschanche haben als Auswärtsmannschaften.

Wir wollen uns daher jetzt der Frage zuwenden, wie in sinnvoller Weise die Wahrscheinlichkeit eines zufälligen Ereignisses bei Zufallsexperimenten, bei denen nicht mehr alle Versuchsausgänge gleichberechtigt sind, definiert werden kann.

Ausgangspunkt für die Entwicklung der Wahrscheinlichkeitsrechnung war die Erfahrungstatsache, daß bei vielfacher Durchführung eines Versuchs unter Beibehaltung der wesentlichen

Versuchsbedingungen der prozentuale Anteil des Eintretens eines Ereignisses A einem Grenzwert "zustrebt".

Man hat diese Erfahrungstatsache auch durch gezielte Experimente erhärtet:

Buffon:

4040 Münzwürfe, 50,69 % Wappen

Pearson:

24000 Münzwürfe, 50,05 % Wappen

Man definiert die relative Häufigkeit wie folgt:

Definition 1.4.

Die relative Häufigkeit des Ereignisses A in n Versuchen ist

N ( A)

hn ( A) : n

n

wobei Nn ( A) die Anzahl des Eintretens von A in diesen n Versuchen ist (absolute Häufigkeit).

Die relative Häufigkeit gibt also gerade an, in wieviel % der Versuche Ereignis A eintritt

(1% 1/100 ; in hn ( A) 100% tritt A ein).

Eigenschaften der relativen Häufigkeit:

(1) hn () N n () n 1 (Das sichere Ereignis tritt immer ein)

n

N n ()

(2) hn ()

0 (Das unmögliche Ereignis tritt nie ein)

n

(3) 0 Nn ( A) n 0 hn ( A) 1

(4)Gilt A B (d.h. A und B können nie gleichzeitig eintreten)

hn ( A B) hn ( A) hn ( B)

(5) hn ( A ) 1 hn ( A)

(6) hn ( A B) hn ( A) hn ( B) hn ( A B)

(7) A B hn ( A) hn ( B)

12

Man hat in der Vergangenheit versucht, die Wahrscheinlichkeit als Grenzwert der relativen

Häufigkeit zu definieren. Diese Definition erwies sich jedoch als unhandlich und nicht widerspruchsfrei. Daher definiert man heute die Wahrscheinlichkeit als eine Funktion auf der

Menge aller Ereignisse, die wesentliche Eigenschaften der klassischen Wahrscheinlichkeit und

der relativen Häufigkeit in sich vereint.

1.7. Der Wahrscheinlichkeitsbegriff

Vergleichen wir die Eigenschaften (1) bis (7) der klassischen Wahrscheinlichkeit (Abschnitt

1.4.) mit den entsprechenden Eigenschaften der relativen Häufigkeit (Abschnitt 1.6.), so stellen

wir fest, daß sie übereinstimmen. Es liegt also nahe, derartige Eigenschaften auch für die Wahrscheinlichkeit zu fordern. Zunächst wollen wir jedoch (4) auf abzählbar unendlich viele Ereignisse verallgemeinern:

(4') Es seien Ai (i N) Ereignisse mit Ai A j für i j .

Dann gilt für die klassische Wahrscheinlichkeit

P Ai P Ai

i 1 i 1

und für die relative Häufigkeit

hn Ai hn Ai .

i 1 i 1

Dabei gilt für die klassische Wahrscheinlichkeit Ai = für alle i n0 und ein gewisses

n0 N . Für die relative Häufigkeit gilt ebenfalls hn Ai 0 für alle i n0 und ein

gewisses n0 N . Die Eigenschaft (4') wird aber wesentlich, wenn man unendlich viele

Versuchsausgänge hat und n betrachten will.

Im folgenden bezeichnet A die Menge aller Ereignisse. Für abzählbares ist ,

die Potenzmenge, d.h. die Menge aller Teilmengen von .

Allgemein ist , wobei A ein Mengensystem mit folgenden Eigenschaften darstellt:

(a) A

(b) AA A

(c) Ai

für i N U Ai

i 1

(Ein derartiges Mengensystem wird als -Algebra, -Feld oder auch Wahrscheinlichkeitsfeld

bezeichnet.)

Definition 1.5:

Die Wahrscheinlichkeit (bzw. das Wahrscheinlichkeitsmaß) ist eine Funktion P: 0,1 ,

die folgende Eigenschaften hat:

(a) P 1

13

(b) Wenn Ai

für i N , Ai A j für i j , A Ai , dann folgt

i 1

P A P Ai .

i 1

P(A) heißt dann Wahrscheinlichkeit des Ereignisses A .

Bemerkung: Die übrigen Eigenschaften (1) bis (7) lassen sich aus diesen beiden Eigenschaften

(a) und (b) ableiten.

Beispiele:

1. "Werfen zweier Würfel"

2, 3, 4, 5, 6, 7, 8 ,9, 10, 11, 12 (Augenzahl)

p2 P2 1 P12 p12 ,

36

p3 P3

2

1

P11 p11 .

36 18

Z. B.: A = "mindestens 11 Augen" = {11, 12}

1

1

1

P A pi pi p11 p12

18

36

12

i A

i 11,12

2. "Urnenmodell"

In einer Urne befinden sich

10 schwarze Kugeln, 5 weiße Kugeln, 3 rote Kugeln und 2 grüne Kugeln.

Versuch: Beliebiges Entnehmen einer Kugel.

s, w, r , g

Ps 10 1 , Pw 5 1 , Pr 3 , Pg 2 1 .

20 2

20 4

20 10

20

3. Ein Automat produziert Drehteile, deren Abmessungen wie folgt schwanken:

Abmessung [mm]

Anteil [%]

16.7

16.8

16.9

17.0

17.1

17.2

17.3

4

11

12

33

24

10

6

Wie groß ist die Wahrscheinlichkeit, daß ein Teil um höchstens 0.2 mm von 17.0 mm

abweicht?

16.7, 16.8, 16.9, 17.0, 17.1, 17.2, 17.3

Zufallsgröße: X 17 für (Abweichung)

P X 0.2 P : X 0.2 P 168

. , 16.9, 17.0, 171

. , 17.2 0.9 90%

1 P X 0. 2

14

1.8. Geometrische Wahrscheinlichkeiten

Sachverhalt: Ein Punkt werde völlig willkürlich auf eine Kurve S bzw. eine Fläche F

"geworfen", so daß kein Gebiet der Kurve bevorzugt wird. Die Wahrscheinlichkeit, daß

der Punkt dann in eine Menge R S bzw. G F fällt, sei

I R

(I - Gesamtlänge) bzw.

P R

I S

I G

(I - Flächeninhalt).

P G

IF

Beispiel: Quadratische Schießscheibe, Seitenlänge: 20 cm

Durchmesser des 5. Ringes: 10 cm

Voraussetzung: Es werde so geschossen, daß kein Gebiet der Scheibe bevorzugt wird.

A = "mindestens 5 Ringe"

P A 25 79 0. 2

400 400

2. BEDINGTE WAHRSCHEINLICHKEITEN

2.1. Einführende Beispiele

1. "Urnenmodell": In einer Urne befinden sich 1 schwarze und 1 weiße Kugel.

Versuch: Zweimaliges Ziehen ohne Zurücklegen ( s, w, w, s )

B = "weiße Kugel beim 1. Ziehen"

w, s ,

P B 1

2

B " schwarze Kugel beim 1. Ziehen " w, s ,

A = "weiße Kugel beim 2. Ziehen"

s, w B ,

w, s ,

A = "schwarze Kugel beim 2. Ziehen"

P B 1 P B

1

2

P A 1

2

1

P A

2

Wie groß ist die Wahrscheinlichkeit, beim 2. Ziehen eine weiße Kugel zu erhalten, wenn

bekannt ist, daß beim 1. Ziehen schon eine weiße Kugel gezogen wurde?

Offenbar ist diese Wahrscheinlichkeit 0 , denn es ist unmöglich, daß A eintritt, wenn B

schon eingetreten ist.

Die Wahrscheinlichkeit ändert sich also, wenn sich die Versuchsbedingungen ändern,

wenn also z.B. Informationen über den Ausgang des Zufallsversuches hinzukommen.

15

2. "Schießscheibenexperiment"

x, y: x, y 0,1

A " linke obere Hälfte"

x, y : y x

B " obere Hälfte" x , y : y

1

2

Wie groß ist die Wahrscheinlichkeit, daß der Punkt in der linken oberen Hälfte liegt, wenn schon

bekannt ist, daß er in der oberen Hälfte liegt? (Bezeichnung für diese Wahrscheinlichkeit: P A B )

I A B

I A B

P A B

I

P A B

I B

I B

P B

I

3. Bedingte relative Häufigkeit

Wir betrachten die relative Häufigkeit eines Ereignisses A unter der Bedingung B ,

hn A B , d.h. wir zählen nur die eingetretenen Versuchsausgänge von A , die auch in B

liegen:

Nn A B

N A B

h A B

n

hn A B n

n

Nn B

Nn B

hn B

n

Daher liegt folgende Definition nahe.

Definition 2.1.

Unter der bedingten Wahrscheinlichkeit des Ereignisses A unter der Bedingung B mit

P A B

.

P B 0 versteht man den Ausdruck P A B

P B

Satz 2.2.

Für festes B ( P B 0 ) ist PB A P A B ein Wahrscheinlichkeitsmaß (zu demselben

Grundraum )

Eigenschaften:

(1) bis (7) aus Abschnitt 1.4. bzw. 1.6. gelten analog, außerdem:

P B B

( P B B

P B B 1

1 ) ,

P B

P A

P A

P A ,

P

16

P B B

P B B P

0 .

P B

P B

Definition 2.3.

Die Ereignisse A und B heißen unabhängig voneinander gdw. P A B P A P B .

Bedeutung: Gilt P(B) > 0 , ist die obige Bedingung gleichbedeutend mit P A B P A ,

P A B P A P B

denn P A B

P A , d.h. also, die Wahrscheinlichkeit von

P B

P B

A ist unabhängig davon, ob B eingetreten ist oder nicht. (Ist P(A) > 0 , so folgt analog

P B A P B . )

Beispiel: "Zweimaliges Werfen eines Würfels"

Wie groß ist die Wahrscheinlichkeit, daß beim zweimaligen Werfen eines Würfels beim

zweiten Wurf eine "6" geworfen wird, wenn beim ersten Wurf schon eine "6" fiel?

Der Wahrscheinlichkeitsraum kann hier wie beim Werfen zweier Würfel gewählt werden, es

ergeben sich dann auch dieselben Wahrscheinlichkeiten. Es sei

A = "Sechs im 1.Wurf" 6,1,6,2,6,3,6,4,6,5,6,6,

B = "Sechs im 2.Wurf" 1,6,2,6,3,6,4,6,5,6,6,6

Folglich

1

P A B

P6,6

36 1

P B A

P B

P A

P 6,1 , 6,2 , 6,3 , 6,4 , 6,5 , 6,6

6 6

36

Analog läßt sich zeigen, daß es bei mehrmaligem Werfen eines Würfels für die Wahrscheinlichkeit des Auftretens einer "6" keine Rolle spielt, wann letztmalig eine "6" aufgetreten ist.

Sind P A B und P B bekannt, so erhält man P A B P A B P B .

Es seien Ai , i N0 , Ereignisse, A = A1 A2 und B = A0 .

Dann gilt P A2 A1 A0 P A2 A1 A0 P A1 A0 P A2 A1 A0 P A1 A0 P A0 .

Durch vollständige Induktion erhält man:

Satz 2.4.

Es sei P An1 An2 ... A1 A0 0 . Dann gilt

P An An1 ... A1 A0

P An An1 ... A1 A0 P An1 An2 ... A1 A0 ... P A1 A0 P A0 .

17

Definition 2.5.

Die Ereignisse A1 , A2 , ... , An heißen insgesamt unabhängig gdw. für beliebige Indizes

ij {1,2,...,n} mit 1 i1 i2 i3 ... ik n gilt

P Ai1 Ai2 ... Aik P Ai1 P Ai2 ... P Aik .

Bedeutung: Jedes Ereignis A A1 , ... , An ist von jedem Durchschnitt anderer Ereignisse

aus

dieser Menge unabhängig.

Bemerkung: Sind A1 , A2 , ... , An insgesamt unabhängig, so vereinfacht sich der Multiplikationssatz zu

P A1 A2 ... An P A1 P A2 ... P An .

Beispiel: Wahrscheinlichkeit für 5 Knabengeburten hintereinander

Ai = "i-tes Kind ist Knabe"

5

1

1

P A1 A2 A3 A4 A5

32

2

Satz von der totalen (vollständigen) Wahrscheinlichkeit

Definition 2.6.

B1 , B2 , ... , Bn heißt vollständiges Ereignissystem genau dann, wenn B1 , B2 , ... , Bn

Ereignisse mit

(a) Bi B j für i j (d.h. die Bi sind paarweise unvereinbar)

(b) B1 B2 ... Bn

und

sind.

Satz 2.7. (Satz von der totalen Wahrscheinlichkeit)

Ist A ein Ereignis und

B1 , B2 , ... , Bn

ein vollständiges Ereignissystem mit P Bi 0

für

i = 1,2,...,n , so gilt

n

P A P A B1 P B1 P A B2 P B2 ... P A Bn P Bn P A Bi P Bi

i 1

Beweis:

Es gilt A A A B1 B2 ... Bn A B1 A B2 ... A Bn .

Da die Ereignisse A Bi paarweise unvereinbar sind, folgt

P A P A B1 ... P A Bn P A B1 P B1 ... P A Bn P Bn .

18

Beispiel: In zwei Werken W1 , W2 werden Glühlampen hergestellt; es sind von sehr guter

Qualität (mindestens 15000 h Lebensdauer)

80% der von W1 gelieferten und

25% der von W2 gelieferten.

Der Handel bezieht 40% von W1 und 60% von W2 .

Wie groß ist die Wahrscheinlichkeit, eine sehr gute Glühlampe zu erhalten?

Lösung: B1 = "Lampe von W1" , B2 = "Lampe von W2" , A = "Lampe von sehr guter Qualität"

P A P A B1 P B1 P A B2 P B2 0.80 0.40 0.25 0.60 0.32 015

. 0.47

Man kann aber nun auch die Frage stellen, wie groß die Wahrscheinlichkeit ist, daß die

gekaufte Glühlampe von Werk W1 stammt, wenn sich herausstellt, daß sie von sehr guter

Qualität ist.

Satz 2.8. (Bayessche Formel)

Ist A ein Ereignis mit P A 0 und

B1 , B2 , ... , Bn

mit P Bi 0 für i = 1,2,...,n , so gilt

P Bj A

P A B P B

P Bj A

P A

j

j

n

P A Bi P Bi

ein vollständiges Ereignissystem

.

i 1

0.32

Zu obigem Beispiel: P B1 A 0.47 0.68

Berechnungsschema:

P A B P A B P B

j

P Bj

1

.

.

.

2

.

.

.

n

j

.

.

.

j

j

P A P A B j P B j

.

.

.

P Bj A

.

.

.

Beispiel: Drei Maschinen produzieren dieselben Teile.

1. Maschine: 60% der Produktion, 3.0% Ausschuß

2. Maschine: 25% der Produktion, 5.0% Ausschuß

3. Maschine: 15% der Produktion, 2.0% Ausschuß

19

Wie groß ist der prozentuale Ausschußanteil? Wie groß ist die Wahrscheinlichkeit, daß ein

Ausschußteil von der i-ten Maschine stammt?

Lösung: A = "Teil ist Ausschuß" , Bj = "Teil stammt von j-ter Maschine"

j

P Bj

P A Bj

1

2

3

0.60

0.25

0.15

0.03

0.05

0.02

P A B P B

j

j

}

0.018

0.012

0.003

P A P A B j P B j

P Bj A

0.54

0.37

0.09

0.033

3. Diskrete Zufallsgrößen

3.1. Die Wahrscheinlichkeitsverteilung einer diskreten Zufallsgröße

Wir haben bereits im Abschnitt 1.5. Zufallsgrößen als Abbildungen X : R eingeführt.

Mit (X) bezeichnen wir den Wertevorrat dieser Abbildung X, d.h.

W X x R : X x fnr ein .

Definition 3.1.

Eine Zufallsgröße X : R heißt diskret gdw. ihr Wertevorrat (X) abzählbar ist

(d.h. endlich oder abzählbar unendlich).

(X) hat also die Gestalt W X x1 , x2 , x3 , ... xi iI w, wobei I = N oder

I 1,2,3, ... , n gilt.

Die Elemente des Wertevorrates, d.h. die Werte, die die Zufallsgröße annehmen kann, heißen

Realisierungen der Zufallsgröße. Sie werden meist durch kleine Buchstaben bezeichnet,

während man für die Zufallsgröße selbst oft große Buchstaben verwendet.

(Bei unserer Definition des Begriffes "Zufallsgröße" ist nicht von vornherein klar, ob

X 1 xi : X xi

X 1 xi : X xi ein Ereignis ist, d.h. ob

gilt. Wir werden dies aber im folgenden stets voraussetzen.)

Definition 3.2.

Die Abbildung p : W

X 0,1

mit p xi P : X xi

Wahrscheinlichkeitsverteilung der diskreten Zufallsgröße X .

Schreibweise: p xi p xi P X xi

20

für i I heißt

Satz 3.3.

Es sei W x1 , x2 , x3 , ... xi iI , p : W R , p xi p xi für i I .

X

p ist Wahrscheinlichkeitsverteilung einer Zufallsgröße X mit Wertevorrat

genau dann, wenn

(a) 0 pxi 1 für i I

(b) pxi 1

i I

Die Wahrscheinlichkeitsverteilung einer diskreten Zufallsgröße läßt sich in Form einer (Wahrscheinlichkeits-)Tabelle angeben:

i

x1

x2

x3

...

pxi

px1

px2

px3

...

Beispiele:

1. Werfen zweier Würfel

i , j : i , j 1,2,3,4,5,6 ,

Zufallsgrößen:

X i , j i j ,

Y i , j maxi , j ,

X 2,3,4,5,6,7,8,9,10,11,12

Y 1,2,3,4,5,6

X()

Y()

X()

Y()

X()

Y()

(1,1)

(1,2)

(1,3)

(1,4)

(1,5)

(1,6)

2

3

4

5

6

7

1

2

3

4

5

6

(3,1)

(3,2)

(3,3)

(3,4)

(3,5)

(3,6)

4

5

6

7

8

9

3

3

3

4

5

6

(5,1)

(5,2)

(5,3)

(5,4)

(5,5)

(5,6)

6

7

8

9

10

11

5

5

5

5

5

6

(2,1)

(2,2)

(2,3)

(2,4)

(2,5)

(2,6)

3

4

5

6

7

8

2

2

3

4

5

6

(4,1)

(4,2)

(4,3)

(4,4)

(4,5)

(4,6)

5

6

7

8

9

10

4

4

4

4

5

6

(6,1)

(6,2)

(6,3)

(6,4)

(6,5)

(6,6)

7

8

9

10

11

12

6

6

6

6

6

6

Wahrscheinlichkeitsverteilung von X :

21

xi

2

3

4

pxi

1

36

2

36

3

36

5

4

36

6

7

8

5

36

6

36

5

36

9

4

36

10

11

12

3

36

2

36

1

36

1

0.18

0.16

0.14

0.12

0.1

0.08

0.06

0.04

0.02

0

0

2

4

6

8

10

12

Wahrscheinlichkeitsverteilung von Y :

yi

1

2

3

4

5

6

p yi

1

36

3

36

5

36

7

36

9

36

11

36

1

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

0

1

2

3

4

5

6

2. Beispiel

In einer Kiste sind 10 Glühlampen, davon 3 defekte.

Versuch: Zweimaliges Ziehen ohne Zurücklegen

Zufallsgröße: X = "Anzahl der defekten Glühlampen unter den gezogenen"

Gesucht: Wahrscheinlichkeitsverteilung von X

Lösung: W X 0,1, 2

0,0,0,1,1,0,1,1 , dabei bedeutet: 0 - Glühlampe ist o.k.; 1 - Glühlampe

ist defekt.

Mit Y i , j i und Z i , j j gilt X i , j Y i , j Z i , j i j . Es folgt

p0 P X 0 PY 0 Z 0 P Z 0 Y 0 PY 0 6 7 7 ,

9 10 15

p2 P X 1 PY 1 Z 1 P Z 1 Y 1 PY 1 2 3 1 ,

9 10 15

22

p1 P X 1 PY 0 Z 1 Y 1 Z 0

PY 0 Z 1 PY 1 Z 0

P Z 1 Y 0 PY 0 P Z 0 Y 1 PY 1 3 7 7 3 7

9 10 9 10 15

xi

2

3

4

pxi

7

15

7

15

1

15

0.5

0.4

0.3

0.2

1

0.1

0

0

1

2

Definition 3.4.

Die diskreten Zufallsgrößen X 1 , X 2 , ... , X n mit den Wahrscheinlichkeitsverteilungen

p1 , p2 , ... , pn heißen (insgesamt)

unabhängig gdw. für alle x1 W X 1 , x 2 W

X ,

2

... , x n W

X

n

gilt:

P X 1 x1 , X 2 x 2 , ... , X n x n P X 1 x1 P X 2 x 2 ... P X n x n

p1x1 p x22

...

p xnn

.

3.2. Erwartungswert und Varianz diskreter Zufallsgröße

Beispiel: Bei einer Erbsensorte interessiert man sich für die Anzahl der Erbsen pro Schote.

Versuch: Willkürliche Entnahme einer Schote, Zählen der Erbsen

X = "Anzahl der Erbsen in dieser Schote"

Es werden n Versuche gemacht und die Häufigkeiten Nn X i Nn X i ermittelt.

Wenn wir annehmen, daß 10 eine obere Schranke für die Anzahl der Erbsen pro Schote ist,

dann gilt für die mittlere Anzahl m der Erbsen pro Schote:

10

10

m 1 i N n X i i hn X i .

n i 0

i 0

Ist nun p die Wahrscheinlichkeitsverteilung der Zufallsgröße X , d.h. pi P X i ,

dann erwartet man für große n , daß pi hn X i gilt.

10

Daraus folgt dann aber m i pi .

i 0

Definition 3.5.

Ist X eine diskrete Zufallsgröße mit Wertevorrat W

X x1, x2 , x3 , ... xi iI

Wahrscheinlichkeitverteilung p . Dann heißt EX xi p xi xi P X xi

i I

Erwartungswert der Zufallsgröße X , falls xi pxi .

i I

23

i I

und

Bemerkungen:

(1) Gilt xi pxi , so sagt man, daß der Erwartungswert existiert.

i I

(2) Ist I bzw. W

X

endlich, so existiert der Erwartungswert stets.

Beispiel: Es wurde eine Klausur geschrieben mit folgendem Zensurenspiegel:

Note

1

2

3

4

5

Anzahl

4

7

6

2

1

ni sei die Anzahl der Arbeiten mit Note i . Es wird willkürlich eine Arbeit gezogen; X sei

die Note der gezogenen Arbeit. Die Wahrscheinlichkeit, daß die gezogene Arbeit die Note i

hat, ist dann

n

pi P X i i . Es ergibt sich für den Erwartungswert von X

20

5

5

4 14 18 8 5 49

EX i pi 1 i ni

2. 45 .

20 i 1

20

20

i 1

Man erkennt daran, daß der Erwartungswert in der Regel nicht zum Wertevorrat der

Zufallsgröße gehört.

Satz 3.6.

Es sei g eine Funktion g:R R . Für die Zufallsgröße Y g X (d.h. Y g X

gilt dann EY g xi p xi , falls g xi p xi .

i I

i I

Bemerkung: Aufgrund von Satz 3.6. gilt insbesondere E X xi pxi , falls

i I

xi pxi . Da aber diese Reihe höchstens bestimmt divergieren kann, werden wir

i I

diese Bezeichnung generell verwenden, also auch im Fall xi pxi .

i I

Analog setzen wir generell E Y E g X g xi p xi für Y g X .

i I

Satz 3.7. (Weitere Eigenschaften des Erwartungswertes)

(a) EX E X falls E X , R

(b) X1 und X2 seien Zufallsgrößen, X X1 X2 (d.h. X X1 X 2 ) .

Existieren die Erwartungswerte von X1 und X2 , so existiert auch der Erwartungswert

von X und es gilt EX E X 1 X 2 EX 1 EX 2 .

(c) Ec c für Konstante c R (d.h. X c )

(d) X1 und X2 seien unabhängige Zufallsgrößen, X X1 X 2 (d.h.

X X1 X 2 ) . Existieren die Erwartungswerte von X1 und X2 , so

existiert auch der Erwartungswert von X und es gilt EX E X 1 X 2 EX 1 EX 2 .

24

Der Erwartungswert ist eine Kenngröße der Wahrscheinlichkeitsverteilung, d.h. er charakterisiert die Wahrscheinlichkeitsverteilung. Daß diese Charakterisierung recht unvollständig ist,

zeigt das folgende Beispiel.

Beispiel: Zwei Betriebe stellen dasselbe Drehteil her, X j - Durchmesser eines beliebig entj

nommenen Teiles vom Betrieb j (in mm) ; W X xi i 1,...,5 19.8,19.9, 20.0, 20.1, 20.2

d

, px j P X j xi

i

i für j = 1, 2 .

xi

px1

19.8

19.9

20.0

20.1

20.2

2%

5%

86%

5%

2%

100%

xi

p x2

19.8

19.9

20.0

20.1

20.2

10%

12%

56%

12%

10% 100%

i

i

Es gilt EX 1 19.8 0. 02 19. 9 0. 05 20. 0 0.86 20.1 0. 05 20. 2 0. 02 20 .

Analog: EX 2 20 .

Man sieht, daß im 1. Betrieb 14% der Teile von 20.0 mm um wenigstens 0.1 mm abweichen,

im 2. Betrieb sogar 44% , obwohl die Erwartungswerte gleich sind.

Wir werden daher eine weitere Kenngröße einführen, die die Abweichung vom Mittelwert

kennzeichnet.

Definition 3.8.

X sei eine Zufallsgröße mit E X . Dann heißt D 2 X E X EX 2 Varianz von X .

DX D2 X heißt Streuung von X .

Gilt D2 X , so sagt man, daß die Varianz existiert.

Satz 3.9. (Eigenschaften der Varianz)

(a) D2 X E X 2 EX 2 , falls D2 X . (Dabei ist E X 2 EX 2 xi2 pxi .)

i I

(b) D X D X für R , falls D X .

2

2

2

2

(c) D2 c 0 für c R ( c = const).

(d) D 2 X 1 X 2 D 2 X 1 D 2 X 2 , falls X1 und X2 unabhängige Zufallsgrößen sind,

deren

Varianzen existieren.

Standardisierung von Zufallsgröße:

Es sei X eine Zufallsgröße mit µ = EX und = DX . Dann ist Y

Zufallsgröße mit EY = 0 und D2Y = 1 , denn:

25

X

eine

EY 1 E X 1 EX 1 0 und

2

D2Y 12 D2 X 12 E X 02 2 1

3.3. Tschebyscheffsche Ungleichung

Man erwartet von einer Zufallsgröße, daß ihre Realisierungen in der Nähe des Erwartungswertes liegen, "um ihn herum schwanken", und zwar umso mehr, je kleiner die Streuung der

Zufallsgröße ist. Eine Aussage in dieser Richtung stellt der folgende Satz dar.

Satz 3.10. (Tschebyscheffsche Ungleichung)

X sei eine beliebige (diskrete) Zufallsgröße mit Erwartungswert EX und D2 X , c > 0

eine beliebige reelle Zahl. Dann gilt

2

P X EX c 1 D 2X

c

Bemerkung: Für c DX ist die Ungleichung trivialerweise erfüllt.

Beispiel:

Von einem Glühlampenwerk ist bekannt, daß für eine beliebig herausgegriffene Glühlampe die

Zufallsgröße X = "Lebensdauer der Glühlampe" folgende Eigenschaften hat:

EX 15000 , D2 X 10000 , d.h. DX 100 .

2

(a) Für c = 3erhält man D 2X 1 , also

9

c

P X 15000 300 1 1 0.89 , d.h.

9

14700 < X < 15300 in mindestens 89% der Fälle.

2

(b) Für c = 18erhält man D 2X 1 , also

324

c

P X 15000 1800 1 1 0.997 , d.h.

324

13200 < X < 16800 in mindestens 99.7% der Fälle.

Hier wird also eine höhere Sicherheit (99.7% statt 89%) durch eine unschärfere Ungleichung

erkauft.

3.4. Spezielle diskrete Wahrscheinlichkeitsverteilungen

3.4.1. Das Bernoullische Versuchsschema. Die Binomialverteilung

Wir betrachten folgenden Sachverhalt: Bei der Durchführung eines Versuchs interessiert man

sich vor allem dafür, ob ein bestimmtes Ereignis A eintritt oder nicht. Dabei sei

P A p und folglich P A 1 p q . Es werden nun n unabhängige Versuchsdurch26

führungen betrachtet, und man interessiert sich nun dafür, wie oft dieses Ereignis in den n

Versuchen auftritt. Um die Verteilung der betrachteten Zufallsgröße Z = Nn(A) = "Anzahl des

Eintretens von A in n Versuchen" mathematisch exakt bestimmen zu können, muß man die

n Einzelversuche zu einem Gesamtversuch zusammenfassen.

Es sei der Grundraum der Einzelversuche, A .

Wir wählen als Grundraum des Gesamtversuchs

~

... n Faktoren , d.h.

~

~ , , ... , : , i 1,2, ... , n .

1

2

n

i

% aus allen möglichen Versuchsausgängen des Gesamtversuchs.

Offenbar besteht

Es sei nun Ai = "A im i-ten Versuch" , d.h.

~

~ , , ... ,

Ai

: i A ...

A

... .

1

2

n

i ter Faktor

Wir definieren weiterhin eine Zufallsgröße Xi durch

~ A

1 für

i

~

X i

~

0 für Ai

(Man kann Xi auch durch die sogenannte Indikatorfunktion IB einer Menge B darstellen, die

wie folgt definiert ist:

~

~ , , ... ,

Ai

: i A ...

A

... . Offenbar

1

2

n

i ter Faktor

%

gilt Xi I Ai , d.h. Xi I Ai für alle

Xi ist also genau dann gleich 1 , wenn A im i-ten Versuch eintritt. Folglich

P X i 1 P Ai p und P X i 0 P Ai q .

n

Es gilt Z X i .

i 1

Wir wollen uns jetzt überlegen, welche Gestalt die Wahrscheinlichkeitsverteilung von Z hat.

Offenbar gilt W Z 1, 2, ... , n . Wir betrachten zunächst eine beliebige Realisierung der

Zufallsgrößen X1, X2 , ... , Xn , bei der genau k Stück den Wert 1 annehmen. Da die

Zufallsgrößen unabhängig sein sollen (wegen der vorausgesetzten Unabhängigkeit der Versuchsdurchführungen), ergibt sich z. B.

P X 1 1, X 2 0, X 3 1, X 4 1, ... , X n1 1, X n 0

P X 1 1 P X 2 0 P X 3 1 P X 4 1 ... P X n1 1 P X n1 0

p q p p ... p q p k q nk . Offensichtlich erhält man für jede solche Realisierung mit

n

k Einsen und n-k Nullen denselben Wert. Da es verschiedene derartige Realisierungen

k

gibt, d.h. Möglichkeiten, k Einsen und n-k Nullen hintereinander anzuordnen, ergibt sich

n

p k P Z k p k q n k .

k

27

Definition 3.11.

Es sei p 0,1 und q 1 p . Die Wahrscheinlichkeitsverteilung einer Zufallsgröße X mit

Wertevorrat W X 0,1, 2, ... , n heißt Binomialverteilung mit den Parametern n und p

genau dann, wenn

n

n

n k

pk P X k p k 1 p

p k q n k für alle k W X gilt. Die

k

k

Zufallsgröße X selbst heißt dann binomialverteilt mit den Parametern n und p . Dafür

schreiben wir kurz

X B(n,p) .

0,45

p=0.1

0,4

p=0.5

0,35

p=0.75

0,3

0,25

0,2

0,15

0,1

0,05

0

0

1

2

3

4

5

6

7

8

Binomialverteilungen für n = 8

Beispiele:

1. Ein Automat produziert Schrauben mit einer Ausschußquote von 3% . Um ein aufwendige

Qualitätskontrolle zu umgehen, werden in eine "Hunderterpackung" jeweils 105 Stück gepackt.

Wie groß ist die Wahrscheinlichkeit, beim Kauf einer Packung wenigstens 100 einwandfreie

Schrauben zu erhalten?

Lösung: Wir sehen die Produktion jeder Schraube als den Einzelversuch eines Bernoullischen

Versuchsschemas mit n Versuchen an und betrachten dabei insbesondere das Ereignis A =

"Schraube defekt". Es gilt p = P(A) = 0.03 . Bezeichnet Z die Anzahl der defekten Schrauben in den n Versuchen, dann gilt "wenigstens 100 einwandfreie Schrauben"

= {Z 5} . Es folgt

5

5

n k

105

P Z 5 P Z k pk mit pk

p 1 pn k

0. 03k 0. 97105 k .

k

k

k 0

k 0

F

IJ

G

HK

F

IJ

G

HK

Man erhält p0 = 0.041 , p1 = 0.133 , p2 = 0.213 , p3 = 0.226 , p4 = 0.179 , p5 = 0.112 und

P(Z 5) = 0.903 .

2. Eine Fluggesellschaft benutzt Maschinen mit 75 Passagierplätzen. Erfahrungsgemäß erscheinen 4.1% der Passagiere nicht zum Start der Maschine. Die Fluggesellschaft verkauft deshalb pro Flug 76 Flugkarten. Wie oft kommt es im Durchschnitt vor, daß ein Passagier mit

einem Notsitz vorliebnehmen muß?

28

Lösung: Die folgende Lösung setzt voraus, daß die Passagiere im wesentlichen unabhängig

zum Flugzeug kommen, d.h. z.B., daß die 4.1% nicht dadurch zustandegekommen sind, daß

ganze Reisegruppen das Flugzeug versäumt haben. Wir ordnen jedem der 76 Passagiere einen

Zufallsversuch zu. bei dem das Ereignis A = "Passagier erscheint zum Abflug" eintreten kann

oder nicht. Es gilt p = P(A) = 0.959 , n = 76 . Z sei die Anzahl der Fluggäste, die zum Abflug

erscheinen. Gesucht: P(Z = 76) .

76

p76 P Z 76

0. 959760. 0410 0. 95976 0. 0415 .

76

F

IJ

G

HK

3. Ein biologischer Versuch dauert 1 Jahr und gelingt in 60% aller Fälle. Wieviel versuchsansätze sind notwendig, damit mit Wahrscheinlichkeit von 0.99 wenigstens 2 Versuche

gelingen?

Lösung: Es sei A = "Versuch gelingt" . Gesucht ist die Anzahl n der durchzuführenden Versuche. Für festes n ist Z = Nn(A) B(n,p) mit p = 0.6 . Gefordert ist P Nn A 2 0. 99 .

n

n

Man erhält P Nn A 2 1 P Nn A 1 1

0. 4 n

0. 6 0. 4n1 . Gesucht ist

0

1

a

f

I

f F

G

HJ

K

a

F

I

G

HJ

K

a

f

nun das kleinste n , für das

n

n

3n

P Nn A 1

0. 4n

0. 6 0. 4n1 0. 4n 1

0. 01 gilt. Durch Probieren erhält

0

1

2

IJ F

IJ

fF

G

G

HK HK

man:

N A 1f 0. 0188

n = 7: Pa

N A 1f 0. 0085

n = 8: Pa

F

H IK

a

n

n

Es sind also 8 Versuchsansätze notwendig.

Satz 3.12.

Es sei X B(n,p) . Dann gilt

(1) EX np

(2) D2 X np1 p npq

a f

Beweis: Es seien X1 , X 2 , ... , X n unabhängige Zufallsgrößen mit P X i 1 p und

P X i 0 1 p q . Dann gilt EXi 0 q 1 p p und

D2 X i EX i2 EX i 2 0 q 1 p p2 p p2 1 p p pq . Für die Zufallsgröße

a f

n

a f

F

IJ

G

H K

F X IJ D X

D Z D G

H K

n

n

Z X i gilt dann EZ E X i EX i np und wegen der Unabhängigkeit der Xi

i 1

außerdem

i 1

2

2

n

i 1

i 1

n

i

i 1

2

i

npq . Da aber - wie bereits bekannt ist -

Z B(n,p) , folgt die Behauptung.

29

3.4.2. Der Satz von Poisson und die Poissonverteilung

Beispiel (Radioaktiver Zerfall):

Wir betrachten eine Masse eines radioaktiven Elements mit n Atomen und fragen nach der

Wahrscheinlichkeitsverteilung der Anzahl Z der Atome, die in einer Zeiteinheit zerfallen.

Wenn wir davon ausgehen, daß sich die einzelnen Atome beim Zerfall nicht wesentlich beeinflussen, d.h. praktisch unabhängig voneinander zerfallen (also insbesondere keine Kettenreaktion vorliegt) und annehmen, daß die Zerfallswahrscheinlichkeit jedes Atoms in der

Zeiteinheit p beträgt, so haben wir wieder die Situation eines Bernoullischen Versuchsn k

n k n k

p 1 pn k

p q

schemas vorliegen, und es gilt pk P Z k

. Dabei ist aber

k

k

F

IJ

G

HK

F

IJ

G

HK

n sehr groß und p sehr klein, so daß sich pk in dieser Form kaum berechnen läßt. Hier hilft

der folgende Satz weiter.

Satz 3.13. (Grenzwertsatz von Poisson)

n k

1

Es sei >0 . Dann gilt lim

n k

n

n

F

IJFI F I

G

HKHKH K

Fortsetzung des Beispiels:

Für = np erhalten wir

n k

n

pk P Z k

p 1 p n k

k

k

F

IJ

G

HK

n k

k

e

k!

F

IJF I F1 I

G

HKHn KH n K

n k

k

k

e .

k!

k

Da man für pk

e

k!

k

k

e e 1 erhält, stellen die pk eine Wahrscheinlichkeits pk e e

k 0

k 0 k !

k 0 k !

verteilung dar.

Definition 3.14.

Es sei Die Wahrscheinlichkeitsverteilung pk einer Zufallsgröße X mit Wertevorrat

k

für k W X heißt Poissonverteilung mit PaW X 0,1, 2, ... und pk

e

k!

rameter X selbst heißt poissonverteilt mit Parameter Bezeichnung: X ().

30

0,7

0,6

0,5

0,4

0,3

0,2

0,1

0

0

2

4

6

8

10

Abbildung: Poissonverteilungen

0.45

0.4

Binomialverteilung

n=8, p=0.1

0.35

Poissonverteilung

np=0.8

0.3

0.25

0.2

0.15

0.1

0.05

0

0

1

2

3

4

5

6

0.3

7

8

Binomialverteilung

n=8, p=0.5

0.25

Poissonverteilung

np=4

0.2

0.15

0.1

0.05

0

0

1

2

3

4

5

Vergleich Binomialverteilung und Poissonverteilung

31

6

7

8

Faustregel: Für np < 5 kann in vielen Fällen die Binomialverteilung durch die Poissonverteilung mit = np ersetzt werden.

Satz 3.15. (Eigenschaften der Poissonverteilung)

(1) Es sei X (). Dann gilt EX D2 X .

(2) Es seien X und Y unabhängige Zufallsgrößen mit X () und Y (µ) . Dann folgt

X + Y (+ µ) .

Numerisches Beispiel: n = 100 , p = 0.05 , k = 3 , folglich = np = 5 .

100

53

0. 053 0. 9597 0.1396 , e 5 0.1404 , relativer Fehler: 0.0057 = 0.57%

3

3!

F

IJ

G

HK

3.4.3. Versuchsdurchführung bis zum ersten Erfolg und die geometrische Verteilung

Wir betrachten jetzt einen Versuch, der solange (unabhängig) wiederholt wird, bis erstmalig

das gewünschte Ereignis A ("Erfolg") eintritt. Die Wahrscheinlichkeit, daß bei einem

Einzelversuch Erfolg eintritt, sei p . Wie beim Bernoullischen Versuchsschema fassen wir

auch hier wieder die Einzelversuche zu einem Gesamtversuch zusammen, der Unterschied

besteht jedoch darin, daß hier die Anzahl der Einzelversuche nicht durch ein festes n

beschränkt ist, sondern im Prinzip beliebig viele Versuche möglich sind.

Wir können hier als Grundraum des Gesamtversuchs

... wählen, d.h. 1 , 2 , 3 , ... : i , i 1, 2, 3, ... .

k a

f

p

Hier werden also gedanklich die Einzelversuche unendlich oft wiederholt.

Es sei nun wieder Ai = "A im i-ten Versuch" . Offenbar ist P(Ai) = p .

(Als Teilmenge des Grundraumes hat Ai jetzt die Darstellung

Ai 1 , 2 , 3 , ... : i A ...

... ).

{A

n a

f

s

i ter Faktor

Es bezeichne X die Anzahl der Versuche, bevor der erste Erfolg eintritt.

Dann gilt

p0 P X 0 P A1 p ,

p1 P X 1 P A1 A2 1 p p und allgemein

pk

af

b g

P X k Pb

A A ... A A g

1 p

1

2

k

k 1

k

p q k p für k N , q = 1 - p .

Definition 3.16.

Es sei p [0,1] , q = 1 - p Die Wahrscheinlichkeitsverteilung pk einer Zufallsgröße X mit

Wertevorrat W X 0,1, 2, ... und pk q k p für k W X heißt geometrische

Verteilung mit Parameter pX selbst heißt geometrisch verteilt mit Parameter p Bezeichnung: X (p) .

32

k 0

k 0

k 0

(Offenbar gilt pk q k p p q k p

1

p

1 . Diese Beziehung zur geome1 q p

trischen Reihe ist der Grund für die Namenswahl. Die geometrische Verteilung hat nichts mit

geometrischen Wahrscheinlichkeiten zu tun!)

0.8

p=0.25

0.7

p=0.50

p=0.75

0.6

0.5

0.4

0.3

0.2

0.1

0

0

2

4

6

8

10

12

14

16

Geometrische Verteilungen

Satz 3.17. (Eigenschaften der geometrischen Verteilung)

Es sei X (p) . Dann gilt

1 p q

(1) EX

p

p

1 p

q

(2) D2 X 2 2

p

p

3.4.4. Statistische Qualitätskontrolle und die hypergeometrische Verteilung

Beispiel: Ein Automat stellt Teile her, von denen normalerweise 1% Ausschuß ist. Infolge von

Verschleißerscheinungen kann dieser Anteil erheblich höher sein. Um einen Anhaltspunkt über

den aktuellen Ausschußanteil zu erhalten, werden aus der Tagesproduktion von N Stück

n = 10 Teile entnommen und deren Qualität geprüft. Wir haben hier also n Versuche

vorliegen, wobei bei jedem Versuch das Ereignis A = "Teil ist Ausschuß" eintreten kann oder

nicht. Wir wollen zunächst einmal die Wahrscheinlichkeit berechnen, daß mindestens 2 Teile

Ausschuß sind, wenn der Automat normal arbeitet, d.h. wenn unter den N Teilen M N

100

Teile Ausschuß sind. Um hier das Bernoullische Versuchsschema verwenden zu können,

müssen die einzelnen Versuche unter denselben Bedingungen durchgeführt werden und kein

Versuchsausgang darf den Ausgang eines nachfolgenden Versuchs beeinflussen. Das läßt sich

erreichen, wenn man nach dem Entnehmen eines Teiles die Qualitätskontrolle durchführt, an33

schließend das Teil wieder zurücklegt und vor der nächsten Entnahme die Teile gut "durchmischt" ("Ziehen mit Zurücklegen"). Es sei Z die Anzahl der Ausschußteile unter den entnommenen. Dann gilt

n k

10

pk P Z k

p 1 pnk

0. 01k 0. 9910k und

k

k

10

10

P Z 2 1 P Z 1 P Z 0 1

0. 011 0. 999

0. 9910 0. 0043 .

1

0

F

IJ

G

HK

F

IJ

G

HK

F

IJ

G

HK

F

IJ

G

HK

Arbeitet der Automat normal, so wird nur in 0.43% der Fälle unter den 10 entnommenen Teilen

mehr als 1 Ausschußteil sein. Sind also 2 Ausschußteile darunter, so wird man eine Reparatur

des Automaten veranlassen. Die Wahrscheinlichkeit, daß man "umsonst" eine Reparatur veranlaßt, ist 0.0043 .

Störend bei dieser Lösung ist natürlich die Annahme, daß das Teil nach der Prüfung zurückgelegt wird. Insbesondere wird man selbstverständlich ein defektes Teil nicht wieder zurücklegen wollen. Bei Prüfverfahren, bei denen die Teile zerstört werden, ist ein Zurücklegen ohnehin nicht möglich. Wir wenden uns daher jetzt dem Ziehen ohne Zurücklegen zu.

Wir nehmen an, daß unter N Objekten M das interessierende Merkmal aufweisen. Es werden

n Objekte entnommen, und es wird nach der Wahrscheinlichkeit gefragt, daß darunter k das

entsprechende Merkmal haben. (Es muß selbstverständlich 0 k n N gelten. Unter den n

entnommenen Objekten können aber auch nur dann k das Merkmal aufweisen, wenn k M

und n - k N - M gilt.) Es bezeichne Z wieder die Anzahl der Objekte unter den entnommenen, die das interessierende Merkmal haben. Wählen wir hier als Grundraum die Menge

aller Kombinationen ohne Wiederholung von N Objekten zur n-ten Klasse, so erhalten wir

hier einen klassischen Wahrscheinlichkeitsraum (vergleiche das LOTTO-Beispiel).

N

Es gibt

Möglichkeiten, aus N Objekten n Stück ohne Zurücklegen und ohne

n

M NM

Berücksichtigung der Reihenfolge zu entnehmen. Darunter sind Z k

k

nk

M

günstig für das Ereignis Z k , denn es gibt

Möglichkeiten, aus den M interk

NM

essierenden Objekten k auszuwählen, und zu jeder solchen Auswahl gibt es

nk

F

I

G

HJ

K

F

I

G

HJ

K

F

IF

I

G

HJ

KG

H J

K

F

IJ

G

H K

Möglichkeiten, aus den übrigen N - M Objekten n - k Stück auszuwählen. Damit erhalten wir

M NM

k

nk

für die gesuchte Wahrscheinlichkeit pk P Z k

.

N

n

F

IJF

IJ

G

G

HKH K

F

IJ

G

HK

Nehmen wir im obigen Beispiel N = 1000 , M = 10 und n = 10 an, so ergibt sich

34

P Z 2 1 P Z 1 1 p0 p1

10 IF

990 I F

10 IF

990 I

F

G

J

G

J

G

J

G

H0 KH10 K H1 KH9 J

K 0. 0039 . Offensicht 1

1000 I

1000 I

F

F

G

J

G

H10 K H10 J

K

lich unterscheidet sich dieser Wert nicht sehr von dem mit Hilfe der Binomialverteilung

erhaltenen. Darauf werden wir noch kurz eingehen.

Definition 3.18.

Es seien N N , M N , n N , n N , M N Die Wahrscheinlichkeitsverteilung pk

einer Zufallsgröße X mit Wertevorrat W X k N : max 0, n N M k min n, M

M NM

k

nk

und pk P X k

für k W X heißt hypergeometrische Verteilung mit

N

n

F

IF

I

G

HJ

KG

H J

K

F

I

G

HJ

K

den Parametern N , M und n . X selbst heißt hypergeometrisch verteilt mit den Parametern

N , M und n Bezeichnung: X (N, M, n) .

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

0

2

4

6

8

10

Hypergeometrische Verteilung mit N = 100 , M =20 . n = 10

Satz 3.19. (Eigenschaften der hypergeometrischen Verteilung)

Es sei X (N, M, n) . Dann gilt

M

(1) EX n

N

M

M Nn

2

1

(2) D X n

N

N N 1

F

H IK

Wir haben in obigem Beispiel für die hypergeometrische Verteilung einen ähnlichen Wert wie

für die Binomialverteilung erhalten. Wir wollen uns jetzt überlegen, unter welchen Bedingungen das zu erwarten ist. Es gilt

M NM

N M!

M!

n

M ! N M ! n ! N n !

M k! N M n k!

k

nk

pk

N!

N

k

k ! M k ! n k ! N M n k ! N !

N n !

n

F

IJF

IJ

G

G

HKH K

F

IJ

G

HK

F

IJ

G

HK

35

n k Faktoren

k Faktoren

n N M n k 1 N M n k 2

n

N M M k 1

M

nk

...

...

1 p p k

N n 1

N n2

N k N k 1

N

k

k

M

p (n , k fest).

falls N und

N

n k

M

Für große Stichprobenumfänge ist also pk

.

p 1 pnk mit p

k

N

M 1

Numerisches Beispiel: N = 100 , M = 10 , n = 4 , k = 1 , also p

.

N 10

10 90

4 1 1 9 3

1 3

0. 2916 . Der relative Fehler bez. der Näherung be 0. 2996 ,

100

1 10 10

4

F

IJ

G

HK

F

IJF

IJ

G

G

HKH K

F

IJ

G

HK

F

IJF I F I

G

HKH KH K

trägt also 2.7%

36