Beispiel 24 Parameter der Rechteckverteilung

Werbung

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

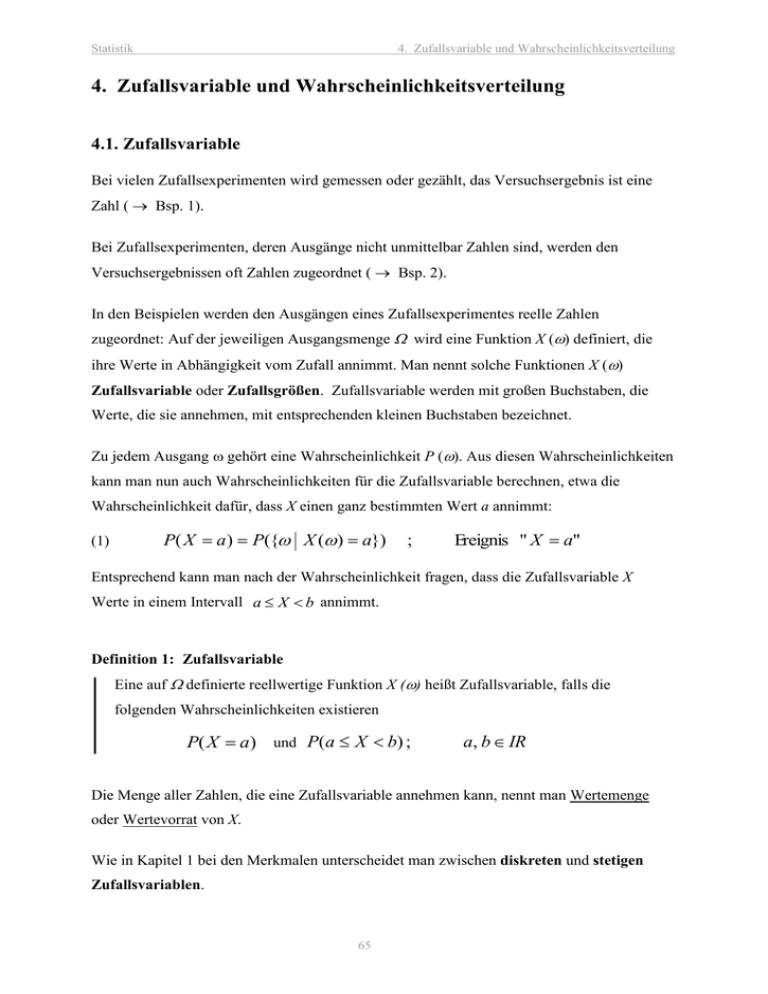

4.1. Zufallsvariable

Bei vielen Zufallsexperimenten wird gemessen oder gezählt, das Versuchsergebnis ist eine

Zahl ( Bsp. 1).

Bei Zufallsexperimenten, deren Ausgänge nicht unmittelbar Zahlen sind, werden den

Versuchsergebnissen oft Zahlen zugeordnet ( Bsp. 2).

In den Beispielen werden den Ausgängen eines Zufallsexperimentes reelle Zahlen

zugeordnet: Auf der jeweiligen Ausgangsmenge wird eine Funktion X () definiert, die

ihre Werte in Abhängigkeit vom Zufall annimmt. Man nennt solche Funktionen X ()

Zufallsvariable oder Zufallsgrößen. Zufallsvariable werden mit großen Buchstaben, die

Werte, die sie annehmen, mit entsprechenden kleinen Buchstaben bezeichnet.

Zu jedem Ausgang gehört eine Wahrscheinlichkeit P (). Aus diesen Wahrscheinlichkeiten

kann man nun auch Wahrscheinlichkeiten für die Zufallsvariable berechnen, etwa die

Wahrscheinlichkeit dafür, dass X einen ganz bestimmten Wert a annimmt:

(1)

P( X a ) P({ X ( ) a})

;

Ereignis " X a"

Entsprechend kann man nach der Wahrscheinlichkeit fragen, dass die Zufallsvariable X

Werte in einem Intervall a X b annimmt.

Definition 1: Zufallsvariable

Eine auf definierte reellwertige Funktion X () heißt Zufallsvariable, falls die

folgenden Wahrscheinlichkeiten existieren

P( X a) und P(a X b) ;

a, b IR

Die Menge aller Zahlen, die eine Zufallsvariable annehmen kann, nennt man Wertemenge

oder Wertevorrat von X.

Wie in Kapitel 1 bei den Merkmalen unterscheidet man zwischen diskreten und stetigen

Zufallsvariablen.

65

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 1:

a) Augenzahl eines Würfels

b) Zahl der in einer Telefonzentrale pro Tag eingehenden Gespräche

c) Größe oder Gewicht einer zufällig ausgewählten Person

d) Alle experimentellen Messungen

Beispiel 2:

a) Qualitätskontrolle: brauchbar 1; unbrauchbar 0

b) mehrmaliges Werfen einer Münze: Anzahl „Wappen“

c) Glücksspiel: Gewinn

Beispiel 3:

Anzahl der „Wappen“ bei dreimaligem Werfen einer Münze.

= { ZZZ, ZZW, ZWZ, ZWW, WZZ, WZW, WWZ, WWW}

X () = Anzahl der W

Ausgang :

X ():

ZZZ ZZW ZWZ ZWW WZZ WZW WWZ WWW

0

1

2

3

Unter der Voraussetzung einer idealen Münze kann man leicht Wahrscheinlichkeiten

berechnen, etwa:

P ( X 3)

1

;

8

P (0 X 1,5)

P ( X 2)

1

;

2

3

8

P ( X 3) 0

66

x

Statistik

4.2.

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Diskrete Zufallsvariable

4.2.1. Beschreibung diskreter Zufallsvariabler

Definition 2: Diskrete Zufallsvariable

Eine Zufallsvariable heißt diskret, falls ihre Wertemenge nur endlich oder abzählbar

unendlich viele verschiedene Werte enthält.

Diskrete Zufallsvariable entsprechen den diskreten Merkmalen in Kapitel 2.1. Man kann sie

durch Funktionen beschreiben, die den Häufigkeitsfunktionen einer Stichprobe sehr ähnlich

sind; die Rolle der relativen Häufigkeiten übernehmen jetzt die Wahrscheinlichkeiten.

Zur Beschreibung einer diskreten Zufallsvariablen X benötigt man die Wahrscheinlichkeiten

(2)

P ( X xk ) f ( xk ) ;

f ( xk ) heißt Wahrscheinlichkeitsfunktion von X

Bei jeder Durchführung des Zufallsexperimentes nimmt die Zufallsvariable X genau einen

ihrer Werte an. Die zugehörigen Ereignisse „ X x1 “, „ X x 2 “ ... sind unvereinbar, bilden

also eine Ausgangsmenge, aus der alle für X interessierenden Ereignisse aufgebaut werden

können. Für ihre Wahrscheinlichkeiten gilt (vgl. entsprechende Eigenschaften der relativen

Häufigkeiten)

(3)

0 f ( xk ) 1

(4)

f ( xk ) 1

xk

wobei in (4) die Wahrscheinlichkeiten aller x k der Wertemenge von X aufsummiert werden.

Eine diskrete Zufallsvariable X kann somit eindeutig beschrieben werden durch die

Zahlenpaare ( x k , f ( x k )) , die man zweckmäßig in einer Verteilungstabelle

(Wahrscheinlichkeitstabelle) anordnet:

(5)

X:

x1

f (x )

1)

x2

f ( x2

...

. . .

67

Statistik

Beispiel 4a:

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Idealer Würfel, X = Augenzahl

xk

1

2

3

4

5

6

f ( xk )

1

6

1

6

1

6

1

6

1

6

1

6

Beispiel 5:

( = 1)

Idealer Würfel, X = Anzahl der Würfe bis zur ersten Sechs

xk

1

2

3

...

f ( xk )

1

6

5 1

6 6

5 1

6 6

k

2

5

6

…

IN

...

k 1

1

6

…

( = 1)

Die Wahrscheinlichkeiten f ( x k ) sind das theoretische Gegenstück zu den relativen

Häufigkeiten in Kapitel 2.1. Dort wird ein Merkmal aber auch beschrieben durch die

~

relativen Summenhäufigkeiten, bzw. die empirische Verteilungsfunktion F (x); ganz

entsprechend definiert man jetzt die Verteilungsfunktion F ( x ) einer diskreten

Zufallsvariablen als Summe aller Wahrscheinlichkeiten „von links her bis zur Stelle x“:

F ( x ) P( X x )

(6)

f ( xk )

xk x

Die graphische Darstellung der Wahrscheinlichkeiten f ( xk ) ergibt ein Stabdiagramm, die

Darstellung von F (x) eine monoton von 0 nach 1 wachsende Treppenfunktion.

Beispiel 4b:

Idealer Würfel, X = Augenzahl

x

0

1

2

3

4

5

6

7

f (x)

0

1

6

1

6

1

6

1

6

1

6

1

6

0

F (x)

0

1

6

2

6

3

6

4

6

5

6

1

1

68

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Die letzte Zeile bedeutet dabei ausführlich

F( x )

0

1

6

1

3

...

1

für

x 1

für

1 x 2

für

2 x3

für

6 x

1

f(x)

F(x)

1

2

1

2

1

6

1

6

1

Beispiel 6:

2

3

4

5

6

x

1

x

0

1

2

3

f (x)

1

8

3

8

3

8

1

8

F (x)

1

8

4

8

7

8

1

4

5

6

F (x)

1

1

1

2

1

2

1

3

Dreimaliges Werfen einer idealen Münze, X = Anzahl der Wappen

(vgl. Bsp. 3 in Abschnitt 2.1.)

f(x)

0

2

2

3

0

x

69

1

2

3

x

x

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Eigenschaften der Verteilungsfunktion einer diskreten Zufallsvariablen:

Jede diskrete Zufallsvariable X hat als Verteilungsfunktion eine Treppenfunktion F (x) , die an

den Stellen x k Sprünge der Höhe f ( x k ) P( X x k ) besitzt, mit folgenden Eigenschaften:

(7a)

F ( ) 0

(7b)

F ( ) 1

(7c)

x x*

F ( x ) F ( x* )

monoton nicht fallend

Mit Hilfe der Verteilungsfunktion F (x) kann man sehr einfach die Wahrscheinlichkeit

berechnen dafür, dass X Werte aus einem Intervall annimmt:

(8)

P(a X b) F (b) F (a)

(9)

P( X a) 1 P( X a) 1 F (a)

70

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

4.2.2. Erwartungswert einer diskreten Zufallsvariablen

Eine Zufallsvariable sei gegeben durch die Verteilungstabelle

(10)

X:

x1

f(x )

1

x2

f(x2 )

... xn

... f(xn )

n

mit

f ( xi ) 1

i 1

Wird das zugehörige Experiment sehr oft ausgeführt, so interessiert man sich dafür, welchen

Wert X „im Mittel“ annimmt.

Definition 3: Erwartungswert

Der Mittelwert aller Werte x i gewichtet mit ihren Wahrscheinlichkeiten f ( xi ) heißt

Erwartungswert (Mittelwert) der Zufallsvariablen X:

(11)

E( X )

n

x

i 1

i

f(xi )

Ist eine Verteilung wie in Beispiel 7 symmetrisch, dann ist ihr Erwartungswert natürlich das

Symmetriezentrum.

Ist Y g ( X ) eine für alle Werte der Zufallsvariablen X definierte Funktion, dann ist auch Y

eine diskrete Zufallsvariable mit den Werten y i g ( xi ) . Da die Werte g ( xi ) mit derselben

Wahrscheinlichkeit f ( xi ) angenommen werden wie die Werte xi , erhält man als Erweiterung

der Definition (11) den Erwartungswert einer Funktion der Zufallsvariablen X :

E (Y ) E[ g ( X )]

(12)

n

g ( xi ) f ( xi )

i 1

Wichtig sind die Erwartungswerte der Funktionen X k und ( X ) k ; k = 1, 2, 3, ... :

(13)

n

k E ( X ) xi k f ( xi )

k

... k. Moment

i 1

n

(14)

k E[( X ) k ] ( xi ) k f ( xi )

i 1

... k. zentrales Moment

Speziell gilt

0 E ( X 0 ) E (1) 1 , 1 E ( X 1 ) E ( X )

71

Statistik

Beispiel 7:

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Erwartungswerte diskreter Zufallsvariabler

a) Würfel (Beispiel 4):

E( X ) 1

1

1

1

2 ... 6 3,5

6

6

6

b) dreimaliger Münzwurf (Beispiel 6):

E( X ) 0

1

3

3

1

1 2 3 1,5

8

8

8

8

Beachten Sie in beiden Fällen die Symmetrie!

Beispiel 8:

Ein Spieler wirft 2 Münzen. Bei „WW“ erhält er 4 Euro, für jedes „Z“

muss er 1 Euro zahlen. Wie groß ist bei häufigem Spielen sein mittlerer

Gewinn?

Lösung:

Sei X = Anzahl der W, dann ist der Gewinn Y des Spielers eine Funktion

der Zufallsvariablen X, also selbst eine Zufallsvariable Y g ( X )

Die gesuchte durchschnittliche Gewinnerwartung ist der Erwartungswert

von g ( X ) .

Für X und Y lauten die Verteilungstabellen (gleiche Einzelwahrsch.!)

0 1 2

X : 1 1 1

4 2 4

E[ g ( X )] 2

- 2

Y g(X ) : 1

4

1

1

1

1 4 0

4

2

4

72

-1

1

2

4

1

4

… „faires Spiel“

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

4.2.3. Varianz und Standardabweichung einer diskreten Zufallsvariablen

Der Erwartungswert der Zufallsvariable X ist ein reiner Lageparameter; er gibt zwar

Auskunft, um welchen mittleren Wert die zufällige Größe gruppiert ist, sagt aber nichts aus

über ihre Verstreutheit. So haben die zwei Zufallsvariablen X und Y in Beispiel 9 zwar

denselben Erwartungswert, die Werte von Y streuen aber viel stärker als die Werte von X.

Der Erwartungswert der Differenz ( X ) ist wegen

(15)

E( X ) E( X ) 0

als Maß für die Streuung ungeeignet. Der Erwartungswert von X wäre zwar ein

vernünftiges Streuungsmaß, mathematisch günstiger ist es aber, den Erwartungswert der

Abstandsquadrate zu bilden (vgl. entsprechende Überlegungen bei der Einführung von

Streuungsparametern in Kapitel 2).

Definition 4: Varianz und Standardabweichung einer diskreten Zufallsvariablen X

n

(16.a)

2 Var( X ) E[( X )2 ] ( xi )2 f ( xi ) ... Varianz

i 1

(16.b)

Var ( X )

... Standardabweichung

Ist 2 klein, so muss jedes Glied der Summe klein sein: Werte, die weit von entfernt liegen,

besitzen eine kleine Wahrscheinlichkeit. Umgekehrt folgt bei großem 2 , dass nicht alle x i

nahe bei liegen können.

Zur einfacheren Berechnung von 2 kann man (16.a) noch etwas umformen:

(17)

2 Var( X ) E ( X 2 ) 2

... Verschiebungssatz

Übung : Beweisen Sie Gleichung (15) und den Verschiebungssatz (17).

73

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 9:

5

6 7

8

9

4

X:

0,2 0,2 0,2 0,1 0,1 0,2

x 6,3

2

4

8 10 11

1

Y:

0,2 0,1 0,2 0,1 0,1 0,3

y 6,3

0.3

0.3

0.2

0.2

0.1

0.1

0

1

2

3

4

5

µ-

6

7

µ

8

9

10

µ+

11

>

0

>

0

f2(y)

0.4

f1(x)

0.4

0

12

x

1

2

3

4

µ-

Varianzen (mit (17) berechnen!):

x 2 16 0,2 25 0,2 36 0,2 49 0,1 64 0,1 81 0,2 6,3 2

42,9 39,69 3,21

y 2 1 0,2 4 0,1 16 0,2 64 0,1 100 0,1 121 0,3 6,3 2

56,5 39,69 16,81

Standardabweichung:

x 3,21 1,79

Veranschau lichung im Diagramm!

y 16,81 4,10

74

5

6

7

µ

8

9

10

11

µ+

12

y

Statistik

4.3.

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Theoretische diskrete Verteilungen

4.3.1. Binomialverteilung

Bei vielen Zufallsexperimenten interessieren nur zwei sich gegenseitig ausschließende

Ereignisse, von denen bei jeder Durchführung genau eines eintritt: „Erfolg“ oder

„Misserfolg“.

Die Zufallsexperimente in Beispiel 10 haben folgende gemeinsame Eigenschaften:

1)

Der Ausgangsraum enthält nur zwei Elemente A und A :

(18)

2)

A,

P(A) p

A mit

P (A ) q 1 - p

A Erfolg

A Mißerfolg

Die Versuche sind beliebig oft wiederholbar unter gleichen

Bedingungen; die Wiederholungen sind voneinander unabhängig.

Ein Zufallsexperiment mit diesen Eigenschaften heißt Bernoulli-Experiment.

Beispiel 10:

a)

b)

c)

d)

Werfen eines Münze: {Wappen; Zahl}

Untersuchung von Werkstücken: {brauchbar, unbrauchbar}

Ziehen aus einer Urne mit roten und weißen Kugeln mit Zurücklegen: {rot, weiß}

Medikament: {wirksam, nicht wirksam}

Bei Bernoulli-Experimenten stellt sich die Frage nach der Anzahl der Erfolge bei n

Versuchen. Wir betrachten dazu die Zufallsvariable

X =

Anzahl der Erfolge bei n-maliger Durchführung eines Bernoulli-Experimentes

Das Ereignis „ X k “, d.h. „k Erfolge bei n Versuchen“, lässt sich auf verschiedene Weisen

realisieren: Es besteht aus allen geordneten n-Tupeln mit k -mal A und (n k ) -mal A , d.h.

aus einfachen Ereignissen der Form (in der Klammer aufgelistet sind der Reihe nach die

beobachteten Ergebnisse A bzw. A )

(19)

( A A A A A ... A A)

mit

k mal A, ( n k ) mal A

0k n

Die n Einzelversuche sind nach Voraussetzung unabhängig; für die Wahrscheinlichkeit eines

solchen Ereignisses (19) folgt also nach dem Multiplikationssatz für unabhängige Ereignisse

(20)

P( ) P( A) k P( A )n k p k (1 p )n k

75

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 11:

3-maliges Würfeln, B = „genau 2 Sechsen“, P( B) ?

Lösung:

A = „Sechs“, A = „keine Sechs“, p P ( A)

1

6

Mögliche Realisierungen ( Elementereignisse ):

AAA ,

AA A ,

A AA

B AAA AA A A AA

Wahrscheinlichkeit der Elementarereignisse:

2

1 5

P( AAA ) P( AA A) P( A AA) P( A) P( A) P( A )

6 6

2

1 5

P( B) P( AAA ) P( A AA) P( A AA) 3

6 6

Die Realisierungen (n-Tupel) der Bauart (19) lassen sich wie folgt aufbauen:

1. Schritt: Auswahl von k Stellen aus n für Erfolg A

2. Schritt: restliche Stellen mit A auffüllen

n

n1 Möglichkeiten

k

n2 1 Möglichkeit

Nach dem Fundamentalen Zählprinzip besteht das interessierende Ereignis „ X k “ also aus

n

n1 n 2 gleichwahrscheinlichen unvereinbaren Ereignissen. Mit Hilfe des

k

Additionssatzes für unvereinbare Ereignisse folgt damit für die gesuchte Wahrscheinlichkeit:

(21)

n

P( X k ) f B (k ; n; p) p k (1 p)n k

k

; k 0 , 1, ... n

f B ( k ; n; p ) heißt Wahrscheinlichkeitsfunktion der Binomialverteilung mit den

Parametern n und p.

Aus (21) ergibt sich für die Verteilungsfunktion der Binomialverteilung

(22)

FB ( x; n; p ) P( X x )

0

x

f B ( k ; n; p )

für x 0

für x 0

k 0

Aufsummiert wird dabei von 0 bis zur größten natürlichen Zahl k mit k x .

76

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 12:

Wie groß ist die Wahrscheinlichkeit dafür, dass bei dreimaligem Werfen

eines idealen Würfels genau 3 ( 2, 1, 0 ) -mal eine Augenzahl kleiner als

5 auftritt?

Lösung:

A " kleiner als 5" {1, 2, 3, 4 } ;

Binomialverteilung mit n 3 ,

P( X 3)

2

f B (3; 3; )

3

P( X 2) f B ( 2; 3;

P( X 1)

2

)

3

2

f B ( 1; 3; )

3

P( X 0) f B ( 0; 3;

3

2

)

3

P ( A)

p

2

3

2

3

0

3 2 1

3 3 3

2

1

3 2 1

2 3 3

1

2

3 2 1

1 3 3

0

3

3 2 1

0 3 3

1

8

1

27

8

27

3

4 1

9 3

12

27

2 1

3

3 9

11

1

27

1

6

27

1

27

Binomialverteilte Zufallsvariable kommen in der praktischen Anwendung häufig vor. Werte

von f B (k ; n; p) und FB (k; n; p) findet man in Tabellen bzw. als Statistik-Funktionen in

Taschenrechnern und PCs. Wegen der Symmetrie der Binomialkoeffizienten

n

n

k

n k

(23)

werden nur Werte für p 0,5 tabelliert; wegen (23) gilt dann

f B (k ; n ; p) f B (n k ; n ; 1 p )

(24)

Für Mittelwert und Varianz 2 einer binomialverteilten Zufallsvariablen mit den

Parametern n und p erhält man

(25)

E( X ) B n p ;

Beispiel 13:

Var( X ) B 2 n p (1 p) n p q

X sei die Anzahl der Wappen beim viermaligen Werfen einer idealen

Münze. Wie groß sind E ( X ) und Var ( X ) ?

77

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Lösung:

Binomialverteilung mit den Parametern

1

2

2

1 1

4 1

2 2

E( X ) 4

Aus (25) folgt

Var( X ) 2

n4 ;

p q

1

2

(anschauli ch klar! )

Wenn keine Verwechslungsgefahr besteht, lässt man die Parameter n und p in der

Argumentklammer weg und schreibt kurz

f B ( k ) , FB ( x )

anstelle von

f B ( k ; n ; p ) , FB ( x ; n ; p )

Mit (21) und (22) lassen sich leicht folgende Wahrscheinlichkeiten berechnen (für beliebige

Parameter n IN und 0 p 1 ):

a) Höchstens s Erfolge (s = 0, 1, ... n)

(26)

P( X s )

s

f B (k ) FB ( s)

k 0

b) Mindestens r Erfolge (r = 0, 1, ... n)

(27)

P( X r )

n

r 1

k r

k 0

f B (k ) 1 f B (k ) 1 FB ( r 1)

c) Mindestens ein Erfolg

(28)

P( X 1) 1 f B (0) 1 FB (0) 1 q n

d) Mindestens r und höchstens s Erfolge

(29)

P( r x s ) f B ( r ) ... f B ( s ) FB ( s ) FB ( r 1)

78

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Diagramme zur Binomialverteilung

Die folgenden Bilder zeigen die Abhängigkeit der Binomialverteilung von ihren Parametern

n und p ; zur besseren Veranschaulichung sind statt Stabdiagrammen die entsprechenden

Polygonzüge gezeichnet.

p = 0.1

0.4

p = 0.9

0.3

p = 0.3

p = 0.7

p = 0.5

0.2

0.1

0

0

1

2

3

4

5

6

7

8

9

10

k

a) Abhängigkeit von p bei festem n 10

n

2

1

p

Die Verteilung für

entsteht aus der Verteilung für p durch Spiegelung am

Mittelpunkt x M .

Für p 0,5 ist die Verteilung symmetrisch zu x M

n=5

0.4

n = 10

0.3

n = 25

0.2

0.1

0

0

1

2

3

4

5

6

7

8

9

10

k

b) Abhängigkeit von n bei festem p 0,2

Mit wachsendem n nähern sich die Polygone immer mehr einer

symmetrischen Glockenkurve mit Maximum bei np

79

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

4.3.2. Poissonverteilung (Verteilung seltener Ereignisse)

Bei vielen Anwendungen, die durch Bernoulli-Experimente beschrieben werden können, ist

die Erfolgswahrscheinlichkeit p des einzelnen Experiments klein, während die Anzahl n der

Experimente sehr groß ist.

Beispiel 14:

a) Atomzerfall: Die Wahrscheinlichkeit, dass ein bestimmtes Atom einer gewissen Menge

radioaktiven Materials im Zeitraum t zerfällt, ist sehr klein; die Anzahl der Atome ist

sehr groß…

b) Anzahl der Verkehrsunfälle pro Tag in einer Großstadt

c) Anzahl der Kunden, die während einer Minute an einem Schalter ankommen

d) Anzahl der Druckfehler pro Seite in einem Buch

Für großes n und kleines p ist die Berechnung der Binomialkoeffizienten sehr mühsam.

Vorteilhaft erweist sich bei solchen „seltenen Ereignissen“ die Näherung

(30)

n

p0

Setzt man p

n

n p const

mit

, q 1

n

( ist der Erwartungswert )

in die Wahrscheinlichkeitsfunktion f ( k ; n , p ) der

B

Binomialverteilung (21) ein und lässt n gehen, dann geht die Wahrscheinlichkeitsfunktion f ( k ; n , p ) mit den zwei Parametern n und p über in die WahrscheinlichkeitsB

funktion f ( k ; ) mit dem einen Parameter n p :

P

(31)

P( X k ) f P ( k ; )

k

k!

e ,

k 0 , 1, 2 , . . .

. . . Wahrscheinlichkeit der Poisson-Verteilung mit dem Mittelwert

(Verteilung seltener Ereignisse)

80

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Schreibt man die Wahrscheinlichkeiten der Reihe nach an, so erhält man die

Wahrscheinlichkeitstabelle

k

0

e

f (k )

P

1

e

2

3

2

2

e

...

3

3!

e

...

Betrachtet man die Einzelwahrscheinlichkeiten f (k ) in dieser Tabelle, so erkennt man

P

leicht folgende rekursive Beziehung zwischen f (k ) und f (k 1)

P

f P (k )

(32)

k

P

f P (k 1)

Beim Grenzübergang (30) ergibt sich aus der Varianz

Varianz

2

P

2

B

der Binomialverteilung (25) die

der Poissonverteilung:

B 2 n p q (1

n

)

P2

für

n

Poisson-verteilte Zufallsvariable haben also die Varianz

2

(33)

In Tabellen bzw. PC-Software findet man neben den Einzelwahrscheinlichkeiten f (k ; )

P

auch die zugehörigen Verteilungsfunktionen F ( k ; ) ; häufig steht dabei anstelle von k die

P

Variable x.

Zur Veranschaulichung der Güte der Poisson-Näherung sind in der folgenden Tabelle einige

Binomial- und Poisson-Wahrscheinlichkeiten für n p 1 zusammengestellt:

Binomial

Poisson

1

k

n = 4; p = 1/4

n = 10; p = 1/10

n = 100; p =1/100

0

0,316

0,349

0,366

0,368

1

0,422

0,387

0,370

0,368

2

0,211

0,194

0,185

0,184

3

0,047

0,057

0,061

0,061

4

0,004

0,011

0,015

0,015

5

-

0,002

0,003

0,003

81

Statistik

Beispiel 15:

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Zahlenwerte zur Poisson-Näherung

3

60

3

57

f B ( 3 ; 60 ; 0,01 ) 0,01 0,99

0,0193

3

f P ( 3 ; 0,6 )

0,6

0,6

e

0,0198

3!

70

4

66

f B ( 4 ; 70 ; 0,03 ) 0,03 0,97

0,0995

4

f P ( 4 ; 2,1 )

2,1

2,1

e

0,0992

4!

100

2

98

0,05 0,95

f B ( 2 ; 100 ; 0,05 )

0,0812

2

f P ( 2; 5)

4

2

5

5

e

0,0842

2!

Beispiel 16: Eine Telefonvermittlung wird im Durchschnitt m-mal pro Stunde beansprucht.

Wie groß ist die Wahrscheinlichkeit für

a) 3 Anrufe in 2 Minuten,

b) mindestens 1 Anruf in 2 Minuten,

c) mindestens 3 Anrufe in 2 Minuten?

Lösung:

Die Anzahl X der Anrufe in einem (beliebigen) Zeitintervall der Länge 2 Minuten ist

poissonverteilt mit

E( X )

m

m

2

;

60

30

k

f P (k )

1 m

m / 30

e

k! 30

3

a) P( X 3)

1 m

m / 30

e

3! 30

m / 30

b) P( X 1) 1 P( X 0) 1 f P (0) 1 e

c) P( X 3) 1 P( X 2) 1 f P (0) f P (1) f P (2) 1 e m / 30 1

Zahlenwerte für m = 60:

Pa 0,18 ;

Pb 0,865 ;

82

Pc 0,32

2

m 1 m

30 2 30

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 17:

Folgende Tabelle enthält die Ergebnisse einer Zählung von Fadenbrüchen an einer

Webmaschine. Zeigen Sie, dass angenähert eine Poisson-Verteilung vorliegt.

Fadenbrüche pro Längeneinheit

Häufigkeit

0

1

2

3

4

5

6

15

26

21

19

8

3

0

Lösung:

Als Schätzwert für den Parameter nimmt man den arithmetischen Mittelwert der

Stichprobe

0 15 1 26 2 21 3 19 4 8 5 3 6 0

172

1,87

15 26 21 19 8 3 0

92

k

1,87

1,87

f P ( k ; 1,87 )

e

k!

Poisson-Wahrscheinlichkeiten:

Zum Vergleich mit den beobachteten absoluten Häufigkeiten werden die PoissonWahrscheinlichkeiten f (k ) mit dem Stichprobenumfang n 92 multipliziert; anschließend

P

wird gerundet:

k

0

1

2

3

4

5

6

f (k )

0,1541

0,2882

0,2695

0,1680

0,0785

0,0294

0,0092

92 f (k )

14,18

26,51

24,79

15,46

7,22

2,70

0,84

≈

14

27

25

15

7

3

1

P

P

4.3.3 Hypergeometrische Verteilung

Betrachtet werden zwei unterschiedliche Ziehungen: In einer Urne sind N Kugeln, M

schwarze und (N – M) weiße. Es werden n Kugeln gezogen

a) mit Zurücklegen

b) ohne Zurücklegen.

Wie groß ist die Wahrscheinlichkeit, genau k schwarze Kugeln zu ziehen?

Ist „X = Anzahl der schwarzen Kugeln in der Menge der n gezogenen Kugeln“ ein, dann sind

die Wahrscheinlichkeiten P( X k ) ; k 0 , 1, . . . n zu bestimmen

83

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Im Fall a) handelt es sich bei den Ziehungen um n Bernoulli-Experimente mit p

M

, die

N

gesuchte Wahrscheinlichkeit ist die Binomial-Wahrscheinlichkeit :

(34)

n

Pa ( X k ) f B ( k ; n ; p ) p k (1 p)n k

k

mit

p

M

.

N

Im Fall b) erhält man die gesuchte Wahrscheinlichkeit mit den Hilfsmitteln der Kombinatorik

nach der klassischen Definition

P( A)

A

Anzahl der für A günstigen Fälle

Anzahl der möglichen Fälle

Die Anzahl der möglichen Fälle ist gleich der Anzahl der ungeordneten n Stichproben ohne

Zurücklegen aus einer N-Menge

N

n

Günstig für das Ereignis A = „X – k“ sind alle Anordnungen von k aus M schwarzen und

(n – k) aus (N – M ) weißen Kugeln

M N M

A

k

n

k

(Fundamentales Zählprinzip!)

Damit ergibt sich für die gesuchte Wahrscheinlichkeit bei der Ziehung b) ohne Zurücklegen

(35)

M N M

k n k

Pb ( X k ) f H ( k ; n; M ; N )

N

n

0k n

kM

nk N M

f ( k ; n; M ; N ) heißt Wahrscheinlichkeitsfunktion der Hypergeometrischen

H

Verteilung mit den Parametern n, M und N .

(*)

2

Für Erwartungswert und Varianz einer hypergeometrisch verteilten Zufallsvariablen X

mit den Parametern n, N, M erhält man

(36)

E ( X ) H n

M

;

N

Var( X ) H2

84

n M ( N M )( N n )

N 2 ( N 1)

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Die hypergeometrische Verteilung spielt beim Ziehen ohne Zurücklegen dieselbe Rolle wie

die Binomialverteilung beim Ziehen mit Zurücklegen. Für große Werte von N, M , N - M und

kleine Werte von n werden sich die Wahrscheinlichkeiten beim Ziehen mit bzw. ohne

Zurücklegen nur wenig unterscheiden, die dreiparametrige hypergeometrische Verteilung (59)

kann dann angenähert werden durch die zweiparametrige Binomialverteilung (58).

Anwendung der hypergeometrischen Verteilung in der Qualitätskontrolle

Bei der Massenfertigung von Werkstücken kann die Endkontrolle des Herstellers bzw. die

Abnahmekontrolle des Kunden nach folgendem Schema erfolgen:

Werden die Werkstücke in Packungen zu jeweils N Stück geliefert, dann wird jeder Packung

durch Ziehen ohne Zurücklegen eine Stichprobe von n Stück entnommen. Enthält diese

Stichprobe nicht mehr als eine zugelassene Zahl c fehlerhafter Stücke, so wird die Packung

angenommen, andernfalls wird sie zurückgewiesen. Die Wahrscheinlichkeit P, dass eine

Packung angenommen wird, heißt Annahmewahrscheinlichkeit; sie hängt natürlich ab vom

relativen Anteil M/N der fehlerhaften Stücke.

Beispiel 18

Eine Lieferung von 100 Teilen enthält 10 Ausschussteile; fünf Teile werden überprüft. Wie

groß sind die Wahrscheinlichkeiten für k = 0, 1, . . . 5 fehlerhafte Teile in der Stichprobe

a) exakt (Ziehung ohne Zurücklegen)

b) näherungsweise (Ziehung mit Zurücklegen)

(*) Die Reihenfolge der beiden Parameter N und M in der Argumentklammer ist in der

Statistik-Literatur nicht einheitlich; wir folgen hier der Reihenfolge der Parameter in der

Excel-Funktion HYPGEOMVER .

85

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Lösung:

a) Hypergeometrische Verteilung mit den Parametern n = 5; M = 10; N = 100

10 90

0

5

P( X 0)

100

5

(35)

P( X 1)

10 90

1 4

100

5

P( X 2)

10 90

2 3

100

5

90 89 88 87 86

1 2 3 4 5

100 99 98 97 96

1 2 3 4 5

1

0,5838

10 90 89 88 87 5

100 99 98 97 96

0,3394

0,0702

P( X 3) . . .

0,0064

P( X 4) . . .

0,0003

P( X 5) . . .

0,0000

b) Binomialverteilung mit den Parametern n = 5 ; p = 0,1

5

3

f (0) 0,9 0,5905

B

4

4

f B (1) 5 0,1 0,9 0,3281

2

2

f (3) 10 0,1 0,9 0,0081

B

f B (4) 5 0,1 0,9 0,00045

3

f B (2) 10 0,1 0,9 0,0729

5

f B (5) 0,1 0,0000

Zusatz: Erwartungswert und Varianz der Zufallsvariablen in Beispiel 18

H B n

2

H

M

5 0,1 0,5

N

n M ( N M )( N n)

2

N ( N 1)

5 10 90 95

2

100 99

2

B n p (1 p) 5 0,1 0,9 0,45

86

0,4318

H

B

0,657

0,671

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

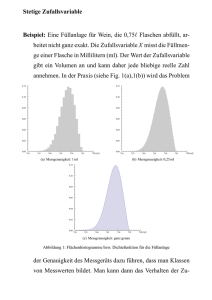

4.4. Stetige Zufallsvariable

In der beschreibenden Statistik (Kapitel 2) betrachten wir neben diskreten Merkmalen auch

stetige Merkmale mit kontinuierlicher Verteilung; diesen stetigen Merkmalen entsprechen in

der Wahrscheinlichkeitsrechnung stetige Zufallsvariablen mit einem Intervall als

Wertebereich ( Beispiel 19).

Definition: Stetige Zufallsvariable

Eine Zufallsvariable X heißt stetig, wenn eine nicht negative integrierbare Funktion f

existiert, so dass die zugehörige Verteilungsfunktion F in Integralform dargestellt

werden kann

F ( x ) P( X x )

(37)

x

f (u) du.

f (x) heißt Dichtefunktion oder Dichte der stetigen Zufallsvariablen X.

Aus (37) folgt wegen P( X ) 1

(38)

f (u) du

1

(vgl. diskret:

f (x ) 1)

i

i

und nach dem Hauptsatz der Differential- und Integralrechnung

(39)

F ( x) f ( x)

(für jede Stetigkeitsstelle von f )

Die Dichte f (x) ist die Ableitung der Verteilungsfunktion F (x) .

Bemerkungen:

1. Der Summenformel für die Verteilungsfunktion Fd einer diskreten Zufallsvariablen X

Fd ( x )

f ( xi )

f ( xi ) ... Wahrscheinlichkeitsfunktion

xi x

entspricht bei einer stetigen Zufallsvariablen die Integralformel (37).

2. Nach (38) hat die Fläche unter der Dichtefunktion den Flächeninhalt 1. f (x) ist also das

theoretische Gegenstück zur Häufigkeitsdichte in der beschreibenden Statistik: Die Fläche

des Häufigkeitsdichte-Histogramms hat ebenfalls den Wert 1 (vgl. 2.1. Bsp. 7 ).

87

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 19: Drehscheibe (stetiges Roulette)

x

X = Winkel des zum Stillstand gekommenen Zeigers

gegen Bezugsrichtung (Bogenmaß)

X 0, 2

Bei einer idealen Scheibe ist die Wahrscheinlichkeit dafür, dass X einen Wert im Intervall

a, b 0, 2 annimmt, gleich dem Verhältnis der Intervall-Länge b a zur

Gesamtlänge 2 :

P( X [a, b] ) (b a)

1

2

Für die Verteilungsfunktion F ( x) P( X x) ergibt sich damit

für

x0

für

0 x 2

für

2 x

1

2

für

0 x 2

0

sonst

0

x

F ( x)

2

1

Die Funktion

f ( x)

bezeichnet man als Dichtefunktion oder kurz Dichte der Zufallsvariablen X.

Zwischen F (x) und f (x) besteht offenbar die Beziehung

x

F ( x)

0

1

du

2

für x [0,2 ] ,

die man wegen f ( x) 0 für x [0,2 ] allgemeiner schreiben kann in der Form

x

F ( x)

f (u )du

x IR

1

F (x )

1

2

x

x

2

2

88

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Aus der Definition (37) der Verteilungsfunktion folgt die wohl wichtigste Formel zur

Berechnung von Wahrscheinlichkeiten bei gegebenem F (x) bzw. f (x) :

P(a X b) P( X b) P( X a )

(40)

P ( a X b) F ( b) F ( a )

b

f ( x)dx

a

Die Wahrscheinlichkeit für das Ereignis a X b ist

-

die Fläche unter der Dichtekurve zwischen x a und x b

-

der Zuwachs der Verteilungsfunktion zwischen x a und x b .

Dichtekurve und Intervallwahrscheinlichkeiten:

P(a X b) F (b) F (a)

F ( x0 )

P ( x c ) 1 F (c )

xo

a

c

b

x

Wahrscheinlichkeiten bei stetigen Zufallsvariablen lassen sich entsprechend der Skizze als

Flächen darstellen. Es ist deshalb auch nur sinnvoll, nach Intervallwahrscheinlichkeiten zu

fragen. Für jeden einzelnen Wert x 0 ergibt sich die „Punktwahrscheinlichkeit“ P( X x0 ) 0 .

Aus diesem Grund kann man bei der Berechnung von Wahrscheinlichkeiten Intervallgrenzen

hinzunehmen oder weglassen, ohne dass sich die entsprechende Wahrscheinlichkeit ändert;

für stetige Zufallsvariablen gelten also (im Unterschied zu diskreten Zufallsvariablen)

folgende Beziehungen:

(41)

P ( a X b) P ( a X b) P ( a X b) P ( a X b)

F ( x ) P( X x ) P( X x )

Fortsetzung zu Beispiel 19:

3

stehen bleibt:

4

2

3

3

3 1

1

P( X ) F ( ) F ( )

2

4

4

2

8 4

8

Wahrscheinlichkeit dafür, dass der Zeiger zwischen

89

und

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Durch Angabe einer Verteilungsfunktion F (x) oder einer Dichtefunktion f (x) ist eine

stetige Zufallsvariable eindeutig bestimmt. Die wesentlichen Eigenschaften dieser Funktion

sind

(42)

(43)

Verteilung sfunktion

Dichte

F ( x ) stetig, monoton nichtfalle nd

F ( ) 0

F ( ) 1

f ( x) 0

f ( x ) dx

1

Erwartungswert und Varianz einer stetigen Zufallsvariablen sind analog zum diskreten Fall

definiert; das Summenzeichen wird durch ein Integral ersetzt:

(44)

diskrete ZV

stetige ZV

E( X ) :

xi f ( xi )

x f ( x) dx

E[ g ( X )] :

g ( xi ) f ( xi )

g ( x) f ( x) dx

E[ X 2 ] :

2

xi f ( xi )

2

x f ( x) dx

Var ( X ) 2 :

2

( xi ) f ( xi )

2

( x ) f ( x) dx

Für die Varianz gilt in beiden Fällen der Verschiebungssatz

(45)

Var ( X ) E ( X 2 ) [ E ( X )]2 E ( X 2 ) 2

90

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

4.5. Eigenschaften von Erwartungswert und Varianz

4.5.1. Lineare Transformationen

Bei Änderung von Skalen, z.B. Celsius in Fahrenheit…

Für eine lineare Transformation Y a X b mit a, b R einer Zufallsvariable X gilt

E ( a X b) a E ( X ) b

(46)

Var( a X b) a 2 Var( X )

Beweis: (am Modell diskreter Zufallsvariablen)

E ( aX b) ( a xi b) f ( xi ) a xi f ( xi ) b f ( xi )

Var(aX b) (axi b [a b]) f ( xi ) a

2

1

2

(x ) f (x )

2

i

i

2

a Var( X )

2

Definition: Die Zufallsvariable

Z

(47)

X

heißt standardisierte (normierte) Zufallsvariable.

Wegen der Eigenschaften (46) gilt:

(48)

E(Z )

1

E( X )

1

0 , Var( Z ) 2 Var( X ) 1

4.5.2. Summe von Zufallsvariablen

X und Y seien zwei stochastisch unabhängige Zufallsvariable; f ( x ) und g ( y )

ihre Wahrscheinlichkeitsfunktionen. Dann gilt:

P ( X xi , Y y j ) f ( xi ) g ( y j )

Für Erwartungswert und Varianz gilt dann

(49)

E ( X Y ) E ( X ) E (Y )

Var( X Y ) Var( X ) Var(Y )

91

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 20:

a) Werfen eines Würfels:

x

:1 2 3 4 5 6

X : i

1

f ( xi ) : ..... 6 .....

6

6

i 1

i 1

1

6

E ( X ) xi f ( xi ) i

6

1

6

7

2

2 Var ( X ) i 2 ( ) 2

i 1

7

3,5

2

35

12

b) (Gleichzeitiges) Werfen von n Würfeln:

S n : „Augensumme der n Würfel (Summe von n unabhängigen Zufallsvariablen X)

7

35

n E (S n ) n E ( X ) n

, Var ( S n ) n

2

12

c) Mittlere Augenzahl bei n Würfeln:

X

1

Sn :

n

E( X )

1

1

7 7

E (S n ) n

n

n

2 2

92

2

1 35

1

, Var ( X ) Var ( S n )

n 12

n

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

4.6. Normalverteilung

4.6.1. Dichte und Verteilungsfunktion der Normalverteilung

Bei vielen Verteilungen häufen sich die Werte in der Nähe des Mittelwertes. Die zugehörigen

Dichtekurven haben einen höchsten Punkt und nehmen nach rechts und links hin monoton ab.

Häufig sind diese Kurven symmetrische Glockenkurven. Theoretische Untersuchungen

zeigen, dass die Dichten vieler praktisch wichtiger Zufallsvariablen hinreichend genau durch

einen ganz bestimmten Glockenkurven-Typ beschrieben werden können, die sogenannte

Gaußsche Glockenkurve der Normalverteilung.

Definition 1: Dichte der Normalverteilung

a) Die Zufallsvariable X heißt normalverteilt mit Mittelwert und Varianz 2 , wenn

für ihre Dichte gilt

1

f ( x)

e

2

(50)

( x )2

... N ( ; 2 ) Verteilung

2 2

b) Die Zufallsvariable Z mit der Dichtefunktion

z2

(51)

1 2

( z)

e

2

... N ( 0 ; 1) Verteilung

ist normalverteilt mit Mittelwert 0 und Varianz 2 1 .

Die N ( 0; 1 ) Verteilung heißt Standard-Normalverteilung.

Die zugehörigen Kurven y f (x) nach (50) haben folgende Eigenschaften:

symmetrisch zur Geraden x

Maximum ( /

Wendepunkte bei x1, 2

Horizontale Asymptote ... x-Achse

Verschiebung längs x-Achse

Streckung bzw. Stauchung der Dichtekurve

1

2

)

Je kleiner , desto größer ist das Maximum und desto rascher fällt die Dichtekurve

nach beiden Seiten hin ab.

93

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Fläche unter der Dichtekurve ist 1

_

0,5

1

2

_

1

2

-2

0

2

4

8

6

x

10

Dichtekurven der Normalverteilung für 4 und verschiedene Werte von

Zur Berechnung von Wahrscheinlichkeiten mit Gleichung (40) benötigt man Verteilungsfunktionen.

Definition 2: Verteilungsfunktion der Normalverteilung

a) Die N ( ; 2 ) verteilte Zufallsvariable X besitzt die Verteilungsfunktion

(52)

x

F ( x ) P( X x )

f (u) du

1

2

x

e

(u )2

2 2

du

b) Die N ( 0; 1 ) verteilte Zufallsvariable Z besitzt die Verteilungsfunktion

(53)

( z ) P( Z z )

z

(t ) dt

94

1

2

z

e

t2

2

dt

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Die Integrale in (52) und (53) sind nicht geschlossen integrierbar: es gibt im Bereich der

elementaren Funktionen keine Stammfunktion von f (x) bzw. (z ) ! Man muss deshalb

neue Funktionen definieren bzw. Werte der Verteilungsfunktionen in Tabellenform

bereitstellen.

Mit Hilfe der Substitution

(54)

t

u

, du dt

u

ux

t

x

t

geht (52) über in

x

(55)

F ( x)

1

2

e

t2

2

x

dt

Damit lassen sich alle Wahrscheinlichkeitsberechnungen für normalverteilte Zufallsvariable

zurückführen auf Berechnungen für die standardisierte N ( 0; 1 ) Verteilung.

Verteilungsfunktion der N ( 0 ; 1) Verteilung

(z )

z

95

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Für die Wahrscheinlichkeit, dass eine N ( ; 2 ) verteilte Zufallsvariable X Werte annimmt

zwischen a und b ergibt sich mit (55)

(56)

b

a

P ( a X b) F ( b) F ( a )

Insbesondere gilt ( Tabelle zur NV im Anhang)

P( X )

a)

(1) (1)

0,8413 0,1587

0,6826

b) P( 2 X 2 ) (2) (2) 0,9772 0,0228 0,9544

P( 3 X 3 )

c)

(3) (3)

0,9987 0,0013 0,9974

Anders formuliert: Bei normalverteilten Zufallsvariablen liegen

a) etwa 2/3 aller Werte zwischen und

b) etwa 95% aller Werte zwischen 2 und 2

Regeln der NV

c) etwa 99,7% aller Werte zwischen 3 und 3

Bemerkungen:

1) Wegen der Symmetrie der Dichtefunktion (z ) ist (z ) häufig nur tabelliert

für z 0 ; dann ist folgende Beziehung nützlich

(57)

( z) 1 ( z)

2) Anstelle der Funktion (z ) ist oft tabelliert die Funktion

(58)

* ( z )

1

2

z

e

t2

2

dt

0

Zwischen und * besteht offensichtlich wegen der Symmetrie der Normalverteilung

der Zusammenhang

(59)

( z ) * ( z )

1

2

96

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Sigma-Regeln der Normalverteilung

3

2

2

3

2

3

95%

99,7%

Veranschaulichung zu (57) - (59)

*z)

(z)

z

(-z)

>

1 (z)

-z

z

97

>

z

>

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 21:

Intervall-Wahrscheinlichkeiten bei gegebenen Grenzen

X1 sei N ( 0 ; 1) verteilt , d.h. normalverteilt mit 0 und 2 1 ;

X2 sei N ( 0,8 ; 4 ) verteilt , d.h. normalverteilt mit 0,8 und 2 4

Bestimmen Sie für i 1, 2 folgende Wahrscheinlichkeiten:

a) P( X i 2,44)

b) P( X i 1,16)

c) P( X i 1)

d) P(2 X i 10)

Lösung (mit Tabelle):

P( X 1 2,44) (2,44) 0,9927

a)

2,44 0,8

P( X 2 2,44)

(0,82) 0,7939

2

P( X 1 1,16) (1,16) 0,1230

b)

oder mit (46) ... 1 (1,16) 1 0,8770 0,1230

1,16 0,8

P( X 2 1,16)

(0,98) 0,1635

2

P( X 1 1) 1 (1) (1) 0,1587

c)

1 0,8

P( X 2 1) 1

1 (0,1) 0,4602

2

P(2 X 1 10) (10) (2) 1 0,97725 0,02275

d)

10 0,8

2 0,8

P(2 X 2 10)

(4,6) (0,6) 0,2743

2

2

98

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 22:

Grenzen bestimmen zu vorgegebenen Wahrscheinlichkeiten

X sei normalverteilt mit 2 und 2 0,25 . Bestimmen Sie c so , dass gilt

a)

P( X c) 0,2

b) P(2 c X 2 c) 0,9

Lösung (mit Tabelle):

c 2 !

P( X c) 1 P( X c) 1

0,2

0,5

a)

z ( ) Tab.

(2c 4) 0,8

2c 4 0,842 c 1,579

!

2 c 2

2 c 2

(2c) (2c) D(2c) 0,9

0,5

0,5

b)

z ( D ) Tab.

2c 1,645

c 0,8225

4.6.2. Eigenschaften normalverteilter Zufallsvariabler

a) Die Normalverteilung ist eine zweiparametrige Verteilung: sind Mittelwert und Varianz

gegeben, so ist die Verteilung vollständig bestimmt: gibt die Lage, 2 die Form der

Verteilung an. Bestehen Gründe zur Vermutung, dass ein Merkmal normalverteilt ist, so

wählt man als Schätzweret für und 2 den arithmetischen Mittelwert x und die

empirische Varianz s

b) Satz 1:

2

(s. Abschnitte 2.1. / 5.3) :

x;

2 s2

Jede lineare Funktion einer normalverteilten Zufallsvariablen ist

normalverteilt:

X : N ( ; 2 )

Satz 2:

Y aX b :

N ( a b; a 2 2 )

Die Summe normalverteilter Zufallsvariabler ist normalverteilt:

2

X 2 : N ( 2 ; 2 )

unabhängig

X 1 : N ( 1 ; 1 )

2

99

Z X 1 X 2 : N( 1 2 ; 1 2 )

2

2

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

4.6.3. Grenzwertsätze

Satz von de Moivre-Laplace

Die Diagramme auf Seite 79 zeigen, dass sich die Binomialverteilung mit wachsendem n

immer mehr einer symmetrischen glockenförmigen Verteilung nähert; diese Eigenschaft der

Binomialverteilung findet ihren Ausdruck im Satz von de Moivre-Laplace.

Die Verteilung der Zufallsvariable

X n = Anzahl der Erfolge bei n Versuchen mit

E ( X n ) np

Var ( X n ) 2 npq

ist zum Vergleich mit anderen Verteilungen nur schlecht geeignet, da und 2 linear mit n

wachsen. Man geht deshalb über zur zugehörigen standardisierten Zufallsvariablen

Xn

*

Xn

X np

n

npq

mit

E(X n* ) 0

Var( X n* ) 1

Für ihre Verteilungsfunktion Fn * ( x) P( X n * x) gilt der Grenzwertsatz von de MoivreLaplace

lim Fn ( x )

*

n

n

1

2

x

e

t2

2

dt ( x )

Die Verteilungsfunktion der standardisierten Binomialverteilung nähert sich für

n der N ( 0 ; 1 ) Verteilung.

Zentraler Grenzwertsatz

( X 1 , X 2 , X 3 ...) sei eine Folge von unabhängigen Zufallsvariablen mit Erwartungswerten i

und Varianzen i . Durch fortgesetzte Addition der Zufallsvariablen Xi lässt sich eine neue

Folge ( S1 , S 2 , S 3 ...) von Zufallsvariablen bilden:

2

n

Sn X i

i 1

n

mit

E ( Sn ) i

i 1

n

, Var( Sn ) 2 i

2

i 1

Der zentrale Grenzwertsatz besagt, dass die Summe von unabhängigen Zufallsvariablen

angenähert normalverteilt ist, wenn die Zahl der Summanden hinreichend groß ist;

genauer gilt:

Die Folge der Verteilungsfunktionen der standardisierten Zufallsvariablen

konvergiert gegen die N ( 0 ; 1 ) Verteilungsfunktion

100

Sn

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Bemerkungen:

1) Der zentrale Grenzwertsatz erklärt, warum viele Zufallsvariable normalverteilt oder

näherungsweise normalverteilt sind:

Normalverteilung kann angenommen werden, wenn sich viele unabhängig voneinander

wirkende zufällige Einflussgrößen additiv zur betrachteten Zufallsvariable überlagern.

2) Mit ähnlichen Überlegungen lässt sich aus dem zentralen Grenzwertsatz auch das

Gaußsche Fehlergesetz begründen: Gauß zeigte, dass Messungen einer Größe, die mit

Zufallsfehlern behaftet sind, um den Mittelwert der Beobachtungen normalverteilt sind;

die Parameter und 2 dieser Normalverteilung müssen dabei in der Praxis aus den

Messwerten geschätzt werden durch den arithmetischen Mittelwert und die empirische

Varianz.

4.6.4. Annäherung der Binomialverteilung durch die Normalverteilung

Für große Werte von n lässt sich die Binomialverteilung der Zufallsvariablen Xn nach dem

Grenzwertsatz von de Moivre-Laplace annähern durch eine Normalverteilung mit

2

Erwartungswert n p und Varianz n p q ; q 1 p (vgl. dazu die Diagramme

auf Seite 79 und den Abschnitt 4.5.2).

Für die näherungsweise Berechnung von Binomial-Wahrscheinlichkeiten erhält man damit:

Für 0 k1 k2 n mit ganzen Zahlen k , k gilt

1

P(k1 X n k2 )

(60)

mit

k2

k k1

k1 n p 0,5

;

n pq

2

f B ( k ; n; p ) ( ) ( )

k2 n p 0,5

n pq

Zur Erläuterung von (60), vor allem zur Begründung der Grenzen und , kann man das

Histogramm einer Binomialverteilung betrachten. Ersetzt man das Stabdiagramm, bei dem

über den möglichen ganzzahligen Werten k 0 , 1, . . . n jeweils die Wahrscheinlichkeit

f (k ) aufgetragen wird, durch ein Histogramm, bei dem über den Intervallen

B

101

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

k 0,5 x k 0,5 Rechtecke der Höhe f (k ) aufgetragen werden, dann ist die Fläche

B

des über k bzw. über k 0,5 x k 0,5 liegenden Rechtecks gleich der Wahrscheinlichkeit P( X k ) f (k ).

n

B

BV: n = 10; p = 0,5

0

1

2

3

5

4

7

6

8

9

10

*

Bezeichnet man die Histogramm-Treppenfunktion mit f B (x ) , dann gelten offensichtlich die

Beziehungen

(61)

k 0, 5

*

f B ( x) dx

P( X n k ) f B ( k )

k 0, 5

(62)

P(k1 X n k 2 )

k 2 0, 5

*

f B ( x) dx

k1 0,5

*

Nach dem Satz von de Moivre-Laplace kann man f B (x ) annähern durch die Dichte der

Normalverteilung mit n p und

(63)

P(k1 X n k2 )

2

n p q : aus (62) folgt also

k 2 0, 5

1

2 n p q

Mit Hilfe der Standardsubstitution z

x

Näherungsformel (60).

102

k1 0,5

( x n p)2

exp(

) dx

2n p q

xn p

folgt daraus aber sofort die

n pq

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Die Näherung (60) ist brauchbar für

d.h. B 3 ,

n pq 9

(64)

ihr Vorteil gegenüber den unhandlichen Ausdrücken der Binomialverteilung für große n

leuchtet unmittelbar ein.

Beispiel 23

Bestimmen Sie die Wahrscheinlichkeit für mindestens 4 und höchstens 6 Wappen bei 10

Münzwürfen

a) exakt

b) näherungsweise mit Normalverteilung

Lösung:

a) Binomial-Verteilung mit n = 10, p = 0,5

10 10 10 1 10

P(4 X 6) f (4) f (5) f (6)

B

B

B

4 5 6 2

210 252 210 672

0,65625

1024

1024

b) Näherung mit de Moivre-Laplace-Grenzwertsatz (60)

P(4 X 6) (

6,5 5

2,5

) (

3,5 5

2,5

) (0,95) (0,95)

Tabelle

D(0,95)

0,6579

Bemerkung: Die Übereinstimmung ist trotz n p q 2,5 9 recht gut, da wegen p 0,5

eine symmetrische Verteilung vorliegt (s. Histogramm auf Seite 79).

103

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

4.7. Weitere stetige Zufallsvariablen

Eine Zufallsvariable X heißt gleichmäßig verteilt über dem Intervall a x b , wenn sie

die Dichtefunktion bzw. Verteilungsfunktion

(65)

0

xa

für a x b

; F ( x)

ba

sonst

1

1

f ( x) b a

0

für

xa

für

a xb

für

xb

besitzt (vgl. Beispiel 14 Seite 37). Für Erwartungswert und Varianz erhält man

Gl

(66)

ab

;

2

2

Gl

(b a ) 2

12

1

1

ba

x

a

b

x

a

b

Eine Zufallsvariable X heißt exponentialverteilt mit dem Parameter 0 , wenn sie die

Dichtefunktion bzw. Verteilungsfunktion

(67)

e x

f ( x)

0

für x 0

sonst

1 e x

; F ( x)

0

für x 0

sonst

besitzt. Für Erwartungswert und Varianz erhält man

(68)

E

1

;

E2

1

2

F(x)

1

f (x)

x

x

Anwendungen der Exponentialverteilung: Zufällige Zeitdauer

- eines Telefongesprächs

- zwischen zwei aufeinanderfolgenden Anrufen in einer Telefonzentrale

- bis zum Ausfall von Bauelementen (Lebensdauerprobleme)

- für die Durchführung von Wartungs- oder Instandhaltungsmaß

104

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

Beispiel 24 Parameter der Rechteckverteilung

1

1 b

1 1 2

ab

2

x f ( x) dx x

dx

x dx

(b a )

ba

ba a

ba 2

2

a

2

b

2

( x ) f ( x) dx

1 b a

3 ba

2

x f ( x) dx

2

3

3

1 b 2

2

x dx

ba a

1

1 2

1

2

2

2

(a b) (b ab a ) (a b)

4

3

4

1 2

(b a )

2

(b 2ab a )

12

12

2

;

ba

12

Beispiel 25

Zur Reparatur eines elektrischen Gerätes werden im Durchschnitt 2 Stunden benötigt. Wie

groß ist (bei Annahme einer zugrundeliegenden Exponentialverteilung) die Wahrscheinlichkeit dafür, dass zur Reparatur eines beliebigen Gerätes mindestens 3 Stunden aufgewendet

werden müssen?

Lösung:

Die Zufallsgröße X = zufällige Reparaturzeit gemessen in h unterliegt einer Exponentialverteilung mit dem Parameter

1 1

2 h

( Erwartungswert

P( X 3) 1 P( X 3) 1 F (3)

E

0,53

1,5

1 1 e

0,2231

e

105

1

1

)

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

4.8. Aufgaben

1. In einer Schachtel liegen 4 rote und 6 schwarze Kugeln. Zwei davon werden gezogen

a) mit Zurücklegen

b) ohne Zurücklegen

Ermitteln Sie in beiden Fällen die Wahrscheinlichkeitsfunktion f (x) für die

Zufallsvariable „X = Anzahl der gezogenen schwarzen Kugeln“.

2. Bestimmen Sie die Wahrscheinlichkeitsfunktion (Wahrscheinlichkeitstabelle) der

diskreten Zufallsvariablen „X = Augensumme zweier idealer Würfel“.

Skizzieren Sie das zugehörige Stabdiagramm und berechnen Sie Erwartungswert und Varianz.

3. Bei einem Spiel mit zwei Würfeln erhält man bei einem Einsatz von 0,40 Euro als Gewinn

1 Euro für die Augensumme 10, 2 Euro für die Augensumme 11 und 3 Euro für die

Augensumme 12; in den übrigen Fällen erhält man keinen Gewinn. Wie groß ist der

Erwartungswert des Reingewinnes?

4. a) Eine ideale Münze wird fünfmal geworfen. Wie groß ist die Wahrscheinlichkeit dafür,

dass genau dreimal Wappen erscheint?

b) Durch Beobachtungen über einen längeren Zeitraum stellte man fest, dass von 1000

Neugeborenen im Mittel 515 Knaben sind. Wie groß ist die Wahrscheinlichkeit dafür,

dass in einer Familie mit 6 Kindern mindestens 4 Knaben sind?

c) Von 1000 Werkstücken einer Produktionsreihe seien im Mittel 920 fehlerfrei. Wie

groß ist die Wahrscheinlichkeit dafür, dass in einer Stichprobe von 10 Werkstücken

mindestens 9 fehlerfrei sind?

5. Auf ein Ziel werden 8 Schüsse abgegeben; die Trefferwahrscheinlichkeit bei einem

Schuss sei 0,3. Wie groß ist die Wahrscheinlichkeit für

a) höchstens 4 Treffer

b) mindestens 3 Treffer

c) mindestens 1 Treffer

d) mindestens 3 und höchstens 4 Treffer?

Gewinnwahrscheinlichkeiten beim Lotto „6 aus 49“

6.

Wie groß sind die Wahrscheinlichkeiten für 6, 5, 4, 3, 2, 1, 0 – Richtige?

7.a) Gegeben ist ein System aus 4 gleichartigen voneinander unabhängigen Komponenten,

das genau dann funktionsfähig ist, wenn mindestens 3 der Komponenten intakt sind; die

Zuverlässigkeit jeder Komponente sei p. Wie groß ist die Funktionswahrscheinlichkeit

dieses „3 aus 4 – Systems“?

b) Vergleichen Sie die Wahrscheinlichkeit aus a) mit der Zuverlässigkeit eines Systems aus

3 in Reihe geschalteten Komponenten für p = 0,99 .

c) Geben Sie eine allgemeine Formel an für die Zuverlässigkeit eines „m aus n – Systems“

mit Komponentenzuverlässigkeit p.

106

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

8. Fünf Arbeiter, die unabhängig voneinander arbeiten, benötigen Strom, und zwar jeweils

im Mittel etwa 12 Minuten pro Stunde. Genügt es, die Stromversorgung so einzurichten,

dass 3 Arbeiter gleichzeitig Strom entnehmen können oder entstehen erhebliche

Wartezeiten dadurch, dass mehr als 3 Arbeiter gleichzeitig Strom entnehmen wollen?

9.

Von 100 Personen ist durchschnittlich eine Person farbenblind.

a) Berechnen Sie die Wahrscheinlichkeit dafür, dass sich unter 100 zufällig ausgewählten

Personen zwei oder mehr farbenblinde Personen befinden.

b) Wie viele Personen müssen zufällig ausgewählt werden, damit sich mit einer

Wahrscheinlichkeit von mindestens 95% mindestens eine farbenblinde Person unter

ihnen befindet?

10.

Tote durch Hufschlag in der preußischen Armee im Zeitraum 1875 – 1894 (Zahlen nach

v. Bortkiewicz)

Untersuchungen an 10 preußischen Kavallerieregimentern während 20 Jahren ergaben

folgende Tabelle ( z(k) = Anzahl der Regimenter mit k Toten durch Hufschlag pro Jahr )

k

z(k)

0

109

1

65

2

22

3

3

4

1

5

0

Zeigen Sie, dass angenähert eine Poisson-Verteilung vorliegt.

11. Auf einer stark befahrenen Straße werden in 2 Stunden 10 080 Fahrzeuge gezählt. Die

Voraussetzungen für Poisson- und Exponentialverteilung seien erfüllt.

a) Wie groß ist die Wahrscheinlichkeit, dass

- in 3 sec kein Fahrzeug

- in 3 sec mindestens 6 Fahrzeuge

- in 6 sec genau 4 Fahrzeuge

in 6 sec höchstens 10 Fahrzeuge

vorüber fahren?

b) Wie groß ist die Wahrscheinlichkeit, dass bis zum Vorüberfahren des nächsten

Fahrzeugs

- höchstens 1 sec

- höchstens 2 sec

- mindestens 0,5 sec vergehen?

12. Ein Automat stellt Bolzen her, deren Durchmesser D normalverteilt ist mit = 15 mm und

= 0,25 mm. Bolzen mit 14,5 mm D 15,3 mm werden als maßgerecht betrachtet;

Bolzen mit D 15,3 mm werden nachgearbeitet, Bolzen mit D 14,5 mm sind Ausschuss.

Wie viel Prozent der Bolzen

a) sind maßgerecht,

b) können nachgearbeitet werden,

c) sind Ausschuss?

107

Statistik

4. Zufallsvariable und Wahrscheinlichkeitsverteilung

13. Eine Metallhobelmaschine stellt Platten der Dicke X her. X sei normalverteilt und habe

bei einer bestimmten Maschineneinstellung die Werte = 10 mm und = 0,02 mm.

a) Wieviel Prozent Ausschuss ist zu erwarten, falls die Platten

a1) mindestens 9,97 mm stark sein sollen,

a2) höchstens 10,05 mm stark sein dürfen,

a3) um höchstens 0,03 mm vom Sollwert 10 mm abweichen dürfen?

b) Wie muss man die Toleranzgrenze 10 – c und 10 + c wählen, damit man nicht mehr

als 5% Ausschuss erhält?

c) Wie ändert sich der Ausschussanteil für die in b) bestimmte Größe c, wenn sich der

Mittelwert infolge Abnützung des Hobelstrahls nach 10,01 mm verschiebt?

x

14.

Zeigen Sie, dass

e

f ( x)

0

für x 0

Dichtefunktion einer stetigen

sonst

Zufallsvariablen ist (Exponentialverteilung).

Berechnen und skizzieren Sie die zugehörige Verteilungsfunktion. Wie groß sind

Erwartungswert und Varianz? Wie groß ist die Wahrscheinlichkeit P (1 X 2) ?

x

15. Gegeben ist die Funktion f (x) x 2

0

für

0 x 1

für

sonst

1 x 2

a) Zeigen Sie, dass f (x) die Eigenschaften einer Dichtefunktion besitzt. Skizze!

b) Bestimmen und skizzieren Sie die zugehörige Verteilungsfunktion F (x).

2

c) Wie groß sind Erwartungswert und Varianz ?

d) Wie groß ist die Wahrscheinlichkeit für „X < 0,5“ ?

108