Poisson - Christian-Albrechts

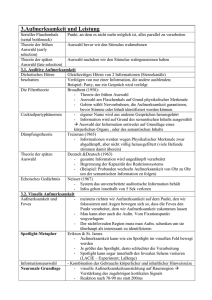

Werbung

Poisson-Neurone und

Poisson-Verhalten

Christian Kaernbach

Bernoulliverteilung

• beschreibt zufällige Ereignisse

mit nur zwei möglichen

Versuchsausgängen

– Erfolg (X=1)

mit Wahrscheinlichkeit p

– Misserfolg (X=0)

mit Wahrscheinlichkeit 1 – p

– Erwartungswert E(X) = µ = p

– Varianz V(X) = ² = p · (1 – p)

1

0

0

1

0

1

1

0

Binomialverteilung

n k

n k

B(k | p, n ) p 1 p

k

1

• beschreibt die Anzahl der Erfolge

in einer Serie von n gleichartigen

und unabhängigen

Bernoulliprozessen

mit Wahrscheinlichkeit p

– Erwartungswert µ = n · p

– Varianz ² = n · p · (1 – p)

1

n=4

p=0,5

0,5

0

0

0

1

0 1 2 3 4

1

n=8

p=0,25

0,5

0

0 1 2 3 4 5 6 7 8

Poissonverteilung

P( k | )

k

k!

1

• beschreibt die Anzahl der Erfolge in

einer Serie von unendlich vielen

gleichartigen und unabhängigen

Poissonprozessen mit infinitisemaler

Wahrscheinlichkeit.

• P() geht hervor aus der

Binomialverteilung B(p,n)

im Grenzwert

p 0, n , n·p =

– Erwartungswert

µ=n·p

– Varianz

² = n · p · (1 – p)

e

n=4

p=0,5

0,5

0

0 1 2 3 4

1

n=8

p=0,25

0,5

0

0 1 2 3 4 5 6 7 8

1

=2

0,5

0

0 1 2 3 4 5 6 7 8 9

Poissonverteilung

1

=0,2

1

k

P( k | )

=1

k!

1

0,5

0,5

0,5

0

0

0

0 1 2 3 4 5 6 7 8 9

0 1 2 3 4 5 6 7 8 9

=2

0 1 2 3 4 5 6 7 8 9

0,2

• Für > 30 nähert sich die

Poissonverteilung der

Gaußverteilung an.

e

=4,5

0,1

0

0 1 2 3 4 5 6 7 8 9

0,1

=30

0,05

0

13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50

Poissonprozesse

P( k | )

k

k!

e

• diskrete Ereignisse in der Zeit mit folgenden Eigenschaften:

–

selten

–

–

unabhängig von der Zeit

unabhängig von der Vorgeschichte („geschichtslos“)

• es gibt ein t so dass annähernd gilt: in [t,t+t] gibt es maximal ein Ereignis

• Zahl der Vorereignisse

• Abstand des letzten Vorereignisses

Die Wahrscheinlichkeit, in einem Intervall der Länge t ein Ereignis zu

finden, hängt nur von der Länge des Intervalls ab.

finden, ist proportional der Länge des Intervalls.

• p1([t,t+t]) = g · t

g Ereignisrate [s–1]

p0([t,t+t]) = 1 – g · t

• p0([0,t+t]) = p0(t+t) = p0(t) · p0([t,t+t]) = p0(t) – p0(t) · g · t

• dp0(t)/dt = – p0(t) · g

p0(t) = e–g·t

• pk(t+t) = pk(t) · p0([t,t+t]) + pk–1(t) · p1([t,t+t])

= pk(t) – pk(t) · g · t + pk–1(t) · g · t

• dpk(t)/dt = – pk(t) · g + pk–1(t) · g

pk(t) = ((g·t)k/k!) · e–g·t = (k/k!) · e–

Poissonprozesse

P( k | )

k

k!

e

• diskrete Ereignisse in der Zeit mit folgenden Eigenschaften:

–

selten

–

–

unabhängig von der Zeit

unabhängig von der Vorgeschichte („geschichtslos“)

• es gibt ein t so dass annähernd gilt: in [t,t+t] gibt es maximal ein Ereignis

• Zahl der Vorereignisse

• Abstand des letzten Vorereignisses

–

Test auf Geschichtslosigkeit einer Zeitreihe

• dazu Korrelationen cor(Li,Li–1), cor(Li,Li–2), ...

Zahl der Fälle

• Zeit zwischen zwei Ereignissen Li = Ti – Ti–1

ist exponentialverteilt mit g·e–g·t.

25

20

15

10

5

0

• Stoppuhrparadox: Zeit „ab Stoppuhr“ Nj = Ti>j – Ej

(Ej = externer Trigger für Stoppuhr)

bis zum nächsten Ereignis nach Ej

T1 T2

ist exponentialverteilt mit g·e–g·t.

–

Nj: Nj Li, E(Nj/Li) = 1/2.

0

1

2

3

L3

E1

T3

N1

4 5 6

Li [Tage]

T4 T5

T6

7

8

9

T7

Poissonprozesse

P( k | )

k

k!

e

• diskrete Ereignisse in der Zeit mit folgenden Eigenschaften:

–

selten

–

–

unabhängig von der Zeit

unabhängig von der Vorgeschichte („geschichtslos“)

• es gibt ein t so dass annähernd gilt: in [t,t+t] gibt es maximal ein Ereignis

• Zahl der Vorereignisse

• Abstand des letzten Vorereignisses

• Beispiele

–

–

–

–

Kaufhauskunden

Radioaktivität

Siméon Denis Poisson, 1837: Urteile in Straf- und Zivilsachen

Ladislaus von Bortkewitsch, 1898: Todesfälle durch Hufschlag

neuronale Ereignisse

Poissonprozesse

P( k | )

k

k!

e

• diskrete Ereignisse in der Zeit mit folgenden Eigenschaften:

–

selten

–

–

unabhängig von der Zeit

unabhängig von der Vorgeschichte („geschichtslos“)

• es gibt ein t so dass annähernd gilt: in [t,t+t] gibt es maximal ein Ereignis

• Zahl der Vorereignisse

• Abstand des letzten Vorereignisses

neuronale Ereignisse

• Elektrophysiologie: Exponentialverteilung der Inter-Spike-Intervalle

– hier: retinale Ganglienzellen bei der Katze

» beachte: Refraktärperiode

• Modellierung: „Poisson-Neuron“,

z. B. bei „Integrate & Fire Neuron“

• Verhalten: Signalentdeckungstheorie

Gaußsches Modell

mit gleicher Varianz

Ja

Nein

Signal + Rauschen

(S+R) Treffer Auslasser

1

pT

Rauschen

(R)

Falsche Korrekte

Alarme Zurückweisung

0,5

d'

-3

-2

-1

0

„nein“

R

S+R

1

k

2

3

„ja“

4

5

0

0

S+R = N(0,1)

S+R = N(d',1)

0,5

pFA

1

Gaußsches Modell: Symmetrie

Ja

Nein

Signal + Rauschen

(S+R) Treffer Auslasser

1

pT

Rauschen

(R)

Falsche Korrekte

Alarme Zurückweisung

0,5

d'

-3

-2

-1

0

„nein“

R

S+R

1

k

2

3

„ja“

4

5

0

0

S+R = N(0,1)

S+R = N(d',1)

0,5

pFA

1

Asymmetrie realer Daten

1

1

pT

0.5

0,5

original

gespiegelt

0

0

0

0.5

1

0

0,5

pFA

1

ROC nach Gauß (gl. Varianz) zu symmetrisch

Gaußsches Modell

mit ungleicher Varianz

d'

R

S+R

1

pT

-3

-2

-1

k

0

1

2

3

4

5

0.5

S+R = N(0,1)

S+R = N(d',)

0

0

0.5

ROC nicht konvex

pFA

1

Hochschwellenmodell

(Blackwell, 1953)

1

0.8

0.6

0.4

0.2

0

1

R

S+R

D

pT

D

0.5

S+R = {1, 0}

S+R = {1, }

0

0

0.5

pFA

unrealistisch: Falschalarmrate = 0

1

Niedrigschwellenmodell

(Luce, 1963)

1

0.8

0.6

0.4

0.2

0

R

S+R

S'+R

D

1

pT

D

0.5

S+R = {1, }

S+R = {1, }

0

0

0.5

pFA

perfekte Leistung unmöglich

1

Hoch/Niedrigschwellenmodell

(Krantz, 1969)

1

0,8

0,6

0,4

0,2

0

R

S+R

S'+R

D

D

1

pT

D*

0.5

S+R = {1, , 0}

S+R = {1, , }

0

0

0.5

zuviele Parameter

pFA

1

Das Poissonmodell (Egan, 1975)

0.8

R

S+R

S'+R

0.6

0.4

1

pT

0.2

0

0 1 2 3 4 5 6 7 8

0.5

S+R = P(µR)

S+R = P(µS+R)

0

0

va bene

0.5

pFA

1

Rating-ROCs

•

„Nein“

„Ja“

ROCs aus Rating-Daten sind „rund“:

– VP gibt Sicherheit für „Ja“ auf kontinuierlicher Skala an (Bleistiftstrich)

– VL setzt post-hoc verschiedene Schwellen für „Ja“

•

•

Ist das ein Beweis gegen diskrete Modelle (mit eckigem ROC)?

Krantz argumentiert dagegen

– gegeben zwei Zustände, D und D.

– verschmiertes Antwortverhalten aus Skala, Gaußverteilungen für D und D.

runder ROC

•

Rating-ROCs sind oft asymmetrisch

– durch verschmiertes Antwortverhalten kann keine Asymmetrie

zustande kommen

Studie zu Magical Ideation

Ein Experiment aus den Diplomarbeiten von Gerit Haas und Ulrike Jury,

Karl-Franzens-Universität Graz, 2007.

• 245 Versuchspersonen füllen Online-Fragebogen aus

– Persönlichkeitsmerkmal “Magical Ideation” (MI) erheben

mit 30 Items wie

• Ich vollführe ab und zu kleine Rituale, um ungünstige Ereignisse abzuwenden.

• Es gibt Leute, bei denen ich spüre, wenn sie an mich denken.

• Wenn bestimmte Leute mich ansehen oder mich berühren, habe ich manchmal das Gefühl,

Energie zu gewinnen oder zu verlieren.

• Ich glaube, ich könnte lernen, die Gedanken Anderer zu lesen, wenn ich nur wollte.

• Die Regierungen halten Informationen über UFOs zurück.

• ...

– Extremgruppenvergleich

• 8 Personen mit niedrigem MI-Wert (1,25 1,3)

• 9 Personen mit hohem MI-Wert

(22 2,4)

Erkennen von Wörtern

in Rauschen

• behaviorale Untersuchung:

– 100 Durchgänge, davon

• 60 mal nur Rauschen

• 20 mal Rauschen plus sehr leises Wort

• 20 mal Rauschen plus leises Wort

– Aufgabe: War da ein Wort?

Vierstufiges Rating

•

•

•

•

sicher ja

eher ja

eher nein

sicher nein

• bildgebendes Verfahren (NIRS)

zu Wörtern in Rauschen

Ergebnisse

•

MI-hoch und MI-niedrig produzieren

gleiche ROC-Kurve

– basale Wahrnehmungsprozesse sind identisch

(liefern gleiche Information)

•

Position der Punkte auf ROC-Kurve

unterscheidet sich deutlich

– Kriterien beim Auswerten dieser Information

sind unterschiedlich

•

Asymmetrie der ROC-Kurve:

– kompatibel mit Poissonverteilung mit kleinem

– Hinweis auf diskrete neuronale Ereignisse

• Entscheidung basiert auf

einigen wenigen neuronalen Ereignissen

Interpretation

•

Asymmetrie der ROC-Kurve:

– kompatibel mit Poissonverteilung mit kleinem

– Hinweis auf diskrete neuronale Ereignisse

• Entscheidung basiert auf

einigen wenigen neuronalen Ereignisse

•

Tatort Wernicke-Areal

– Viele gleichartige, voneinander

unabhängig operierende Einzelzellen

(Großmutterzellen) mit

niedriger Falsch-Alarm-Rate?

– sparse coding

– Rekurrent vernetzte Zellen interagieren und

produzieren neuronale „Groß-Ereignisse“

(synchrone Bursts o. ä.)?

SDT oberhalb der Schwelle

• Zwei sehr ähnliche Stimuli oberhalb der Schwelle

• Zwei verschiedene Aufgaben denkbar

– Vergleich

• 50% der Einzelversuche enthalten Änderung nach oben (Anstieg)

• 50% der Einzelversuche enthalten Änderung nach unten (Abstieg)

Aufgabe: „Welcher Stimulus ist lauter/heller/höher...?“

⇨ Einzelne Zahl als Sensitivitätsmaß (Prozent richtig)

– Änderungsentdeckung: Gleich oder verschieden? (same/different)

• 50% der Einzelversuche enthalten Änderung

• 50% der Einzelversuche enthalten keine Änderung

Aufgabe: „War da eine Änderung?“

⇨ ROC-Kurve beschreibt Sensitivität und Strategie

• Annahme: Vergleichs- & Änderungsentdeckungsentscheidungen

haben gleiche Entscheidungsbasis

Vergleich der Repräsentation

• Zwei sehr ähnliche Stimuli oberhalb der Schwelle

Vergleich der

Repräsentationen:

Stimulus Stimulus

Zahl

Zahl

• 50% der Einzelversuche enthalten Anstieg

• 50% der Einzelversuche enthalten Abstieg

– Aufgabe: „Welcher ist lauter/heller/höher...?“

– Vergleich der Stimulusrepräsentationen

• Beide Stimuli intern repräsentiert als Zahlen e1, e2

• Vergleich macht eine einzige Zahl draus: e = e2 e1

erster Stimulus

zweiter Stimulus

e

Vergleich der Repräsentation

• Zwei sehr ähnliche Stimuli oberhalb der Schwelle

• 50% der Einzelversuche enthalten Anstieg

• 50% der Einzelversuche enthalten Abstieg

– Aufgabe: „Welcher ist lauter/heller/höher...?“

– Vergleich der Stimulusrepräsentationen

•

•

•

•

Beide Stimuli intern repräsentiert als Zahlen e1, e2

Vergleich macht eine einzige Zahl draus: e = e2 e1

Entscheidung basiert auf e: „Anstieg“ wenn e > 0

Oberhalb der Schwelle: große Zahlen für e1 und e2

Vergleich der

Repräsentationen:

Stimulus Stimulus

Zahl

Zahl

Vergleich

Zahl

Alle Arten von

VergleichsEntscheidungen:

entscheidung

Änderungsentdeckung,

Vergleich...

– e1 und e2 und demzufolge e sind normalverteilt

– Repräsentationsvergleich ⇨ Gaußsche SDT

falsch

richtig

0

e

Änderungsentdeckung

Richtung der Änderung unbekannt

Vergleich der

Repräsentationen:

Stimulus Stimulus

Zahl

• Zwei sehr ähnliche Stimuli oberhalb der Schwelle

• 25% der Einzelversuche enthalten Anstieg

• 25% der Einzelversuche enthalten Abstieg

• 50% der Einzelversuche enthalten keine Änderung

Vergleich

Zahl

– Aufgabe: „War da eine Änderung?“

– Vergleich der Stimulusrepräsentationen

Alle Arten von

Entscheidungen:

Änderungsentdeckung,

Vergleich...

Abstieg

keine Änderung

„Änderung“

Anstieg

p(Änderung|verschieden)

• Entscheidung basiert auf e: „Änderung“ wenn abs(e) > c

• Gaußsche SDT: asymmetrischer ROC

1

• Asymmetrische ROCs in experimentellen Daten

gefunden, stellen aber keine Widerlegung dar des

Vergleichs der Stimulusrepräsentationen

c

c

„keine

Änderung“

0

Zahl

0

„Änderung“

0

p(Änderung|gleich)

e

1

Änderungsentdeckung

Richtung der Änderung bekannt

Vergleich der

Repräsentationen:

Stimulus Stimulus

Zahl

• Zwei sehr ähnliche Stimuli oberhalb der Schwelle

• 50% der Einzelversuche enthalten Anstieg

• 50% der Einzelversuche enthalten keine Änderung

Vergleich

Zahl

– Aufgabe: „War da eine Änderung?“

– Vergleich der Stimulusrepräsentationen

c

keine Änderung

Anstieg

„keine

Änderung“

0

Alle Arten von

Entscheidungen:

Änderungsentdeckung,

Vergleich...

1

p(Änderung|Anstieg)

• Entscheidung basiert auf e: „Änderung“ wenn e > c

• Gaußsche SDT: symmetrischer ROC

• Asymmetrische ROCs wäre Hinweis auf

Poisson SDT für Änderungsentdeckung

und würde den Repräsentationsvergleich in Frage stellen

Zahl

0

„Änderung“

0

p(Änderung|gleich)

e

1

Experiment 1

• 6 Teilnehmer, Versuchspersonenstunden

• Stimuli: 2 Sinustöne

– Dauer 200 ms, 10 ms Rampe, 300 ms ISI

– Intensität I = 60 dB, I individuell abgepaßt

– Frequenz der Sinustöne im Paar gleich,

zwischen Paaren randomisiert, 500-2000 Hz

• 3 Bedingungen:

– Richtung unbekannt, Anstieg, Abstieg

• Aufgabe: „War da eine Änderung?“

– 4 Antwortkategorien,

•

•

•

•

Sicher Ja

Vielleicht Ja

Vielleicht Nein

Sicher Nein (diese Kategorie wurde von den Teilnehmern so gut wie nie genutzt)

– ROC-Kurve: post hoc Kriterium anlegen

• 12000 Einzelversuche Training, 9000 Einzelversuche Daten

Experiment 2

• 5 Teilnehmer

• Stimuli und Bedingungen wie Exp. 1

– I: individuell angepaßt so daß

ROC-Fläche 50% bei „Richtung unbekannt“

• Aufgabe: „War da eine Änderung?“

– Multiple-Response Payoff Matrix

gleich Änderung

•

Ganz sicher Ja: 13

•

Sicher Ja: 5

•

Vielleicht Ja: 1

•

Vielleicht Nein: +1

•

Sicher Nein: +3

• Ganz sicher Nein: +5

+5

+3

+1

1

5

13

Punkte (ergibt €)

Punkte

Punkte

Punkte

Punkte

Punkte

– ROC-Kurve: post hoc Kriterium anlegen

• 18000 Einzelversuche

– Trainingseffekte (Leistung, Geschwindigkeit)

Ergebnis

• Änderungs-ROCs bei unbekannter Richtung

(schwarze Kurve) sind asymmetrisch

– Das widerlegt nicht die Gaußsche SDT

Repräsentationsvergleich

Ton

Ton

Zahl

Zahl

Vergleich

Zahl

Alle Arten von

Entscheidungen...

Ergebnis

• Änderungs-ROCs bei unbekannter Richtung

(schwarze Kurve) sind asymmetrisch

– Das widerlegt nicht die Gaußsche SDT

• Änderungs-ROCs bei bekannter Richtung

(rot/grün) sind ebenfalls asymmetrisch

– nicht mit Gaußscher SDT kompatibel

– Poissonprozeß mit niedrigem Mittelwert

•

Repräsentationsvergleich

Ton

Ton

Zahl

Zahl

Vergleich

Zahl

Alle Arten von

Entscheidungen...

Kein Vergleich der Repräsentationen

Ergebnis

• Änderungs-ROCs bei unbekannter Richtung

(schwarze Kurve) sind asymmetrisch

– Das widerlegt nicht die Gaußsche SDT

• Änderungs-ROCs bei bekannter Richtung

(rot/grün) sind ebenfalls asymmetrisch

– nicht mit Gaußscher SDT kompatibel

– Poissonprozeß mit niedrigem Mittelwert

Stimulusvergleich

Tonpaar

AnstiegsDetektor

AbstiegsDetektor

Zahl

Zahl

Änderung?

Anstieg?

Abstieg?

Vergleich

•

•

Kein Vergleich der Repräsentationen

Auswertung des Gesamtstimulus

resultiert in zwei Zahlen

– Anstieg und Abstieg werden

unabhängig detektiert

» Größere Sensitivität für

Anstiege (ökologisch sinnvoll)

– Inkrement- und DekrementDetektoren erzeugen an der

differentiellen Schwelle

nur wenige neuronale Events

SDT mit zwei Indikatoren

• Modell: Poisson-Verteilungen

für Ninc und Ndec für drei Stimuli

– same

– decrement

– increment

µinc = 2

µinc = 2

µinc = 6

µdec = 2

µdec = 4

µdec = 2

0,5

0,5

0

0 1 2 3 4 5 6 7 8 9

0

0,5

0 1 2 3 4 5 6 7 8 9

0 1 2 3 4 5 6 7 8 9

0

0,5

0 1 2 3 4 5 6 7 8 9

0,5

0

0,5

0

0

0 1 2 3 4 5 6 7 8 9

p(

p( p(

(N

(Ninc

(N

,N

,N

) || decrement

)increment

| same ) ))

inc,N

incdec

dec)dec

Stimulusvergleich

Tonpaar

AnstiegsDetektor

AbstiegsDetektor

Zahl

Zahl

Änderung?

Anstieg?

Abstieg?

Vergleich

0 1 2 3 4 5 6 7 8 9

SDT mit zwei Indikatoren

• Modell liefert p ( Detektoren | Stimulus )

• aufgabenabhängig: a priori Wahrsch.

• Bayes liefert p ( Stimulus | Detektoren )

p( (Ninc,Ndec) | increment )

Stimulusvergleich

Tonpaar

AnstiegsDetektor

AbstiegsDetektor

Zahl

Zahl

Änderung?

Anstieg?

Abstieg?

Vergleich

p (same)

p (decrement)

p (increment)

50

25

25

U

50 50 0

50 0 50

0 50 50

D I V

SDT mit zwei Indikatoren

•

•

•

•

Modell liefert p ( Detektoren | Stimulus )

aufgabenabhängig: a priori Wahrsch.

Bayes liefert p ( Stimulus | Detektoren )

Aufgabe Inkrement

– optimale Strategie achtet nur auf Ninc

p(

p(p(

(N

increment

(N

) | )|increment

N

| same

) ))

inc,N

inc,N

decdec

inc,Ndec

Stimulusvergleich

Tonpaar

AnstiegsDetektor

AbstiegsDetektor

Zahl

Zahl

Änderung?

Anstieg?

Abstieg?

Vergleich

p (same)

p (decrement)

p (increment)

50

25

25

U

50 50 0

50 0 50

0 50 50

D I V

SDT mit zwei Indikatoren

•

•

•

•

Modell liefert p ( Detektoren | Stimulus )

aufgabenabhängig: a priori Wahrsch.

Bayes liefert p ( Stimulus | Detektoren )

Aufgabe Dekrement

– optimale Strategie achtet nur auf Ndec

p( decrement | Ninc,Ndec )

Stimulusvergleich

Tonpaar

AnstiegsDetektor

AbstiegsDetektor

Zahl

Zahl

Änderung?

Anstieg?

Abstieg?

Vergleich

p (same)

p (decrement)

p (increment)

50

25

25

U

50 50 0

50 0 50

0 50 50

D I V

SDT mit zwei Indikatoren

•

•

•

•

Modell liefert p ( Detektoren | Stimulus )

aufgabenabhängig: a priori Wahrsch.

Bayes liefert p ( Stimulus | Detektoren )

Aufgabe „Änderung“ (unknown)

– Reduktion auf eine Zahl schwierig

•

•

near miss · Ninc² + · Ndec²

2-dim. Konturen

p(

p(

p(change

NNinc

,Ndec

| |N|change)

same

,Ndec) )

inc,N

dec

inc

Stimulusvergleich

Tonpaar

AnstiegsDetektor

AbstiegsDetektor

Zahl

Zahl

Änderung?

Anstieg?

Abstieg?

Vergleich

p (same)

p (decrement)

p (increment)

50

25

25

U

50 50 0

50 0 50

0 50 50

D I V

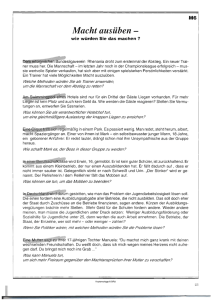

d'

Likelihood flooding

• ROC kommt zustande durch

– klassisch: Kriterium im likelihood ratio

– äquivalent: Kriterium im Ereignisraum

-3

-2

-1

0

„nein“

R

S+R

1

k

2

3

„ja“

4

5

• Voraussetzung: Ereignisraum bezüglich

likelihood ratio wohlsortiert

1

– likelihood ratio p(S+R)/p(R)

hängt monoton zusammen mit

likelihood p(S+R)

pT

0,5

0

0

0,5

pFA

1

SDT mit zwei Indikatoren

•

•

•

•

Modell liefert p ( Detektoren | Stimulus )

aufgabenabhängig: a priori Wahrsch.

Bayes liefert p ( Stimulus | Detektoren )

Aufgabe „Änderung“ (unknown)

– Reduktion auf eine Zahl schwierig

•

•

near miss · Ninc² + · Ndec²

2-dim. Konturen

p(p(N

change

N

,N,N

| |Nchange

| inc

same)

,Ndec )

incinc

dec

dec

Stimulusvergleich

Tonpaar

AnstiegsDetektor

AbstiegsDetektor

Zahl

Zahl

Änderung?

Anstieg?

Abstieg?

Vergleich

p (same)

p (decrement)

p (increment)

50

25

25

U

50 50 0

50 0 50

0 50 50

D I V

SDT mit zwei Indikatoren

•

•

•

•

Modell liefert p ( Detektoren | Stimulus )

aufgabenabhängig: a priori Wahrsch.

Bayes liefert p ( Stimulus | Detektoren )

Aufgabe Vergleich

– vielleicht reicht eine Zahl

•

·Ninc – ·Ndec

p(

p( N

Ninc

increment

,Ndec

increment

| Ninc,Ndec ))

inc,N

dec || decrement

Stimulusvergleich

Tonpaar

AnstiegsDetektor

AbstiegsDetektor

Zahl

Zahl

Änderung?

Anstieg?

Abstieg?

Vergleich

p (same)

p (decrement)

p (increment)

50

25

25

U

50 50 0

50 0 50

0 50 50

D I V

SDT mit zwei Indikatoren

•

•

•

•

Modell liefert p ( Detektoren | Stimulus )

aufgabenabhängig: a priori Wahrsch.

Bayes liefert p ( Stimulus | Detektoren )

Alt / Neu

– Alt-Detektor, Neu-Detektor

– es gibt kein Drittes

p( neu | Nneu,Nalt )

Stimulusvergleich

NeuDetektor

AltDetektor

Zahl

Zahl

neu

Stimulus

Änderung?

Anstieg?

Abstieg?

alt/neu

alt

p (same)

p (alt)

p (neu)

50

25

25

U

50 50 0

50 0 X

0 50 1-X

D I V