P (Erkältung)

Werbung

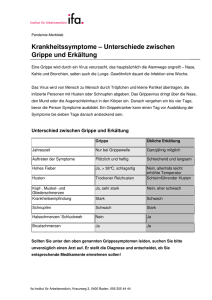

Methoden der KI in der Biomedizin Unsicheres Schließen Karl D. Fritscher Motivation Insofern sich die Gesetze der Mathematik auf die Wirklichkeit beziehen, sind sie nicht sicher. Und insofern sie sich sicher sind, beziehen sie sich nicht auf die Wirklichkeit. Albert Einstein Motivation • Formulierungen/Regeln mit Hilfe der klassischen Prädikatenlogik sind für reale Probleme oft unzureichend: ∀ p Symptom(p, Zahnschmerzen) ⇒ Krankheit(p, Loch) Diese Aussage ist aber nicht immer richtig: nicht alle Patienten mit Zahnschmerzen haben Löcher. Manche Patienten haben Zahnfleischprobleme oder einen Abszess oder eines von mehreren anderen Problemen Um diese Aussage wahr zu machen müsste man eine nahezu unbegrenzte Liste möglicher Ursachen einfügen. Umkehrung: ∀ p Krankheit(p, Loch) ⇒ Symptom(p, Zahnschmerzen) Ebenfalls unrichtig, weil nicht alle Löcher Zahnschmerzen verursachen. Repräsentation von Unsicherheit in logischen Aussagen Lösung Fuzzy Logic ?? Fuzzy-Logik ● ● ● Die Unschärfe ist eine Form der Ungenauigkeit bei der Abbildung bzw. Wiedergabe eines Sachverhalts. Repräsentation und Verarbeitung von ungenauen Daten („fuzzy“) Beschäftigt sich mit Wahrheitsgraden Probabilistisches Schließen ● ● ● Die Wahrscheinlichkeit ist eine Einstufung von Aussagen und Urteilen nach dem Grad der Gewissheit. Repräsentation und Verarbeitung von Unsicherheit Beschäftigt sich mit Glaubensgraden Ursachen für Unsicherheit • Faulheit: Es macht zu viel Arbeit, die vollständige Menge an Antezendenzen oder Konsequenzen aufzulisten • Theoretisches Unwissen: Viele Dinge sind auch theoretisch unbekannt (zB Medizin) • Praktisches Unwissen: Selbst wenn alle Regeln bekannt sind, kann man z.B. bei einem Patienten immer noch bzgl. einer Diagnose unsicher sein, weil nicht alle erforderlichen Tests ausgeführt wurden oder ausgeführt werden konnten. Woher kommen Wahrscheinlichkeiten? Verschiedene Standpuntke: Frequentisten: Zahlen können nur aus Experimenten stammen: Wenn von 100 Menschen 1 Mensch ein Loch im Zahn hat, beträgt die Wahrscheinlichkeit für das Auftreten 0.1 0.1 ist der Bruchteil der im Rahmen von unendlich vielen Stichproben beobachtet wird Objektivisten: Wahrscheinlichkeiten sind reale Aspekte des Universums, Tendenzen von Objekten sich auf eine bestimmte Weise zu verhalten und nicht nur Beschreibung des Glaubensgrades eines Beobachters Die Maße des Frequentisten sind Versuche diese Tendenzen zu beobachten (Quantenphänomene ?) Woher kommen Wahrscheinlichkeiten? Subjektivisten: Beschreiben Wahrscheinlichkeiten als Möglichkeit, den Glauben (an eine Sache) ohne physische Bedeutung zu charakterisieren („Ich sehe ein 90% Chance das BMI Studium innerhalb der nächsten X Jahre erfolgreich abzuschliessen“) Letztendlich beinhaltet auch eine streng frequentistische Position eine subjektive Analyse. Das wir im Referenzklassenproblem deutlich: Damit ein frequentistischer Arzt Wahrscheinlichkeiten ermitteln kann, muss er eine bestimmte Anzahl von Patienten beobachten, die relevante Ähnlichkeiten aufweisen. Was aber sind relevante Ähnlichkeiten?? Grundlagen diskreter Wahrscheinlichkeitstheorie • Zufallsvariable: verweist auf einen Teil der Welt, dessen Zustand anfänglich unbekannt ist • Domäne: Werte, welche ein Zufallsvariable annehmen kann Boolsche Zufallsvariable: Domäne ⟨true,false⟩ (zB Zahnschmerz) Diskrete Zufallsvariable: übernehmen Werte aus einer abzählbaren Domäne (z.B. Wetter ⟨wolkenlos, regnerisch, wolkig, schneefall⟩, Würfel). Werte in der Domäne müssen sich gegenseitig ausschließen. Stetige Zufallsvariablen: nehmen als Werte reelle Zahlen an z.B. Temperatur [-20,40] Grundlagen diskreter Wahrscheinlichkeitstheorie • Atomare Ereignisse: vollständige Spezifikation des Zustands der Welt, über den ein Agent unsicher ist. Besteht meine Welt z.B. nur aus den boolschen Variablen Loch und Zahnschmerzen, dann gibt es nur 4 versch. atomare Ereignisse. Ein solches Ereignis wäre z.B. „Loch = false ⋀ Zahnschmerzen = true“ Eigenschaften atomarer Ereignisse: 1. Atom. Ereignisse schließen sich gegenseitig aus 2. Die Menge aller atomarer Ereignisse ist erschöpfend und es muss mindestens eines der Fall sein (d.h. die Disjunktion aller atomaren Ereignisse ist logisch äquivalent mit true) 3. Aus jedem atomaren Ereignis folgt logisch die Wahrheit oder Falschheit jeder Aussage, ob einfach oder komplex. (zB hat das atomare Ereignis Loch ⋀ ⌝ Zahnschmerzen die Wahrheit von Loch und Falschheit von Loch ⇒ Zahnschmerzen als logische Konsequenz) Grundlagen diskreter Wahrscheinlichkeitstheorie 4. Jede Aussage ist logisch äquivalent mit der Disjunktion aller atomaren Ereignisse, aus denen die Wahrheit der Aussage logisch folgt (z.B. die Aussage Loch ist äquivalent mit der Disjunktion der atomaren Ereignisse Loch ⋀ Zahnschmerzen und Loch ⋀ ⌝Zahnschmerzen ) Unbedingte Wahrscheinlichkeit • Die unbedingte (=a-priori) Wahrscheinlichkeit , die einer Aussage a zugeordnet ist, ist der Glaubensgrad, der Ihr bei Fehlen einer anderen Information zugeordnet wird; sie wird als P(a) geschrieben. Anstatt von P(Wetter=sonnig) = 0.7, P(Wetter=regnerisch) = 0.02 P(Wetter=wolkig) = 0.2, P(Wetter=schneefall) = 0.08 wird P(Wetter)= (0.7, 0.2, 0.02, 0.08) geschrieben. Diese Aussage definiert die unbedingte Wahrscheinlichkeitsverteilung für die Zufallsvariable Wetter. • Für Ausdrücke wie P(Wetter, Loch) wird eine 4 x 2 Tabelle zur Repräsentation der gemeinsamen Wahrscheinlichkeitsverteilung von Wetter und Loch benutzt. Unbedingte Wahrscheinlichkeit • Für stetige Zufallsvariablen wir die Wahrscheinlichkeit, dass die Variable den Wert x annimmt, als parametrisierte Funktion von x dargestellt: P(X=x) = U[18,26](x) Die Maximaltemperatur für den nächsten Tag ist gleichmäßig zwischen 18 und 26 Grad verteilt. • Wahrscheinlichkeitsverteilungen für stetige Variablen werden als probabilistische Dichtefunktionen (=Wahrscheinlichkeitsdichtefunktion) bezeichnet. Dichtefunktionen unterscheiden sich in Ihrer Bedeutung von diskreten Verteilungen: Die Dichtefunktion f(x) ist die erste Ableitung der Verteilungsfunktion, falls diese an der Stelle x differenzierbar ist. Bedingte Wahrscheinlichkeit • Die bedingte (a-posteriori) Wahrscheinlichkeit von X=x, bei bekanntem Y=y ist: Für Verteilungen: Bayes Regel: Kettenregel: Bedingte Wahrscheinlichkeit • Bedingte Wahrscheinlichkeiten sind nicht einfach logische Implikationen mit zusätzlicher Unsicherheit: P(loch | zahnschmerzen) = 0.8 sagt nur etwas über die Wahrscheinlichkeit eines Loches aus, wenn „zahnschmerzen“ der einzig vorhandene Hinweis ist. • Zusätzliche Information kann die Wahrscheinlichkeit für ein Loch erhöhen: P(loch | zahnschmerzen, loch) = 1 vermindern : P(loch | zahnschmerzen, zahnfleischprobleme) = 0.1 irrelevante Information: P(loch | zahnschmerzen, regen) =0.8 Marginalisierung Gemeinsame Verteilung von (Wetter, Loch): Randwahrscheinlichkeit(=Marginale Wahrscheinlichkeit) von P(wetter=regnerisch) = P(Wetter=regnerisch ⋀ loch) + P(Wetter=regnerisch ⋀ ⌝ loch) Marginalisierung allgemein: Statistische Unabhängigkeit von Variablen X und Y sind genau dann statistisch unabhängig wenn gilt: Unabhängigkeit führt zur Verkleinerung der Tabelle zur Repräsentation der gemeinsamen Wahrscheinlichkeitsverteilung: • Mit Wetter gleich ⟨sonnig, wolkig, regnerisch, schneefall⟩, hat die Tabelle zur Darstellung der gemeinsamen Wahrscheinlichkeitsverteilung von (Wetter, Zahnschmerzen, Verfangen, Loch), 4 x 2 x 2 x 2 = 32 Einträge Statistische Unabhängigkeit von Variablen • Mit dem Wissen, dass das Wetter unabhängig vom Rest der Variablen ist, kann die Kettenregel verwendet werden um die gemeinsame Wahrscheinlichkeitsverteilung auf P(Wetter, Zahnschmerzen, Verfangen, Loch) = P(Wetter) P(Zahnschmerz, Verfangen, Loch) zu reduzieren und bekommt so 2 Tabellen mit 4 bzw. 8 Einträgen, anstatt von einer Tabelle mit 32 Einträgen Bedingte Unabhängigkeit von Variablen • Bedingte Unabhängigkeit: (Zwei) nicht von einander unabhängige Variablen können durch Vorwissen unabhängig werden • Beispiel: Wahrscheinlichkeit P(Erkältung | Schnupfen, Husten) • Einfach bei Vorliegen einer vollständigen, gemeinsamen Wahrscheinlichkeitsverteilung (was für eine große Anzahl an Variablen jedoch ungeeignet bzw. unrealistisch ist) • Verwendung der Bayes Regel: P(Erkältung | Schnupfen, Husten) = α P(Husten, Schnupfen| Erkältung) P(Erkältung) Bei genauerer Überlegung, merkt man, dass Schnupfen und Heiserkeit nicht voneinander unabhängig sind, aber unabhängig werden, wenn man weiß, ob eine Erkältung vorliegt oder nicht! Bedingte Unabhängigkeit von Variablen • X und Y sind bei bekanntem Z bedingt unabhängig wenn gilt: P(X,Y | Z) = P(X|Z) ⇔ P(Y,Z | Z) P(Y|Z) ⇔ P(X,Y | Z) = P(X|Z) P(Y|Z) • Husten und Schnupfen sind also bei bekannter Erkältung bedingt unabhängig: P(Schnupfen, Husten |Erkältung) = P(Husten| Erkältung) P(Schnupfen | Erkältung) • Daraus ergibt sich: P(Erkältung | Schnupfen, Husten) = α P(Husten, Schnupfen | Erkältung) P(Erkältung)= α P(Husten | Erkältung) P(Schnupfen | Erkältung) P(Erkältung) Bedingte Unabhängigkeit von Variablen P(Erkältung | Schnupfen, Husten) = α P(Husten, Schnupfen | Erkältung) P(Erkältung)= α P(Husten | Erkältung) P(Schnupfen | Erkältung) P(Erkältung) • Durch Anwendung der Bayes Regel wird eine diagnostische Schlussfolgerung (Symptome Ursache) in kausalen Schlussfolgerungen (Ursache Symptome) transformiert, welche im allgemeinen robuster sind: Die kausale Information P(Husten, Schnupfen | Erkältung) ist unabhängig von der Prävalenz der Erkrankung. Die Prävalenz der Erkrankung wird aber durch Miteinbeziehen von P (Erkältung) für die Schlussfolgerung P(Erkältung | Schnupfen, Husten) sehr wohl berücksichtigt. Vorteile der bedingten Unabhängigkeit ?? • Die Größe der Repräsentation für n Symptome, welche alle bedingt unabhängig sind, wächst linear anstatt exponentiell Naive Bayes Modelle • Wahrscheinlichkeitsverteilungen der Form P(Ursache, Effekt 1 , , Effekt n ) P Ursache P(Effekt i | Ursache) i unter Annahme bedingter Unabhängigkeit werden häufig auch dann verwendet, wenn die „Effekt“-Variablen bei gegebener „Ursache“Variable nicht bedingt unabhängig sind ( naiv ). • In der Praxis funktionieren diese „naiven“ Bayes-Schemata jedoch außerordentlich gut, selbst wenn die Unabhängigkeitsannahme nicht wahr ist. Zusammenfassung • Vollständige gemeinsame Verteilungsfunktionen enthalten vollständige Informationen über die Wahrscheinlichkeiten aller Kombinationen einer Menge von Zufallsvariablen • Miteinbeziehen von zusätzlichem Wissen führt zu bedingten Wahrscheinlichkeiten • Bayes Regel wird benutzt um diagnostische Schlussfolgerungen mittels kausalem Wissen zu tätigen • Unabhängigkeit und bedingte Unabhängigkeit erlauben eine vereinfachte Repräsentation gemeinsamer Verteilungsfunktionen • Naive Bayes Modelle setzen die bedingte Unabhängigkeit der „Effekt“Variablen bei gegebener Ursache voraus

![[1] Prof. Dr. Ronald Eccles, Common Cold Centre](http://s1.studylibde.com/store/data/002012069_1-8d66d203450ea2af3b31afd1401a142d-300x300.png)