Wichtige Definitionen und Aussagen

Werbung

Wichtige Definitionen und Aussagen

Zufallsexperiment, Ergebnis, Ereignis:

Unter einem Zufallsexperiment verstehen wir einen Vorgang, dessen Ausgänge

sich nicht vorhersagen lassen. Die möglichen Ausgänge heißen Ergebnisse. Diese

fasst man in der Ergebnismenge Ω zusammen. Bei Zufallsexperimenten mit endlicher Ergebnismenge Ω bezeichnen wir eine beliebige Teilmenge von Ω als Ereignis.

Einelementige Teilmengen von Ω heißen auch Elementarereignisse. Die Ergebnismenge Ω ist ebenfalls ein Ereignis und wird auch sicheres Ereignis genannt. Die

leere Menge ∅ heißt hingegen auch unmögliches Ereignis. Das zu einem Ereignis

E komplementäre Ereignis Ω\E wird auch mit E oder E c bezeichnet.

Verknüpfung von Ereignissen:

Sind E1 und E2 zwei Ereignisse, so bezeichnet

E1 ∪ E2 die Menge aller Ergebnisse ω, die eintreten, wenn E1 oder E2 eintritt, d.h.

E1 ∪ E2 = {ω ∈ Ω|ω ∈ E1 oder ω ∈ E2 }, und

E1 ∩ E2 die Menge aller Ergebnisse ω, die eintreten, wenn E1 und E2 eintreten, d.h.

E1 ∩ E2 = {ω ∈ Ω|ω ∈ E1 und ω ∈ E2 }.

Laplace-Wahrscheinlichkeit:

Die Laplace-Wahrscheinlichkeit für das Eintreten eines Ereignisses E ⊂ Ω einer

endlichen Ergebnismenge Ω ist definiert durch

P (E) =

Anzahl der für E günstigen Ausgänge

|E|

=

.

Anzahl aller möglichen Ausgänge

|Ω|

Bernoulli-Experiment:

Als Bernoulli-Experiment bezeichnet man ein Zufallsexperiment, bei dem man

sich nur dafür interessiert, ob ein bestimmtes Ereignis eintritt oder nicht.

Eigenschaften der Laplace-Wahrscheinlichkeit:

1. Nichtnegativität: Für jedes Ereignis E ⊂ Ω ist P (E) ≥ 0.

2. Normiertheit: Es gilt P (Ω) = 1.

3. Sind E1 und E2 zwei Ereignisse, so ist

P (E1 ∪ E2 ) = P (E2 ∪ E1 ) ≥ P (E1 ) und P (E1 ∪ E2 ) ≥ P (E2 ).

4. Sind E1 , E2 , . . . , En−1 , En paarweise disjunkte Ereignisse (d.h. alle Ereignisse

besitzen verschiedene Elemente), dann ist

P (E1 ∪ · · · ∪ En ) =

n

X

i=1

5. P (E) = P (E c ) = 1 − P (E)

1

P (Ei ).

bedingte Wahrscheinlichkeit:

Seien E und F Ereignisse mit P (E) > 0. Dann heißt

P (F |E) =

P (F ∩ E)

P (E ∩ F )

=

P (E)

P (E)

die bedingte Wahrscheinlichkeit von F unter der Bedingung E (oder kurz

die Wahrscheinlichkeit von F gegeben E).

Unabhängigkeit von Ereignissen:

Zwei Ereignisse E und F heißen unabhängig, wenn

P (E ∩ F ) = P (E) · P (F ).

Ist P (E) > 0 (bzw. P (F ) > 0), so ist die Bedingung äquivalent zu P (F |E) = P (F )

(bzw. P (E|F ) = P (E)).

Satz von der totalen Wahrscheinlichkeit:

Sind Ei (i = 1, . . . , n) paarweise disjunkte Ereignisse mit P (Ei ) > 0 und Ω =

E1 ∪ · · · ∪ En , dann gilt für jedes Ereignis F ⊂ Ω

P (F ) =

n

X

P (F |Ei ) · P (Ei ).

i=1

Formel von Bayes:

Sind Ei (i = 1, . . . , n) paarweise disjunkte Ereignisse mit P (Ei ) > 0 und Ω =

E1 ∪ · · · ∪ En , dann gilt für ein Ereignis F ⊂ Ω mit P (F ) > 0

P (Ei |F ) =

P (F |Ei ) · P (Ei )

P (F |Ei ) · P (Ei )

.

= Pn

P (F )

j=1 P (F |Ej ) · P (Ej )

Zufallsvariable:

Sei Ω ein Ergebnisraum. Eine Zufallsvariable X ist eine Funktion, die jedem Ergebnis ω ∈ Ω einen Wert X(ω) zuordnet. Nimmt in einem Experiment die Zufallsvariable den Wert x an, so wird x auch als Realisation von X bezeichnet. Die

Menge aller möglichen Realisationen wird auch mit X bezeichnet.

diskrete Wahrscheinlichkeitsverteilung:

Sei X eine Zufallsvariable, die nur endlich oder abzählbar unendlich viele Realisationen x1 , x2 , . . . ∈ X besitzt, dann heißt die Funktion f mit der Eigenschaft

X

f (xi ) = P (X = xi ) und

f (xi ) = 1

i

diskrete Wahrscheinlichkeitsverteilung von X.

Dichte:

Eine reellwertige Funktion f auf R mit

R∞

a) −∞ f (s) ds = 1 und

2

b) f (s) ≥ 0 für alle s ∈ R

heißt Wahrscheinlichkeitsdichte oder kurz Dichte. Eine Zufallsvariable X besitzt die Dichte f , wenn

Z b

f (s) ds für alle a, b ∈ R mit a < b.

P (a < X ≤ b) =

a

Verteilungsfunktion:

Ist X eine reellwertige Zufallsvariable, so heißt die Funktion F mit F (x) = P (X ≤ x)

Verteilungsfunktion von X. Besitzt X eine

R xDichte f , so berechnet sich die Verteilungsfunktion durch F (x) = P (X ≤ x) = −∞ f (t) dt.

Unabhängigkeit von Zufallsvariablen:

Zufallsvariablen X1 , . . . , Xn heißen unabhängig, wenn

P ((X1 ≤ x1 ) ∩ · · · ∩ (Xn ≤ xn )) = P (X1 ≤ x1 ) · . . . · P (Xn ≤ xn ).

Sind die Zufallsvariablen diskret, so ist dies äquivalent zu

P ((X1 = x1 ) ∩ · · · ∩ (Xn = xn )) = P (X1 = x1 ) · · · P (Xn = xn ).

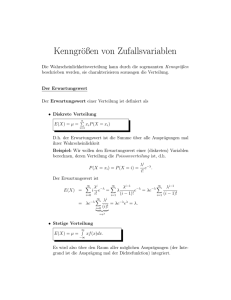

Erwartungswert

a) Für eine diskrete Zufallsvariable X mit n Realisationen xi (i = 1, . . . , n) heißt

die Zahl

n

X

E[X] =

xi P (X = xi )

i=1

Erwartungswert von X.

b) P

Für eine diskrete Zufallsvariable X mit Realisationen xi (i ∈ N) und

i∈N |xi |P (X = xi ) < ∞ heißt die Zahl

E[X] =

X

xi P (X = xi )

i∈N

Erwartungswert von X.

c) Für eine Zufallsvariable X mit Wahrscheinlichkeitsdichte f und

∞ heißt die Zahl

Z ∞

E[X] =

xf (x) dx

R∞

−∞

|x|f (x) dx <

−∞

Erwartungswert von X.

Der Erwartungswert einer diskreten Zufallsvariable X lässt sich auch schreiben als

X

E[X] =

X(ω)P ({ω}).

ω∈Ω

Der Erwartungswert ist linear, d.h. es gilt E[aX + bY ] = aE[X] + bE[Y ].

3

Varianz, Standardabweichung:

Ist X eine reellwertige Zufallsvariable mit E[X 2 ] < ∞, so heißt

2

σX

= V ar(X) = E[(X − E[X])2 ]

p

2

σX

die Standardabweichung von X. Ist X

die Varianz von X und σX =

diskret, so gilt

X

V ar(X) =

(xi − E[X])2 P (X = xi ).

i

Besitzt X eine Dichte f , so gilt

Z

∞

V ar(X) =

(x − E[X])2 f (x) dx.

−∞

Allgemein gilt die Verschiebungsformel V ar(X) = E[X 2 ] − (E[X])2 .

α-Quantil:

Sei X eine Zufallsvariable und 0 < a < 1. Dann heißt jede Zahl ξα ∈ R mit

P (X ≤ ξα ) ≥ α und P (X ≥ ξα ) ≥ 1 − α

ein α-Quantil von X. Ein 12 -Quantil von X wird auch Median von X genannt.

Besitzt X die Dichte f , so ist ξα bestimmt durch

Z

ξα

α = P (X ≤ ξα ) =

f (x) dx.

−∞

Kovarianz, Korrelationskoeffizient:

Sind X und Y zwei reellwertige Zufallsvariablen mit E[X 2 ] < ∞ und E[Y 2 ] < ∞,

so heißt

cov(X, Y ) = E (X − E[X])(Y − E[Y ])

die Kovarianz von X und Y . Der Wert

%X,Y =

cov(X, Y )

σX · σY

wird als Korrellationskoeffizient bezeichnet.

Es gilt cov(X, Y ) = E[XY ] − E[X] · E[Y ].

X und Y heißen positiv korreliert, wenn cov(X, Y ) > 0, und negativ korreliert,

wenn cov(X, Y ) < 0.

Zentraler Grenzwertsatz:

Seien X1 , . . . , Xn unabhängige und identisch verteilte Zufallsvariablen

mit ErwarPn

2

tungswert µ und endlicher Varianz σ . Dann ist die Summe Σn = i=1 Xi annähernd

normalverteilt mit Erwartungswert nµ und Varianz nσ 2 . Dies ist gleichbedeutend

dazu, dass

Σn − nµ

Zn = √

nσ

annähernd standardnormalverteilt ist.

4

Mathematisches Stichprobenmittel und Stichprobenvarianz:

Sind X1 , . .P

. , Xn unabhängige und identisch verteilte Zufallsvariablen, so heißt

1

XM = nP ni=1 Xi mathematisches Stichprobenmittel. Die Zufallsvariable

n

1

2

S 2 = n−1

i=1 (Xi − XM ) heißt dann auch mathematische Stichprobenvarianz.

Konfidenzintervall für den Erwartungswert einer Zufallsvariable X:

Das Intervall [XM − d, XM + d] mit

P (XM − d ≤ E[X] ≤ XM + d) = 1 − α

heißt Konfidenzintervall für E[X] zum Konfidenzniveau 1 − α. Das Intervall

[xM − d, xM + d], in dem die Zufallsvariable XM durch eine Realisation xM ersetzt

wurde, nennen wir zur Unterscheidung konkretes Konfidenzintervall.

Wichtige Konfidenzintervalle:

1. X ∼ N (µ, σ 2 ) mit bekanntem σ 2 :

h

i

σ

σ

XM − √ z1− α2 , XM + √ z1− α2 ,

n

n

wobei z1− α2 das 1 − α2 -Quantil der Standardnormalverteilung bezeichnet.

2. X ∼ N (µ, σ 2 ) mit unbekanntem oder nur geschätztem σ 2 :

wobei tn−1,1− α2

i

h

S

S

α

α

XM − √ tn−1,1− 2 , XM + √ tn−1,1− 2 ,

n

n

das 1 − α2 -Quantil der tn−1 -Verteilung bezeichnet.

√

n

3. X beliebig: Für große n ist (XM −µ)

annähernd standardnormalverteilt (nach

S

dem Zentralen Grenzwertsatz). Für große n erhalten wir also das Konfidenzintervall

h

i

S

S

XM − √ z1− α2 , XM + √ z1− α2 ,

n

n

wobei z1− α2 das 1 − α2 -Quantil der Standardnormalverteilung bezeichnet.

Maximum-Likelihood-Schätzer:

Ist X eine diskrete (bzw. stetige) Zufallsvariable mit zugehöriger Verteilung (bzw.

Dichte) f , die von einem (unbekannten) Parameter λ abhängt, und X1 , . . . , Xn eine

mathematische Stichprobe, dann heißt

Lλ (x1 , . . . , xn ) = fλ (x1 ) · · · fλ (xn )

Likelihood-Funktion zu X. Der Parameter λmax , für den die Funktion Lλ maximal

wird, bezeichnet man als Maximum-Likelihood-Schätzer für λ.

Kleinste-Quadrate-Schätzer:

Wenn zwischen zwei Zufallsvariablen X und Y ein Zusammenhang Y = aX + b + ε

5

mit (zufälligem) Fehler ε besteht, dann kann man die Koeffizienten a und b durch

die Kleinste-Quadrate-Schätzer

Pn

(X − X̄)(Yi − Ȳ )

SXY

Pn i

â = 2 = i=1

2

SX

i=1 (Xi − X̄)

und b̂ = Y − âX schätzen.

Konfidenzintervall für Varianzen:

Sei X ∼ N (µ, σ 2 ) und X1 , . . . , Xn eine mathematische Stichprobe zu X, d.h. X1 , . . . , Xn

sind unabhängig und N (µ, σ)-verteilt. Dann ist

(n − 1)S 2 (n − 1)S 2

,

χ2n−1;1− α

χ2n−1; α

2

2

ein Konfidenzintervall zum Niveau 1 − α für die Varianz σ 2 .

Hypothese, Test:

Eine Hypothese ist eine (auf Beobachtungen bzw. Auswertungen von Experimenten basierende) Vermutung über die Verteilung einer Zufallsvariable. Eine Entscheidungsregel, ob die Hypothese (abhängig von der Stichprobe) angenommen oder verworfen werden soll, bezeichnet man als Test. Um eine (Null-)Hypothese H0 gegen

eine Alternativhypothese (oder kurz Alternative) H1 zu testen, zerlegt man die

Menge aller möglichen Stichprobenergebnisse in zwei disjunkte Teilmengen A und

S und legt fest:

Falls ω ∈ A, wird H0 angenommen (A Annahmebereich).

Falls ω ∈ S, wird H0 verworfen (S Verwerfungsbereich, kritischer Bereich).

Fehler 1. Art und Fehler 2. Art:

Ein Fehler 1. Art liegt vor, wenn eine wahre Hypothese verworfen wird.

Ein Fehler 2. Art liegt vor, wenn eine falsche Hypothese angenommen wird.

Gütefunktion, Niveau eines Tests:

Im Falle einer parametrischen Verteilung Pϑ , ϑ ∈ Θ, und eines Testproblems der

Form H0 : ϑ ∈ Θ0 gegen H1 : ϑΘ1 = Θ\Θ0 nennt man die Funktion β(ϑ) = Pϑ (S)

Gütefunktion des Tests. Der Test hat das Niveau α, wenn β(ϑ) ≤ α für alle

ϑ ∈ Θ0 .

Gauß-Test:

Sei X ∼ N (µ, σ 2 ) mit bekannter Varianz σ 2 . Für eine Stichprobe mit Umfang n

gibt es nun drei mögliche Gauß-Tests:

1. H0 : µ ≤ µ0 , H1 : µ > µ0

H0 wird angenommen, wenn

σ

xM ≤ µ0 + z1−α √ .

n

2. H0 : µ ≥ µ0 , H1 : µ < µ0

H0 wird angenommen, wenn

σ

xM ≥ µ0 − z1−α √ .

n

6

3. H0 : µ = µ0 , H1 : µ 6= µ0

H0 wird angenommen, wenn

σ

σ

µ0 − z1− α2 √ ≤ xM ≤ µ0 + z1− α2 √ .

n

n

Dabei bezeichne z1−α das (1 − α)-Quantil und z1− α2 das 1 −

dardnormalverteilung.

α

2

-Quantil der Stan-

Binomial-Test:

Sei X ∼ B1,p mit unbekanntem p. Für hinreichend großen Stichprobenumfang n

(Faustregel: n·po ·(1−p0 ) > 9) gibt es (approximativ) folgende mögliche BinomialTests:

1. H0 : p ≤ p0 , H1 : p > p0

H0 wird angenommen, wenn

xM

p

p0 (1 − p0 )

√

.

≤ p0 + z1−α

n

2. H0 : p ≥ p0 , H1 : p < p0

H0 wird angenommen, wenn

xM

p

p0 (1 − p0 )

√

≥ p0 − z1−α

.

n

3. H0 : p = p0 , H1 : p 6= p0

H0 wird angenommen, wenn

p

p

p0 (1 − p0 )

p0 (1 − p0 )

√

√

≤ xM ≤ p0 + z1− α2

.

p0 − z1− α2

n

n

Dabei bezeichne z1−α das (1 − α)-Quantil und z1− α2 das 1 −

dardnormalverteilung.

α

2

-Quantil der Stan-

t-Test:

Sei X ∼ N (µ, σ 2 ) mit unbekannter Varianz σ 2 . Für eine Stichprobe vom Umfang

n gibt es drei mögliche t-Tests:

1. H0 : µ ≤ µ0 , H1 : µ > µ0

H0 wird angenommen, wenn

s

xM ≤ µ0 + tn−1;1−α √ .

n

2. H0 : µ ≥ µ0 , H1 : µ < µ0

H0 wird angenommen, wenn

s

xM ≥ µ0 − tn−1;1−α √ .

n

7

3. H0 : µ = µ0 , H1 : µ 6= µ0

H0 wird angenommen, wenn

s

s

µ0 − tn−1;1− α2 √ ≤ xM ≤ µ0 + tn−1;1− α2 √ .

n

n

Dabei bezeichne tn−1;1−α das (1 − α)-Quantil und tn−1;1− α2 das 1 −

tn−1 -Verteilung.

α

2

-Quantil der

t-Test für abhängige Stichproben:

Dieser Test dient zum Vergleich der Mittelwerte zweier Zufallsvariablen X und Y .

Man geht wie folgt vor:

1. Man beobachtet die Wertepaare (xi , yi ) (i = 1, . . . , n), wobei xi Realisationen

von X und yi Realisationen von Y seien. Bilde di = xi − yi (i = 1, . . . , n) und

berechne den Mittelwert d¯ und die Stichprobenvarianz s2d .

2. Die Werte di (i = 1, . . . , n) sind Realisationen der Zufallsvariablen Di (i =

2

1, . . . , n) mit Erwartungswert µ = µX − µY . Bilde D und SD

.

2

3. Wenn Di ∼ N (µ, σD

), dann ist T =

√

d¯ n

s2s

√

D n

SD

∼ tn−1 . RT bezeichne die Realisation

von T .

4. Es gibt folgende Tests zum Signifikanzniveau α:

a) H0

H0

b) H0

H0

c) H0

H0

: µ = 0, H1 : µ 6= 0

wird angenommen, wenn |RT | ≤ tn−1;1− α2 .

: µ ≤ 0, H1 : µ > 0

wird angenommen, wenn RT ≤ tn−1;1−α .

: µ ≥ 0, H1 : µ < 0

wird angenommen, wenn RT ≥ tn−1;1−α .

χ2 -Anpassungstest:

Situation: Wir vermuten, dass eine Zufallsvariable X einer bestimmten Verteilung

folgt, deren freie Parameter wir bereits geschätzt haben.

Der χ2 -Test funktioniert nun folgendermaßen:

• Man teilt den Wertebereich X der Zufallsvariable X in geeignete disjunkte

Klassen

Pk K1 , . . . , Kk ein und bestimmt die Klassenhäufigkeiten n1 , . . . , nk mit

n = i=1 ni . Dabei gibt ni an, wie viele der Stichprobenergebnisse xj in der

Klasse Ki enthalten sind.

• Gemäß der Verteilungsannahme berechnet man pi = P (X ∈ Ki ) (i = 1, . . . , k).

• Man gibt sich ein Irrtumsniveau α vor und liest das (1−α)-Quantil der χ2k−r−1 Verteilung aus Tabellen ab. Dabei steht k für die Anzahl der Klassen und r

für die Anzahl der Schätzungen.

• H0 : X besitzt die vermutete Verteilung

H0 wird angenommen, wenn

Tχ2 =

k

X

(ni − npi )2

i=1

npi

8

≤ χ2k−r−1;1−α .