New Logic – Ein Überblick - Hu

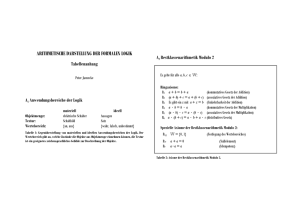

Werbung

New Logic – Ein Überblick

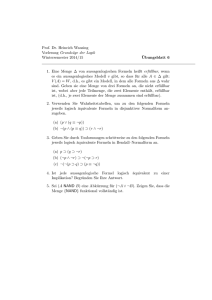

PD Dr. Timm Lampert

Inhaltsverzeichnis

1

Ziel und Motivation

1

2

Historische Rekonstruktion

6

3

Philosophische Analyse

10

4

Logische Alternative

27

5

Literatur

32

Vorbemerkung In diesem Text gebe ich einen Überblick über mein Forschungsprojekt “New Logic”. Aus diesem Projekt ist schließlich ein Computerprogramm hervorgegangen, das Formeln der reinen Quantorenlogik 1. Stufe ohne Identität entscheidet.

Der vorliegende Text möchte ein Verständnis für die historischen und logisch-philosophischen Hintergründe dieses Programmes vermitteln. Es soll klar werden, warum es

sich lohnt, sich mit diesem Programm sowie seinen Hintergründen auseinander zu setzen. Und zwar sollte dies sowohl für diejenigen verständlich werden, die sich nicht mit

ähnlichen Themen beschäftigen, als auch für diejenigen, die auf Grund ihrer Kenntnis von Logik an Voraussetzungen gewöhnt sind, die ich durch mein Projekt in Frage

stelle.

1

Ziel und Motivation

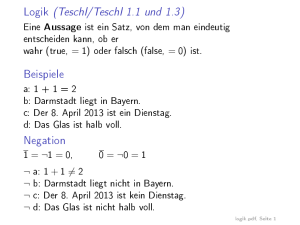

Begriff der New Logic. Unter New Logic verstehe ich das Programm, die Quantorenlogik 1. Stufe ohne Identität (“pure first order logic”, kurz FOL) ohne mengentheoretische Grundlage und damit ohne Semantik auszuarbeiten, und zwar so, dass

daran die klassische Semantik gemessen werden kann. Der Kerngedanke besteht darin,

einen Algorithmus zu entwickeln, der allein auf bekannten syntaktischen Äquivalenzumformungen beruht und durch den alle Formeln einer Klasse logisch äquivalenter

Formeln genau einem Repräsentanten zugeordnet werden. Logische Eigenschaften –

wie z.B. logische Wahrheit – sind auf dieser Basis allein durch syntaktische, sinnlich

wahrnehmbare Eigenschaften der Repräsentanten zu definieren und zu identifizieren.

1

Der Titel “New Logic” geht auf Wittgenstein zurück. Unter “New Logic” verstand

Wittgenstein eine Konzeption der Logik, die die “Old Logic” Freges und Russells ablösen sollte. Der Kernpunkt der New Logic geht auf Wittensteins Forderung zurück, logische (und auch mathematische) Begriffe allein über rein syntaktische Identifikationskriterien zu explizieren. Philosophisch gesehen ist dies eine erklärte Absage an jegliche

Form von “Extensionalismus” in der Logik und Mathematik. Die gewählte Alternative

ist kein “Intensionalismus”, der von irgendwelchen nicht-extensionalen Bedeutungen

ausgeht, sondern ein vollständiger Verzicht auf jeglichen Rekurs auf Semantik in Logik und Mathematik. Vorausgesetzt wird allenfalls der Gebrauch von Ausdrücken, aber

nicht deren etwaige Intension oder Extension.

Abgrenzung zum traditionellen Verständnis der Logik. Das traditionelle Verständnis der Logik, das auf der extensionalen Semantik aufbaut, interpretiert logische Formeln ϕ als Wahrheitsfunktionen, denen in Abhängigkeit von Interpretationen = der logischen und nicht-logischen Bestandteile einer Formel Wahrheitswerte WW zugeordnet werden. Interpretationen sind Zuordnungen von Extensionen zu den Bestandteilen

logischer Formeln. Die Interpretation der logischen Bestandteile ist fix; die der nichtlogischen Bestandteile variiert und muss jeweils angegeben werden, um den Wahrheitswert zu bestimmen, der einer logischen Formel relativ zu einer Interpretation zugeordnet wird. ∃y∀x(F xy ↔ ¬F xx) ist z.B. eine Wahrheitsfunktion, die den Wert F erhält,

wenn =(x, y) = {x | x ist eine Menge}, =(F ) = {< x, y >| x y}. Eine logische Formel plus eine Interpretation repräsentiert einen Satz S; die angegebene Formel plus die

angegebene Interpretation repräsentieren z.B. den Satz “Es gibt eine Menge, die alle

und nur die Mengen enthält, die sich selbst nicht als Element enthalten” (= Russells

Paradox). Dieser Satz ist gemäß der extensionalen Semantik falsch, denn ihm wird

auf Grund der Extensionen, die seinen logischen wie nicht-logischen Bestandteilen gemäß ihrer extensionalen Bedeutung zuzuordnen sind, der Wahrheitswert F zugeordnet.

Dieses Verständnis logischer Formeln lässt sich durch folgende Form kurz ausdrücken

(“→” steht für eine extensionale Zuordnung):

=(ϕ) → W W ; wobei =(ϕ) wahr ist gdw. S.

Die Zuordnung zu Wahrheitswerten muss nicht berechenbar sein, denn die Extensionen, auf die Bezug genommen wird, sind im Falle von FOL nicht notwendigerweise

endlich.

New Logic versteht eine logische Formel ϕ nicht als eine Wahrheitsfunktion, sondern als Anweisung zur Konstruktion eines eindeutigen Repräsentanten ϕ0 einer Klasse

logisch äquivalenter Formeln. Es wird nicht einer Formel relativ zu einer Interpretation

ein Wahrheitswert zugeordnet, sondern es wird eine Formel durch ein berechenbares

Äquivalenzumformungsverfahren ein Repräsentant einer Äquivalenzklasse zugeordnet. Dieser Repräsentant (ein “ideales Symbol”) wird verstanden als eine Satzform SF

(auch kurz “logische Form”). Eine Satzform ist eine Darstellung der Eigenschaften, die

ein Satzzeichen haben muss, um Möglichkeiten der Wahrheit und Falschheit eines Satzes im logischen Raum unterscheiden zu können. Unter dem logischen Raum wird die

Mannigfaltigkeit der Unterscheidungsmöglichkeiten verstanden, die Sätze auf Grund

des Gebrauchs logischer Partikel wie “alle”, “ein”, “nicht”, “und”, “oder” u.dgl. haben

2

können. Während Formeln durch logische Schlussregeln syntaktische Eigenschaften

verliehen werden, die Möglichkeiten der Wahrheit und Falschheit im logischen Raum

bedingen, stellt ein ideales Symbol diese Eigenschaften durch seine sinnlich wahrnehmbaren Eigenschaften dar. Als Merkformel bietet sich in Gegenüberstellung zum

traditionellen Verständnis folgende Form an (“⇒” steht für ein berechenbares Äquivalenzumformungsverfahren):

ϕ ⇒ ϕ0 wobei ϕ0 = SF.

Das dieser Konzeption zu Grunde liegende logisch-philosophische Verständnis kann

ich in diesem Überblicksartikel nicht darlegen. An dieser Stelle sei nur betont, dass

diese Konzeption ohne die Begriffe der Wahrheitsfunktion, der Interpretation und der

Repräsentation von Sätzen auskommt. Nach dem Verständnis der New Logic führt die

Repräsentation von Sätzen mittels Interpretation logischer Formeln als Wahrheitsfunktionen zu Irrtümern. New Logic lehnt eine Interpretation logischer Formeln im Sinne

einer extensionalen Semantik ab; eine derartige vorschnelle Interpretation logischer

Formeln beruht auf einem Unverständnis ihrer logischen Form. Bevor logische Formeln auf irgendeine Weise intensionale oder extensionale Bedeutung zugeordnet wird,

ist ihre logische Form zu klären, denn damit wird allererst geklärt, wie logische Formeln Bedeutung verliehen werden kann.

Statt sich etwa durch die oben angegebene Interpretation der Formel ∃y∀x(F xy ↔

¬F xx) zu irgendwelchen Annahmen bezüglich der Existenz oder Nicht-Existenz etwaiger Mengen verleiten zu lassen, wird darauf beharrt, dass die genannte Formel die

Form einer Kontradiktion hat, durch die gar kein spezifischer Gehalt zum Ausdruck

gebracht werden kann. Ohne weitere Voraussetzungen über logische Formen und die

Möglichkeiten ihrer Interpretation zu machen, kann man sich dies daran vor Augen führen, dass aus Kontradiktionen logisch gesehen alles folgt. Dies impliziert auch, dass alle

Kontradiktionen äquivalent sind. Was immer man also falsch nennt, das von der Form

∃y∀x(F xy ↔ ¬F xx) sein soll, es folgt hieraus genau dasselbe wie aus “Es regnet und

es regnet nicht”. Aus diesem Blickwinkel erscheint es bedenklich, aus Russells Paradox irgendwelche substantiellen Folgerungen zu ziehen wie etwa die, dass die naive

Mengenlehre nicht korrekt ist (vgl. die Ausführungen auf S. 18). Den Wahrheitswert

F einer kontradiktorischen Formel samt einer spezifischen Interpretation zuzuordnen,

ist irreführend, denn es suggeriert, dass man – wie etwa im Falle der Zuordnung von

F zu einem sinnvollen Satz wie “Es gibt einen Kellner, der alle und nur bedient, die

sich nicht selbst angemeldet haben” – einem Satz mit einem spezifischen Gehalt einen

Wahrheitswert zuordnet. Bevor Formeln mit einer Interpretation versehen werden, um

ihnen auf dieser Grundlage einen Wahrheitswert zuzuordnen, sollte geklärt werden,

wie die logische Formelsprache verwendet werden kann, um ausdrücken zu können,

was es heißt, einen Satz wahr oder falsch zu nennen. Nach Auffassung der New Logic

stellen vorschnelle Interpretationen gemäß der extensionalen Semantik eine Verhexung

des Verstandes durch die Mittel von FOL dar. Die gewöhnliche logische Formelsprache ist ebenso wie die Umgangssprache einer weiteren Analyse bedürftig. Analyse der

logischen Formelsprache in Form algorithmischer Äquivalenztransformation vor aller

Interpretation ist der maßgebliche Schutz gegen Fehlinterpretationen und die einzige

sichere Grundlage für ein adäquates Verständnis in Logik.

3

Die extensionale Semantik soll im Rahmen der New Logic aber nicht nur durch philosophische Analyse und auf Basis eines alternativen Verständnisses kritisiert werden.

Vielmehr ist der entscheidende Punkt, dass die Konzeption der New Logic ein Maßstab bereitstellt, die in Frage stehenden Alternativen zu bemessen. Das Kernargument

hierfür ist wie folgt: 1) Eine Folge der extensionalen Semantik ist Churchs Theorem

(Unentscheidbarkeit von FOL). 2) Das Konzept der New Logic impliziert mit der Forderung eines Äquivalenzverfahrens im oben genannten Sinne die Entscheidbarkeit von

FOL. 3) Beide Konzeptionen stimmen – wenn auch aus unterschiedlichen Gründen –

überein in Bezug auf die Gültigkeit logischer Schlussregeln und damit innerlogischer

Äquivalenzumformungen. 4) Kann auf dieser Basis ein Entscheidungsverfahren für

FOL angegeben werden, dann ist dies ein unabhängiges Argument gegen das traditionelle Verständnis von FOL und für New Logic. Der vorliegende Text will vor allem

die Hintergründe dieses Argumentes soweit ausführen, dass man bereit ist, sich darauf

einzulassen.

Alternative zur mathematischen Logik. New Logic soll eine Alternative zu dem

Verständnis von FOL darstellen, das der mathematischen Logik zu Grunde liegt. Die

mathematische Logik genießt weitgehend Anerkennung. Sie galt und gilt vielen Wissenschaftlern und Philosophen sogar als eine Art Leitbild exakter Wissenschaft. Wenn

irgendwo, dann trifft auf sie Kuhns Begriff eines “Paradigma” zu: Es handelt sich um

eine institutionell eingebettete Disziplin mit festen Methoden, Begrifflichkeiten, einer

einheitlichen Symbolsprache (Syntax + Semantik von FOL) und wohldefinierten Problemen (“Rätseln”). Vor allem aber bestehen einzelne anerkannte Musterlösungen von

Problemen, die vorgeben, welche Art von Problemen wie zu lösen sind. Das prominenteste Beispiel in Hinblick auf FOL ist Churchs / Turings Lösung des von Hilbert

gestellten Entscheidungsproblems. Die mathematische Logik bildet ein System, innerhalb dessen durch wohldefinierte Beweisverfahren metamathematische Theoreme

bewiesen werden.

Motivation. Auf Grund des Status, den die mathematische Logik genießt, ist es für

die meisten prima facie nicht einsehbar, dass man eine dezidierte Alternative ausarbeiten will. Am Beginn einer Diskussion, in der noch gar kein Verständnis für eine Alternative vorausgesetzt werden kann, kann ich nicht viel mehr tun, als einige Hinweise

anzugeben, die mein Unterfangen motivieren. Ein volles Verständnis wird man nur gewinnen können, wenn man eine vollständige Alternative vor Augen hat. Nur dann wird

man auch beurteilen können, ob sich das Unterfangen lohnt bzw. gelohnt hat. Abgesehen von allen Überzeugungen, die jeder einzelne hat oder auch nicht hat, scheint mir

die Ausarbeitung einer konkreten Alternative nötig, um eine ernsthafte Diskussion und

Beurteilung allererst zu ermöglichen.

Für meine eigene Arbeit sind vor allem vier Punkte maßgeblich, die mich unabhängig und vor den Resultaten, zu denen meine Arbeit führte, antrieben:

1. Historischer Kontext der Entstehung der mathematischen Logik. In der zweiten

Hälfte des 19. Jahrhunderts wird ein vollkommen verallgemeinerter, mengentheoretischer Funktionsbegriff (“Dirichiletscher Funktionsbegriff”) im Zuge des

damaligen Bildes des Fortschritts der Mathematik im Sinne ihrer zunehmenden

4

Universalisierung allererst entwickelt. Wie sieht eine Logik aus, die an dieser

Schnittstelle einen anderen Weg einschlägt und stattdessen an den Begriff einer

Funktion im Sinne einer “Rechenvorschrift” anschließt und dies auf die Logik

überträgt? Da dieser Punkt am besten geeignet ist, sich gedanklich von Voraussetzungen zu befreien, deren man sich heutzutage oftmals gar nicht mehr bewusst

ist, werde ich hierauf in Abschnitt 2 näher eingehen.

2. Philosophische Einwände. Eine mengentheoretische Grundlegung der Logik kann

philosophische Ansprüche an eine Explikation logischer Grundbegriffe, z.B. den

der logischen Wahrheit, nicht einlösen (zum Begriff der Explikation s.u., S.

10). “Allgemeingültigkeit” (Wahrheit in allen Modellen) kann logische Wahrheit nicht explizieren, sondern bestenfalls ein Modell logischer Wahrheit bilden.

Logische Wahrheit wird durch den Begriff der Allgemeingültigkeit auf Wahrheit von Allaussagen zurückgeführt; Allaussagen müssen aber nicht logisch wahr

sein. Allgemeingültigkeit ist folglich keine Eigenschaft, die logisch wahre Formeln auszeichnet. Dies ist ein mittlerweile bekannter Kritikpunkt, der auch von

Verteidigern der Modelltheorie akzeptiert wird, vgl. z.B. Shapiro(1998). Mengentheorie birgt darüber hinaus zahlreiche eigene philosophische Probleme, z.B.

die Annahme des extensional Unendlichen sowie die mengentheoretischen Paradoxien und den Umgang mit diesen. Es ist prima facie alles andere als klar,

warum eine solche Lehre die Grundlage der Logik bilden soll. Man hat z.B. die

Intuition, dass die logische Wahrheit logischer Formeln nicht davon abhängen

sollte, dass es unendlich viele Gegenstände gibt. Ohne diese Annahme kommt

man aber in der Modelltheorie von FOL nicht aus. Modelltheorie ist die unhinterfragte Voraussetzung metamathematischer Beweismethoden und wird in der

mathematischen Logik als Maßstab verwendet, um Korrektheit und Vollständigkeit von Kalkülen zu bemessen. Es ist an der Zeit, einen Maßstab zu entwickeln,

an dem die Korrektheit der Modelltheorie gemessen werden kann. Bestärkt in

diesem Vorhaben hat mich John Etchemendys Buch “The Concept of Logical

Consequence” (Etchemendy(1999)).

3. Logische Bedürfnisse. Während in der Aussagenlogik mit Wahrheitswerttabellen und disjunktiven Normalformen und in der monadischen Quantorenlogik mit

Venn-Diagrammen Mittel zur Verfügung stehen, logische Formeln auf algorithmischem Wege verständlich zu machen und in einem gewissen Sinne “zu explizieren”, gibt es in der mehrstelligen Quantorenlogik hierfür kein Pendant. Es ist

ein bekanntes Problem, dass Paraphrase von Formeln der mehrstelligen Quantorenlogik im Allgemeinen zu keinerlei Einsicht führt und es irgendeines Mittels

bedarf, um mehr anzugeben als intuitiv gewonnene einzelne wahre oder falsche

Modelle. Innerhalb der mathematischen Logik wird derartigen Problemen kaum

Beachtung geschenkt, da das Gewicht auf Metatheoremen liegt, die im Rahmen

der mehrstelligen Quantorenlogik dem Unterfangen einer “Explikation” von Formeln auf algorithmischem Weg ohnehin prinzipielle Grenzen aufzuzeigen scheinen. Erschwerend kommt hinzu, dass man sich seit Russells und Whiteheads

Principia Mathematica in der Quantorenlogik an pränexen Normalformen orientiert (während in der Aussagenlogik disjunktive Normalformen (DNF) Standard

5

sind). Demgegenüber verlangt New Logic ein Verfahren zur Bildung disjunktiver Normalformen in FOL, das verwendet werden kann, um auf rein algorithmischem Weg auch Formeln der mehrstelligen Quantorenlogik im Sinne von formalen Darstellungen der Möglichkeiten der Wahrheit und Falschheit von Sätzen

zu explizieren.

4. Wittgensteins Kritik der mathematischen Logik. Wittgenstein ist ein scharfer

Kritiker der mathematischen Logik. Die Schärfe seiner Kritik stand einer ernsthaften Diskussion im Wege, da sie anerkannte Theoreme der mathematischen

Logik in Frage stellt, was nach dem Verständnis der meisten Mathematiker und

Philosophen einem Philosophen nicht zusteht. Jede tiefer gehende Auseinandersetzung mit Wittgensteins Philosophie der Logik und Mathematik steht vor diesem Problem. Es scheint prima facie ausgemacht, dass Wittgenstein sich “geirrt”

hat1 (z.B. die neuesten Bücher von Landini(2008), S. 112-118 und Potter(2009),

S. 181-183 zu Churchs Theorem). Die Kritik setzt aber hierbei die “Erkenntnisse” seitens der mathematischen Logik unhinterfragt voraus. Ich wollte die Motive und den sachlichen Gehalt von Wittgensteins Kritik in ihrem historischen

Kontext verstehen und eine Grundlage für eine ernsthafte Auseinandersetzung

mit Wittgensteins Kritik schaffen. Auch wenn ich glaube, dass Wittgenstein seine Gedanken aus einer größeren Distanz klarer und weniger idiosynktratisch

hätte formulieren können (oder sollen), ist die Auseinandersetzung mit seinen

Schriften für mich eine wesentliche Quelle der Inspiration des ganzen Projektes. Allerdings hat sich naturgemäß meine Arbeit zunehmend verselbständigt.

Schließlich habe ich meine Aufgabe darin gesehen, das systematisch auszuarbeiten, was Wittgenstein nur programmatisch angedeutet hat.

2

Historische Rekonstruktion

Es sei hier kurz auf einige wesentliche Schritte in der Entwicklung der mathematischen

Logik aufmerksam gemacht, um vor Augen zu führen, wovon dieser Ansatz abhängt.

Mathematical Analysis of Logic. Vor 1847 hatten Mathematik und Logik nicht viel

miteinander zu tun. Man rechnete in der Mathematik mit Formeln, während Logik

nicht formal betrieben wurde, da gar keine explizite Formelsprache vorlag. Dies änderte sich damit, dass Mathematiker – allen voran Boolos, Schröder, Jevon, DeMorgan,

Peirce u.a. – für die Logik eine Sprache nach dem Vorbild der Algebra einführten. Man

nennt diesen Abschnitt in der Entwicklung der Logik den der “mathematical analysis

of logic”, vgl. Kvasz(2008). Man kann dies als den 1. Schritt in der Entwicklung der

modernen Logik auffassen. Mit diesem Schritt ist nur eine Syntax, aber keine Semantik

1 Mühlhölzer(2010), S. 9f. bemerkt richtig, dass Wittgensteins Philosophie der Mathematik wegen seiner

Kritik an der modernen Mengenlehre einen schlechten Ruf genießt und fährt fort: “Es gehört deswegen fast

zum guten Ton, in Abhandlungen über diese Philosophie, auch wenn man ihr wohlgesinnt ist, entsprechende

abwertende Äußerungen der Kritiker zu zitieren” (S. 10). Mühlhölzer, der um eine konstruktiv-kritische

Interpretation von Wittgensteins Philosophie der Mathematik bemüht ist, will sich hieran nicht beteiligen.

Er hält Wittgensteins “vehemente Kritik” aber ebenfalls für “überzogen” und führt sie auf “einen Mangel an

mathematischem Wissen” (S. 9) zurück.

6

festgelegt. Es ist noch offen, wie die neue Syntax zu verstehen ist. Prinzipiell gibt es

zwei grundlegend unterschiedliche Möglichkeiten:

1. Man versteht aus dem Blickwinkel der Logik die mathematischen Formelsprachen neu: Ein allgemeiner, mengentheoretischer Funktionsbegriff bildet die Grundlage dafür, logische Formeln als Wahrheitsfunktionen zu interpretieren. Numerische Funktionen der Mathematik bilden nur einen Spezialfall von Funktionen und Gleichungen der Mathematik einen Spezialfall von Wahrheitsfunktionen. Logik wird zur Grundlagensprache der Mathematik und darüber hinaus zur

“Universalsprache” der Wissenschaft. Universale Repräsentierbarkeit von Aussagen in der neuen logischen Formelsprache ist der Lohn (oder Fluch – je nach

Sichtweise) dieses Ansatzes.

2. Man versteht die logische Sprache in Analogie zur mathematischen Formelsprachen: Während man mit arithmetischen Termen rechnet, um etwa Gleichungen

zu lösen, rechnet man mit logischen Formeln, um ihre logischen Eigenschaften zu bestimmen. In mathematischen Termen werden Operationen an Zahlen

vorgenommen, in logischen Termen werden Operationen an Satzformen vorgenommen. Die logische Formelsprache und die mathematischen Formelsprachen

bilden nach dieser Auffassung autonome Kalküle. Die Sprache der Logik dient

nicht als Grundlagensprache der Mathematik. Es wird kein umfassender Funktionsbegriff eingeführt, der u.a. numerische Funktionen und Wahrheitsfunktionen

unter einen Hut bringen soll. Die Sprache der Logik wird nicht an ihrer Ausdruckskraft gemessen, sondern daran, logische Eigenschaften von Satzformen

algorithmisch zu identifizieren.

Dirichiletscher Funktionsbegriff und Wortsprache. Die mathematische Logik und

mit ihr die moderne “Grundlegung” der Mathematik schlug Weg 1 ein (während New

Logic Weg 2 nimmt). An der Schnittstelle der beiden Wege liegt der neue, mengentheoretische Funktionsbegriff, der explizit von Dirichilet 1859 formuliert wurde. Der

entscheidende Punkt ist, dass nicht mehr Symbole (formale Ausdrücke) gemäß Rechenvorschriften Symbolen (formalen Ausdrücken) zugeordnet werden. Stattdessen

wird die Zuordnung extensional als Zuordnung von Objekten einer Menge zu Objekten einer anderen Menge aufgefasst. Man ist bereit, den Bereich des Berechenbaren zu

Gunsten der Ausdruckskraft zu verlassen. Es ist nun möglich, zahlentheoretische Funktionen, die nicht in Form von Rechenvorschriften definiert werden können, mittels der

Wortsprache (Umgangssprache) zu definieren. Z.B.: f (n) = 1 gdw. n rational ist und

f (n) = 0 gdw. n irrational ist (Dirichilet-Funktion im engeren Sinn). Ebenso lassen

sich Definitionen angeben, von denen man nicht entscheiden kann, ob sie Zahlen de∞

P

1

, wobei f (n) = 1 gdw. Goldbachs Vermutung

finieren oder nicht, z.B. D =

2f (n)

n=1

wahr ist und 0 sonst. Man kann z.B. nicht entscheiden, ob 1 + (D − D) = 1 ist.

Logical Analysis of Mathematics. Frege und Russell machten sich den mengentheoretischen Funktionsbegriff zu Nutze, um die Logik auf den Begriff der Wahrheitsfunktion (propositional function) zu gründen, in dem die zugeordneten Werte “Wahr7

heitswerte” sind. Dies ist die Grundlage aller Semantik in der Logik. Zugleich bildet

dies den Ausgangspunkt, um Gleichungen und darüber hinaus beliebige mathematische

Sätze (Theoreme wie “Vermutungen”) in der Sprache der Logik zu “repräsentieren”.

Z.B. kann Goldbachs Vermutung nun im Rahmen der Peano Arithmetik wie folgt repräsentiert werden:

x ist eine gerade Zahl (ϕx): ∃v 2 · v = x,

x ist eine Primzahl (ψx): x 6= 1 ∧ ∀u∀v(u · v = x → (u = 1 ∨ v = 1))

Goldbachs Vermutung (GV): ∀x(ϕx → ∃y∃z(ψy ∧ ψz ∧ y + z = x))

Gödels Unvollständigkeitsbeweis beruht auf einer Abfolge von 46 derartigen Definitionen, durch die schließlich “x ist beweisbar” durch eine Formel in Peanos Arithmetik

repräsentiert wird.

Repräsentation. Dass eine Formel einen Satz repräsentiert, heißt, dass die Formel

gemäß ihrer Interpretation wahr ist gdw. der Satz wahr ist. Die Interpretation einer

Formel beruht auf der Interpretation der in ihr enthaltenen Ausdrücke. Hierbei wird

die Interpretation selbst wieder als eine Funktion verstanden, die Extensionen Zeichen

zuordnet (z.B. Wahrheitswerte Satzbuchstaben, Mengen von n-Tupeln Prädikatbuchstaben). Vollständig ausgearbeitet wird diese Semantik erst in der Modelltheorie, die

vornehmlich auf Tarski zurückgeht. Der entscheidende Punkt in unserem Zusammenhang ist, dass Formeln selbst keine eigene Ausdruckskraft besitzen; eine logische Formel wird z.B. nicht als Ausdruck einer aus ihr allererst zu berechnenden logischen

Form verstanden. Vielmehr erhalten die “toten” Formeln erst durch ihre Interpretation

und damit durch die Bezugnahme auf Extensionen Bedeutung, wobei alle Bedeutung

letztlich dazu beiträgt, den Wahrheitswert von Sätzen, repräsentiert durch logische Formeln samt ihrer Interpretation, zu bestimmen. Um in intendierten Interpretationen auf

bestimmte Extensionen Bezug nehmen zu können, muss letztlich auf die Umgangssprache Bezug genommen werden. Diese dient im Rahmen der extensionalen Semantik allein dazu, auf Extensionen Bezug zu nehmen. Es wird vorausgesetzt, dass Aussagesätze auf Wahrheitswerte, n-stellige Prädikate auf Mengen von n-Tupeln, Namen

auf Gegenstände referieren. Es wird dabei des Weiteren vorausgesetzt, dass auf diese

referierende Funktion Bezug genommen werden kann und zugleich von allen anderen Aspekten umgangssprachlicher Ausdrücke abgesehen werden kann. Es wird damit

auch vorausgesetzt, dass von einer weitergehenden Analyse der Form oder des Gebrauchs der Ausdrücke abgesehen werden kann, um von einer referierenden Funktion

in einer extensionalen Semantik Gebrauch zu machen.

Entwicklung der mathematischen Logik. Die Entwicklung der mathematischen

Logik bis zu Churchs Theorem (Unentscheidbarkeit von FOL) lässt sich verstehen als

eine konsequente Ausformulierung des mengentheoretischen Ansatzes. Es wird das

neue Konzept der Repräsentation von Funktionen mittels Interpretation logischer Formeln immer weiter entwickelt und ausgereizt. Dies kulminiert in den metamathematischen Beweisen, in denen die Eigenschaften der Beweisbarkeit und Entscheidbarkeit

8

als numerische Funktionen innerhalb eines logischen Formalismus, der zahlentheoretische Funktionen umfasst, repräsentiert werden. Dies kann an dieser Stelle nicht mehr

ausgeführt werden. Stattdessen seien an dieser Stelle nur grob 10 maßgebliche Schritte

genannt, die sich alle als eine systematische Konsequenz von Schritt 2 – der Einführung

des Dirichiletschen Funktionsbegriffes – auffassen lassen. Die Hinweise auf Jahresdaten und Autoren sollen nur einer groben Orientierung dienen.

Schritt 1: Mathematical Analysis of Logic (Boolos 1847).

Schritt 2: Dirichiletscher Funktionsbegriff (Dirichilet 1859).

Schritt 3: Logical Analysis of Mathematics (Frege 1884, 1891).

Schritt 4: Logische Systeme (Frege, Russell, Zermelo / Fraenkel, Peano)

Schritt 4.1: Quantorenlogik (Frege: GA 1893, Russell / Whitehead: PM 1910)

Schritt 4.2: Axiomatische Mengenlehre (Zermelo / Fraenkel: 1908, 1922)

Schritt 4.3: Peano Arithmetik (Peano: 1908)

Schritt 5: Axiomatische Methode: Hilberts Formalismus (1902)

Schritt 6: Modelltheorie (Hilbert 1900-1930, u. Ackermann 1928, Tarski 1933)

Schritt 7: Logische Analyse von Paradoxien (Ramsey 1925, Tarski 1933)

Schritt 8: Beweistheorie: Hilbertprogramm (Hilbert 1918-22)

Schritt 9: Metamathematik: Methoden und Theoreme (Gödel 1931)

Schritt 10: “Churchs Theorem”: Unentscheidbarkeit von FOL (Church 1936, Turing

1936)

Bezug zu New Logic und Wissenschaftsphilosophie. Das Konzept der New Logic

setzt bei Schritt 2 an: Hier ist der Scheideweg und es soll eine Alternative entwickelt

werden, die dezidiert nicht auf Schritt 2 und allen Folgeschritten aufbaut.2 In Hinblick

auf Abschnitt 4 sei an dieser Stelle betont, dass Churchs Theorem ein “Theorem” – ein

beweisbarer Satz – im System der mathematischen Logik ist. Das Theorem ist Folge

einer mengentheoretischen Grundlegung der Logik und Mathematik, die mit Schritt 2

ansetzt. In gewisser Hinsicht kulminiert die Entwicklung der mathematischen Logik in

Churchs Theorem. Es markiert die Grenze der Berechenbarkeit innerhalb des Systems

der mathematischen Logik: dyadic pure first-order logic.

Man muss sich aber im Klaren darüber sein, dass das Programm einer dezidierten Alternative zur mathematischen Logik, die ab Schritt 2 nicht mitgeht, an derartige

Theoreme prima facie nicht gebunden ist. Dies bedeutet nicht, dass durch das bloße Vorhaben eines Alternativprogrammes irgendetwas gegen Churchs Theorem eingewendet worden sei. Jede etwaige Kritik hängt von der konkreten Ausarbeitung einer

2 Es lassen sich übrigens aus Wittgensteins Nachlassschriften zu jedem der Schritte 2-10 Zitate angeben,

die eben diese Schritte ablehnen. Dies wird verständlich, sobald man seine Kritik als Ausdruck der Ablehnung des Dirichiletschen Funktionsbegriffes in der Logik und Mathematik versteht.

9

Alternative ab. Unabhängig hiervon ist Churchs Theorem ein beweisbarer Satz innerhalb des Systems der mathematischen Logik. Andererseits ist auch festzuhalten, dass

es müßig ist, unter Voraussetzung der “Errungenschaften” der mathematischen Logik

gegen das Vorhaben eines Gegenkonzeptes zu argumentieren. Es ist vollkommen verständlich und respektabel, dass Wissenschaftler, die unter einem bestimmten Paradigma arbeiten, kein Interesse und keine Bereitschaft haben, die Grundlage ihrer Arbeit

in Frage zu stellen. M.E. bietet dies eine Chance für Wissenschaftsphilosophen: Sie

unterliegen nicht den Zwängen, denen ein Wissenschaftler unterliegt und sollten diese

Freiheit dazu nutzen, Schnittstellen in der wissenschaftlichen Entwicklung aufzutun,

diese Schnittstellen einer philosophischen Analyse unterziehen und dort, wo es sich

lohnt, konkrete Alternativkonzepte ausarbeiten. Diese Art von Wissenschaftsphilosophie dient dem Ziel, vor Augen zu führen, dass vieles in den Wissenschaften auch

anders und dabei nicht weniger erfolgsversprechend hätte verlaufen können als man

gemeinhin denkt.

3

Philosophische Analyse

Ziel der philosophischen Analyse. Ziel einer philosophischen Analyse in dem hier

zu Grunde gelegten Sinn ist es in erster Linie, Voraussetzungen unterschiedlicher Konzeptionen explizit zu machen und die Konsequenzen aufzuzeigen. Es geht nicht darum,

“wer Recht hat”, sondern darum, wer warum welchen Weg geht bzw. nicht mitgeht.

Wenn man so will, ist es eher Ziel, die Unterbestimmtheit von Positionen vor Augen

zu führen, als Urteile zu fällen. Damit soll nicht ausgeschlossen werden, dass sich nicht

begründete Urteile fällen lassen, nur gehören diese dann nicht mehr zum Geschäft der

philosophischen Analyse. Im Folgenden werden die Konzeptionen der mathematischen

Logik und der New Logic mit einander verglichen. Ich beschränke mich darauf, an ein

paar Punkten exemplarisch und skizzenhaft vor Augen zu führen, warum man aus dem

Blickwinkel des Ansatzes der New Logic nicht geneigt ist, wesentliche Schritte innerhalb der mathematischen Logik mit zu gehen.

Explikation vs. Interpretation, Teil 1. Es wurde in Abschnitt 1, S. 5 bereits darauf

hingewiesen, dass der modelltheoretische Begriff der Allgemeingültigkeit den Begriff

der logischen Wahrheit nicht expliziert. Im Folgenden soll grundlegender darauf hingewiesen werden, dass es im Wesen des mengentheoretischen Ansatzes liegt, keine

Explikationen geben zu können. Freilich kann man von vorne herein den Anspruch ablehnen, Explikationen logischer (oder mathematischer) Begriffe zu geben. Eine wohl

verstandene Modelltheorie erhebt in der Tat nur den Anspruch, extensional adäquate

Definitionen anzugeben. Aber um diesen Anspruch bemessen zu können, muss expliziert werden können, nach welchen Kriterien die fraglichen “Extensionen” zu identifizieren sind. New Logic will diese Frage im Rahmen der Logik durch Bereitstellung

syntaktischer Identifikationskriterien beantworten. Aber auch unabhängig von dieser

Argumentation kann man Explikationskraft als einen Massstab ansehen, den zu erfüllen jedenfalls besser ist als ihn nicht zu erfüllen.

Unter einer Explikation verstehe ich die Ersetzung eines Ausdruckes durch einen

anderen, der auf Grund seiner syntaktischen Struktur eine höhere Explikationskraft be10

sitzt. Es geht bei der Explikation im Wesentlichen darum, etwas noch einmal anders

auszudrücken, wobei der andere Ausdruck etwas zu klären vermag. Er ist unmissverständlicher als der Ausdruck, der expliziert wird, da er syntaktische Identifikationskriterien bereitstellt. Der Prozess der Explikation kann als eine “begriffliche Analyse” verstanden werden, der durch Definitionen – dem Ersetzen von Ausdrücken durch

Ausdrücke – geleitet ist und in Ausdrücken resultiert, die in einem gewissen Sinne unmissverständlich sind. Inwieweit zwischen Explanandum und Explanans “Äquivalenz”

bestehen muss, braucht hier nicht im Allgemeinen erörtert zu werden. Denn für die

Zielsetzung der New Logic kann der Begriff der logischen Äquivalenz im Sinne der gegenseitigen Ableitbarkeit im Rahmen bekannter FOL-Kalküle vorausgesetzt werden.

Dies ist ein systemabhängiger Äquivalenzbegriff, der einen gewissen Anhaltspunkt in

der Praxis des Schlussfolgerns auf Basis einer standardisierten Verwendung der logischen Partikel “alle”, “ein”, “nicht”, “und”, “oder”, “wenn ... dann” (und etwaiger anderer Partikel) hat. Diese Praxis und die damit verbundenen Äquivalenzurteile (nachweisbar in Logikkalkülen) werden vorausgesetzt; jede Explikation auf dem Gebiete

von FOL soll mit diesen Urteilen übereinstimmen. Innerhalb dieser Voraussetzungen

stellt sich allererst das Problem der Explikation von FOL-Ausdrücken: Wie können

die Äquivalenzen unterschiedlicher logischer Formeln auf eine gemeinsame logische

Form zurückgeführt werden? An Stelle einer semantischen Reduktion gegenseitiger

Ableitbarkeit auf Allgemeingültigkeit soll eine syntaktische Reduktion auf logische

Formen gegeben werden. Dies sei im folgenden Abschnitt etwas näher erläutert, indem

exemplarisch gezeigt wird, was “Explikation” gemäß New Logic im Rahmen von FOL

bedeutet. Nach dem Exkurs wird dann erklärt, warum ein mengentheoretischer Ansatz

grundsätzlich keine Explikationen liefern kann.

Exkurs: Explikation in der Logik

Ein Beweis im Rahmen der New Logic ist eine Form von Explikation, nämlich ein algorithmischer Prozess der Analyse von logischen Formeln im Sinne eines logischen

Äquivalenztransformationsverfahrens, dessen Ziel Ausdrücke sind, die syntaktische

Identifikationskriterien für die logischen Eigenschaften der Formeln bereitstellen. Eine

gewisse Vorstellung eines derartigen Verfahrens liefern Wahrheitswerttabellen, wenn

man sie nicht semantisch interpretiert, sondern als Umformungen logischer Formeln

zum Zwecke der Darstellung von Möglichkeiten der Wahrheit und Falschheit versteht,

die ein Satz auf Grund seiner Struktur besitzt. Dass kein “F” unter dem Hauptjunktor

steht, kann dann in dieser Deutung als ein syntaktisches Merkmal verstanden werden,

das aussagenlogische Wahrheit identifiziert. Die Darstellung von Wahrheitswerttabellen ist eine isomorphe Darstellung von kanonischen disjunktiven Normalformen, die

innerhalb eines aussagenlogischen Kalküls nach einem vorgegebenen Äquivalenztransformationsverfahren aus einer input-Formel und ihrer Negation algorithmisch erzeugt

werden kann. Insofern können Wahrheitwerttabellen auf Äquivalenzumformungen innerhalb der Aussagenlogik zurückgeführt werden.

Wittgenstein, der fälschlicherweise als einer der Erfinder der Wahrheitswerttabellen

gilt, hat das Verständnis von Beweisen im Sinne einer Explikation im Rahmen der Logik mit seiner “ab-Notation” realisieren wollen, die anders als Wahrheitswerttabellen

auch auf FOL Anwendung findet. Dies kann an dieser Stelle nur ganz kurz angedeutet

11

werden, wobei es mir im Wesentlichen darauf ankommt, eine Methode bzw. Denkart

zu demonstrieren, wie im Rahmen der New Logic logische Probleme – seien sie auch

so trivial wie das folgende Beispiel – behandelt werden.

Nehmen wir die beiden logisch äquivalenten FOL-Formeln ∀xF x und ¬∃x¬F x.

Im Rahmen der mathematischen Logik hat es keinen klaren Sinn zu fragen, welche

logische Form sie darstellen. Inbesondere macht es keinen Sinn zu fragen, welche

“Möglichkeiten der Wahrheit oder Falschheit” sie darstellen – der Begriff der “Möglichkeit” wird im Rahmen eines extensionalen Ansatzes tunlichst vermieden und allenfalls Philosophen überlassen. Man wird vielmehr die beiden Formeln im Rahmen

eines korrekten und vollständigen FOL-Kalküls auseinander ableiten und semantisch

begründen, dass der Kalkül korrekt und vollständig ist. In Principia Mathematica wird

etwa die Äquivalenz der beiden genannten Formeln axiomatisch eingeführt (vgl. PM

*9.01). Auf Grund der Priorität der Semantik im Rahmen der mathematischen Logik wird die Äquivalenz der Formeln schließlich darauf zurückgeführt, dass es keine

Interpretation gibt, die Modell der einen, aber nicht Modell der anderen Formel ist:

Jeder Satz, der die eine Formal wahr macht, macht auch die andere wahr und umgekehrt. Von Wahrheitsmöglichkeiten (z.B. “logischer Wahrheit” im Sinne “notwendiger

Wahrheit” o. dgl.) und logischer Form wird hier nicht geredet. Einzelne Sätze können bestenfalls in einem abgeleiteten Sinne als “logisch wahr” bezeichnet werden: sie

gehören zu einer Klasse von Sätzen, die auf Grund der Bedeutung der in ihnen enthaltenen logischen Konstanten alle in einem primitiven Sinne wahr sind. Es ist nicht

eine etwaige logische Form, die logische Wahrheit einzelner Sätze definiert. Allenfalls

würde man sagen, dass Formeln selbst logische Formen sind, die interpretiert werden.

In diesem Fall hätten die beiden genannten Formeln unterschiedliche logische Formen.

Der entscheidende Punkt ist, dass die Äquivalenz der beiden Formeln letztlich auf die

Allgemeingültigkeit (“Wahrheit in allen Interpretationen”) von ∀xF x ↔ ¬∃x¬F x

zurückgeführt wird: eine rein syntaktische Rechtfertigung gibt es dafür nicht, da die

gegenseitige Ableitbarkeit semantisch begründet wird.

Eine Skizze des Umgangs mit den beiden Formeln im Rahmen der New Logic sieht

demgegenüber wie folgt aus. Wie in unserer Umgangssprache haben wir es mit zwei

Ausdrücken zu tun, die auf Grund unseres Gebrauchs der Ausdrücke “alle”, “ein” und

“nicht” in vielen Kontexten und in allen, die für FOL relevant sind, austauschbar sind.

In der Umgangssprache und in FOL sind es Schlussregeln, die unseren Ausdrücken die

Eigenschaft der Äquivalenz verleihen. Diese Äquivalenz liegt nicht darin begründet,

dass die beiden Formeln relativ zu allen Interpretation denselben Wahrheitswert haben.

Vielmehr liegt ihre Äquivalenz in der identischen logischen Form der beiden Formeln

begründet. Die in Frage stehende logische Äquivalenz ist eine formale Eigenschaft, die

ganz unabhängig von jedweder Interpretation besteht und durch eine entsprechende

Explikation sinnlich wahrnehmbar zum Ausdruck kommt. Eines Rekurses auf Wahrheitswerte relativ zu Interpretationen bedarf es nicht; es bedarf nur der adäquaten Analyse der logischen Form der beiden Formeln. Diese Analyse macht deutlich, dass es

– gegeben den Gebrauch von “alle”, “ein” und “nicht”, wie er dem Schlussfolgern im

Rahmen von FOL zu Grunde liegt – gar nicht möglich ist, die beiden Formeln so zu

deuten, dass durch die Formeln unterschiedliche Wahrheitsmöglichkeiten ausgedrückt

werden.

Dies gilt es aber nun allererst zu zeigen, denn die logische Form kommt in den

12

FOL-Ausdrücken ebenso wie in der Umgangssprache noch gar nicht eindeutig zum

Ausdruck. Die Identifikation der logischen Form liefert erst der logische Beweis. Dieser besteht im Rahmen der New Logic in einem Konstruktionsprozess in Form der

Übersetzung logischer Formeln in ein ab-Symbol, das logische Formen eindeutig repräsentiert. Hierfür ist ausgehend von logischen Formeln von innen nach aussen wie

folgt vorzugehen: In einem ersten Schritt ist das Prädikat F x zu ersetzen durch einen

Ausdruck, der explizit macht, dass es sich um eine bipolare Struktur handelt. Bipolarität ist das syntaktische Merkmal, das im Rahmen von FOL die Ausdrücke identifiziert, die nicht logisch wahr oder logisch falsch sind. Da logische Wahrheit / Falschheit

im Rahmen von FOL allein von den Junktoren und Quantoren abhängt, sind atomare

Aussagefunktionen im Rahmen von FOL bipolar. “Bipolarität” ist selbst eine formale Eigenschaft, die in einer unmissverständlichen logischen Notation durch syntaktische Merkmale ausgedrückt werden muss. Sie besagt – salopp gesprochen – soviel wie

“die Wahrheit und Falschheit von Ausdrücken dieser Form kann nicht innerhalb des

Systems von FOL entschieden werden”. Die Missverständlichkeit der gewöhnlichen

FOL-Notation wird nirgendwo augenfälliger als in der Tatsache, dass Satzbuchstaben,

P , Q, . . ., in der gewöhnlichen Notation dieselbe äußere Form wie Namenbuchstaben

haben. Dies verleitet aus der Sichtweise der New Logic zum Missverständnis, Sätze

als Namen von Wahrheitswerten misszuverstehen bzw. Satzbuchstaben Wahrheitswerte unterschiedlicher Sätze zuzuordnen. Demgegenüber beschränkt sich New Logic darauf, von bipolaren atomaren Strukturen auszugehen, die in der Anwendung der Logik

als Ausdrücke behandelt werden können, die wahr oder falsch sein können. Um überhaupt einen Ausdruck so verwenden zu können, dass er wahr oder falsch sein kann,

muss dieser selbst eine bipolare syntaktische Struktur haben, auf die in der Anwendung Bezug genommen werden kann, um Möglichkeiten der Wahrheit von denen der

Falschheit unterscheiden zu können.

Um kenntlich zu machen, dass es sich bei der Bipolarität um eine strukturelle Eigenschaft handelt, die keine vorschnelle Interpretation3 erfahren soll und um insbesondere die Pole nicht wiederum als Namen für Wahrheitswerte misszuverstehen, verwendet Wittgenstein die Zeichen “a” und “b” als Kennzeichen von Polen. Folglich ist an

die Stelle von F x der Ausdruck a − F x − b zu verwenden, um zu explizieren, dass in

FOL von bipolaren atomaren Strukturen ausgegangen wird.

Die logischen Junktoren werden in diesem Ansatz als “Anweisungen zur Konstruktion einer logischen Form” rein syntaktisch verstanden: sie sind ab-Operationen.

An Stelle von ¬F x wird b − a − F x − b − a geschrieben. Quantoren werden in

der ab-Notation nicht aufgelöst; sie sind wesentliche, strukturelle Merkmale quantorenlogischer Formen (ähnlich wie ¬, ∧ und ∨ selbst Teil von DNFs sind). Es wird

damit insbesondere keinerlei Annahme darüber gemacht, welche oder auch nur wie

viele Gegenstände es gibt oder geben könnte. Der Bezug auf Mengen und eine etwaige Interpretation von Formeln als Aussagen über Mengen gehört zur Anwendung der

Logik und setzt allererst die Bestimmung einer logischen Form voraus. Nur Letzteres

gehört in die Logik. Um der internen Beziehung der Quantoren syntaktisch Ausdruck

zu verleihen, wird im Rahmen des Konstruktionsprozesses eines idealen Symbols ∃

3 Vorschnell ist eine Interpretation, wenn sie sich nicht auf das ab-Symbol – das Resultat eines logischen

Beweises gemäß New Logic – bezieht, sondern bereits Ausdrücke zu Beginn (logische Formeln) oder innerhalb des Konstruktionsprozesses des ab-Symbols (ab-Zeichen) interpretiert.

13

dem b-Pol zugeordnet, wenn ∀ dem a-Pol zugeordnet wird u.u., wobei der Quantor,

der in der Ausgangsformel enthalten ist, dem a-Pol zugeordnet und mit einem äußeren

a-Pol versehen wird, der selbst wieder Ausgangspunkt weiterer ab-Operationen sein

kann (der andere Quantor wird entsprechend mit einem äußeren b-Pol versehen und

dem b-Pol zugeordnet). Dies bildet ab, dass einen allquantifizierten Satz zu negieren,

bedeutet, einen existenzquantifierten zu behaupten u.u. Mit dem Merkmal der Bipolarität wird dieser internen Beziehung der Quantoren zwangsläufig ein syntaktischer

Ausdruck verliehen. Dies ist auch insofern nicht willkürlich als die ganze Prozedur der

Übersetzung in “ideale logische Symbole” letztlich dadurch geleitet ist, dem vorausgesetzten Verständnis der logischen Äquivalenz einen formalen Ausdruck zu verleihen.

Diese Prozedur ist schließlich als Resultat eines allgemeinen Algorithmus für beliebige FOL-Ausdrücke zu formulieren, wobei die einzelnen Schritte auf einem Verständnis darauf beruhen, was die einzelnen Teilausdrücke zur Identifikation einer logischen

Form beitragen.

Kurzum, ∀xF x ist in a − ∀x − a − F x − b − ∃x − b zu übersetzen und ¬∃x¬F x

in a − b − ∀x − b − a − F x − b − a − ∃x − a − b. Am Ende des Konstruktionsprozesses eindeutiger Repräsentanten logischer Formen ist man damit noch nicht. Es ist nun

noch zu bestimmen, welche Merkmale der so gewonnenen ab-Zeichen in Wittgensteins

Terminologie “symbolisieren”, d.h. Merkmale sind, die die logische Form identifizieren und auf die bei einer etwaigen Interpretation Bezug zu nehmen ist. Hierbei gilt

die Regel, dass stets nur die äußersten und die innersten a- bzw. b−Pole die logische

Form festlegen (= Transitivitätsregel, von Wittgenstein explizit angegeben). Eine weitere Regel ist, dass nicht die Zeichengestalt von Variablen symbolisiert, sondern nur

der Bezug eines Quantors zu den Argumentstellen, an denen die von ihm gebundene Variable vorkommt. Letzteres ergibt sich z.B. aus der Äquivalenz von ∃xF x und

∃yF y. Auf Grund der ersten Regel werden a- und b-Pole, die zwischen den äußersten

und innersten Polen vorkommen, gestrichen. Auf Grund der zweiten Regeln werden

Variablen durch Zahlen ersetzt. Man erhält als Resultat des Umformungsprozesses für

beide Ausgangsformeln:

a − ∀ 1 − a − F1 − b − ∃ 1 − b

Das ab-Symbol – das “ideale Symbol”, das das Resultat des Konstruktionsprozesses

bildet – wird in Form von Polgruppen angegeben. Polgruppen erhält man, indem alle

Pfade von äußersten zu innersten Polen einzeln aufgeführt werden. In unserem Beispiel

ist dies trivial. Man erhält als ab-Symbol:

a − {∀1 − a − F1 };

b − {∃1 − b − F1 }.

Dieser Ausdruck stellt die logische Form der beiden Ausgangsformeln dar, er ist der

Repräsentant aller mit ∀xF x äquivalenten Formeln. Die a-Polgruppen sind isomorph

zu einer DNF, die mit der Ausgangsformel logisch äquivalent ist; die b-Polgruppen sind

isomorph mit einer DNF, die mit der Negation der Ausgangsformel logisch äquivalent

ist.

Wenn irgendwo, dann kann frühestens am ab-Symbol eine “Interpretation” ansetzen. Wobei “Interpretation” im Rahmen der New Logic nichts mit einer etwaigen Zuordnung von Extensionen zu Ausdrücken zu tun hat. Vielmehr meint “Interpretation”

14

hier selbst wieder ein mechanisches Verfahren der Paraphrase von ab-Symbolen mittels

einer standardisierten Umgangssprache. Im Beispielfall erhält man folgende Interpretation:

• Eine Instanz der logischen Formeln ∀xF x bzw. ¬∃x¬F x ist wahr gdw.

– die Instanz der einstelligen Aussagefunktion F x für alle Gegenstände wahr

ist.

• Eine Instanz der logischen Formeln ∀xF x bzw. ¬∃x¬F x ist falsch gdw.

– die Instanz der einstelligen Aussagenfunktion F x für mindestens einen Gegenstand falsch ist.

Überflüssig zu erwähnen, dass hierdurch nicht beansprucht wird (und nicht beansprucht

werden kann), “alle” bzw. “ein” zu definieren oder zu explizieren.4 Die Quantoren sind

wesentlicher Bestandteil der ab-Symbole bzw. der quantorenlogischen Formen und in

diesem Sinne primitiv. Es geht einzig und allein um die Explikation einer logischen

Form, die allein durch strukturelle Merkmale – Beziehungen zwischen Symbolen –

eindeutig identifiziert werden soll. Gemäß der angegebenen “Interpretation” stellen abSymbole – d.i. die Repräsentanten der Klasse logisch äquivalenter Formeln – Möglichkeiten der Wahrheit und Falschheit von Sätzen dar, die die Ausgangsformeln instanziieren. In dieser Hinsicht gleicht dieser Ansatz dem einer Wahrheitsbedingungssemantik

(“representational view” in Etchemendys Worten), der von Etchemendy von der extensionalen Semantik der mathematischen Logik (“interpretational view” in Etchemendys

Worten) unterschieden wird. Den Unterschied dieser Ansätze kann man sich u.a. daran

vor Augen führen, dass im Rahmen der representational semantics Möglichkeiten der

Wahrheit und Falschheit derselben Instanz expliziert werden, während im Rahmen des

interpretational views von unterschiedlichen wahren und falschen Instanzen ausgegangen wird, die in verschiedenen Interpretationen repräsentiert werden.

Im Unterschied zu einer Semantik im Sinne des representational view wird eine Interpretation im Rahmen von New Logic jedoch ausschließlich auf syntaktische (strukturelle) Eigenschaften idealer Symbole (im Falle von FOL: ab-Symbole) zurückgeführt.

Die algorithmisch erzeugten ab-Symbole stellen allererst Kriterien für die Definition

eines (logischen) Raumes an Möglichkeiten bereit. Grundlage jeder Art von “Interpretation” muss nach dem Ansatz der New Logic die algorithmische Definition von

Möglichkeitsräumen sein, innerhalb derer überhaupt nur sinnvolle Aussagen getroffen

werden können. Die Definitionen von Möglichkeitsräumen beruhen auf der Analyse

(d.i. der syntaktischen Explikation) der jeweiligen Konstanten des Ausgangsformalismus. Im Falle von FOL sind es die Junktoren und Quantoren, die einen logischen Raum

definieren. Der logische Raum schränkt die Ausdruckskraft bereits in hohem Maße

ein. Keineswegs können alle die Aussagen, die gemäß der Grammatik der deutschen

4 Ein etwaige Definition gelingt auch in der Modelltheorie nicht, da die hier angegebenen modelltheoretischen Definitionen quantifizierter Ausdrücke “ein” bzw. “alle” enthalten. Analoges gilt für die Junktoren

in der Modelltheorie. In New Logic werden zwar Junktoren über ab-Operationen definiert, aber dies betrifft

nur den Konstruktionsprozess eines ab-Symbols. Bei der Paraphrase von ab-Symbolen können “und” und

“oder” verwendet werden. Auch hier wird kein Anspruch auf eine Definition erhoben. Die Paraphrase in

Form von Disjunktionen von Konjunktionen ist primitiv, wenn alle strukturellen Merkmale “symbolisieren”.

15

Sprache “wahr” oder “falsch” genannt werden können, in diesem Raum angemessen

abgebildet werden, denn der logische Raum setzt die Bipolarität der atomaren Aussagenfunktionen sowie deren logische Unabhängigkeit voraus. Hiermit scheidet z.B. die

“Identitätsfunktion” als Instanz von F xy aus, insofern man davon ausgeht, dass “a =

a” ein Theorem bzw. die Form von Sätzen ist, die “bedingungslos wahr” wahr sind.

Eine Rekonstruktion mathematischer Gleichungen mit den Mitteln von FOL scheidet

schon aus diesem Grunde aus. Will man den mannigfachen Schlussbeziehungen, die

zwischen Sätzen bestehen, gerecht werden, bedarf es mehr als der Analyse der so genannten “logischen Konstanten”. Es bedarf der syntaktischen Analyse etwa der mathematischen Symbole oder des Identitätszeichen und vielem anderen mehr. Die Analyse

von FOL gemäß New Logic führt vor Augen, dass eine wohlverstandene Logik nur

als ein Vergleichsobjekt für die Analyse umgangssprachlicher Sätze verwendet werden

kann, da nur gewisse Teilaspekte – nämlich die Logik logischer Konstanten – berücksichtigt werden.

“Explikation der Form der Sätze” in diesem Sinne ist ein umfassendes philosophischen Unternehmen, dem mit den begrenzten Mitteln von FOL nicht beizukommen

ist. Der Beitrag, den eine Analyse von FOL zur Definition von Möglichkeitsräumen

liefern kann, ist nur ein bescheidener. Die Sprache der Logik ist alles andere als eine

Universalsprache. “Logische Analyse” im traditionellen Sinne der Repräsentation umgangssprachlicher Sätze in der Sprache der Logik und damit ohne vorherige Klärung

der logischen Form befreit den Verstand nicht von den Verhexungen durch die Mittel der Sprache, sondern ist ihnen erlegen. Zur Analyse umgangsprachlicher Sätze im

Sinne der Explikation ihrer Form, die ihr den adäquaten Platz innerhalb eines syntaktisch definierten Raumes an Möglichkeiten zuweist, gehört im Allgemeinen sehr viel

mehr als logische Analyse. Eine adäquate Sprachanalyse sollte den mannigfachen Einschränkungen dessen, was wir auf Grund unserer mannigfachen Verwendung mannigfacher sprachlicher Ausdrücke überhaupt nur für möglich erachten, Rechnung tragen

und nicht trachten, dies auf einige wenige Ausdrücke (“logische Konstante”) zu reduzieren. Was wir für möglich erachten, ist eine Funktion unseres Sprachgebrauchs und

der syntaktischen Analyse bzw. philosophischen Explikation obliegt es, dies explizit

zu machen.

Das oben angegebene Beispiel der Explikation der logischen Form der beiden genannten logischen Formeln ist äußerst einfach. An dieser Stelle kann nur an einem

trivialen Beispiel demonstriert werden, welche Art von “logischer Explikation” in der

New Logic angestrebt wird. Die alles entscheidende Frage ist, ob sich diese Form der

Explikation für FOL vollständig ausarbeiten lässt in Form eines allgemeinen Algorithmus, der alle Formeln einer Klasse logisch äquivalenter FOL-Formeln genau einem ab-Symbol zuordnet, das sich direkt als Ausdruck einer logischen Form verstehen

lässt. Man denke an komplexe Formeln der zweistelligen Quantorenlogik, die etwa im

Rahmen der klassischen Semantik nur “wahre Modelle im Unendlichen” haben, um

sich eine Vorstellung von der Explikationskraft so eines Algorithmus zu machen: Ein

derartiger Algorithmus wird in endlichen Schritten auf Basis der Konstruktion eines

ab-Symbols entscheiden, dass die entsprechende Ausgangsformel nicht logisch falsch

ist (dies leistet FOL-Decider) und er wird zudem auf Basis der syntaktischen Merkmale

des ab-Symbols Strukturen von Modellen identifizieren, die Bedingungen der Wahrheit

explizieren können (hierauf beruht FOL-ModelCheck).

16

Explikation und Interpretation, Teil 2. Die mathematische Logik strebt auf Grund

ihres extensionalen Ansatzes keine Explikation an. Ihr geht es allein darum, Sätze in

der Sprache der Logik zu repräsentieren (s. zum Begriff der Repräsentation S. 8). Dies

geschieht wesentlich über Interpretation im Sinne der Zuordnung von Extensionen zu

den Ausdrücken einer formalen Sprache (in diesem Sinne soll “Interpretation” ab jetzt

wieder verstanden werden). Hierzu müssen die Extensionen sprachlicher Ausdrücke

nicht notwendigerweise bekannt sein, es muss allerdings auf irgendeine Weise auf Extensionen Bezug genommen werden und dies geschieht letzten Endes mittels der Wortsprache. Folgende Interpretation ist z.B. durchaus zulässig:

=(P ) = W gdw. Goldbachs Vermutung wahr ist.

Wir wissen nicht, ob Goldbachs Vermutung wahr ist, wir wissen also auch nicht, ob

diese Interpretation P den Wahrheitswert W oder F zuordnet. Aber einen der beiden

Wahrheitswerte – das sei hier vorausgesetzt – hat Goldbachs Vermutung und folglich

ordnet die Interpretation auch einen der beiden Wahrheitswerte zu, ob wir diesen nun

kennen oder nicht. Im Unterschied zu der auf S. 8 genannten Repräsentation von Goldbachs Vermutung ist die hier angegebene Interpretation nicht besonders interessant, da

sie Goldbachs Vermutung nicht auf einen formalen Ausdruck zurückführt, in dem nur

Konstanten der gewählten formalen Sprache vorkommen. Nur in diesem Falle könnte man hoffen, die formale Repräsentation des Satzes in dem gewählten axiomatischen

System abzuleiten. Hierdurch hätte man sie dann als wahr bewiesen, insofern die Axiome wahr sind. Dies gelingt allerdings auch im Falle der auf S. 8 angegebenen formalen

Repräsentation von Goldbachs Vermutung nicht – nicht jeder formal repräsentierbare Ausdruck bzw. seine Negation muss beweisbar sein. Goldbachs Vermutung konnte

bislang nicht als Theorem der Peano Arithmetik nachgewiesen werden.

Es ist wichtig, sich vor Augen zu führen, dass auch die Auffassung primitiv rekursiver Funktionen, durch die im Rahmen der mathematischen Logik der Begriff der

Berechenbarkeit modelliert werden soll, durch und durch auf dem extensionalen Verständnis von Funktionen aufbaut. Dies erlaubt etwa folgende, primitiv rekursive und

folglich (berechenbare!) Definitionen (vgl. Smith(2007), S. 88):

n gdw. Fermats Vermutung wahr ist.

fermat(n) =

0 sonst.

julius(n)

=

n gdw. Caesar an seinem dritten Geburtstag Trauben aß.

0 sonst.

Im ersten Fall “wissen” wir seit Wiles Beweis von 1995, dass f ermat(n) = n

ist, im zweiten Fall kennen wir den Wert von julius(n) nicht, aber er ist n oder 0

und folglich ist julius(n) entweder die Identitäts- oder die Nullfunktion und damit per

definitionem primitiv rekursiv, auch wenn wir keine Möglichkeit haben, den richtigen

Wert zu berechnen.

Man nehme sich ein beliebiges Lehrbuch der mathematischen Logik und wird

schnell erkennen, dass nahezu alle Beweise auf “Definitionen” (besser Interpretatio-

17

nen) von Funktionen der Form

f (x) = y gdw. . . .

zurückgehen, wobei die Leerstelle “. . .” umgangssprachliche Ausdrücke enthalten

darf und f die Interpretationsfunktion selbst sein kann. Das “gdw.” ist ein extensionales: es wird Extensionsgleichheit behauptet, aber keineswegs innerhalb des Formalismus, auf den auf der linken Seite Bezug genommen wird, irgendeine Form von Äquivalenz nachgewiesen. Es ist das Dirichiletsche Verständnis von Funktionen, das erlaubt,

derartige Interpretationen in die mathematische Logik einzuführen.

Diese Technik der Repräsentation hat gar nichts mit Explikation zu tun, denn sie

beruht auf extensionaler “Äquivalenz” (Gleichheit von Wahrheitswerten) und nicht auf

der Substitution von Ausdrücken innerhalb eines formalen Systems mit dem Ziel der

Generierung syntaktischer Identifikationskriterien. Es ist diese Technik und die mit ihr

verbundenen “prosaischen Definitionen”, die New Logic ablehnt. Erstens geben derartige Definitionen den Funktionen keinen mathematischen oder logischen Gehalt noch

explizieren sie die umgangssprachlichen Ausdrücke. Sie sind so klar bzw. unklar wie

die umgangssprachlichen Ausdrücke, die in ihnen verwendet werden. Es wird wesentlich über die Manipulation formaler Ausdrücke hinausgegangen und damit das Gebiet

des Berechenbaren, das syntaktischer Kriterien unterliegt, verlassen. Gemäß des Standpunktes der New Logic bleiben die formalen wie die umgangssprachlichen Ausdrücke

gleichermaßen explikationsbedürftig. Sie haben eben den mathematischen oder logischen Gehalt, den eine algorithmische Explikation ihnen geben kann; werden sie nicht

algorithmisch expliziert, dann haben sie noch keinen wohldefinierten logischen oder

mathematischen Gehalt. Auf eine etwaige Funktion der Wortsprache, auf Extensionen

zu referieren, will man sich im Rahmen der New Logic erstens nicht verlassen und

zweitens spielt eine derartige Funktion in dieser Konzeption keine Rolle in der Logik

und Mathematik. Von größerer Bedeutung ist aber der zweite Grund der Ablehnung:

Solange die Form der Ausdrücke nicht expliziert ist, ist man nicht vor Fehlinterpretation gefeit, die durch die äußere Form der Ausdrücke evoziert werden. New Logic

sieht die Hauptquelle philosophischer Probleme in der vorschnellen Interpretationen

von Ausdrücken, deren Form noch gar nicht adäquat expliziert wurde. Aus dem Blickwinkel der New Logic ist diese Quelle in der der mathematischen Logik heftig am

Sprudeln. Dies sei kurz in den folgenden Paragraphen angedeutet.

Paradoxien und Diagonalisierung. Im Rahmen der mathematischen Logik werden

Paradoxien auf Widersprüche zurückgeführt. Folglich können sie Beweiskraft haben,

denn man wird in den meisten Fällen genötigt, eine Annahme aufzugeben. Man kann

viele Paradoxien und Beweise, die auf Diagonalisierungen beruhen, auf Interpretationen der folgenden Formel zurückführen (vgl. Thomson(1962), Redecker(2006), S.105

nennt weitere Vertreter, die sich dieser Analyse angeschlossen haben):

∃y∀x(F xy ↔ ¬F xx)

(1)

Der Barbier ergibt sich für =(F ) = {x|x wird rasiert von y}. Russells Paradox

ergibt sich für =(F ) = {x|x ist Element von y}. Cantors Theorem setzt =(F ) =

18

{x|x ist Element einer Menge mit der Zahl y} voraus.

Aus dem Barbier-Paradox wird die Schlussfolgerung gezogen, dass es kein Barbier

gebe, der alle die rasiert, die sich selbst nicht rasieren. Diese Schlussfolgerung ist für

Logik, Mengenlehre oder Mathematik nicht weiter von Bedeutung. Anders ist dies im

Falle von Beweisführungen im Rahmen der mathematischen Logik. Russells Paradox

ist eine Instanz des “unrestricted comprehension axiom schema” (UCAS) der “naiven”

Mengenlehre:

∃y∀x(xy ↔ ϕx)

Setzt man für ϕx entsprechend ¬xx ein, ergibt sich Russells Paradox in Form einer

widersprüchlichen logischen Formel. Hieraus zieht man die Konsequenz, dass (UCAS)

und hiermit die “naive” Mengenlehre falsch ist. Dies hat enorme Konsequenzen. Begriffe und Mengen müssen nicht mehr einander korreliert sein. Ein extensionales Verständnis von Mengen scheint nun sogar logisch zwingend. Man gibt das dichotomische

Konzept von Mengen zu Gunsten der kumulativen Hierarchie von Mengen auf. Man

führt die Typentheorie ein oder entwickelt neue axiomatische Systeme der Mengenlehre (ZF), um dem kumulativen Konzept Rechnung zu tragen. Ähnlich zieht Cantor

auf Basis von Diagonalisierungen die Schlussfolgerung, dass es überabzählbare Mengen gibt. Dies ist im Rahmen der mathematischen Logik ein Theorem und bildet die

Grundlage für die transfinite Mengenlehre.

Widerspruchsbeweise auf Basis von Diagonalisierung ist die Methode metamathematischer Beweisführungen, auf die sich zahlreiche Theoreme, z.B. Tarkis Theorem, Gödels Theoreme, die Unlösbarkeit des Halte-Problems (die Churchs Theorem

zu Grunde liegt) u.v.a.m. zurückführen lassen. An dieser Stelle kann nur exemplarisch

an den obigen Beispielen aufgezeigt werden, warum im Rahmen der New Logic solche

Beweise keine Beweiskraft haben.

Gemäß New Logic ist zunächst die logische Form von (1) zu klären. Übersetzung

in ein ab-Symbol führt zu einem ab-Symbol, das keine a-Pole besitzt. Dies besagt gemäß der Deutung von ab-Symbolen, dass die logische Form von Instanzen von (1),

die diesen Instanzen durch die “logischen Konstanten” verliehen wird, eine sinnvolle Interpretation ausschließt. Instanzen einer derartigen logischen Form sind logisch

falsch; ihnen kann kein Gehalt gegeben werden, der an etwas außerhalb der Symbole

zu messen wäre. Dies bringt die Tatsache zum Ausdruck, dass ihr unmissverständlicher Ausdruck in der ab-Notation in Form eines ab-Symbols nicht mehr das Merkmal

der Bipolarität besitzt. Jede Instanz einer derartigen Form ist im strengen logischen

Sinn äquivalent und besagt dasselbe (nämlich nichts). Der Barbier, Russells Paradox,

Cantors Theorem in den genannten Lesarten sagen damit alle gleich viel bzw. gleich

wenig wie der Satz “Es regnet und es regnet nicht”. Sie alle haben dieselbe Form, auf

Grund der sie bereits logisch falsch sind; – etwaige Interpretationen können derartigen

logischen Formen keinen Sinn verleihen. Es ist unsinnig, Kontradiktionen zu interpretieren und hieraus Schlüsse auf die Existenz oder Nicht-Existenz etwaiger Entitäten zu

ziehen.

Man kann aus einer Kontradiktion keine substantiellen Schlussfolgerungen in Form

eines Widerspruchsbeweises gewinnen, denn die Negation einer Kontradiktion führt zu

einer Tautologie, die ebenso nichtssagend ist. Es ist die äußere Form von (1) die sug-

19

geriert, dass man es mit substantiellen Existenzbehauptungen zu tun hat, deren Negation dann die Existenz von etwas leugnet: Interpretiert man Ausdrücke wie (1) ohne

sie vorab logisch zu explizieren, dann wird der grundlegende Unterschied zu negierten

Existenzbehauptungen, die nicht tautologisch sind, nicht hinreichend offensichtlich. Ist

man darüber hinaus auch noch der Auffassung, dass Einsetzungsinstanzen von Kontradiktionen einfachhin “falsch” sind (bzw. ihre Extension der Wahrheitswert F ), gelangt

man zur Auffassung, dass man durch ihre Bildung sogar logisch zwingend zu substantiellen Einsichten gelangen kann. Infolgedessen ist man der Ansicht, es drücke eine

substantielle Erkenntnis aus, dass es keine Barbiere gebe, die alle die rasieren, die sich

selbst nicht rasieren, bzw. keine Menge aller normalen Mengen gebe bzw. dass die Diagonalmenge nicht Element einer Aufzählung von Teilmengen ist. In jedem dieser Fälle

erscheint es aus dem Blickwinkel der New Logic demgegenüber als ein unsinniges Unternehmen, Kontradiktionen oder Tautologien zu interpretieren und damit irgendetwas

Gehaltvolles zum Ausdruck bringen zu wollen.

Für die Analyse von Paradoxien kann man noch einen wichtigen Schritt weiter

gehen. Der Barbier ist gemäß New Logic gar kein Paradox, sondern einfach ein logischer Widerspruch. Anders verhält es sich bei Russells Paradox und den metamathematischen Theoremen. Hier wird man bereits ihre Darstellung mittels der Sprache

der Logik in Frage stellen. Der Unterschied zwischen dem Barbier und Russells Paradox besteht darin, dass “x wird rasiert von y” gewöhnlicherweise als bipolare, atomare

Aussagefunktion verwendet wird. “x ist Element von y” hingegen kann nicht einfachhin als bipolare atomare Aussagefunktion verstanden werden, da “x ist Element von x”

im Allgemeinen noch kein klarer Sinn gegeben ist, da nicht klar ist, was z.B. genau der

Fall sein soll, wenn eine Menge von Pferden ein Pferd wäre. Auch in diesem Falle erliegt man Fehlinterpretationen suggeriert durch die äußere Form der Wortsprache und

von FOL-Ausdrücken: “x ist Element von y” hat dieselbe äußere, relationale Form wie

“x wird rasiert von y” und “ϕ(x, y)” legt – anders als etwas “a − ϕxy − b” – Einsetzungsinstanzen nicht auf bipolare Aussagefunktionen fest. Der Fehler der Analyse von

Russells Paradox in Form der Widerlegung von (UCAS) steckt schon in der vorschnellen logischen Formulierung von (UCAS). Die logische Formalisierung von (UCAS) ist

ein indäquater formaler Ausdruck der akzeptablen “naiven” dichotomen Mengenauffassung, nach der Mengen durch bipolare Aussagefunktionen identifiziert werden. Der

adäquate formale Ausdruck für diesen internen Zusammenhang zwischen Mengen und

bipolaren Aussagefunktionen ist der, “x ist Element von y” und auch “x ist eine Menge”

nicht eigens als Aussagefunktionen mit den Mitteln der logischen Sprache abzubilden.

Dies zeigt, das – zumindest im Rahmen der “naiven Mengenlehre” – Ausdrücken wie

“die Mengen aller Mengen” oder “die Menge aller normalen Menge” keine Bedeutung

gegeben werden kann. Der Raum der Möglichkeiten, den eine naive Mengenlehre absteckt, bietet hierfür keinen Platz. Nicht die naive Mengenlehre erzeugt Paradoxien,

sondern das Missverständnis ihrer logischen Repräsentation innerhalb der mathematischen Logik erzeugt die Paradoxien. Es ist hier und nicht an der Mengenlehre, wo

anzusetzen ist, um die mengentheoretischen Paradoxien aufzulösen.

Der entscheidende Punkt ist einmal mehr, die “Denkbewegung” nachzuvollziehen,

die dazu führt, dass eine bestimmte Form von Widerspruchsbeweisen ihre Beweiskraft

verliert. Es ist eine Sache der Gewöhnung, um an anderen Beispielen zu gleichartigen

Einschätzungen zu gelangen: Statt scheinbar substantielle Existenzbehauptungen wie

20

“Es gibt überabzählbare Mengen”, “Es gibt keine Turing-Maschine, die für jede beliebige Turing-Maschine berechnet, ob sie hält oder nicht”, “Es gibt kein Prädikat 1.

Stufe, dessen Extension die Menge aller wahren Sätze ist”, “Es gibt keine primitivrekursive Funktion, die im Kalkül primitiv-rekursiver Funktionen der Gödelzahl einer

Formel 0 zuordnet gdw. die entsprechenden Formel ableitbar ist” etc. zu behaupten,

wird man jeweils die Möglichkeit der Interpretation einer entsprechenden Funktion

zurückweisen und sich damit begnügen, dass den entsprechenden “Theoremen” gar

kein klarer Sinn verliehen werden kann. Statt auf Basis von Interpretationen der Form

“f (x) = y gdw. . . .” Theoreme abzuleiten, werden diese Interpretationen zurückgewiesen, wobei jeweils abgelehnt wird, dass sich der fragliche Gehalt von “. . .” durch

die Syntax, auf die im linken Teil des Bikonditionals Bezug genommen wird, bringen

lässt. Die Theoreme werden damit nicht etwa geleugnet bzw. ihr Gegenteil behauptet,

sondern es wird darauf beharrt, dass ihnen kein klarer Sinn verliehen worden ist, da

ein etwaiger Sinn nicht in der Syntax der ausgewählten Ausdrucksweise ausgedrückt

werden kann. In gewisser Weise verschärft man sogar die negativen Existenzbehauptungen: Das, dessen Existenz in den Theoremen geleugnet werden soll, lässt sich noch

nicht einmal sinnvoll annehmen.

Dies ist alles andere als eine facon de parler. Man hat z.B. nicht mehr die Neigung, transfinite Mengenlehre oder Metamathematik zu betreiben. Der Grund dafür

ist, dass man die Widerspruchsbeweise nicht als Beweis der Falschheit einer gehaltvollen Voraussetzung auffasst, deren Negation nun zu neuen gehaltvollen Theoremen

führt. Vielmehr versteht man die Widerspruchsbeweise als Ausdruck der Inadäquatheit

einer unterstellten Syntax und die Konsequenz, die zu ziehen ist, besteht allenfalls in

der Bestimmung einer adäquaten Syntax. Dies sei kurz anhand von Tarskis Theorem

erläutert.

Tarskis Theorem. Tarskis Theorem besagt, dass die Menge aller wahren Sätze einer

Sprache nicht durch ein Wahrheitsprädikat innerhalb derselben Sprache repräsentiert

werden kann. Dies wird im Rahmen einer formalen Sprache bewiesen, die gegenüber

FOL um ein Symbol für die Diagonalfunktion und ein Standardnamensymbol angereichert wird (vgl. Brendel(1992)). Diese Symbole erhalten fixe Interpretationen, unter

deren Voraussetzung sich Diagonalisierungen repräsentieren lassen. Interpretation eines Prädikates als Wahrheitsprädikat führt dann zu Widersprüchen, z.B. ließe sich in

dieser Sprache das Lügnerparadox repräsentieren. Tarski zieht hieraus den Schluss, “x

ist wahr” als ein metasprachliches Prädikat zu verstehen.

Sieht man einmal von der vorbehaltlosen Interpretation einer Funktion im Sinne

einer Diagonalfunktion ab, dann wird New Logic anders als Tarski in der unhinterfragten Voraussetzung, “x ist wahr” als Prädikat (= propositionale Funktion, deren Werte

Wahrheitswerte sind) zu behandeln, die Wurzel des Problems sehen. Nicht die äußere Form, sondern der tatsächliche Gebrauch ist Kriterium für eine adäquate syntaktische Analyse. Ähnlich wie im Fall von (UCAS) wird man in Tarskis Schema einen

inadäquaten formalen Ausdruck einer ganz angemessen Auffassung sehen, nämlich der

Auffassung, dass “ist wahr” im Allgemeinen so verwendet wird, dass es dem Sinn eines

Satzes nichts hinzufügt. Man wird in Folge dessen ablehnen, “x ist wahr” syntaktisch

als ein Prädikat der Form ϕx – welcher Stufe auch immer – aufzufassen. Um die Form

21

einer “syntaktischen Lösung” zu veranschaulichen, bietet sich alternativ auf Basis der

ab-Notation folgende Analyse an. “x ist wahr” ist nicht Ausdruck einer “Aussagefunktion”, sondern Ausdruck einer (Redundanz)operation, der in der ab-Notation durch eine

redundante ab-Operation Ausdruck verliehen werden kann: Während P durch a−P −b

dargestellt wird, kann “P ist wahr” durch a − a − P − b − b dargestellt werden, was

schließlich ebenfalls zum ab-Symbol a − P − b führt. “P ist nicht wahr” ist dementsprechend durch b − a − a − P − b − b − a darzustellen, was nach Streichung der

Zwischenpole zu b − a − P − b − a führt (also dem ab-Symbol, dem auch ¬P zugeordnet wird). Überflüssig zu erwähnen, dass in dieser Syntax “Dieser Satz ist falsch”

nicht ausgedrückt werden kann, da die Anwendung von ab-Operationen bipolare, atomare Aussagefunktionen voraussetzt und “x ist falsch” nach diesem Verständnis nicht

als bipolare Aussagefunktion, sondern als ab-Operation (bzw. “Wahrheitsoperation”)

verwendet wird. Es ist die äußere Form des umgangssprachlichen Ausdruckes “x ist

wahr”, der äußerlich dieselbe Form hat wie “x ist ein Mensch”, die einem zum Narren

hält. Nicht diese äußere Form, sondern der tatsächliche Gebrauch der Ausdrücke ist die

Richtschnur für ihre Explikation, die im erfolgreichen Fall unsinnige Interpretationen

ausschließt.

Sobald man “Unmöglichkeitsbeweise” als Ausdruck dessen versteht, dass man Ausdrücken eine bestimmte Interpretation verleihen will, die durch die Form der Ausdrücke ausgeschlossen ist, wird man sich nicht mehr im Reich des Unmöglichen tummeln wollen und dabei etwaige Hierarchien von Mengen oder Sprachen ersinnen, sondern man wird sich auf die Explikation der Formen und der Möglichkeiten ihrer Interpretation besinnen und beschränken.

Unentscheidbarkeitsbeweis von FOL. Vgl. zu diesem Abschnitt auch:

http://www2.hu-berlin.de/NewLogic/webMathematica/Logic/critique.pdf.

Der Unentscheidbarkeitsbeweis für FOL lässt sich so führen: Es wird gemäß eines effektiven Verfahrens festgelegt, wie Turing-Maschinen samt ihrem input in FOLAusdrücke Γ übersetzt werden, die die jeweilige TM-Machine und ihren input gemäß

Interpretation repräsentieren. Des Weiteren wird gezeigt, wie der Satz “Die TuringMaschine TM hält auf input n” (kurz “TM hält”) effektiv in eine FOL-Formel übersetzt werden kann, die den entsprechenden Satz gemäß Interpretation repräsentiert.

Dann wird “bewiesen”, dass gilt:

` (Γ → D) gdw. TM hält

(2)

Wenn ` (Γ → D) entschieden werden kann, wird damit entschieden, ob TM auf den

gegebenen input hält oder nicht. Es ist aber schon gezeigt worden, dass das HalteProblem nicht entschieden werden kann. Also kann FOL nicht entscheidbar sein.

Da New Logic nicht behauptet, dass das Halte-Problem lösbar ist, fragt sich, wie

man aus dieser Sichtweise zu diesem Unentscheidbarkeitsbeweis stehen soll: Hat nicht

zumindest dieser Beweis Beweiskraft nicht nur innerhalb des Systems der mathematischen Logik?

22

Man erkennt schon an der Form von (2), dass auch diese Frage verneint werden

muss. Wir haben es mit einer typischen extensionalen Korrelation eines umgangssprachlichen Ausdrucks mit einer – gemäß Verständnis von New Logic – Eigenschaft

der logischen Form einer Formel zu tun. Um vor Augen zu führen, dass hierbei etwas

nach Auffassung der New Logic nicht stimmt, beschränken wir uns auf den “Beweis”

der einen Richtung des Bikonditionals, wie er z.B. von Boolos(2003), S. 130 gegeben

wird:

The ‘only if’ part is easy. All sentences in Γ are true in the standard

interpretation, whereas D is true only if the given machine started with

the given input eventually halts. If the machine does not halt, we have an

interpretation where all sentences in Γ are true and D isn’t, so Γ does not

imply D.

Die Argumentation kann man sich durch eine Zeile einer Wahrheitswerttabelle veranschaulichen, wobei die Indices den Argumentationsschritt andeuten:

`

F3

(Γ

W1

→

F2

D)

F1

→

W4

TM hält

F1

Schritt 1: Dieser Schritt beruht auf =(Γ) = W und =(D) = Wahrheitswert von “TM

hält” = F. =(Γ) = W ergibt sich daraus, dass von einer Turing-Maschine mit einem input n und einer ganz bestimmten, effektiv angebbaren Abfolge an Befehlen ausgegangen wird, die nach einem effektiven Verfahren in eine FOL-Formel

Γ übersetzt werden, wobei die einzelnen Bestandteile der Übersetzung gemäß

einer festgelegten Standard-Interpretation Extensionen zugeordnet werden, und

zwar so, dass in dieser Interpretation dann Γ wahr ist. “=(D) = Wahrheitswert

von ‘TM hält”’ ist auch Teil dieses effektiven Übersetzungsverfahrens samt Angabe einer Standard-Interpretation. Der Wahrheitswert kann in diesem Fall allerdings nicht vorausgesetzt werden. Der Beweis von (2) spielt einfach beide Fälle

=(D) = F und =(D) = W durch. Oben zitierter “Beweis” betrachtet nur den

ersten Fall.

Schritt 2: F2 ergibt sich durch Anwendung der modelltheoretischen Definition von

“→”.

Schritt 3: Durch Anwendung der modelltheoretischen Definition der Allgemeingültigkeit und auf Grund der Vollständigkeit von FOL ergibt sich 6` (Γ → D).

Schritt 4: W4 ergibt sich wieder in Folge der Anwendung der modelltheoretischen

Definition von “→”. Mit Schritt 4 ist man am Beweisziel angelangt: Die Implikation konnte unter den genannten Voraussetzungen als wahr erwiesen werden.

Innerhalb des Systems der mathematischen Logik kann gegen so eine Art des “Beweises” nichts eingewandt werden. Aus der Perspektive der New Logic ist allerdings

eine derartige Argumentationsweise inakzeptabel. Man lehnt es ab, die Tatsache, dass

23

gemäß der Grammatik der deutschen Sprache die Ausdrücke “wahr” bzw. “falsch” zulässiger Weise ohne weitere Differenzierung Sätzen wie “Γ impliziert D” bzw. “TM

hält” zugeschrieben werden, auch schon als hinreichendes Kriterium dafür zu werten,

dies dann auch im Rahmen einer (vorschnellen) Interpretationen im Rahmen einer Beweisführung zu tun. Vor jeder Zuschreibung von Wahrheitswerten – hypothetisch oder

auf Grund irgendwelcher Überzeugungen – wird man im Rahmen einer Beweisführung

eine Explikation verlangen, was in welchem Sinn und in Rahmen welchen Systems für

wahr angenommen wird.

Man wird fragen, in welchem Sinne in unserem Zusammenhang von einer Maschine die Rede sein soll: In einem empirischen Sinn oder im Sinne einer Abfolge von

Befehlen? Der erste Sinn ist wohl nicht gemeint, denn man wird die Bemerkung, dass

empirische Maschinen mitunter halten, weil der Strom ausgefallen ist etc. als unangemessen zurückweisen. Es ist dementsprechend anscheinend gemeint, dass gegeben ein

input n aus der bloßen Definition der Regeln der Maschine folgen soll, ob sie hält oder

nicht. Es soll also nicht regelkonform und in diesem Sinne “unmöglich” sein, dass die

Maschine hält, wenn Anwendung ihrer Regeln auf den input n etwa in eine Schleife

führt. Eine derartige Unmöglichkeit kann aber gemäß Verständnis der New Logic aus

mindestens zwei Gründen nicht dadurch zum Ausdruck gebracht werden, dass ein bestimmtes materiales Konditional (Γ → D) nicht allgemeingültig bzw. kein Theorem

ist.