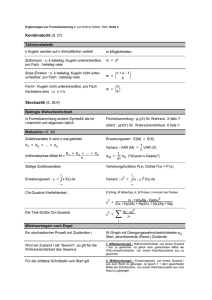

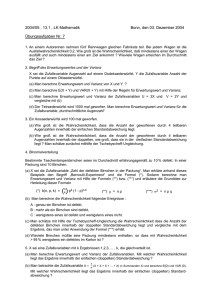

Kapitel 3, Wahrscheinlichkeitstheorie

Werbung

3

Elementare Wahrscheinlichkeitstheorie

3.1

Einführung

Bisher haben wir gesehen, daß Daten, Meß- und Beobachungsergebnisse schwanken. Schwankungen haben wir graphisch und quantitativ dargestellt. Um solche

Beobachtungen verstehen und im Modell erfassen zu können, benötigen wir einige Grundbegriffe der Wahrscheinlichkeitsrechnung.

Unter einem zufälligen Ereignis verstehen wir eines, das als Folge eines Vorgangs eintritt, dessen Ergebnis nicht vorhersagbar ist. Das kann der Fall sein,

wenn viele Einzeleinflüsse eine Rolle spielen, die wir wegen ihrer hohen Zahl

nicht erfassen können, oder wenn bestimmte Parameter prinzipiell verborgen

sind. Beispiele sind Merkmalsvererbung, Mutationen beim Kopieren von Erbinformation, Flugrichtung von Insekten, . . . .

Wir unterscheiden Zufallsexperimente von deterministischen Experimenten. Das Ergebnis eines Z.s ist nicht vorhersagbar, wir können nur Aussagen

machen über die Wahrscheinlichkeiten bestimmter Ereingisse. Wahrscheinlichkeiten sind dabei Zahlen p mit der Eigenschaft 0 ≤ p ≤ 1. Beispiele:

• Münzwurf. Zwei Ergebnisse, jeweils mit pKopf = pZahl = 1/2.

• Wurf mit zwei Würfeln. Wahrscheinlichkeit, daß sich genau die Augenzahl 3 ergibt. Zwei günstige Fälle (12 und 21) von 36 insgesamt möglichen: pSumme=3 = 2/36 = 1/18. Wahrscheinlichkeit für ein Pasch. Sechs

günstige Fälle (11, 22, . . . , 66): pPasch = 6/36 = 1/6.

• Geschlecht von Neugeborenen. Von den Lebendgeborenen in Zürich zwischen 1931 und 1985 sind 51,3% Jungen. Wir schließen daraus, daß allgemein pJunge = 1 − pMädchen = 0.513. Bei großer Stichprobengröße dienen

die relativen Häufigkeiten als sehr guter Schätzer für die Wahrscheinlichkeiten von Ereignissen. Dieser Zusammenhang heißt auch Gesetz der

großen Zahlen.

3.2

Grundbegriffe

Die Menge aller möglichen Ergebnisse eines Zufallsexperiments heißt Ergebnismenge oder Stichprobenraum Ω. Ihre Elemente ω ∈ Ω heißen Elementarereignisse. Teilmengen E ⊂ Ω heißen Ergeignisse. Man sagt, Ereignis E sei

eingetreten, wenn ein Zufallsexoerimet ein Ergebnis ω ∈ E liefert.

Bei einem Würfel sind die Elementarereignisse ω1 = 1, . . . , ω6 = 6. Als Ereignis definieren wir z.B. “Augenzahl gerade”, also Egerade = {2, 4, 6}.

Das Ereignis E = Ω heißt das sichere Ereignis, E = ∅ heißt das unmögliche

Ereignis. Alle möglichen Ergebnisse ω sind in Ω enthalten, es tritt also sicher

ein. In ∅ dagegen keines, es tritt also sicher nicht ein.

15

Das Ereignis Ē − Ω\E = {ω ∈ Ω|ω ∈

/ E} heißt zu E komplementär. Im

Würfelbeispiel ist Ēgerade = Eungerade = {1, 3, 5}. Ē tritt genau dann ein, wenn

E nicht eintritt.

3.2.1

Verknüpfung von Ereignissen und Mengenlehre

Ereignisse sind Teilmengen von Ω, wie läßt sich formulieren, daß z.B.

zwei Ereignisse gleichzeitig eintreten, oder

mindestens eines von zweien eintritt?

Bsp. Würfel. Egerade = {2, 4, 6} und E≤3 = {1, 2, 3}. Beide gleichzeitig

bedeutet: Augenzahl kleiner als 3 und Augenzahl gerade, also die Schnittmenge

Egerade ∩ E≤3 = {2, 4, 6} ∩ {1, 2, 3} = {2}

Mindestens eins von beiden bedeutet die Vereinugungsmenge

Egerade ∪ E≤3 = {2, 4, 6} ∪ {1, 2, 3} = {1, 2, 3, 4, 6}

Allgemein formuliert. Bei zwei Ereignissen E und F tritt

E ∩ F genau dann ein, wenn beide gleichzeitig eintreten, und

E ∪ F genau dann ein, wenn E oder F (oder beide) eintritt (eintreten).

Zwei Ereignisse E und F , die nicht gleichzeitig eintreten können, heißen

disjunkt (“unverbunden”). Ihre Schnittmenge ist leer: E ∩ F = ∅. Beispiel:

Egerade und E5 = {5} sind disjunkt. Wenn ich einen Fünfer würfle, habe ich

keine gerade Zahl bekommen.

3.3

Axiome von Kolmogorov

Wir haben gesehen, wie man Ereignisse mengentheoretisch beschreiben kann.

Wie kann man ihnen Wahrscheinlichkeiten zuordnen, mit denen man auch noch

sinnvoll rechnen kann. In der Sprache der Mathematik nennt man solch eine

grundlegende Formalisierung ein Axiomensystem. Für uns als “Anwender” der

mathematischen Werkzeuge ist es wichtig, den Wert der Formalisierung zu erkennen, und uns immer Anwendungsbeispiele vorstellen zu können — sie also

in die “richtige Welt” zu übertragen.

K0 Jedem Ereignis E ⊂ Ω wird eine Zahl P (E), genannt die Wahrscheinlichkeit von E, zugeordnet mit folgenden Eigenschaften:

K1 Für alle Ereignisse E ⊂ Ω gilt: 0 ≤ P (E) ≤ 1

K2 P (Ω) = 1

K3 Für disjunkte Ereignisse E und F , also E ∩ F = ∅, beide treten nicht

gemeinsam auf, gilt P (E ∪ F ) = P (E) + P (F )

Beispiel: Würfel. Betrachte die sechs Ereignisse, die aus den jeweiligen Elementarereignissen bestehen:

E1 = {1},

E2 = {2},

E3 = {3},

16

E4 = {4},

E5 = {5},

E6 = {6}

Die Ei sind paarweise disjunkt, d.h.

Ei ,

Ei ∩ E j =

∅

falls i = j

sonst

Die Ereignisse sind gleich wahrscheinlich, P (Ei ) = P (Ej ) für alle i, j ∈ {1, . . . , 6}.

Mit Hilfe der Kolmogorov-Axiome rechnen wir die einzelnen Wahrscheinlichkeiten aus

1

= P (Ω)

= P (E1 ∪ . . . ∪ E6 )

= P (E1 ) + P (E2 ∪ . . . ∪ E6 )

= P (E1 ) + P (E2 ) + P (E3 ∪ . . . ∪ E6 )

...

= P (E1 ) + . . . + P (E6 )

= 6 P (Ei )

K2

K3

K3

K3

für alle i, weil alle gleich wahrscheinlich

Daher gilt für alle i: P (Ei ) = 1/6.

Rechenregeln angewandt: Die Wahrscheinlichkeit, eine gerade Zahl zu würfeln. Egerade ist die disjunkte Vereinigung von E2 , E4 und E6 . Daher

P (Egerade ) = P (E2 ) + P (E4 ) + P (E6 ) = 3 ·

3.4

3.4.1

1

1

=

6

2

Elementare Rechenregeln

Komplementäre Ereignisse

Für ein Ereignis E gilt wegen

1 = P (Ω) = P (E ∪ Ē) = P (E) + P (Ē)

(denn E und Ē sind disjunkt)

P (Ē) = 1 − P (E)

3.4.2

Vereinigung nicht disjunkter Ereignisse

Aus der Abbildung

F

E

E ∩F

E ∩F

E ∩F

17

Ω

sehen wir, daß

E ∪ F = (E ∩ F̄ ) ∪ (E ∩ F ) ∪ (Ē ∩ F )

E = (E ∩ F̄ ) ∪ (E ∩ F )

F = (E ∩ F ) ∪ (Ē ∩ F ),

wobei auf den rechten Seiten disjunkte Vereinigungen stehen. Mit Axiom K3

ergibt sich daraus

P (E ∩ F̄ ) = P (E) − P (E ∩ F )

P (Ē ∩ F ) = P (F ) − P (E ∩ F )

Damit folgt

P (E ∪ F ) = P (E ∩ F̄ ) + P (E ∩ F ) + P (Ē ∩ F )

= P (E) − P (E ∩ F ) + P (E ∩ F ) + P (F ) − P (E ∩ F )

= P (E) + P (F ) − P (E ∩ F )

(34)

Wenn zwei Ereignisse nicht disjunkt sind, hat man mit P (E) + P (F ) die

Schnittmenge doppelt gezählt. Man muß deren Wahrscheinlichkeit daher wieder einmal abziehen.

3.4.3

Inklusion

Wenn E ein Spezialfall von F , also E ⊂ F , dann ist P (E) ≤ P (F ). Anschaulich klar. Läßt sich mit den K-Axiomen zeigen:

F = E ∪ (F ∩ Ē), disjunkt vereinigt. Daher P (F ) = P (E) + P (F ∩ Ē).

Wegen K1 ist aber P (F ∩ Ē) ≥ 0, also P (F ) ≥ P (E).

3.4.4

Mehrere paarweise disjunkte Ereignisse

Die Summenregel K3 läßt sich verallgemeinern

P (E1 ∪ . . . ∪ En ) = P (E1 ) + . . . + P (En )

Siehe die Rechnung für den Würfelwurf.

3.5

Bedingte Wahrscheinlichkeiten

Betrachte ein Beispiel. 1000 Personen werden untersucht. Eine verbreitete

Krankheit tritt häufiger bei Untergewichtigen als bei normalgewichtigen auf.

Zahlenbeispiel:

untergewichtig

normalgewichtig

Spaltensumme

krank gesund Zeilensumme

300

200

500

100

400

500

400

600

18

Insgesamt sind 40% der Testpersonen erkrankt, aber 60% der Untergewichtigen. Wenn wir das Gewicht einer Person kennen, wissen wir also etwas über die

Erwartung, ob sie krank oder gesund ist. Allgemeiner formuliert: Mit welcher

Wahrscheinlichkeit tritt Ereignis E ein, wenn wir wissen, daß F eintritt. Das

ist die bedingte Wahrscheinlichkeit P (E|F ).

Analysiere das Beispiel genauer. Unterscheide folgende Ereignisse:

K:

G:

U:

N:

die

die

die

die

Person

Person

Person

Person

ist

ist

ist

ist

krank.

gesund.

untergewichtig.

normalgewichtig.

Offensichtlich gilt für die Ergebnismenge

Ω = K ∪ G = U ∪ N = (K ∩ U ) ∪ (G ∩ U ) ∪ (K ∩ N ) ∪ (G ∩ N )

Die Wahrscheinlichkeiten der Ereignisse lassen sich aus der Tabelle ablesen:

P (U ) = 0.5, P (N ) = 0.5, P (K) = 0.4, P (G) = 0.6, sowie P (K ∩ U ) = 0.3,

P (G ∩ U ) = 0.2, P (K ∩ N ) = 0.1, P (G ∩ N ) = 0.4.

Durch geeignetes Kombinieren erhält man den Anteil der Kranken unter

den Untergewichtigen

P (K ∩ U )

:= P (K|U ) = 0.6

P (U )

oder der Gesunden unter den Normalgewichtigen

P (G ∩ N )

:= P (G|N ) = 0.8

P (N )

oder der Untergewichtigen unter den Kranken

P (K ∩ U )

:= P (U |K) = 0.75

P (K)

oder . . .

Allgemein: Seien E, F ⊂ Ω zwei Ereignisse, mit P (F ) > 0, d.h. F ist nicht

unmöglich. Dann ist

P (E ∩ F )

.

(35)

P (E|F ) =

P (F )

3.6

Bayessche Formel

Anwendungsbeispiel ist ein Test auf eine seltene Krankheit, der nicht fehlerfrei

ist. Folgendes ist bekannt:

1. Die Krankheit haben 0.1% der Bevölkerung

2. Der Test gibt bei 95% aller Kranken einen positiven Befund.

3. Der Test gibt bei 3% aller Gesunden einen positiven Befund.

19

Wir wollen entscheiden, ob der Test geeignet für eine Reihenuntersuchung ist.

Dazu müssen wir zwei Fragen klären: Wie groß ist die Wt., daß eine Person

mit positivem Testergebnis nicht krank ist, und daß eine mit negativem krank

ist. Wir berechnen also die Irrtumswahrscheinlichkeiten.

Ereignisse definieren: K krank, π positives Testergebnis. Wir wissen: P (K) =

0.001, P (π|K) = 0.95, P (π|K̄) = 0.03. Gesucht sind P (K̄|π) und P (K|π̄).

Dazu benötigen wir den Satz von der totalen Wahrscheinlichkeit. Betrachte

eine Zerlegung von Ω in paarweise disjunkte Ereignisse, Ω = F1 ∪. . .∪Fn . Dann

können wir ein beliebiges Ereignis E darstellen durch

P (E) =

n

X

i=1

P (E ∩ Fi ) =

n

X

P (E|Fi ) P (Fi )

(36)

i=1

siehe Gleichung (35).

Jetzt “drehen” wir mit Hilfe der Gleichungen (35) und (36) “den Spieß um”

und erhalten

P (Fi |E) =

P (Fi ∩ E)

P (E|Fi ) P (Fi )

= Pn

,

P (E)

j=1 P (E|Fj ) P (Fj )

(37)

die sogenannte Bayessche Formel (nach Thomas Bayes, 1702-1761).

Anwendung auf unser Beispiel: Die Zerlegung ist Ω = K ∪ K̄ = F1 ∪ F2 .

Das positive Testergebnis π ist E. Einsetzen

0.03 · 0.999

P (π|K̄) P (K̄)

=

= 0.96

0.95 · 0.001 + 0.03 · 0.999

P (π|K) P (K) + P (π|K̄) P (K̄)

(38)

Das heißt, 96% der positiv getesteten sind überhaupt nicht krank! Der Test ist

also zu unsicher.

P (K̄|π) =

Die andere Irrtumswahrscheinlichkeit ist

0.05 · 0.001

P (π̄|K) P (K)

=

= 0.00005

0.05 · 0.001 + 0.97 · 0.999

P (π̄|K) P (K) + P (π̄|K̄) P (K̄)

(39)

Über ein negatives Testergebnis darf man sich also beruhigt freuen.

P (K|π̄) =

3.7

Laplace–Wahrscheinlichkeiten

Wenn alle Elementarereignisse ω1 . . . ωn ∈ Ω gleich wahrscheinlich sind, also

P ({ω1 }) = . . . = P ({ωn }) = 1/n, heißt (Ω, P ) Laplacescher Wahrscheinlichkeitsraum, benannt nach Pierre–Simon (Marquis de) Laplace (1749–1827).

Die Wahrscheinlichkeit eines Ereignisses E ergibt sich dann aus der Kardinalität von E, d.h. aus der Anzahl der Elementarereignisse in E. Als anschauliches Bild stellt man sich oft eine Urne oder Lostrommel vor, aus der man

Kugeln zieht.

Hier einige Beispiele von häufig auftretenden Verteilungen.

20

3.7.1

Kugeln ziehen, nicht zurücklegen, Reihenfolge beachten

Bei der ersten Kugel n Möglichkeiten, bei der zweiten n(n − 1), usw. Es gibt

für k Kugeln

n!

n (n − 1) . . . (n − k + 1) =

(n − k)!

Möglichkeiten. Der Ausdruck n! = 1·2·. . .·n heißt n-Fakultät. Nach Definition

0! = 1.

3.7.2

Kugeln ziehen, nicht zurücklegen, Reihenfolge nicht beachten

Das entspricht den Lottozahlen. Es gibt n!/(n − k)! Möglichkeiten, Kugeln zu

ziehen. Jeweils k! davon untescheiden sich nur durch Unterschiedliche Reihenfolge. Es gibt also

n

n!

=

k

k! (n − k)!

(“n über k”, sog. Binomialkoeffizient) echt verschiedene Möglichkeiten.

3.7.3

Kugeln ziehen, zurücklegen, Reihenfolge beachten

Bei jedem Zug gibt es n Möglichkeiten, insgesamt also nk .

3.8

Mehrstufige Bernoulli–Experimente

Zufallsexperimente, deren Ergebnismenge Ω nur zwei Elementarerignisse enthält, heißen Bernoulli–Experimente, benannt nach dem Basler Jakob Bernoulli

(1655–1705). Münzwurf, Geschlecht von Kindern, . . . .

Was passiert, wenn B-Experimente n–mal wiederholt werden? Z.B., mit

Wahrscheinlichkeit p ist ein Kind männlich, mit q = 1 − p weiblich. Wie ist die

Wahrscheinlichkeit, unter n Kindern k Jungen zu haben. Betrachte dazu den

Entscheidungsbaum:

p

q

M

W

p

q

MM

p

p

MW

q

p

q

WM

p

q

WW

q

p

q

MMM MMW MWM MWW WMM WMW WWM WWW

Aus dem Baumdiagramm kann man die Wahrscheinlichkeiten der Elementarereignisse ablesen. Jeder schritt nach links hat Wt. p, jeder nach rechts hat

21

Wt. q. So erhält man z.B.

P (M M M ) = p3

P (W W W ) = q 3

P (W M W ) = p q 2

P (M W W ) = p q 2 usw.

Die Wt.en der Elementarereignisse hängen nur von der Anzahl der W bzw. M

ab.

Wir fassen nun für n Wiederholungen die Elementarereignisse mit jeweils

k

Ergebnissen vom typ M zusammen. Nach Abschnitt gibt es davon nk Stück,

alle disjunkte Elementarereignisse, mit derselben Wt. pk q n−k . Also ist

n

pn,p (k) =

pk (1 − p)n−k

(40)

k

die gesuchte Wahrscheinlichkeit. Sie heißt auch Binomialverteilung.

Beipiel: Mendelscher Versuch, zweimal die Binomialverteilung angewandt.

Kreuzung homozygoter Erbsen mit runder (RR) und eckiger (EE) Samenform.

In der F1 –Generation erhält man heterozygote (RE). In der F2 –Generation

erhält jedes Individuum von Vater und Mutter jeweils mit p = 1/2 ein E– bzw.

ein R–Gen. Daher ist p(EE) = p(RR) = 1/4 und p(ER) = 1/2. Wichtig: wir

können nicht zwischen ER und RE unterscheiden, beide Fälle werden also

zusammengefaßt.

F1

F2

p(EE) = p(ER) = p(RE) = p(RR) = 1/4

R ist dominant. Die Wahrscheinlichkeit einen runden Samen im Phänotyp

zu erhalten ist also p(R) = p(RR) + p(ER) = 3/4. Wie groß ist z.B. die

Wahrscheinlichkeit unter 32 Samen 26 runde und 6 eckige zu zählen? Binomial:

32

p32,3/4 (26) =

0.7526 0.256 ≈ 0.1249.

(41)

26

3.9

3.9.1

Diskrete Zufallsvariablen

Wahrscheinlichkeitsdichte und Verteilungsfunktion

Eine Zufallsvariable X, die nur diskrete (d.h. isolierte) Werte annehmen kann

heißt diskrete Zufallsvariable. Beispiel: Ganze Zahlen, wie z.B. die Zahl runder

22

Erbsensamen in Mendels Experiment.

Eine Funktion f , die jedem Wert x, den die Zufallsvariable X annehmen

kann, eine Wahrscheinlichkeit P (X = x) = f (x) zuordnet, heißt Wahrscheinlichkeitsdichte.

Wenn X die Werte x ∈ Ξ annehmen kann, sind die Ereignisse Ex =

{ω|X(ω) = x} paarweise disjunkt. Dann ist

X

X

X

f (x) =

p(X = x) =

p(Ex ) = p(∪x∈Ξ Ex ) = p(Ω) = 1.

(42)

x∈Ξ

x∈Ξ

x∈Ξ

Fazit: Die einzelnen Wahrscheinlichkeiten bzw. Wahrscheinlichkeitsdichten summieren sich zu 1 auf.

Entsprechend der Kumulativen Häufigkeit bei Stichproben definiert man

auch die Verteilungsfunktion der Zufallsvariablen X,

X

F (x) =

f (x).

(43)

{y∈Ξ|y≤x}

Man kann F als Stammfunktion zu f auffassen. Mehr dazu später bei Verteilungen kontinuierlicher Zufallsvariablen. Für den maximalen Wert xmax =

max Ξ gilt: F (xmax ) = 1. Warum?

3.9.2

Unabhängigkeit

Zwei Zufallsvariablen X und Y mit Werten x ∈ Ξ und y ∈ Ψ heißen unabhängig, wenn

p((X = x) ∧ (Y = y)) = p(X = x) p(Y = y)

(44)

gilt für alle Werte x und y.

3.9.3

Erwartungswert und Varianz

Wir kennen bereits arithmetisches Mittel und empirische Varianz von Stichproben. Zu einer diskreten Zufallsvariablen X definieren wir den Erwartungswert

X

E(X) =

x p(X = x)

(45)

x

und die Varianz

V(X) =

X

x

(x − E(X))2 p(X = x)

(46)

p

Ihre Wurzel V(X) heißt Standardabweichung. Nach dem Gesetz der großen

Zahlen konvergieren bei langen Serien unabhängiger Ergebnisse einer Zufallsvariablen die empirischen Mittel und Varianzen von Meßreihen gegen die “tatsächlichen” Größen der zugrundeliegenden Verteilungen.

23

Verschiebungssatz: V(X) kann man aus E(X) und E(X 2 ) berechnen.

X

V(X) =

(x − E(X))2 p(X = x)

x

=

X

x

=

(x2 − 2xE(X) + E(X)2 ) p(X = x)

X

x

x2 p(X = x) − 2E(X)

X

x

x p(X = x) + E(X)2

= E(X 2 ) − 2E(X)2 + E(X)2 = E(X 2 ) − E(X)2

X

p(X = x)

x

Beispiel: Bernoulli-Experiment mit Werten 0 und 1, p(X = 1) = p.

E(X) = 1 · p + 0 · (1 − p) = p

V(X) = E(X 2 ) − E(X)2

= 12 · p + 02 · (1 − p) − E(X)2

= p − p2 = p (1 − p)

(47)

An dieser Stelle können wir verstehen, warum beim Schätzer der Varianz

einer Meßreihe n − 1 im Nenner steht. Nimm an, wir haben eine Meßreihe

x1 , . . . , xn von n unabhängig ausgewürfelten Werten einer Zufallsvariablen X.

Berechne den Erwartungswert

!2

n

X

X

1

xi −

E

(48)

xj =

n

i=1

j

indem wir einsetzen p(X(1) = x1 ∧ . . . ∧ X(n) = xn ) = p(X(1) = x1 ) · . . . ·

p(X(n) = xn ). X(i) bezeichnet die i-te Ziehung der Z.variablen.

!2

n

X

X

X X

1

xj

p(X(1) = x1 ) · . . . · p(X(n) = xn )

...

xi −

=

n

xn

x1

j

i=1

!2

X

X

X

X X

1

2

xi xj

xj −

p(X(1) = x1 ) · . . . · p(X(n) = xn )

x2i +

...

=

n

n

x

x

i,j

j

i

1

n

= n E(X 2 ) −

X

1X X

p(X(1) = x1 ) · . . . · p(X(n) = xn )

xi xj

...

n x

x

i,j

n

1

trenne die Summe auf nach i = j und i 6= j

X

1X X

= (n − 1) E(X 2 ) −

p(X(1) = x1 ) · . . . · p(X(n) = xn )

xi xj

...

n x

x

i6=j

1

= (n − 1) E(X 2 ) −

n

n(n − 1) X X X

n

x1

x2

x3

...

X

xn

p(X(1) = x1 )p(X(2) = x2 )p(X(3) = x3 ) · . . .

der letzte Schritt gilt, weil die Summe für alle Paare i, j gleich ist. Es gibt

n(n − 1) solcher Paare.

= (n − 1) E(X 2 ) − (n − 1) E(X)2

= (n − 1) V(X).

24

(49)

(50)

Übungsaufgaben: Rechenregeln für Varianz und Erwartungswert. Seien

X und Y Zufallsvariablen, c eine reelle Zahl. Zeige, daß

E(cX) = cE(X)

E(X + Y ) = E(X) + E(Y )

V(cX) = c2 V(X)

Zeige außerdem für unabhägige X und Y

E(XY ) = E(X) E(Y )

V(X + Y ) = V(X) + V(Y )

3.9.4

Beispiele diskreter Verteilungen

Geometrische Verteilung

Betrachte eine Folge von Zufallsexperimenten, z.B. eine Serie von Münzwürfen.

Wie lange muß man warten, bis der erste Erfolg eintritt, z.B. bis zum ersten

Mal “Zahl” geworfen wird?

Definiere als Zufallsvariable den “Erfolg” im t–ten Schritt, Et = 1 bei Erfolg

und = 0 bei Mißerfolg. Dann ist der Zeitpunkt des ersten Erfolgs

T = min{t ≥ 1|Et = 1} und W = T − 1

die Wartezeit W . Wir haben also W –mal 0 und dann eine 1 erhalten. Die

Wahrscheinlichkeit für jeden einzelnen Erfolg p ist, ist die Wahrscheinlichkeit

für die Eintreffzeit T = k also

P (T = k) = P (E1 = 0, . . . , Ek−1 = 0, Ek = 1) = (1 − p)k−1 p.

(51)

Erwartungswert der Eintreffzeit

E(T ) =

∞

X

k P (T = k) = p

∞

X

k=1

k=1

k (1 − p)k−1

Läßt sich mit einem Trick ausrechnen

X d

ET = −p

(1 − p)k

dp

k

d

= −p

dp

= −p

X

k

(1 − p)

d 1

1

=

dp p

p

k

(52)

(53)

!

(54)

Das Ergebnis ist intuitiv einleuchtend: Wenn bei jedem Schritt die Erfolgswahrscheinlichkeit p ist, tritt der Erfolg im Mittel beim 1/p–ten Schritt ein.

Analog für die Varianz

X

V(T ) = p

k 2 (1 − p)k−1 − E(T )2

(55)

k

= ... =

1−p

p2

(56)

25

Anmerkung: Summenformel für geometrische Reihe

(1 − q)

k

X

l=0

q l = 1 − q k+1 → 1

im Limes k → ∞ für q < 1.

Multinomialverteilung

Wiederhole ein Zufallsexperiment n–mal, dessen Ergebnismenge

Ω = {ω1 , . . . , ωk }

P

mit Einzelwahrscheinlichkeiten pi ist. Natürlich i pi = 1. Im Gegensatz zum

Bernoulli–Experiment mit Binomialverteilung haben wir hier also k mögliche

Elementarereignisse. Der Vektor N = (N1 , . . . , Nk ) gibt die jeweiligen Häufigkeiten an. Was ist seine Wahrscheinlichkeitsdichte, also P (N1 = n1 , . . . , Nn =

nn ) = P (N = n).

Wahrscheinlichkeit

Stichprobe, bei der ni –mal ωi beobachtet wird

Q einer

nk

ni

n1

ist p1 · . . . · pk = i pi . Jetzt müssen wir noch berücksichtigen, wieviele

Kombinationen es gibt, auf wieviele

auf

Weisen wir die ωi s verteilen könnenn−n

n

die n Ziehungen. Dabei gibt es n1 Möglichkeiten für ω1 . Danach bleiben n2 1

für ω2 , n−nn13−n2 für ω3 , usw. Insgesamt also ist die Anzahl der Möglichkeiten

gegeben durch den Multinomialkoeffizienten

n!

n − n1

n

n − n1 − . . . nk−1

· ... ·

=

n1

n2

nk

n1 ! n 2 ! · . . . · n k !

Daher

P (N = n) =

n!

pn1 · . . . · pnk k

n1 ! n 2 ! · . . . · n k ! 1

(57)

Poissonverteilung

Grenzfall der Binomialverteilung mit Wt.dichte pn,p (k) für n → ∞ und p → 0,

so daß aber n p ≡ λ konstant bleibt. Explizit einsetzen p = λ/n

n−k

k 1

λ

λ

pn,p (k) =

1−

n(n − 1) · . . . · (n − k + 1)

k!

n

n

k−1

1

k

λ −λ 1 1 − n · . . . · 1 − n

(58)

e

=

k

k!

1− λ

n

= pλ (k)

(59)

wobei wir benutzt haben, daß (1 − λ/n)n → exp(−λ) und daß der Bruch für

feste λ und k gegen 1 geht.

Beispiele: 1. Ein Protein hat 45 mögliche Stellen, an denen eine flureszierende grüne Markierung angebracht werden kann, an jeder Stelle ist die Wahrscheinlichkeit, daß ein Marker bindet etwa 5%. Die Verteilung der Anzahl der

Marker an einem Protein ist streng genommen binomial, kann aber schon recht

gut durch eine Poisson–Verteilung mit λ = 0.05 · 45 beschrieben werden.

2. Samen werden gleichmäßig über ein größes Feld verteilt. Zahl der Samen in

einem kleinen Flächenstück ist Poisson–verteilt.

Historisch: Nach Siméon Denis Poisson (1781–1840). Entwickelte die Verteilung Recherches sur la probabilité des jugements en matière criminelle et

matière civile. Auf ihn geht auch der Begriff Gesetz der großen Zahlen zurück.

26

3.10

Stetige Verteilungen

In Kapitel 2 haben wir Histogramme von Größen gezeichnet, die beliebige reelle

Werte annehmen können, z.B. bei Messungen von Längen, Winkeln, Konzentrationen . . . . Wir haben dazu den “Raum” oder Wertebereich, in dem die

Meßergebnisse liegen, in Klassen unterteilt und das Histogramm gezeichnet

nach der Anzahl der Meßpunkte in jeder Klasse. Dadurch haben wir den zunächst kontinuierlichen Wertebereich durch einen diskreten angenähert, über

dem wir die Häufigkeitsdichten bestimmt und gezeichnet haben.

3.10.1

Stetige Wahrscheinlichkeitsdichte

Ähnlich machen wir es mit Wahrscheinlichkeitsdichten. Betrachte eine Zufallsvariable X mit Werten in den reellen Zahlen. Wir teilen den Wertebereich in

immer feinere Intervalle Iε (n) = [ε(n−1/2), ε(n+1/2)) der Länge ε auf und bestimmen für jedes Intervall die Wahrscheinlichkeit P (X ∈ Iε (n)). Wir denken

uns ein “Histogramm”, genauer eine Stufenfunktion fε (x) = P (X ∈ Iε (n))/ε

für x ∈ Iε (n), also 1/ε mal der diskreten Wahrscheinlichkeitsdichte, daß der

Wert von X in dem betreffenden Intervall liegt.

f(x)

ε=1

ε = 1/2

ε = 1/4

1

−1

x

Hier ein Beispiel mit ε = 1, 1/2, 1/4. In vielen Fällen nähert sich diese Stufenfunktion immer näher eine glatten, stetigen Funktion f (x) an. Diese ist die

Wahrscheinlichkeitsdichte der Zufallsvariable X. Wegen der Konstruktion von

gilt für das Integral Rüber die gesamte Ergebnismenge Ω, den gesamten möglichen Wertebereich, Ω f (x) dx = 1.

Die Wahrscheinlichkeit, daß der Wert von X in einem Bestimmten Bereich

liegt, z.B. dem Intervall [a, b], ist dann gegeben durch Anteil der Gesamtdichte,

der über [a, b] liegt, nämlich

Z b

P (a ≤ X ≤ b) =

f (x) dx

(60)

a

Wie für diskrete Zufallsvariablen definieren wir auch hier eine Verteilungsfunktion

Z x

F (x) = P (X ≤ x) =

f (y) dy

(61)

inf Ω

(inf Ω bezeichnet dabei das untere Ende des Wertebereichs, das Infinum von

Ω, das obere Ende ist das Supremum, sup Ω). Die Verteilungsfunktion ist oft

bequem zum rechnen. Z.B.

P (a ≤ X ≤ b) = F (b) − F (a)

27

(62)

oder: Die Wahrscheinlichkeit, daß das Maximum von n unabhängigen Ziehungen von X, also der größte Wert bei n Ziehungen, kleiner als x ist, ist gerade

P (max(X1 , . . . , Xn ) ≤ x) = P (X1 ≤ x) · . . . · P (Xn ≤ x) = F (x)n

(63)

Den Median oder allgemeiner p–Quantil einer Verteilung bestimmt man aus

der Verteilungsfunktion durch

P (X ≤ xp ) = p bzw. F (xp ) = p

3.10.2

(64)

Erwartungswert und Varianz

Wie bei den diskreten Zufallsvariablen berechnen wir mit Hilfe der Wahrscheinlichkeitsdichte den Erwartungswert

Z

E(X) = x f (x) dx

(65)

einer Zufallsvariablen und ihre Varianz

Z

V(X) = (x − E(X))2 f (x) dx = E(X 2 ) − E(X)2

3.10.3

(66)

Transformationen von Zufallsvariablen

Auch hier hilft die Verteilungsfunktion. Angenommen wir haben die Transformation von x nach y = y(x) und ihre Umkehrfunktion x = x(y), die aber streng

monoton sein soll, also: für x1 < x2 gilt auch y1 = y(x1 ) < y2 = y(x2 ). Was ist

dann die Wahrscheinlichkeitsdichte g(y)? Berechne mit der Verteilungsfunktion

G(y) = P (Y ≤ y) = P (X < x(y)) = F (x(y))

(67)

Also ist nach der Kettenregel

g(y) = G0 (y) =

d

d

dx

dx

G(y) =

F (x(y)) = F 0 (x(y))

= f (x(y))

dy

dy

dy

dy

(68)

Die Wahrscheinlichkeitsdichte g(y) ist also gegeben durch die des zugehörigen x, f (x(y)), multipliziert mit einem Faktor dx/dy. Beispiel wäre die Umrechnung von Celsius in Fahrenheit aus Kapitel 2: y = 9/5 x + 32, also

x = 5/9 (y − 32). Dann ist dx/dy = 5/9 und g(y) = 5/9 f (5/9 (y − 32)).

Der Vorfaktor 5/9 ist auch intuitiv klar: Die Fahrenheitwerte y streuen über

einen größeren Bereich als die Celsiuswerte x, die Dichte muß deshalb geringer

sein.

3.10.4

Beispiele stetiger Verteilungen

Gleichverteilung

Jeder Wert auf einem Intervall [a, b] sei gleich wahrscheinlich. Dann ist die

W.dichte

1

für x ∈ [a, b]

b−a

f (x) =

(69)

0

sonst

28

Je schmaler das Intervall, desto höher die Dichte in seinem Inneren. Die gesamte Fläche muß 1 sein.

Normalverteilung

Eine besondere Rolle, die wir noch sehen werden, spielt die Gaußsche Normalverteilung. Mit Mittelwert 0 und Varianz 1 ist sie

2

1

−x

f0,1 = √

exp

.

(70)

2

2π

R

Der Vorfaktor garantiert f0,1 = 1, die Normierung der Wahrscheinlichkeitsverteilung. Allgemeiner, mit Mittelwert µ und Varianz σ 2 , was man durch eine

Transformation der Variablen x → µ + σx erhält

1

−(x − µ)2

(71)

fµ,σ = √

exp

2σ 2

2πσ 2

Häufig benutzte Eigenschaften der Gaußverteilung:

Erwartungswert

Z ∞

1

−(x − µ)2

x√

E(X) =

dx

exp

2σ 2

2πσ 2

∞

Z ∞

1

−(x − µ)2

(x − µ) √

=

dx

exp

2σ 2

2πσ 2

∞

Z ∞

1

−(x − µ)2

√

dx

+ µ

exp

2σ 2

2πσ 2

∞

= µ

(72)

wobei das erste Integral = 0 ist, weil der Integrand symmetrisch um µ ist, und

das zweite gerade = 1 wegen der Normierung einer Wahrscheinlichkeitsverteilung.

Varianz

Z ∞

1

−(x − µ)2

2

V(X) =

(x − µ) √

dx

(73)

exp

2σ 2

2πσ 2

∞

2

Z ∞

σ3

−y

2

= √

dy

y exp

2

2

2πσ

∞

= σ2

wobei wir zur 2. Zeile hin die Variablentransformation y = (x − µ)/σ benutzt

haben.

σ–Bereich

Z µ+σ

Z 1

fµ,σ (x) dx =

f0,1 (x) dx ≈ 0.68

(74)

µ−σ

−1

Die Wahrscheinlichkeit eine Zahl im Bereich einer Standardabweichung links

und rechts von der Mitte zu erhalten ist 0.68 (gerundet auf ganze %). Wegen

der Symmetrie ist die Wt. für Werte unterhalb von µ − σ und oberhalb von

µ + σ jeweils 0.16 (auch gerundet). Diese Werte sind also die 0.16– und 0.84–

Quantile. Ferner liegen zwischen µ − 2σ und µ + 2σ ca. 95.4%, zwischen µ − 3σ

und µ + 3σ ca. 99.7% der Gesamtwahrscheinlichkeit.

29

0.4

2σ−Bereich

σ−Bereich

f0,1

0.3

0.2

0.1

0

−4 −3 −2 −1

0

1

2

3

4

Beispiele: (1) Der Intelligenzquotient einer Bevölkerung folgt recht gut einer

Normalverteilung. Seine Skala wurde so gewählt, daß µ = 100 und σ = 15.

D.h., 50% aller Menschen haben einen IQ > 100, 16% > 115 und 2.3% > 130.

(2) Bei Reihenuntersuchungen von Kindern (U1, U2, . . . ) werden u.a. Maße

wie Größe, Gewicht etc. in ihrer zeitlichen Entwicklung in eine Graphik eingetragen, sog. Somatogramm. Zum Vergleich sind die 3%–, der Median, und die

97%–Quantile als Linien angegeben. Solche Maße sind also auch normalverteilt.

Einschub: Grenzwertsätze (Gesetz der Großen Zahlen).

Zur Herleitung brauchen wir die Ungleichng von Tschebyscheff. Sie macht eine Aussage darüber, wie (un)wahrscheinlich “große Ausreißer” sind. Betrachte

eine Zufallsvariable X mit Erwartungswert µ und Varianz σ 2 . Wir Verknüpfen

σ 2 mit der Wahrscheinlichkeit, Werte außerhalb eines Bereiches ±η um µ zu

erhalten:

Z

2

V(X) = σ = (x − µ)2 f (x) dx

Z µ−η

Z ∞

2

≥

(x − µ) f (x) dx +

(x − µ)2 f (x) dx

(75)

−∞

≥ η2

Z

µ+η

µ−η

f (x) dx + η 2

−∞

Z

∞

µ+η

f (x) dx = η 2 P (|X − µ| > η)

andersherum geschrieben

P (|X − µ| > η) ≤

V(X)

η2

(76)

In Abschnitt 3.9.3 hatten wir Erwartungswert und Varianz von Summen unabhängiger Zufallsvariablen kennengelernt. Bei n unabängigen “Ziehungen” von

X1 , . . . , Xn von X ist der Erwartungswert ihres arithmetischen Mittels

!

1X

1

1X

(77)

E

Xi =

E(Xi ) = n E(X) = E(X) =: µ

n i

n i

n

und die Varianz des arithmetischen Mittels

!

1X

1 X

1

1

σ2

V

V(Xi ) = 2 n V(X) = V(X) = .

Xi = 2

n i

n i

n

n

n

30

(78)

√

Die Varianz nimmt also mit 1/n ab, die Standardabweichung mit. 1/ n.

Die Wahrscheinlichkeit, daß das arithmetische Mittel der n Ziehungen nicht

weiter als ein kleines ε von µ abweicht, geht wegen Tschebyscheff mit der Zahl

der Ziehungen nach 1:

!

!

1 X

X

σ 2 n→∞

1

1

P Xi − µ < ε ≥ 1 − 2 V

Xi = 1 − 2 −→ 1. (79)

n

ε

n i

nε

i

Fazit: Wenn man nur genug Daten hat, kann man den Erwartungswert beliebig

gut messen. Das ist das Gesetz der Großen Zahlen. Allerdings kann “beliebig”

ganz schön groß sein. Wenn man eine Messung um den Faktor 10 verbessern

will (d.h. σ auf 1/10 drücken), braucht man 100–mal soviele Daten!

Zentraler Grenzwertsatz.

Hier zeigt sich nun die Bedeutung der Gauß–Normalverteilung. Wenn X beliebig verteilt ist, mit Erwartungswert µ und Varianz σ 2 , dann konvergiert die

Verteilung der arithmetischen Mittel von n Ziehungen gegen eine Gaußverteilung mit Erwartungswert µ und Varianz σ 2 /n.

Daß Erwartungswert und Varianz diese Werte annehmen, haben wir bereits

oben gezeigt. Daß es tatsächlich eine Gaußverteilung ist, erfordert etwas mehr

Aufwand. Wir zeigen hier nur einige Beispiele, die das veranschaulichen:

8

7

6

5

4

3

2

1

0

−0.2

0

0.2

0.4

0.6

0.8

1

1.2

0.45

0.4

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

−5

−4

−3

−2

−1

0

1

2

3

4

5

Hier eine zwischen 0 und 1 gleichverteilte Zufallsvariable, Histogramme der

Häufigkeitsdichten von 2.5 × 105 Ziehungen. Dabei sind die Zahlen selbst und

die arithmetischen Mittel über je 2, 4, 8, 16, und 32 Zahlen erfaßt. Oberes

Diagramm: Man sieht, wie die Verteilungen immer schärfer um die Mittelwert

µ = 1/2 werden. Unteres Diagramm: Die

√ Verteilungen sind alle auf Mittelwert

0 und Varianz 1 reskaliert, also über n (x − µ)/σ aufgetragen. Man sieht,

wie die Kurven für höhere n alle übereinanderliegen. Sie nähern sich einer

Gauß–Normalverteilung an.

31

5

4.5

4

3.5

3

2.5

2

1.5

1

0.5

0

0

0.5

1

1.5

2

2.5

3

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

−5

0

5

10

Dasselbe für eine schiefe Verteilung, Exponentialverteilung mit µ = 1/2 und

die gleichen n. Je mehr Zahlen gemittelt werden, umso mehr gleicht sich die

Form einer symmetrischen Gaußverteilung an.

0.45

0.4

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

−5

−4

−3

−2

−1

0

1

2

3

4

5

Hier sind je n = 128 gleichverteilte und exponentialverteilte Zahlen gemittelt,

die resultierende Häufigkeitsdichte reskaliert geplottet. Sie lassen sich nicht

mehr voneinander und von einer Gauß–Verteilung unterscheiden.

Eine letzte Anmerkung zur Sonderrolle der Gauß–Verteilung: Das arithmetische Mittel zweier (und damit auch mehrerer) normalverteilter Zufallsvariablen ist auch wieder normalverteilt. Betrachte X1 und X2 , unabhängig, beide

mit Wt.dichte f (x), dann ist die Wt.dichte des arithm. Mittels der beiden

Zahlen

Z ∞

2

P x ≤ X1 +X

<

x

+

dx

2

=

f2 (x) =

f (x − y/2) f (x + y/2) dy

(80)

dx

−∞

Zur Erklärung: wir integrieren mit y über zwei Zahlen x1 = x − y/2 und

x2 = x + y/2, die voneinander den Abstand y haben und deren arithmetisches

Mittel gerade gleich x ist. Diese Kombination ist eine Form der Faltung der

beiden Wahrscheinlichkeitsdichten. Wenn man für f (x) eine Gauß–Funktion

einsetzt, ergibt sich

Z ∞

1

(x − y/2 − µ)2 (x + y/2 − µ)2

−

dy

f2 (x) =

exp −

2πσ 2 −∞

σ2

σ2

32

Z ∞

1

2(x − µ)2 + y 2 /2

=

exp −

dy

2πσ 2 −∞

σ2

Z ∞

1

1

(x − µ)2

y2

√

= √

exp − 2

exp − 2 dy

σ /2

2σ

2πσ 2

2πσ 2 −∞

2 √

1

(x − µ)

= √

2

exp − 2

2

σ /2

2πσ

1

(x − µ)2

= p

exp − 2

σ /2

2πσ 2 /2

√

nämlich eine Gaußverteilung um µ mit Standardabweichung σ/ 2.

Exponentialverteilung

Die Exponentialverteilung ist das stetige Gegenstück zur geometrischen Verteilung im diskreten Fall. Dort hatten wir diskrete Plätze, auf jedem mit Wahrscheinlichkeit p eine 1 (Erfolg) und mit 1 − p eine 0 (Mißerfolg).

Betrachte nun die Gerade der reellen Zahlen, die wir in kleine Intervalle der

Länge dx einteilen. Wir nehmen an, daß in jedem mit der Wahrscheinlichkeit

ρ dx eine 1 und mit 1 − ρ dx eine 0 sitzt. Die 1er sind mit Dichte ρ gleichmäßig

verteilt.

Was ist nun die Wahrscheinlichkeitsdichte der Abstände zwischen zwei

1ern? Eine davon sitze am Punkt x0 . Die Wahrscheinlichkeit, daß die nächste im Intervall [x0 + x, x0 + x + dx] und dazwischen gar keine ist, ist

x/dx

ρx

x/dx

pρ (x) = (1 − ρ dx)

ρ dx = 1 −

ρ dx −→ ρ exp(−ρx) dx.

x/dx

(81)

n

(den Grenzübergang (1 + y/n) → exp y haben wir schon bei der Poissonverteilung kennengelernt.)

Exponentialverteilte Wartezeiten treten z.B. beim Öffnen und Schließen

von Ionenkanälen in Zellmembranen. Die reelle Zahlengerade ist hier die Zeitachse. Zu jedem Zeitpunkt ist das Ereignis “öffne/schließe dich jetzt” gleich wahrscheinlich. Die Wartezeiten dazwischen, also die Zeitspannen, die der Kanal

offen/geschlossen ist, sind daher exponentialverteilt.

Wir haben das simuliert

5

3

x 10

6

10

2.5

5

10

2

4

10

1.5

1

3

10

0.5

0

2

10

0

0.5

1

1.5

2

2.5

3

3.5

4

0

0.5

1

1.5

2

2.5

3

3.5

4

−5

−5

x 10

x 10

hier am Beispiel des Einheitsintervalls [0, 1], auf das N = 262144 Markierungen verteilt sind. Ihre Mittlere Dichte ist also ρ = N , und in einem kleinen

33

Stückchen der länge dx ist die Wahrscheinlichkeit, eine Markierung zu finden,

gleich ρ dx = N dx. Die Graphik zeigt die Verteilung der Wartezeiten, einmal

in einer linearen Darstellung (links), die einen schnellen Abfall nach 0 zeigt. In

halblogarithmischer Darstellung (rechts) wird aus dem exponentiellen Abfall

eine Gerade.

34