3. Zufallsvariable und Verteilungen

Werbung

3. Zufallsvariable und Verteilungen

Häufige Situation in der Praxis:

• Es interessiert nicht so sehr das konkrete Ergebnis ω ∈ Ω

eines Zufallsexperimentes, sondern eine Zahl, die von ω abhängt

Beispiele:

• Gewinn in Euro im Roulette

• Gewinn einer Aktie an der Börse

• Monatsgehalt einer zufällig ausgewählten Person

104

Intuitive Bedeutung einer Zufallsvariablen:

• Vorschrift, die das ’abstrakte’ ω in eine Zahl übersetzt

Begrifflichkeiten:

Deskriptive Statistik

Grundgesamtheit

Merkmal

Messwert

Wskt.-Rechnung

←→

Ergebnismenge

←→

Realisation

←→

Zufallsvariable

105

3.1 Grundbegriffe und Definitionen

Definition 3.1: (Zufallsvariable [kurz: ZV])

Unter einer Zufallsvariablen versteht man formal eine (mathematische) Funktion

X : Ω −→ R

ω −→ X(ω).

Bemerkungen:

• Eine Zufallsvariable ordnet jedem Ergebnis ω ∈ Ω eine reelle

Zahl zu

106

Zufallsvariable als Abbildung der Ergebnismenge auf die reelle Zahlenachse

(vgl. Schira, 2009, S. 258)

107

Bemerkungen: [I]

• Intuition:

Eine Zufallsvariable X charakterisiert eine Zahl, deren Wert

man noch nicht kennt

• Nach der Durchführung des Zufallsexperimentes realisiert sich

die Zufallsvariable X im Wert x

• x heißt die Realisation oder Realisierung der ZV X nach

Durchführung des zugehörigen Zufallsexperimentes

• In dieser VL:

Zufallsvariablen werden immer mit Großbuchstaben, Realisationen immer mit Kleinbuchstaben bezeichnet

108

Bemerkungen: [II]

• Die Zufallsvariable X beschreibt die Situation ex ante, d.h.

vor der tatsächlichen Durchführung des Zufallsexperimentes

• Die Realisation x beschreibt die Situation ex post, d.h. nach

der Durchführung des Zufallsexperimentes

• Wahrscheinlichkeitsaussagen kann man nur über die Zufallsvariable X treffen

• Für den Rest der VL sind Zufallsvariablen von zentraler Bedeutung

109

Beispiel 1:

• Betrachte den 1-maligen Münzwurf (Z=Zahl, K=Kopf). Die

ZV X bezeichne die ’Anzahl der Köpfe’ bei diesem Zufallsexperiment

• Es gilt:

Ω = {K, Z}

• Die ZV X kann 2 Werte annehmen:

X(Z) = 0,

X(K) = 1

110

Beispiel 2:

• Betrachte den 3-maligen Münzwurf. Die ZV X bezeichne

erneut die ’Anzahl der Köpfe’

• Es gilt:

K,

Z)}, . . . , (Z,

Z,

Z)}}

Ω = {(K,

K,

K)}, (K,

{z

|

{z

|

{z

|

=ω1

=ω2

=ω8

• Die Zufallsvariable X ist definiert durch

X(ω) = Anzahl der K in ω

• Offensichtlich:

X ordnet verschiedenen ω dieselbe Zahl zu, z.B.

X((K, K, Z)) = X((K, Z, K)) = X((Z, K, K)) = 2

111

Beispiel 3:

• Aus einer Personengruppe werde zufällig 1 Person ausgewählt.

Die ZV X soll den Erwerbsstatus der ausgewählten Person

bezeichnen

• Es gilt:

Ω = {’erwerbstätig’

|

{z

}, |’nicht erwerbstätig’

{z

}}

=ω1

=ω2

• Die ZV X kann definiert werden durch

X(ω1) = 1,

X(ω2) = 0

(Codierung)

112

Beispiel 4:

• Das Zufallsexperiment bestehe in der Messung des morgigen

Kurses einer bestimmten Aktie. Die ZV X bezeichne diesen

Aktienkurs

• Es gilt:

Ω = [0, ∞)

• X ist definiert durch

X(ω) = ω

113

Zwischenfazit:

• Die ZV X kann verschiedene Werte annehmen und zwar mit

bestimmten Wskt’en

Vereinfachende Schreibweise: (a, b, x ∈ R)

• P (X = a) ≡ P ({ω|X(ω) = a})

• P (a < X < b) ≡ P ({ω|a < X(ω) < b})

• P (X ≤ x) ≡ P ({ω|X(ω) ≤ x})

114

Frage:

• Wie kann man diese Wskt’en bestimmen und mit diesen rechnen?

Lösung:

• Die Berechnung solcher Wskt’en kann über die sogenannte

Verteilungsfunktion der ZV’en X erfolgen

Intuition:

• Die Verteilungsfunktion der ZV’en X charakterisiert die

Wahrscheinlichkeiten, mit denen sich die potenziellen Realisationen x auf der reellen Zahlenachse verteilen

(die sogenannte Verteilung der ZV’en X)

115

Definition 3.2: (Verteilungsfunktion [kurz: VF])

Gegeben sei die Zufallsvariable X. Unter der Verteilungsfunktion der ZV’en X (in Zeichen: FX ) versteht man die folgende

Abbildung:

FX : R −→ [0, 1]

x −→ FX (x) = P ({ω|X(ω) ≤ x}) = P (X ≤ x).

116

Beispiel: [I]

• Betrachte das Laplace-Experiment des 3-fachen Münzwurfes.

Die ZV X messe die ’Anzahl Kopf’.

• Zunächst gilt:

Ω = {(K,

K,

K)}, (K,

K,

Z)}, . . . , (Z,

Z,

Z)}}

{z

{z

{z

|

|

|

= ω1

= ω2

= ω8

• Für die Wskt’en der ZV X errechnet sich:

P (X

P (X

P (X

P (X

= 0)

= 1)

= 2)

= 3)

=

=

=

=

P ({(Z, Z, Z)}) = 1/8

P ({(Z, Z, K), (Z, K, Z), (K, Z, Z)}) = 3/8

P ({(Z, K, K), (K, Z, K), (K, K, Z)}) = 3/8

P ({(K, K, K)}) = 1/8

117

Beispiel: [II]

• Daraus ergibt sich die VF:

FX (x) =

0.000

0.125

0.5

0.875

1

für x < 0

für 0 ≤ x < 1

für 1 ≤ x < 2

für 2 ≤ x < 3

für x ≥ 3

Graph der Verteilungsfunktion

118

Bemerkungen:

• Es genügt (fast immer), lediglich die VF FX der ZV X zu

kennen

• Oft ist es in praxi gar nicht möglich, den Grundraum Ω oder

die explizite Abbildung X : Ω −→ R anzugeben

(jedoch kann man meistens die VF FX aus sachlogischen

Überlegungen heraus angeben)

119

Allgemeingültige Eigenschaften von FX :

• FX (x) ist monoton wachsend

• Es gilt stets:

lim FX (x) = 0

x→−∞

und

lim FX (x) = 1

x→+∞

• FX ist rechtsseitig stetig, d.h.

F (z) = FX (x)

lim

z→x X

z>x

(vgl. Eigenschaften der empirischen Verteilungsfunktion aus

der VL Statistik I)

120

Fazit:

• VF FX (x) der ZV’en X gibt Antwort auf die Frage

’Wie hoch ist die Wahrscheinlichkeit, dass X höchstens den

Wert x annimmt?’

Jetzt:

• Antwort auf die Frage

’Welchen Wert wird die ZV’e X mit einer vorgegebenen

Wahrscheinlichkeit p ∈ (0, 1) nicht überschreiten?’

−→ Quantilfunktion der ZV’en X

121

Definition 3.3: (Quantilfunktion)

Gegeben sei die ZV X mit VF FX . Für jeden reellen Wert p ∈

(0, 1) versteht man unter der Quantilfunktion von X (in Zeichen:

QX (p)) die folgende Abbildung:

QX : (0, 1) −→ R

p

−→ QX (p) = min{x|FX (x) ≥ p}.

Der Wert der Quantilfunktion xp = QX (p) heißt p − Quantil der

ZV’en X.

122

Bemerkungen:

• Das p-Quantil xp ist die kleinste Zahl x ∈ R mit der Eigenschaft, dass FX (x) den Wert p erreicht oder überschreitet.

• Interpretiert man p ∈ (0, 1) als eine Wahrscheinlichkeit, so ist

das p-Quantil xp die kleinste Realisation der ZV’en X, die X

mit Wskt. p nicht überschreitet.

Spezielle Quantile:

• Median: p = 0.5

• Quartile: p = 0.25, 0.5, 0.75

• Quintile: p = 0.2, 0.4, 0.6, 0.8

• Dezile: p = 0.1, 0.2, . . . , 0.9

123

Frage:

• Warum diese ’scheinbar komplizierte’ Definition?

Betrachte 3 Fälle:

• Stetige, streng monoton wachsende VF FX

• Stetige, teilweise konstante VF FX

• Rechtsseitig stetige Treppen-VF FX

124

Stetige, streng monoton wachsende Verteilungsfunktion

125

Stetige, teilweise konstante Verteilungsfunktion

126

Rechtsseitig stetige Treppen-Verteilungsfunktion

127

Jetzt:

• Typisierung von ZV’en

(diskrete vs. stetige ZV’en)

Grund:

• Unterschiedliche mathematische Methoden zur Behandlung

von ZV’en

• Bei diskreten ZV’en:

Endliche und unendliche Summen

• Bei stetigen ZV’en:

Differential- und Integralrechnung

128

Definition 3.4: (Diskrete Zufallsvariable)

Die ZV X heißt diskret, wenn sie entweder

1. nur endlich viele Realisationen x1, x2, . . . , xJ oder

2. abzählbar unendlich viele Realisationen x1, x2, . . .

mit streng positiver Wahrscheinlichkeit annehmen kann, d.h. falls

für alle j = 1, . . . , J, . . . gilt

P (X = xj ) > 0

und

J,...

X

P (X = xj ) = 1.

j=1

129

Typische diskrete Merkmale sind:

• Zählmerkmale (’X = Anzahl von . . .’)

• Codierte qualitative Merkmale

Definition 3.5: (Träger einer diskreten Zufallsvariablen)

Die Menge aller Realisationen, die eine diskrete ZV X mit streng

positiver Wskt. annehmen kann, heißt Träger von X (in Zeichen:

TX ):

TX = {x1, . . . , xJ }

bzw.

TX = {x1, x2, . . .}.

130

Definition 3.6: (Wahrscheinlichkeitsfunktion)

Für eine diskrete ZV X heißt die Funktion

fX (x) = P (X = x)

die Wahrscheinlichkeitsfunktion von X.

Bemerkungen: [I]

• Die Wahrscheinlichkeitsfunktion fX der ZV X nimmt nur für

die Elemente des Träger TX positive Werte an. Für Werte

außerhalb des Trägers, d.h. für x ∈

/ TX , gilt fX (x) = 0:

fX (x) =

(

P (X = xj ) > 0

0

für x = xj ∈ TX

/ TX

für x ∈

131

Bemerkungen: [II]

• Die Wahrscheinlichkeitsfkt. fX hat die Eigenschaften

fX (x) ≥ 0 für alle x

X

fX (xj ) = 1

xj ∈TX

• Für eine beliebige Menge B ⊂ R berechnet sich die Wskt. des

Ereignisses {ω|X(ω) ∈ B} = {X ∈ B} durch

P (X ∈ B) =

X

fX (xj )

xj ∈B

132

Beispiel: [I]

• Betrachte 3-fachen Münzwurf und X = ’Anzahl Kopf’

• Offensichtlich: X ist diskret mit dem Träger

TX = {0, 1, 2, 3}

• Die Wahrscheinlichkeitsfunktion ist gegeben durch

fX (x) =

P (X = 0) = 0.125

P (X = 1) = 0.375

P (X = 2) = 0.375

P (X = 3) = 0.125

0

für x = 0

für x = 1

für x = 2

für x = 3

/ TX

für x ∈

133

Beispiel: [II]

• Die Verteilungsfunktion ist gegeben durch (vgl. Folie 118)

FX (x) =

0.000

0.125

0.5

0.875

1

für x < 0

für 0 ≤ x < 1

für 1 ≤ x < 2

für 2 ≤ x < 3

für x ≥ 3

134

Wahrscheinlichkeits- und Verteilungsfunktion

135

Offensichtlich:

• Für die Verteilungsfunktion gilt

FX (x) = P (X ≤ x) =

X

{xj ∈TX |xj ≤x}

=P (X=xj )

z }| {

fX (xj )

Fazit:

• Die VF einer diskreten ZV’en X ist eine Treppenfunktion

mit Sprüngen an den Stellen xj ∈ TX . Die Sprunghöhe an

der Stelle xj beträgt

lim F (x) = P (X = xj ) = fX (xj ),

FX (xj ) − x→x

j

x<xj

d.h. die Sprunghöhe ist der Wert der Wskt.-Funktion

(Beziehung: Verteilungs- und Wahrscheinlichkeitsfunktion)

136

Jetzt:

• Definition von stetigen Zufallsvariablen

Intuition:

• Im Gegensatz zu diskreten ZV’en (vgl. Definition 3.4, Folie

129) sind stetige ZV’e solche, die überabzählbar viele Realisationen (z.B. jede reelle Zahl in einem Intervall) annehmen

können

Tatsächlich:

• Definition stetiger ZV’en komplizierter (technischer)

137

Definition 3.7: (Stetige ZV, Dichtefunktion)

Eine ZV X heißt stetig, wenn sich ihre Verteilungsfunktion FX

als Integral einer Funktion fX : R −→ [0, ∞) schreiben lässt:

FX (x) =

Z x

−∞

fX (t)dt

für alle x ∈ R.

Die Funktion fX (x) heißt Dichtefunktion [kurz: Dichte] von X.

Bemerkungen:

• Die VF FX einer stetigen ZV’en X ist (eine) Stammfunktion

der Dichtefunktion fX

• FX (x) = P (X ≤ x) ist gleich dem Flächeninhalt unter der

Dichtefunktion fX von −∞ bis zur Stelle x

138

Verteilungsfunktion FX und Dichte fX

fX(t)

P(X ≤ x) = FX(x)

x

t

139

Eigenschaften der Dichtefunktion fX :

1. Die Dichte fX ist niemals negativ, d.h.

fX (x) ≥ 0

für alle x ∈ R

2. Die Fläche unter der Dichte ist gleich 1, d.h.

Z +∞

−∞

fX (x)dx = 1

3. Wenn FX (x) differenzierbar ist, gilt

0 (x)

fX (x) = FX

140

Beispiel: (Gleichverteilung über [0, 10]) [I]

• Gegeben sei die ZV X mit Dichtefunktion

fX (x) =

(

0

0.1

, für x ∈

/ [0, 10]

, für x ∈ [0, 10]

• Berechnung der VF FX : [I]

Für x < 0 gilt:

FX (x) =

Z x

−∞

fX (t) dt =

Z x

−∞

0 dt = 0

141

Beispiel: (Gleichverteilung über [0, 10]) [II]

• Berechnung der VF FX : [II]

Für x ∈ [0, 10] gilt:

FX (x) =

Z x

=

Z 0

−∞

fX (t) dt

0 dt +

{z

| −∞

=0

}

Z x

0

0.1 dt

= [0.1 · t]x0

= 0.1 · x − 0.1 · 0

= 0.1 · x

142

Beispiel: (Gleichverteilung über [0, 10]) [III]

• Berechnung der VF FX : [III]

Für x > 10 gilt:

FX (x) =

Z x

=

Z 0

−∞

fX (t) dt

0 dt +

{z

| −∞

=0

= 1

}

Z 10

|0

0.1 dt +

{z

=1

}

Z ∞

0 dt

| 10{z }

=0

143

Verteilungsfunktion und Dichte der Gleichverteilung über [0, 10]

144

Jetzt:

• Wskt.’en für Intervalle, d.h. (für a, b ∈ R, a < b)

P (X ∈ (a, b]) = P (a < X ≤ b)

• Es gilt:

P (a < X ≤ b) = P ({ω|a < X(ω) ≤ b})

= P ({ω|X(ω) > a} ∩ {ω|X(ω) ≤ b})

= 1 − P ({ω|X(ω) > a} ∩ {ω|X(ω) ≤ b})

= 1 − P ({ω|X(ω) > a} ∪ {ω|X(ω) ≤ b})

= 1 − P ({ω|X(ω) ≤ a} ∪ {ω|X(ω) > b})

145

= 1 − [P (X ≤ a) + P (X > b)]

= 1 − [FX (a) + (1 − P (X ≤ b))]

= 1 − [FX (a) + 1 − FX (b)]

= FX (b) − FX (a)

=

Z b

=

Z b

−∞

a

fX (t) dt −

Z a

−∞

fX (t) dt

fX (t) dt

146

Intervall-Wahrscheinlichkeit mit den Grenzen a und b

fX(x)

P(a < X ≤ b)

a

b

x

147

Wichtiges Ergebnis für stetige ZV X:

P (X = a) = 0

für alle a ∈ R

Begründung:

P (X = a) = lim P (a < X ≤ b) = lim

b→a

=

Z a

a

Z b

b→a a

fX (x) dx

fX (x)dx = 0

Fazit:

• Die Wskt., dass eine stetige ZV X einen einzelnen Wert annimmt, ist immer Null!!

148

Punkt-Wahrscheinlichkeit bei stetiger ZV

fX(x)

a

b3

b2

b1

x

149

Vorsicht:

• Das bedeutet nicht, dass dieses Ereignis unmöglich ist

Konsequenz:

• Da bei stetigen ZV’en für alle a ∈ R stets P (X = a) = 0 gilt,

folgt für stetige ZV stets

P (a < X < b) = P (a ≤ X < b) = P (a ≤ X ≤ b)

= P (a < X ≤ b) = FX (b) − FX (a)

(Ob Intervalle offen oder geschlossen sind, spielt für die

Wskt.-Bestimmung bei stetigen ZV keine Rolle)

150

3.2 Erwartungswert und Varianz einer Zufallsvariablen

Jetzt:

• Beschreibung der Wskt.-Verteilung der ZV’en X durch bestimmte Kenngrößen

• In dieser VL lediglich Betrachtung von

Erwartungswert

Varianz

151

Zunächst:

• Der Erwartungswert einer ZV’en X ist eine Maßzahl für die

Lage der Verteilung

• Der Erwartungswert einer ZV’en X ähnelt in seiner Bedeutung dem arithmetischen Mittel einer Datenreihe

(vgl. deskriptive Statistik, VL Statistik I)

152

Wiederholung:

• Für eine gegebene Datenreihe x1, . . . , xn ist das arithmetische

Mittel definiert als

n

n

X

1

1 X

xi =

xi ·

x=

n i=1

n

i=1

• Jeder Summand xi · 1/n entspricht einem Datenpunkt × relativer Häufigkeit

Jetzt:

• Übertragung dieses Prinzips auf die ZV X

153

Definition 3.8: (Erwartungswert)

Der Erwartungswert der ZV’en X (in Zeichen: E(X)) ist definiert

als

E(X) =

X

xj · P (X = xj )

{xj ∈TX }

Z +∞

−∞

x · fX (x) dx

, falls X diskret ist

.

, falls X stetig ist

Bemerkungen: [I]

• Der Erwartungswert der ZV’en X entspricht also (in etwa)

der Summe aller möglichen Realisationen jeweils gewichtet

mit der Wskt. ihres Eintretens

154

Bemerkungen: [II]

• Anstelle von E(X) schreibt man häufig µX

• Anstelle der Formulierung ’Erwartungswert der ZV’en X’

sagt man häufig ’Erwartungswert der Verteilung von X’

• Es gibt ZV’en, die keinen Erwartungswert besitzen

(kein Gegenstand dieser VL)

155

Beispiel 1: (Diskrete ZV) [I]

• Man betrachte den 2-maligen Würfelwurf. Die ZV X stehe

für die (betragliche) Differenz der Augenzahlen. Man berechne

den Erwartungswert von X

• Zunächst ergibt sich als Träger der Zufallsvariablen

TX = {0, 1, 2, 3, 4, 5}

• Die Wahrscheinlichkeitsfunktion ist gegeben durch

fX (x) =

P (X = 0) = 6/36

P (X = 1) = 10/36

P (X = 2) = 8/36

P (X = 3) = 6/36

P (X = 4) = 4/36

P (X = 5) = 2/36

0

für x = 0

für x = 1

für x = 2

für x = 3

für x = 4

für x = 5

/ TX

für x ∈

156

Beispiel 1: (Diskrete ZV) [II]

• Als Erwartungswert ergibt sich

E(X) = 0 ·

6

10

8

6

4

2

+1·

+2·

+3·

+4·

+5·

36

36

36

36

36

36

70

=

= 1.9444

36

• Achtung:

In diesem Beispiel ist E(X) eine Zahl, die die ZV X selbst

gar nicht annehmen kann

157

Beispiel 2: (Stetige ZV)

• Es sei X eine stetige ZV mit der Dichte

x

, für 1 ≤ x ≤ 3

fX (x) =

4

0

, sonst

• Zur Berechnung des Erwartungswertes spaltet man das Integral auf:

E(X) =

Z +∞

=

Z 3 2

x

Z 1

Z 3

Z

+∞

x

x · fX (x) dx =

0 dx

0 dx +

x · dx +

4

−∞

3

−∞

1

1 1 3 3

dx = ·

·x

4 3

1 4

1

1

27 1

26

=

·

−

=

= 2.1667

4

3

3

12

158

Häufige Situation:

• Kenne ZV X mit Wskt.- oder Dichtefunktion fX

• Suche den Erwartungswert der transformierten ZV

Y = g(X)

159

Satz 3.9: (Erwartungswert einer Transformierten)

Gegeben sei die ZV X mit Wskt.- oder Dichtefunktion fX . Für

eine beliebige (Baire)Funktion g : R −→ R berechnet sich der

Erwartungswert der transformierten ZV Y = g(X) als

E(Y ) = E(g(X))

=

X

g(xj ) · P (X = xj )

{x ∈T }

j

X

Z +∞

−∞

g(x) · fX (x) dx

, falls X diskret ist

.

, falls X stetig ist

160

Bemerkungen:

• Alle Funktionen, die im VWL- und/oder BWL-Studium auftauchen, sind Baire-Funktionen

• Für den Spezialfall g(x) = x (die Identitätsfunktion) fällt der

Satz 3.9 mit der Definition 3.8 zusammen

161

Rechnen mit Erwartungswerten (Teil 1):

• Betrachte die (lineare) Transformation

Y = g(X) = a + b · X

mit a, b ∈ R

• Ist X stetig mit Dichtefunktion fX , so gilt:

E(Y ) = E(a + b · X) =

=

Z +∞

−∞

= a·

Z +∞

−∞

(a + b · x) · fX (x) dx

[a · fX (x) + b · x · fX (x)] dx

Z +∞

| −∞

fX (x) dx +b ·

{z

=1

= a + b · E(X)

}

Z +∞

| −∞

x · fX (x) dx

{z

=E(X)

}

162

Bemerkung:

• Der Erwartungswert ist ein linearer Operator, d.h.

E(a + b · X) = a + b · E(X)

für reelle Zahlen a, b ∈ R

(Spezialfälle: a = 0, b 6= 0 bzw. a 6= 0, b = 0)

163

Rechnen mit Erwartungswerten (Teil 2):

• Betrachte die aufgespaltene Funktion

Y = g(X) = g1(X) + g2(X)

• Ist X stetig mit Dichtefunktion fX , so gilt:

E(Y ) = E[g1(X) + g2(X)]

=

Z +∞

=

Z +∞

−∞

| −∞

[g1(x) + g2(x)] · fX (x) dx

g1(x) · fX (x) dx +

{z

=E[g1 (X)]

}

Z +∞

| −∞

g2(x) · fX (x) dx

{z

=E[g2(X)]

}

= E[g1(X)] + E[g2(X)]

164

Bemerkung:

• Für diskrete ZV’en sind die Herleitungen analog

Satz 3.10: (Zusammenfassung)

Es seien X eine beliebige ZV (stetig oder diskret), a, b ∈ R reelle

Zahlen und g1, g2 : R −→ R (Baire)Funktionen. Dann gelten die

folgenden Rechenregeln:

1. E(a + b · X) = a + b · E(X).

2. E[g1(X) + g2(X)] = E[g1(X)] + E[g2(X)].

165

Jetzt:

• Beschreibung des Streuungsverhaltens einer ZV X

Wiederholung aus deskriptiver Statistik:

• Für eine gegebene Datenreihe x1, . . . , xn ist die empirische

Varianz definiert durch

n

n

X

X

1

1

2

2

2

s =

(xi − x) =

(xi − x) ·

n i=1

n

i=1

• Jeder Summand entspricht der quadratischen Abweichung

des Datenpunktes xi vom arithmetischen Mittel x gewichtet

mit seiner relativen Häufigkeit

166

Definition 3.11: (Varianz, Standardabweichung)

Für eine beliebige stetige oder diskrete ZV X ist die Varianz

von X [in Zeichen: V (X)] definiert als die erwartete quadrierte

Abweichung der ZV von ihrem Erwartungswert E(X), d.h.

V (X) = E[(X − E(X))2].

Unter der Standardabweichung von X [in Zeichen: σ(X)] versteht man die (positive) Wurzel aus der Varianz, d.h.

q

σ(X) = + V (X).

167

Bemerkungen:

• Offensichtlich ist die Varianz von X ein Erwartungswert. Mit

g(X) = [X − E(X)]2 und Satz 3.9 (Folie 160) gilt für die

Varianz von X:

V (X) = E[g(X)]

=

X

2 · P (X = x )

[x

−

E(X)]

j

j

{xj ∈TX }

Z +∞

−∞

[x − E(X)]2 · fX (x) dx

, für diskretes X

, für stetiges X

• Es gibt ZV’en, die keine endliche Varianz besitzen

(nicht Gegenstand dieser VL)

168

Beispiel: (Diskrete ZV)

• Betrachte erneut den 2-maligen Münzwurf mit der ZV X

als (betraglicher) Differenz der Augenzahlen (vgl. Beispiel 1,

Folie 156). Für die Varianz gilt:

V (X) = (0 − 70/36)2 · 6/36 + (1 − 70/36)2 · 10/36

+ (2 − 70/36)2 · 8/36 + (3 − 70/36)2 · 6/36

+ (4 − 70/36)2 · 4/36 + (5 − 70/36)2 · 2/36

= 2.05247

169

Jetzt:

• Rechenregeln für Varianzen

Man beachte:

• Varianz ist per definitionem ein Erwartungswert

−→ Rechenregeln für Erwartungswerte anwendbar

Rechenregel 1: [I]

• Betrachte die (lineare) Transformation

Y = g(X) = a + b · X

mit a, b ∈ R

170

Rechenregel 1: [II]

• Es gilt

V (Y ) = V [g(X)]

= E[[g(X) − E(g(X))]2]

= E[[a + b · X − a − b · E(X)]2]

= E[b2 · [X − E(X)]2]

= b2 · E[[X − E(X)]2]

= b2 · V (X)

−→ Spezialfall: b = 0, a ∈ R (Varianz einer Konstanten)

V (a) = 0

171

Rechenregel 2:

• Vereinfachte Varianzberechnung:

V (X) = E[(X − E(X))2]

= E[X 2 − 2 · E(X) · X + [E(X)]2]

= E(X 2) − 2 · E(X) · E(X) + [E(X)]2

= E(X 2) − [E(X)]2

172

Übungsaufgabe:

• Berechnen Sie anhand dieser Formel die Varianz der stetigen

ZV’en X mit Dichte

x

, für 1 ≤ x ≤ 3

fX (x) =

4

0

, sonst

Satz 3.12: (Zusammenfassung)

Es seien X eine beliebige ZV (stetig oder diskret) sowie a, b ∈ R

reelle Zahlen. Es gelten die folgenden Rechenregeln:

1. V (X) = E(X 2) − [E(X)]2.

2. V (a + b · X) = b2 · V (X).

173

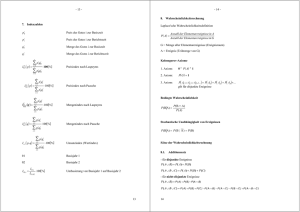

3.3 Spezielle diskrete Verteilungen

Jetzt:

• Einige wichtige diskrete Verteilungen:

Bernoulli-Verteilung

Binomial-Verteilung

Geometrische Verteilung

Poisson-Verteilung

174

1. Die Bernoulli-Verteilung

Ausgangssituation:

• Ein Zufallsexp. habe nur 2 interessierende Ausgänge:

Ω=A∪A

• Oft bezeichnet man das Ereignis A als Erfolg und A als Misserfolg oder Niete

Definition 3.13: (Bernoulli-Experiment)

Ein Zufallsexperiment, bei dem man sich nur dafür interessiert,

ob ein Ereignis A eintritt oder nicht, nennt man ein BernoulliExperiment.

175

Jetzt:

• Definiere die codierte ZV X als

X=

(

1

0

, falls A eintritt (Erfolg)

, falls A eintritt (Misserfolg)

Beispiele: [I]

• Das Geschlecht einer zufällig ausgewählten Person aus einer

Population:

X=

(

1

0

, falls die Person weiblich ist

, falls die Person männlich ist

176

Beispiele: [II]

• Eine Urne enthält insgesamt N Kugeln, von denen M rot und

N − M weiß sind. Betrachte das Experiment des 1-maligen

Ziehens einer Kugel:

X=

(

1

0

, falls die Kugel rot ist

, falls die Kugel weiß ist

Offensichtlich:

P (X = 1) =

M

≡p

N

P (X = 0) =

M

N −M

=1−

=1−p≡q

N

N

177

Definition 3.14: (Bernoulli-Verteilung)

Die ZV X repräsentiere ein Bernoulli-Experiment und für ein

festes p ∈ [0, 1] gelte

P (X = 1) = P (A) = p,

P (X = 0) = P (A) = 1 − p ≡ q.

Dann heißt die ZV X Bernoulli-verteilt mit Parameter (Erfolgswskt.) p und man schreibt X ∼ Be(p).

Berechnung des E-Wertes bzw. der Varianz:

• E(X) = 0 · (1 − p) + 1 · p = p

• V (X) = (0 − p)2 · (1 − p) + (1 − p)2 · p = p · (1 − p) = p · q

178

Wahrscheinlichkeits- und Verteilungsfunktion der Bernoulli-Verteilung

179

2. Die Binomial-Verteilung

Jetzt:

• Betrachte n gleichartige und unabhängig voneinander

durchgeführte Bernoulli-Experimente

(alle mit derselben Erfolgswahrscheinlichkeit p)

• Die ZV X bezeichne die Anzahl der Erfolge, d.h. der Träger

von X ist

TX = {0, 1, . . . , n}

Gesucht:

• Wskt. genau x Erfolge zu erzielen, d.h. P (X = x)

180

Herleitung:

• Bei

n unabhängigen Bernoulli-Experimenten gibt es genau

n

x Versuchsreihen, die exakt x Erfolge und gleichzeitig n − x

Misserfolge aufweisen

• Wegen der Unabhängigkeit der

Bernoulli-Experimente ist die

x · (1 − p)n−x

Wskt. jeder einzelnen dieser n

Versuchsreihen

p

x

• Wegen der Disjunktheit der n

x Versuchsreihen folgt für die

gesuchte Wskt.

P (X = x) =

n

x

· px · (1 − p)n−x

181

Definition 3.15: (Binomial-Verteilung)

Eine diskrete ZV X mit Träger TX = {0, 1, . . . , n} und Wahrscheinlichkeitsfunktion

n

P (X = x) =

· px · (1 − p)n−x für x = 0, 1, . . . , n,

x

heißt binomialverteilt mit den Parametern n und p [in Zeichen:

X ∼ B(n, p)].

Bemerkung:

• Die Bernoulli-Verteilung aus Definition 3.14 (Folie 178) ist

ein Spezialfall der Binomialverteilung, denn es gilt

X ∼ Be(p)

ist das gleiche wie

X ∼ B(1, p)

182

Beispiel: [I]

• Eine Urne enthält 10 Kugeln, davon 3 rote und 7 weiße. Es

werden 2 Kugeln mit Zurücklegen gezogen. Gesucht sind die

Wskt’en dafür, genau 0, 1 bzw. 2 rote Kugeln zu ziehen

• Es bezeichne X die Anzahl der gezogenen roten Kugeln.

Die Wskt. bei genau einem Zug eine rote Kugel zu ziehen,

beträgt p = 3/10 = 0.3

−→ X ∼ B(n = 2, p = 0.3)

183

Beispiel: [II]

• Berechung der Wskt. Funktion:

P (X = 0) =

P (X = 1) =

P (X = 2) =

2

0

2

1

2

2

· 0.30 · (1 − 0.3)2−0 = 0.49

· 0.31 · (1 − 0.3)2−1 = 0.42

· 0.32 · (1 − 0.3)2−2 = 0.09

E-Wert und Varianz einer Binomial-Verteilung:

• E(X) = n · p

• V (X) = n · p · (1 − p)

(Beweise: später mit Ergebnissen aus Kapitel 4)

184

Wahrscheinlichkeits- und Verteilungsfunktion der Binomial-Verteilung

185

3. Die Geometrische Verteilung

Ausgangssituation:

• Bernoulli-Experiment (Ausgänge A bzw. A, P (A) = p) kann

prinzipiell beliebig oft wiederholt werden

(gleichartige unabhängige Experimente)

Von Interesse:

• Zeitpunkt des 1. Erfolges, d.h. ZV

X = Anzahl der Experimente bis zum 1. Ausgang A

186

Offensichtlich:

• Träger von X ist TX = {1, 2, . . .} = N

Berechnung der Wskt.-Funktion:

P (X = 1) = p

P (X = 2) = (1 − p) · p = p · (1 − p)

P (X = 3) = (1 − p) · (1 − p) · p = p · (1 − p)2

...

Allgemein gilt:

x−1

=

p

·

−

p)

·p

(1

P (X = x) = (1

·

−

p)

.

.

.

·

(1

−

p)

{z

}

|

x−1 mal

187

Definition 3.16: (Geometrische Verteilung)

Eine diskrete ZV X mit Träger TX = N und der Wahrscheinlichkeitsfunktion

P (X = x) = p · (1 − p)x−1

für x ∈ N

heißt geometrisch verteilt mit Parameter p ∈ (0, 1) [in Zeichen:

X ∼ G(p)].

Bemerkung:

• Bei der Berechnung diverser Verteilungseigenschaften spielt

die unendliche geometrische Reihe eine Rolle, z.B.

∞

X

x=1

P (X = x) =

∞

X

x=1

p · (1 − p)x−1 = p ·

1

=1

1 − (1 − p)

188

Satz 3.17: (Kenngrößen der geometrischen Verteilung)

Die diskrete ZV X sei geometrisch verteilt mit Parameter p,

d.h. X ∼ G(p). Dann sind der Erwartungswert bzw. die Varianz

von X gegeben durch

E(X) =

∞

X

1

x−1

=

x · p · (1 − p)

∞

X

1−p

x−1

=

.

(x − 1/p) · p · (1 − p)

2

p

x=1

V (X) =

x=1

p

2

189

Beispiel: [I]

• Aus einer Urne mit 10 Kugeln (4 rote, 6 weiße) wird mit

Zurücklegen gezogen. Gesucht werden

1. die Wskt., dass bei der 3. Ziehung erstmalig eine rote

Kugel gezogen wird,

2. die Wskt., dass frühestens bei der 3. Ziehung erstmalig

eine rote Kugel gezogen wird,

3. der Erwartungswert für das erstmalige Ziehen einer roten

Kugel,

4. die Varianz für das erstmalige Ziehen einer roten Kugel.

190

Beispiel: [II]

• Betrachte ZV

X = Nummer der Ziehung, bei der erstmalig eine rote

Kugel gezogen wird

• Offensichtlich: X ∼ G(0.4). Damit gilt:

1. P (X = 3) = 0.4 · 0.62 = 0.144

2.

∞

X

x=3

P (X = x) = 1 − P (X = 1) − P (X = 2) = 0.36

3. E(X) = 1/0.4 = 2.5

4. V (X) = (1 − 0.4)/(0.42) = 3.75

191

3. Die Poisson-Verteilung

Häufiges Anwendungsgebiet:

• Warteschlangenmodelle, z.B. zur Modellierung von

Schlangen vor einem Bankschalter

Auftragsschlangen bei einem Internet-Server

In dieser VL:

• Keine sachlogische Herleitung, sondern nur

formale Definition

Angabe von Erwartungswert und Varianz

192

Definition 3.18: (Poisson-Verteilung)

Die diskrete ZV X mit dem Träger TX = {0, 1, . . .} = N ∪ {0} und

der Wahrscheinlichkeitsfunktion

µx

−µ

P (X = x) = e ·

für x = 0, 1, 2, . . .

x!

heißt Poisson-verteilt mit Parameter µ > 0 [in Zeichen: X ∼

P o(µ)].

Bemerkung:

• e bezeichnet die Eulersche Zahl und die Funktion ex die

natürliche Exponentialfunktion

(vgl. Abschnitt 2.2, VL Statistik I)

193

Satz 3.19: (Kenngrößen der Poisson-Verteilung)

Die diskrete ZV X sei Poisson-verteilt mit Parameter µ, d.h. X ∼

P o(µ). Dann sind der Erwartungswert bzw. die Varianz von X

gegeben durch

E(X) = µ

sowie

V (X) = µ.

194

Herleitungen: [I]

• Für den Erwartungswert gilt:

∞

X

∞

x

x

X

µ

µ

E(X) =

x · e−µ ·

= e−µ

x·

x!

x!

x=0

x=1

∞

X

x−1

µ

= e−µ

µ·

(x − 1)!

x=1

∞

x

X

µ

= µ · e−µ

x=0 x!

= µ · e−µ · eµ

= µ

195

Herleitungen: [II]

• Zur Bestimmung der Varianz berechnet man zunächst

E(X 2) =

∞

X

x=0

µx

2

−µ

x ·e ·

x!

= ...

= µ2 + µ

• Nach Satz 3.12(a) (vgl. Folie 173) folgt damit für die Varianz:

V (X) = E(X 2) − [E(X)]2 = µ2 + µ − µ2 = µ

196

3.4 Spezielle stetige Verteilungen

Jetzt:

• Drei bekannte stetige Verteilungen

Gleichverteilung

Exponentialverteilung

Normalverteilung

197

1. Die Gleichverteilung

Definition 3.20: (Gleichverteilung)

Die stetige ZV X heißt gleichverteilt über dem Intervall [a, b], a <

b, [in Zeichen: X ∼ U (a, b)], falls X die folgende Dichtefunktion

besitzt:

1

, falls a ≤ x ≤ b

fX (x) =

.

b−a

0

, sonst

198

Bemerkungen:

• Die ZV X auf Folie 141 ist gleichverteilt über dem Intervall

[0, 10], d.h. X ∼ U (0, 10)

• Die Gleichverteilung U (a, b) sinnvoll, falls X keinerlei Werte

zwischen a und b ’bevorzugt’ annimmt

• Die Verteilungsfunktion berechnet sich zu

0

Z x

x−a

fX (t) dt =

FX (x) =

b−a

−∞

1

, falls x < a

, falls a ≤ x ≤ b

, falls x > b

199

Dichte- und Verteilungsfunktion der Gleichverteilung über [a, b]

200

Satz 3.21: (E-Wert, Varianz)

Für die stetige, gleichverteilte ZV X ∼ U (a, b) sind Erwartungswert

und Varianz gegeben durch

E(X) =

Z +∞

V (X) =

Z +∞

−∞

x · fX (x) dx =

a+b

,

2

(b − a)2

.

[x − E(X)] · fX (x) dx =

12

−∞

2

201

2. Die Exponentialverteilung

Definition 3.22: (Exponentialverteilung)

Die stetige ZV X heißt exponentialverteilt mit Parameter λ > 0

[in Zeichen: X ∼ Exp(λ)], falls X die folgende Dichtefunktion

besitzt:

fX (x) =

(

0

λ · e−λ·x

, falls x < 0

.

, falls x ≥ 0

Bemerkung:

• Die Verteilungsfunktion berechnet sich zu

FX (x) =

Z x

−∞

fX (t) dt =

(

0

1 − e−λ·x

, falls x < 0

, falls x ≥ 0

202

Dichtefunktionen der Exponentialverteilung

fX(x)

4

3

λ=3

2

λ=2

1

λ=1

0

0.0

x

0.5

1.0

1.5

2.0

2.5

3.0

3.5

203

Verteilungsfunktionen der Exponentialverteilung

FX(x)

1.0

λ=1

0.8

λ=2

0.6

λ=3

0.4

0.2

0.0

0.0

0.5

1.0

1.5

2.0

2.5

3.0

3.5

x

204

Satz 3.23: (E-Wert, Varianz)

Für die stetige, exponentialverteilte ZV X ∼ Exp(λ) sind Erwartungswert und Varianz gegeben durch

E(X) =

Z +∞

V (X) =

Z +∞

−∞

x · fX (x) dx =

1

,

λ

1

[x − E(X)]2 · fX (x) dx = 2 .

λ

−∞

205

3. Die Normalverteilung

Einführende Bemerkungen: [I]

• Normalverteilung (auch Gaußverteilung) ist die wichtigste

Verteilung überhaupt

Praxis:

−→ Relevanz resultiert aus zentralem Grenzwertsatz

(vgl. Kapitel 4)

Theorie:

−→ Relevant für Entwicklung von Schätz- und Testverfahren

(vgl. Kapitel 5-7)

206

Einführende Bemerkungen: [II]

• Viele Phänomene lassen sich gut durch eine Normalverteilung

approximieren, z.B.

Biometrische Größen

(Körpergrößen, Gewicht etc.)

Ökonomische Größen

(Veränderungsraten)

Zufällige Fehler

(Messfehler, Produktionsfehler)

207

Definition 3.24: (Normalverteilung)

Die stetige ZV X heißt normalverteilt mit Parametern µ ∈ R

und σ 2 > 0 [in Zeichen: X ∼ N (µ, σ 2)], falls X die folgende

Dichtefunktion besitzt:

fX (x) = √

x−µ 2

1

−2 σ

1

·e

2π · σ

,

x ∈ R.

Bemerkungen:

• Die Parameter µ und σ 2 geben der Dichtefunktion ihre spezielle

Gestalt

• Die Normalverteilung N (0, 1) heißt Standardnormalverteilung.

Ihre Dichte wird oft mit ϕ(x) bezeichnet

208

Dichtefunktionen der Normalverteilung

fX(x)

N(5,1)

N(0,1)

N(5,3)

N(5,5)

0

5

x

209

Satz 3.25: (Eigenschaften der Normalverteilung) [I]

Es sei X ∼ N (µ, σ 2). Dann gilt:

1. Die Dichte fX (x) hat ihr einzige lokales Maximum an der

Stelle x = µ.

2. Die Dichte fX (x) ist symmetrisch um µ.

3. Die Dichte fX (x) besitzt Wendepunkte an den Stellen x =

µ + σ und x = µ − σ.

210

Satz 3.25: (Eigenschaften der Normalverteilung) [II]

4. Für Erwartungswert und Varianz von X gilt:

E(X) = µ

und

V (X) = σ 2.

5. Auch die linear transformierte ZV Y = a + b · X mit a, b ∈ R

ist normalverteilt mit Erwartungswert E(Y ) = a + b · µ und

Varianz V (Y ) = b2 · σ 2, d.h.

Y ∼ N (a + b · µ, b2 · σ 2).

211

Jetzt:

• Bestimmung der Verteilungsfunktion FX :

FX (x) = P (X ≤ x) =

Z x

=

Z x

−∞

fX (t) dt

t−µ 2

1

−2 σ

1

√

·e

−∞ 2π · σ

dt

Problem:

• Keine mathematisch geschlossene Lösung des Integrals

• VF’en können nur approximativ berechnet werden

(durch numerische Verfahren)

212

(Approximative) Verteilungsfunktionen der Normalverteilung

FX(x)

1

N(0,1)

N(5,5)

0.5

N(5,3)

N(5,1)

0

5

x

213

Bezeichnung:

• Die

Verteilungsfunktion

der

Standardnormalverteilung

wird oft mit Φ(x) bezeichnet, also

Φ(x) ≡ FX (x) = P (X ≤ x)

für X ∼ N (0, 1)

Zentrales Ergebnis:

• Für jede beliebige normalverteilte ZV X ∼ N (µ, σ 2) kann

die VF FX (x) = P (X ≤ x) auf die VF der Standardnormalverteilung zurückgeführt werden

214

Herleitung: [I]

• Für die VF von X ∼ N (µ, σ 2) gilt

FX (x) = P (X ≤ x) = P (X − µ)/σ ≤ (x − µ)/σ

|

{z

}

≡Y

• Nach Satz 3.25(e) folgt

1

X −µ

µ

=

Y =

·X −

σ

σ

σ

|{z}

|{z}

≡a

≡b

ist normalverteilt, und zwar

1

1

µ

2

2

2

Y ∼ N (a + b · µ, b · σ ) = N − + · µ, 2 · σ = N (0, 1)

σ

|

{z σ } |σ {z }

=0

=1

215

Herleitung: [II]

• Insgesamt gilt also für die ZV X ∼ N (µ, σ 2):

x − µ

FX (x) = P (X ≤ x) = P |{z}

Y

≤

=Φ

σ

∼N (0,1)

x−µ

σ

Beispiel: [I]

• Überdeckungswahrscheinlichkeiten bei der Normalverteilung

• Es seien X ∼ N (µ, σ 2) und k ∈ R eine reelle Zahl

• Gesucht: Wahrscheinlichkeit dafür, dass sich X im Intervall

[µ − k · σ, µ + k · σ] realisiert

216

Beispiel: [II]

• Es gilt:

P (µ − k · σ ≤ X ≤ µ + k · σ) = FX (µ + k · σ) − FX (µ − k · σ)

µ+k·σ−µ

= Φ

σ

µ−k·σ−µ

−Φ

σ

= Φ(k) − Φ(−k)

• Die VF Φ(x) der Standardnormalverteilung ist in allen StatistikLehrbüchern ausreichend tabelliert

(z.B. in Mosler/Schmid, 2008)

217

Beispiel: [III]

• Außerdem:

Φ(x) kann in allen statistischen Programmpaketen berechnet

werden

(z.B. in Excel, EViews, SPSS)

• Für k = 1, 2, 3 gilt:

k = 1 : Φ(1) − Φ(−1) = 0.6827

k = 2 : Φ(2) − Φ(−2) = 0.9545

k = 3 : Φ(3) − Φ(−3) = 0.9973

218

Überdeckungswahrscheinlichkeiten der Normalverteilung

F lä c h e n in h a lte :

1

1+2+4

1+2+3+4+5

1

5

µ−3σ

4

µ−2σ

3

2

µ−σ

µ

µ+σ

: 0 .6 8 2 7

: 0 .9 5 4 5

: 0 .9 9 7 3

µ+2σ

µ+3σ

219