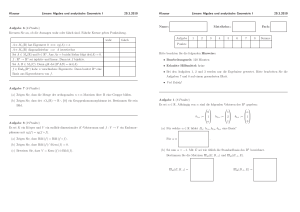

Lineare Algebra und Geometrie 1 - BFH

Werbung

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Lineare Algebra und Geometrie 1

4 ECTS

Inhalt

Themen

Seite

Vektorgeometrie2

I

II

I.1 Das Vektorprodukt

2

I.2 Anwendungen

4

Formelsammlung

Papula1

Lineare Algebra

II.1 Lineare Gleichungssysteme, der Gauss-Algorithmus

7

VII 3.1 - 3.2, 3.4

II.2 Matrizen und Determinanten

10

VII 1.1 - 1.5, 2.1 - 2.6

II.3 Die Cramersche Regel

15

VII 3.5

II.4 Homogene lineare Gleichungssysteme, lineare (Un-)Abhängigkeit 16

III

Komplexe Zahlen

III.1 Definition, Rechenoperationen mit komplexen Zahlen

18

VIII 1 - 4

III.2 Polynome, komplexe Nullstellen

21

VIII 4

III.3 Eulerformel, Exponentialform

25

VIII 1, 8

IV.1 Erweiterung der reellen Funktionen

27

VIII 3-5, 7

IV.2 Komplexe Funktionen einer reellen Variablen, Ortskurven

28

VIII 6

IV.3 Abbildungen der komplexen Ebene, insbesondere Inversion

32

VIII 6.3

IV

Komplexwertige Funktionen

1

Lothar Papula: Mathematische Formelsammlung für Ingenieure und Naturwissenschaftler,

Viewegs Fachbücher der Technik (wird auch in den andern Mathematikmoduln verwendet)

2

Bemerkung: Vektorgeometrie bis und mit Skalarprodukt sowie Trigonometrie gehören zum

Berufsmaturstoff und werden deshalb hier vorausgesetzt; eine Aufarbeitung dieses Stoffes wird in der

fakultativen Übungsserie „Repetition Berufsmaturstoff Mathematik“ angeboten (siehe

https://prof.hti.bfh.ch/baw2 ).

1

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

I

Vektorgeometrie

I.1

Das Vektorprodukt

HS 2011 / baw2

Wenn wir in unserem dreidimensionalen Anschauungsraum ein festes rechtwinkliges Koordinatensystem einführen, können wir jeden Punkt x in bekannter Weise durch ein Zahlentripel (x1, x2, x3)

charakterisieren. Wir schreiben dabei einfach x = (x1, x2, x3). Statt des Punktes x können wir aber

⎡ x1 ⎤

r

auch seinen Ortsvektor x = ox = ⎢ x 2 ⎥ betrachten, was noch nützlicher ist, weil für Vektoren

⎢x ⎥

⎣ 3⎦

Rechenoperationen definiert sind. Es ist aber wichtig, Punkte und Vektoren zu unterscheiden, weil

sich sonst leicht Missverständnisse ergeben. Wir wollen uns nicht auf den dreidimensionalen Raum

n

beschränken und definieren daher den n-dimensionalen reellen Raum R als Menge aller n-Tupel

r ⎡ x1 ⎤

x = (x1,…, xn) von reellen Zahlen, und wir nennen auch hier x = ⎢ : ⎥ den Ortsvektor von x. Während

⎢x n ⎥

⎣ ⎦

n

das Ihnen bereits bekannte Skalarprodukt von zwei Vektoren auch im R definiert ist (Summe der

Produkte entsprechender Komponenten), ist das in diesem Kapitel einzuführende Vektorprodukt eine

Spezialität des 3-dimendionalen Raumes, also nur im Fall n = 3 definiert, und zwar wie folgt:

r

⎧⎪Betrag : ar b sin( Zwischenwi nkel)

r r

a × b = Vektor ⎨

r

r

⎪⎩Richtung : senkrecht auf a und b in Rechtsschraubenricht ung

Zur Erläuterung: Man denke sich die beiden Vektoren im gleichen Punkt befestigt und betrachte das

r r

von ihnen aufgespannte Parallelogramm. Der Betrag von a × b kann dann als Flächeninhalt dieses

Parallelogramms gedeutet werden. Eine senkrecht in diese Fläche eingeschraubte Rechtsschraube

r r

r

bewegt sich in der Richtung von a × b , wenn man sie so dreht, dass der (mitgedrehte) Vektor a sich

r

b annähert.

r r

a ×b

Vektorprodukt

r

b'

ϕ

r

b

r

b sin(ϕ)

r

a

Wenn einer der Vektoren der Nullvektor ist, oder wenn einer ein Vielfaches des andern ist (kurz: wenn

r r r

die beiden linear abhängig sind), dann (und nur dann) ist a × b = 0 . Man kann also mit dem

2

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Vektorprodukt testen, ob zwei Vektoren linear abhängig sind, ähnlich wie man mit dem Skalarprodukt

testet, ob sie senkrecht zueinander sind.

Um mit dem Vektorprodukt arbeiten zu können, brauchen wir Rechenregeln, vor allem eine Formel,

die gestattet, das Vektorprodukt aus den Komponenten der Faktoren zu berechnen. Zunächst ist aus

der Definition unmittelbar ersichtlich, dass

r r

r r

a ×b = −b × a

(Antikommutativgesetz)

r r r

Das Vektorprodukt ist also nicht kommutativ! Ebenso gilt das Assoziativgesetz nicht, d.h. a × (b × c )

r r r

und (a × b ) × c sind i. A. nicht gleich. Können Sie ein Beispiel angeben? Bezüglich Streckung mit

Skalarfaktoren λ verhält sich das Vektorprodukt jedoch verträglich, wie man leicht nachprüft:

r

r

r r

r r

a × λb = λ(a × b) = λa × b

Eine wichtige Regel ist das Ausmultiplizieren bzw. Ausklammern

r r r

r r r r

a × (b + c ) = a × b + a × c

r r r r r r r

(a + b) × c = a × c + b × c

(Distributivgesetze)

Wegen der Antikommutativität genügt es, das erste zu beweisen. Dazu zerlegen wir den Übergang

r

r r

r

von einem beliebigen Vektor b zu a × b (wobei a fest), in drei Teilschritte:

r

r

r

1. Senkrechte Projektion von b auf die zu a senkrecht Ebene (Vektor b' in der Figur)

r

2. in dieser Ebene: Drehung 90°, diesmal bezüglich a als Rechtsschraube

r

3. Streckung mit Faktor a

Jeder dieser Teilschritte kann bei einer Summe von Vektoren summandenweise angewendet werden,

was folglich auch für die Gesamtoperation gilt; dies ist aber gerade das Distributivgesetz.

Damit können wir nun schon die Komponentenformel herleiten. Wir schreiben

⎡ 1⎤

⎡0⎤

⎡0⎤

r ⎡ a1 ⎤

r

r

r r

a = ⎢a 2 ⎥ = a1 ⎢0⎥ + a 2 ⎢ 1⎥ + a 3 ⎢0⎥ = a1e 1 + a 2 e 2 + a 3 e 3 , b analog, und erhalten mit den bisherigen

⎢a ⎥

⎢⎣0⎥⎦

⎢⎣0⎥⎦

⎢⎣ 1⎥⎦

⎣ 3⎦

3 3

r r

r r

Rechenregeln a × b = ∑ ∑ a ib j e i × e j . Die Produkte der Einheitsvektoren sind leicht zu berechnen, da

i =1 j =1

r r r

r

r

r r

r r

sie senkrecht aufeinander stehen und Länge 1 haben: e1 × e1 = 0 , e1 × e 2 = e 3 , e 2 × e1 = −e 3 , etc.

r r

r

r

r

Somit ergibt sich a × b = (a 2b 3 − a 3b 2 )e1 + (a 3b1 − a1b 3 )e 2 + (a1b 2 − a 2b1 )e 3 , d.h.

⎡ a1 ⎤ ⎡ b1 ⎤ ⎡ a 2b 3 − a 3b 2 ⎤

⎢a 2 ⎥ × ⎢b 2 ⎥ = ⎢− (a1b3 − a3b1 )⎥

⎢a ⎥ ⎢b ⎥ ⎢ a b − a b ⎥

2 1 ⎦

⎣ 3⎦ ⎣ 3⎦ ⎣ 1 2

Die Schreibweise in der mittleren Komponente wurde so gewählt, weil man alle 3 Komponenten

⎡ a1 b1 ⎤

zunächst als Unterdeterminante der Matrix ⎢a 2 b 2 ⎥ berechnen kann (vgl. Abschnitt II.2), mit

⎢a b ⎥

⎣ 3 3⎦

anschliessendem Vorzeichenwechsel in der mittleren Komponente.

r r v

r r v

In Anwendungen kommen häufig auch Produkte von 3 Vektoren vor, z. B. (a × b ) × c und (a × b) • c

r r

r

( • = Skalarprodukt). Das erste ist ein Vektor, der senkrecht zu a × b steht und somit in der von a und

r

r

r

b aufgespannten Ebene liegt, also eine Linearkombination von a und b sein muss. Mit Hilfe der

Komponentenformel kann man sich davon überzeugen, dass

3

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

r v r r v r

r r v

(a × b) × c = −(b • c )a + (a • c )b

r r v

Das Produkt (a × b ) • c ist eine Zahl; es ist auch unter dem Namen Spatprodukt bekannt, weil der

r r v

r r v

Betrag dieser Zahl das Volumen des von a, b, c aufgespannten Spates (Parallelflächner; falls a, b, c

r

r

senkrecht zueinander sind: Quader) ist. Wenn man das von a und b aufgespannte Parallelogramm

als Grundfläche des Spates betrachtet, ist die Höhe gleich (eventuell mit falschem Vorzeichen) der

r

r r

v

1 r r

Projektion von c auf a × b , also gleich ( r r (a × b)) • c , das Volumen daher

a ×b

r r v

r r

v

1 r r

a × b ⋅ ( r r (a × b)) • c = (a × b) • c . Die Berechnung des Spatproduktes in Komponenten ergibt

a ×b

⎡ a1 b1

r r r

(a × b) • c = (a 2b 3 − a 3b 2 )c 1 − (a1b 3 − a 3b1 )c 2 + (a1b 2 − a 2b1 )c 3 = det( ⎢a 2 b 2

⎢a b

3

⎣ 3

c1 ⎤

c 2 ⎥)

c 3 ⎥⎦

(Determinanten werden in Abschnitt II.2 eingeführt.)

I.2

Anwendungen

Anwendungen in der Geometrie

r r

1 r r

(b − a ) × (c − a )

2

1)

F=

2)

Abstand d des Punktes p von der Geraden durch a und b:

r r

r r

(p − a ) × (b − a )

d=

r r

b−a

Abstand d des Punktes p von der Ebene durch a, b und c:

r r

r r

r r

((b − a ) × (c − a )) • (p − a )

d=

r r

r r

(b − a ) × (c − a )

Fläche F des Dreiecks mit den Ecken a, b, c:

r r

Bemerkung: b − a ist der Verbindungsvektor von a nach b.

3)

4)

r r

r

r r

Koordinatengleichung der Ebene durch a, b und c:

Der Vektor n = (b − a ) × (c − a ) ist ein

Normalenvektor der Ebene, ihre Koordinatengleichung ist also n1x1 + n2 x 2 + n3 x 3 = d , wo d

noch zu bestimmen ist (z.B. indem man einen der gegebenen Punkte einsetzt).

V=

r r

r r

r r

((b − a ) × (c − a )) • (d − a )

5)

Volumen V des Tetraeders mit den Ecken a, b, c, d:

6)

r r

r r

r r

((b − a ) × (d − c )) • (c − a )

Abstand s der Geraden durch a, b von der Geraden durch c, d: s =

.

r r

r r

(b − a ) × (d − c )

6

Wenn der Nenner in dieser Formel 0 ist, sind die beiden Geraden parallel. In diesem Fall ist

r r

r r

(b − a ) × (c − a )

(gemäss 2)).

der Abstand s =

r r

b−a

4

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Die meisten dieser Formeln sind aufgrund der geometrischen Bedeutung der vorkommenden Vektorund Spatprodukte rasch klar (machen Sie jeweils eine Skizze!), ausser vielleicht 6): Hier beachte

r r

man, dass der Vektor c − a ein Verbindungsvektor der beiden Geraden ist und folglich s die

r r

r r

Projektion dieses Vektors auf den zu beiden Geraden senkrechten Vektor (b − a ) × (d − c )

Anwendungen in der Physik

1)

r

Drehmomente: Greift eine Kraft K in einem Punkt p eines Körpers an, so übt sie bezüglich

r

r

r r

eines fest gewählten Punktes p0 das polare Drehmoment Dp 0 = (p − p 0 ) × K aus („Hebelarm x

r

Kraft“). Ist der Körper um eine feste Achse a durch p0 mit Richtungsvektor a drehbar, so ist

r

r

r

r r

a

das axiale Drehmoment Da = ((p − p 0 ) × K ) • r von Interesse (die Projektion von Dp0 auf die

a

Achse). Überlegen Sie, dass man p0 auch durch einen andern Punkt auf der Achse ersetzen

kann, ohne dass sich das axiale Drehmoment ändert.

2)

Corioliskraft: Infolge der Drehung der Erde um sich selbst hat jeder Punkt der Erdoberfläche

eine gewisse Ostgeschwindigkeit. So auch wir, aber solange wir uns relativ zu unserer

Umgebung nicht bewegen, merken wir nichts davon. Bewegen wir uns jedoch z. B. auf der

Nordhalbkugel gegen Norden, so kommen wir in Gebiete mit kleinerer Ostgeschwindigkeit.

Wollen wir den Nordkurs beibehalten, müssen wir also die Ostgeschwindigkeit abbremsen,

wozu eine Führungskraft (ausgeübt von Schiene, Strasse, …) nötig ist. Fehlt diese

Führungskraft, so weichen wir nach Osten ab und erklären uns diese Abweichung als Folge

einer Kraft, der Corioliskraft. Die Berechnung dieser Kraft bzw. der entsprechenden

Beschleunigung ist ein rein mathematisches Problem, das wir aber hier nicht angehen

können. Statt dessen geben wir einfach das Resultat an:

r

r r

C = −2m(ω × v )

r

Dabei ist v die Relativgeschwindigkeit des betrachteten Körpers bezüglich seiner Erdr

Umgebung, m seine Masse, und ω die vektorielle Winkelgeschwindigkeit der Erddrehung,

r

d.h. die Richtung von ω ist die Richtung der Erdachse (vom Süd- zum Nordpol) und der

2π

Betrag ist ungefähr ω ≈

≈ 72.7 ⋅ 10 − 6 [s −1] .

24 ⋅ 60 ⋅ 60

Für einen Körper, der sich gegen Norden bewegt, ergibt diese Formel auf der Nordhalbkugel

tatsächlich eine nach Osten gerichtete Kraft, auf der Südhalbkugel jedoch gegen Westen;

r

direkt auf dem Äquator ist sie Null. Für einen fallenden Körper ( v Richtung Erdmittelpunkt)

ergibt sich auf der ganzen Erdoberfläche eine gegen Osten gerichtete Kraft (am grössten über

dem Äquator, über den Polen Null), was ebenfalls mit der Anschauung übereinstimmt. Um

quantitative Berechnungen machen zu können, führen wir ein Koordinatensystem ein, dessen

x-Achse horizontal nach Osten zeigt, die y-Achse horizontal nach Norden, und die z-Achse

vertikal nach oben (Zenit), mit Nullpunkt an dem Ort. wo sich der Körper gerade befindet.

N

r

ω

y ψ

z

ψ

Zerlegung der Winkelgeschwindigkeit

S

5

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

⎤

0

r ⎡

In diesem Koordinatensystem ist ω = ⎢ω cos( ψ )⎥ , wo ψ die geographische Breite bedeutet

⎢ ω sin( ψ ) ⎥

⎣

⎦

(vgl. Figur).

r ⎡v O ⎤

Mit v = ⎢ v N ⎥

⎢v ⎥

⎣ Z⎦

wird

⎡ 0 ⎤ ⎡v O ⎤

r

C = −2mω ( ⎢cos( ψ )⎥ × ⎢ v N ⎥ ) = 2mω

⎢ sin( ψ ) ⎥ ⎢ v ⎥

⎦ ⎣ Z⎦

⎣

⎡v N sin( ψ ) − v Z cos( ψ )⎤

⎢

⎥.

− v O sin( ψ )

⎢

⎥

v

cos(

)

ψ

O

⎣

⎦

Spezialfälle:

⎡v N sin( ψ )⎤

⎥ (Richtung Ost bzw. West)

⎢

0

⎥

⎢

0

⎦

⎣

⎡− v Z cos( ψ )⎤

r

r ⎡0⎤ r

⎥ (Richtung Ost)

v = ⎢ 0 ⎥ ( v Richtung Erdmittelpunkt, vZ negativ) ⇒ C = 2mω ⎢

0

⎥

⎢

⎢⎣v Z ⎥⎦

0

⎦

⎣

⎡ v N sin(ψ ) ⎤

r

r ⎡v O ⎤ r

v = ⎢ v N ⎥ ( v horizontal) ⇒ C = 2mω ⎢− v O sin( ψ )⎥

⎢0⎥

⎢ v cos( ψ ) ⎥

⎦

⎣ O

⎣ ⎦

r

Im letzten Fall interessiert uns vor allem die Horizontalkomponente von C . Diese ist

⎡ vN ⎤

⎡ v N sin(ψ ) ⎤

r

r

Chor = 2mω ⎢− v O sin(ψ )⎥ = 2mω sin(ψ ) ⎢− v O ⎥ , also senkrecht zu v , mit Betrag

⎢ 0 ⎥

⎥

⎢

0

⎦

⎣

⎦

⎣

r

r

r

Chor = 2m ω sin(ψ ) v , unabhängig von der Richtung von v . Auf der Nordhalbkugel

r

(sin(ψ) > 0) zeigt sie von v aus gesehen nach rechts, auf der Südhalbkugel nach links. Wenn

nun bei einem Tiefdruckgebiet auf der Nordhalbkugel die Luft von allen Seiten nach innen

strömt, wird sie überall nach rechts abgelenkt, was schliesslich einen im Gegenuhrzeigersinn

kreisenden Wirbel ergibt, auf der Südhalbkugel jedoch im Uhrzeigersinn. Die Behauptung,

dass man dasselbe in einem Lavabo oder einer Badewanne beobachten könne, ist allerdings

ein Märchen; statistische Untersuchungen haben keinen Unterschied zwischen Nord- und

Südhalbkugel gezeigt. Dies ist auch verständlich: Die Corioliskraft ist in diesem Fall viel zu

klein und ihre Einwirkungszeit viel zu kurz, um einen messbaren Effekt zu erzeugen. Die

Wirbel im Lavabo entstehen durch Unregelmässigkeiten in der Form des Lavabos oder einen

bereits vorhandenen Drehimpuls des Wassers bei Beginn des Abflussvorganges.

r

r ⎡0⎤ r

v = ⎢v N ⎥ ( v Richtung Nord, vN positiv,) ⇒ C = 2m ω

⎢0⎥

⎣ ⎦

3)

r

Lorentzkraft: Auf ein Teilchen mit der Ladung q, das sich mit Geschwindigkeit v in einem

r

r

r

r

Magnetfeld mit Flussdichte B bewegt, wirkt die Lorentzkraft K = q( v × B) .

6

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

II

Lineare Algebra

II.1

Lineare Gleichungssysteme, der Gauss-Algorithmus

Einleitung

Eine lineare Gleichung in einer Unbekannten, a x = b, hat die Lösung x = b/a, falls a ≠ 0. Falls jedoch

a = 0, gibt es zwei Fälle: Falls b ≠ 0, hat die Gleichung keine Lösung (weil 0 x = 0); falls b = 0, ist jede

reelle Zahl Lösung, die Lösungsmenge also R.

Eine lineare Gleichung in zwei Unbekannten, a1x1 + a2x2 = b, hat als Lösungsmenge (d.h. die Menge

2

aller Punkte (x1, x2), welche die Gleichung erfüllen) bekanntlich eine Gerade im R , falls a1, a2 nicht

beide 0 sind. Ist z.B. a1 ≠ 0, so können wir x2 frei wählen und schreiben dafür x2 = t, und x1 muss dann

x1 = (b – a2 t)/a1 sein. Wir können dann den Ortsvektor jedes Lösungspunktes in der Form

⎡ x1 ⎤ ⎡b / a1 ⎤ ⎡− a 2 / a1 ⎤

⎢⎣ x 2 ⎥⎦ = ⎢⎣ 0 ⎥⎦ + t ⎢⎣ 1 ⎥⎦

(t frei)

schreiben. Dies ist eine „Parameterdarstellung“ der Lösungsgerade. Ist a1 = 0 (oder auch nicht), aber

a2 ≠ 0, erhalten wir auf die gleiche Art

⎡ x1 ⎤ ⎡ 0 ⎤ ⎡ 1 ⎤

⎢⎣ x 2 ⎥⎦ = ⎢⎣b / a 2 ⎥⎦ + t ⎢⎣− a1 / a 2 ⎥⎦

Sind a1, a2 beide 0, müssen wir wieder die Fälle b ≠ 0 und b = 0 unterscheiden. Im Fall b = 0 sind alle

2

Punkte (x1, x2) Lösungen, d.h. die Lösungsmenge ist die ganze Ebene R ; im Fall b ≠ 0 hat die

Gleichung keine Lösungen, d.h. die Lösungsmenge ist die leere Menge {}.

Zum besseren geometrischen Verständnis bemerken wir noch, dass in jedem der oberen Fälle der

⎡a ⎤

Vektor ⎢ 1 ⎥ senkrecht auf dem Richtungsvektor der Gerade steht (Skalarprodukt = 0), also ein

⎣a 2 ⎦

„Normalenvektor“ der Geraden ist.

Der Fall einer linearen Gleichung in 3 Unbekannten, a1x1 + a2x2 + a3x3 = b, kann ganz analog

⎡ a1 ⎤

behandelt werden. Wenn a1, a2, a3 nicht alle 0 sind (also der Vektor ⎢a 2 ⎥ nicht der Nullvektor ist), ist

⎢a ⎥

⎣ 3⎦

3

die Lösungsmenge eine Ebene im R ; im Fall a1 ≠ 0 z. B. ist

⎡ x1 ⎤ ⎡b / a1 ⎤

⎡− a 2 / a1 ⎤

⎢x 2 ⎥ = ⎢ 0 ⎥ + s ⎢ 1 ⎥ + t

⎢x ⎥ ⎢ 0 ⎥

⎢ 0 ⎥

⎣ 3⎦ ⎣

⎦

⎣

⎦

⎡− a3 / a1 ⎤

⎢ 0 ⎥

⎢ 1 ⎥

⎦

⎣

(s, t frei)

⎡ a1 ⎤

eine Parameterdarstellung dieser Ebene; wiederum ist ⎢a 2 ⎥ ein Normalenvektor der Ebene. (Prüfen

⎢a ⎥

⎣ 3⎦

Sie, dass das Skalarprodukt mit den beiden Richtungsvektoren 0 ist!). Wenn a1 = a2 = a3 = 0, ist die

3

Lösungsmenge R (falls b = 0) oder {} (falls b ≠ 0).

Der Fall einer linearen Gleichung mit mehr als 3 Unbekannten kann rechnerisch ebenfalls ganz

analog behandelt werden, nur dass wir im Fall n > 3 keine geometrische Vorstellung zur Verfügung

haben.

7

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Wir gehen jetzt zu Systemen von linearen Gleichungen (m Gleichungen, n Unbekannte) über. Unter

n

der Lösungsmenge eines solchen Systems versteht man die Menge aller Punkte (x1, …, xn) im R , die

alle Gleichungen des Systems erfüllen. Dies ist mengentheoretisch die Schnittmenge der

Lösungsmengen der einzelnen Gleichungen. Betrachten wir als Beispiel den Fall n = 3 (also 3

3

Unbekannte). Aufgrund des oben Gesagten kann die Lösungsmenge nur R , eine Ebene, eine

Gerade, einpunktig oder {} sein. Die Schnittmenge von zwei Ebenen ist normalerweise eine Gerade,

kann aber auch eine Ebene oder {} sein. Die Schnittmenge von drei Ebenen ist normalerweise

einpunktig, kann aber auch eine Ebene oder Gerade oder {} sein. Letzteres kann auch dann eintreten,

wenn keine zwei der drei Ebenen parallel sind, aber die Schnittgerade von zwei Ebenen parallel zur

dritten Ebene ist. Wir sehen, dass schon im Fall n = 3 eine grosse Vielfalt von Fällen auftritt, sodass

ein systematisches Vorgehen nötig ist.

Der Gauss-Algorithmus

Ein lineares Gleichungssystem (m Gleichungen, n Unbekannte)

a11x1 + a12x2 + … + a1nxn = b1

a21x1 + a22x2 + … + a2nxn = b2

:

:

am1x1 + am2x2 + … + amnxn = bm

wird nach Gauss durch eine Folge von Äquivalenz-Umformungen (d. h. Umformungen, welche die

Lösungsmenge L nicht verändern, siehe weiter unten), auf Zeilenstaffelform (row echelon form)

gebracht. Dies bedeutet, dass für jede Gleichung gilt:

Ist xk die erste in dieser Gleichung (mit einem von 0 verschiedenen Koeffizienten) vorkommende

Unbekannte, so enthalten alle folgenden Gleichungen diese Unbekannte nicht mehr. Der Koeffizient

von xk in dieser Gleichung heisst Pivot von xk . Unbekannte mit Pivot nennt man gebunden,

Unbekannte ohne Pivot nennt man frei. Das Gleichungssystem hat dann also folgende Gestalt:

c1pxp + …

c2qxq + …

= d1

= d2

:

Hier sind p < q < … die Nummern der gebundenen Unbekannten. Am Ende des Systems können

dabei auch Gleichungen auftreten, die keine Unbekannten mehr enthalten. Diese sind von der Form

0 =d

Hier entscheidet sich, ob das System überhaupt Lösungen hat: Gibt es auch nur eine einzige solche

Gleichung mit einem d ≠ 0, so hat das System keine Lösung. Andernfalls hat es Lösungen, und die

Lösungsmenge lässt sich wie folgt bestimmen:

Die freien Unbekannten werden als Variable betrachtet („Parameter“ der Lösungsmenge). Die

gebundenen Unbekannten kann man durch „Rückwärts-Einsetzen“ in der Reihenfolge … q, p

ausrechnen:

…;

xq = 1/c2q·(d2 − …);

xp = 1/c1p·(d1 − …)

Dabei werden in … jeweils die schon berechneten bzw. freien Unbekannten mit grösserer Nummer

eingesetzt. Fasst man alle Unbekannten in einen Vektor zusammen, so erhält man den Ortsvektor

eines Punktes (wenn es keine Parameter gibt) oder eine Parameterdarstellung einer Geraden (wenn

es genau einen Parameter gibt) oder einer Ebene (wenn es genau zwei Parameter gibt), usw., alles

im n-dimensionalen Raum.

Jetzt müssen wir noch den Reduktionsprozess beschreiben, der das System auf Zeilenstaffelform

bringt. Man verwendet dabei nur die folgenden drei Arten von Äquivalenz-Umformungen:

1)

Vertauschen von zwei Gleichungen

8

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

2)

Multiplizieren einer Gleichung mit einer von 0 verschiedenen Zahl

3)

Zu einer Gleichung ein Vielfaches einer andern Gleichung addieren

Dies sind Äquivalenz-Umformungen, weil dabei offensichtlich keine Lösungen verloren gehen, aber

auch keine neuen dazukommen, da man ja jede solche Umformung durch eine Umformung gleicher

Art wieder rückgängig machen kann.

Wenn die Unbekannte x1 im System gar nicht vorkommt (d. h. ak1 = 0 für alle k von 1 bis m), ist x1 frei.

Andernfalls wähle man ein k mit ak1 ≠ 0 und vertausche die erste Gleichung mit der k-ten. Wir nehmen

jetzt also a11 ≠ 0 an. Damit ist x1 gebunden, mit Pivot a11. Um zu erreichen, dass x1 in den folgenden

Gleichungen nicht mehr vorkommt, addieren wir zur j-ten Gleichung (für j von 2 bis m) das (−aj1/a11)fache der ersten Gleichung.

Dieses Verfahren wiederholen wir nun für die Unbekannte x2, und zwar im vollen System, wenn x1 frei

ist, aber nur im System der Gleichungen 2 bis m, wenn x1 gebunden ist, hierauf für x3 usw.

Dieser Reduktionsprozess kann solange fortgesetzt werden, bis die Zeilenstaffelform für das ganze

System erreicht ist.

Bemerkungen

1. Welche Unbekannten frei und welche gebunden sind, hängt vom Reduktionsprozess ab, in

dem man ja viele Wahlmöglichkeiten hat. Jedoch ist die Anzahl der freien Variablen festgelegt,

wenn das System überhaupt Lösungen hat, denn diese Anzahl ist die Dimension der

Lösungsmenge.

2. Umformungen vom Typ 2) wurden in der obigen Beschreibung des Reduktionsprozesses gar

nicht verwendet. Sie sind aber manchmal nützlich, um im System möglichst einfache Zahlen zu

haben.

3. Auf Taschenrechnern und in Matlab gibt es die Funktion rref (reduced row echelon form).

Diese treibt die Umformung noch etwas weiter. Sie ist anzuwenden auf die sogenannte

erweiterte Matrix (rechteckiges Schema der gegebenen Zahlen) des Systems,

⎡ a11 ... a1n b1 ⎤

⎢

⎥

...

:

: ⎥

⎢ :

⎢⎣a m1 ... amn bm ⎥⎦

und liefert die erweiterte Matrix eines äquivalenten Systems, bei dem alle Pivots 1 sind, und wo

auch oberhalb eines solchen Pivots in der gleichen Spalte nur noch Nullen stehen, was man ja

durch Anwendung von Umformungen vom Typ 2) und 3) immer erreichen kann. Dies

vereinfacht den Prozess des Rückwärts-Einsetzens.

Beispiel

Gegeben ist das System (b ist noch nicht spezifiziert)

w + x + y + z =2

2w – x + 3y + 2z = 1

–w + 2x – 2y – z = b

Der erste Reduktionsschritt ergibt

1w + x + y + z = 2

–3x + y

= –3

3x – y

=b+2

Der zweite Reduktionsschritt ergibt (die fettgedruckten Zahlen sind die gewählten Pivots)

1w + x + y + z = 2

–3x + y

= –3

0 =b–1

womit die Zeilenstaffelform erreicht ist. Wir können jetzt zwei Fälle unterscheiden:

Wenn b ≠ 1, hat das System wegen der letzten Gleichung keine Lösungen. Wenn b = 1, ist es lösbar,

die beiden Unbekannten y, z sind frei. Wir setzen y = s, z = t (Parameter der Lösungsmenge) und

erhalten durch Rückwärtseinsetzen x = (–3 – y)/( –3) = 1 + s/3, w = 2 – x – y – z = 2 – 1 – s/3 – s – t =

1 – 4s/3 – t.

9

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Vektoriell zusammengefasst:

⎡ w ⎤ ⎡ 1⎤

⎡− 4 / 3⎤ ⎡− 1⎤

⎢ x ⎥ ⎢ 1⎥

⎢ 1/ 3 ⎥ ⎢ 0 ⎥

⎢ y ⎥ = ⎢0⎥ + s ⎢ 1 ⎥ + t ⎢ 0 ⎥

⎢ z ⎥ ⎢⎣0⎥⎦

⎢⎣ 0 ⎥⎦ ⎢⎣ 1 ⎥⎦

⎣ ⎦

Dies stellt eine Ebene im 4-dimensionalen Raum dar.

Der Matlab-Befehl für den Fall b = 1 lautet rref([1 1 1 1 2; 2 -1 3 2 1; -1 2 -2 -1 1])

und liefert das Resultat

1.0000

0

0

0

1.0000

0

1.3333

-0.3333

0

1.0000

0

0

1.0000

1.0000

0

Lesen Sie daraus die Lösungsmenge ab! (w = 1 – 4y/3 – z; x = 1 + y/3; y, z frei).

Für den Fall b = 5 ergibt rref([1 1 1 1 2; 2 -1 3 2 1; -1 2 -2 -1 5]) jedoch

1.0000

0

0

0

1.0000

0

1.3333

-0.3333

0

1.0000

0

0

0

0

1.0000

Die letzte Zeile entspricht hier der Gleichung 0 = 1 im System, weshalb es keine Lösungen hat.

II.2

Matrizen und Determinanten

Unter einer mxn-Matrix (m Zeilen, n Spalten) versteht man ein rechteckiges Zahlenschema

⎡ a11 a12

⎢

A = ⎢ a 21 a 22

:

:

⎢a

⎣ m1 am2

... a1n ⎤

... a 2n ⎥

:::

: ⎥

... amn ⎥⎦

Bei dieser Doppelindex-Schreibweise ist jeweils der erste Index der Zeilenindex (Nummer der Zeile),

der zweite der Spaltenindex. Dass solche Matrizen bei linearen Gleichungssystemen eine Rolle

spielen, kann man schon im Abschnitt II.1 erahnen. Sie spielen aber auch in andern Gebieten der

Mathematik und auch in der Physik eine wichtige Rolle. Z. B. ist der Trägheitstensor eines starren

Körpers eine Matrix, mit der man für jede Achsenrichtung das Trägheitsmoment des Körpers

bezüglich der Achse (mit der gegebenen Richtung) durch den Schwerpunkt berechnen kann.

Um diese Matrizen zu einem nützlichen Instrument zu machen, muss man aber Rechenoperationen

definieren. Addition und Subtraktion werden komponentenweise ausgeführt, sind also nur für Matrizen

jeweils gleicher Dimension mxn definiert. Ausserdem ist Multiplikation einer Matrix mit einer Zahl

ebenfalls immer komponentenweise gemeint (wie bei Vektoren, die man ja auch als einspaltige

Matrizen auffassen kann). Für diese drei Operationen gelten auch die von Zahlen bzw. Vektoren her

bekannten Rechenregeln. Die komponentenweise Multiplikation kann man natürlich auch betrachten;

sie ist aber nicht so nützlich. Statt dessen wird eine andere Multiplikation eingeführt, und zwar so,

dass die linke Seite eines linearen Gleichungssystems als Matrixprodukt A ⋅ X betrachtet werden

kann. Allgemein formuliert: Das Produkt einer mxn-Matrix A mit einer nxp-Matrix B ist eine mxp-Matrix

C = A·B, deren Komponente an der Stelle (i, k) (d.h. i-te Zeile, k-te Spalte) mit der Formel

n

c ik = ai1b1k + ai2b 2k + ... + ainbnk = ∑ aijb jk

j =1

berechnet wird. Das Produkt einer Matrix A mit der Matrix B ist also nur definiert, wenn die

Zeilenlänge („Breite“) von A mit der Spaltenlänge („Höhe“) von B übereinstimmt, und die Komponente

an der Stelle (i,k) ist eine Art Skalarprodukt der i-ten Zeile von A mit der k-ten Spalte von B.

10

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Die Rechenregeln für diese neue Operation sind

A·(B·C) = (A·B)·C

(Assoziativgesetz)

A·(B + C) = A·B + A·C

(A + B)·C = A·C + B·C

(Distributivgesetze)

immer unter der Voraussetzung, dass die Dimensionen so sind, dass die Produkte definiert sind. Das

direkte Nachprüfen dieser Relationen ist etwas mühsam. Als Übung ist es jedoch sehr zu empfehlen,

mindestens eine davon für 2x2-Matrizen nachzurechnen.

Das Kommutativgesetz gilt jedoch nicht, auch wenn A·B und B·A beide definiert sind und die gleiche

Dimension haben.

Beispiel:

⎡0 1⎤ ⋅ ⎡0 0⎤ = ⎡ 1 0⎤ , aber

⎢⎣0 0⎥⎦ ⎢⎣ 1 0⎥⎦ ⎢⎣0 0⎥⎦

⎡0 0⎤ ⋅ ⎡0 1⎤ = ⎡0 0⎤

⎢⎣ 1 0⎥⎦ ⎢⎣0 0⎥⎦ ⎢⎣0 1⎥⎦

⎡ 1 0 ... 0⎤

⎢0 1

0⎥

Wir erwähnen noch die spezielle nxn-Matrix En = ⎢

(Einsen auf der Diagonale, Nullen

:

⋅. : ⎥

⎢0 0 ... 1⎥

⎣

⎦

daneben), genannt Einheitsmatrix der Dimension nxn. Für diese gilt A ⋅ En = A = Em ⋅ A , für jede mxnMatrix A, d.h. diese Einheitsmatrizen verhalten sich bei Multiplikation wie bei den Zahlen die 1. Wenn

klar ist, welche Dimension gemeint ist, schreiben wir auch nur E statt En.

Wie bereits gesagt, können wir ein lineares Gleichungssystem jetzt auch als Matrixgleichung

A⋅X = B

schreiben (A gegebene mxn-Matrix, B gegebene mx1-Matrix, X unbekannte nx1-Matrix). Es ist

naheliegend sich zu fragen, ob man dies nicht mittels einer Division durch A tun kann. Im Fall von

Zahlen kann man ja durch jede Zahl a ≠ 0 dividieren, indem man mit a-1 multipliziert, und a-1 ist eine

Zahl mit der Eigenschaft a-1a = 1. Entsprechend suchen wir nun zu A eine Matrix C mit der

Eigenschaft

A·C = E, C·A = E

(Wegen der Nichtkommutativität braucht es beide Gleichungen.) Hat man ein solches C (man nennt

es eine Inverse von A), so ist die Gleichung A·X = B gleichbedeutend mit X = C·B, denn aus A·X = B

folgt C·A·X = C·B, wegen C·A = E also X = C·B. Umgekehrt folgt aus X = C·B, dass A·X = A·C·B,

wegen A·C = E also A·X = B.

Man kann nun zeigen, dass die Existenz einer Inversen höchstens im Fall n = m möglich ist.

Tatsächlich zeigt die obige Überlegung, dass, wenn eine Inverse C zu A existiert, das

Gleichungssystem A·X = B unabhängig von B immer genau eine Lösung besitzt (nämlich X = C·B),

was im Fall n ≠ m nie richtig ist. (Dies kann man mit Hilfe des Gauss-Algoritmus’ einsehen, wir gehen

aber hier nicht näher darauf ein.) Wir setzen daher von jetzt an bei der Frage nach einer Inversen C

von A voraus, dass A eine „quadratische“ Matrix ist, und analysieren zuerst den Fall n = 2.

Inverse einer 2x2-Matrix

a12 ⎤ ⎡c11 c12 ⎤ ⎡ 1 0⎤

⎡a

Wir suchen zunächst ein C mit A·C = E, d.h. ⎢ 11

⎥⋅⎢

⎥ = ⎢⎣0 1⎥⎦ , ausgeschrieben

a

a

22 ⎦ ⎣c 21 c 22 ⎦

⎣ 21

a11c12 + a12c22 = 0

| ·a22

| ·(−a21)

a11c11 + a12c21 = 1

a21c11 + a22c21 = 0

a21c12 + a22c22 = 1

| ·(−a12)

| ·a11

Um jeweils ein Unbekannte zu eliminieren, multiplizieren wir untereinander stehende Gleichungen mit

den hinten angegebenen Zahlen und addieren sie, was folgende vier neue Gleichungen ergibt:

11

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

(a11a22 − a21a12) c11 = a22

(a11a22 − a21a12) c21 = −a21

HS 2011 / baw2

(a11a22 − a21a12) c12 = −a12

(a11a22 − a21a12) c22 = a11

Diese sind zwar nicht unbedingt äquivalent zu den ursprünglichen, aber wir können ja die Lösung am

Schluss durch Einsetzen überprüfen. Auffallend ist, dass in allen vier Gleichungen der Faktor vor der

Unbekannten gleich ist, nämlich d := a11a22 − a21a12. Man nennt diesen Faktor die Determinante der

Matrix A. Ist d ≠ 0, muss c11 = a22/d, c21 = −a21/d, c12 = −a12/d, c22 = a11/d gelten, zusammengefasst

c 12 ⎤ 1 ⎡ a 22 − a12 ⎤

⎡c

=

C = ⎢ 11

⎣c 21 c 22 ⎥⎦ d ⎢⎣− a 21 a11 ⎥⎦

Die Überprüfung ergibt, dass wirklich A·C = E, aber nicht nur dies, sondern auch C·A = E, d.h. wir

haben tatsächlich eine Inverse von A gefunden! Und die Herleitung zeigt auch, dass es die einzige ist.

Man bezeichnet sie mit inv(A) oder A-1. Ist hingegen die Determinante d = 0, so zeigen die vier neuen

Gleichungen, dass es keine Lösung geben kann, wenn auch nur eine Komponente von A von Null

verschieden ist (links steht überall 0). Wenn aber A die Nullmatrix ist, hat sie sowieso keine Inverse.

Wir fassen unsere Erkenntnisse zusammen:

Eine 2x2-Matrix A hat genau dann eine Inverse, wenn ihre Determinante d = a11a22 − a21a12 von Null

verschieden ist. Die Inverse ist eindeutig bestimmt und gegeben durch

inv( A ) =

1 ⎡ a 22 − a12 ⎤

d ⎢⎣− a 21 a11 ⎥⎦

Wir können nun damit beispielsweise das lineare Gleichungssystem

3 x1 + 5 x 2 = 1

2 x1 − 5 x 2 = 9

⎡x ⎤

in Matrixform geschrieben: ⎡3 5 ⎤ ⋅ ⎢ 1 ⎥ = ⎡ 1⎤

⎢⎣2 − 5⎥⎦ ⎣ x 2 ⎦ ⎢⎣9⎥⎦

1 ⎡− 5 − 5⎤ ⎡ 1⎤ ⎡ 2 ⎤

⎡x ⎤

so auflösen: Es ist d = 3·(–5) – 2·5 = –25 ≠ 0, also ⎢ 1 ⎥ = inv( A ) ⋅ ⎡ 1⎤ =

.

⋅

=

⎢

⎥

9

x

⎣

⎦

−

25 ⎢⎣− 2 3 ⎥⎦ ⎢⎣9⎥⎦ ⎢⎣− 1⎥⎦

⎣ 2⎦

Der Vorteil dieser Methode gegenüber dem Gauss-Algorithmus ist der, dass sie eine explizite Formel

für die Lösung liefert (Cramer-Regel, vgl. nächsten Abschnitt), aber eben nur für den Fall, dass die

Determinante von A nicht Null ist. Wir versuchen nun, die Methode auf höhere Dimensionen zu

verallgemeinern. Der kritische Punkt dabei ist die Definition der Determinanten.

Determinanten

Die Determinantenfunktion det ordnet jeder quadratischen Matrix A eine Zahl zu, ihre Determinante

det(A). Für 1x1-Matrizen A = [a11] definieren wir det(A) = a11, für 2x2-Matrizen haben wir sie oben

schon definiert: det(A) = a11a22 − a21a12. Wir listen nun einige Eigenschaften auf, die wir von der

Determinantenfunktion allgemein erwarten, weil sie offensichtlich für n = 2 erfüllt sind.

1)

det(E) = 1

2)

det(A) ist linear bezüglich jeder Spalte von A.

Um zu erklären, was damit gemeint ist, schreiben wir A = [S1, …, Sn], wo S1, …, Sn die

Spalten von A sind. Ist nun die k-te Spalte eine Summe von zwei Vektoren, Sk = Sk’+Sk’’, so

soll

det(A) = det([…,Sk’,…]) + det([…,Sk’’,…]) gelten, wobei in […,Sk’,…] und […,Sk’’,…] alle

Spalten ausser der k-ten gleich sind wie in A. Ebenso, wenn Sk = λSk’ mit einem Zahlenfaktor

λ, soll det(A) = λ det([…,Sk’,…]) gelten.

3)

Wenn man zwei Spalten von A vertauscht, wechselt det(A) nur das Vorzeichen.

12

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

4)

HS 2011 / baw2

Für die transponierte Matrix AT gilt det(AT) = det(A)

Die transponierte Matrix AT erhält man aus A durch Spiegeln an der Hauptdiagonale, d.h.

(AT)ik = aki . Dadurch werden aus den Zeilen von A Spalten von AT, und umgekehrt. Die

Eigenschaft 4) hat zur Folge, dass die Eigenschaften 2) und 3), und auch 5) bis 7) unten,

analog für Zeilen gelten.

5)

Entwicklung von det(A) nach der 1. Spalte:

2 +1

n +1

ˆ

ˆ

ˆ

det( A ) = ( −1)1+1a11 det( A

a 21 det( A

an1 det( A

(11) ) + ( −1)

( 21) ) + ... + ( −1)

(n1) )

Diese Formel gestattet, die Berechnung einer Determinante auf Determinanten von Matrizen

kleinerer Dimension zurückzuführen. Wir bezeichnen mit  (ik ) die Untermatrix von A, die man

durch Streichen der i-ten Zeile und k-ten Spalte erhält, eine (n−1)x(n−1)-Matrix, die auch die

ˆ ) wird auch –

zu (i,k) komplementäre Untermatrix genannt wird. Ihre Determinante det( A

(ik )

etwas unpräzis – die zu (i,k) komplementäre Unterdeterminante genannt. In der Formel wird

jedes Element der 1. Spalte mit der komplementären Unterdeterminante und einem

abwechselnden Vorzeichen multipliziert, und alle diese Produkte werden addiert. Wegen 1)

bis 5) kann man aber die Determinante genauso gut nach irgendeiner anderen Spalte oder

irgendeiner Zeile entwickeln. Z. B. lautet die Entwicklung nach der 2. Zeile:

2+ 2

2+n

ˆ

ˆ

ˆ

det( A ) = ( −1)2 +1a 21 det( A

a 22 det( A

a 2n det( A

( 21) ) + ( −1)

( 22 ) ) + ... + ( −1)

( 2n ) )

Hier beginnt das abwechselnde Vorzeichenmuster also mit „−“.

Wir notieren noch zwei Folgerungen aus 2) und 3)

6)

Wenn zwei Spalten von A gleich sind, ist det(A) = 0.

7)

Wenn man zu einer Spalte von A ein Vielfaches einer andern Spalte addiert, ändert sich die

Determinante nicht.

Nun gilt es zu beweisen, dass eine Funktion det mit den Eigenschaften 1) bis 5) wirklich existiert.

Wenn man die Determinanten für Matrizen der Dimension (n−1)x(n−1) schon definiert hat, und zwar

so, dass 1) bis 5) für diese und kleinere Dimensionen gelten, kann man sie mittels der ersten Formel

in 5) (Entwicklung nach der ersten Spalte) für Matrizen der Dimension nxn definieren. Man muss dann

noch die Eigenschaften 1) bis 4) für Matrizen der Dimension nxn nachweisen. So kann man Stufe um

Stufe zu Matrizen beliebiger Dimension aufsteigen. Wir illustrieren das Verfahren (man nennt es

„Induktion“) am Übergang von Stufe 2 zu Stufe 3.

Wie gesagt, gelten alle Regeln für die bereits definierten Determinanten von 2x2-Matrizen. Für eine

3x3-Matrix erhalten wir durch Entwicklung nach der ersten Spalte

⎡a11 a12

det( ⎢a 21 a 22

⎢a

⎣ 31 a 32

a13 ⎤

⎡a

a 23 ⎥ ) = a11 det( ⎢ 22

⎥

⎣a 32

a 33 ⎦

a 23 ⎤

⎡a

) − a 21 det( ⎢ 12

a 33 ⎥⎦

⎣a 32

a13 ⎤

⎡a

) + a 31 det( ⎢ 12

a 33 ⎥⎦

⎣a 22

a13 ⎤

)=

a 23 ⎥⎦

= a11(a 22a 33 − a 32a 23 ) − a 21(a12a 33 − a 32a13 ) + a 31(a12a 23 − a 22a13 ) =

= a11a 22a 33 + a 21a 32a13 + a 31a12a 23 − a11a 32a 23 − a 21a12a 33 − a 31a 22a13

Mit dieser letzten Form sind jetzt die Regeln 1) bis 4) leicht nachzuweisen. Um z. B. 2) zu begründen,

bemerke man, dass jeder der sechs Summanden aus jeder Spalte genau einen Faktor enthält. Somit

ist klar, dass diese Funktion bezüglich jeder Spalte von A linear ist. Bei Vertauschung von zwei

Spalten geht jeder der Summanden mit einem „+“ in einen Summanden mit „−“ über, und umgekehrt,

womit 3) begründet ist. Der Leser möge selber überlegen, warum 1) und 4) gelten.

13

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Für die soeben hergeleitete Formel für die Determinante einer 3x3-Matrix gibt es eine einfache

Merkregel, die „Regel von Sarrus“: Man schreibe die Matrix zweimal untereinander und berechne die

zu addierenden Produkte gemäss nachstehendem Schema

a11

a 21

a 31

a11

a 21

a 31

a12

a 22

a 32

a12

a 22

a 32

a13

a 23

a 33

a13

a 23

a 33

−

−

−

+

+

+

Der allgemeine Übergang von Stufe n−1 auf Stufe n ist natürlich etwas komplizierter, weil es nicht

ganz einfach ist, die Summanden in der ausmultiplizierten Form der Determinante zu charakterisieren.

Beim Übergang n−1 → n vervielfacht sich die Anzahl Summanden um Faktor n, also sind es

insgesamt

1·2·3·…·n = n! Summanden; jeder besteht aus n Faktoren, aus jeder Spalte und jeder Zeile genau

einer, aber das Problem ist die Festlegung des Vorzeichens. Wir wollen dies hier nicht weiter

verfolgen, betonen aber noch, dass die Regel von Sarrus nur im Fall n = 3 gilt, da sie ja 2n

Summanden liefert statt n!. Nur im Fall n = 3 ist 2n = n!.

Die Berechnung einer Determinante kann mit den Regeln 2) und 7) stark vereinfacht werden, indem

sich die Matrix durch Umformungen dieser Art auf „Dreiecksform“ bringen lässt, ähnlich wie man im

Gauss-Algorithmus ein Gleichungssystem auf Staffelform bringt. „Dreiecksform“ bedeutet, dass

unterhalb (oder oberhalb) der Hauptdiagonale nur Nullen stehen. Die Determinante einer

Dreiecksmatrix ist einfach das Produkt der Hauptdiagonalelemente:

⎡a11 a12

⎢0

⋅.

det( ⎢

:

⎢

..

⎣0

.. a1n ⎤

.. a 2n ⎥

) = a11a 22 ...ann

⋅. : ⎥

⎥

0 ann ⎦

Begründen Sie dies!

Zum Schluss noch eine weitere wichtige Eigenschaft der Determinantenfunktion:

8)

det(B·A) = det(B)·det(A)

Auch diese ist nicht ganz einfach zu beweisen. Für n = 2 ist sie rasch nachgerechnet (tun Sie es!),

aber für höhere Dimensionen wird der Aufwand bald zu gross, sodass nur theoretische Betrachtungen

zum Ziel führen: Man zeigt erstens, dass die Funktion det’(A) := det(B·A) (B fest, A variabel) die

Eigenschaften 2) und 3) erfüllt, und zweitens, dass für jede Funktion det’, die 2) und 3) erfüllt, gilt:

det’(A) = det’(E)·det(A). (Wir gehen nicht auf die Details ein.) Da in unserem Fall

det’(E) = det(B·E) = det(B), ist 8) erfüllt.

Inverse einer nxn-Matrix

Wir können nun die Frage nach der Inversen einer nxn-Matrix A beantworten. Um aufwändige

Rechnungen zu vermeiden, geben wir direkt das Resultat an und kontrollieren seine Korrektheit.

Eine nxn-Matrix A hat genau dann eine Inverse, wenn ihre Determinante d = det(A) von Null

verschieden ist. Die Inverse ist eindeutig bestimmt und ihre Komponente an der Stelle (i,k) ist

gegeben durch

1

ˆ )

(inv( A ))ik = ( −1)i + k det( A

(ki )

d

Zu beachten ist, dass jeweils nicht die zur Stelle (i,k) komplementäre Unterdeterminante zu nehmen

ist, sondern die zur (bezüglich Hauptdiagonale) gespiegelten Stelle (k,i). Überzeugen Sie sich davon,

dass im Fall n = 2 die bereits bekannte Formel (Seite 12) herauskommt.

14

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Im Fall det(A) = 0 kann es keine Inverse geben, da aus C·A = E nach 8) folgt, dass det(C)·det(A) = 1.

Diese Überlegung zeigt, dass

det(inv( A )) =

1

det( A )

Wir überprüfen jetzt die Formel für inv(A) und berechnen dazu für die durch die angegebene Formel

definierte Matrix C beispielhaft die beiden Komponenten (C·A)11 und (C·A)12.

(C ⋅ A )11 = c11a11 + c12a 21 + ... + c1nan1 =

=

1

1

1+ 2

1+ n

ˆ

ˆ

ˆ

(( −1)1+1 det( A

det( A

det( A

det( A ) = 1

(11) )a11 + ( −1)

( 21) )a 21 + ... + ( −1)

(n1) )an1 ) =

d

d

(Entwicklung von det(A) nach der ersten Spalte).

(C ⋅ A )12 = c11a12 + c12a 22 + ... + c1nan2 =

=

1

1+ 2

1+ n

ˆ

ˆ

ˆ

(( −1)1+1 det( A

det( A

det( A

(11) )a12 + ( −1)

( 21) )a 22 + ... + ( −1)

(n1) )an2 )

d

Die Summe in der Klammer ist die Entwicklung nach der 1. Spalte der Determinante der Matrix

A’ = [S2,S2,S3,…Sn], wobei wieder Sk die k-te Spalte von A bezeichnet. Man hat also in A die erste

Spalte durch eine Kopie der 2. Spalte ersetzt. Dies beeinflusst die komplementären Unterˆ ' ) = det( A

ˆ ) . Da det(A’) = 0

determinanten der Elemente der 1. Spalte nicht, d.h. es gilt det( A

( k1)

(k1)

wegen Regel 6), folgt (C·A)12 = 0. Auf ähnliche Art ergibt sich, dass (C·A)kk = 1 und (C·A)ik = 0 für i ≠ k,

und dasselbe für A·C (hier muss man die entsprechenden Regeln für Zeilen verwenden).

II.3

Die Cramer-Regel

Wir kehren jetzt zu den linearen Gleichungssystemen zurück, aber nur im Fall n = m (Anzahl

Unbekannte = Anzahl Gleichungen). Wenn ein solches System gegeben ist,

A·X = B

(A gegebene nxn-Matrix, B gegebene nx1-Matrix, X unbekannte nx1-

Matrix)

und det(A) ≠ 0 (man nennt das System bzw. die Matrix A in diesem Fall regulär), dann hat es nach

den Betrachtungen des letzten Abschnitts genau eine Lösung, nämlich X = inv(A)·B. Dies gilt

allgemeiner auch dann, wenn B eine gegebene nxp-Matrix (p beliebig) und X eine gesuchte nxp-Matrix

ist. Im klassischen Fall p = 1 können wir jedoch die Lösung noch etwas umformen: Die k-te

Unbekannte ist

xk = (inv(A)·B)k =

1

k +2

k +n

ˆ

ˆ

ˆ

(( −1)k +1 det( A

det( A

det( A

(1k ) )b1 + ( −1)

( 2k ) )b 2 + ... + ( −1)

(nk ) )bn )

det( A )

und die Summe in der Klammer ist die Entwicklung einer Determinante nach der k-ten Spalte, aber

nicht der Determinante von A, sondern der Matrix, die man aus A erhält, wenn man die k-te Spalte

durch den Vektor B ersetzt. Wir bezeichnen diese Matrix mit A S ←B . Damit haben wir die

k

sogenannte

Cramer-Regel:

⎡ x1 ⎤

Für die Lösung X = ⎢ : ⎥ eines regulären linearen Gleichungssystems A·X = B gilt

⎢xn ⎥

⎣ ⎦

det( A S ←B )

k

(k = 1…n).

xk =

det( A )

15

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Betrachten wir als Beispiel nochmals das System

3 x1 + 5 x 2 = 1

2 x1 − 5 x 2 = 9

⎡x ⎤

in Matrixform geschrieben: ⎡3 5 ⎤ ⋅ ⎢ 1 ⎥ = ⎡ 1⎤

⎢⎣2 − 5⎥⎦ ⎣ x 2 ⎦ ⎢⎣9⎥⎦

Es ist det(A) = 3·(–5) – 2·5 = –25 ≠ 0, also ist das System regulär. Nach Cramer erhalten wir

−5 − 45

27 − 2

1

1

= 2 , x2 =

= −1 .

det( ⎡ 1 5 ⎤ ) =

det( ⎡3 1⎤ ) =

x1 =

⎢⎣9 − 5⎥⎦

⎢⎣2 9⎥⎦

− 25

− 25

− 25

− 25

Die Cramer-Regel hat für numerische Berechnungen kaum praktische Bedeutung (ausser vielleicht in

den Fällen n = 2 oder n = 3), da der Gauss-Algorithmus oder ähnliche Verfahren effizienter sind. Sie

sind jedoch sehr nützlich in theoretischen Betrachtungen, z.B. wenn A und/oder B Grössen enthalten,

die noch verändert werden können („Parameter“, z.B. Widerstände in einem elektrischen Netzwerk).

Dann kann man mit ihrer Hilfe untersuchen, wie die Lösung von diesen Parametern abhängt.

Man kann sich fragen, ob die Determinanten in der Cramer-Regel auch eine Bedeutung haben, wenn

das System nicht regulär ist, also det(A) = 0. In der Form

x k det( A ) = det( A S

k

←B

)

sind die Gleichungen auch hier eine Folgerung aus dem ursprünglichen System, aber nicht äquivalent

dazu. Wenn nun auch nur eine der Determinanten det( A S ←B ) (k = 1…n) von Null verschieden ist,

k

hat die entsprechende Gleichung keine Lösung, das ursprüngliche System also auch nicht. Falsch ist

aber, obwohl es oft behauptet wird, dass das System immer unendlich viele Lösungen hat, wenn auch

die Determinanten det( A S ←B ) (k = 1…n) alle Null sind. Einfache Gegenbeispiele sind die Systeme

k

x1 + 2 x 2 − x 3 = 1

2 x1 + 4 x 2 − 2 x 3 = 5

− 5 x1 − 10 x 2 + 5 x 3 = 2

0 x1 + 0 x 2 = 0

0 x1 + 0 x 2 = 1

Beide haben offensichtlich gar keine Lösung, obwohl bei beiden Systemen neben det(A) auch alle

Determinanten det( A S ←B ) Null sind. (Überzeugen Sie sich davon!)

k

II.4

Homogene lineare Gleichungssysteme, lineare (Un-)Abhängigkeit

Die am Schluss des letzten Abschnitts erwähnte Falschbehauptung ist in einem wichtigen Spezialfall

richtig, nämlich wenn B = 0 (rechte Seite des Gleichungssystems Null). Ein solches System

A·X = 0

x1S1 + … + xnSn = 0

oder anders geschrieben:

(wo S1 , …, Sn wieder die Spaltenvektoren von A sind) heisst homogen.

Homogene lineare Gleichungssysteme kommen z.B. in der Theorie der Eigenvektoren von Matrizen

vor (vgl. Übungsblatt „Matrizen und Determinanten“, Aufgabe 6), sowie LAG2), allgemein immer dann,

wenn Vektoren gesucht sind, die nur bis auf Vielfache bestimmt sind, z. B. der Normalenvektor einer

Ebene.

Ein homogenes System hat immer die „triviale“ Lösung X = 0. Wenn es noch eine andere Lösung hat,

wo also mindestens eines der xk ≠ 0 ist, kann man einen der Vektoren S1 ,…, Sn als

Linearkombination der übrigen ausdrücken, d.h. die Vektoren sind dann linear abhängig. Hat das

System nur die triviale Lösung, ist dies nicht möglich, die Vektoren sind linear unabhängig.

Ist det(A) ≠ 0, so hat das System, wie wir wissen, genau eine Lösung, und dies muss die triviale sein,

d.h. die Vektoren S1 ,…, Sn sind linear unabhängig. Wir behaupten nun aber, dass davon auch die

Umkehrung gilt: Wenn die Vektoren (Spalten von A) S1 ,…, Sn linear unabhängig sind, ist det(A) ≠ 0.

Hiezu überlegen wir wie folgt: Wenn wir einen der Vektoren, sagen wir Sk, ersetzen durch

16

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Sk + λSj, wo λ eine beliebige Zahl ist und j ≠ k, dann bleiben die Vektoren linear unabhängig. Ebenso,

wenn wir zwei Vektoren vertauschen. Durch solche Operationen können wir aber die Matrix auf

Spaltenstaffelform bringen (ähnlich wie wir im Gauss-Algorithmus das Gleichungssystem auf

Zeilenstaffelform gebracht haben): In jeder Spalte steht das erste von Null verschiedene Element

(Pivot) weiter unten als dasjenige der vorherigen Spalte.

⎡ 0 0 0 .. 0⎤

⎢:

: : .. : ⎥

⎢d1 :

⎥

⎢:

⎥

:

⎢

⎥

⎢ : d2

⎥

: : .. : ⎦⎥

⎣⎢ :

Die Pivots d1, d2, … können aber nach rechts hin nicht schneller als in Einerschritten absteigen (und

d1 steht an der Stelle (1,1)), weil sonst die letzte Spalte 0 wäre, was der linearen Unabhängigkeit

widerspräche, d.h. sie müssen auf der Hauptdiagonale liegen. Da die Matrix untere Dreiecksform hat

(oberhalb der Diagonale Nullen), ist ihre Determinante das Produkt der Hauptdiagonalelemente, d.h.

der Pivots, also ≠ 0. Bei den angewandten Manipulationen verändert aber die Determinante der Matrix

höchstens das Vorzeichen, sodass also auch die Determinante der ursprünglichen Matrix ≠ 0 ist.

Etwas anders formuliert: Wenn det(A) = 0, müssen die Spaltenvektoren von A linear abhängig sein,

d.h. das Gleichungssystem x1S1 + … + xnSn = 0 hat auch nichttriviale Lösungen. Wir fassen

zusammen:

Ein homogenes lineares Gleichungssystem A·X = 0 (wo A eine quadratische Matrix ist) hat

genau dann nichttriviale Lösungen, wenn det(A) = 0.

n

Ein Set von n Vektoren S1 , …, Sn im R ist genau dann linear unabhängig, wenn

det([S1, …, Sn]) ≠ 0.

Beide Aussagen bedeuten eigentlich dasselbe, einmal positiv, einmal negativ formuliert. Wenn

n

S1 ,…, Sn linear unabhängig sind, kann man noch mehr sagen: Jeder Vektor B im R lässt sich auf

genau eine Art als Linearkombination von S1 ,…, Sn darstellen, B = x1S1 + … + xnSn, weil das

Gleichungssystem A·X = B (dessen Matrix A = [S1, …, Sn] ja jetzt als regulär erkannt ist), genau eine

n

Lösung hat. Man sagt auch, die Vektoren S1 ,…, Sn bilden eine Basis des R .

n

Man könnte auch fragen, wann m Vektoren S1 ,…, Sm im R linear unabhängig sind, oder allgemeiner,

wann ein Set von m Vektoren p linear unabhängige Vektoren enthält. Die Antwort lautet:

n

Ein Set von m Vektoren S1 , …, Sm im R enthält genau dann p linear unabhängige Vektoren,

wenn es eine reguläre pxp-Untermatrix von A = [S1, …, Sm] gibt,

das heisst, wenn p ≤ m und p ≤ n und es möglich ist, in der Matrix n−p Zeilen und m−p Spalten zu

streichen, so dass die verbleibende pxp-Matrix regulär ist. Die grösste Zahl p mit dieser Eigenschaft

wird auch als Rang von A bezeichnet.

Beweis der Aussage: Wenn es eine solche Untermatrix gibt, sind deren Spalten linear unabhängig,

umso mehr die entsprechenden Spalten von A, denn eine lineare Abhängigkeit würde bestehen

bleiben, wenn man in den Vektoren gewisse Komponenten streicht. Enthält umgekehrt die volle Matrix

A eine Auswahl von p linear unabhängigen Spalten, streichen wir zunächst die andern und bringen

wie oben die restliche Matrix A’ auf Spaltenstaffelform. Es gibt p Pivots, die aber jetzt nach rechts hin

auch rascher absteigen können. Wir streichen jetzt alle Zeilen, die kein Pivot enthalten; es verbleibt

also eine untere Dreiecksmatrix A’’ (pxp mit den Pivots auf der Diagonalen), deren Determinante

somit nicht Null ist. Wenn wir in A’ die Spaltenoperationen, mit denen wir Staffelform erreicht haben,

rückgängig machen, geht A’’ in eine reguläre Untermatrix von A’ und damit von A über (die

Determinante wechselt höchstens das Vorzeichen).

17

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

III

Komplexe Zahlen

III.1

Definition, Rechenoperationen mit komplexen Zahlen

Im Laufe der Geschichte haben die Menschen ihren Zahlenbegriff mehrfach erweitert, von den

natürlichen Zahlen (N) zu Brüchen von natürlichen Zahlen (positive rationale Zahlen), durch

Hinzunahme von 0 und negativen Zahlen zu den rationalen Zahlen (Q), durch Übergang zu unendlich

langen Dezimalbrüchen zu den reellen Zahlen (R). Jedesmal war der Auslöser, dass gewisse

Rechenoperationen im vorhandenen Zahlenbereich nicht ausführbar waren. Die vier

Grundrechenarten sind zwar in Q uneingeschränkt durchführbar, soweit es überhaupt sinnvoll ist (d.h.

ausser Division durch 0), aber nicht alle rationalen Zahlen haben in Q eine Wurzel. In R haben zwar

alle positiven Zahlen eine Wurzel, nicht jedoch die negativen. Um diesen Mangel zu beheben, wurden

schliesslich noch die komplexen Zahlen (C) eingeführt. Der Bereich der komplexen Zahlen ist

algebraisch abgeschlossen, d.h. hier hat sogar jede polynomiale Gleichung immer Lösungen, nicht

nur Gleichungen der Form x2 = a.

Es gibt verschiedene Möglichkeiten, diese komplexen Zahlen einzuführen. Wichtig ist nicht, was sie

„sind“, sondern wie man damit rechnet. In diesem Sinne wählen wir eine Definition, die nahtlos an das

letzte Kapitel anschliesst: Matrizen. Wir bezeichnen mit C die Menge der 2x2-Matrizen der Form

⎡x − y⎤

⎢⎣ y x ⎥⎦

(x, y beliebige reelle Zahlen)

und schreiben sie in der Form

⎡x − y⎤

⎡1 0⎤

⎡0 − 1⎤

⎢⎣ y x ⎥⎦ = x ⎣⎢0 1⎥⎦ + y ⎣⎢ 1 0 ⎦⎥ = xE + yJ

In C können wir alle vier Grundrechenarten uneingeschränkt durchführen, und die Multiplikation ist

sogar kommutativ, obwohl sie dies bei Matrizen allgemein nicht ist. Um dies zu sehen, brauchen wir

die Relationen

J·E = E·J = J, J·J = −E

Rechnen Sie die letzte nach; sie ist grundlegend. Damit wird

(xE + yJ) · (uE + vJ) = (xu−yv)E + (xv+yu)J = (uE + vJ) · (xE + yJ)

1

1

x

−y

⎡ x y⎤

( xE + yJ)−1 =

= 2

( xE − yJ) = 2

E+ 2

J

2

2

⎢

⎥

−

y

x

det( xE + yJ) ⎣

⎦ x +y

x +y

x + y2

Damit diese Inverse existiert, muss nur x2+y2 ≠ 0 sein, d.h. (xE + yJ) darf nicht die Nullmatrix sein. Die

Division wird dann zu

uE + v J

ux + vy

−uy + vx

= (uE + vJ) ⋅ ( xE + yJ) −1 = 2

E+ 2

J

2

xE + yJ

x +y

x + y2

Addition und Subtraktion sind problemlos:

(xE + yJ) ± (uE + vJ) = (x±u)E + (y±v)J

Wir wollen als nächstes eine geometrische Interpretation einführen und gleichzeitig die Schreibweise

vereinfachen. So wie man sich reelle Zahlen als Punkte auf einer Geraden, der „reellen

Zahlengeraden“, vorstellen kann, denken wir uns komplexe Zahlen als Punkte einer Ebene mit

rechtwinkligem Koordinatensystem, der „Gauss’schen Zahlenebene“ oder „komplexen Zahlenebene“.

Der komplexen Zahl xE+yJ entspricht dabei der Punkt (x, y). Die x-Achse des Koordinatensystems

soll der reellen Zahlengeraden entsprechen, damit wir R als Teilmenge von C auffassen können. Wir

18

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

schreiben statt xE+yJ nur noch x+yj, statt x+0j nur x, statt 0+yj nur yj, statt 1j nur j. Dabei ist aus E die

reelle Zahl 1 auf der x-Achse geworden, aus J die „imaginäre Einheit“ j (aus historischen Gründen so

benannt, in der Mathematik meistens mit i bezeichnet, aber in der Elektrotechnik mit j), in der

geometrischen Interpretation dem Punkt (0, 1) auf der „imaginären Achse“ entsprechend, mit der

fundamentalen Beziehung

j2 = −1

Im Übrigen brauchen wir uns keine speziellen Rechenregeln zu merken; für die vier

Grundrechenarten gelten genau die gleichen Regeln wie die, die wir von den reellen Zahlen her

kennen. Wenn wir eine komplexe Zahl mit einem einzigen Symbol bezeichnen, z.B. z = x+yj, nennen

wir x auch den Realteil von z und y (nicht yj !) den Imaginärteil von z, geschrieben

x = Re(z) ,

y = Im(z)

Im

yj

j

˚

˚

˚

r

ϕ

(Matlab: real(z), imag(z))

z

˚1 ˚x

˚

komplexe Zahlenebene

Re

˚ z*

−z

In dieser Zahlenebene liegt –z spiegelbildlich zu z bezüglich 0. Die Zahl, die spiegelbildlich zu z

bezüglich der reellen Achse liegt, heisst die zu z konjugierte Zahl z* (Matlab: conj(z)). Wenn z = x+yj,

ist z* = x−yj. Sie ist nützlich bei der Ausführung einer Division, da z·z* = (x+yj)·(x−yj) = x2−(yj)2 =

x2−(yj)2 = x2+y2 reell ist; man erweitere also den Bruch mit der Konjugierten des Nenners:

u + vj (u + vj)( x − yj) (ux − vyj2 ) + ( −uy + vx ) j ux + vy − uy + vx

=

=

= 2

+ 2

j

x + yj ( x + yj)( x − yj)

x2 + y2

x + y2

x + y2

Beispiel: Wir möchten (1 − j ⋅

1+ 2j 2

) berechnen.

3 − 4j

1+ 2j 2

(1 + 2 j)(3 + 4 j) 2

(3 + 8 j 2 ) + ( 4 + 6 ) j 2

− 5 + 10 j 2

− 1+ 2j 2

) = (1 − j ⋅

)

=

(

1

−

j

⋅

) = (1 − j ⋅

) = (1 − j ⋅

) =

3 − 4j

25

25

5

32 + 42

5 + j − 2 j2 2

7 + j 2 49 + 14 j + j2 48 14

(

) =(

) =

=

+

j = 1.92 + 0.56 j

5

5

25

25 25

(1 − j ⋅

Es ist auch möglich, die Rechenoperationen geometrisch zu interpretieren. Für Addition und

Subtraktion liegt es auf der Hand: Es werden ja einfach entsprechende Koordinaten addiert, und

deshalb können wir auch die Ortsvektoren der beiden Punkte addieren bzw. subtrahieren und

erhalten den Ortsvektor der Summe bzw. Differenz.

Für die geometrische Interpretation von Multiplikation und Division benötigen wir noch eine andere

Darstellung der komplexen Zahlen, die Polarform. (Die Form x+yj wird kartesische Form oder

Normalform genannt.) In der Polarform werden die Polarkoordinaten r, ϕ von z angegeben, d.h. der

Abstand r des Punktes z zum Nullpunkt und der Winkel ϕ, gemessen von der reellen Achse bis zum

Ortsvektor von z (vgl. obige Figur). Es sind verschiedene Schreibweisen geläufig:

z = r∠ϕ = r cis(ϕ) = r e jϕ

19

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Die erste Schreibweise (gelesen „r Versor ϕ“) wird Versorform genannt und in der Elektrotechnik

gelegentlich noch verwendet. Die zweite ist eine Abkürzung von r(cos(ϕ)+j sin(ϕ)) (mit i statt j); in der

Tat ist ja x = r cos(ϕ) und y = r sin(ϕ). Die dritte verwendet die noch zu definierende Exponentialfunktion. Wir benützen gerade diese Schreibweise. Man nennt r auch den Betrag von z, den Winkel ϕ

das Argument von z,

ϕ = Arg(z)

r = |z| ,

(Matlab: abs(z), angle(z))

Die Umrechnung in die kartesische Form verläuft wie gesagt gemäss

x = r cos(ϕ) ,

y = r sin(ϕ)

in der umgekehrten Richtung gemäss

x

ϕ = sign( y ) ⋅ arccos( )

r

r = x2 + y2 ,

(sign(y) ist das Vorzeichen von y)

Man kann ϕ auch mit Hilfe von arctan(y/x) ausrechnen, muss dann aber noch mehr

Fallunterscheidungen machen. Bei numerischen Berechnungen wird empfohlen, die im Rechner

implementierte Funktion zu verwenden, z.B. eben angle(z) in Matlab. Wir machen darauf aufmerksam,

dass ϕ nur bis auf Vielfache von 2π bestimmt ist, d.h. man kann immer ein ganzzahliges Vielfaches

von 2π addieren oder subtrahieren, ohne die Zahl z zu verändern. Mit Arg(z) ist nach heutiger

Konvention immer der Winkel im Intervall –π < Arg(z) ≤ π gemeint, und so ist auch die entsprechende

Funktion auf Rechnern implementiert.

Wir können nun die angekündigte geometrische Interpretation von Multiplikation und Division

angehen. Seien z = r e jϕ , w = s e jψ in Polarform gegeben. Also

z ⋅ w = r(cos(ϕ) + j sin( ϕ)) ⋅ s(cos(ψ ) + j sin( ψ )) =

rs((cos( ϕ) cos( ψ ) − sin( ϕ) sin( ψ )) + j(cos( ϕ) sin(ψ ) + sin( ϕ) cos( ψ ))) = rs(cos( ϕ + ψ ) + j sin(ϕ + ψ )) = rs e j( ϕ + ψ )

(wobei wir die Additionstheoreme von cos und sin verwendet haben). Das bedeutet:

Um zwei Zahlen zu multiplizieren, multipliziert man ihre Beträge und addiert ihre Argumente.

Um zwei Zahlen zu dividieren, dividiert man ihre Beträge und subtrahiert ihre Argumente.

Die zweite Aussage folgt unmittelbar aus der ersten, weil Division die Umkehrung von Multiplikation

w w ⋅ z * rs e j( ψ − ϕ) s j( ψ − ϕ)

=

=

= e

.

ist. Man kann es auch so sehen: Weil z* = r e j( − ϕ) = r e − jϕ , ist

z

z⋅z*

r

r 2 e j0

Einige Rechenbeispiele:

j2 = 1e

j

π

2

⋅ 1e

j

π

2

= e − jπ = −1

2

(1 + j) ⋅ ( −1 + 3 j) = ( 2 e

3 + j 10

(

) =(

1− j

π

j

2e 6

2e

−j

10

π

4

)

j

π

4 )2

(Statt 1e jϕ schreibt man auch kürzer e jϕ .)

⋅ 2e

=( 2e

j

j

2π

3

= 4e

5π

12 e − jπ )10

j

7π

6

= 4e

−j

10 j

= 2 e

5π

6

= −2 3 − 2 j

5π

⋅10

12

= 32 e

j

25 π

6

= 32 e

j

π

6

= 16( 3 + j)

Die Exponentialschreibweise für die Polarform ist sehr nützlich, weil die Regeln, die wir für

Multiplikation und Division hergeleitet haben, so in natürlicher Weise in die bekannten Rechenregeln

für Potenzen übergehen. In den obigen Rechnungen haben wir auch benutzt, dass

(r e jϕ )m = r me jmϕ

für eine ganze Zahl m

was sich unmittelbar aus den Regeln für Multiplikation und Division ergibt.

20

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

III.2

HS 2011 / baw2

Polynome, komplexe Nullstellen

Dank der Zahl j können wir jetzt auch Wurzeln aus negativen Zahlen ziehen; z.B. hat die Gleichung

z2 = −5 die beiden Lösungen ± 5 j , d.h. das Polynom P(z) = z2 + 5 hat 2 Nullstellen in C. Wir werden

– wie schon erwähnt – sehen, dass jedes nichtkonstante Polynom P(z) in C Nullstellen hat,

beschäftigen uns aber vorerst mit zwei Spezialfällen, wo man die Nullstellen leicht berechnen kann.

a) Kreisteilungsgleichungen

Hier geht es darum, Gleichungen der Form zn = a aufzulösen, d.h. die Nullstellen des Polynoms

P(z) = zn – a zu bestimmen. Dabei ist n eine natürliche, a eine beliebige komplexe Zahl ≠ 0. (Die

Gleichung zn = 0 hat die einzige Lösung z = 0.)

Wir schreiben z und a in Polarform: z = r e jϕ , a = s e jα . Damit lautet die zu lösende Gleichung

r n e jnϕ = s e jα , für Betrag und Winkel einzeln aufgeschrieben

rn = s, nϕ = α mod 2π

Dabei ist mit „mod 2π“ gemeint, dass nϕ und α nur bis auf Vielfache von 2π übereinstimmen müssen,

d.h. nϕ = α + k·2π mit einer ganzen Zahl k. Da s eine positive reelle Zahl ist und r eine solche sein

1

n

s

n

. Für den Winkel haben wir zunächst unendlich viele

soll, ist r eindeutig bestimmt, nämlich r = s =

α

2π

Möglichkeiten, ϕ = + k ⋅

, k ∈ Z. Wenn sich aber zwei Werte von k um ein Vielfaches von n

n

n

unterscheiden, unterscheiden sich die entsprechenden Werte von ϕ um ein Vielfaches von 2π, liefern

also die gleiche Zahl z. Wir erhalten deshalb nur n verschiedene Lösungen, nummeriert z.B. durch

k = 0, 1, …, n−1:

n

zk = s

2π

α

j( + k ⋅ )

n

n

e

=

n

ae

j(

Arg( a )

2π

+k ⋅ )

n

n

,

k = 0, 1, …, n−1

Da alle Lösungen den gleichen Betrag r = n a haben, liegen sie auf einem Kreis um 0 mit diesem

Arg( a )

n

2π

zum Winkel

n

erreicht werden, bilden sie die Ecken eines regelmässigen n-Ecks. Es ist jetzt klar, wieso die

Gleichung zn = a eine „Kreisteilungsgleichung“ genannt wird. Die Lösung z0 wird auch als n-te Wurzel

aus a bezeichnet:

Radius. Da sie ferner von z 0 =

1

n

a = a n := n a e

j

n

ae

j

aus durch Addition eines Vielfachen von

Arg( a )

n

j

π

Wir erinnern daran, dass –π < Arg(a) ≤ π. Es ist also − 1 = 1 e 2 = j (da Arg(−1) = π). Für die so

definierten Wurzeln gelten jedoch die vom reellen Rechnen her bekannten Regeln nicht mehr

uneingeschränkt. Z.B. ist 1 = 1 = ( −1) ⋅ ( −1) ≠

− 1 ⋅ − 1 = j ⋅ j = −1 . Wir gehen später genauer auf

dieses Problem ein.

Spezielle Beachtung verdient der Fall n = 2. Die beiden Lösungen der Gleichung z2 = a sind

z0 = a =

ae

j

Arg( a )

2

, z1 =

ae

j(

Arg( a )

+ π)

2

= −z0 = − a

21

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Hier noch ein Beispiel für eine „Kreisteilung“:

Im

Lösungen von z3 = −8:

z0

j

˚

˚

˚

z0 = 3 8 e

60°

z1

z1 = 2 e

˚1

˚z

Re

j

π

3

= 2(cos(60 o ) + j sin(60 o )) = 1 + 3 j

π 2π

j( + )

3 3

z2 = 2 e

π 4π

j( +

)

3 3

= 2 e j π = −2

= 2e

−j

π

3

= 1 − 3 j = z 0*

2

Beachten Sie dass, nach unserer Definition von Wurzeln,

Ihren Taschenrechner und Matlab!

3

−8 = 3 8e

j

π

3

= 1 + 3 j , nicht −2. Fragen Sie

b) Quadratische Gleichungen

Auch eine quadratische Gleichung a z 2 + b z + c = 0 (a, b, c є C, a ≠ 0) hat in C immer Lösungen, da in

der Lösungsformel

z 0,1 =

− b ± b 2 − 4ac

2a

die Wurzel jetzt definiert ist. Wenn die Diskriminante d := b2 – 4ac Null ist, gibt es genau eine Lösung

( z 0 = z1 =

−b

−b

), andernfalls zwei, und

liegt in der Mitte zwischen den beiden Punkten z0, z1.

2a

2a

Berechnen wir zur Übung die Lösungen der quadratischen Gleichung z2 + (1+j)z + j = 0:

Die Diskriminante ist d = (1+j)2 − 4j = −2j = 2 e

π

j( − )

2 ,

ihre Wurzel

= 2 (cos( −45°) + j sin( −45°)) = 1 − j . Damit erhalten wir z 0 =

d = 2e

π

j( − )

4

=

−(1 + j) + 1 − j

−(1 + j) − (1 − j)

= − j , z1 =

= −1 .

2

2

Betrachten wir noch den in der Praxis wichtigen Fall einer quadratischen Gleichung mit reellen

Koeffizienten a, b, c: Wenn d > 0, sind beide Lösungen reell (wie bekannt!); wenn hingegen d < 0 (der

früher „unlösbare“ Fall), bilden die beiden Lösungen z 0,1 =

d

−b

d −b

±

=

±

j ein Paar zueinander

2a 2a

2a

2a

konjugierter komplexer Zahlen.

Wir kommen jetzt zum allgemeinen Fall und formulieren gerade das als

Fundamentalsatz der Algebra

bekannte Resultat:

Jedes nichtkonstante Polynom P(z) = anzn + an−1zn−1 + … + a0 hat in C mindestens eine

Nullstelle c (d.h. es gilt P(c) = 0).

22

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

Die Koeffizienten a0, a1, …, an dürfen dabei beliebige komplexe Zahlen sein (an ≠ 0), auch wenn

natürlich der Fall wo sie reell sind von speziellem Interesse ist.

Der erste vollständige Beweis dieser Aussage stammt von C. F. Gauss (1777 bis 1855). Wir

begnügen uns mit einer Skizze eines anschaulichen Beweises, deren Details zwar nicht ausgeführt

werden, aber durchaus plausibel sind.

Wir können annehmen, dass an = 1, da wir ja die Gleichung P(z) = 0 durch an dividieren können, ohne

die Lösungen zu verändern. Wir können auch annehmen, dass a0 ≠ 0, denn wenn a0 = 0, ist P(0) = 0,

d.h. 0 ist eine Nullstelle.

Wir untersuchen nun, wie sich P(z) ändert, wenn wir z auf einem Kreis mit Radius r um den Nullpunkt

einmal herumlaufen lassen. Wenn wir r sehr gross (viel grösser als |an−1| bis |a0| und 1) wählen, ist

P(z) ≈ zn, und diese Zahl macht n Umläufe auf einem Kreis mit Radius rn, da zn = (r e jϕ )n = r ne jnϕ . Die

Zahl P(z) umläuft also auf einer geschlossenen Kurve, die immer in der Nähe des Kreises mit Radius

rn verläuft (eine Art Gummiband, vgl. Figur), n mal den Nullpunkt.

r = 4;

P(z) = z5 + j·z4 +(1−j)·z3 + (−2−j)·z2 + 2·z + (1+3·j)

Lassen wir jetzt r schrumpfen, dann schrumpft auch dieses Gummiband und entfernt sich dabei immer

mehr von Kreisform. Am Schluss, wenn r = 0, ist es zum Punkt a0 zusammengeschrumpft, da

P(0) = a0. Nun muss es aber doch in irgendeinem Zwischenstadium passieren, dass das Gummiband

genau durch den Nullpunkt geht, d.h. es muss auf dem Kreis mit dem gerade aktuellen Radius r einen

Punkt z geben, für den P(z) = 0.

Der Fundamentalsatz ist ein schönes theoretisches Resultat, gibt aber keinen Ansatz, wie die Nullstellen konkret zu berechnen sind. Für den Fall n = 2 haben wir oben die Lösungsformeln angegeben;

ähnliche, wenn auch kompliziertere Formeln gibt es bis Grad 4. Ab Grad 5 gibt es keine allgemeine,

aus Wurzelausdrücken aufgebaute Formel mehr (das wurde von Mathematikern bewiesen!); man ist

also auf numerische Näherungsverfahren angewiesen, z.B. das Newtonverfahren, das Sie

wahrscheinlich aus der Analysis kennen.

Folgerungen aus dem Fundamentalsatz

1)

Produktdarstellung eines Polynoms

Jedes Polynom P(z) = anzn + an−1zn−1 + … + a0 kann auch in der Form

P(z) = an(z−c1)(z−c2)···(z−cn)

dargestellt werden, wobei c1, c2, …, cn (alle) Nullstellen des Polynoms in C sind.

Diese Nullstellen können auch ganz oder teilweise zusammenfallen. Sind c1, c2, …, cr die voneinander

verschiedenen Nullstellen, so erhält man durch Zusammenfassen gleicher Faktoren die Darstellung

23

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

n

n

P(z) = an(z−c1) 1(z−c2) 2···(z−cr)

HS 2011 / baw2

nr

, wobei n1 + n2 + … + nr = n = Grad von P

(Die Zahlen n1, n2 ,…, nr heissen Vielfachheiten der Nullstellen.) Dieser Satz beruht darauf, dass man

bei Vorliegen einer Nullstelle c (durch den Fundamentalsatz garantiert) durch Polynomdivision eine

Faktorzerlegung P(z) = (z−c)·Q(z) herstellen kann. (Die Polynomdivision liefert zunächst eine

Darstellung P(z) = (z−c)·Q(z) + R, wo R eine Konstante ist. Jedoch gilt 0 = P(c) = (c−c)·Q(c) + R = R.)

Das Polynom Q hat einen um 1 kleineren Grad als P. Wenn es noch nicht eine Konstante ist, hat es

nach dem Fundamentalsatz wieder eine Nullstelle, usw. Am Schluss bleibt ein Faktor vom Grad 0

(eine Konstante). Diese muss mit an übereinstimmen, da (z−c1)(z−c2)···(z−cn) = zn + … nach

Wiederausmultiplizieren.

Beispiel: Wir untersuchen das Polynom P(z) = z4 + 2·z3 + 8z + 16. Man kann eine Nullstelle erraten:

−2. Durch Polynomdivision erhält man P(z) = (z + 2)(z3 + 8). Wir haben weiter oben die Lösungen der

Gleichung z3 = −8 bestimmt: −2, 1± 3 j. Also hat unser Polynom P(z) = z4 + 2·z3 + 8z + 16 die

Faktordarstellung P(z) = ( z + 2)2 ( z − 1 − 3 j)( z − 1 + 3 j) . Die Nullstelle −2 ist „doppelt“ vorhanden,

d.h. sie hat Vielfachheit 2. Wenn wir die beiden nicht-reellen Faktoren wieder ausmultiplizieren,

erhalten wir P( z) = ( z + 2)2 (( z − 1)2 − ( 3 j)2 ) = ( z + 2)2 (( z − 1)2 + 3) = ( z + 2)2 ( z 2 − 2z + 4) . Das

Besondere daran ist die Tatsache, dass jetzt alle Faktoren reell sind (d.h. reelle Koeffizienten haben),

allerdings einer davon quadratisch, mit negativer Diskriminante. In diesem einfachen Beispiel hätte

man auch direkt (ohne Verwendung von komplexen Zahlen) auf dieses Resultat kommen können,

aber tatsächlich können wir es verallgemeinern: Jedes reelle Polynom (d.h. die Koeffizienten a0, a1,

…, an sind reell) kann als Produkt von reellen linearen und/oder quadratischen Faktoren dargestellt

werden, genauer:

2)

Reelle Produktdarstellung eines reellen Polynoms

Jedes reelle Polynom P(z) = anzn + an−1zn−1 + … + a0 kann in der Form

n

n

P(z) = an(z−c1) 1···(z−cr) r ( z 2 + β1z + γ1 )m1 ⋅ ⋅ ⋅ ( z 2 + β s z + γ s )m s

dargestellt werden, wobei c1, c2, …, cr (alle) reellen Nullstellen des Polynoms sind, und die

quadratischen Faktoren ebenfalls reell, mit negativer Diskriminante.

Um dies zu begründen, brauchen wir noch einen Hilfssatz:

Wenn c є C Nullstelle des reellen Polynoms P ist, dann ist auch die konjugierte Zahl c*

Nullstelle von P.

Denn 0 = (P(c))* = (ancn + an−1cn−1 + … + a0)* = (ancn)* + (an−1cn−1)* + … + (a0)* =

(an)*(c*)n + (an−1)*(c*)n−1 + … + (a0)* = an(c*)n + an−1(c*)n−1 + … + a0 = P(c*). Hierbei haben wir benutzt,

dass man in einer Summe summandenweise und in einem Produkt faktorweise konjugieren darf

(d.h. (z + w)* = z* + w* und (z·w)* = z*·w*; warum?), und dass die ak reell sind.

Ist nun c eine nichtreelle Nullstelle von P, so können wir also die beiden Faktoren (z−c) und (z−c*)

abspalten: P(z) = (z−c)(z−c*)Q(z). Dann multiplizieren wir sie wieder aus,

(z−c)(z−c*) = z2 – (c+c*)z + cc*, und beachten, dass β = −(c+c*) = −2Re(c) und γ = cc* = |c|2 reell sind.

Dass die Diskriminante dieses reellen Faktors z2 + βz + γ negativ ist, folgt aus der Tatsache, dass er

ja keine reelle Nullstelle hat. Um nun in der gleichen Art mit den Nullstellen von Q fortfahren zu

können, müssen wir wissen, dass auch Q reell ist. Dies kann man einsehen, indem man sich Q(z) als

durch die reelle Polynomdivision P(z) : (z2 + βz + γ) entstanden denkt.

Beispiel: Wie lautet die reelle Faktorzerlegung des Polynoms P(z) = z 6 + z 3 + 1 ? Um die Nullstellen

zu bestimmen, bemerken wir, dass die Substitution w = z3 zunächst auf die quadratische Gleichung

w2 + w + 1 = 0 führt, mit den Lösungen w =

±j

− 1± − 3 − 1± 3 j

=

=e

2

2

24

2π

3

. Die Nullstellen sind

BFH-TI Abteilungen EKT und M

Lineare Algebra und Geometrie 1

HS 2011 / baw2

8π

2π 4π

4π ⎫

⎧⎪ ± j 2 π ± j( 2 π + 2 π )

mj

±j

± j( +

)

⎪

9

9

3

9

9

3

=e

= e 9 ⎬ , wobei jeweils die beiden

demnach die 6 Zahlen ⎨e

, e

, e

⎪⎩

⎪⎭

Zahlen mit dem betragsmässig gleichen Winkel (±) zueinander konjugiert sind. Nun ist

Re( e ± jα ) = cos( α ) und e ± jα = 1 , also ( z − e jα )(z − e − jα ) = z 2 − 2 cos(α ) z + 1 .

Wenn wir noch beachten, dass cos(160°) = −cos(20°), erhalten wir schliesslich

z 6 + z 3 + 1 = ( z 2 + 2 cos(20°) z + 1) ⋅ ( z 2 − 2 cos( 40°) z + 1) ⋅ ( z 2 − 2 cos(80°) z + 1)

Diese Zerlegung hätten wir ohne den Umweg über die komplexen Zahlen kaum finden können!

Wir prüfen das Resultat mit Matlab:

>> a = pi/9; % 20°

>> p = conv(conv([1 2*cos(a) 1],[1 -2*cos(2*a) 1]),[1 -2*cos(4*a) 1])

p =

1.0000

0

-0.0000

1.0000

-0.0000

0

1.0000

Die Anweisung conv multipliziert zwei Polynome; Ein- und Ausgabe der Polynome geschehen in

Form ihrer Koeffizientenvektoren, d.h. – beispielsweise – der Vektor [2 0 -5 1] würde für das

Polynom 2 z 3 − 5 z + 1 stehen.

III.3

Eulerformel, Exponentialform

In diesem Abschnitt wollen wir die Schreibweise e jϕ für die Zahl mit Betrag 1 und Argument ϕ

rechtfertigen, d.h. die sogenannte Eulerformel