1 Grundlagen der computergesteuerten Klangerzeugung

Werbung

Sound-Engineering am Computer

Spezialgebiet von Christoph Karner im Wahlpflichtfach

Informatik

Inhaltsverzeichnis

1

2

3

4

5

Grundlagen der computergesteuerten Klangerzeugung ............................................... 2

1.1

Synthesizer ............................................................................................................ 2

1.1.1

Allgemeines .................................................................................................... 2

1.1.2

Geschichte ..................................................................................................... 2

1.2

Klangsynthese ....................................................................................................... 3

1.2.1

Subtraktive Synthese ..................................................................................... 4

1.2.2

Additive Synthese (Fouriersynthese) .............................................................. 6

1.2.3

Frequenzmodulation (FM-Synthese) .............................................................. 8

1.3

Wellenformen ........................................................................................................ 9

1.3.1

Sinus-Wellenform ........................................................................................... 9

1.3.2

Rechteck-Wellenform ................................................................................... 10

1.3.3

Sägezahn-Wellenform .................................................................................. 10

1.3.4

Dreieck-Wellenform ...................................................................................... 11

1.3.5

Rauschen ..................................................................................................... 12

1.3.6

Pulswellen .................................................................................................... 12

1.4

Virtual Studio Technology (VST) ......................................................................... 13

Audioformate .............................................................................................................. 14

2.1

AAC ..................................................................................................................... 14

2.2

AIFF ..................................................................................................................... 14

2.3

MP3 ..................................................................................................................... 14

2.4

Ogg ...................................................................................................................... 15

2.5

Real Audio ........................................................................................................... 16

2.6

VQF ..................................................................................................................... 16

2.7

Wave ................................................................................................................... 17

MIDI ............................................................................................................................ 17

3.1

Allgemeines ......................................................................................................... 17

3.2

Grundstruktur einer Standard-MIDI-Datei ............................................................ 18

3.3

Kanal-Events ....................................................................................................... 19

3.4

Event-Typen ........................................................................................................ 19

Soundkarten ............................................................................................................... 20

4.1

Geschichte........................................................................................................... 20

4.2

Verfahren ............................................................................................................. 20

4.2.1

Sampling ...................................................................................................... 21

4.2.2

Wavetable-Synthese .................................................................................... 21

4.2.3

Moderne Soundkarten .................................................................................. 21

Aufnahmeverfahren und Audiobearbeitung ................................................................ 23

1 Grundlagen der computergesteuerten

Klangerzeugung

1.1 Synthesizer

1.1.1 Allgemeines

Ein Synthesizer ist ein regelbarer, elektronischer Klangerzeuger. Viele Menschen sind der

Meinung, dass ein Synthesizer einfach ein Computer ist, aus dem auf Knopfdruck

computergenerierte, unkreative Musik kommt. Dies stimmt jedoch nur bedingt. Synthesizer

sind elektronische Musikinstrumente, die eine präzise Kontrolle über die Erzeugung

musikalischer Klänge ermöglichen und diese auf elektronischem Weg (analog oder digital)

produzieren.

Oft werden Synthesizer verwendet um Klänge zu erzeugen, die in der Natur nicht

vorkommen bzw. die nicht durch ein anderes Instrument erzeugbar sind. Ein weiteres

Einsatzgebiet ist aber eben diese Nachbildung von bekannten Instrumenten. Hierbei wird

versucht, die Klangfarbe und damit die für ein bestimmtes Instrument typischen Obertöne

zu erzeugen.

1.1.2 Geschichte

Der Traum von der Erstellung künstlicher und noch nie dagewesener Klänge beschäftigt

die Menschen schon seit langem. Mit dem Aufkommen der Elektronik in den 40er Jahren

des 20. Jahrhunderts rückte dessen Erfüllung näher. Einige kuriose Entwicklungen wie

das Aetherophon erweckten zwar eine gewisse Aufmerksamkeit, setzten sich aber, vor

allem wegen ihrer für Musiker ungewohnten Spielweise, nicht großflächig durch.

Dies änderte sich 1964 mit einer Erfindung von Dr. Robert A. Moog (*1934), die er

Synthesizer nannte. Er verknüpfte in seiner Erfindung die Klangerzeugenden Module mit

einem normalen Keyboard, also einer Klaviatur. In diesem Jahr stellte sein erstes, modular

aufgebautes Gerät fertig. Es arbeitete mit der subtraktiven Synthese, die auch heute noch

vorwiegend in Synthesizern anzutreffen ist. Bereits während der Entwicklung konnte er

den Musiker Walter Carlos (später Wendy Carlos) für das Instrument begeistern, der durch

seine praktischen Erfahrungen zur Weiterentwicklung beitrug. Carlos spielte viele Werke

von J.H. Bach auf seinem Synthesizer, was ihm große Erfolge brachte. Da das Moog

Modular System (Abb. 1.1) jedoch für den praktischen Einsatz zu groß, zu kompliziert zu

bedienen und nicht zuletzt durch den hohen Preis für viele Künstler unerschwinglich war,

integrierte Moog die wichtigsten Komponenten seines Synthesizers in ein kompaktes

Gerät, das den Namen Minimoog (Abb. 1.2) erhielt. Bald darauf interessierten sich

zahlreiche und namhafte Musiker für den Minimoog und die Verbreitung des Synthesizers

nahm ihren Anfang.

Im Laufe der 70er Jahre des 20. Jahrhunderts entstanden andere Hersteller und brachten

Synthesizer auf den Markt, die nach dem gleichen Prinzip wie die von Moog arbeiteten:

ARP (von Alan Robert Pearlman), Oberheim und Sequential Circuits.

Zu Beginn der 80er Jahre nahm die Digitaltechnik gleich auf mehreren Ebenen ihren

Einzug in die Synthesizer-Technologie. Musste man bei den Analog-Synthesizern noch

jeden Klang manuell einstellen, kamen nun Geräte auf, die Klangeinstellungen speichern

und schnell wieder abrufen konnten. Zunehmends wurden die Geräte polyphon spielbar

(auch der Minimoog war nur monophon, d.h. nur eine Note konnte zur gleichen Zeit

gespielt werden), und mittels MIDI war es möglich, Synthesizer z. B. von Sequenzern aus

anzusteuern.

2

Abbildung 1.1: Moog Modular System

Abbildung 1.2: Minimoog

Ein Meilenstein in der Entwicklung der digitalen Synthesizer war der Yamaha DX-7 (Abb.

1.3), der 1983 auf den Markt kam.

Der Yamaha DX-7 sorgte mit seiner Synthese durch Frequenzmodulation zum Teil für den

Sound der 80er Jahre. Er vereinte nicht einfach nur die Grundbausteine VCO, VCF, VCA

und LFO in sich; er war etwas völlig Neues. Er bot die oben angesprochene völlig neue

Syntheseform FM-Synthese. Plötzlich waren ganz neue Klänge möglich. Und für die

damalige Zeit klangen diese sogar überraschend naturgetreu. Ein Nachteil des DX-7 war

allerdings, dass die von ihm verwendete FM-Synthese recht kompliziert zu programmieren

war und daher viele Musiker hauptsächlich auf Presets, also vom Hersteller mitgelierferte

Einstellungen, zurückgriffen.

Mittlerweile gibt es sehr viele verschiedene Synthesizer auf dem Markt, mit deren Hilfe

bereits nahezu unendlich viele verschiedene Töne bzw. Klangfarben erzeugbar sind.

Durch die Entwicklung von VST ist der Synthesizer auch keine reine Hardware mehr,

siehe Abschnitt „VST“.

Abbildung 1.3: Yamaha DX-7

1.2 Klangsynthese

Grundlegende Klassifizierung von Synthesizern:

Als Digital-Synthesizer werden alle Synthesizer bezeichnet, deren Klangerzeugung digital

arbeitet. Digitalsynthesizer sind im Prinzip auf Errechnung von digitalen Audio-Signalen

spezialisierte Computer. Computer-Programme, die einen Synthesizer nachbilden, heißen

Software-Synthesizer (siehe Kapitel , Seite ).

Analog-Synthesizer heißen alle Geräte, deren Klangerzeugung mit analogen

Audiosignalen arbeitet. Ältere Geräte werden auch durch analoge Steuer-Signale bzw.

3

spannungsgesteuert kontrolliert, moderne Analog-Synthesizer werden digital über MIDI

gesteuert.

1.2.1 Subtraktive Synthese

Die subtraktive Synthese war bis zur Entwicklung der Digitaltechnik das einzig verfügbare

Syntheseprinzip, da es mit analogen, spannungsgesteuerten Bausteinen (so genannten

Modulen) realisiert werden konnte. Die subtraktive Synthese ist auch heute noch Basis

vieler digitaler Syntheseformen, und wegen der wachsenden Beliebtheit der Techno-Musik

steht sie momentan sogar wieder auf Platz eins.

Die Arbeitsweise basiert auf sehr obertonreichen Wellenformen, die von einem oder

mehreren Oszillatoren erzeugt werden und in ihrer rohen Form steril und hart klingen (siehe

Kapitel 1.3 Wellenformen, Seite 9). Diese Wellenformen werden von einem Filter bearbeitet, das

ihnen bestimmte Klanganteile entzieht. Meist werden Obertöne herausgeschnitten, der

harte Klang wird also durch das Filtern dunkler. Da der Filter von außen steuerbar ist,

kann seine Wirkung im Zeitverlauf durch Modulationen, Hüllkurven oder Spielhilfen

(Controller) gesteuert werden. Die Lautstärke des Klanges beeinflusst ein steuerbarer

Verstärker, der Verläufe wie Einschwingen, Abklingen oder Aushalten realisieren kann.

Diese signalverarbeitenden Module wiederum können von außen durch bestimmte

Steuerbausteine kontrolliert werden, durch deren Arbeit erst ein dynamisches, automatisch

ablaufendes Klangbild möglich ist.

Die unten verwendeten Abkürzungen bezeichnen Module eines subtraktiven Synthesizers.

"DCO" beispielsweise bedeutet „Digitally Controlled Oscillator“. Früher, in rein analogen

Synthesizern, waren die Module spannungsgesteuert, die Kürzel begannen deshalb mit

einem "V". "VCO" bedeutete dementsprechend „Voltage Controlled Oscillator“. In DCSynthesizern wird das Klangsignal zwar noch auf analogem Wege erzeugt, jedoch sind die

Module digital gesteuert, wodurch sich Klänge auch abspeichern lassen.

Die wichtigsten Module eines subtraktiven Synthesizers sind:

Oscillator (VCO, DCO)

Filter (VCF, DCF)

Amplifier (VCA, DCA, Loudness)

Envelope-Generator (ENV, EG, Contour)

Low Frequency Oscillator (LFO, MG)

Noise-Generator

1.2.1.1 Oscillator

Der Oszillator (Schwingungserzeuger) liefert die rohen Wellenformen, die im Kapitel

Wellenformen erklärt werden. Am Oszillator wird außer der Wellenform auch die Tonhöhe

bestimmt. Diese lässt sich in Oktaven vorwählen, fein einstellen (Tune) und natürlich von

anderen Modulen steuern.

1.2.1.2 Filter

In jedem analogen Synthesizer befindet sich ein so genannter Tiefpassfilter, der die tiefen

Anteile passieren lässt und die oberen beschneidet. Der wichtigste Parameter eines

solchen Filters ist die Cutoff-Frequenz, also der Punkt, an dem das Filter auf den Klang

einzuwirken beginnt. Die Klangformung eines Synthesizers wird im Wesentlichen dadurch

realisiert. dass die Cutoff-Frequenz die Obertonanteile der Rohwellen beeinflusst. Da die

Cutoff-Frequenz von außen durch Modulationen oder Hüllkurven steuerbar ist, lassen sich

so Klangfarbenmodulationen und -verläufe erzielen.

Ein weiteres Merkmal ist die Flankensteilheit, die in Dezibel pro Oktave (dB/Oct)

4

angegeben wird. Je steiler ein Filter. desto definierter und sauberer sein "Klang". Ist

beispielsweise die Cutoff-Frequenz eines Filters auf 1 kHz eingestellt und seine

Flankensteilheit 12 dB/Oct, so werden ab 1 kHz sämtliche Frequenzanteile beschnitten.

Wie stark die oberen Anteile abgeschnitten werden, hängt von der Steilheit ab, so werden

hier die Frequenzanteile bei 2 kHz um 12 dB, bei 4kHz bereits um 24dB abgesenkt.

Ein weiterer, wichtiger Parameter ist die Resonanz (Resonance, Peak). Die Resonanz

betont die Frequenzanteile um die Cutoff-Frequenz. Dies kann bis zur Selbstschwingung

des Filters führen. Die Filterresonanz ist verantwortlich für typische Synthesizereffekte wie

z. B. Wah-Wah, die durch ständige Veränderung der Cutoff-Frequenz bei hoher Resonanz

erzeugt werden.

Die Auslegung eines Filters hat beim sowohl bei analogen als auch bei digitalen

Synthesizern eine entscheidende Bedeutung für dessen Klangcharakteristik. Berühmt

geworden ist das Moog-Kaskadenfilter mit einer Flankensteilheit von 24 dB/Oct, das dem

legendären Synthesizer Minimoog seine unverwechselbare Klangfarbe gegeben hat.

Außer dem Tiefpassfilter gibt es unter Anderem folgende Filtertypen:

Hochpass wirkt umgekehrt wie der Tiefpass und beschneidet die unteren Frequenzanteile

Bandpass ist eine Kombination aus Hochpass und Tiefpass, er beschneidet sowohl die

Anteile unter- als auch oberhalb der Cutoff-Frequenz.

Sperrpass (Notch) wirkt umgekehrt wie der Bandpass; er beschneidet nur das

Frequenzband im Bereich der Cutoff-Frequenz und lässt die äußeren Bereiche passieren.

1.2.1.3 Amplifier

Der Amplifier, also Verstärker, kann abhängig von einem Steuersignal die Lautstärke des

Eingangssignals anheben oder absenken. In analogen Synthesizern war das Steuersignal

eine Spannung, heute ist dies ein digitaler Wert.

1.2.1.4 Envelope-Generator

Der Envelope-Generator erzeugt einen zeitabhängigen Verlauf, der als Hüllkurve

bezeichnet wird. Ein typisches, weit verbreitetes Beispiel ist die ADSR-Hüllkurve:

Die ADSR-Hüllkurve ist ein zeitlich bedingter Kurvenverlauf zur Beeinflussung von

Klangparametern, der in analogen Synthesizern vorwiegend für Lautstärke- und

Filterverläufe eingesetzt wird. Die mit analoger Hardware realisierten Verläufe der

Hüllkurve werden mit den folgenden Parametern bestimmt:

A = Attack: Regelt die Geschwindigkeit bis zum höchsten Ausschlag.

D = Decay: Regelt die Zeit bis zum Erreichen des "Halte"pegels; setzt in der Regel erst mit

dem Loslassen der Taste ein.

S = Sustain: Regelt die Amplitude oder "Höhe" des Haltepegels.

R = Release: Regelt die Zeit bis zum Abfall auf 0

Erst mit digitalen Synthesizern kamen komplexere Hüllkurven auf. Je komplexer diese

Hüllkurve ist, desto genauer kann man Verläufe nachbilden

1.2.1.5 Low Frequency Oscillator

Der LFO wird auch als Niederfrequenzoszillator bezeichnet. Er ist ein spezieller Oszillator,

der Schwingungen im unhörbaren Bereich zwischen 0,01 Hz und etwa 30 Hz (je nach

Synthesizer) erzeugen kann. Diese werden nicht als Audiosignale, sondern als

Steuersignale für Modulationen eingesetzt. Der LFO ist für Effekte wie Vibrato, Tremolo,

Wah-Wah, Triller und ähnliche zuständig. Für die Art der erzeugten Modulation ist außer

dem Zielmodul die Wellenform des LFOs wichtig.

5

Während eine Sinus- oder Dreieckwelle fließende Übergänge erzeugt, kann die

Rechteckwelle für harte, abrupte Modulationen verwendet werden. Ein abfallender

Sägezahn simuliert das Anschlagen einer Note, während ein ansteigender sich für

Rückwärtseffekte eignet. Viele LFOs lassen sich zum Tastenanschlag synchronisieren,

d.h. sie starten ihre Modulation genau beim Anschlag einer Note. Dies ist bei langsamen

Modulationen und Effekten notwendig, um etwa beim Tremolo keine „Löcher“ entstehen zu

lassen.

1.2.1.6 Noise-Generator

Ein wichtiger Baustein eines Synthesizers, der jedoch oft in den Oszillator integriert ist, ist

der Rauschgenerator (Noise). Abgesehen von Klangeffekten wie Wind oder Donner, die

direkt aus Rauschen bestehen, wird der Noise-Generator oft dem Oszillatorsignal

hinzugemischt, um Nebenanteile von Klängen zu erzeugen, wie sie in der Anblasphase

von Flötenklängen, anderen Holzblasinstrumenten oder Orgel-Tastenclicks enthalten sind.

Als Modulationsquelle für Filter oder Oszillator benutzt, "verunreinigt" das Rauschen den

Klang etwas, nimmt ihm dadurch in einigen Fällen die Sterilität und erzeugt erst einen

realitätsnahen Klang. Man unterscheidet zwei Arten von Rauschen, deren Bezeichnungen

dem Lichtspektrum entlehnt sind:

Das gebräuchlichere Weiße Rauschen (White Noise) enthält sämtliche Anteile des

Frequenzspektrums in gleichem Maße, ebenso wie weißes Licht sämtliche Farbanteile

enthält.

Im Rosa Rauschen (Pink Noise) sind die tieferen Frequenzanteile stärker vertreten. Es

eignet sich daher besonders gut für dumpfe Geräusche wie Donner oder Sturm.

Diese Bausteine des subtraktiven Synthesizers sind auch bei anderen Formen der

Klangsynthese vorzufinden.

Die stärken eines subtraktiven Synthesizers, besonders des analogen, liegen bei

synthetischen, warmen und druckvollen Klängen. Seine Schwachstelle ist die Nachbildung

von Naturinstrumenten. Analoge Synthesizer erzeugen in erster Linie Solo- und

Flächensounds, Brass (Blechbläser), synthetische Orgelsounds und Effekte.

1.2.2 Additive Synthese (Fouriersynthese)

Die additive Synthese arbeitet nach dem umgekehrten Prinzip wie die subtraktive

Synthese. Statt von einem obertonreichen Spektrum auszugehen und diesem mittels Filter

Anteile zu entziehen, wird beim additiven Synthesizer das Klangspektrum Oberton für

Oberton aufgebaut. In der Regel bietet der additive Synthesizer entweder 32, 64 oder 128

Obertöne. Entweder entsprechen diese der harmonischen Reihe, d.h. unharmonische

Anteile lassen sich nicht oder nur durch Übereinanderlegen und Verstimmen mehrerer

Wellenformen erzielen, oder es lassen sich Obertöne bzw. Obertonblöcke einzeln

stimmen.

Um einen Klang aufzubauen, werden die Obertöne nacheinander in der Amplitude

eingestellt, bis die gewünschte Klangfarbe erzielt ist. Es wäre falsch zu glauben, man

könnte auf diese Weise Naturinstrumente analysieren und durch Nachbildung des

Obertonspektrums wieder synthetisieren, denn bis zu diesem Punkt besitzt man lediglich

ein steriles Spektrum, dessen Klangeindruck dem einer Oszillatorwellenform nicht

unbedingt überlegen ist, schließlich handelt es sich „nur“ um eine Wellenform. Um nun

Zeitverläufe, Schwebungen und Klangformungen zu realisieren, benutzt man je nach

Aufwand verschiedene Verfahren.

6

1. subtraktive Nachbearbeitung

In diesem Fall ersetzt die additive Wellenform den Oszillator in einem

subtraktiven Stimmenaufbau. Der Vorteil gegenüber dem analogen Synthesizer

ist der, dass bereits das rohe Klangmaterial aufgrund seiner Obertonstruktur dem

Zielklang sehr ähnlich ist. Lautstärke- und Klangverläufe werden hier also wie

gewohnt durch Filter und Amplifier gebildet, Schwebungen werden innerhalb des

Spektrums kompromissweise durch Detunen (verstimmen; überlagern) zweier

Wellenformen oder einen Choruseffekt erzeugt.

Die restlichen Module sind ebenfalls mit denen eines subtraktiven Synthesizers

vergleichbar. Der Nachteil besteht darin, dass die zur detaillierten Klangformung

nötigen Verläufe einzelner Obertöne nicht möglich sind, sondern dass immer ein

kompletter Block durch den Filter bearbeitet wird.

2. Kombination mehrerer Spektren

Dieses Prinzip, das übrigens ebenfalls mit einer subtraktiven Nachbearbeitung

verknüpft sein kann, realisiert die Klangformung dadurch, dass mehrere sehr

unterschiedliche Spektren gebildet werden, von denen jedes einen bestimmten

Anteil am Klang übernimmt. Diese Spektren werden dann durch geschickt

programmierte Hüllkurven ineinander geblendet. Dieses Prinzip ist eine

technisch einfachere Variante des Prinzips 3).

Beispiel: In einem Gitarrensound übernimmt ein sehr perkussives Spektrum aus

hohen, ungeraden Obertönen das Zupfgeräusch, während zwei Spektren den

Grundklang der Gitarre mit abnehmendem Obertongehalt im zeitlichen Verlauf

erzeugen.

3. Obertöne separat programmierbar

Dieses System ist technisch sehr aufwendig und stellt auch an den

Programmierer hohe Anforderungen, liefert jedoch die besten Ergebnisse. Hier

ist jeder Oberton in seiner Amplituden- und gegebenenfalls Frequenzhüllkurve

einzeln programmierbar, sodass sehr vielschichtige Klangverläufe sowie

Verstimmungen der Obertöne innerhalb des Spektrums möglich sind. Erst diese

ermöglichen die wirklich authentische Nachbildung eines Naturinstruments bzw.

die Erzeugung komplexer, neuartiger Digitalsounds.

Mit additiver Synthese lassen sich vornehmlich digital klingende, technische und

metallische Sounds bilden. Die Programmierung additiver Systeme ist relativ komplex und

trotz der konkreten Wellenformen vorher schwer bestimmbar, und deshalb konnte sich

diese Form der Synthese gegenüber der subtraktiven Synthese nicht durchsetzen. Hierbei

ist von Bedeutung, dass die Obertöne einer z. B. Sägezahnschwingung mit verschiedene

Amplitude (Lautstärke) schwingen. Diese müssen bei der Additiven Synthese erst noch

einzeln bestimmt werden.

Ein älteres, sehr bekanntes Instrument, das die Additive Synthese anwendet, ist die

Hammond-Orgel (Abb 1.4). Dabei ist die Zusammensetzung der Frequenzen statisch, doch

die elektromechanische Erzeugung der Töne führt zu einer „Verunreinigung“ der Töne,

was dem Instrument die typische Klangfarbe verpasst. Bei einem natürlichen Instrument

verändert sich jedoch die Zusammensetzung der verschiedenen Frequenzen mit der Zeit.

7

Abbildung 1.4: Hammond B3

1.2.3 Frequenzmodulation (FM-Synthese)

Die Entwicklung der FM-Synthese stellte zweifelsohne einen Meilenstein auf dem Gebiet

der digitalen Klangerzeugung dar. Da das Prinzip patentiert ist, wird es bisher

ausschließlich von Yamaha verwendet. Yamahas DX7 (Abb. 1.3) erzielte mit der FMSynthese auf einen Schlag einen weltweit bisher unerreichten Erfolg. Heutzutage ist FM

nur eine unter vielen Syntheseformen.

FM steht für Frequenzmodulation. Das Prinzip an sich wurde von dem amerikanischen

Wissenschaftler Dr. John Chowning entwickelt. Im DX7 wurde es erstmals hardwaremäßig

realisiert und in Serie produziert. Die FM-Synthese erzeugt Klänge auf der Basis

sogenannter Operatoren. Ein Operator ist ein Sinusoszillator (in neueren Geräten oder

PC-Soundkarten gibt es bereits auch andere Wellenformen) mit einer programmierbaren

Frequenz und Hüllkurve. Jeder Operator hat einen Pitch-Eingang, der sowohl vom

Keyboard als auch vom Frequency-Parameter (Stimmung) seine Daten erhält, und einen

Modulationseingang, der mit dem Ausgang eines Modulators oder des LFO "verbunden"

wird.

Im FM-Synthesizer werden mehrere Operatoren in Strukturen zusammengeschaltet. Die

einfachste Struktur ist das Carrier-Modulator-Paar. Die vom Modulator erzeugte

Schwingung wird dem Frequenzeingang des Carriers (Trägers) zugeführt und moduliert

dessen Tonhöhe. Die Frequenzmodulation kann man sich als Vibrato vorstellen, dessen

Frequenz im hörbaren Bereich liegt, das also nicht mehr als langsame Schwingung,

sondern als "Klangfarbe" wahrgenommen wird. Je mehr Operatoren zusammengeschaltet

sind, desto komplexere Spektren sind möglich. Die Kombination dieser Operatoren

bestimmt wesentlich das Ergebnis und wird als "Algorithmus" bezeichnet.

Je nach Synthesizertyp sind vier bis sechs (in den Yamaha-HX-Orgeln aber bis zu 16)

Operatoren zu verteilen. Daraus werden Gruppen miteinander verknüpfter Operatoren,

sogenannte "Stränge", gebildet. Hier gibt es zwei Grundregeln:

Viele einfache Stränge eignen sich für Sounds mit mehreren Bestandteilen, die für sich

allein keine komplexe Obertonstruktur aufweisen.

Wenige komplexe Stränge (je drei oder vier Operatoren) erzeugen äußerst komplizierte

Spektren.

Man unterscheidet zwischen einfacher und komplexer Frequenzmodulation. Die einfache

Frequenzmodulation beschränkt sich auf ein einziges Carrier-Modulatorpaar. Hier spielen

folgende Faktoren eine wesentliche Rolle:

1. Das Frequenzverhältnis des Carriers zum Modulator (Ratio) bestimmt die

Zusammensetzung des Spektrums: Die bei der Frequenzmodulation erzeugten

Obertöne sind vom Frequenzverhältnis des Carriers zum Modulator abhängig.

Die FM-Synthesizer arbeiten mit relativen Frequenzen, wobei der von der

gespielten Note definierte Grundton den Wert 1.00 hat, die Oktave darüber 2.00

8

usw. Die Werte des Frequenzparameters (Coarse) entsprechen den

Frequenzstufen der harmonischen Obertonreihe, zusätzlich lassen sich über

einen Fine-Parameter ungerade Obertöne erzielen.

2. Die Amplitude des Modulators (Modulationsindex): Wie weit die Reihe der

erzeugten Obertöne reicht, wird von der Modulationsintensität bestimmt. Diese

ist vom Level abhängig, mit dem der Modulator den Carrier beeinflußt. Einfacher

gesagt: Je höher der Modulatorlevel, desto höher die Modulationsintensität,

desto mehr Obertöne werden erzeugt. Da der Modulator eine eigene Hüllkurve

besitzt, lassen sich komplexe Klangfarbenverläufe bereits mit einem einzigen

Pärchen erzeugen, ganz zu schweigen von vier seriellen Operatoren. Hier liegt

dementsprechend auch die Stärke der Frequenzmodulation.

Mit Hilfe der komplexen Frequenzmodulation werden die eigentlich interessanten Sounds

erzeugt. Die komplexe FM wird durch Kaskadierung oder Parallelschaltung von Carriern

oder Modulatoren erreicht. Werden beispielsweise drei Operatoren übereinander

angeordnet, so wandert das bereits frequenzmodulierte Signal aus dem mittleren Operator

als Modulationsquelle in den Carrier. Dessen Signal wird demzufolge umso komplexer.

Der Vorteil der FM-Synthese besteht darin, daß man bereits mit recht einfachen Mitteln

und wenigen Parametern Lebendigkeit und Komplexität erreicht. Ein Nachteil, zumindest

für Einsteiger, ist die Tatsache, dass das Klangergebnis bei der Programmierung schwer

vorhersehbar ist.

Möchte man die Klangcharakteristik der FM-Synthese beschreiben, kann man sie sowohl

als „akustisch“, „klar“ oder auch als „metallisch“ bezeichnen. Kein Syntheseprinzip ist so

variabel wie die FM-Synthese. Dies wird allein dadurch bewiesen, dass für FMSynthesizer Zehntausende unterschiedlicher Sounds existieren.

Es gibt neben diesen drei Formen der Klangsynthese noch viele weitere, modernere

Syntheseformen, die jedoch immer komplizierter zu beschreiben sind. Hinzu kommt, dass

nahezu jeder namhafte Hersteller von Synthesizern laufend neue Verfahren entwickelt

bzw. verbessert.

Die bei Soundkarten wichtigen Formen Wavetable-Synthese und das spezielle Sampling

wird in Kapitel 4 beschrieben.

1.3 Wellenformen

Ein Oszillator (siehe Kapitel 1.2.1.1 Oscillator, Seite 4) erzeugt rohe Wellenformen, die hier

beschrieben werden.

1.3.1 Sinus-Wellenform

Dies ist die einfachste Wellenform und bildet zugleich das Grundgerüst für alle anderen

Wellenformen. Reine Sinusschwingungen kommen in der Natur nicht vor, doch im Prinzip

ist es möglich, alle in der Natur vorkommenden akustischen Ereignisse so weit

mathematisch zu zerlegen, dass nur noch Sinus-Töne übrig bleiben. Wie genau eine

Sinusschwingung mathematisch berechnet wird, kann man in jedem drittklassigen

Mathematik-Buch nachlesen. Der Piep-Ton bei TV-Testbildern ist ein bekanntes Beispiel

für eine einfache Sinusschwingung.

9

1.3.2 Rechteck-Wellenform (Square)

Abbildung 1.5: Rechteck-Wellenform

Wenn man sich die vertikale Y-Achse als Zahlenleiste vorstellt, die von -1 bis +1 reicht

(wobei die rote Line die „null“ markiert), springen bei Rechteck-Wellenformen die Werte

immer zwischen einem festgelegten positiven und negativen Wert hin- und her (z.B.

zwischen 0.75 und -0.75). Wenn man eine Rechteck-Wellenform in einzelne Sinustöne

zerlegt, findet man nur ungerade Harmonische, die in einem ungeraden Verhältnis in der

Lautstärke abnehmen.

„Harmonische“ = „Obertöne“ = „Teiltöne“. Sie bezeichnen Schwingungen, deren Frequenz

oberhalb der Grundfrequenz des Klanges liegt. Sie bestimmen die Klangcharakteristik des

Tons, ob er dumpf oder hell, spitz oder rund klingt.

Die mathematische Formel für Rechteck-Schwingungen lautet:

f(t) = sin(t) + 1/3 sin(3t) + 1/5 sin (5t) + 1/7 sin (7t) + 1/9 sin (9t) + 1/11 sin (11t) (...)

Man könnte also eine Sinus-Schwingung von 100 Hz in voller Lautstärke nehmen, dazu

eine Sinus-Schwingung von 300 Hz zumischen, die nur 33% der Originallautstärke besitzt,

außerdem eine 500 Hz Sinusschwingung mit 20% der Originallautstärke, eine 700 Hz

Sinusschwingung mit 14,29 % der Originallautstärke usw.

Auf diese Weise kann man eine Rechteck-Wellenform rekonstruieren.

1.3.3 Sägezahn-Wellenform (Saw)

Bei Abb. 1.6 handelt es sich um einen so genannten „steigenden“ Sägezahn. Der

Sägezahn enthält sowohl gerade als auch ungerade Teiltöne. Das macht ihn klanglich

zum interessantesten Ton. Sägezähne werden fast immer mit einem Tiefpassfilter (siehe

Abschnitt subtraktive Synthese) versehen, um den Ton weicher und runder zu gestalten.

Die mathematische Formel für einen Sägezahn lautet:

f(t) = sin (t) + 1/2 sin (2t) + 1/3 sin (3t) + 1/4 sin (4t) + 1/5 sin (5t) + 1/6 sin (6t) + 1/7 sin (7t)

(...)

Wenn man die geraden Teiltöne in der Phase dreht (invertiert), ergibt sich ein fallender

Sägezahn.

10

Die mathematische Formel für einen fallenden Sägezahn lautet:

f(t) = sin (t) - 1/2 sin (2t) + 1/3 sin (3t) - 1/4 sin (4t) + 1/5 sin (5t) - 1/6 sin (6t) + 1/7 sin (7t)

(...)

Abbildung 1.6: steigender Sägezahn

1.3.4 Dreieck-Wellenform (Triangle)

Abbildung 1.7: Dreieck-Wellenform

Die Dreiecks-Wellenform kommt der Sinus-Welle klanglich und optisch sehr nahe. Sie

enthält nur wenige (ungerade) Teiltöne, deren Lautstärke exponential abnimmt.

Ihre Formel lautet:

f(t) = sin (t) + 1/9 sin (3t) + 1/25 sin (5t) + 1/49 sin (7t) + 1/81 sin (9t) + 1/121 (11t)

11

1.3.5 Rauschen (Noise)

Abbildung 1.8: Rauschen

Beim Rauschen wird der Wert auf der Y-Achse nach einem Zufalls-Algorithmus gestreut.

Man unterscheidet je nach Formel zwischen rosa und weißem Rauschen. Rauschen

kommt in der Natur unter Anderem als Windgeräusch und Meeresrauschen in reiner Form

vor. Man kennt es aus dem Radiogerät und vom Kassettenrecorder. Jeder natürliche Ton

hat immer einen gewissen Rauschanteil und so ist es auch zur Nachbildung von

Naturinstrumenten unverzichtbar. Ein beliebter Sound-Effekt besteht darin, Rauschen

durch einen Filter mit hoher Resonanz-Einstellung zu schicken, dessen Cutoff-Frequenz

auf und ab wandert (siehe Abschnitt subtraktive Synthese).

1.3.6 Pulswellen (Pulse)

Abbildung 1.9: Pulswellen

Pulswellen sind Wellenformen, die durch einen Gleichrichter geschickt wurden, der alle

negativen Werte auf der Y-Achse in positive Werte verwandelt. Dadurch verdoppelt sich

die Frequenz und die Wellenformen werden "energiereicher". Eine Pulswelle läßt sich

durch drei Parameter beschreiben:

Der Impulsabstand, also der Abstand zwischen den einzelnen Impulsen. Je

geringer der Impulsabstand, desto höher ist die Grundfrequenz.

12

Die Pulsbreite ("pulse width") - die horizontale Ausdehnung der einzelnen Impulse.

Je schmaler die Impulse sind, desto dünner und brüchiger wirkt der Sound.

Die Fläche unter den Impulsen. Je größer sie ist, desto "energiereicher" ist der

Sound.

1.4 Virtual Studio Technology (VST)

VST bezeichnet die 1996 von der Firma Steinberg festgelegte Schnittstelle für virtuelle

Instrumente. Das VST-Interface ist bis heute eine kleine Revolution im Bereich der

digitalen Musik.

VST erlaubt die Integration von virtuellen Effektprozessoren und -instrumenten in einer so

genannten Host-Anwendung bzw. Sequencer.

Es ist quasi eine virtuelle Nachahmung einer Studioumgebung in einem Rechner. Dies

wird mittels VST-Plugins realisiert, die klassische, teure Hardware-Effektgeräte ersetzen,

aber sie können auch Instrumente (Synthesizer, Sampler) simulieren. Diese VST-Plugins

werden auch VSTi genannt. VSTi sind also mit Ausnahme der Sampler SoftwareSynthesizer. Diese Software-Synthesizer, aber auch VST-Sampler und ähnliche “Geräte”

werden komplett über MIDI gesteuert. Man lädt einen oder mehrere Software-Synthesizer

in einen Sequencer und schreibt mit diesem Sequencer die Noten und Steuerbefehle für

das jeweilige PlugIn. Das PlugIn empfängt dann die MIDI-Befehle vom Sequencer, macht

daraus hörbare Klänge und sendet diese zurück zum Sequencer.

Da VST-Plugins nur in einer Host-Anwendung laufen, die die Audio-Datenströme

organisiert, sind sie also keine richtigen Anwendungen. Der Datenstrom wird zu diesem

Zweck in Blöcke zerlegt und an das Plugin übergeben. Die Host-Anwendung ist an der

eigentlichen Signalverarbeitung nicht beteiligt und braucht auch keine Informationen über

den Prozess, um das Plugin zu benutzen. Der Quell-Code eines VST-Plugins ist

plattformunabhängig, aber seine Einbindung hängt von der Plattform-Architektur und dem

Betriebssystem ab. Auf einem PC ist ein VST-Plugin eine DLL (Dynamic Link Library), auf

dem Apple Macintosh ist es eine Raw-Code-Ressource. Der Name des Plugins entspricht

nicht dem Dateinamen, sondern dem Namen der Ressource. Die Host-Anwendung sucht

bei Programmstart einen Ordner mit dem Namen „VstPlugIns“.

13

2 Audioformate

2.1 AAC

AAC steht für Advanced Audio Coding. Das Format wurde von Dolby Laboratories, AT&T,

Sony und dem Fraunhofer Institut entwickelt. Standardisiert als Erweiterung zu MPEG 2

und als Teil von MPEG 4, hat es einen großen Vorteil gegenüber MP3: es ergibt sich die

gleiche Qualität bei halber Dateigröße, da es auf einem verbesserten MP3-Algorithmus

beruht. Dadurch ist schon bei ISDN-Bandbreite (64 kB/s) gute Stereoübertragung möglich.

2.2 AIFF

AIFF steht für Audio Interchange File Format.

Das Format wurde ursprünglich von Apple entwickelt (1988) und entspricht dem EA IFF 85

Standard for Interchange Format Files von Electronic Arts.

Das Format weist eine Chunkstruktur auf (Chunk = Happen, Brocken) wie auch das Waveoder AVI-Format (ein Videoformat). Ein Chunk besteht aus einem Kopfteil und einem

Datenteil.

In der ursprünglichen Version war keine Kompression vorgesehen. Erst mit der

Erweiterung des Formates zu AIFF-C war es möglich die Daten zu komprimieren, wobei

man in der Wahl der Kompressionsart frei war. Die Informationen zur verwendeten

Kompressionart werden in einem zusätzlichen Chunk gespeichert.

Merkmale:

Übertragungsrate von 960 kB/min (unkomprimiert)

Die Größe einer komprimierten Datei hängt vom verwendeten Algorithmus ab.

AIFF besitzt annähernd Radioqualität.

2.3 MP3

MP3, genauer MPEG 1 Layer 3, ist eine Sonderform des MPEG-Videoformats, die vom

Fraunhofer Institut für integrierte Schaltungen in Erlangen entwickelt wurde.

MP3 hat sich binnen kürzester Zeit zum Standardformat für Musik im Internet etabliert.

Die enorm hohe Kompressionsrate wird durch gezielte Ausblendung von für das

menschliche Ohr kaum hörbaren Elementen und Transformationscodierung mittels FFT

(Fast Fourier Transformation) und DCT (Discrete Cosinus Transformation) erreicht. Die

dadurch erzielte Dateigröße liegt bei einer Abtastung von 128 kB/s und einer

Samplingfrequenz von 44,1 KHz bei 1 MB/min.

Es sind wahlweise konstante oder variable Bitraten möglich. Bei variabler Bitrate zur

Abtastung wird in Bereichen großer Dynamikschwankungen, geringer Stereotrennung

(gleiche Signale für beide Kanäle) oder auch Pausen im zu kodierenden Stück mit weniger

Bits abgetastet, während an Stellen mit feinen Dynamikschwankugen oder hoher

Stereotrennung die Auflösung der Abtastwerte hochgefahren wird. Dies bewirkt eine

geringe Einsparung an Speicherplatz, bringt aber auch einige Probleme mit sich. So kann

der Player nicht mehr die exakte Länge des Stücks ermitteln und Sprünge innerhalb des

Stücks können mitunter nicht exakt ausgeführt werden, was zur Folge hat, dass diese

Form der Kodierung recht selten angewandt wird, da der Gewinn an Speicherplatz zu

gering ist, als dass man diese Nachteile in Kauf nehmen würde.

14

MP3 rauscht stärker als eine CD.

MP3 klingt härter, kälter und farbloser als eine CD.

MP3 hat Schwächen bei feinen Dynamikunterschieden.

Aufgrund dieser Eigenschaften ist MP3 für klassische Musik nicht besonders geeignet,

aber für aktuelle Pop- und Rockmusik sind die Ergebnisse mehr als akzeptabel, wobei

dies auch immer auch immer vom subjektiven Eindruck und Qualitätsanspruch abhängt.

Eine Weiterentwicklung des MP3-Formats ist MP3pro.

Dank neuartiger Technologie braucht MP3Pro bei gleicher Klangqualität nur die Hälfte an

Speicherplatz auf einem Datenträger. Den Schlüssel zu dieser enormen

Kompressionssteigerung liefert SBR. Die Abkürzung steht für Spectral Band Replication.

SBR eignet sich speziell für die Codierung von hohen Frequenzen in

Audiokompressionsalgorithmen und bügelt die MP3-Schwachstelle aus, bei niedrigen BitRaten in den Höhen muffig zu klingen. Das Verfahren setzt auf dem MP3-Codec auf.

Dadurch bleibt es abwärtskompatibel zu herkömmlichen MP3-Files.

Eine mit MP3Pro codierte Datei mit 64 kBit/s entspricht qualitativ einer MP3 Datei mit ca.

100 kbit/s Stereo, und das bei halber Dateigrüße. Dieser Vorteil macht sich besonders bei

portablen MP3-Playern bemerkbar, bei denen Speicherplatz momentan noch ein großer

Kostenfaktor darstellt. Bei zunehmender Bandbreite des Netzes wird MP3Pro zu einer

noch schnelleren Übertragung von MP3-Files bei Musiktauschbörsen wie KaZaA führen.

Dies ist der Musikindustrie natürlich ein Dorn im Auge.

Eine Besonderheit des MP3-Formats ist das ID3-Tag.

ID3-Tags in MP3-Dateien können die Informationselemente Titel, Künstler, Album, Jahr,

Kommentar und Genre des Musikstücks enthalten. Sofern vorhanden, befinden sich die

Tags am Ende der Audiodatei und sind nach dem ID3v1-Standard exakt 128 Bytes lang.

Der Aufbau ist exakt festgelegt: Die ersten drei Bytes sind für die Zeichenfolge "TAG"

reserviert, um den Anfang zu definieren.

Insgesamt sind die 128 Bytes wie folgt eingeteilt:

TAG 3 Bytes, Titel 30 Bytes, Künstler 30 Bytes, Album 30 Bytes, Jahr 4 Bytes, Kommentar

30 Bytes, Genre 1 Byte.

Diese Tags werden von jedem MP3-Player gelesen und bei der Wiedergabe angezeigt.

Das neuere und erweiterte Tag-Konzept (ID3v2) umgeht das 128-Byte-Limit, verlegt die

Tags an den Anfang der Datei und erlaubt einen theoretischen Umfang von bis zu 256

MB. Hier lassen sich dann etwa Songtexte oder Bilder der Künstler einbinden.

Da die ID3v2-Tags mit den älteren ID3v1-Tags nicht kollidieren und problemlos

nebeneinander existieren können, sind keinerlei Probleme zu befürchten, wenn man

"klassische" Tags anlegt oder ändert obwohl gleichzeitig erweiterte Tags bestehen.

2.4 Ogg

Ogg Vorbis ist ein neues Audio-Kompressions-Format. Es ist schwer mit anderen

Formaten zum Speichern und Abspielen von digitaler Musik (wie z.B. MP3, VQF, AAC,...)

zu vergleichen, weil Ogg Vorbis absolut kostenlos und patenfrei ist, und der Quellcode

offen liegt (Open Source).

Vorbis ist der der Name eines speziellen Audiokompressions-Schemas, das benutzt wird,

um Ogg Vorbis Dateien zu erstellen. Es ist Bestandteil des Ogg Projektes, einem

umfassenden Projekt um ein völlig kostenloses Multimedia-System zu erstellen. Zurzeit ist

Ogg Vorbis der einzige funktionierende Teil des Ogg Projektes.

Vorbis bietet ein qualitativ hochwertiges Format um Audiodateien zu hören. Bei gegebener

15

Dateigröße klingt Vorbis besser als MP3 und wird durch die andauernde Entwicklung noch

besser werden. Es gibt bereits umfassende Player-Unterstützung und sollte bald auf

mehreren größeren Hardware-Playern abspielbar sein. Mit Vorbis kann man bei

gleichbleibender Qualität Platz sparen. Auch ist man bei der Benutzung nicht an Lizenzen

gebunden. Zurzeit kann man nur aus wenigen MP3-Encodern wählen, da die meisten

Unternehmen nicht bereit oder nicht fähig sind, Lizenzen zu zahlen.

Zwei Dateien werden immer gleich groß sein, wenn sie beide mit CBR (Konstante Bitrate)

enodiert wurden. Der aktuelle Vorbis Encoder kann Dateien auch in VBR (Variable Bitrate)

encodieren, welches kleinere Dateien mit besserer Qualität zur Folge hat, da es keine

Daten für Dateien verschwendet, die leicht zu encodieren sind. Dateien, die bei der

Standard-Einstellung 3 encodiert werden, haben dann bei 110 kbps eine kleinere Größe

und deutliche bessere Genauigkeit als MP3-Kompression bei 128kbps hat.

Ein weiterer wichtiger Bestandteil von Vorbis ist das streaming, ähnlich wie bei Real Audio.

Das Format wurde von Grund auf entwickelt, einfach zu streamen zu sein.

2.5 Real Audio

Real Audio wurde 1995 von RealNetworks (Seattle) als hoch komprimiertes, speziell für

das Internet konzipiertes Soundformat entwickelt.

Obwohl es durch MP3 immer mehr in den Hintergrund gedrängt wurde, wird es immer

noch verwendet, da es streamingfähig ist. Dies bedeutet, dass die eigentliche Datei in

kleine Pakete zerlegt und separat verschickt wird. Dadurch ist sie auch bei niedriger

Bandbreite in Echtzeit vom Server abspielbar, was mit MP3 zurzeit noch nicht möglich ist.

Aufgrund der Streamingfähigkeit wird Real Audio für Internetradio und andere LiveÜbertragungen verwendet.

Die Qualität ist abhängig von der Bandbreite, die zur Verfügung steht. Das heißt, je

weniger Bandbreite zur Übertragung zur Verfügung steht, desto niedriger ist die Qualität

der übermittelten Version. Sollte die Bandbreite unter ein Minimum fallen (< 14kB/s), so

werden einfach Pakete ausgelassen. Dies hat zur Folge, dass ab etwa 15% fehlender

Pakete eine menschliche Stimme wie ein Roboter klingt.

2.6 VQF

VQF ist ein von Yamaha entwickeltes Soundformat. Es erschien kurz nach MP3 (im Jahr

1995) und ist auch aus SoundVQ oder TwinVQ bekannt.

Der Kompressionsalgorithmus beruht auf Vektorquantisierung. Aufgrund der Ähnlichkeiten

der Elemente in Musikstücken ist es möglich, diesen „Standardbausteinen“ einen Index

zuzuweisen, der einem Eintrag in einer Bitmustertabelle entspricht. Diese Tabelle kann

mehrdimensional aufgebaut sein, wobei der Index dann einem Vektor entspricht. Der

Dekoder besitzt die gleiche Mustertabelle und kann aus den Indexen (Vektoren) die

komplette Bitstruktur wieder zusammensetzen. Dadurch entsteht eine Dateigröße, die

etwa 25-35% kleiner ist als die einer MP3 (bei 128 kB/s) bei besserer oder gleicher

Qualität. Die maximale Abtastrate beträgt allerdings 96 kB/s.

Die allgemeine Ausrichtung liegt eher auf hoher Kompression als auf High-End

Audioqualität. Dies macht das Format vor allem für Benutzer interessant, die großen Wert

auf Platzersparnis legen oder über geringe Bandbreite verfügen. Allerdings ist es sehr

unwahrscheinlich, dass sich das Format gegen Mp3 als Standard durchsetzen können

wird, da sowohl die Bandbreiten als auch die Festplatten immer größer und billiger

werden.

16

2.7 Wave

Das Wave-Format wurde von Microsoft und IBM Anfang der achtziger Jahre entwickelt

und wurde das Standard-Format in der Windows PC-Welt. So sind zum Beispiel sämtliche

Windows System-Klänge im Wave-Format kodiert.

Wave-Dateien enthalten digital kodierte analoge Signale; die Dateien sind in Chunks

strukturiert.

Der Speicherbedarf von Wave-Dateien ist sehr groß, ca. 10MB/min bei

Standardparametern (Auflösung 16 Bit, 44,1 kHz Samplingrate, Stereo). Durch Variation

dieser Werte lassen sich unterschiedliche Dateigrößen und Qualitäten erzielen.

Da kein Qualitätsverlust beim Erstellen einer Wave Datei gegenüber dem Original auftritt,

ist es immer noch das am häufigsten verwendete Arbeitsformat für Audiobearbeitung.

Das WAV Format von Microsoft basiert wie AIFF/AIFF-C auf dem EA IFF 85 Standard for

Interchange Format Files, besteht also auch aus Chunks. Ein wesentlicher Unterschied

besteht jedoch in der Anordnung der Bytes (INTEL-Anordnung). WAV ist ein Teil des

allgemeinen RIFF-Standards (Resource Interchange File Format) von Microsoft. So

existieren neben WAV auch Dateien für die Speicherung von Bitmaps, Farbpaletten und 2

Formate für MIDI Daten.

3 MIDI

3.1 Allgemeines

MIDI steht für Musical Instrument Digital Interface, übersetzt Digitale Schnittstelle für

Musikinstrumente.

Es wurde maßgeblich von den Firmen Sequential Circuits und Roland entwickelt und

erstmals 1983 vorgestellt.

MIDI ist im eigentlichen Sinne gar kein Audioformat, da es keine Audiodaten bzw.

Klangsamples enthält, sondern ein Textformat, welches Steuerdaten für Midigeräte

enthält. MIDI an sich ist also ein Protokoll, das Klänge nicht direkt darstellt, sondern aus

Befehlen zur Ansteuerung eines Empfängers wie digitalen Instrumenten oder Soundkarten

besteht.

Diese Befehle werden Events oder auch Messages genannt, und sie sind als Sprache zu

verstehen. Diese Sprache besteht aus genormten Codes (wie auch z.B. das MorseAlphabeth oder der ASCII-Standard), die zur Übertragung bestimmter Informationen wie

zum Beispiel dem Drücken einer Taste dienen. (siehe Event-Tabelle unten)

Dadurch dass MIDI nur aus Text besteht, sind Dateien im Vergleich zur direkten

Speicherung von Musik (wie z.B. als WAV-Datei) klarerweise wesentlich kleiner.

Damit in einem MIDI-System nicht alle Geräte dieselben Noten spielen, ist es möglich, die

Messages zu kanalisieren. Dies wird durch die sogenannten MIDI-Kanäle möglich

gemacht. So ist es möglich einem Gerät, welches z.B. Schlagzeugklänge erzeugen kann,

einen anderen MIDI-Kanal zuzuweisen als einem zweiten Instrument, welches z.B. für

Bass-Klänge zuständig ist. Die an die Instrumente übermittelten Messages sind mit einer

Kanal-Information versehen, sodass der Empfänger erkennen kann, welche Informationen

er verarbeiten soll (diese werden auf "seinem" MIDI-Kanal übermittelt) und welche nicht.

Viele Instrumente sind heutzutage in der Lage, auf mehreren Kanälen gleichzeitig zu

empfangen (dieses wird auch Multimode genannt), sodass ein Instrument z.B. auf Kanal 1

einen Klavierklang, auf Kanal 2 den Klang einer Trompete, auf Kanal 3 einen Orgelsound

usw. erzeugen kann. Insgesamt gibt es 16 MIDI Kanäle. Um zwei verschiedene Klänge

17

dasselbe spielen zu lassen, ist es natürlich auch möglich, zwei Geräte (oder zwei Parts

eines Multimode-Gerätes) auf demselben MIDI-Kanal zu betreiben. Sämtliche 16 MIDIKanäle werden über ein MIDI-Kabel, ein 5-poliges DIN-Kabel, übertragen. Das läßt sich

mit einem Fernseher vergleichen, der ja auch mehrere Programme empfangen kann,

obwohl er nur ein Antennenkabel benutzt.

MIDI entstand aus den Wünschen von Musikern, die eingespielte Tracks oder Samples,

wie kurze musikalische Notizen, möglichst schnell, günstig und platzsparend aufzeichnen

und speichern wollten. Weiters sollten mehr Bearbeitungen für die aufgezeichneten Daten

vorhanden sein als auf einem Tonbandgerät, und nicht zuletzt sollten die Dateien einfach

zu transportieren sein.

Zur Bearbeitung in einem Computer ist eine MIDI-Schnittstelle notwendig. Diese war bei

alten Atari Rechnern serienmäßig vorhanden, weswegen auch heute noch diese alten

Rechner in Studios verwendet werden. Beim PC kann man ein MIDI-Gerät über den

Gameport der Soundkarte anschließen. Der größte Nachteil dieser Methode ist, dass der

Gameport auch bei neueren Soundkarten nicht besonders schnell ist. Mittlerweile können

MIDI-Geräte bzw. -Interfaces (mit eingebauten Anschlüssen für DIN-Kabel) auch über die

schnelle USB-Schnittstelle an den Computer angeschlossen werden. Bei modernen

Computern wird in der Regel nicht mehr der „Umweg“ über Soundmodule, also Geräte, die

Messages in Klänge umsetzen, gemacht, da der Klang meist direkt von der Soundkarte

des Computers oder VST-Instrumenten erzeugt wird.

Hier ist der Begriff General MIDI wichtig. Dieser Standard wurde 1991 festgelegt und ist

eine Erweiterung der 1983 festgelegten MIDI Spezifikation. General MIDI legt sie ersten

128 Basisklänge eines MIDI-Gerätes fest, sodaß eine Komposition auf anderem

Equipment zumindest ähnlich klingt. 128 Klänge waren im Jahr 1983 technisch noch

unmöglich.

Es ist ein altes Missverständnis, dass MIDI mit Audio verwechselt wird. Der Unterschied,

der ein Verwechseln praktisch unmöglich macht, ist:

MIDI hat keinen Sound. Es klingt nicht, es steuert.

3.2 Grundstruktur einer Standard-MIDI-Datei

<Standard-MIDI-Datei> = <Header> <Track> [<Track>]...

<Header> = 4D 54 68 64 00 00 00 00 00 xx yy yy zz zz

Die ersten 4 Byte sind die Kennung einer MIDI-Datei.

xx = {00 | 01} Typ der MIDI-Datei:

Typ 0: Datei enthält nur einen Track

Typ 1: Datei enthält mehrere Tracks

yy yy = Anzahl der Tracks

zz zz = Zeitbasis: Anzahl der Zeitelemente je Viertelnote, sollte durch 24 teilbar sein.

Gebräuchliche Werte sind:

00 78 (120), 00 F0 (240), 01 E0 (480), 03 C0 (960)

<Track> = <Track-Header> <Zeitdiff> <Event> [<Zeitdiff> <Event>]...

18

<Track-Header> = 4D 54 72 6B xx xx xx xx

xx xx xx xx Länge des Tracks in Byte. Der Track-Header zählt nicht mit.

<Zeitdiff> = Zeitdifferenz zwischen den Events:

gemessen in Zeitelementen (siehe Zeitbasis). Die erste "Zeitdiff" zählt vom

Beginn des Musikstücks bis zum ersten Event des Tracks.

<Event> = { <Kanal-Event> | <Meta-Event> | <Sysex-Event> }

3.3 Kanal-Events

Ein Kanal-Event ist ein Befehl an einen bestimmten MIDI-Kanal des Wiedergabegerätes.

Die allgemeine Syntax lautet:

<Kanal-Event> = [<Status-Byte>] <Daten-Byte> [<Daten-Byte>]

<Status-Byte> = <Event-Typ> <Kanal-Nr.>

<Event-Typ> = {8 | 9 | A | B | C | D | E} Das erste (führende) Halbbyte des Status-Bytes.

Es kennzeichnet die Art des Befehls, siehe folgende Tabelle.

<Kanal-Nr.> = {0 | ... | F} Das zweite Halbbyte des Status-Bytes.

Es gibt die Nummer des MIDI-Kanals an. Die Numerierung beginnt mit 0.

<Daten-Byte> = {00 | ... | 7F} Parameter des Befehls.

Eine Kette aus Kanal-Events mit gleichem Status-Byte kann verkürzt werden, indem man

das Status-Byte nur im ersten Event setzt und in den folgenden Events wegläßt (sog.

Laufzeitstatus). Davon wird praktisch immer Gebrauch gemacht. Da Daten-Bytes < 80 und

Status-Bytes >= 80 sind, ist die Kodierung eindeutig.

3.4 Event-Typen

Art des Befehls

1. Halbbyte

des StatusBytes

1. Daten-Byte

2. Daten-Byte

Note ein

Einschalten einer MIDINote. Die Note wird so

lange gespielt, bis "Note

aus" eintrifft.

9

Tonhöhe, numeriert in

Halbtonschritten. Im GMStandard hat c' die Nr. 3C.

Bei Schlagzeugen wird die

Tonhöhe als ein bestimmtes

Schlaginstrument

interpretiert.

Note aus

Es gibt zwei Möglichkeiten.

9

Tonhöhe

00

8

Tonhöhe

Anschlagstärke für

das Ausschalten

A

Tonhöhe, auf die der Befehl

wirkt, wenn dort eine Note

eingeschaltet ist.

Veränderte

Anschlagstärke

Aftertouch

Die Anschlagstärke einer

Note wird verändert.

Anschlagstärke

(Velocity),

Wert 00 verboten.

19

Regler-Einstellung

B

Nr. des Reglers. Im GMStandard gibt es einige

vordefinierte Regler

Regelgröße

Klangprogramm

Wahl des MelodieInstruments oder des

Schlagzeugs

C

Nr. des Klangprogramms.

Die Instrumentenzuweisung

ist im GM-Standard

festgelegt.

entfällt

Kanaldruck

Ändern der

Anschlagstärke aller

laufenden Noten im

Kanal.

D

Veränderte Anschlagstärke

entfällt

Tonhöhenbeugung

Die laufenden Noten

werden verstimmt.

E

Formel für die Verstimmung (in C-Notierung):

V = 0x80 * Datenbyte2 + Datenbyte1 - 0x2000

V liegt im Bereich -2000...+1FFF. Dies entspricht

standardmäßig einer Verstimmung von -2...+2

Halbtönen.

4 Soundkarten

4.1 Geschichte

Die ersten Soundkarten wurden im Jahr 1987 von der Firma Creative Labs (heute

Creative) entwickelt. Die allererste Soundkarte hieß Gameblaster und wurde von Creative

Labs hergestellt. Kurz davon erschien von der Firma AdLib die gleichnamige Soundkarte.

1989 entwickelte Creative Labs den Soundblaster, der nach der AdLib-Karte zum QuasiStandard bei Soundkarten wurde.

In der AdLib-Karte war ein Soundchip der Firma Yamaha eingebaut, der das Prinzip der

Frequenzmodulation (siehe Kapitel 1, Abschnitt Klangsynthese) benutzte und nur zur

Tonwiedergabe verwendet werden konnte. Trotzdem war sie dem Gameblaster, der mit

dem Verfahren der Amplitudenmodulation arbeitete, klanglich deutlich überlegen.

Der Soundblaster arbeitete nach dem Verfahren des Sampling. Er verfügte über einen

Mikrofoneingang, durch den sich erstmals Geräusche aufzeichnen ließen, sowie einen

Verstärker für Kopfhörer und Lautsprecher. Es waren auch zum ersten Mal ein ADWandler (Analog-Digital-Wandler) und ein DA-Wandler (Digital-Analog-Wandler)

eingebaut. Außerdem befand sich auf dem Soundblaster ein so genannter Gameport

(Joystick-Anschluss).

Bei neueren Karten wie dem Soundblaster Pro, die mittlerweile jedoch auch schon wieder

veraltet sind, befanden sich die AD- und DA-Wandler auf einem Chip, der CODEC

(COder/DECoder) genannt wird. Darüber hinaus enthielten sie Schnittstellen für

Musikinstrumente und CD-ROMs. Die MIDI-Schnittstelle war aber keinesfalls eine DINBuchse, sondern wurde über ein spezielles Kabel am Gameport realisiert.

4.2 Verfahren

20

4.2.1 Sampling

Funktionsprinzip eines Samplers:

Ein Sampler (eigentlich ein eigenes Hardware-Gerät) ist in der Lage, aus einem

Audiosignal Proben, genannt Samples, zu entnehmen und in digitaler Form zu speichern.

Grundsätzlich lässt sich mit einem Sampler jedes beliebige Signal aufnehmen und

wiedergeben. Dabei ist das entscheidende, dass ein Sample transponierbar ausgegeben

werden kann. Daraus ergibt sich eines der ersten Probleme des Sampelns: der so

genannten Mickey-Mouse-Effekt. Je höher ein Sample transponiert wird, desto schneller

wird das Sample wiedergegeben. Das Sample wird also zur Transponierung einfach

schneller (höher) bzw. langsamer (tiefer) aus dem Speicher ausgelesen. Dem Problem

des Mickey-Mouse-Effektes kommt man entgegen, wenn man mehrere Samples auf die

Tastatur verteilt. Dies nennt man Multisampling. Eine andere Möglichkeit sind

Zeitkorrekturverfahren, indem der Sampler in die Lage versetzt wird, bei höheren

Wiedergaben das Sample auf die Originallänge zu strecken bzw. bei tieferen Wiedergaben

zu stauchen. Dieses Verfahren ist jedoch sehr rechenaufwendig und teuer, sodass sich

das Multisampling durchgesetzt hat.

Beim Sampling in der Soundkarte werden analoge Signale, die durch die Soundkarte in

Zahlenwerte umgesetzt werden, in einer Datei gespeichert, die die Grundlage für die

spätere Ausgabe bildet. Diese Zahlenwerte werden wieder in analoge, elektrische

Spannung zurückverwandelt, die dann über einen Lautsprecher ausgegeben werden

kann. Der Vorgang der Digitalisierung vollzieht sich mehrere Tausend Mal pro Sekunde.

Die Qualität eines Klangs wird durch die Samplingrate und die Samplingtiefe beurteilt. Die

Samplingrate beschreibt die Häufigkeit, mit der die analogen Signale in digitale Signale

umgewandelt werden, die Samplingtiefe die Genauigkeit, mit der dies geschieht. Die

Samplingrate sollte bei mindestens 44,1 kHz und die Samplingtiefe mindestens bei 16 Bit

liegen.

4.2.2 Wavetable-Synthese

Die Wellenform- oder Wavetable-Synthese war bis vor wenigen Jahren in Synthesizern

sehr verbreitet und wurde von vielen Herstellern in den unterschiedlichsten Abwandlungen

eingesetzt. Im Grunde versteht man unter Wellenform-Synthese die Klangerzeugung auf

der Basis fertiger, digitaler Wellenformen, die entweder durch additive oder subtraktive

Nachbearbeitung (siehe Kapitel 1, Abschnitt Klangsynthese) geformt und zu Klängen

verarbeitet werden. Diese Wellenformen liegen als fest abgespeicherte Zahlentabellen

(daher die Bezeichnung Wavetable) vor.

In der Soundkarte werden Muster für Klänge von Instrumenten (in Form von Samples) in

der Wellenform-Tabelle gespeichert. Dadurch, dass diese Klangmuster für Einzeltöne

vorliegen, wird weniger Speicherplatz verbraucht. Die verschiedenen Tonhöhen werden

dann errechnet.

Auf diese Weise kann vom Soundprozessor auf die einzelnen Töne zurückgegriffen

werden, ohne dass z.B. ein Musikstück in seiner vollen Länge gesampelt werden muss.

Dieses Verfahren wird gerne verwendet, da ein fast originalgetreuer Sound erreicht wird.

4.2.3 Moderne Soundkarten

Seit der ersten Soundkarte im Jahr 1987 hat sich einiges getan. Beispielsweise sind die

verstärker für Lautsprecher verschwunden und durch einen Line-Out Ausgang ersetzt

worden, da sich aktive Lautsprecherboxen durchgesetzt haben. Es wurden auch Systeme

wie ein 5.1 Dolby-Surround-Ausgang entwickelt, die jedoch für professionellere

21

Audiobearbeitung ungeeignet sind.

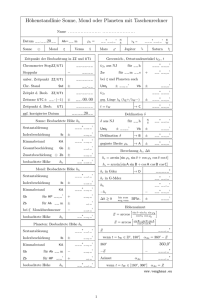

4.2.3.1 A/D-Wandler

Die AD- und DA-Wandler wurden stark verbessert, und Soundkarten können bereits

digitale Daten mit einer Bitrate und Frequenz von 24 Bit und 96 kHz aufgenommen und

wiedergegeben werden. In guten Soundkarten sind die AD- und DA-Wandler nicht direkt

auf der Soundkarte, sondern in einer externen Anschlussbox vorhanden, da die Wandler

sehr empfindlich sind und durch die im Computer in hohem Maß vorhandene

elektromagnetische Strahlung gestört werden können. Diese externe Anschlussbox wird

dann mit einem digitalen Datenkabel mit der Soundkarte verbunden. Ein absolut wichtiges

Kriterium für A/D-Wander ist die Form des Steckers. Standard ist, wie im Jahr 1987, die

3.5 mm Stereo-Klinke (Abb. 4.1). Sie ist zwar platzsparend, dafür aber anfällig für

Störgeräusche und Wackelkontakte, inkompatibel zu gängigen Kabel-Standards und geht

leicht kaputt. Cinch, 6.3 mm Klinke (Abb. 4.1) oder sogar XLR (Abb. 4.2) sind dagegen

akzeptable und robuste Stecker-Standards.

Abbildung 4.1:

3.5mm Stereo-Klinke (oben)

Abbildung 4.2: XLR-Stecker

6.3mm Stereo-Klinke (unten)

A/D-Wandler müssen auch in der Lage sein, so genanntes "Alasing" zu vermeiden. Es tritt

auf, wenn der Wandler versucht, Signale oberhalb der halben Sampling-Frequenz zu

quantisieren und bewirkt, dass diese Frequenzen entlang der halben Sampling-Frequenz

gespiegelt werden und somit hörbar gemacht werden. Mit einem analogen Tiefpass-Filter

(der nur Frequenzen unterhalb eines bestimmten Wertes hindurch lässt) kann man diese

Frequenzen vor der Quantisierung herausfiltern. Leider arbeiten analoge Filter nicht wie

gewünscht; sie sind nicht in der Lage, an einem bestimmten Wert alle darüber liegenden

Frequenzen herauszufiltern. Deshalb gibt es das sog. „Oversampling“. Die Abtastrate wird

bei x-fachem Oversampling um den Faktor x erhöht, und ein digitaler Tiefpass-Filter

rechnet die Abtast-Rate wieder auf den normalen Wert zurück.

4.2.3.2 Full Duplex

Den „Full Duplex“ Modus beherrschen heutzutage fast alle Soundkarten. Er ermöglicht das

gleichzeitige Aufnehmen und Abspielen von Audiodateien. Dies ist unerlässlich, falls

nachträglich echte Instrumente zu vorhandenem Material einspielen werden sollen. Ältere

Soundkarten wie der Soundblaster 16 haben allerdings Probleme bei der

Synchronisierung beider Datenströme. Das kann dazu führen, dass bei der Aufnahme

Temposchwankungen auftreten. Außerdem ist die Wiedergabequalität während der

Aufnahme oft nur in 8 Bit, und/oder es knackt vereinzelt.

4.2.3.3 DSP-Prozessor

DSP steht für Digital Signal Processing.

22

Viele teurere Soundkarten haben bereits DSP-Prozessoren eingebaut. DSP-Prozessoren

sind je nach Leistung in der Lage, in Echtzeit eine oder mehrere Audioquellen mit Effekten

wie Reverb, Delay etc. zu versehen. Dadurch ist es möglich, auch ohne einen schnellen

Computer Audiospuren in Echtzeit mit Klangreglung und Effekten zu versehen. Auf diese

Weise kann zu einem nicht unerheblichen Teil ein virtuelles Studio realisiert werden.

4.2.3.4 OPL3-Chips

Es gehört auch zu den Aufgaben einer Soundkarte, MIDI-Dateien abzuspielen. Ältere

Soundkarten haben dazu einen so genannten OPL3-Chip eingebaut, der die Klänge

mathematisch berechnet. Er arbeitet mit der Frequenzmodulation (deshalb wird der OPL3Chip auch oft FM-Chip genannt), die 1987 noch modern war und auf heutigen

Synthesizern noch gut klingt, doch heutzutage kann man den Klang solcher Soundkarten

nur noch als schlecht bezeichnen.

4.2.3.5 Wavetable-Chips

Besser als OPL3-Chips sind „Wavetable“-Karten. Sie sind mit ROM-Chips bestückt, auf

denen sich Samples befinden. Deren Reihenfolge durch den GM-Standard festgelegt

(siehe Kapitel 3). Mit diesen Samples werden die MIDI-Daten zum Klingen gebracht.

Wenn diese Chips und Sounds von namhaften Herstellern wie Yamaha, Ensoniq oder

Roland kommen, kann es gut sein, dass die Qualität nahe an die eines professionellen

Keyboards herankommt. Es ist vor allem wichtig, welche Klangqualität die Samples haben,

wieviel Megabyte an ROMs vorhanden sind, wieviele Spuren gleichzeitig

zusammengemischt werden können und ob DSP-Effekte auf die Spuren gelegt werden

können.

Wavetable-Chips wurden vor allem für Computerspiele konzipiert, denn fast alle älteren

Spiele lassen MIDI-Musik im Hintergrund laufen, und die klingt mit einem OPL3-Chip

grausam. Heutzutage kann man die Musik in einem Computerspiel fast schon mit

Filmmusik vergleichen, und die Stücke liegen oft im MP3-Format vor.

Doch leider klingen auch Wavetable-Sounds zu seicht und ausdruckslos, um wirklich gute,

qualitativ hochwertige Musik herzustellen. In Zeiten, wo Musik zur Massenware

verkommen ist, kann nur noch der mithalten, der einen eigenen Sound aufzuweisen hat.

4.2.3.6 RAM-Chips

Die Krönung bieten Chips, die nicht mit ROMs bestückt sind, sondern mit RAMs, sodass

beliebig austauschbare Sounds auf der Soundkarte abgespielt werden können. Auf diese

Weise funktioniert eine Soundkarte (theoretisch) wie ein Sampler.

Wichtig dabei ist, wieviel RAM die Soundkarte besitzt, und ob diese Zahl erweiterbar ist.

Ab 4 MB RAM kann man bereits vernünftig arbeiten. Je nach Musikstil braucht man mehr

(z.B. bei Filmmusik) oder weniger (z.B. bei Techno) RAM.

5 Aufnahmeverfahren und Audiobearbeitung

23