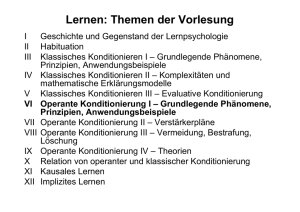

Lernen

Werbung

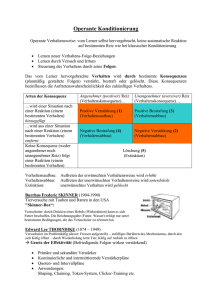

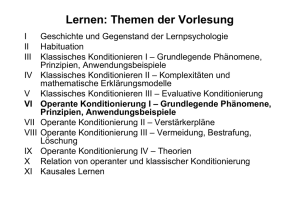

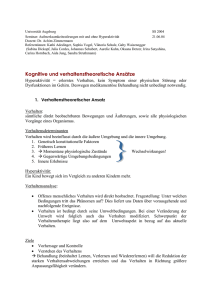

LERNEN Klassische Konditionierung Bsp. Pawlow: Speichelsekretion bei Hunden Terminologie: US: unkonditionierter Stimulus (Futter) UR: unkonditionierte Reaktion (Speichelfluss) NS: neutraler Stimulus (Glockenton) OR: Orientierungsreaktion (Ohren aufstellen usw.-->Hinwenden zur Reizquelle, Steigerung d. Aufmerksamkeit) CS: konditionierter Stimulus (Glockenton) CR: konditionierte Reaktion (Speichelfluss) Vorgehensweise: Kontrollphase Prüfung, ob US zuverlässiger Auslöser für UR, und NS noch nicht UR auslöst, falls unbekannt aber OR Konditionierungsphase: US löst aus: UR NS löst aus: OR UR+OR sollten sich unterscheiden NS ist gepaart mit US US löst aus: UR Ergebnis des Konditionierungstrainings: NS wird CS CS löst aus CR Löschungsphase: US nicht mehr mit CS gepaart Ergebnis der Löschungsphase: CS löst mit abnehmend. Wirkung aus: CR Keine spezifische Reaktion auf den CS Spontanerholung: Kein US CS löst nochmals aus: CR Formen klassischer Konditionierung: Verzögerte Konditionierung: erst NS:hält an, bis US eintritt führt am schnellsten zu Reaktion Simultane Konditionierung: NS + CS treten simultan auf Effizient abhängig , welche Reaktion, Zeitverlauf usw. Spuren- Konditionierung: erst NS, dann CS Effizienz abhängig von Intervall zwischen NS + CS Rückwirkende Konditionierung: erst US, anschließend NS am ineffizientesten Messung der Stärke der CR Reaktionsamplitude: z.B. Messung der Speichelabsonderung Reaktionslatenz: Schnelligkeit, mit der CR aus CS folgt Löschungswiderstand: Anzahl der Durchgänge, bis CS nicht mehr zu CR führt Reizgeneralisierung + Reizdiskrimination Reizgeneralisierung: Neben CS können auch ähnliche Reize die CR auslösen ( bsp. Kreis und Ellipse, Glockenton und Klingel) Reizdiskrimination: CR wird nur durch spezifischen CS ausgelöst ( Kreis vs. Ellipse) Diskriminationstraining experimentelle Neurose ( bei Tieren, wenn Reize sehr ähnlich, massive Verhaltensstörung wg mangender Differenzierung) Konditionierung nicht nur bei Reflexen sondern auch bei Furcht-/Angstreaktionen möglich: Bsp. Watson und Rayner (1920) Der kleine Albert: US( lauter Glockenschlage) + UR (Angst – Reaktion) + NS ( weiße Ratte)CS (weiße Ratte)CR (Angst)Albert hat Angst vor Ratten + alles Fellige ( Generalisierung) Anwendung bei Phobien Phobie: (unbegründete) starke Angst vor best. Objekten/Situationen ( Höhenangst, Klaustophobie..) Exposition /Konfrontationstherapie o Basiert auf Verhaltenslöschung: Verknüpfung zw. CS ( stimulus) und CR ( Angst) wird schwächer Systematische Densibilisierung (Wolpe, 1958) o Basiert auf Gegenkonditionierung: Verknüpfung des CS mit Verhalten, dass nicht mit CR ( Angst) kompatibel ( bsp. Entspannung) Andere Anwendung: bei Immunsystem ( siehe Bio) Neurobiologische Grundlagen Untersuchung bei Meeresschnecken ( Nervensystem mit einigen tausend großen Neuronen)Nobelpreis für Kandel Durch Lernen Verbindung von Neuronen ( B aktiviert C, A aktiviert nicht C; parallele Aktivierung von A+B A aktiviert C Auch bei größeren Zellverbänden möglichbei Mensch aber je nach konditionierter Reaktion unterschiedliche Hirnareale beteiligt ( bsp. Lidschlagreflex = Cerebellum; Angst: Amygdala) Operante Konditionierung Ziel: Auftretens-WS für Verhalten erhöhen/vermindern Versuchsparadigma: Lernen am Erfolg Thorndike( 1898, 1911): Katze mit Futter draußen schlaufe ziehen um dran zu kommen Gesetz des Effektes: bei versch. Reaktionen in gleicher Situation werden die Reaktionen mehr mit Situation verknüpft, die mit befriedigendem Zustand begleitet oder gefolgt werden Lernen durch Versuch + Irrtum ( vs. Lernen durch bewusstes Denken) Skinner ( 1938, 1951): Skinnerbox: Ratte in KäfigHebel für Futter Vorgehensweise: Bestimmung der Basisrate: wie oft wird Verhalten gezeigt Trainingsphase ( Verstärkung): auf Verhalten folgt Belohnung/Bestrafung Löschung: bei Verhalten keine Reaktion(Verstärkung) Spontanerholung Verstärkungen: Verstärkung von Verhalten Unterdrückung von Verhalten Arten von Verstärkungen: Primäre Verstärker: befriedigen physiologische Bedürfnisse, wirken ohne vorherigen Lernprozess Sekundäre Verstärker: Neutraler Reiz bekommt Verstärkerwirkung durch wiederholte Darbietung mit primärem Verstärker Generalisierte Verstärker: Verknüpfung mit mehreren primären u sekundären Verstärkern bsp. Geld (kann primären Verstärker Hunger und sekundären Verstärker Kleider? Befriedigen) Personenverstärker: Zuwendung/Abwendung einer geliebten Person Selbstverstärker: eigene Belohnung eines ungeliebten Verhaltens mit beliebter Aktivität ( Premack – Prinzip) Verstärkungspläne Bestimmen Art + Häufigkeit der Kopplung von Verstärkung und Verhalten Kontinuierliche Verstärkung: nach jedem Verhalten Verstärkungführt schneller zu angestrebtem Verhalten als IV Intermittierende Verstärkung: manchmal Verstärkung manchmal nicht führt zu höherer Löschungsresistenz o Intervallpläne: bestimmtes Zeitintervall wird festgelegt, erstes Mal in dem Intervall wird jeweils verstärkt o Quotenpläne: durchschnittlich jedes X. Mal des Verhaltens wird verstärkt höhere Reaktionshäufigkeit als Intervallpläne Fixiert: Intervall/Quote sind festgelegtvorhersehbar Variabel: Intervalle verändern sich,nicht vorhersehbar stabiles + einheitliches Verhalten Optimaler Verstärkungsplan: anfangs kontinuierliche Verstärkung zum Verhaltensaufbau, anschließend über längeren Zeitraum abnehmende intermittierende variable Verstärkung zur Stabilisierung Einfluss der Verstärkermenge ( Crespi, 1942) Reduzierte Verstärkungnegativer Kontrasteffekt ( Depressionseffekt) ( bsp. Mäuse vorher viel Futter, dann nur noch wenig laufen langsamer) Erhöhte Verstärkungpositiver Kontrasteffekt ( mehr Futter schneller) Latentes Lernen ( Tolman & Honzik, 1939) Unterscheidung zwischen Kompetenz ( wissen über Weg im Labyrinth) und Performanz ( ausführen des Verhaltens richtigen Weg suchen) Versuch: Weg im Labyrinth suchen, 1. keine Verstärkung mit Futteram schlechtesten; 2. kontinuierliche Verstärkung mit Futter, 3. bis zum 11. Tag KEINE Verstärkung, dann schon Ergebnis: gruppe mit keiner Verstärkung lernt trotzdem, zeigts aber anfangs nicht (latent!)! Verstärkung dient nur als Motivation, ein bestimmtes Zial aufzusuchen ( widerspricht behavioristischer Definition von Lernen(= Veränderung einer Verhaltenshäufigkeit) Wirkung einer zeitlichen Verzögerung der Verstärkung ( Grice, 1948) Versuch: Mäuse müssen entscheiden, welchen Gang; am Ende Futter/kein Futter: Weg zum Ziel variiert Ergebnis: je länger Weg zu Ziel, desto mehr Durchgänge benötigt, um keine Fehler mehr zu machen ( bei 10 sec. Kein Lerneffekt mehr) Zeitliche + soziale Falle ( Hardin, Platt, Spada & Ernst) Zeitliche Falle: pos Konsequenzen sofort + neg. Konsequenzen mit starker zeitlicher Verzögerung Soziale Falle: pos. Konsequenzen für sich selbst + neg. Konsequenzen für alle Versuch dazu von Rachlin & Green ( 1972) Untersuchen Wechselwirkung zwischen zeitl. Verzögerung +Menge von Verstärkung bei Tauben Ergebnis: wählen lieber schnell kleine Belohnung, als länger zu warten + große Belohnung ( Effekt einer Diskontierung: Verringerung d. subjektiven Werts bei zeitlicher Verzögerung) Aufbau eines spezifischen Verhaltens 1.) Reizdiskrimination: Ausblenden: Tauben lernen lesen: zu Beginn 2 Wörter durch versch. Visuelle Reize unterscheidbar, später nur noch Wörter Lernen zu lernen: bei erstem mal braucht Reizdiskriminationsprozess längerspäter System verstanden, geht schneller 2.) Verhaltensdifferenzierung Verhaltensformung: durch selektive Verstärkung bestimmter Merkmale Klinische Verhaltensmodifikation: o A Verstärkung für Hinwendung zur Gruppe o B. Verstärkung für Annäherung o C) Verstärkung für Beteiligung an der Gruppe 3.) Verhaltensverkettung Aufbau komplexer Verhaltensabläufe Zunächst letztes Verhalten in Kette (m) durch primäre Verstärkung ( Futter) auf Hinweisreiz n trainiert Konditionierung eines Verhaltens m-1 auf Hinweisreiz n-1; Verstärkung: Hinweisreiz n (sekundär) usw. Reduktion eines spezifischen Verhaltens 1.) Löschung: Entfernen der Verstärker ( z.B ignorieren von Kind, wenn schreit) 2.) Ablösung von Verhalten: Aufbau von konkurrierendem Verhalten durch Verstärkung ( + gleichzeitige Löschung) 3.) Bestrafung Umso effektiver, je unmittelbarer + intensiver der Strafreiz Soll direkt auf Verhalten folgen Weniger wirksam, wenn inkonsequent (gelegentlich auch positiv verstärkt wird oder Bestrafung gelegentlich grundlos erfolgt) Führt häufig eher zu Unterdrückung als Löschung Wirkung von Bestrafung (Estes, 1944) Versuch: Aufbauphase: Belohnung für häufiges Hebeldrücken Löschungsphase: KG: keine Belohnung mehr; EG: keine Belohnung, teilweise Bestrafung2.+3. Löschungsphase: keine Belohnung: Ergebnis: am Anfang effektiver, wenn bestraft; in 3. Phase besser, wenn nicht bestraft Kritische Punkt bei Bestrafung Reduziert Permormanz und nicht Kompetenz Lenkt Aufmerksamkeit auf unerwünschtes Verhalten Beeinträchtigt Beziehung Kann als Modellverhalten gelernt werden Hat emotionale ü motivationale Folgen ( Angst, Ärger, Agression) Konditionierte emotionale Hemmung ( Estes & Skinner, 1941) Abgrenzung von Verhaltenskontigentem Bestrafungstraining, da aversiver Reiz unabhängig von Verhalten gegeben wird Phasen 1.) Verhalten A durch positive Verstärkung aufgebaut ( operante Konditionierung) 2.) Unabhängig von jeweiligem Verhalten aversiver Reiz / US), signalisiert durch Hinweisreiz ( NS, dann CS) ( klassische Konditionierung)keine Möglichkeit, aversivem Reiz zu entgehen Folge: Verhalten A wird in Gegenwart von Hinweisreizen seltener gezeigt, auch ohne weiteren aversiven Reiz Vergleich mit diskriminativem Bestrafungstraining ( Hunt & Brady, 1955) Verhaltensunterdrückung stabiler und Löschungsresistenter Anzeichen von Hilflosigkeit in Gegenwart des Hinweisreizes Neurobiologische Basis der operanten Konditionierung Versuche mit Meeresschnecken Identifizierung d. Neuronenschaltkreises, der zu operanten Konditionierung führtVerstärker: Reizung d. Nervs, der die Information „Nahrung“ vermittelt Verstärkung durch Neurotransmitter Dopamin vermittelt, Blockade v. Dopamin macht Lerneffekt unmöglichAktivierbarkeit von Neuronen für die Auslösung von Fressbewegungen wurde erhöht Dopamin auch ein Neurotransmitter, der bei höheren Tieren eine Rolle spielt (limbisches System) Angst, Vermeidung, Hilflosigkeit Gelernte Furcht - / Angst- Reaktion (Miller, 1948( Experiment mit MäusenKäfig 5 Phasen: o 1.) Exploration bei offener Tür o 2.) 1 min kein Schock1min alle 5sec SchockDauerschock bei offener Tür o 3.) ohne Schock bei offener Tür o 4.) ohne Schock: Tür öffnet sich nur, wenn an Rolle gedreht wird o 5.) ohne Schock, Tür öffnet sich nur, wenn Hebel gedrückt wird o in 4.) + 5.) öernen Tiere ein neues Verhalten aus Angst vor SchockAufbau von aktivem Vermeidungsverhalten Erklärung: 2 – Faktorentheorie ( Mowrer, 1947) Klassische Konditionierung: Furcht-/Angstreaktion wird für weiße Käfigkälfte gelernt Operante Konditionierung: Fluchtverhalten ( bzw. aktives Vermeidungsverhalten) wird negativ verstärkt durch Verringerung der Angst bei Verlassen d. weißen Käfigs Verhalten wird sehr löschungsresistent Kognitive Erklärung: Verhaltensänderung nur bei Verletzung von Erwartungen, was auf Verhalten passiert ( ansonsten beibehalten) Anwendung für Behandlung von Phobien! Gelernte Hilflosigkeit ( Seligman & Maier, 1967) Triadisches Design: 2 EG, 1KG Experiment mit Hunden: o 1. Phase: unvermeidbare + unkontrollierte Stromschläge o 2. Phase: Stromschläge wären vermeidbar Ergebnis: Hunde lernen Flucht/Vermeidungsverhalten gar nicht /sehr langsam Interpretation: Lernen, dass Reiz + Verhalten nicht zusammenhängenkeine Verhaltenskontrolle für aversiven Reiz möglich HilflosigkeitserwartungGeneralisierung Neuformulierung d. Theorie d. Kausalattribution :entscheidend für Entstehung gelernter HIlflosigekt ist, ob Ursache global (viele Bereiche), stabil, internal ( eigene Unfähigkeit) attribuiert wird Hilflosigkeitserwartung: 3- Faches Defizit Motivational: Reduktion d. Antriebs Emotional: Depressive Symptome Kognitiv: Zshng. Zwischen Verhalten + Konsequenzen werden schlechter erkannt Aufsuchen-Meiden-Konflikt (Brown, 1948) = Annäherungs- Vermeidungskonflikt Je näher zum Ziel, desto stärker stärker Annäherungs oder Vermeidungstendenz ( je nach Bedingung); Vemeidungstendenz steigt schneller als Annäherungstendenz Wenn 2 tendenzen miteinander konkurrieren, siegt stärkere Tendenz ( Vermeidung) Paradigmen mit aversiven Reizen: Überblick Fluchttraining: Unabhängig vom augenblicklichen Verhalten erfolgt aversiver Reiz + Möglichkeit, d. Reiz zu entfliegen Fluchtverhalten wird bei aversivem Reiz immer schneller ü häufiger gezeigt Passives Vermeidungslernen: Auf Verhalten erfolgt jedes Mal Bestrafung durch aversiven Reiz AuftretensWS d. Verhaltens reduziert Diskriminantes passives Vermeidungslernen: Bestrafung erfolgt nur in Gegenwart eines diskriminativen Hinweisreizes AuftretensWS d. Verhaltens in Gegenwart d. Hinweisreizes reduziert Aktives Vermeidungslernen Unabhängig von Verhalten erfolgt nach Hinweisreiz aversiver Reiz, dann Möglichkeit durch best. Verhalten aversiven Reiz zu vermeidenaktives Vermeidungsverhalten wird aufgebaut Gelernte Hilflosigkeit 1.) Unabhängig von Verhalten aversiver Reiz, kann nicht verhindert werden 2.) Nach Hinweisreiz aversiver Reiz, Flucht möglich Flucht – (Vermeidungsverhalten tritt kaum auf, obwohl möglich Konditionierte emotionale Hemmung Pos Verstärkung auf best. Verhalten, wenn sicher, dann unabhängig von Verhalten aversiver Reiz nach Hinweisreiz ( keine Möglichkeit der Flucht) AuftretensWS in Gegenwart d. Hinweisreizes reduziert, auch wenn aversiver Reiz weg Artspezifisches Lernen : Aus evolutionspsychologischer Sicht Widerlegung, dass Gesetze der klassischen + operanten Konditionierung allgemein gültig sind Evolutionär begründete, biologische Dispositionen bestimmen, was gelernt wird Klassische Konditionierung: o „prepardeness“ (Seligman) biologische Dispositionen steuern Aubau von Verhaltensweisen o Geschmacksaversion: Ratten wird aromatisiertes Wasser gebene, gleichzeitig lichtblitze + Lärm; danach Giftstarke Übelkeit Überprüfung, wogegen Ratte Aversion aufbaut; Ergebnis: gegen Wasser, nicht gegen anderen Reize Erklärung: disposition, überkeit mit Futter/Wasser zu verbinden, nicht aber mit anderen Reizen o Geschmacksaversion als Sonderfall Konditionierung schon bei einer einzigen neg. Erfahrung Visuelle + akustische Reize dabei nicht konditioniert Zwischen Aufnahme d. Nahrung und Überlkeit oft lange Zeit, trotzdem konditioniert Sehr löschungsresistent o Wachteln dagegen eher auf gefärbtes wasser (vs. Aromatisiert) konditioniert tagaktiv, sehen gut ( Disposition) Operante Konditionierung: Dominanz artspezifischer Verhaltensmuster ( manche Verhaltensweisen sehr schnell gelernt, andere überhaupt nicht o Bsp. Katze: lernt schnell an schlaufen zu ziehen etc. aber nicht sich zu kratzen o Shettleworth: Ergebnis hängt davon ab, ob Verhalten in „Verhaltensstrom „ passt o Retten lernen weg im labyrinth, wenn wasser als Verstärkung, wenn Futter, dann nicht ( weil in Natur auch so) Aktives Vermeidungslernen (Bolles): Artspezifisches Abwehrreaktion:; Tiere zeigen bestimmte Abwehrreaktionendie sind leicht zu konditionieren, andere Verhaltensweisen dagegen schwer oder unmöglich Lernen = ontogenetische Ausdifferenzierung eines physiologisch gegebenen Rahmens = Anlage & Umwelt Lernen aus kognitiver Sicht Tolman: Zielgerichtetes Verhalten nach Ortslernen Versuch bei Ratten Sollten Weg durch Labyrinth lernen; durch Sperre lernen von Weg 2 Bei Sperre 3 bisherige Erwartung, dass Ratte nacheinander Weg 1, 2 und dann erst 3 nimmt ABER Ratte geht gleich Weg 3 Kognitive Landkarte statt Reiz – ReaktionsVerknüpfung o Ratten lernen nicht Bewegungsabfolge sondern Wege zum Ziel Andere Beispiele: Orientierung bei Menschen ( blind + gegenstände), Die neurobiologische Basis des Ortslernens: Der Hippocampus Bei Läsionen im Hippocampus deutliche Defizite im Ortslernen ( bei Ratten suchen nach Plattform) Bedeutung des Informationsgehalts von Reizen Nutzung d. Paradigmas konditionierter, emotionaler Hemmung für beide Versuche: Möglichkeit, die Stärke einer klassischen Konditionierung anhand einer Unterdrückung eines operant konditionierten Verhaltens zu prüfen. Experiment von Rescorla ( 1968) o Aufbau: wahrscheinlichkeit, dass elektrischer Schlag während eines Tons auftritt wird variiert o Ergebnis: nur , wenn Reiz verlässliche Info vermittelt, wird Reiz gelernt ( wenn Stromschlag bei Ton wahrscheinlich! Reiz als guter Prädiktor für Stromschlag) Experiment von Kamin ( 1969) o Aufbau: Sequenz von neutralen Reizen wird variiert ( Licht, Rauschen, Licht + Rauschen), jeweils in unterschiedlicher Kombination und Abfolge; danach messen, ob Verhalten ( Hebeldrücken) unterdrückt wird. o Nur Reize, die zusätzliche Infos vermitteln, werden gelernt: Gruppe, wo erst nur rauschen + dann Rauschen + Licht, lernen Reiz „Licht“ nicht mehr, da keine zusätzlichen InfosBlockierungseffekt Lernen durch Einsicht Kohler ( 1921): Problemlöseverhalten von Schimpansen Epstein et al. (1984): Einsichtslernen bei Tauben o 1.) Konditionoierung 2 einzelner Verhaltensweisen ( Pappschachtel von a nach b schieben; auf pappschachtel steigen um an Futter zu kommen o 2.) Aufgabe, die Kombination beider Verhalten benötigt Eichsicht: da nach einmaligem Lösen keine Probleme mehr Lernen durch Beobachtung Beispiele aus dem Tierreich Vögel lernen, Milchkannen aufzupicken Affen, die Kartoffeln waschen + später auch in Meerwasser um zu salzen Affen lernen Weizen von Spreu zu trennen einer beginnt, Stamm oder andere Vögel übernehmen nach und nach durch Beobachtung Schäferhunde als Drogenspürhunde: Welpen von ausgebildeten und nicht ausgebildeten Hunden werden verglichen; die , die Mutter beobachten konnten beim Drogen aufspüren zeigen selbst dieses Verhalten! Imitation als Instinkt Instinktpsychologie ( Mc. Dougall) Instinkt = genetisch verankerte Verhaltensdisposition, die Lebewesen leiten, ohne Einsicht und vorheriger Erfahrungsmöglichkeit der Umwelt angepasste Verhaltensweisen zu zeigen Annahme: Menschen + Tiere haben angeborene Imitationsbereitschaft : Imitationsinstinkt Begründung: Kinder zeigen sehr früh Imitation ( Mimik, Gestik) Kritik : Zirkularität der Erklärung: Verhalten wird beobachtetInstinkt liegt zugrundeBeweis: Verhalten ist vorhanden Imitation als Lernen durch operante Konditionierung Miller & Dollard ( 1941) Operante Konditionierung: Verbindung zwischen Reiz und Reaktion wird gestärkt durch Belohnung Bei Imitation: Verhalten anderer , als diskriminativer Hinweisreiz für Nachahmungsreaktion Imitation: gleiches voneinander abhängiges Verhalten ( matched – dependent behavior) Versuch bei Kindern: Aufbau: 2 Bedingungen: 1. Imitationsbed.-->Kinder wurden wurden für Imitation belohnt; 2. Gegensätzliche Verhaltensbed._-> Kinder wurden für entgegengesetztes Verhalten belohnt; o 2 SchachtelnModellkind holt ein Bonbon; anderes Kind findet entweder in gleicher Schachter ( Bedingung 1) oder in 2. Schachtel ( Bed. 2) ebenfalls Bonbon Ergebnis: Ohne Belohnung nur 20-25% der Kinder wählen gleiche Schachtel; mit Verstärkung Bed. 100%, Bed. 2 0% Kinder lernen nur durch Verstärkung zu imitieren Probleme der Erklärung Erlernen von Imitation kann nur dann erklärt werden, wenn direkt verstärkt wird, Reaktion muss selbst ausgeführt werden. Problem: stellvertretende Verstärkung durch Beobachtung am Modell Wenn Imitationsverhalten nicht mehr belohnt, müsst es zu Löschung kommen, bleibt aber. Erklärung: GeneralisierungVerstärkung wird auf andere Situationen generalisiert, auch dort imitiert Imitationsverhalten, Reaktion d. Beobachters an Modellverhalten gebunden. Problem: Transfer des beobachteten Verhaltens auf neue Situation in Abwesenheit von Modell nicht erklärbar Lernen neuer Verhaltensmuster nicht erklärbar ( imitierte Reaktion soll nur Verhalten betreffen, dass im Repertoire schon vorhanden ist Der sozial – kognitive Lerntheorie von Albert Bandura (1977, 1986) Betonte Rolle kognitiver + motivationaler Prozesse für Lernen und Verhaltensausfürhung Rocky – Experiment Ergebnis: Testphase 1: Jungen imitieren aggressives Verhalten deutlich mehr; in Bestrafungsbed. Viel weniger Imitation Testphase 2: durch Belohnung aufheben d. Bedingungsunterschied, alle ahmen nach; Geschlechterunterschied weniger ( aber nicht ganz aufgehoben) KG zeigt Verhalten genauso oft wie Belohnungsgruppe Untersuchungen zur Sozial – Kognitiven Lerntheorie: Lernen aggressiver Verhaltensweisen (Bandura, 1965): Anwesenheit d. Modells + Verstärkung sind für Lernen nicht notwendig ( Verstärkung aber für Ausführen ( Variation d. Rocky –Exp.) Lernen von Belohnungsaufschub ( Bandura & Mischel, 1965): Verzicht auf sofortige Belohnung zugunsten späteren größeren durch Modelllernen Übernehmen von Selbstverstärkungsverhalten ( Bandura & Kupers , 1964): Je nach Selbstbewertungsstandard (hoch – niedrig) des Modells belohnten sich Kinder selbst für mittlere bzw. für hohe Leistungen ( Erklärung für Entstehung dysfunktionaler Selbstbewertungsmechanismen) Rolle von Kodierungsprozessen für das Lernen am Modell ( Bandura & Jeffrey, 1973): Kategorisierung d. Modellverhaltens + Merkhilfen verbessern die Reproduktion ( Bewegungsabfolge merken, mit Kodierung einfacher; Kritik: sehr einfach, wird Komplexität d. Lernen nicht gerecht Kernannahmen Banduras Unterscheidung von Lernen und Ausführung ( 2 – Faktoren – Theorie) Verstärkung beeinflusst vor allem die Ausführung Unmittelbare Verhaltensausführung nicht notwendig für Lernen Modelle können real oder symbolisch sein ( z.B. Film) Verstärkung kann direkt oder stellvertretend erfolgen, sowie durch Selbstverstärkung Betonung der Rolle von Kognition bei Lernprozessen Voraussetzung für Behaltensprozess: Aufmerksamkeit gegenüber Modellverhalten Lernender muss Verhalten kodieren und einprägen Ergebnis: überdauernde kognitive Repräsentation d. Beobachteten: Ausgangspunkt für spätere Reproduktion Arten von Modellwirkung Verhaltensbahnung: Verhaltensmuster, die bereits im Repertoire vorhanden; Nachahmung reflexartig (bsp. Gähnen, Klatschen) Hemmung/Enthemmung: bei bereits gelernten Verhaltensweisen durch Beobachtung von Verhaltenskonsequenzen ( Anwendung bei Phobien) Erwerb neuer Verhaltensweisen durch Beobachtung: Verhalten, das vorher noch nicht so vorhanden ( aber evtl. schon Teilschritte) Soziale Steuerung: Verhaltensalternative wird mit pos. Konsequenz verbunden ( z.B. Kleidung) Veränderung emotionaler Erregung: emotionale Erregung wird durch Beobachtung auf Beobachtenden übertragen ( wichtig für menschliches Zusammenleben) Kategorisierung nach Byrne Grundlage für Spiegelneuronen Nachahmungsverhalten nach Mechanismus kategorisiert o Reizverstärkung: Aufmerksamkeit wird auf best. Objekt gelenkt durch beobachten, nicht aber Verhalten gelernt o Verhaltensbahnung: WS für ein best. Verhalten erhöht o Zielnachahmung: Nur Ziel wird nachgeahmt, Verhalten gezeigt, dass ebenfalls zu Ziel führt, nicht aber identisch o Verhaltensimitation: neue Verhaltensweise wird kopiert Neurophysiologische Korrelate von Nachahmungsverhalten: Spiegelneuronen Neurone im Gehirn von Affen, die bei motorischer Handlung und bei Beobachtung der Handlung aktiv sind Spiegelneuronen reagieren nur auf bedeutungsvolle, zielgerichtete Handlungen z.B. greifen Bei Mensch Forschung schwierig, da Aktivität einzelner Neuronen bisher nicht direkt erfasst werden kann Ergebnis mit bildgebenden Verfahren: Auch bei Mensch „Spiegelsystem“ Interpretation: Spiegelneuronen dienen Erwerb internaler Repräsentationen d. beobachteten Handlung Grundlage für Empathie: sich in Zustand anderer hineinversetzen Grundlage für Beobachtungslernen Anwendungsbereiche des Beobachtungslernens Methode in Verhaltenstherapie o Moedllerlen bei Kindern mit Angst vor Hunden o Pratizipative Modellierung bei Schlangenphobie: erst Beobachten beim Umgang, dann selbst Schrittweise Annäherung ( besser abgeschnitten als systematische Densibilisierung und symbolisches Modellernen) Training komplexer Verhaltenskompetenzen o Kompetenztraining für Konfliktlösung o Lernen von Kooperation am Modell ( Spada) Training motorischer Fertigkeiten ( Sport) Medienwirkung: Lernen von Gewaltumstritten