Erwartungswerte, Varianzen - staff.uni

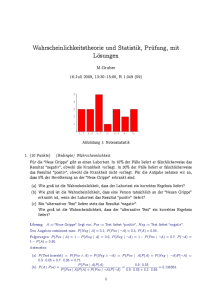

Werbung

Kapitel 3

Erwartungswerte, Varianzen

Wir wollen nun Zufallsvariablen eine Maßzahl zuordnen, die ihr typisches Verhalten in vager Weise angibt.

Haben wir n Punkte x1 , . . . , xn ∈ Rd , so ist der Schwerpunkt n1 (x1 + . . . + xn ). Für eine Zufallsvariable,

die mit gleicher Wahrscheinlichkeit jeden der Werte xi annimmt, nennen wir dieses arithmetische Mittel

ihrer Werte den Erwartungswert. Dies ist offenbar eine nützliche Kenngröße. Wir werden diesen Begriff

zunächst auf diskrete Zufallsvariablen erweitern und dann auf allgemeinere reelle Zufallsvariablen. Es folgt

ein Abschnitt über die Größe der Abweichungen von diesen Schwerpunkt, die wir Varianz nennen, und

deren Rolle der des Trägheitsmomentes in der Mechanik entspricht.

3.1

Erwartungswerte für diskrete Zufallsvariablen

Definition 3.1 Sei X eine reelle Zufallsvariable und W := WX ⊂ R abzählbar. Es gelte P[X ∈ W ] = 1.

Dann nennen wir X eine diskrete (reelle) Zufallsvariable mit Wertebereich WX .

Offenbar kann man WX durch jede abzählbare Obermenge von WX ersetzen, der Wertebereich ist also

nicht eindeutig. Klar ist aber für diskrete Zufallsvariablen

P[X = x] = P[X ∈ WX ] = 1.

x∈WX

Setzen wir nun W̃X := {x ∈ WX : P[X = x > 0]}, so ist W̃X der minimale Wertebereich von X. Wir

werden dies im Folgenden aber nicht benötigen.

53

54

Erwartungswerte, Varianzen

Definition 3.2 Sei X eine diskrete reelle Zufallsvariable mit Wertebereich WX . Wir sagen, dass X einen

Erwartungswert hat, falls

|x|P[X = x] < ∞.

x∈WX

1

1

Wir schreiben dann auch X ∈ L := L (P) und nennen

xP[X = x]

E[X] :=

x∈WX

den Erwartungswert von X. Ist P[X ≥ 0] = 1, so nennen wir stets

E[X] :=

xP[X = x] ∈ [0, ∞]

x∈WX

den Erwartungswert von X. Gelegentlich schreiben wir daher auch E[|X|] < ∞ für X ∈ L1 (P).

Beispiel 3.3 Ist (Ω, P) ein diskreter Wahrscheinlichkeitsraum, so ist jede reelle Zufallsvariable diskret und

WX = {X(ω) : ω ∈ Ω}. Es gilt dann

X ∈ L1 (P)

⇐⇒

P[{ω}]|X(ω)| < ∞.

ω∈Ω

In diesem Fall ist

E[X] =

P[{ω}]X(ω).

ω∈Ω

3

Beispiele 3.4

(i) Sei X eine Bernoulli-Zufallsvariable mit Parameter p ∈ [0, 1]: X ∼ Berp . Dann ist

W = {0, 1} und

E[X] = 0 · (1 − p) + 1 · p = p.

(ii) Sei X ∼ bn,p für gewisse n ∈ N und p ∈ [0, 1]. Dann ist W = {0, . . . , n} und

n

n k

k

p (1 − p)n−k

k

k=1

n

n − 1 k−1

=

np

p

(1 − p)(n−1)−(k−1)

k−1

E[X] =

k=1

= np

n−1

bn−1,p ({k}) = np.

k=0

(iii) (Mittlere Wartezeit auf den ersten Erfolg) Sei X ∼ γp geometrisch verteilt mit Parameter p ∈ (0, 1].

1

Sei f (x) = 1−x

. Dann hat f für x ∈ (−1, 1) die Potenzreihenentwicklung

f (x) =

∞

n=0

xn

3.1 Erwartungswerte für diskrete Zufallsvariablen

55

und die Ableitung (per gliedweiser Differentiation)

∞

1

=

f

(x)

=

nxn−1 ,

(1 − x)2

n=0

Also bekommen wir

E[X] =

∞

x ∈ (−1, 1).

p(1 − p)n−1 · n

n=1

= p f (1 − p) =

1

.

p

3

Satz 3.5 (Rechenregeln) Seien X, Y, Xn , Yn ∈ L1 (P), n ∈ N, diskrete reelle Zufallsvariablen auf

(Ω, A, P). Dann gilt

(i) Ist PX = PY , so ist E[X] = E[Y ].

(ii) (Linearität) Es gelten für alle c ∈ R: cX ∈ L1 (P), X + Y ∈ L1 (P) (mit der Dreiecksungleichung

E[|X + Y |] ≤ E[|X|] + E[|Y |]) sowie

E[cX] = cE[X]

E[X + Y ] = E[X] + E[Y ].

(iii) Ist P[X ≥ 0] = 1, so sind äquivalent

E[X] = 0

⇐⇒

P[X = 0] = 1.

(iv) (Monotonie) Gilt P[X ≤ Y ] = 1, so gilt E[X] ≤ E[Y ] mit Gleichheit genau dann, wenn P[X =

Y ] = 1.

∞

(v) Ist P[Xn ≥ 0] = 1 für alle n ∈ N und gilt P[ n=1 Xn = X] = 1, so ist

E[X] =

∞

E[Xn ].

n=1

(vi) Gilt Yn ↑ Y , so gilt E[Y ] = limn→∞ E[Yn ].

(vii) Sind X und Y unabhängig, so ist X · Y ∈ L1 (P) und E[XY ] = E[X]E[Y ].

Beweis

(i) Klar.

(ii) Klar ist WcX = cWX := {cx : x ∈ WX } also

|y|P[cX = y] = |c| ·

|x| · P[X = x] < ∞.

y∈WcX

x∈WX

Die selbe Rechnung ohne Betragstriche liefert E[cX] = cE[X].

56

Erwartungswerte, Varianzen

Klar ist WX+Y = WX + WY := {x + y : x ∈ WX , y ∈ WY }. Also ist nach der Formel von der

totalen Wahrscheinlichkeit

|z|P[X + Y = z]

E[|X + Y |] =

z∈WX+Y

=

|z|P[X = x, X + Y = z]

x∈WX , z∈WX+Y

=

|x + y|P[X = x, Y = y]

x∈WX , y∈WY

≤

(|x| + |y|)P[X = x, Y = y]

x∈WX y∈WY

=

x∈WX

=

|x|

P[X = x, Y = y] +

y∈WY

|x|P[X = x] +

x∈WX

|y|

y∈WY

P[X = x, Y = y]

x∈WX

|y|P[Y = y]

y∈WY

= E[|X|] + E[|Y |].

Die selbe Rechnung ohne Betragstriche ergibt E[X + Y ] = E[X] + E[Y ]. Dabei dürfen wir die

Summationsreihenfolge vertauschen, weil nach dem eben gezeigten alle Reihen absolut konvergieren.

(iii) Der Wertebereich von X ist WX ⊂ [0, ∞), also ist E[X] = x∈WX xP[X = x] ≥ 0.

Sei nun P[X ≥ 0] = 1 und E[X] = 0. Dann ist für n ∈ N

0 = E[X] =

xP[X = x]

x∈WX

≥

xP[X = x]

1

x∈WX ∩[ n

,∞)

≥

1

x∈WX ∩[ n

,∞)

1

P[X = x]

n

1

1

P[X ∈ WX ∩ [ , ∞)]

n

n

1

1

= P[X ≥ ],

n

n

=

also P[X ≥

1

n]

= 0. Wegen {X ≥

1

n}

↑ {X > 0} folgt

P[X > 0] = lim P[X ≥

n→∞

1

] = 0.

n

(iv) Setze Z := Y − X und wende (iii) auf Z an.

N

(v) Für N ∈ N setze SN := n=1 Xn . Dann ist SN ≤ X nach Voraussetzung, also E[X] ≥ E[SN ]

(nach (iv)) und damit

E[X] ≥ lim E[SN ] = lim

N →∞

N →∞

N

n=1

E[Xn ] =

∞

n=1

E[Xn ].

3.1 Erwartungswerte für diskrete Zufallsvariablen

57

Um die andere Ungleichung zu zeigen, zeigen wir dass für jedes c ∈ (0, 1) gilt

cE[X] ≤

∞

E[Xn ].

(3.1)

n=1

Definiere die Zufallsvariable T mit Werten in N durch

T := min{N ∈ N : SN ≥ cX}.

Wegen SN ↑ X und c < 1 folgt P[T < ∞] = 1. Betrachte nun die Zufallsvariable ST : ω →

∞

ST (ω) (ω). Dann ist der Wertebereich WST ⊂ N =1 WSN abzählbar, also ST diskret. Per Konstruktion ist ST ≥ cX also

cE[X] ≤ E[ST ]

sP[ST = s]

=

s∈WST

=

∞

sP[SN = s, T = N ]

N =1 s∈WST

=

∞

sP[(SN 1{T =N } ) = s]

N =1 s∈WST

=

∞

E[SN 1{T =N } ]

N =1

=

∞ N

E[Xn 1{T =N } ]

N =1 n=1

=

∞ N

xP[Xn = x, T = N ]

N =1 n=1 x∈WXn

=

∞

∞

xP[Xn = x, T = N ]

n=1 x∈WXn N =n

=

∞

xP[Xn = x, T ≥ N ]

n=1 x∈WXn

≤

∞

xP[Xn = x]

n=1 x∈WXn

=

∞

E[Xn ].

n=1

(vi) Wende (v) an auf Xn = Yn+1 − Yn und X = Y − Y1 .

58

Erwartungswerte, Varianzen

(vii) Klar ist WXY = {xy : x ∈ Wx , y ∈ Wy } abzählbar. Also ist

E[|XY |] =

|z|P[XY = z]

z∈WXY

=

|x| · |z/x|P[Y = z/x, X = x]

z∈WXY x∈WX , x=0

=

|x| · |y|P[Y = y, X = x]

y∈WY x∈WX

=

|x|P[X = x] · |y|P[Y = y]

y∈WY x∈WX

= E[|X|] · E[|Y |] < ∞.

Also ist XY ∈ L1 . Die selbe Rechnung ohne Betragstriche liefert E[XY ] = E[X] · E[Y ].

2

Beispiele 3.6

(i) (Binomialverteilung) Sei X ∼ bn,p für n ∈ N und p ∈ [0, 1]. Sind X1 , . . . , Xn und

abhängig und Bernoulli verteilt mit Parameter p, so ist X = X1 + . . . + Xn , also

E[X] = E[X1 + . . . + Xn ] = E[X1 ] + . . . + E[Xn ] = pn.

(ii) (Negative Binomialverteilung) Sei X ∼ b−

n,p und seien X1 , . . . , Xn unabhängig und geometrisch

verteilt mit Parameter p. Nach Beispiel 3.4 ist E[X1 ] = p1 . Es ist Xi − 1 ∼ b−

1,p und (vergleiche

d

Beispiel 2.38) X = X1 + . . . + Xn − n. Also ist E[X] = nE[X1 ] − n =

1−p

p n.

3

Beispiel 3.7 In einer Urne seien m blaue Kugeln und n rote Kugeln. Wir ziehen diese ohne Zurücklegen

und legen sie von links nach rechts aufgereiht auf einen Tisch. Wie groß ist die erwartete Anzahl von blauen

Kugeln, neben denen rechts eine rote Kugel liegt? Wir setzen für i = 1, . . . , m + n

Xi =

1,

0,

die i-te Kugel ist blau,

sonst.

Setze

Yi = 1{Xi =1} 1{Xi+1 =0} ,

i = 1, . . . , m + n − 1,

und Y := Y1 + . . . + Ym+n−1 . Dann ist

P[Yi = 1] = P[Y1 = 1] =

also E[Yi ] =

mn

(m+n)(m+n−1) .

n

m

,

m+n m+n−1

Insgesamt ist die gesuchte erwartete Anzahl

E[Y ] =

m+n−1

i=1

E[Yi ] =

mn

.

m+n

3

3.2 Erwartungswerte für allgemeine reelle Zufallsvariablen

3.2

59

Erwartungswerte für allgemeine reelle Zufallsvariablen

Sei X eine reelle Zufallsvariable. Dann ist (mit x := max{k ∈ Z : k ≤ x})

Xn := 2−n 2n X

eine diskrete Zufallsvariable mit Wertebereich WXn = 2−n Z. Offenbar ist

Xn ≤ X ≤ Xn + 2−n

(3.2)

|Xn | − 2−n ≤ |X| ≤ |Xn | + 2−n .

(3.3)

und

Ferner ist Xn ↑ X. In Anlehnung an Satz 3.5(vi) treffen wir die folgende Definition.

Definition 3.8 (Erwartungswert für allgemeine reelle Zufallsvariablen) Wir sagen, dass eine reelle Zufallsvariable X einen Erwartungswert besitzt (und schreiben X ∈ L1 (P) oder E[|X|] < ∞), falls

Xn ∈ L1 (P) für ein n ∈ N (und damit für alle n ∈ N) und nennen

E[X] := lim E[Xn ]

n→∞

den Erwartungswert von X.

Satz 3.9 Die Rechenregeln aus Satz 3.5 gelten auch für nicht-diskrete Zufallsvariablen.

Beweis Man muss jeweils immer nur zeigen, dass Summation und Limes vertauschen. Nach (3.2) und

(3.3) sind die Limiten jeweils gleichmäßig, vertauschen also mit der Summation. Wir lassen die Details aus

und verweisen auf die Vorlesung Stochastik I“. Exemplarisch sei hier nur die Additivität gezeigt. Seien

”

also X, Y ∈ L1 (P). Dann ist

|E[X + Y ] − E[X] − E[Y ]| = lim E[2−n 2n (X + Y ) − 2−n 2n X − 2−n 2n Y n→∞

≤ lim 4 · 2−n = 0.

n→∞

2

Bemerkung 3.10 Ist X eine reelle Zufallsvariable mit P[X ≥ 0] = 1, so ist

∞

E[X] =

P[X ≥ t] dt.

(3.4)

0

Nimmt speziell X Werte in N0 an, so ist

E[X] =

∞

P[X ≥ n].

(3.5)

n=1

3

60

Erwartungswerte, Varianzen

Beweis Gelte zunächst P[X ∈ N0 ] = 1. Dann ist

∞

E[X] =

kP[X = k]

k=1

∞ k

=

P[X = k]

k=1 n=1

∞

∞ =

P[X = k]

n=1 k=n

∞

=

P[X ≥ n].

n=1

Sei nun der allgemeine Fall X ≥ 0 betrachtet. Sei Xn := 2−n 2n X. Dann ist

E[X] = lim E[Xn ]

n→∞

= lim 2−n

n→∞

= lim 2−n

n→∞

=

∞

0

∞

k=1

∞

P[Xn ≥ k2−n ]

P[X ≥ k2−n ]

k=1

P[X ≥ t] dt,

wobei wir im letzten Schritt die Reihe als Riemann-Summe angesehen haben, die das Integral approximiert.

2

Satz 3.11 Sei X eine reelle Zufallsvariable und habe die Verteilung PX eine Dichte fX . Dann gilt

∞

fX (x) |x| dx < ∞.

E[|X|] < ∞

⇐⇒

(3.6)

−∞

Ist E[|X|] < ∞, so ist

E[X] =

∞

−∞

f (x)x dx.

(3.7)

Beweis Seien Xn , n ∈ N, approximierende Zufallsvariablen wie oben. Dann ist (wegen |x| − 2−n ≤

|2−n 2n x| ≤ |x| + 2−n )

E[|Xn |] =

|k2−n |P[Xn = k2−n ]

k∈Z

=

|k2−n |

k∈Z

≤

k∈Z

∞

(k+1)2−n

k2−n

(k+1)2−n

k2−n

f (x) dx

(|x| + 2−n )f (x) dx

(|x| + 2−n )f (x) dx

∞

−n

=2 +

|x| f (x) dx.

=

−∞

−∞

3.2 Erwartungswerte für allgemeine reelle Zufallsvariablen

Analog erhalten wir

E[|Xn |] ≥ −2−n +

∞

−∞

61

f (x)|x| dx.

Also haben wir (3.6) gezeigt. Die selbe Rechnung ohne Betragstriche liefert (3.6).

2

2

2

Beispiel 3.12 Sei

√ X ∼ Nµ,σ normalverteilt mit Parametern µ ∈ R und σ > 0. Nach Beispiel 1.54 ist

Y := (X − µ)/ σ 2 ∼ N0,1 . Die Verteilung von Y hat die Dichte

2

1

f (x) = √ e−x /2 ,

2π

Daher ist

∞

2

|x|f (x) dx = √

2π

−∞

∞

0

x ∈ R.

2

x e−x

/2

2

< ∞.

dx = √

2π

Also ist Y ∈ L1 und damit X ∈ L1 . Weiter ist f (x) = f (−x), also x → xf (x) eine ungerade Funktion

und damit

∞

E[Y ] =

Folglich ist E[X] = µ +

√

σ 2 E[Y ] = µ.

−∞

xf (x) = 0.

3

Beispiel 3.13 Sei X Standard-Cauchy verteilt, das heißt X ist reell mit Dichte

1 1

,

π 1 + x2

f (x) =

x ∈ R.

Dann ist f (x) = f (−x) wie bei der Normalverteilung, aber hier existiert der Erwartungswert nicht (und ist

insbesondere nicht Null), denn

∞

2 ∞ x

2 ∞ x

1 ∞1

dx = ∞

|x|f (x) dx =

dx

≥

dx

≥

π 0 1 + x2

π 1 1 + x2

π 1 x

−∞

(wobei wir für x ≥ 1 ausgenutzt haben, dass

1

1+x2

≥

1

2x2 ).

Also ist E[|X|] = ∞.

3

Beispiel 3.14 Seien X1 , X2 , . . . identisch verteilte Zufallsvariablen mit E[|X1 |] < ∞. Dann gilt

P[|Xn | ≥ n für unendlich viele n ∈ N] = 0.

(Vergleiche Beispiel 2.39.) Dies folgt leicht aus dem Borel-Cantelli Lemma, denn nach Bemerkung 3.10 ist

∞

n=1

P[|Xn | ≥ n] =

∞

P[|X1 | ≥ n] = E[|X1 |] < ∞.

n=1

3

Satz 3.15 (Wald’sche Identität) Seien T, X1 , X2 , . . . unabhängige reelle Zufallsvariablen in L1 (P). Es

sei P[T ∈ N0 ] = 1, und es seien X1 , X2 , . . . identisch verteilt. Wir setzen

ST :=

T

Xi .

i=1

Dann ist ST ∈ L1 (P) und

E[ST ] = E[T ]E[X1 ].

62

Erwartungswerte, Varianzen

Beweis Setze Sn =

n

i=1

Xi für n ∈ N0 . Dann ist (mit Hilfe der Dreiecksungleichung, siehe Satz 3.5(i))

E[|ST |] =

=

≤

∞

n=1

∞

n=1

∞

E[|Sn |1{T =n} ]

E[|Sn |]E[1{T =n} ]

E[|X1 |]nP[T = n]

n=1

= E[|X1 |]E[T ].

2

Die selbe Rechnung ohne Betragstriche liefert die Aussage.

3.3

Varianzen

Wir wollen in diesem Abschnitt Varianzen und Kovarianzen von reellen Zufallsvariablen untersuchen.

Zunächst betrachten wir allgemein Erwartungswerte von Funktionen von Zufallsvariablen, danach speziell

quadratische Funktionen, die die Kovarianzen und Varianzen definieren.

Satz 3.16

(i) Sei X = (X1 , . . . , Xn ) eine diskrete Rn -wertige Zufallsvariable (mit Wertebereich WX )

und H : Rn → Reine beliebige Abbildung. Setze Y := H(X1 , . . . , Xn ). Dann ist Y ∈ L1 (P)

genau dann, wenn x∈WX |H(x)|P[X = x] < ∞. In diesem Fall ist

E[H(X)] =

H(x) P[X = x].

x∈WX

Xn ) ein Rn -wertige Zufallsvariable mit Dichte fX (also P[X1 ≤ x1 , . . . , Xn ≤

(ii) Sei X =

1, . . . , x(X

xn

1

dtn fX (t1 , . . . , tn )) und H : Rn → R eine messbare Abbildung sowie Y :=

xn ] = −∞ dt1 · · · −∞

H(X). Dann ist Y ∈ L1 (P) genau dann, wenn Rn dx1 . . . dxn |H(x1 , . . . , xn )| · fX (x1 , . . . , xn ) <

∞. In diesem Fall gilt

∞

∞

dx1 · · ·

dxn H(x1 , . . . , xn ) fX (x1 , . . . , xn ).

E[H(X)] =

−∞

−∞

Beweis

(i) Für den Wertebereich WH(X) gilt klar WH(X) = H(WX ) := {H(x) : x ∈ WX }.

Für

jedes

y ∈ WH(X) ist das Ereignis {H(X) = y}die disjunkte Vereinigung {H(X) = y} =

x∈H −1 ({y}) {X = x}. Es gilt also P[H(X) = y] =

x∈H −1 ({y}) P[X = x]. Mithin ist

E[|H(X)|] =

|y| P[H(X) = y]

y∈WH(X)

=

|y| P[X = x]

y∈WH(X) x∈H −1 ({y})

=

|H(x)| P[X = x]

y∈WH(X) x∈H −1 ({y})

=

|H(x)| P[X = x].

x∈WX

Die selbe Rechnung ohne Betragstriche liefert die Aussage.

3.3 Varianzen

63

(ii) Wir betrachten zunächst nur H : Rn → [0, ∞). Dann ist nach Bemerkung 3.10

∞

P[H(X) ≥ t] dt

E[H(X)] =

∞

0 ∞ ∞

dt

dx1 · · ·

dxn f (x1 , . . . , xn )1[t,∞) (H(x1 , . . . , xn ))

=

0

−∞

−∞

∞

∞

∞

=

dx1 · · ·

dxn f (x1 , . . . , xn )

dt1[t,∞) (H(x1 , . . . , xn ))

−∞

−∞

0

∞

∞

=

dx1 · · ·

dxn f (x1 , . . . , xn )H(x1 , . . . , xn ).

−∞

−∞

Für allgemeines H : Rn → R betrachte H = H + − H − mit H + : Rn → [0, ∞) und H − : Rn →

[0, ∞). Dann ist nach dem bisher Gezeigten

E[|H(X)|] = E[H + (X)] + E[H − (X)]

∞

∞

=

dx1 · · ·

dxn f (x1 , . . . , xn ) H + (x1 , . . . , xn ) + H − (x1 , . . . , xn )

−∞

−∞

∞

∞

=

dx1 · · ·

dxn f (x1 , . . . , xn ) |H(X)|.

−∞

−∞

Die selbe Rechnung ohne Betragstriche liefert die Aussage.

2

Sei stets X eine reelle Zufallsvariable, und sei p ≥ 1.

Definition 3.17 Wir sagen, dass X ein p-tes Moment besitzt, falls

Mp (X) := E[|X|p ] < ∞.

Wir schreiben dann X ∈ Lp := Lp (P) und nennen Mp (X) das p–te absolute Moment von X. Ist p ∈ N

und Mp (X) < ∞ , oder p ∈ {2, 4, 6, . . .}, oder ist X ≥ 0, so heißt

mp (X) := E[X p ]

das p–te Moment von X.

Satz 3.18 Ist p ≥ r ≥ 1 und X ∈ Lp , so ist X ∈ Lr .

Beweis Die folgt direkt aus der Ungleichung |x|r ≤ 1 + |x|p für alle x ∈ R.

Definition 3.19 Seien X, Y ∈ L2 . Dann heißt

Var[X] := E[X 2 ] − E[X]2

die Varianz von X und σ :=

Var[X] heißt die Streuung von X. Ferner heißt

Cov[X, Y ] := E[XY ] − E[X]E[Y ]

die Kovarianz von X und Y . Gilt Cov[X, Y ] = 0, so heißen X und Y unkorreliert.

2

64

Erwartungswerte, Varianzen

Bemerkung Man beachte, dass |xy| ≤ x2 +y 2 . Daher ist E[|XY |] ≤ E[X 2 ]+E[Y 2 ] < ∞. Für X, Y ∈ L2

existiert also stets die Kovarianz.

Beispiele 3.20

(i) Sei X ∼ Berp . Dann ist E[X] = p und X 2 = X, also E[X 2 ] = p. Mithin ist

Var[X] = p − p2 = p(1 − p).

(3.8)

(ii) Sei X ∼ Poiλ für ein λ ≥ 0. Dann ist E[X] = λ und

E[X(X − 1)] =

∞

e−λ k(k − 1)

k=2

∞

λk

λk

= λ2

= λ2 .

e−λ

k!

k!

k=0

Also ist

Var[X] = E[X 2 ] − E[X]2 = E[X(X − 1)] + E[X] − E[X]2 = λ2 + λ − λ2 = λ.

(iii) Sei X ∼ γp für p ∈ (0, 1]. Dann ist E[X] =

f (x) =

Dann ist

und

1

p

(3.9)

(siehe Beispiel 3.4(iii)). Setze

∞

1

=

xn ,

1 − x n=0

x ∈ (−1, 1).

1

= f (x) =

nxn−2 ,

2

(1 − x)

n=1

2

= f (x) =

n(n − 1)xn−2 ,

3

(1 − x)

n=1

also

E[X 2 ] = p

∞

n2 (1 − p)n−1

n=0

= pf (1 − p) + (1 − p)f (1 − p)

=

2−p

1 2(1 − p)

+

=

.

p

p2

p2

Insgesamt erhalten wir

Var[X] = E[X 2 ] − E[X]2 =

2−p

1

1−p

− 2 =

.

p2

p

p2

(3.10)

3

Satz 3.21 Sind X, Y ∈ L2 (P) unabhängig, so sind X und Y unkorreliert.

Beweis Nach Satz 3.5(vii) ist E[XY ] = E[X]E[Y ]. Hieraus folgt direkt die Aussage.

2

3.3 Varianzen

65

Bemerkung 3.22 Ins Satz 3.21 gilt die umgekehrte Implikation natürlich nicht. Hierzu betrachten wir als

Beispiel X und Y mit

P[X = 0, Y = −1] = P[X = 0, Y = 1] = P[X = −1, Y = 0] = P[X = 1, Y = 0] =

Dann ist Cov[X, Y ] = 0, aber P[X = 0, Y = 0] = 0 =

1

4

1

.

4

= P[X = 0]P[Y = 0].

3

Satz 3.23 Es gelten

(i) Cov[X, Y ] = E[(X − E[X])(Y − E[Y ])]

(ii) Var[X] = E[(X − E[X])2 ]

(iii) Speziell ist stets Var[X] ≥ 0 und

Var[X] = 0

Beweis

⇐⇒

P[X = E[X]] = 1.

(3.11)

(i) Dies liefert die einfache Rechnung

E[(X − E[X])(Y − E[Y ])] = E[XY ] − E[E[X]Y ] − E[XE[Y ]] + E[E[X]E[Y ]]

= E[XY ] − E[X]E[Y ] − E[X]E[Y ] + E[X]E[Y ]

= E[XY ] − E[X]E[Y ]

= Cov[X, Y ].

(ii) Dies folgt direkt aus (i), weil Var[X] = Cov[X, X].

(iii) Die Aussage folgt aus (ii) zusammen mit Satz 3.5(iii)), angewandt auf die Zufallsvariable (X −

E[X])2 .

2

Beispiel 3.24 Sei X ∼ Nµ,σ2 mit µ ∈ R und σ 2 > 0. Dann ist E[X] = µ und mittels affiner Substitution

und partieller Integration erhalten wir

Var[X] = E[(X − µ)2 ]

∞

1

(x − µ)2

2

=√

(x − µ) exp −

dx

2σ 2

2πσ 2 −∞

∞

x2

1

x2 exp − 2 dx

=√

2σ

2πσ 2 −∞

2

2 ∞

x

σ

x2 exp −

=√

dx

2

2π −∞

2 ∞

∞

2

x

σ2

−xe−x /2 +

exp −

dx

=√

2

−∞

2π

−∞

= σ2 .

3

66

Erwartungswerte, Varianzen

Satz 3.25 Die Abbildung

Cov : L2 (P) × L2 (P) → R

ist eine positiv semidefinite symmetrische Bilinearform mit Cov[X, Y ] = 0, falls es ein y ∈ R gibt mit

P[Y = y] = 1. Ausgeschrieben heißt dies: Für X1 , . . ., Xm , Y1 , . . ., Yn ∈ L2 (P) und α1 , . . . , αm ,

β1 , . . . , βn ∈ R, sowie d, e ∈ R

⎤

⎡

m

n

Cov ⎣d +

αi Xi , e +

βj Yj ⎦ =

αi βj Cov[Xi , Yj ].

(3.12)

i=1

j=1

i,j

Speziell gilt die Bienaymé-Gleichung

m

m

m

Var

Xi =

Var[Xi ] +

Cov[Xi , Xj ].

i=1

Für unkorrelierte (speziell also für unabhängige) X1 , . . . , Xm gilt

m

m

Var

Xi =

Var[Xi ].

i=1

Beweis

⎡

Cov ⎣d +

m

αi Xi , e +

i=1

(3.13)

i,j=1

i=j

i=1

(3.14)

i=1

n

⎤

βj Yj ⎦

j=1

⎡

⎞⎤

⎛ n

m

= E⎣

αi (Xi − E[Xi ]) ⎝

βj (Yj − E[Yj ])⎠⎦

i=1

=

n

m j=1

αi βj E[(Xi − E[Xi ])(Yj − E[Yj ])]

i=1 j=1

=

m n

αi βj Cov[Xi , Yj ].

i=1 j=1

2

Beispiel 3.26 Seien n ∈ N und p ∈ [0, 1], sowie X ∼ bn,p . Wir wollen die Varianz von X ausrechnen.

Seien X1 , . . . , Xn unabhängig und Bernoulliverteilt mit Parameter p (und damit Var[Xi ] = p(1−p). Dann

d

ist X = X1 + . . . + Xn , also

Var[X] = Var[X1 + . . . + Xn ] = Var[X1 ] + . . . + Var[Xn ] = np(1 − p).

3

3.3 Varianzen

67

Beispiel 3.27 Seien n ∈ N und p ∈ (0, 1], sowie X ∼ b−

n,p . Seien X1 , . . . , Xn unabhängig Xi ∼ γp . (und

damit Var[Xi ] =

1−p

p2

d

nach Beispiel 3.20(iii)). Dann ist X = X1 + . . . + Xn − n, also

Var[X] = Var[X − n] = Var[X1 + . . . + Xn ] = n

1−p

.

p2

3

Korollar 3.28 Sind X, Y ∈ L2 , so gilt die Cauchy-Schwarz-Ungleichung

2

(Cov[X, Y ]) ≤ Var[X] Var[Y ].

(3.15)

In (3.15) gilt Gleichheit genau dann, wenn es Zahlen a, b ∈ R gibt mit P[X = aY + b] = 1. In diesem

Fall nennen wir X und Y perfekt korreliert.

Beweis Die Cauchy-Schwarz Ungleichung gilt für jede positiv semidefinite Bilinearform · , · auf einem

Vektorraum V . Es gilt jeweils Gleichheit x, y2 = x, xy, y genau dann, wenn es eine Zahl a ∈ R gibt

mit x − ay, x − ay = 0. Wenden wir dies auf die positiv semidefinite Bilinearform Cov[ · , · ] auf L2 (P)

an, so erhalten wir die Cauchy-Schwarz Ungleichung für X, Y ∈ L2 mit Gleichheit genau dann, wenn

Var[X − aY ] = 0, also genau dann, wenn (vergleiche Satz 3.23(iii)) P[X = aY − E[X] + aE[Y ]] = 1,

also die gewünschte Aussage mit b = aE[Y ] − E[X].

Zeigen wir nun also die Aussage für die allgemeine positiv semidefinite Bilinearform. Ohne Einschränkung

gilt y, y > 0 (sonst ist die Aussage trivial). Es gilt dann

0 ≤ y, yx − x, yy, y, yx − x, yy

= y, y2 x, x − 2y, yx, y2 + y, yx, y2

= y, y y, yx, x − x, y2 ,

also

y, yx, x − x, y2 ≥ 0.

Es gilt Gleichheit genau dann, wenn

x, y

x, y

y, x −

y

x−

y, y

y, y

!

= 0.

2

Satz 3.29 (Formel von Blackwell-Girshick) Seien T, X1 , X2 , . . . unabhängige reelle Zufallsvariablen in

L2 (P). Es sei P[T ∈ N0 ] = 1, und es seien X1 , X2 , . . . identisch verteilt. Wir setzen

ST :=

T

Xi .

i=1

Dann ist ST ∈ L2 (P) und

Var[ST ] = E[X1 ]2 Var[T ] + E[T ]Var[X1 ].

68

Erwartungswerte, Varianzen

Beweis Es ist

E[ST2 ] =

∞

n=0

⎡

E ⎣1T =n

n

2 ⎤

Xi

⎦

i=1

⎡

2 ⎤

∞

n

=

E[1T =n ]E ⎣

Xi ⎦

n=0

i=1

⎛ ⎡

2 ⎤ n

2 ⎞

∞

n

=

P[T = n] ⎝E ⎣

(Xi − E[Xi ]) ⎦ +

E[Xi ] ⎠

n=0

=

∞

i=1

i=1

P[T = n] nVar[X1 ] + n2 E[X1 ]2

n=0

= E[T ]Var[X1 ] + E[T 2 ]E[X1 ]2 .

Nach der Wald’schen Identität (Satz 3.15) ist E[ST ] = E[T ]E[X1 ], also ist

Var[ST ] = E[ST2 ] − E[ST ]2 = E[T ]Var[X1 ] + (E[T 2 ] − E[T ]2 )E[X1 ]2 .

2

Dies ist aber die Behauptung.

Wir kommen nun zu einer weiteren wichtigen Ungleichung für reellwertige Zufallsvariablen. Trotz der

Einfachheit des Argumentes ist diese Aussage fundamental.

Satz 3.30 (Markoffungleichung, Tschebyscheffungleichung)

(i) Sei X eine reelle Zufallsvariable und

f : [0, ∞) → [0, ∞) eine monotone Funktion. Dann gilt für jedes a > 0 mit f (a) > 0 die Markoffungleichung

E[f (|X|)]

.

(3.16)

P[|X| ≥ a] ≤

f (a)

(ii) Speziell gilt für X ∈ L2 (P) die Tschebyscheffungleichung

P[|X − E[X]| > a] ≤

Beweis

Var[X]

.

a2

(3.17)

(i) Betrachte die Zufallsvariable Y := f (a)1{|X|≥a} . Dann ist Y ≤ f (|X|), also (nach Satz 3.5(iv))

E[f (|X|)] ≥ E[Y ] = f (a)P[|X| ≥ a].

(ii) Wende (i) auf die Zufallsvariable X = X − E[X] an mit f (x) = x2 .

2

Beispiel 3.31 Sei X ∼ b−

n,p . Wie können wir für a ∈ N die Wahrscheinlichkeit P[X ≥ a] einfach

abschätzen?

1−p

Es ist E[X] = n 1−p

p (siehe Beispiel 3.6) und Var[X] = n p2 (Beispiel 3.20). Daher liefert die Tschebyscheffungleichung

"

P[X ≥ a] ≤ P |X − E[X]| ≥ a − E[X] ≤

Var[X]

1−p

=

.

2

(a − E[X])

(ap − n(1 − p))2

3.4 Der Median

69

3

Beispiel 3.32 Sei X ∼ Poiλ für ein λ > 0. Wie groß ist P[X ≥ a]?

Wir wenden zunächst die Tschebyscheffungleichung an. Es ist E[X] = λ und Var[X] = λ (siehe Beispiel 3.20(ii)). Also ist

Var[X]

λ

P[X ≥ a] ≤

=

.

(3.18)

(a − E[X])2

(a − λ)2

Wir wollen diese Abschätzung verbessern, indem wir eine geeignetere Funktion in der Markoffungleichung

wählen. Setze f (x) := exp(θx), wobei θ := log(a/λ). Dann ist

P[X ≥ a] ≤ e−θa E[eθX ]

∞

λk

= e−θa

e−λ eθk

k!

k=0

−θa −λ λeθ

=e

e

e

θ

= e−θa e−λ(1−e ) .

Dieser Ausdruck wird minimal genau für unsere Wahl von θ, und es folgt

a P[X ≥ a] ≤ exp a − λ − a log

.

λ

(3.19)

3

Für große a ist diese Abschätzung besser als (3.18).

3.4

Der Median

Für reelle Zufallsvariablen X, die keinen Erwartungswert besitzen, ist es nützlich, eine andere Kenngröße

anzugeben, die einen typischen Wert angibt. Dies kann der Median sein, der als derjenige Wert mX definiert ist, so dass X mit Wahrscheinlichkeit mindestens 12 Werte kleiner als mX annimmt, ebenfalls mit

Wahrscheinlichkeit mindestens 12 Werte größer als mX .

Definition 3.33 (Median) Sei µ ein Wahrscheinlichkeitsmaß auf R. Dann heißt jede Zahl m ∈ R mit

µ((−∞, m]) ≥

1

2

und

µ([m, ∞)) ≥

1

2

(3.20)

ein Median von µ. Ist speziell X eine reelle Zufallsvariable, so heißt mX Median von X, falls mX der

Median von PX ist, also falls

P[X ≤ mX ] ≥

1

2

und

P[X ≥ mX ] ≥

1

.

2

(3.21)

Satz 3.34 Die Menge Mµ = {m ∈ R : mist Median von µ} =: [m− , m+ ] ist ein kompaktes Intervall, das

möglicherweise aus nur einem Punkt besteht.

Beweis Seien m1 , m2 ∈ Mµ , m1 ≥ m2 , so ist für jedes m ∈ [m1 , m2 ]:

µ((−∞, m]) ≥ µ((−∞, m2 ]) ≥

1

2

und

µ([m, ∞)) ≥ µ([m1 , ∞)) ≥

1

.

2

70

Erwartungswerte, Varianzen

Also ist m ∈ Mµ . Außerdem gilt µ((−∞, x]) → 0 für x → −∞, also existiert ein x ∈ R mit µ((−∞, x]) ≤

1

4 . Klar ist x ≤ m für alle m ∈ Mµ . Analog existiert ein y ∈ R mit y > m für alle m ∈ Mµ . Also ist Mµ

beschränkt.

Ist #Mµ = 1, so ist klar Mµ kompakt. Sei also nun Mµ ein nicht entartetes Intervall und m− := inf Mµ ∈

R. Sei mn ∈ Mµ für jedes n ∈ N und m1 > m2 > m3 > . . . sowie m− = limn→∞ mn , so ist

µ((−∞, m− ]) = lim µ((−∞, mn ]) ≥

n→∞

1

2

und

1

.

2

Mithin ist m− ∈ Mµ . Analog folgt m+ := sup Mµ ∈ Mµ , also ist Mµ abgeschlossen und damit kompakt.

2

µ([m− , ∞) ≥ µ((m− , ∞)) = lim µ([mn , ∞)) ≥

n→∞

Der Median hat eine einfache Transformationseigenschaft.

Satz 3.35 Sei X eine reelle Zufallsvariable und ϕ : R → R eine monoton wachsende, oder monoton

fallende, Abbildung. Sei ferner mX ein Median von X. Dann ist ϕ(mX ) ein Median der Zufallsvariablen

ϕ(X).

Beweis Sei zunächst ϕ monoton wachsend. Für alle x ∈ R ist {ϕ(X) ≤ ϕ(x)} ⊃ {X ≤ x} und

{ϕ(X) ≥ ϕ(x)} ⊃ {X ≥ x}. Daher ist

P[ϕ(X) ≤ ϕ(mX )] ≥ P[X ≤ mX ] ≥

1

2

und

P[ϕ(X) ≥ ϕ(mX )] ≥ P[X ≥ mX ] ≥

1

.

2

Analog ist für ϕ monoton fallend {ϕ(X) ≤ ϕ(x)} ⊃ {X ≥ x} und {ϕ(X) ≥ ϕ(x)} ⊃ {X ≤ x}. Daher

ist

P[ϕ(X) ≤ ϕ(mX )] ≥ P[X ≥ mX ] ≥

1

2

und

P[ϕ(X) ≥ ϕ(mX )] ≥ P[X ≤ mX ] ≥

1

.

2

2

Beispiel 3.36 Wir nehmen an, dass ein an einem Faden aufgehängter frei drehbarer Spiegel eine zufällige

Lage X einnimmt, die gleichverteilt sein soll in dem Intervall (0, π/2). Um die Lage abzulesen, verwenden

wir einen Laserstrahl, der einen Messpunkt Y auf einem Längeneinheiten entfernten Wandschirm liefert.

Wir können annehmen, dass die Winkel so angegeben sind, dass gilt: Y = tan(X). Welches ist eine gute

Kenngröße für Y ? Die Stammfunktion von x → tan(x) ist x → − log(cos(x)). Also ist

E[Y ] =

0

π/2

x=π/2

2

π

tan(x) dx = − log(cos(x))

= ∞.

π

2

x=0

Andererseits ist von X der Median mX = π4 , also von Y der Median mY = tan(π/4) = . Können wir

nun experimentell mY bestimmen, so können wir ebenfalls auf den Median von X rückschließen durch

3

mX = arctan(mY /

).

Bemerkung 3.37 Ist die Verteilungsfunktion x → FX (x) = P[X ≤ x] streng monoton wachsend, so ist

der Median eindeutig.

3

Beweis Übung!

2

3.4 Der Median

71

Satz 3.38 Ist X ∈ L1 (P), so ist jeder Median mX ein Minimierer des L1 -Abstands zu X:

E[|X − a|] ≥ E[|X − mX |]

für alle x ∈ R]

(3.22)

a ist eine Median von X.

(3.23)

und

E[|X − a|] = E[|X − mX |]

⇐⇒

Beweis Definiere

h(a) := E[|X − a|],

Dann ist

h(a) =

=

=

∞

0 ∞

0 ∞

a ∈ R.

P[|X − a| ≥ t] dt

P[X − a ≥ t] + P[X − a ≤ −t] dt

a

P[X ≥ t] dt +

P[X ≤ t] dt.

−∞

a

Für t < mX ist 1 − P[X ≤ t] − P[X < t] ≤ 0. Für a ≤ b ≤ mX ist daher

h(b) − h(a) =

b

a

=

P[X ≥ t] dt +

a

P[X ≤ t] dt

b

b

(1 − P[X ≤ t] − P[X < t]) dt

a

=

b

(1 − P[X ≤ t] − P[X < t]) dt

a

≤ 0.

Speziell ist h(mX ) ≥ h(a) für alle a ≤ mX . Analog erhält man m(mX ) ≥ h(a) für alle a ≥ mX . Sei nun

m− der kleinste Median von X und b < m− . Dann ist für alle t ∈ (b, m− ) sogar 1 − P[X ≤ t] − P[X <

t] < 0, also h(b) − h(m− ) > 0. Analog erhält man h(b) − h(m+ ) > 0 für alle b die echt größer sind als

2

der größte Median m+ .

Korollar 3.39 Ist X ∈ L2 (P) und ist m ein Median von X, so ist

|m − E[X]| ≤ Var[X] .

(3.24)

Beweis Für jedes c ∈ R ist |E[X] − c| = |E[X − c]| ≤ |E[|X − c|]| = E[|X − c|]. Außerdem ist für

Y ∈ L2 (P) stets E[Y 2 ] = Var[Y ]+E[Y ]2 ≥ E[Y ]2 . Wir wenden dies an mit c = m und Y = |X −E[X]|

und erhalten

|E[X] − m| ≤ E[|X − m|]

Satz 3.38

≤

E[|X − E[X]|] ≤ E[(X − E[X])2 ] = Var[X].

2