stochastik

Werbung

STOCHASTIK

Wahrscheinlichkeitstheorie und mathematische

Statistik

Prof. Dr. Barbara Grabowski

Hochschule für Technik und Wirtschaft

des Saarlandes

Lehreinheit zur Kurseinheit „Mathematik für Informatiker“

im Fernstudiengang „Allgemeine Informatik“ der ZFH Koblenz

Einleitung

Einleitung

Diese Kurseinheit dient der Vermittlung von Grundkenntnissen auf dem

Gebiet der Wahrscheinlichkeitsrechnung und mathematischen Statistik.

Mathematische Statistik und Wahrscheinlichkeitsrechnung sind zwei

unterschiedliche Teildisziplinen der Mathematik, die ohne einander nicht

denkbar sind und unter dem Sammelbegriff „Stochastik“ zusammengefasst

werden. Aufgabe der Wahrscheinlichkeitsrechnung ist es, Gesetzmäßigkeiten

des Zufalls zu untersuchen, bzw. mathematische Modelle dafür zu liefern.

Die Wahrscheinlichkeitsrechnung ist zugleich das theoretische Fundament

der mathematischen Statistik. Diese wird in der Regel in die Teildisziplinen

„Beschreibende Statistik“ und „Schließende Statistik“ unterteilt. Während es in

der Beschreibenden Statistik um Methoden der Aufbereitung und Darstellung

von Datenmaterial geht, stehen im Mittelpunkt der Schließenden Statistik

Verfahren, mit deren Hilfe von Beobachtungsdaten eines Merkmals an n

Objekten einer Grundgesamtheit, d.h. von der sogenannten Stichprobe, auf

die Verteilung der Merkmalswerte in der gesamten Grundgesamtheit

geschlossen wird. Dieser Schluss wird mit Hilfe von Methoden der

Wahrscheinlichkeitsrechnung

durch

Irrtumsbzw.

Sicherheitswahrscheinlichkeiten bewertet.

Die Stochastik hat längst in viele moderne wissenschaftliche Teildisziplinen

Einzug gehalten, auch die Informatik und die Kommunikationstechnik sind

ohne stochastische Methoden nicht mehr denkbar. Stochastische Methoden

finden hier zum Beispiel Anwendung

- bei der probabilistischen Analyse von Algorithmen

- bei der Codierung bzw. in der Informationstheorie

- in der Sprach- und Signalverarbeitung

- bei der Mustererkennung bzw. Bildverarbeitung

- bei der Modellierung von Rechner- bzw. Informationsnetzen

- bei der Simulation komplexer Systeme, wie z.B. Fertigungs-,

Informations-, Verkehrssysteme usw.

Darüber hinaus sind Methoden der Statistik fester Bestandteil von

Datenbanksystemen geworden und finden als Data-Mining-Verfahren

Anwendung.

Wir geben in dieser Kurseinheit eine Einführung in die Methoden der

Stochastik, wobei wir uns aufgrund der beschränkten Seitenzahl dieser

Lehreinheit auf eine Einführung in die Wahrscheinlichkeitsrechnung und

einige wenige Methoden der Schließenden Statistik beschränken. Für weitere

Methoden der Stochastik, insbesondere auch der Beschreibenden Statistik,

Stochastik

verweisen wir auf die im Literaturverzeichnis des Anhangs angegebene

weiterführende Literatur.

Im ersten Kapitel werden Sie mit dem Begriff der Wahrscheinlichkeit und mit

Grundgesetzen des Rechnens mit Wahrscheinlichkeiten vertraut gemacht. Im

Kapitel 2 wird der Begriff der Zufallsgröße eingeführt und die Methodik zur

Modellierung der Wahrscheinlichkeitsverteilungen von Zufallgrößen

dargestellt. Kapitel 3 enthält Angaben über die Verteilung von Summen und

anderen Funktionen von Zufallsgrößen. Im Mittelpunkt von Kapitel 4 steht

die Aufgabe der Identifizierung der Verteilung einer Zufallsgröße anhand

von Beobachtungen dieser Zufallsgröße. Anhand dieser Aufgabenstellung

werden wichtige Grundprinzipien der Schließenden Statistik, wie Punkt- und

Bereichsschätzungen, für Verteilungsparameter erläutert. Die Kurseinheit

schließt mit dem Kapitel 5 ab, in welchem Algorithmen zur Erzeugung von

Pseudo-Zufallszahlen vorgestellt werden.

In jedem Kapitel werden eine Reihe von Übungsaufgaben gestellt. Am Ende

dieser Kurseinheit finden Sie die Lösungen zu allen Übungsaufgaben.

Für die Herleitung vieler Aussagen in dieser Kurseinheit benötigt man

Grundkenntnisse der Analysis, wie z.B. die einfache Integralrechnung.

Nach Durcharbeiten dieser Kurseinheit können Sie zufällige Einflussparameter in stochastischen Systemen mathematisch modellieren. Insbesondere können Sie

• mit Wahrscheinlichkeiten rechnen,

• auf der Basis einer Folge von Beobachtungen eines Ereignisses A dessen

Wahrscheinlichkeit mit vorgegebener Genauigkeit schätzen,

• auf der Basis von Beobachtungen einer Zufallsgröße ein Histogramm

aufstellen und eine Hypothese über die Verteilung der Zufallsgröße

bilden und diese prüfen, sowie die Parameter der Verteilung schätzen,

• Algorithmen für die Erzeugung von Zufallszahlen typischer z.B. in der

Simulation verwendeter Verteilungen entwickeln.

Inhaltsverzeichnis

-I-

Inhaltsverzeichnis

1 Der Wahrscheinlichkeitsraum

1

1.1 Der Wahrscheinlichkeitsraum................................................................................... 1

1.1.1 Kleiner Exkurs zur Mengenlehre .................................................................. 2

1.1.2 Zufälliger Versuch und zufällige Ereignisse................................................ 5

1.1.3 Das Ereignisfeld............................................................................................... 7

1.1.4 Relative Häufigkeit von Ereignissen und Definition der

Wahrscheinlichkeit.......................................................................................... 8

1.2 Der klassische Wahrscheinlichkeitsbegriff ............................................................ 11

1.3 Bedingte Wahrscheinlichkeit und stochastische Unabhängigkeit von

Ereignissen ................................................................................................................ 13

1.4 Totale Wahrscheinlichkeit und Bayes’sche Formel ............................................. 17

2 Zufallsgrößen

20

2.1 Begriff der Zufallsgröße........................................................................................... 20

2.2 Diskrete Zufallsgrößen............................................................................................. 22

2.2.1 Diskrete Zufallsgröße und ihre Wahrscheinlichkeitsverteilung ............. 22

2.2.2 Spezielle diskrete Wahrscheinlichkeitsverteilungen ................................ 25

2.3 Stetige Zufallsgrößen................................................................................................ 27

2.3.1 Stetige Zufallsgrößen, Verteilungsdichte und Verteilungsfunktion....... 27

2.3.2 Bedingte Wahrscheinlichkeiten und Quantile........................................... 30

2.3.3 Spezielle stetige Verteilungen...................................................................... 33

2.4 Erwartungswert und Varianz von Zufallsgrößen ................................................ 39

3 Verteilungen von Funktionen von Zufallsgrößen

44

3.1 Erwartungswert und Varianz von Summen und linearen Transformationen

von Zufallsgrößen .................................................................................................... 44

3.2 Verteilungen von Summen von Zufallsgrößen..................................................... 45

3.3 Verteilung von Funktionen von Zufallsgrößen .................................................... 50

4 Schätzung von Wahrscheinlichkeiten und Identifizieren von

Verteilungen durch statistische Methoden

52

4.1 Schätzung einer unbekannten Wahrscheinlichkeit .............................................. 52

4.2 Schätzung unbekannter Verteilungsparameter .................................................... 60

4.3 Identifizieren von Verteilungen.............................................................................. 63

- II –

Stochastik

4.3.1 Modellierung stetiger Verteilungen durch Histogramme ....................... 64

4.3.2 Der χ2-Test zur Verteilungsprüfung .......................................................... 67

5 Erzeugung von Zufallszahlen

81

5.1 Erzeugung von Zufallszahlen diskreter Verteilungen......................................... 82

5.2 Erzeugung von Realisierungen stetig verteilter Zufallsgrößen - die inverse

Transformationsmethode........................................................................................ 84

5.3 Erzeugung von Realisierungen einer normalverteilten Zufallsgröße ............... 87

Literaturverzeichnis

89

Tabellen und Diagramme

90

Lösungshinweise zu den Aufgaben

94

Glossar

115

Stichwortverzeichnis

127

Der Wahrscheinlichkeitsraum

1

Der Wahrscheinlichkeitsraum

In diesem Kapitel werden der Wahrscheinlichkeitsbegriff für Ereignisse

definiert und die Grundgesetze des Rechnens mit Wahrscheinlichkeiten

dargestellt. Es bildet damit die Grundlage für alle weiteren Kapitel.

Nach Durcharbeiten dieses Kapitels können Sie

•

•

•

•

•

1.1

die Grundgesetze des Rechnens mit Wahrscheinlichkeiten anwenden,

ihre Chancen in Glücksspielen mittels der klassischen Wahrscheinlichkeit berechnen,

die stochastische Unabhängigkeit von Ereignissen überprüfen,

bedingte Wahrscheinlichkeiten berechnen,

mit Hilfe der Bayes’schen Formel einfache Aufgaben lösen.

Der Wahrscheinlichkeitsraum

Die Wahrscheinlichkeitstheorie untersucht mathematische Modelle für reale

Vorgänge, in denen der Zufall eine Rolle spielt. Wir nennen sie Vorgänge mit

zufälligem Ergebnis und bezeichnen sie als zufällige Versuche.

Beispiel:

Der Betreiber einer Poststation interessiert sich für die Wartezeit von Kunden

in seiner Anlage. Er lässt sie beobachten. Das Ergebnis – hier die Wartezeit ist nicht vorhersagbar. Ein Vorgang mit zufälligem Ergebnis läuft ab. Mit

dem Vorgang sind Ereignisse verbunden:

-

Die Wartezeit ist kleiner als 10 Minuten.

Die Wartezeit beträgt mindestens 20 Minuten.

Die Wartezeit liegt zwischen 10 und 50 Minuten.

Für die Beurteilung der Qualität des Services der Post ist es vielleicht

notwendig, dass das Ereignis: „Die Wartezeit beträgt höchstens 10 Minuten“

eine Wahrscheinlichkeit von mindestens 0,95 besitzt.

Das mathematische Modell für einen Vorgang mit zufälligem Ergebnis ist der

Wahrscheinlichkeitsraum [Ω,ℑ,P]. Hierbei repräsentiert Ω die Menge der

möglichen Ergebnisse des Vorgangs. ℑ enthält diejenigen Teilmengen von Ω,

-1-

-2–

Stochastik

die wir Ereignisse nennen, und wird als Ereignisfeld zu unserem zufälligen

Versuch bezeichnet. P schließlich ist die sogenannte Wahrscheinlichkeitsverteilung, die jedem Ereignis aus ℑ eine als Wahrscheinlichkeit des

Ereignisses bezeichnete Zahl zwischen 0 und 1 zuordnet.

Diese

Wahrscheinlichkeit soll den Grad der Gewissheit über das Eintreten des

Ereignisses ausdrücken. In den folgenden Abschnitten werden die Begriffe

Ereignis, Grundmenge Ω, Ereignisfeld ℑ und Wahrscheinlichkeitsmaß P

näher erklärt.

1.1.1

Mengen

Kleiner Exkurs zur Mengenlehre

Es ist in der Wahrscheinlichkeitsrechnung üblich, Ereignisse durch Mengen

darzustellen. Auf diese Weise kann man mit Ereignissen wie mit Mengen

rechnen. Eine Menge wird angegeben, indem man alle ihre Elemente angibt,

z.B.

- durch Aufzählung oder

- durch Angabe einer die Elemente charakterisierenden Eigenschaft

Dabei ist zu beachten, dass jedes Element in der Menge nur einmal

vorkommt. Mengen werden mit Großbuchstaben und ihre Elemente mit

kleinen Buchstaben bezeichnet.

x ∈ A bedeutet: x ist Element der Menge A

x ∉ A bedeutet: x ist kein Element von A

|A| = Anzahl der Elemente in A.

Beispiele: A={1,2,7}, B = {x ∈ R| 2 ≤ x < 10}, 2 ∈ A , 1 ∉ B, |A| = 3.

Teilmengen,

leere Menge,

Potenzmenge

Mengen stehen in Relationen zueinander. Es bedeutet:

A = B : Die Elemente von A und B sind gleich.

A ⊆ B : Die Elemente von A sind auch in B enthalten (A ist Teilmenge von B).

A ⊂ B : Die Elemente von A sind auch in B enthalten und B enthält

mindestens ein Element, welches nicht in A enthalten ist (A ist echte

Teilmenge von B).

Die Menge ∅={}, die kein Element enthält, wird als leere Menge bezeichnet.

Offensichtlich gilt für jede Menge A: ∅ ⊆ A.

Die Menge, die alle möglichen Teilmengen einer Menge A enthält, wird als

Potenzmenge von A bezeichnet: ℘(A) = {M| M ⊆ A}.

Der Wahrscheinlichkeitsraum

-3-

Beispiel:

Sei A = {1,2,7}. Dann ist ℘(A) = { ∅, {1},{2},{7}, {1,2}, {1,7}, {2,7}, {1,2,7} }.

Mengen kann man durch Operationen miteinander verknüpfen. Diese

Operationen kann man sich in sogenannten Venn-Diagrammen

veranschaulichen:

Operation

Vereinigung

Durchschnitt

Differenz

Mengenoperationen

Operator Bedeutung

Venn-Diagramm

A∪B

enthält alle Elemente, die

in A oder B enthalten

sind

A∩B

enthält alle Elemente, die

in A und B enthalten sind

A\B

enthält alle Elemente, die

in A, aber nicht in B

enthalten sind

Zwei Mengen A und B heißen disjunkt, falls sie kein gemeinsames Element

besitzen, falls also gilt: A ∩ B = Φ.

disjunkte Mengen

Beispiel: Seien A={1,2,3}, B={2,3,7,9}. Dann ist: A∪B={1,2,3,7,9}, A∩B={2,3},

A\B= {1}, B\A = {7,9}. Die Mengen A∩B und B\A sind disjunkt.

Ist A ⊆ M, also A eine Teilmenge einer Obermenge M, so

AM

= M\A als

bezeichnet man die Menge

Komplementärmenge

Komplementärmenge (bzw. Komplement) von A (bzgl. M).

Beispiel: Sei M = {1,2,3,4,5,6}, A={2,4,6}. Dann ist AM = {1,3,5}. Offensichtlich

sind AM und A disjunkt und ihre Vereinigung ergibt M.

Mengenoperationen besitzen Eigenschaften. So zum Beispiel sind ∪ und ∩

kommutativ, aber \ nicht. Weiterhin kann man aus den Venn-Diagrammen

der Tabelle erkennen, dass gilt: (A∩B) ∪ (A\B) = A. Im folgenden Satz sind

einige wichtige Eigenschaften von Mengenoperationen aufgelistet:

Satz: (Eigenschaften von Mengenoperationen)

Es gilt:

1. A∪B=B∪A und A∩B=B∩A

2. (A∪B)∩C = (A∩C) ∪ (B∩C) und (A∩B)∪ C = (A∪C) ∩(B∪C)

3. (A∪B)∪ C = A ∪ (B∪ C) und (A∩B)∩ C = A ∩(B∩C)

Eigenschaften von

Mengenoperationen

-4–

Stochastik

4. A = (A∩B) ∪ (A\B)

5. Wenn A ⊆ B , so gilt A∩B=A und A∪B = B

6. Wenn A ⊆M und B ⊆M, so gilt:

_________

_________

( A ∪ B) M = AM ∩ BM und ( A ∩ B) M = AM ∪ BM (de Morgansche

Regeln)

Übungsaufgaben

1.1

Sei A = {1,2,3,4,5,6,7,8,9}, B={2,4,6}, C={2,4,6,20,40}.

Berechnen Sie A∩B, B\A, C\A, B ∪C, B A , ℘(B), |℘(B)|.

In welcher Relation stehen B und C zueinander?

Sind B A und C disjunkt oder nicht ?

1.2

Welches Bild gehört zu welcher Formel? Ordnen Sie zu!

a)A∩(B∩C), b)A∩(B∪C), c)A∪(B∩C)

d)A∪(B∪C), e)(A∩B)∪C, f)(A∪B)∩C

1.3

_________

Stellen Sie im folgenden Diagramm die Mengen ( A ∪ B ) M und

AM ∩ BM dar. Was stellen Sie fest?

1.4

Machen Sie sich analog zu 1.3 die Aussagen 2., 5. und 6. des

Satzes „Eigenschaften von Mengenrelationen“ klar, indem Sie die

Menge der linken Seite und diejenige der rechten Seite der

jeweiligen Gleichung im Venn-Diagramm darstellen und diese

Grafiken dann miteinander vergleichen.

Der Wahrscheinlichkeitsraum

1.1.2

-5-

Zufälliger Versuch und zufällige Ereignisse

Ein unter Beibehaltung eines festen Komplexes von Bedingungen beliebig oft

wiederholbarer Vorgang mit ungewissem Ausgang heißt zufälliger Versuch.

Wir bezeichnen ihn mit V. Die Menge Ω der möglichen Ergebnisse von V

wird als Grundmenge bzw. Ergebnismenge zu V bezeichnet. Die Elemente ω

von Ω stellen jeweils ein mögliches Ergebnis bei Durchführung von V dar. Als

Ereignisse zu V bezeichnet man Teilmengen von Ω. Für Ereignisse

verwenden wir Großbuchstaben A,B,C, .... . Die Aussage „Das Ereignis A ist

eingetreten“ bedeutet, dass irgendein Element von A als Ergebnis des

zufälligen Versuches beobachtet wurde.

zufälliger Versuch,

Grundmenge,

Ergebnisse,

Ereignisse

1. Beispiel:

Versuch : V = Werfen eines Spielwürfels

einige mögliche Ergebnisse: ω = 2 oder ω = 6

Grundmenge: Ω = {1,2,3,4,5,6}

einige mögliche Ereignisse:

„ungerade Augenzahl“ : A= {1,3,5}

“Augenzahl ist größer als 3“: B ={4,5,6}

„Augenzahl ist gleich 6“ : C={6}

2. Beispiel:

Versuch : V = Ermittlung der Wartezeit eines Kunden in der Post

einige mögliche Ergebnisse: ω = 10 Minuten oder ω = 15 Minuten

Grundmenge: Ω = {ω ∈ R| ω ≥ 0 } (enthält alle möglichen Wartezeiten)

einige mögliche Ereignisse:

„Wartezeit ist kleiner als 10 Minuten“ : A= {ω ∈ R| 0≤ ω < 10 }

„Wartezeit liegt zwischen 20 und 50 Minuten“: B = {ω ∈ R| 20 ≤ ω ≤ 50 }

„Wartezeit beträgt 15 Minuten“ : C={15}

Wir unterscheiden zwischen Elementarereignissen und zusammengesetzten

Ereignissen. Elementarereignisse sind „Einermengen“, die jeweils genau ein

Ergebnis des zufälligen Versuchs enthalten. Damit treten niemals zwei

Elementarereignisse gleichzeitig ein, sie sind disjunkt. In unseren Beispielen

stellt jeweils das Ereignis C ein Elementarereignis dar. Demgegenüber heißen

Ereignisse, die durch Vereinigung mehrerer Elementarereignisse entstehen,

zusammengesetzte Ereignisse.

Elementarereignis

Da Ereignisse durch Mengen dargestellt werden, können die Relationen und

Operatoren der Mengenlehre verwendet werden, um Relationen zwischen

und Verknüpfungen von Ereignissen darzustellen. Dabei bedeutet:

Verknüpfung von

Ereignissen

-6–

Stochastik

A⊆B

A=B

A∪B

A∩B

A\B

Mit dem Ereignis A tritt auch das Ereignis B ein (A zieht B nach

sich).

A zieht B nach sich und B zieht A nach sich.

A oder B oder beide Ereignisse treten ein.

(Summe von Ereignissen)

A und B treten ein. (Produkt von Ereignissen)

Das Ereignis A aber nicht das Ereignis B tritt ein.

Wir können die Summe und das Produkt von Ereignissen auf mehr als zwei

Ereignisse verallgemeinern.

A1 ∪ A2 ∪ ⋯ ∪ An Mindestens eines der Ereignisse Ai , i = 1,..., n ,tritt ein.

A1 ∩ A2 ∩ ⋯ ∩ An Alle Ereignisse Ai , i = 1,..., n ,treten gemeinsam ein.

Komplementärereignis,

sicheres Ereignis,

unmögliches

Ereignis

Das Ereignis A = Ω\A heißt Komplementärereignis oder Gegenereignis zu A

und bedeutet, dass A nicht eintritt. Zwei Ereignisse A und B heißen disjunkt,

wenn sie nicht gemeinsam eintreten, d.h., wenn gilt: A ∩ B = ∅. Ein

Ereignis, welches bei jeder Durchführung des Versuchs V eintritt, heißt

sicheres Ereignis und eines, welches nie eintritt unmögliches Ereignis.

Offensichtlich ist Ω ein sicheres und Ω =∅ ein unmögliches Ereignis.

Der in Abschnitt 1.1.1. angegebene Satz über Eigenschaften von

Mengenoperationen gilt genauso für die entsprechenden Verknüpfungen von

Ereignissen.

1.5

In einem Reaktionszeitversuch V seien folgende Ereignisse von

Interesse: A= „Die Reaktionszeit ist größer oder gleich 3

Sekunden“, B= „Die Reaktionszeit ist nicht größer als 5

Sekunden“, C= „Die Reaktionszeit ist größer als 7 Sekunden“, D=

„Die Reaktionszeit liegt zwischen 3 und 5 Sekunden

(einschließlich 3 und 5)“.

a) Stellen Sie A,B,C,D als Mengen dar!

b) In welcher Relation stehen A und C zueinander?

c) Stellen Sie D aus A und B unter Verwendung von

Mengenoperationen dar!

d) Welches Ereignis wird durch die Menge A\C

beschrieben? Geben Sie die Menge an!

e) Geben Sie alle Paare disjunkter Ereignisse an, die sich aus

A,B,C und D bilden lassen!

Der Wahrscheinlichkeitsraum

1.1.3

-7-

Das Ereignisfeld

Zu einem Versuch V können wir immer viele Ereignisse definieren. Alle

Ereignisse sind immer Teilmengen der Grundmenge Ω. Im folgenden fassen

wir die bei Durchführung von V praktisch relevanten Ereignisse in einer

Menge, dem sogenannten Ereignisfeld von V zusammen. Wir fordern dabei,

dass die Anwendung der Operationen ∪, ∩ und \ auf die Ereignisse des

Ereignisfeldes nicht aus diesem hinausführt, d.h., wir fordern, dass

Ereignisfeld alle Ereignisse enthält, die sich durch Anwendung der

Mengenoperationen ∪, ∩ und \ bilden lassen.

Definition: Sei V ein zufälliger Versuch mit der Grundmenge Ω. Ein

Ereignisfeld ℑ=ℑ(Ω) zu V über Ω ist eine Menge von Ereignissen A ⊆ Ω, die

folgende Eigenschaft besitzt:

1. ℑ enthält das unmögliche Ereignis ∅ und das sichere Ereignis Ω, also

∅∈ℑ und Ω∈ℑ.

2. Wenn A ∈ℑ und B∈ℑ, so ist auch A∪B ∈ℑ und A∩B ∈ ℑ.

3. Wenn A ∈ ℑ, so ist auch das Komplement A ∈ ℑ.

4. Mit abzählbar unendlich vielen Ereignissen Ai ∈ ℑ, i=1,2,..., sind auch

∞

∞

i =1

i =1

deren Summe ∪ Ai und deren Produkt ∩ Ai in ℑ enthalten.

Ereignisfelder zu einem zufälligen Versuch sind nicht eindeutig bestimmt.

Beispiel:

Sei V der zufällige Versuch „Würfeln mit einem Würfel“. Dann ist die

Grundmenge Ω={1,2,3,4,5,6}. Mögliche Ereignisfelder zu V sind:

1. ℑ = {∅, {2,4,6}, {1,3,5}, Ω}

2. ℑ = ℘ (Ω) = {A| A ⊆ Ω}.

1.6

Sei V der zufällige Versuch „Würfeln mit einem Würfel“.

a) Geben Sie mindestens zwei weitere Ereignisfelder zu V an!

b) Warum ist {∅, {2}, {4}, {1,3,5,6}, Ω} kein Ereignisfeld zu V?

c) Wie viele Ereignisse enthält das Ereignisfeld ℑ = ℘(Ω)?

Üblicherweise legt man in der Wahrscheinlichkeitsrechnung bei Versuchen V

mit endlichen Grundmengen Ω die Potenzmenge ℑ = ℘(Ω) als Ereignisfeld

zugrunde, da dieses Ereignisfeld alle möglichen zu V definierbaren

Ereignisse, insbesondere die Elementarereignisse, enthält. Bei Versuchen mit

reellen Grundmengen (Ω=R) wird in der Regel als Ereignisfeld nicht die

Potenzmenge von R, sondern eine etwas „kleinere“ Menge, nämlich die

Das Ereignisfeld

-8–

Stochastik

Menge der sogenannten Borel-Mengen zugrunde gelegt. Diese enthält alle

offenen, halboffenen und abgeschlossenen reellen Zahlen-Intervalle, sowie

deren Summen, Produkte und Komplemente. Auf eine ausführliche

Definition der Borel-Mengen sei hier verzichtet.

Vollständiges

Ereignissystem

Definition:

Sei V ein zufälliger Versuch mit der Grundmenge Ω und dem Ereignisfeld ℑ.

Eine Menge von Ereignissen A1 , A2 ,..., An , Ai ⊆ Ω für i=1,...,n, heißt

vollständiges Ereignissystem in ℑ, falls gilt:

a) Ai ∩ A j = ∅ für i≠j und b) A1 ∪ A2 ∪ ⋯ ∪ An = Ω .

Übungsaufgaben

1.7

Sei V der zufällige Versuch „Zweimaliger Münzwurf. Ein

Versuchsausgang sei durch das Paar ω=(M1, M2), Mi ∈{K,Z},

beschrieben Mi.: Ergebnis des i.ten Wurfes, i=1,2).

a) Geben Sie Ω an!

b) Geben Sie das Ereignisfeld ℑ = ℘(Ω) an!

c) Beschreiben Sie die Ereignisse A={(K,K),(Z,K)},

B={(K,K),(Z,Z)}, C={(K,K), (Z,K), (K,Z)} in Worten!

d) Geben Sie mindestens 2 vollständige Ereignissysteme in

ℑ=℘(Ω) an!

1.8

1.1.4

Relative Häufigkeit

Ein Ereignisfeld ℑ zu einem Versuch V enthalte die Ereignisse A

und B. Zeigen Sie, dass die Ereignisse A∪B, A ∩B, A ∩ B ,

A ∩ B ein vollständiges System von Ereignissen in ℑ bilden!

Relative Häufigkeit von Ereignissen und Definition der

Wahrscheinlichkeit

Will man wissen, wie groß die Chance des Eintretens eines Ereignisses A∈ℑ

bei Durchführung eines Versuches V ist, so könnte man den Versuch n mal

durchführen und dabei beobachten, wie oft A eingetreten ist, d.h., die relative

Häufigkeit hn(A) von A ermitteln. Die relative Häufigkeit hn(A) ist der Anteil

der Versuche an den n Versuchswiederholungen, in denen A eintritt. Tritt A

beispielsweise bei 50 Versuchen 10 mal ein, so ist hn(A)=10/50 = 1/5. Welcher

Der Wahrscheinlichkeitsraum

-9-

Wert sich für hn(A) in einer konkreten Versuchsreihe ergibt, ist vom Zufall

abhängig, d.h., kann nicht mit Bestimmtheit vorhergesagt werden. Dennoch

besitzt die relative Häufigkeit allgemeingültige Eigenschaften, z.B. :

1. 0 ≤ hn(A),

2. hn(Ω)=1,

3. Wenn A∩B=∅, so ist hn(A∪B)= hn(A)+hn(B).

Da die relative Häufigkeit vom Zufall abhängt und außerdem mit der Anzahl

n der Versuche stark schwankt, ist sie kein ideales Maß für die

Quantifizierung der Chance des Eintretens von A. Wir kommen deshalb zu

einem allgemeineren Begriff, dem der sogenannten Wahrscheinlichkeit P(A)

eines Ereignisses A. P(A) ist ein idealisiertes nicht vom Zufall abhängendes

Modell der relativen Häufigkeit. Damit die Wahrscheinlichkeit P(A) ein gutes

Modell für die relative Häufigkeit hn(A) sein kann, muss sie die o.g. 3

grundlegenden Eigenschaften der relativen Häufigkeit erfüllen. Für eine

mathematische Definition bilden sie 3 von 4 Axiomen, die vom russischen

Mathematiker Kolmogorov 1933 festgelegt wurden und aus denen sich die

ganze Wahrscheinlichkeitstheorie herleiten lässt.

Definition: (Axiomatische Definition der Wahrscheinlichkeit)

Sei V ein zufälliger Versuch mit der Grundmenge Ω und dem Ereignisfeld

ℑ=ℑ (Ω). Dann heißt jede Abbildung P: ℑ → [0,1] Wahrscheinlichkeitsmaß

auf ℑ, falls für alle Ereignisse A, B, Ai (i=1,2,...) aus dem Ereignisfeld ℑ

folgende Eigenschaften (Axiome) erfüllt sind:

1. 0 ≤ P(A),

2. P(Ω)=1,

3. Wenn A∩B= ∅, so ist P(A∪B)=P(A)+P(B),

4.

∞

∞

P(∪ Ai ) = ∑ P( Ai ) , falls Ai ∩ A j = ∅ für i≠j.

i =1

i =1

P(A) wird als Wahrscheinlichkeit (Chance) des Eintretens von A bei

einmaliger Durchführung des Versuchs V bezeichnet.

Wenn man den Versuchsumfang n einer Versuchsreihe sehr groß macht (im

Idealfall gegen ∞ gehen lässt), so wird man feststellen, dass sich die relative

Häufigkeit hn(A) stets auf ein und denselben festen Wert, und zwar P(A),

einpegelt. Diese Eigenschaft bezeichnet man als Stabilität der relativen

Häufigkeit. Demzufolge kann man die Wahrscheinlichkeit P(A) auch als

Vorhersagewert für die relative Häufigkeit betrachten, mit der das Ereignis A

in einer langen Reihe von Wiederholungen des Versuchs V eintritt. So ist P(A)

= 0,5 die Wahrscheinlichkeit dafür, beim Münzwurf Kopf zu werfen,

Axiomatische

Definition der

Wahrscheinlichkeit

- 10 –

Stochastik

gleichzeitig bedeutet dieser Wert aber auch, dass bei n maligem Münzwurf

(n groß) in ungefähr 50 Prozent aller Würfe Kopf geworfen wird. Umgekehrt

liefert eine beobachtete relative Häufigkeit einen Schätzwert für die

Wahrscheinlichkeit des betrachteten Ereignisses. Je größer dabei n ist, desto

genauer ist dieser Schätzwert für P(A).

Aus den o.g. 4 Axiomen folgen eine Reihe weiterer Eigenschaften der

Wahrscheinlichkeit P. Einige davon fassen wir in folgendem Satz zusammen:

Eigenschaften der

Wahrscheinlichkeit

Satz: (Eigenschaften der Wahrscheinlichkeit)

Sei V ein zufälliger Versuch mit der Grundmenge Ω und dem Ereignisfeld

ℑ=ℑ (Ω). Dann besitzt ein Wahrscheinlichkeitsmaß P auf ℑ für alle Ereignisse

A, B, Ai (i=1,2,...) aus dem Ereignisfeld ℑ folgende Eigenschaften:

1. 0 ≤ P(A) ≤ 1,

2. P(∅)=0, P(Ω)=1,

3. P( A ) = 1-P(A),

4.

n

n

P(∪ Ai ) = ∑ P( Ai ) , für alle n∈N, falls Ai ∩ A j = ∅ für i≠j,

i =1

i =1

5. P(A∪B) = P(A)+P(B)-P(A∩B)

6. Wenn A⊆B, so ist P(A) ≤ P(B)

Beweis: Stellvertretend beweisen wir die Aussage 3. des Satzes. Es gilt:

Ω = A∪ A und es ist A∩ A =∅. In Anwendung der Axiome 2 und 3 der

Wahrscheinlichkeitsdefinition erhalten wir:

1=P(Ω) = P(A∪ A ) = P(A)+P( A )

Stellen wir diese Gleichung nach P( A ) um, so erhalten wir die Behauptung 3.

des Satzes.

q.e.d

1.9

Zeigen Sie, dass für zwei beliebige Ereignisse A und B eines

Ereignisfeldes gilt: P(A∪B) = P(A)+P(B)-P(A∩B).

Beispiel: Die Hochbegabung von Kindern einer bestimmten Altersstufe wird

mit zwei Testverfahren ermittelt. Bestehen die Kinder beide Tests, so werden

sie als hochbegabt eingestuft. Es sei bekannt, dass 2 % der Kinder der

betrachteten Altersstufe Test 1 (T1) besteht. Die Wahrscheinlichkeit, dass ein

Kind den zweiten Test (T2) besteht, ist 0,03. Insgesamt bestehen 96% weder

den ersten noch den zweiten Test. Mit welcher Wahrscheinlichkeit wird ein

Kind als hochbegabt eingestuft?

Lösung: Es gilt: P(T1)=0,02, P(T2)=0,03 und P( T1 ∩ T2 ) =0,96. Gesucht ist

P(T1∩T2). Aus den Eigenschaften von P folgt:

P(T1∩T2) = P(T1)+P(T2)-P(T1∪T2).

Der Wahrscheinlichkeitsraum

Da

T1∪T2

das

Komplement

- 11 -

von

T1 ∩ T2

ist,

gilt

weiterhin

P(T1∪T2)=1-P( T1 ∩ T2 ) = 0,04.

Daraus folgt für die gesuchte Wahrscheinlichkeit

P(T1∩T2) = P(T1)+P(T2)-P(T1∪T2) = 0,02+0,03-0,04 = 0,01.

Das heißt, dass 1 Prozent der Kinder der betreffenden Altersklasse als

hochbegabt eingestuft werden.

Übungsaufgaben

1.10

In deutschsprachlichen E-Mails tritt häufig das Wort „Viagra“

oder das Wort „Rolex“ auf. Mit mindestens einem dieser beiden

Worte sind 2,5 % aller E-Mails behaftet. Eine E-Mail wird nur

dann nicht als spamverdächtig klassifiziert, wenn sie keines der

beiden Worte enthält. Mit welcher Wahrscheinlichkeit wird eine

E-Mail nicht als spamverdächtig eingestuft?

1.11

Bei der Herstellung eines Produktes treten 2 Fehler F1= „nicht ´

maßhaltig“

und

F2=„nicht

funktionsfähig“

mit

den

Wahrscheinlichkeiten P(F1)=0,015 und P(F2)=0,01 ein. Mit beiden

Fehlern behaftet sind insgesamt 0,5 % aller Produkte. Ein Produkt

ist nur dann verkäuflich, wenn es keinen der beiden Fehler

besitzt. Mit welcher Wahrscheinlichkeit ist ein Produkt

verkäuflich?

1.2

Der klassische Wahrscheinlichkeitsbegriff

Bereits im 17. Jahrhundert interessierte man sich für die Berechnung von

Gewinn-Wahrscheinlichkeiten in Glücksspielen.

Charakteristisch für

Glücksspiele ist es, dass ihnen zufällige Versuche zugrunde liegen, bei denen

es nur endlich viele gleichwahrscheinliche Versuchsausgänge gibt. Diese

Versuche bezeichnet man als Laplace-Versuche. Die Wahrscheinlichkeit in

Laplace-Versuchen wird als klassische Wahrscheinlichkeit bezeichnet. Sie ist

gleich dem Quotienten aus der Anzahl der für dieses Ereignis günstigen

Versuchsausgänge und der Gesamtzahl der möglichen Versuchsausgänge, Im

folgenden werden wir sehen, dass sich diese Formel als Spezialfall aus den 4

Axiomen der Wahrscheinlichkeit ergibt.

- 12 –

Stochastik

Laplace-Versuch

Definition: Sei V ein zufälliger Versuch mit der endlichen Grundmenge

Ω = {ω1 ,..., ω m }. Ist P( ω i ) = p für alle i=1,...,m, so heißt V Laplace-Versuch.

Klassische

Wahrscheinlichkeit

Satz: (Klassische Wahrscheinlichkeit in Laplace-Versuchen)

Sei V ein Laplace-Versuch mit der Grundmenge Ω = {ω1 ,..., ω m }. Dann gilt

1

und

m

| A|

2. P(A)=

für jedes Ereignis A∈ℑ = ℘ (Ω).

|Ω|

1. P({ ω i }) =

Beweis zu 1. Es ist P( Ω) = P ({ω1 } ∪ ... ∪ {ω m }) =

Daraus folgt die Behauptung p=P({ ω i }) =

1.12

m

m

∑ P({ω }) = ∑ p = mp.

i =1

i

i =1

1

.

m

Beweisen Sie die Behauptung 2. des Satzes!

Die Berechnung der klassischen Wahrscheinlichkeit läuft auf die Ermittlung

der Anzahl von Elementen einer Menge hinaus. Dazu benötigen wir im

wesentlichen zwei kombinatorische Formeln.

Kombinatorische

Formeln

Satz: (Kombinatorische Formeln)

1.) Es gibt genau n! Vertauschungen von n Elementen.

2.) Es

gibt

genau

n

n!

=

. k-elementige Teilmengen einer

k k!(n − k )!

n-elementigen Menge.

Mit diesen beiden Formeln kann man nahezu beliebige Aufgaben zur

klassischen Wahrscheinlichkeit lösen.

Beispiel: Wie groß ist die Wahrscheinlichkeit dafür, beim Würfeln mit 5

Würfeln (Kniffel) genau 2 mal die Augenzahl 4 und des weiteren die Zahlen

1,2,3 gewürfelt werden?

Lösung: Wir überlegen uns zunächst, wie die Elementarereignisse aussehen.

Einen Versuchsausgang kann man offensichtlich durch ein 5 – Tupel

(i1,i2,i3,i4,i5) mit ij∈{1,2,3,4,5,6} beschreiben, ij ist die Augenzahl des j-ten

Würfels. Ω ist die Anzahl aller 5-Tupel. Da jeder Würfel 6 Möglichkeiten

besitzt und alle 5-Tupel durch eine Kombination der 6 Möglichkeiten aller 5

5

Würfel entstehen, gilt: |Ω|= 6 ⋅ 6 ⋅ 6 ⋅ 6 ⋅ 6 =6 . Das Ereignis A ist die Menge

aller 5-Tupel, in denen 2 mal eine 4 und die Zahlen 1, 2, 3 vorkommen.

Der Wahrscheinlichkeitsraum

- 13 -

Würden wir alle diese 5 Tupel auflisten wollen, müssten wir aus den 5

Würfeln immer 2 auswählen, denen wir die 4 zuordnen, der Rest bekommt

5

5!

= 10 Möglichkeiten, 2 Würfel aus

die Zahlen 1,2,3. Es gibt genau =

2 2!3!

fünfen auszuwählen. Haben wir zwei Würfel festgelegt, so ordnen wir den

restlichen 3 Würfeln die Zahlen 1,2,3 zu. Dafür gibt es genau 3!

Möglichkeiten. Folglich ist

P(A)=

5

5!

| A |= 3!= = 60 und es ergibt sich

2!

2

| A | 60 10

=

=

≈ 0,008 . Die Chance, 2 mal eine 4 und die Zahlen 1,2,3

| Ω | 65 64

zu würfeln, beträgt 8 zu 1000.

Übungsaufgaben

1.13

Ein 5-stelliger Zahlencode, bestehend aus den Ziffern 1 bis 6, wird

zufällig durch Würfeln mit 5 gleichmäßigen Würfeln bestimmt.

Wie groß ist die Wahrscheinlichkeit dafür,

a) die Zahlen 1,2,3,4,5 zu würfeln?

b) 2 mal die 4 und 3 mal die 6 zu würfeln?

c) 5 verschiedene Zahlen zu würfeln?

1.14

Wie groß ist die Wahrscheinlichkeit dafür, beim 3maligen

Würfeln mit einem gleichmäßigen Würfel mindestens 2 mal eine 6

zu würfeln?

1.3

Bedingte Wahrscheinlichkeit und stochastische Unabhängigkeit

von Ereignissen

Ein Zufallsexperiment sei durch die Grundmenge Ω beschrieben. Ein Ereignis

A ⊆ Ω hat dann die Wahrscheinlichkeit P(A). Wie ändert sich diese

Wahrscheinlichkeit, wenn wir die Zusatzinformation erhalten, dass im

Experiment das Ereignis B eingetreten ist? Beim Würfeln mit einem Würfel

ist die Wahrscheinlichkeit eine 6 zu würfeln gleich 1/6. Erhalten wir aber die

Zusatzinformation, dass eine gerade Zahl gewürfelt wurde, so ist die

Wahrscheinlichkeit für eine 6 gleich 1/3.

Wir gehen bei unseren

- 14 –

Stochastik

Überlegungen von Ω zu einem kleineren Grundraum B über und berechnen

in diesem Grundraum die Wahrscheinlichkeit für A∩B.

Bedingte

Wahrscheinlichkeit

Definition: Sei V ein zufälliger Versuch mit der Grundmenge Ω und dem

Ereignisfeld ℑ. Seien A∈ℑ und B∈ℑ zwei beliebige Ereignisse zu V mit

P(B)>0. Dann heißt

P(A|B) =

P( A ∩ B )

P( B)

bedingte Wahrscheinlichkeit von A unter der Bedingung B.

Speziell ist P(B|B) = 1, denn aufgrund der Information ist das Eintreten von B

sicher. Die bedingte Wahrscheinlichkeit P(⋅|B) ist bei festgehaltener

Bedingung B ein Wahrscheinlichkeitsmaß auf ℑ, d.h. P(⋅|B) erfüllt alle

Axiome und Eigenschaften der Wahrscheinlichkeit, die in Abschnitt 1.1.4

dargestellt wurden. Insbesondere gilt dann auch P ( A | B ) = 1 − P ( A | B ) .

Man beachte aber, dass im allgemeinen P ( A | B ) ≠ 1 − P ( A | B ) ist.

Multiplikationssatz

1.15

Zeigen Sie anhand der Definitionsgleichung der bedingten

Wahrscheinlichkeit, dass P ( A | B ) = 1 − P ( A | B ) gilt!

Multiplizieren wir in der Definitionsgleichung für die bedingte

Wahrscheinlichkeit beide Seiten mit P(B), so erhalten wir die sogenannte

Multiplikationsformel:

P( A ∩ B) = P( A | B) ⋅ P( B)

Oftmals sind die Wahrscheinlichkeiten P(A|B) und P(B) gegeben oder leicht

zu ermitteln und die Multiplikationsformel wird dann angewendet, um die

Die MultiplikaProduktwahrscheinlichkeit

P ( A ∩ B ) zu ermitteln.

tionsformel lässt sich auf beliebig viele Ereignisse verallgemeinern:

Satz: (Multiplikationssatz)

Sei V ein zufälliger Versuch mit der Grundmenge Ω und dem Ereignisfeld

ℑ=ℑ(Ω). Seien Ai∈ℑ , i=1,...,n , n beliebige Ereignisse. Dann gilt:

P( A1 ∩ A2 ∩ ⋯ ∩ An )

= P ( A1 ) P( A2 | A1 ) P( A3 | A1 ∩ A2 ) ⋅ ⋯ ⋅ P( An | A1 ∩ ⋯ ∩ An −1 )

Beispiel: Aus einem gut gemischten Kartenspiel sollen 3 Spieler nacheinander

eine Karte ziehen. Mit welcher Wahrscheinlichkeit zieht jeder Spieler eine

Pik-Karte (Ereignis A)?

Der Wahrscheinlichkeitsraum

- 15 -

Lösung: Unter den 32 Karten sind 8 Pik-Karten. Die Wahrscheinlichkeit, dass

der erste Spieler eine Pik-Karte zieht ist P(A1)=8/32=1/4. Nachdem der erste

Spieler eine Pik-Karte gezogen hat, sind nur noch 31 Karten und davon 7 PikKarten im Spiel. Somit ist die Wahrscheinlichkeit dafür, dass der zweite

Spieler eine Pik-Karte zieht P(A2|A1) = 7/31. Analog erhalten wir dann

P(A3|A1∩A2)=6/30

und

somit:

P(A) = P(A1∩A2∩A3)=

8 7 6

7

⋅ ⋅

=

.

32 31 30 620

Verändert die Information über das Eintreten von B die Chancen für A nicht,

d.h. gilt P(A|B)=P(A), so heißen A und B stochastisch unabhängig.

Unabhängige

Ereignisse

Für 2 unabhängige Ereignisse gilt die Produktformel:

Produktformel für 2

unabhängige

Ereignisse

P ( A ∩ B ) = P ( A) ⋅ P ( B )

Beispiel: Sind die beiden Ereignisse A = „Würfeln einer geraden Zahl“ und

B= „Würfeln einer Zahl ≥ 4“ stochastisch unabhängig?

Lösung: Es gilt P(A)=1/2 und P(B|A)=2/3. Damit sind P(A)≠P(B|A) und

folglich sind A und B nicht stochastisch unabhängig. Das gleiche Ergebnis

erhalten wir, wenn wir die Produktformel untersuchen: Es ist P(A)=1/2,

P(B)=1/2 und P(A∩B)=2/6. Folglich ist P(A∩B)≠P(A)P(B), woraus folgt, dass

A und B nicht stochastisch unabhängig sind.

1.16 Zeigen Sie dass aus P ( A ∩ B ) = P ( A) ⋅ P ( B ) folgt, dass auch die

Beziehungen P ( A ∩ B ) = P ( A ) ⋅ P ( B ) ,

P( A ∩ B ) = P ( A) ⋅ P( B )

und P ( A ∩ B ) = P ( A ) ⋅ P ( B ) gelten!

(D.h., aus der stochastischen Unabhängigkeit von A und B folgt

die stochastische Unabhängigkeit von A , B sowie A, B , sowie

A , B ).

Die Definition der Unabhängigkeit von n beliebigen Ereignissen sieht etwas

komplizierter aus. Die inhaltliche Bedeutung ist analog zum Fall zweier

Ereignisse: das Eintreten jeweils eines Teils der Ereignisse beeinflusst die

Chancen des Eintretens des anderen Teils nicht. Für die Berechnungen ist die

Verallgemeinerung der Produktformel wichtig:

Sind Ereignisse A1 , A2 , ⋯ , An stochastisch unabhängig, so gilt für jede

beliebige Teilauswahl A1* , A2* , ⋯ , Ak * von k Ereignissen aus diesen n:

P ( A1* ∩ A2* ∩ ⋯ ∩ Ak * ) = P( A1* ) P ( A2* ) ⋅ ⋯ ⋅ P( Ak * )

Allgemeine

Produktformel für n

unabhängige

Ereignisse

- 16 –

Stochastik

Beispiel: Die Wahrscheinlichkeit, dass ein Beobachter in einem gewissen

Zeitraum ein Signal auf einem Bildschirm übersieht, sei 0,2 und bei allen

Beobachtern gleich. Wie viele unabhängig voneinander arbeitende

Beobachter benötigt man, wenn insgesamt die Wahrscheinlichkeit dass ein

Signal übersehen wird (Ereignis A), nicht größer als 0,01 sein soll?

Lösung: Sei Ai das Ereignis „Das Signal wird von Beobachter i übersehen“.

Dann gilt P(Ai)=0,2. Da die Beobachter unabhängig voneinander arbeiten,

gilt:

n

P(A)= P ( A1 ∩ A2 ∩ ⋯ ∩ An ) = P( A1 ) P( A2 ) P( A3 ) ⋅ ⋯ ⋅ P( An ) =(0,2) .

0,2 n ≤ 0,01 . Daraus folgt durch

Logarithmieren : log(0,2 n ) = n log(0,2) ≤ log(0,01) . Bei der Auflösung der

Gleichung nach n muss man durch den negativen Wert log(0,2) dividieren;

dadurch kehrt sich das Relationszeichen um. Wir erhalten:

log(0,01)

n≥

= 2,86 . Das heißt, dass mindestens 3 Beobachter nötig sind.

log(0,2)

Die

geforderte

Bedingung

war:

Übungsaufgaben

1.17

Aus 11 Buchstaben „m“, „i“, „i“, „i“, „i“, „s“, „s“, „s“, „s“, „p“, „p“

wird zufällig der Reihe nach jeweils einer ausgewählt und zu einem

Wort angelegt. Berechnen Sie unter Verwendung des

Multiplikationssatzes die Wahrscheinlichkeit dafür, dass das Wort

„mississippi“ entsteht!

1.18

Zwei Studenten bearbeiten unabhängig voneinander die gleiche

Übungsaufgabe. Jeder der beiden findet die richtige Lösung mit der

Wahrscheinlichkeit 0,6. Wie groß ist die Wahrscheinlichkeit dafür,

dass mindestens einer der beiden die Aufgabe richtig löst?

1.19

Ein System besteht aus 4 Elementen, die wie folgt angeordnet sind:

Das System verhält sich wie bei

Reihen- und Parallelschaltungen. Es

funktioniert, wenn mindestens eine

Reihe funktioniert. Eine Reihe

funktioniert, wenn alle Elemente der

Reihe funktionieren.

Jedes Element arbeitet unabhängig von den anderen mit der

gleichen

Wahrscheinlichkeit

p=0,9, d.h. fällt mit der

Der Wahrscheinlichkeitsraum

- 17 -

Wahrscheinlichkeit 0,1 unabhängig von den anderen Elementen aus.

a) Wie groß ist die Wahrscheinlichkeit dafür, dass das System S

funktioniert?

b) Wie groß ist die Wahrscheinlichkeit dafür, dass Element 3

funktioniert unter der Bedingung, dass das System S

funktioniert ?

c)

1.4

Sind die Ereignisse „Das System S funktioniert“ und „Das

Element 3 funktioniert“ stochastisch unabhängig?

Totale Wahrscheinlichkeit und Bayes’sche Formel

Oft liegen Wahrscheinlichkeiten für ein vollständiges System von Ereignissen

A1, A2,..., An vor, sowie die Wahrscheinlichkeiten P(B/Ai) für das Eintreten

eines weiteren Ereignisses B unter der Bedingung Ai und es ist P(B) und/oder

P(Ai/B) gesucht.

Sind A1, A2,..., An ein vollständiges System von Ereignissen, so gilt:

B = ( A1 ∩ B) ∪ ( A2 ∩ B) ∪ ⋯ ∪ ( An ∩ B) , wobei alle Ereignisse ( Ai ∩ B) und

( A j ∩ B ) paarweise

für

i≠j

disjunkt

sind.

Nach

Axiom

n

3

Formel der Totalen

Wahrscheinlichkeit

der

n

Wahrscheinlichkeit erhalten wir dann P(B) = P (∪( Ai ∩ B )) = ∑ P ( Ai ∩ B )

i =1

i =1

und aus dem Multiplikationssatz für 2 Ereignisse folgt daraus

n

P(B) = ∑ P ( Ai ) P( B / A i ) .

i =1

Diese Formel wird als Formel der totalen Wahrscheinlichkeit bezeichnet.

Der Engländers Thomas Bayes entwickelte im Jahre 1764 eine Formel für die

Wahrscheinlichkeit des Eintreten von Aj unter der Voraussetzung, dass B

eingetreten ist und unternahm damit als erster den Versuch, für statistische

Schlüsse logische Grundlagen anzugeben.

Satz: (Formel von Bayes)

Sind A1, A2,..., An ein vollständiges System von Ereignissen und B ein

weiteres Ereignis, so gilt:

Satz von Bayes

- 18 –

Stochastik

P ( A j | B) =

P ( A j ∩ B)

P( B )

=

P( A j ) P( B / A j )

n

.

∑ P ( A ) P( B / A )

i =1

i

i

Eine besondere Bedeutung dieser Formel liegt in folgender Überlegung:

Angenommen, eine direkte Beobachtung der Ereignisse A1,...,An ist nicht

möglich und man hat auf irgendeine Weise aber eine Anfangs-Information

über deren Wahrscheinlichkeiten P(A1),..,P(An) erhalten. Diese werden als apriori-Wahrscheinlichkeiten bezeichnet. Beobachtet man nun bei Durchführung

des zufälligen Versuchs das Ereignis B, so ist man bestrebt, diese Information

zur verbesserten Entscheidungsfindung darüber zu verwenden, welches der

Ereignisse A1,...,An eingetreten ist. In diesem Zusammenhang pflegt man die

Wahrscheinlichkeiten P(A1/B), ..., P(An/B) als a-posteriori-Wahrscheinlichkeiten

zu bezeichnen. Eine andere Anendung dieser Formel besteht darin, die

Trennschärfe eines beobachteten Ereignisses B für die Entscheidung, dass ein

Ereignis Ai eingetreten ist, zu beurteilen. Entscheidet man sich bei Auftreten

von B für das Ereignis Ai, so wird P(Aj/B) für i≠j als Irrtumswahrscheinlichkeit bei dieser Entscheidung interpretiert.

Beispiel: Ein Übertragungssystem sendet und empfängt die Zeichen 0 und 1

(Ereignisse S0 und S1). In 80 % aller Fälle wird eine 0 in 20 % aller Fälle eine 1

gesendet. Die Übertragung ist fehlerbehaftet. Die Wahrscheinlichkeit dafür,

dass eine 1 empfangen wird (Ereignis E1), unter der Bedingung, dass eine 0

gesendet wurde, beträgt 0,01. Die Wahrscheinlichkeit dafür, dass eine 0

empfangen wurde (E0) unter der Bedingung, dass eine 1 gesendet wurde, ist

0,02. Wir stellen uns nun auf den Standpunkt, dass wir nur die empfangenen

Zeichen beobachten können. Es werden nur die Zeichen 0 und 1 empfangen.

a) In wieviel % aller Fälle wird eine 1 empfangen und b) wie groß ist die

Wahrscheinlichkeit dafür, dass tatsächlich auch eine 1 gesendet wurde, wenn

eine 1 empfangen wurde?

Lösung: Offensichtlich bilden S0 und S1 ein vollständiges Ereignissystem.

Gegeben sind folgende Wahrscheinlichkeiten: P(S0)=0,8, P(S1)=0,2,

P(E1/S0)=0,01 und P(E0/S1)=0,02. Gesucht sind a) P(E1) und b) P(S1/E1).

Gemäß der Formel der totalen Wahrscheinlichkeit gilt:

P ( E1) = P( S 0) P ( E1 | S 0) + P( S1) P( E1 | S1) .

Da nur die Zeichen 0 und 1 empfangen werden,

P ( E1 | S1) = 1 − P ( E 0 | S1) = 1 − 0,02 = 0,98 und wir erhalten für a)

P ( E1) = 0,8 ⋅ 0,01 + 0,2 ⋅ 0,98 = 0,204

ist

Der Wahrscheinlichkeitsraum

Wir sehen, dass die Wahrscheinlichkeit dafür, eine 1 zu empfangen sich als

bewichtetes Mittel der Wahrscheinlichkeiten ergibt, eine 1 zu empfangen,

wenn tatsächlich eine 1 gesendet wurde und eine 1 zu empfangen, wenn

keine 1 gesendet wurde. Aufgrund des Übertragungsfehlers empfangen wir

etwas mehr Einsen als gesendet wurden. Für die Wahrscheinlichkeit b) ergibt

sich nach der Bayes’schen Formel:

P ( S1 | E1) =

P ( S1) P( E1 / S1) 0,2 ⋅ 0,98

=

≈ 0,96 .

P( E1)

0,204

Übungsaufgaben

1.20

Wir wollen die Zuverlässigkeit eines SPAM-Filters untersuchen,

dabei nehmen wir an, dass wir genau wissen, was eine SPAM ist!.

Unser SPAM-Filter arbeitet wie folgt: Es werden alle Texte als

SPAM eingestuft, in denen das Wort „Viagra“ vorkommt. In

jedem anderen Fall werden die Texte als O.K. eingestuft. Es soll

die Zuverlässigkeit dieses SPAM-Filters, d.h., die Trennschärfe

des Wortes „Viagra“ untersucht werden. Aus Untersuchungen

von Texten sei bekannt, dass 20 % aller Texte SPAM’s sind. Es

sei weiterhin bekannt, dass in 90% aller Texte, die tatsächlich

SPAM’s sind, das Wort „Viagra“ vorkommt, aber leider auch in

1% aller Texte, die keine SPAM’s sind.

a) Wie groß ist die Wahrscheinlichkeit dafür, dass ein Text,

der als SPAM eingestuft wurde auch wirklich ein SPAM

ist?

b) Wie groß ist die Wahrscheinlichkeit dafür, dass ein nicht

als SPAM eingestufter Text ein SPAM ist?

1.21

Eine Firma bezieht jeweils 30 %, 20% bzw. 50% von benötigten

Teilen von 3 verschiedenen Zulieferern Z1, Z2 bzw. Z3. Über die

Ausschussrate (Anteil der defekten Teile unter den gelieferten) sei

bekannt, dass sie bei Z1 1%, bei Z2 und Z3 2% bzw. 0,5 % beträgt.

a) Wie viel % Ausschuss (Ereignis A) erhält die Firma

insgesamt?

b) Mit welcher Wahrscheinlichkeit stammt ein defektes Teil

von Z1?

- 19 -

- 20 –

Stochastik

2

Zufallsgrößen

In diesem Kapitel wird der Begriff der Wahrscheinlichkeit auf Zufallsgrößen

erweitert. Es wird der Begriff Zufallsgröße eingeführt und es wird erläutert,

wie Wahrscheinlichkeitsverteilungen von Zufallsgrößen

mathematisch

beschrieben werden. Wir unterscheiden dabei zwischen diskreten und

stetigen Zufallsgrößen, die sich hinsichtlich der Modellierung ihrer

Verteilungen grundsätzlich unterscheiden.

Nach Durcharbeiten dieses Kapitels können Sie

•

•

•

•

•

2.1

diskrete und stetige Zufallsgrößen voneinander unterscheiden,

auf der Basis einer gegebenen Wahrscheinlichkeitsverteilung Wahrscheinlichkeiten für eine diskrete Zufallsgöße berechnen,

auf

der

Basis

einer

gegebenen

Verteilungsdichte

oder

Verteilungsfunktion Wahrscheinlichkeiten einer stetigen Zufallsgröße

berechnen,

spezielle diskrete Verteilungen (Gleichverteilung, Binomialverteilung

und Poissonverteilung) und spezielle stetige Verteilungen (stetige

Gleichverteilung,

die

Exponentialverteilung

und

die

Normalverteilung) voneinander unterscheiden und typischen

Anwendungsfällen

zuordnen,

sowie

auf

ihrer

Basis

Wahrscheinlichkeiten für praktische Anwendungen berechnen,

typische Parameter von Verteilungen von Zufallsgrößen, wie

Erwartungswert, Varianz und Quantile berechnen und interpretieren.

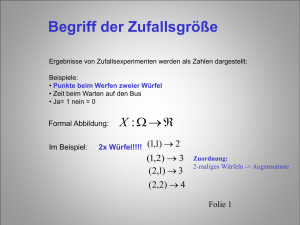

Begriff der Zufallsgröße

Es gibt viele praktische Anwendungsfälle, in denen nicht die elementaren

Versuchsausgänge ω, sondern aus diesen abgeleitete reelle Größen X(ω), die

sogenannten Zufallsgrößen, interessieren. Zufallsgrößen kann man auch als

Abbildungen von Ω in die Menge der reellen Zahlen auffassen: X:

ω∈Ω→X(ω)∈R. Bei der zufälligen Auswahl einer Person könnte z.B. ω der

Name der Person und X(ω) ihr Einkommen oder ihr Alter sein. In der

Qualitätskontrolle könnte X(ω) die Anzahl der defekten Teile in einem Los

bestehend aus n Teilen sein. ω ist dann ein n-Tupel, bestehend aus den

Zahlen 0 (Teil ist OK) und 1 (Teil ist defekt), X(ω) wäre gleich der Summe der

Elemente von ω. Andere Beispiele sind die zufällige Anzahl der Kunden in

Zufallsgrößen

einem Postamt, die zufällige Anzahl der defekten Sektoren auf einer

Festplatte, die zufällige Zeit, die zwischen dem Eintreffen zweier Nachrichten

vergeht, die zufällige durchschnittliche Temperatur und Niederschlagsmenge

in einem bestimmten Monat an einem bestimmten Ort, das alles sind

Zufallsgrößen.

In allen diesen Fällen interessiert uns nicht, mit welcher Wahrscheinlichkeit

P(A) ein Ereignis A⊆Ω eintreten wird, sondern uns interessiert, mit welcher

Wahrscheinlichkeit X Werte in einer Menge B⊆R annimmt, also PX (B). Fassen

wir Ereignisse B⊆R zu einem Ereignisfeld E zusammen und fordern wir, dass

für

jedes

Ereignis

B∈E

das

zugehörige

−1

Urbildereignis X ( B ) = {ω ∈ Ω | X (ω ) ∈ B} =AB in dem Ereignisfeld ℑ(Ω)

von Ω liegt und dass P ein Wahrscheinlichkeitsmaß auf ℑ(Ω) ist, so kann man

die Wahrscheinlichkeit eines beliebigen Ereignisses B∈E auf „natürliche“

Weise“ bestimmen zu:

PX ( B) = P({ω ∈ Ω | X (ω ) ∈ B}) =P(AB)

D.h., durch eine Zufallsgröße X wird der Wahrscheinlichkeitsraum

[Ω,ℑ (Ω),P] in den Wahrscheinlichkeitsraum [X,E,PX] transformiert, wobei

X⊆R der Wertebereich von X ist. PX besitzt wegen dieser Transformation alle

Eigenschaften eines Wahrscheinlichkeitsmaßes (auf E).

Für Zufallsgrößen verwenden wir im folgenden große lateinische Buchstaben

X,Y,T,Z,..., für ihre Wertebereiche die zugehörigen Buchstaben in

Frakturschrift

X, Y, T, Z,... ,

und für die Realisierungen

(konkreten Beobachtungen) der Zufallsgrößen kleine lateinische Buchstaben

x,y,z,t,... .

Wir verwenden folgende Schreibweise für Ereignisse: X∈B (statt B) und

schreiben: X=x , falls B={x}; X ≤ b, falls B={x∈X|x≤b}; a<X<b, falls B={

x∈X|a<x<b} usw. . Für die Wahrscheinlichkeit PX schreiben wir im folgenden

der Einfachheit halber nur P.

- 21 -

- 22 –

Stochastik

2.2

2.2.1

Diskrete Zufallsgrößen

Diskrete Zufallsgröße und ihre Wahrscheinlichkeitsverteilung

Eine Zufallsgröße X heißt diskret, falls ihr Wertebereich X endlich oder

abzählbar unendlich ist, falls also gilt: X={a1,a2,...,ak}, k∈N, k≤ ∞, ai∈R.

Bei diskreten Zufallsgrößen interessierenden Ereignisse der Form: X∈B,

B⊆X., die in dem Ereignisfeld E=ℑ(X) zusammengefasst sind. D.h. wir

wollen ein Wahrscheinlichkeitsmaß P auf dem Ereignisfeld E angeben. Ein

solches Maß ist eindeutig durch die Einzelwahrscheinlichkeiten pi=P(X=ai)

bestimmt.

Definition: Sei P ein Wahrscheinlichkeitsmaß auf dem Ereignisfeld E=ℑ(X).

Als (Einzel-)Wahrscheinlichkeitsverteilung P einer diskreten Zufallsgröße,

bezeichnet man die Gesamtheit der Einzelwahrscheinlichkeiten pi=P(X=ai),

i=1,..., k. Die Einzelwahrscheinlichkeiten lassen sich in Tabellenform angeben:

Wert ai

P(X=ai)

a1 a2 a3 a4 ...

p1 p2 p3 p4 ...

ak

pk

Offensichtlich gilt (da P ein Wahrscheinlichkeitsmaß ist) für die Einzelwahrscheinlichkeiten:

0 ≤ pi ≤ 1 für alle i=1,2,...,k und

k

∑p

i =1

i

= 1.

Mit Hilfe der Einzelwahrscheinlichkeiten kann man die Wahrscheinlichkeit

für jedes beliebige Ereignis X∈B, B⊆X, berechnen. Sei B={a1*,a2*,...,am*}. Da die

Ereignisse X=ai* und X=aj* für i* ≠ j* disjunkt sind, gilt gemäß Axiom 3 für

Wahrscheinlichkeitsmaße :

P(X∈B) = P( (X=a1*) ∪...∪ (X=am*))=

m

m

i =1

i =1

∑ P ( X = a i* ) = ∑ p i*

Beispiel: X sei die Anzahl der ‚Köpfe’ beim zweimaligen Münzwurf. Gesucht

ist die Wahrscheinlichkeitsverteilung von X.

Lösung: Der Wertebereich von X ist X={0,1,2}. Gesucht sind die

Einzelwahrscheinlichkeiten pi = P(X=i), i=0,1,2.. Unser Versuch hat die

folgenden elementaren Versuchsausgänge: (K,Z),(Z,K),(K,K),(Z,Z), (K=’Kopf’,

Z=’Zahl’), wobei das erste Element der Tupel das Ergebnis des ersten Wurfes

Zufallsgrößen

- 23 -

und das zweite Element das Ergebnis des 2.Wurfes repräsentiert.

offensichtlich folgende Abbildung:

X ist

Das heiß, das Ereignis „X=0“ ist äquivalent zu A0={(Z,Z)}, „X=1“ ist

äquivalent zu A1={(K,Z),(Z,K)}, „X=2“ bedeutet, dass A2={(K,K)}eingetreten

ist, und wir erhalten wegen P(X=i) = P(Ai) in Anwendung der Regel

P(Ai)=|Ai|/|Ω| der klassischen Wahrscheinlichkeit folgende Tabelle:

i

pi=P(X=i)

0

1/4

1

1/2

2

1/4

Die Wahrscheinlichkeit, dass beim zweimaligen Münzwurf mindestens

einmal Kopf auftritt, ist offensichtlich P(X ≥ 1) = p1 +p2 = 3/4.

Beispiel: Wie groß ist die Wahrscheinlichkeit dafür, beim 3maligem Würfeln

mindestens 2 Sechsen zu würfeln?

Lösung: Sei X=“die Anzahl der Sechsen beim 3maligen Würfeln“. Dann ist X ∈

X={0,1,2,3}. Gesucht ist P(X ≥ 2) = p2 + p3, wobei pi=P(X=i) ist. Wir bestimmen

nun die Einzelwahrscheinlichkeitsverteilung von X. Dazu müssen wir nicht

unbedingt Ω und die Abbildung X:Ω→ X genau bestimmen, sondern wir

können eleganterweise auch wie folgt vorgehen. Sei Xi

folgende

Zufallsgröße, die das Ergebnis des i.ten Wurfes beschreibt:

0 falls ' keine 6 '

Xi =

1 falls ' eine 6'

Offensichtlich ist nach den Regeln der klassischen Wahrscheinlichkeit

P(Xi=1)=1/6 und P(Xi=0)=5/6. Darüber hinaus gilt die Äquivalenz folgender

Ereignisse: X = 3 ⇔ X 1 = 1 ∩ X 2 = 1 ∩ X 3 = 1 ;

X = 2 ⇔ ( X 1 = 0 ∩ X 2 = 1 ∩ X 3 = 1) ∪ ( X 1 = 1 ∩ X 2 = 0 ∩ X 3 = 1)

∪ ( X 1 = 1 ∩ X 2 = 1 ∩ X 3 = 0)

usw., usf. Wir wollen nun beispielsweise P(X=2) berechnen. Die durch ∪

verknüpften Teilereignisse der rechten Seite der Äquivalenz zu ‚X=2’ sind

alle disjunkt. Nach Axiom 3 der Wahrscheinlichkeit gilt folglich:

- 24 –

Stochastik

P( X = 2) = P( X 1 = 0 ∩ X 2 = 1 ∩ X 3 = 1) + P( X 1 = 1 ∩ X 2 = 0 ∩ X 3 = 1)

+ P( X 1 = 1 ∩ X 2 = 1 ∩ X 3 = 0)

Die 3 Ereignisse ' X 1 = e1 ' , ' X 2 = e2 ' , ' X 3 = e3 ' , ei ∈ {0,1} , sind gegenseitig

stochastisch unabhängig (d.h., das Ergebnis eines Wurfes beeinflusst die

Ergebnisse der anderen Würfe nicht). Demzufolge kann man auf die

Verbundwahrscheinlichkeiten die Produktformel für unabhängige Ereignisse

anwenden, beispielsweise gilt:

P ( X 1 = 0 ∩ X 2 = 1 ∩ X 3 = 1) = P ( X 1 = 0) ⋅ P( X 2 = 1) ⋅ P ( X 3 = 1) =

5 1 1

⋅ ⋅

6 6 6

Wir erhalten:

5 1 1 1 5 1 1 1 5

1 1 5

⋅ ⋅ + ⋅ ⋅ + ⋅ ⋅ = 3 ⋅ ⋅ ⋅ ≈ 0,069

6 6 6 6 6 6 6 6 6

6 6 6

1 1 1

und P ( X = 3) = ⋅ ⋅ ≈ 0,005 .

6 6 6

P ( X = 2) =

Die Wahrscheinlichkeit, beim 3 maligen Würfeln mindestens 2 mal die 6 zu

würfeln ist also P(X ≥ 2) = p2 + p3 = 0,074.

Übungsaufgaben

2.1

Bestimmen Sie die vollständige Wahrscheinlichkeitsverteilung der

Zufallsgröße X=„Anzahl der Sechsen beim 3maligen Würfeln“!

2.2

Wie groß ist die Wahrscheinlichkeit dafür, dass beim Würfeln mit

zwei Würfeln die Summe der Augenzahlen 6, 7 oder 8 ist?

2.3

Ein Eisverkäufer erzielt bei schönem Wetter einen Tagesgewinn

von 100 Euro und bei Regen von 50 Euro. Bei Schneefall macht er

40 Euro Verlust, ebenso macht er einen Verlust von 20 Euro bei

starkem Wind (ohne Regen und Schnee). Aus den

Wetterberichten der letzten Jahre sei bekannt, dass die

Wahrscheinlichkeit für schönes Wetter 0,5, für Regen 0,25, für

Schneefall 0,15 und für starken Wind 0,1 beträgt. Wie groß ist die

Wahrscheinlichkeit dafür, dass der Eisverkäufer keinen Verlust

am Tag erzielt?

Zufallsgrößen

2.2.2

- 25 -

Spezielle diskrete Wahrscheinlichkeitsverteilungen

Im folgenden stellen wir einige Standardmodelle für Verteilungen diskreter

Zufallsgrößen vor.

Definition: In einem zufälligen Versuch wird beobachtet, ob ein Ereignis A

eintritt oder nicht. Wir können das durch die folgende Zufallsgröße X

abbilden:

eintritt (Misserfolg)

0 falls A nicht

X =

1 falls A eintritt (Erfolg)

Zweipunktverteilung

P(X=0)=1 - p

P(X=1)=p

Die Verteilung von X heißt Zweipunkt- oder Bernoulliverteilung, p = P(X=1)

heißt Erfolgswahrscheinlichkeit.

In Verallgemeinerung der Zweipunktverteilung entsteht die sogenannte

Binomialverteilung.

Definition: Wir gehen von einem zweipunktverteilten Versuch mit

Erfolgswahrscheinlichkeit p aus. X sei die Anzahl der Erfolge bei n maliger

stochastisch unabhängiger Wiederholung des zweipunktverteilten Versuchs.

X hat dann den Wertebereich {0,1,...,n} und besitzt die folgende als

Binomialverteilung mit den Parametern n und p bezeichnete Verteilung:

n

pi = P( X = i) = p i (1 − p) n −i ,

i

i=0,1,...,n.

Wir schreiben: X~B(n,p).

Beispiel: In einer Mathematik-Klausur werden 6 Aufgaben zu je drei

Antwortalternativen gestellt, von denen jeweils nur eine richtig ist. Wie groß

ist die Wahrscheinlichkeit dafür, dass ein Student mehr als 4 Aufgaben nur

durch Raten richtig beantwortet (und damit unverdient eine 1 bekommt)?

Lösung: Für jede Aufgabe i erhalten wir eine zweipunktverteilte Zufallsgröße

Xi, wobei Xi=1 ist, falls die Aufgabe i richtig geraten wird. Die

Erfolgswahrscheinlichkeit ist p=P(Xi =1) =1/3. Da die Lösung stets geraten

wird, hängt das Ergebnis für eine Aufgabe nicht vom Ergebnis der anderen

Aufgaben ab. Wir haben es also mit einer n=6 fachen stochastisch

unabhängigen Wiederholung eines zweipunktverteilten Versuches mit

Erfolgswahrscheinlichkeit p=1/3 zu tun. Die Zufallsgröße X=’Anzahl der

Binomialverteilung

- 26 –

Stochastik

richtig geratenen Aufgaben’ ist also binomialverteilt mit n=6 und p=1/3 und

wir erhalten die Lösung:

6

6

13

P( X > 4) = P( X = 5) + P( X = 6) = (1 / 3) 5 (2 / 3) + (1 / 3) 6 (2 / 3) 0 = 6

3

5

6

≈0,018.

Das heißt, unser nicht erwünschte Fall kommt bei 1000 Studenten, die die

Klausur nur durch Raten absolvieren, ca. 18 mal vor. (Glücklicherweise sind

die Studenten aber alle fleißig und lösen eine Klausur selten durch Raten.)

Gleichverteilung

Definition: Eine Zufallsgröße X besitzt eine (diskrete) Gleichverteilung auf der

endlichen Menge X={a1,a2,...,ak}, wenn sie die Werte a1,a2,...,ak mit derselben

pi = P( X = ai ) =

Wahrscheinlichkeit

1

k

für alle i=1,...,k, annimmt. X

beschreibt eine Auswahl „auf gut Glück“ aus der Menge ={a1,a2,...,ak}. Wir

schreiben: X~ R({a1,a2,...,ak}).

Poissonverteilung

Definition: Eine Zufallsgröße X besitzt eine Poissonverteilung (ist poisson-verteilt)

mit dem Parameter λ>0, wenn sie die Werte

0,1,2,....

mit den

Wahrscheinlichkeiten

pi = P( X = i) =

λi

i!

e −λ , i=0,1,2,....

annimmt. Wir schreiben: X~P(λ).

Die Poissonverteilung findet als Modell oft Anwendung, wenn eine

Zufallsgröße X zählt, wie viele von einer großen Anzahl von unabhängigen

Ereignissen mit recht kleiner Wahrscheinlichkeit eintreten Sie dient für λ= n⋅p

als Approximation der Binomial-Wahrscheinlichkeiten für große n und

kleine

p

(Empfehlung:

n

>

20,

p < 0,01), denn man kann zeigen, dass gilt:

lim

p →0

n →∞

np = λ ( konstant )

n i

λi

p (1 − p ) n −i = e −λ

i!

i

Wie wir im Abschnitt 2.4 sehen werden, lässt sich λ als arithmetisches Mittel

der Beobachtungen von X in einer langen Reihe von wiederholten

Beobachtungen von X interpretieren.

Beispiel: Die Anzahl X der Anrufe, die in einer Telefonzentrale zwischen 22

und 23 Uhr eintreffen, sei poissonverteilt mit dem Parameter λ=5 (d.h., im

Schnitt treffen in diesem Zeitraum ca. 5 Anrufe ein.) Man unterstellt, dass die

Telefonzentrale eine große Anzahl von Kunden bedient, von denen jeder

Zufallsgrößen

- 27 -

unabhängig vom anderen im fraglichen Zeitraum anrufen wird. Die

Wahrscheinlichkeit, dass in dieser Zeit höchstens 2 Anrufe eintreffen, beträgt:

P ( X ≤ 2) = P ( X = 0) + P ( X = 1) + P ( X = 2) = e −5 + 5e −5 +

25 −5

e = 0,12 .

2

Übungsaufgaben

2.4

Eine Firma, die CD-RW’s herstellt, gibt Ihre Ausschussrate (Anteil

der defekten CD-RW’s an allen) mit 1 % an. Wie groß ist die

Wahrscheinlichkeit dafür, dass in einem Paket von 10 CD-RW’s

mehr als 1 defekt ist?

Hinweis: Überlegen Sie sich zunächst, wie die Zufallsgröße X

definiert werden kann und welches Verteilungsmodell für sie in

Frage kommt!

2.5

Die Anzahl X der pro ms eintreffender Signale in einer

Empfängerstation sei poissonverteilt mit dem Parameter λ=3 (d.h.,

im Schnitt treffen ca. 3 Signale pro ms ein). Wie groß ist die

Wahrscheinlichkeit dafür, dass die Kapazität K=5 Signale/ms der

Empfängerstation überschritten wird?

2.3

2.3.1

Stetige Zufallsgrößen

Stetige

Zufallsgrößen,

Verteilungsfunktion

Verteilungsdichte

und

Wir betrachten nun Zufallsgrößen, deren Wertebereich X gleich der Menge R

der reellen Zahlen oder ein (endliches oder unendliches) Teilintervall von R

ist, und für die |X|=∞ ist. Die Wahrscheinlichkeitsverteilung P einer solchen

Zufallsgröße lässt sich nicht mehr durch die Einzelwahrscheinlichkeiten

P(X=x) beschreiben, denn diese sind i.A. gleich Null (Nach den Regeln der

klassischen Wahrscheinlichkeit wäre beispielsweise P(X=x)= 1/|X|=0). Die

für praktische Zwecke bei einer stetigen Zufallsgröße interessierenden

- 28 –

Stochastik

Ereignisse sind deshalb nicht mehr von der Form „X=x“, sondern von der

Form X∈B, wobei B sogenannte Borelmengen in R sind. Borelmengen sind

nicht alle Teilmengen von R, sondern nur die, die sich durch die Operationen

∪, ∩ und Komplementbildung aus halboffenen Intervallen (-∞,x], x∈R, bilden

lassen. Hierzu gehören u.a. alle offenen, halboffenen und geschlossenen

Intervalle, also Ereignisse der Form: X< a, X ≤ a, X > b, X ≥ b, a < X < b,

a ≤ X < b, a < X ≤ b, a ≤ X ≤ b, für a ≤ b (einschließlich a=-∞ und b=∞). Bei

stetigen

Zufallsgrößen

tritt

an

die

Stelle

der

Einzelwahrscheinlichkeitsverteilung die sogenannte Dichtefunktion f(x).

Während wir bei diskreten Zufallsgrößen die Wahrscheinlichkeit P(X ∈B)

durch eine Summe der Einzelwahrscheinlichkeiten beschrieben haben:

P(X∈B) =

∑ P(X = a ) = ∑ p

i

i:ai ∈B

i:ai ∈B

i

werden wir bei stetigen Zufallsgrößen diese Wahrscheinlichkeit durch ein

Integral darstellen:

P(X∈B) =

∫ f ( x)dx

x: x∈B

Stetige

Zufallsgröße,

Dichtefunktion

Definition: Eine Zufallsgröße X heißt stetig, wenn (in Verallgemeinerung der

Einzelwahrscheinlichkeiten) eine integrierbare Funktion f:R→R mit folgenden

Eigenschaften existiert:

(D1) f(x) ≥ 0 für alle x∈R

∞

(D2)

∫ f ( x)dx = 1

−∞

b

(D3) P (a < X ≤ b) =

∫ f ( x)dx

für alle a,b∈R.

a

Die Funktion f heißt Dichtefunktion oder kurz Dichte von X.

Abbildung 1:

Dichte f einer stetigen Zufallsgröße

Als Konsequenz der Eigenschaft (D3) ergibt sich für alle c∈R: P(X=c)=0. Bei

einer stetigen Zufallsgröße sind deshalb die Wahrscheinlichkeiten z. B.

folgender Ereignisse gleich:

Zufallsgrößen

- 29 -

X< a und X ≤ a, sowie X>b und X≥ b,

sowie a < X < b, a ≤ X < b, a < X ≤ b, und a ≤ X ≤ b.

Da sich Intervalle bzw. beliebige Borelmengen stets aus den halboffenen

Intervallen (-∞,x], x∈R, durch Anwendung der Operationen ∪, ∩ und

Komplementbildung erzeugen lassen, kann man die Wahrscheinlichkeiten

P(X∈B) beliebiger Borelmengen B auch aus den Wahrscheinlichkeiten

P(-∞<X ≤ x)=P(X ≤ x) erzeugen. Deshalb spielt bei stetigen Zufallsgrößen die

sogenannte Verteilungsfunktion, die durch

x

F(x) = P(X ≤ x)=

∫ f (u)du

−∞

definiert ist, eine zentrale Rolle. Wahrscheinlichkeitsverteilungen stetiger

Zufallsgrößen sind durch die Angabe der Dichtefunktion f(x) oder der

Verteilungsfunktion F(x) eindeutig bestimmt, wobei es oft bequemer ist, mit

der Verteilungsfunktion zu arbeiten. Die Intervallwahrscheinlichkeiten in

(D3) lassen sich z.B. mit Hilfe der Verteilungsfunktion wie folgt berechnen:

P (a < X ≤ b) = F (b) − F (a ).

Offensichtlich kann man die Dichtefunktion bestimmen, wenn man die

Verteilungsfunktion kennt, es gilt:

F’(x)=f(x).

2.6

Deuten Sie die Verteilungsfunktion einer stetigen Zufallsgröße

mit Hilfe von Abbildung 1 grafisch!

2.7

Stellen Sie die Wahrscheinlichkeit P(X > b) mit Hilfe der

Verteilungsfunktion F und mit Hilfe der Dichtefunktion f dar!

2.8

Stellen Sie die Wahrscheinlichkeiten

P(X ≤ b), P(X>a),

P(a ≤ X ≤ b), P(|X – a|≥ b) grafisch als Fläche unter der

Dichtefunktion f dar!

Warum ist die in Abb. a) gegebene Funktion k e i n e

Dichtefunktion? Warum sind die in Abb. b) und c) gegebenen

Funktionen k e i n e Verteilungsfunktionen?

2.9

a)

b)

c)

Verteilungsfunktion

- 30 –

Stochastik

2.3.2

Bedingte

Wahrscheinlichkeiten

Bedingte Wahrscheinlichkeiten und Quantile

Wir können auch bedingte Wahrscheinlichkeiten berechnen. Für die

Ereignisse A = ' X ≥a ' und B = 'X ≤ b' gilt: P(B/A) = P ( A∩ B)/ P ( A ).

Folglich ist

P( X ≤ b | X ≥ a) =

P(a ≤ X ≤ b) F (b) − F (a)

=

1 − F (a )

P( X ≥ a)

Abbildung 2:

α-Quantil

Veranschaulichung der bedingten Wahrscheinlichkeit

Manchmal interessiert nicht die Wahrscheinlichkeit dafür, mit der eine

zufällige Größe einen vorgegebenen Wert nicht überschreitet, sondern es

interessiert der Wert x, der von X mit einer vorgegebenen Wahrscheinlichkeit

α nicht überschritten wird. Das sind die sogenannten Quantile.

Definition: Wir bezeichnen den kleinsten Wert xα aus dem Definitionsbereich

von X, für den gilt:

P( X ≤ xα ) ≥ α

als α - Quantil der Verteilung von X.

Quantile spielen insbesondere bei stetigen Verteilungen eine Rolle. Ist F die

Verteilungs- und f die Dichtefunktion einer stetigen Zufallsgröße X, so

erfüllt ein α-Quantil xα offenbar die Beziehung:

P ( X ≤ xα ) = F ( xα ) =

xα

∫ f ( x)dx = α

−∞

Abbildung 3:

α-Quantil einer stetigen Verteilung

Zufallsgrößen

- 31 -

Ist die Verteilungsdichte

− xα = x1−α ..

von X symmetrisch, so gilt offensichtlich

Beispiel: Sei X eine Zufallsgröße mit der Verteilungsfunktion

0 falls x < 2

F ( x) = x −3 2 falls 2 ≤ x ≤ 5

1 falls x > 5

Ofensichtlich hat X dann die Dichtefunktion

0 falls x < 2 oder x > 5

f ( x) = 1

2≤ x≤5

3 falls

Abbildung 4:

Dichte- und Verteilungsfunktion für unser Beispiel

Die Gesamtfläche unter der Dichte ist gleich 1. Die Fläche unter der Dichte

von -∞ bis x=3 entspricht dem Funktionswert der Verteilungsfunktion F (3)

an der Stelle x=3. Die Größe der Fläche unter der Dichte zwischen 3 und 5 ist

5

∫ f ( x)dx = F (5) − F (3) =

1-1/3 = 2/3 und gleich der Wahrscheinlichkeit

3

P (3 ≤X ≤ 5) dafür, dass X zwischen 3 und 5 liegt (siehe Abbildung 5a).

5a

Abbildung 5:

5b

Veranschaulichung der Wahrscheinlichkeiten für unser Beispiel

- 32 –

Stochastik

Die bedingte Wahrscheinlichkeit dafür, dass X kleiner als 4 ist, unter der

Bedingung (Voraussetzung), dass X ≥ 3 ist:

2 1

−

P(3 < X < 4) F (4) − F (3) 3 3 1

=

=

=

P( X ≤ 4 | X ≥ 3) =

1 2

1 − F (3)

P( X ≥ 3)

1−

3

D.h., in 50 Prozent aller Fälle, in denen X einen Wert ≥ 3 besitzt, ist dieser

kleiner als 4, siehe Abbildung 5b.

Das 0.9-Quantil der Verteilung ist gegeben durch die Gleichung:

x0 , 9

∫ f ( x)dx = 0,9.

−∞

x0 , 9

Wir erhalten:

1

∫ f ( x)dx = 0,9 ⇔ 3 ( x

0,9

− 2) = 0,9 ⇔ x0,9 = 2,7.

−∞

D.h. nur 10% aller Beobachtungen von X überschreiten den Wert 4,7.

Übungsaufgaben

2.10

Die zufällige Zeit X, die eine Berliner U-Bahn verspätet an einer

Station eintrifft, liegt zwischen 0 und 3 Minuten. Die

Dichtefunktion ist in folgender Skizze gegeben.

Berechnen Sie

a) die Verteilungsfunktion von X!

b) den Anteil aller Fälle, in denen die Verspätung eine Minute

überschreitet! Stellen Sie diesen Anteil grafisch dar!

c) die Wahrscheinlichkeit dafür, dass die Verspätung 2 Minuten

überschreitet, wenn man bereits eine Minute (Verspätung) auf

die U-Bahn gewartet hat! Stellen Sie diese Wahrscheinlichkeit

grafisch dar!

d) Berechnen und interpretieren Sie das 50%-Quantil der

Verteilung von X.

Zufallsgrößen

2.3.3

- 33 -

Spezielle stetige Verteilungen

Wichtige Standardmodelle stetiger Zufallsgrößen sind die Gleichverteilung

auf [a,b],

die Dreiecksverteilung die Exponentialverteilung und die

Normalverteilung.

Definition: Eine Zufallsgröße X besitzt eine Gleichverteilung auf dem Intervall

[a,b] (ist gleichverteilt auf [a,b]), wenn ihre Dichte die Gestalt besitzt:

1

f ( x) = b − a

0

für

Gleichverteilung

auf [a,b]

a≤ x≤b

sonst

Wir schreiben: X~R([a,b]).

Eine auf [a,b] gleichverteilte Zufallsgröße X beschreibt die Auswahl „auf gut

Glück“ eines Punktes aus dem Intervall [a,b]. Der Wertebereich von X ist das

Intervall [a,b]. Höhere Programmiersprachen besitzen häufig eine RANDOM

– Funktion oder eine built-in-Prozedur ‚RAN’, die bei Aufruf eine Zahl

zurückliefert, die als Wert einer auf [0,1] gleichverteilten Zufallsgröße

angesehen werden kann.

2.11

Skizzieren Sie die Dichtefunktion

gleichverteilten Zufallsgröße!

2.12

Zeigen Sie, dass bei einer auf [a,b] gleichverteilten

Zufallsgröße alle Teilintervalle in [a,b] gleicher Länge d die

gleiche Wahrscheinlichkeit besitzen! Berechnen Sie diese!

Geben Sie die Verteilungsfunktion einer auf [a,b]

gleichverteilten Zufallsgröße an und skizzieren Sie diese!

2.13

einer

auf

[a,b]

Wenn man weiß, dass X Werte in [a,b] annimmt und nicht alle Teilintervalle

gleicher Länge gleichberechtigt sind, sondern sich Beobachtungen von X um

einen Wert c häufen, so kann man als Modell eine sogenannte

Dreiecksverteilung wählen.

Definition: Eine Zufallsgröße X besitzt eine Dreiecksverteilung auf [a,b] mit der

Höhe c, wenn ihre Dichte die Gestalt besitzt:

2( x − a )

(c − a )(b − a)

2(b − x)

f ( x) =

(b − c)(b − a)

0

falls a ≤ x ≤ c

falls c ≤ x ≤ b

sonst

Dreiecksverteilung

- 34 –

Stochastik

Wir schreiben: X~D([a,c,b]).

Exponentialverteilung mit dem

Parameter λ

2.14

Skizzieren Sie die Dichtefunktion der Dreiecksverteilung auf

[a,b] mit Höhe h!

2.15

Wie groß ist die Höhe h? Warum muss h kleiner werden,

wenn das Intervall [a,b] länger wird?

Definition: Eine exponentialverteilte Zufallsgröße nimmt Werte im Intervall

[0,∞) an. Die Dichte einer Exponentialverteilung mit dem Parameter λ>0 hat

die Gestalt:

λe − λx

f ( x) =

0

für x ≥ 0

für x < 0

Bezeichnung: X~E(λ).

Abbildung 6:

Dichtefunktion der Exponentialverteilung für verschiedene Parameter

λ

Die Exponentialverteilung dient oft als Modell für zufällige Abbauzeiten,

zufällige Zwischenzeiten zwischen dem Eintreffen zweier Signale in einer

Empfängerstation, zufällige Lebensdauern, wie z.B. die Zeit bis zum Ausfall

eines technischen Gerätes, die Laufzeit eines Jobs im Computer oder die

Zeitdauer eines Telefongespräches. Eine exponentialverteilte Zufallsgröße

besitzt eine wichtige Eigenschaft, die sogenannte Vergessens- bzw.

Nichtalterungseigenschaft. Diese besagt, das die Wahrscheinlichkeit, ein

Zeitintervall der Länge t zu überleben unabhängig davon ist, ob die

Zufallsgröße X bereits die Zeit s überlebt hat oder ob die Lebensdauer soeben

beginnt. In Formeln ausgedrückt :

P(X>s+t/ X>s) = P(X>t)

Zufallsgrößen

- 35 -

Übungsaufgaben

2.16

Berechnen und skizzieren Sie die Verteilungsfunktion einer mit

dem Parameter λ exponentialverteilten Zufallsgröße!

2.17

Zeigen Sie, dass für eine exponentialverteilte Zufallsgröße X gilt:

P(X>s+t/ X>s) = P(X>t) für alle s,t ∈ R.

2.18

Die zufällige Zeit T (Stunden), die bis zum Abbau einer

bestimmten Droge (z.B. ein Glas Wein, 10 cl) im menschlichen

Blut vergeht, sei durch folgende Dichtefunktion charakterisiert:

0

falls x < 0

x

f ( x) =

−

2

falls x ≥ 0

0,5e

a) Berechnen Sie die Verteilungsfunktion von X!

b) In wieviel Prozent aller Fälle dauert der Abbau länger als 2

Stunden?

c) Welche Abbauzeit wird nur in 10 % aller Fälle überschritten?

Fertigen Sie alle Teilaufgaben zunächst Skizzen an!

Eine für die Theorie und Anwendungen sehr wichtige stetige Verteilung ist

die Normalverteilung. Normalverteilungen treten als Modelle für

Körpergrößen,

Geburtsgewichte,

Messfehler,

Niederschlagsmengen,

landwirtschaftliche Erträge usw. auf. In der Theorie erscheinen

Normalverteilungen als Näherungen für andere (auch diskrete) Verteilungen

(siehe dazu auch Kapitel 3.2).

Definition: Eine mit den Parametern µ und σ normalverteilte Zufallsgröße hat

die Dichtefunktion:

2

f ( x) =

1

2πσ

e

−

( x−µ )2

2σ 2

, -∞ < x < ∞, µ∈R, σ>0.

Wir schreiben: X~N(µ,σ2).

Das Bild der Dichtefunktion ist die sogenannte Gaußsche Glockenkurve. Sie hat

ihren Gipfel bei x=µ und ist umso flacher, je größer σ2 ist. Ihren Namen erhielt

Normalverteilung

mit den Parametern

2

µ und σ

- 36 –

Stochastik

sie nach C.F. Gauß, der sie bei der Berechnung von Beobachtungsfehlern

einführte.

Eine besondere Normalverteilung ist diejenige mit den Parametern µ=0 und

σ=1, d.h. N(0,1). Sie wird als Standardnormalverteilung bezeichnet. Als Symbol

für die Dichtefunktion verwendet man ϕ(x) und für die Verteilungsfunktion

Φ(x). Die Quantile der Standardnormalverteilung werden mit uα bezeichnet.

7a: Dichtefunktion der Normalverteilung für einige

Werte von µ und σ

Abbildung 7:

Standardnormalverteilung

7b: Dichtefunktion der

Standardnormalverteilung

Dichtefunktionen der Normalverteilung