Wahrscheinlichkeit

Werbung

WAHRSCHEINLICHKEIT UND STATISTIK

W.1 WAHRSCHEINLICHKEITEN

Wahrscheinlichkeit

Inhaltsverzeichnis

Wahrscheinlichkeit

W.1 Wahrscheinlichkeiten

W.1.1

W.1.2

W.1.3

W.1.4

W.1.5

Ereignisraum, Grundraum . . . . . . . . . . . . . . .

Wahrscheinlichkeitsmass . . . . . . . . . . . . . . . .

Endliche Räume . . . . . . . . . . . . . . . . . . . . . .

Bedingte Wahrscheinlichkeit. . . . . . . . . . . . . .

Unabhängigkeit . . . . . . . . . . . . . . . . . . . . . . .

W.2.1

W.2.2

W.2.3

W.2.4

W.2.5

W.2.6

Diskrete Zufallsvariablen . . . . . . . . . . . . . . . .

Stetige Zufallsvariablen . . . . . . . . . . . . . . . . .

Transformation von Zufallsvariablen . . . . . . . .

Simulation von Verteilungen. . . . . . . . . . . . . .

Erwartungswert. . . . . . . . . . . . . . . . . . . . . . .

Varianz und Standardabweichung . . . . . . . . . .

W.2 Zufallsvariablen

W.3 Wichtige Verteilungen

W.3.1 Diskrete Verteilungen . . . . . . . . . . . . . . . . . .

W.3.2 Stetige Verteilungen. . . . . . . . . . . . . . . . . . . .

W.4 Gemeinsame Verteilungen

W.4.1

W.4.2

W.4.3

W.4.4

W.4.5

W.4.6

Randverteilungen . . . . . . . . . . . . . . . . . . . . .

Bedingte Verteilung . . . . . . . . . . . . . . . . . . . .

Unabhängigkeit . . . . . . . . . . . . . . . . . . . . . . .

Funktionen von Zufallsvariablen . . . . . . . . . . .

Erwartungswert. . . . . . . . . . . . . . . . . . . . . . .

Kovarianz und Korrelation . . . . . . . . . . . . . . .

W.5.1

W.5.2

W.5.3

W.5.4

Gesetz der grossen Zahlen . . . . . . . . . . . . . . .

Zentraler Grenzwertsatz. . . . . . . . . . . . . . . . .

Chebyshev-Ungleichung . . . . . . . . . . . . . . . . .

Monte Carlo Integration . . . . . . . . . . . . . . . .

W.5 Grenzwertsätze

Statistik

S.1 Grundlagen

S.2 Deskriptive Statistik

S.2.1 Histogramm . . . . . . . . . . . . . . . . . . . . . . . . . .

S.2.2 Boxplot . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

S.2.3 QQ-Plot . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

W.1

Wahrscheinlichkeiten

1 W.1.1 Ereignisraum, Grundraum

1

1 Ereignisraum: Der Ereignisraum oder Grundraum Ω ist die

1 Menge aller möglichen Ereignisse eines Zufallexperiments. Die

1 Elemente ω ∈ Ω heissen Elementarereignisse.

2

2 Ereignis: Ein Ereignis A ⊆ Ω ist eine Teilmenge von Ω.

2 Die Klasse aller beobachtbaren Ereignisse F ist eine Teilmenge

2 der Potenzmenge P(Ω) von Ω.

2

2

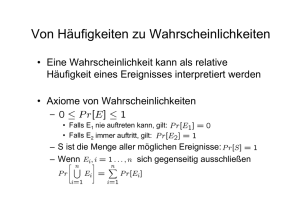

3 W.1.2 Wahrscheinlichkeitsmass

3 Wahrscheinlichkeitsmass: Ein Wahrscheinlichkeitsmass P

3 ist eine Abbildung P : F → [0, 1] mit folgenden Eigenschaften:

3

i: P[Ω] = 1.

4 ii: P[A] ≥ 0 für alle A ∈ F .

S

P∞

5 iii: P[ ∞

i=1 Ai ] =

i=1 P[Ai ] falls Ai ∩ Aj = ∅ für i 6= j .

5

5 Aus denCAxiomen i bis iii folgen direkt die Rechenregeln:

i: P[A ] = 1 − P[A].

5

ii:

P[∅] = 0.

5

iii:

A

⊆ B ⇒ P[A] ≤ P[B].

6

iv:

P

[A

∪ B] = P[A] + P[B] − P[A ∩ B] (Additionsregel ).

6

6

6 W.1.3 Endliche Räume

6 Für einen endlichen Raum Ω = {ω , . . . , ω } mit P[ω ] = p

1

n

i

i

7 für alle 1 ≤ i ≤ n gilt

7

X

P[A] =

pi

7

i

mit

wi ∈A

7

Laplace-Raum: In einem Laplace-Raum sind alle Ereignisse

7 ω1 , . . . , ωn gleich wahrscheinlich (pi = pj für alle i, j ). Es gilt

7 dann

7

8

P [A] =

|A|

|Ω|

S.3 Schätzer

8

S.4 Tests

9 Bedingte Wahrscheinlichkeit: Seien

S.3.1 Momenten-Methode . . . . . . . . . . . . . . . . . . . .

S.3.2 Maximum-Likelihood . . . . . . . . . . . . . . . . . . .

S.4.1

S.4.2

S.4.3

S.4.4

S.4.5

S.4.6

S.4.7

S.4.8

Fehler 1. und 2. Art . . . . . . . . . . . . . . . . . . . .

Mögliches Vorgehen. . . . . . . . . . . . . . . . . . . . .

Likelihood-Quotienten Test . . . . . . . . . . . . . . .

z-Test. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

t-Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Gepaarter Zweistichprobentest. . . . . . . . . . . . .

Ungepaarter Zweistichprobentest . . . . . . . . . . .

Kondenzbereiche . . . . . . . . . . . . . . . . . . . . . .

Anhang

A.1 Kombinatorik

A.2 Reihen und Integrale

8

8

W.1.4 Bedingte Wahrscheinlichkeit

A, B Ereignisse und

P

[A] > 0, dann ist die bedingte Wahrscheinlichkeit von B

9

9 gegeben A deniert durch:

9

P[A ∩ B]

P[B | A] :=

9

P[A]

9

9 Aus der Denition der bedingten Wahrscheinlichkeit folgt die

9 Multiplikationsregel :

10

P[A ∩ B] = P[B | A]P[A]

10

Satz (Totale Wahrscheinlichkeit): Sei A1≤i≤n eine dis10 junkte Zerlegung von Ω, dann gilt für ein beliebiges

Ereignis

10 B :

P[B] =

n

X

P[B | Ai ]P[Ai ]

i=1

SEITE 1

JEROME DOHRAU

WAHRSCHEINLICHKEIT UND STATISTIK

W.2 ZUFALLSVARIABLEN

A1 , . . . , An eine disjunkte W.2.2 Stetige Zufallsvariablen

Zerlegung von Ω mit P[Ai ] > 0 für alle i und B ein Ereignis

Dichte: Eine Zufallsvariable X mit der Verteilungsfunktion

mit P[B] > 0, dann gilt für jedes k:

FX (t) heisst stetig mit Dichte fX : R → [0, ∞), falls gilt

P[B | Ak ]P[Ak ]

Z t

P[Ak | B] = Pn

i=1 P[B | Ai ]P[Ai ]

f (s)ds für alle t ∈ R.

F (t) =

Satz (Formel von Bayes): Sei

X

X

−∞

W.1.5 Unabhängigkeit

Unabhängigkeit: Die Ereignisse

A1 , . . . , An heissen unabhängig, wenn für alle m ∈ N und {k1 , . . . , km } ⊆ {1, . . . , n}

gilt

P

"m

\

#

Ak i =

i=1

m

Y

Für eine Dichtefunktion fX gilt:

i: fRX (t) ≥ 0 für alle t ∈ R.

∞

ii: −∞

fX (s)ds = 1.

Hinweis: Es gilt

P[Aki ].

stetig ist.

d

dt FX (t)

= fX (t) falls fX an der Stelle t

i=1

Hinweis: Bei unabhängigen Ereignissen A, B hat das Eintre- W.2.3 Transformation von Zufallsvariablen

ten des einen Ereignisses keinen Einuss auf die WahrscheinSatz: Sei X eine stetige Zufallsvariable mit Dichte fX und

lichkeit des anderen Ereignisses: P[B | A] = P[A∩B]

P[A] = P[B]

fX (t) = 0 für t ∈

/ I ⊆ R. Sei g : R → R stetig dierenzierbar

und streng monoton auf I mit Umkehrfunktion g −1 . Dann

hat die Zufallsvariable Y := g(X) die Dichte

W.2

Zufallsvariablen

(

Zufallsvariable: Eine Zufallsvariable X auf Ω ist eine Funktion X : Ω → W(X) ⊆ R. Jedes Elementarereignis ω wird auf

eine Zahl X(ω) abgebildet.

Verteilungsfunktion: Die Verteilungsfunktion einer Zufallsvariable X ist die Abbildung FX : R → [0, 1],

FX (t) := P[X ≤ t] := P[{ω | X(ω) ≤ t}].

fY =

d −1

g (t)| für t ∈ {g(x) | x ∈ I}

fX (g −1 (t))| dt

sont

0

Beispiel (Lineare Transformation): Aus Y

a > 0, b ∈ R folgt

t−b

t−b

= FX

FY (t) = P[aX + b ≤ t] = P X ≤

a

a

Jede Verteilungsfunktion FX hat folgende Eigenschaften:

i: a ≤ b ⇒ FX (a) ≤ FX (b) (monoton wachsend).

ii: lim FX (t) = FX (u) (rechtsstetig).

t→u,t>u

iii: lim FX (t) = 0 und lim FX (t) = 1.

und mit der Kettenregel ergibt sich

W.2.1 Diskrete Zufallsvariablen

folgt

t→−∞

:= aX +b mit

fY (t) =

1

d

FY (t) = fX

dt

a

t−b

a

.

t→∞

Beispiel (Nichtlineare Transformation): Aus

Y := X 2

Eine Zufallsvariable heisst diskret, falls ihr Wertebereich FY (t) = P[X 2 ≤ t] = P−√t ≤ X ≤ √t = FX √t−FX −√t

W(X) endlich oder abzählbar ist.

und somit

Gewichtsfunktion: Die Wahrscheinlichkeitsfunktion oder

√

√

Gewichtsfunktion einer diskreten Zufallsvariable X ist gegefX t + fX − t

d

√

fY (t) = FY (t) =

ben durch

dt

2 t

pX (x) =

P[X = x] für x ∈ W(X)

0

sonst

Eine Gewichtsfunktion weist folgende Eigenschaften auf:

i: P

pX (x) ∈ [0, 1] für alle x.

ii: xi ∈W(X) pX (xi ) = 1.

W.2.4 Simulation von Verteilungen

Satz: Sei F eine stetige und streng monoton wachsende Ver-

teilungsfunktion mit Umkehrfunktion F −1 . Ist X ∼ U(0, 1)

und Y := F −1 (X), so hat Y die Verteilungsfunktion F .

Diskrete Verteilungsfunktion: Die Verteilungsfunktion

Beispiel: Um die Verteilung Exp(λ) zu simulieren bestimmt

FX einer diskreten Zufallsvariable X mit Wertebereich

man zu der Verteilungsfunktion F (t) = 1 − e−λt für t ≥ 0 die

W(X) = {x1 , . . . , xn } ist die Funktion

Inverse F −1 (t) = − log(1−t)

. Mit U ∼ U(0, 1) erhält man

λ

X

FX (t) = P[X ≤ t] =

pX (xk )

log(1 − U )

xk ∈W(X)

X := F −1 (U ) = −

∼ Exp(λ).

xk ≤t

λ

SEITE 2

JEROME DOHRAU

WAHRSCHEINLICHKEIT UND STATISTIK

W.2.5 Erwartungswert

W.3 WICHTIGE VERTEILUNGEN

W.3.1.2 Bernoulli-Verteilung

Diskreter Erwartungswert: Ist X diskrete Zufallsvariable Eine bernoulli-verteilte Zufallsvariable X ∼ Be(p) mit Paramit Gewichtsfunktion pX , so ist der Erwartungswert von X meter p ∈ [0, 1] nimmt die Werte 0 und 1 mit Wahrscheinlichkeiten

deniert als

X

pX (1) = p und pX (0) = 1 − p

E[X] :=

xi pX (xi ),

xi ∈W(X)

an. Eine alternative Schreibweise ist

x

sofern diese Reihe konvergiert.

p (1 − p)1−x x ∈ {0, 1}

pX (x) =

0

sonst.

Stetiger Erwartungswert: Falls X eine stetige Zufallsvariable mit Dichte fX ist, dann ist der Erwartungswert von X

Erwartungswert : p

deniert als

Z ∞

Varianz

: p(1 − p)

E[X] :=

xfX (x)dx,

−∞

Beispiel (Münzwurf): Ein fairer Münzwurf ist bernoulli-

falls das Integral konvergiert.

verteilt mit Parameter p = 21 . Für einen Parameter p 6=

Satz (4.1): Sei X eine diskrete Zufallsvariable mit Gewichts- wäre der Münzwurf unfair.

funktion pX und Y := g(X), dann gilt

1

2

W.3.1.3 Binomialverteilung

E[Y ] = E[g(X)] =

X

g(xi )pX (xi ).

xi ∈W(X)

Falls X eine stetige Zufallsvariable mit Dichte fX ist, ist analog

Z

E[Y ] = E[g(X)] =

∞

g(x)fX (x)dx

Die Gewichtsfunktion pX einer binomial-verteilten Zufallsvariable X ∼ Bin(n, p) mit Parameter n ∈ N und p ∈ [0, 1] ist

gegeben durch

px (k) =

n k

p (1 − p)n−k

k

für k ∈ {0, . . . , n}

−∞

W.2.6 Varianz und Standardabweichung

Varianz: Sei X eine Zufallsvariable mit E[X 2 ] < ∞. Die Varianz von X ist deniert als

Var[X] := E (X − E(X))2 .

Erwartungswert : np

Varianz

: np(1 − p)

X ist die Anzahl der Erfolge k bei n unabhängigen

Wiederho-

lungen eines Bernoulli-Experiments. Es gibt nk verschiedene

Möglichkeiten bei n Versuchen k-mal erfolgreich zu sein. Jeder dieser Möglichkeit hat Wahrscheinlichkeit pk (1 − p)n−k .

Hinweis: Nach Satz 4.1 lässt sich die Varianz folgendermas- W.3.1.4 Geometrische Verteilung

sen berechnen:

Die Gewichtsfunktion pX einer geometrisch-gleichverteilten

Z ∞

2

Zufallsvariable X ∼ Geom(p) mit Parameter p ∈ [0, 1] ist

Var[X] =

(x − E[X]) fX (x)dx

gegeben durch

−∞

Standardabweichung: Die Standardabweichung einer Zufallsvariable X ist

σX :=

W.3

p

Var[X].

Wichtige Verteilungen

W.3.1 Diskrete Verteilungen

W.3.1.1 Diskrete Gleichverteilung

pX (k) = p(1 − p)k−1

Erwartungswert :

Varianz

:

1

p

1

p2 (1

für k ∈ {1, 2, . . .}

− p)

Beispiel (Wartezeit): Die Geometrische Verteilung ist

die Wahrscheinlichkeitsverteilung der Anzahl X BernoulliVersuche, die notwendig sind, um den ersten Erfolg zu erzielen. Für die Anzahl Würfelfwürfe, die man braucht um eine

6 zu würfeln, ist p = 61 .

Zufallsvariable X mit Wertebereich W(X) = {x1 , . . . , xn } W.3.1.5 Negativbinomiale Verteilung

und alle Werte haben die gleiche Wahrscheinlichkeit falls

Die Gewichtsfunktion pX einer negativ-binomial-verteilten

1

Zufallsvariable X mit Parameter r ∈ N und p ∈ [0, 1] ist

pX (xi ) =

für i ∈ {1, . . . , n}

gegeben durch

n

Beispiel (Würfeln): Die Zufallsvariable X gibt die Augen-

zahl bei einem Würfelwurf an. Der Wertebereich ist also

W = {1, 2, 3, 4, 5, 6} und somit n = 6.

SEITE 3

pX (k) =

k−1 r

p (1 − p)k−r

r−1

für k ∈ {r, r + 1, . . .}

JEROME DOHRAU

WAHRSCHEINLICHKEIT UND STATISTIK

W.3 WICHTIGE VERTEILUNGEN

a, b ∈ R wobei a < b sind gegeben durch

( 1

− p)

für t ∈ [a, b]

b−a

fX (t) =

0

für t ∈/ [a, b]

X entspricht der Wartezeit auf den r-ten Erfolg. Es gibt k−1

r−1

für t < a

möglichkeiten für r − 1 Erfolge bei k − 1 Versuchen; der r-te

0

t−a

Erfolg tritt ja beim k-ten Versuch ein.

für t ∈ [a, b]

FX =

b−a

1

für t > b

Erwartungswert :

Varianz

:

r

p

r

p2 (1

W.3.1.6 Hypergeometrische Verteilung

Die Gewichtsfunktion pX einer hypergeometrisch-verteilten

Zufallsvariable X mit Parameter r, n, m ∈ N, wobei r, m ≤ n,

ist gegeben durch

pX (k) =

r

k

n−r

m−k

n

m

für k ∈ {0, . . . , min{r, m}}

Erwartungswert : m nr

Varianz

: m nr (1 − nr ) n−m

n−1

In einer Urne benden sich n Gegenstände. Davon sind r

Gegenstände vom Typ A und n − r vom Typ B. Es werden m Gegenstände ohne Zurücklegen gezogen. X beschreibt

die Wahrscheinlichkeitsverteilung für die Anzahl k der Gegenstände vom Typ A in der Stichprobe.

Beispiel (Lotto): Anzahl Zahlen

n = 45, richtige Zahlen

r = 6, meine Zahlen m = 6. Die Wahrscheinlichkeit für 4

Richtige ist

6

4

39

2

45

6

pX (4) =

≈ 0.00136.

W.3.1.7 Poisson Verteilung

Erwartungswert : 12 (a + b)

1

Varianz

: 12

(a − b)2

Beispiel: Rundungsfehler einer Messung.

W.3.2.2 Exponentialverteilung

Die Dichte fX und Verteilungsfunktion FX einer exponentialverteilten Zufallsvariable X ∼ Exp(λ) mit Parameter λ > 0

sind gegeben durch

(

fX (t)

=

0

(

FX (t)

=

Erwartungswert :

Varianz

:

λe−λt

für t ≥ 0

für t < 0

1 − e−λt

0

für t ≥ 0

für t < 0

1

λ

1

λ2

Beispiel (Lebensdauer): Die Exponentialverteilung ist ei-

ne typische Lebensdauerverteilung. So ist beispielsweise die

Lebensdauer von elektronischen Bauelementen häug annähernd exponentialverteilt.

Die Gewichtsfunktion pX einer Poisson-verteilten Zufallsva- W.3.2.3 Normalverteilung

riable X ∼ P(λ) mit Parameter λ ist gegeben durch

Die Dichte fX einer normalverteilten Zufallsvariable X ∼

N (µ, σ 2 ) mit Parameter µ ∈ R und σ 2 > 0 ist gegeben durch

k

−λ λ

pX (k) = e

für k ∈ {0, 1, . . .}

2

k!

Erwartungswert : λ

Varianz

:λ

Die Poisson-Verteilung eignet sich zur Modellierung von seltenen Ereignissen, wie z.B. Versicherungsschäden.

fX (t) =

(t−µ)

1

√ e− 2σ2

σ 2π

Für die Verteilungsfunktion FX existiert kein geschlossener

Ausdruck. Deshalb werden die Werte der Verteilungsfunktion

Φ(t) der Standard-Normalverteilung

t2

1

fX (t) = √ e− 2

2π

Hinweis: Die Binomialverteilung Bin(n, p) kann approximativ durch die Poissonverteilung P(λ) mit λ = np berechnet mit µ = 0 und σ 2 = 1 tabelliert. Für allgemeine Normalverwerden. Faustregel: Die Approximation kann für np2 ≤ 0.05 teilungen berechnet man dann

benutzt werden.

X −µ

t−µ

t−µ

FX (t) = P[X ≤ t] = P

≤

=Φ

.

W.3.2 Stetige Verteilungen

W.3.2.1 Stetige Gleichverteilung

σ

σ

σ

Erwartungswert : µ

Varianz

: σ2

Die Dichte fX und Verteilungsfunktion FX einer stetigen und

gleichverteilten Zufallsvariable X ∼ U(a, b) mit Parameter Beispiel: Streuung von Messwerten um den Mittelwert.

SEITE 4

JEROME DOHRAU

WAHRSCHEINLICHKEIT UND STATISTIK

W.4 GEMEINSAME VERTEILUNGEN

Bedingte Dichte: Für zwei stetige Zufallsvariablen

X und

Y mit gemeinsamer Dichte fX,Y (x, y) ist die bedingte Dichte

Gemeinsame Verteilung: Die gemeinsame Verteilungs- fX|Y von X gegeben Y deniert durch

funktion von n Zufallsvariablen X1 , . . . , Xn ist die Abbildung

fX,Y (x, y)

F : Rn → [0, 1],

fX|Y (x | y) :=

fY (y)

F (t1 , . . . , tn ) := P[X1 ≤ t1 , . . . , Xn ≤ tn ].

falls fY (y) > 0 und 0 falls fY (y) = 0.

Gemeinsame Gewichtsfunktion: Falls X1 , . . . , Xn diskreW.4

Gemeinsame Verteilungen

te Zufallsvariablen sind, ist ihre gemeinsame Gewichtungsfunktion p : Rn → [0, 1] deniert durch

p(x1 , . . . , xn ) := P[X1 = x1 , . . . , Xn = xn ].

Gemeinsame Dichte: Seien

X1 , . . . , Xn stetige Zufallsvariablen mit gemeinsamer Verteilungsfunktion F (t1 , . . . , tn ).

Die Funktion f : Rn → [0, ∞) heisst gemeinsame Dichte von

X1 , . . . , Xn , falls für alle ti ∈ R gilt

Z

t1

F (t1 , . . . , tn ) =

Z

tn

...

−∞

f (x1 , . . . , xn )dxn . . . dx1

−∞

W.4.3 Unabhängigkeit

Unabhängigkeit: Die Zufallsvariablen

X1 , . . . , Xn heissen

unabhängig, falls die gemeinsame Verteilungsfunktion das

Produkt der Verteilungsfunktionen der Randverteilungen ist:

F (x1 , . . . , xn ) =

n

Y

FXi (xi )

i=1

Im diskreten Fall sind X1 , . . . , Xn unabhängig, genau dann

wenn

n

p(x1 , . . . , xn ) =

Y

pXi (xi )

Falls X1 , . . . , Xn eine gemeinsame Dichte f haben, so hat diei=1

se folgende Eigenschaften:

gilt und analog im stetigen Fall, falls

i: fR (t1 , . . . , tn ) ≥ 0 für alle ti ∈ R.

n

Y

ii: Rn f (t1 , . . . , tn )dµ = 1.R

fXi (xi ).

f

(x

,

.

.

.

,

x

)

=

1

n

iii: P[(X1 , . . . , Xn ) ∈ A] = (t1 ,...,tn )∈A f (t1 , . . . , tn )dµ.

n

i=1

iv: f (t1 , . . . , tn ) = ∂t1∂···∂tn F (t1 , . . . , tn ), falls deniert.

W.4.1 Randverteilungen

W.4.4 Funktionen von Zufallsvariablen

Ausgehend von den Zufallsvariablen X1 , . . . , Xn kann man

X und Y Zufallsvariablen mit ge- mit einer Funktion g : Rn → R eine neue Zufallsvariable Y =

meinsamer Verteilungsfunktion FX,Y , dann ist die Randver- g(X1 , . . . , Xn ) bilden.

teilung FX : R → [0, 1] von X deniert durch

Beispiel (Summe, diskret): Für die Gewichtsfunktion pZ

FX := P[X ≤ x] = P[X ≤ x, Y < ∞] = lim FX,Y (x, y).

der Summe Z = X + Y zweier diskreten Zufallsvariablen X

y→∞

und Y mit gemeinsamer Gewichtsfunktion p erhält man

Für zwei diskrete Zufallsvariablen X und Y mit gemeinsaX

X

P[X = xi , Y = z−xi ] =

p(xi , z−xi )

mer Gewichtsfunktion pX,Y (x, y) ist die Gewichtsfunktion der pZ (z) =

Randverteilung von X gegeben durch

xi ∈W(X)

xi ∈W(X)

X

X

Beispiel (Summe, stetig): Sind X und Y stetige ZufallspX = P[X = x] =

P[X = x, Y = yj ] =

pX,Y (x, yj ).

variablen mit gemeinsamer Dichte f , so ist die Verteilungsj

j

funktion FZ der Summe Z = X + Y gegeben durch

Für zwei stetige Zufallsvariablen X und Y mit gemeinsaZ ∞ Z z−x

Z z Z ∞

mer Dichte fX,Y (x, y) ist die Randdichte (Dichtefunktion der

v=x+y

FZ =

f (x, y)dydx =

f (x, v−x)dxdv

Randverteilung) von X gegeben durch

−∞ −∞

−∞ −∞

Z ∞

und somit auch die Dichte

fX (x) =

fX,Y (x, y)dy.

Z ∞

−∞

d

FZ (z) =

f (x, z − x)dx.

fZ =

dz

−∞

Randverteilung: Seien

W.4.2 Bedingte Verteilung

Bedingte Gewichtsfunktion: Seien X und Y diskrete Zu- W.4.4.1 i.i.d Annahme

fallsvariablen mit gemeinsamer Gewichtsfunktion pX,Y (x, y),

dann ist die bedingte Gewichtsfunktion pX|Y (x | y) von X Die Abkürzung i.i.d. kommt vom Englischen independent and

identically distributed. Die n-fache Wiederholung eines Zugegeben Y deniert durch

fallsexperiments ist selbst wieder ein Zufallsexperiment. Für

die Zufallsvariablen Xi der i-ten Wiederholung wird oft aus

pX,Y (x, y)

pX|Y (x | y) := P[X = x | Y = y] =

Gründen der Einfachheit Folgendes angenommen:

pY (y)

i: X1 , . . . , Xn sind paarweise unabhängig.

falls pY (y) > 0 und 0 falls pY (y) = 0.

ii: Alle Xi haben dieselbe Verteilung.

SEITE 5

JEROME DOHRAU

WAHRSCHEINLICHKEIT UND STATISTIK

W.4.4.2 Spezielle Funktionen von Zufallsvariablen

Wichtige Spezialfälle sind die Summe Sn = i=1 Xi und das

arithmetische Mittel X n = Snn .

1. Wenn Xi ∼ Be(p), dann ist Sn ∼ Bin(n, p).

2. Wenn Xi ∼ P(λ), dann ist Sn ∼ P(nλ).

3. Wenn Xi ∼ N (µ, σ 2 ), dann ist Sn ∼ N (nµ, nσ 2 ).

Für den Erwartungswert und die Varianz gilt allgemein

E[Sn ] = nE[Xi ] Var[Sn ] = nVar[Xi ]

Pn

W.4.5 Erwartungswert

W.5 GRENZWERTSÄTZE

Hinweis: Die Korrelation misst die Stärke und Richtung der

linearen Abhängigkeit zweier Zufallsvariablen X und Y :

Corr[X, Y ] = ±1 ⇔ ∃ a ∈ R, b > 0 : Y = a ± bX

Hinweis: Sind X und Y unabhängig, dann ist Cov[X, Y ] = 0

und Corr[X, Y ] = 0. Die Umkehrung gilt aber im Allgemeinen

nicht.

W.5

Hinweis: Der Erwartungswert einer n-dimensionalen Vertei-

Grenzwertsätze

lung wird als n-Tupel der Erwartungswerte aller Randverteilungen E[Xi ] angegeben.

W.5.1 Gesetz der grossen Zahlen

Y := g(X1 , . . . Xn ) der Zufallsvariablen X1 , . . . , Xn gilt im

µ = E[Xi ] und die Varianz Var[Xi ] = σ haben, gilt

Satz (Schwaches GGZ): Für eine Folge X1 , X2 , . . . von

Satz (4.2): Für den Erwartungswert E[Y ] einer Funktion unkorrelierten Zufallsvariablen, die alle2 den Erwartungswert

diskreten Fall

n

E[Y ] =

X

X n :=

g(x1 , . . . , xn )p(x1 , . . . , xn )

x1 ,...,xn

und analog im stetigen Fall

E[Y ] =

Z

n→∞

−→

µ = E[Xi ].

Das heisst

Z

...

1X

Xi

n i=1

P |X n − µ| > −→ 0 ∀ > 0.

g(x1 , . . . , xn )f (x1 , . . . , xn )dxn . . . dx1 .

n→∞

Rn

Satz (4.4): Seien X1 , . . . , Xn Zufallsvariablen mit endlichen Satz (Starkes GGZ): Für eine Folge X1 , X2 , . . . unabhängiger Zufallsvariablen, die alle den endlichen Erwartungswert

Erwartungswerten E[X1 ], . . . , E[Xn ], dann ist

µ = E[Xi ] haben, gilt

"

#

E a+

n

X

i=1

bi Xi = a +

n

X

bi E[Xi ].

i=1

W.4.6 Kovarianz und Korrelation

Kovarianz: Seien X und Y Zufallsvariablen mit E[X 2 ] < ∞

und E[Y 2 ] < ∞, dann ist die Kovarianz von X und Y gegeben

durch

Cov[X, Y ] := E[(X − E(X))(Y − E(Y ))].

Es gelten folgende Rechenregeln:

i: Var[X] = E[X 2 ] − E[X]2 .

ii: Var[a +P

bX] = b2 Var[X]

P.

iii: Var[a+ ni=1 bi Xi ] = ni=1 b2i Var[Xi ], für Xi unabhängig.

iv: Var[X + Y ] = Var[X] + Var[Y ] + 2Cov[X, Y ].

v: Cov[X, Y ] = Cov[Y, X].

vi: Cov[X, X] = Var[X].

vii: Cov[X, Y ] = E[XY ] − E[X]E[Y ].

viii: Cov[X, a] = 0 für alle a ∈ R.

ix: Cov[X, bY ] = bCov[X, Y ] für alle b ∈ R.

x: Cov[X, YP+ Z] = Cov[X,PY ] + Cov[X, Z].

xi: Cov[a + ni=1 bi Xi , c + m

j=1 dj Yj ]

Pn Pm

= i=1 j=1 bi dj Cov[Xi , Yj ]

xii: Cov[X, Y ] = 0, falls X und Y unabhängig.

Korrelation: Seien X und Y Zufallsvariablen, dann heisst

Cov[X, Y ]

p

Corr[X, Y ] := p

Var[X] Var[Y ]

Korrelation von X und Y . Ist Corr[X, Y ] = 0, oder äquivalent

Cov[X, Y ] = 0, dann heissen X und Y unkorreliert.

SEITE 6

n

X n :=

1X

Xi

n i=1

n→∞

−→

µ = E[Xi ]. P-fastsicher

Das heisst

h

i

P {ω ∈ Ω | X n (ω) −→ µ} = 1.

n→∞

W.5.2 Zentraler Grenzwertsatz

Satz (ZGS): Sei

X1 , X2 , . . . eine Folge von i.i.d. Zufallsvariablen mit µ P

= E[Xi ] und σ 2 = Var[Xi ], dann gilt für die

Summe Sn = ni=1 Xi

Sn − nµ

√

lim P

≤ t = Φ(t) ∀t ∈ R

n→∞

σ n

wobei Φ die Verteilungsfunktion von N (0, 1) ist.

Hinweis: Die Summe

Sn hat Erwartungswert E[Sn ] = nµ

und Varianz Var[Sn ] = nσ 2 . Die Grösse

Sn∗ :=

Sn − nµ

Sn − E[Sn ]

√

= p

σ n

Var[Sn ]

hat Erwartungswert 0 und Varianz 1. Für grosse n gilt zudem:

P[Sn∗ ≤ x]

Sn∗

Sn

≈

∼

approx.

∼

approx.

Φ(x)

N (0, 1)

N (nµ, nσ 2 )

JEROME DOHRAU

WAHRSCHEINLICHKEIT UND STATISTIK

S.2 DESKRIPTIVE STATISTIK

W.5.3 Chebyshev-Ungleichung

S.2

Für eine Zufallsvariable Y mit Erwartungswert µY und Varianz σY2 und jedes > 0 gilt

S.2.1 Histogramm

Deskriptive Statistik

Bei grossem Stichprobenumfang n werden benachbarte Werte zu einer Klasse zusammengefasst. Der Wertebereich der

Daten wird dadurch in disjunkte Intervalle (die Klassen) unterteilt.

W.5.4 Monte Carlo Integration

i) √

Die Anzahl der Klassen sollte von der Grössenordnung

Das Integral

Z 1

n sein.

ii)

Die

Klassenbreite sollte für alle Klassen gleich sein; als

g(x)dx

I :=

0

Ausnahme können die Klassen am linken und rechten

lässt sich als Erwartungswert auassen, denn mit einer gleichRand grösser sein (Ausreisser).

verteilten Zufallsvariable U ∼ U(0, 1) folgt

P[|Y − µY | > ] ≤

E[g(U )] =

Z

σY2

.

2

∞

Z

−∞

1

g(x)dx.

g(x)fU (x)dx =

0

180

Mit einer Folge von Zufallsvariablen U1 , . . . , Un , die unabhängig gleichverteilt Ui ∼ U(0, 1) sind, lässt sich das Integral approximieren: Nach dem schwachen Gesetz der grossen Zahlen

gilt

g(Un ) =

1

n

n

X

200

160

140

120

100

g(Ui ) −→ E[g(U1 )] = I.

n→∞

80

i=1

Statistik

S.1

60

40

20

0

−4

Grundlagen

Stichprobe: Die Gesamtheit der Beobachtungen

x1 , . . . , x n

−3

−2

−1

0

1

2

3

4

Abb. 1: Histogramm einer standard-norvmalverteilten Zufallsvariable.

oder der Zufallsvariablen X1 , . . . , Xn wird Stichprobe genannt; die Anzahl n heisst Stichprobenumfang.

Empirische Verteilungsfunktion: Die empirische Vertei- S.2.2

Boxplot

lungsfunktion Fn zu den Messdaten x1 , . . . , xn ist deniert Aus einem Boxplot lässt sich folgendes ablesen:

durch

a: empirischer Median

X

1

1

b: empirisches 0.25-Quantil

Fn (y) := |{xi | xi ≤ y}| =

fi .

c: empirisches 0.75-Quantil

n

n

i mit xi ≤y

d: kleinster Datenwert xi mit b − xi < 1.5(c − b)

e: grösster Datenwert xi mit xi − c < 1.5(c − b)

Empirischer Mittelwert:

f: Ausreisser

n

xn = x =

1X

xi

n i=1

Empirische Varianz und Standardabweichung:

n

1 X

s2n = s2 =

(xi − x)2

n − 1 i=1

Empirisches Quantil: Das empirische α-Quantil zu den geordneten Daten x(1) , . . . , x(n) ist gegeben durch

e

11

c

10

b

8

7

(1 − α)x(k) + αx(k+1) = x(k) + α x(k+1) − x(k) ,

6

wobei k = bαnc und α ∈ (0, 1). Damit liegt etwa der Anteil

α unterhalb des empirischen α-Quantils, und somit etwa der

Anteil 1 − α oberhalb.

5

Empirischer Median: Der empirische Median ist deniert

a

9

d

f

4

1

Abb. 2: Boxplot

als das 0.5-Quantil.

SEITE 7

JEROME DOHRAU

WAHRSCHEINLICHKEIT UND STATISTIK

S.3 SCHÄTZER

S.2.3 QQ-Plot

Es gilt aber auch Var[X] = E[X 2 ] − E[X]2 = λ. Es kann also

auch g1 (µ1 , µ2 ) = µ2 − µ21 gewählt werden. Dadurch erhält

Mit einem QQ-Plot (Quantil-Quantil) kann man die Abwei- man einen

anderen Momentenschätzer

chung der Daten von einer gewählten Modell-Verteilung F

!

!2

graphisch überprüfen.

n

n

n

X

1X 2

1X

Es werden die empirischen Quantile auf der y -Achse gegenλ

=

xi −

xi

(xi − x)2

=

n

n

über den theoretischen Quantilen auf der x-Achse geplottet.

i=1

i=1

i=1

MM

S.3

S.3.2 Maximum-Likelihood

Schätzer

Für eine Stichprobe X1 , . . . , Xn soll ein passendes Modell gefunden werden. Die Parameter ϑ = (ϑ1 , . . . , ϑm ) des Modells

versucht man mit einem Schätzer T = (T1 , . . . , Tm ) aufgrund

der Stichprobe herauszunden. Die Schätzer sind Zufallsvariablen der Form Tj = tj (X1 , . . . , Xn ) für eine geeignete Funktion tj : Rn → R. Durch Einsetzen von Daten xi erhält man

Schätzwertwerte tj (x1 , . . . , xn ) für ϑj .

Es wird von einer Zufallsvariable X1 , . . . , Xn ausgegangen, deren gemeinsame Dichte f (t1 , . . . , tn | ϑ) von einem Parameter

ϑ abhängt. Die Likelihood-Funktion L ist gegeben durch

L(x1 , . . . , xn | ϑ) = f (x1 , . . . , xn | ϑ).

Anschaulich ist das die Wahrscheinlichkeit , dass im Modell

Pϑ die Stichprobe X1 , . . . , Xn die Werte x1 , . . . , xn liefert. Um

eine

möglichst gute Anpassung des Modells an die Daten zu

Erwartungstreu: Ein Schätzer T heisst erwartungstreu für erreichen,

wird der Likelihood-Schätzer als Funktion von ϑ

ϑ, falls E[T ] = ϑ (im Mittel wird richtig geschätzt).

maximiert.

Konsistent: Eine Folge von Schätzern T (n) , n ∈ N heisst

konsistent für ϑ, falls T (n) für n → ∞ im Modell Pϑ gegen ϑ Hinweis: Im diskreten Fall wird lediglich die Dichte f durch

die Gewichtsfunktion p ersetzt.

konvergiert. Das heisst für jedes ϑ ∈ Θ und > 0 gilt

1

lim P[ |T (n) − ϑ| > ] = 0.

Oft sind die Zufallsvariablen Xi unter Pϑ i.i.d. mit Dichtefunktion f (t | ϑ), so dass sich die Likelihood-Funktion vereinHinweis: Der Grundraum Ω und die Menge der beobacht- facht zu

n

Y

baren Ereignisse F sind fest. Die Wahl des Parameters ϑ aus

L(x

,

.

.

.

,

x

|

ϑ)

=

f (xi | ϑ).

1

n

dem Parameterraum Θ hat aber Einuss auf das Wahrscheini=1

lichkeitsmass Pϑ . Mit Eϑ wird der Erwartungswert unter Pϑ

bezeichnet.

Aufgrund der Monotonie des Logarithmus kann dann die logarithmierte Likelihood-Funktion verwendet werden, ohne dass

sich dadurch das Maximum der Funktion verschiebt.

S.3.1 Momenten-Methode

n→∞

Moment: Das k-te Moment einer Zufallsvariablen X im Model Pϑ ist

µk := µk (ϑ) := Eϑ [X ].

log L(x1 , . . . , xn | ϑ) =

k -te Stichprobenmoment von

Zufallsvarialben X1 , . . . , Xn ist

n

µ̂k :=

1X k

X .

n i=1 i

Die Parameter ϑi der theoretischen Verteilung werden als

Funktion der Momente µk angegeben.

ϑj = gj (µ1 , . . . , µm ) für j ∈ {1, . . . , m}

log f (xi | ϑ)

i=1

k

Stichprobenmoment: Das

n

X

Beispiel: Gegeben seien

n unabhängige Realisierungen

x1 , . . . , xn einer Zufallsvariable X ∼ Exp(λ) mit Dichte

f (t) = λe−λt 1[0,∞) (t) und unbekanntem Parameter λ. Für

die Likelihood-Funktion erhält man

L(λ) := L(x1 , . . . , xn | λ) =

n

Y

λe−λxi

i=1

und durch logarithmieren

n

X

log λe−λxi = n log λ − λ

n

X

xi .

Den Momentenschätzer für ϑ = (ϑ1 , . . . , ϑm ) erhält man, ini=1

i=1

dem man die Stichprobenmomente in die Funktionen der Momente einsetzt; der Schätzer ist also T = (T1 , . . . , Tm ) mit

Zur Bestimmung des Maximums wird die Ableitung nullgesetzt:

Tj := gj (µ̂1 , . . . , µ̂m ) für j ∈ {1, . . . , m}

log L(λ) =

Beispiel: Gegeben seien

n unabhängige Realisierungen

x1 , . . . , xn einer Zufallsvariablen X ∼ P(λ). Es gilt E[X] = λ.

Für die Funktion g1 kann also die Idendität gewählt werden.

Der Momentenschätzer ist somit

SEITE 8

⇒

n

λLH = Pn

i=1

xi

d

n

Aus dλ

2 L(λ) = − λ2 < 0 für λ > 0 folgt, dass es sich auch

tatsächlich um ein Maximum handelt.

2

n

λMM = µ̂1 =

n

d

n X

!

log L(λ) = −

xi = 0

dλ

λ i=1

1X

xi = x.

n i=1

1 oder

zumindest das stetige Pendant zur Wahrscheinlichkeit.

JEROME DOHRAU

WAHRSCHEINLICHKEIT UND STATISTIK

S.4

Tests

S.4.1 Fehler 1. und 2. Art

Fehler 1. Art: Die Hypothese wird zu Unrecht abgelehnt,

S.4 TESTS

Ist dieser Quotient klein, sind die Beobachtungen im Modell

PΘA deutlich wahrscheinlicher als im Modell PΘ0 . Der Verwerfungsbereich K := [0, c) wird so gewählt, dass der Test

das gewünschte Signikanzniveau einhält.

d.h. obwohl sie richtig ist. Die Wahrscheinlichkeit für einen Hinweis: Sind Hypothese und Alternative beide einfach, so

Fehler 1. Art ist

ist der Test optimal (nach Neyman-Pearson-Lemma).

Pϑ [T ∈ K] für ϑ ∈ Θ0 .

Fehler 2. Art: Die Hypothese wird akzeptiert, obwohl sie S.4.4

falsch ist. Die Wahrscheinlichkeit für einen Fehler 2. Art ist

Pϑ [T ∈/ K] = 1 − Pϑ [T ∈ K] für ϑ ∈ ΘA .

S.4.2 Mögliches Vorgehen

z-Test

Seien X1 , . . . , Xn i.i.d.

∼ N (ϑ0 , σ 2 ) unter Pϑ0 mit bekannter Va2

rianz σ . Es soll die Hypothese H0 : ϑ = ϑ0 getestet werden.

Mögliche Alternativen HA sind ϑ > ϑ0 , ϑ < ϑ0 (einseitig)

oder ϑ 6= ϑ0 (zweiseitig). Die Teststatistik ist

Ausgangspunkt ist eine Stichprobe X1 , . . . , Xn in einem MoX n − ϑ0

dell Pϑ mit unbekanntem Parameter ϑ ∈ Θ.

√ ∼ N (0, 1)

T :=

σX / n

1: Aufgrund einer Vermutung, wo sich der richtige Parameter ϑ bendet, werden eine Hypothese Θ0 ⊆ Θ und eine unter dem Modell P . Der Verwerfungsbereich ist von der

ϑ0

Alternative ΘA ⊆ Θ mit Θ0 ∩ ΘA = ∅ formuliert:

Form (c> , ∞), bzw. (−∞, c< ), bzw. (−∞, −c6= ) ∪ (c6= , ∞).

Hypothese H0 : ϑ ∈ Θ0

Zum Beispiel liefert die Bedingung

Alternative HA : ϑ ∈ ΘA

α = Pϑ0 [T ∈ K> ] = Pϑ0 [T > c> ] = 1 − Φ(c> ),

Hinweis: Die Hypotese (bzw. Alternative) heisst einfach,

falls sie nur aus einem einzelnen Wert besteht, also z.B. dass c> = Φ−1 (1 − α), also das (1 − α)-Quantil der N (0, 1)Θ0 = {ϑ0 } (bzw. ΘA = {ϑA }).

Verteilung, sein muss.

2. Es wird eine Teststatistik T = t(X1 , . . . , Xn ) gewählt,

S.4.5 t-Test

wobei t : Rn → R eine geeignete Funktion ist.

3. Es wird ein Signikanzniveau α ∈ (0, 1) gewählt.

4. Ein Verwerfungsbereich K ⊆ R wird konstruiert, so dass Seien X1 , . . . , Xn ∼ N (µ0 , σ 2 ) unter Pϑ wobei ϑ = (µ, σ 2 )

und insbesondere die Varianz σ 2 unbekannt ist. Die Hypothesup Pϑ [T ∈ K] ≤ α.

se H0 : µ = µ0 soll getestet werden. Die

ϑ∈Θ0

Pnunbekannte 2Varianz

1

σ 2 wird durch den Schätzer s2 = n−1

i=1 (Xi − X) (empiDadurch wird die Wahrscheinlichkeit eines Fehlers 1. Art rische Varianz) ersetzt. Danach kann mit der Teststatistik

durch α beschränkt.

5. Die Hypothese wird verworfen, falls der realisierte Wert

X n − µ0

√

∼ tn−1

T :=

t(x1 , . . . , xn ) im Verwerfungsbereich K liegt.

s/ n

i.i.d.

Hinweis: Alternative zu Schritt 4 und 5: Der P-Wert p wird gleich wie beim z-Test vorgegangen werden.

berechnet und die Hypothese verworfen, falls p ≤ α.

P-Wert: Der P-Wert ist die Wahrscheinlichkeit, dass unter S.4.6

Gepaarter Zweistichprobentest

der Nullhypothese H0 ein zufälliger Versuch mindestens so

Seien X1≤i≤n ∼ N (µX , σ 2 ) und Y1≤i≤n ∼ N (µY , σ 2 ) unextrem ausfällt, wie der beobachtete Wert t.

ter Pϑ . Falls man eine natürliche Paarbildung zwischen Xi

und Yi hat, lässt der Test zum Vergleich von µX und µY auf

Macht: Die Macht eines Tests ist die Funktion

eine Stichprobe zurückführen:

β : ΘA → [0, 1], ϑ 7→ β(ϑ) := Pϑ [T ∈ K].

i.i.d.

Das Maximieren der Macht β(ϑ) entspricht dem Minimieren

der Wahrscheinlichkeit für einen Fehler 2. Art 1 − β(ϑ) =

Pϑ [T ∈/ K] für ϑ ∈ ΘA .

S.4.3 Likelihood-Quotienten Test

i.i.d.

i.i.d.

Zi := Xi − Yi ∼ N (µx − µy , 2σ 2 )

S.4.7 Ungepaarter Zweistichprobentest

Seien X1≤i≤n ∼ N (µX , σ 2 ) und Y1≤i≤m ∼ N (µY , σ 2 )

Als Teststatistik wird der Likelihood-Quotient R gewählt, wo- unter Pϑ2.

a) Ist σ bekannt, so ist die Teststatistik

bei L die Likelihood-Funktion ist:

sup L(x1 , . . . , xn | ϑ)

T := R(x1 , . . . , xn ) :=

ϑ∈Θ0

sup L(x1 , . . . , xn | ϑ)

ϑ∈ΘA

SEITE 9

i.i.d.

T :=

i.i.d.

(X n − Y m ) − (µX − µY )

q

∼ N (0, 1).

1

σ n1 + m

JEROME DOHRAU

WAHRSCHEINLICHKEIT UND STATISTIK

b) Ist σ2 unbekannt, berechnet man

1

((n − 1)s2X + (m − 1)s2Y )

m+n−2

s2 :=

A.2 REIHEN UND INTEGRALE

Bei den folgenden Integralen wurden die Integrationskonstanten weggelassen.

R

und wählt für die Teststatistik

R

R

(X n − Y m ) − (µX − µY )

q

∼ tn+m−2

1

s n1 + m

T :=

S.4.8 Kondenzbereiche

(ax + b) dx

R 1

x dx

R 1

ax+b dx

R 1

x2 +a2 dx

proben X1 , . . . , Xn ist eine Menge C(X1 , . . . , Xn ) ⊆ Θ. In

den meisten Fällen ist das ein Intervall, dessen Endpunkte

von X1 , . . . , Xn abhängen.

C heisst ein Kondenzbereich zum Niveau 1 − α, falls gilt

R

R

Pϑ [ϑ ∈ C(X1 , . . . , Xn )] ≥ 1 − α

A.1

R

geordnet

mit zurücklegen

ohne zurücklegen

n

ungeordnet

n+k−1

k

n

k

n!

(n−k)!

k

Reihen und Integrale

Pn

k

=

k2

=

n(n+1)

2

n(n+1)(2n+1)

6

k

k=0 a0 q

P∞

k

k=0 a0 q

P∞ k

k=0 ak

=

a0 1−q

1−q

=

=

a0

1−q

a

(a−1)2 ,

xk

k=0 k!

=

ex

k=1

Pn

k=1

=

log|x|,

=

1

a

1

a

=

eax dx =

xeax dx =

Pn

P∞

a 6= −1

c+1

+ b)

arctan xa

1 ax

ae

eax

a2 (ax

2

x

a

− 1)

2x

a2

eax

R

log|x| dx =

x(log|x| − 1)

−

+

2

a3

x(loga |x| − loga e)

xa+1

1

a+1 log x − a+1 ,

1

2

c 6= −1

log|ax + b|

x2 eax dx =

loga |x| dx =

,

x 6= 0

R

xa log x dx =

R 1

x log x dx =

Ziehen von k Elementen aus einer Menge mit n Elementen

A.2

=

R

Kombinatorik

ax

1

a+1

,

a+1 x

1

a(c+1) (ax

xa dx =

c

Kondenzbereich: Ein Kondenzbereich für ϑ zu den Stich-

Anhang

a dx =

log2 x,

R

sin(ax + b) dx =

− a1 cos(ax + b)

R

cos(ax + b) dx

R

tan x dx

R 1

sin x dx

R 1

cos x dx

R

sin2 x dx

R

cos2 x dx

R

tan2 x dx

=

1

a

=

− log|cos x|

=

log|tan x2 |

=

log|tan( x2 + π4 )|

=

=

1

2 (x

1

2 (x

=

tan x − x

dx =

log|f (x)|

a 6= −1, x > 0

x>0

sin(ax + b)

− sin x cos x)

+ sin x cos x)

n+1

R

f 0 (x)

f (x)

|a| > 1

Partielle Integration:

Z

b

a

b

f 0 (x)g(x)dx = [f (x)g(x)]a −

Z

b

f (x)g 0 (x)dx

a

Substitutionsregel:

Z

b

0

f (g(x))g (x)dx

a

SEITE 10

t=g(x)

Z

g(b)

=

f (t)dt

g(a)

JEROME DOHRAU