Statistik IV

Werbung

Statistik IV

Modul P8: Grundlagen der Statistik II

Vorlesung P8.1: Wahrscheinlichkeitstheorie

und Inferenz II

Prof. Dr. Torsten Hothorn

Institut für Statistik

Ludwig–Maximilians–Universität München

LATEX-Satz von Dipl.-Stat. Andreas Böck

Korrekturen von Dipl.-Math. Michael Kobl, MSc. und

den Hörern der Vorlesungen im SS 08, 09, 10 und 11.

20. März 2012

Inhaltsverzeichnis

1 Grundlagen des statistischen Schließens

1.1 Grundbegriffe und Problemstellung . . .

1.2 Schätzer und ihre Eigenschaften . . . . .

1.3 Exponentialfamilien . . . . . . . . . . . .

1.4 Invariante Verteilungsfamilien . . . . . .

1.5 Suffizienz . . . . . . . . . . . . . . . . .

1.6 Die Fisher-Information . . . . . . . . . .

.

.

.

.

.

.

2

2

5

10

19

21

24

2 Punktschätzungen

2.1 Maximum-Likelihood-Schätzung . . . . . . . . . . . . . . . . . . . . . . . .

2.2 M-Schätzung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

30

47

3 Inferenzkonzepte

3.1 Parametertests . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.2 Wald-, Likelihood-Quotienten- und Score-Test . . . . . . . . . . . . . . . .

3.3 Bayes-Inferenz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

52

52

60

65

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Kapitel 1

Grundlagen des statistischen

Schließens

1.1

Grundbegriffe und Problemstellung

Stochastik stellt Modelle für Experimente zur Verfügung

(Ω1 , F1 , P)

Wahrscheinlichkeitsraum

(Ω2 , F2 )

Meßraum

X1 : Ω1 → Ω2

Zufallsvariable

(F1 -F2 meßbar)

−1

PX1 = P X1 (A) ∀A ∈ F2 Verteilung von X1

Statistik sucht ein Modell für ein Experiment

n

oder

Ω

2n

R

oder

X = (X1 , ..., Xn ) : Ω1 → X =

∞

R

oder

...

PX = P (X −1 (A)) ∀A ∈ σ(X ) Verteilung

(X , σ(X ), PX )

Wahrscheinlichkeitsraum

Aber: PX ist in der Statistik nicht bekannt. Dafür aber Beobachtungen aus X( Daten“)

”

Grundproblem: Wie kann ich aus Daten auf PX schließen?

Diese Vorlesung basiert auf Material aus Rüger (1999); Lehmann (2001) und Held (2008).

Definition 1.1 (Beobachtung, Stichprobe)

Ist ω

b ∈ Ω1 ein beobachtetes Elementarereignis, so heißt x = X(b

ω ) = (X1 (b

ω ), . . . , Xn (b

ω )) eine Stichprobe vom Stichprobenumfang n mit Beobachtungen x1 = X1 (b

ω ), . . . , xn = Xn (b

ω ).

2

1.1. GRUNDBEGRIFFE UND PROBLEMSTELLUNG

3

Bemerkung. Xi und Ω2 selbst dürfen mehrdimensional sein!

Bemerkung. Sind X1 , . . . , Xn u.i.v. , so auch x1 , . . . , xn u.i.v.

Definition 1.2 (Verteilungsannahme)

Sei PX,I eine Menge von Verteilungen, die für die Zufallsvariable X im Prinzip in Betracht

kommen:

PX,I = {PX,i | i ∈ I} .

Dann heißt PX,I Verteilungsannahme.

Definition 1.3 (Parameter, Parameterraum)

Sei Θ ⊆ Rk und g : Θ → PX,I bijektiv mit PX,ϑ = g(ϑ) für ϑ ∈ Θ. Dann heißt ϑ

Parameter der Verteilung PX,ϑ , g heißt Parametrisierung von PX,I (=: PX,Θ ) und PX,Θ

heißt k-parametrige Verteilungsannahme mit Parameterraum Θ.

Bemerkung.

PX,Θ = {PX,ϑ | ϑ ∈ Θ}

Definition 1.4 (Stichprobenraum, statistischer Raum)

(X , σ(X ), PX,Θ ) heißt statistischer Raum, (X , σ(X )) heißt Stichprobenraum.

Beispiel 1.1 (Qualitätskontrolle)

N Glühbirnen im Lager, ϑ = P(Glühbirne defekt) ∈ [0, 1] unbekannt

Ω = {OK, defekt}N

F = P(Ω)

X : Ω1 → {0, 1}n

n<N

ω = (ω1 , . . . , ωN ) 7→ (Idefekt (ωi1 ), . . . , Idefekt (ωin )) =: x

Q

PX,Θ = { i B(1, ϑ) | ϑ ∈ Θ = [0, 1]}

({0, 1}n , P ({0, 1}n ) , PX,Θ )

statistischer Raum

x = (x1 , . . . , xn ) = X(ω̂) = X(b

ω1 , . . . , ω

b )

| {z N}

|

{z

}

Stichprobe vom

Umfang n<N

N -Tupel von

Glühbirnen

im Lager

Frage: Wie kann ich von x auf ϑ schließen?

Bemerkung. Für (Rn , B n , PX,Θ ) gilt einfacher PX,Θ = {FX (x; ϑ) | ϑ ∈ Θ} mit Verteilungsfunktionen FX (x; ϑ) bzw. PX,Θ = {fX (x; ϑ) | ϑ ∈ Θ} mit Dichten; (deren Existenz vorausgesetzt).

PX,Θ heißt stetig parametrisiert, wenn FX (x; ϑ) bzw. fX (x; ϑ) in ϑ ∈ Θ stetig sind. Ansonsten heißt PX,Θ nichtparametrisch.

1.1. GRUNDBEGRIFFE UND PROBLEMSTELLUNG

4

Beispiel 1.2 (Angeln)

Wie oft muß die Angel ausgeworfen werden, bis ein Fisch anbeißt?

Ω1 = {0, 1}∞

X : Ω1 → N

ω 7→ X(ω) = Stelle der ersten 1“ in ω.

”

PX,Θ = {f (x; ϑ) = ϑ(1 − ϑ)x−1 | ϑ ∈ [0, 1]}

Familie von geometrischen Verteilungen

E(X) = ϑ1

ein kleines ϑ spricht für wenig Fische im See.

Beispiel 1.3 (Augeninnendruck)

N = 10.000 gesunde Rekruten

Y ∼ N (µ, σ 2 ) beschreibt Augeninnendruck

für jeden der N Rekruten.

2 y−µ

1

1

2

fY (y; µ, σ ) = √2πσ exp − 2 σ

Stichprobe vom Umfang n < N

X = (X1 , . . . , Xn ) mit Xi = Y i = 1, . . . , n

ϑ = (µ, σ 2 ) ∈ Θ = R × R+ \ {0} Parameterraum

n

Y

fX (x; µ, σ 2 ) =

fY (xi ; µ, σ 2 )

i=1

=

1

√

2πσ

n

PX,Θ = {fX (x; µ, σ 2 ) | ϑ = (µ, σ 2 ) ∈ Θ}

Betrachte

n

1X

exp −

2 i=1

xi − µ

σ

2 !

Familie von Normalverteilungen.

n

x̄ =

1X

xi

n i=1

und

n

s

Es gilt:

1 X

(xi − x̄)2

=

n − 1 i=1

2

n

X

(xi − µ)2 = (n − 1)s2 + n(x̄ − µ)2

i=1

Damit:

2

fX (x; µ, σ ) =

1

√

2πσ

n

1

2

2

exp − 2 (n − 1)s + n(x̄ − µ)

2σ

hängt nun noch von s2 und x̄ , aber nicht mehr von x1 , . . . , xn ab!

1.2. SCHÄTZER UND IHRE EIGENSCHAFTEN

5

Bemerkung. Die zentralen Fragen des statistischen Schließens (statistische Inferenz) von

einer Stichprobe x auf die Verteilung PX,ϑ der zugehörigen Zufallsvariable X sind:

1. Welche Verteilungsannahme PX,Θ ist überhaupt angemessen?

2. Wie soll ein Verfahren aussehen, welches von den Realisierungen auf die unbekannte

Verteilung schließt?

3. Wie gut ist ein solches Verfahren?

4. Welches ist das beste Verfahren? (gibt es sowas überhaupt?)

1.2

Schätzer und ihre Eigenschaften

Definition 1.5 (Stichprobenfunktion, Statistik)

Eine meßbare Funktion t : X → Rk heißt Stichprobenfunktion oder Statistik.

Bemerkung. Üblicherweise X = Rn und k < n.

Beispiel 1.4 X ∼ Nn (µ, σ 2 In )

t : Rn → R2

n

1 X

1 X

2

x 7→ t(x) =

xi ,

(xi − x̄)

|n {z } n − 1 i=1

|

{z

}

=:x̄

=:s2

X ∼ B(n, p)

t:R→R

x 7→ t(x) = x/n

Definition 1.6 (Schätzen, Schätzfunktion, Schätzwert)

Sei Θ ⊆ Rk und t : X → Rk eine Statistik. Dann heißt t Schätzer oder Schätzfunktion für

ϑ ∈ Θ und ϑb = t(x) heißt Schätzwert für ϑ ∈ Θ.

Bemerkung. t(x) ist eine Realisation der Zufallsvariable t ◦ X = t(X).

Beispiel 1.5

X ∼ Nn (µ, σ 2 In )

t : Rn → R

n

P

x 7→ t(x) = n1

xi

i=1

x̄ = t(x) ist Realisation von X̄ =

µ

b = t(x) = x̄.

1

n

P

Xi und (hoffentlich ein guter) Schätzer für µ, also

1.2. SCHÄTZER UND IHRE EIGENSCHAFTEN

6

Bemerkung. ϑb = t(x) muß nicht notwendigerweise Element von Θ ⊂ Rk sein; ϑb ∈

/ Θ ist

erlaubt!

Definition 1.7 (parametrische Funktion)

Eine Abbildung g : Θ → Rl heißt parametrische Funktion.

Definition 1.8

Sei Θ ⊆ Rk , g : Rk → Rl eine parametrische Funktion und t : X → Rl eine Statistik. Dann

d = t(x) dessen Schätzwert.

ist t ein Schätzer für g(ϑ) und g(ϑ)

Definition 1.9 (Erwartungstreue, Verzerrung)

Sei T = t ◦ X und t ein Schätzer für g(ϑ). Dann heißt

bg (ϑ) = Eϑ (T ) − g(ϑ)

R

die Verzerrung (engl. bias) von t, wobei Eϑ (T ) = t dPX,ϑ . Falls bg (ϑ) = 0, also Eϑ (T ) = g(ϑ),

so heißt t erwartungstreu oder unverzerrt (engl. unbiased) für g(ϑ).

Beispiel 1.6

X1 , . . . , Xn mit Xi ∼ N (µ, σ 2 ) u.i.v.

X̄ ist erwartungstreu für µ, denn

Eϑ (X̄) =

T1 =

1

n−1

n

P

1

nEµ (Xi ) = µ

n

(Xi − X̄)2 ist erwartungstreu für σ 2 , denn

i=1

n

P

(Xi − µ)2 = (n − 1)T1 + n(X̄ − µ)2

i=1

⇒

n · σ2

2

⇒ n · σ 2 − nσn

⇒

σ2

T2 =

1

n

P

= (n − 1)E(T1 ) + n ·

= (n − 1)E(T1 )

= E(T1 )

σ2

n

(Xi − X̄)2 ist verzerrt, denn

1

(n − 1) E

E(T2 ) =

n

|

=

n−1 2

σ

n

1 X

2

(Xi − X̄)

n−1

{z

}

E(T1 )=σ 2

1.2. SCHÄTZER UND IHRE EIGENSCHAFTEN

7

mit bias

n−1 2

σ − σ2

n

1

= − σ2

n

Eϑ (T2 ) − g(ϑ) =

Beispiel 1.7 (einfaktorielle Varianzanalyse)

Auf 2n Feldern wird Getreide angebaut, jeweils auf n Feldern mit Düngemittel A und

Düngemittel B.

Xi,j : Erträge auf Feld i = 1, . . . , n für Düngemittel j ∈ {A, B}

Verteilungsannahme für X = (X1,A , . . . , Xn,A , X1,B , . . . , Xn,B )

n

n

Q

Q

PX,Θ =

fXi,A (xi,A ; µA , σ 2 ) fXi,B (xi,B ; µB , σ 2 ) |

i=1

i=1

2

+

+

+

ϑ = (µA , µB , σ ) ∈ Θ = R × R × R

mit fX (x; µ, σ 2 ) Dichte von N (µ, σ 2 )

ϑ = (µA , µB , σ 2 ) selbst ist uninteressant. Wichtig ist g(ϑ) = µB − µA

(sog. Kontrast“)

”

Beispiel 1.8

X1 , . . . , X n

Xi ∼ G(p) u.i.v.

n

P

t(x) = n1

xi = x̄

i=1

E (t(X)) = n1 n · E(Xi ) = p1

Es folgt nicht: E X̄ −1 = p

Jedoch:

P

X̄ −→

1

p

(GdgZ) und mit Satz 9.7

P

X̄ −1 −→ p

Definition 1.10 (Schätzverfahren)

Für n ∈ N sei jeweils tn : Rn → Rl eine Schätzfunktion für g(ϑ). Dann heißt die Menge

{tn | n ∈ N} Schätzverfahren für g(ϑ).

Beispiel 1.9

n

P

tn = n1

xi

i=1

Definition 1.11 (asymptotisch erwartungstreu, Konsistenz)

Sei X n = (X1 , . . . , Xn ), eine Folge von Stichproben, PX n ,Θ die Verteilungsannahme, ϑ ∈ Θ

und g eine parametrische Funktion, sowie {tn | n ∈ N} ein Schätzverfahren. Dann heißt die

Folge von Zufallsvariablen Tn = tn ◦ X n , n ∈ N

1.2. SCHÄTZER UND IHRE EIGENSCHAFTEN

8

asymptotisch erwartungstreu für g(ϑ) :⇔

lim Eϑ (Tn ) = g(ϑ) ∀ϑ ∈ Θ

n→∞

schwach konsistent für g(ϑ) :⇔

P

Tn → g(ϑ)

stark konsistent für g(ϑ) :⇔

f.s.

Tn → g(ϑ)

Beispiel 1.10

X n = (X1 , . . . , Xn ) stu Xi ∼ B(1, p)

n

P

Xi = X̄n

tn (X1 , . . . Xn ) = n1

i=1

P

P

Tn = n1

Xi → p

(schwaches GdgZ)

und sogar

f.s.

Tn → p

(starkes GdgZ)

Also: Der Mittelwert ist ein stark konsistenter Schätzer für den Anteilswert p.

Beispiel 1.11

X n = (X1 , . . . , Xn ) stu E(Xi ) = µi , V(Xi ) = σi2

n

n

P

P

tn (x1 , . . . , xn ) =

wi xi mit

wi µi =: µ ∀n.

i=1

i=1

Ist Tn = tn ◦ X n konsistent für µ ?

n

n

P

P

E(Tn ) =

wi E(Xi ) =

w i µi = µ

i=1

i=1

V(Tn ) = E (Tn − E(Tn ))2 = E (Tn − µ)2

n

n

X

X

2

=

wi V(Xi ) =

wi2 σi2

i=1

Hinreichend:

i=1

V(Tn ) = E ((Tn − µ)2 ) → 0 für n → ∞

2

⇔ Tn → µ

P

⇒ Tn → µ

(9.2c)

Falls Xi ∼ N (µi , σi2 ) gilt:

P

Tn ∼ N (µ, τn2 ) mit τn2 = wi2 σi2

und dann ist obige Bedingung sogar notwendig (Beispiel 9.4).

Satz 1.12

Sei t : Rn → R ein Schätzer für ϑ ∈ Θ ⊂ R. Dann gilt:

Pϑ (|t(X) − ϑ| < ) ≥ 1 −

1

2

E

(t(X)

−

ϑ)

ϑ

2

1.2. SCHÄTZER UND IHRE EIGENSCHAFTEN

9

Der Ausdruck Eϑ ((t(X) − ϑ)2 ) := MSE(t, ϑ) heißt mittlerer quadratischer Fehler (mean

squared error).

Beweis. weiss

Satz 7.14 mit Y = t(X) − ϑ und n = 2, Gegenereignis.

Bemerkung. Pϑ (|t(X) − ϑ| < ) wird dann groß, wenn MSE(t, ϑ) klein wird.

Definition 1.13

Seien t1 : Rn → R und t2 : Rn → R Schätzer für ϑ ∈ Θ ⊂ R. Dann heißt t1 mindestens so

gut wie t2 , wenn gilt

MSE(t1 , ϑ) ≤ MSE(t2 , ϑ) ∀ϑ ∈ Θ

Satz 1.14 (Bias-Varianz-Zerlegung)

MSE(t, ϑ) = Vϑ (t(X)) + (Eϑ (t(X)) − ϑ)2

{z

}

|

bias b(t,ϑ)

Beweis. weiss

MSE(t, ϑ)

=

kreative 0

Eϑ (t(X) − ϑ)2

=

Eϑ (t(X) − Eϑ (t(X)) + Eϑ (t(X) − ϑ))2

Eϑ (t(X) − Eϑ (t(X)))2 + (Eϑ (t(X)) − ϑ)2

=

Vϑ (t(X)) + b(t, ϑ)2

=

Bemerkung. Für einen erwartungstreuen Schätzer gilt

MSE(t, ϑ) = Vϑ (t(X))

Das heißt, der beste erwartungstreue Schätzer ist derjenige mit der kleinsten Varianz. Dies

ist ein wichtiges Gütekriterium für die Beurteilung und den Vergleich von Schätzern.

1.3. EXPONENTIALFAMILIEN

10

Beispiel 1.12

X = (X1 , . . . , Xn ) u.i.v. Xi ∼ N (µ, σ02 ) , σ02 bekannt

t1 (X) = X̄ erwartungstreu mit mittlerem quadratischen Fehler MSE(t1 , µ) = Eµ (X̄ − µ)2 =

σ2

V(X̄) = n0

Sei t2 ein weiterer erwartungstreuer Schätzer für µ, also

n

P

t2 (X) =

wi Xi mit

i=1

Eµ (t2 (X)) = Eµ

X

w i Xi = µ

X

!

wi = µ

X

⇔

wi = 1

Dann gilt:

P

V(t2 (X)) = σ02 · wi2

Sei ∆i = wi − n1 mit

P

P

P1

∆i = wi −

=1−1=0

n

1

Dann wi = ∆i + n und

V(t2 (X)) = σ02

=

=

=

=

X

wi2

2

X

1

2

σ0

∆i +

n

X

1

2

2

2

σ0

∆i + ∆i + 2

n

n

1

X 2 2 X

σ02

∆i +

∆i +

n | {z } n

=0

1 X 2

∆

σ02 +

n | {z }i

≥0

≥

σ02

n

⇒ t2 ist nicht besser als t1 und somit ist t1 optimal (unter allen linearen erwartungstreuen

Schätzern).

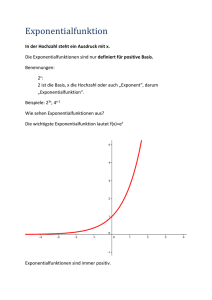

1.3

Exponentialfamilien

Definition 1.15 (Exponentialfamilie)

Eine Verteilungsfamilie PX,Θ = {f (x; ϑ) | ϑ ∈ Θ} (d.h., die Dichten existieren) heißt

1.3. EXPONENTIALFAMILIEN

11

k-parametrige Exponentialfamilie, wenn sich die Dichten f (x; ϑ) bzgl. (des oder eines geeigneten dominierenden Maßes) ν auf die folgende Gestalt bringen lassen:

!

k

X

f (x, ϑ) = c(ϑ) b(x) exp

γj (ϑ) tj (x)

j=1

mit

tj : X → R t = (t1 , . . . , tk )

b : X → R+

)

meßbar

und

γj : Θ → R γ = (γ1 , . . . , γk )

c : Θ → R+

0

γ = γ(ϑ) heißt natürlicher Parameter dieser Exponentialfamilie mit natürlichem Parameterraum γ(Θ) = {γ(ϑ) | ϑ ∈ Θ} ⊆ Rk .

Satz 1.16

Folgende Verteilungsfamilien sind Exponentialfamilien:

a) {Exp(λ) | λ > 0}

Exponentialverteilung

b) {B(1, p) | p ∈ [0, 1]}

Bernoulliverteilung

c) {B(n, p) | p ∈ [0, 1]}

Binomialverteilung

d) {P (λ) | λ > 0}

Poissonverteilung

e) {N (µ, σ02 ) | µ ∈ R}

f) {N (µ0 , σ 2 ) | σ 2 > 0}

Normalverteilung

Normalverteilung

Beweis. weiss

a)

f (x; λ) = |{z}

λ exp(|{z}

−λ |{z}

x ) I(0,∞) (x)

| {z }

c(λ)

γ(λ)

t(x)

b(x)

1.3. EXPONENTIALFAMILIEN

12

b)

f (x; p) = px (1 − p)1−x I{0,1} (x)

p

= (1 − p) I{0,1} exp(|{z}

x log

)

| {z } | {z }

1−p

t(x) |

{z

}

c(p)

b(x)

γ(p)

c)

n x

f (x; p) =

p (1 − p)n−x I{0,1,...,n} (x)

x

n

p

= (1 − p)

I{0,1,...,n} (x) exp |{z}

x log

| {z } x

1−p

t(x) |

|

{z

}

{z

}

c(p)

n

b(x)

γ(p)

x x

p

p

p

=

denn exp x log

= exp log

1−p

1−p

1−p

d)

f (x; λ) =

λx

exp(−λ) IN (x)

x!

1

= exp(−λ) IN (x) exp |{z}

x log(λ)

| {z } |x! {z }

| {z }

t(x)

c(λ)

γ(λ)

b(x)

e)

f (x; µ, σ02 )

1 (x − µ)2

1

exp −

=√

2 σ02

2πσ0

1

1

2

2

=√

exp − 2 (x − 2xµ + µ )

2σ0

2πσ0

x

1

x2

µ2

exp − 2 exp − 2 exp 2 µ

=√

|{z}

2σ

2σ

σ

0

2πσ0

0

|{z} γ(µ)

|

{z

}|

{z 0 }

b(x)

f) HA.

c(µ)

t(x)

1.3. EXPONENTIALFAMILIEN

13

Bemerkung. b(x) ist der einzige Faktor, der unabhängig von ϑ Null werden kann → alle

PX,ϑ haben denselben Träger.

Satz 1.17

Sei PX,ϑ = f (·; ϑ) ν Maß mit Dichte f in Exponentialform bzgl. ν (in der Regel ν = λ

R

oder ν = µz ). Sei nun ν̃(B) := B b(x) dν(x) (B ⊆ X ) (also ν̃ = b ν) , dann gilt

PX,ϑ = f˜ ν̃

wobei

f˜(x, ϑ) = c(ϑ) exp(γ(ϑ)> t(x))

bzw. mit γ0 (ϑ) = log(c(ϑ))

f˜(x, ϑ) = exp(γ0 (ϑ) + γ(ϑ)> t(x))

Beweis. weiss

PX,ϑ = f ν

ν̃ = b ν

Z

⇒ PX,ϑ (B)

f dν

=

ZB

=

ZB

=

c(ϑ) b(x) exp(t(x)> γ(ϑ)) dν(x)

c(ϑ) exp(t(x)> γ(ϑ))b(x) dν(x)

B

Lemma

3.28

StatIII

=

Z

c(ϑ) exp(t(x)> γ(ϑ)) dν̃(x)

{z

}

B|

=:f˜(x,ϑ)

Definition 1.18

Eine Exponentialfamilie heißt strikt k-parametrig, wenn ihre Dichten in der Form von Def.

1.15 oder Satz 1.17 darstellbar sind, und zusätzlich die Funktionen t0 ≡ 1, t1 , . . . , tk sowie

γ0 ≡ 1, γ1 , . . . , γk linear unabhängig sind (außer auf Nullmengen).

1.3. EXPONENTIALFAMILIEN

14

Satz 1.19

Sei X1 : Ω1 → R und PX1 ,Θ eine k-parametrige Exponentialfamilie mit Funktionen c, b, γ

und t. Dann gilt: PX,Θ mit X = (X1 , . . . , Xn ) u.i.v. ist ebenfalls k-parametrige Exponentialfamilie mit Funktionen

cn (ϑ) = c(ϑ)n

bn (x1 , . . . , xn ) =

n

Y

b(xi )

i=1

γn (ϑ) = γ(ϑ)

tn (x1 , . . . , xn ) =

n

X

( t1 (xi ), . . . , tk (xi ) )

i=1

Beweis. weiss

fX (x, ϑ)

u.i.v.

=

n

Y

fXi (xi , ϑ)

i=1

=

n

Y

!

c(ϑ) b(xi )

exp

i=1

=

c(ϑ)n

n

X

!

γ(ϑ)> t(xi )

i=1

n

Y

!

b(xi )

exp γ(ϑ)> tn (x)

i=1

Beispiel 1.13

X = (X1 , . . . , Xn ) Xi ∼ N (µ, σ02 )

⇒ PX,Θ = {Nn (µ, σo2 I) | µ ∈ R}

ist eine einparametrige Exponentialfamilie mit

n

P

2

n

(x

−

µ)

1 i=1 i

1

fX (x; µ, σ02 ) = √

exp

−

2

2

σ0

2πσ0

=

n

Y

|i=1

n

P x

1

x2i

µ2

i

√

exp − 2 exp − 2

exp 2 µ

|{z}

2σ0

2σ

σ0

2πσ0

| {z } γ(µ)

{z 0 }

{z

}|

bn (x)

cn (µ)

tn (x)

1.3. EXPONENTIALFAMILIEN

15

Beispiel 1.14

PX,Θ = {Nn (µ, σ 2 In ) | µ ∈ Rn , σ 2 ∈ R+ }

ϑ = (µ, σ 2 )

2

fX (x; µ, σ ) =

1

√

2πσ

n

1

exp

− 2

n

P

2

(xi − µ)

σ2

i=1

n

1

1

2

2

exp − 2 (n(x̄ − µ) + (n − 1)s )

= √

2σ

2πσ

n

X

µ

1 X 2

n µ2

1

√

xi − 2

xi

exp − 2 exp

=

2σ

σ2

2σ

σ 2π

P P

mit γ(ϑ) = σµ2 , − 2σ1 2 und t(x) = ( xi , x2i )

Definition 1.20 (natürliche Parametrisierung)

Sei γ = γ(ϑ) und c̃(γ) derart, daß gilt:

c̃(γ) = c(ϑ).

Dann heißt die k-parametrige Exponentialfamilie in kanonischer Form dargestellt mit Dichte

f˜(x; γ) = c̃(γ) exp(γ > t(x))

bezüglich ν̃.

R

Bemerkung. Sei ω(γ) = exp(γ > t(x)) dν̃(x) < ∞. Dann kann f˜ zu einer ν̃-Dichte umgeschrieben werden mit c̃(γ) = ω(γ)−1 . Der natürliche Parameterraum Γ ⊆ Rk besteht aus

allen γ ∈ Rk , für die dies möglich ist.

Satz 1.21

Der natürliche Parameterraum ist konvex.

Beweis. weiss

Sei γ und γ ∗ ∈ Γ. z.z.: αγ+(1−α)γ ∗ ∈ Γ. Dies ist der Fall, wenn exp (αγ + (1 − α)γ ∗ )> t(x)

sich zu einer Dichte bzgl. ν̃ normieren läßt, also wenn das entsprechende Integral endlich

1.3. EXPONENTIALFAMILIEN

16

ist:

Z

exp (αγ + (1 − α)γ ∗ )> t(x) dν̃(x) =

Z

= exp αγ > t(x) exp (1 − α)γ ∗ > t(x) dν̃(x)

= exp αγ > t(x) exp (1 − α)γ ∗ > t(x) 1

Hölder >

∗>

≤ exp αγ t(x) p exp (1 − α)γ t(x) q

1

p= α

1

q= 1−α

=

Z

1−α

α Z

1

(1−α)· 1−α

α· α1

∗>

dν̃(x)

exp γ t(x)

dν̃(x)

exp γ t(x)

1−α

α

>

Z

>

exp γ t(x) dν̃(x)

|

{z

}

<∞

da γ∈Γ

<∞

Z

>

∗

exp γ t(x) dν̃(x)

|

{z

}

<∞

da γ ∗ ∈Γ

⇒ αγ + (1 − α)γ ∗ ∈ Γ ⇔ Γ konvex

Bemerkung.

Z

Eϑ g(X)

=

γ=γ(ϑ)

=

Z

g dPX,ϑ =

Z

g(x)fX (x; ϑ) dν(x)

g(x)f˜X (x, γ) dν̃(x) = Eγ g(X)

und h(γ) = Eγ g(X) ist beliebig oft nach γ unter Vertauschung von Integration und Differentiation differenzierbar.

Satz 1.22

Sei PX,Θ eine k-parametrige Exponentialfamilie in γ und T = t(X). Dann bildet PT,Θ

ebenfalls eine k-parametrige Exponentialfamilie in γ und der Identität.

Beweis. weiss

1.3. EXPONENTIALFAMILIEN

17

PT,ϑ (A)

Bildmaß,

siehe Def.

5.1,5.2

PX,ϑ t−1 (A)

∀A ∈ B k

Z

f˜(x; ϑ) dν̃(x)

=

=

t−1 (A)

Z

c̃(γ) exp γ > t(x) dν̃(x)

=

t−1 (A)

Z

Subst.

c̃(γ) exp(γ > t) dν̃T (t)

{z

}

|

=

A

f˜(t,γ)

Dichte von PT,ϑ

mit ν̃T (A) = ν̃(t−1 (A)) ∀A ∈ B k (Bildmaß).

Satz 1.23

Sei PX,Θ eine k-parametrige Exponentialfamilie in γ und T = t(X). Dann besitzt die

Statistik T Momente beliebig hoher Ordnung, diese sind als Funktion von γ beliebig oft

nach γ differenzierbar; die Ableitungen dürfen durch Differentiation unter dem betreffenden

Integral gebildet werden.

Beweis. weiss

(Skizze)

MT (s) = Eγ exp(s> T )

k

X

exp

= Eγ

!!

sj Tj

j=1

k

X

Z

=

exp

!

sj Tj

f˜T (γ > T ) dν̃T

j=1

Z

= c̃(γ)

k

X

exp

(sj + γj )Tj

!

dν̃T

j=1

vgl. Bemerkung auf Seite 16 wegen Differentierbarkeit

c̃(γ)

=

c̃(γ + s)

Z

c̃(γ + s) exp

c̃(γ)

c̃(γ + s)

!

(sj + γj )Tj

dν̃T

j=1

|

=

k

X

{z

=1

}

1.3. EXPONENTIALFAMILIEN

18

Beispiel 1.15 (2-Stichprobenproblem)

X = (X1 , . . . , Xn )

2

Xi ∼ N (µX , σX

) u.i.v.

Y = (Y1 , . . . , Ym )

Yi ∼ N (µY , σY2 ) u.i.v.

Z = (X, Y ) stu

2

Fall A: µX = µY = µ und σX

= σY2 = σ 2

→ zweiparametrige Exponentialfamilie, siehe Beispiel 1.14.

2

Fall B: µX , µY beliebig, σX

= σY2 = σ 2

f (z; µX , µY , σ 2 ) = f (x, y; µX , µY , σ 2 )

!!

n+m

n

m

X

X

1

1

= √

(xi − µX )2 +

(yi − µY )2

exp − 2

2σ

2πσ

i=1

j=1

n+m

2

2

1

µX X

µY X

1 X 2 X 2

nµX + mµY

xi +

yj )

= √

exp

xi + 2

yj − 2 (

exp −

2σ 2

σ2

σ

2σ

2πσ

µX µY

1

γ(ϑ) =

,

,− 2

σ2 σ2

2σ

X X X

X 2

t(z) = t(x, y) =

xi ,

yi ,

xi +

yj2

→ Dreiparametrige Exponentialfamilie.

2

, σY2 beliebig

Fall C: µX = µY = µ und σX

2 X

2 !!

n m

m n yi − µ

1

1 X xi − µ

1

√

+

f (x, y; ϑ) = √

exp −

2 i=1

σX

σY

2πσX

2πσY

j=1

2

ϑ = (µ, σX

, σY2 )

n m

1

mµ2

1

nµ2

√

= √

exp − 2 − 2 ·

2σX

2σY

2πσX

2πσY

X

X

X

µ

µ

1

1 X 2

2

· exp

xi + 2

yj − 2

xi − 2

yj

2

σX

σY

2σX

2σY

µ µ

1

1

γ(ϑ) =

, 2 ,− 2 ,− 2

2

σX

σY

2σ

2σ

X X X Y X

X 2

t(z) = t(x, y) =

xi ,

yj ,

xi ,

yj2

Achtung: ϑ ∈ R3 und γ ∈ R4

Ursache für Behrens-Fisher-Problem“.

”

1.4. INVARIANTE VERTEILUNGSFAMILIEN

19

2

Fall D: µX , µY , σX

, σY2 beliebig

µX µY

1

1

wie unter Fall C mit γ(ϑ) = σ2 , σ2 , − 2σ2 , − 2σ2

X

1.4

Y

X

Y

Invariante Verteilungsfamilien

Beispiel 1.16

XF . . . Temperatur in Fahrenheit

XK . . . Temperatur in Kelvin

XC . . . Temperatur in Celsius

XF = 95 · XC + 32

XC = XK + 273.15

Sinnvoll: Ergebnis der Inferenz sollte nicht von der gewählten Skala abhängen.

Definition 1.24 (Invarianz)

Sei X = (X1 , . . . , Xn ) eine Stichprobe und PX,Θ = {PX,ϑ | ϑ ∈ Θ} die Familie von Verteilungen von X. Sei G eine Klasse von Transformationen des Stichprobenraumes

g : X → X,

wobei g bijektiv und g, g −1 meßbar sind. Dann ist die Verteilung der ZV g(X)

Pg(X),ϑ (B) = PX,ϑ (g −1 (B)) ∀ B ∈ σ(X )

und Pg(X),Θ die zugehörige Verteilungsannahme. Diese heißt invariant gegenüber der Klasse

G von Transformationen , falls

Pg(X),Θ = PX,Θ

∀ g ∈ G.

Beispiel 1.17 (Normalverteilung)

PX,(µ,σ2 ) = N (µ, σ 2 ) | (µ, σ 2 ) ∈ R × R+

ist nach Satz 8.15 invariant gegenüber linearen Transformationen.

Bemerkung. PX,Θ ist genau dann invariant bzgl. G, wenn es zu jedem g ∈ G und ϑ ∈ Θ

0

genau ein ϑ ∈ Θ gibt, so daß PX,ϑ = Pg(X),ϑ0 , d.h. zu jedem g : X → X gibt es ein

0

0

0

g : Θ → Θ , so daß ϑ = g (ϑ).

1.4. INVARIANTE VERTEILUNGSFAMILIEN

20

Beispiel 1.18 (Normalverteilung)

g(x) = bx + a

0

⇒ g (µ, σ 2 ) = (bµ + a, b2 σ 2 )

Beispiel 1.19 (Lokationsfamilie)

X = (X1 , . . . , Xn )

u.i.v. Xi ∼ H

( n

)

Y

PX,Θ =

H(xi , ϑ) | ϑ ∈ Θ

i=1

H(x, ϑ) = H0 (x − ϑ)

| {z }

bekannt

0

Dann ist PX,Θ invariant bzgl. g(x) = x + a. Es folgt: g (ϑ) = ϑ + a.

Beispiel 1.20 (Skalenfamilie)

H(x, ϑ) = H0 (x/ϑ)

PX,Θ invariant bzgl. g(x) = bx.

0

g (ϑ) = bϑ

Beispiel 1.21 (Lokations- Skalen- Familie)

H(x, ϑ) = H0

x−µ

σ

mit ϑ = (µ, σ)

PX,Θ invariant bgzl. g(x) = bx + a.

0

g (ϑ) = (bµ + a, bσ)

Beispiel 1.22 (Permutationsinvarianz, Vertauschbarkeit)

oW

Sei p ∈ Vn,n

; p = (p1 , . . . , pn ) und πp : X → X mit πp (x) = (xp1 , xp2 , . . . , xpn ) eine

Permutation von x.

Dann heißt PX permutationsinvariant bzw. X = (X1 , . . . , Xn ) vertauschbar, wenn gilt

oW

PX = Pπp (X) ∀ p ∈ Vn,n

.

Bemerkung. Vertauschbarkeit ⇐ Unabhängigkeit.

z.B. X = (X1 , . . . , Xn ) ∼ H(n, K, N )

P

X1 , . . . , Xn sind nicht unabhängig, aber vertauschbar, da Verteilung nur über k =

xi

von x abhängt.

1.5. SUFFIZIENZ

1.5

21

Suffizienz

Beispiel 1.23

X = (X1 , . . . , Xn ) u.i.v. Xi ∼ B(1, p)

t : Rn → R x 7→ t(x) = x̄

Welche Information über p enthält x̄ ?

P

Gesucht: Verteilung von X| Xi = k.

Dichtefunktion:

fX| P Xi =k (x1 , . . . , xn |

X

Xi = k)

X

= P(X1 = x1 , . . . , Xn = xn |

Xi = k)

P

P(Xi = xi ∀i = 1, . . . , n; Xi = k)

P

=

P( Xi = k)

P

0

xi 6= k

=

P

k

n−k

−1

np (1−p)

= nk

xi = k

(k )pk (1−p)n−k

⇒ fX| P Xi =k ist unabhängig von p; d.h. nach der Beobachtung von X̄ ist in X keinerlei

Information über p mehr enthalten.

Definition 1.25 (Suffiziente Statistik)

Sei X = (X1 , . . . , Xn ) eine Stichprobe und PX,Θ = {PX,ϑ | ϑ ∈ Θ} eine Verteilungsannahme

sowie t : X → Rk eine Statistik. Dann heißt T = t ◦ X suffizient für PX,Θ (oder einfach für

ϑ), wenn die bedingte Verteilung

PX|T =t(x)

definiert durch

PX|T =t(x) (B) =

P(X −1 (B) ∩ (t ◦ X)−1 (t(x)))

P((t ◦ X)−1 (t(x)))

unabhängig von ϑ ist (deren Existenz vorausgesetzt; dies ist mit X = Rn aber der Fall).

Bemerkung. Es existieren im allgemeinen viele suffiziente Statistiken.

T = X ist suffizient, denn PX|T =t(x) = PX|X=x ist eine Einpunktverteilung mit

PX|X=x (x) = 1

T = X̄ und T =

P

Xi sind suffizient für p im einführenden Beispiel

1.5. SUFFIZIENZ

22

Definition 1.26 (bedingter Erwartungswert)

Seien X und Y Zufallsvariablen mit Randverteilungen PX = fX νX und PY = fY νY

sowie bedingte Verteilungen PX|Y =y = fX|Y =y νX . Dann ist der bedingte Erwartungswert

von g(X) gegeben Y = y als Funktion von y definiert durch

Z

E(g(X)|Y = y) =

g(x) dPX|Y =y (x)

Z

=

g(x)fX|Y =y (x|y) dνX (x)

Bemerkung. Für die meisten praktischen Fälle ist die Definition

fX|Y =y (x|y) :=

fX,Y (x, y)

fY (y)

der bedingten Dichte ausreichend.

Satz 1.27 (Satz vom iterierten Erwartungswert)

EY (EX|Y (X|Y )) = EX (X)

Beweis. weiss

Z

EY (EX|Y (X|Y ))

=

EY

x dPX|Y =y (x)

Z

=

x fX|Y =y (x|y) dνX (x)

EY

Z Z

=

x fX|Y (x|y) dνX (x) fY (y) dνY (y)

Fubini

Z Z

Fubini

Z

=

=

Z

x fX|Y (x|y) fY (y) dνX (x) dνY (y)

Z

x

fX,Y (x, y) dνY (y) dνX (x)

|

{z

}

=

x

=

EX (X)

fX (x) dνX (x)

1.5. SUFFIZIENZ

23

Satz 1.28 (Faktorisierungssatz von Fisher und Neyman)

Sei X = (X1 , . . . , Xn ) eine Stichprobe und PX,Θ = {f (x; ϑ) | ϑ ∈ Θ} eine Verteilungsannahme, so gilt für eine Statistik T = t ◦ X (t : Rn → Rk )

T ist suffizient für ϑ ⇔

g : Θ × Rk → R

∃

h:

Rn → R

)

meßbar

so daß

f (x; ϑ) = g(ϑ, t(x)) h(x).

Beweis. weiss

PX,ϑ = fX (x; ϑ) ν

PT,ϑ = fT (t; ϑ) νT

PX,T,ϑ = fX,T (x, t; ϑ) (ν ⊗ νT )

Dann gilt

fX,T (x, t; ϑ) = fX|T (x|t; ϑ) fT (t; ϑ)

aber auch

fX,T (x, t; ϑ) =

0

falls t 6= t(x)

fX (x; ϑ) falls t = t(x)

⇒ fX (x; ϑ) = fX|T (x|t(x), ϑ) fT (t(x); ϑ)

{z

} | {z }

|

=:g(ϑ,t(x))

=:h(x)

denn für eine suffiziente Statistik t ist fX|T (x|t(x), ϑ) nicht mehr von x abhängig.

Satz 1.29

Sei PX,Θ eine k-parametrige Exponentialfamilie mit Dichten

fX (x; ϑ) = c(ϑ) b(x) exp(γ(ϑ)> t(x))

⇒ t ◦ X ist suffizient für ϑ ∈ Θ.

Beweis. weiss

fX (x; ϑ) = c(ϑ) exp(γ(ϑ)> t(x)) b(x)

|

{z

} |{z}

=:g(ϑ,t(x))

=:h(x)

1.6. DIE FISHER-INFORMATION

1.6

24

Die Fisher-Information

Beispiel 1.24

X = (X1 , . . . , Xn ) Xi ∼ B(1, p) u.i.v.

1

t1 (X) = (X1 + Xn ) Schätzer für E(Xi ) = p

2

t2 (X) = X̄ Schätzer für E(Xi )

1

1

V(t1 (X)) = · 2 · V(X1 ) = V(X1 )

4

2

1

1

V(t2 (X)) = 2 · n · V(Xi ) = V(Xi )

n

n

t1 ist nicht suffizient, t2 schon und enthält daher die gesamte Information von X über

E(X). Aber wie groß ist die Information“ eigentlich?

”

Definition 1.30 (Fisher Regularität)

Sei PX,Θ = {f (x; ϑ) | ϑ ∈ Θ ⊆ R} mit den folgenden Regularitätseigenschaften

R1) Die Dichten f (x; ϑ) existieren (d.h. PX,ϑ = f ν).

R2) Θ ist offenes Intervall.

R3) Der Träger C := {x | f (x; ϑ) > 0} ist unabhängig von ϑ.

R4)

Z

∂f (x; ϑ)

dν(x) =

∂ϑ

Z 2

∂ f (x; ϑ)

dν(x) =

∂ 2ϑ

Z

∂

f (x; ϑ)dν(x) = 0

∂ϑ

Z

∂

∂f (x; ϑ)

dν(x) = 0

∂ϑ

∂ϑ

∀x ∈ C.

Dann heißt die Verteilungsfamilie PX,Θ Fisher-regulär.

Bemerkung. Eine Exponentialfamilie ist i.a. Fisher-regulär, vgl. Bemerkung auf Seite 16.

Definition 1.31 (Scorefunktion)

∂f (x;ϑ)

∂ log f (x; ϑ)

= ∂ϑ

∂ϑ

f (x; ϑ)

heißt Scorefunktion der Beobachtung x und die Zufallsvariable S(ϑ; X) heißt Scorefunktion

der Stichprobe X.

S(ϑ; x) =

1.6. DIE FISHER-INFORMATION

25

Beispiel 1.25

X1 ∼ P (λ)

f˜1 (x1 ; λ) = λx1 exp(−λ)

log f˜1 (x1 ; λ) = x1 log(λ) − λ

∂ log f˜1 (x1 ; λ)

x1

S(λ; x1 ) =

=

−1

∂λ

λ

log f˜1 (x1 ; λ) ist maximal, wenn S(λ; x1 ) = 0 ⇔ λ = x1 (und somit auch f˜1 (x1 ; λ) maximal)

X = (X1 , . . . , Xn ) Xi ∼ P (λ) u.i.v.

f˜(x; λ) =

n

Y

f˜1 (xi ; λ)

i=1

X = exp(−λ)n exp log(λ)

xi

X

log f˜(x; λ) = −nλ + log(λ)

xi

P

∂ log f˜(x; λ)

xi

S(λ; x) =

= −n +

∂λ

λ

P

1

also f˜(x; λ) maximal, wenn S(λ; x) = 0 ⇔ λ = n xi

Satz 1.32

Unter Fisher-Regularität gilt:

Eϑ S(ϑ; X) = 0

Vϑ S(ϑ; X) = −Eϑ

∂

S(ϑ; X)

∂ϑ

Beweis. weiss

Z

Eϑ S(ϑ; X) =

S(ϑ; x) f (x; ϑ) dν(x)

Z

=

∂ f (x, ϑ)

dν(x)

∂ϑ

R4

= 0

Vϑ S(ϑ; X) = Eϑ S(ϑ; X)2

!2

Z

∂ f (x;ϑ)

∂ϑ

=

f (x; ϑ) dν

f (x; ϑ)

Z

Z

∂2

∂2

=

f

(x;

ϑ)

dν

−

log f (x; ϑ) f (x; ϑ) dν

∂ 2ϑ

∂ 2ϑ

1.6. DIE FISHER-INFORMATION

26

∂ f (x;ϑ)

∂f (x;ϑ)

∂

∂

ϑ

(wegen Quotientenregel:

= ∂ϑ ∂ϑ −

∂ϑ f (x; ϑ)

f (x; ϑ)

∂2

=

∂ 2ϑ

Z

Z

f (x; ϑ) dν −

|

{z

}

∂ f (x;ϑ)

∂ϑ

f (x; ϑ)

!2

)

∂

S(ϑ; x)f (x; ϑ) dν

∂ϑ

1

= −Eϑ

∂S(ϑ; X)

∂ϑ

Definition 1.33 (Fisher-Information)

Sei PX,Θ = {f (x; ϑ) | ϑ ∈ Θ} Fisher-regulär und x ∈ C (dem Träger von f ). Dann heißt

I(ϑ; x) := −

∂

S(ϑ; x)

∂ϑ

die Fisher-Information der Beobachtung x über den Parameter ϑ. Der Erwartungswert der

Zufallsvariable I(ϑ; X) heißt Erwartete Fisher-Information IX (ϑ) der Stichprobe X:

IX (ϑ) = Eϑ I(ϑ; X)

∂

= Eϑ −

S(ϑ; X) = Vϑ S(ϑ; X)

∂ϑ

Bemerkung. IX (ϑ) hängt nur von der Verteilung PX,ϑ ab (kann also a priori berechnet

werden), I(ϑ, x) kann erst nach der Beobachtung von X = x betrachtet werden.

Beispiel 1.26

1.6. DIE FISHER-INFORMATION

27

X ∼ B(n, p)

n x

f (x, p) =

p (1 − p)n−x

x

∂

n

S(p; x) =

log

+ x log(p) + (n − x) log(1 − p)

∂p

x

x n−x

=

−

p

1−p

IX (p) = Vp (S(p; X))

X

n−X

= V

−

p

1−p

n

X

X

−

+

= V

p

1−p 1−p

1

1

n

= V X

+

−

p 1−p

1−p

X

= V

p(1 − p)

np(1 − p)

= 2

p (1 − p)2

n

=

p(1 − p)

Satz 1.34

Sei X = (X1 , . . . , Xn ) u.i.v. und IXi (ϑ) die erwartete Fisher-Information von Xi . Dann gilt:

IX (ϑ) =

n

X

IXi (ϑ)

i=1

Beweis. weiss

X1 , X2 u.i.v. ⇒ fX1 ,X2 = fX1 fX2

∂ log(fX1 ,X2 )

∂ϑ

∂ log fX1 ∂ log fX2

=

+

∂ϑ

∂ϑ

= S(ϑ; X1 ) + S(ϑ; X2 )

⇒ S(ϑ; (X1 , X2 )) =

⇒ V(S(ϑ; (X1 , X2 ))) = V(S(ϑ; X1 )) + V(S(ϑ;2 ))

{z

}

|

{z

} | {z }

|

IX1 ,X2 (ϑ)

IX1 (ϑ)

IX2 (ϑ)

1.6. DIE FISHER-INFORMATION

28

Satz 1.35 (Cramèr-Rao-Ungleichung)

Sei PX,Θ Fisher regulär und t : X → R ein erwartungstreuer Schätzer für ϑ ∈ Θ. Falls für

die ZV T = t ◦ X gilt

Cov(T, S(ϑ; X)) = 1

so folgt

Vϑ (T ) ≥

1

.

IX (ϑ)

Beweis. weiss

1

=

Covϑ (T, S(ϑ; X))2

=

Cov(T − ϑ, S(ϑ; X))2

=

Eϑ ((T − ϑ) · S(ϑ; X))2

Hölder mit

p=q=2

⇔

≤

Eϑ ((T − ϑ)2 ) · Eϑ (S(ϑ; X)2 )

=

Vϑ (T ) · IX (ϑ)

1

Vϑ (T ) ≥

IX (ϑ)

Bemerkung.

Ein unverzerrter Schätzer hat keine beliebig kleine Varianz.

Falls V(T ) =

Schätzern.

1

IX (ϑ)

, so ist T minimal varianter Schätzer unter allen erwartungstreuen

Allgemeiner gilt:

IT =t(X) (ϑ) = V(ST (ϑ, T )) ≤ IX (ϑ)

mit =“ genau dann, wenn T suffizient ist (vgl. Rüger, 1999, Seite 98ff).

”

Bemerkung. Für ϑ ∈ Θ ⊂ Rk , k > 1 gilt

∂

∂

S(ϑ; x) = ∂ϑ1 log f (x; ϑ), . . . , ∂ϑk log f (x; ϑ)

Scorevektor ( = Gradientenvektor)

1.6. DIE FISHER-INFORMATION

29

2

I(ϑ; x) = − ∂ϑ∂i ∂ϑj log f (x; ϑ)

i,j=1,...,k

Informationsmatrix“ ( = negative Hessematrix)

”

IX (ϑ) = Eϑ (I(ϑ; X)) heißt Fisher-Informationsmatrix für X bzw. IT (ϑ) für T = t(X).

IX (ϑ) − IT (ϑ) ≥ 0 (psd)

Löwner-Halbordnung

Beispiel 1.27

X = (X1 , . . . , Xn ) Xi ∼ N (µ, σ02 ) u.i.v.

n

1 X

1

2

exp − 2

(xi − µ)

f (x; µ) = √

2σ0

2πσ0

∂ log f (x; µ)

∂µ

2

√

∂

1 X xi − µ

=

− n log( 2πσ0 ) −

∂µ

2

σ0

X

1

n(x̄ − µ)

=

2(xi − µ) =

2

2σ0

σ02

S(µ; x) =

S(µ; X) =

V(S(µ; X)) =

=

=

=

n(X̄ − µ)

σ02

n2

V(X̄)

σ04

n2 1 X

V(Xi )

σ04 n2

1

n · σ02

σ04

n

σ02

= IX (µ)

und (da X̄ e-treu ist) gilt

V(X̄) =

σ02

1

1

=

= n

n

IX (µ)

σ2

0

⇒

X̄ ist minimalvarianter Schätzer für µ.

Kapitel 2

Punktschätzungen

2.1

Maximum-Likelihood-Schätzung

Beispiel 2.1

X = (X1 , . . . , Xn ) Xi ∼ P (λ) u.i.v

PX,Θ = {f (x; λ) | λ ∈ R+ } mit Dichte

f (x; λ) =

n

Y

λ xi

i=1

xi !

exp(−λ)

P

exp(−λn)λ

Qn

=

i=1 xi !

xi

Wahrscheinlichkeitstheorie x unbekannt, λ bekannt, also f (x; λ) Funktion von x ∈ Rn

Statistik x beobachtet ( Daten“), λ unbekannt, also kann f (x; λ) als Funktion von λ bei

”

festem x ∈ Rn betrachtet werden

Also: L(λ; x) := f (x; λ)

Da f (x; λ) = PX,λ (X = x) sprechen große Werte von f (x; λ) für eine hohe Wahrscheinlichkeit, bei gegebenem λ das Ergebnis X = x zu beobachten. Jetzt suchen wir das zum

beobachteten x passende“ λ. Also

”

b := argmax L(λ; x)

λ

λ∈R+

P

∂L(λ; x)

∂λ xi exp(−λn)

=

∂λ

∂λ

X

P

P

!

=

xi λ xi −1 exp(−λn) − nλ xi exp(−λn) = 0

30

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

31

P

P

x i P xi

λ

exp(−λn) = nλ xi exp(−λn)

Pλ

xi

⇔

=n

λ

X

b= 1

⇔ λ

xi

n

⇔

Definition 2.1 (Likelihood)

Sei X = (X1 , . . . , Xn ) mit Verteilungsannahme PX,Θ = {f (x; ϑ) | ϑ ∈ Θ} (d.h., die Dichten

existieren), dann heißt die Funktion

L : Θ × X → R+

ϑ 7→ L(ϑ; x) = f (x; ϑ)

die Likelihoodfunktion für ein festes x ∈ X (= Rn üblicherweise).

Definition 2.2 (Maximum- Likelihood- Schätzer)

Sei X = (X1 , . . . , Xn ) und PX,Θ die zugehörige Verteilungsannahme (siehe Def. 2.1). Dann

heißt der Schätzer

tML : Rn → Rk

x 7→ tML (x) = ϑbML := argmax L(ϑ; x)

ϑ∈Θ

der Maximum-Likelihood-Schätzer für ϑ ∈ Θ ⊆ Rk .

Bemerkung.

ϑbML = argmax L(ϑ; x) = argmax log L(ϑ; x)

ϑ∈Θ

ϑ∈Θ

Dieses Optimierungsproblem ist i.a. viel einfacher zu lösen!

Definition 2.3 (Log- Likelihood)

`(ϑ; x) = log L(ϑ; x) = log f (x; ϑ)

heißt Log- Likelihoodfunktion.

Beispiel 2.2 (Nichtexistenz von ϑbML )

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

32

X = (X1 , . . . , Xn ) Xi ∼ P (λ) u.i.v.

Yi = I(Xi > 0)

P(Yi = 0) = e−λ

P(Yi = 1) = 1 − e−λ

fYi (y; λ) = P(Yi = y)

fY (y; λ) =

n

Y

fYi (yi ; λ)

i=1

=

1 − e−λ

P yi

e−λ

P

(1−yi )

= L(λ; y)

X

X

`(λ; y) = log(L(λ; y)) =

yi log(1 − e−λ ) − λ

(1 − yi )

P

∂`(λ; y)

yi −λ X

!

=

e −

(1 − yi ) = 0

−λ

∂λ

1−e

yi e−λ X

=

(1 − yi )

1 − e−λ P

n

(1 − yi )

e−λ

P

=

= P −1

−λ

1−e

yi

yi

P

⇔

⇔

x

=a

1−x

a

x= a+1

−λ

Pn −

yi

Pn

yi

1

=1−

⇔

e

log

b = − log(1 − ȳ)

λ

⇔

=

1

Pn

yi

= 1 − ȳ

b existiert nicht, wenn ȳ = 1 ⇔ yi ≡ 1 ∀i weil L(λ; y) = 1 − e−λ

λ

n

monoton in λ.

Beispiel 2.3 (Lineare Regression)

Y = Xβ + mit

X ∈ Rn,p fest, bekannt

⇒ Y ∼ Nn (Xβ, σ 2 In )

β ∈ Rp fest, unbekannt

∼ Nn (0, σ 2 In )

Gesucht: Schätzer für β (Satz 8.25)

n

1

1

>

L(β; Y, X) = √

exp − 2 (Y − Xβ) (Y − Xβ)

2σ

2πσ

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

33

L(β; Y, X) maximal ⇔ kY − Xβk2 minimal

⇔ βbML = X + Y

Rg(X) = p < n

=

Verteilung von βbML :

βbML ∼ N β, σ 2 (X > X)−1

(X > X)−1 X > Y

(i.w. Def. 8.23, Satz 8.24).

Beispiel 2.4 (Verallgemeinerte Lineare Regression)

∼ Nn (0, σ 2 V ), V ∈ Rn,n pd.

⇒ Y ∼ Nn (Xβ, σ 2 V ); also Beobachtungen Yi eben nicht unabhängig.

(Satz 8.25)

1

1

>

2

−1

p

L(β; Y, X) = p

exp − (Y − Xβ) (σ V ) (Y − Xβ)

2

(2π)n det(σ 2 V )

L(β; Y, X) maximal ⇔ (Y − Xβ)> (σ 2 V )−1 (Y − Xβ) minimal

Betrachte Y ∗ = R−1 Y

mit σ 2 V = RR>

= R−1 Xβ + R−1 Cholesky-Zerlegung

Cov(Y ∗ ) = R−1 Cov(Y )R−1

>

>

= R−1 RR> R−1 = I

(Y − Xβ)> (σ 2 V )−1 (Y − Xβ) minimal ⇔

(Y ∗ − R−1 Xβ)> (Y ∗ − R−1 Xβ) minimal ⇔

βbML =

=

−1 −1 > ∗

(R X) Y

(R−1 X)> (R−1 X)

!−1

>

−1

−1

X> R

| {zR } X

V −1

=

X > V −1 X

−1

>

X > R−1 ) R−1 Y

|

{z

}

V −1

X > V −1 Y

Beispiel 2.5 (Logistische Regression)

Yi ∼ B(1, pi )

i = 1, . . . , n u.v.

exp x>

1

i β

=

pi =

>

β

1 + exp xi β

1 + exp −x>

i

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

34

mit xi ∈ Rp fest, bekannt und β ∈ Rp unbekannt.

fY (y) =

n

Y

fYi (yi )

i=1

=

n

Y

pyi i (1 − pi )1−yi

i=1

=

n Y

i=1

1

1 + exp(−x>

i β)

yi 1

1−

1 + exp(−x>

i β)

1−yi

= L(β; Y, X)

`(β; Y, X) =

n

X

i=1

yi log

1

1 + exp(−x>

i β)

+ (1 − yi ) log 1 −

1

1 + exp(−x>

i β)

βbML ? Analytisch: Viel Spaß!

Einfacher: optim() in R. Diese Funktion sucht nach Minima, also −`(β; Y, X) (die negative

log-Likelihood) betrachten.

Bemerkung. Sei PX,Θ Fisher-regulär. Dann gilt:

S(ϑ; x) =

∂`(ϑ; x)

∂ϑ

Scorefunktion = Ableitung der log. Likelihoodfkt

ϑb = argmax L(ϑ, x)

⇔

S(ϑ̂; x) = 0

ϑ∈Θ

und

∂S(ϑ; x)

| ∂ϑ

{z }

<0

b

ϑ=ϑ

−I(ϑ;x)

negative Fisher-Information

und wenn L(ϑ; x) ein globales Maximum hat!

Deswegen re-definieren wir ϑb als Lösung von

b x) = 0 mit I(ϑ;

b x) > 0

S(ϑ;

wozu die folgenden Annahmen an PX,Θ gemacht werden

R1) R2) R3) und R4)

sowie

C1)

ϑ1 = ϑ2 ⇔ PX,ϑ1 = PX,ϑ2

C2)

Θ ⊂ R offen, also Θ = (ϑ, ϑ)

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

35

Wenn C1) gilt, heißt ϑ identifizierbar.

X ∼ N (µ, 1) und Y = |X|. Dann ist ϑ nicht identifizierbar, denn nach Beobachtung von

Y führen −ϑ und ϑ zum selben Ergebnis.

Satz 2.4 (Konsistenz des ML-Schätzers)

Sei X = (X1 , . . . , Xn ) u.i.v. mit R1-R4 und C1,C2. Dann existiert eine Folge von Statistiken

ϑbn = tML (X), definiert über S(ϑbn ; x = (x1 , . . . , xn )) = 0 und I(ϑbn , (x, . . . , xn )) > 0 (also

potentiell lokale Maxima der Likelihood) so daß gilt:

P

ϑbn → ϑ

(X ∼ PX,ϑ )

(ϑbn ist schwach konsistent).

Beweis. weiss

Es ist zu zeigen, daß für jedes > 0 die ZV ϑb im Intervall (ϑ − , ϑ + ) liegt. Wegen R4)

ist L(ϑ; X) stetig und diffbar, also langt es zu zeigen daß

n→∞

PX,ϑ (Ln (ϑ − ; X) < Ln (ϑ; X) > Ln (ϑ + ; X)) −→ 1

(Achtung: Ln (ϑ; X) = fX (X = (X1 , .., Xn ); ϑ) hängt von X ab!)

zunächst:

PX,ϑ (Ln (ϑ − ; X) < Ln (ϑ; X))

Ln (ϑ; X)

= PX,ϑ 1 <

Ln (ϑ − ; X)

Ln (ϑ; X)

= PX,ϑ 0 < log

Ln (ϑ − ; X)

Ln (ϑ; X)

1

= PX,ϑ 0 < log

n

Ln (ϑ − ; X)

Für die Folge von ZV

1

log

n

Ln (ϑ; X)

Ln (ϑ − ; X)

Qn

f (Xi ; ϑ)

1

i=1

=

log Qn

n

i=1 f (Xi ; ϑ − )

n

1X

f (Xi ; ϑ)

=

log

n i=1

f (Xi ; ϑ − )

gilt das schwache Gesetz der großen Zahlen, also

1X

f (Xi ; ϑ)

f (Xi ; ϑ)

P

log

→ E log

n

f (Xi ; ϑ − )

f (Xi ; ϑ − )

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

36

Weiterhin gilt:

E log

f (Xi ; ϑ)

f (Xi ; ϑ − )

f (Xi ; ϑ − )

= E − log

f (Xi ; ϑ)

Abschätzung durch Jensen’sche Ungl. wegen strikt log-konvex

f (Xi ; ϑ − )

> − log E

f (Xi ; ϑ)

Z

f (xi ; ϑ − )

= − log

f (xi ; ϑ) dν(xi )

f (xi ; ϑ)

Z

= − log f (xi ; ϑ − ) dν(xi )

|

{z

}

=1

=0

x (ϑ)

>0 →1

und damit PX,ϑ n1 log LLn (ϑ−)

Andere Richtung äquivalent. Damit folgt die Konsistenz.

Bemerkung. Satz 2.4 garantiert nicht die Existenz eines lokalen Maximums, weder für alle

x ∈ X noch n ∈ N.

Korollar 2.5

Es gelten die Annahmen von Satz 2.4; wenn S(ϑbn ; x) = 0 eindeutige Nullstelle ist, so gilt:

P

i) ϑbn → ϑ

f.s.

ii) ϑbn → ϑbML

(d.h. die Lösung der Scoregleichung führt zum Maximum-Likelihood-Schätzer mit

Wahrscheinlichkeit 1 für n → ∞).

Beweis. weiss

i) ⇐ Satz 2.4

ii) S(ϑbn ; x) = 0 kann für ein

a) lokales Maximum oder b) ein lokales Minimum der Likelihood sprechen. Ebenso

c) für einen Sattelpunkt.

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

37

b) und c): Es kann in diesen Fällen kein lokales Maximum geben, ohne die Eindeutigkeit

der Nullstelle zu verletzen. Die Wahrscheinlichkeit, daß kein lokales Maximum

existiert geht mit Satz 2.4 gegen 0.

a) ϑb ist lokales Maximum.

Falls ϑbn 6= ϑbML , dann gäbe es ja L(ϑbML ; x) > L(ϑbn ; x) und insbesondere ein

lokales Minimum im Intervall (ϑbML , ϑbn ), was im Widerspruch zur Eindeutigkeit

der Nullstelle der Scorefunktion steht. ⇒ ϑbn = ϑbML mit Wahrscheinlichkeit 1.

Beispiel 2.6

X = (X1 , . . . , Xn ) Xi ∼ N (µ, σ 2 )

u.i.v.

A) σ 2 = σ02 bekannt

`(µ; x) = log fX (x; µ)

n

Y

1

1

2

√

exp − 2 (xi − µ)

= log

2σ0

2πσ

i=1

√

1 X

= −n log 2π − n log σ0 − 2

(xi − µ)2

2σ0

∂`(µ; x)

∂µ

1 X

!

=

(xi − µ) = 0

2

σ

X0

⇔

(xi − µ) = 0

X

⇔

xi − nµ = 0

1X

1X

⇔

x=µ⇒µ

b=

xi

n

n

S(µ; x) =

Da L(µ; x) maximal wird wenn

X

X

(xi − µ)2 =

(xi − x̄)2 + n(x̄ − µ)2

minimal wird, ist µ

bML = x̄ = µ

b.

B) µ = µ0 bekannt

√

√

1 X

`(σ 2 ; x) = −n log( 2π) − n log σ 2 − 2

(xi − µ0 )2

2σ

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

38

n

1 X

(xi − µ0 )2

+

2

2σ

2σ 4

1

1 X

!

2

=

−n + 2

(xi − µ0 ) = 0

2

2σ

σ

X

1

⇔ 2

(xi − µ0 )2 = n

σ

1X

⇔ σb2 =

(xi − µ0 )2

n

S(σ 2 ; x) = −

eindeutige Lösung ⇒

Alternativ:

σb2 = σb2 ML

n

1 X

S(σ; x) = − + 3

(xi − µ0 )2 = 0

σ

σ

p

⇒ σ

b = σb2

Satz 2.6 (Invarianz des ML-Schätzers)

Seien die Bedingungen von Satz 2.4 erfüllt und g(ϑ) eine stetige parametrische Funktion.

d = g(ϑbn ) ist ein konsistenter Schätzer für g(ϑ).

Dann gilt: g(ϑ)

n

Beweis. weiss

P

P

Aus ϑbn → ϑ folgt mit Satz 9.7 auch g(ϑbn ) → g(ϑ)

d

Bemerkung. Ist g bijektiv (also eine streng monotone Transformation) so gilt g(ϑ)

ML =

b

g(ϑML ).

Bemerkung. Konsistenz ist nicht sehr hilfreich, Informationen über die Verteilung eines

ML-Schätzers sind sehr viel nützlicher.

Beispiel 2.7

X1 ∼ P (λ)

x

f (x; λ) = λx! exp(−λ)

∂ log(f (x;λ))

= λx − 1

∂λ

IX1 (λ) = V( Xλ ) = λ12 V(X) = λ12 λ = λ1

X = (X1 , . . . , Xn ) Xi ∼ P (λ) u.i.v.

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

39

bML = x̄ (Beispiel auf Seite 25) und IX (λ) = P IX (λ) =

λ

1

bML ) = V(X̄) =

V(λ

ZGWS

⇒

⇔

⇔

n

λ

1

λ

nλ = = IX (λ)−1

2

n

n

b −λ D

λ

qML

→ N (0, 1)

b

V(λML )

b −λ D

λ

q ML

→ N (0, 1)

1

−1

I

(λ)

n X1

√

D

bML − λ) →

n(λ

N (0, IX1 (λ)−1 ) = N (0, λ)

Das bedeutet:

der ML-Schätzer ist asymptotisch erwartungstreu

√

geeignet skaliert (mit n), sind die Abweichungen vom wahren Parameterwert normalverteilt mit Varianz = der inversen Fisher-Information des wahren Parameters.

Satz 2.7 (Verteilung der Scorefunktion)

Sei X = (X1 , . . . , Xn ) u.i.v. und S(ϑ; X) die zugehörige Scorefunktion. Dann gilt:

1

D

√ S(ϑ; X) → N (0, IX1 (ϑ))

n

Beweis. weiss

u.i.v.

IX1 (ϑ) = V(S(ϑ, X1 )) ⇒ IX (ϑ) = nIX1 (ϑ)

∂ log(fX (X; ϑ))

∂ϑ

n

∂ X

=

log(fXi (Xi ; ϑ))

∂ϑ i=1

S(ϑ, X) =

=

n

X

∂fXi (Xi ;ϑ)

∂ϑ

i=1

f (X ; ϑ)

| Xi {zi }

S(ϑ,Xi )

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

40

E(S(ϑ, Xi )) = 0 ∀ i Satz 1.32

V(S(ϑ, Xi )) = IX1 (ϑ)

1

1

1

V( S(ϑ, X)) = 2 n · IX1 (ϑ) = IX1 (ϑ)

n

n

n

1

S(ϑ,

X)

−

0

ZGWS

D

n

q

⇒

→ N (0, 1)

1

I (ϑ)

n X1

1

D

√ S(ϑ, X) → N (0, IX1 (ϑ))

n

⇔

Satz 2.8 (Quadratische Approximation der Log-Likelihood)

1

`(ϑ; x) ≈ `(ϑbML ; x) − I(ϑbML ; x)(ϑ − ϑbML )2

2

Beweis. weiss

`(ϑ; x)

Taylor

bML

um ϑ

≈

∂`(ϑ; x) b

`(ϑML ; x) +

(ϑ − ϑbML )

∂ϑ ϑ=ϑbML

|

{z

}

bML ,x)=0

S(ϑ

1 ∂ 2 `(ϑ; x) +

(ϑ − ϑbML )2

2

2

∂ ϑ

b

|

{z ϑ=ϑML}

bML ,x)

−I(ϑ

=

Beispiel 2.8

X ∼ B(n, p)

P

pbML = n1

Xi

n

I(p; x) = p(1−p) ;

S(p; x) = xp − n−x

1−p

und − ∂S(p;x)

=

∂p

x

p2

1

`(ϑbML ; x) − I(ϑbML ; x)(ϑ − ϑbML )

2

denn

(Beispiel 1.26)

+

n−x

(1−p)2

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

41

Einsetzen von pbML liefert

n−x

(1 − pbML )2

(1 − pbML )2 x + pb2ML (n − x)

=

pb2ML (1 − pbML )2

pML )

pbML

x

+

(n

−

x)

pbML (1 − pbML ) (1−b

pbML

1−b

pML

=

2

pbML (1 − pbML )2

I(b

pML ; x) =

=

x

pb2ML

+

1−b

pML

x

pbML

+

− x)

pbML (1 − pbML )

n−x+

=

pbML

(n

1−b

pML

x

n

n−x

n

(n − x)

pbML (1 − pbML )

n−x+x

=

pbML (1 − pbML )

n

=

pbML (1 − pbML )

Beachte

`(p; X) − `(b

pML ; X) ≈ −

1

n

(p − pbML )2

2 pbML (1 − pbML )

→ Abb.

Satz 2.9 (asymptotische Normalität des ML-Schätzers)

Sei X = (X1 , . . . , Xn ) u.i.v. mit Verteilungsannahme PX,Θ = {f (x; ϑ) | ϑ ∈ Θ} (Fisherregulär). Weiterhin gelte:

C1, C2 sowie

C3) ∀x ∈ C (Träger von f ) ist f (x; ϑ) mindestens dreimal stetig differenzierbar.

C4) Für den wahren Parameterwert ϑ0 existiert eine Funktion Mϑ0 (x) und eine Konstante

c(ϑ0 ) so daß

3

∂ `(ϑ; x) ∂ 3 ϑ ≤ Mϑ0 (x) ∀x ∈ C, (ϑ − ϑ0 ) < x(ϑ0 )

sowie

Eϑ0 (Mϑ (X)) < ∞.

Dann gilt für jede konsistente Folge von ZV ϑbn = tScore (X) (siehe Satz 2.4)

√

1

D

n(ϑbn − ϑ0 ) → N (0,

)

IX1 (ϑ0 )

wobei 0 < IX1 (ϑ0 ) < ∞

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

42

Beweis. weiss

S(ϑbn ; X)

Taylor

um ϑ0

∂S(ϑ;

X)

S(ϑ0 ; X) + (ϑbn − ϑ0 )

∂ϑ ϑ=ϑ0

2

1 b

2 ∂ S(ϑ; X) + (ϑn − ϑ0 )

2

∂ 2ϑ =

ϑ=ϑ0

Da nach Definition von ϑbn

S(ϑbn ; X) = 0 gilt:

!

2

∂S(ϑ;

X)

∂

S(ϑ;

X)

1

S(ϑ0 ; X) = (ϑbn − ϑ0 ) −

− (ϑbn − ϑ0 )

∂ϑ ϑ=ϑ0 2

∂ 2 ϑ ϑ=ϑ0

⇔ (ϑbn − ϑ0 ) =

− ∂S(ϑ;X)

∂ϑ ϑ=ϑ0

S(ϑ0 ; X)

− 1 (ϑbn − ϑ0 )

2

√

n √

⇔ n(ϑbn − ϑ0 ) =

Nach Satz 2.7 gilt

S(ϑ0 ;X) D

√

→

n

− n1 ∂S(ϑ;X)

∂ϑ ∂ 2 S(ϑ;X) ∂2ϑ √

S(ϑ0 ; X)/ n

− 1 (ϑbn − ϑ0 )

ϑ=ϑ0

2n

ϑ=ϑ0

∂ 2 S(ϑ;X) ∂2ϑ ϑ=ϑ0

N (0, IX1 (ϑ0 )).

1 ∂S(ϑ; X) −

n

∂ϑ ϑ=ϑ0

u.i.v

=

=

=

n

1 X ∂S(ϑ; Xi ) −

n i=1

∂ϑ

ϑ=ϑ0

∂f (xi ;ϑ) n

∂ϑ

1X ∂

ϑ=ϑ0

−

n i=1 ∂ϑ f (xi ; ϑ0 )

1

n

n

X

∂f (xi ;ϑ)

∂ϑ

i=1

f (xi ; ϑ0 )

!2

−

1

n

n

X

i=1

∂ 2 f (xi ;ϑ) ∂2ϑ

ϑ=ϑ0

f (xi ; ϑ0 )

E(S(ϑ0 ; Xi )2 ) = IX1 (ϑ0 ) (Satz 1.32 und Def. 1.33)

und daraus folgt (GdgZ)

1X

P

S(ϑ0 ; Xi )2 → IX1 (ϑ0 )

n

Für den zweiten Term gilt mit R4:

2

∂ f (xi ;ϑ) Z 2

∂ f (xi ; ϑ)

∂ 2 ϑ ϑ=ϑ0

E

dν(xi ) = 0 mit Xi ∼ PXi = f ν

=

f (xi ; ϑ0 )

∂ 2ϑ

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

43

zusammen folgt

1 ∂S(ϑ; X) P

−

→ IX1 (ϑ0 )

n

∂ϑ

ϑ=ϑ0

Der letzte Term

∂ 2 S(ϑ; X) 1 b

− (ϑn − ϑ0 )

2n

∂ 2 ϑ ϑ=ϑ0

P

∂ 2 S(ϑ;X) geht gegen Null, falls ∂ 2 ϑ beschränkt ist (wegen ϑbn → ϑ0 nach Voraussetzung).

ϑ=ϑ0

1 ∂ 2 S(ϑ; X) 1 X ∂ 3 log(f (xi ; ϑ)) =

n

∂ 2 ϑ ϑ=ϑ0

n

∂ 3ϑ

ϑ=ϑ0

Mit Annahme C4) gilt jedoch

X ∂ 3 log f (xi ; ϑ) ∂ϑ

ϑ=ϑ

X

<

Mϑ0 (xi )

∗

für alle ϑ∗ mit |ϑ∗ − ϑ0 | < c(ϑ0 ) , also insbesondere auch ϑbn .

Zusammen:

√

1

D N (0, IX1 (ϑ0 ))

n(ϑbn − ϑ0 ) →

= N (0,

)

IX1 (ϑ0 )

IX1 (ϑ0 )

Beispiel 2.9

X1 , . . . , Xn u.i.v.

Xi ∼ N (aσ, σ 2 ) , a bekannt.

1

1 X

2

L(σ; x) = √ n exp − 2

(xi − aσ)

2σ

2π σ n

√

1 X

2π + n log(σ) − 2

`(σ, x) = − log

(xi − aσ)2

2σ P

P 2

xi

a xi na2

=

b −n log(σ) −

−

+

2σ 2

σ

2

n

P 2

P

∂`(σ; x)

n

xi

a xi !

=− +

−

=0

3

2

∂σ

σ

σ

σ

P

P

1

x2i

a xi

⇔

−n +

−

=0

σ

σ2

σ

{z

}

|

!

=0

P

⇔

x2i

σ2

−

a

P

σ

xi

=n

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

mit γ :=

44

1

σ

X

x2i − γa

xi = n

P

xi

n

⇔ γ 2 − γa P 2 = P 2

xi

xi

⇔ γ2

X

Nullstellen:

γ =d±

mit d =

also

r

n

P 2 + d2

xi

P

a xi

P 2

2 xi

s

P

P

a2 ( xi )2

1

n

a xi

=γ

b= P 2+ P 2+

P 2

xi

σ

b

2 xi

4 ( x2i )

(andere Nullstelle negativ!)

∂S(σ, X1 )

IX1 (σ) = E −

∂σ

X2

1

∂ − σ1 + σ31 − aX

σ2

= E −

∂σ

1

3X12 2aX1

= E −

− 4 +

σ2

σ

σ3

1

3E(X12 ) 2aE(X1 )

= − 2+

−

σ

σ4

σ3

2

2 2

1

3(σ + a σ ) 2aaσ

= − 2+

− 3

σ

σ4

σ

1

σ 2 3 (1 + a2 ) 2a2

= − 2+

− 2

σ

σ4

σ

1

=

−1 + 3 + a2

σ2

1

2

2

+

a

=

σ2

√

σ2

Satz 2.9

D

⇒

n (b

σ − σ) → N 0,

2 + a2

Satz 2.10

Sei ϑbn Schätzer für ϑ und g eine diffbare parametrische Funktion. Dann gilt

!

2

√ ∂g(ϑ)

D

n g(ϑbn ) − g(ϑ) → N 0,

I−1

X1 (ϑ)

∂ϑ

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

45

Beweis. weiss

Satz 2.9 und Satz 9.16

Bemerkung. ϑ ∈ Rk ;

ϑbn ∈ Rk . Dann gilt (unter Regularitätsbedingungen)

√ D

b

n ϑn − ϑ → Nk 0, I−1

X1 (ϑ)

mit I−1

X1 (ϑ) inverse Fisher-Informationsmatrix, siehe letzte Bemerkung in Abschnitt 1.

Beispiel 2.10

X1 ∼ N (µ, σ 2 )

2

f (x; µ, σ ) =

`(µ, σ 2 ; x) =

∂`(µ, σ 2 ; x)

=

∂µ

∂`(µ, σ 2 ; x)

=

∂σ 2

2

1

1

2

√

exp − 2 (x − µ)

2σ

2πσ

√ 1

2π − log(σ) − 2 (x − µ)2

− log

2σ

1

(x − µ)

σ2

1

1

− 2 + 4 (x − µ)2

2σ

2σ

!

2

2

IX1 (µ, σ ) = E −

∂∂`(µ,σ ;X)

∂µ∂µ

∂∂`(µ,σ 2 ;X)

∂µ∂σ 2

∂∂`(µ,σ ;X)

∂µ∂σ 2

∂∂`(µ,σ 2 ;X)

∂σ 2 ∂σ 2

∂ σ12 (x − µ)

∂∂`(µ, σ 2 ; X)

1

=

=− 2

∂µ∂µ

∂µ

σ

1

2

∂ σ2 (x − µ)

∂∂`(µ, σ ; X)

1

=

= − 4 (x − µ)

2

2

∂µ∂σ

∂σ

σ

1

1

2

∂ − 2σ2 + σ4 (x − µ)2

∂∂`(µ, σ ; X)

=

∂σ 2 ∂σ 2

∂σ 2

1

1

=

− 6 (x − µ)2

4

2σ

σ

!

1

0

σ2

⇒ IX1 (µ, σ 2 ) =

0 2σ1 4

Jetzt X = (X1 , . . . , Xn ) Xi ∼ N (µ, σ 2 ) u.i.v.

`(µ, σ 2 ; x) = −n log σ −

1 X

(xi − µ)2

2σ 2

2.1. MAXIMUM-LIKELIHOOD-SCHÄTZUNG

I

∂`(µ,σ 2 ;x)

∂µ

II

∂`(µ,σ 2 ;x)

∂σ

46

1 X

(xi − µ) = 0

σ2

n

1 X

=− + 3

(xi − µ)2 = 0

σ σ

=

Lösung des Gleichungssystems:

I ⇒ µ

b = x̄

P

in II ⇒ nσ = σ13 (xi − x̄)2

P

⇔ σ̂ 2 = n1 (xi − x̄)2

Achtung: nicht unverzerrt.

⇒

√

n

X̄ − µ

σ̂ 2 − σ 2

!

mit

2

Σ = I−1

X1 (µ, σ ) =

⇒

X̄ und

1

n

1

σ2

0

0

1

2σ 4

D

→ N (0, Σ)

!−1

=

σ2 0

0 2σ 4

!

P

(Xi − X̄)2 sind (asymptotisch) unabhängig.

P

Da σ̂ 2 → σ 2 gilt

und

√ (X̄ − µ) D

n √

→ N (0, 1)

σ̂ 2

(Slutsky)

√ (σ̂ 2 − σ 2 ) D

→ N (0, 1)

n √

2σ̂ 4

(Slutsky)

Satz 2.11

Unter den Annahmen von Satz 2.9 gilt ebenso

√ (ϑbn − ϑ) D

nq

→ N (0, 1)

b

IX1 (ϑn )

√ (ϑbn − ϑ) D

np

→ N (0, 1)

I(ϑ, X)

√ (ϑbn − ϑ)

D

nq

→ N (0, 1)

I(ϑbn , X)

Beweis. weiss

Es langt, die Konsistenz von IX1 (ϑbn ), I(ϑ, X) und I(ϑbn , X) gegen IX1 (ϑ) zu zeigen, die

obigen Behauptungen folgen dann aus Satz 9.7 (Inverse + Wurzel-trafo) und Satz 9.11

2.2. M-SCHÄTZUNG

47

(Slutsky). Bleibt zu zeigen

1

I(ϑ, X)

n

n

1X

I(ϑ, Xi )

n i=1

=

GdgZ

P

→

E (I(ϑ, Xi )) = IX1 (ϑ)

Bemerkung. IX1 (ϑbn ) (erwartete Fisher-Information an der Stelle des ML- Schätzers) und

I(ϑbn , X) (beobachtete Fisher-Information an der Stelle des ML-Schätzers) sind für Daten

X = x berechenbar und somit können die Ergebnisse aus Satz 2.11 direkt und praktisch

für die Approximation der Verteilung des ML-Schätzers angewendet werden.

2.2

M-Schätzung

Beispiel 2.11

√

n

√ −1 !

(X̄ − µ) σ̂ 2

D

√ −1

→

N

(σ̂ 2 − σ) 2σ̂ 4

0,

1 0

0 1

!!

nach Beispiel 2.10. Allerdings war X = (X1 , . . . , Xn ) mit Xi ∼ N (µ, σ 2 ) angenommen

worden. Zwei Fragen kommen auf

1. Ist das Ergebnis auch für andere Verteilungen valide?

2. Kann man die Schätzer X̄ und σ̂ 2 auch ohne genaue Spezifikationen der Normalverteilung herleiten?

Definition 2.12 (M-Schätzer)

Sei X = (X1 , . . . , Xn ) u.i.v. mit Xi ∼ F; Xi ∈ Rp . Sei ψ : Rp × Rk → R eine Funktion, so

daß für den wahren Parameter ϑ gilt:

Z

E ψ(X1 , ϑ) = ψ(x, ϑ) dF(x) = 0

Dann heißt ϑb mit

n

X

i=1

M-Schätzer.

b

ψ Xi , ϑ = 0

2.2. M-SCHÄTZUNG

48

Bemerkung. Die Lösung von E ψ(X1 , ϑ) = 0 ist gleichbedeutend mit dem Minimierungsproblem

Z

ρ(x, ϑ) dF(x) → min !

wobei dann ψ(x, ϑ) = c ·

∂ρ(x,ϑ)

.

∂ϑ

Beispiel 2.12 (Mittelwert)

ψ(x, ϑ) = x − ϑ ⇒ ρ(x, ϑ) = (x − ϑ)2

Z

(x − ϑ)2 dF(x) → min ! ⇔ ϑ = E(X)

denn

Z

Z

(x − ϑ) dF(x) =

!

x dF(x) −ϑ = 0 ⇔ E(X) = ϑ

| {z }

E(X)

Der M-Schätzer für ϑ ist dann gegeben durch die sog. Schätzgleichung

n

X

1X

xi

(xi − ϑ) = 0 ⇔ ϑb =

n

i=1

Achtung: Wir haben keine Annahmen über F gemacht, die Dichte ist nicht notwendig.

Beispiel 2.13 (Median)

ψ(x, ϑ) =

−1 x − ϑ < 0

0

1

x=ϑ

x−ϑ>0

ρ(x, ϑ) = |x − ϑ|

Z

E ρ(X1 , ϑ) =

|x − ϑ| dF(x) → min !

⇔ ϑ = Med(F)

und

n

X

ρ(xi , ϑ) =

X

|xi − ϑ| → min ⇔

i=1

ϑb = Med(x1 , . . . , xm )

2.2. M-SCHÄTZUNG

49

Beispiel 2.14 (ML-Schätzung)

Sei f Dichte von Fϑ und

−∂ log f (x; ϑ)

∂ϑ

(Achtung: ψ hängt von F über die Dichte ab)

ψ(x, ϑ) =

ρ(x, ϑ) = − log f (x; ϑ)

und ϑb ist gegeben durch die Minimierung von

n

X

ρ(xi , ϑ) = −

i=1

n

X

log (f (xi ; ϑ)) =

b log-Likelihood

i=1

bzw. die Lösung der Scoregleichungen

−

n

X

∂ log f (xi ; ϑ)

i=1

∂ϑ

!

= −S(X, ϑ) = 0

Satz 2.13

Sei X = (X1 , . . . , Xn ); ψ(x, ϑ) monoton in ϑ und in ϑ stetig. Dann gilt für die Lösung der

Schätzgleichung ϑbn :

n

X

!

ψ(Xi , ϑ) = 0

i=1

P

ϑbn → ϑ.

Beweis. weiss

Sei

Z

g(ϑ) =

ψ(x, ϑ) dF(x) und

n

gn (ϑ) =

GdgZ

1X

ψ(Xi , ϑ)

n i=1

P

⇒ gn (ϑ) → g(ϑ) ∀ ϑ

Sei > 0. Wenn ψ monoton steigend in ϑ ist und ϑ0 eine eindeutige Lösung von g(ϑ0 ) = 0

dann gilt:

g(ϑ0 − ) < 0 < g(ϑ0 + )

P

Da gn (ϑ0 ± ) → g(ϑ0 ± ) folgt das Ergebnis.

2.2. M-SCHÄTZUNG

50

Satz 2.14 (asymptotische Normalität des M-Schätzers)

√ D

n ϑbn − ϑ0 → N (0, V (ϑ0 ))

Beweis. weiss

(Skizze)

n

1X

ψ(Xi , ϑ)

gn (ϑ) :=

n i=1

Taylor

∂gn (ϑ) b

um ϑ0

b

(ϑn − ϑ0 ) + Rest

0 = gn (ϑn ) = gn (ϑ0 ) +

∂ϑ ϑ0

!−1

√ √

∂g

(ϑ)

n

⇔ n ϑbn − ϑ0 ∼

ngn (ϑ0 )

=−

∂ϑ ϑ0

0

∂ψ(x,ϑ)

der Gradient von ψ. Damit gilt:

,

.

.

.

,

Sei ψ (x, ϑ) = ∂ψ(x,ϑ)

∂ϑ1

∂ϑk

∂gn (ϑ) −

∂ϑ ϑ0

=

GdgZ

P

√

n

1 X 0

−ψ (Xi , ϑ0 )

n i=1

→

0

E −ψ (X1 , ϑ0 ) =: A(ϑ0 )

=

1 X

√

ψ(Xi , ϑ0 )

n i=1

n

ngn (ϑ0 )

ZGWS

D

→

N (0, B(ϑ0 ))

mit B(ϑ0 )

=

E ψ(X1 , ϑ0 ) ψ(X1 , ϑ0 )>

|

{z

}

√ ⇒

n ϑbn − ϑ0

D

Cov(ψ(X1 ,ϑ0 ))

Slutsky

→

=

√

A(ϑ0 )−1 ngn (ϑ0 )

>

Nk 0, A(ϑ0 )−1 B(ϑ0 )A(ϑ0 )−1

|

{z

}

=:V (ϑ0 )

Bemerkung.

>

A(ϑ0 )−1 B(ϑ0 ) A(ϑ0 )−1 =

| {z } | {z } | {z }

Brot

Schinken

Brot

V (ϑ0 )

| {z }

Sandwich-Matrix

2.2. M-SCHÄTZUNG

51

Satz 2.15 (Sandwich Schätzer)

P

b ϑbn )−1 B(

b ϑbn )A(

b ϑbn )−1 > →

Vb (ϑbn ) = A(

V (ϑ0 )

mit

n

X

∂ψ(Xi , ϑbn )

b ϑbn ) = 1

−

A(

n i=1

∂ ϑbn

n

X

>

b ϑbn ) = 1

ψ(Xi , ϑbn )ψ(Xi , ϑbn )

B(

n i=1

Beweis. weiss

∂ψ(Xi , ϑ)

E −

= A(ϑ)

∂ϑ

n

X

∂ψ(Xi , ϑ) P

GdgZ 1

⇒

−

→ A(ϑ)

n i=1

∂ϑ

Satz 9.7

⇒

P

A(ϑbn ) → A(ϑ)

Bemerkung. Falls

∂ log f (x; ϑ)

(=

b ML-Schätzer)

∂ϑ

∂S(ϑ, X1 )

A(ϑ) = E

= −IX1 (ϑ)

∂ϑ

ψ(x; ϑ) = −

ist

und

B(ϑ) = E S(ϑ, X1 )2 = IX1 (ϑ)

und somit

V (ϑ) = IX1 (ϑ)−1

(vgl. Satz 2.9)

Kapitel 3

Inferenzkonzepte

3.1

Parametertests

Beispiel 3.1

X = (X1 , . . . , Xn ) u.i.v. Xi ∼ N (µ, σ 2 )

µ̂ = X̄

x = (1, 1.5, 0.5, 2.7, −0.3) ⇒ µ̂ = x̄ = 1.08

P (X̄ = µ) = 0 (stetige Verteilung)

Wie groß ist die wahrscheinliche Abweichung des wahren µ von µ̂? Können wir eine Entscheidung treffen, ob µ ≤ 0 oder µ > 0?

Definition 3.1 (Testproblem)

Sei ϑ ∈ Rk Parameter und Θ ⊂ Rk der zugehörige Parameterraum. Dann heißt

H0 : ϑ ∈ Θ0

vs. H1 : ϑ ∈ Θ1

mit Θ = Θ0 ∪ Θ1 , Θ0 ∩ Θ1 = ∅, Θ0 6= ∅, Θ1 6= ∅

Statistisches Testproblem. H0 heißt (Null)hypothese, H1 Alternative.

Beispiel 3.2 (einfaktorielle Varianzanalyse)

vgl. Beispiel 1.7

µ = g(ϑ) = µB − µA ∈ R = Θ

52

3.1. PARAMETERTESTS

53

H0 : µ ≤ 0

Θ0 = R \ R+

H1 : µ > 0

Θ1 = R+

)

Düngemittel B

ist besser als A

)

vs.

Düngemittel A

=

b ist besser als B

oder gleichgut

Testproblem

Schlußfolgerung

Entscheidung

=

b kaufe A

kaufe B

Handlung

Beispiel 3.3 (Lineare Regression)

Yi = β0 + β1 xi + i i ∼ N (0, σ 2 ) u.i.v.

H0 : β1 = 0

Θ0 = {0}

H1 : β1 6= 0

Θ1 = R \ {0}

vs.

=

b x wirkt nicht auf y

x wirkt auf y

(positiv oder negativ)

Definition 3.2 (einfache, einseitige und zweiseitige Hypothesen)

H0 : ϑ ∈ Θ0 vs. H1 : ϑ ∈ Θ1

|Θ0 | = 1 ⇔: einfache Hypothese“, sonst: zusammengesetzte Hypothese“

”

”

|Θ1 | = 1 ⇔: einfache Alternative“, sonst: zusammengesetze Alternative“

”

”

Bei skalaren Parametern unterscheidet man noch

H0 : ϑ ≤ ϑ0 vs. H1 : ϑ > ϑ0 ”rechtsseitige

einseitiges

Alternative“

Testproblem

H0 : ϑ ≥ ϑ0 vs. H1 : ϑ < ϑ0

linksseitige

”

Altervative“

zweiseitiges

Testproblem

H0 : ϑ = ϑ0

vs.

H1 : ϑ 6= ϑ0

Definition 3.3 (statistischer Test)

φ : X → {0, 1} (meßbar)

heißt nichtrandomisierter Test. ( X Stichprobenraum)

φR : X → [0, 1] (meßbar)

heißt randomisierter Test.

3.1. PARAMETERTESTS

54

Bemerkung.

φ ◦ X ist wieder ZV.

φ(x) für Beobachtungen X = x meint:

φ(x) = 1 . . . ϑ ∈ Θ1 ( lehne H0 ab“)

”

φ(x) = 0 . . . ϑ ∈ Θ0 ( lehne H0 nicht ab“)

”

φR (x) = π meint: lehne H0 mit Wahrscheinlichkeit π ab, also

φ(x) ∼ B(1, φR (x))

Definition 3.4 (kritischer Bereich)

K := {x ∈ X | φ(x) = 1}

heißt kritischer Bereich oder Ablehnbereich.

K heißt Annahmebereich.

Bemerkung.

1 x ∈ K

φ(x) =

=

0 x ∈ K

IK (x)

Definition 3.5 (Fehlerarten)

ϑ ∈ Θ0 , φ(x) = 1 . . . Fehler erster Art

ϑ ∈ Θ1 , φ(x) = 0 . . . Fehler zweiter Art

Definition 3.6 (Gütefunktion)

βφ (ϑ) := PX,ϑ (φ(X) = 1)

Z

= Eϑ φ(X) = φ(x) dPX,ϑ (x)

heißt Gütefunktion des Tests φ. Diese Funktion beschreibt die Wahrscheinlichkeit, die Nullhypothese H0 : ϑ ∈ Θ0 abzulehnen für eine Stichprobe X = (X1 , . . . Xn ) aus der Verteilung

PX,ϑ .

Beispiel 3.4 (Erwartungswert einer Normalverteilung)

X ∼ N (µ, 1) ... nur eine Beobachtung

3.1. PARAMETERTESTS

H0 : µ ≤ 0

vs.

55

H1 : µ > 0

1 x > 1.645

φ(x) :=

0 x ≤ 1.645

⇔ K = (1.645, ∞)

βφ (µ) = Pµ (X > 1.645) = 1 − Pµ (X ≤ 1.645)

= 1 − Φµ (1.645)

→ Abb.

βφ (µ) ist monotone Funktion in µ und βφ (0) = 0.05 ist die Wahrscheinlichkeit, die Nullhypothese H0 : µ ≤ 0 zu verwerfen, obwohl sie (gerade noch) richtig ist =

b Wahrscheinlichkeit

für den Fehler erster Art.

Für µ > 0 ist βφ (µ) die Wahrscheinlichkeit, die Nullhypothese richtigerweise zu verwerfen

=

b 1− Wahrscheinlichkeit für den Fehler zweiter Art.

Definition 3.7 (Niveau-α-Test)

Ein Test φ mit der Eigenschaft

βφ (ϑ) ≤ α ∀ ϑ ∈ Θ0

heißt Niveau-α-Test. D.h., die Wahrscheinlichkeit für den Fehler erster Art ist maximal

α ∈ (0, 1).

Definition 3.8 (Macht, Power)

βφ (ϑ) ∀ ϑ ∈ Θ1

heißt Macht oder Powerfunktion des Tests.

Beispiel 3.5 (Binomialtest)

X = (X1 , . . . , Xn ) Xi ∼ B(1, p) u.i.v.

P

P

⇒ Xi ist suffizient für p und

Xi ∼ B(n, p)

H0 : p ≤ p0 vs. H1 : p > p0 (einseitiger TP)

Idee: Lehne ab, wenn

P

Xi zu groß ist, als daß p ≤ p0 plausibel wäre.

Nichtrandomisierter Test:

φ

X

xi

1 P x > k “zu groß“

i

=

P

0

xi ≤ k “zu klein“

3.1. PARAMETERTESTS

56

Wir hätten gern, daß

βφ (p) ≤ α für alle p ≤ p0

X X

Pp φ

Xi = 1 = Pp

Xi > k

Wegen der Monotonie in p muß also für einen Niveau-α-Test gelten:

X

X

Pp o

Xi > k = 1 − Pp 0

Xi ≤ k ≤ α

|

{z

}

FB(n,po ) (k)

P

Achtung: Das tatsächliche Niveau ist Ppo ( Xi > k), was in der Regel kleiner als α ist.

Randomisierter Test:

φR

X

xi =

X

1

γ

0

P

xi > k

P

xi = k

P

xi < k

>0

βφ (p) = Pp φR

Xi

X

X

!

= Pp

Xi > k + γPp

Xi = k = α

Konstruktion: Bestimme k wie für den nichtrandomisierten Test und dann aus obiger

Beziehung γ.

n = 15,

p0 = 41 ,

α = 0.1 ⇒

Xi > 6 = 0.0566 < α

X

P1/4

Xi > 5 = 0.148 > α

P

α − P1/4 ( Xi > 6)

P

γ=

= 0.4728

P1/4 ( Xi = 6)

k = 6, dann

P1/4

X

Beispiel 3.6 (einfacher Gauß-Test)

X = (X1 , . . . , Xn ) u.i.v. Xi ∼ N (µ, σ02 ) σ02 bekannt.

H0 : µ ≤ µ0

Idee:

P

vs. H1 : µ > µ0

Xi ist suffizient für µ, benutze Test der Form

1 x̄ > k

φ(x̄) =

0 x̄ ≤ k

3.1. PARAMETERTESTS

57

(Achtung: P(X̄ = k) = 0!)

βφ (µ) = Pµ X̄ > k

X̄ − µ

k−µ

= Pµ q 2 > q 2

σ0

n

σ0

n

√ k−µ

n

= 1−Φ

σ0

monoton wachsend in µ

Konstruktion Niveau-α-Test:

√

k − µ0

α=1−Φ

n

σ0

√ k − µ0

⇔ 1−α=Φ

n

σ0

−1

Φ (1 − α) · σ0

√

⇔

+ µ0 = k

n

Somit kann die Gütefunktion auch geschrieben werden als

Φ−1 (1−α)

√

σ 0 + µ0 − µ

√

n

βφ (µ) = 1 − Φ n

σ0

√ µ0 − µ

−1

= 1 − Φ

n

+

Φ

(1

−

α)

|

{z

}

σ

0

| {z }

<0 für

µ>µ0 =H

b 1

|

|

konstant, >0 für

α<0.5 (sinvoll)

{z

wird klein für größere Differenzen

von µ − µ0 und für größere

Stichprobenumfänge n.

{z

wird groß, wenn µ − µ0 groß

wird und n wächst.

}

}

Definition 3.9 (Bester Test)

Seien φ und φ∗ Niveau-α-Test für das TP H0 vs. H1 . Dann heißt φ mindestens so gut wie

φ∗ wenn gilt:

βφ (ϑ) ≥ βφ∗ (ϑ) ∀ ϑ ∈ Θ1 .

Gilt diese Beziehung für alle beliebigen Niveau-α-Tests φ∗ , so heißt φ gleichmäßig bester

Test (uniformly most powerful, UMP).

Definition 3.10 (Unverfälschter Test)

Ein Niveau-α-Test φ heißt unverfälscht, wenn gilt

βφ (ϑ0 ) ≤ βφ (ϑ1 ) ∀ ϑ0 ∈ Θ0 und ϑ1 ∈ Θ1

3.1. PARAMETERTESTS

58

Ein Niveau-α-Test φ heißt gleichmäßig bester unverfälschter (auch: unverzerrter) Test,

wenn er gleichmäßig bester Test unter allen unverfälschten Niveau-α-Tests ist.

Beispiel 3.7 (Einstichproben t-Test)

X = (X1 , . . . , Xn ) u.i.v. Xi ∼ N (µ, σ 2 )

H0 : µ ≤ µ0 v.s. H1 : µ > µ0

n

n

P

P

1

Xi σ̂ 2 = n−1

(Xi − X̄)2

µ̂ = n1

i=1