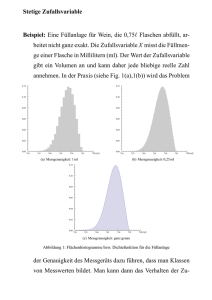

Wahrscheinlichkeitsrechnung und Statistik für Studierende

Werbung