Mathematische Methoden der Biowissenschaften II

Werbung

Universität Bielefeld

SS 2007

Fakultät für Mathematik

Prof. Dr. M. Baake

Mathematische Methoden der

Biowissenschaften II

TEXed by

Marc Paffen

Kristina Petkau

Eyla Willing

Inhaltsverzeichnis

1 Elementare Konzepte und Beispiele

1.1 Münzwurf . . . . . . . . . . . . . . . . . . .

1.2 Mehrfacher Münzwurf . . . . . . . . . . . .

1.2.1 Binomialverteilung . . . . . . . . . .

1.2.2 Gleichverteilung . . . . . . . . . . .

1.3 Weiterentwicklung der allgemeinen Theorie

1.4 Fortsetzung: Diskrete Verteilung . . . . . .

1.4.1 Geometrische Verteilung . . . . . . .

1.4.2 Poisson-Verteilung . . . . . . . . . .

1.5 Theorie neu beleuchtet, Standardgrößen . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2

. 2

. 2

. 3

. 5

. 6

. 6

. 6

. 8

. 11

2 Statistik

2.1 Grundlegende Definitionen .

2.1.1 Merkmaltypen . . .

2.1.2 Skalen . . . . . . . .

2.2 Intervallskalierte Größen . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

14

14

14

15

15

Mathematische Methoden der Biowissenschaften II (Prof. Dr. M. Baake)

TEXed by ewilling

WS 2007

02.04.07, VL 01

1 Elementare Konzepte und Beispiele

1.1 Münzwurf

Ene Münze besitzt die zwei Zustände Kopf/Zahl. Wir gehen davon aus, dass nur diese beiden

Zustände eintreten können. Es sei:

n Versuche: nK Anzahl “Kopf”, nZ Anzahl “Zahl”, nK + nZ = n

Man erwartet“, dass nK ≈ nZ (für n groß), obwohl (weil?) jeder einzelne Wurf zufällig ist.

”

⇒ Idee:

nK

pK “:=“ lim

n→∞ n

|{z}

↑

“Wahrscheinlichkeit für Kopf“

Definition 1.1.1 (fair)

Eine Münze heißt fair, wenn pK = pZ gilt (Dann ist pK = pZ = 12 ).

(abstrakte) Deutung:

1 ≡ K, 0 ≡ Z; P (1) = pK = p

P (0) = pZ = q = 1 − p

yGrundraum: Ω = {0, 1}

Ereignisraum: P(Ω) = {∅, {0}, {1}, {0, 1}} entspricht hier der Potenzmenge von Ω, also der

Menge aller Teilmengen. {1}, {0}: sind die Elementarereignisse

Ereignis

∅

{0}

{1}

{0, 1}

Deutung

weder K noch Z

“unmögliches Ereignis“

Z

K

K oder Z

“Sicheres Ereignis“

Wahrscheinlichkeit

0

q =1−p

p

1

1.2 Mehrfacher Münzwurf

(s1 , s2 , . . . , sn ), si ∈ {0, 1}

Wie hoch ist die Wahrscheinlichkeit l-mal eine “1” zu werfen? (Frage: P (ℓ − mal 1)?)

Ansatz:

∃ 2n mögliche Elemtarereignisse, davon

n

ℓ

=

n!

ℓ!(n−ℓ)!

1 n

P (ℓ − mal 1) = Pℓ = n

≥0

2 ℓ

2

mit ℓ − mal 1. Daraus folgt:

Konsistenzcheck

n

X

ℓ=0

Beispiel

n

X

1

n ∗

Pℓ =

·

=1

2n

l

ℓ=0

∗ letztes Sem.

n=4

P

ℓ

1

1

1

1

2

1

1

3

1

4

3

6

1

4

1

16

1

4

1

b

b

b

b

0

b

1

2

3

l

4

Allgemeiner

P (K) = p, P (Z) = 1 − p = q,

0≤p≤1

n

(!)

y P (ℓ − mal 1) = Pℓ =

· pℓ · (1 − p)n−ℓ

ℓ

Check

n X

n

ℓ=0

l

· pℓ · (1 − p)n−ℓ = (p + (1 − p))n = 1n = 1 X

1.2.1 Binomialverteilung

Definition 1.2.1 (Binomialverteilung)

Die durch

n

Pℓ :=

· pl · (1 − p)n−ℓ ,

ℓ

0 ≤ p ≤ 1, n ≥ 1

gegebene Verteilung heißt Binomialverteilung zu den Parametern n und p, abgekürzt als B(n, p).

Frage: Wieviele 1er dürfen wir denn erwarten?

m :=

n

X

ℓ=0

=

n

X

ℓ=1

ℓ · Pl =

n

X

ℓ=1

ℓ·

n

·pl · (1 − p)n−ℓ

ℓ

n−1

·pℓ · (1 − p)n−ℓ = ⊛

n·

ℓ−1

n−1

· pk+1 · (1 − p)n−1−k

k

k=0

n−1

X n − 1

=n · p ·

· pk · (1 − p)n−1−k = n · p

k

⊛=

n−1

X

n

k=1

Dabei heißt m Mittelwert oder Erwartungswert der Verteilung.

3

Mathematische Methoden der Biowissenschaften II (Prof. Dr. M. Baake)

TEXed by mpaffen

Frage:

WS 2007

13.04.07, VL 02

Wie stark variiert das Ergebnis?

V :=

n

X

ℓ=0

=

=

n

X

(ℓ − m)2 · Pℓ

(ℓ2 − 2ℓm + m2 ) · Pℓ

ℓ=0

n

X

l=0

=

n

X

ℓ=0

ℓ · Pℓ

!

ℓ2 · Pℓ

!

2

Diese Größe heißt Varianz , und σ :=

druck

− 2m

− m2

n

X

ℓ=0

|

ℓ · Pℓ

{z

m

!

}

+m2

n

X

Pℓ

ℓ=0

| {z }

1

√

V heißt Standardabweichung der Verteilung. Der Ausn

X

ℓ=0

ℓ2 · Pℓ

heißt 2. Moment.

Um die Varianz zu bestemmen müssen wir noch das 2. Moment berechnen:

n

n

n

X

X

X

n

n

2

ℓ

n−ℓ

2

ℓ · Pℓ =

ℓ·

· p · (1 − p)

=

ℓ ·

· pℓ · (1 − p)n−ℓ

ℓ

ℓ

ℓ=0

ℓ=0

ℓ=1

n

X

n−1

=n·

ℓ·

· pℓ · (1 − p)n−ℓ

ℓ−1

ℓ=1

n−1

X

′

′

n−1

′

(ℓ + 1) ·

= n·p·

· pℓ · (1 − p)n−1−ℓ

′

ℓ′ =ℓ−1

ℓ

ℓ′ =0

#

# " n−1 " n−1 X

X n − 1 ℓ′

′

′

′

n

−

1

ℓ

n−1−ℓ

′

n−1−ℓ

+

p (1 − p)

ℓ

= np

p (1 − p)

1

ℓ′

ℓ′

ℓ′ =0

ℓ′ =0

{z

} |

{z

}

|

=1

= n · p + n · (n − 1) · p

=(n−1)·p

2

Damit erhalten wir:

V = n p + n(n − 1)p2 − n2 p2 = n p + (n2 − n) p2 − n2 p2

= n p + n2 p2 − n p2 − n2 p2 = n p − n p2 = n p (1 − p) = n p q

Satz 1.2.1

Die Binomialverteilung B(n, p) besitzt die (elementaren) Wahrscheinlichkeiten

n

Pℓ =

· pℓ · (1 − p)n−ℓ ,

0 ≤ ℓ ≤ n,

ℓ

4

den Erwartungswert

m=n·p

und die Varianz

V =n·p·q

Beispiel:

Faire Münze p = q =

(q = 1 − p)

1

2

√

1

n

1

⇒ m = n, V = n bzw. σ =

2

4

2

n = 100, m = 50, σ = 5

√

Beachte: 1

n ist noch ziemlich groß“.

2

”

1.2.2 Gleichverteilung

Ein anderes Beispiel:

Der klassische Würfel

Elementarereignisse (Ω) : 1, 2, 3, 4, 5, 6

Fair: P(1) = · · · = P(6) =

1

6

Erwartungswert:

m=

6

X

ℓ=1

Varianz V =

1

6

6

X

ℓ=1

ℓ

ℓ·

1 1

7

1

= · ·6·7=

6

6 2

2

oder:

1

1 · P + 2 · P(2) + · · · + 6 · P(6) = · (1 + 2 + · · · + 6)

6

1 1

1 1

7

= · k(k + 1)

= · · 6 · 7 = = 3, 5

6 2

6

2

2

k=6

2

!

−

49

4

=

91

6

−

49

4

=

35

12

Definition und Satz 1.2.1 (Gleichverteilung)

Der faire Würfel mit n Seiten wird durch die Gleichverteilung beschrieben, mit P1 = P2 = · · · =

Pn = n1 . Dabei gilt:

1

m = · (n + 1)

2

1

V =

· (n + 1) · (n − 1)

12

Beweis:

(i)

m=

1 1

n+1

1

· (1 + 2 + · · · + n) = · n · (n + 1) =

n

n 2

2

(ii)

n

X

ℓ=1

ℓ2 · Pℓ =

n

X

ℓ=1

ℓ2 ·

n

1

1 X 2 (!) 1 1

(n + 1)(2n + 1)

= ·

ℓ = · · n · (n + 1) · (2n + 1) =

n

n

n 6

6

ℓ=1

5

Dann ist die Varianz :

V =

(n + 1)(2n + 1) (n + 1)2

n2 − 1

1

−

= ··· =

=

· (n + 1)(n − 1)

6

4

12

12

2

1.3 Weiterentwicklung der allgemeinen Theorie

Ω = {1, 2, 3, 4, 5, 6}

P(Ω) = {∅, {1}, {2}, {3}, . . ., {6}, {1, 2}, {1, 3}, . . ., Ω}

(Grundraum)

Ereignisraum

Der Ereignisraum hat 26 Elemente.

Deutung:

∅

{1}, etc

{1, 2}

..

.

unmögliches Ereignis

Elementarwurf

Wurf von 1 oder 2

{1, 3, 5}

..

.

Wurf ist ungerade

{1, 2, 3, 4, 5, 6}

sicheres Ereignis

Wahrschenlichkeiten:

A ∈ P(Ω) y P(A)

Wir nehmen an, dass P(A) für alle A ∈ P(Ω) existiert. Axiome (offensichtliche Eigenschaften)

0 ≤ P(A) ≤ 1,

P(∅) = 0

∀A ∈ P(Ω)

P(Ω) = 1

A ∩ B = ∅ ⇒ P(A ∪ B) = P(A) + P(B)

Ā := Ω \ A ⇒ P(Ā) = 1 − P(A)

Komplementärereignis“

”

Dies motiviert:

Definition: 1.3.1 (Wahrscheinlichkeitsraum)

Ist ein endlicher Grundraum Ω gegeben, zusammen mit einer Abbildung. P : P → [0, 1], die

Axiome erfüllt, so heißt das Tripel (Ω, P(Ω), P) ein Wahrscheinlichkeitsraum.

Beispiel:

Münzwurf, Würfel, Roulette

Problem:

Wenn Ω nicht endlich ist, muss man P(Ω) durch eine kleinere Menge ersetzen, genannt Σ.

y Satz von Vitali P(Ω) dann nicht möglich.

1.4 Fortsetzung: Diskrete Verteilung

1.4.1 Geometrische Verteilung

Ausgangspunkt: (gezinkte) Münze: Bernoulli-Experiment mit Wahrscheinlichkeit 0 < p < 1

6

Frage: Was ist die Wahrscheinlichkeit, dass 1“ (Kopf) genau beim n-ten Wurf zum ersten

”

mal auftritt?

y P( 1“ zum ersten Mal genau in Wurf n) = (1 − p)n−1 · p = Pn

”

(Ω = N)

Normierung:

∞

X

n=1

Pn =

∞

X

n−1

(1 − p)

n=1

∞

X

·p= p·

(1 − p)ℓ = p ·

ℓ=0

p

1

= =1

1 − (1 − p)

p

Satz 1.4.1

Die geometrische Verteilung mit Parameter p, 0 < p < 1, ist durch die Wahrscheinlichkeit

Pn = (1 − p)n−1 · p,

gegeben. Sie erfüllt m =

1

p

und V =

1−p

p2

7

n ∈ N,

Mathematische Methoden der Biowissenschaften II (Prof. Dr. M. Baake)

TEXed by kpetkau

WS 2007

20.04.07, VL 03

Erwartungswert:

m=

∞

X

n · Pn =

n=1

∞

X

=p ·

n=1

∞

X

n=1

n−1 n·x

∞

∞

X

d n d X n (!)

=p·

x x = p·

dx dx n=1 n=1

x=1−p

x=1−p

x=1−p

1

d 1 p

1

=p·

=p

= 2 =

2

dx 1 − x (1 − x) p

p

∞

d X n x =p ·

dx n=0 | {z } x=1−p

(!)

1

1−x

Varianz:

n · (1 − p)n−1 p

x=1−p

x=1−p

2.Moment:

∞

X

n=1

2

n · Pn =

∞

X

n=1

2

n−1

n · (1 − p)

d

n

·x n

p=p

dx

n=1 | {z }

∞

d n (!!) X d

x·

=p

x dx

dx

n=1

Varianz:

d

x

=p ·

·

dx (1 − x)2 ∞

X

x=1−p

n·xn−1

x=1−p

x=1−p

d

1

d

x ·

·

=p·

dx |dx {z

1 − x}

x=1−p

1

(1−x)2

1 + x = ... = p ·

(1 − x)3 1

1−p

2−p

V = 2 − 2 =

p

p

p2

2

V =2. Moment − m

√

1−p

σ=

p

Beispiel: Idealer Würfel – Wann erscheint eine 6?

p=

1

, m = 6, V = 30 (groß!)

6

1.4.2 Poisson-Verteilung

Betrachte B(n, p) mit n riesig“ und p klein“

”

”

y unbequem! y Setze λ = n · p

Asymptotisch betrachten wir einen Grenzwert:

n→∞ mit λ = n · p

p→0

8

=

x=1−p

2

2−p

p2

In diesem Limes wird die Wahrscheinlichkeit, dass 1“ genau n-mal eintritt (extrem gezinkte

”

Münze) gegeben durch:

λn −λ

(n ∈ N0 )

P (n − mal 1“) = Pn =

e

”

n!

Der Beweis folgt mit der sogenannten Stirlingschen Formel“, wird hier aber ausgelassen.

”

Normierung:

∞

∞

X

X

λn −λ

λn

e = e−λ

= e−λ · eλ = e0 = 1

n!

n!

n=0

n=0

| {z }

eλ

Erwartungswert:

∞

X

λn−1

λn −λ

−λ

=λ

e = λe

n·

n!

(n − 1)!

n=1

n=0

{z

}

|

∞

X

=eλ

2.Moment:

∞

X

n=0

n2 ·

(!)

= λe−λ

∞

X

X d

λn −λ

λn

λn−1

e = λe−λ

= λe−λ

n

n!

(n − 1)!

dλ (n − 1)!

n=1

n≥1

X

λn−1

d

d X λn

λ

= λe−λ d λeλ

= λe−λ

dλ

(n − 1)!

dλ

(n − 1)!

dλ

n≥1

n≥1

|

{z

}

eλ

= λe

Varianz:

−λ

λ

λ

2

(e + λe ) = λ + λ

⇒ V = 2. Moment − m2 = λ + λ2 − λ2 = λ

Satz:

Die Poisson-Verteilung mit Parameter λ > 0 ist gegeben durch die Wahrscheinlichkeiten

Pn =

λn −λ

e ,

n!

Sie besitzt Erwartungswert

m=λ

und die Varianz

V = λ.

9

n ∈ N0 .

Beispiel/Anwendung:

(i) radioaktive Zerfälle pro Zeiteinheit.

(ii) # Rosinen pro Volumeneinheit in (engl.) Kuchen

(iii) # Regentropfen pro Pflasterstein und Zeiteinheit

(iv) # Pferdehufschlagtote in preussischen Kavallerieregimenten

Drei Bemerkungen:

(i)

α

n

=

α(α−1)·...·(α−n+1)

n!

(ii) (1 + x)α =

∞ X

α n

x ,

n

n=0

,

(α ∈ R)

für α ∈ R und |x| < 1 (Newton 1667)

(iii) Poisson aus Binomial → Ergänzung!

Siehe Skript

10

1.5 Theorie neu beleuchtet, Standardgrößen

Zurück zu (Ω, P (Ω), P)(bzw.(Ω, Σ, P)):

Da Ω recht abstrakt sein kann ( Farbe“,Kopf/Zahl), benötigt man noch ein Konzept zum Quan”

tifizieren.

Definition 1.5.1 (Zufallsvariable, ZV)

Unter einer Zufallsvariable (ZV) versteht man eine Abbildung X : Ω → R.

Die Werte, die X annehmen kann, heißen Ihre Realisierungen.

Je nach Bildbereich nennt man X diskrete oder kontinuierliche Zufallsvariable.

Beispiel: Ω = {Kopf, Zahl} ;

X:Ω→R :

X(Kopf)

X(Zahl)

=1

=0

Weil der Münzwurf zufällig ist, mit Ereignis w ∈ Ω, ist auch x = X(w) zufällig.

Notation:

X für Zufallsvariable, x für Realisierung (oder auch K für Zufallsvariable, k für Realisierung)

Zuordnung: (im diskreten Fall):

pi = P(X = xi ) =

X

P(wj )

j

X(wj )=xi

Definition 1.5.2 (Verteilungsfunktion)

Sei X eine Zufallsvariable, zum Wahrscheinlichkeitsraum (Ω, Σ, P). Dann heißt:

F (x) := P(X ≤ x)

die zugehörige Verteilungfunktion.

Eigenschaften

(i) 0 ≤ F (x) ≤ 1, mit lim F (x) =

x→±∞

(ii) x ≤ y ⇒ F (x) ≤ F (y)

Beipiel: Münzwurf:

X(Ω) = {0, 1} ⊂ R

(

1 (+)

0 (−)

(Monotonie)

GRAPH

rechtsseitig stetig

Für diskrete Zufallsvariablen ist die Verteilungsfunktion eine Funktion mit Sprungstellen versehen. Für kontinuierliche Zufallsvariablen hingegen sieht das vielleicht so aus:

GRAPH

11

Dies liegt nahe:

Z

F (x) =

| {z }

x

−∞

f (ξ) dξ

|{z}

f (ξ)ist Dichtefunktion, f ≥ 0, Fläche 1“

”

Verteilungsfunktion

Beispiel: Gleichverteilung auf [a, b]

GRAPH, Funktionen

f (x) =

F (x)

(

1

b−a ,

wenna ≤ x ≤ b

sonst

0,

0,

x<a

a≤x≤b

b≤x

= x−a

,

b−a

y P(X ∈ [α, β]) =

1,

Z

β

α

f (x) dx = F (β) − F (α)

(!)

Definition 1.5.3 (Standardgrößen (E,V,SD))

Ist X eine diskrete Zufallsvariable (über(Ω, Σ, P)), so heißt

X

xi · P(X = xi )

m := E(X) :=

ihr Erwartungswert.

Ist X kontinuierlich, mit Dichte f (x), so ist

m := E(x) :=

Z

+∞

−∞

x · f (x)dx

Allgemein:

E(g(x)) :=

Z

+∞

−∞

g(x) · f (x)dx

(bzw. E(x) =

−∞

X

i

(g(xi )) · P(X = xi ))

Weiter heißt

V = E((X − m)2 )

Varianz von X, und σ =

Lemma 1.5.1:

√

V heißt Standardabweichung.

E (X − m)2 = E X 2 − m2 = E X 2 − E(X)2

12

Beweis:

Wie früher, nämlich : E(.) ist linear!!!

E (X − m)2 =E(X 2 − 2mX + m2 ) = E(X 2 ) − 2m E(X) +m2 · E(1)

| {z }

| {z }

m

2

2

=E(X ) − 2m + m

=E(X 2 ) − m2

2

2

=E(X 2 ) − (E(X))

13

2

=1

Mathematische Methoden der Biowissenschaften II (Prof. Dr. M. Baake)

TEXed by mpaffen

WS 2007

04.05.07, VL 05

2 Statistik

Angenommen, wir haben eine faire Münze. Sie wird 4 mal geworfen. Wie hoch ist dann die

Wahrschienlichkeit 2 mal Kopf zu erhalten.

2 2

4

1

1

P4 (2 Erfolge) =

·

·

2

2

2

Wahrscheinlichkeitsrechnung

↓

Berechne Wahrscheinlichkeiten

Schlüsse über die Verteilung

↑

(schließende Statistik) Sammlung und Darstellung von Daten

(Beschreibende Statistik)

2.1 Grundlegende Definitionen

Beschreibende Statistik befasst sich mit der Sammlung und Darstellung der Daten.

Schließende Statistik zieht Schlüsse über die Verteilung auf Geund von gesammelten Daten.

Statistiche Einheiten sind die Objekte/Personen, über die wir unsere Daten sammel, Gegenstück in der Wahrscheinlichkeitsrechnung ist ω.

Grundgesamtheit ist die Menge aller statistischen Einheiten. Gegenstück in der Wahrscheinlichkeitsrechnung ist Ω.

Stichprobenumfang nennt man die Größe der Stichprobe.

Stichprobe ist eine Teilmenge der Grundgesamtheit. (Teilgesamtheit). x1 , . . . , xn . Die einzelnen Elemente der Stichprobe müssen dabei zufällig (gut gemischt) aus der Grundgesamtheit

ausgewählt werden.

Merkmale sind Größen, die an den statistischen Einheiten gemessen werden.

Merkmalsprägungen sind die möglichen Werte der Merkmale.

2.1.1 Merkmaltypen

Diskrete Merkmale haben endlich viele oder abzählbar unendliche mögliche Werte.

Stetige Merkmale können alle Werte eines Intervalls annehmen.

Stetige Merkmale lassen sich durch Gruppierung des Intervalls in diskrete Merkmale transformieren.

14

2.1.2 Skalen

Nominalskalierte Merkmale sind solche, deren Werte Namen (Bezeichnungen) sind. (Farbe,

Religion, Geschlecht)

Ordinalskalierte Merkmale sind deren Werte Ordnungsrelationenn zulassen, aber Wertedifferenzen haben keine Bedeutung. (Engagement)

Intervallsklaierte Merkmale erlauben Ordnungsrelationen und die Wertedifferenzen enthalten Informationen. (Temperatur)

Skalenart

nominal

ordinal

intervall

auszählen

ja

ja

ja

ordnen

nein

ja

ja

Differenz bilden

nein

nein

ja

2.2 Intervallskalierte Größen

Merkmal

Zufallsvariable X

Ausprägung

Die Möglichen Werte von X

Stichprobe

x1 , x2 , . . . , xn

(unabhängige, zufällige n Realisierungen von X)

Ordne nach Werten ξ1 < ξ2 < . . . < ξr , r ≤ n

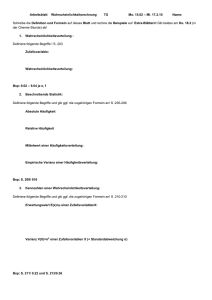

Absolute Häufigkeiten

n 1 , n 2 , . . . , nr ,

X

nj = n

j

Relative Häufigkeiten

nj X

,

hj = 1

n

n2

nr

n1

, h2 =

, . . . , hr =

h1 =

n

n

n

hj :=

x1

ξ1

n1

h1

<

x2

ξ2

n2

h2

<

...

...

...

...

<

xn

ξr

nr

hr

approkimierte wahrscheinlichkeit

lim h = pj = P(X = ξj )“

” n→∞ j

empirischer Mittelwert

r

x̄ :=

empirische Varianz

s2 :=

1X

x1 + . . . + xn

ni · ξi

=

n

n i=1

(x1 − x̄)2 + . . . + (xn − x̄)2

n−1

15

Index

Binomial

-verteilung, 3

Binomialverteilung, 5

Ereignisraum, 2

Erwartungswert, 3

Binomialverteilung, 5

fair, 2

Gleichverteilung, 5

Grundraum, 2

Münzwurf, 2

-mehrfacher, 2

Mittelwert, 3

Raum

Ereignis-, 2

Grund-, 2

Standardabweichung, 4

Varianz, 4

Binomialverteilung, 5

Verteilung

Binomial-, 3

Wahrscheinlichkeitsraum, 6

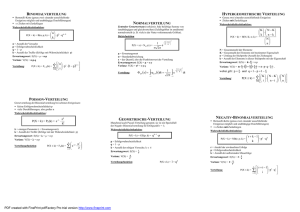

16