Vorwort

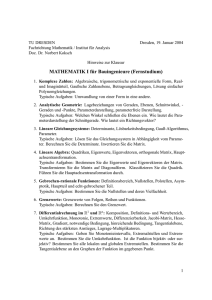

Werbung

V

Vorwort

Dieses Buch ist aus einer Vorlesung hervorgegangen, die der ältere der beiden Autoren im Wintersemester 1987/88 an der Universität Göttingen gehalten hat, die vom

jüngeren Autor ausgearbeitet und zunächst vom Mathematischen Institut der Universität Göttingen herausgegeben worden ist. Für die Veröffentlichung als Lehrbuch ist

dieses Manuskript noch einmal grundlegend überarbeitet und an zahlreichen Stellen

ergänzt worden. Wir hoffen, daß die Darstellung so ausführlich, interessant und klar

geraten ist, daß sich das Buch nicht nur als Begleitlektüre zu einer entsprechenden

Vorlesung, sondern auch zum Selbststudium, zum Nachlesen oder zur Vorbereitung

auf Prüfungen eignet.

Auf die Stoffauswahl gehen wir in der Einleitung ausführlich ein. Hier sei nur bemerkt,

daß einerseits der Geometrie und vor allem der Nahtstelle zwischen geometrischer Anschauung und mathematisch-logischer Formulierung ein großes Gewicht eingeräumt

wird. Andererseits wird ein großer Teil der grundlegenden Theorie, wie er etwa auch

von Studenten der Wirtschaftsmathematik oder Physik benötigt wird, in diesem Buch

behandelt, auch wenn es nur den Inhalt des ersten Teils der zweisemestrigen Vorlesung Analytische Geometrie und lineare Algebra“ wiedergibt. Breiten Raum nehmen

”

die Behandlung linearer Gleichungssysteme (Gaußscher Algorithmus), die Determinantentheorie und die Eigenwerttheorie linearer Abbildungen in euklidischen“

”

Vektorräumen (Hauptachsentransformation) ein.

Wir sind bemüht, schnell zu den Kernpunkten der jeweiligen Themenbereiche vorzustoßen und verzichten dabei bewußt auf größtmögliche Allgemeinheit. Zahlreiche

Beispiele, die teilweise den Charakter von gelösten Übungsaufgaben haben, sollen das

Verständnis neuer Begriffe oder Methoden unmittelbar fördern.

Wir haben dem Verlag und insbesondere den Herren Andreas Türk und Martin Reck

zu danken für die jederzeit angenehme Zusammenarbeit. Herrn Peter Lerner danken

wir für seine tatkräftige Mitwirkung bei der Erstellung der LATEX-Dateien und Herrn

Christian Meister für seine Hilfe bei der Durchsicht des Manuskripts.

Göttingen und Bayreuth, im März 1999

Hans Grauert

Hans-Christoph Grunau

VI

Zu den Autoren

Hans Grauert wurde am 8. Februar 1930 in Haren (Ems) geboren. Er studierte Mathematik und Physik in Mainz, Münster und an der ETH Zürich. Er wurde 1958 an die

Universität Göttingen als Nachfolger von C. L. Siegel berufen. Er verbrachte insgesamt drei Jahre in Amerika (u. a. am Institute for Advanced Study in Princeton), war

aber auch in anderen Ländern wie vor allem in Frankreich (Institut des Hautes Études

Scientifiques) und u. a. in Japan, China, der UdSSR und Indien. Seine wissenschaftlichen Arbeiten befassen sich mit Fragen der komplexen Analysis.

Hans-Christoph Grunau wurde am 23. März 1961 in Wuppertal geboren. Er studierte

Mathematik in Marburg und Göttingen und hat sich 1996 an der Universität Bayreuth

habilitiert. Sein wissenschaftliches Interesse gilt der reellen Analysis und insbesondere

der Theorie der partiellen Differentialgleichungen. Auf diesem Gebiet arbeitet er mit

Wissenschaftlern u. a. aus den Niederlanden, Spanien und Italien zusammen.

VII

Inhaltsverzeichnis

Vorwort

V

Einleitung

IX

1

1.1

1.2

1.3

Der Vektorraumbegriff

Der n . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Reelle Vektorräume . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Basis und Dimension . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

1

7

11

2

2.1

2.2

2.3

2.4

Der anschauliche Raum

Gibt es eine geometrische Anschauung? . . . . . .

Addition von Vektoren in der anschaulichen Ebene

Multiplikation mit Skalaren . . . . . . . . . . . .

Geometrie . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

19

19

23

28

34

3

3.1

3.2

3.3

Lineare Abbildungen

Abbildungen . . . . . . . . . . . . . .

Lineare Abbildungen . . . . . . . . . .

Lineare Abbildungen n → m . . . .

Gaußscher Algorithmus . . . . . . . .

Rang und Corang . . . . . . . . . . . .

Allgemeine lineare Gleichungssysteme

Matrizenoperationen . . . . . . . . . .

Ebenen . . . . . . . . . . . . . . . . .

Spezielle lineare Abbildungen . . . . .

Projektionen . . . . . . . . . . . . . .

Umkehrbar lineare Abbildungen . . . .

3.4

3.5

3.6

3.7

3.8

4

4.1

4.2

4.3

4.4

4.5

R

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

39

. 40

. 47

. 53

. 59

. 65

. 73

. 78

. 89

. 105

. 105

. 107

Vektorraumkonstruktionen

Beispiele unendlichdimensionaler Vektorräume

Direkte Summen . . . . . . . . . . . . . . . .

Linearformen und Dualräume . . . . . . . . .

Dualräume endlichdimensionaler Vektorräume

Weitere spezielle lineare Abbildungen . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

R

R

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

119

120

122

128

136

141

VIII

Inhaltsverzeichnis

5

5.1

5.2

5.3

5.4

5.5

5.6

Determinantentheorie

Allgemeines Kroneckersymbol . . . . . . . .

Determinanten . . . . . . . . . . . . . . . .

Weitere Eigenschaften der Determinante . . .

Berechnung von Determinanten . . . . . . .

Cramersche Regel . . . . . . . . . . . . . .

Die Determinante einer linearen Abbildung F

. .

. .

. .

. .

. .

:V

. . .

. . .

. . .

. . .

. . .

→V

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

147

147

152

157

164

170

177

6

6.1

6.2

6.3

6.4

Orthogonalität

Die euklidische Ebene .

Die Länge eines Vektors

Orthogonale k-Beine . .

Das Kreuzprodukt . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

179

179

191

198

202

7

7.1

7.2

7.3

7.4

Eigenwerte und Hauptachsentransformation

Der allgemeine Körperbegriff, komplexe Vektorräume

Unitäre und adjungierte Abbildungen . . . . . . . . .

Eigenwerte . . . . . . . . . . . . . . . . . . . . . . .

Die Hauptachsentransformation . . . . . . . . . . . .

Normale Matrizen . . . . . . . . . . . . . . . . . . .

Hermitesche und reell symmetrische Matrizen . . . . .

Unitäre und reell orthogonale Matrizen . . . . . . . .

.

.

.

.

.

.

.

209

210

218

228

238

243

246

254

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Literaturverzeichnis

259

Symbolverzeichnis

261

IX

Einleitung

In der Anfängervorlesung Analytische Geometrie und lineare Algebra“ ist es heute

”

vielfach üblich, einfach mit der abstrakten Theorie der Vektorräume und evtl. sogar

der Moduln über Ringen zu beginnen. Man hat das Bestreben, sofort von den mathematischen Grundbegriffen auszugehen und aus ihnen alles zusammenzubauen. Das

soll zu einer logischen Übersichtlichkeit führen. Aber der Anfänger wird staunen, was

es so alles gibt. Er kann sich bei manchem nur wenig denken.

In der Technik, aber auch in der Physik wird im allgemeinen erst nur der 3dimensionale anschauliche Raum auftreten. Er hat noch keine Koordinaten. Man hat

noch keine Tripel von reellen Zahlen, dafür aber gibt es eine Vorstellung von Geraden,

Winkeln, Translationen, Drehungen. Vektoren gibt es. Sie sind Pfeile einer bestimmten

Länge. Man kann mit ihnen rechnen. Warum geht man dann nicht von diesem Raum

aus? Man kann die Vektorraumeigenschaften ableiten und so den Studenten zu den

in der Mathematik natürlich notwendigen Abstraktionen hinführen. Die Abstraktionen

werden dann als natürlich empfunden. Man kann dann auch die Existenz von rechtwinkligen Koordinaten zeigen und die Isomorphie mit dem Zahlenraum herstellen. Die

Existenz einer solchen Isomorphie bedeutet, daß der anschauliche Raum die gleiche

Gestalt wie der Zahlenraum hat.

Wer seinen Baum beschneiden will, wird nicht erst Koordinaten in seinen Garten

legen.

Das hier vorgestellte Axiomensystem ist auch ein vollständiges Axiomensystem der

euklidischen Geometrie. Anders als bei Hilbert werden jedoch keine Geraden, sondern

Pfeilvektoren verwendet. Das ist praktischer. Die Pfeilvektoren finden ja überall Anwendung. Natürlich wird nicht die alte hyperbolische Geometrie mit eingeschlossen.

Diese dürfte aber auch heute ziemlich ohne Bedeutung sein. Wenn man sie machen

will, ist es ohnehin besser, gleich die Quotienten von Liegruppen zu untersuchen! Die

nicht-euklidischen Geometrien werden hier gleich dadurch ausgeschlossen, daß man

fordert, daß die Relation parallel“ eine Äquivalenzrelation ist und daß das Parallelo”

gramm der Kräfte gilt.

Es sei noch erwähnt, daß die Griechen keinen Beweis des Satzes von Pythagoras

geliefert haben, der den heutigen Anforderungen entspricht. Sie haben nämlich den

Flächeninhalt benutzt, ohne ihn zu definieren. Auch hätten sie zeigen müssen, daß

er invariant gegen Drehungen ist. An sich hat der Pythagoräische Satz mit dem

Flächeninhalt nichts zu tun. Dieses Buch enthält einen exakten Beweis.

X

Einleitung

In dem ersten Kapitel dieses Buches wird zwar zunächst der n-dimensionale reelle

Zahlenraum n als Menge der n-tupel von reellen Zahlen und der Begriff des abstrakten Vektorraums eingeführt, damit man die späteren Begriffe einordnen kann.

Dann geht man jedoch im zweiten Kapitel sofort zur Anschaulichkeit über. Insbesondere wird die anschauliche Ebene betrachtet. Hier wird unser Axiomensystem der

anschaulichen Geometrie soweit entwickelt, daß die anschauliche Ebene als zweidimensionaler reeller Vektorraum erkannt werden kann.

R

Hierauf aufbauend entwickeln wir im 3. Kapitel die Grundlagen der Theorie endlichdimensionaler (zunächst ausschließlich reeller) Vektorräume sowie der linearen

Abbildungen zwischen diesen. Wir werden zeigen, daß durch Einführung geeigneter Isomorphismen “ (Koordinatensysteme) die Betrachtung linearer Abbildungen

”

zwischen endlichdimensionalen Vektorräumen zurückgeführt werden kann auf die Betrachtung linearer Abbildungen n → m . Diese sind dem ebenso einfachen wie

wirkungsvollen Matrizenkalkül (dabei handelt es sich lediglich um die Manipulation

von Zahlenschemata) zugänglich, den wir simultan und gleichberechtigt zur Theorie linearer Abbildungen entwickeln und mit dessen Hilfe wir zahlreiche theoretische

Resultate herleiten werden. Breiten Raum nimmt die Behandlung linearer Gleichungssysteme bzw., was, wie wir in Kapitel 3.7 darlegen werden, dazu gleichwertig ist,

allgemeiner s-dimensionaler Ebenen ein. In diesem Zusammenhang wird der Gaußsche Algorithmus vorgestellt, aus dem wir neben rechnerischem auch stets großen

theoretischen Nutzen ziehen werden.

R

R

In Kapitel 4 sprechen wir speziellere Fragen der Vektorraumtheorie an. Im Mittelpunkt stehen dort duale Vektorräume und duale Abbildungen sowie in diesem

Zusammenhang einige Besonderheiten unendlichdimensionaler Vektorräume. Die

Idee, zusammen mit einem Vektorraum V die Gesamtheit aller linearen Abbildungen

V → zu betrachten, ist grundlegend in vielen Bereichen der modernen Mathematik,

führt zum einen von einer abstrakten Seite hin auf den Begriff der Orthogonalität und

bietet zum anderen in allgemeinen Situationen einen Ersatz für bzw. eine Verallgemeinerung von Orthogonalität. Ausführlichere Erklärungen versuchen wir zu Beginn und

im Verlauf von Kapitel 4.

R

Kapitel 5 ist der klassischen Determinantentheorie und dabei wegen ihrer enormen

Wichtigkeit unter anderem der Cramerschen Regel gewidmet. Auch dieses Kapitel

führt wegen der geometrischen Bedeutung der Determinante hin zu Kapitel 6, in

dem unser in Kapitel 2 begonnenes Axiomensystem der anschaulichen Geometrie um

diejenigen Axiome ergänzt wird, die Orthogonalität, Länge, Winkel, Drehung, u. ä

betreffen.

R

R

Damit erhalten die anschauliche Ebene, 2 und allgemeiner n die volle Struktur

euklidischer Vektorräume“. Das Vorhandensein eines Skalarprodukts erlaubt es uns,

”

in Kapitel 7 etwa othogonale“, selbstadjungierte“ oder normale“ Abbildungen zu

”

”

”

betrachten. Die starken Eigenschaften solcher speziellen Abbildungen erlauben die

Herleitung sehr weitreichender Resultate ( Hauptachsentransformation“), deren volle

”

XI

Einleitung

Eleganz und Allgemeinheit sich aber nur in komplexen Vektorräumen erreichen läßt.

Deshalb beginnt dieses Kapitel mit einer Einführung in komplexe Zahlen und komplexe Vektorräume; in der Hoffnung, daß vieles schon aus der gleichzeitig erlernten

Analysis vertraut ist, fassen wir uns hier recht kurz. Für die angesprochenen Klassen

von Matrizen werden wir orthogonale Koordinatensysteme konstruieren, so daß das

Rechnen mit linearen Abbildungen in diesen Koordinaten so einfach wird wie das

Rechnen mit reellen oder komplexen Zahlen. Als Beispiele werden wir Wurzeln und

Exponentialfunktionen geeigneter linearer Abbildungen bestimmen. Ganz wesentliches Standbein dieses Kapitels ist die Eigenwerttheorie linearer Abbildungen“, die

”

mit all ihren Weiterentwicklungen und Verallgemeinerungen grundlegend für viele

Bereiche der modernen Mathematik und Physik bis hin zur Quantenmechanik ist.

Mit dieser Stoffauswahl hoffen wir:

•

die geometrischen Wurzeln der linearen Algebra mit logischer Strenge freizulegen,

•

die wichtigsten Elemente der Theorie reeller und komplexer Vektorräume und

linearer Abbildungen zu entwickeln und

•

stets den Blick schon ein wenig zu öffnen in Richtung auf Weiterentwicklungen

im Bereich der Geometrie (allgemeine Ebenen etwa als einfachste Prototypen allgemeiner Mannigfaltigkeiten), der Analysis (unendlichdimensionale Vektorräume

werden gestreift, um Appetit zu machen auf die Theorie linearer Abbildungen zwischen vollständigen normierten Vektorräumen, die Funktionalanalysis“) und der

”

mathematischen Physik (etwa Lorentztransformationen oder Eigenwerttheorie).

Technische Hinweise zum Lesen des Buches erübrigen sich weitestgehend. Das

Kästchen 2 kennzeichnet das Ende von Beweisen. Die Numerierung sollte selbsterklärend und vollkommen unzweideutig sein: Sätze, Definitionen, Beispiele, usw.

werden unterschiedslos dreistellig numeriert, die erste Stelle gehört zum Kapitel

und die zweite zum Teilkapitel (Abschnitt). Am Ende des Buches befinden sich ein

ausführliches Symbolverzeichnis und ein Sachverzeichnis, so daß (hoffentlich!) jedes

interessierende Thema im Text mühelos aufgefunden werden kann.

Um eventuellen Mißverständnissen vorzubeugen, sei schon hier erwähnt, daß wir

n-tupel aus dem n bzw. n zwar grundsätzlich als Zeilen ~b = (b1 , . . . , bn )

schreiben, um die Lesbarkeit vor allem des fortlaufenden Textes zu gewährleisten,

daß wir im Rahmen des Matrizenkalküls darunter jedoch (zumeist stillschweigend)

die entsprechenden Spaltenvektoren

b1

~b = ...

bn

R

verstehen.

C

209

7 Eigenwerte und

Hauptachsentransformation

In diesem Kapitel werden wir eingehend die am Ende von Abschnitt 3.6 aufgeworfene

Frage studieren: Sei F : V → V eine lineare Abbildung des n-dimensionalen

Vektorraums V in sich, G : n → V eine Karte, G−1 : V → n das entsprechende

Koordinatensystem und A die zur Abbildung in den Koordinaten G−1 ◦F ◦G gehörige

n × n-Matrix.

R

R

R

Für welche Matrizen A läßt sich eine Koordinatenwechselabbildung G−1 ◦ Ĝ : n →

n mit zugehöriger n × n-Matrix B finden, so daß Â := B −1 ◦ A ◦ B Diagonalgestalt

λ1 0 . . . 0

..

.

0 λ2

= .

..

..

..

.

.

0 . . . . . . λn

R

hat? Wir wollen uns hier auf den Fall beschränken, daß die Karten G und Ĝ

auseinander durch Drehungen hervorgehen, daß die Transformationsmatrix B also

orthogonal ist. In diesem Fall sagt man, daß B die Hauptachsentransformation für

die Matrix A vermittelt.

Man ist deshalb so an einer Diagonalform interessiert, weil diese einerseits eine

besonders naheliegende Interpretation der entsprechenden Abbildungen gestattet und

weil so andererseits Matrizen auf einfache Weise auch komplexen Berechnungen wie

Potenzieren oder unendlichen Reihenbildungen zugänglich gemacht werden.

Hat  Diagonalgestalt, so gilt  ◦ ~ej = λj ~ej und deshalb für die Basiselemente

x̂j := Ĝ(~ej ) von V :

F (x̂j ) = λj x̂j .

Derartige Vektoren x̂j heißen Eigenvektoren zum jeweiligen Eigenwert λj , diese

werden unter der Anwendung von F lediglich um den Faktor λj gestreckt. Solche

Eigenvektoren werden beim Aufsuchen der Diagonalform  von A eine grundlegende

Rolle spielen, dazu vgl. man den Abschnitt 7.3.

Es wird sich herausstellen, daß eine geschlossene Behandlung der angesprochenen

Fragen für reelle Vektorräume im allgemeinen nicht möglich ist. Deshalb werden wir

210

7 Eigenwerte und Hauptachsentransformation

im folgenden Abschnitt zunächst den Körper der komplexen Zahlen und komplexe

Vektorräume einführen und in Abschnitt 7.2 die unitären Matrizen als Verallgemeinerung der orthogonalen Matrizen behandeln.

In Abschnitt 7.4 werden wir, zunächst im Komplexen, für die größtmögliche“ Klasse

”

der normalen“ Matrizen Diagonalisierungsresultate herleiten. Ein entsprechendes

”

reelles Resultat können wir daraus im allgemeinen nur für die wesentlich speziellere

Klasse der symmetrischen (selbstadjungierten)“ Matrizen folgern, da nur in diesem

”

Fall stets die Existenz hinreichend vieler reeller Eigenwerte gesichert ist.

7.1 Der allgemeine Körperbegriff,

komplexe Vektorräume

Allgemeine Körper

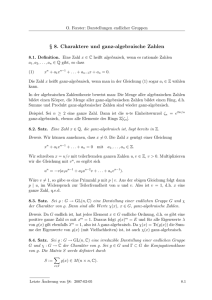

7.1.1 Definition

Eine Menge K, die mit einer Addition

+:K ×K →K

und einer Multiplikation

·:K ×K →K

versehen ist, heißt Körper, falls gilt:

(1) (K, +) ist eine abelsche Gruppe.

(2) Es bezeichne 0 das Nullelement von (K, +) und K ∗ := K\{0}. Dann ist (K ∗ , · )

ebenfalls eine abelsche Gruppe.

(3) Die Distributivgesetze gelten, d. h. für alle a, b, c, d ∈ K ist

(a + b) · c = a · c + b · c,

a · (c + d) = a · c + a · d.

Das neutrale Element bzgl. der Multiplikation wird mit 1 bezeichnet und die inversen

Elemente bzgl. der Addition mit (−a) und bzgl. der Multiplikation mit a−1 oder

1

a . In jedem Körper gelten insbesondere sowohl für die Addition als auch für die

Multiplikation die Regeln, wie wir sie in Abschnitt 1.1 für (abelsche) Gruppen

zusammengestellt haben. Darüber hinaus haben wir für die Verknüpfung additiver und

multiplikativer Eigenschaften folgende Gesetze:

7.1.2 Satz

Sei K ein Körper, dann gilt für alle a, b ∈ K:

(a) a · 0 = 0 · a = 0,

211

7.1 Der allgemeine Körperbegriff, komplexe Vektorräume

(b) aus a · b = 0 folgt a = 0 oder b = 0,

(c) (−a) · b = a · (−b) = −(a · b),

(Nullteilerfreiheit)

(−a) · (−b) = a · b.

Für den Beweis sowie für weitere Folgerungen aus den Körperaxiomen verweisen wir

auf die Lehrbücher der Analysis etwa von O. Forster [4, § 2] und von H. Grauert, I.

Lieb [6, § 3].

Der Körper der reellen Zahlen verfügt zudem über einen Abstandsbegriff (Betrag),

bzgl. dessen er vollständig ist, und über eine archimedische Anordnung (≤, ≥).

Der Körper der komplexen Zahlen

C

Der für das Folgende außerordentlich wichtige Körper

der komplexen Zahlen

wird im allgemeinen in der Differentialrechnung definiert. Daher werden hier manche

Eigenschaften nur skizziert und einige Beweise übergangen. Zur weiteren Information

sei wieder auf O. Forster [4, § 13] verwiesen.

C als den zweidimensionalen reellen Vektorraum

C := R2 = {(x, y) : x, y ∈ R}

ein. Damit ist C bereits eine additive abelsche Gruppe. Eine Multiplikation

·:C×C→C

Wir führen

wird durch

(x, y) · (u, v) := (xu − yv, xv + yu)

C

erklärt. Damit wird

zum Körper: das neutrale Element ist bzgl. der Addition

0 = (0, 0) und bzgl. der Multiplikation 1 = (1, 0). Das Negative von (x, y) ist

1

(−x, −y), für (x, y) 6= 0 gilt (x, y)−1 = x2 +y

2 (x, −y).

Die reellen Zahlen werden folgendermaßen in den komplexen Zahlkörper eingebettet:

Die Abbildung

Φ : → , x 7→ (x, 0)

R C

ist ein injektiver Körperhomomorphismus, d. h. stets ist

Φ(x + y) = Φ(x) + Φ(y) und

R

C

Φ(x · y) = Φ(x) · Φ(y).

Infolgedessen ist Φ( ) ein Teilkörper von , d. h. eine Teilmenge von

denselben Verknüpfungen wie versehen, ein Körper. Man identifiziert

C

C und, mit

R = Φ(R) = {(x, 0) : x ∈ R}.

Für a ∈ R, (x, y) ∈ C gilt a · (x, y) = (a, 0) · (x, y) = (a · x, a · y), die

Skalarmultiplikation auf R2 ist also ein Spezialfall der Multiplikation auf C.

212

7 Eigenwerte und Hauptachsentransformation

Durch Einführung der imaginären Einheit i := (0, 1) mit i2 = −1 gelangt man zur

üblichen Darstellung komplexer Zahlen

(x, y) = (x, 0) + (0, y) = x · 1 + y · i = x + iy.

Da jetzt i stets die imaginäre Einheit bezeichnet, steht es als Summationsindex

nicht mehr zur Verfügung. Deshalb ersetzen wir fortan die bisherigen StandardSummationsindizes i, j durch µ, ν.

C

Für z = x + iy ∈

ist Re(z) := x der Realteil und Im(z) := y der Imaginärteil

von z. Zu jeder komplexen Zahl z = x + iy wird die konjugiert komplexe Zahl

z̄ = x − iy erklärt. Wegen z̄¯ = z ist die Konjugation eine bijektive Abbildung.

Ferner gilt z1 + z2 = z̄1 + z̄2 und z1 · z2 = z̄1 · z̄2 , die Konjugation ist also ein

Körperisomorphismus.

Da reelle Zahlen durch die Konjugation nicht verändert werden, ist diese insbesondere

eine bijektive lineare Abbildung des -Vektorraums

in sich, eine umkehrbar lineare Abbildung. Sie ist anschaulich eine Spiegelung an der x-Achse. Die Elemente

iy, y ∈ , der y-Achse heißen rein imaginär; es gilt: = {(x, 0) : x ∈ } = {z :

z = z̄} und i := {iy : y ∈ } = {(0, y) : y ∈ } = {z : z = −z̄}.

R

R

R

R

R

C

R

R

R

Mittels der Konjugation erhält man geschlossene Formeln für Real- und Imaginärteil:

1

Re(z) = (z + z̄),

2

Im(z) =

1

(z − z̄).

2i

Betrag einer komplexen Zahl

Für z = x + iy ∈

C wird entsprechend der euklidischen Länge in R2 durch

|z| :=

p

x2 + y 2

der Betrag erklärt, offensichtlich ist |z|2 = z · z̄. Damit erhält man für z 6= 0 eine

einfache Formel zur Bestimmung der komplexen Kehrwerte:

1

z̄

= 2.

z

|z|

Es gelten die typischen Eigenschaften eines Betrages, für alle z, z1 , z2 ∈

C ist:

(1) |z| = 0 ⇔ z = 0,

(2) |z1 · z2 | = |z1 | · |z2 |,

(3) |z1 + z2 | ≤ |z1 | + |z2 |.

(Dreiecksungleichung)

Die erste und die dritte Eigenschaft folgen unmittelbar daraus, daß der Betrag der

komplexen Zahl z = x + iy mit der euklidischen Länge des Vektors (x, y) ∈ 2

übereinstimmt. Für die multiplikative Eigenschaft berechnet man

R

|z1 · z2 | = |(x1 + iy1 ) · (x2 + iy2 )| = |(x1 x2 − y1 y2 ) + i(x1 y2 + x2 y1 )|

213

7.1 Der allgemeine Körperbegriff, komplexe Vektorräume

=

q

x21 x22 + y12 y22 + x21 y22 + x22 y12 =

q

(x21 + y12 ) · (x22 + y22 ) = |z1 | · |z2 |.

Da Konvergenz einer komplexen Zahlenfolge (zk )k∈N = (xk + iyk )k∈N äquivalent

zur Konvergenz der beiden reellen Zahlenfolgen (xk )k∈N und (yk )k∈N ist, erhält man

aus der Vollständigkeit von :

R

C der komplexen Zahlen ist vollständig.

Im Gegensatz zu R ist jedoch C nicht angeordnet, man kann also nicht von größeren“

”

Der Körper

und kleineren“ komplexen Zahlen sprechen.

”

Komplexe Vektorräume

7.1.3 Definition

Auf einer nichtleeren Menge V sei eine Addition

+: V ×V →V

und eine Skalarmultiplikation

·:

C×V

→V

gegeben. Es sei (V, +) eine abelsche Gruppe, es gelten also die Eigenschaften (1)-(4)

aus Definition 1.1.3. Ferner gelte für alle c, d ∈ und x, y ∈ V :

C

(5) 1 · x = x,

(Unitäres Gesetz)

(6) (c · d) · x = c · (d · x),

(Assoziativgesetz)

(7) (c + d) · x = c · x + d · x und c · (x + y) = c · x + c · y.

Dann heißt V ein komplexer Vektorraum oder

C-Vektorraum.

(Distributivgesetze)

Man beachte die nahezu wörtliche Übereinstimmung mit der Definition 1.2.1, es wird

nur der Skalarenkörper durch ersetzt. Mit Ausnahme der Abschnitte, in denen Orthogonalität eine Rolle spielt (d. h. Kapitel 4.5 und Kapitel 6), kann im gesamten Buch

ohne weiteres durch ersetzt werden. Hinsichtlich der Orthogonalität werden wir

unten zeigen, daß sich die Definition des Skalarproduktes in geeigneter Weise modifizieren läßt. Zur Vermeidung von Mißverständnissen bezüglich des zugrundeliegenden

Skalarenkörpers (man vgl. Satz 7.1.6) spricht man von linearer (Un-) Abhängigkeit

über , -Dimension (man schreibt dimC ), usw.

R

C

R

C

CC

Der n-dimensionale komplexe Zahlenraum

Cn := {(z1, . . . , zn) : zν ∈ C}

ist mit den Verknüpfungen

~z + w

~ := (z1 + w1 , . . . , zn + wn ) und

c · ~z := (c · z1 , . . . , c · zn )

214

7 Eigenwerte und Hauptachsentransformation

ein komplexer Vektorraum mit der

C-Basis

{~e1 = (1, 0, . . . , 0), . . . , ~en = (0, . . . , 0, 1)}.

R

R

C

In derselben Weise, wie als Teilmenge von aufgefaßt werden kann, ist auch der

n-dimensionale reelle Zahlenraum n in n enthalten; für ~z ∈ n schreiben wir

~z = ~x + i~y mit ~x, ~y ∈ n .

R

C

C

Es gilt wörtlich wie in Satz 3.3.14:

7.1.4 Satz

dimC

R

Cn = n.

C

Da

ein Teilkörper von

ist, wird jeder komplexe Vektorraum V durch Einschränkung der Skalarmultiplikation von

× V auf

× V zu einem reellen

Vektorraum. Im Folgenden stellen wir dar, wie die Eigenschaften von V als Vektorraum und als -Vektorraum zusammenhängen.

C

R

R

C

7.1.5 Satz

C

Es sei V ein -Vektorraum und {z1 , . . . , zn } eine Basis von V über

{z1 , i · z1 , . . . , zn , i · zn } eine -Basis von V .

R

Beweis

C. Dann ist

R

Wir zeigen zunächst die lineare Unabhängigkeit über . Seien a1 , . . . , an , b1 , . . . , bn ∈

mit

n

n

X

X

aν zν +

bν (i · zν ) = 0.

R

ν=1

Für cν := aν + ibν folgt

c1 = · · · = cn = 0, also

ν=1

Pn

ν=1 cν zν

= 0. Die lineare Unabhängigkeit über

C liefert

a1 = . . . = an = b1 = . . . = bn = 0.

R

Andererseits wird V auch von dem angegebenen System über

erzeugt. Da

{z1 , . . . , zn } über ein Erzeugendensystem von V ist, existieren zu beliebigem z ∈ V

komplexe Zahlen cν = aν + ibν ∈ , aν , bν ∈ , ν = 1, . . . , n, mit

C

z=

n

X

ν=1

C

cν zν =

n

X

ν=1

R

(aν + ibν )zν =

n

X

ν=1

aν zν +

n

X

bν (izν ).

ν=1

Eine unmittelbare Folgerung ist

7.1.6 Satz

Sei V ein komplexer Vektorraum mit dimC V = n. Dann gilt dimR V = 2n.

2

215

7.1 Der allgemeine Körperbegriff, komplexe Vektorräume

C

R

R

Die Isomorphie von n und 2n über sieht man am deutlichsten, indem man im

n-tupel ~z = (z1 , . . . , zn ), zν = xν + iyν jede Komponente als Zahlenpaar (xν , yν )

schreibt: ((x1 , y1 ), . . . , (xn , yn )). Gemäß Satz 7.1.5 erhält man eine -Basis von n

durch

R

C

{~e1 , i · ~e1 , . . . , ~en , i · ~en }

n

=

(1, 0), (0, 0), . . . , (0, 0) , (0, 1), (0, 0), . . . , (0, 0) , . . .

o

. . . , (0, 0), . . . , (0, 0), (1, 0) , (0, 0), . . . , (0, 0), (0, 1) .

Komplex lineare Abbildungen

7.1.7 Definition

C

Unter einer komplex linearen oder -linearen Abbildung F : V → W zwischen

den komplexen Vektorräumen V und W versteht man eine Abbildung, die mit den

Vektorraumoperationen verträglich ist, so daß für alle x, y ∈ V , c ∈ gilt:

C

F (x + y) = F (x) + F (y),

Sei nun F :

Matrix

F (c · x) = c · F (x).

Cn → Cn eine C-lineare Abbildung, die durch die komplexe n × nc11

..

C=

.

cn1

...

...

c1n

..

, cµν = aµν + ibµν , aµν , bµν ∈

.

cnn

gegeben wird.

R

R

R

R,

Man kann F insbesondere auch als -lineare Abbildung 2n → 2n auffassen. Wir

wollen untersuchen, wie die zugehörige reelle 2n × 2n-Matrix A aus C hervorgeht.

Dazu sind die Bilder der Einheitsvektoren ~e1 , i · ~e1 , . . . , ~en , i · ~en zu bestimmen. Für

ν = 1, . . . , n gilt:

F (~eν ) = (c1ν , . . . , cnν ) = (a1ν , b1ν ), . . . , (anν , bnν ) ,

F (i~eν ) = i · (ciν , . . . , cnν ) = (i · c1ν , . . . , i · cnν )

= (−b1ν , a1ν ), . . . , (−bnν , anν ) ,

und man erhält:

a11

b11

.

A=

..

a

n1

bn1

−b11

a11

..

.

...

...

a1n

b1n

..

.

−bn1

an1

...

...

ann

bnn

−b1n

a1n

..

.

.

−b

nn

ann

216

7 Eigenwerte und Hauptachsentransformation

Also geht die reelle Matrix A aus der komplexen Matrix C hervor, indem man jede

komplexe Komponente cµν = aµν + ibµν von C durch das reelle 2 × 2-Kästchen

aµν −bµν

bµν aµν

ersetzt.

Auch die Determinantentheorie für komplexe Matrizen läßt sich genauso wie im

reellen Fall durchführen. Insbesondere gilt:

7.1.8 Satz

C

C

Es sei F : n → n eine

Dann sind äquivalent:

C-lineare Abbildung mit zugehöriger Matrix C = C n,n.

(a) Die Abbildung F ist bijektiv.

(b) Die Matrix C ist nichtsingulär.

(c) det(C) 6= 0.

Nach diesen Vorbereitungen definieren wir genauso wie in 3.8.5:

7.1.9 Definition

Die Menge aller nichtsingulären komplexen n × n-Matrizen

C

GL(n, ) := {C : C ist komplexe n × n-Matrix mit det(C) 6= 0}

heißt allgemeine lineare Gruppe vom Rang n über

7.1.10 Bemerkung

C.

C

Im Zusammenhang mit der Determinantentheorie -linearer Abbildungen ist Vorsicht

geboten, da sich hier der Wert der Determinante ändern kann, wenn man zu der Interpretation derselben Abbildung als -linearer Abbildung zwischen -Vektorräumen

mit doppelt so großer -Dimension wechselt. Als Beispiel betrachten wir F : → ,

F (z) = −z; die entsprechende komplexe 1 × 1-Matrix lautet C = ( −1 ), det(C) =

2 →

2 , F (x, y) = −(x, y) gehört dagegen die reelle 2 × 2-Matrix

−1. Zu

F :

−1 0

A=

mit det(A) = 1.

0 −1

R

R

R

R

R

C C

Ein komplexes Skalarprodukt

C

Um auch n mit einem Skalarprodukt

p zu versehen, geht man von der Idee aus, daß

n die euklidische Norm k ~

z k = |z1 |2 + . . . + |zn |2 tragen soll und daß diese von

C

!

dem gesuchten Skalarprodukt erzeugt werden soll: (~z, ~z ) = k ~z k2 . Indem man noch

217

7.1 Der allgemeine Körperbegriff, komplexe Vektorräume

das bereits erwähnte Gesetz |zν |2 = z̄ν · zν beachtet, gelangt man zu der Setzung

(~z, w)

~ :=

n

X

z̄ν · wν .

ν=1

C

Es stellt sich heraus, daß die axiomatische Beschreibung des Skalarproduktes in n

oder allgemeiner in komplexen Vektorräumen gegenüber der Charakterisierung in

Satz 6.2.1 für den n bzw. für reelle Vektorräume hinsichtlich der Linearitäts- und

Symmetrieeigenschaften zu modifizieren ist.

R

7.1.11 Satz

Für das durch (~z, w)

~ =

Skalarprodukt gilt:

Pn

ν=1 z̄ν

· wν auf

Cn

gegebene kanonische komplexe

C

(1) Es ist konjugiert linear in der ersten Komponente, d. h. für c ∈ , ~z, ~z 0 , w

~∈

gilt:

(~z + ~z 0 , w)

~ = (~z, w)

~ + (~z 0 , w),

~

(c · ~z, w)

~ = c̄ · (~z, w).

~

(2) Es ist linear in der zweiten Komponente, d. h. für c ∈

(~z, w

~ +w

~ 0 ) = (~z, w)

~ + (~z, w

~ 0 ),

Cn

C, ~z, w,

~ w

~ 0 ∈ Cn gilt:

(~z, c · w)

~ = c · (~z, w).

~

(3) Es ist Hermitesch (konjugiert symmetrisch), d. h. für ~z, w

~∈

Cn gilt:

(~z, w)

~ = (w,

~ ~z ).

(4) Es ist positiv definit, d. h. für ~z ∈

(~z, ~z ) ≥ 0

Cn ist (~z, ~z ) reell, und es gilt:

und (~z, ~z ) > 0, falls ~z 6= 0.

Beweis

Der Beweis folgt durch elementares Nachrechnen aus der Definition des Skalarprodukts.

2

C C

C

Abbildungen n ⊕ n → mit den Eigenschaften (1) und (2) nennt man sesquilinear.

Das kanonische komplexe Skalarprodukt ist also eine Hermitesche, positiv definite

Sesquilinearform.

Es wird in der Literatur nicht einheitlich gehandhabt, ob das Skalarprodukt in der

ersten oder in der zweiten Komponente als konjugiert

linear definiert wird. Häufig

P

wird z. B. das Skalarprodukt in n auch durch nν=1 zν w̄ν eingeführt.

C

7.1.12 Satz

Durch die Setzung

v

u n

p

uX

k ~z k := (~z, ~z ) = t

z̄ν · zν

ν=1

218

7 Eigenwerte und Hauptachsentransformation

Cn zu einem normierten komplexen Vektorraum. Die Abbildung k . k n:

C R hat also die typischen Eigenschaften einer Norm; für alle c ∈ C, ~z, w~ ∈ C

wird

n →

gilt:

(1) k ~z k = 0 ⇔ ~z = 0,

(2) k c · ~z k = |c| · k ~z k,

(3) k ~z + w

~ k ≤ k ~z k + k w

~ k.

Beweis

Man könnte zunächst die auch in

Cn gültige Cauchy-Schwarzsche Ungleichung

|(~z, w)|

~ ≤ k ~z k · k w

~k

herleiten und anschließend genauso wie im Beweis von Satz 6.2.4 verfahren.

Hier wollen wir allerdings direkt auf das dort erzielte Resultat zurückgreifen und

verwenden, daß n und 2n als -Vektorräume kanonisch isomorph sind. Wie bereits

vorher bemerkt, stimmen für

C

R

R

~z = (z1 , . . . , zn ) = (x1 + iy1 , . . . , xn + iyn ) = ((x1 , y1 ), . . . , (xn , yn ))

die euklidische Norm in

R2n und die euklidische Norm in Cn überein:

2

k (x1 , y1 , . . . , xn , yn ) k =

n

X

ν=1

x2ν

+

yν2

=

n

X

z̄ν · zν = k ~z k2 .

ν=1

Die Eigenschaften (1) und (3) folgen also direkt aus dem reellen Resultat. Für c ∈

~z ∈ n gilt weiter:

C

k c · ~z k2 = (c · ~z, c · ~z ) = c̄ · (~z, c · ~z ) = c̄ · c · (~z, ~z ) = |c|2 · k ~z k2 .

C,

2

7.2 Unitäre und adjungierte Abbildungen

Die unitäre Gruppe

Die unitären Abbildungen sind die komplexen Verallgemeinerungen der orthogonalen

Abbildungen. Zwar könnte man die folgende Theorie auch allgemein in endlichdimensionalen Vektorräumen mit Skalarprodukt (diese nennt man unitär bzw. im reellen Fall

euklidisch ) durchführen, wir beschränken uns aber der Einfachheit halber auf Abbildungen n → n . Zudem kann man sich, ganz ähnlich wie bei allgemeinen linearen

Abbildungen in Kapitel 3, durch die Einführung unitärer Karten stets auf diesen Fall

zurückziehen.

C

C

Zur Definition wählen wir eine der Eigenschaften aus Satz 6.3.2.

219

7.2 Unitäre und adjungierte Abbildungen

7.2.1 Definition

C

Eine komplexe n × n-Matrix C heißt unitär, falls k C ◦ ~z k = k ~z k für alle ~z ∈ n

gilt. Eine lineare Abbildung F : n → n heißt unitär, falls die zugehörige Matrix

unitär ist. Wir nennen

C

C

U (n) := {C : C ist unitäre n × n-Matrix}

die unitäre Gruppe vom Rang n.

Tatsächlich ist die Bezeichnung unitäre Gruppe“ gerechtfertigt:

”

7.2.2 Satz

C

U (n) ist eine Untergruppe von GL(n, ).

Beweis

Offenbar ist die zu C ∈ U (n) gehörige lineare Abbildung injektiv. Wie in Kapitel 3

folgt daraus, daß C nichtsingulär ist und C −1 ∈ GL(n, ) existiert. Es folgt

U (n) ⊂ GL(n, ) und auf Grund von k ~z k = k C ◦ C −1 ◦ ~z k = k C −1 ◦ ~z k

auch C −1 ∈ U (n). Wegen E n,n ∈ U (n) ist U (n) 6= ∅. Schließlich ist U (n) auch

gegenüber der Matrizenmultiplikation abgeschlossen, denn mit C1 , C2 ∈ U (n) ist

wegen k C1 ◦ C2 ◦ ~z k = k C2 ◦ ~z k = k ~z k auch C1 ◦ C2 ∈ U (n).

2

C

C

Wir studieren zunächst die Verbindungen mit dem reellen Begriff der orthogonalen

n×n ist natürlich auch eine komplexe Matrix

Matrix. Eine reelle Matrix C ∈

n×n

C ∈

und vermittelt damit sowohl Abbildungen FR : n → n als auch

n

FC :

→ n . Die komplexe Abbildung FC geht dabei aus FR hervor, indem man

für ~z = ~x + i~y ∈ n , ~x, ~y ∈ n beachtet:

R

C

C

C

C

R

R

R

FC (~z ) = FC (~x + i~y ) = FC (~x ) + iFC (~y ) = C ◦ ~x + i C ◦ ~y = FR (~x ) + iFR (~y ).

Dieses Verfahren, das man auch unabhängig vom Matrizenkalkül durchführen kann,

heißt Komplexifizierung.

7.2.3 Satz

O(n) ⊂ U (n).

Beweis

Sei C ∈ O(n) und ~z = ~x + i~y , ~x, ~y ∈

in n ergeben:

C

Rn. Die Eigenschaften der euklidischen Norm

k ~z k2 = k ~x k2 + k ~y k2 = k C ◦ ~x k2 + k C ◦ ~y k2

= k C ◦ ~x + i C ◦ ~y k2 = k C ◦ (~x + i~y ) k2 = k C ◦ ~z k2 .

2

220

7 Eigenwerte und Hauptachsentransformation

C

R

R

Wie bereits im vorhergehenden Abschnitt erläutert, können wir n und 2n als Vektorräume identifizieren und entsprechend -lineare Abbildungen n → n als

-lineare Abbildungen 2n → 2n auffassen. In diesem Sinne ist der folgende Satz

zu verstehen.

R

R

C

R

C

C

7.2.4 Satz

U (n) ist eine Untergruppe von O(2n).

Beweis

R

Es sei Φ : U (n) → 2n×2n die in Abschnitt 7.1 beschriebene Abbildung: Für

C = (cµν )µ,ν=1,...,n erhält man A = Φ(C), indemman jede komplexe

Komponente

aµν −bµν

cµν = aµν + ibµν durch das reelle 2 × 2-Kästchen

ersetzt.

bµν aµν

Wir haben also zu zeigen, daß Φ : U (n) → O(2n) ein injektiver Gruppenhomomorphismus ist.

Da C und A = Φ(C) dieselbe Abbildung beschreiben und die euklidische Norm in

n mit der in 2n übereinstimmt, folgt Φ(U (n)) ⊂ O(2n) aus Satz 6.3.2.

C

R

Wir zeigen nun, daß Φ ein Gruppenhomomorphismus ist. Seien C1 , C2 ∈ U (n). Die

durch C1 ◦ C2 gegebene Abbildung n → n stimmt mit der durch Φ(C1 ) ◦ Φ(C2 )

gegebenen Abbildung 2n → 2n überein, denn die Komposition der Abbildungen

ist unabhängig davon, ob man n als komplexen oder reellen Vektorraum interpretiert.

Also gilt Φ(C1 ◦ C2 ) = Φ(C1 ) ◦ Φ(C2 ).

R

R

C

C

C

Die Injektivität von Φ ergibt sich schließlich aus

Φ(C) = E 2n,2n

⇒

C = E n,n .

2

Im Spezialfall n = 1 läßt sich Genaueres aussagen:

7.2.5 Satz

U (1) ∼

= SO(2).

Beweis

Für die im vorherigen Beweis betrachtete Abbildung Φ : U (1) → O(2) bleibt zu

zeigen:

Φ(U (1)) ⊂ SO(2), Φ : U (1) → SO(2) ist surjektiv.

2 = |c · c̄| = |c̄| = |c| und damit |c| = 1. Mit

Sei c ∈ U (1), es ist also insbesondere |c|

a −b

2

2

c = a + ib gilt a + b = 1 und Φ(c) =

, also Φ(c) ∈ SO(2).

b a

Um noch die Surjektivität von Φ zu zeigen, sei A ∈ SO(2)

gegeben.

Gemäß Satz 6.1.8

a

−b

existieren dann a, b ∈ mit a2 + b2 = 1 und A =

. Für c := a + ib gilt

b a

R

221

7.2 Unitäre und adjungierte Abbildungen

C

|c| = 1 und damit für alle d ∈ : |c · d| = |c| · |d| = |d|, d. h. c ∈ U (1). Ferner ist

Φ(c) = A und folglich im(Φ) = SO(2).

2

R2 ist also die Multiplikation mit einer komplexen Zahl c, deren

Eine Drehung des

Betrag |c| = 1 ist.

Das nächste Ziel ist die komplexe Entsprechung des Satzes 6.3.2, es sollen also einige

äquivalente und für das Folgende grundlegende Charakterisierungen unitärer Matrizen

zusammengestellt werden. Dazu sind vorbereitend einige aus Kapitel 6 bekannte

Begriffe auf den n auszudehnen und einige Hilfsresultate zu beweisen.

C

Komplexe Orthogonalität

7.2.6 Definition

C

Die Vektoren ~z, w

~ ∈ n heißen (komplex) orthogonal, wenn (~z, w)

~ = 0 gilt. Unter

dem orthogonalen Komplement des Untervektorraums V ⊂ n verstehen wir

V ⊥ := {~z ∈

7.2.7 Satz

Cn :

C

(~z, w)

~ = 0 für alle w

~ ∈ V }.

C

R

Die Vektoren ~z, w

~ ∈ n seien (komplex) orthogonal, ~z = ~x + i~y , w

~ = ~u + i~v

mit ~x, ~y , ~u, ~v ∈ n . Dann sind die entsprechenden Vektoren (x1 , y1 , . . . , xn , yn ),

(u1 , v1 , . . . , un , vn ) ∈ 2n (reell) orthogonal.

R

Beweis

Aus der komplexen Orthogonalität folgt

0 = (~z, w)

~ =

n

X

(xν − i yν )(uν + i vν )

ν=1

=

n

X

(xν uν + yν vν ) + i ·

ν=1

n

X

(xν vν − yν uν )

ν=1

und damit durch Betrachtung des Realteils die Behauptung.

2

C

Der Beweis zeigt, daß komplexe Orthogonalität in n eine wesentlich stärkere Eigenschaft als reelle Orthogonalität in 2n ist, denn das entsprechende reelle Skalarprodukt

ist lediglich der Realteil des komplexen Skalarprodukts. Dazu geben wir folgendes

einfache Beispiel:

R

7.2.8 Beispiel

C natürlich nicht orthogonal, die entsprechenden

R2 hingegen schon.

Die komplexen Zahlen 1 und i sind in

reellen Vektoren (1, 0) und (0, 1) in

222

7 Eigenwerte und Hauptachsentransformation

7.2.9 Satz

Für jeden Untervektorraum V ⊂

V

Cn gilt

⊥⊥

Beweis

Offensichtlich ist V ⊥

⊥

= {~z ∈

:= V

Cn :

⊥

⊥

= V.

(~z, w)

~ = 0 für alle w

~ ∈ V ⊥} ⊃ V .

Die umgekehrte Inklusion beweist man mit Hilfe eines Dimensionsarguments. Sei

k = dimC V , wie in Satz 6.3.6 zeigt man dimC V ⊥ = n − k. Eine Wiederholung

⊥

dieses Schlusses ergibt dimC V ⊥ = n − (n − k) = k und damit wegen V ⊂ V ⊥⊥

die behauptete Gleichheit.

2

In unendlichdimensionalen (unitären) Vektorräumen kann das Dimensionsargument

nicht verwendet werden. Tatsächlich behält der obige Satz dort nur unter zusätzlichen

Voraussetzungen seine Gültigkeit.

7.2.10 Definition

Man nennt ein k-tupel (~z1 , . . . , ~zk ) von Vektoren aus

nales k-Bein, wenn für µ, ν = 1, . . . , k gilt:

Cn ein (komplexes) orthogo-

(~zµ , ~zν ) = δµν .

Ist ein orthogonales k-Bein gleichzeitig auch Erzeugendensystem eines Untervektorraums V von n , so spricht man von einer Orthonormalbasis von V .

C

Eine Orthonormalbasis von V ist also eine Basis aus paarweise orthogonalen, normierten (d. h. mit Länge 1) Vektoren.

Wir bezeichnen mit C̄ t die zur m × n-Matrix C konjugiert transponierte n × mMatrix, die also aus C = (cµν ) µ=1,...,m durch Transponieren und komponentenweises

ν=1,...,n

Konjugieren hervorgeht:

c̄11

c̄12

C̄ t =

...

c̄21

c̄22

..

.

...

...

..

.

c̄1n

c̄2n

. . . c̄mn

c̄m1

c̄m2

.

..

.

Wir betrachten nun wieder ausschließlich quadratische Matrizen.

7.2.11 Satz

Für jede n × n-Matrix C und alle Vektoren ~z, w

~∈

Cn gilt:

(w,

~ C ◦ ~z ) = (C̄ t ◦ w,

~ ~z ).

223

7.2 Unitäre und adjungierte Abbildungen

Beweis

Das komplexe Skalarprodukt lautet in Matrizenschreibweise:

(~z, w)

~ = ~z¯ t ◦ w,

~

daraus erhält man:

¯ t ◦ w)

¯~ t ◦ ~z = w

¯~ t ◦ (C ◦ ~z ) = (w,

(C̄ t ◦ w,

~ ~z ) = (C̄ t ◦ w)

~ t ◦ ~z = (C̄

~ C ◦ ~z ).

7.2.12 Satz

Ist D eine komplexe n × n-Matrix derart, daß ~z¯ t ◦ D ◦ ~z = 0 für alle ~z ∈

dann folgt: D = On,n .

2

Cn gilt,

Beweis

C

Wir zeigen zunächst, daß die Sesquilinearform, die je zwei Vektoren ~z, w

~ ∈ n

t

die komplexe Zahl (~z, D ◦ w)

~ = ~z¯ ◦ D ◦ w

~ zuordnet, bereits durch die Werte der

t

¯

quadratischen Form ~z 7→ ~z ◦ D ◦ ~z bestimmt ist. Bei dem folgenden Verfahren der

Polarisierung setzt man geeignete Kombinationen der beliebig vorgegebenen Vektoren

~z, w

~ ∈ n ein:

C

¯~ t ◦ D ◦ ~z + w

¯~ t ◦ D ◦ w,

(~z + w)

~ t ◦ D ◦ (~z + w)

~ = ~z¯ t ◦ D ◦ ~z + ~z¯ t ◦ D ◦ w

~ +w

~

t

t

t

t

t

¯~ ◦ D ◦ ~z + w

¯~ ◦ D ◦ w,

(~z − w)

~ ◦ D ◦ (~z − w)

~ = ~z¯ ◦ D ◦ ~z − ~z¯ ◦ D ◦ w

~ −w

~

¯~ t ◦ D ◦ ~z + w

¯~ t ◦ D ◦ w,

(~z + iw)

~ t ◦ D ◦ (~z + iw)

~ = ~z¯ t ◦ D ◦ ~z + i~z¯ t ◦ D ◦ w

~ − iw

~

t

t

t

t

t

¯

¯

¯

¯

(~z − iw)

~ ◦ D ◦ (~z − iw)

~ = ~z ◦ D ◦ ~z − i~z ◦ D ◦ w

~ + iw

~ ◦ D ◦ ~z + w

~ ◦ D ◦ w.

~

Indem man jeweils die ersten und letzten beiden Gleichungen voneinander subtrahiert,

erhält man:

¯~ t ◦ D ◦ ~z

~z¯ t ◦ D ◦ w

~ +w

1

=

(~z + w)

~ t ◦ D ◦ (~z + w)

~ − (~z − w)

~ t ◦ D ◦ (~z − w)

~ ;

2

¯~ t ◦ D ◦ ~z

~z¯ t ◦ D ◦ w

~ −w

1

(~z + iw)

~ t ◦ D ◦ (~z + iw)

~ − (~z − iw)

~ t ◦ D ◦ (~z − iw)

~ .

=

2i

Diese Gleichungen werden zueinander addiert, und es folgt:

1

(~z + w)

~ t ◦ D ◦ (~z + w)

~ − (~z − w)

~ t ◦ D ◦ (~z − w)

~

~z¯ t ◦ D ◦ w

~=

4

1 (~z + iw)

~ t ◦ D ◦ (~z + iw)

~ − (~z − iw)

~ t ◦ D ◦ (~z − iw)

~ .

+

4i

Wir setzen nun in dieses auch an sich interessante Zwischenergebnis unsere Voraussetzung ein, daß stets ~z¯ t ◦ D ◦ ~z = 0 ist. Dadurch erhalten wir für alle ~z, w

~ ∈ n:

C

~z¯ t ◦ D ◦ w

~ = 0.

224

7 Eigenwerte und Hauptachsentransformation

Indem wir für ~z und w

~ die Elemente ~eµ und ~eν der kanonischen Basis des

einsetzen, folgt schließlich für D = (dµν )µ,ν=1,...,n :

Cn

2

dµν = ~eµt ◦ D ◦ ~eν = 0.

7.2.13 Bemerkung

Die komplexe n × n-Matrix D und damit die entsprechende Sesquilinearform S :

n ⊕

n →

, S(~z, w)

~ = ~z¯ t ◦ D ◦ w

~ = (~z, D ◦ w)

~ sind durch die quadratische

t

¯

Form ~z 7→ ~z ◦ D ◦ ~z, d. h. durch die Werte der Sesquilinearform auf der Diagonalen“

”

~z = w

~ eindeutig bestimmt.

C

C

C

Ein entsprechendes Resultat gilt im Reellen nur unter Zusatzvoraussetzungen,

wie et

0 1

wa der Symmetrie (man vgl. den Beweis von Satz 6.3.2), wie das Beispiel

−1 0

zeigt.

Unitäre Matrizen

7.2.14 Satz

Für alle komplexen n × n-Matrizen A = (~a1 , . . . , ~an ) sind äquivalent:

(a) Āt ◦ A = E;

(b) für alle ~z, w

~∈

C gilt (A ◦ ~z, A ◦ w)

~ = (~z, w);

~

(c) A ist unitär;

(d) (~a1 , . . . , ~an ) ist ein komplexes orthogonales n-Bein.

Beweis

C

(a) ⇒ (c)“: Für alle ~z ∈ n gilt in Matrizenschreibweise:

”

k ~z k2 = ~z¯ t ◦ ~z = ~z¯ t ◦ E ◦ ~z = (~z¯ t ◦ Āt ) ◦ (A ◦ ~z )

= (A ◦ ~z ) t ◦ (A ◦ ~z ) = k A ◦ ~z k2 .

(c) ⇒ (b)“: In diesem Beweisteil können wir von den in Satz 7.2.12 geleisteten

”

Vorarbeiten profitieren. Wir wollen zeigen, daß die Sesquilinearform

S:

Cn ⊕ Cn → C, S(~z, w)

~ = (A ◦ ~z, A ◦ w)

~ − (~z, w)

~

(∗)

stets den Wert 0 ergibt. Gemäß Voraussetzung (c) ist der Wert dieser Form auf der

Diagonalen“ ~z = w

~ stets 0. Indem man noch beachtet, daß für alle ~z, w

~∈ n

”

(A ◦ ~z, A ◦ w)

~ − (~z, w)

~ = ~z¯ t ◦ Āt ◦ A ◦ w

~ − ~z¯ t ◦ w

~

t

t

= ~z¯ ◦ Ā ◦ A − E ◦ w

~

C

225

7.2 Unitäre und adjungierte Abbildungen

gilt, daß also die Sesquilinearform S in (∗) durch die Matrix Āt ◦ A − E gegeben

wird, ergibt Satz 7.2.12 tatsächlich, daß es sich bei dieser Matrix um die Nullmatrix

handelt. Mithin verschwindet die Sesquilinearform S in (∗) identisch, und wir haben

gleichzeitig auch (c) ⇒ (a)“ mitbewiesen.

”

(b) ⇒ (d)“: Gemäß Voraussetzung (b) ist die Matrix A längen-“ und winkeltreu“,

”

”

”

das gilt insbesondere auch für die Elemente der kanonischen Basis des n :

C

δµν = (~eµ , ~eν ) = (A ◦ ~eµ , A ◦ ~eν ) = (~aµ , ~aν ).

(d) ⇒ (a)“: Dieser Schluß basiert allein auf der Definition der Matrizenmultiplikati”

on:

¯t

~a1

.

t

¯µt ◦ ~aν

Ā ◦ A = .. ◦ (~a1 , . . . , ~an ) = ~a

µ,ν=1,...,n

¯nt

~a

= (~aµ , ~aν )

= (δµν )µ,ν=1,...,n = E.

µ,ν=1,...,n

2

Adjungierte Abbildungen

Wiederholt hat die zur komplexen n × n-Matrix A konjugiert transponierte Matrix Āt

eine Rolle gespielt, nicht zuletzt als Umkehrmatrix unitärer Matrizen. Deshalb werden

wir nun die entsprechenden Abbildungen eingehender studieren.

7.2.15 Definition

Sei A eine komplexe n × n-Matrix und F :

Abbildung.

Cn

→

Cn die zugehörige C-lineare

(a) Die zur konjugiert transponierten Matrix Āt gehörige

n →

n heißt die zu F adjungierte Abbildung.

C

(b) Gilt

C

Āt

C-lineare

Abbildung

= A, so heißt A Hermitesch und F selbstadjungiert.

Ein Spezialfall hiervon ist die entsprechende reelle Definition:

7.2.16 Definition

Sei A eine reelle n × n-Matrix und F :

Abbildung.

Rn

(a) Die zur transponierten Matrix At gehörige

die zu F adjungierte Abbildung.

→

Rn

die zugehörige

R-lineare

R-lineare Abbildung Rn → Rn heißt

(b) Ist A symmetrisch, d. h. A = At , so nennen wir F selbstadjungiert.

226

7 Eigenwerte und Hauptachsentransformation

7.2.17 Bemerkung

R

R

Bei reellen Matrizen A ∈ n×n und zugehörigen linearen Abbildungen F : n →

n fallen die adjungierte und die duale Abbildung zusammen. Im Komplexen dagegen wird die duale Abbildung F ∗ unverändert durch At , die adjungierte Abbildung

F adjungiert dagegen durch Āt gegeben. Hier besteht bei den Abbildungen der Zusam

menhang: F adjungiert (~z ) = F ∗ ~z¯ .

R

Um im Folgenden nicht unnötig komplizierte Bezeichnungen verwenden zu müssen,

werden wir mitunter die zur Matrix A gehörige lineare Abbildung ebenfalls mit A

bezeichnen und beispielsweise von Āt als der zu A adjungierten Abbildung sprechen.

7.2.18 Satz

Eine komplexe n × n-Matrix A ist genau dann Hermitesch, wenn für alle ~z ∈

Zahl (~z, A ◦ ~z ) reell ist.

Cn die

Beweis

Grundlegend ist die folgende, auf den Eigenschaften konjugiert transponierter Matrizen beruhende Gleichheit:

(~z, Āt ◦ ~z ) = (A ◦ ~z, ~z ) = (~z, A ◦ ~z ).

Ist A Hermitesch, so gilt für alle ~z ∈

diese Zahlen stets reell.

Cn also (~z, A ◦ ~z ) = (~z, A ◦ ~z ), demgemäß sind

Ist dagegen (~z, A ◦~z ) stets reell, d. h. (~z, A ◦~z ) = (~z, A ◦ ~z ), so verschwindet die von

Āt − A gegebene quadratische Form identisch, es ist also stets (~z, (Āt − A) ◦ ~z ) = 0.

Der schon wiederholt zitierte Satz 7.2.12 zeigt Āt − A = O und damit die Hermitizität

von A.

2

Auch um die Symmetrie einer reellen n × n-Matrix zu prüfen, ist die quadratische

Form (~z, A ◦ ~z ) für alle komplexen Vektoren ~z ∈ n zu betrachten.

C

7.2.19 Satz

Für die zur komplexen n × n-Matrix A gehörige lineare Abbildung gilt:

(a) ker(A) = im(Āt )⊥ ,

(b) im(A) = ker(Āt )⊥ .

Beweis

Sei ~z ∈ ker(A), d. h. A ◦ ~z = ~0. Für alle Āt ◦ w

~ ∈ im(Āt ), w

~ ∈

Satz 7.2.11

(~z, Āt ◦ w)

~ = (A ◦ ~z, w)

~ = (~0, w)

~ = 0.

Somit ist ker(A) ⊂ im(Āt )⊥ .

Cn, folgt mit

227

7.2 Unitäre und adjungierte Abbildungen

Sei nun umgekehrt ~z ∈ im(Āt )⊥ , für alle w

~∈

Cn haben wir also

0 = (~z, Āt ◦ w)

~ = (A ◦ ~z, w).

~

Indem man speziell w

~ = A ◦ ~z wählt, ergibt sich A ◦ ~z = ~0, ~z ∈ ker(A),

t

⊥

im(Ā ) ⊂ ker(A) und damit insgesamt Behauptung (a).

Indem man in (a) zu den orthogonalen Komplementen übergeht, die Matrix A durch

t

Āt ersetzt und Āt = A beachtet, erhält man

ker(Āt )⊥ = im(A)⊥⊥ .

C

Vorher hatten wir schon für beliebige Untervektorräume V ⊂ n die Gültigkeit von

V ⊥⊥ = V gezeigt, und folglich ist auch Behauptung (b) bewiesen.

2

Bei selbstadjungierten Abbildungen können wir mit Hilfe dieses Satzes durch Abspaltung des Kerns zu Isomorphismen übergehen.

7.2.20 Satz

C

C

Die lineare Abbildung F : n → n sei selbstadjungiert, es bezeichne V = ker(F )⊥ .

Dann ist die Einschränkung von F auf V

F |V : V → V

ein Isomorphismus.

Beweis

Gemäß dem vorhergehenden Satz ist im(F |V ) ⊂ im(F ) = ker(F )⊥ = V . Die

Abbildung F |V ist offensichtlich injektiv und damit auf Grund der Dimensionsformel

auch surjektiv.

2

Normale Abbildungen

Unitäre und selbstadjungierte Abbildungen scheinen zunächst wenig miteinander zu

tun zu haben: Unitäre Abbildungen sind längentreu, mithin stets Isomorphismen.

Selbstadjungierte Abbildungen können durchaus einen nichttrivialen Kern haben und

die eingesetzten Vektoren strecken oder stauchen. Dennoch teilen diese Abbildungen

eine Eigenschaft, die sich in Abschnitt 7.4 als entscheidend für die Diagonalisierbarkeit erweisen wird.

7.2.21 Definition

C

Wir nennen eine n × n-Matrix A und die zugehörige lineare Abbildung F : n →

n normal, wenn die Abbildung und ihre adjungierte kommutieren, falls also die

Bedingung

Āt ◦ A = A ◦ Āt

C

erfüllt ist.

228

7 Eigenwerte und Hauptachsentransformation

7.2.22 Satz

Eine n × n-Matrix A ist normal genau dann, wenn für alle ~z, w

~∈

Cn gilt:

(Āt ◦ ~z, Āt ◦ w)

~ = (A ◦ ~z, A ◦ w).

~

Beweis

Ist A normal, so folgt für alle ~z, w

~∈

(∗)

Cn

(A ◦ ~z, A ◦ w)

~ = (~z, Āt ◦ A ◦ w)

~ = (~z, A ◦ Āt ◦ w)

~

t

t

= (Ā ◦ ~z, Ā ◦ w).

~

C

Gilt nun umgekehrt (∗) für alle ~z, w

~ ∈ n , so folgt

~z, Āt ◦ A ◦ w

~ = (A ◦ ~z, A ◦ w)

~ = Āt ◦ ~z, Āt ◦ w

~

= ~z, A ◦ Āt ◦ w

~ ,

0 = ~z, Āt ◦ A − A ◦ Āt ◦ w

~ .

Indem man bei beliebigem w

~ für ~z = Āt ◦ A − A ◦ Āt ◦ w

~ einsetzt, erhält man

t

t

~

Ā ◦ A − A ◦ Ā ◦ w

~ = 0 und damit

Āt ◦ A − A ◦ Āt = O;

die Matrix A ist normal.

2

7.3 Eigenwerte

Wir haben stets die Theorie linearer Abbildungen und den Matrizenkalkül simultan und gleichberechtigt entwickelt und haben häufig mit Gewinn zwischen diesen

beiden Standpunkten gewechselt. In diesem Abschnitt stellen wir den Abbildungs”

standpunkt“ in den Vordergrund.

Es bezeichne V stets einen n-dimensionalen komplexen Vektorraum und F : V → V

eine -lineare Abbildung.

C

Eigenräume

7.3.1 Definition

Ein Vektor z ∈ V \ {0} heißt Eigenvektor von F zum Eigenwert λ ∈

Eigenwertgleichung

F (z) = λ · z

erfüllt ist.

C, wenn die

229

7.3 Eigenwerte

C

Da gleichzeitig Eigenwert λ und Eigenvektor z gesucht werden und die Abbildung ×

V → V , (λ, z) 7→ λ · z nicht linear ist, handelt es sich bei der Eigenwertbestimmung

um ein nichtlineares Problem.

Diese Begriffe stehen ebenso wie die im Folgenden noch zu definierenden auch für

beliebige n × n-Matrizen zur Verfügung, indem man die entsprechende -lineare

Abbildung betrachtet. So ist ~z ∈ n \ {~0} Eigenvektor von A zum Eigenwert λ ∈ ,

falls A ◦ ~z = λ · ~z gilt. Das Bestehen dieser Eigenwertgleichung ist äquivalent zu

(A − λE) ◦ ~z = ~0, bzw. auf Abbildungsebene zu (F − λ · id)(z) = 0. Also gilt

C

C

{z ∈ V : z ist Eigenvektor von F : V → V zu λ ∈

= {z : (F − λ · id)(z) = 0} = ker(F − λ · id).

C

C} ∪ {0}

7.3.2 Definition

Für λ ∈

C heißt die Menge aller Eigenvektoren zu λ, ergänzt um den Nullvektor,

Vλ := Vλ (F ) := ker(F − λ · id)

Eigenraum von F zum Eigenwert λ ∈

C.

7.3.3 Bemerkung

C

Als Kern einer linearen Abbildung ist Vλ ein -Untervektorraum von V . Genau dann

ist λ Eigenwert von F , wenn dim Vλ 6= 0 gilt. Ist z Eigenvektor zu λ von F , so auch

jedes komplexe Vielfache c · z, c ∈ .

C

7.3.4 Satz

Es seien z1 , . . . , zk Eigenvektoren von F zu den paarweise verschiedenen Eigenwerten

λ1 , . . . , λ k ∈ :

C

F (zν ) = λν zν ,

zν 6= 0,

λµ 6= λν für µ 6= ν.

Dann sind z1 , . . . , zk linear unabhängig.

Insbesondere hat F höchstens n paarweise verschiedene Eigenwerte.

Beweis

Wir führen den Beweis durch Induktion nach der Anzahl k der Eigenvektoren.

Der Fall k = 1 ist offensichtlich, denn Eigenvektoren sind definitionsgemäß vom

Nullvektor verschieden. Sei nun die Behauptung für k − 1 gezeigt, und es seien

z1 , . . . , zk Eigenvektoren zu den paarweise verschiedenen Eigenwerten λ1 , . . . , λk .

Wir betrachten Linearkombinationen des Nullvektors aus z1 , . . . , zk :

k

X

ν=1

aν zν = 0,

aν ∈

C.

230

7 Eigenwerte und Hauptachsentransformation

Man erhält durch Multiplikation mit λk :

k

X

aν λk zν = 0

ν=1

und durch die Anwendung von F :

0 = F (0) = F

k

X

!

aν zν

=

ν=1

k

X

aν F (zν ) =

ν=1

k

X

aν λν zν .

ν=1

Durch Subtraktion der beiden Gleichungen folgt:

k

X

aν (λk − λν )zν =

ν=1

k−1

X

aν (λk − λν )zν = 0.

ν=1

Nach Induktionsvoraussetzung sind z1 , . . . , zk−1 linear unabhängig und somit aν (λk −

λν ) = 0. Da die Eigenwerte als paarweise verschieden vorausgesetzt sind, erhalten wir

a1 = . . . = ak−1 = 0. Aus der ursprünglichen Linearkombination des Nullvektors

wird 0 = ak zk , hieraus folgt schließlich auch ak = 0.

2

Das charakteristische Polynom

Die Bestimmung von Eigenwerten soll auf die Bestimmung der Nullstellen eines

komplexen Polynoms reduziert werden. Wir fassen hier komplexe Polynome im Sinne

der analytischen Definition als Funktionen → auf.

C

C

n

C C

Sei G :

→ V eine Karte, d. h. ein -Vektorraumisomorphismus. Die Abbildung

F in den Koordinaten, G−1 ◦ F ◦ G, wird durch eine n × n-Matrix A gegeben. Wegen

der Linearität des Koordinatensystems G−1 lautet die Abbildung F − λ · id in den

Koordinaten: G−1 ◦(F −λ·id)◦G = G−1 ◦(F ◦G−λ·G) = G−1 ◦F ◦G−λ·G−1 ◦G =

G−1 ◦ F ◦ G − λ · idCn , sie wird also durch die Matrix A − λ · E beschrieben. Da

die komplexe Zahl λ Eigenwert von A bzw. F genau dann ist, wenn A − λE singulär

(nicht invertierbar) ist, liegt es nahe, die entsprechende Determinante zu betrachten:

det(A − λE) =

n

X

δ(ν1 , . . . , νn )(aν1 1 − λδν1 1 ) · . . . · (aνn n − λδνn n )

ν1 ,...,νn =1

n

n

= (−1) · (λ + Q(λ)) ,

dabei ist Q(λ) ein Polynom in λ vom Grade ≤ n − 1. Es handelt sich bei det(A − λE)

also um ein Polynom n-ten Grades in λ mit höchtem Koeffizienten (−1)n . Auf Grund

der Überlegungen aus Kapitel 5.6 ist det(A − λE) = det(F − λ · id) unabhängig von

der Wahl der Karte G.

231

7.3 Eigenwerte

7.3.5 Definition

Wir nennen P (λ) := PF (λ) := (−1)n ·det(F −λ·id) das charakteristische Polynom

der linearen Abbildung F .

Das charakteristische Polynom ist normiert, besitzt also höchsten Koeffizienten 1.

7.3.6 Satz

C

Sei P (λ) das charakteristische Polynom einer -linearen Abbildung F : V → V .

Dann ist λ ∈ Eigenwert von F genau dann, wenn P (λ) = 0 gilt.

C

Beweis

C

Die komplexe Zahl λ ∈

ist Eigenwert von F genau dann, wenn die Abbildung

F − λ · id nicht injektiv und damit nicht invertierbar ist. Letzteres ist jedoch äquivalent

zum Verschwinden der Determinante: P (λ) = det(F − λ id) = 0.

2

Das charakteristische Polynom ist invariant gegenüber

7.3.7 Satz

C-Isomorphismen:

C

Sei P (λ) das charakteristische Polynom einer -linearen Abbildung F : V → V .

∼

Sei W ein weiterer n-dimensionaler -Vektorraum und H : W → V ein Vektorraumisomorphismus. Für das charakteristische Polynom P̂ (λ) der Abbildung

F̂ := H −1 ◦ F ◦ H gilt P̂ (λ) = P (λ).

C

Beweis

C

C

Sei G : n → V eine Karte. Dann ist H −1 ◦ G eine Karte von W und F̂ lautet in

diesen Koordinaten

(H −1 ◦ G)−1 ◦ F̂ ◦ (H −1 ◦ G) = G−1 ◦ H ◦ H −1 ◦ F ◦ H ◦ H −1 ◦ G = G−1 ◦ F ◦ G,

das ist auch die Abbildung F in den Koordinaten G. Das charakteristische Polynom

ist aber von der Wahl der Karte unabhängig.

2

Als Folgerung erhalten wir die Existenz einer weiteren Matrixinvariante:

7.3.8 Definition

Unter der Spur einer quadratischen Matrix A = (aµν )µ,ν=1,...,n verstehen wir die

Summe der Diagonalelemente:

Sp(A) :=

n

X

aνν .

ν=1

7.3.9 Satz

C

Sei A ∈ n×n beliebig, B ∈

dieselbe Spur.

Cn×n invertierbar. Dann haben A und B −1 ◦ A ◦ B

232

7 Eigenwerte und Hauptachsentransformation

Beweis

Eine genaue Inspektion der Definition des charakteristischen Polynoms ergibt

PA (λ) = (−1)n det(A − λE)

n

X

= (−1)n

δ(ν1 , . . . , νn )(aν1 1 − λδν1 1 ) · . . . · (aνn n − λδνn n )

ν1 ,...,νn =1

n

= λ − Sp(A)λn−1 + Q̃(λ),

das Polynom Q̃(λ) ist vom Grade ≤ n − 2. Die Koeffizienten dieses Polynoms ändern

sich unter dem Koordinatenwechsel B nicht.

2

7.3.10 Bemerkung (Existenz reeller Eigenvektoren)

R

Sei λ ∈

ein Eigenwert der reellen n × n-Matrix A. Dann ist det(A − λE) = 0,

und es existiert ein ~x ∈ n \ {~0} mit (A − λE) ◦ ~x = ~0. Also besitzt A einen reellen

Eigenvektor.

R

Der folgende, für unsere Zwecke zentrale Satz verliert in den reellen Zahlen seine

Gültigkeit und ist der Grund dafür, daß die Eigenwerttheorie in komplexen Vektorräumen durchgeführt wird.

7.3.11 Satz (Fundamentalsatz der Algebra)

C

Jedes komplexe Polynom zerfällt über in Linearfaktoren. Genauer gilt: Sei P (λ) ein

Polynom vom Grade n über . Dann gibt es Zahlen s ∈ , s ≤ n, r1 , . . . , rs ∈

mit r1 + · · · + rs = n, a ∈ \ {0}, c1 , . . . , cs ∈ mit cµ 6= cν für µ 6= ν, so daß gilt:

C

C

N

C

N

P (λ) = a · (λ − c1 )r1 · . . . · (λ − cs )rs .

Man sagt, daß P (λ) in cν eine Nullstelle rν -ter Ordnung besitzt.

Der Beweis kann mit den hier zur Verfügung stehenden Mitteln nicht geführt werden

und wird im Rahmen der Funktionentheorie oder der Algebra gegeben.

Als Folgerung erhalten wir insbesondere ein Existenzresultat für komplexe Eigenwerte:

7.3.12 Satz

Jede

C-lineare Abbildung F : V

→ V besitzt mindestens einen Eigenwert.

7.3.13 Definition

N

Sei PF (λ) = (λ − λ1 )r1 · . . . · (λ − λs )rs mit λν 6= λµ für µ 6= ν, r1 , . . . , rs ∈ und

r1 + . . . + rs = n das charakteristische Polynom einer -linearen Abbildung F . Man

nennt die Nullstellenordnung rν die algebraische und die Dimension des Eigenraumes

dim Vλν die geometrische Vielfachheit des Eigenwertes λν .

C

233

7.3 Eigenwerte

7.3.14 Beispiele

(a) Sei

a1

A :=

...

..

.

O

∗

..

.

an

eine Dreiecksmatrix. Gemäß Satz 5.4.2 gilt:

P (λ) = (−1)n · det(A − λE) = (−1)n ·

n

Y

n

Y

(aν − λ) =

ν=1

(λ − aν ).

ν=1

Die Diagonalelemente a1 , . . . , an sind die Eigenwerte von A.

(b) Sei

O

a1

..

A :=

O

.

an

eine Diagonalmatrix. Es gilt A ◦ ~eν = aν · ~eν , d. h. ~eν ist Eigenvektor von A zum

Eigenwert aν . Die kanonische Basis ist eine Orthonormalbasis aus Eigenvektoren

von A. Die algebraischen und geometrischen Vielfachheiten der Eigenwerte

stimmen überein.

(c) Auch reelle Matrizen haben i. a. nur komplexe

Eigenwerte. Dazu berechnen wir

0 1

die Eigenwerte von A =

. Das charakteristische Polynom lautet

−1 0

−λ 1

P (λ) = det

= λ2 + 1, die Eigenwerte sind i und −i.

−1 −λ

(d) Nichtfür jedeMatrix existiert eine Basis aus Eigenvektoren. Man betrachte dazu

1 a

A=

mit a ∈ \ {0}. Es ist P (λ) = (−1)2 (1 − λ)2 = (1 − λ)2 , 1 ist

0 1

also einziger Eigenwert von A. Zur Bestimmung der Eigenvektoren ist folgendes

Gleichungssystem zu lösen:

~0 = (A − E) ◦ ~z = 0 a · z1 = a · z2 .

0 0

z2

0

C

Der Eigenraum zum einzigen Eigenwert 1 ist also

V1 = {(z1 , z2 ) ∈

C2 :

z2 = 0} = {(z1 , 0) : z1 ∈

C}.

Insbesondere existieren nicht zwei linear unabhängige Eigenvektoren von A. Die

algebraische Vielfachheit des Eigenwertes 1 ist 2, die geometrische 1.

234

7 Eigenwerte und Hauptachsentransformation

7.3.15 Folgerung

Die Determinante ist das Produkt der Eigenwerte (entsprechend ihren algebraischen

Vielfachheiten). Genauer gilt: Sei PF (λ) = (λ − λ1 )r1 · . . . · (λ − λs )rs mit λν 6= λµ

für µ 6= ν, r1 , . . . , rs ∈ und r1 + . . . + rs =Qn das charakteristische Polynom der

-linearen Abbildung F . Dann gilt: det(F ) = sν=1 λrνν .

N

C

Beweis

Wir haben

n

PF (λ) = (−1) det(F − λ id) =

s

Y

(λ − λν )rν .

ν=1

Durch Einsetzen von λ = 0 folgt

det(F ) =

s

Y

λrνν .

2

ν=1

Eigenvektoren normaler Matrizen

Am Ende von Abschnitt 7.2 haben wir die normalen Matrizen auf zunächst wenig

anschauliche Weise als Oberbegriff für die Hermiteschen und unitären Matrizen eingeführt. Die nächsten Sätze verdeutlichen, wie wichtig dieser neue Begriff tatsächlich

ist.

7.3.16 Satz

Die n × n-Matrix A sei normal. Dann ist λ Eigenwert von A genau dann, wenn λ̄

Eigenwert der adjungierten Abbildung Āt ist; die Eigenräume stimmen überein:

Vλ (A) = Vλ̄ (Āt ).

Beweis

Zunächst sei bemerkt, daß mit A auch A − λ E normal ist.

Sei ~z ∈ Vλ (A), also A ◦ ~z − λ ~z = ~0. Mit Hilfe von Satz 7.2.22 folgt

0 = k A ◦ ~z − λ~z k2 = ((A − λE) ◦ ~z, (A − λE) ◦ ~z )

t

t

= (A − λE) ◦ ~z, (A − λE) ◦ ~z

= (Āt − λ̄ · E) ◦ ~z, (Āt − λ̄ · E) ◦ ~z

= k Āt ◦ ~z − λ̄ · ~z k2 ;

Ā ◦ ~z = λ̄ · ~z.

t

t

t

Somit ist Vλ (A)

t⊂

Vλ̄ (Ā ). Derselbe Schluß, nun angewandt auf λ̄ und Ā , zeigt

Vλ̄ (Āt ) ⊂ Vλ̄¯ Āt = Vλ (A) und damit auch Vλ (A) = Vλ̄ (Āt ).

2

235

7.3 Eigenwerte

7.3.17 Satz

Je zwei Eigenvektoren ~z1 , ~z2 einer normalen Matrix A zu verschiedenen Eigenwerten

λ1 6= λ2 sind orthogonal.

Beweis

Gemäß Voraussetzung ist A ◦ ~z1 = λ1~z1 , A ◦ ~z2 = λ2~z2 ; der vorhergehende Satz

impliziert Āt ◦ ~z1 = λ̄1~z1 , Āt ◦ ~z2 = λ̄2~z2 . Damit folgt:

λ2 (~z1 , ~z2 ) = (~z1 , λ2~z2 ) = (~z1 , A ◦ ~z2 )

= (Āt ◦ ~z1 , ~z2 ) = (λ̄1 ◦ ~z1 , ~z2 ) = λ1 (~z1 , ~z2 ),

0 = (λ1 − λ2 )(~z1 , ~z2 ).

Aus der Verschiedenheit der Eigenwerte erhalten wir die Orthogonalität der Eigenvektoren: (~z1 , ~z2 ) = 0.

2

Eigenwerte Hermitescher Matrizen

7.3.18 Satz

Alle Eigenwerte Hermitescher Matrizen sind reell.

Beweis

Sei A = An,n Hermitesch mit Eigenvektor ~z ∈

Satz 7.2.18 zeigt:

Cn \ {~0} zum Eigenwert λ ∈ C.

λk ~z k2 = λ(~z, ~z ) = (~z, λ · ~z ) = (~z, A ◦ ~z ) ∈

Wegen k ~z k2 ∈

R \ {0} folgt, daß λ reell ist.

R.

2

7.3.19 Beispiele

(a) Für die Hermitesche 2 × 2-Matrix

A=

1 −3i

3i

1

lautet das charakteristische Polynom

P (λ) = det(A − λ E) = det

1−λ

3i

−3i

1−λ

= (λ − 1)2 − 9 = (λ − 4)(λ + 2);

die Eigenwerte sind λ1 = 4 und λ2 = −2.

= (1 − λ)2 + 9i2

236

7 Eigenwerte und Hauptachsentransformation

(b) Wir betrachten nun die reelle symmetrische 3 × 3-Matrix

7

1

− 23

6

6

2

2

A = − 23

−

.

3

3

1

2

7

−

6

3

6

Das charakteristische Polynom lautet

(7 − 6λ)

−4

1

det −4

(4 − 6λ)

P (λ) = (−1)3 det(A − λ E) = −

216

1

−4

(7 − 6λ)

−4

1

1

=−

det

24(1 − λ)

−6(2 + λ) 0

216

12(−3λ2 + 7λ − 4) 24(1 − λ) 0

72 =−

8(1 − λ)2 + (2 + λ)(−3λ2 + 7λ − 4)

216

1

= − −3λ3 + 9λ2 − 6λ = λ(λ − 1)(λ − 2),

3

1

−4

(7 − 6λ)

wir haben also die drei Eigenwerte λ1 = 0, λ2 = 1, λ3 = 2.

Eigenwerte unitärer Matrizen

7.3.20 Satz

Für jeden Eigenwert λ einer unitären Matrix A gilt |λ| = 1.

Beweis

Sei λ Eigenwert von A ∈ U (n) zum Eigenvektor ~z ∈

unitären Matrix impliziert

Cn \ {~0}. Die Längentreue der

k ~z k2 = k A ◦ ~z k2 = (A ◦ ~z, A ◦ ~z ) = (λ · ~z, λ · ~z ) = λλ̄ k ~z k2 .

Da k ~z k2 6= 0 ist, folgt |λ| = 1.

7.3.21 Satz

R

2

Sei A ∈ O(n, ) eine reelle orthogonale Matrix. Die Raumdimension n sei ungerade.

Dann ist +1 oder −1 Eigenwert von A. Ist A sogar eine Drehung, d. h. A ∈ SO(n, ),

dann ist +1 Eigenwert von A.

Wir werden auf S. 257 mit Hilfe der Diagonalisierungsresultate erläutern, daß in

der zu +1 gehörige Eigenvektor als Drehachse interpretiert werden kann.

R

R3

237

7.3 Eigenwerte

Beweis

Das charakteristische Polynom PA (λ) von A hat reelle Koeffizienten und wird hier

als Funktion → aufgefaßt. Der Term höchster Ordnung ist λn mit der ungeraden

Potenz n. Aus der Analysis weiß man limλ→∞ PA (λ) = +∞ und limλ→−∞ PA (λ) =

−∞. Der Zwischenwertsatz ergibt die Existenz wenigstens einer reellen Nullstelle λ0

mit |λ0 | = 1, denn A ist orthogonal und insbesondere unitär.

R R

Die nichtreellen Eigenwerte von A treten immer in zueinander konjugierten Paaren

auf: Sei λ1 Eigenwert von A, d. h. Nullstelle des charakteristischen Polynoms

0 = PA (λ1 ) =

λn1

+

n−1

X

aν λν1 ,

aν ∈

R.

ν=0

Durch Konjugation erhält man

0 = PA (λ1 ) =

λn1

+

n−1

X

aν λν1

ν=0

=

λ̄n1

+

n−1

X

aν λ̄ν1 ,

ν=0

λ̄1 ist also ebenfalls Eigenwert. Indem man den quadratischen Faktor (λ − λ1 )(λ − λ̄1 )

abspaltet, der nur reelle Koeffizienten besitzt, und das Verfahren iteriert, erhält man:

Die Matrix A hat 0 ≤ k ≤ (n − 1)/2 (nicht notwendigerweise verschiedene) Paare

zueinander konjugiert komplexer Eigenwerte λ1 , λ̄1 , . . . , λk , λ̄k und eine ungerade

Anzahl reeller Eigenwerte λ2k+1 , . . . , λn ∈ {+1, −1}; die Eigenwerte werden jeweils

entsprechend ihrer algebraischen Vielfachheit aufgeführt. Die Determinante ist das

Produkt der Eigenwerte:

det(A) = |λ1 |2 · . . . · |λk |2 · λ2k+1 · . . . · λn = λ2k+1 · . . . · λn .

Ist nun det(A) = +1, so können nicht alle reellen Eigenwerte = −1 sein, denn

n wurde als ungerade vorausgesetzt. In diesem Fall ist +1 (zumindest einfacher)

Eigenwert von A.

2

7.3.22 Beispiel

Durch direktes Nachrechnen sieht man, daß die reelle 3 × 3-Matrix

√

√

2

2

1

1

1

−

−

+

+

2

4√